Metody heurystyczne i eksperckie 1 2 3 4

![Efekt przywiązania – korzystanie ze zbyt mało różnorodnych źródeł informacji [1]. Efekt pseudopewności – Efekt przywiązania – korzystanie ze zbyt mało różnorodnych źródeł informacji [1]. Efekt pseudopewności –](https://slidetodoc.com/presentation_image/3f86f5a8934a78a36a5f9536f8a93c8f/image-45.jpg)

- Slides: 50

Metody heurystyczne i eksperckie 1. 2. 3. 4. 5. 6. 7. 8. Burza mózgów. Synektyka Gordona. Metoda delfijska. Metoda morfologiczna. Wybrane techniki CERMA. Rozkład Pareto. Metoda scenariuszowa. Charakterystyka ryzyk i zagrożeń w/w metod spowodowana błędami

Pojęcie heurystyki Heurystyka (gr. heurisko – odkrywam, znajduję) – nauka o dokonywaniu odkryć, zajmująca się badaniem praw, które rządzą myśleniem twórczym, oraz formowaniem metod ułatwiających i systematyzujących tego rodzaju działania. Heurystyka proponuje metody, które pomagają rozwiązać problem w warunkach niedostatecznej informacji i zrekompensować jej brak intuicją oraz wyobraźnią. Celem większości z nich jest rozwiązanie problemu lub przynajmniej zebranie idei prowadzących do jego rozwiązania oraz rozbudzanie fantazji, wyobraźni i kreatywności ludzi. Wyższa jakość uzyskiwanych rozwiązań oraz krótszy czas potrzebny na jego osiągnięcie to wynik pracy zespołowej, która stanowi podstawowe założenie znacznej większości metod heurystycznych. Kreatywność zbiorowa ma wiele zalet, w tym: • wysoką efektywność w zakresie rozwiązywania złożonych problemów, • nieograniczoną komunikację i większe możliwości opracowywania rozwiązań, • wyższy stopień tolerancji ryzyka w związku ze zwiększeniem szans na rozwiązanie problem

Heurystyka wywodzi się z j. greckiego i najczęściej kojarzone ze słynnym okrzykiem Archimedesa, który to pojęcie heurystyka (gr. εὕρηκα (heurēka) – znalazłem) użył podczas swojego odkrycia. Obecnie to pojęcie związane jest z filozofią, logiką, pedagogiką, psychologią, sztuczną inteligencją, teorią informacji oraz metodami przeszukiwania i oceny jakości interfejsów zasobów informacyjnych w Internecie. W szerokim ujęciu heurystyka jest nazwą dziedziny wiedzy, której cel stanowi poszukiwanie i badanie optymalnych metod oraz reguł odnajdywania odpowiedzi na stawiane zapytania lub problemy. Wielka encyklopedia PWN heurystykę definiuje jako umiejętność wykrywania nowych faktów i związków między faktami, zwłaszcza czynność formułowania hipotez. Zgodnie z Wielką Encyklopedią Multimedialną heurystyka to sztuka wykrywania nowych faktów oraz związków występujących pomiędzy nimi, prowadząca do odkrywania nowych prawd i stawiania hipotez. Podstawowe właściwości heurystyki pozwalają m. in. na: odkrywanie i tworzenie nowych rzeczy i zjawisk, rozwiązywanie problemów w sposób twórczy, wspieranie procesu tworzenia oraz rozwój cech z tym związanych, wykrywanie powiązań między faktami, samodzielne dochodzenie do prawdy, tworzenie hipotez, brak gwarancji uzyskania najlepszego rozwiązania.

Metody heurystyczne to two rcze rozwia zywanie problemo w. Algorytm to dokładny przepis (zasada) – heurystyka to czasem uz yteczna wskazo wka (Ne cka, 1994). Prognozowanie heurystyczne - to przewidywanie nowych obrazo w rzeczywistos ci kto re nie koniecznie wynikaja z dotychczasowego rozwoju systemu. Poła czenie s wiadomego wymys lania przyszłos ci z nies wiadomym porza dkowaniem i ła czeniem posiadanych informacji w celu ukazania moz liwego obrazu badanego obiektu w przyszłos ci. Heurystyczne metody prognozowania metody wykorzystuja ce do sformułowania prognozy, opinie eksperto w oparte na intuicji i dos wiadczeniu. (Krupowicz, 1997). Istnieje wiele metod heurystycznych dwie najcze s ciej stosowane: - burza mo zgów - metoda delficka

Kiedy nie matematyczne metody prognozowania daja dobre rezultaty? - brak czytelnej struktury systemu - brak informacji statystycznych o zachowaniu systemu w przeszłos ci - moz liwos c wysta pienia istotnych niecia głos ci w przyszłos ci - brak jednoznacznych informacji o zachowaniu otoczenia systemu w przyszłos ci. Metody analogowe Przewidywanie przyszłos ci okres lonej zmiennej przez wykorzystanie informacji o innych zmiennych, kto rych zmiany w czasie sa podobne, ale nie ro wnoczesne. Stosujemy następujące analogie: - biologiczne - przestrzenne - historyczne, oraz - przestrzenno – czasowe Dwie pierwsze wykorzystywane do prognoz jakos ciowych. Pozostałe dwie gło wnie do prognoz ilos ciowych.

WYBO R GRUPY EKSPERTO W Metody heurystyczne oparte na opiniach eksperto w, którzy je wykorzystują pamietając o ograniczeniach ich stosowania Metody heurystyczne – trafnos c sa do w grupowych jest zazwyczaj wyz sza niz trafnos c sądów indywidualnych (liczebność grupy ekspertów waha się od paru do paruset osób) Rozłoz enie ryzyka decyzji na grupe – sta d bardziej możliwe jest prawdopodobne formułowanie nietypowych rozwia zan. KRYTERIA DOBORU GRUPY EKSPERTO W: 1. Dobo r eksperto w jest ro żnorodny: od zajmuja cych sie ogo lnymi problemami jak ro wniez specjalis ci z danej dziedzinie (ro żnorodnośc grupy ekspertów zwie ksza szanse uzyskania niekonwncjonalnego (konserwatywnego) rozwia zania) 2. Grupa powinna być na tyle liczna, aby reprezentowac ro żne pogla dy 3. Eksperci powinni niezalez nie mys lec i posiadac własne pogla dy na temat przyszłos ci (badanego zjawiska) 4. Brak jest jednoznacznych kryterio w w ustaleniu optymalnej liczebnos ci grupy eksperto w i jej struktury.

RODZAJE HEURYSTYK Heurystyka Charakterystyka DOSTĘPNOŚCI (ang. availability heuristic) – uproszczona metoda wnioskowania polegająca na przypisywaniu większego prawdopodobieństwa zdarzeniom, które łatwiej przywołać do świadomości i są bardziej nacechowane emocjonalnie (ang. representativeness heuristic) – uproszczona metoda wnioskowania polegająca na dokonywaniu klasyfikacji na podstawie częściowego REPREZENTATYWNOŚCI podobieństwa do przypadku typowego, charakterystycznego, reprezentatywnego, który już znamy. ZAKOTWICZENIA I DOSTOSOWANIA (ang. anchoring and adjustment heuristic) zwana również zakotwiczeniem i dostosowaniem – uproszczona metoda wnioskowania polegająca na oparciu się (zakotwiczeniu) na jakiejś informacji, a następnie zmodyfikowaniu jej (dostosowaniu się do niej) w celu uzyskania odpowiedzi na pytanie lub wydania sądu.

Koncepcja „twórczego ścierania się” G. Hirshberga, zgodnie z którą nad projektem powinny pracować pary projektantów różniących się podejściem zawodowym, stylem pracy, doświadczeniem, wiedzą itp. , zakłada, że takie zderzenia są źródłem twórczych napięć, a wszelkie nowe pomysły będą przeanalizowane przez druga stronę i zrównoważone odmienną ideą. Interakcje pomiędzy ludźmi o różnych specjalizacjach, wnoszenie odmiennych spojrzeń i kompetencji zwiększa szansę na znalezienie nowatorskich rozwiązań. Heurystyka powiązana jest ściśle z tzw. myśleniem lateralnym (ang. lateral thinking), oznaczającym „sposób myślenia twórczego poszukujący rozwiązań trudnych problemów metodami nieortodoksyjnymi albo za pomocą elementów normalnie pomijanych przez logikę tradycyjną”. Do najpopularniejszych metod heurystycznych zaliczyć można: • burzę mózgów, • synektykę Gordona, • listy kontrolne, • listy atrybutów • skrzynki na propozycje

BURZA mózgów Najbardziej znaną metodą heurystyczną jest burza mózgów. Znana jest ona również pod nazwą brainstorming, metoda odroczonego wartościowania, metoda twórczej dyskusji, sesja pomysłowości, twórcza dyskusja. Jej twórcą był A. F. Osborn, który nazywany jest też pionierem opisywania metod twórczego myślenia (creative thinking). Wyszedł on z założenia, że każdy człowiek jest zdolny do działania twórczego, jednak nie w pełni wykorzystuje swoje możliwości. Pierwszą burzę mózgów przeprowadził w 1938 roku. Od tamtego czasu metoda ta jest powszechnie wykorzystywana na całym świecie. Zespół biorący udział w burzy mózgów, po odpowiednim przeszkoleniu, może wykorzystywać tą metodę do większości problemów. Jest to uniwersalna technika generowania dużych ilości nowych pomysłów oraz wyboru z nich najlepszych rozwiązań. Poprzez pobudzenie członków zespołu do aktywności i usunięcie barier hamujących ich twórczość, burza mózgów jest jedną z metod o największej płodności heurystycznej.

Na właściwy przebieg burzy mózgów składają się dwie sesje: twórczości i oceny, poprzedzonych fazą przygotowań. Faza przygotowań składa się z następujących elementów: • przygotowanie pomieszczenia do przeprowadzenie burzy mózgów, • zapewnienie ciszy i spokoju uczestnikom (eliminacja czynników rozpraszających uwagę), • zapewnienie względnego komfortu (wygoda stworzona dla uczestników BM nie powinna być zbyt duża, by ich nie „rozleniwiać”), • przygotowanie uczestników do przeprowadzenia burzy mózgów, • podział uczestników na zespoły, • wybór przewodniczącego i sekretarza w każdym z zespołów, • wyjaśnienie/przypomnienie zasad burzy mózgów, • podanie tematu (zagadnienia, problemu) burzy mózgów. Plusy metody burzy mózgów - krótki czas - niewielkie koszty Najlepsze efekty dla rozwiązywania niezbyt złożonych problemów.

Schemat przebiegu burzy mózgów Faza przygotowań Faza 1 Sesja twórczości Faza 2 Sesja oceny pomysłów Faza 3 Przewodniczący zespołu jest jednocześnie animatorem pracy grupy. Ma on za zadanie pobudzać uczestników do jak największej twórczości, dbać o prawidłowy przebieg (zachowanie zasad) burzy mózgów. Sekretarz natomiast zapisuje pomysły w sposób widoczny i czytelny dla uczestników. Podobnie jak przewodniczący zespołu, może również sam zgłaszać pomysły. Sesja twórczości polega na intensywnej, twórczej pracy nad problemem. Celem jest zgłoszenie jak największej liczby pomysłów przez możliwie wszystkich uczestników burzy mózgów przy zachowaniu zasad metody.

Podstawowe zasady burzy mózgów: • nie krytykować!, • zgłaszać wszystkie pomysły!. Pomysły mogą być nierealne; z nich mogą powstawać nowe warianty rozwiązania. Każdy z uczestników powinien zgłaszać swoje pomysły, jeśli to możliwe - pojedynczo. Nie powinno być dominacji jednej lub grupy osób. Pomiędzy fazą drugą i trzecią może dojść do krótkiej przerwy, w której ewentualnie zachodzi odejście z zespołu osób nie będących specjalistami z analizowanej dziedziny. Faza trzecia może również nastąpić po kilku dniach, w czasie których również jest możliwe zgłaszanie pomysłów. Sesja oceny pomysłów obejmuje wybór metody selekcji wariantów rozwiązań oraz wybór jednego lub kilku rozwiązań końcowych, najlepszych zdaniem zespołu oceniającego. Istnieje kilka odmian burz mózgów. Najbardziej interesującą jest indywidualna BM, pozwalająca osobie samej tworzyć i oceniać swoje pomysły. Nie występuje tu wtedy oczywiście efekt synergii, zmniejszona jest możliwość wygenerowania dużej liczby pomysłów. Innymi odmianami, bardziej raczej nastawionymi na wymuszanie twórczości niż na swobodę w jej stosowaniu, są 635 oraz Philips 66 Buzz Session

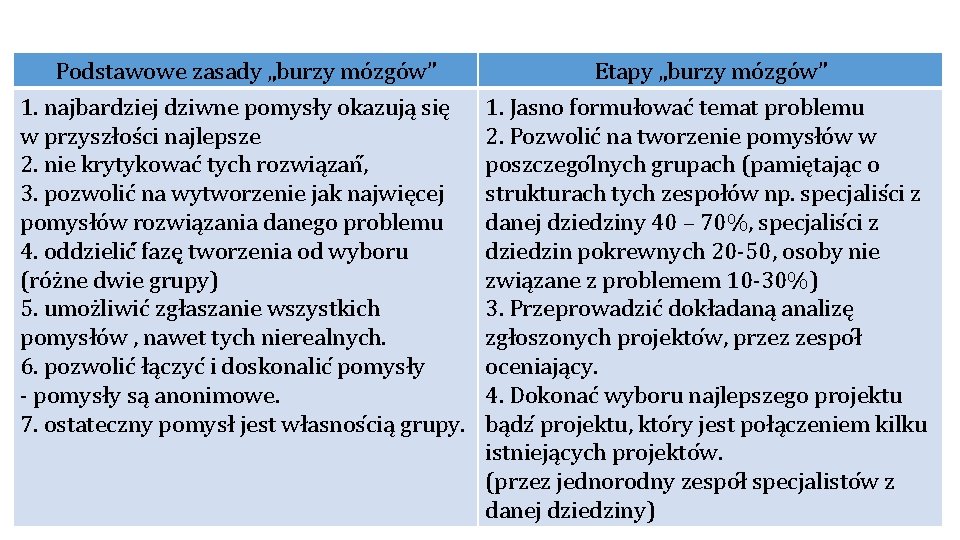

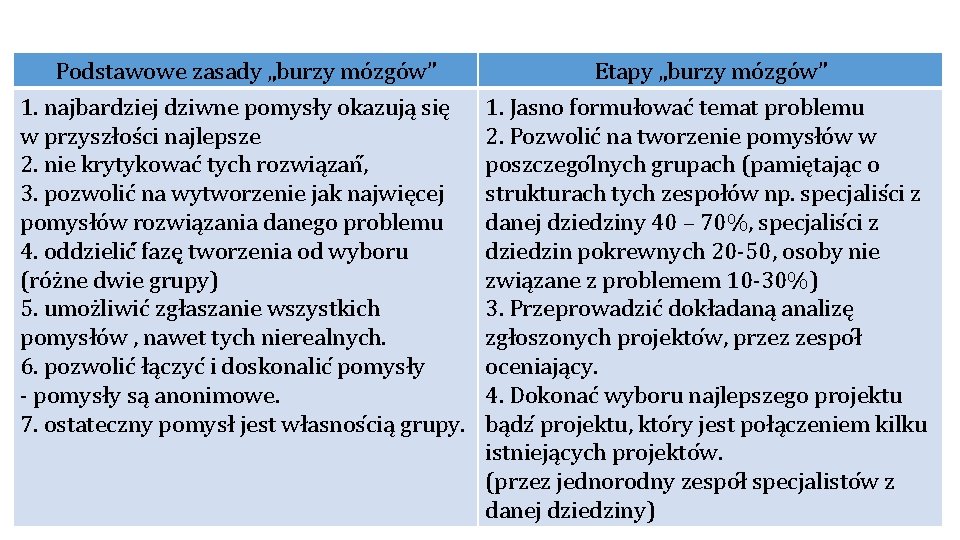

Podstawowe zasady „burzy mózgów” 1. najbardziej dziwne pomysły okazują się w przyszłości najlepsze 2. nie krytykować tych rozwiązań , 3. pozwolić na wytworzenie jak najwięcej pomysłów rozwią zania danego problemu 4. oddzielić fazę tworzenia od wyboru (różne dwie grupy) 5. umożliwić zgłaszanie wszystkich pomysłów , nawet tych nierealnych. 6. pozwolić ła czyc i doskonalic pomysły - pomysły sa anonimowe. 7. ostateczny pomysł jest własnos cia grupy. Etapy „burzy mózgów” 1. Jasno formułować temat problemu 2. Pozwolić na tworzenie pomysłów w poszczego lnych grupach (pamiętając o strukturach tych zespołów np. specjalis ci z danej dziedziny 40 – 70%, specjalis ci z dziedzin pokrewnych 20 -50, osoby nie zwia zane z problemem 10 -30%) 3. Przeprowadzić dokładaną analizę zgłoszonych projekto w, przez zespo ł oceniaja cy. 4. Dokonać wyboru najlepszego projektu ba dz projektu, kto ry jest poła czeniem kilku istnieja cych projekto w. (przez jednorodny zespo ł specjalisto w z danej dziedziny)

Wady tradycyjnych metod eksperckich • - dominacja jednego eksperta, lub grupy • - presja grupy na indywidualnego eksperta • - konserwatyzm wobec zaje tego wczes niej stanowiska • - duża liczba zbe dnych informacji

Synektyka Gordona Wyraz „synektyka” pochodzi z języka greckiego i znaczy w przybliżeniu zestawienie okoliczności pozornie niezależnych. Twórcą tej metody jest W. J. J. Gordon. Zaproponował on, by rozwiązanie problemów powstawało poprzez integrację różnych pomysłów, nawet nie mających ze sobą związku, bądź też poprzez negację i krytykę rozwiązań, które są powszechnie stosowane. Do wykorzystania tej metody potrzebny jest jednak odpowiedni, czasem długotrwały trening, który ma na celu rozwinięcie giętkości myślenia. Atmosfera wytworzona w trakcie stosowania tej metody powinna być podobna jak przy BM: duży dynamizm generowania pomysłów w atmosferze oderwania od rzeczywistości. Synektyka - symulacja procesów twórczych (wg Gordona i Prince’a). Myśl przewodnia. Metoda synektyczna przywiązuje wagę do wykorzystywania metafor i podobieństw pobieranych przede wszystkim z natury. Przy metodycznym stosowaniu tego postępowania usiłujemy symulować proces twórczy przebiegający nieświadomie. Zastosowanie: do analizy i problemów koniunkturalnych Wykorzystanie. Nowe podejście do pomysłów rozwiązań zagadnień technicznych przekazuje się ekspertom do dalszego opracowania i oceny. Wyniki należy podać do wiadomości uczestnikom zebrania.

Metoda delfijska Nazwa tej metody pochodzi od nazwy starożytnego miasta Delfy, gdzie znajdowała się świątynia Apollina, w której kapłanki (Pytie) przepowiadały przyszłość. Metoda ta powstała w 1963 roku. Jest metodą predykcji naukowej i technicznej, biorącą początek od prac grupy naukowców RAND Corporation (Research and Development Corporation) z Santa Monica w Kaliforni. W tej metodzie wykorzystuje się wiedzę ekspertów i ich przypuszczenia dotyczące pojawienia się w przyszłości rozwiązań problemów. Wywodzi się z założenia, że prognozy dokonywane przez grupę osób cechują się większą trafnością, niż prognozy pojedynczych osób. W trakcie bezpośrednich spotkań dochodzi jednak do zaburzenia procesu dochodzenia do wspólnego zdania. Rozwiązaniem problemu było wykorzystanie ankiet. Spowodowane jest to predyspozycjami interpersonalnymi poszczególnych osób. „Prace nad zwiększeniem efektywności grupowych ocen w tworzeniu prognoz przyniosły efekty, dzięki którym usunięto następujące mankamenty zbiorowej ekspertyzy prognostycznej: dominację silnych indywidualności w grupie, dążenie do konformizmu, wewnętrzne związki i oddziaływania w grupie, niechęć do publicznej zmiany stanowiska”. M. Cieślak (red. ). Prognozowanie gospodarcze. Wydawnictwo Akademii Ekonomicznej we Wrocławiu, Wrocław 1993, s. 105.

Etapy badania ankietowego w metodzie delfickiej 1. Zdefiniowanie problemu 2. Wybór grona ekspertów 3. Przygotowanie i wysłanie ankiety 4. Analiza odpowiedzi zwrotnych 5. Czy zgoda została osiągnięta: - Tak, przejście do pkt. 8 - Nie, przejście do pkt 6 6. Przygotowanie i wysłanie następnej ankiety 7. Kolejna analiza odpowiedzi, powrót do pkt 5 8. Przedstawienie wyników Metodę delficką cechuje: niezależność opinii anonimowość opinii oraz ekspertów unikanie dominujących osobowości kontrolowane sprzężenie zwrotne zdalna, asynchroniczna, grupowa komunikacja statystyczne opracowanie wyników wieloetapowość uzgadnianie i sumowanie opinii kompetentnych osób

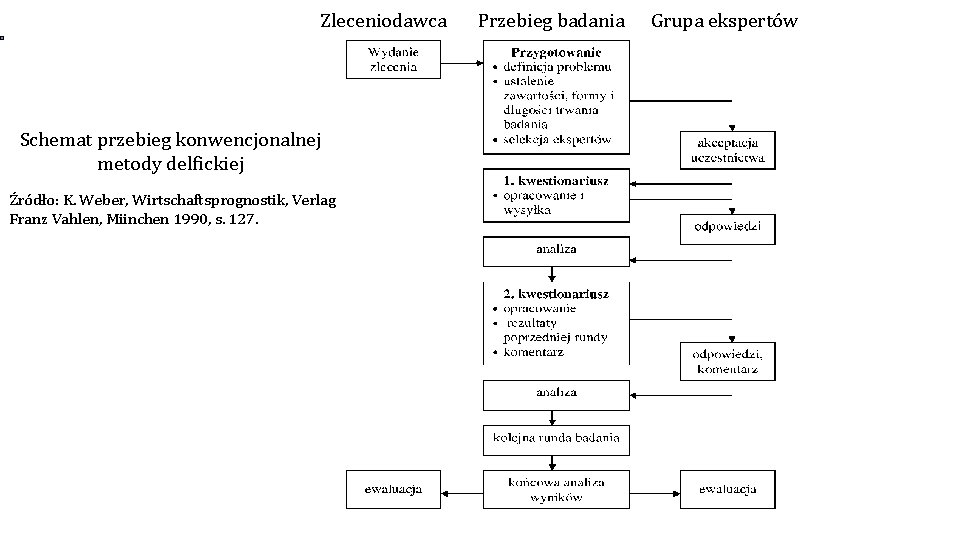

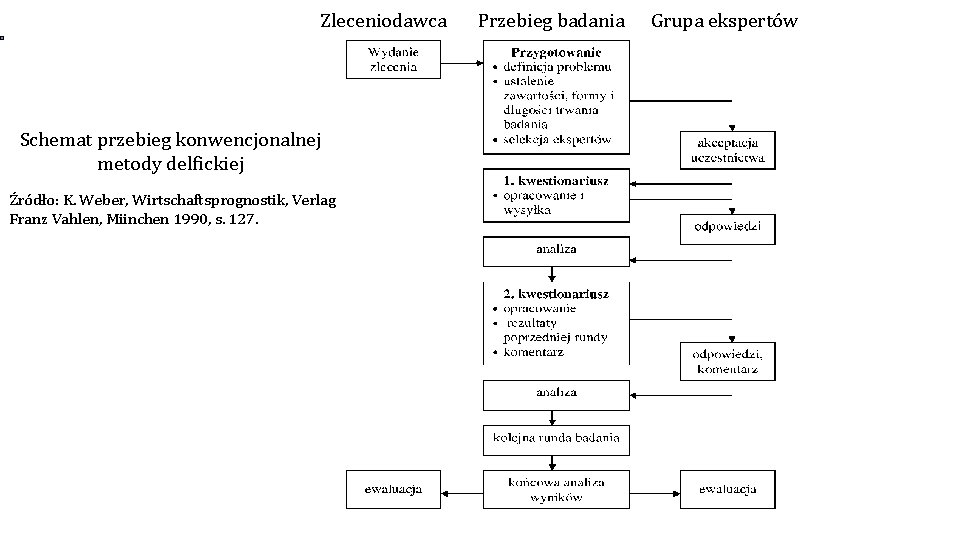

Zleceniodawca Przebieg badania Grupa ekspertów Schemat przebieg konwencjonalnej metody delfickiej Źródło: K. Weber, Wirtschaftsprognostik, Verlag Franz Vahlen, Miinchen 1990, s. 127.

Metodę delficką stosuje się do różnorodnych aspektów prognozowania i planowania. Wymaga ona udzielenia odpowiedzi przez co najmniej dwudziestu wysoko wykwalifikowanych ekspertów. Pomiędzy ekspertami nie ma konieczności występowania kontaktów, dlatego też mogą oni mieszkać daleko od siebie. Skład zespołów ekspertów może być utrzymany całkowicie w tajemnicy (przynajmniej do czasu opublikowania wyników). Zgromadzone na podstawie doświadczeń z przeprowadzaniem badania metodą delficką obserwacje mówią, że należy się liczyć ze znacznym stopniem zmniejszania się liczby ekspertów w trakcie jego trwania w związku z dużą liczbą rund (badanie delfickie w swej klasycznej postaci zawiera jedynie dwie rundy). Eksperci mogą (a w niektórych sytuacjach nawet powinni) wraz z pytaniami otrzymać dodatkowe informacje o badanym zjawisku czy procesie (mogą być one wartościowe szczególnie w pierwszej rundzie). Przygotowywane pytania powinny być możliwie precyzyjnie i neutralnie sformułowane, przy czym należy uwzględnić kompetencje ekspertów. Pytania mogą być zasadniczo zadawane niezależnie jedno od drugiego i dotyczyć mogą różnych obszarów wiedzy. Można je podzielić tematycznie lub zadawać pojedynczo. „Należy zauważyć, że zdaniem autorów niemieckich obok zewnętrznych ekspertów bardzo korzystny może być też fachowo wykwalifikowany personel”. K. Weber, Wirtschaftsprognostik, Verlag Franz Vahlen, Miinchen 1990, s. 128.

Łączna liczba pytań nie powinna powodować nadmiernego (zniechęcającego) obciążenia ekspertów. Czas przygotowania odpowiedzi na pytania nie powinien przekroczyć jednej godziny - przeciętnie jest to 25 pytań. Nadmierna liczba pytań może prowadzić do niepożądanej sytuacji udzielania zbyt szybko odpowiedzi (snap judgements) i przez to powodować konieczność przeprowadzenia następnego badania w przyszłości. Pytania mogą przykładowo dotyczyć przypuszczalnego punktu czasu zajścia zdarzenia. Mogą też zawierać prośbę o podaniu prawdopodobieństwo jego wystąpienia i wykorzystane źródło informacji. Włączenie pustych miejsc może zachęcać ekspertów do wyrażenia komentarzy. Komentarze te mogą dawać okazję do przekształcenia i uzupełnienia pytań do następnych rund. Z praktyki jednak wynika, że ich wykorzystanie dla tego celu może być bardzo trudne. Końcowe sprawozdanie trafia do zleceniodawców i zazwyczaj też do ekspertów biorących udział w badaniu.

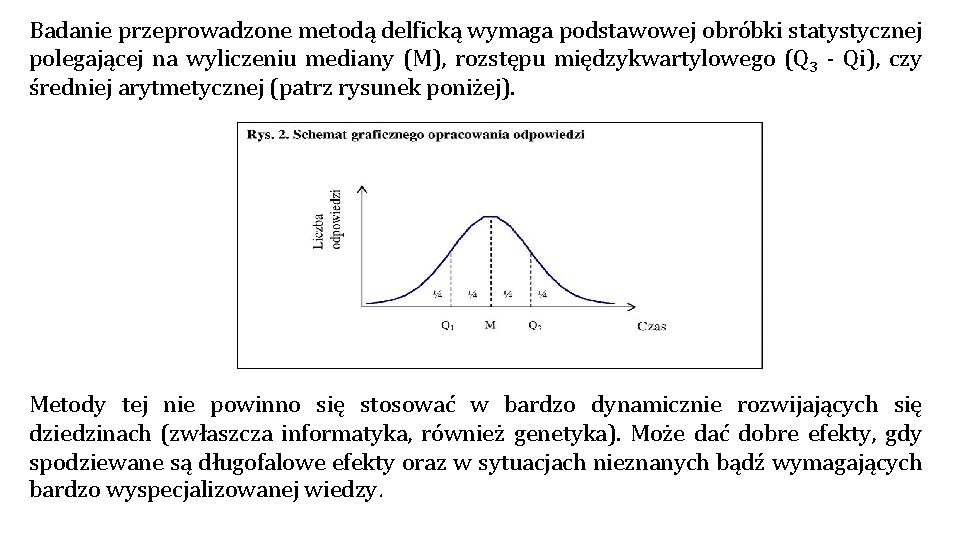

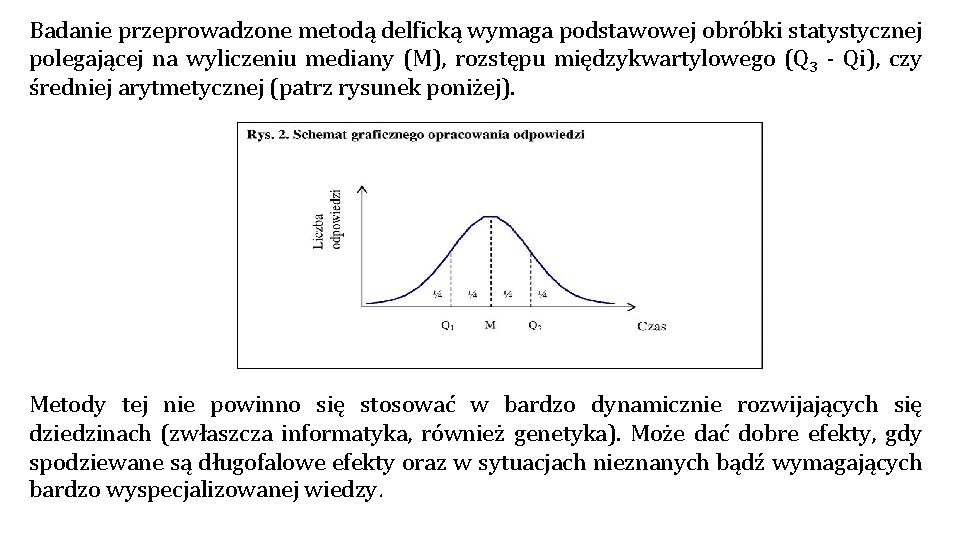

Badanie przeprowadzone metodą delficką wymaga podstawowej obróbki statystycznej polegającej na wyliczeniu mediany (M), rozstępu międzykwartylowego (Q 3 - Qi), czy średniej arytmetycznej (patrz rysunek poniżej). Metody tej nie powinno się stosować w bardzo dynamicznie rozwijających się dziedzinach (zwłaszcza informatyka, również genetyka). Może dać dobre efekty, gdy spodziewane są długofalowe efekty oraz w sytuacjach nieznanych bądź wymagających bardzo wyspecjalizowanej wiedzy.

Wady metody delfickiej: 1. Wolna 2. Kosztowna 3. Ograniczona do jednego tematu 4. Założenie, że zgodność opinii jest równoznaczna z ich prawdziwością i trafnością 5. Trudności w doborze grupy ekspertów 6. Konieczność zaangażowania dużej liczby osób opracowujących ankietę i odpowiedzi 7. Brak bezpośredniej wymiany poglądów 8. Wykorzystanie tylko do prognoz długookresowych, co utrudnia weryfikację

Metoda morfologiczna Autorem tej metody jest astrofizyk z California Institute of Technology - F. Zwicky. Zaproponował on dla jej nazwania termin „analiza morfologiczna”. W rzeczywistości idea tej metody pochodzi od mnicha R. Lullusa. Jest to kolejna próba zmechanizowania procesu wynalazczości. „W istocie rzeczy analiza morfologiczna jest metodą twórczości, dokładniej - systematyczną pomocą w twórczości. Nie eliminuje ona twórczej pracy człowieka, lecz stymuluje i rozwija ją, pozwalając wyobraźni działać na większej liczbie idei, niż byłoby to możliwe przy bardziej klasycznym podejściu”. Metoda ta polega ona na analizie wszystkich rozwiązań danego problemu. Tworzone są „iloczyny morfologiczne”, będące kombinacjami wszystkich wariantów cech charakteryzujących problem. Ponieważ lista ta jest bardzo długa, należy dokonać selekcji pomysłów. Brak uniwersalnego sposobu selekcji był zasadniczą wadą tej metody. Podobnie jak w przypadku algorytmu wynalazku, brak jest w literaturze przykładów znaczących przykładów zastosowań zakończonych sukcesem. Podaje się natomiast dziedziny, w których możliwe jest zastosowanie tej metody. Pomimo spadku zainteresowania metodami heurystycznymi w latach osiemdziesiątych, metoda morfologiczna znalazła swoje współczesne zastosowanie np. w komputerowych wydawnictwach słownikowych. W Komputerowym Słowniku Języka Polskiego PWN metodę tą użyto do wspomagania wyszukiwania powiązań pomiędzy różnymi odmianami słowa, co zwłaszcza w języku polskim może sprawiać problemy nie tylko cudzoziemcom.

Techniki CERMA Jest to grupa 46 technik stworzonych w Centrum Studiów i Badań nad Metodologią Stosowaną (nazwa wzięła się od pierwszych liter oryginalnej, francuskiej nazwy Centrum). Metody te spopularyzowane zostały w Polsce przez Budzanowską, a następnie przez Martyniaka (nazwę: „metoda CERMA” wprowadził J. Antoszkiewicz). Dają one możliwość różnorodnego podejścia do problemu. Są uniwersalne i dość łatwe w stosowaniu. Wybranymi przykładami są: Technika adwokata - polega ona na tym, że jedna z osób gra rolę adwokata i stara się za wszelką cenę obronić dany wariant rozwiązania. Przeciwną do niej techniką jest technika „adwokata diabła”, w której jedna z osób atakuje analizowaną propozycję. Technika antyhistoryczna - analizy zjawisk dokonuje się w oderwaniu od kontekstu historycznego, bez wglądu w przyczyny, które je spowodowały. Technika małych zmian- jest to technika, która przez analogię podobna jest do występującej w programowaniu liniowym analizy wrażliwości. Bada się wpływ wprowadzenia takich małych zmian, które nie pogorszyłyby dotychczasowych wyników. Technika modeli analogicznych - celem stosowania tej techniki jest wykorzystanie rozwiązań z danej dziedziny w innej przy wykorzystaniu podobieństw pomiędzy nimi. Podobna do niej jest analogia historyczna, która była używana jako narzędzie prognostyczne. Technika zastosowania teorii - na podstawie ogólnego prawa próbuje się przewidzieć, jakie może mieć niewykorzystane dotąd zastosowania. Technikę tą często nazywa się metodą analogii i nie zalicza się jej do grupy metod heurystycznych, Opis niektórych metod CERMA można znaleźć np. w: J. Antoszkiewicz, Metody heurystyczne. Twórcze rozwiązywanie problemów, PWE, wyd. II, Warszawa 1990, s. 165 -180 lub szerzej w: Z. Martyniak, Elementy metodologii organizowania. Warszawa 1996.

Rozkład Pareto, znany również pod nazwami metoda 20 -80, ABC, krzywa Pareto, zawdzięcza swoje powstanie włoskiemu ekonomiście - V. Pareto. Badając rozkłady dochodów ludności w zależności od liczebności osób w danych grupach zauważył on prawidłowość w ich występowaniu. Metodę tę z powodzeniem można było zastosować w innych dziedzinach. Jest to jedna z bardziej popularnych metod heurystycznych. Wykorzystywana jest ona często do usprawniania przedsiębiorstw (analiza kosztów). Dzięki jej zastosowaniu możliwe jest w dość prosty i obrazowy sposób znalezienie obszarów, w których wprowadzenie zmian da największe zmiany wyników ekonomicznych. Podstawową cechą metody jest oparcie jej o interpretację stosunku 20: 80. Może to na przykład oznaczać, że 20% czynności pociąga za sobą 80% kosztów. Właśnie te czynności powinny być zatem szczególnie uwzględniane w planach usprawniania firmy. Oczywiście nie musi występować dokładnie taka proporcja (może to być np. 30: 70). Pokazuje ona jednak sferę, w której powinny być podjęte najbardziej intensywne kroki zmierzające np. do redukcji kosztów.

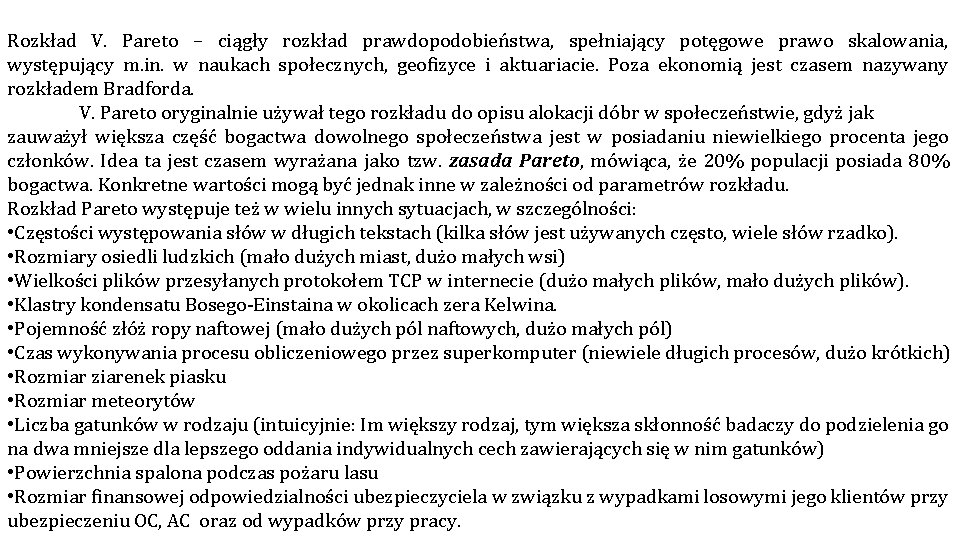

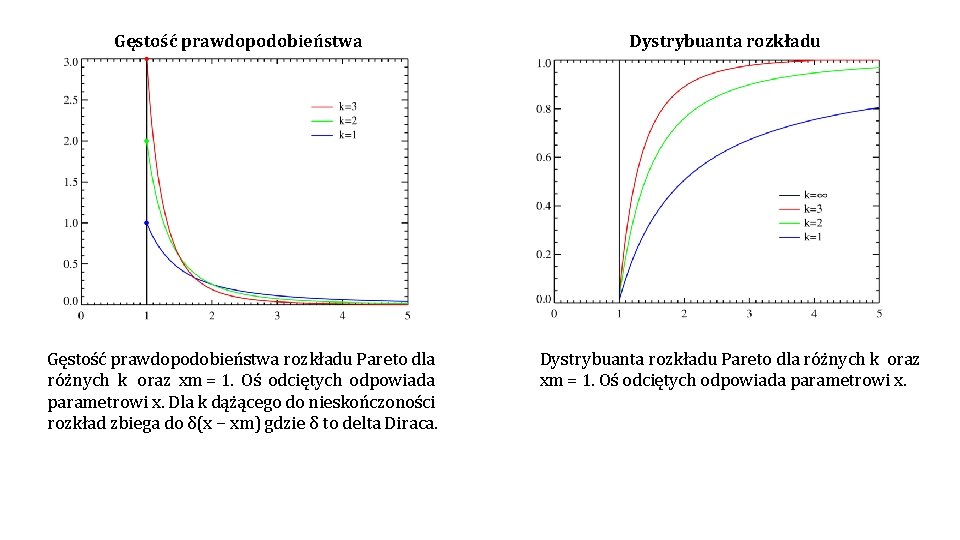

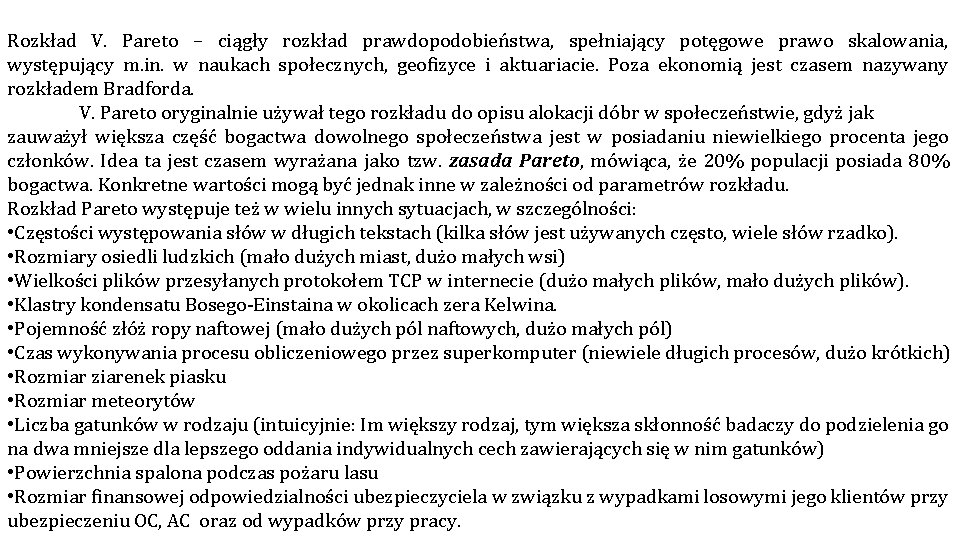

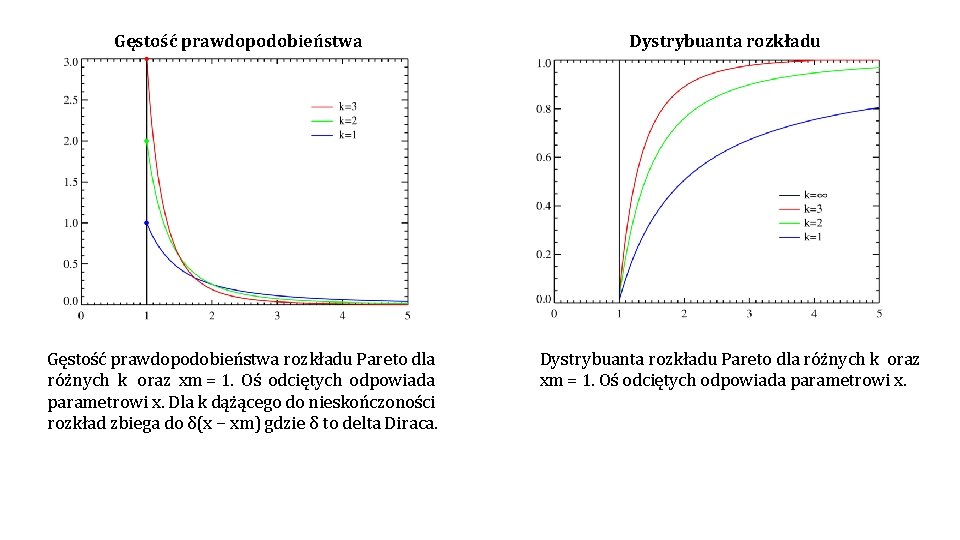

Rozkład V. Pareto – ciągły rozkład prawdopodobieństwa, spełniający potęgowe prawo skalowania, występujący m. in. w naukach społecznych, geofizyce i aktuariacie. Poza ekonomią jest czasem nazywany rozkładem Bradforda. V. Pareto oryginalnie używał tego rozkładu do opisu alokacji dóbr w społeczeństwie, gdyż jak zauważył większa część bogactwa dowolnego społeczeństwa jest w posiadaniu niewielkiego procenta jego członków. Idea ta jest czasem wyrażana jako tzw. zasada Pareto, mówiąca, że 20% populacji posiada 80% bogactwa. Konkretne wartości mogą być jednak inne w zależności od parametrów rozkładu. Rozkład Pareto występuje też w wielu innych sytuacjach, w szczególności: • Częstości występowania słów w długich tekstach (kilka słów jest używanych często, wiele słów rzadko). • Rozmiary osiedli ludzkich (mało dużych miast, dużo małych wsi) • Wielkości plików przesyłanych protokołem TCP w internecie (dużo małych plików, mało dużych plików). • Klastry kondensatu Bosego-Einstaina w okolicach zera Kelwina. • Pojemność złóż ropy naftowej (mało dużych pól naftowych, dużo małych pól) • Czas wykonywania procesu obliczeniowego przez superkomputer (niewiele długich procesów, dużo krótkich) • Rozmiar ziarenek piasku • Rozmiar meteorytów • Liczba gatunków w rodzaju (intuicyjnie: Im większy rodzaj, tym większa skłonność badaczy do podzielenia go na dwa mniejsze dla lepszego oddania indywidualnych cech zawierających się w nim gatunków) • Powierzchnia spalona podczas pożaru lasu • Rozmiar finansowej odpowiedzialności ubezpieczyciela w związku z wypadkami losowymi jego klientów przy ubezpieczeniu OC, AC oraz od wypadków przy pracy.

Gęstość prawdopodobieństwa rozkładu Pareto dla różnych k oraz xm = 1. Oś odciętych odpowiada parametrowi x. Dla k dążącego do nieskończoności rozkład zbiega do δ(x − xm) gdzie δ to delta Diraca. Dystrybuanta rozkładu Pareto dla różnych k oraz xm = 1. Oś odciętych odpowiada parametrowi x.

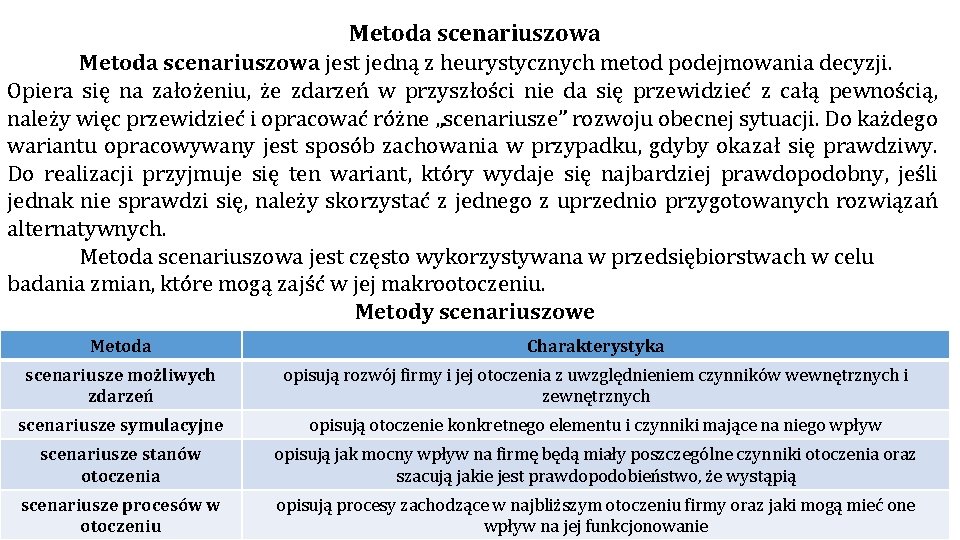

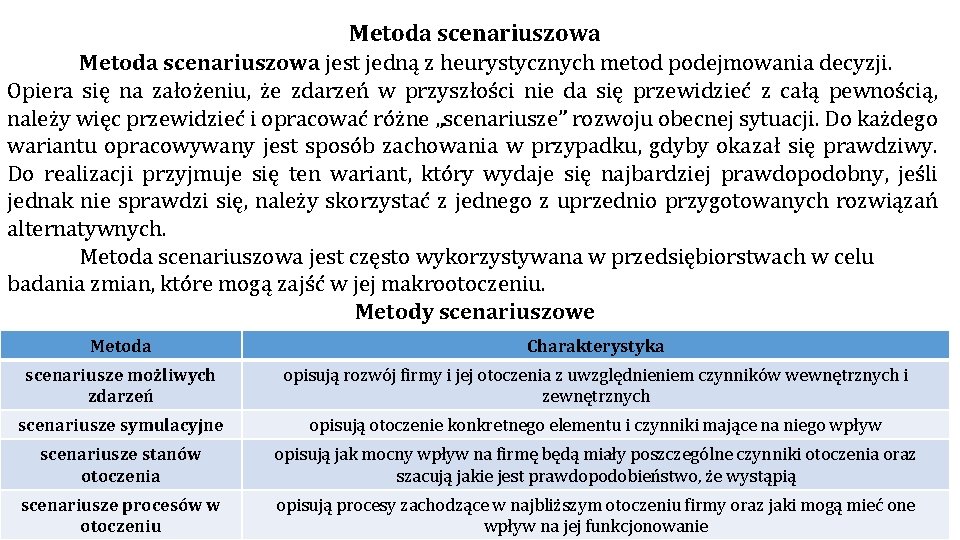

Metoda scenariuszowa jest jedną z heurystycznych metod podejmowania decyzji. Opiera się na założeniu, że zdarzeń w przyszłości nie da się przewidzieć z całą pewnością, należy więc przewidzieć i opracować różne „scenariusze” rozwoju obecnej sytuacji. Do każdego wariantu opracowywany jest sposób zachowania w przypadku, gdyby okazał się prawdziwy. Do realizacji przyjmuje się ten wariant, który wydaje się najbardziej prawdopodobny, jeśli jednak nie sprawdzi się, należy skorzystać z jednego z uprzednio przygotowanych rozwiązań alternatywnych. Metoda scenariuszowa jest często wykorzystywana w przedsiębiorstwach w celu badania zmian, które mogą zajść w jej makrootoczeniu. Metody scenariuszowe Metoda Charakterystyka scenariusze możliwych zdarzeń opisują rozwój firmy i jej otoczenia z uwzględnieniem czynników wewnętrznych i zewnętrznych scenariusze symulacyjne opisują otoczenie konkretnego elementu i czynniki mające na niego wpływ scenariusze stanów otoczenia opisują jak mocny wpływ na firmę będą miały poszczególne czynniki otoczenia oraz szacują jakie jest prawdopodobieństwo, że wystąpią scenariusze procesów w otoczeniu opisują procesy zachodzące w najbliższym otoczeniu firmy oraz jaki mogą mieć one wpływ na jej funkcjonowanie

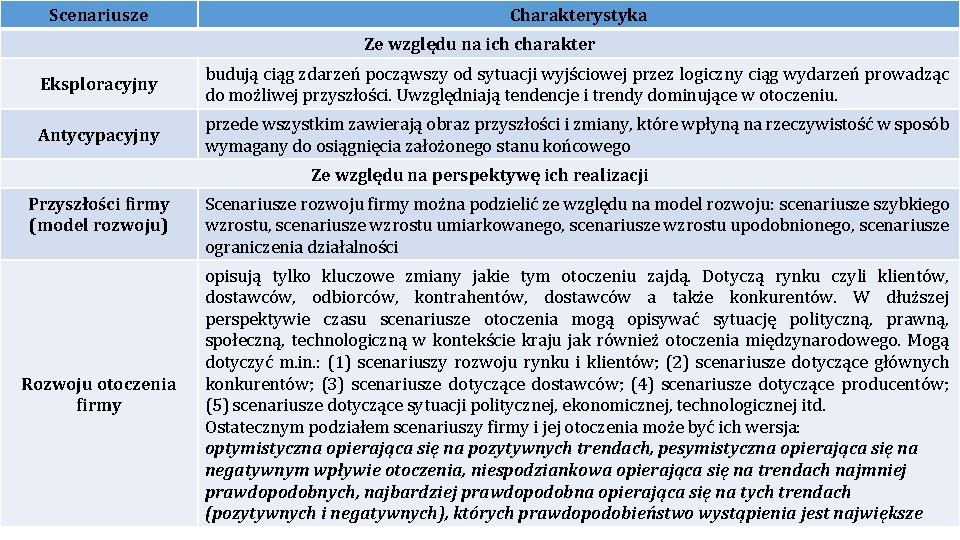

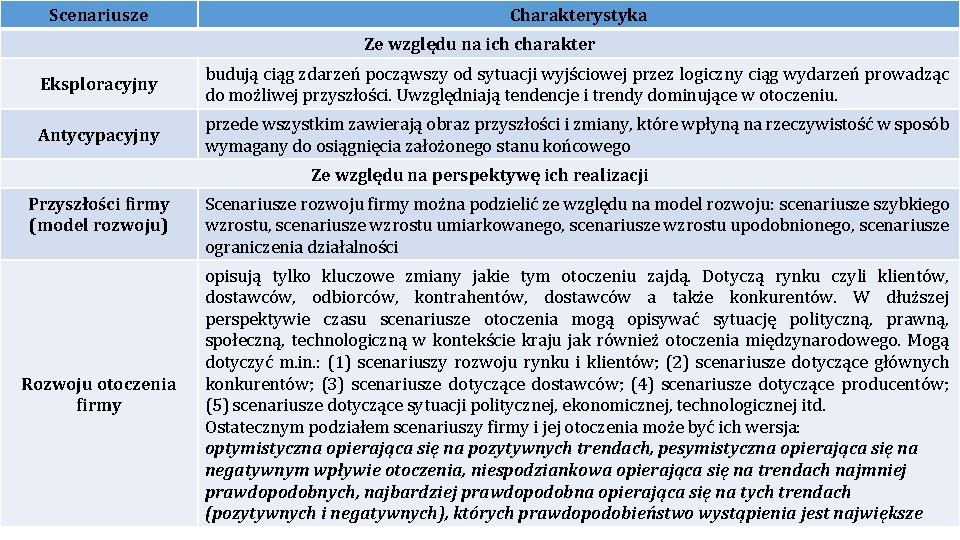

Scenariusze Charakterystyka Ze względu na ich charakter Eksploracyjny budują ciąg zdarzeń począwszy od sytuacji wyjściowej przez logiczny ciąg wydarzeń prowadząc do możliwej przyszłości. Uwzględniają tendencje i trendy dominujące w otoczeniu. Antycypacyjny przede wszystkim zawierają obraz przyszłości i zmiany, które wpłyną na rzeczywistość w sposób wymagany do osiągnięcia założonego stanu końcowego Ze względu na perspektywę ich realizacji Przyszłości firmy (model rozwoju) Rozwoju otoczenia firmy Scenariusze rozwoju firmy można podzielić ze względu na model rozwoju: scenariusze szybkiego wzrostu, scenariusze wzrostu umiarkowanego, scenariusze wzrostu upodobnionego, scenariusze ograniczenia działalności opisują tylko kluczowe zmiany jakie tym otoczeniu zajdą. Dotyczą rynku czyli klientów, dostawców, odbiorców, kontrahentów, dostawców a także konkurentów. W dłuższej perspektywie czasu scenariusze otoczenia mogą opisywać sytuację polityczną, prawną, społeczną, technologiczną w kontekście kraju jak również otoczenia międzynarodowego. Mogą dotyczyć m. in. : (1) scenariuszy rozwoju rynku i klientów; (2) scenariusze dotyczące głównych konkurentów; (3) scenariusze dotyczące dostawców; (4) scenariusze dotyczące producentów; (5) scenariusze dotyczące sytuacji politycznej, ekonomicznej, technologicznej itd. Ostatecznym podziałem scenariuszy firmy i jej otoczenia może być ich wersja: optymistyczna opierająca się na pozytywnych trendach, pesymistyczna opierająca się na negatywnym wpływie otoczenia, niespodziankowa opierająca się na trendach najmniej prawdopodobnych, najbardziej prawdopodobna opierająca się na tych trendach (pozytywnych i negatywnych), których prawdopodobieństwo wystąpienia jest największe

Procedura sporządzania scenariuszy przyszłości firmy zawiera: • określenie czemu scenariusz ma służyć • ocena sytuacji wyjściowej firmy • ocena czynników, które mogą wpłynąć na rozwój firmy • określenie potencjału rozwojowego firmy na podstawie zebranych już doświadczeń • opisanie możliwych wizji przyszłości firmy i kroków, które wpłyną na te wizje • opracowanie planu wykorzystania scenariuszy do budowy przyszłości firmy

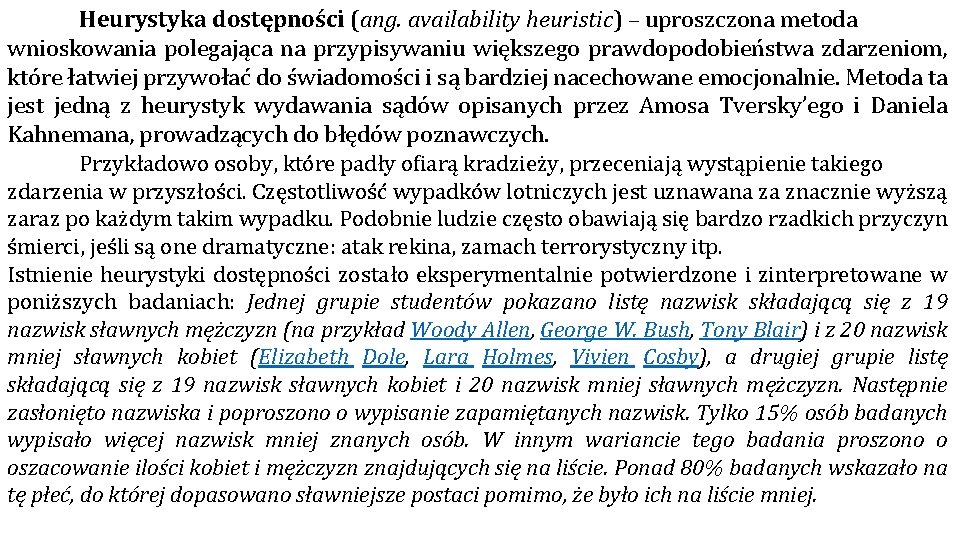

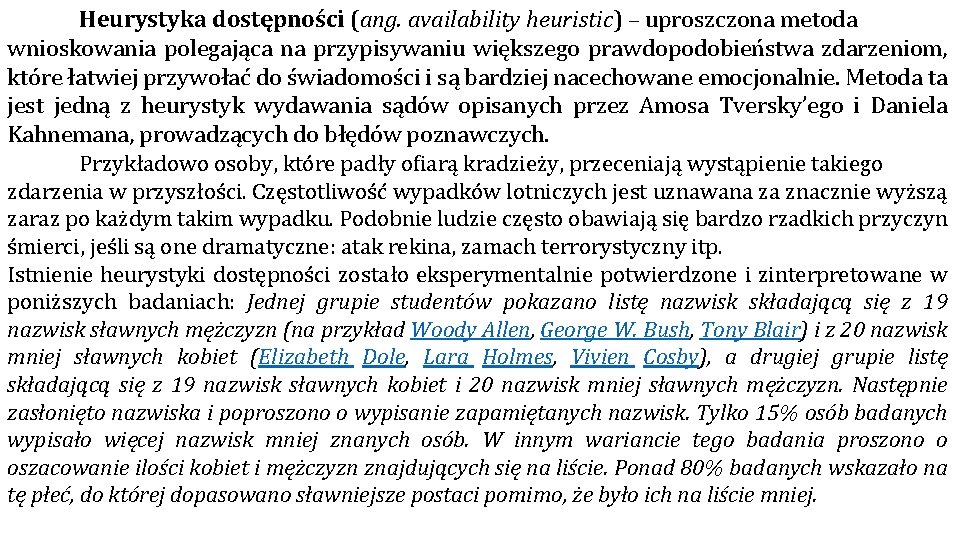

Heurystyka dostępności (ang. availability heuristic) – uproszczona metoda wnioskowania polegająca na przypisywaniu większego prawdopodobieństwa zdarzeniom, które łatwiej przywołać do świadomości i są bardziej nacechowane emocjonalnie. Metoda ta jest jedną z heurystyk wydawania sądów opisanych przez Amosa Tversky’ego i Daniela Kahnemana, prowadzących do błędów poznawczych. Przykładowo osoby, które padły ofiarą kradzieży, przeceniają wystąpienie takiego zdarzenia w przyszłości. Częstotliwość wypadków lotniczych jest uznawana za znacznie wyższą zaraz po każdym takim wypadku. Podobnie ludzie często obawiają się bardzo rzadkich przyczyn śmierci, jeśli są one dramatyczne: atak rekina, zamach terrorystyczny itp. Istnienie heurystyki dostępności zostało eksperymentalnie potwierdzone i zinterpretowane w poniższych badaniach: Jednej grupie studentów pokazano listę nazwisk składającą się z 19 nazwisk sławnych mężczyzn (na przykład Woody Allen, George W. Bush, Tony Blair) i z 20 nazwisk mniej sławnych kobiet (Elizabeth Dole, Lara Holmes, Vivien Cosby), a drugiej grupie listę składającą się z 19 nazwisk sławnych kobiet i 20 nazwisk mniej sławnych mężczyzn. Następnie zasłonięto nazwiska i poproszono o wypisanie zapamiętanych nazwisk. Tylko 15% osób badanych wypisało więcej nazwisk mniej znanych osób. W innym wariancie tego badania proszono o oszacowanie ilości kobiet i mężczyzn znajdujących się na liście. Ponad 80% badanych wskazało na tę płeć, do której dopasowano sławniejsze postaci pomimo, że było ich na liście mniej.

Pięciu różnym grupom pokazano jedną z liter angielskiego alfabetu (K, L, N, R lub V) i poproszono osoby badane o oszacowanie, czy w języku angielskim jest więcej słów, które zaczynają się na daną literę, czy też więcej słów jest takich, w których występuje ona na trzecim miejscu (polski przykład dla litery K: Kolano i za. Kupy). Ponad 70% badanych stwierdziło, że więcej jest takich słów, gdzie te litery występują na początku, a w rzeczywistości słów, w których te litery występują na trzecim miejscu jest prawie dwa razy więcej. Wyniki obu eksperymentów pokazały, że osoby badane kierują się w swoich sądach dostępnością danych w umyśle. Łatwiej jest zauważyć, a potem sobie przypomnieć znane nazwiska, niż te mniej znane (pojawiają się często w TV, radiu, gazetach, mamy do nich lepszy dostęp). Podobnie łatwiej przypomnieć sobie słowa zaczynające się na jakąś literę, niż takie, w których dana litera jest na którymś miejscu w słowie. Występowanie niektórych błędów poznawczych tłumaczone jest przez aktywizację w umyśle heurystyki dostępności. Te błędy to: Błąd konfirmacji polegający na preferowaniu informacji, które potwierdzają wcześniejsze oczekiwania i hipotezy, niezależnie od tego, czy te informacje są prawdziwe.

Efekt pewności wstecznej, czyli tendencja do oceniania przeszłych wydarzeń jako bardziej przewidywalnych niż rzeczywiście były. Efekt subaddytywności polegający na ocenianiu prawdopodobieństwa całości jako mniejszego, niż prawdopodobieństwo poszczególnych części. Efekt świeżości polegający na silniejszym oddziaływaniu informacji, które nadeszły jako ostatnie (najświeższych), niż tych, które pojawiły się wcześniej. Egocentryzm atrybucyjny polegający na skłonności do przypisywania sobie większej odpowiedzialności za konsekwencje wspólnie wykonywanej pracy, niż skłonny jest to uznać postronny obserwator. Zależność magiczna – termin z zakresu teorii warunkowania sprawczego oznaczający taką relację między reakcją (zachowaniem) a wzmocnieniem (nagrodą), która nie istnieje w rzeczywistości, ale istnieje w przekonaniu organizmu (w języku potocznym używane zamiennie z pojęciem „zabobon”, „przesąd”)

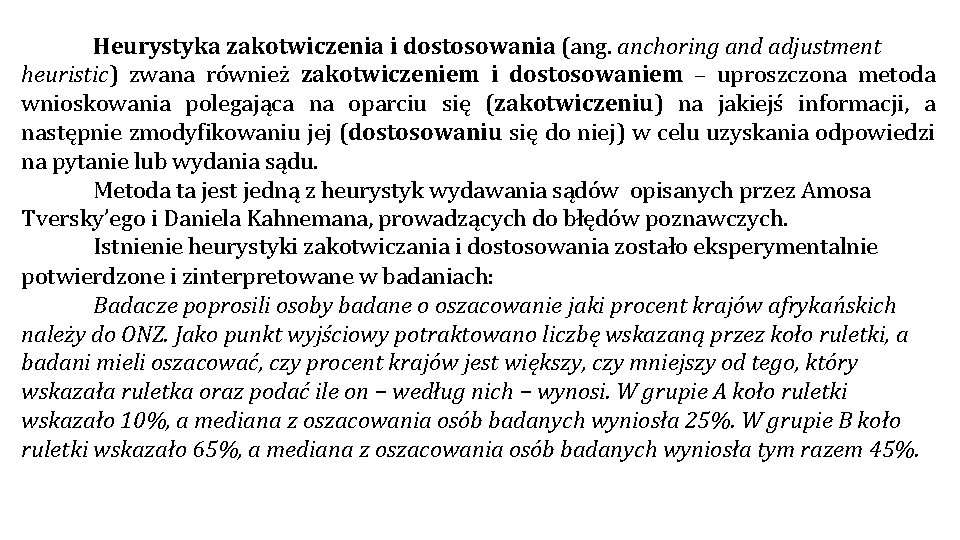

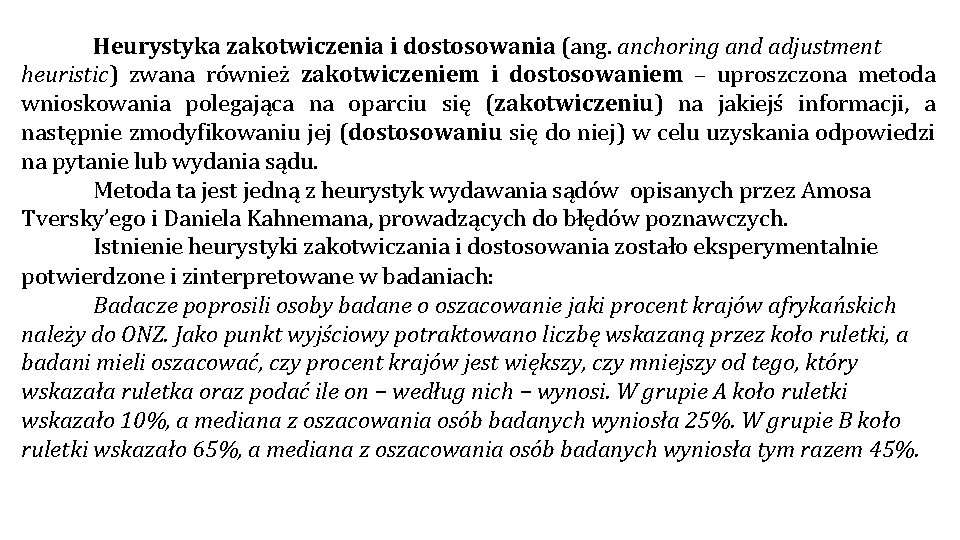

Heurystyka zakotwiczenia i dostosowania (ang. anchoring and adjustment heuristic) zwana również zakotwiczeniem i dostosowaniem – uproszczona metoda wnioskowania polegająca na oparciu się (zakotwiczeniu) na jakiejś informacji, a następnie zmodyfikowaniu jej (dostosowaniu się do niej) w celu uzyskania odpowiedzi na pytanie lub wydania sądu. Metoda ta jest jedną z heurystyk wydawania sądów opisanych przez Amosa Tversky’ego i Daniela Kahnemana, prowadzących do błędów poznawczych. Istnienie heurystyki zakotwiczania i dostosowania zostało eksperymentalnie potwierdzone i zinterpretowane w badaniach: Badacze poprosili osoby badane o oszacowanie jaki procent krajów afrykańskich należy do ONZ. Jako punkt wyjściowy potraktowano liczbę wskazaną przez koło ruletki, a badani mieli oszacować, czy procent krajów jest większy, czy mniejszy od tego, który wskazała ruletka oraz podać ile on − według nich − wynosi. W grupie A koło ruletki wskazało 10%, a mediana z oszacowania osób badanych wyniosła 25%. W grupie B koło ruletki wskazało 65%, a mediana z oszacowania osób badanych wyniosła tym razem 45%.

Uczniowie szkoły średniej mieli za zadanie oszacować w ciągu 5 sekund wynik mnożenia kolejnych rosnących lub malejących liczb. Grupie A pokazano rosnącą sekwencję: 1 × 2 × 3 × 4 × 5 × 6 × 7 × 8. Mediana dla grupy wyniosła 512. Grupie B pokazano malejącą sekwencję: 8 × 7 × 6 × 5 × 4 × 3 × 2 × 1. Mediana dla tej grupy wyniosła 2250. Prawdziwa wartość mnożenia to 40320. Wyniki obu eksperymentów pokazały, że osoby badane zakotwiczyły się na podanej informacji i do niej właśnie dostosowały swoją odpowiedź. Badacze zwracają szczególny fakt na to, że dostosowanie (czyli zmodyfikowanie pierwotnej informacji) było niewystarczające i to właśnie jest przyczyną tego, że używanie tej heurystyki prowadzi do błędów poznawczych. Występowanie niektórych błędów poznawczych tłumaczone jest przez aktywizację w umyśle heurystyki zakotwiczenia i dostosowania. Te błędy to: Efekt pierwszeństwa - polegający na tym, że pierwsza informacja stanowi punkt odniesienia (zakotwiczenia) dla kolejnych informacji, jakie do nas docierają. Efekt halo - zwany również efektem aureoli, czyli tendencja do automatycznego, pozytywnego lub negatywnego przypisywania cech osobowościowych na podstawie pozytywnego lub negatywnego pierwszego wrażenia.

Efekt skupienia polegający na przywiązywaniu zbyt dużej wagi do jednego szczegółu, co zaburza racjonalną ocenę użyteczności rozważanego rozwiązania. Ignorowanie prawdopodobieństwa - polegające na podejmowaniu decyzji bez brania w ogóle pod uwagę prawdopodobieństwa potencjalnych zdarzeń. Zaniedbywanie miarodajności - polegające na podejmowaniu decyzji w oparciu o dane nieistotne i pomijaniu danych, które są istotne – w szczególności, gdy dane statystyczne na temat miarodajności tych danych są dostępne. Norman Anderson skrytykował powierzchowność heurystyk zaproponowanych przez Kahnemana i Tversky'ego i zaproponował własne wytłumaczenie tego fenomenu bazując na swojej Teorii Integracji Informacji (ang. Information Integration Theory). Twierdzi on, że bardzo duże znaczenie w procesie zakotwiczenia ma zarówno efekt pierwszeństwa jak i efekt świeżości, a to, który z tych efektów wpłynie mocniej na sądy konkretnej osoby jest uzależnione od wagi, jaką dana osoba przykłada do poszczególnych informacji. Punkt zakotwiczenia zależy od pierwszej informacji i w zależności od tego, czy nadamy jej dużą wagę (ważność) oraz wartość (przekonanie o prawdziwości), to albo ulegniemy efektowi zakotwiczenia, albo nie. Jeżeli wartość pierwszej wiadomości będzie mała (na przykład wiemy, że nie pochodzi ona z wiarygodnego źródła) i dodatkowo nadamy jej niską wagę (będziemy uważali ją za mało istotną) to nie włączy się heurystyka zakotwiczenia i dostosowania. Wiele wyników badań pokazuje jednak, że nawet kiedy wiadomo, iż informacja pierwsza jest nieprawdziwa, to i tak uaktywnia się proces zakotwiczania

Heurystyka reprezentatywności (ang. representativeness heuristic) – uproszczona metoda wnioskowania polegająca na dokonywaniu klasyfikacji na podstawie częściowego podobieństwa do przypadku typowego, charakterystycznego, reprezentatywnego, który już znamy. Metoda ta jest jedną z heurystyk wydawania sądów opisanych przez Amosa Tversky’ego i Daniela Kahnemana, prowadzących do błędów poznawczych. Istnienie heurystyki reprezentatywności zostało eksperymentalnie potwierdzone i zinterpretowane w badaniach: Osoby badane poinformowano, że psychologowie sporządzili krótkie charakterystyki członków dużej grupy, w której było siedemdziesięciu inżynierów i trzydziestu prawników. Następnie badani dostali przykład takiej charakterystyki: "John jest trzydziestoletnim, żonatym mężczyzną z dwójką dzieci. Działa aktywnie w lokalnych organizacjach politycznych. Jego hobby to kolekcjonowanie książkowych "białych kruków". Jest elokwentny, przekonywający i nastawiony rywalizacyjnie. " Jakie jest prawdopodobieństwo, że John jest raczej prawnikiem, niż inżynierem? Odpowiedzi osób badanych oscylowały pomiędzy 50% a 80%. Wyniki eksperymentu pokazały, że osoby badane ignorują prawidłowości statystyczne (proporcje inżynierów i prawników) i w swoich sądach kierują się heurystyką reprezentatywności, sugerując się opisem Johna, który jest bardziej reprezentatywny dla prawnika, niż dla inżyniera. Prawdziwe prawdopodobieństwo wynosi przecież 30%.

Kolejne badanie zawierało opis, który w założeniu miał być neutralny i nie wskazywać ani na prawnika, ani na inżyniera. W jednej grupie powiedziano, że psychologowie badali grupę składającą się z siedemdziesięciu inżynierów i trzydziestu prawników, a w drugiej, że proporcje były odwrotne. Badani dostali następujący opis mężczyzny: "Dick jest trzydziestoletnim, żonatym mężczyzną o dużych możliwościach i wysokiej motywacji, które dają mu szanse na osiągnięcie sukcesu w swojej dziedzinie. Jest lubiany przez swoich kolegów. " Jakie jest prawdopodobieństwo, że John jest raczej prawnikiem, niż inżynierem? Mediana z odpowiedzi osób badanych w obu grupach wynosiła około 50%. Prawidłowe wyniki (30% lub 70%) uzyskano jedynie w kolejnym, trzecim badaniu, w którym nie podano żadnego opisu. Wyniki tych trzech eksperymentów pokazały, że osoby badane ignorują prawidłowości statystyczne, o ile mają dodatkową informację, która aktywizuje heurystykę reprezentatywności. Istotny tutaj jest fakt, że informacja wpływająca na sądy może być zarówno specyficzna (wskazywać na konkretny zawód), jak i niespecyficzna (neutralny opis)

Występowanie niektórych błędów poznawczych tłumaczonych jest przez aktywizację w umyśle heurystyki reprezentatywności. Te błędy to: • Błąd koniunkcji - polegający na ocenie koniunkcji zdarzeń jako bardziej prawdopodobnej, niż pojedynczych zdarzeń należących do tej koniunkcji. • Błąd alternatywy − będący odwrotnością błędu koniunkcji − polegający na niedocenianiu prawdopodobieństwa alternatywy zdarzeń w stosunku do pojedynczych zdarzeń tej alternatywy. • Paradoks hazardzisty - czyli złudzenie gracza polegające na traktowaniu niezależnych od siebie zdarzeń losowych jako zdarzeń zależnych. • Odwrotny paradoks hazardzisty - polegający na przekonaniu, że pewne bardzo nieprawdopodobne zdarzenie wymaga uprzednio bardzo dużej liczby prób

Wskazówki heurystyczne Jest to grupa sentencji, powiedzeń, „złotych myśli”, które są użyteczne w większości metod heurystycznych. Ułatwiają one aktywizowanie procesu tworzenia i zwiększają jego efektywność. Przykładowe wskazówki to: „myśl twórczo”, „bierz pod uwagę zdanie innych”, „prowadź badania w sposób zorganizowany”, „nigdy nie odkładaj tego, co można zrobić teraz”, „jeśli nie możesz znaleźć rozwiązania, zmień reguły”, „jeśli nie możesz czegoś zrobić, nie ma po co się tym martwić”. „wykorzystuj kombinacje prognoz od statystycznych, poprzez ekonometryczne po eksperckie” „podejmuj działania maksymalizujące zbiór informacji”

CECHY SYSTEMÓW EKSPERCKICH (WG. ARMSTRONGA) Konstruując system ekspercki należy zwrócić szczególną uwagę na trzy zagadnienia: - zdobycie niezbędnej wiedzy pytaj eksperta o zasady jakie stosuje w dojściu do rozwiązania problemu, wykorzystaj wiedzę zawartą w podobnych badaniach opisaną w literaturze, wykorzystaj różne źródła wiedzy, - ustrukturalizowanie i wykorzystanie wiedzy staraj się jak najbardziej uprościć strukturę systemu staraj się aby struktura była kompletna wyjaśnij wszystkie źródła wiedzy wykorzystane w systemie eksperci powinni wyjaśnić dlaczego dali poszczególne rekomendacje - testowanie otrzymanego systemu ponieważ system ekspercki jest kosztowny powinien być wykorzystywany dla wielu prognoz analizowany system jest słabo strukturalizowany dane historyczne o systemie są niedostępne albo niepewne możliwa jest współpraca ekspertów

Błędy poznawcze i ich charakterystyka Błąd poznawczy (ang. cognitive bias) to ogólne określenie nieracjonalnego sposobu postrzegania rzeczywistości. Poniższa lista przedstawia najpowszechniejsze takie błędy zidentyfikowane u ludzi. Faktycznie u każdego człowieka można zaobserwować większość z nich. Wpływają one na sposób formułowania poglądów, , podejmowania decyzji biznesowych i prowadzenia badań naukowych. Większość z nich jest szkodliwa, niektóre mogą prowadzić do katastrofalnych skutków (jak efekt pominięcia). Tylko niektóre z nich pozwalają w pewnych sytuacjach szybciej podejmować decyzje (jak efekt kongruencji czy efekt skupienia). Przyczyną pojawiania się takich błędów są często ograniczone zasoby poznawcze, brak czasu lub motywacji do formułowania poprawnych sądów oraz pragnienie zachowania dobrego samopoczucia.

BŁĘDY WYSTEPUJĄCE PRZY PODEJMOWANIU DECYZJI I NIEODPOWIEDNIM ZACHOWANIU Efekt autorytetu – poleganie wyłącznie na autorytecie. Efekt czystej ekspozycji – wytworzenie pozytywnej opinii czy oceny obiektu pod wpływem samego zwiększenia liczby kontaktów z tym obiektem. Efekt izolacji – tendencja do lepszego zapamiętywania obiektów, które w jakiś sposób wyróżniają się ze środowiska. Efekt kontrastu – subiektywne zwiększenie lub zmniejszenie obserwowanych cech obiektu w zależności od porównania z wcześniej obserwowanym obiektem. Efekt niepotrzebnych informacji – tendencja do zbierania dodatkowych informacji nawet wtedy, gdy nie mogą one mieć wpływu na podejmowaną decyzję. Efekt Pollyanny – tendencja do myślenia o rzeczach przyjemnych i poszukiwania pozytywnych aspektów w każdej sytuacji, przy jednoczesnym ignorowaniu aspektów przykrych lub nieprzyjemnych Efekt pominięcia – tendencja do oceniania szkodliwych działań jako gorsze i bardziej niemoralne niż równie szkodliwy brak działania i bezczynność. Efekt posiadania – tendencja do oceniania posiadanych rzeczy jako bardziej wartościowe niż identyczne nieposiadane. Efekt potwierdzenia – (nazywany też efektem potwierdzania) tendencja do poszukiwania wyłącznie faktów potwierdzających posiadaną opinię, a nie weryfikujących ją.

![Efekt przywiązania korzystanie ze zbyt mało różnorodnych źródeł informacji 1 Efekt pseudopewności Efekt przywiązania – korzystanie ze zbyt mało różnorodnych źródeł informacji [1]. Efekt pseudopewności –](https://slidetodoc.com/presentation_image/3f86f5a8934a78a36a5f9536f8a93c8f/image-45.jpg)

Efekt przywiązania – korzystanie ze zbyt mało różnorodnych źródeł informacji [1]. Efekt pseudopewności – tendencja do unikania ryzyka przy dążeniu do pozytywnych rezultatów, a szukania ryzyka przy dążeniu do uniknięcia analogicznych negatywnych rezultatów. Efekt skupienia – błąd w ocenie wynikający ze zwracania nadmiernej uwagi na jeden aspekt i ignorowania innych aspektów. Efekt statusu quo – tendencja do akceptowania rzeczy takich, jakimi aktualnie są. Efekt ślepej plamki – tendencja do niezauważania błędów we własnej ocenie rzeczywistości. Efekt wspierania decyzji – tendencja do lepszego pamiętania argumentów przemawiających za podjętą już decyzją niż przeciwko niej. Efekt wyniku – tendencja do oceniania decyzji na podstawie znanych później ich rezultatów, zamiast na podstawie informacji znanych w momencie podejmowania tych decyzji. Efekt wyświadczonej przysługi - tendencja do zmiany postawy na bardziej przyjazną w stosunku do osób, dla których z własnej woli zrobiło się coś dobrego. Efekt wiarygodności – ocenianie wiarygodność argumentów na podstawie zgodności wniosków z wcześniejszymi założeniami[1]. Efekt zaprzeczania – tendencja do krytycznego weryfikowania informacji, które zaprzeczają dotychczasowym opiniom, przy jednoczesnym bezkrytycznym akceptowaniu informacji, które je potwierdzają.

Efekt zerowego ryzyka – ocenianie redukcji ryzyka do zera jako bardziej wartościowej, niż wynikałoby to z wyceny samego ryzyka. Hiperboliczne obniżenie wartości – tendencja do przedkładania wcześniejszych zysków nad późniejsze tym silniej, im oba zyski są bliżej obecnej chwili. Ignorowanie prawdopodobieństwa – tendencja do ignorowania zasad rachunku prawdopodobieństwa przy podejmowaniu decyzji w niepewnych sytuacjach. Iluzja wstrząsu – tendencja do przeceniania długości lub intensywności swoich przyszłych stanów emocjonalnych. Niechęć do straty – tendencja do przykładania większego wysiłku do unikania strat niż do uzyskiwania analogicznych zysków. Racjonalizacja zakupu – tendencja do przekonywania post-factum samych siebie o wartości dokonanego zakupu. Selektywna percepcja – tendencja do zaburzania percepcji przez oczekiwania. Skrzywienie zawodowe – tendencja do oceniania rzeczy z punktu widzenia swojej profesji, z ignorowaniem szerszego punktu widzenia. Zasada podczepienia – tendencja do robienia czegoś (i wierzenia w coś) dlatego tylko, że wiele osób tak robi. Powiązany z zachowaniem stadnym i modą. Złudzenie kontroli – przekonanie o możliwości wpływania na sytuacje, na które w rzeczywistości żadnego wpływu się nie ma. Złudzenie planowania – tendencja do niedoceniania kosztów i czasu wykonania przyszłego zadania

Błędy w przekonaniach i ocenie prawdopodobieństwa • Błąd koniunkcji – tendencja do przypisywania bardziej szczegółowym warunkom większego prawdopodobieństwa niż bardziej ogólnym. • Efekt antropiczny – tendencja do niezauważania wpływu sposobu obserwacji na jej wyniki statystyczne. • Efekt nadrzędności przekonań – tendencja do podporządkowywania swoich opinii na różne tematy jednej konkluzji, tak aby nie zachodziły między nimi dylematy. • Efekt obserwatora – nieświadome zaburzanie wyników eksperymentu przez naukowca oczekującego jakiegoś wyniku. • Efekt pewności wstecznej – nazywany efektem "wiedziałem-że-tak-będzie"; ocenianie przeszłych wydarzeń jako bardziej przewidywalnych niż rzeczywiście były. • Efekt polaryzacji – możliwość użycia tych samych (neutralnych) faktów do umocnienia zarówno pozytywnej, jak i negatywnej opinii na jakiś temat. • Efekt przekonania – ocenianie poprawności argumentacji na podstawie zgodności konkluzji z własnymi opiniami, zamiast na podstawie faktycznej logiczności argumentów. • Efekt skupienia uwagi – ignorowanie potrzeby zebrania miarodajnych danych przy badaniu występowania korelacji i powiązań. • Efekt subaddytywności – tendencja do szacowania prawdopodobieństwa całości jako niższego niż prawdopodobieństwo poszczególnych części.

• Heurystyka dostępności – tendencja do przypisywania większego prawdopodobieństwa zdarzeniom które wiążą się z większymi emocjami. • Heurystyka zakotwiczenia – tendencja do sugerowania się podanymi informacjami, nawet jeśli wiemy że nie mają one żadnego związku z rozważanym zagadnieniem. • Iluzja grupowania – tendencja do zauważania wzorców lub korelacji tam, gdzie w rzeczywistości ich nie ma. • Paradoks hazardzisty – zakładanie, że prawdopodobieństwo losowych zdarzeń zależy od poprzednich losowych zdarzeń ("rzucana moneta ma pamięć"). • Pozytywna retrospekcja – tendencja do oceniania przeszłych zdarzeń lepiej, niż się je oceniało, gdy zachodziły (zobacz: autowaloryzacja). • Zaniedbywanie miarodajności – tendencja do dokonywania oceny na podstawie danych, o których wiadomo, że nie mają znaczenia statystycznego. • Zasada szczyt-koniec – tendencja do oceniania doświadczeń wyłącznie na podstawie ich najsilniejszego bodźca (pozytywnego lub negatywnego) oraz efektu końcowego, z ignorowaniem intensywności i liczby pozostałych bodźców.

• BŁĘDY SPOWODOANE ULEGANIU STEREOTYPOM SPOŁECZNYM • Błąd przypisania cech – tendencja do oceniania własnej osobowości, zachowania i humorów jako bardziej zmiennych i mniej przewidywalnych niż u innych. • Efekt grupy – lepsze traktowanie ludzi, którzy przynależą do tej samej grupy co my. • Efekt aureoli – tendencja do wpływania oceny jednej cechy osoby (np. urody) na ocenę innych jej cech (np. kompetencji) • Efekt horoskopowy – tendencja do oceniania jako precyzyjne opisów osób/zdarzeń, które w rzeczywistości są wystarczająco ogólne, żeby odnosić się do wielu osób/zdarzeń. • Złudzenie ponadprzeciętności – tendencja do zakładania przy dowolnej ocenie, że samemu jest się powyżej średniej. • Efekt projekcji – tendencja do zakładania większego poparcia dla własnych poglądów i wyznawanych wartości niż faktycznie występuje. • Egocentryzm – przypisywanie przy wspólnym osiągnięciu sobie większych zasług niż wynikałoby z obiektywnej oceny sytuacji. • Fenomen sprawiedliwego świata – twierdzenie, że świat jest w jakiś sposób sprawiedliwy i ludzie dostają to na co zasłużyli.

• Iluzja asymetrycznego wglądu – tendencja do oceniania własnej wiedzy na temat innych jako głębszą i bardziej dokładną niż wiedza innych o nas. • Iluzja przejrzystości - tendencja ludzi do uważania, że ich stan psychiczny jest widoczny dla innych w większym stopniu niż w rzeczywistości. • Podstawowy błąd atrybucji – tendencja do tłumaczenia sukcesów i porażek innych ludzi wyłącznie ich cechami wewnętrznymi (np. charakterem), przy ignorowaniu czynników zewnętrznych (środowiska). • Samospełniające się proroctwo – nieświadome wykonywanie działań, które doprowadzają do efektów wcześniej przez nas przewidywanych. • Tendencja samoobronna – tendencja do tłumaczenia własnych porażek wpływem środowiska i tłumaczenia sukcesów swoimi cechami wewnętrznymi. • Zasada homogeniczności zewnętrza – ocenianie członków własnej grupy jako bardziej zróżnicowanych niż członkowie innych grup.

Heurystyczne metody prognozowania

Heurystyczne metody prognozowania Metody oceny stanu zdrowia pacjenta

Metody oceny stanu zdrowia pacjenta Metoda programowanego uczenia się przykłady ćwiczeń

Metoda programowanego uczenia się przykłady ćwiczeń Metody dyscyplinowania uczniów

Metody dyscyplinowania uczniów Diagnostika mš

Diagnostika mš Fizyczne metody spulchniania ciast

Fizyczne metody spulchniania ciast Serologicke metody

Serologicke metody Nowoczesne technologie monitorowania aktywności fizycznej

Nowoczesne technologie monitorowania aktywności fizycznej Haki pamięciowe

Haki pamięciowe Vyukove metody

Vyukove metody Metody zarządzania ryzykiem walutowym w przedsiębiorstwie

Metody zarządzania ryzykiem walutowym w przedsiębiorstwie Długość toru transmisyjnego

Długość toru transmisyjnego Jaké metody používáme k odchytu vodních živočichů

Jaké metody používáme k odchytu vodních živočichů Metody spektroskopowe

Metody spektroskopowe Sformuować

Sformuować Metody optyczne

Metody optyczne Jak radzić sobie ze stresem

Jak radzić sobie ze stresem Pirometr fotoelektryczny

Pirometr fotoelektryczny Czynności wykonywane z prawej i lewej strony konsumenta

Czynności wykonywane z prawej i lewej strony konsumenta Metody historyczne

Metody historyczne Dyscyplina w klasie

Dyscyplina w klasie Marzenna czarnocka

Marzenna czarnocka Biologiczne utrwalanie żywności

Biologiczne utrwalanie żywności Trzy metody otrzymywania soli

Trzy metody otrzymywania soli Metody doboru pracowników

Metody doboru pracowników Otrzymywanie soli zadania

Otrzymywanie soli zadania Metody aktywizujące przykłady

Metody aktywizujące przykłady Pedagogická diagnostika vzor

Pedagogická diagnostika vzor Metoda średnich podokresów

Metoda średnich podokresów Metody planowania zatrudnienia

Metody planowania zatrudnienia Metody utrwalania żywności

Metody utrwalania żywności Metody szybkiego uczenia się

Metody szybkiego uczenia się Dywanik pomysłów - metoda aktywizująca

Dywanik pomysłów - metoda aktywizująca Metody, techniki i narzędzia badawcze

Metody, techniki i narzędzia badawcze Metody numeryczne

Metody numeryczne Nieprobabilistyczny

Nieprobabilistyczny Metody aktywizujące przykłady

Metody aktywizujące przykłady Spektrofotometr dwuwiązkowy schemat

Spektrofotometr dwuwiązkowy schemat Planowanie zasobów dystrybucji

Planowanie zasobów dystrybucji Metody szacowania ryzyka

Metody szacowania ryzyka Tensometryczne metody pomiaru naprężeń

Tensometryczne metody pomiaru naprężeń Graficzne metody prezentacji danych

Graficzne metody prezentacji danych Stozek dale'a

Stozek dale'a Metoda nauczania

Metoda nauczania Planowanie mrp

Planowanie mrp Metódy nácviku čítania

Metódy nácviku čítania Metody weryfikacji części

Metody weryfikacji części Fotografia dnia pracy

Fotografia dnia pracy Metody rozdzielcze

Metody rozdzielcze Nefelometria i turbidymetria

Nefelometria i turbidymetria Metoda fonetyczno-literowo-barwna

Metoda fonetyczno-literowo-barwna