DATA REDUCTION DIMENSIONS OF LARGE DATA SETS Pemilihan

![K=1 K=2 ∑ Interval [7. 5, 8. 5] A 11 = 1 A 12 K=1 K=2 ∑ Interval [7. 5, 8. 5] A 11 = 1 A 12](https://slidetodoc.com/presentation_image/3bca58a57055456e92da7a40539af44d/image-36.jpg)

![K=1 K=2 ∑ Interval [0, 7. 5] A 11 = 2 A 12 = K=1 K=2 ∑ Interval [0, 7. 5] A 11 = 2 A 12 =](https://slidetodoc.com/presentation_image/3bca58a57055456e92da7a40539af44d/image-37.jpg)

![K=1 K=2 ∑ Interval [0, 10. 0] A 11 = 4 A 12 = K=1 K=2 ∑ Interval [0, 10. 0] A 11 = 4 A 12 =](https://slidetodoc.com/presentation_image/3bca58a57055456e92da7a40539af44d/image-38.jpg)

- Slides: 38

DATA REDUCTION

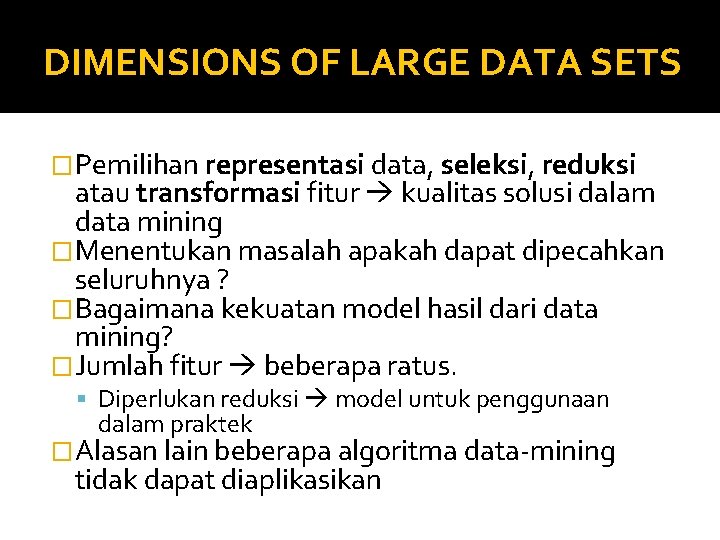

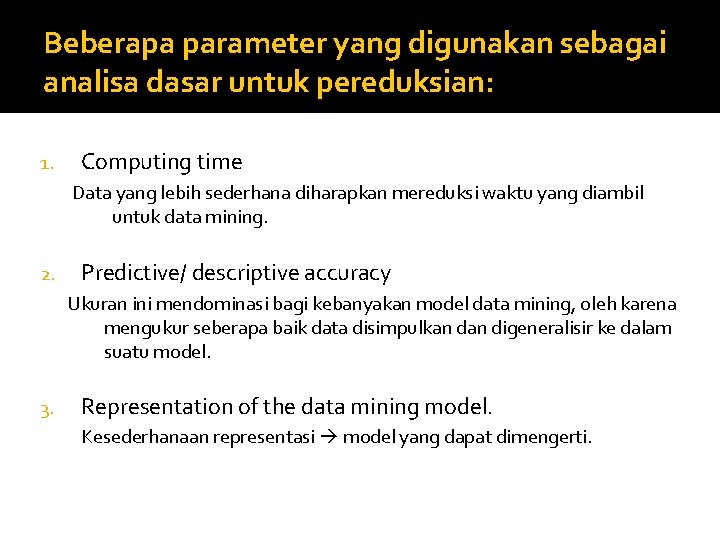

DIMENSIONS OF LARGE DATA SETS �Pemilihan representasi data, seleksi, reduksi atau transformasi fitur kualitas solusi dalam data mining �Menentukan masalah apakah dapat dipecahkan seluruhnya ? �Bagaimana kekuatan model hasil dari data mining? �Jumlah fitur beberapa ratus. Diperlukan reduksi model untuk penggunaan dalam praktek �Alasan lain beberapa algoritma data-mining tidak dapat diaplikasikan

� Tiga dimensi utama dari data set (plain files): Kolom (fitur) Baris (kasus/ contoh) Nilai fitur � Tiga operasi dasar dari proses reduksi data: Delete kolom, Delete baris Pengurangan jumlah nilai kolom (penghalusan suatu fitur).

� Operasi lain: mereduksi tetapi data baru tidak dikenali lagi. � Pendekatan yang digunakan menggantikan sekumpulan fitur awal dengan fitur campuran yg baru. Sebagai contoh, data set mempunyai dua fitur, tinggi-orang dan berat -orang diganti hanya satu fitur, BMI (body-mass-index), merupakan proporsi hasil bagi dari dua fitur awal.

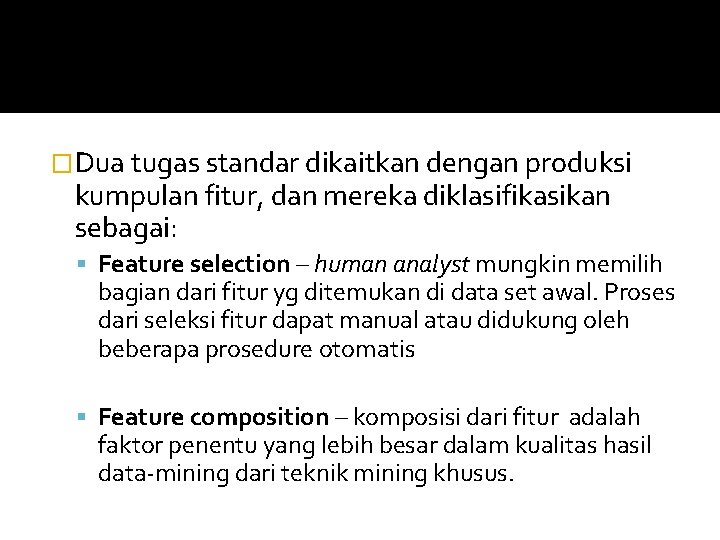

Beberapa parameter yang digunakan sebagai analisa dasar untuk pereduksian: 1. Computing time Data yang lebih sederhana diharapkan mereduksi waktu yang diambil untuk data mining. 2. Predictive/ descriptive accuracy Ukuran ini mendominasi bagi kebanyakan model data mining, oleh karena mengukur seberapa baik data disimpulkan digeneralisir ke dalam suatu model. 3. Representation of the data mining model. Kesederhanaan representasi model yang dapat dimengerti.

� Hal yang ideal adalah jika dapat mereduksi waktu, meningkatkan akurasi dan representasi sederhana pada waktu yg sama, menggunakan reduksi dimensi. Namun tidak ada metode reduksi data yg tunggal dapat paling cocok untuk semua aplikasi. � Pemilihan metode seleksi didasarkan atas pengetahuan yg ada tentang suatu aplikasi (relevansi data, noise data, meta-data, fitur yg berhubungan), dan constraint waktu yg diminta untuk solusi akhir.

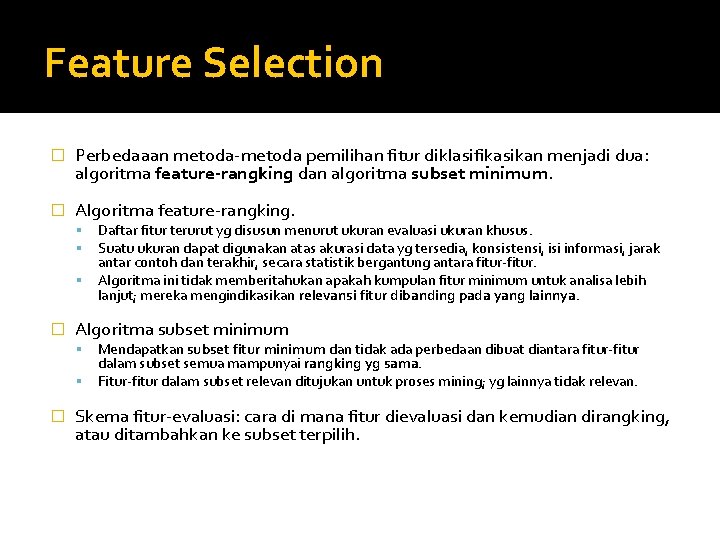

Feature Reduction Pada dasarnya, kita memilih fitur yg relevan pada aplikasi data-mining agar supaya mencapai hasil yang maksimum dengan ukuran dan usaha pemrosesan minimum. Suatu proses reduksi fitur harus menghasilkan: 1. Data yang lebih kecil sehingga algoritma data-mining dapat mempelajari lebih cepat 2. Akurasi dari proses data-mining lebih tinggi sehingga model dapat mengeneralisasi lebih baik dari data 3. Hasil sederhana dari proses data-mining sehingga mereka lebih mudah untuk mengerti dan menggunakan 4. Fitur lebih kecil sehingga rentetan berikutnya dari kumpulan data, suatu penghematan dapat dibuat dengan menghilangkan redundansi atau fitur yang tidak relevan

�Dua tugas standar dikaitkan dengan produksi kumpulan fitur, dan mereka diklasifikasikan sebagai: Feature selection – human analyst mungkin memilih bagian dari fitur yg ditemukan di data set awal. Proses dari seleksi fitur dapat manual atau didukung oleh beberapa prosedure otomatis Feature composition – komposisi dari fitur adalah faktor penentu yang lebih besar dalam kualitas hasil data-mining dari teknik mining khusus.

Feature Selection � Perbedaaan metoda-metoda pemilihan fitur diklasifikasikan menjadi dua: algoritma feature-rangking dan algoritma subset minimum. � Algoritma feature-rangking. � Algoritma subset minimum � Daftar fitur terurut yg disusun menurut ukuran evaluasi ukuran khusus. Suatu ukuran dapat digunakan atas akurasi data yg tersedia, konsistensi, isi informasi, jarak antar contoh dan terakhir, secara statistik bergantung antara fitur-fitur. Algoritma ini tidak memberitahukan apakah kumpulan fitur minimum untuk analisa lebih lanjut; mereka mengindikasikan relevansi fitur dibanding pada yang lainnya. Mendapatkan subset fitur minimum dan tidak ada perbedaan dibuat diantara fitur-fitur dalam subset semua mampunyai rangking yg sama. Fitur-fitur dalam subset relevan ditujukan untuk proses mining; yg lainnya tidak relevan. Skema fitur-evaluasi: cara di mana fitur dievaluasi dan kemudian dirangking, atau ditambahkan ke subset terpilih.

� Seleksi fitur secara umum dapat digambarkan sebagai masalah pencarian, dengan setiap state di area pencarian khusus subset dari fitur yg mungkin. Jika, suatu data set mempunyai 3 fitur {A 1, A 2, A 3}, dan proses seleksi fitur -fitur, keberadaan fitur dikodekan 1 dan keabsenannya dengan 0, sehingga ada 23 subset reduksi fitur dikodekan dengan {0, 0, 0}, {1, 0, 0}, { 0, 1, 0}, {0, 0, 1}, {1, 1, 0}, {1, 0, 1}, {0, 1, 1}, dan {1, 1, 1}. � Masalah seleksi fitur adalah relatif sepeleh jika ruang pencarian kecil, oleh karena kita dapat menganalisa seluruh subset dibeberapa perintah dan suatu pencarian akan lengkap dalam waktu singkat. � Namun pencarian biasanya 2 N di mana jumlah dimensi N di aplikasi datamining adalah besar (N>20). Exhaustive search dari seluruh subset fitur sering digantikan dengan prosedur heuristic search. Penggunaan pengetahuan masalah, prosedur-prosedur ini menemukan subset fitur yang memperbaiki lebih lanjut meningkatkan kualitas proses data mining. � Tujuan seleksi fitur adalah menemukan subset fitur dengan performa data mining dapat dibandingkan pada kumpulan fitur utuh.

� Aplikasi seleksi fitur dan reduksi dimensi data membantu seluruh fase proses data mining untuk penemuan pengetahuan. � Dimulai pada fase preprocessing, meliputi seleksi fitur dan reduksi adalah bagian dari algoritma data-mining, meskipun kadang diaplikasikan di postprocessing untuk evaluasi dan konsulidasi hasil yg dicapai lebih baik.

Entropy Measure for Ranking Features � Suatu metoda untuk seleksi unsupervised fitur atau merangking berdasarkan ukuran entropy adalah teknik yg relatif sederhana � Asumsi dasar adalah semua contoh diberikan sebagai vektor tanpa adanya klasifikasi dari output sample. � Pendekatan didasarkan atas observasi pembuangan fitur yang tidak relevan, fitur redundan, atau keduanya dari kemungkinan yg tidak mengubah karakteristik data set. � Algoritma didasarkan atas ukuran similarity S yang berbanding terbalik dengan jarak D antara dua n-dimensional sample. Ukuran jarak D kecil, dekat dengan contoh, dan yang besar untuk perbedaan pasangan.

, namun sering digunakan konstanta �Ada 2 formula yg dipakai untuk mengukur similarity terhadap fitur: data numerik dan non numerik (kategori). 1. Data numerik: Similarity (S) dimana: e=2. 7183; Namun sering digunakan sebagai konstanta Dan ukuran jarak D didapatkan:

2. Data non-numerik Di mana |xij=xjk| adalah 1 jika xij=xjk, dan sebaliknya 0. Jumlah variable adalah n. Sample F 1 F 2 F 3 R 1 R 2 R 3 R 4 R 5 X Y Y X Z 1 2 2 1 3 A B C Data set dgn 3 fitur kategori R 1 R 2 R 3 R 4 R 5 0/3 2/3 1/3 0/3 0/3 1/3 0/3 Tabel ukuran similarity Sij diantara samples

� Nilai Entropy yang digunakan untuk rangking fitur adalah: � Kedekatan suatu fitur ditunjukan semakin kecilnya perbedaan nilai entropy.

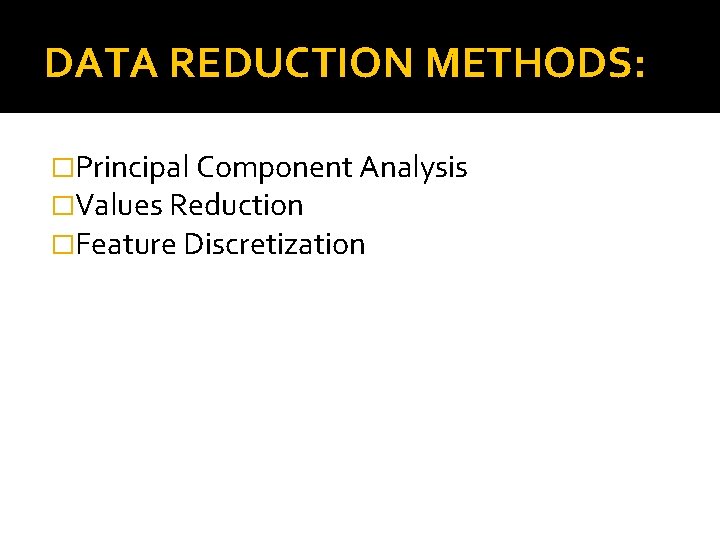

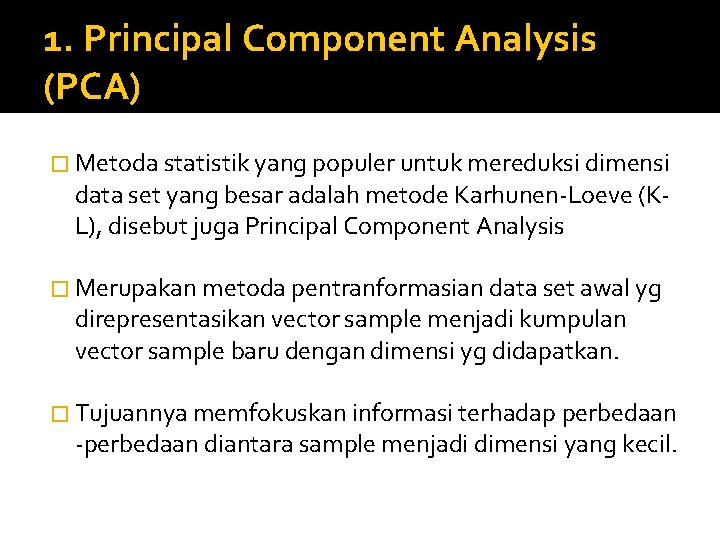

DATA REDUCTION METHODS: �Principal Component Analysis �Values Reduction �Feature Discretization

1. Principal Component Analysis (PCA) � Metoda statistik yang populer untuk mereduksi dimensi data set yang besar adalah metode Karhunen-Loeve (KL), disebut juga Principal Component Analysis � Merupakan metoda pentranformasian data set awal yg direpresentasikan vector sample menjadi kumpulan vector sample baru dengan dimensi yg didapatkan. � Tujuannya memfokuskan informasi terhadap perbedaan -perbedaan diantara sample menjadi dimensi yang kecil.

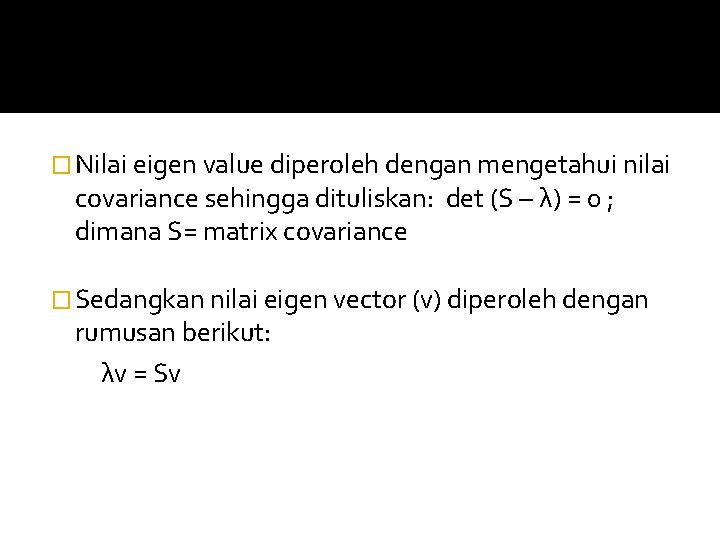

� Ide dasar: sekumpulan vector sampel berdimensi n X={x 1, x 2, x 3, …, xm} ditransformasikan ke himpunan lain Y = {y 1, y 2, y 3, …, ym} dengan dimensi yg sama, tetapi y , memiliki property yg paling informatif isinya disimpan dalam dimensi pertama. � Transformasi didasarkan atas asumsi bahwa informasi yg tinggi berhubungan dengan varian yg tinggi. Sehingga jika mereduksi ke satu dimensi dari matrik X ke matrik Y dapat dituliskan: Y= A ∙ X, pemilihan A sehingga Y mempunyai varian terbesar dari data set yg diberikan. Dimensi tunggal dari Y diperoleh dari transformasi ini disebut first principal component.

� Maka untuk menentukan matrix A, dihitung dahulu covariance matrix S sebagai tahap awal dari transformasi fitur. � Dimana:

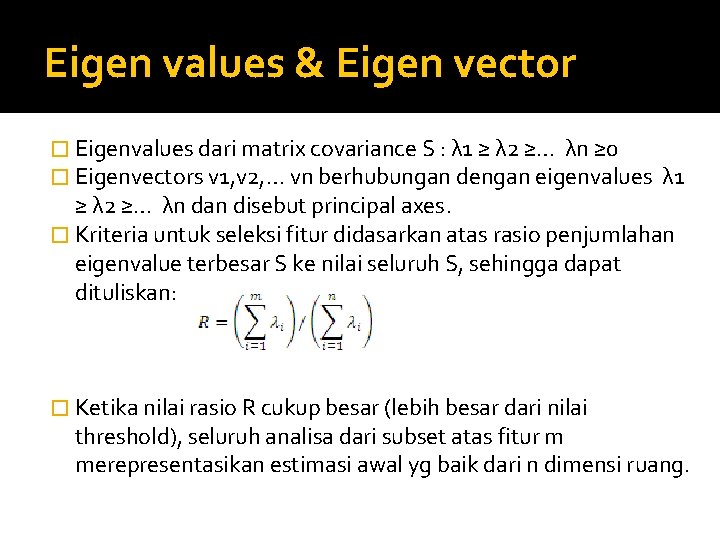

Eigen values & Eigen vector � Eigenvalues dari matrix covariance S : λ 1 ≥ λ 2 ≥… λn ≥ 0 � Eigenvectors v 1, v 2, … vn berhubungan dengan eigenvalues λ 1 ≥ λ 2 ≥… λn dan disebut principal axes. � Kriteria untuk seleksi fitur didasarkan atas rasio penjumlahan eigenvalue terbesar S ke nilai seluruh S, sehingga dapat dituliskan: � Ketika nilai rasio R cukup besar (lebih besar dari nilai threshold), seluruh analisa dari subset atas fitur m merepresentasikan estimasi awal yg baik dari n dimensi ruang.

� Nilai eigen value diperoleh dengan mengetahui nilai covariance sehingga dituliskan: det (S – λ) = 0 ; dimana S= matrix covariance � Sedangkan nilai eigen vector (v) diperoleh dengan rumusan berikut: λv = Sv

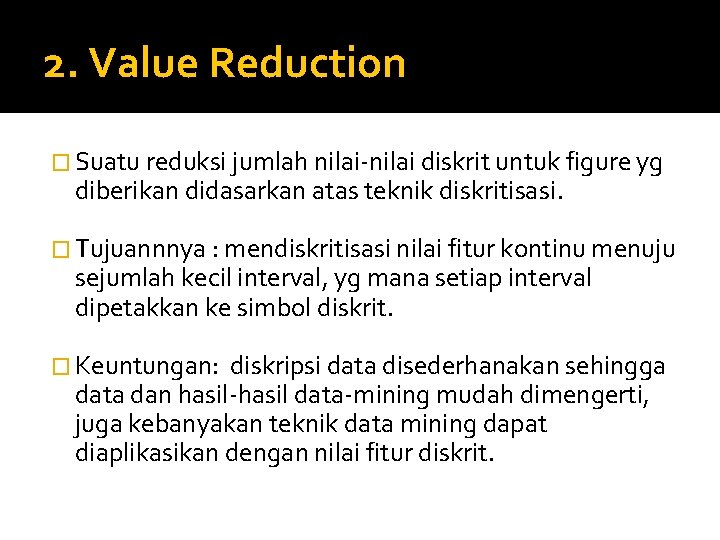

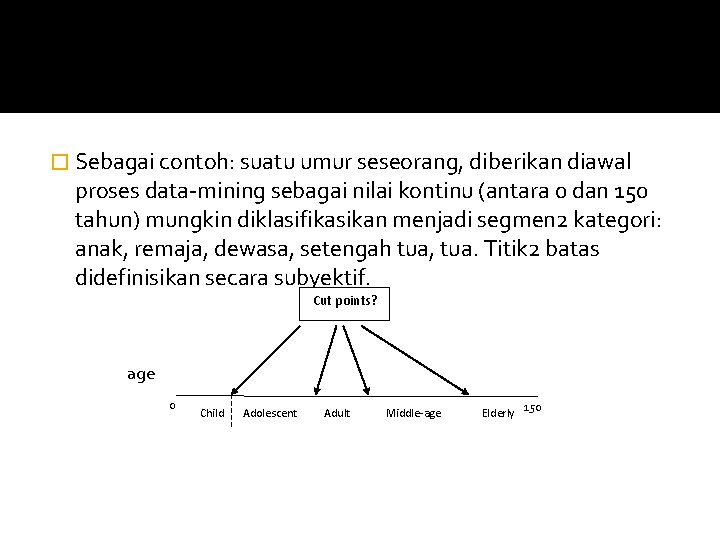

Contoh lain: Covariance Feature 1 Feature 2 Feature 3 Feature 4 Feature 1 1. 0000 1. 1094 0. 8718 0. 8180 Feature 2 − 0. 1094 1. 0000 − 0. 4205 − 0. 3565 Feature 3 0. 8718 − 0. 4205 1. 0000 0. 9628 Feature 4 0. 8180 − 0. 3565 0. 9628 1. 0000 Eigenvalue dari data Feature Eigenvalue Feature 1 2. 91082 Feature 2 0. 92122 Feature 3 0. 14735 Feature 4 0. 02061

� Dengan nilai threshold R*=0. 95, maka dipilih 2 fitur pertama, sebab: R = (2. 91082 + 0. 92199)/(2. 91082 + 0. 92122 + 0. 14735 + 0. 02061) = 0. 958 > 0. 95, sehingga 2 fitur tersebutcukup mendeskripsikan karakteristik data set.

2. Value Reduction � Suatu reduksi jumlah nilai-nilai diskrit untuk figure yg diberikan didasarkan atas teknik diskritisasi. � Tujuannnya : mendiskritisasi nilai fitur kontinu menuju sejumlah kecil interval, yg mana setiap interval dipetakkan ke simbol diskrit. � Keuntungan: diskripsi data disederhanakan sehingga data dan hasil-hasil data-mining mudah dimengerti, juga kebanyakan teknik data mining dapat diaplikasikan dengan nilai fitur diskrit.

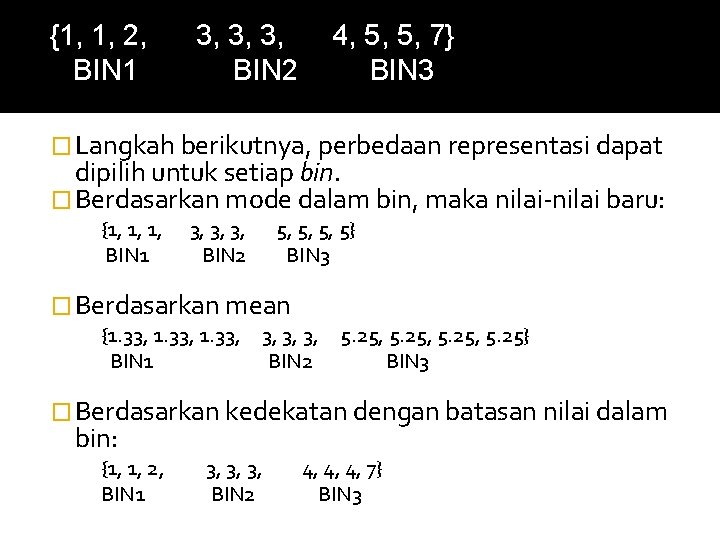

� Sebagai contoh: suatu umur seseorang, diberikan diawal proses data-mining sebagai nilai kontinu (antara 0 dan 150 tahun) mungkin diklasifikasikan menjadi segmen 2 kategori: anak, remaja, dewasa, setengah tua, tua. Titik 2 batas didefinisikan secara subyektif. Cut points? age 0 Child Adolescent Adult Middle-age Elderly 150

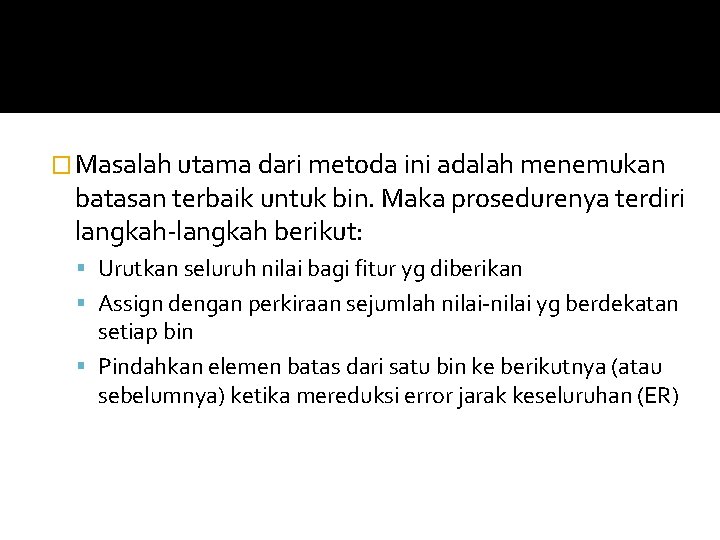

Pengelompokan nilai-nilai fitur � Diberikan suatu fitur mempunyai suatu jarak nilai-nilai numerik, dan nilai-nilai ini dapat diurutkan dari yg terkecil ke yg terbesar. penempatan pembagian nilai-nilai ke dalam kelompok-kelompok dengan nilai-nilai yg dekat. � Seluruh nilai dalam kelompok akan digabung ke konsep tunggal yg direpresentasikan dengan nilai tunggal, biasanya mean atau median dari nilai-nilai tersebut. � Nilai mean/ mode biasanya efektif untuk jumlah nilai yg lumayan besar. � Namun bila kecil/ sedikit, batasan dari setiap kelompok dapat menjadi kandidat untuk representasinya.

� Sebagai contoh, jika diberikan fitur f {3, 2, 1, 5, 4, 3, 1, 7, 5, 3} kemudian setelah sorting didapatkan : {1, 1, 2, 3, 3, 3, 4, 5, 5, 7} � Maka sekarang, mungkin dipecah jumlah kumpulan nilai kedalam 3 bins {1, 1, 2, 3, 3, 3, 4, 5, 5, 7} BIN 1 BIN 2 BIN 3

{1, 1, 2, BIN 1 3, 3, 3, BIN 2 4, 5, 5, 7} BIN 3 � Langkah berikutnya, perbedaan representasi dapat dipilih untuk setiap bin. � Berdasarkan mode dalam bin, maka nilai-nilai baru: {1, 1, 1, 3, 3, 3, 5, 5, 5, 5} BIN 1 BIN 2 BIN 3 � Berdasarkan mean {1. 33, 3, 5. 25, 5. 25} BIN 1 BIN 2 BIN 3 � Berdasarkan kedekatan dengan batasan nilai dalam bin: {1, 1, 2, 3, 3, 3, 4, 4, 4, 7} BIN 1 BIN 2 BIN 3

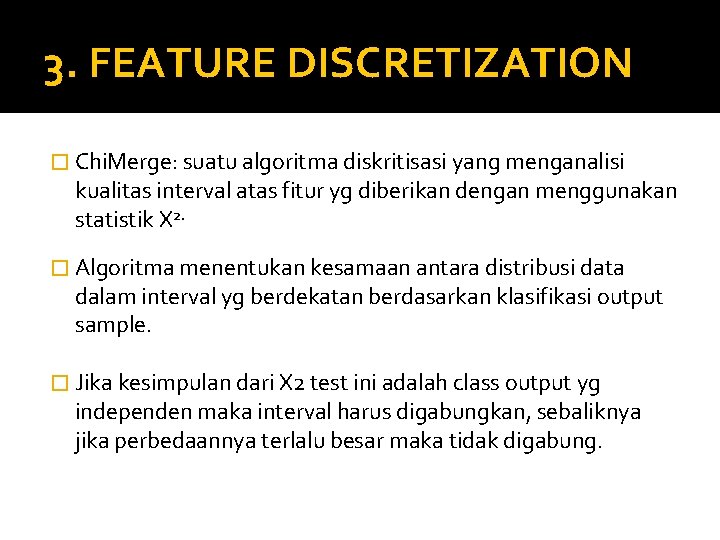

� Masalah utama dari metoda ini adalah menemukan batasan terbaik untuk bin. Maka prosedurenya terdiri langkah-langkah berikut: Urutkan seluruh nilai bagi fitur yg diberikan Assign dengan perkiraan sejumlah nilai-nilai yg berdekatan setiap bin Pindahkan elemen batas dari satu bin ke berikutnya (atau sebelumnya) ketika mereduksi error jarak keseluruhan (ER)

Contoh: Kumpulan nilai dari fitur f adalah {5, 1, 8, 2, 2, 9, 2, 1, 8, 6}. Split ke dalam 3 bin (k=3), dimana bin 2 akan direpresentasikan dengan mode-nya. � Sorted nilai 2 fitur f : { 1, 1, 2, 2, 2, 5, 6, 8, 8, 9} � Inisialisasi bin (k=3) BIN 1 BIN 2 BIN 3 (i) Modes untuk ketiga bin terpilih : {1, 2, 8}. Maka total error: ER = 0 + 1+ 0 + 3 + 2 + 0 + 1 = 7 (ii) Setelah memindahkan 2 elemen dari BIN 2 ke BIN 1 dan 1 elemen dari BIN 3 ke BIN 2, maka diperoleh ER yg lebih kecil dan distribusi akhir menjadi: Final bins f= { 1, 1, 2, 2, 2, 5, 6, 8, 8, 9} BIN 1 BIN 2 BIN 3 � Modesnya: {2, 5, 8}, dan total error ER diminimisasi menjadi 4. � Distribusi akhir, dengan median-median sebagai representative akan didaptkan masalah reduksi nilai. � �

3. FEATURE DISCRETIZATION � Chi. Merge: suatu algoritma diskritisasi yang menganalisi kualitas interval atas fitur yg diberikan dengan menggunakan statistik X 2. � Algoritma menentukan kesamaan antara distribusi data dalam interval yg berdekatan berdasarkan klasifikasi output sample. � Jika kesimpulan dari X 2 test ini adalah class output yg independen maka interval harus digabungkan, sebaliknya jika perbedaannya terlalu besar maka tidak digabung.

Algoritma Chi. Merge berisi 3 tahap untuk diskritisasi: Sort data atas fitur yg diberikan secara urut naik Definisikan inisial awal interval sehingga setiap nilai dalam interval terpisah 3. Ulangi hingga tidak ada X 2 dari 2 interval yg berdekatan lebih kecil dari nilai threshold. � 1. 2.

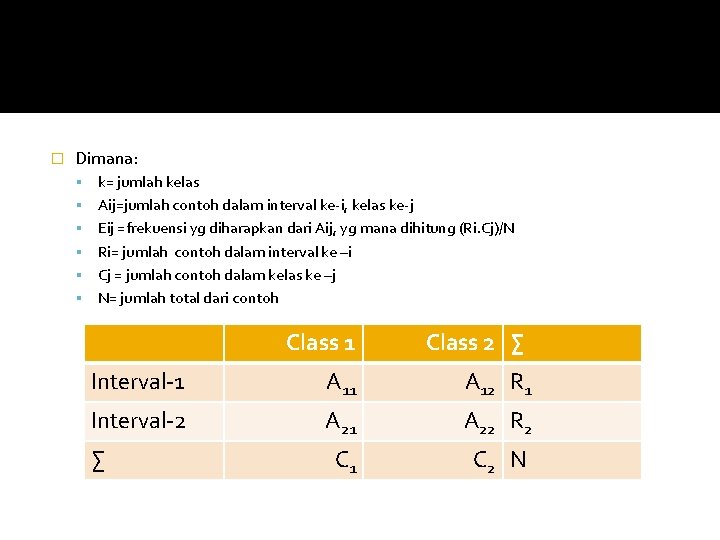

� Dimana: k= jumlah kelas Aij=jumlah contoh dalam interval ke-i, kelas ke-j Eij =frekuensi yg diharapkan dari Aij, yg mana dihitung (Ri. Cj)/N Ri= jumlah contoh dalam interval ke –i Cj = jumlah contoh dalam kelas ke –j N= jumlah total dari contoh Class 1 Class 2 ∑ Interval-1 A 11 A 12 R 1 Interval-2 A 21 A 22 R 2 C 1 C 2 N ∑

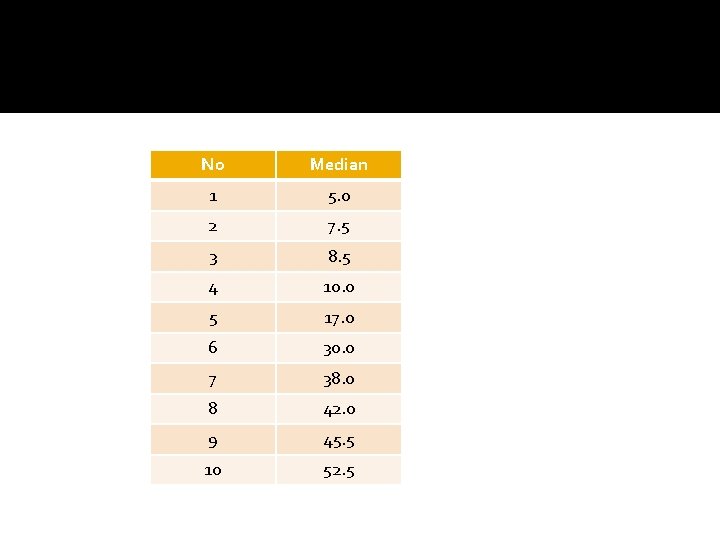

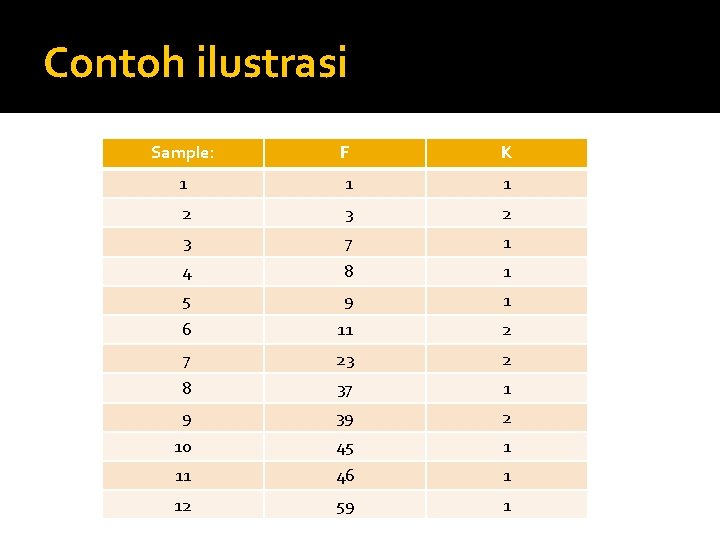

Contoh ilustrasi Sample: F K 1 1 1 2 3 7 1 4 8 1 5 9 1 6 11 2 7 23 2 8 37 1 9 39 2 10 45 1 11 46 1 12 59 1

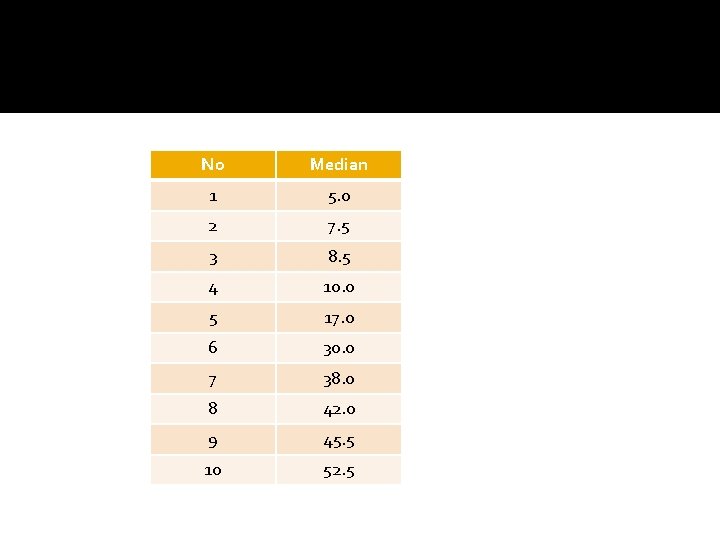

No Median 1 5. 0 2 7. 5 3 8. 5 4 10. 0 5 17. 0 6 30. 0 7 38. 0 8 42. 0 9 45. 5 10 52. 5

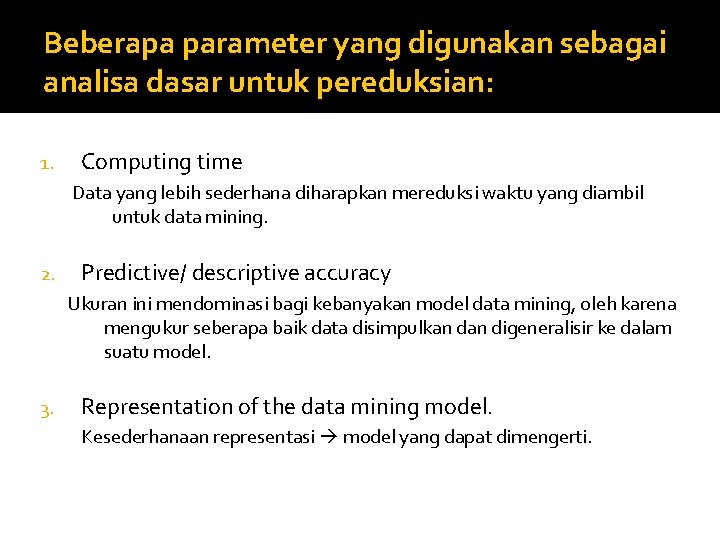

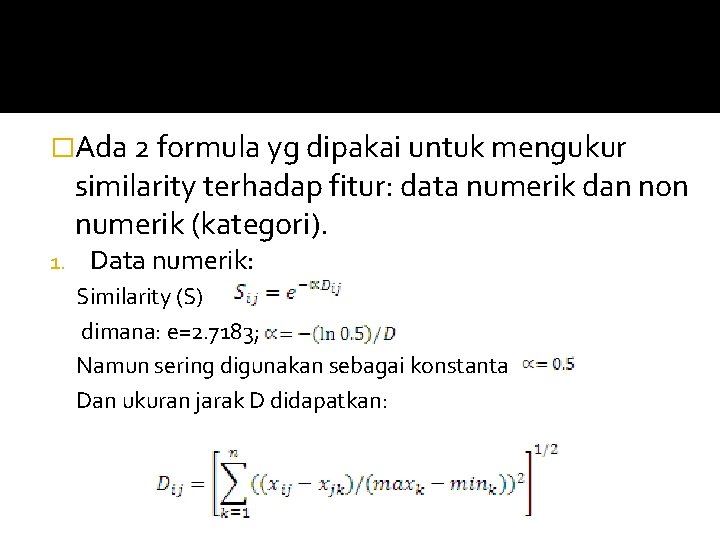

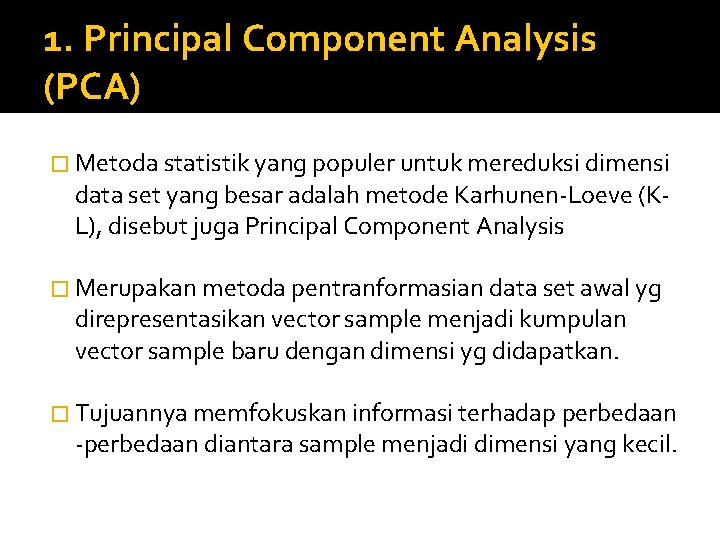

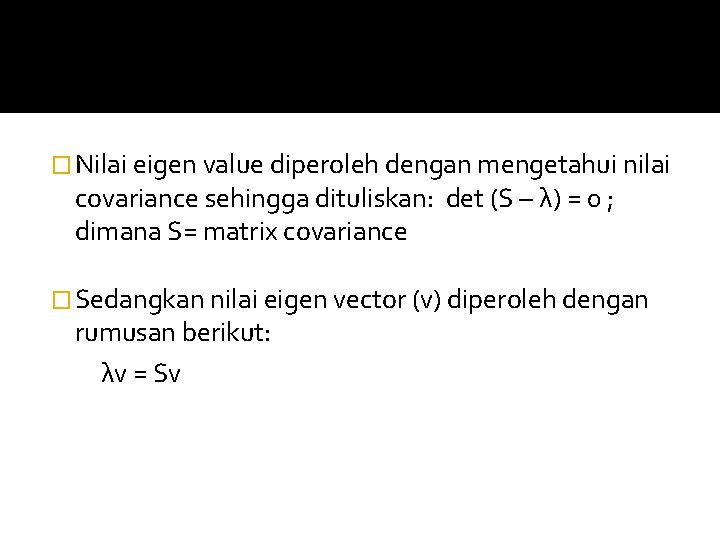

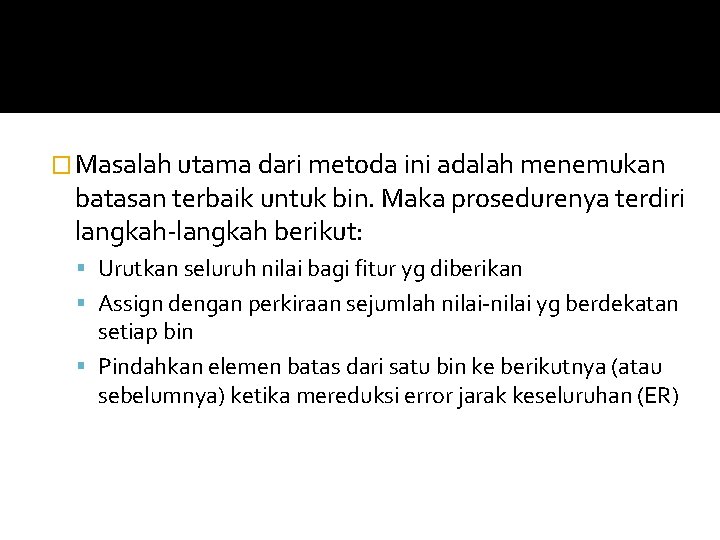

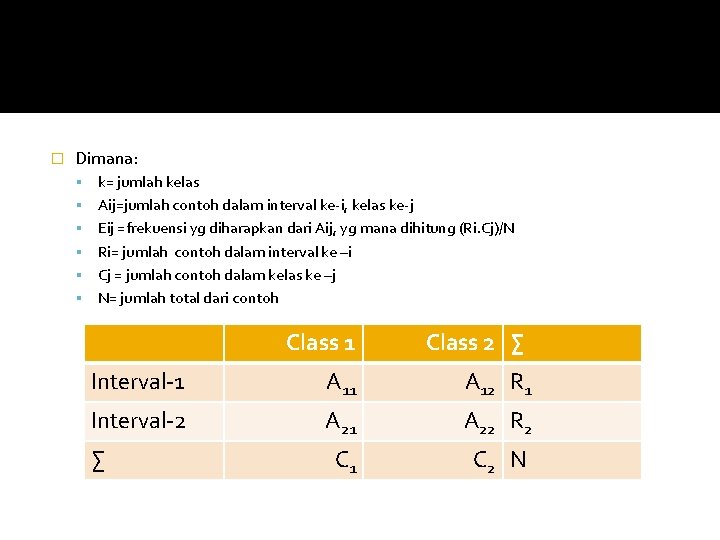

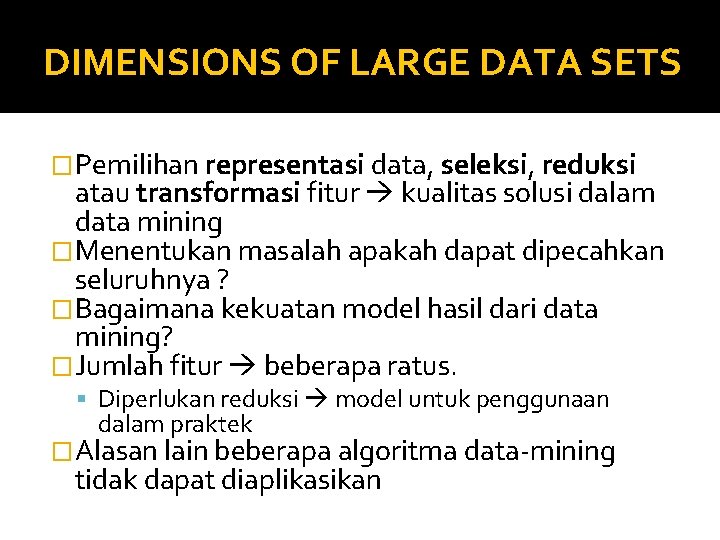

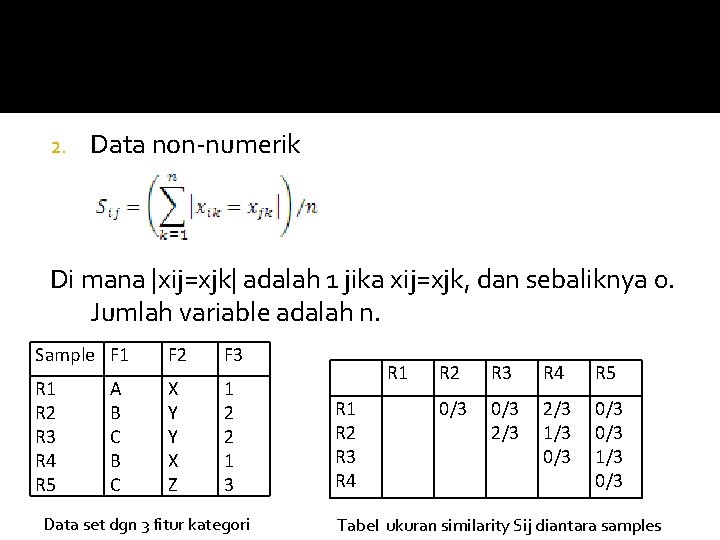

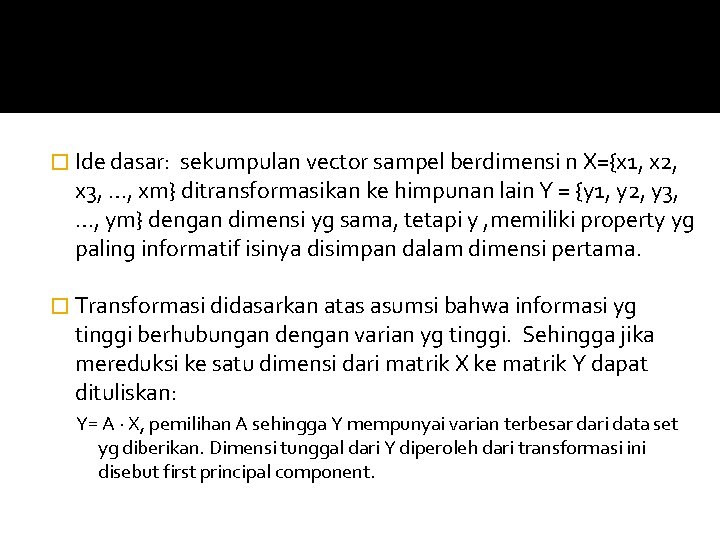

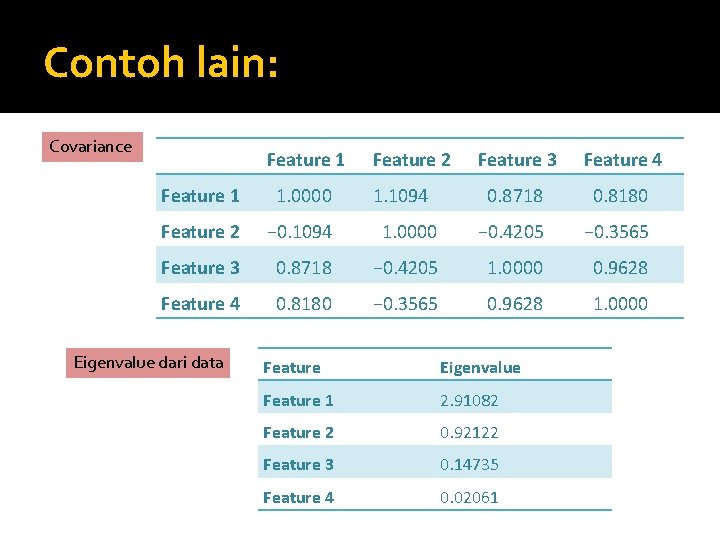

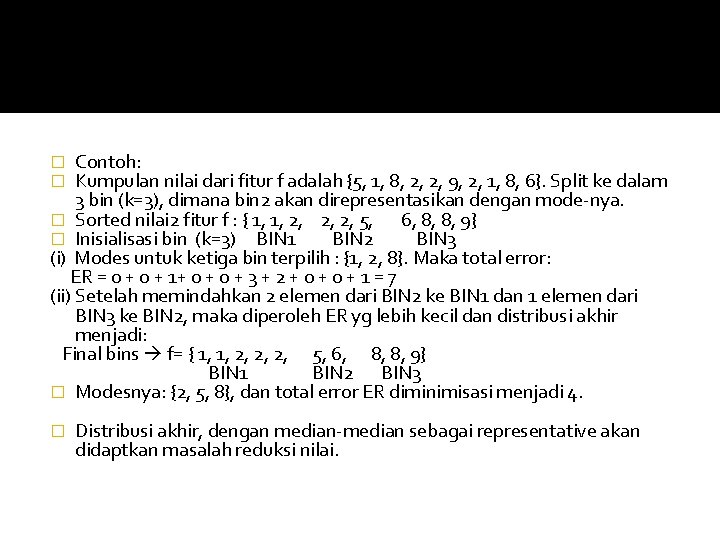

![K1 K2 Interval 7 5 8 5 A 11 1 A 12 K=1 K=2 ∑ Interval [7. 5, 8. 5] A 11 = 1 A 12](https://slidetodoc.com/presentation_image/3bca58a57055456e92da7a40539af44d/image-36.jpg)

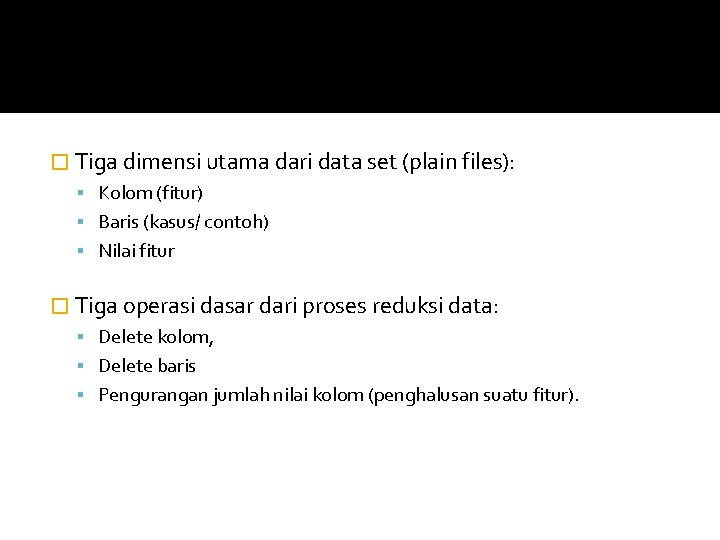

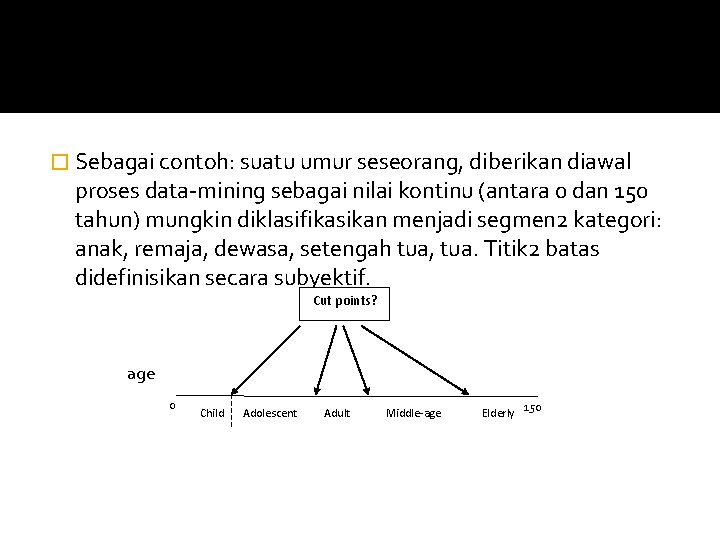

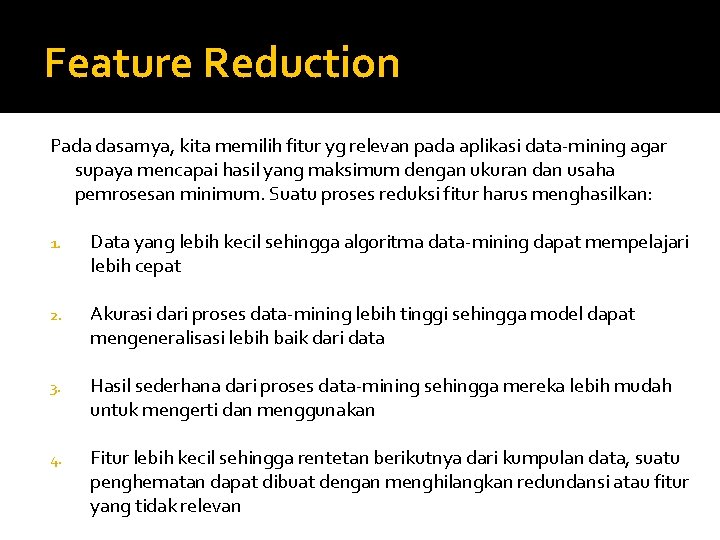

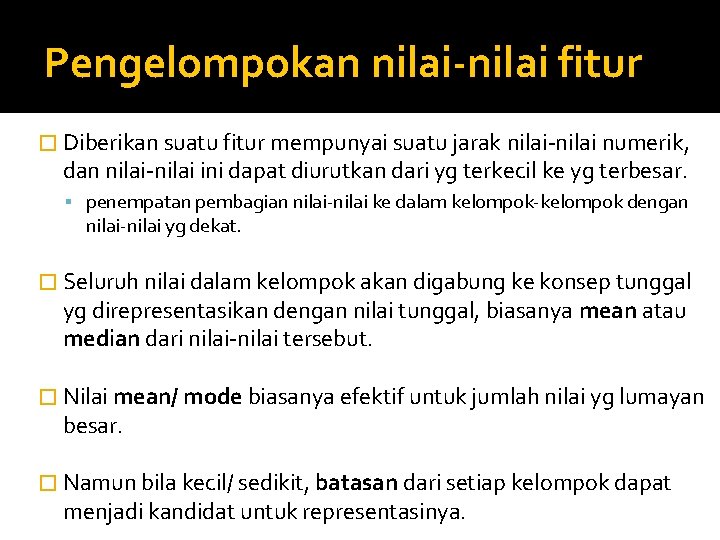

K=1 K=2 ∑ Interval [7. 5, 8. 5] A 11 = 1 A 12 = 0 R 1 = 1 Interval [8. 5, 10] A 21 = 1 A 22 = 0 R 2 = 1 ∑ C 1 = 2 C 2 = 0 N = 2 Berdasarkan tabel di atas didapatkan: E 11 = 2/2 = 1 E 12 0/2 ≈ 0. 1 E 21 = 2/2 = 1 dan E 22 = 0/2 ≈ 0. 1 X 2 =(1 -1)2/1+(0 -0. 1)2/0. 1 +(1 -1)2/1 +(0 -0. 1)2/0. 1 = 0. 2 Oleh karena lebih kecil dari threshold (2. 706 untuk distribusi dg α =0. 1, maka dilakukan penggabungan

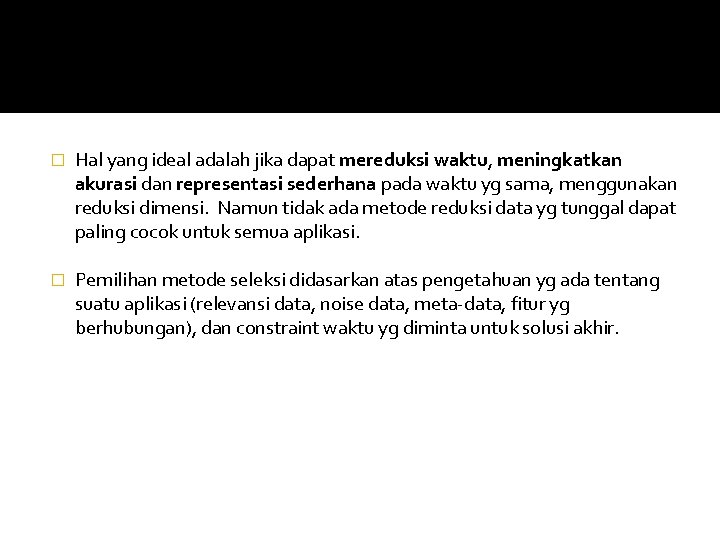

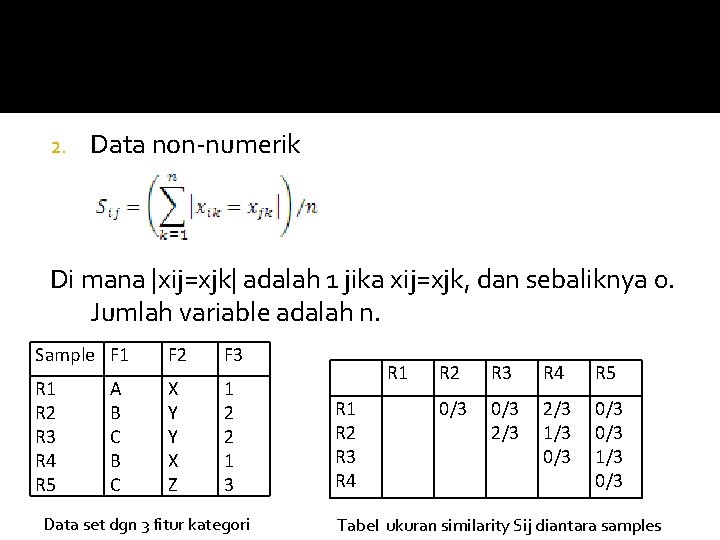

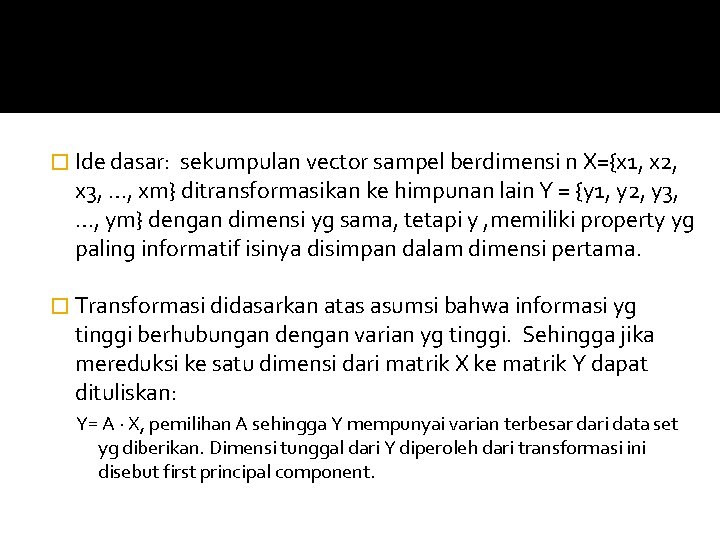

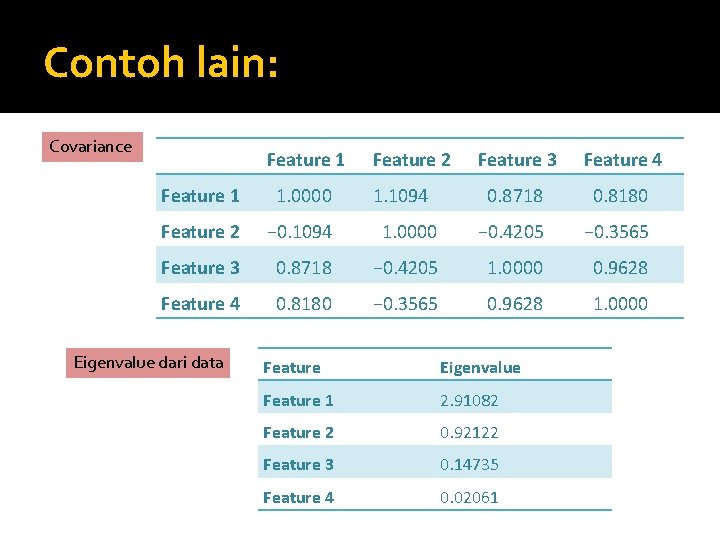

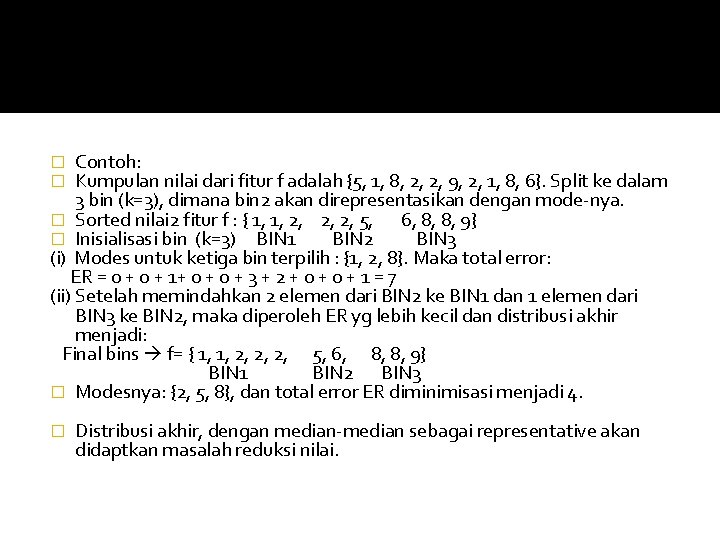

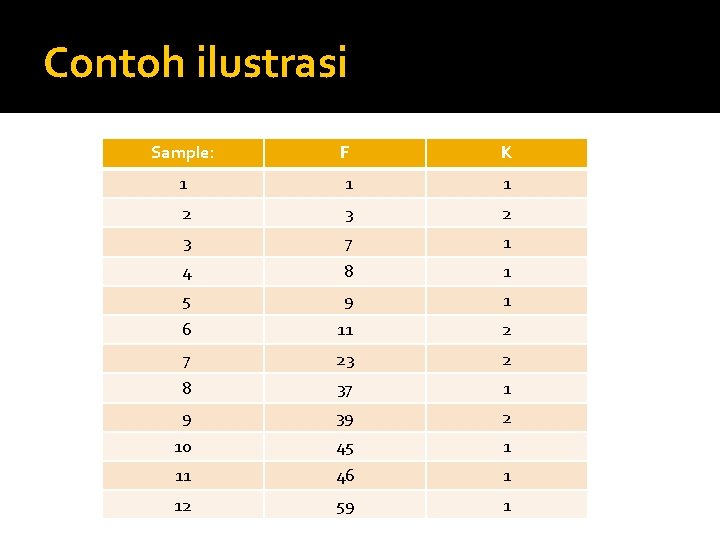

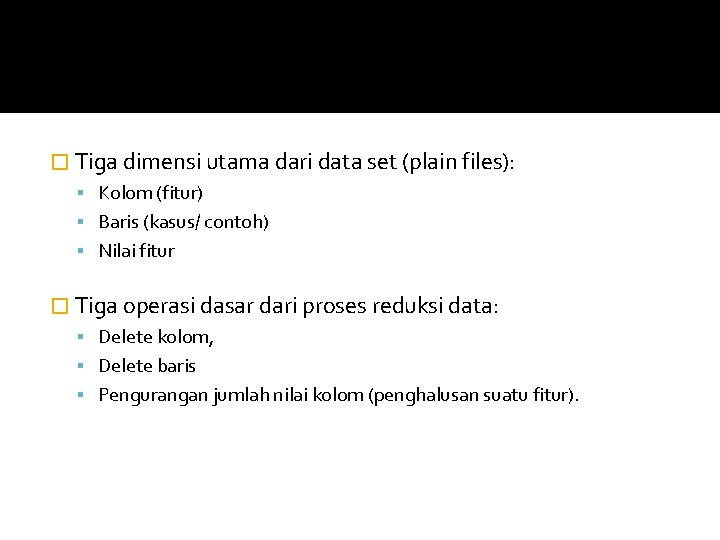

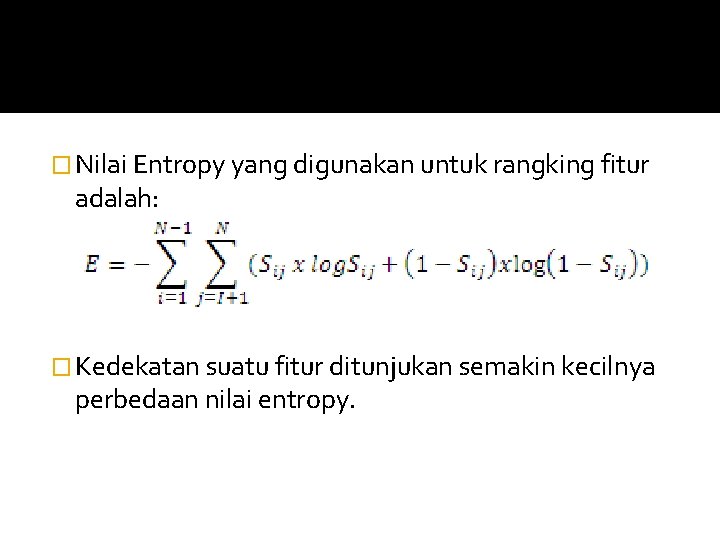

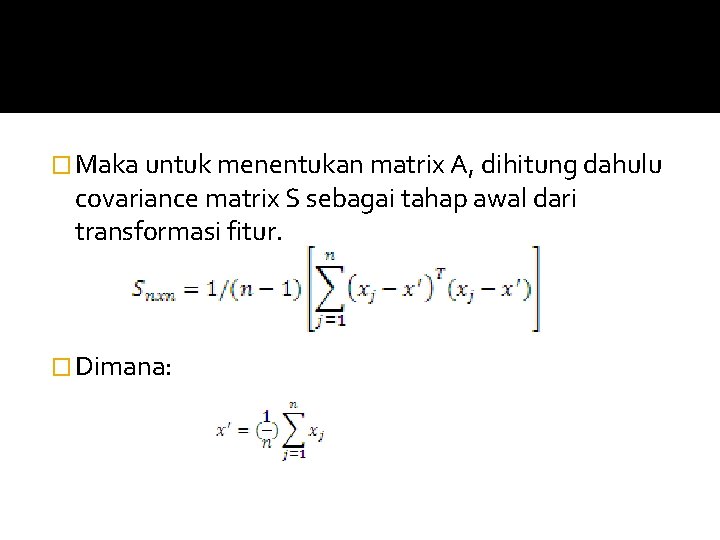

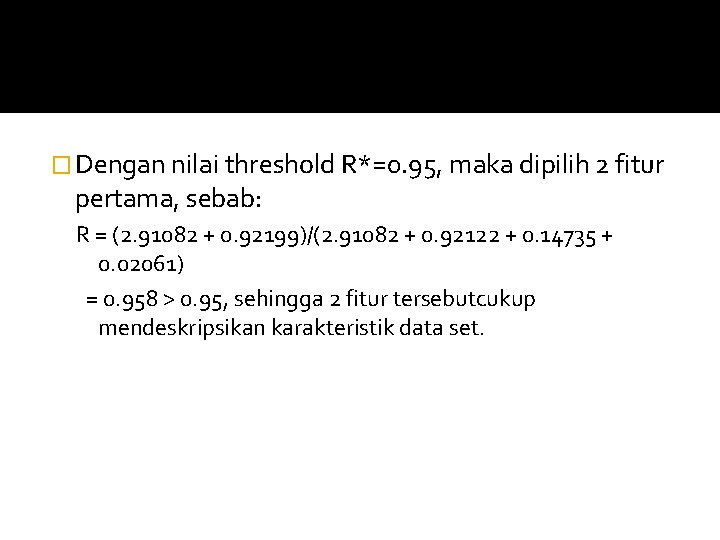

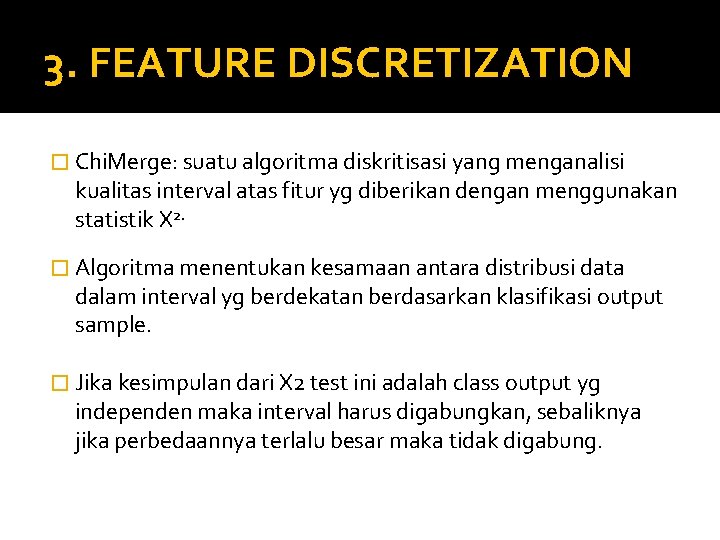

![K1 K2 Interval 0 7 5 A 11 2 A 12 K=1 K=2 ∑ Interval [0, 7. 5] A 11 = 2 A 12 =](https://slidetodoc.com/presentation_image/3bca58a57055456e92da7a40539af44d/image-37.jpg)

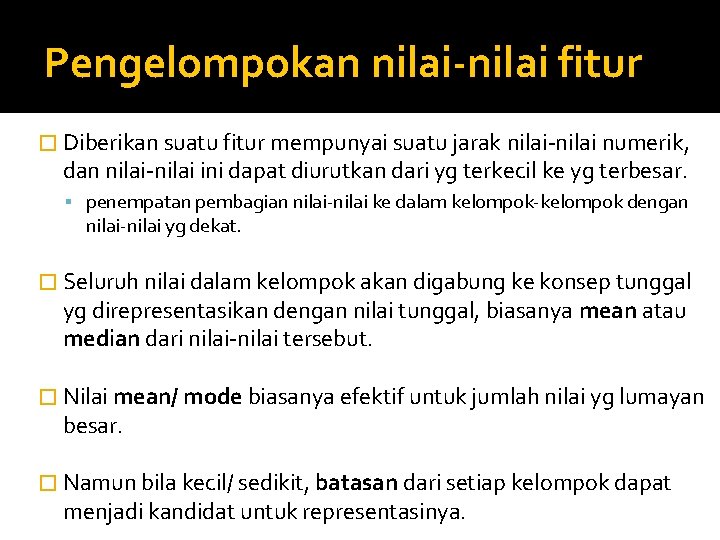

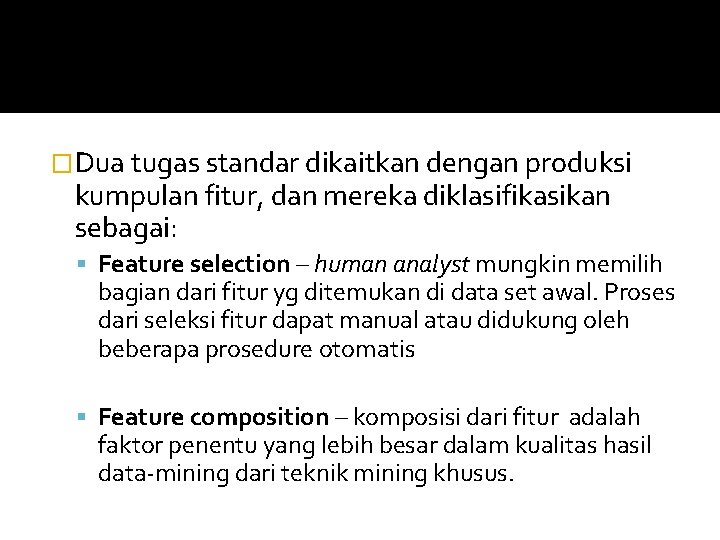

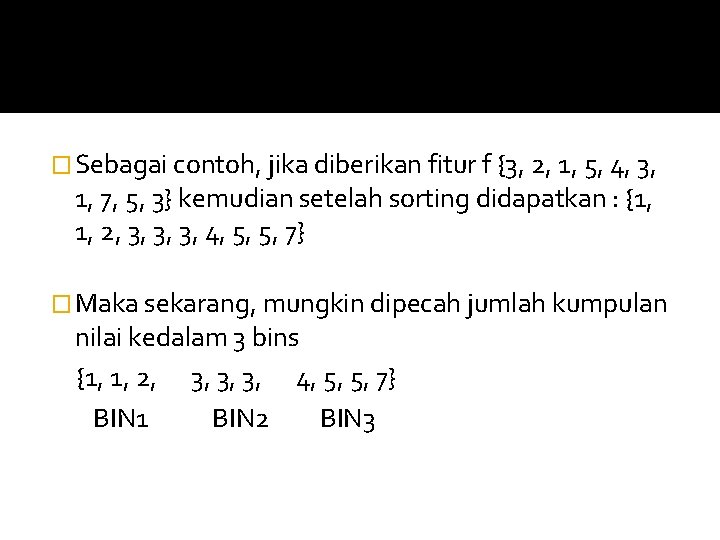

K=1 K=2 ∑ Interval [0, 7. 5] A 11 = 2 A 12 = 1 R 1 = 3 Interval [7. 5, 10] A 21 = 2 A 22 = 0 R 2 = 2 C 1 = 4 C 2 = 1 N = 5 ∑ E 11 = 12/5 = 2. 4 E 12 = 3/5 = 0. 6 E 21 = 8/5 = 1. 6 E 22 = 2/5 = 0. 4 X 2 = 0. 834

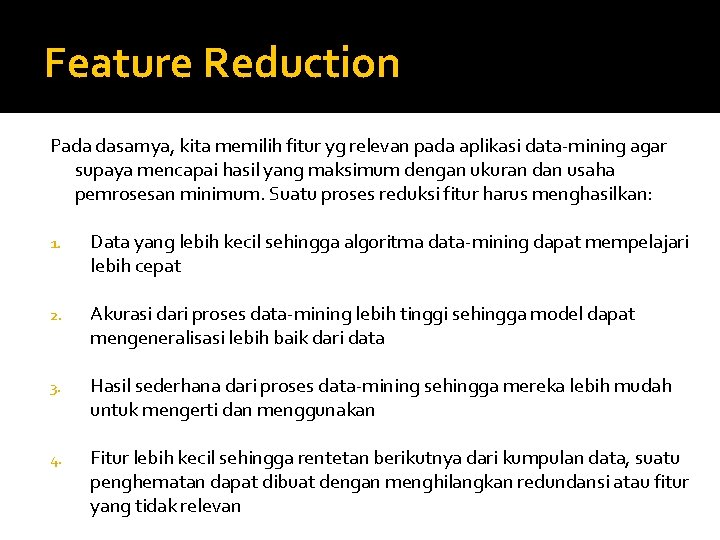

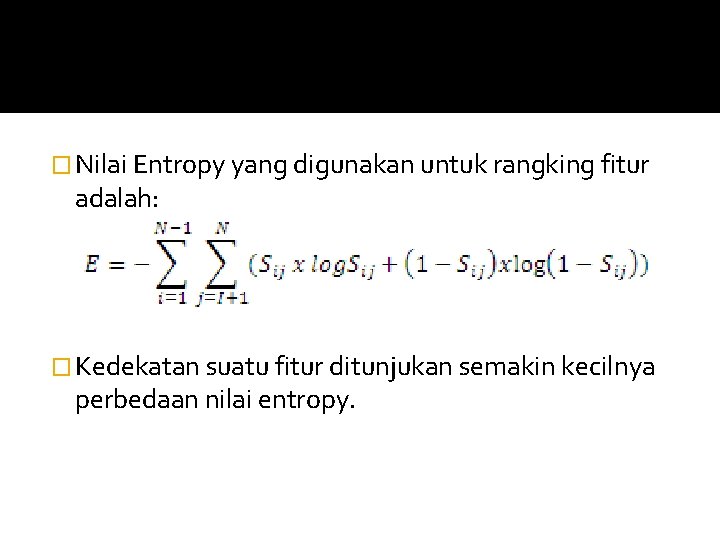

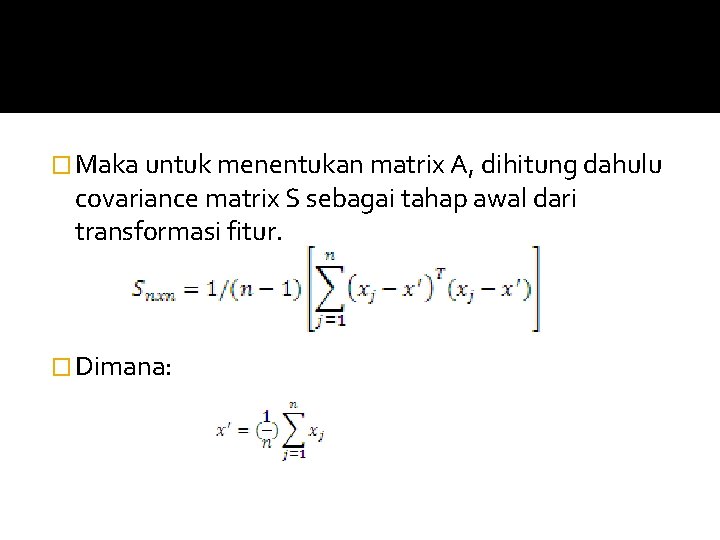

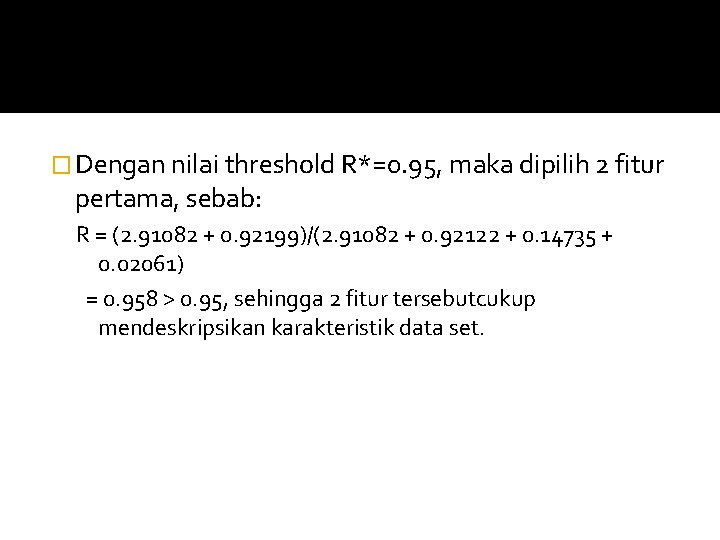

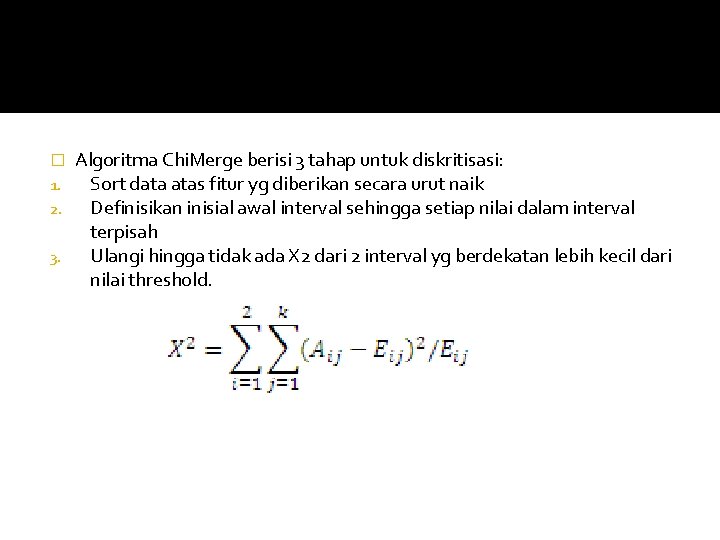

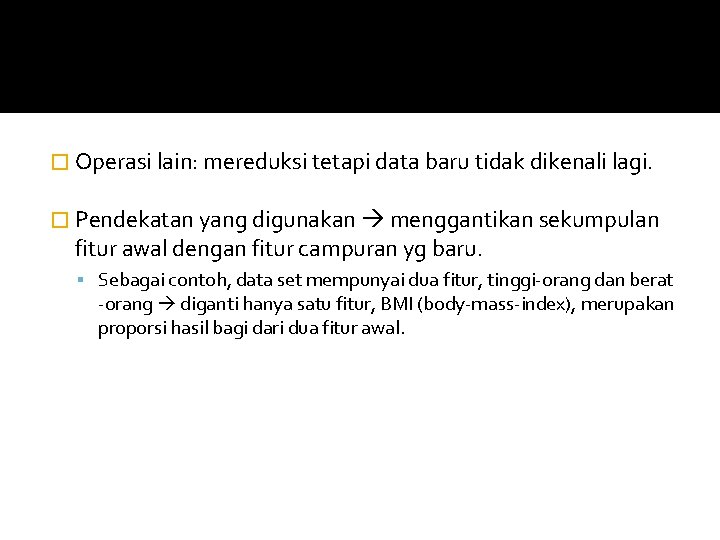

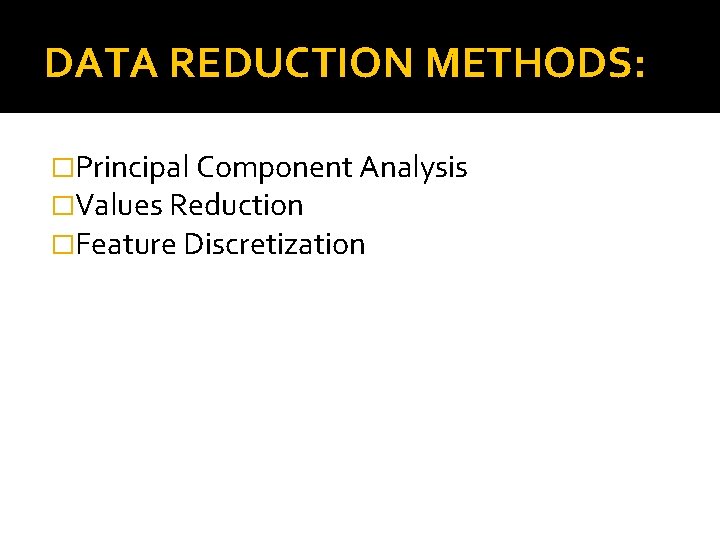

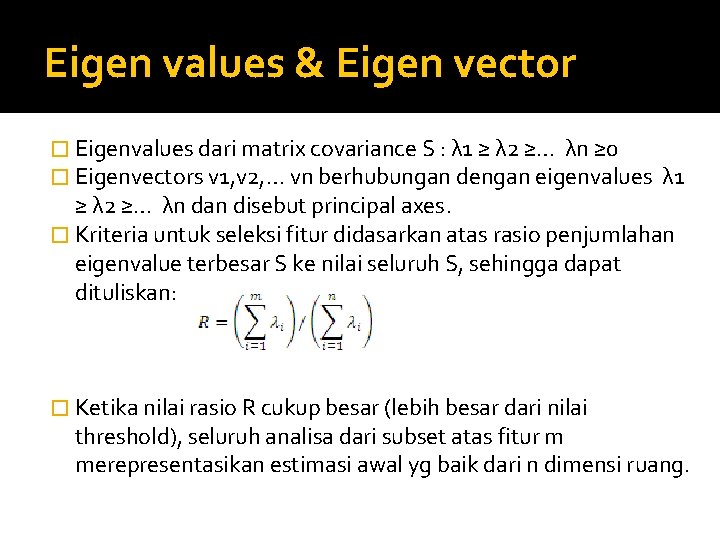

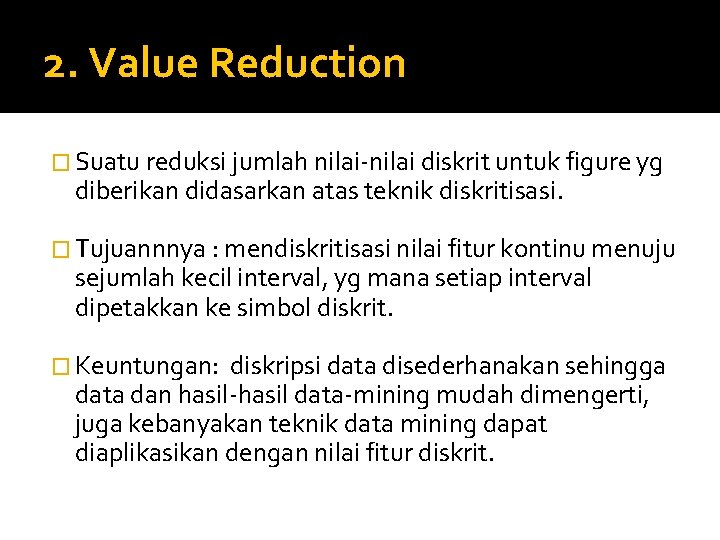

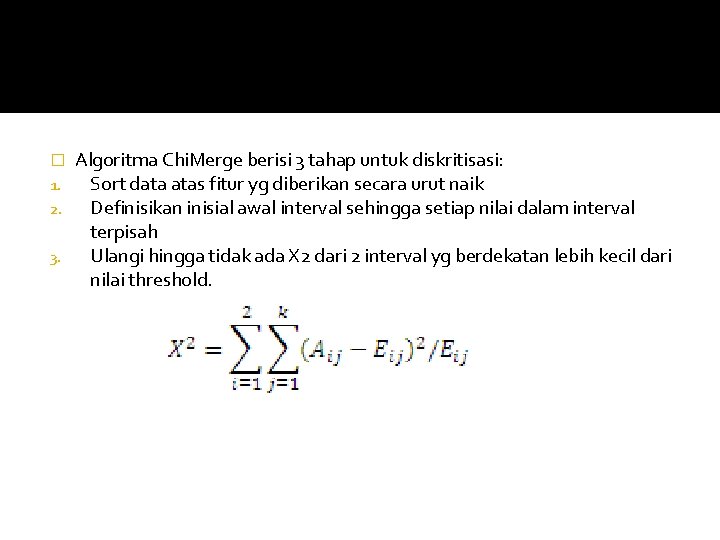

![K1 K2 Interval 0 10 0 A 11 4 A 12 K=1 K=2 ∑ Interval [0, 10. 0] A 11 = 4 A 12 =](https://slidetodoc.com/presentation_image/3bca58a57055456e92da7a40539af44d/image-38.jpg)

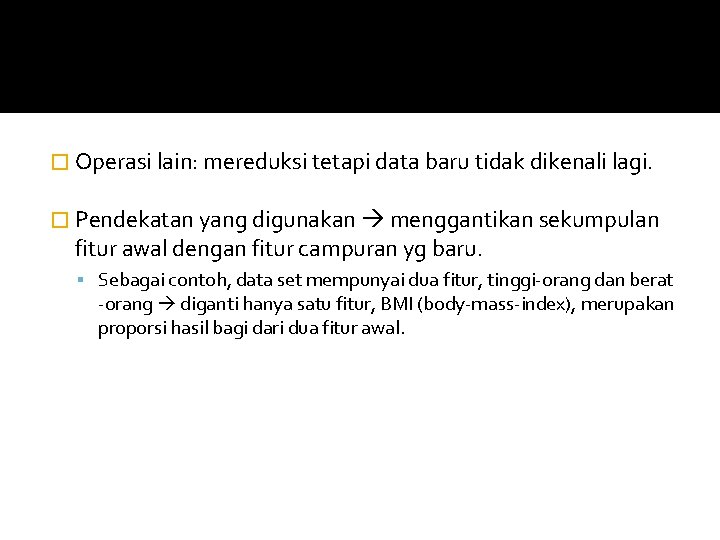

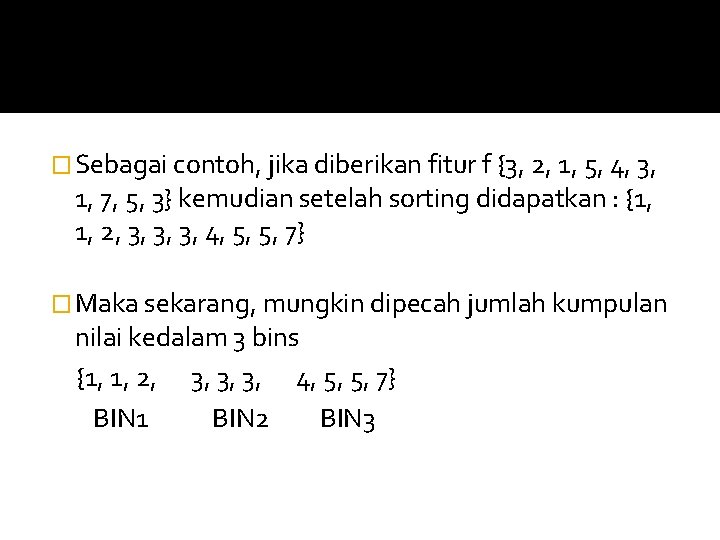

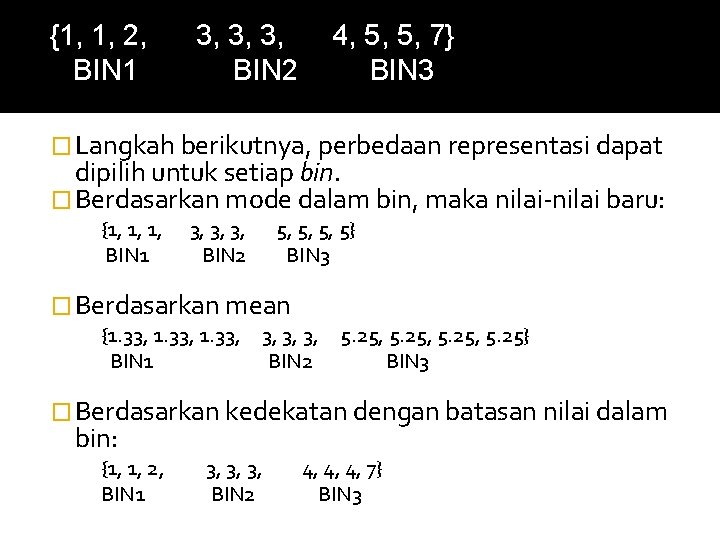

K=1 K=2 ∑ Interval [0, 10. 0] A 11 = 4 A 12 = 1 R 1 = 5 Interval [10. 0, 42. 0] A 21 = 1 A 22 = 3 R 2 = 4 C 1 = 5 C 2 = 4 N = 9 ∑ E 11 = 2. 78, E 12 = 2. 22, E 21 = 2. 22, E 22 = 1. 78, dan χ2 = 2. 72 Oleh karena dihasilkan > dari threshold (2. 706), maka tidak diperlukan lagi penggabungan