Yapay Zeka ve Makine renmesi Ders plan Yapay

- Slides: 109

Yapay Zeka ve Makine Öğrenmesi

Ders planı • Yapay Sinir Ağları (Artificial Neural Networks)

Yapay Sinir Ağları • Yapay Sinir Ağları lineer olmayan ilişkiler modelleme metodudur – Önce görülen metodlar lineer metodlardı – Lineer olmayan ilişkiler için (lineer olmayan) bileşik özellikler kullanılabilirdi, ama. . . – ilişkilerin şekilleri önceden bilmek/tahmin etmek gerekiyordu

Yapay Sinir Ağları • Yapay Sinir Ağları başından itibaren lineer olmayan modeller oluşturur • Genel durumda, lineer olmayan modellerin parametreleri bulma son derecede zordur, ama YSA’ları için verimli algoritmalar geliştirilmiştir

Yapay Sinir Ağları • Bu ölçüde, YSA bügünkü en güçlü ve en esnek makine öğrenme yaklaşımıdır

Yapay Sinir Ağları • YSA’nın uygulamaları: – konuşma tanıma – karakter tanıma – yapay görme – robot navigasyonu – otomatik sürme – vb.

Yapay Sinir Ağları • YSA’nin tarihi 1960 yıllarda başladı • YSA başlangıcı beyin bilimindeki gelişmelere bağlıydı

Yapay Sinir Ağları • Beyin, bizim bilişsel işlevlerimiz için temel araçtır (biliş, düşünme, soyut düşünme, duygu) – Beyin, özel biyolojik “nöron” hücrelerinden oluşturulmuştur – Beyindeki nöronlar yüksek derecede birbirlerine bağlı olmuştur – Temel elektriksel seviyede, nöronlar lineer toplama cihazlarıdır

Yapay Sinir Ağları • Elektriksel nöron: – Biyolojik nöronlarda birçok giriş (“dendrite” denir) ve bir çıkış (“akson” denir) var – Nöronlar, dendriteler yoluyla diğer nörondan elektriksel sinyalleri alıp içinde lineer şekilde toplar – Toplam sinyaline göre, aksonda çıkış olarak ikili elektriksel sinyal oluşturulabilir – Bu sinyal diğer birçok nörona gidip orada ikinci sinyalları oluşturabilir vb

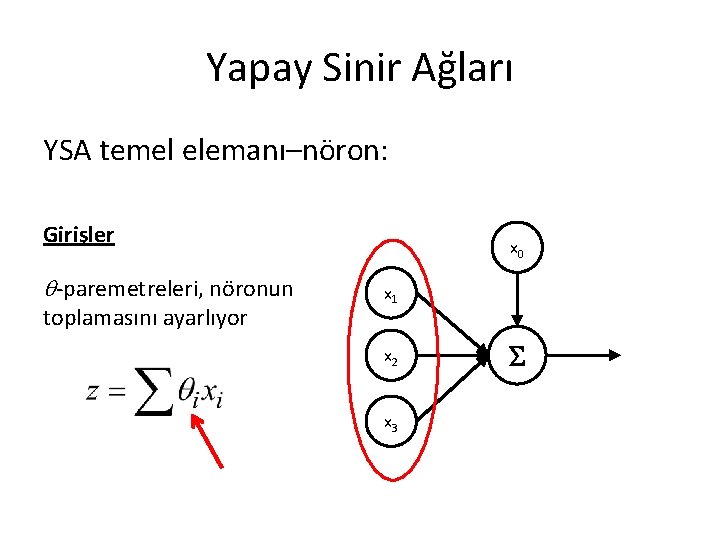

Yapay Sinir Ağları • Yapay Sinir Ağlarında, temel eleman bu şekilde tanımlanır: – “Lineer-lineer olmayan” toplama cıhazıdır, yani • girişler lineer şekilde topluyor • ona göre lineer olmayan bir çıkışı atıyor – Birkaç girişe sahip olabilir – Bir çıkışa sahiptir

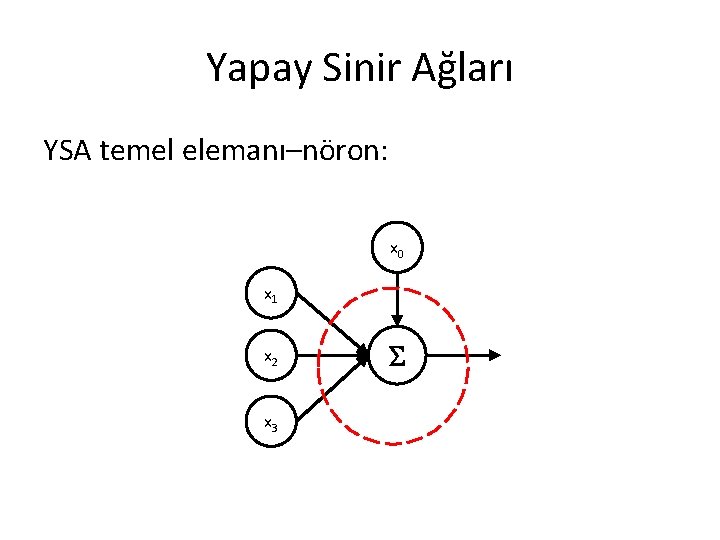

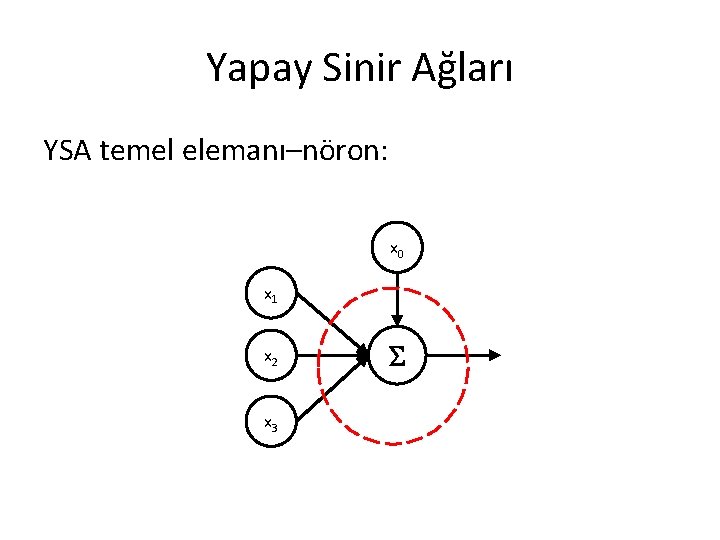

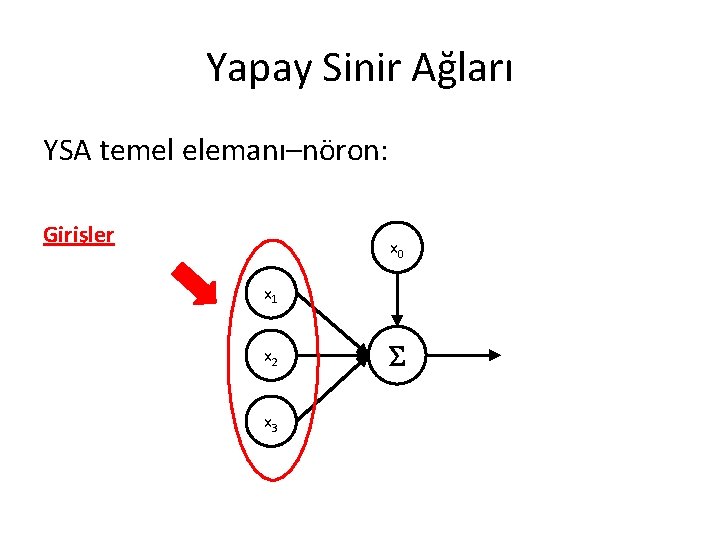

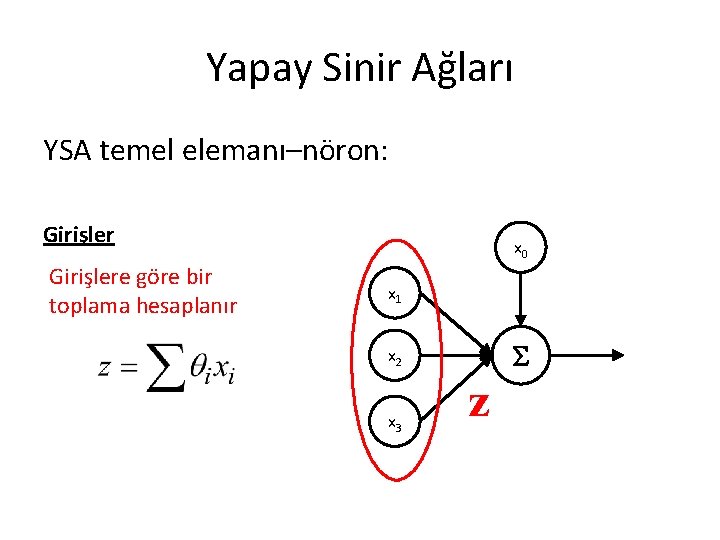

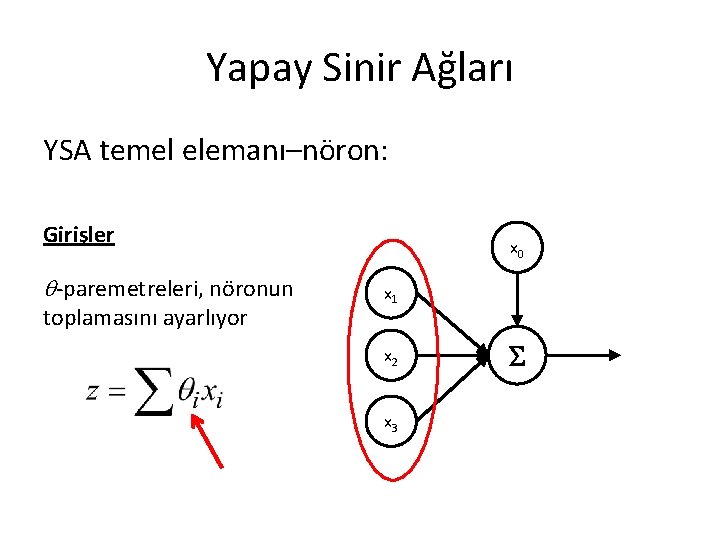

Yapay Sinir Ağları YSA temel elemanı–nöron: x 0 x 1 x 2 x 3

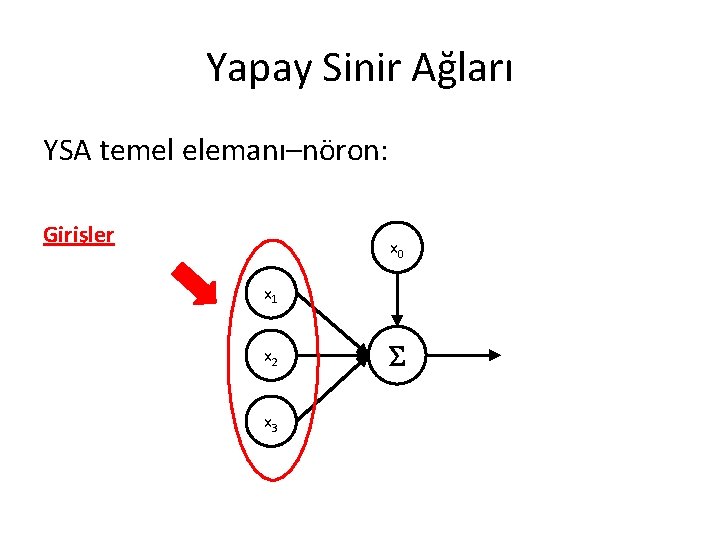

Yapay Sinir Ağları YSA temel elemanı–nöron: Girişler x 0 x 1 x 2 x 3

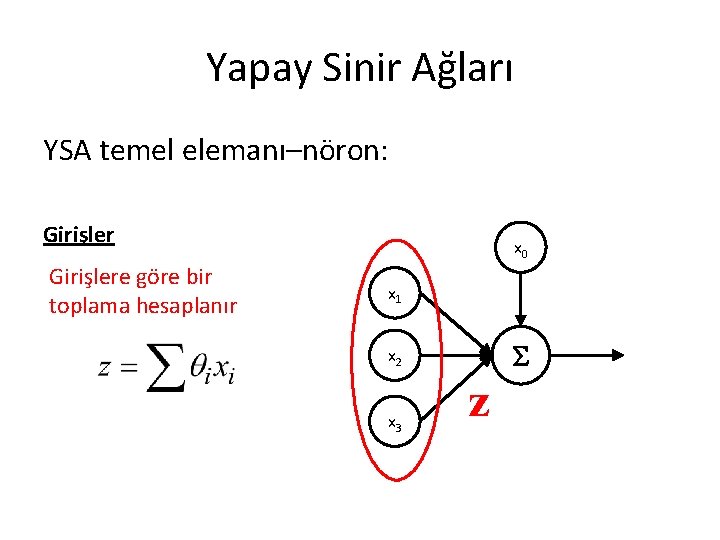

Yapay Sinir Ağları YSA temel elemanı–nöron: Girişlere göre bir toplama hesaplanır x 0 x 1 x 2 x 3 z

Yapay Sinir Ağları YSA temel elemanı–nöron: Girişler -paremetreleri, nöronun toplamasını ayarlıyor x 0 x 1 x 2 x 3

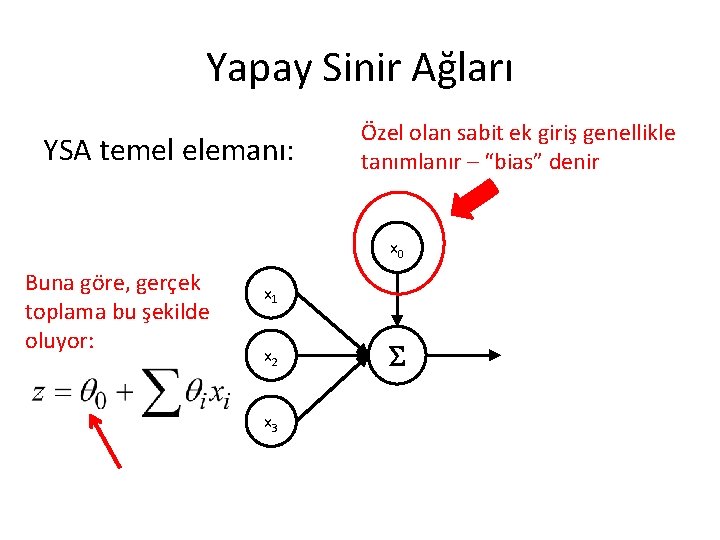

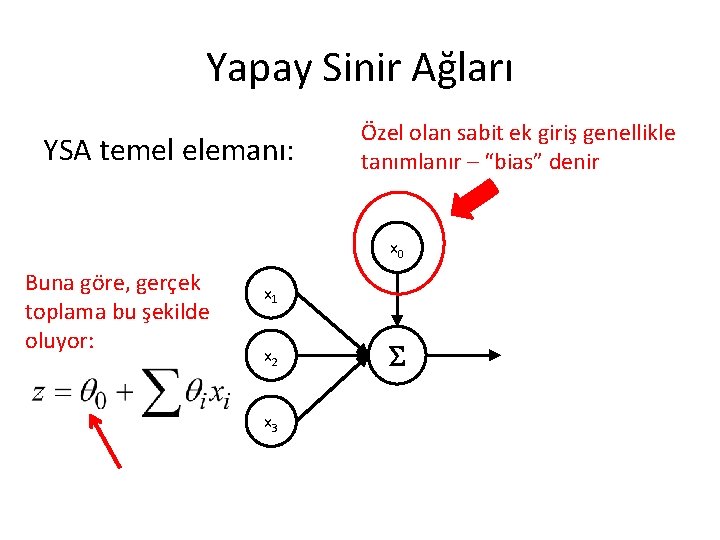

Yapay Sinir Ağları YSA temel elemanı: Özel olan sabit ek giriş genellikle tanımlanır – “bias” denir x 0 x 1 x 2 x 3 x 0 her zaman 1 verir

Yapay Sinir Ağları YSA temel elemanı: Özel olan sabit ek giriş genellikle tanımlanır – “bias” denir x 0 Buna göre, gerçek toplama bu şekilde oluyor: x 1 x 2 x 3

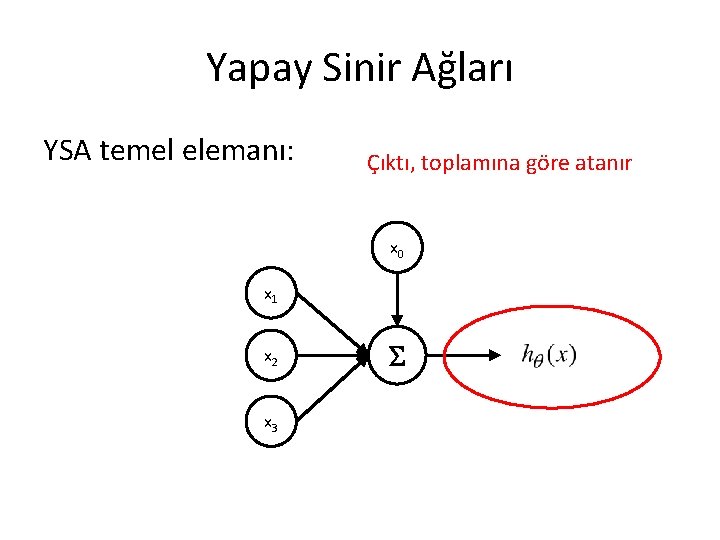

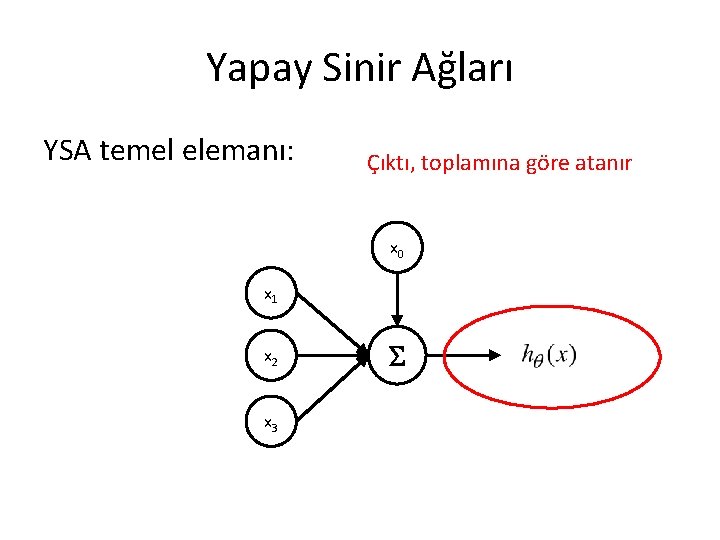

Yapay Sinir Ağları YSA temel elemanı: Çıktı, toplamına göre atanır x 0 x 1 x 2 x 3

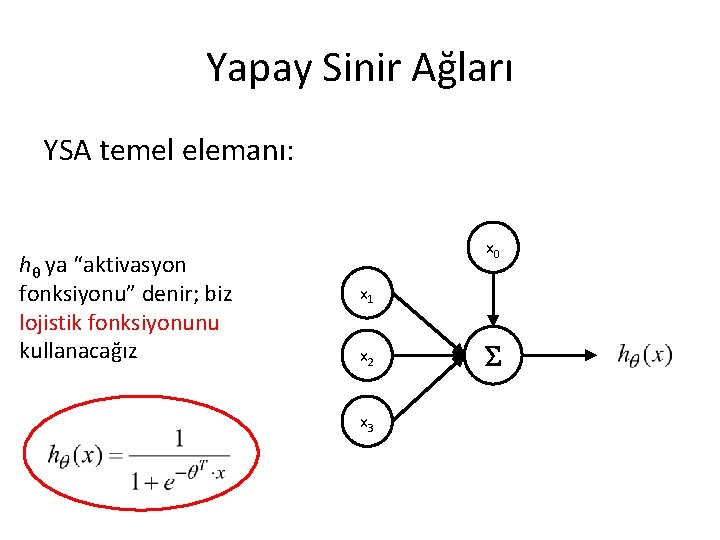

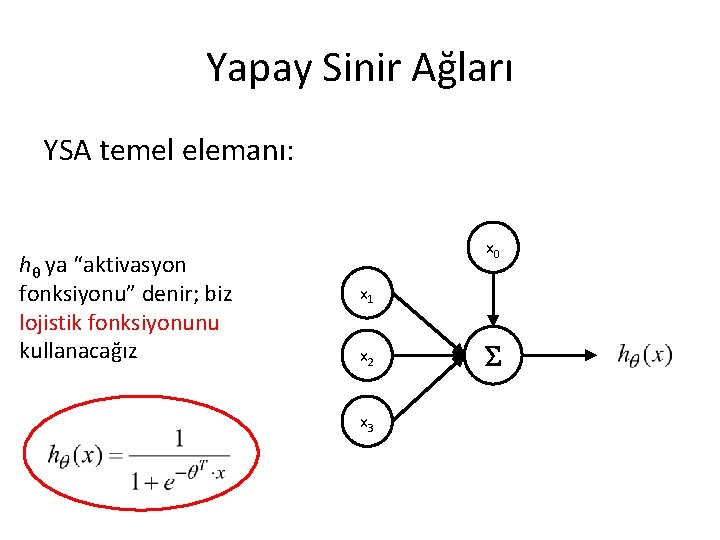

Yapay Sinir Ağları YSA temel elemanı: hθ ya “aktivasyon fonksiyonu” denir; biz lojistik fonksiyonunu kullanacağız x 0 x 1 x 2 x 3

Yapay Sinir Ağları Lojistik fonksiyonu son derste anlatılmış • Temel seviyede, – 0’dan 1’e kadar sürekli şekilde değişir – Büyük negatif girdiler için sıfıra yakın – Büyük pozitif girdiler için bire yakın – Bir olayın bir faktörlerin lineer kombinasyonuna göre olasılığı belirtmiş düşünülebilir

Yapay Sinir Ağları Lojistik fonksiyonu, g(z)

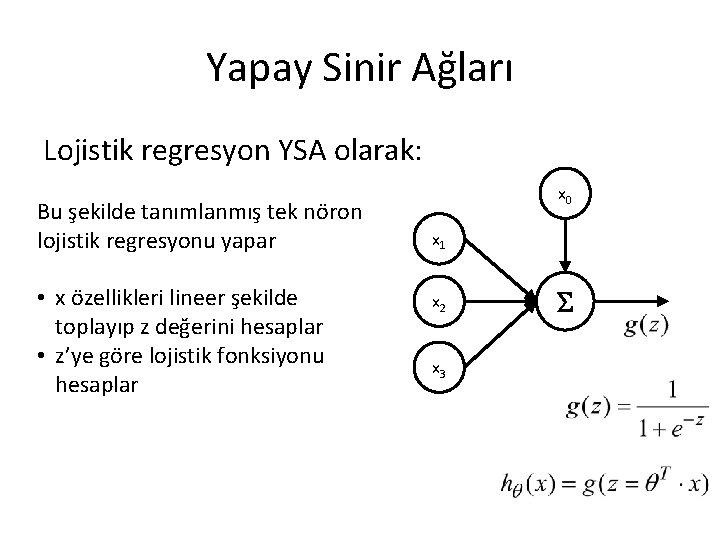

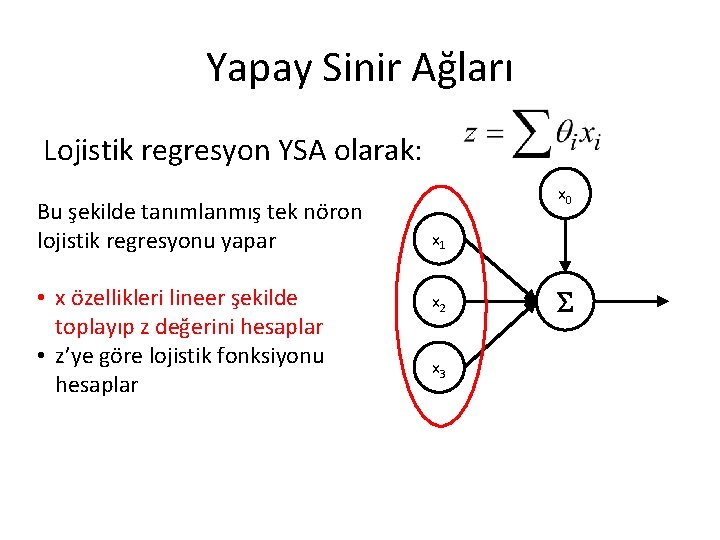

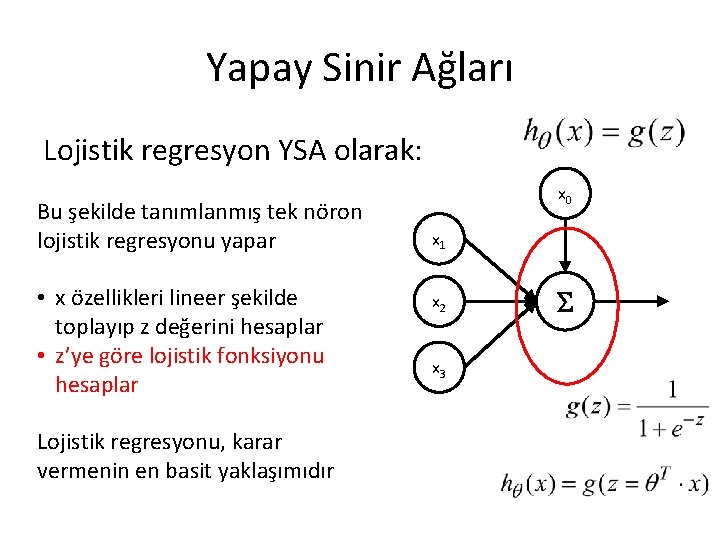

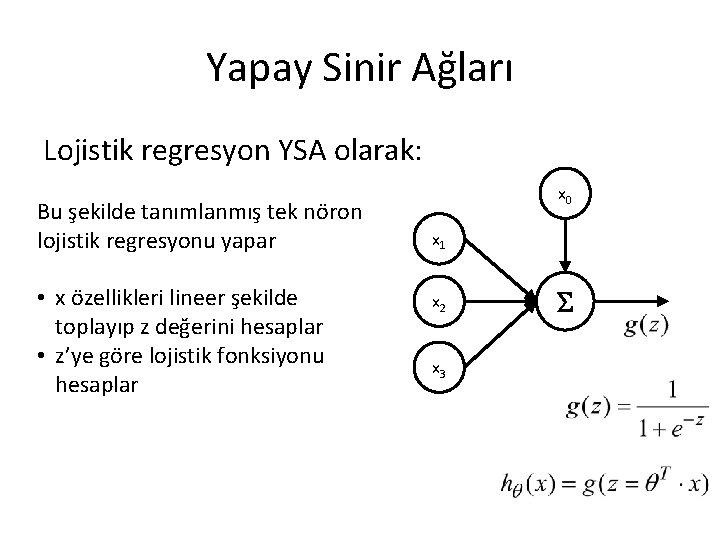

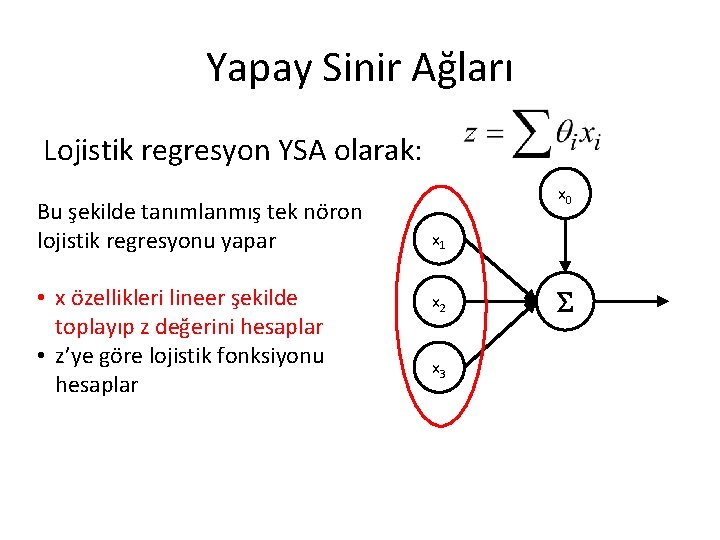

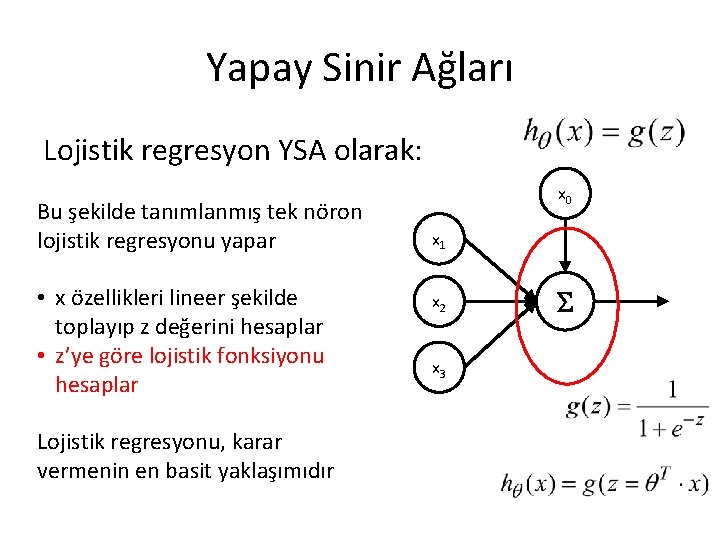

Yapay Sinir Ağları Lojistik regresyon YSA olarak: Bu şekilde tanımlanmış tek nöron lojistik regresyonu yapar • x özellikleri lineer şekilde toplayıp z değerini hesaplar • z’ye göre lojistik fonksiyonu hesaplar x 0 x 1 x 2 x 3

Yapay Sinir Ağları Lojistik regresyon YSA olarak: Bu şekilde tanımlanmış tek nöron lojistik regresyonu yapar • x özellikleri lineer şekilde toplayıp z değerini hesaplar • z’ye göre lojistik fonksiyonu hesaplar x 0 x 1 x 2 x 3

Yapay Sinir Ağları Lojistik regresyon YSA olarak: Bu şekilde tanımlanmış tek nöron lojistik regresyonu yapar • x özellikleri lineer şekilde toplayıp z değerini hesaplar • z’ye göre lojistik fonksiyonu hesaplar Lojistik regresyonu, karar vermenin en basit yaklaşımıdır x 0 x 1 x 2 x 3

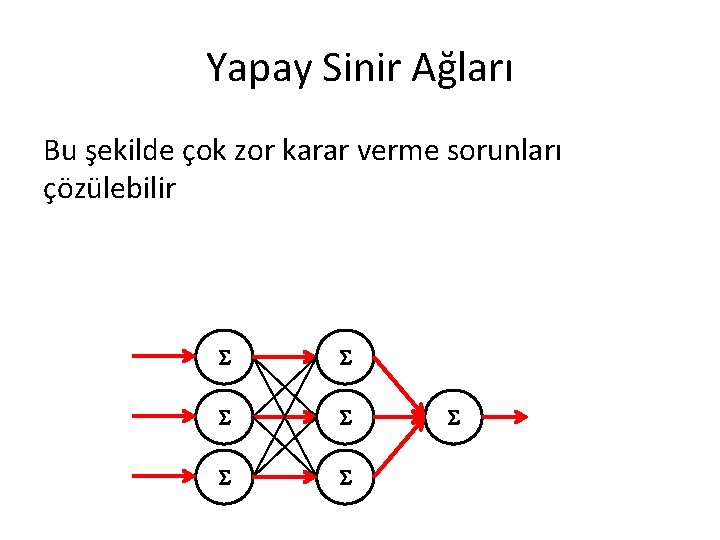

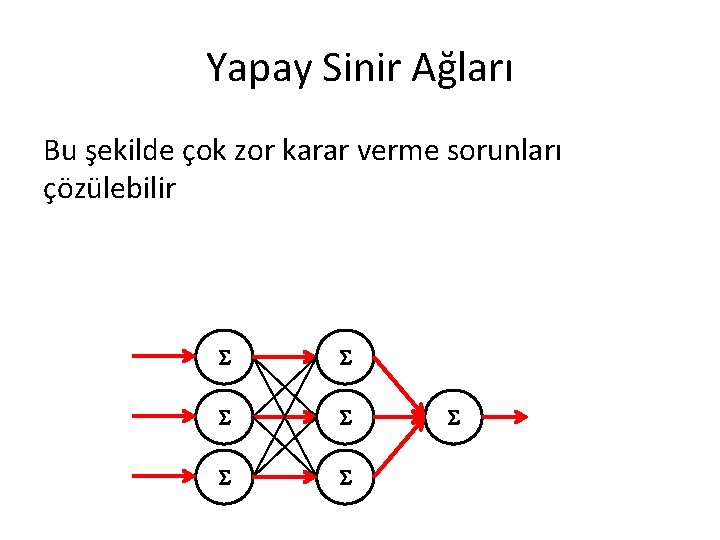

Yapay Sinir Ağları Yapay sınır ağlarında, birçok nöron biraz farklı ( parametrelerine bağlı) lojistik regresyonunu yapıp sonuçlarını diğer nöronlara analiz etme için sunabiliyor

Yapay Sinir Ağları Bu şekilde çok zor karar verme sorunları çözülebilir

Yapay Sinir Ağları YSA temel elemanları–nöronlar: • Girdiler lineer şekilde toplanır – Toplama, bir “ağırlık” paremetreleri tarafından ayarlanır • Toplamı aktivasyon fonksiyonuyla değişip sonuç olarak çıktısını belirtiyor x • Bu şekilde nöron bir lojistik x regresyonu hesaplanır 0 1 x 2 x 3

Yapay Sinir Ağları: • Nöronlar, genellikle büyük bağlantı ağı içinde çalışırlar, yanında analiz ederek sonuçlarını sürekli diğer nöronlara sunar • Böyle sistemler, birçok karmaşık sorunların çözülmesi ve ilişkilerin modellenmesine x yol açar 0 x 1 x 2 x 3

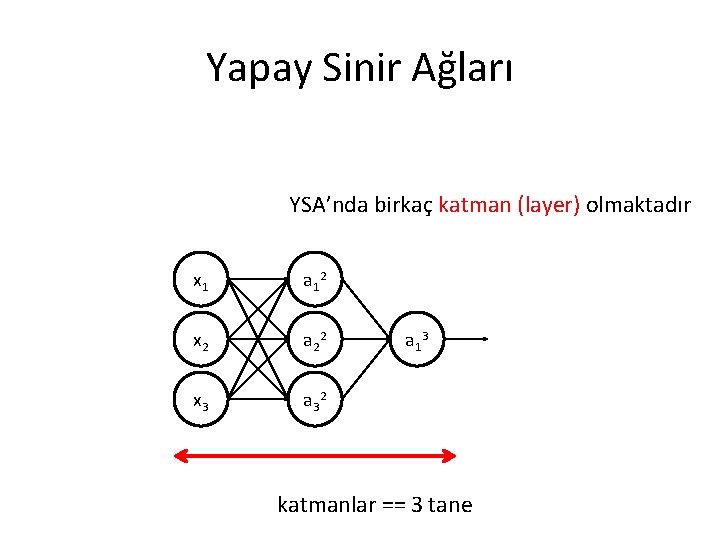

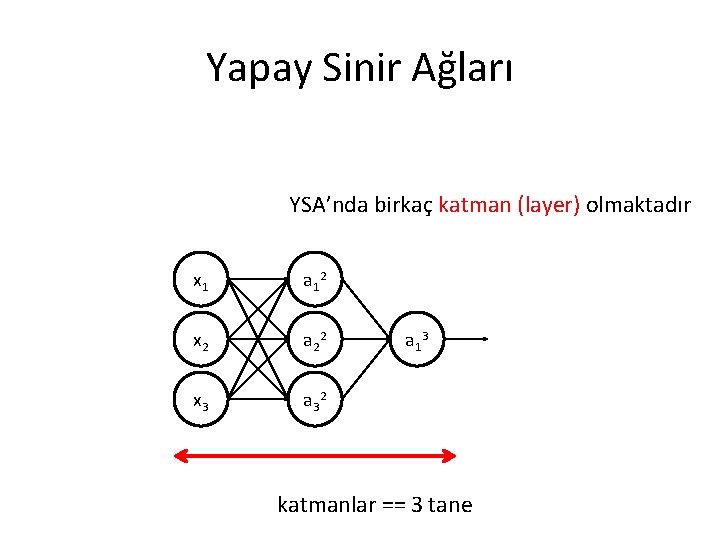

Yapay Sinir Ağları Örnek: Bir basit YSA x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

Yapay Sinir Ağları YSA’nda birkaç katman (layer) olmaktadır x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3 katmanlar == 3 tane

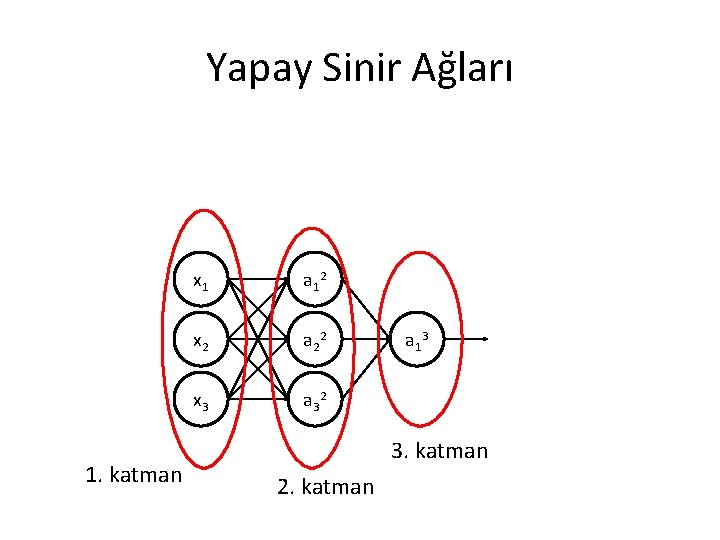

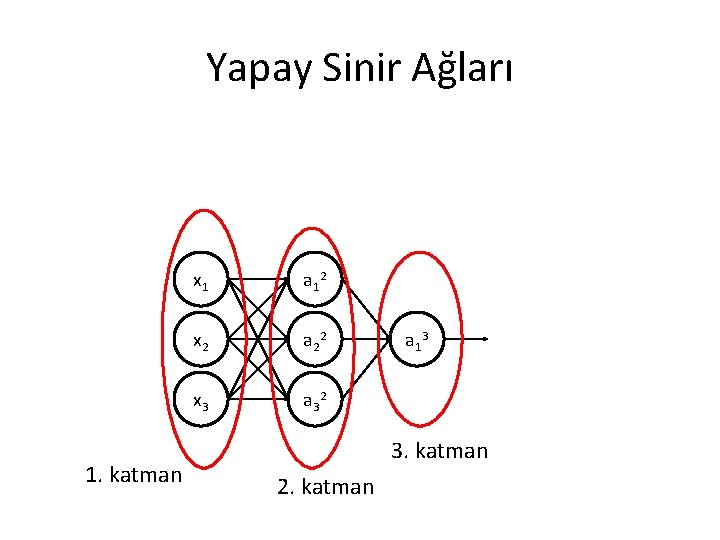

Yapay Sinir Ağları 1. katman x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3 3. katman 2. katman

Yapay Sinir Ağları En soldaki katman modelin girişleri içermeli –bu katmana “giriş katmanı” denir x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 Giriş katmanı a 1 3

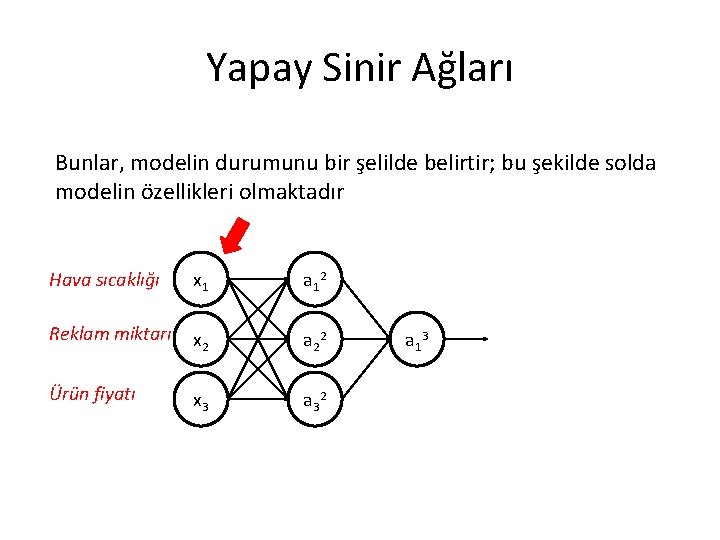

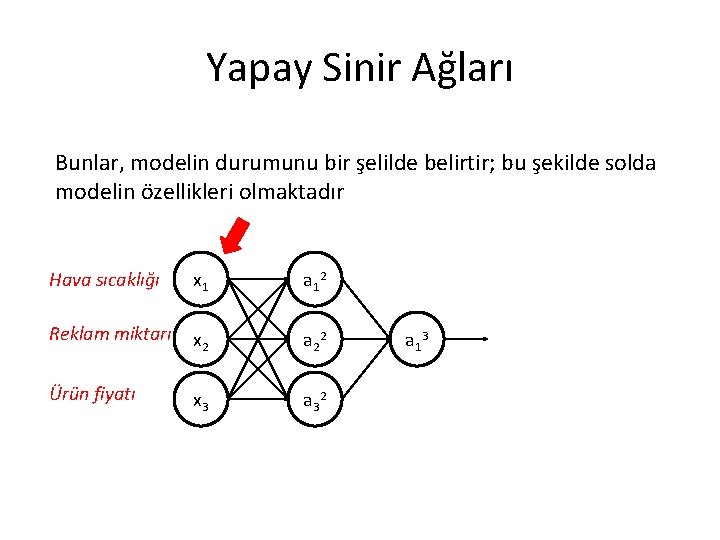

Yapay Sinir Ağları Bunlar, modelin durumunu bir şelilde belirtir; bu şekilde solda modelin özellikleri olmaktadır Hava sıcaklığı x 1 a 1 2 Reklam miktarı x 2 a 2 2 Ürün fiyatı x 3 a 3 2 a 1 3

Yapay Sinir Ağları Bunlar, modelin durumunu bir şelilde belirtir; bu şekilde solda modelin özellikleri olmaktadır Hava sıcaklığı x 1 a 1 2 Reklam miktarı x 2 a 2 2 Ürün fiyatı x 3 a 3 2 a 1 3

Yapay Sinir Ağları En sağdaki katman modelin çıkışını içerir–bu katmana “çıkış katmanı” denir x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3 Çıkış katmanı

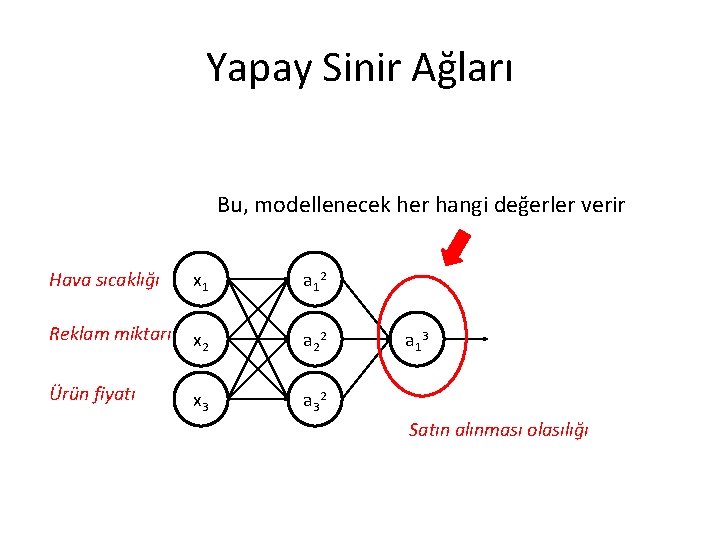

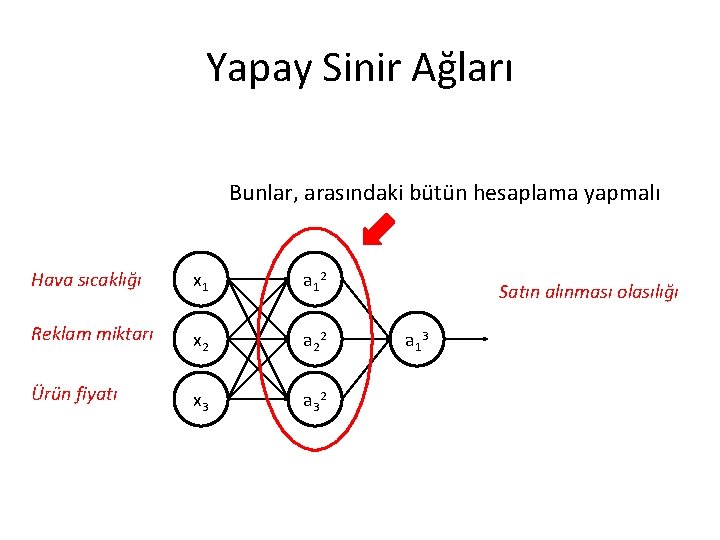

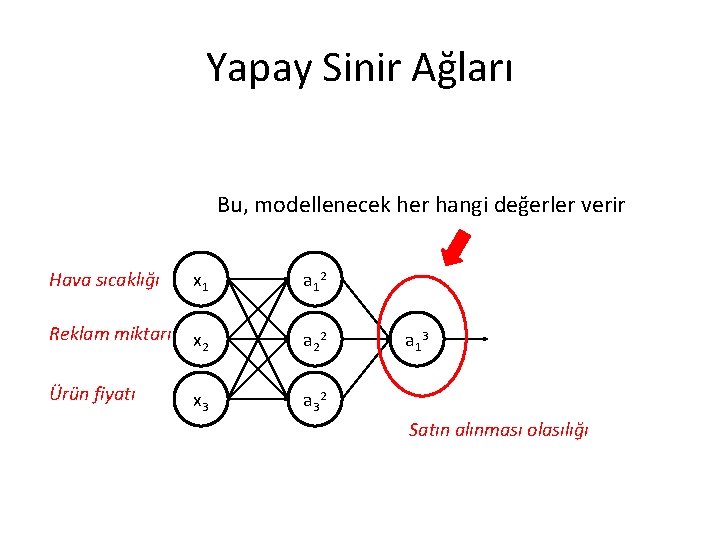

Yapay Sinir Ağları Bu, modellenecek her hangi değerler verir Hava sıcaklığı x 1 a 1 2 Reklam miktarı x 2 a 2 2 Ürün fiyatı x 3 a 3 2 a 1 3 Satın alınması olasılığı

Yapay Sinir Ağları Arasındaki katmanlara “gizli katmanlar” denir x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 Gizli katmanlar a 1 3

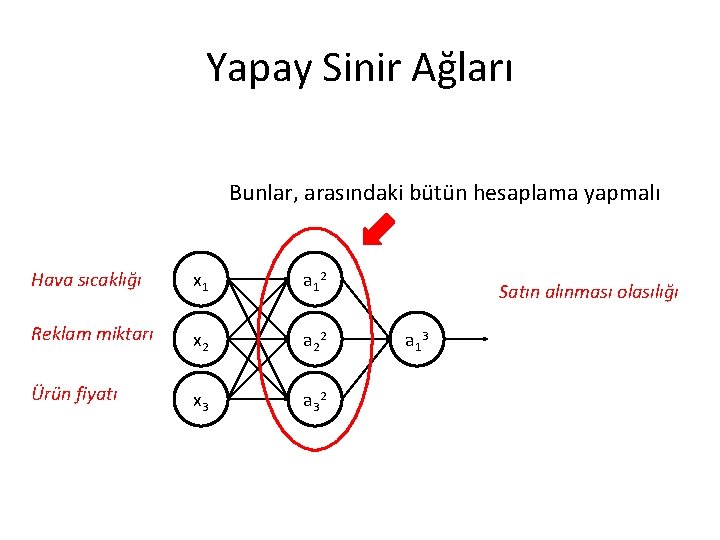

Yapay Sinir Ağları Bunlar, arasındaki bütün hesaplama yapmalı Hava sıcaklığı x 1 a 1 2 Reklam miktarı x 2 a 2 2 Ürün fiyatı x 3 a 3 2 Satın alınması olasılığı a 1 3

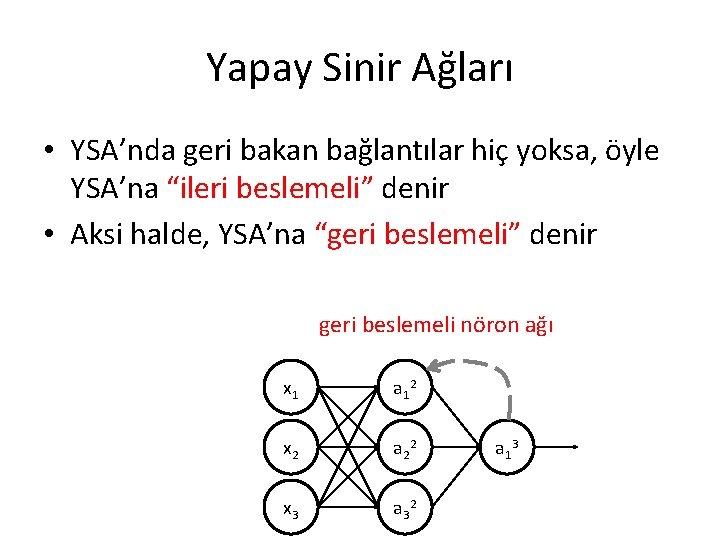

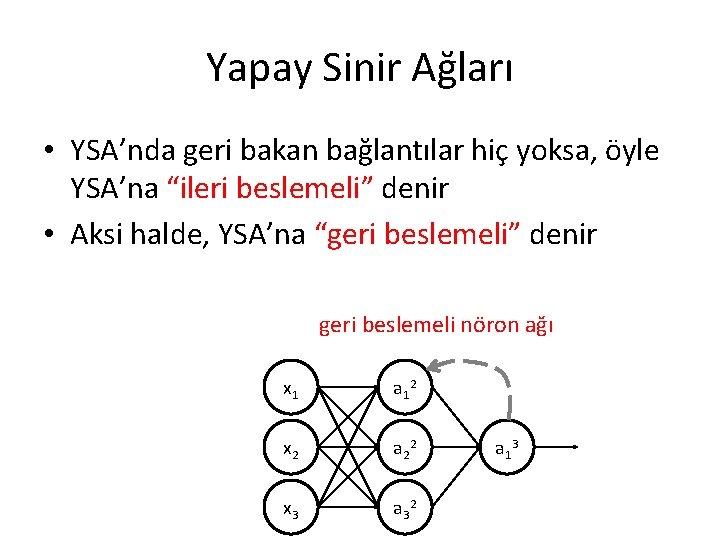

Yapay Sinir Ağları • YSA’nda geri bakan bağlantılar hiç yoksa, öyle YSA’na “ileri beslemeli” denir • Aksi halde, YSA’na “geri beslemeli” denir geri beslemeli nöron ağı x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

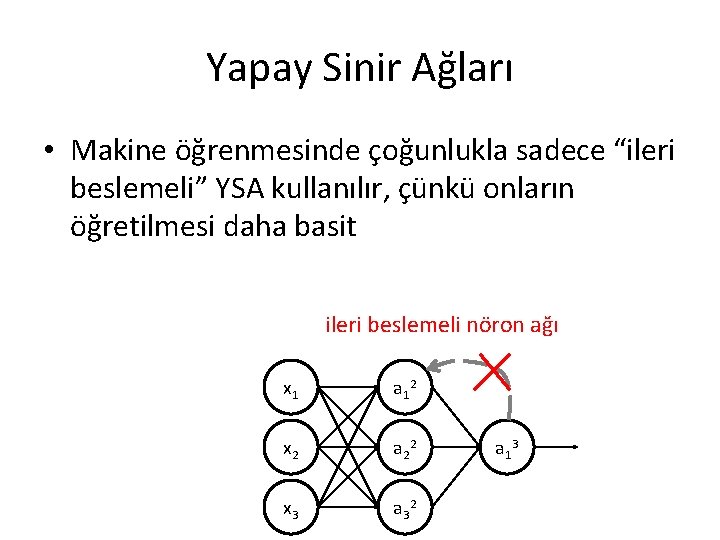

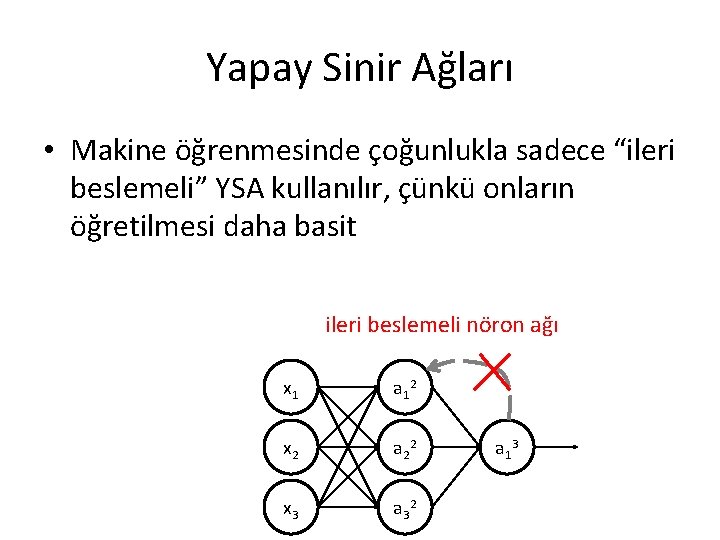

Yapay Sinir Ağları • Makine öğrenmesinde çoğunlukla sadece “ileri beslemeli” YSA kullanılır, çünkü onların öğretilmesi daha basit ileri beslemeli nöron ağı x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

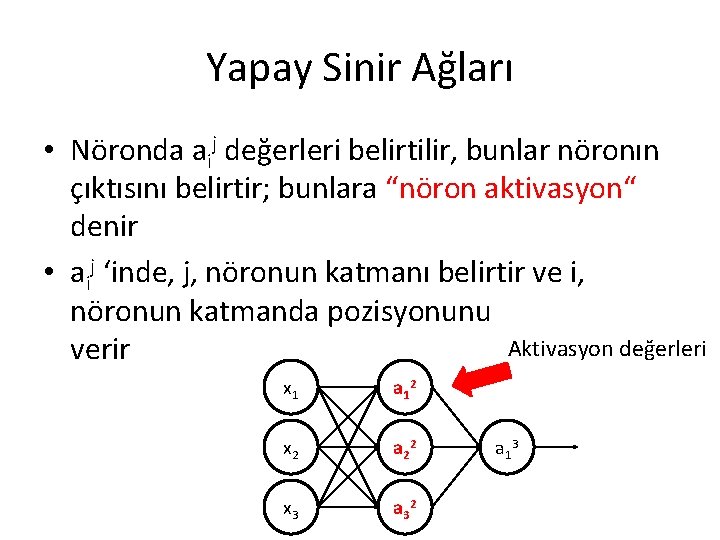

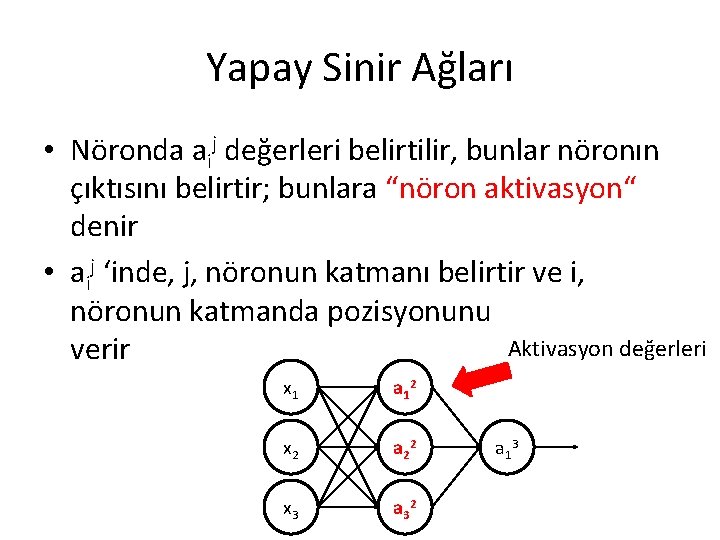

Yapay Sinir Ağları • Nöronda aij değerleri belirtilir, bunlar nöronın çıktısını belirtir; bunlara “nöron aktivasyon“ denir • aij ‘inde, j, nöronun katmanı belirtir ve i, nöronun katmanda pozisyonunu Aktivasyon değerleri verir x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

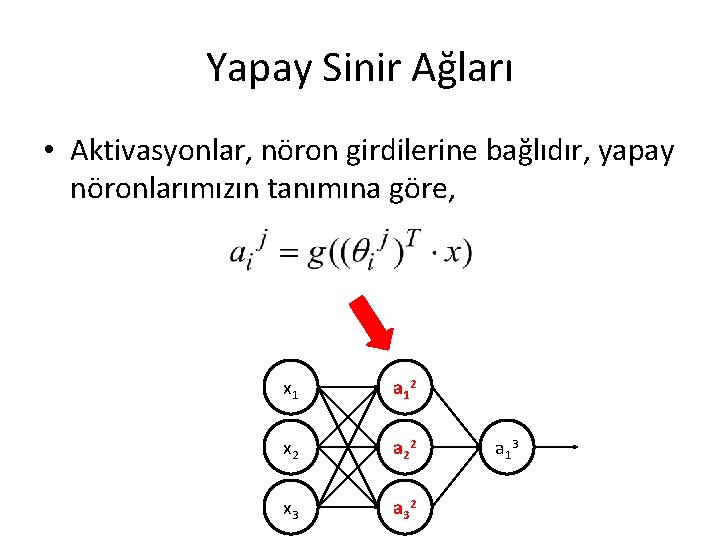

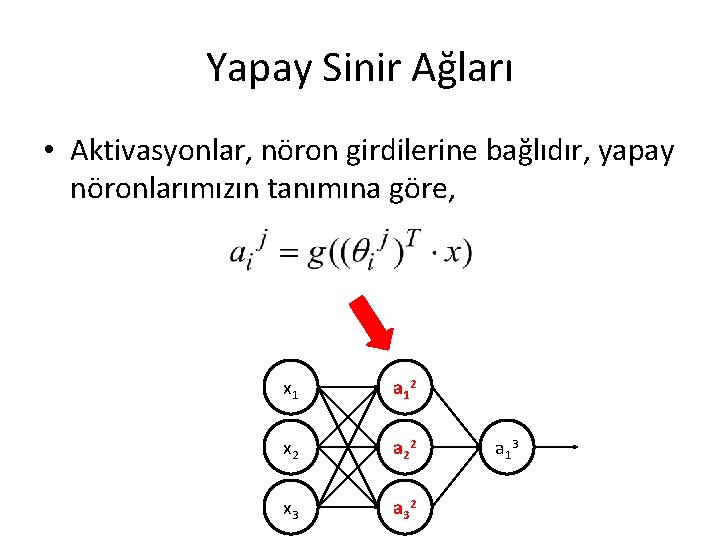

Yapay Sinir Ağları • Aktivasyonlar, nöron girdilerine bağlıdır, yapay nöronlarımızın tanımına göre, x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

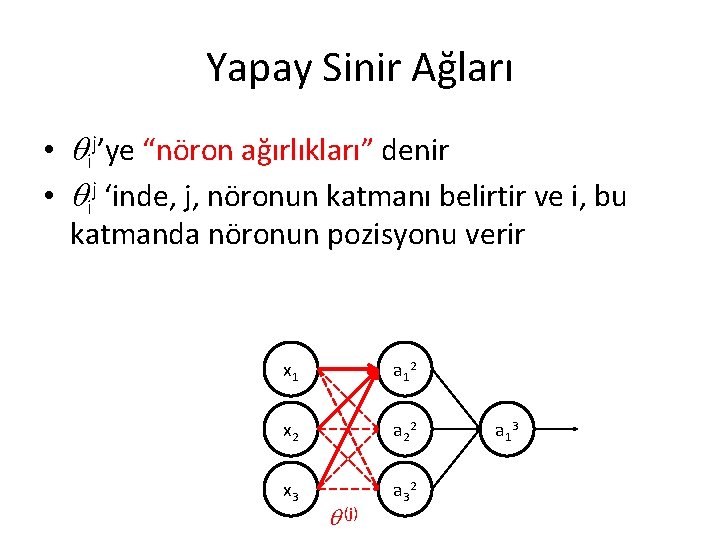

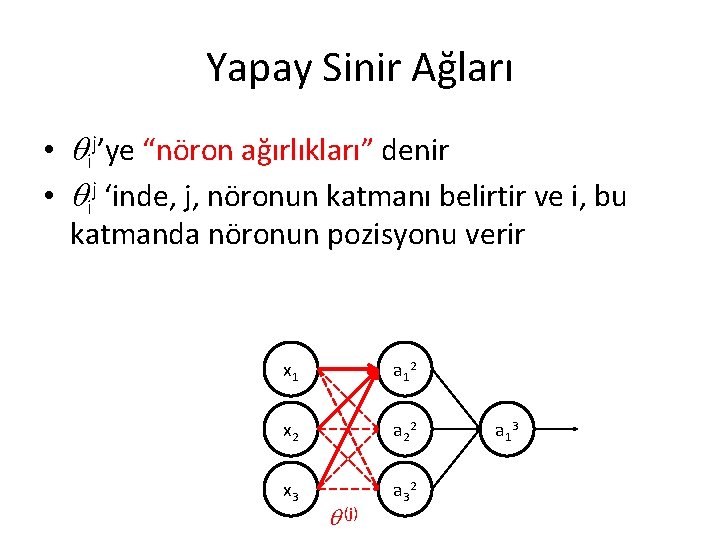

Yapay Sinir Ağları • ij’ye “nöron ağırlıkları” denir • ij ‘inde, j, nöronun katmanı belirtir ve i, bu katmanda nöronun pozisyonu verir x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 (j) a 1 3

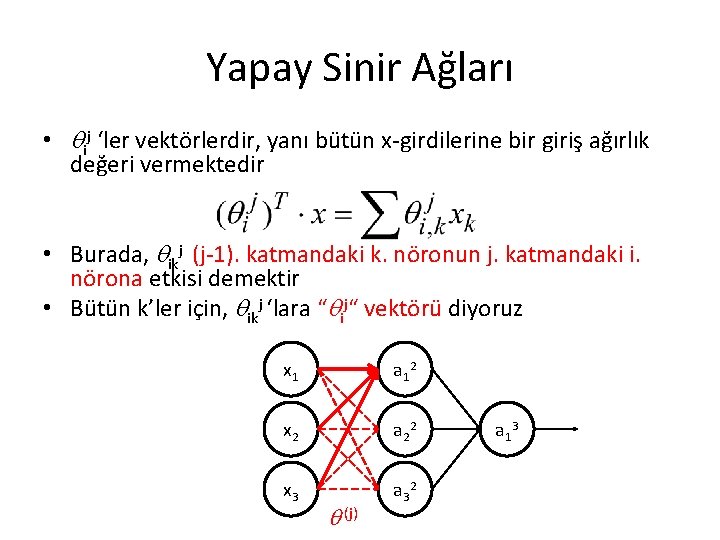

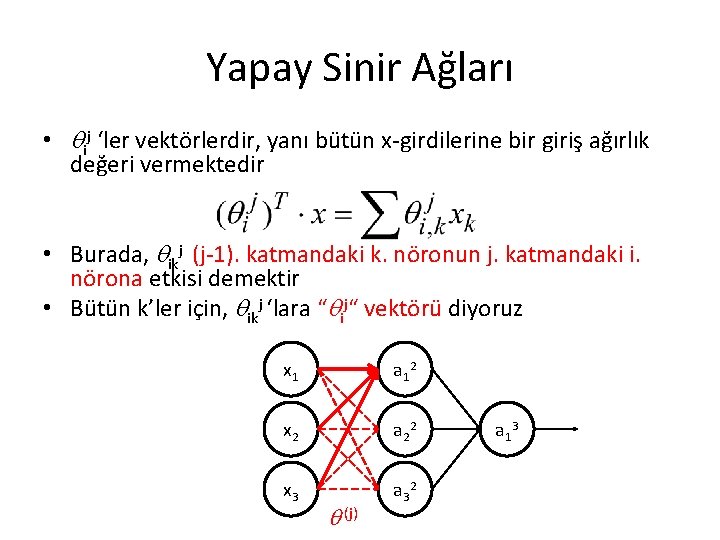

Yapay Sinir Ağları • ij ‘ler vektörlerdir, yanı bütün x-girdilerine bir giriş ağırlık değeri vermektedir • Burada, ikj (j-1). katmandaki k. nöronun j. katmandaki i. nörona etkisi demektir • Bütün k’ler için, ikj ‘lara “ ij“ vektörü diyoruz x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 (j) a 1 3

Yapay Sinir Ağları • Eğer bir j. katman ve i. nöron “ ij ” bir vektördür ise. . . • Bir j. katman için ij vektörler birlikte bir “ (j)” matriksi oluşturur • Bu matriks e “katmanın ağırlık matriksi” denir (notasyon – (j)) • Bu maktriks, katmanın bütün nöronlar için giriş ağırlıklarını belirtmektedir x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 (j) a 1 3

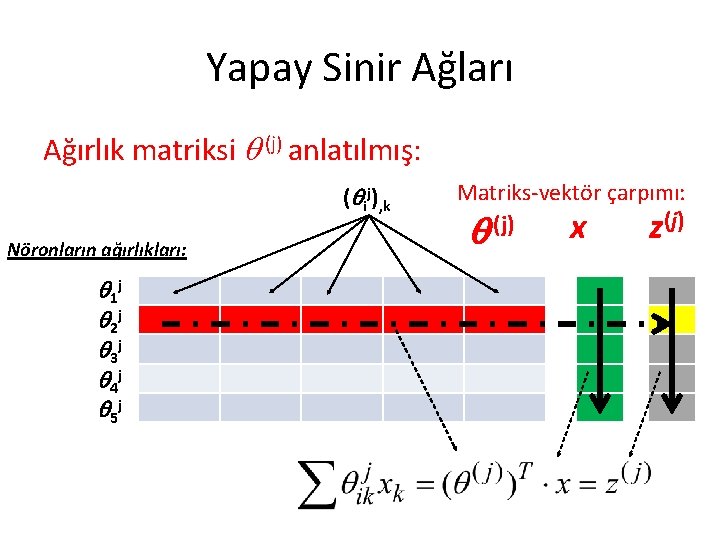

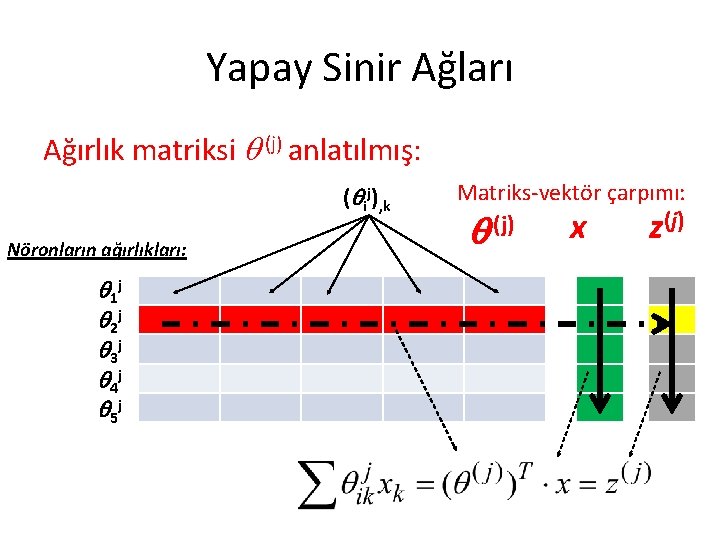

Yapay Sinir Ağları Ağırlık matriksi (j) anlatılmış: ( ij), k Nöronların ağırlıkları: 1 j 2 j 3 j 4 j 5 j Matriks-vektör çarpımı: (j) x z

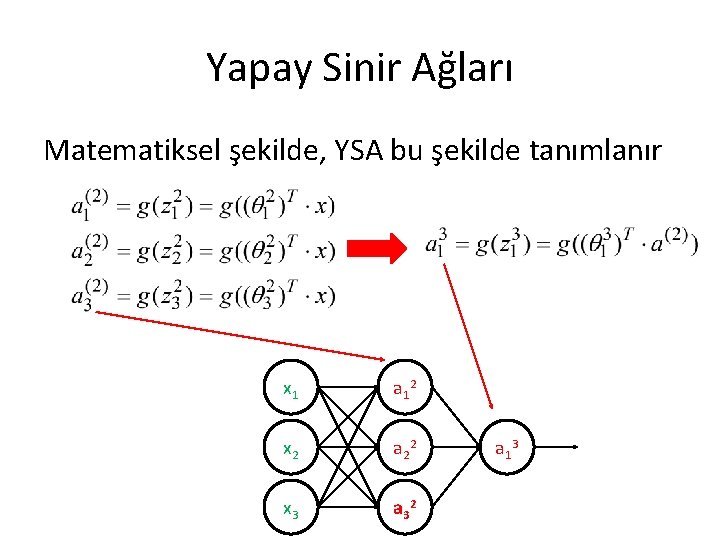

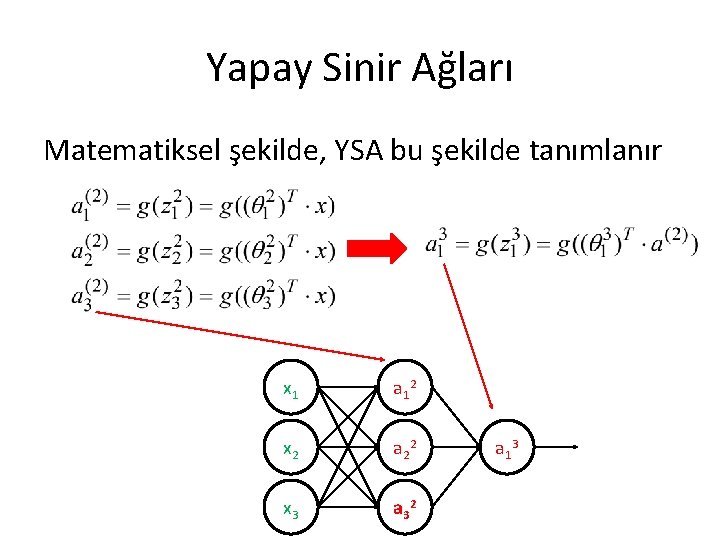

Yapay Sinir Ağları Matematiksel şekilde, YSA bu şekilde tanımlanır x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

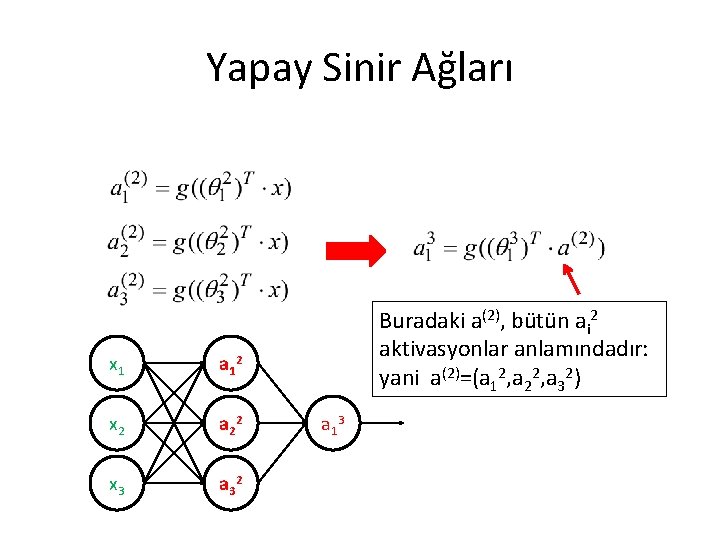

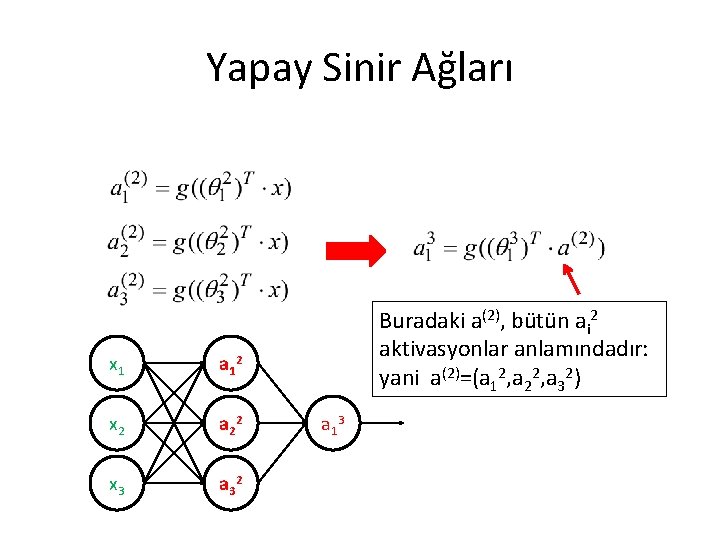

Yapay Sinir Ağları x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 Buradaki a(2), bütün ai 2 aktivasyonlar anlamındadır: yani a(2)=(a 12, a 22, a 32) a 1 3

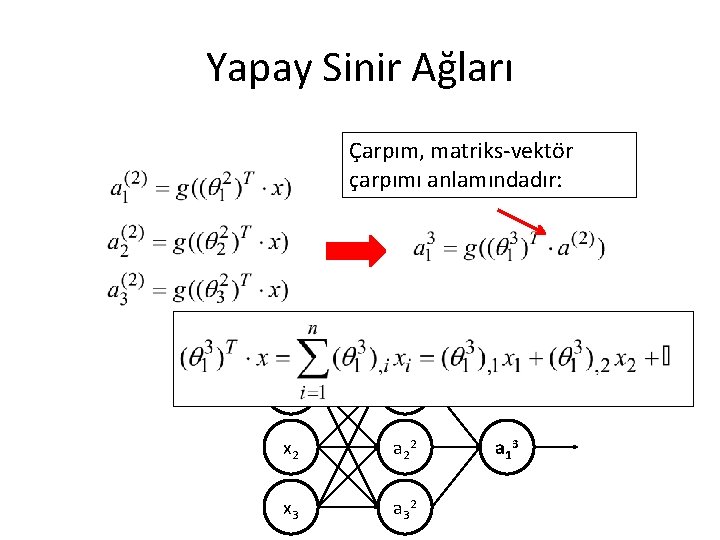

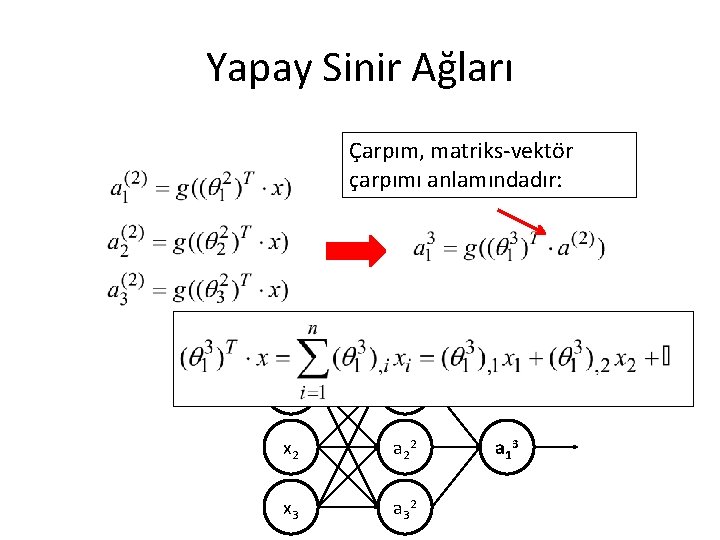

Yapay Sinir Ağları Çarpım, matriks-vektör çarpımı anlamındadır: x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

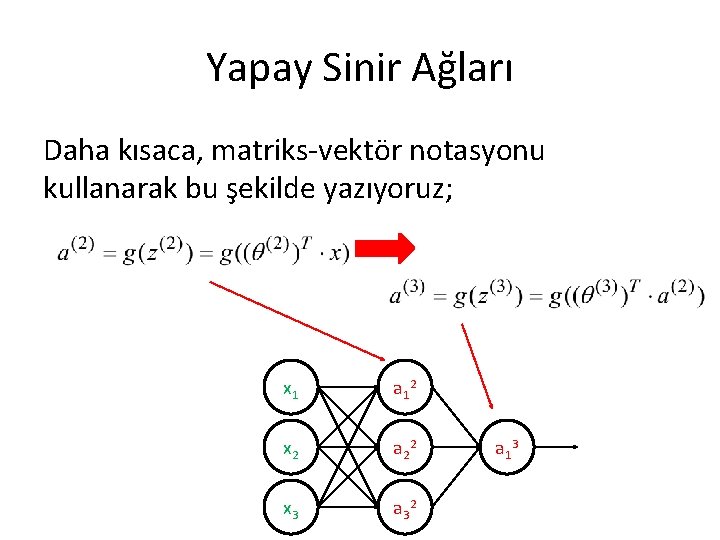

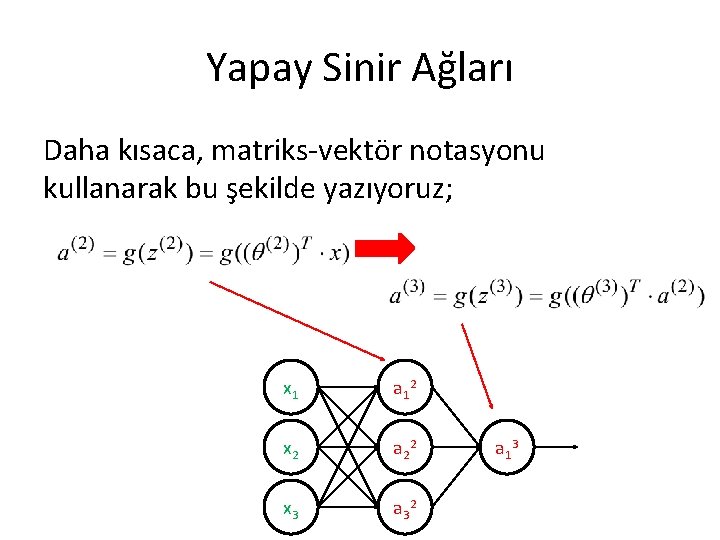

Yapay Sinir Ağları Daha kısaca, matriks-vektör notasyonu kullanarak bu şekilde yazıyoruz; x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

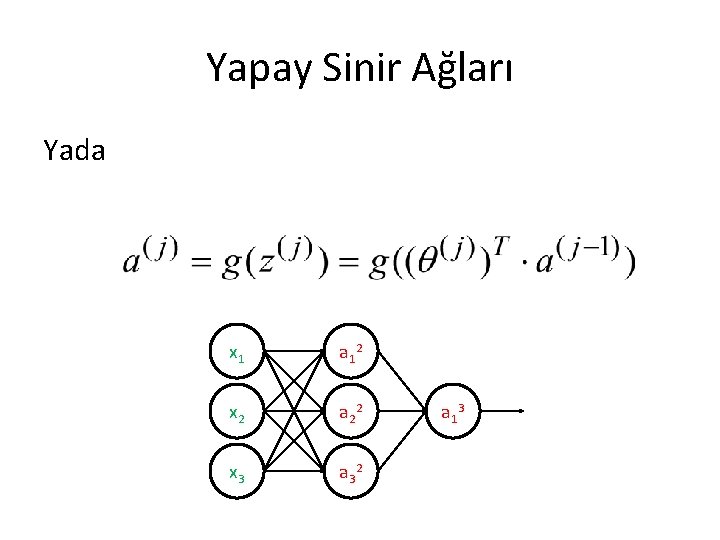

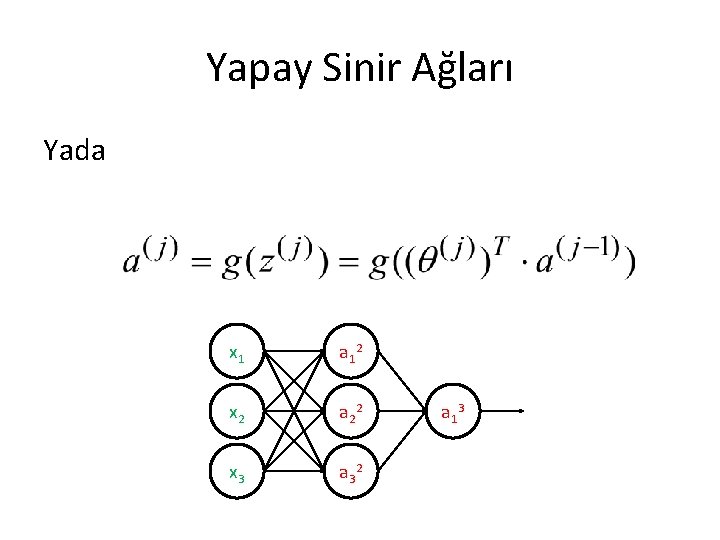

Yapay Sinir Ağları Yada x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

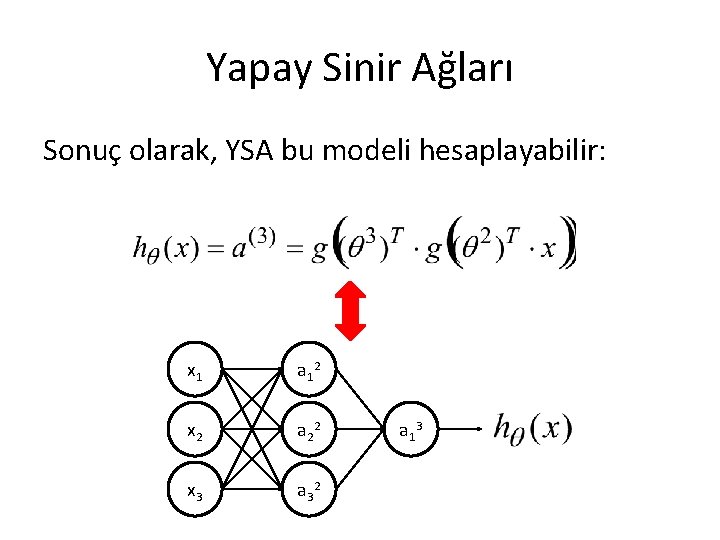

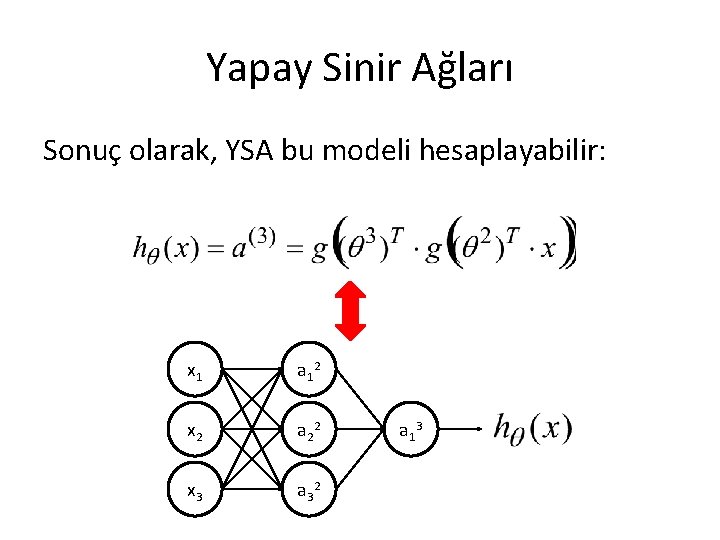

Yapay Sinir Ağları Sonuç olarak, YSA bu modeli hesaplayabilir: x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

Yapay Sinir Ağları Ø Böyle modellenebilir fonksiyonların çok karmaşık olduğu için, YSA çok esnek ve çok güçlü modelleme yaklaşımıdır x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

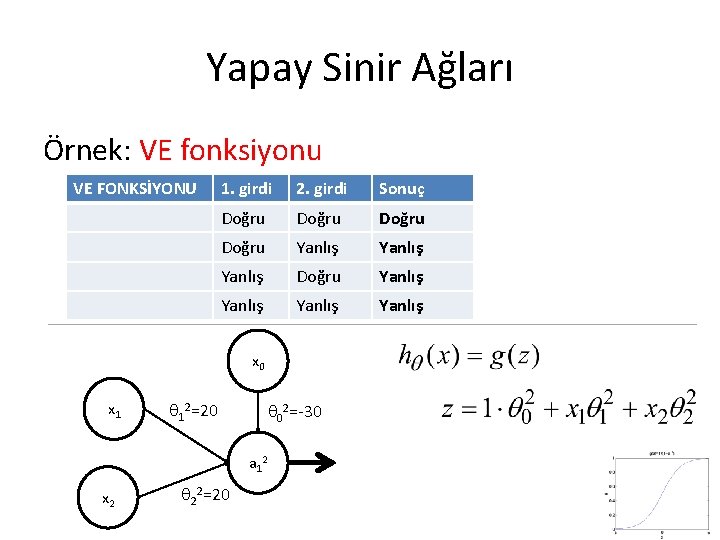

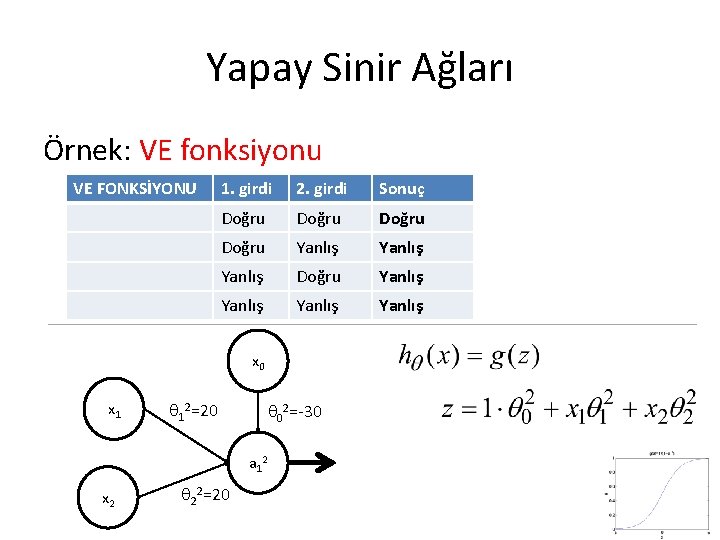

Yapay Sinir Ağları Örnek: VE fonksiyonu VE FONKSİYONU 1. girdi 2. girdi Sonuç Doğru Yanlış Doğru Yanlış

Yapay Sinir Ağları Örnek: VE fonksiyonu VE FONKSİYONU 1. girdi 2. girdi Sonuç Doğru Yanlış Doğru Yanlış x 0 x 1 12=20 02=-30 a 1 2 x 2 22=20

Yapay Sinir Ağları Örnek: VE fonksiyonu (1 katlı nöron ağı) VE FONKSİYONU 1. girdi 2. girdi Sonuç Doğru Yanlış Doğru Yanlış x 0 x 1 12=20 02=-30 a 1 2 x 2 22=20

Yapay Sinir Ağları Örnek: VE fonksiyonu VE 1. girdi 2. girdi Sonuç x 1 x 2 z h Doğru 1 1 10 1 Doğru Yanlış 1 0 -10 0 Yanlış Doğru Yanlış 0 1 -10 0 Yanlış 0 0 -30 0 x 1 12=20 02=-30 a 1 2 x 2 22=20

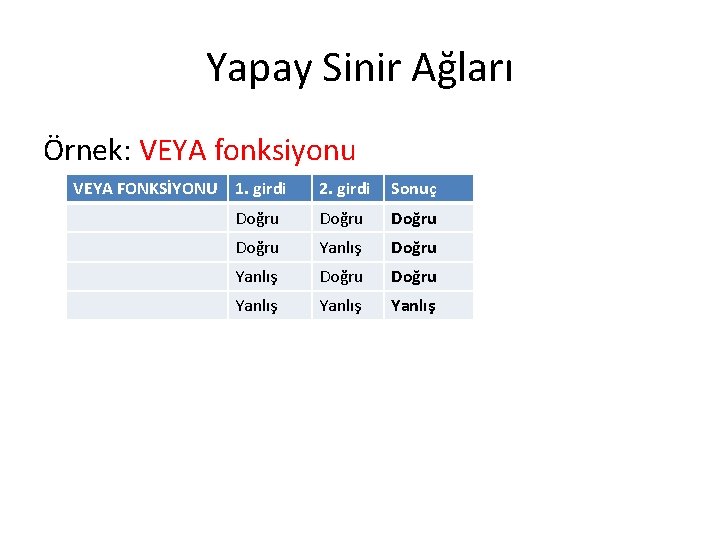

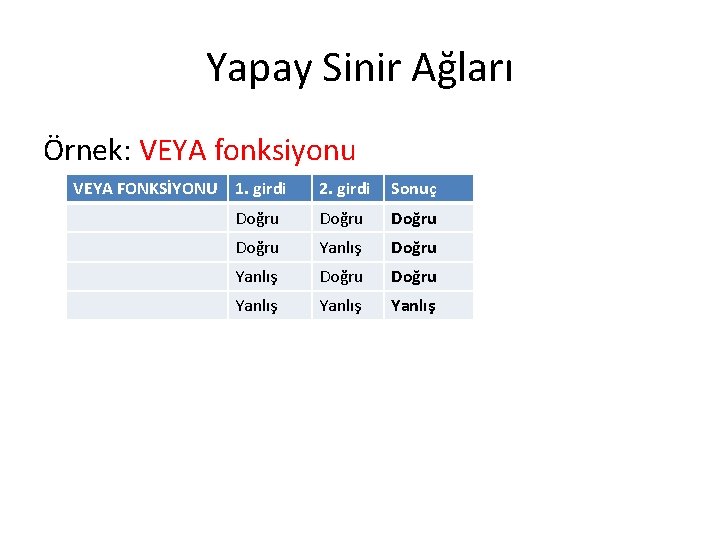

Yapay Sinir Ağları Örnek: VEYA fonksiyonu VEYA FONKSİYONU 1. girdi 2. girdi Sonuç Doğru Doğru Yanlış Yanlış

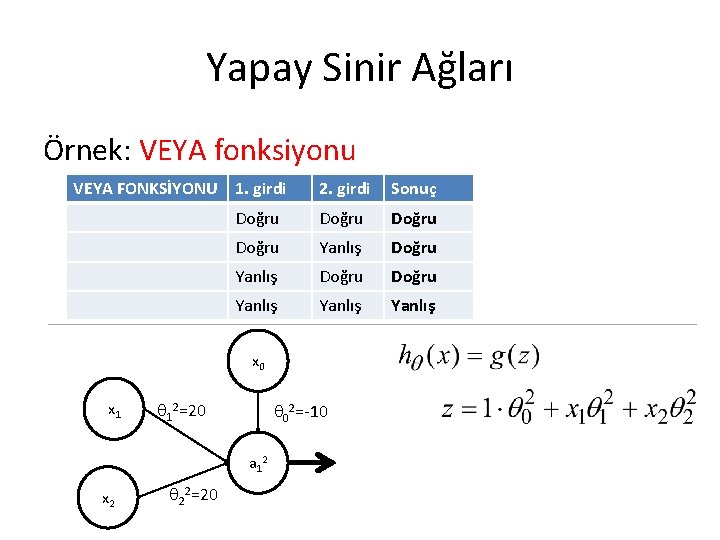

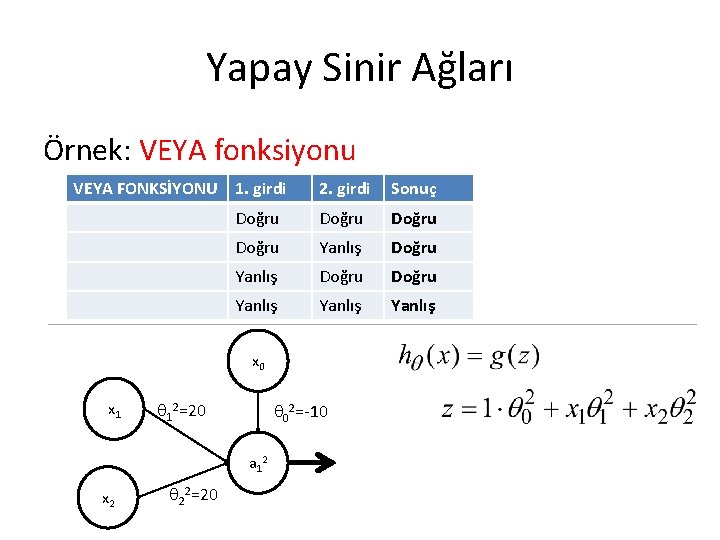

Yapay Sinir Ağları Örnek: VEYA fonksiyonu VEYA FONKSİYONU 1. girdi 2. girdi Sonuç Doğru Doğru Yanlış Yanlış x 0 x 1 12=20 02=-10 a 1 2 x 2 22=20

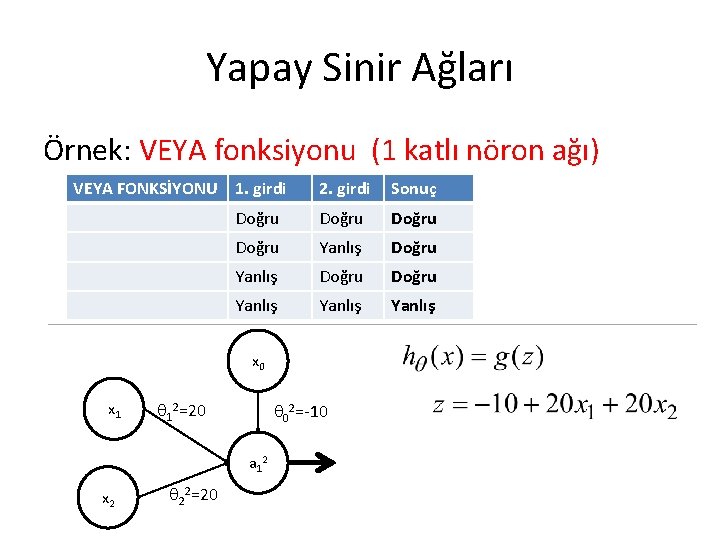

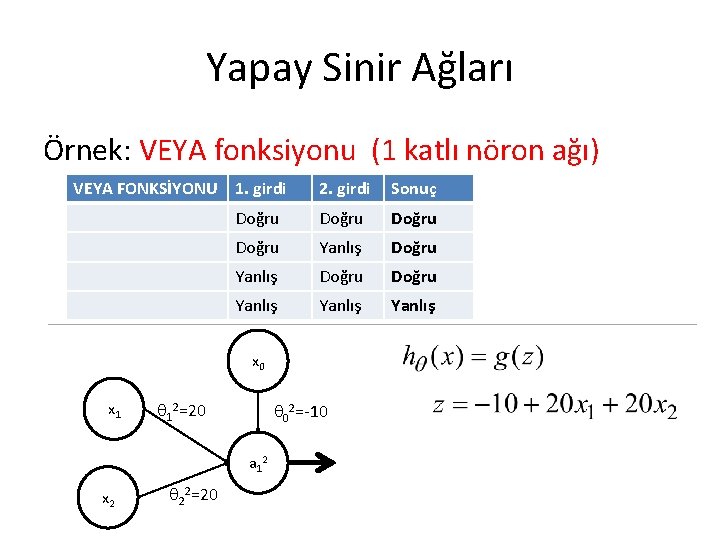

Yapay Sinir Ağları Örnek: VEYA fonksiyonu (1 katlı nöron ağı) VEYA FONKSİYONU 1. girdi 2. girdi Sonuç Doğru Doğru Yanlış Yanlış x 0 x 1 12=20 02=-10 a 1 2 x 2 22=20

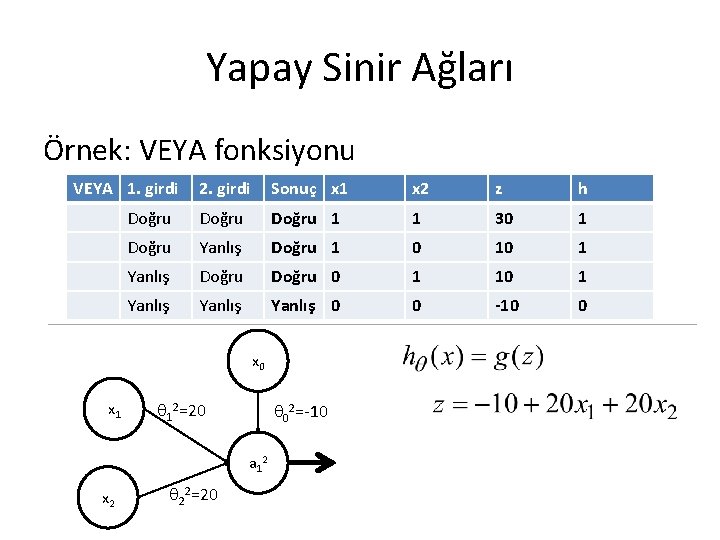

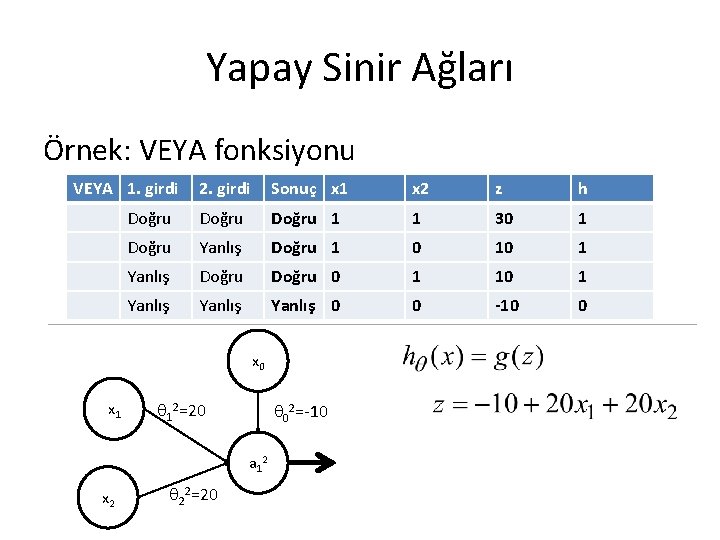

Yapay Sinir Ağları Örnek: VEYA fonksiyonu VEYA 1. girdi 2. girdi Sonuç x 1 x 2 z h Doğru 1 1 30 1 Doğru Yanlış Doğru 1 0 10 1 Yanlış Doğru 0 1 10 1 Yanlış 0 0 -10 0 x 1 12=20 02=-10 a 1 2 x 2 22=20

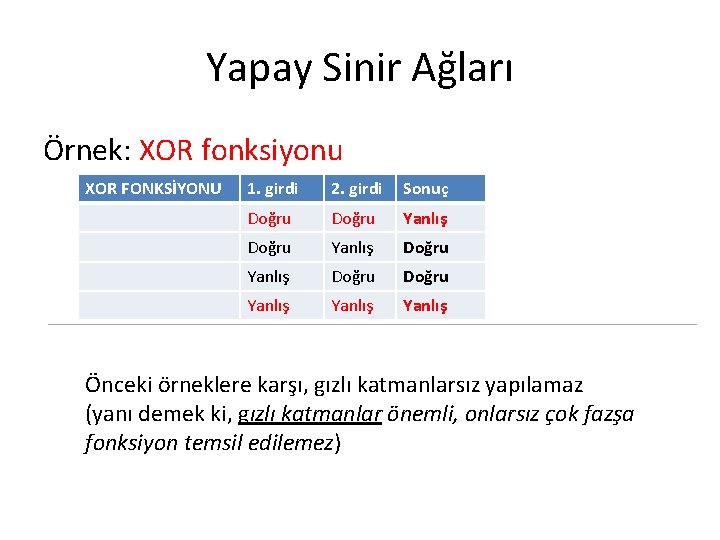

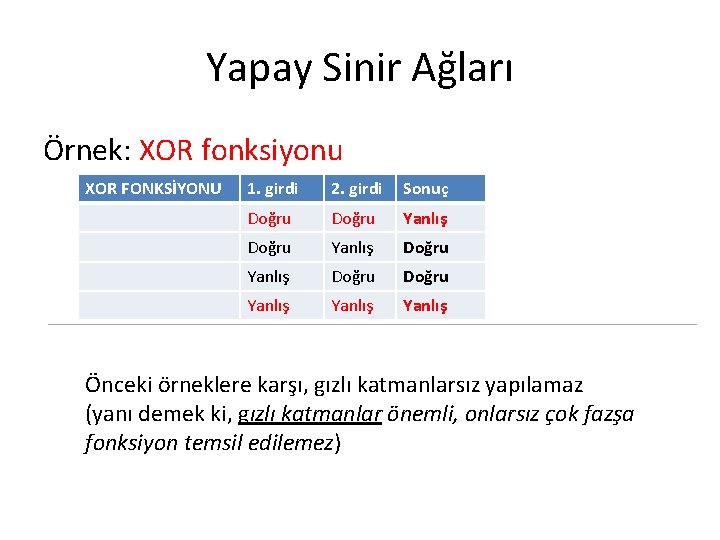

Yapay Sinir Ağları Örnek: XOR fonksiyonu XOR FONKSİYONU 1. girdi 2. girdi Sonuç Doğru Yanlış Doğru Yanlış

Yapay Sinir Ağları Örnek: XOR fonksiyonu XOR FONKSİYONU 1. girdi 2. girdi Sonuç Doğru Yanlış Doğru Yanlış Önceki örneklere karşı, gızlı katmanlarsız yapılamaz (yanı demek ki, gızlı katmanlar önemli, onlarsız çok fazşa fonksiyon temsil edilemez)

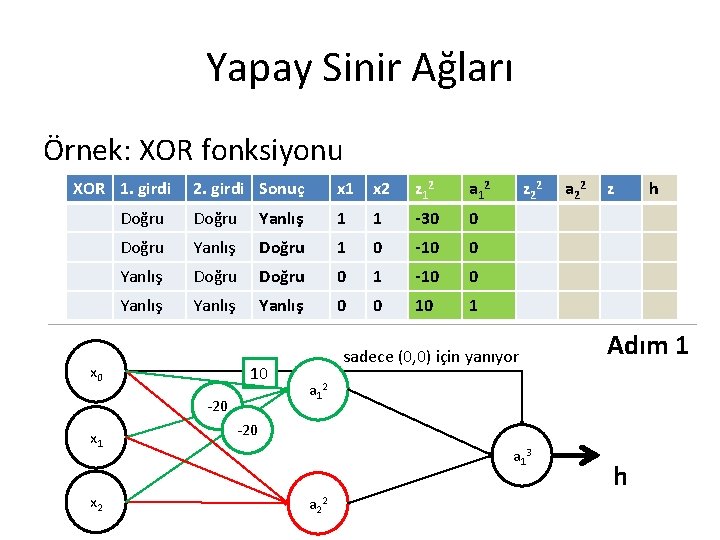

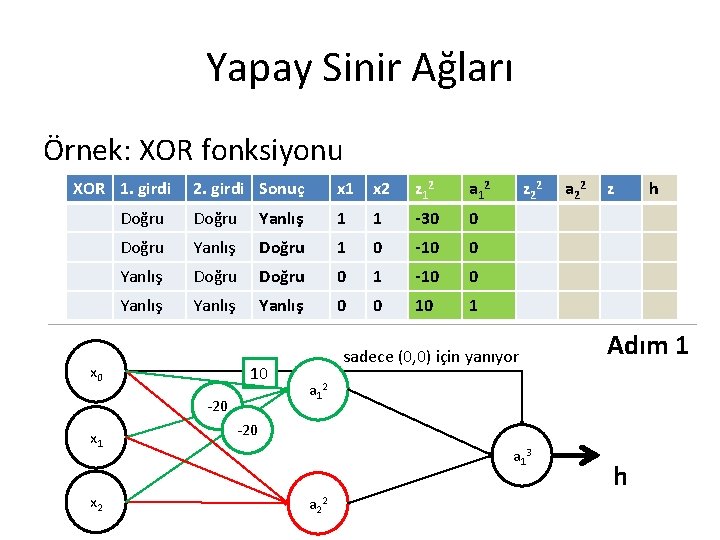

Yapay Sinir Ağları Örnek: XOR fonksiyonu XOR 1. girdi 2. girdi Sonuç x 1 x 2 z 12 a 12 Doğru Yanlış 1 1 -30 0 Doğru Yanlış Doğru 1 0 -10 0 Yanlış Doğru 0 1 -10 0 Yanlış 0 0 10 1 x 0 10 -20 x 1 x 2 z 22 sadece (0, 0) için yanıyor a 22 z Adım 1 a 1 2 -20 a 1 3 a 2 2 h h

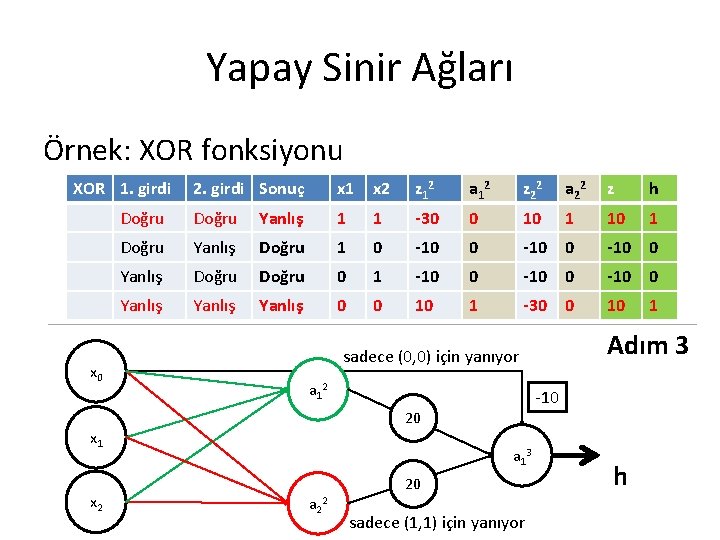

Yapay Sinir Ağları Örnek: XOR fonksiyonu XOR 1. girdi 2. girdi Sonuç x 1 x 2 z 12 a 12 z 22 a 22 Doğru Yanlış 1 1 -30 0 10 1 Doğru Yanlış Doğru 1 0 -10 0 Yanlış Doğru 0 1 -10 0 Yanlış 0 0 10 1 -30 0 sadece (0, 0) için yanıyor x 0 a 1 3 -30 20 20 a 2 2 sadece (1, 1) için yanıyor h Adım 2 a 1 2 x 1 x 2 z h

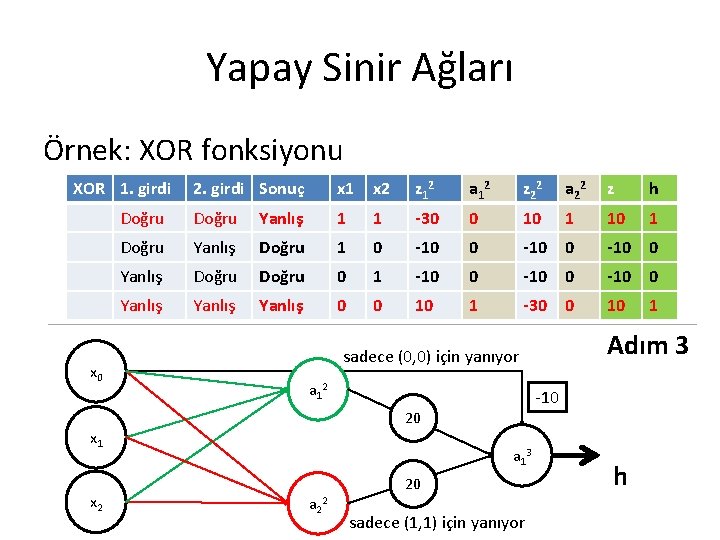

Yapay Sinir Ağları Örnek: XOR fonksiyonu XOR 1. girdi x 0 2. girdi Sonuç x 1 x 2 z 12 a 12 z 22 a 22 z h Doğru Yanlış 1 1 -30 0 10 1 Doğru Yanlış Doğru 1 0 -10 0 Yanlış Doğru 0 1 -10 0 Yanlış 0 0 10 1 -30 0 10 1 a 1 2 -10 20 x 1 x 2 Adım 3 sadece (0, 0) için yanıyor a 1 3 a 2 2 20 sadece (1, 1) için yanıyor h

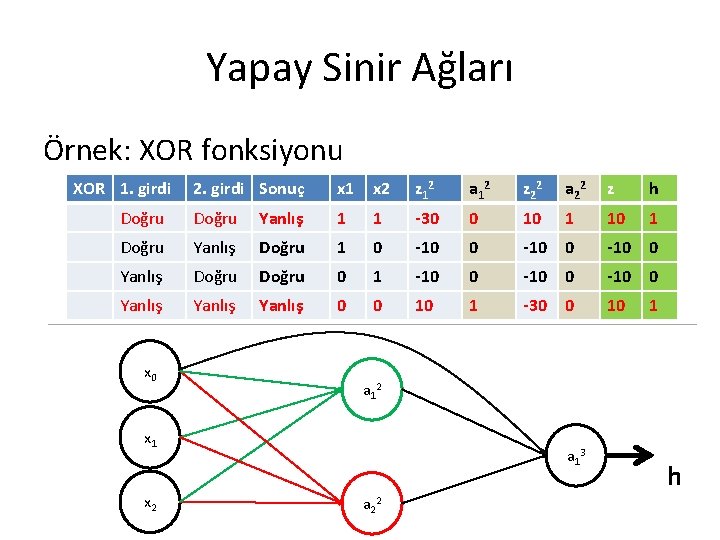

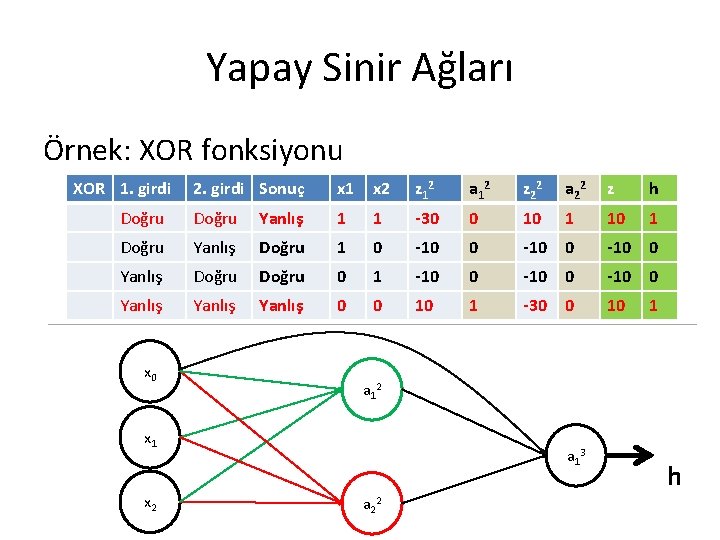

Yapay Sinir Ağları Örnek: XOR fonksiyonu XOR 1. girdi 2. girdi Sonuç x 1 x 2 z 12 a 12 z 22 a 22 z h Doğru Yanlış 1 1 -30 0 10 1 Doğru Yanlış Doğru 1 0 -10 0 Yanlış Doğru 0 1 -10 0 Yanlış 0 0 10 1 -30 0 10 1 x 0 a 1 2 x 1 x 2 a 1 3 a 2 2 h

Yapay Sinir Ağları Ø YSA’ları, karmaşık lineer olmayan fonksiyonlar temsil eder ve birçok esnek parametre içerir Ø Bu nedenle, YSA’ları direkt olarak lineer olmayan aynı zamanda esnek ve bu nedenle güçlü genel modelleme yaklaşımıdır x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

Yapay Sinir Ağları • Paramtreler doğru şekilde nasıl seçilir • Parametreler bulmak için, dereceli azaltma yada benzer optimizasyon metodu kullanılabilir • Maliyet fonksiyonu için, lojistik regresyon maliyeti kullanılabilir (son ders)

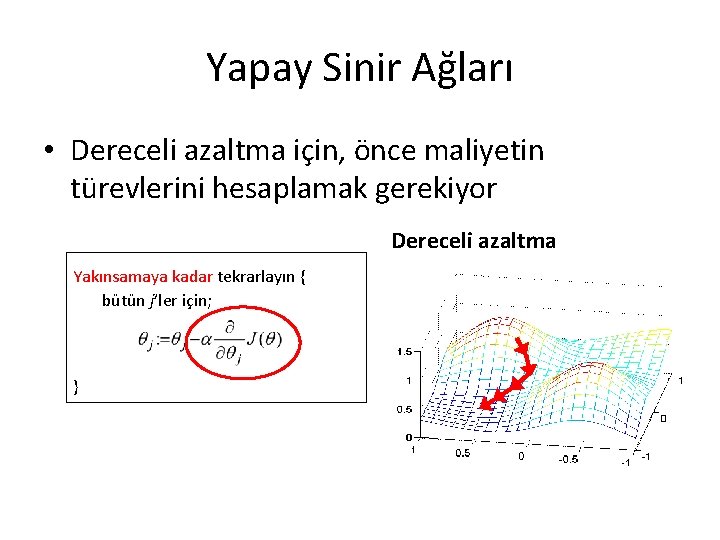

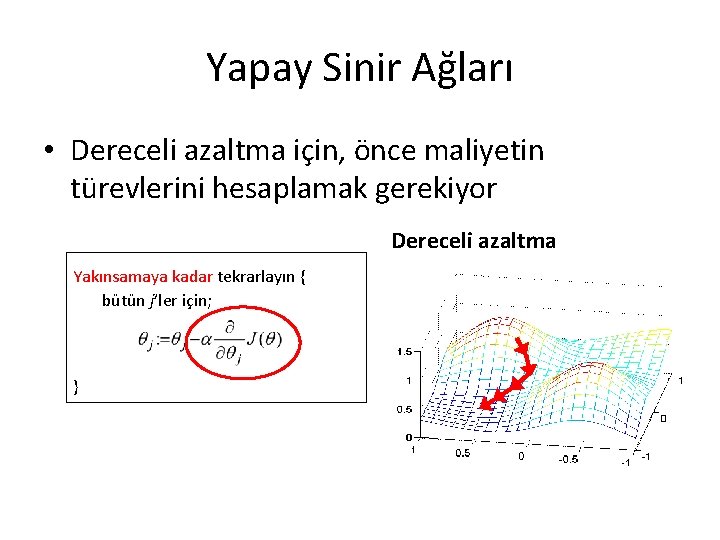

Yapay Sinir Ağları • Dereceli azaltma için, önce maliyetin türevlerini hesaplamak gerekiyor Dereceli azaltma Yakınsamaya kadar tekrarlayın { bütün j’ler için; }

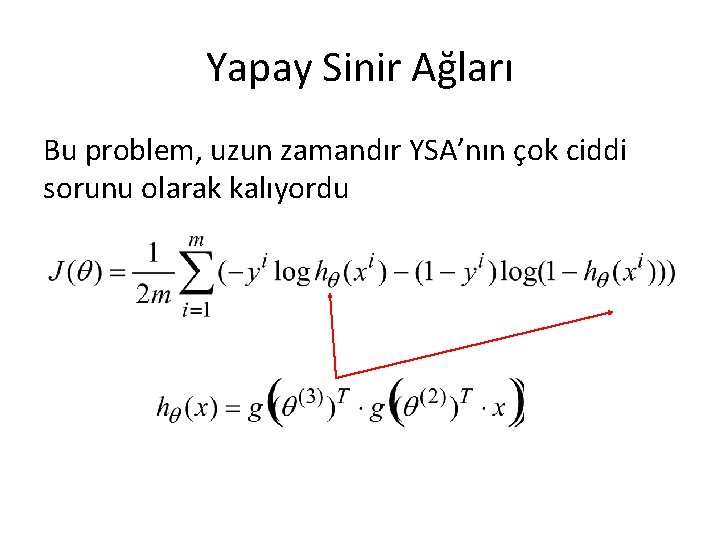

Yapay Sinir Ağları Ama “h ” çok karmaşık, ve bu türevleri kolay değil

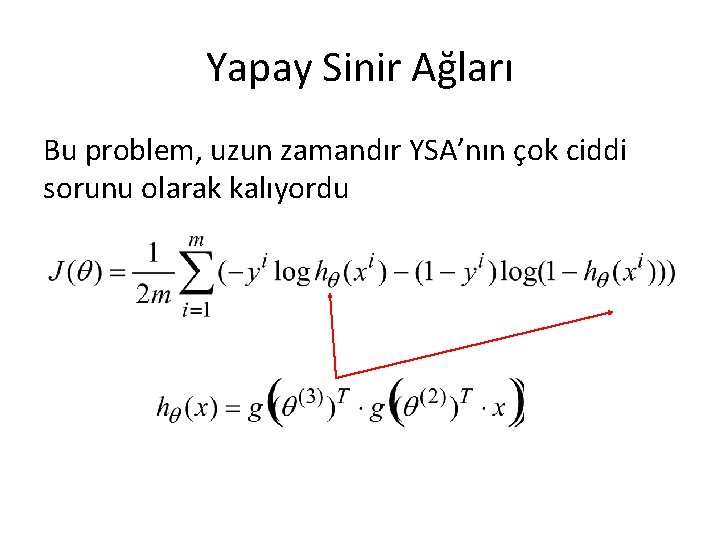

Yapay Sinir Ağları Bu problem, uzun zamandır YSA’nın çok ciddi sorunu olarak kalıyordu

Yapay Sinir Ağları Geri yayılım algoritması, bu türevleri verimli şekilde hesaplamak için 1974’te sunulmuş oldu

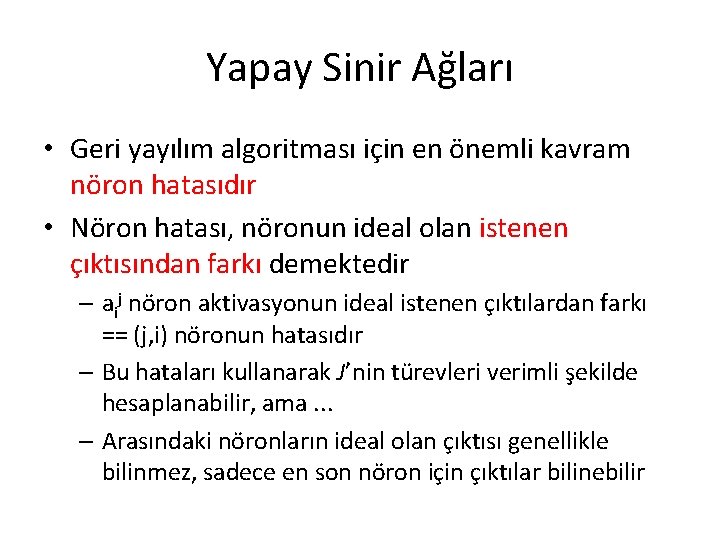

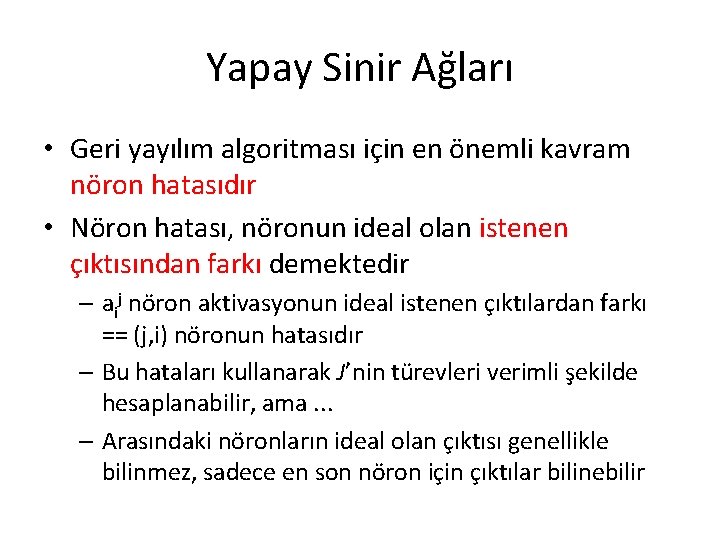

Yapay Sinir Ağları • Geri yayılım algoritması için en önemli kavram nöron hatasıdır • Nöron hatası, nöronun ideal olan istenen çıktısından farkı demektedir – aij nöron aktivasyonun ideal istenen çıktılardan farkı == (j, i) nöronun hatasıdır – Bu hataları kullanarak J’nin türevleri verimli şekilde hesaplanabilir, ama. . . – Arasındaki nöronların ideal olan çıktısı genellikle bilinmez, sadece en son nöron için çıktılar bilinebilir

Yapay Sinir Ağları • Ana problemi: hatalar başından sadece son (çıkış) nöron için bilinebilir (çıkış nöronlardan ne istediğimiz bilinir) • Sadece bu nöronlar için hataları açıkca belirtilebilir (yani modellenecek verinin örnekleri kullanarak çıkış nöronların hataları tahmin edilebilir)

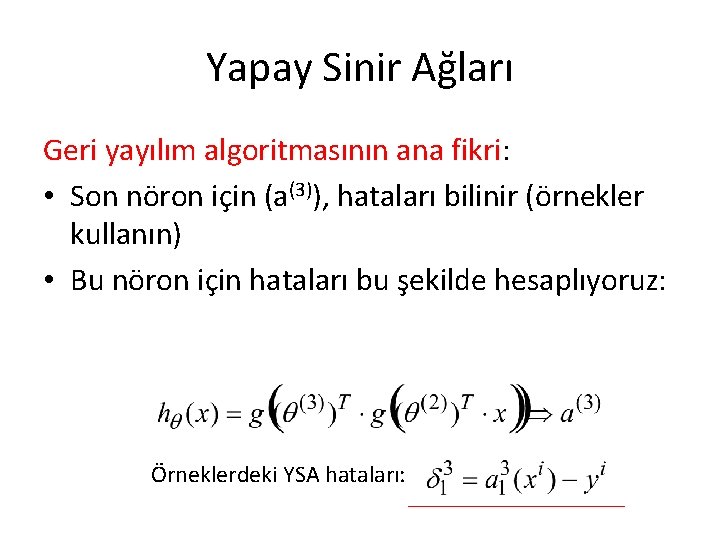

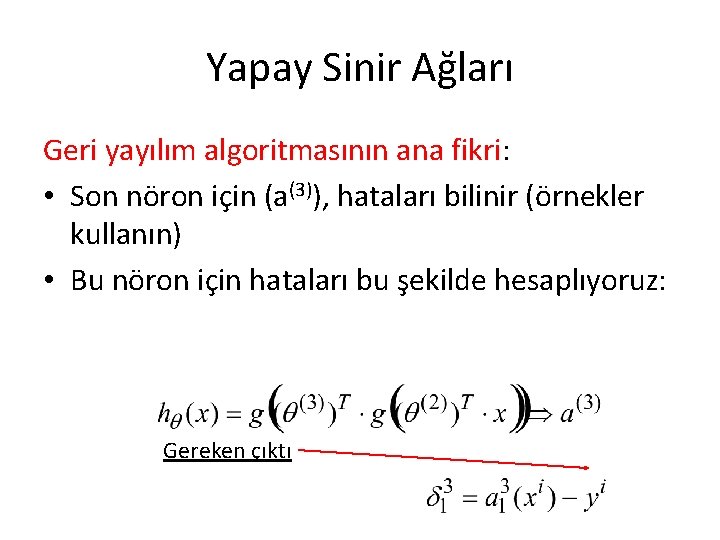

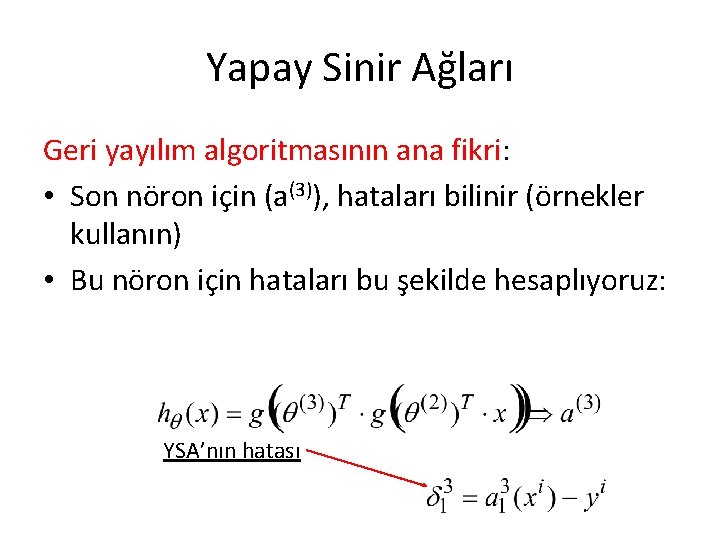

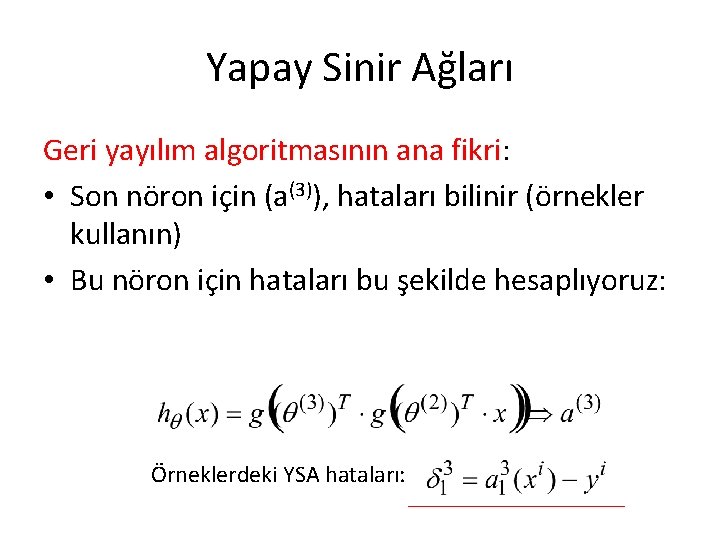

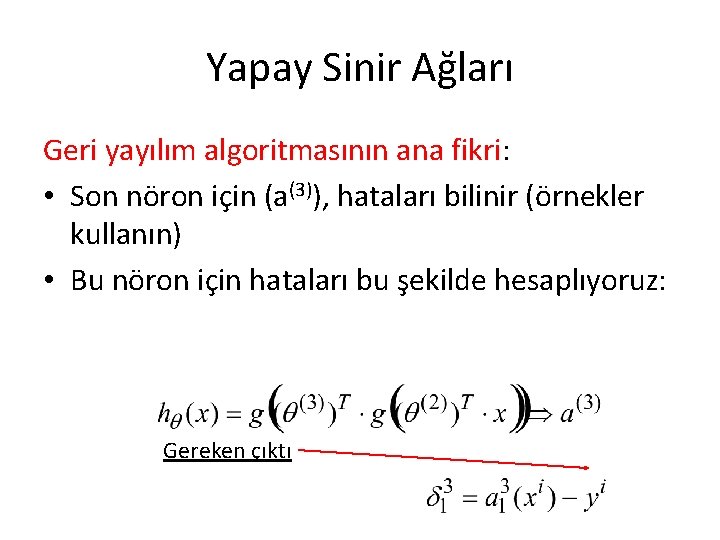

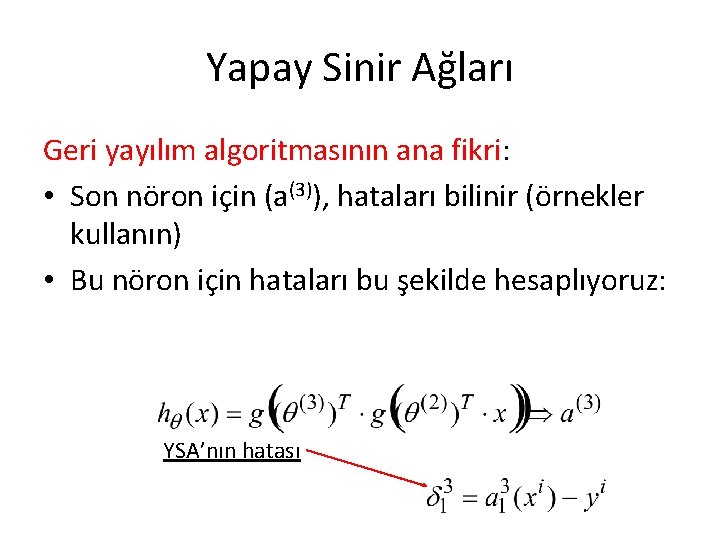

Yapay Sinir Ağları Geri yayılım algoritmasının ana fikri: • Son nöron için (a(3)), hataları bilinir (örnekler kullanın) • Bu nöron için hataları bu şekilde hesaplıyoruz: Örneklerdeki YSA hataları:

Yapay Sinir Ağları Geri yayılım algoritmasının ana fikri: • Son nöron için (a(3)), hataları bilinir (örnekler kullanın) • Bu nöron için hataları bu şekilde hesaplıyoruz: Bu bir örnek idi

Yapay Sinir Ağları Geri yayılım algoritmasının ana fikri: • Son nöron için (a(3)), hataları bilinir (örnekler kullanın) • Bu nöron için hataları bu şekilde hesaplıyoruz: Gereken çıktı

Yapay Sinir Ağları Geri yayılım algoritmasının ana fikri: • Son nöron için (a(3)), hataları bilinir (örnekler kullanın) • Bu nöron için hataları bu şekilde hesaplıyoruz: YSA’ndan alınmış çıktı

Yapay Sinir Ağları Geri yayılım algoritmasının ana fikri: • Son nöron için (a(3)), hataları bilinir (örnekler kullanın) • Bu nöron için hataları bu şekilde hesaplıyoruz: YSA’nın hatası

Yapay Sinir Ağları • Gızlı elemanlar için hataları bilmiyoruz. . . ? x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3 OK

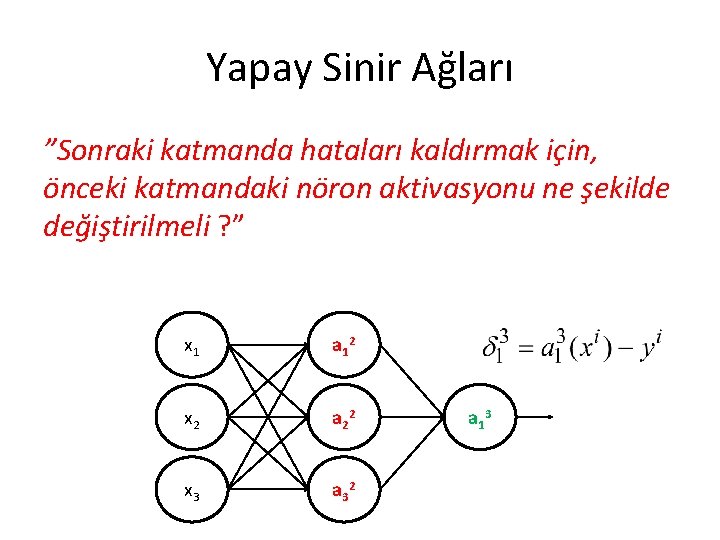

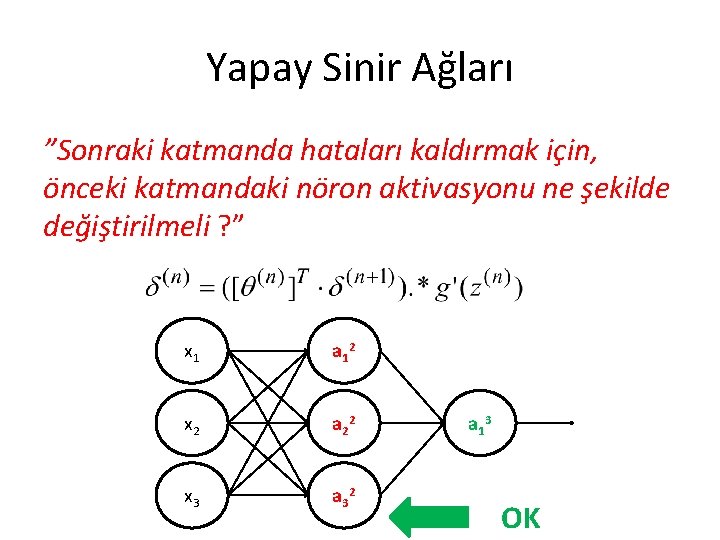

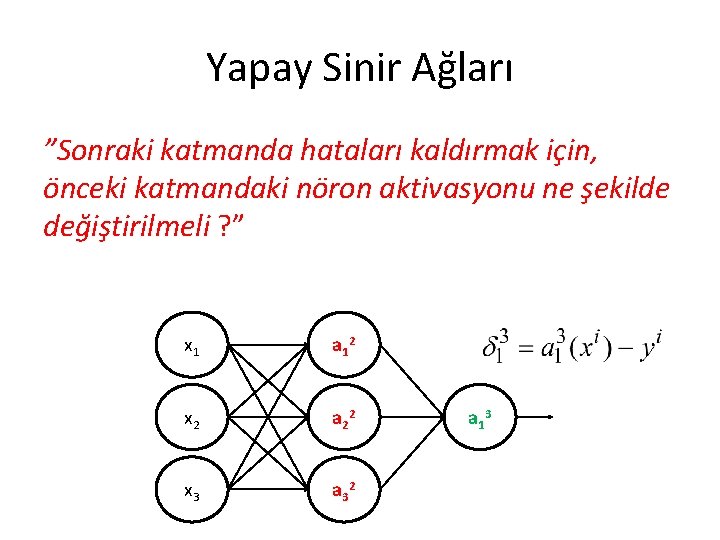

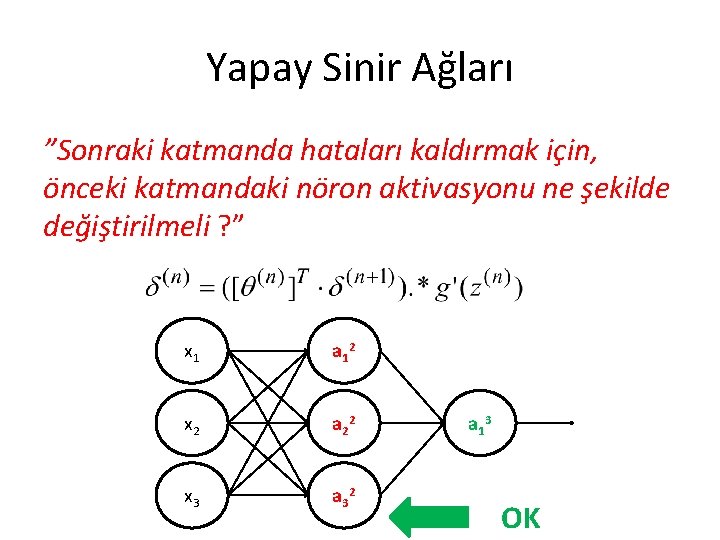

Yapay Sinir Ağları ”Sonraki katmanda hataları kaldırmak için, önceki katmandaki nöron aktivasyonu ne şekilde değiştirilmeli ? ” x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

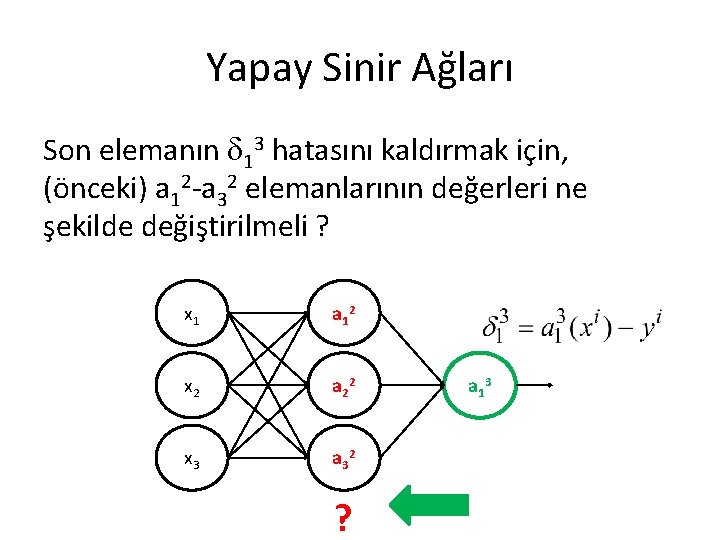

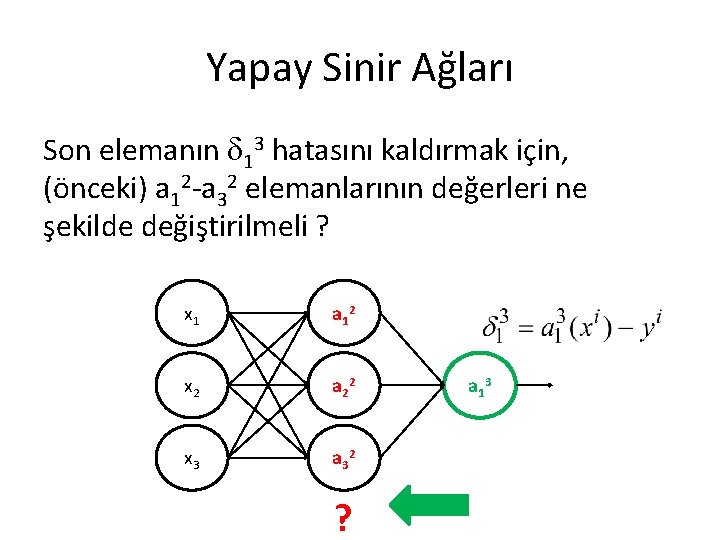

Yapay Sinir Ağları Son elemanın 13 hatasını kaldırmak için, (önceki) a 12 -a 32 elemanlarının değerleri ne şekilde değiştirilmeli ? x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 ? a 1 3

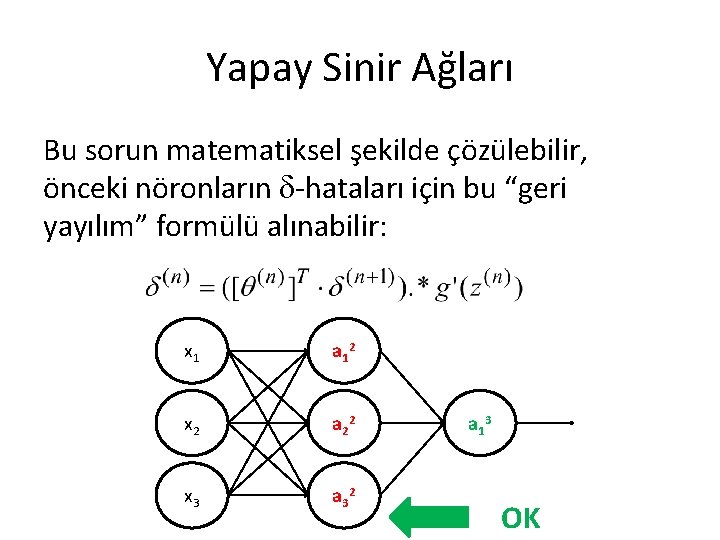

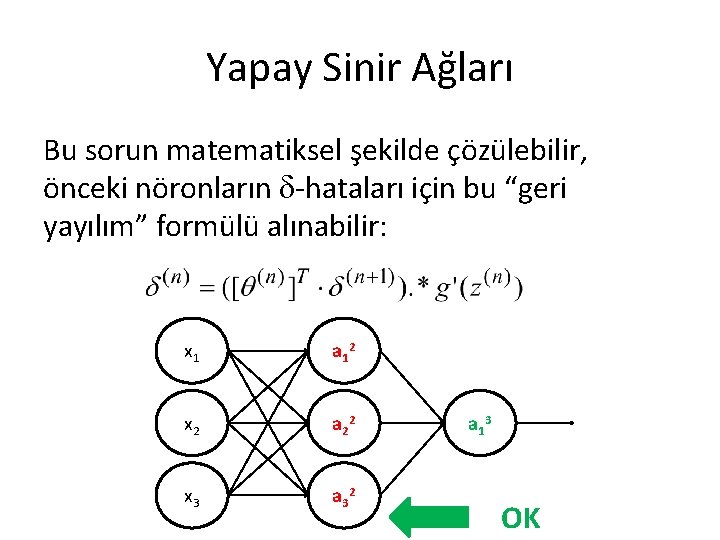

Yapay Sinir Ağları Bu sorun matematiksel şekilde çözülebilir, önceki nöronların -hataları için bu “geri yayılım” formülü alınabilir: x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3 OK

Yapay Sinir Ağları ”Sonraki katmanda hataları kaldırmak için, önceki katmandaki nöron aktivasyonu ne şekilde değiştirilmeli ? ” x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3 OK

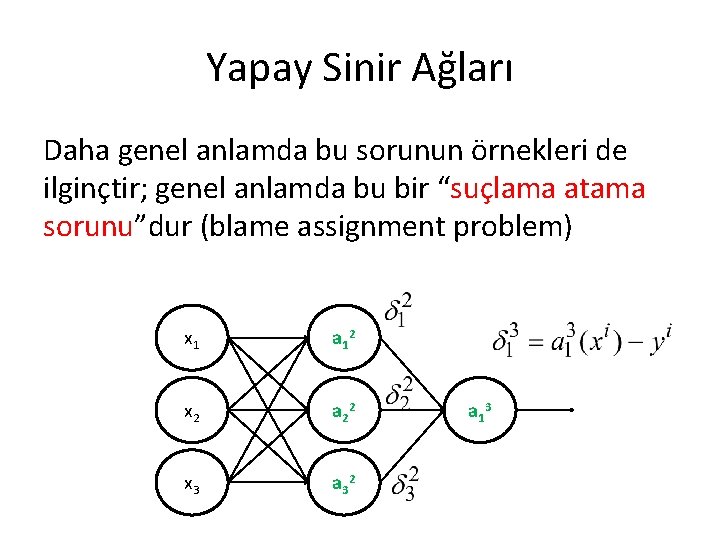

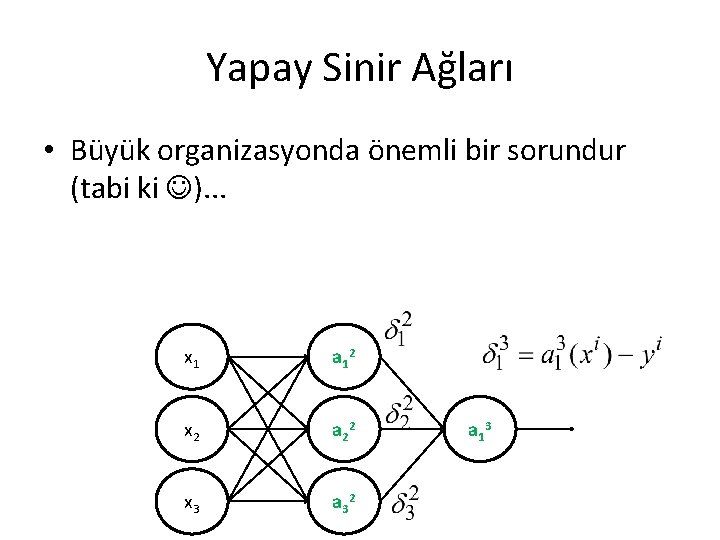

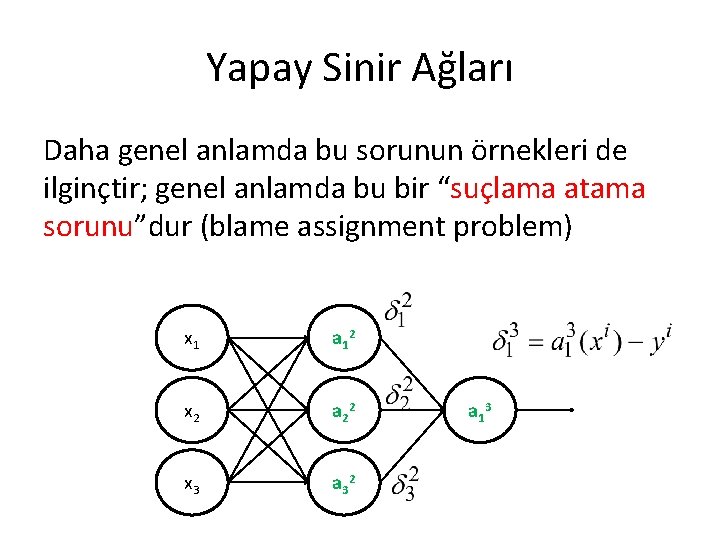

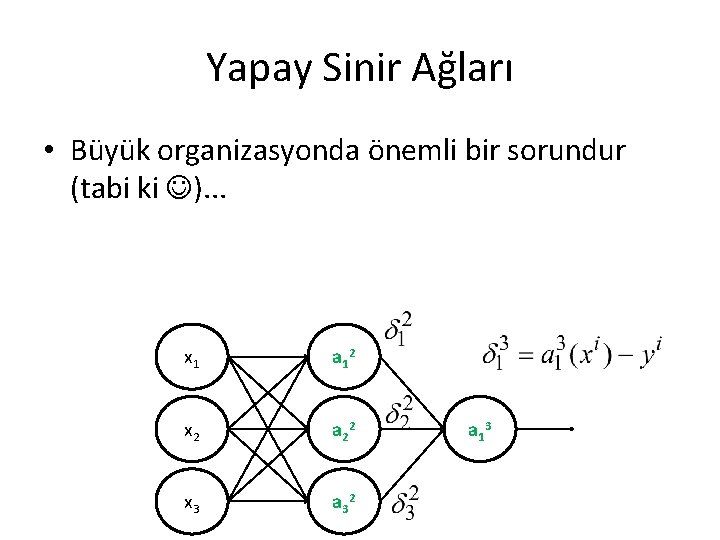

Yapay Sinir Ağları Daha genel anlamda bu sorunun örnekleri de ilginçtir; genel anlamda bu bir “suçlama atama sorunu”dur (blame assignment problem) x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

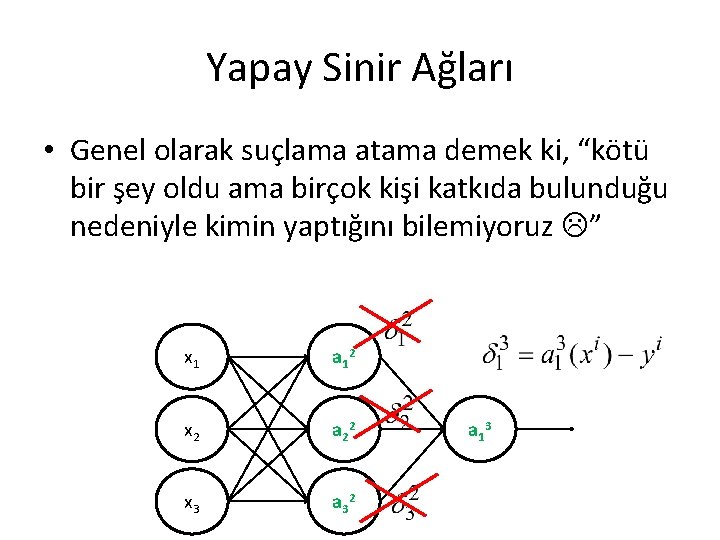

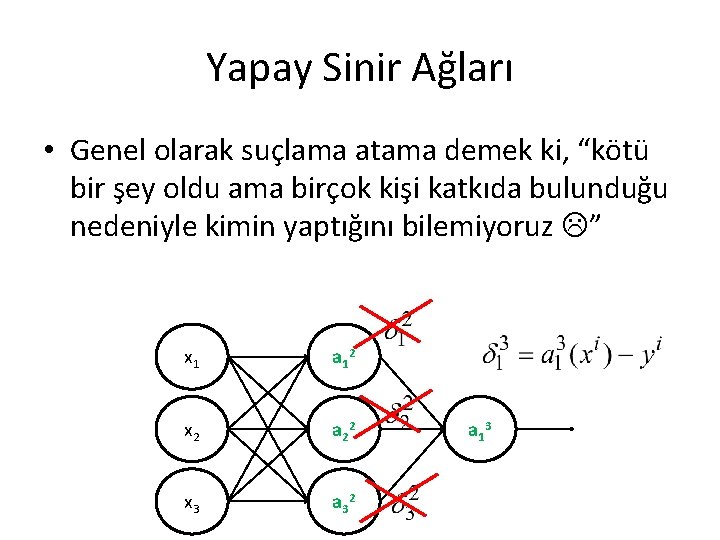

Yapay Sinir Ağları • Genel olarak suçlama atama demek ki, “kötü bir şey oldu ama birçok kişi katkıda bulunduğu nedeniyle kimin yaptığını bilemiyoruz ” x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

Yapay Sinir Ağları • Büyük organizasyonda önemli bir sorundur (tabi ki ). . . x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

Yapay Sinir Ağları • Örnek: bir şirkette ürün çok kötü kalitede bulunmakta, ama. . .

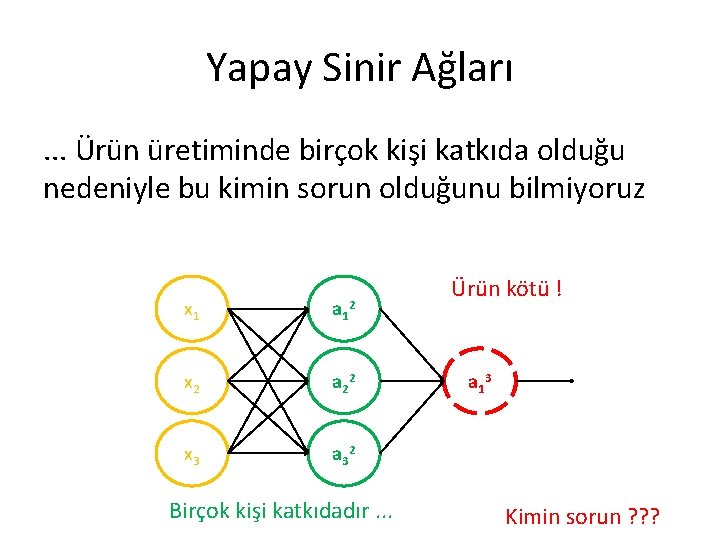

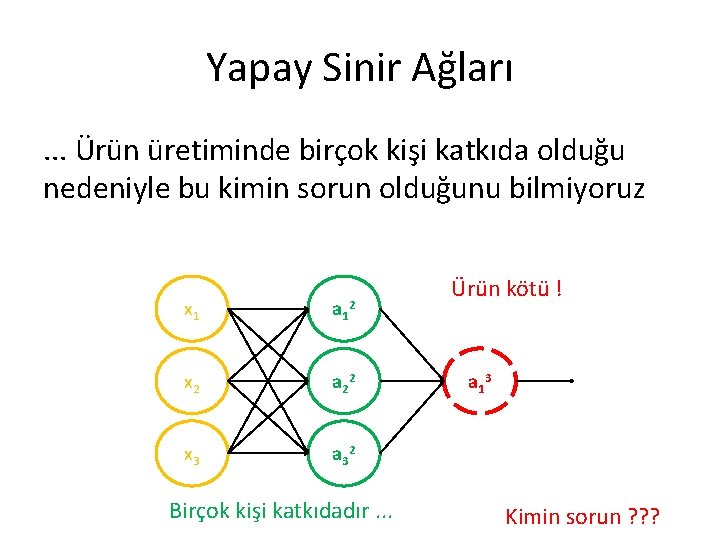

Yapay Sinir Ağları. . . Ürün üretiminde birçok kişi katkıda olduğu nedeniyle bu kimin sorun olduğunu bilmiyoruz x 1 a 1 x 2 a 2 2 x 3 a 3 2 2 Birçok kişi katkıdadır. . . Ürün kötü ! a 1 3 Kimin sorun ? ? ?

Yapay Sinir Ağları. . . Ürün üretiminde birçok kişi katkıda olduğu nedeniyle bu kimin sorun olduğunu bilmiyoruz x 1 a 1 x 2 a 2 2 x 3 a 3 2 2 Ürün kötü ! Suçlama atama sorunu Birçok kişi katkıdadır. . . a 1 3 Kimin sorun ? ? ?

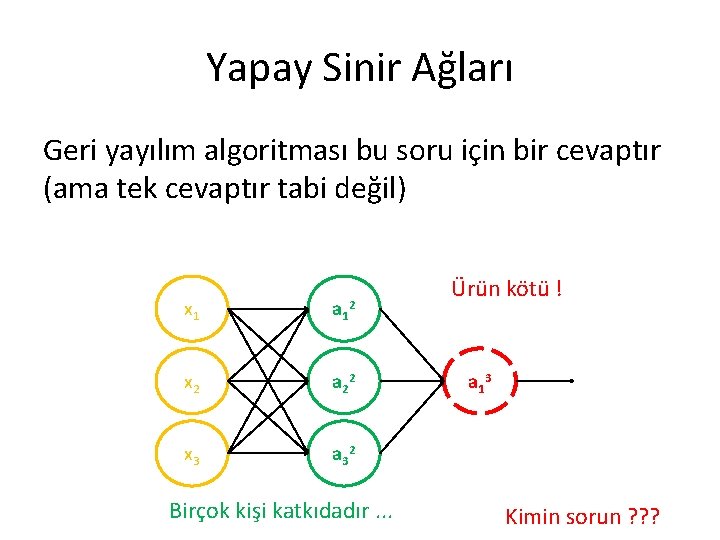

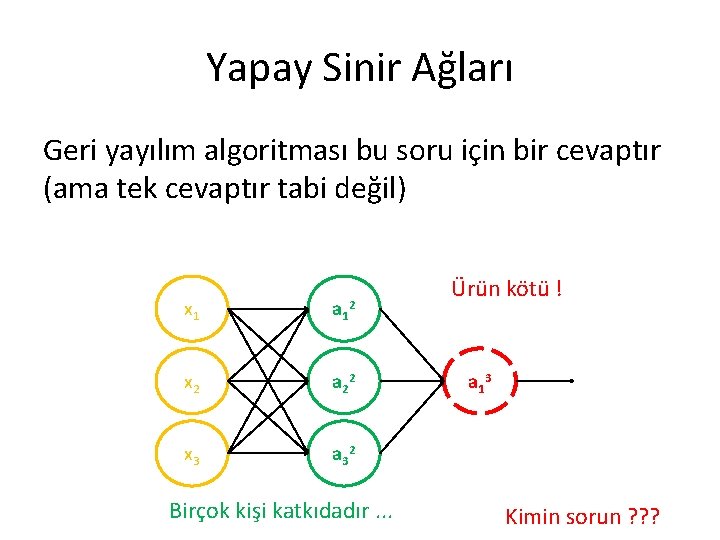

Yapay Sinir Ağları Geri yayılım algoritması bu soru için bir cevaptır (ama tek cevaptır tabi değil) x 1 a 1 x 2 a 2 2 x 3 a 3 2 2 Birçok kişi katkıdadır. . . Ürün kötü ! a 1 3 Kimin sorun ? ? ?

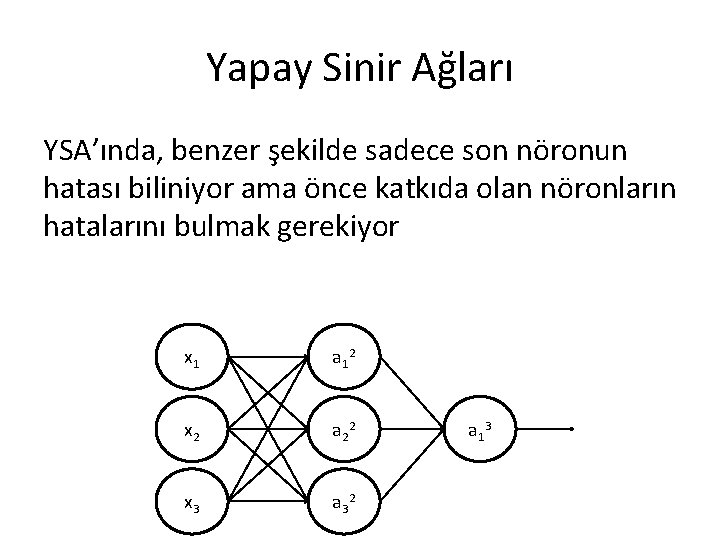

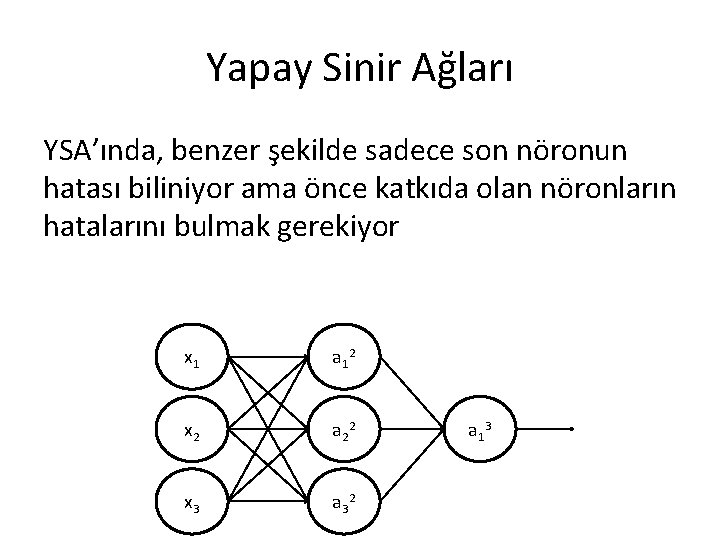

Yapay Sinir Ağları YSA’ında, benzer şekilde sadece son nöronun hatası biliniyor ama önce katkıda olan nöronların hatalarını bulmak gerekiyor x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

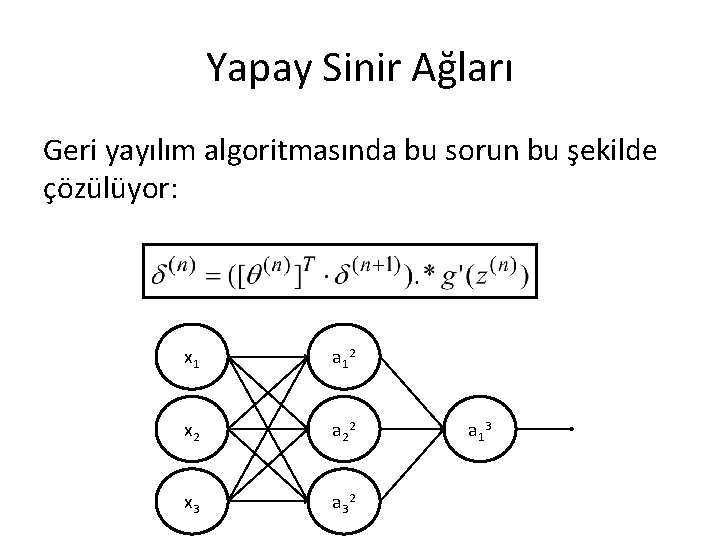

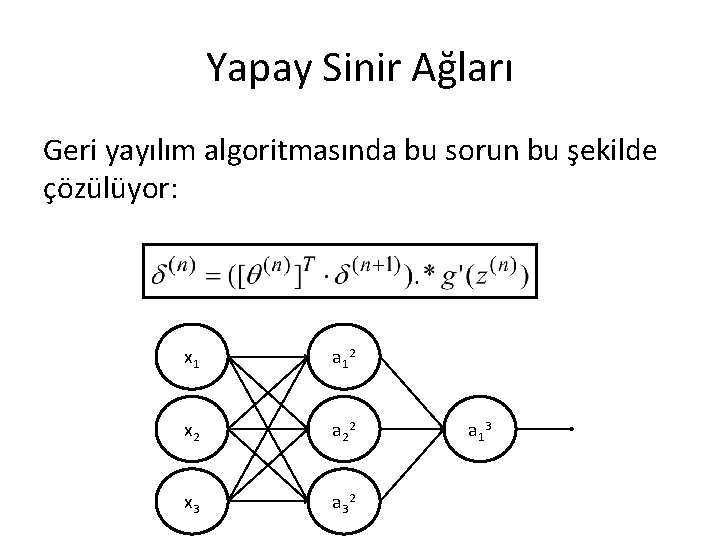

Yapay Sinir Ağları Geri yayılım algoritmasında bu sorun bu şekilde çözülüyor: x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

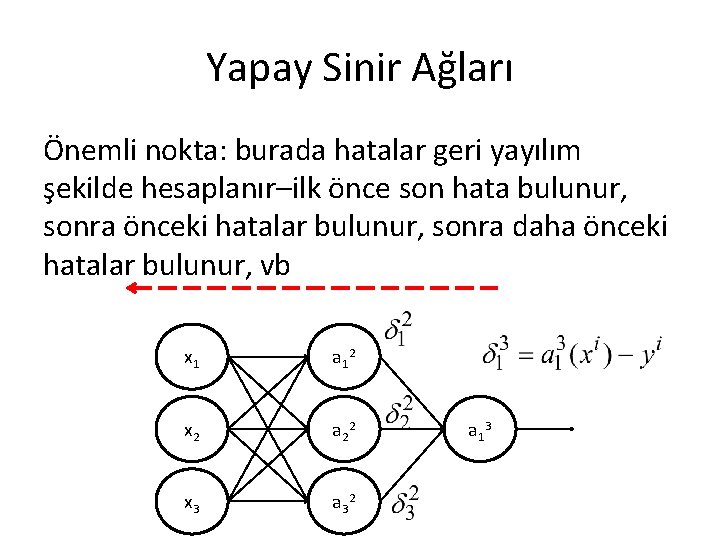

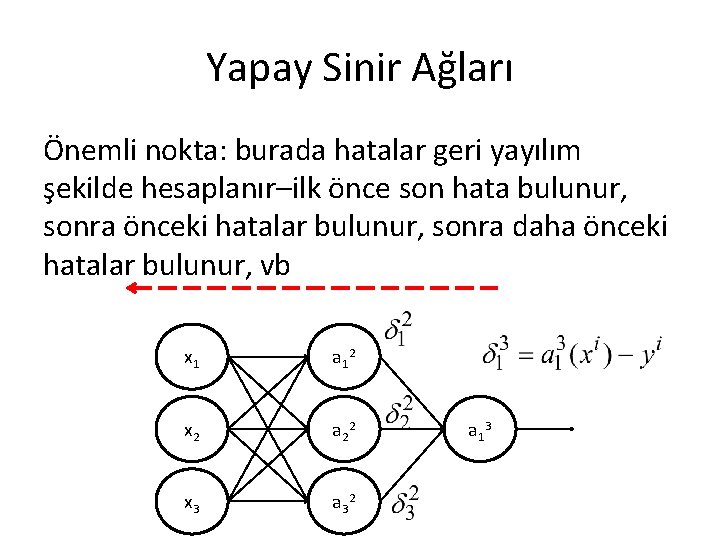

Yapay Sinir Ağları Önemli nokta: burada hatalar geri yayılım şekilde hesaplanır–ilk önce son hata bulunur, sonra önceki hatalar bulunur, sonra daha önceki hatalar bulunur, vb x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

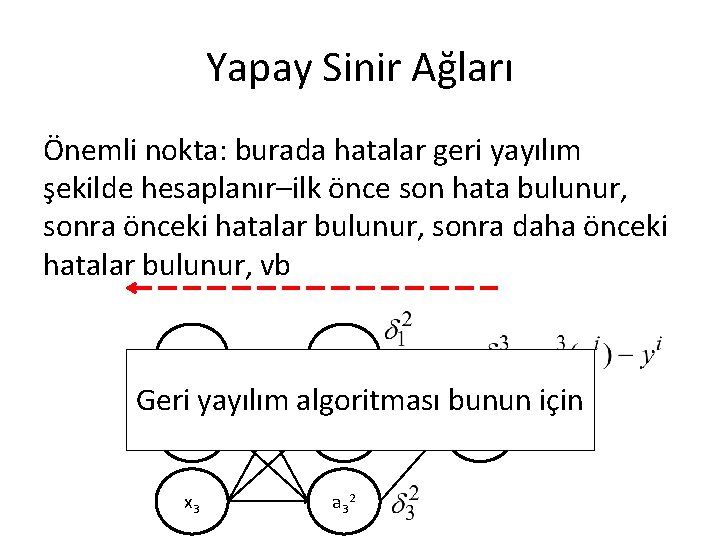

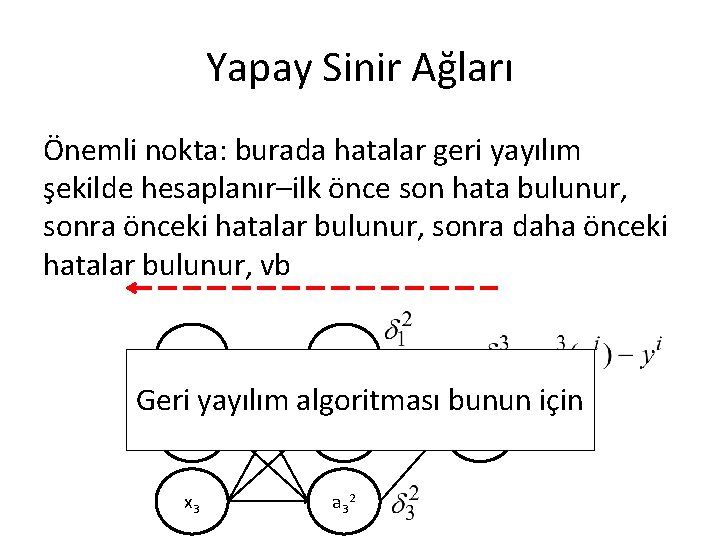

Yapay Sinir Ağları Önemli nokta: burada hatalar geri yayılım şekilde hesaplanır–ilk önce son hata bulunur, sonra önceki hatalar bulunur, sonra daha önceki hatalar bulunur, vb x 1 a 1 2 Geri yayılım algoritması bunun için x 2 a 2 2 x 3 a 3 2 a 1 3

Yapay Sinir Ağları Ø Lojistik aktivasyon fonksiyonu için, geri yayılım algoritması daha basit oluyor x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

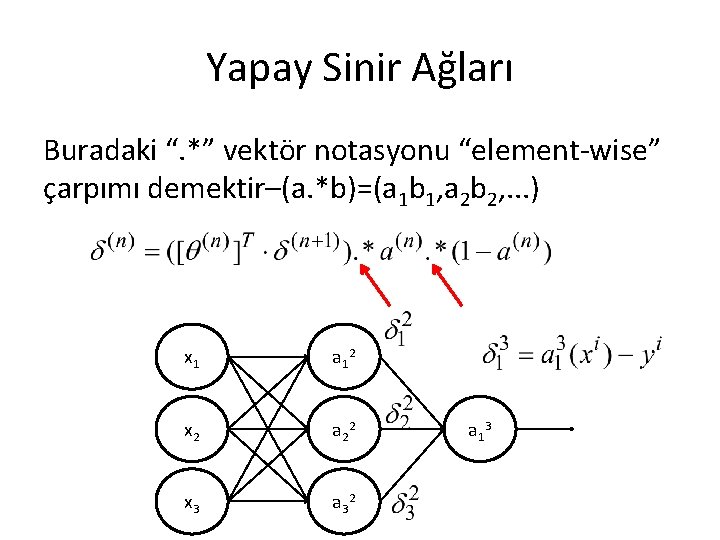

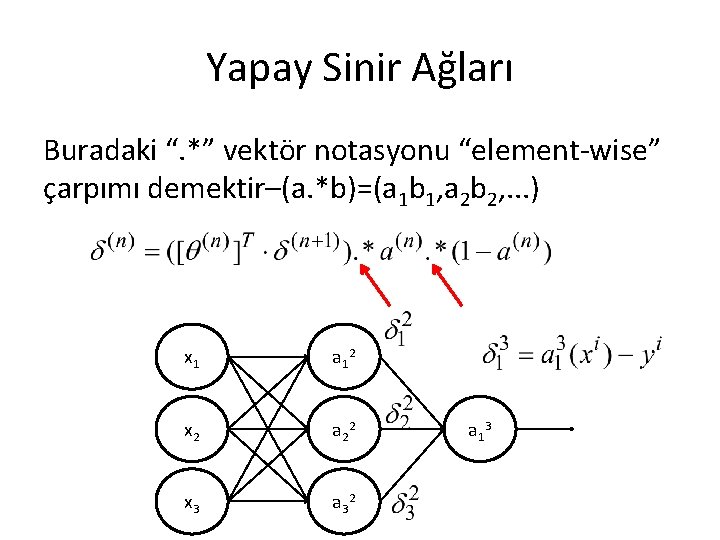

Yapay Sinir Ağları Buradaki “. *” vektör notasyonu “element-wise” çarpımı demektir–(a. *b)=(a 1 b 1, a 2 b 2, . . . ) x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

Yapay Sinir Ağları Buradaki “ ” matriks-vektör çarpımı demektedir x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3

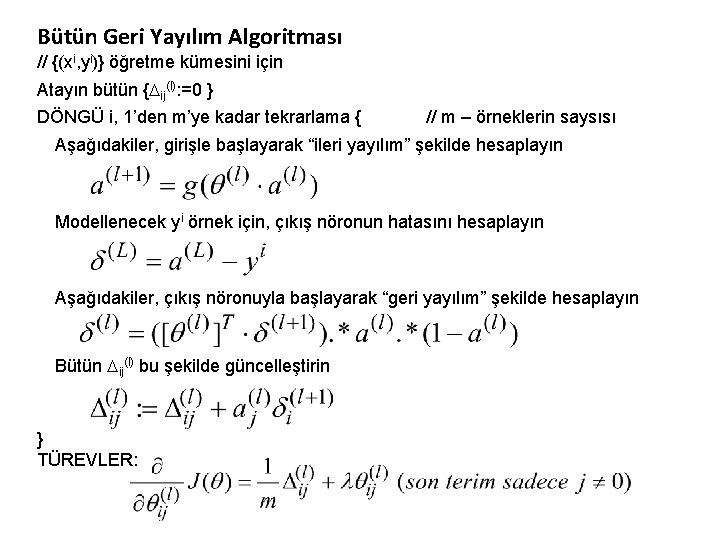

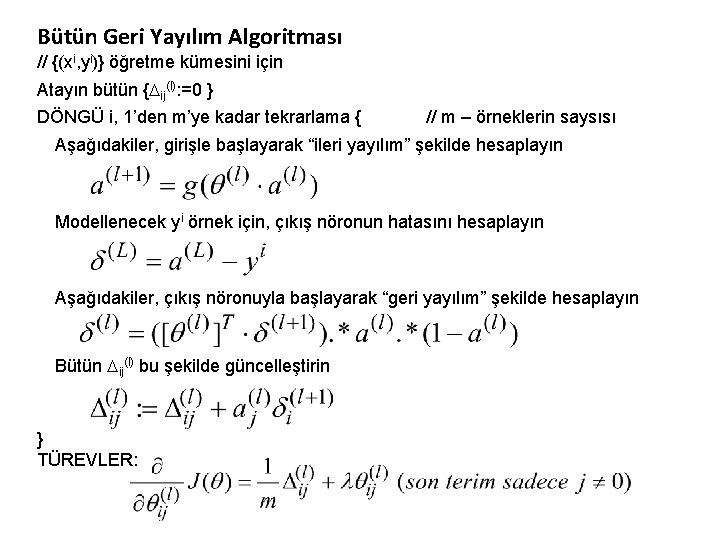

Bütün Geri Yayılım Algoritması // {(xi, yi)} öğretme kümesini için Atayın bütün { ij(l): =0 } DÖNGÜ i, 1’den m’ye kadar tekrarlama { // m – örneklerin saysısı Aşağıdakiler, girişle başlayarak “ileri yayılım” şekilde hesaplayın Modellenecek yi örnek için, çıkış nöronun hatasını hesaplayın Aşağıdakiler, çıkış nöronuyla başlayarak “geri yayılım” şekilde hesaplayın Bütün ij(l) bu şekilde güncelleştirin } TÜREVLER:

Yapay Sinir Ağları • Notasyon açıklama: – l, ağdaki katman, toplam L katman; – (l), (l) katmanın ağırlık matriksidir; – ij(l), (l-1) katmanın j. nörondan (l) katmanın i. nörona giriş ağırlığıdır – a(l), bütün (l) katmanın aktivasyon vektörüdür – Çarpımlar, yada matriks-vektör yada “elementwise” vektör çarpımı anlamındadır

Yapay Sinir Ağları • Geri yayılım algoritmasının zor olduğu nedeniyle, onu uyguladıktan sonra çalışmasının kontrol edilmesi gerekiyor – Türevler direkt olarak hesaplayabilir, yani ij(l)‘i yeni yakın değere değiştirip J/ ij(l) direkt olarak hesaplanabilir – Böyle (yaklaşık) sayısal hesaplama sonuçlarını geri yayılım algoritmasının sonuçlarıyla karşılaştırabilir, algoritma uygulanmasının doğrululuğu kontrol edilebilir

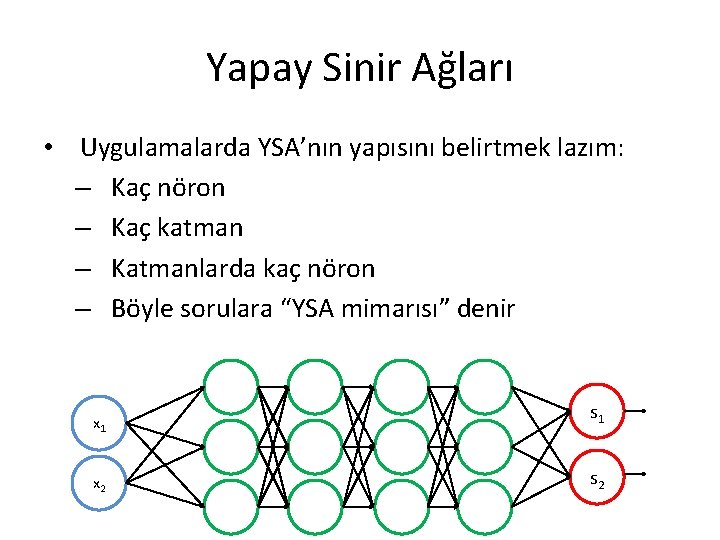

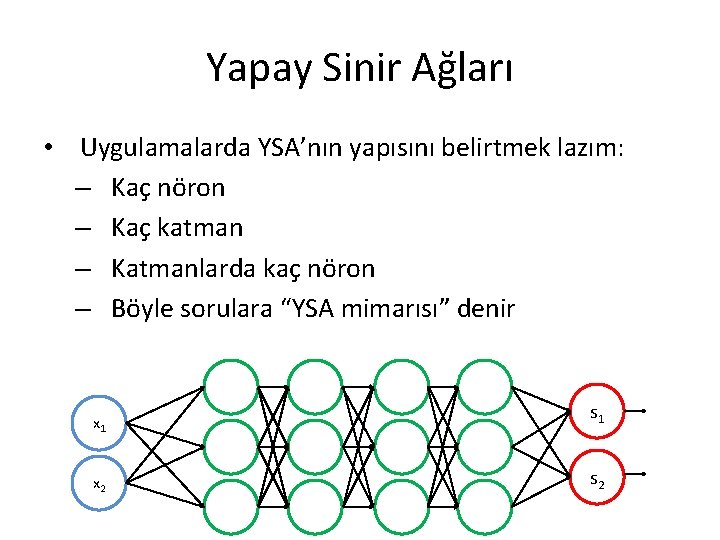

Yapay Sinir Ağları • Uygulamalarda YSA’nın yapısını belirtmek lazım: – Kaç nöron – Kaç katman – Katmanlarda kaç nöron – Böyle sorulara “YSA mimarısı” denir x 1 x 2 s 1 s 2

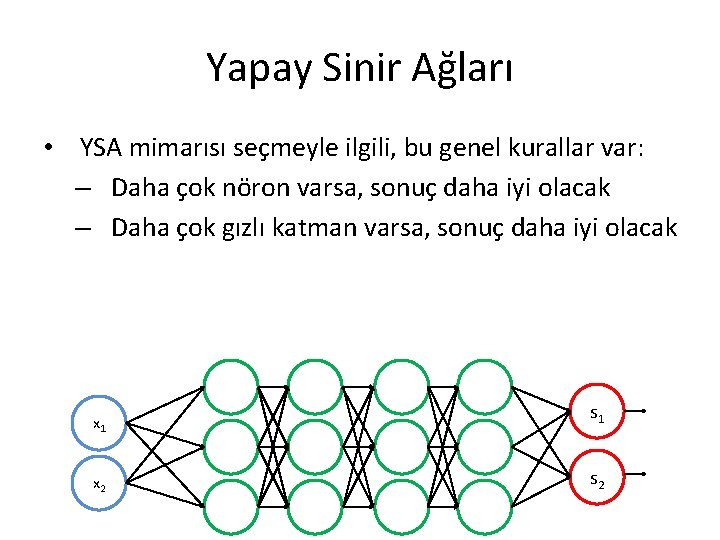

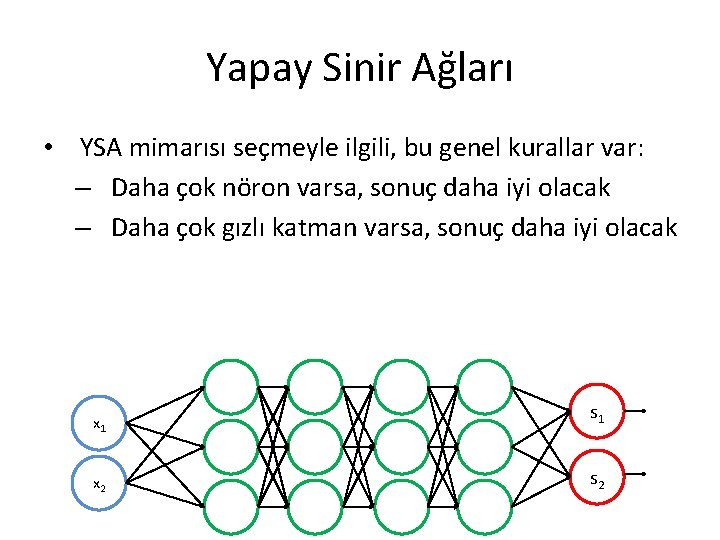

Yapay Sinir Ağları • YSA mimarısı seçmeyle ilgili, bu genel kurallar var: – Daha çok nöron varsa, sonuç daha iyi olacak – Daha çok gızlı katman varsa, sonuç daha iyi olacak x 1 x 2 s 1 s 2

Yapay Sinir Ağları – Nöronları genellikle eş gızlı katmanlara yerleştirir – Birçok sınıflı sınıflandırma için, ağı birkaç çıkış nöron içerebilir, bir çıkış nöronun çıktıları belirli bir sınıf belirtiyor x 1 x 2 s 1 s 2

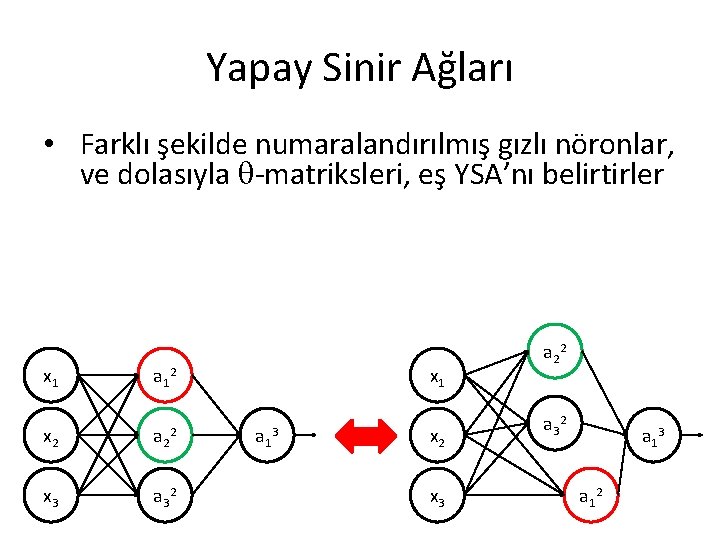

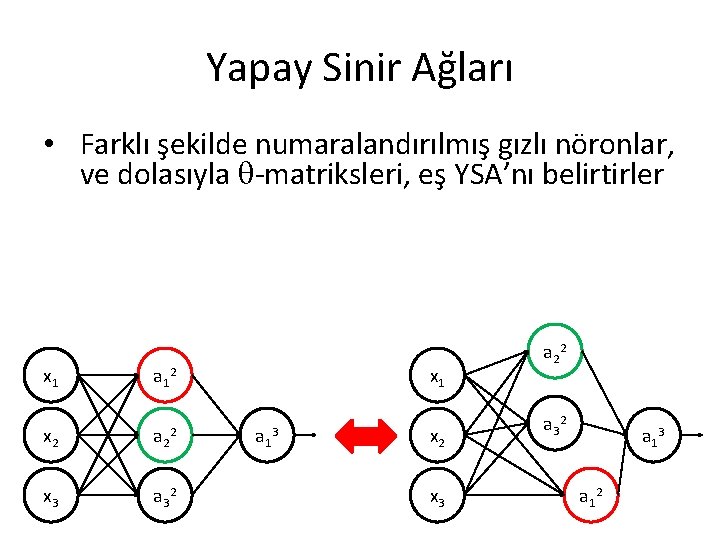

Yapay Sinir Ağları • YSA simetri sorunu: gızlı elemanların numaralandırma herhangi bir şekilde olabilir • Farklı numaralandırma sonuca hiç bir şekilde etki edemez; sadece nöronların sayıları değiştiyse, YSA değişmez x 1 a 1 2 x 2 a 2 x 3 a 3 2 2 x 1 a 1 3 x 2 x 3 a 2 2 a 3 2 a 1 3 a 1 2

Yapay Sinir Ağları • Farklı şekilde numaralandırılmış gızlı nöronlar, ve dolasıyla -matriksleri, eş YSA’nı belirtirler x 1 a 1 2 x 2 a 2 x 3 a 3 2 2 x 1 a 1 3 x 2 x 3 a 2 2 a 3 2 a 1 3 a 1 2

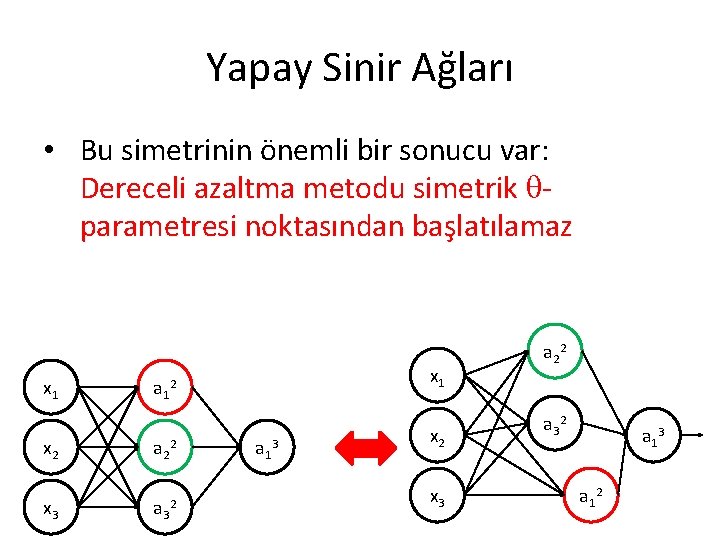

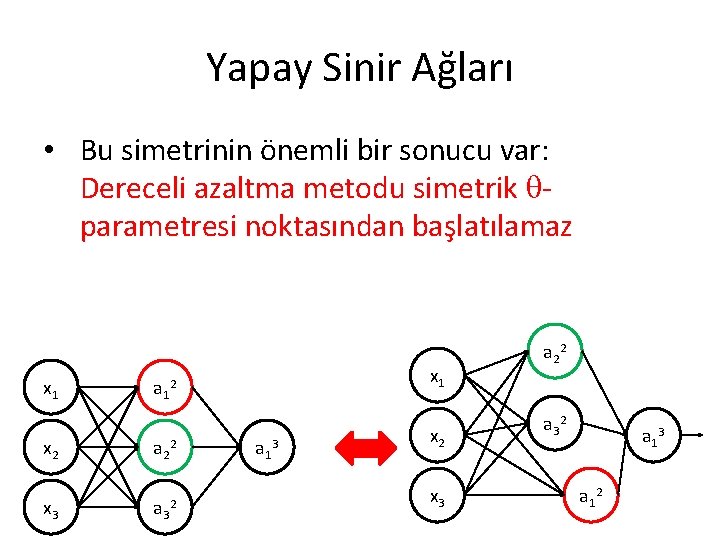

Yapay Sinir Ağları • Bu simetrinin önemli bir sonucu var: Dereceli azaltma metodu simetrik parametresi noktasından başlatılamaz x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3 x 2 x 3 a 2 2 a 3 2 a 1 3 a 1 2

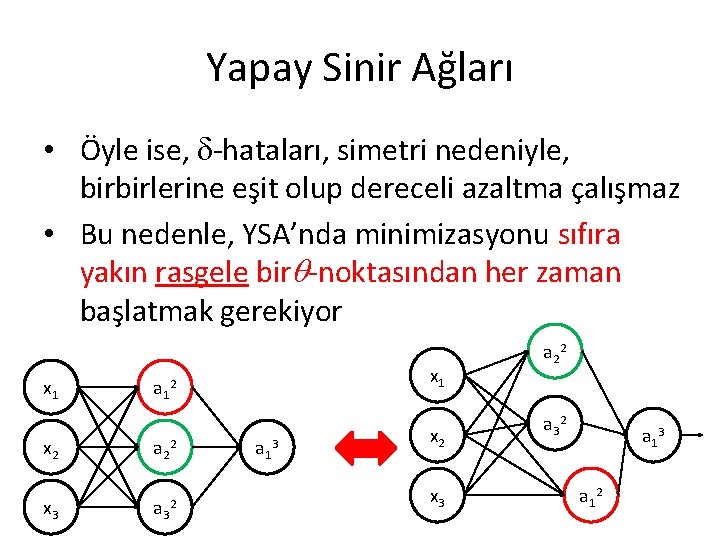

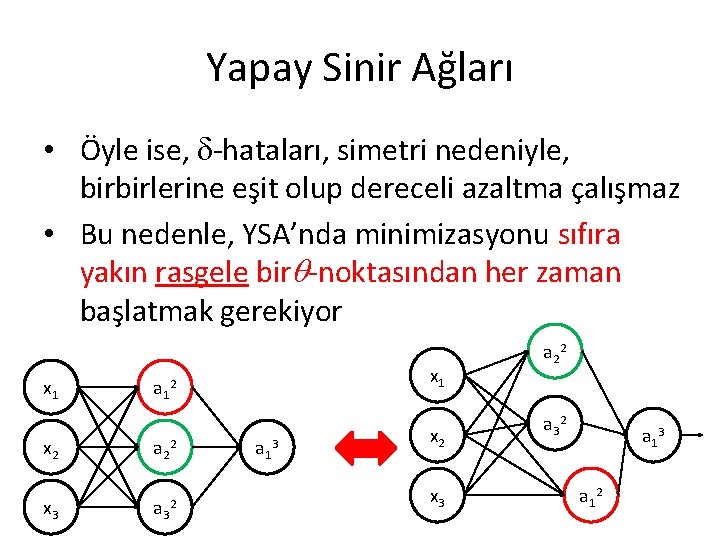

Yapay Sinir Ağları • Öyle ise, -hataları, simetri nedeniyle, birbirlerine eşit olup dereceli azaltma çalışmaz • Bu nedenle, YSA’nda minimizasyonu sıfıra yakın rasgele bir -noktasından her zaman başlatmak gerekiyor x 1 a 1 2 x 2 a 2 2 x 3 a 3 2 a 1 3 x 2 x 3 a 2 2 a 3 2 a 1 3 a 1 2

Come again !

Weka nedir

Weka nedir Derin olan kuyu değil kısa olan iptir karikatür

Derin olan kuyu değil kısa olan iptir karikatür Işitsel zeka nasıl ders çalışmalı

Işitsel zeka nasıl ders çalışmalı Makine öğrenmesi adımları

Makine öğrenmesi adımları Makine ve tezgahlarda durdurma düğmesi

Makine ve tezgahlarda durdurma düğmesi Makine güvenliği önlemleri sıralaması

Makine güvenliği önlemleri sıralaması Emniyet katsayısı

Emniyet katsayısı Makine tezgah periyodik kontrol formu

Makine tezgah periyodik kontrol formu Virtual machine ubuntu kurulumu

Virtual machine ubuntu kurulumu Harran üniversitesi çift anadal bölümleri

Harran üniversitesi çift anadal bölümleri Sürekli mukavemet diyagramı

Sürekli mukavemet diyagramı Gs malatta

Gs malatta Kol gücünden makine gücüne geçiş

Kol gücünden makine gücüne geçiş Botsal

Botsal Demir testere tezgahlarında güvenlik

Demir testere tezgahlarında güvenlik Makine

Makine Makine

Makine Makine

Makine Dynamics of machinery examples

Dynamics of machinery examples Dmi karasu

Dmi karasu Makine dili

Makine dili Anadolu-sak zeka testi örnekleri

Anadolu-sak zeka testi örnekleri Temel kabiliyetler testi

Temel kabiliyetler testi Zeka nedir kariyer planlama

Zeka nedir kariyer planlama Concerta zeka geriliği

Concerta zeka geriliği Zeka peka pasta za zube

Zeka peka pasta za zube Zeka nedir

Zeka nedir Içsel zeka etkinlikleri

Içsel zeka etkinlikleri Sözel dilsel zeka etkinlikleri

Sözel dilsel zeka etkinlikleri Sözel dilsel zeka etkinlikleri

Sözel dilsel zeka etkinlikleri üç katmanlı zeka kuramı

üç katmanlı zeka kuramı özgürlüğü temel alan yaklaşım

özgürlüğü temel alan yaklaşım Allotroplar

Allotroplar Elmas grafit fulleren özellikleri

Elmas grafit fulleren özellikleri Dünya edebiyatındaki yapay destanlar

Dünya edebiyatındaki yapay destanlar Yapay destan nedir

Yapay destan nedir Yapay bozukluk dsm 5

Yapay bozukluk dsm 5 Psödosiyezis

Psödosiyezis Fosforlu kıyafetler ışık kaynağı mıdır

Fosforlu kıyafetler ışık kaynağı mıdır üflemeli bir yapay ses kaynağı

üflemeli bir yapay ses kaynağı Yapay sulak alan

Yapay sulak alan Yapay sucuk

Yapay sucuk Polimerler

Polimerler Doğal birim yapay birim

Doğal birim yapay birim Tarımsal pazarlama ders notları

Tarımsal pazarlama ders notları Kompasite

Kompasite Uluslararası bankacılık ders notları

Uluslararası bankacılık ders notları Uluslararası bankacılık ders notları

Uluslararası bankacılık ders notları Sosyal güvenlik teorisi ders notları

Sosyal güvenlik teorisi ders notları Sorgun mehmet akif ersoy ortaokulu ders programı

Sorgun mehmet akif ersoy ortaokulu ders programı 5e modeli ders plani örneği

5e modeli ders plani örneği Kaynakçaya kitap nasıl yazılır

Kaynakçaya kitap nasıl yazılır Dyk yönetici ek ders görüş yazısı

Dyk yönetici ek ders görüş yazısı Matlab ders notları

Matlab ders notları Bitki materyali 1 ders notları

Bitki materyali 1 ders notları Html ders notları

Html ders notları Oşinografi ders notları

Oşinografi ders notları Hayvancılık ekonomisi

Hayvancılık ekonomisi Ekonomi ve girişimcilik ders notları

Ekonomi ve girişimcilik ders notları Yükseköğretim ek ders ücreti çizelgesi (örnek 15/a)

Yükseköğretim ek ders ücreti çizelgesi (örnek 15/a) Eğitim ekonomisi ders notları

Eğitim ekonomisi ders notları Hidroloji ders notlari

Hidroloji ders notlari Destek eğitim odası açmak için gerekli evraklar

Destek eğitim odası açmak için gerekli evraklar Ders planı hazırlama aşamaları

Ders planı hazırlama aşamaları Ders kitabı forma sayısı ne demek

Ders kitabı forma sayısı ne demek Ruhdilbilim

Ruhdilbilim Yyb dersi

Yyb dersi Verimli ders çalışma veli sunumu

Verimli ders çalışma veli sunumu Cbs uzaktan algılama

Cbs uzaktan algılama Kooperatifçilik ders notları

Kooperatifçilik ders notları Sensörler ve transdüserler megep

Sensörler ve transdüserler megep Ders çalışma hırsı nasıl kazanılır

Ders çalışma hırsı nasıl kazanılır Robotiğe giriş ders notları

Robotiğe giriş ders notları Okuma yazma ölçüt bağımlı ölçü aracı

Okuma yazma ölçüt bağımlı ölçü aracı Neden ders çalışıyoruz

Neden ders çalışıyoruz Excel mantıksal işlemler

Excel mantıksal işlemler Malzeme bilgisi ders notları

Malzeme bilgisi ders notları Doğrulamacılık yanlışlamacılık

Doğrulamacılık yanlışlamacılık Selçuk üniversitesi geçme notu

Selçuk üniversitesi geçme notu Hayvancılık ekonomisi ders notları

Hayvancılık ekonomisi ders notları Hayat bilgisi dersi nedir

Hayat bilgisi dersi nedir Halit armay anadolu lisesi

Halit armay anadolu lisesi Genel zootekni ders notları

Genel zootekni ders notları Limnoloji ders notları

Limnoloji ders notları Dr sultan öztürk

Dr sultan öztürk Itü ninova giriş

Itü ninova giriş Emisyon kontrol sistemleri ders notları

Emisyon kontrol sistemleri ders notları Benzetim nedir

Benzetim nedir Autocad ders notları

Autocad ders notları Arabuluculuk çatışma teorisi

Arabuluculuk çatışma teorisi Ağ temelleri

Ağ temelleri Ayetel kürsi anlamı 8.sınıf ders kitabı

Ayetel kürsi anlamı 8.sınıf ders kitabı Ders çalışırken dikkat edilmesi gerekenler

Ders çalışırken dikkat edilmesi gerekenler Verimli ders çalışma tombalası

Verimli ders çalışma tombalası Dou sınav

Dou sınav Tarımsal yapılar ve sulama ders notları

Tarımsal yapılar ve sulama ders notları Office eylem gerekiyor

Office eylem gerekiyor Medya ekonomisi ders notları

Medya ekonomisi ders notları Muamelat güdüsü nedir

Muamelat güdüsü nedir Organik kimya solomon ders notları

Organik kimya solomon ders notları Röportaj teknikleri ders notları

Röportaj teknikleri ders notları Klorpentan

Klorpentan Fiziksel uygunluk ders notları

Fiziksel uygunluk ders notları Eğitim ekonomisi ders notları

Eğitim ekonomisi ders notları üst yazı örneği

üst yazı örneği Dağıtık sistemler örnek

Dağıtık sistemler örnek Gymnospermae ders notları

Gymnospermae ders notları N tane özdeş nesne r kişiye

N tane özdeş nesne r kişiye Ntp hangi ders

Ntp hangi ders Ikmep ders modülleri

Ikmep ders modülleri