Maschinelles Lernen ID 3 Seminar KI Prof Dr

![Entscheidungsbaum n n [ Outlook= sunny, Humidity= High, Wind=Strong] Playtennis = No DNF lautet: Entscheidungsbaum n n [ Outlook= sunny, Humidity= High, Wind=Strong] Playtennis = No DNF lautet:](https://slidetodoc.com/presentation_image_h2/f5f200cda8862856d1bf41eddd1a931a/image-15.jpg)

![Beispiel o Values(wind)= Weak, Strong S=[9+, 5 -] Sweak [6+, 2 -] Sstrong [3+, Beispiel o Values(wind)= Weak, Strong S=[9+, 5 -] Sweak [6+, 2 -] Sstrong [3+,](https://slidetodoc.com/presentation_image_h2/f5f200cda8862856d1bf41eddd1a931a/image-25.jpg)

![Beispiel {D 1, D 2, …, D 14} [9+, 5 -] Outlook sunny ? Beispiel {D 1, D 2, …, D 14} [9+, 5 -] Outlook sunny ?](https://slidetodoc.com/presentation_image_h2/f5f200cda8862856d1bf41eddd1a931a/image-26.jpg)

- Slides: 30

Maschinelles Lernen & ID 3 Seminar KI Prof. Dr. Katharina Morik Mandana Asfa 10/29/2021 Mandana Asfa 1

Maschinelles Lernen & ID 3 o Einführung n n o ID 3 Algorithmus n n n o o Was ist lernen? Maschinelles Lernen Aufbau der Entscheidungsbäume Vorstellung des ID 3 Entropie Beispiele Einschränkungen Zusammenfassung Literaturliste 10/29/2021 Mandana Asfa 2

Einführung o Was ist lernen? n Michalski(1986): - n Lernen ist das Konstruieren oder Verändern von Repräsentationen von Erfahrungen. Scott(1983): - 10/29/2021 Lernen ist ein Prozess, bei dem ein System eine abrufbare Repräsentation vergangenen Interaktionen mit seiner Umwelt aufbaut. Mandana Asfa 3

Maschinelles Lernen o Die einzelnen Ziele für das maschinelle Lernen : n Prinzipien menschlichen Lernens sollen mithilfe von operationalen Modellen untersucht werden. n Insbesondere der Induktive Schluss soll operationalisiert werden, aber auch die Verwendung anderer Schlussfolgerungen (Deduktion und Abduktion) zum Lernen soll untersucht werden. n Die Arbeit am Rechner soll durch dessen Lernfähigkeit dem Benutzer erleichtert werden. 10/29/2021 Mandana Asfa 4

Maschinelles Lernen o Die Phänomenbereiche n Aggregation (Kategorisierung ) n Charakterisierung n Klassifikation Kategorisierung Charakterisierung Klassifikation 10/29/2021 Mandana Asfa 5

Maschinelles Lernen o o o Induktion Abduktion Deduktion 10/29/2021 Mandana Asfa 6

Maschinelles Lernen o Induktion: n Von zwei oder mehreren wahren Einzelaussagen wird auf eine Regel geschlossen. Aussage 1: Peter ist Mensch n Aussage 2: Karin ist Mensch n Aussage 3: Peter ist sterblich n Aussage 4: Karin ist sterblich Alle Menschen sind sterblich (Regel). n 10/29/2021 Mandana Asfa 7

Maschinelles Lernen o Deduktion n Aus Ursache und Regel wird auf eine Wirkung geschlossen. Ursache: Peter ist Mensch n Regel: Alle Menschen sind sterblich Peter ist sterblich (Wirkung) n 10/29/2021 Mandana Asfa 8

Maschinelles Lernen o Abduktion n Von einer Regel und einer Wirkung wird auf eine Ursache geschlossen. Regel: Alle Menschen sind sterblich. n Wirkung: Peter ist sterblich. Peter ist Mensch (Ursache). n 10/29/2021 Mandana Asfa 9

Mashinelles lernen o Angewendete Lernverfahren: n Top-Down Lernverfahren o Induktive Lernverfahren § § n n ID 3 Conceptual clustering Bottom-Up Lernverfahren Versions-Space Lernverfahren 10/29/2021 Mandana Asfa 10

Aufbau der Entscheidungsbäume o Datenklassifikation n n wichtiges Ziel bei KDD das Finden gemeinsamer Eigenschaften einer Menge von Objekten und die Einteilung der Objekte in verschiedene Klassen aufgrund eines Klassifikationsmodells. 10/29/2021 Mandana Asfa 11

Aufbau der Entscheidungsbäume o o o Zur Erzeugung des Klassifikationsmodells wird eine Trainingsmenge von Objekten benutzt, deren Klassenzugehörigkeit bekannt ist Klassifikationsmodell wird benutzt, um neue, unbekannte Objekte zu Klassifizieren Zur Klassifikation existieren viele Methoden, z. B. statistische Verfahren oder neuronale Netze 10/29/2021 Mandana Asfa 12

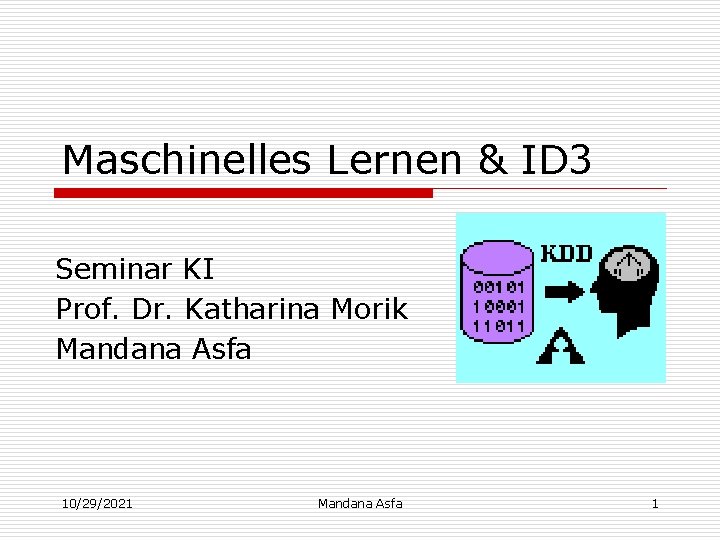

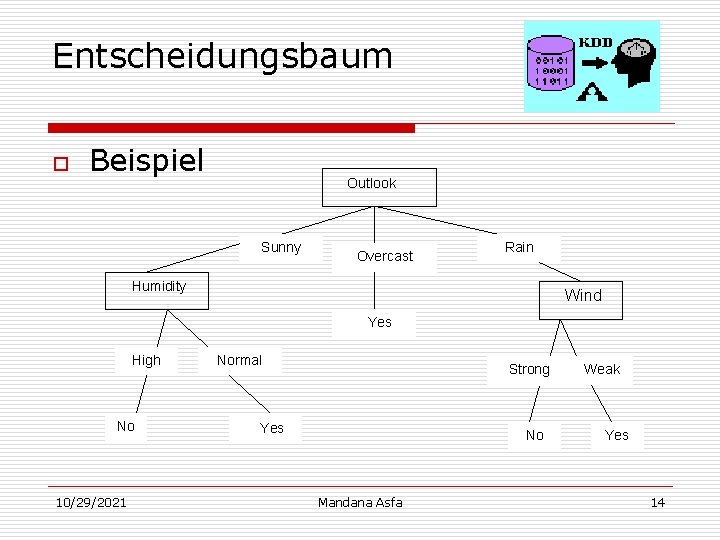

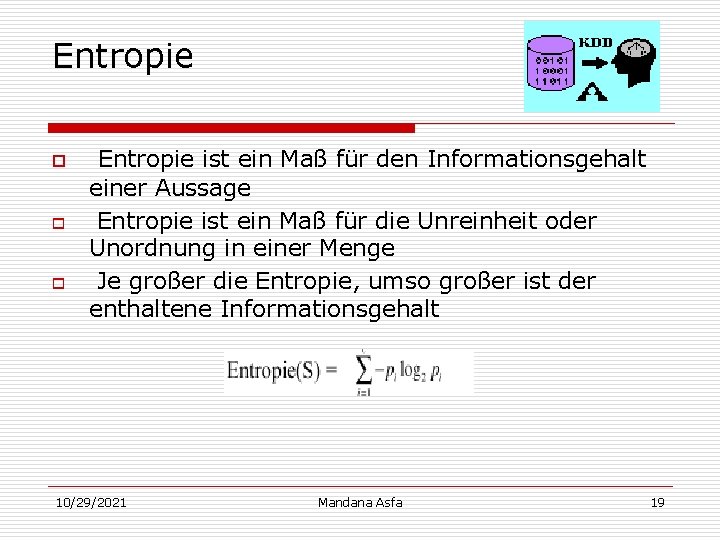

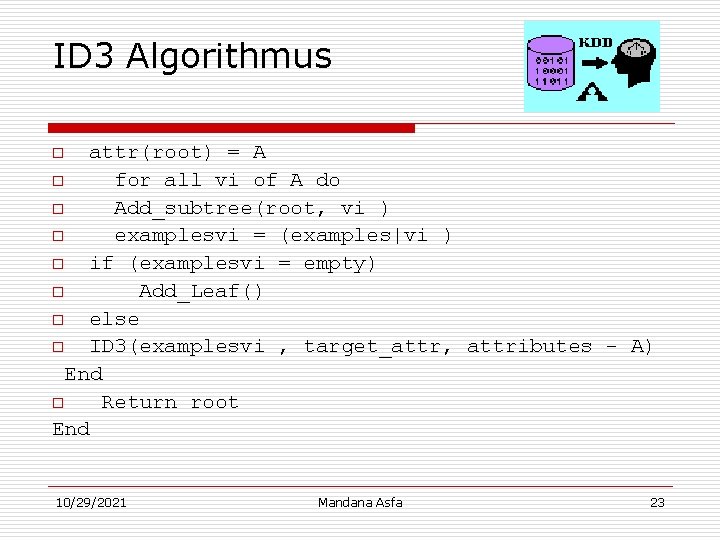

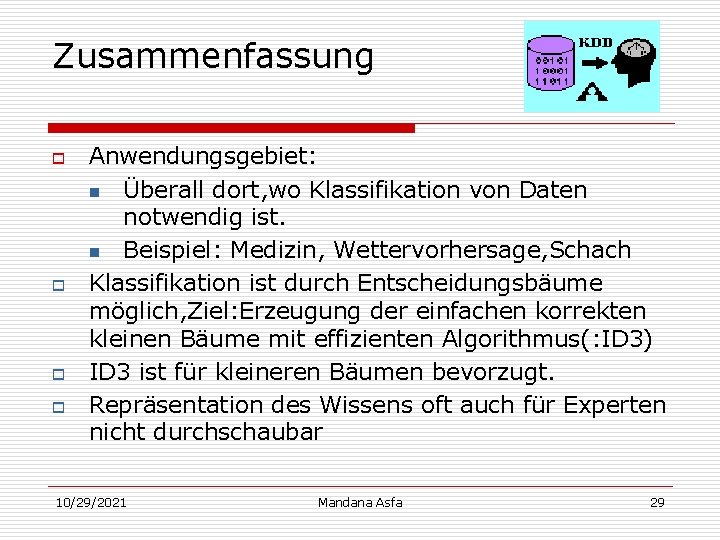

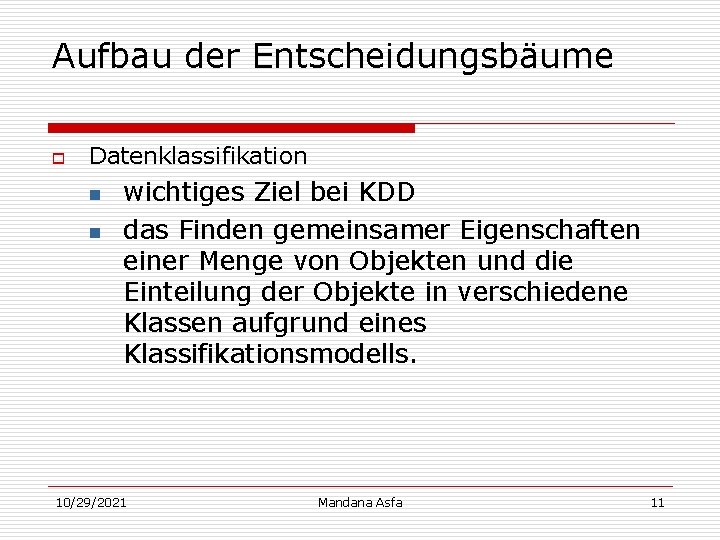

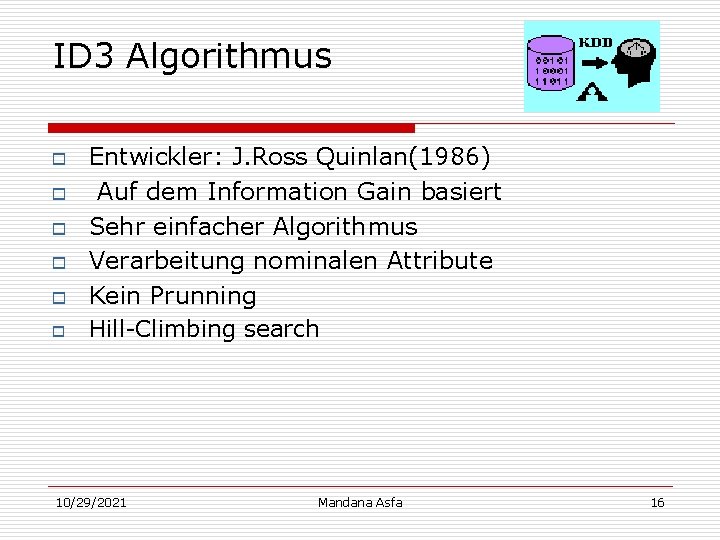

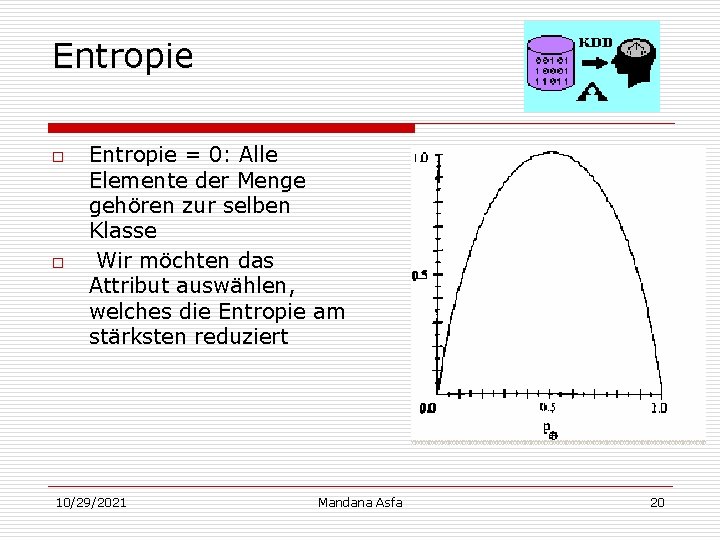

Aufbau der Entscheidungsbäume o o o repräsentiert eine Hypothese Jeder Innere Knoten enthält ein Attribut von jedem inneren Knoten gehen Pfade mit Werten zu weiteren Knoten Blätter enthalten die Klasse mit zugehörenden klassifizierenden Objekt Klassifikation eines unbekannten Objekts erfolgt durch Ablaufen des Baumes repräsentieren eine DNF 10/29/2021 Mandana Asfa 13

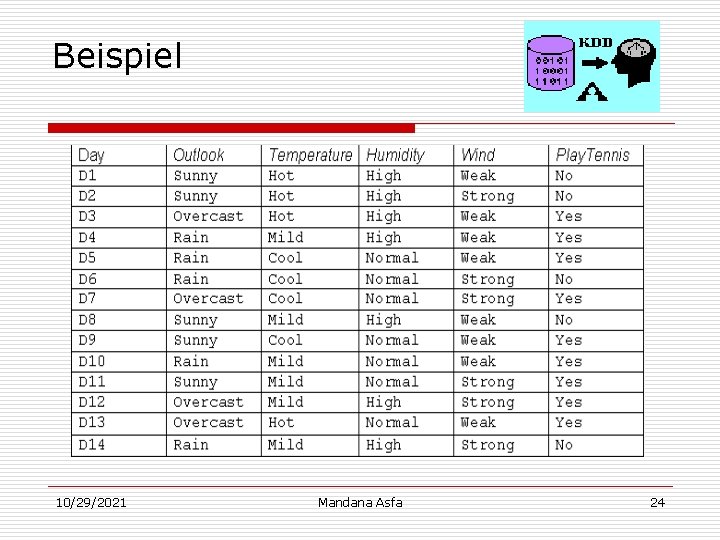

Entscheidungsbaum o Beispiel Outlook Sunny Overcast Rain Humidity Wind Yes High No 10/29/2021 Normal Strong Yes No Mandana Asfa Weak Yes 14

![Entscheidungsbaum n n Outlook sunny Humidity High WindStrong Playtennis No DNF lautet Entscheidungsbaum n n [ Outlook= sunny, Humidity= High, Wind=Strong] Playtennis = No DNF lautet:](https://slidetodoc.com/presentation_image_h2/f5f200cda8862856d1bf41eddd1a931a/image-15.jpg)

Entscheidungsbaum n n [ Outlook= sunny, Humidity= High, Wind=Strong] Playtennis = No DNF lautet: ( Outlook= sunny & Humidity = Normal) V ( Outlook = overcast ) V ( Outlook= Rain & Wind= Weak) 10/29/2021 Mandana Asfa 15

ID 3 Algorithmus o o o Entwickler: J. Ross Quinlan(1986) Auf dem Information Gain basiert Sehr einfacher Algorithmus Verarbeitung nominalen Attribute Kein Prunning Hill-Climbing search 10/29/2021 Mandana Asfa 16

Ziel des ID 3 Algorithmus o o 10/29/2021 Konstruktion eines Entscheidungsbaumes, der als möglichst guter Klassifikator für Testobjekte dient. „Top-Down „- Konstruktion An jedem Knoten wird entschieden, welches Attribut am besten passt Erzeugung von Kindknoten für jeden möglichen Attributwert Mandana Asfa 17

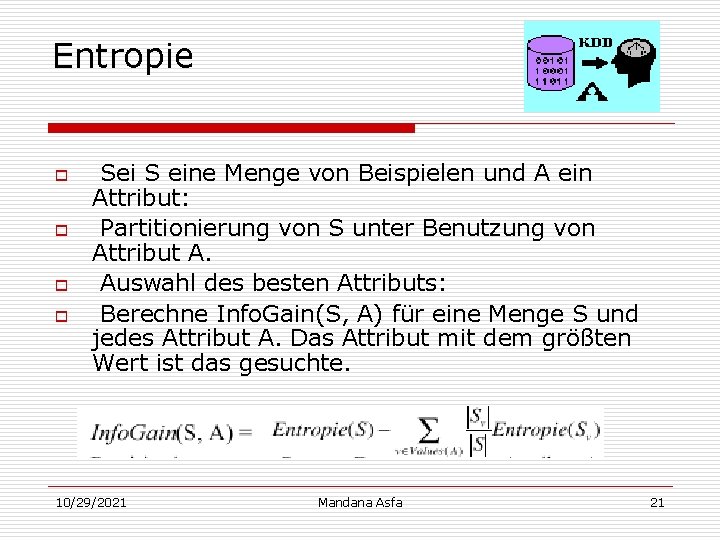

Entropie o Problem n o Welches Attribut klassifiziert die Trainingsdaten am besten? Entropie: n die durchschnittliche Menge an Information einer Antwort 10/29/2021 Mandana Asfa 18

Entropie o o o Entropie ist ein Maß für den Informationsgehalt einer Aussage Entropie ist ein Maß für die Unreinheit oder Unordnung in einer Menge Je großer die Entropie, umso großer ist der enthaltene Informationsgehalt 10/29/2021 Mandana Asfa 19

Entropie o o Entropie = 0: Alle Elemente der Menge gehören zur selben Klasse Wir möchten das Attribut auswählen, welches die Entropie am stärksten reduziert 10/29/2021 Mandana Asfa 20

Entropie o o Sei S eine Menge von Beispielen und A ein Attribut: Partitionierung von S unter Benutzung von Attribut A. Auswahl des besten Attributs: Berechne Info. Gain(S, A) für eine Menge S und jedes Attribut A. Das Attribut mit dem größten Wert ist das gesuchte. 10/29/2021 Mandana Asfa 21

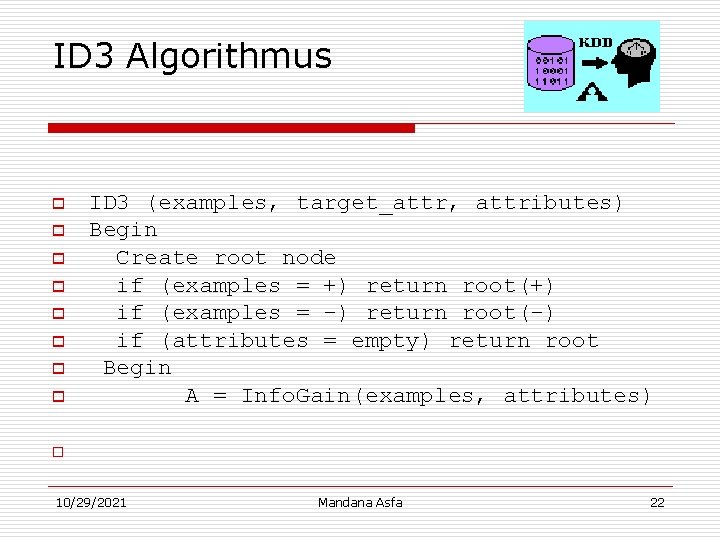

ID 3 Algorithmus o o o o ID 3 (examples, target_attr, attributes) Begin Create root node if (examples = +) return root(+) if (examples = -) return root(-) if (attributes = empty) return root Begin A = Info. Gain(examples, attributes) o 10/29/2021 Mandana Asfa 22

ID 3 Algorithmus attr(root) = A o for all vi of A do o Add_subtree(root, vi ) o examplesvi = (examples|vi ) o if (examplesvi = empty) o Add_Leaf() o else o ID 3(examplesvi , target_attr, attributes - A) End o Return root End o 10/29/2021 Mandana Asfa 23

Beispiel 10/29/2021 Mandana Asfa 24

![Beispiel o Valueswind Weak Strong S9 5 Sweak 6 2 Sstrong 3 Beispiel o Values(wind)= Weak, Strong S=[9+, 5 -] Sweak [6+, 2 -] Sstrong [3+,](https://slidetodoc.com/presentation_image_h2/f5f200cda8862856d1bf41eddd1a931a/image-25.jpg)

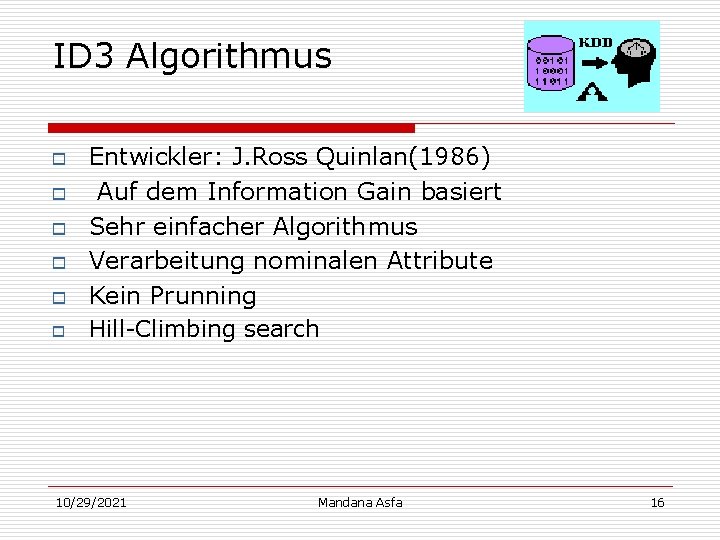

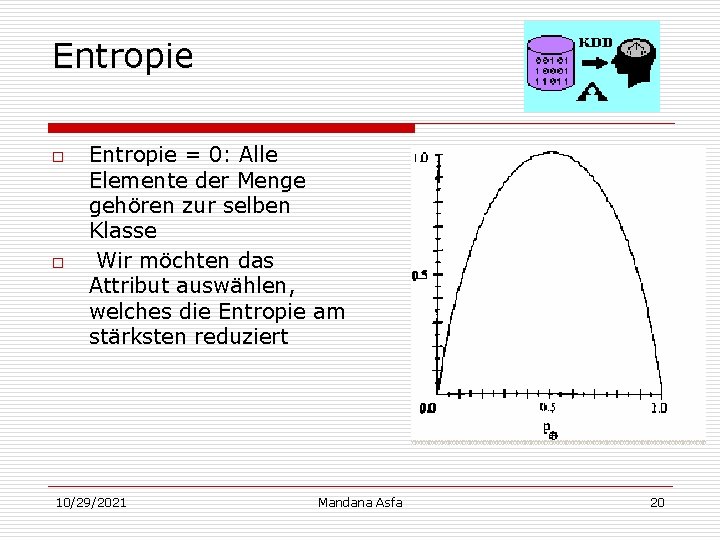

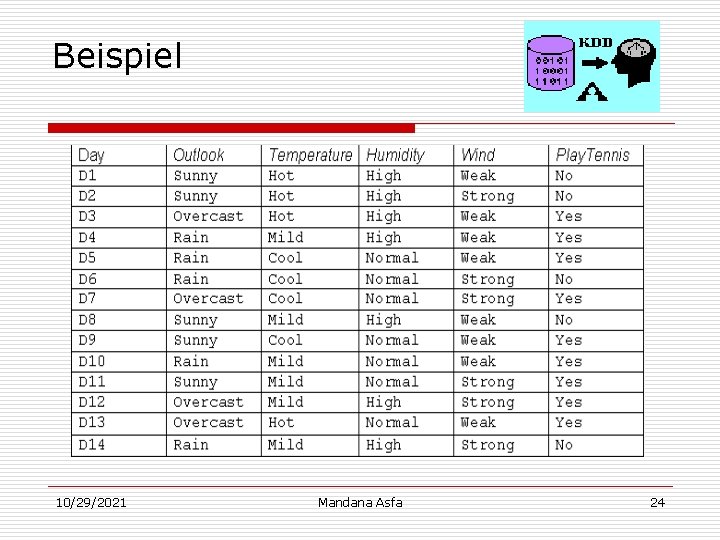

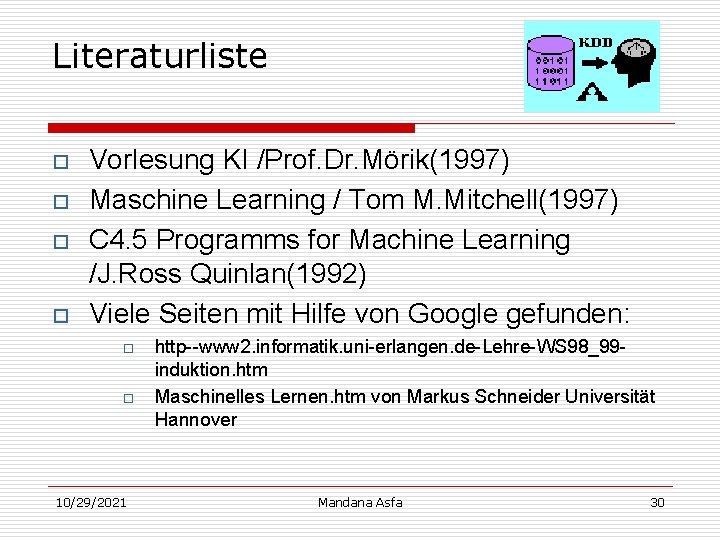

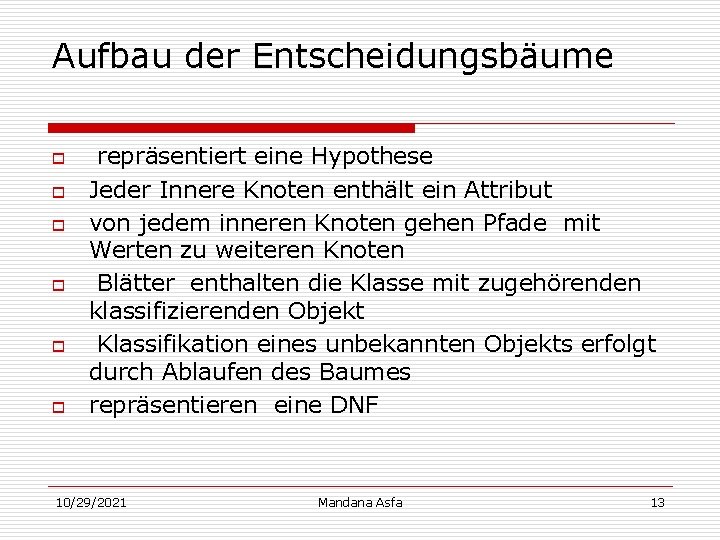

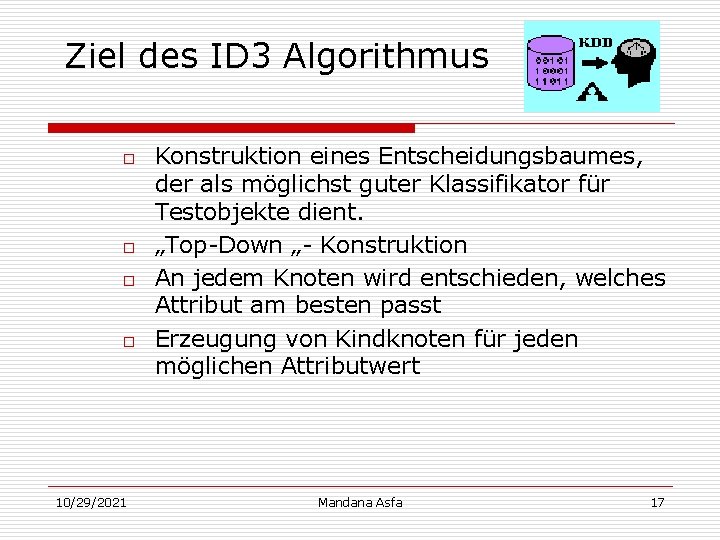

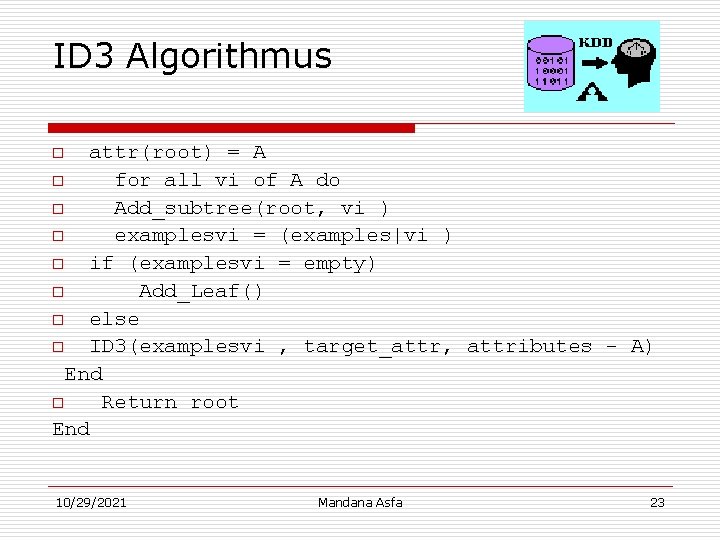

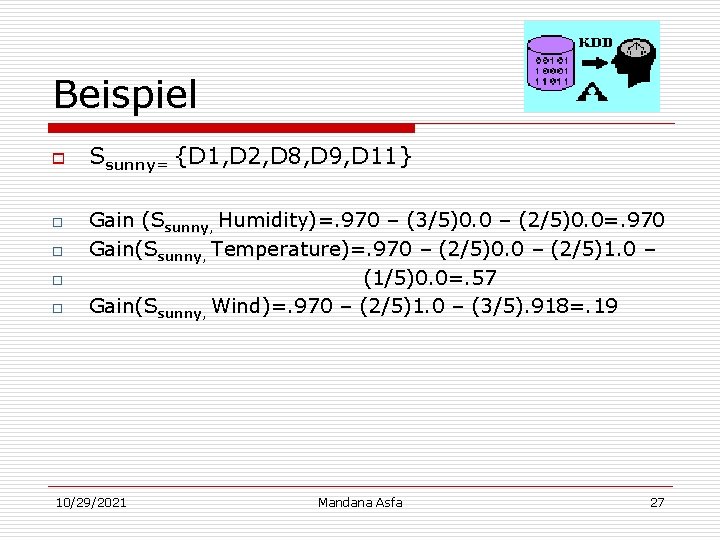

Beispiel o Values(wind)= Weak, Strong S=[9+, 5 -] Sweak [6+, 2 -] Sstrong [3+, 3 -] Gain(S, Wind)= Entropy(S)-S |Sv | / | S | Entropy(Sv) = Entropy(S)- (8/14)Entropy(Sweak) -(6/14)Entropy(SStrong) = 0. 940 – (8/14)0. 811 – (6/14)1. 00 = 0. 048 10/29/2021 Mandana Asfa 25

![Beispiel D 1 D 2 D 14 9 5 Outlook sunny Beispiel {D 1, D 2, …, D 14} [9+, 5 -] Outlook sunny ?](https://slidetodoc.com/presentation_image_h2/f5f200cda8862856d1bf41eddd1a931a/image-26.jpg)

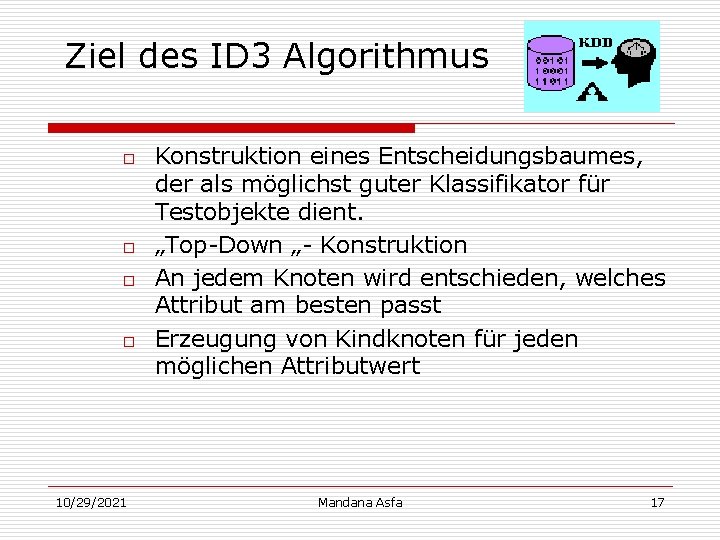

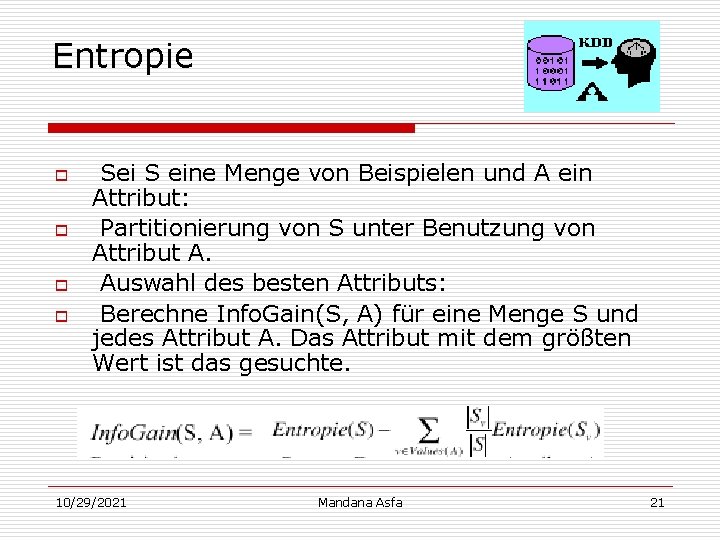

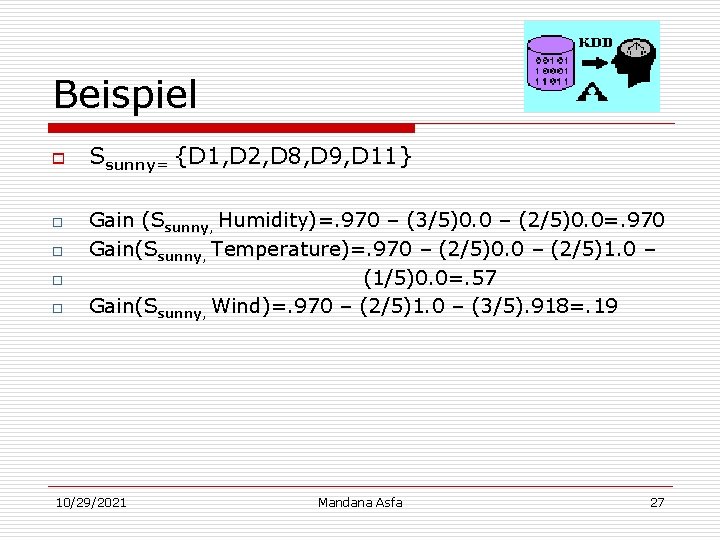

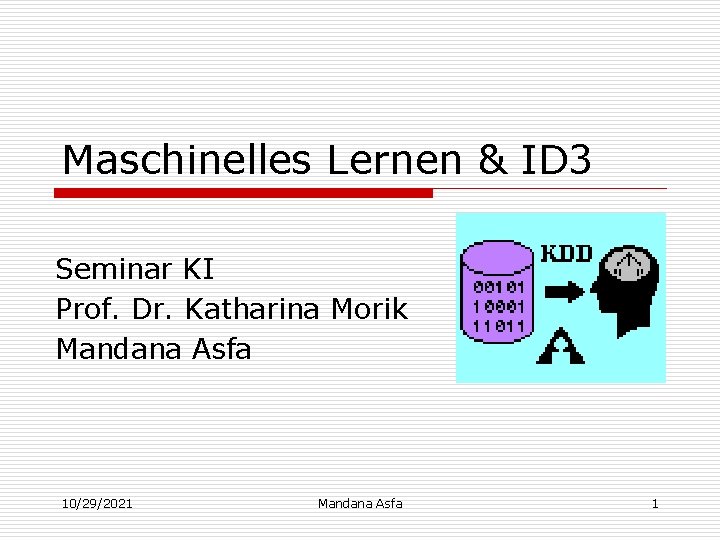

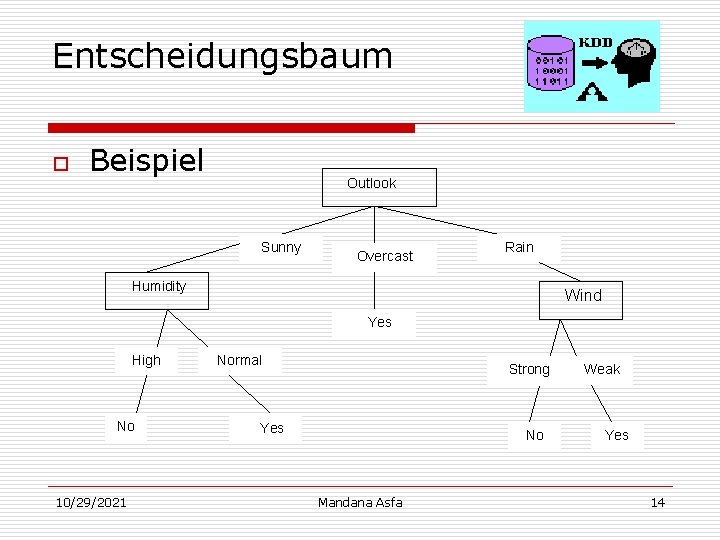

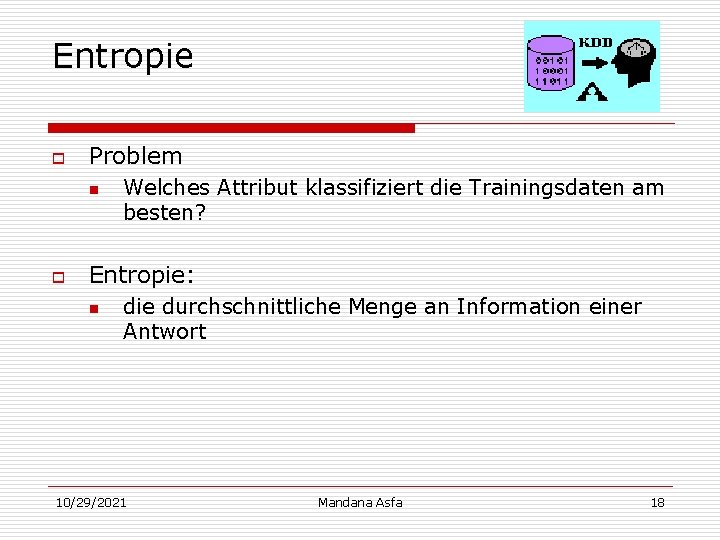

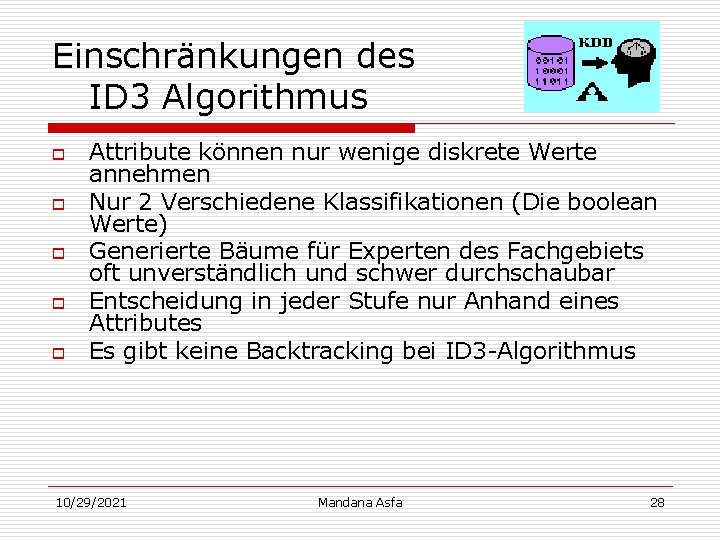

Beispiel {D 1, D 2, …, D 14} [9+, 5 -] Outlook sunny ? o o {D 1, D 2, D 8, D 9, D 11} [2+, 3 -] Overcast Rain {D 3, D 7, D 12, D 13} [4+, 0 -] Yes {D 4, D 5, D 10, D 14} [3+, 2 -] ? Gain(S, Outlook)=0. 246 Gain(S, Humidity)=0. 151 Gain(S, Wind)=0. 048 Gain(S, Temperature)=0. 029 10/29/2021 Mandana Asfa 26

Beispiel o o o Ssunny= {D 1, D 2, D 8, D 9, D 11} Gain (Ssunny, Humidity)=. 970 – (3/5)0. 0 – (2/5)0. 0=. 970 Gain(Ssunny, Temperature)=. 970 – (2/5)0. 0 – (2/5)1. 0 – (1/5)0. 0=. 57 Gain(Ssunny, Wind)=. 970 – (2/5)1. 0 – (3/5). 918=. 19 10/29/2021 Mandana Asfa 27

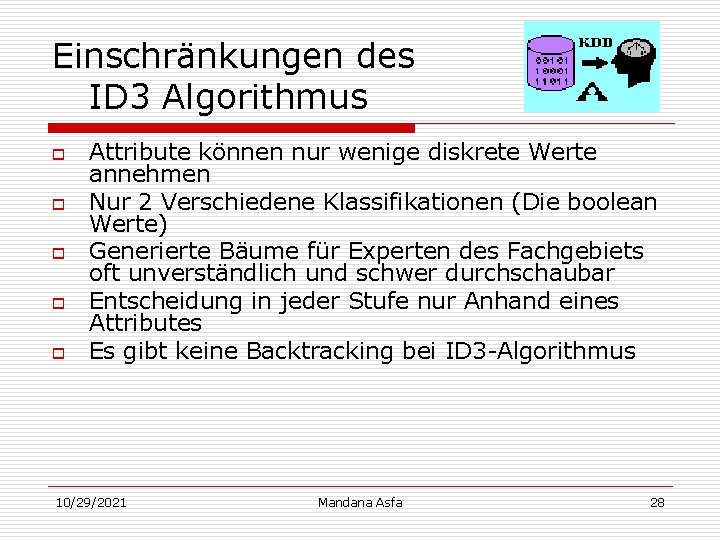

Einschränkungen des ID 3 Algorithmus o o o Attribute können nur wenige diskrete Werte annehmen Nur 2 Verschiedene Klassifikationen (Die boolean Werte) Generierte Bäume für Experten des Fachgebiets oft unverständlich und schwer durchschaubar Entscheidung in jeder Stufe nur Anhand eines Attributes Es gibt keine Backtracking bei ID 3 -Algorithmus 10/29/2021 Mandana Asfa 28

Zusammenfassung o o Anwendungsgebiet: n Überall dort, wo Klassifikation von Daten notwendig ist. n Beispiel: Medizin, Wettervorhersage, Schach Klassifikation ist durch Entscheidungsbäume möglich, Ziel: Erzeugung der einfachen korrekten kleinen Bäume mit effizienten Algorithmus(: ID 3) ID 3 ist für kleineren Bäumen bevorzugt. Repräsentation des Wissens oft auch für Experten nicht durchschaubar 10/29/2021 Mandana Asfa 29

Literaturliste o o Vorlesung KI /Prof. Dr. Mörik(1997) Maschine Learning / Tom M. Mitchell(1997) C 4. 5 Programms for Machine Learning /J. Ross Quinlan(1992) Viele Seiten mit Hilfe von Google gefunden: o o 10/29/2021 http--www 2. informatik. uni-erlangen. de-Lehre-WS 98_99 induktion. htm Maschinelles Lernen. htm von Markus Schneider Universität Hannover Mandana Asfa 30

Lineare regression maschinelles lernen

Lineare regression maschinelles lernen Induktiver bias

Induktiver bias Wiederholen im perfekt

Wiederholen im perfekt Prosoziales verhalten lernen

Prosoziales verhalten lernen Lernen mit kopf herz und hand

Lernen mit kopf herz und hand Text alle kinder lernen lesen

Text alle kinder lernen lesen Lernen vs luzern

Lernen vs luzern Dialogisches lernen in sprache und mathematik

Dialogisches lernen in sprache und mathematik Germanische schriftart

Germanische schriftart L

L Quran auswendig lernen programm

Quran auswendig lernen programm Wechselbrücke fahren lernen

Wechselbrücke fahren lernen Lernen schrobenhausen

Lernen schrobenhausen Mathe lernen regensburg

Mathe lernen regensburg Filme sehen lernen

Filme sehen lernen Sensomotorisches lernen

Sensomotorisches lernen Induktiv deduktiv beispiel unterricht

Induktiv deduktiv beispiel unterricht 10 gebote für gehirngerechtes lernen

10 gebote für gehirngerechtes lernen Abgrenzen lernen

Abgrenzen lernen Www sehen und handeln ch lernen

Www sehen und handeln ch lernen Kas lernen

Kas lernen Urgermanisch lernen

Urgermanisch lernen Bulgarisch lernen passau

Bulgarisch lernen passau Klassische

Klassische Programmiersprache go lernen

Programmiersprache go lernen Potenzgesetz des vergessens

Potenzgesetz des vergessens Hamster programmieren lernen

Hamster programmieren lernen Sindarin alphabet deutsch

Sindarin alphabet deutsch Attiny programmieren

Attiny programmieren Warum deutsch lernen

Warum deutsch lernen Differenzielles lernen schule

Differenzielles lernen schule