Kapitel 3 Regression SS 2009 Maschinelles Lernen und

- Slides: 12

Kapitel 3: Regression SS 2009 Maschinelles Lernen und Neural Computation 59

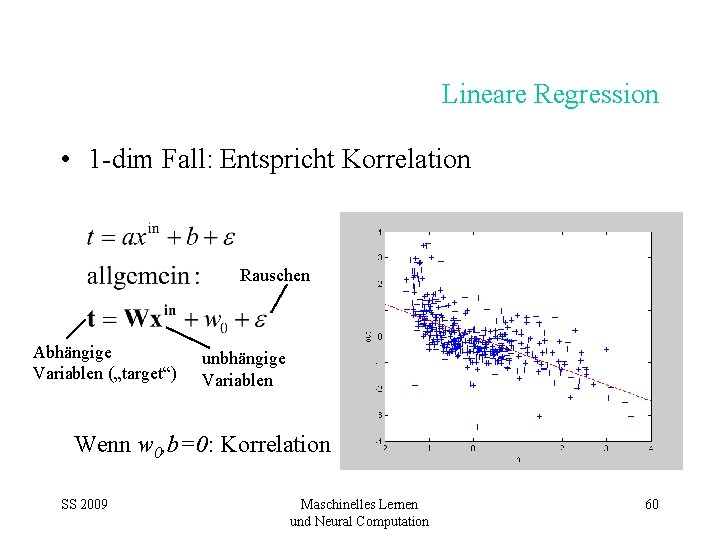

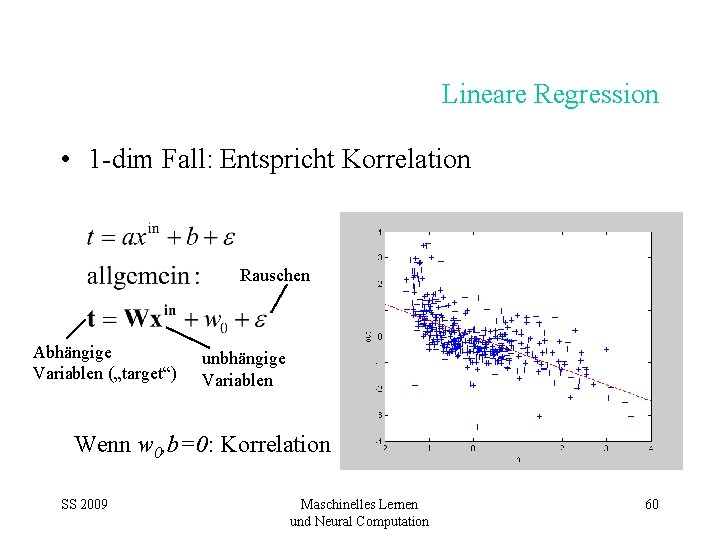

Lineare Regression • 1 -dim Fall: Entspricht Korrelation Rauschen Abhängige Variablen („target“) unbhängige Variablen Wenn w 0, b=0: Korrelation SS 2009 Maschinelles Lernen und Neural Computation 60

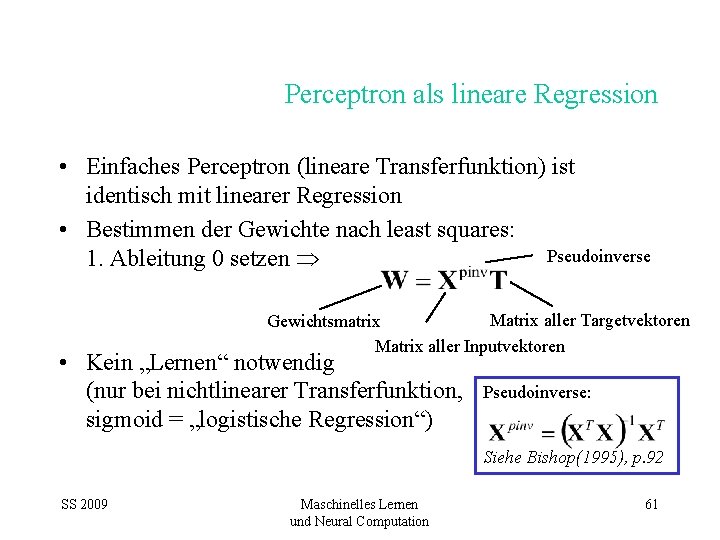

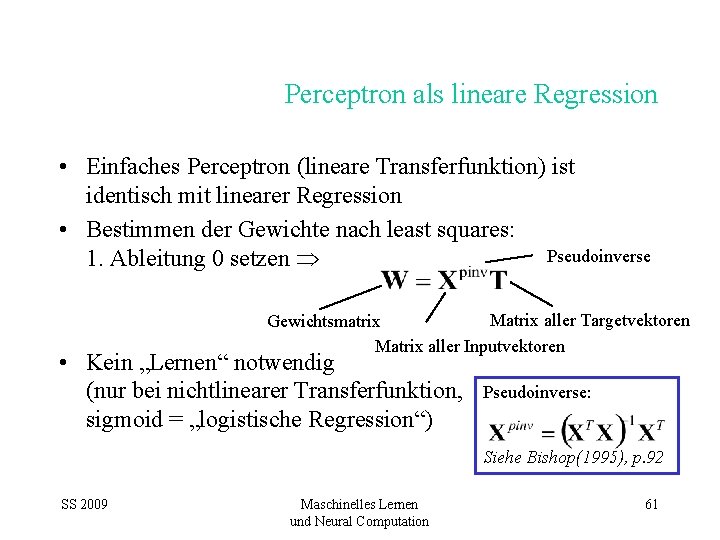

Perceptron als lineare Regression • Einfaches Perceptron (lineare Transferfunktion) ist identisch mit linearer Regression • Bestimmen der Gewichte nach least squares: Pseudoinverse 1. Ableitung 0 setzen Matrix aller Targetvektoren Gewichtsmatrix Matrix aller Inputvektoren • Kein „Lernen“ notwendig (nur bei nichtlinearer Transferfunktion, sigmoid = „logistische Regression“) Pseudoinverse: Siehe Bishop(1995), p. 92 SS 2009 Maschinelles Lernen und Neural Computation 61

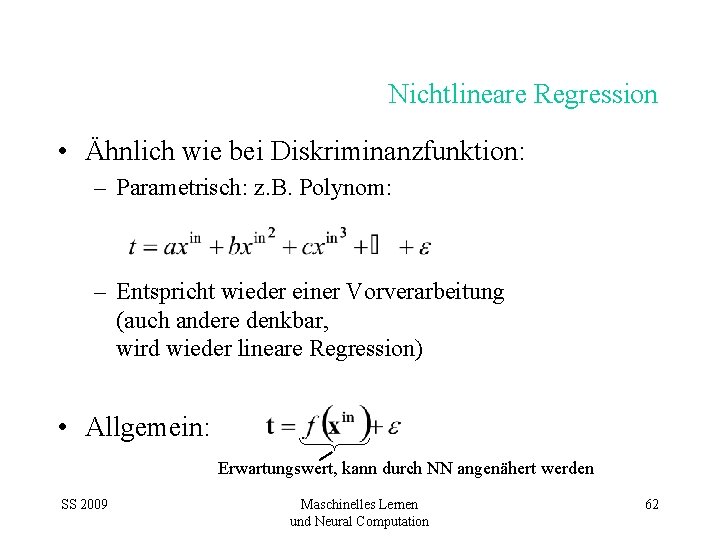

Nichtlineare Regression • Ähnlich wie bei Diskriminanzfunktion: – Parametrisch: z. B. Polynom: – Entspricht wieder einer Vorverarbeitung (auch andere denkbar, wird wieder lineare Regression) • Allgemein: Erwartungswert, kann durch NN angenähert werden SS 2009 Maschinelles Lernen und Neural Computation 62

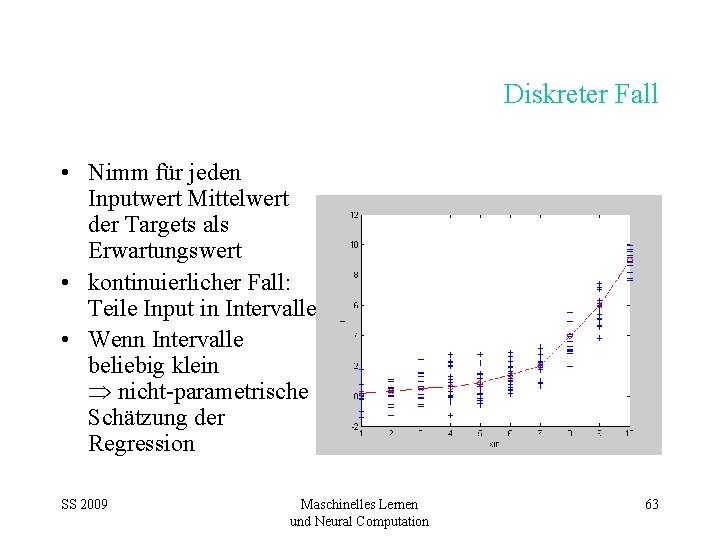

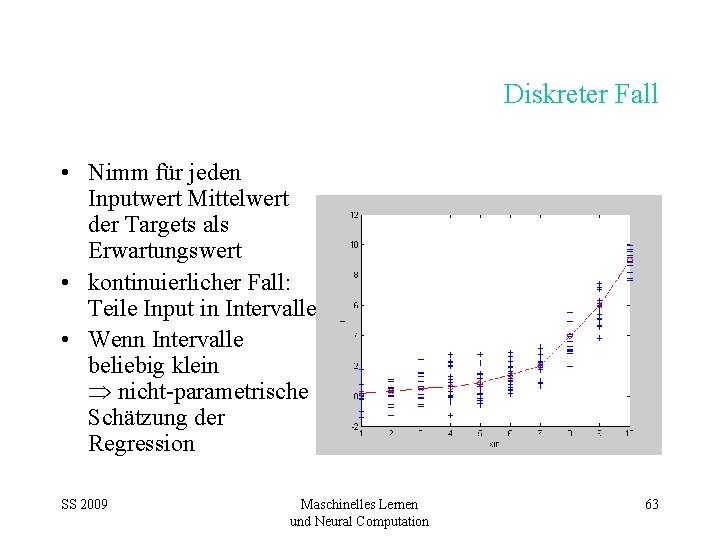

Diskreter Fall • Nimm für jeden Inputwert Mittelwert der Targets als Erwartungswert • kontinuierlicher Fall: Teile Input in Intervalle • Wenn Intervalle beliebig klein nicht-parametrische Schätzung der Regression SS 2009 Maschinelles Lernen und Neural Computation 63

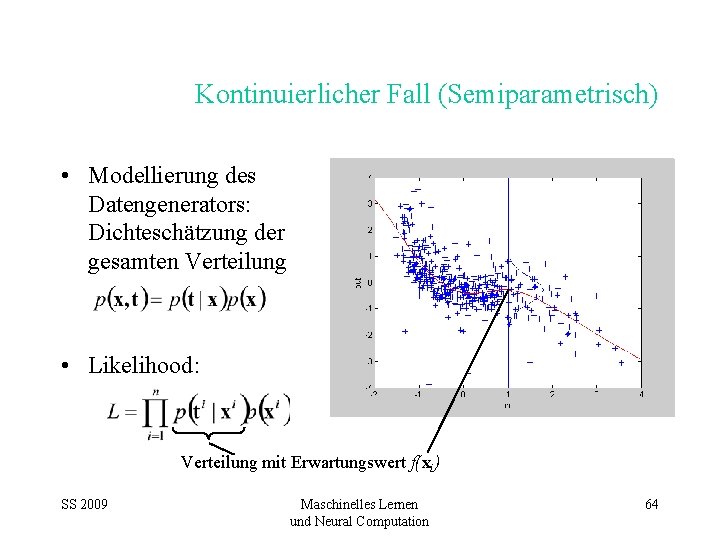

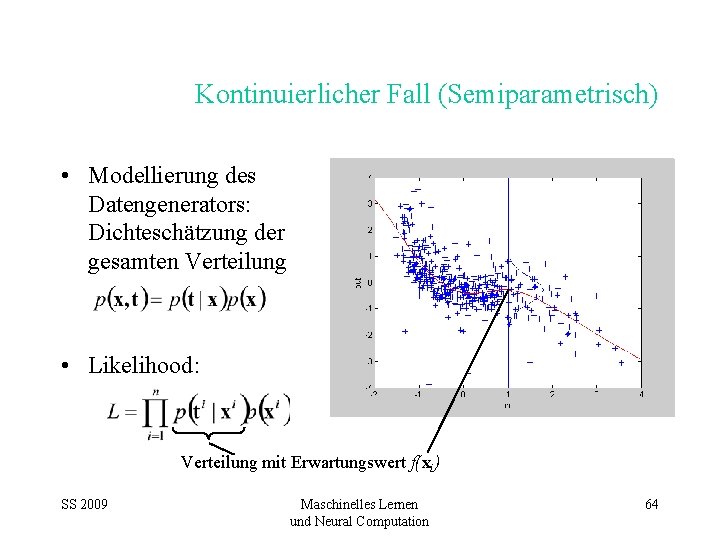

Kontinuierlicher Fall (Semiparametrisch) • Modellierung des Datengenerators: Dichteschätzung der gesamten Verteilung • Likelihood: Verteilung mit Erwartungswert f(xi) SS 2009 Maschinelles Lernen und Neural Computation 64

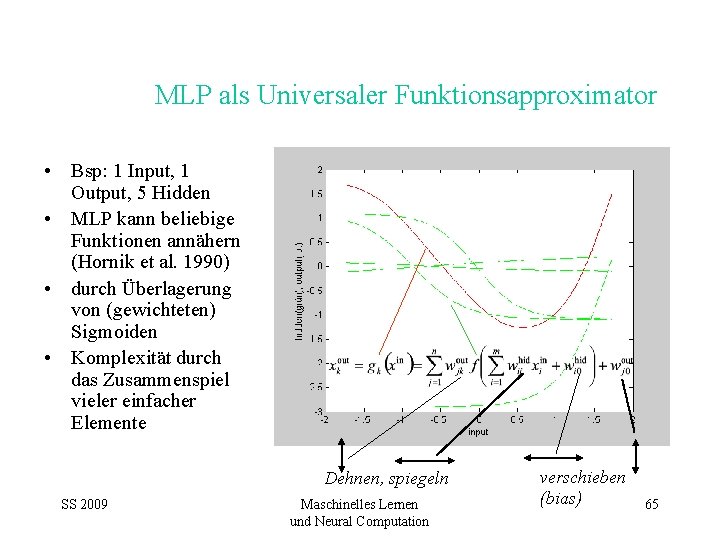

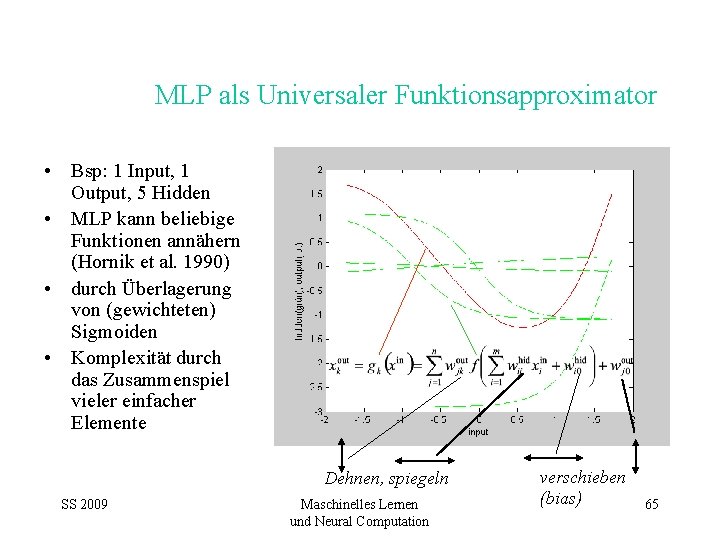

MLP als Universaler Funktionsapproximator • Bsp: 1 Input, 1 Output, 5 Hidden • MLP kann beliebige Funktionen annähern (Hornik et al. 1990) • durch Überlagerung von (gewichteten) Sigmoiden • Komplexität durch das Zusammenspiel vieler einfacher Elemente Dehnen, spiegeln SS 2009 Maschinelles Lernen und Neural Computation verschieben (bias) 65

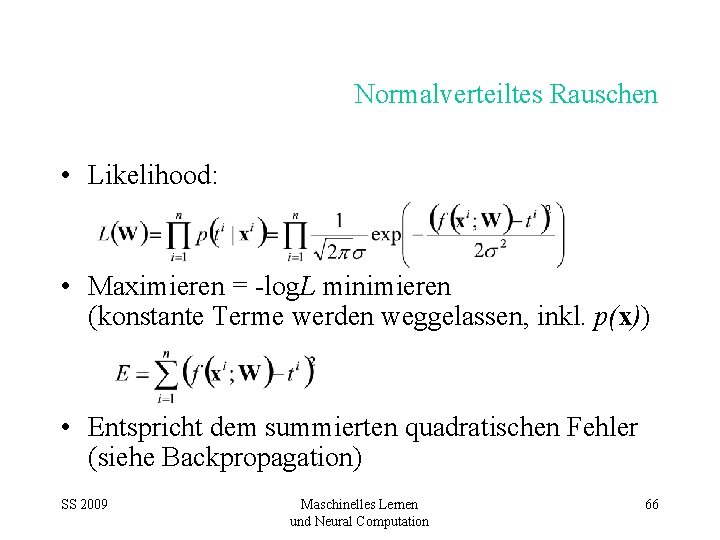

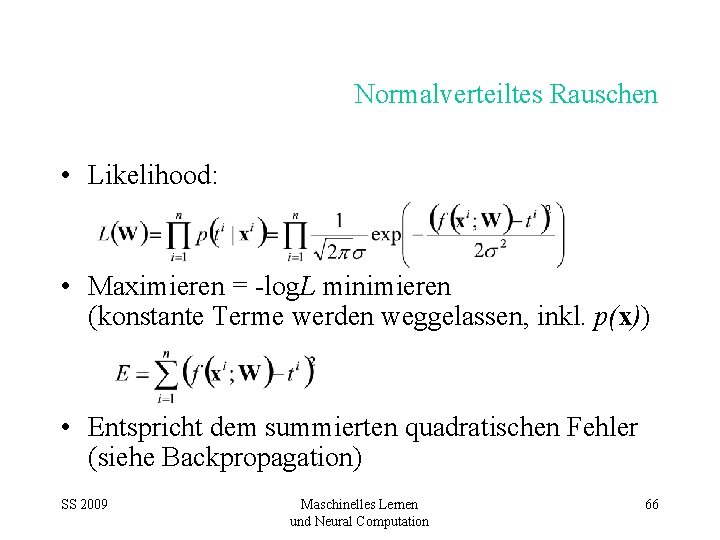

Normalverteiltes Rauschen • Likelihood: • Maximieren = -log. L minimieren (konstante Terme werden weggelassen, inkl. p(x)) • Entspricht dem summierten quadratischen Fehler (siehe Backpropagation) SS 2009 Maschinelles Lernen und Neural Computation 66

Training als Maximum Likelihood • Minimierung des quadratischen Fehlers ist Maximum Likelihood mit den Annahmen: – Fehler ist in jedem Punkt normalverteilt, ~N(0, ) – Varianz dieser Verteilung ist konstant • Varianz des Fehlers (des Rauschens): (verbleibender normalisierter Fehler) • Aber: das muss nicht gelten! Erweiterungen möglich (Rauschmodell) SS 2009 Maschinelles Lernen und Neural Computation 67

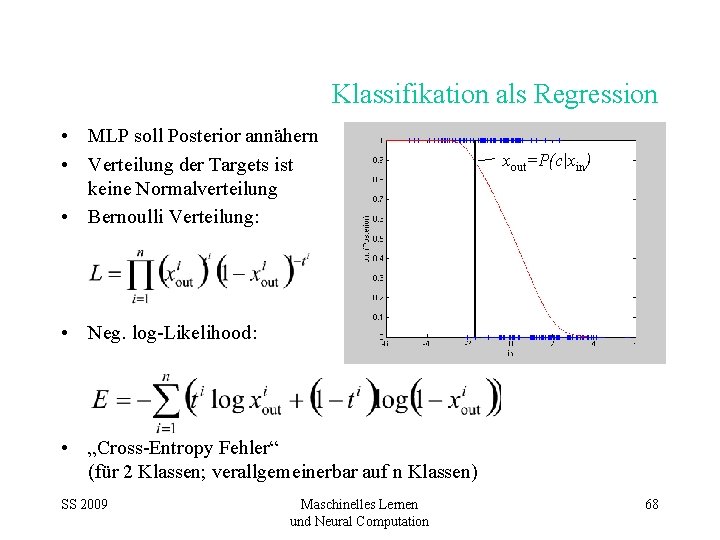

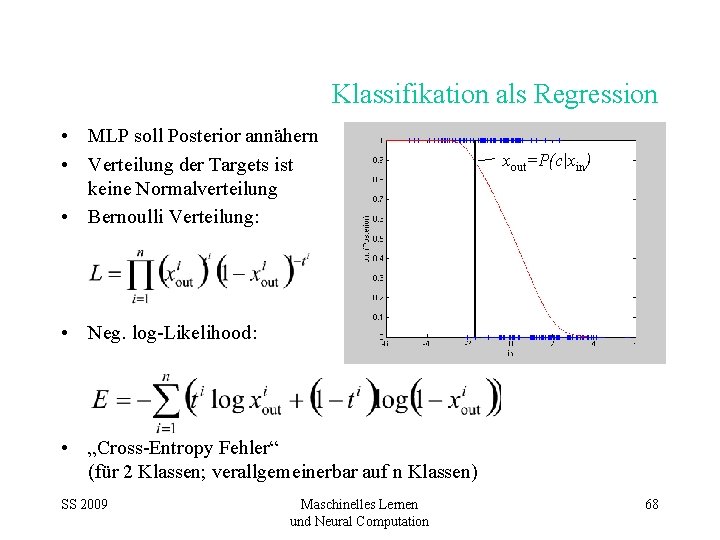

Klassifikation als Regression • MLP soll Posterior annähern • Verteilung der Targets ist keine Normalverteilung • Bernoulli Verteilung: xout=P(c|xin) • Neg. log-Likelihood: • „Cross-Entropy Fehler“ (für 2 Klassen; verallgemeinerbar auf n Klassen) SS 2009 Maschinelles Lernen und Neural Computation 68

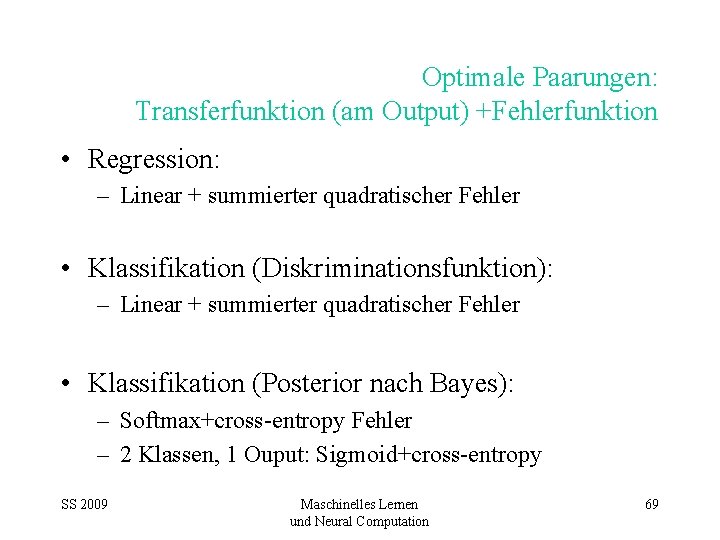

Optimale Paarungen: Transferfunktion (am Output) +Fehlerfunktion • Regression: – Linear + summierter quadratischer Fehler • Klassifikation (Diskriminationsfunktion): – Linear + summierter quadratischer Fehler • Klassifikation (Posterior nach Bayes): – Softmax+cross-entropy Fehler – 2 Klassen, 1 Ouput: Sigmoid+cross-entropy SS 2009 Maschinelles Lernen und Neural Computation 69

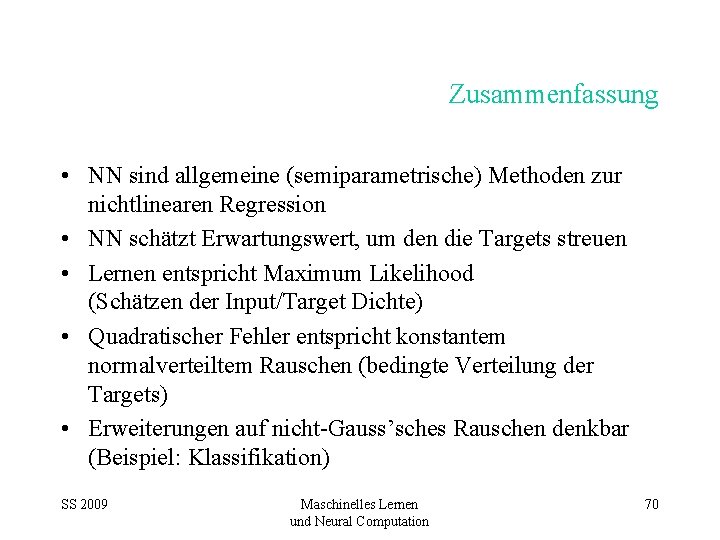

Zusammenfassung • NN sind allgemeine (semiparametrische) Methoden zur nichtlinearen Regression • NN schätzt Erwartungswert, um den die Targets streuen • Lernen entspricht Maximum Likelihood (Schätzen der Input/Target Dichte) • Quadratischer Fehler entspricht konstantem normalverteiltem Rauschen (bedingte Verteilung der Targets) • Erweiterungen auf nicht-Gauss’sches Rauschen denkbar (Beispiel: Klassifikation) SS 2009 Maschinelles Lernen und Neural Computation 70

Lineare regression maschinelles lernen

Lineare regression maschinelles lernen Hypothesenraum

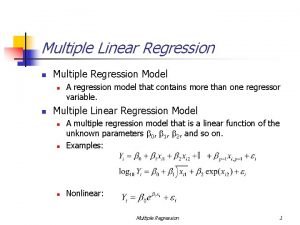

Hypothesenraum Simple linear regression and multiple regression

Simple linear regression and multiple regression Regression linear model

Regression linear model Logistic regression vs linear regression

Logistic regression vs linear regression Logistic regression vs linear regression

Logistic regression vs linear regression Jordabalken 12 kap

Jordabalken 12 kap Emil hilft köpfe waschen

Emil hilft köpfe waschen Kapitel 5 lektion a answers

Kapitel 5 lektion a answers Markusevangelium kapitel 10

Markusevangelium kapitel 10 Good pizza great pizza kapitel 3

Good pizza great pizza kapitel 3 Lena - unser dorf und der krieg kapitel zusammenfassung

Lena - unser dorf und der krieg kapitel zusammenfassung Brief an die galater kapitel 6

Brief an die galater kapitel 6