INTERACTION HOMMEMACHINE EVALUATION DES IHM Prsente par Mme

![Critères d’évaluation –Meinadier(1/2) Performance du couple ordinateur-utilisateur [Meinadier, 91] Bonne IHM 1. facilité d’apprentissage Critères d’évaluation –Meinadier(1/2) Performance du couple ordinateur-utilisateur [Meinadier, 91] Bonne IHM 1. facilité d’apprentissage](https://slidetodoc.com/presentation_image_h/865bc9f30e767228447462a80723a03d/image-38.jpg)

![Critères d’évaluation –Meinadier(2/2) Performance du couple ordinateur-utilisateur [Meinadier, 91] Mauvaise IHM 1. niveau individuel Critères d’évaluation –Meinadier(2/2) Performance du couple ordinateur-utilisateur [Meinadier, 91] Mauvaise IHM 1. niveau individuel](https://slidetodoc.com/presentation_image_h/865bc9f30e767228447462a80723a03d/image-39.jpg)

![Critères d’évaluation –Meinadier(2/2) Performance du couple ordinateur-utilisateur [Meinadier, 91] Mauvaise IHM 2. Niveau entreprise Critères d’évaluation –Meinadier(2/2) Performance du couple ordinateur-utilisateur [Meinadier, 91] Mauvaise IHM 2. Niveau entreprise](https://slidetodoc.com/presentation_image_h/865bc9f30e767228447462a80723a03d/image-40.jpg)

![Critères d’évaluation -Shneiderman 5 critères centraux d’évaluation [Shneiderman, 92] 1. temps d’apprentissage 2. vitesse Critères d’évaluation -Shneiderman 5 critères centraux d’évaluation [Shneiderman, 92] 1. temps d’apprentissage 2. vitesse](https://slidetodoc.com/presentation_image_h/865bc9f30e767228447462a80723a03d/image-41.jpg)

![Critères d’évaluation -Coutaz 7 règles d’or [Coutaz, 90]: 1. lutter pour la cohérence 2. Critères d’évaluation -Coutaz 7 règles d’or [Coutaz, 90]: 1. lutter pour la cohérence 2.](https://slidetodoc.com/presentation_image_h/865bc9f30e767228447462a80723a03d/image-43.jpg)

![Critères d’évaluation -Nielsen 10 heuristiques [Nielsen, 93]: 1. proposer des dialogues simples, naturels et Critères d’évaluation -Nielsen 10 heuristiques [Nielsen, 93]: 1. proposer des dialogues simples, naturels et](https://slidetodoc.com/presentation_image_h/865bc9f30e767228447462a80723a03d/image-48.jpg)

- Slides: 54

INTERACTION HOMME-MACHINE EVALUATION DES IHM Présentée par: Mme: REHAB MOUFIDA Promotion: 2011/2012

Introduction

Introduction Problème de l’industrie du logiciel Ø 84% d’échecs (temps, fonctionnalités, budgets): ü Manque d’intervention des utilisateurs, spécification incomplète, changements par les utilisateurs. Ø 63% d’excès de budgets : ü Demande fréquente de changements par les utilisateurs , taches trop grandes, manque de compréhension des propres requis des utilisateurs, mauvaise communication entre les utilisateurs et les concepteurs Ø Maintenance : 33% debugging, 67% changement par l’utilisateur.

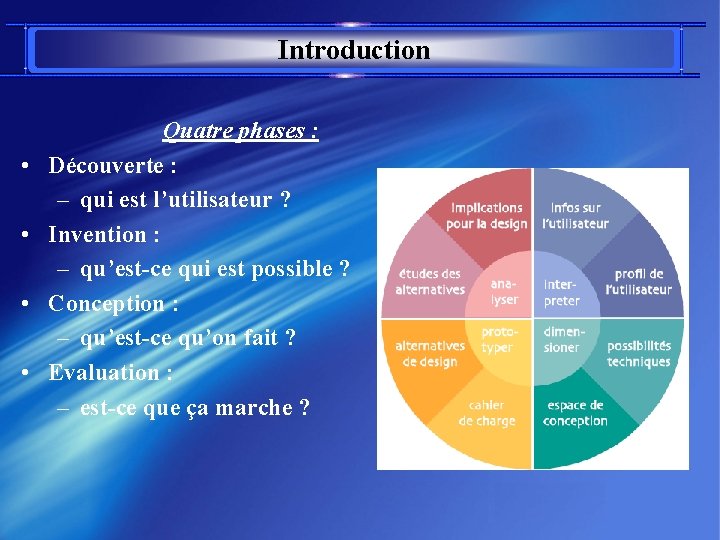

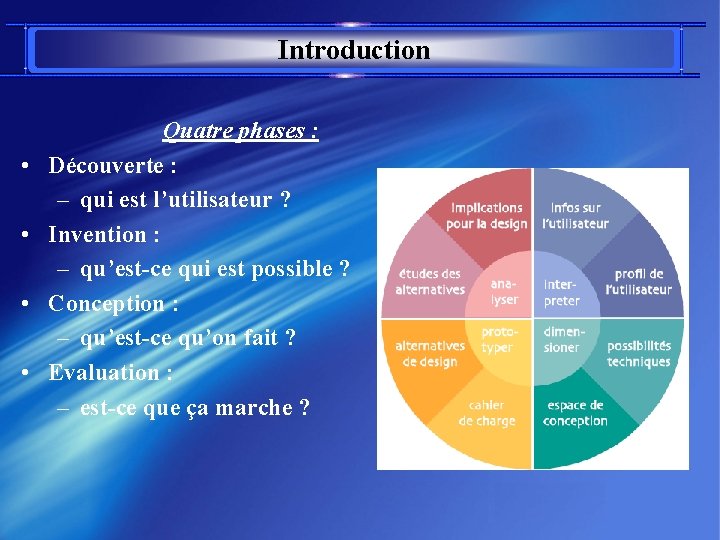

Introduction • • Quatre phases : Découverte : – qui est l’utilisateur ? Invention : – qu’est-ce qui est possible ? Conception : – qu’est-ce qu’on fait ? Evaluation : – est-ce que ça marche ?

Introduction ØModèles de conception : § Souvent centrés systèmes §L’utilisateur n’intervient qu’en amont et en aval de la conception (analyse et évaluation) Modèle en cascade Modèle en V Modèle en Spiral

Historique de l’évalution des IHM Ø Années 1960 : Ø q Années 70 : Ø q PARC Xerox avec en particulier les recherches autour de Smalltalk Début des années 80 Ø q Université de Standford, études sur les partitions d'écran, multifenêtrage Apparition du Star (terminal bureautique de Xerox) et du Lisa (micro bureautique d'Apple). Les idées sont là. Pas la technologie Milieu des années 80 Ø Apparition des microprocesseurs 32 bits look and feel ou WIMP (Windows, Icons, Menus, Pointer)

Historique de l’évalution des IHM q 1984 Ø q 1989 Ø Ø § Lancement du Macintosh (68000) : succès fondé sur la qualité de l'interface et la convivialité PC et compatibles Windows et Presentation Manager CUA (Common User Access, guide) Parallèlement dans le monde UNIX sur stations de travail : X-Window, Motif, Open Look, Next. Step. "convivialité" , "intuitivité", cohérence, contrôle à l'utilisateur années 1990 Ø interfaces multimodales, hypermédia, web (réseau)

Ergonomie Définition Vise à adapter les postes de travail aux caractéristiques physiologiques et psychologiques de la personne

Ergonomie logicielle Définition Vise à adapter les logiciels à l’utilisateur pour diminuer les erreurs, le temps d'apprentissage rendre le logiciel le plus facilement utilisable.

Évaluer, quoi ? Fiabilité et qualité technique Utilisabilité : ØCapacité à permettre à l'utilisateur d'atteindre facilement ses objectifs ØQualité de l’interface (ergonomie) Utilité: ØAdéquation aux objectifs de haut niveau du client ØLe logiciel satisfait-il les spécifications Usages: ØUtilisation réelle du logiciel ØLe logiciel est-il utilisé comme prévu ?

Évaluer, quand ? En cours de conception Øconception itérative de maquettes/prototypes Øconception centrée utilisateur En cours de réalisation Øméthodes classiques de contrôle qualité En cours de diffusion Øsatisfaction des utilisateurs Øincidents critiques Avant un achat Øcomparaison de logiciels Øévaluation sommative

Les méthodes de conception et d’évaluation

Les méthodes d’évaluation Expérimentations contrôlées Quasi-expérience Etude d’utilisabilité

Expériences contrôlées Discipline : psychologie expérimentale/médecine But : ütester une hypothèse ou étudier des corrélations üproduire une connaissance scientifique Étapes: ü Spécifier l'hypothèse : qu'est-ce qu'on étudie ? ü Spécifier les variables indépendantes : qu'est-ce qui varie ? ü Opérationnaliser le comportement comment étudier ces variations ? ü Spécifier les variables dépendantes qu'est-ce qu'on mesure ? ü Spécifier les procédures répartition des groupes, rôle de l'expérimentateur etc. ü Identifier les tests statistiques appropriés y a-t-il une différence ?

Expériences contrôlées-Quelques problemes Réalisées en labo: üpermettent un plus grand contrôle des variables üne peuvent pas être généralisées à des situations réelles

Quasi-Expériences ØBut : Cf. expérimentation contrôlée mais en situation réelle ØProblème : on ne contrôle pas tous les facteurs ØSolution : üFaire varier § le dispositif expérimental §les méthodes expériences , études de cas, interviews §recouper les informations

Etudes d’utilisabilité

l’utilisabilité Utilisabilité : norme ISO 9241 ØDegré selon lequel un produit peut être utilisé, par des utilisateurs identifiés, pour atteindre des buts définis avec efficacité, efficience et satisfaction, dans un contexte d’utilisation spécifié

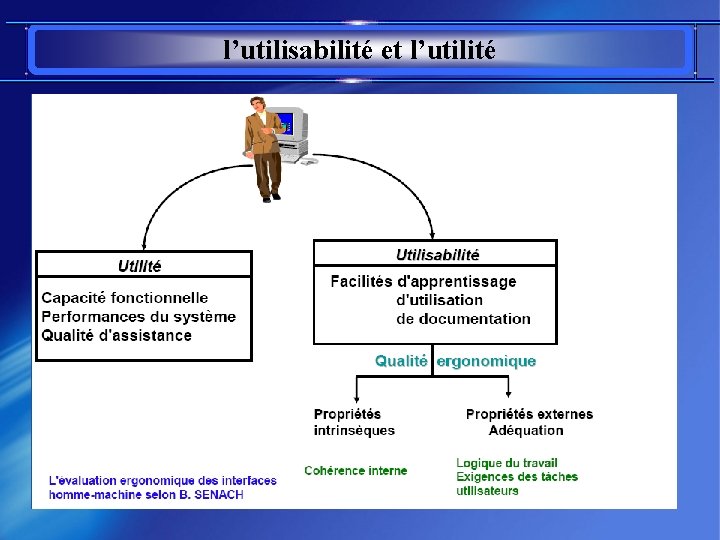

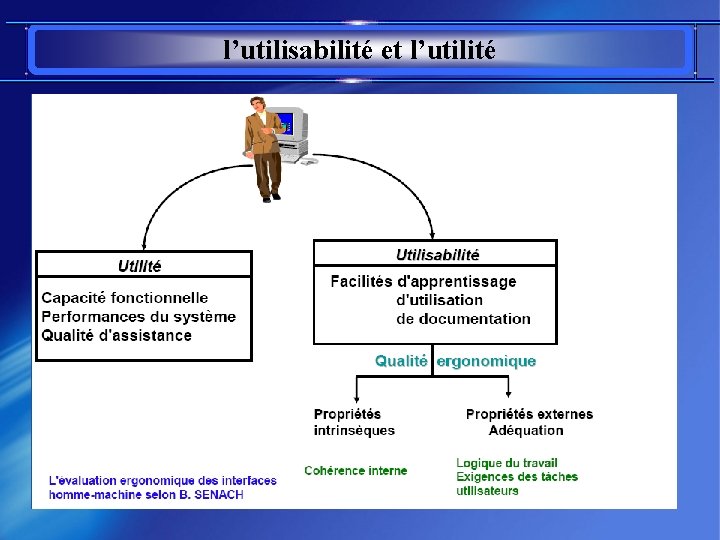

l’utilisabilité et l’utilité

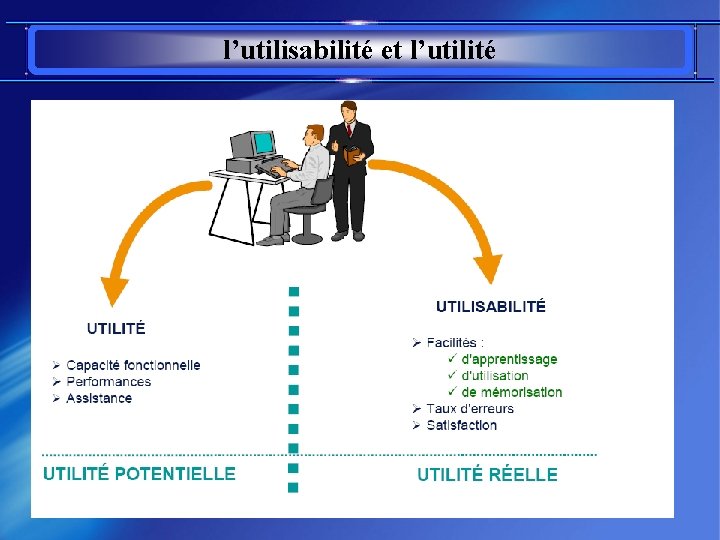

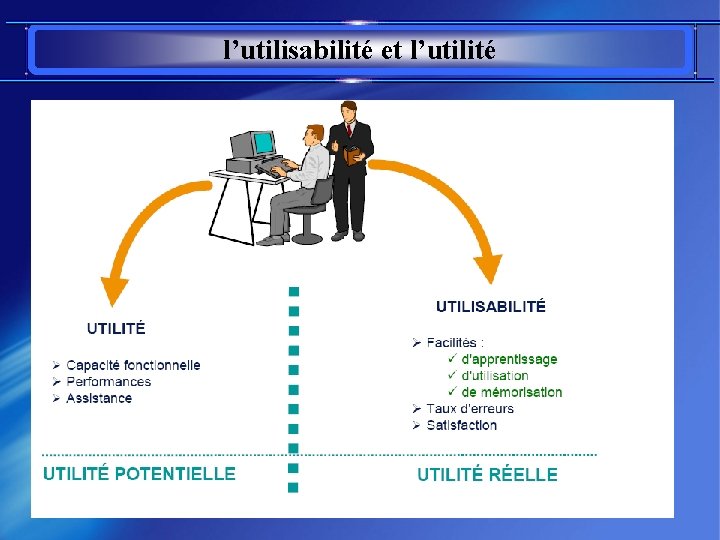

l’utilisabilité et l’utilité

Méthodes d’évaluation de l’utilisabilité

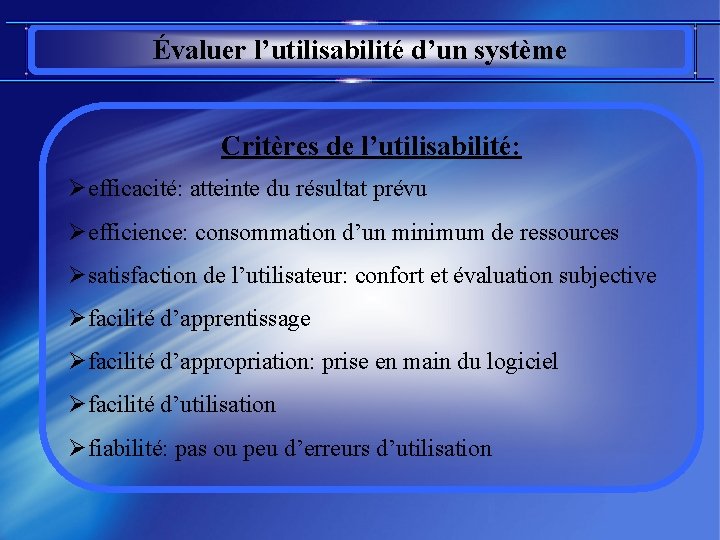

Évaluer l’utilisabilité d’un système Critères de l’utilisabilité: Øefficacité: atteinte du résultat prévu Øefficience: consommation d’un minimum de ressources Øsatisfaction de l’utilisateur: confort et évaluation subjective Øfacilité d’apprentissage Øfacilité d’appropriation: prise en main du logiciel Øfacilité d’utilisation Øfiabilité: pas ou peu d’erreurs d’utilisation

Techniques d’évaluation de l’utilisabilité Évaluation analytique: Øscénario d’utilisation, jugements d’experts Øutilisation de référents Øévaluations heuristiques Øcritères d’évaluation ergonomique

Techniques d’évaluation de l’utilisabilité Évaluation expérimentale: Øobservation et recueil de données Øentretiens, questionnaires

Jugements d’experts Caractéristiques: Ønécessité d’avoir plusieurs experts en début de projet pour évaluer des produits existants Øutiles pour éliminer les grosses erreurs Ønécessité de disposer de scénarios d’utilisation du système et d’une description des futurs utilisateurs

Jugements d’experts Mais. . . Øles experts ne peuvent pas remplacer complètement les utilisateurs Øles experts ont souvent des domaines privilégiés qui constituent des biais d’évaluation

Inspections cognitives (cognitive walkthroughs) ØBut: üévaluer le système en se mettant à la place de l’utilisateur ØMoyen: üspécification d'une série de tâches et des séquences d'actions pour les réaliser üévaluation en imaginant ce que ferait l'utilisateur ücomprend-il les messages, le comportement du système ? üinterprétation et prise en compte des résultats

Entretiens critiques ØBut: üidentifier des exemples spécifiques de problèmes rencontrés par les utilisateurs ØProcédure: üinterviewer l'utilisateur dans son environnement de travail ülui demander de se souvenir d'un problème particulier vécu dans un passé récent ülui demander de décrire chaque incident en détail ülui demander ce qui est habituel et ce qui ne l'est pas dans l'incident

Observations ØBut: üidentifier les gros problèmes du logiciel (prototype / système final) ØProcédure üen laboratoire ou sur le terrain üchoisir au moins 2 utilisateurs qui agiront indépendamment üdéfinir une mission spécifique (résoudre un problème, suivre un scénario) üdécider de ce que l'on veut mesurer üdemander aux utilisateurs d'effectuer la tâche (méthode intrusive) üobservation directe simple avec explication à haute voix üà deux pour observer leurs interactions (interrogations, explications) üenregistrer les interactions, puis les analyser üpapier, audio, vidéo, trace informatique

Observations-Analyses de protocoles(1) ØTraces papier: ücoût de traitement acceptable üne donnent qu’un point de vue

Observations-Analyses de protocoles(2) ØEnregistrements vidéo (ou audio): üDécouvrir les activités de l’utilisateur à travers un enregistrement vidéos ØInconvénients: ütrès long et coûteux à dépouiller

Observations-Analyses de protocoles(3) ØTraces informatiques: ümémorisation de (toutes) les actions de l’utilisateur üpermet de rejouer la session üobjectif : dépouillement automatiquement ül’analyse doit être prévue avant

Questionnaires ØBut: ürésumer économiquement l’avis de nombreux utilisateurs ØSuppositions: üLes utilisateurs répondent honnêtement üLes questions concernent le phénomène auquel on s'intéresse ØProcédure: üdéterminer le public (représentatif) destinataire du questionnaire ücomment diffuser/récupérer ücomment analyser les résultats (automatiquement/manuellement) ØTypes de questions: üinformations générales üquestions ouvertes, dirigées, QCM üéchelle, classements

Évaluation des utilisateurs Connaissances et expérience de l'utilisateur: ØNe se réduit pas à expert ou novice : Donc, divers niveaux d'interface, adaptables selon les utilisateurs sont à prendre en compte : ü Niveau d'éducation (capacité à abstraction, niveau de lecture) ü Habitude à frappe clavier ü Expérience en informatique ü Expérience sur la tâche ü Expérience en systèmes automatisés ü Utilisation d'autres systèmes. .

Évaluer l’utilité d’un système Adéquation aux objectifs de haut niveau du client: Øle logiciel satisfait-il les spécifications ? Øl’utilisateur peut-il accomplir sa tâche à partir des fonctionnalités du système ?

Critères d’évaluation ergonomique

Critères d’évaluation ergonomique 10 heuristiques v. Nielsen Performance du couple ordinateur-utilisateur v Meinadier 5 critères centraux d’évaluation v. Shneiderman 7 règles d’or v Coutaz 8 critères v Ravdenet Johnson critères ergonomiques v. Bastien et Scapin (INRIA)

![Critères dévaluation Meinadier12 Performance du couple ordinateurutilisateur Meinadier 91 Bonne IHM 1 facilité dapprentissage Critères d’évaluation –Meinadier(1/2) Performance du couple ordinateur-utilisateur [Meinadier, 91] Bonne IHM 1. facilité d’apprentissage](https://slidetodoc.com/presentation_image_h/865bc9f30e767228447462a80723a03d/image-38.jpg)

Critères d’évaluation –Meinadier(1/2) Performance du couple ordinateur-utilisateur [Meinadier, 91] Bonne IHM 1. facilité d’apprentissage 2. facilité, efficacité et sécurité d’utilisation 3. plaisir d’utilisation 4. acceptabilité du logiciel 5. satisfaction des utilisateurs 6. productivité satisfaisante du couple personne-machine 7. rentabilité pour l’entreprise

![Critères dévaluation Meinadier22 Performance du couple ordinateurutilisateur Meinadier 91 Mauvaise IHM 1 niveau individuel Critères d’évaluation –Meinadier(2/2) Performance du couple ordinateur-utilisateur [Meinadier, 91] Mauvaise IHM 1. niveau individuel](https://slidetodoc.com/presentation_image_h/865bc9f30e767228447462a80723a03d/image-39.jpg)

Critères d’évaluation –Meinadier(2/2) Performance du couple ordinateur-utilisateur [Meinadier, 91] Mauvaise IHM 1. niveau individuel Øconfusion Øfrustration Øpanique Østress Øennui

![Critères dévaluation Meinadier22 Performance du couple ordinateurutilisateur Meinadier 91 Mauvaise IHM 2 Niveau entreprise Critères d’évaluation –Meinadier(2/2) Performance du couple ordinateur-utilisateur [Meinadier, 91] Mauvaise IHM 2. Niveau entreprise](https://slidetodoc.com/presentation_image_h/865bc9f30e767228447462a80723a03d/image-40.jpg)

Critères d’évaluation –Meinadier(2/2) Performance du couple ordinateur-utilisateur [Meinadier, 91] Mauvaise IHM 2. Niveau entreprise / social Ørejet, erreurs graves (centrale nucléaire) Ømauvaise ou sous-utilisation, baisse des performances Ørégression vers des tâches d’exécution Øcoûts : modification des tâches, réécriture du système, détournement…

![Critères dévaluation Shneiderman 5 critères centraux dévaluation Shneiderman 92 1 temps dapprentissage 2 vitesse Critères d’évaluation -Shneiderman 5 critères centraux d’évaluation [Shneiderman, 92] 1. temps d’apprentissage 2. vitesse](https://slidetodoc.com/presentation_image_h/865bc9f30e767228447462a80723a03d/image-41.jpg)

Critères d’évaluation -Shneiderman 5 critères centraux d’évaluation [Shneiderman, 92] 1. temps d’apprentissage 2. vitesse d’exécution des tâches par le couple homme/machine 3. taux d’erreurs et facilité de leur récupération 4. rétention de l’apprentissage dans le temps 5. satisfaction subjective des utilisateurs

Critères d’évaluation -INRIA 8 critères ergonomiques pour évaluer une interface utilisateur [Bastien & Scapin, 93]: 1. guidage 2. charge de travail 3. contrôle explicite 4. adaptabilité 5. gestion des erreurs 6. homogénéité/cohérence 7. signifiance des codes et dénominations 8. compatibilité

![Critères dévaluation Coutaz 7 règles dor Coutaz 90 1 lutter pour la cohérence 2 Critères d’évaluation -Coutaz 7 règles d’or [Coutaz, 90]: 1. lutter pour la cohérence 2.](https://slidetodoc.com/presentation_image_h/865bc9f30e767228447462a80723a03d/image-43.jpg)

Critères d’évaluation -Coutaz 7 règles d’or [Coutaz, 90]: 1. lutter pour la cohérence 2. lutter pour la concision 3. réduire la charge cognitive 4. mettre le contrôle entre les mains de l’utilisateur 5. souplesse d’utilisation 6. structurer le dialogue 7. prédire les erreurs

Qu'est-ce que l'évaluation heuristique ? C'est une technique d'analyse réalisée à partir de guides d'évaluation appelés guides heuristiques, il s'agit de passer en revue toute l’interface à l'aide d'une grille d'analyse et de vérifier si les guides spécifiés sont présents ou non.

Qu'est-ce que l'évaluation heuristique ? q q Nous dirons que cette méthode fait gagner du temps (et donc de l'argent !) Elle permet d'évaluer rapidement le bon fonctionnement d'une interface (à condition bien entendu de disposer des bons guides) Les premières listes de guides utilisées (en 96 -97) étaient plutôt longues et mal adaptées aux besoins des utilisateurs La principale evaluation heuristiques est celle de J. Nielsen avec sa liste de 10 guides heuristiques qu'il utilise depuis presque une dizaine d'années.

Qu'est-ce que l'évaluation heuristique ? Quand ? q q Elle est appliquer souvent, dès que le test se révèle impossible de par l'insuffisance de la matière accessible. Notamment dans les premiers stades de conception. Mais l'analyse peut être réalisée également à partir de maquette papier, ou maquette écran (type acrobat) Lorsque le produit à évaluer est suffisamment évolué, on peut aussi vérifier la validité de l'interface (à l'aide des guides) en interview avec l'utilisateur.

Qu'est-ce que l'évaluation heuristique ? q Comment ? q q q L'E. H. est généralement réalisée par une équipe de 2 ou 3 experts qui passent en revue l'ensemble de l'interface au moyen d'une liste de principes appelés "heuristiques » . Chaque expert évalue de son côté l'interface avec les guides qui lui sont fournis Ensuite chacun confronte son point de vue avec celui de son collègue

![Critères dévaluation Nielsen 10 heuristiques Nielsen 93 1 proposer des dialogues simples naturels et Critères d’évaluation -Nielsen 10 heuristiques [Nielsen, 93]: 1. proposer des dialogues simples, naturels et](https://slidetodoc.com/presentation_image_h/865bc9f30e767228447462a80723a03d/image-48.jpg)

Critères d’évaluation -Nielsen 10 heuristiques [Nielsen, 93]: 1. proposer des dialogues simples, naturels et minimum 2. parler le langage de l’utilisateur 3. minimiser la charge de mémoire de l’utilisateur 4. être cohérent (sans contradiction), respecter les standards 5. refléter le monde réel 6. fournir un retour à l’utilisateur 7. permettre une personnalisation par les utilisateurs expérimentés 8. prévenir les erreurs 9. aider l’utilisateur à reconnaître, diagnostiquer et réparer les erreurs 10. rendre accessible aide et documentation

Quelques exemples

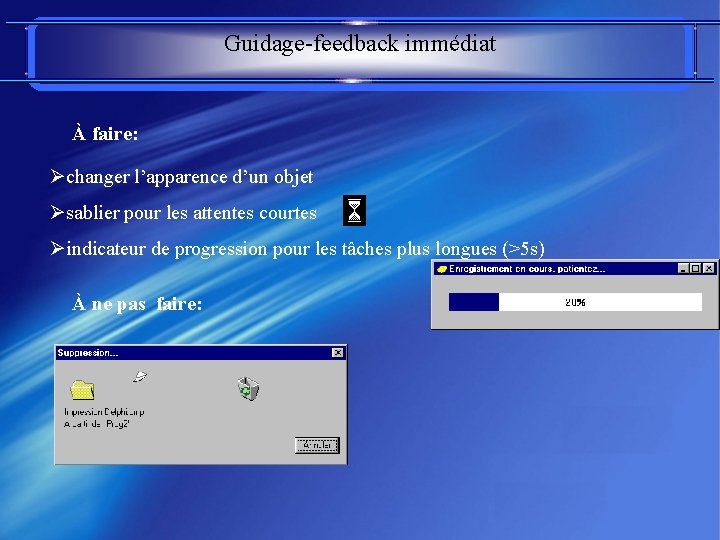

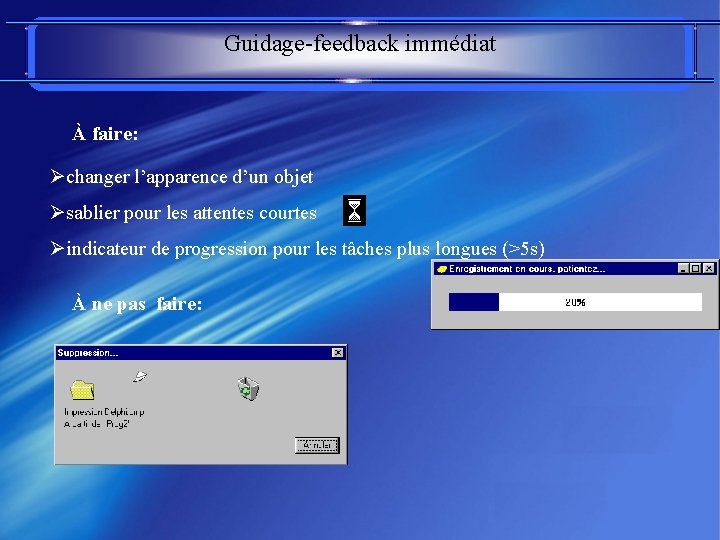

Guidage-feedback immédiat À faire: Øchanger l’apparence d’un objet Øsablier pour les attentes courtes Øindicateur de progression pour les tâches plus longues (>5 s) À ne pas faire:

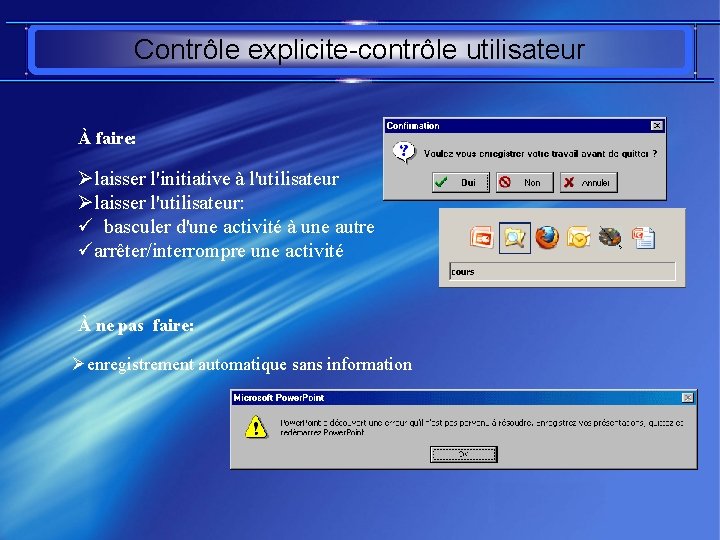

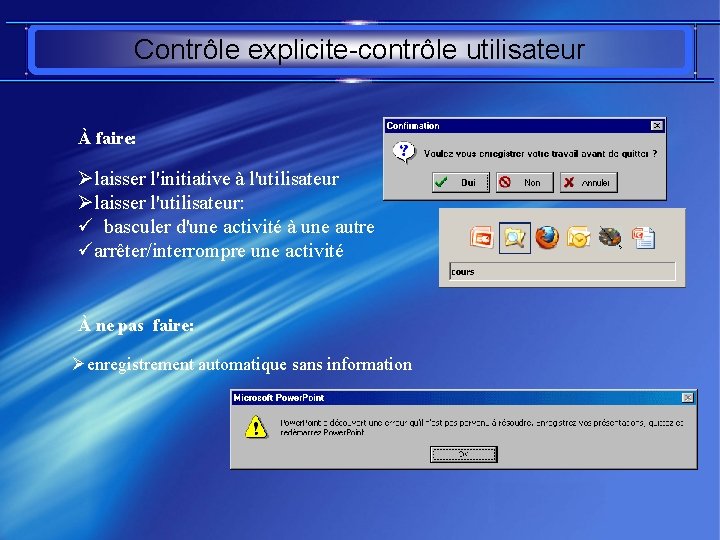

Contrôle explicite-contrôle utilisateur À faire: Ølaisser l'initiative à l'utilisateur Ølaisser l'utilisateur: ü basculer d'une activité à une autre üarrêter/interrompre une activité À ne pas faire: Øenregistrement automatique sans information

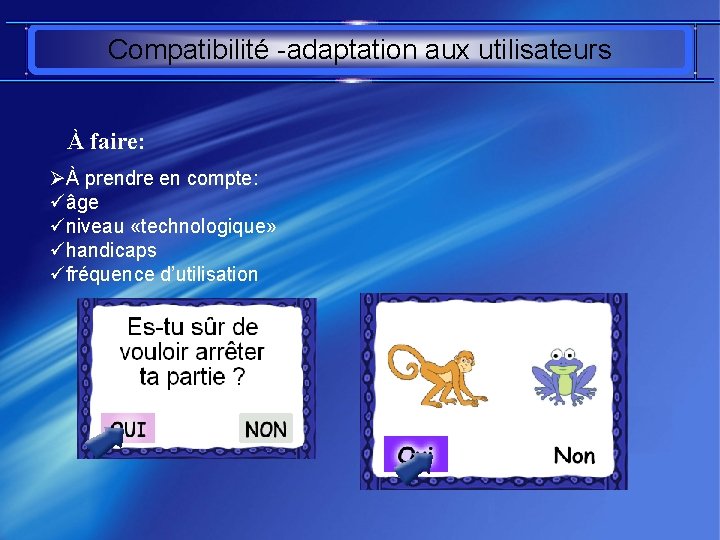

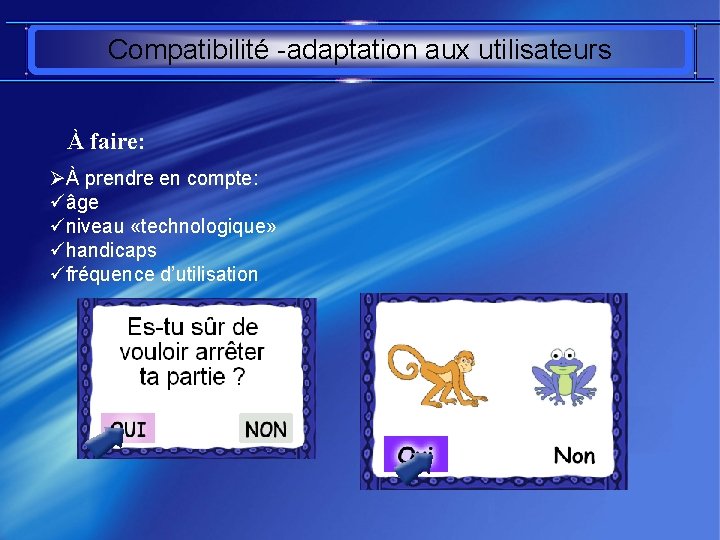

Compatibilité -adaptation aux utilisateurs À faire: ØÀ prendre en compte: üâge üniveau «technologique» ühandicaps üfréquence d’utilisation

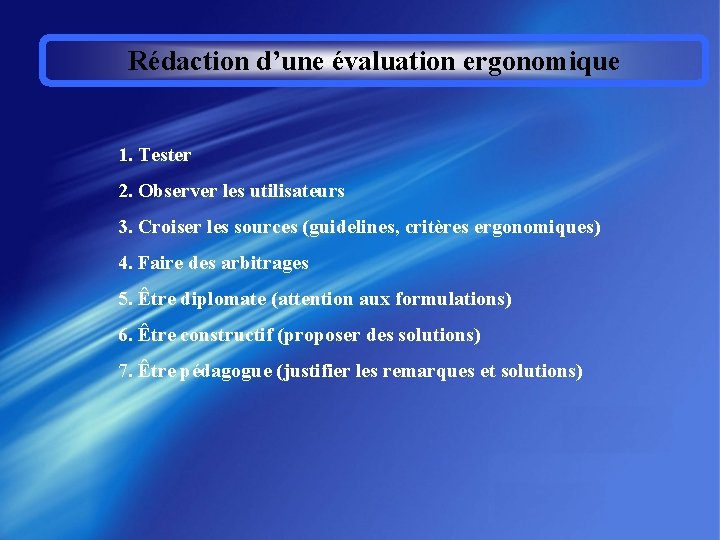

Rédaction d’une évaluation ergonomique 1. Tester 2. Observer les utilisateurs 3. Croiser les sources (guidelines, critères ergonomiques) 4. Faire des arbitrages 5. Être diplomate (attention aux formulations) 6. Être constructif (proposer des solutions) 7. Être pédagogue (justifier les remarques et solutions)

Merci pour votre Attention !