Uenje pojaavanjem Reinforcement Learning Igor Gorean Daniel Zrno

- Slides: 36

Učenje pojačavanjem Reinforcement Learning Igor Gorečan Daniel Zrno

O čemu ćemo govoriti? • Problemi kod klasičnog pristupa strojnom učenju • Svojstva agenta kod RL učenja / učenje strategije • Q-učenje • Proširenje modela za Q učenje • TD učenje • Metode generalizacije • Primjeri realnih sustava temeljenih na RL

Reinforcement Learning, in general Po autoru T. Dietterich, razvoj u strojnom učenju se dijeli na 4 glavna smjera: • Ensambles of classifiers • Methods of scaling up supervised learning algorithms • Learning of complex stochastic models • Reinforcement learning

Česti problemi kod klasičnog pristupa strojnog učenja z Problem odgođene nagrade (DELAYED REWARD) z Problem djelomično vidljivog okoliša (PARTIALLY OBSERVABLE STATES) z Problem istraživanja (EXPLORATION) z Problem učenja "za cijeli život" (LIFE-LONG LEARNING)

Problem odgođene nagrade (DELAYED REWARD) z Ne postoji kvalificirani učitelj koji određuje ispravnost svake akcije (kao kod supervised learning), nego se ocjenjuje samo uspješnost CIJELOG niza akcija (npr. pobjeda ili poraz u šahu) z Kako će stroj odrediti važnost svakog pojedinog koraka u nizu akcija za postizanje krajnjeg rezultata? z Stroj ne zna posljedicu vlastitih akcija tj. način na koje one transformiraju stanje okoliša z Kako učiti s nepostojećim početnim znanjem?

Problem djelomično vidljivog okoliša (PARTIALLY OBSERVABLE STATES) z Stroj ne može u svakom trenutku percipirati cijelo stanje okoliša z Kako iskoristiti prošla opažanja i koje je akcije potrebno izvršiti da se poboljša percepcija/znanje o okolišu?

Problem istraživanja (EXPLORATION) z Kako suprostaviti istraživanje nepoznatog prema iskorištavanju poznatog i naučenog z Kada smatramo da je stroj zadovoljavajuće naučio rješavati problem?

Problem učenja "za cijeli život" (LIFE-LONG LEARNING) z Kod učenja novih spoznaja/načina rješavanja problema, mora iskoristiti i nadograditi se na već naučeno z Kako prepoznati rješenje problema u okviru postoječeg znanja?

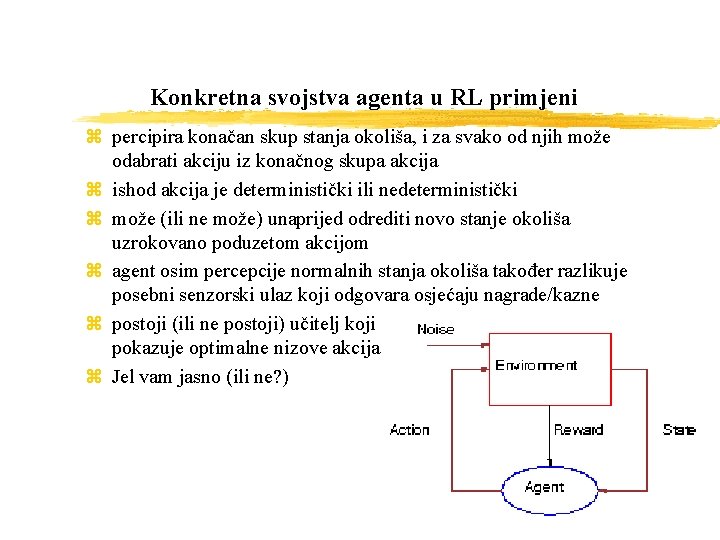

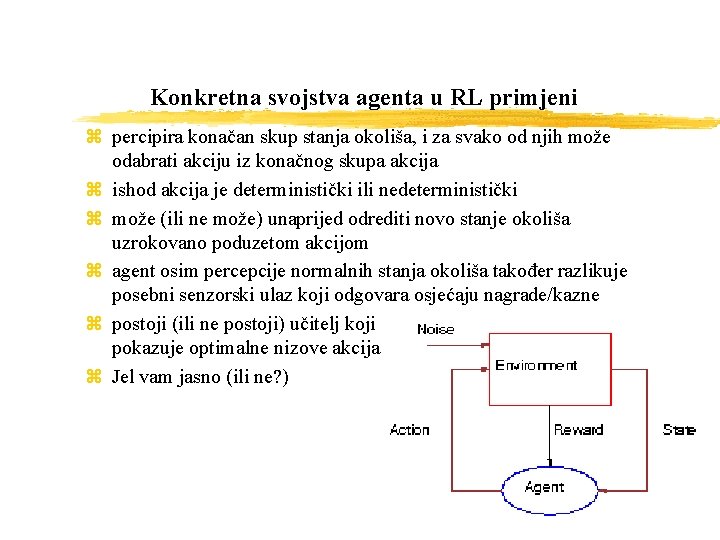

Konkretna svojstva agenta u RL primjeni z percipira konačan skup stanja okoliša, i za svako od njih može odabrati akciju iz konačnog skupa akcija z ishod akcija je deterministički ili nedeterministički z može (ili ne može) unaprijed odrediti novo stanje okoliša uzrokovano poduzetom akcijom z agent osim percepcije normalnih stanja okoliša također razlikuje posebni senzorski ulaz koji odgovara osjećaju nagrade/kazne z postoji (ili ne postoji) učitelj koji pokazuje optimalne nizove akcija z Jel vam jasno (ili ne? )

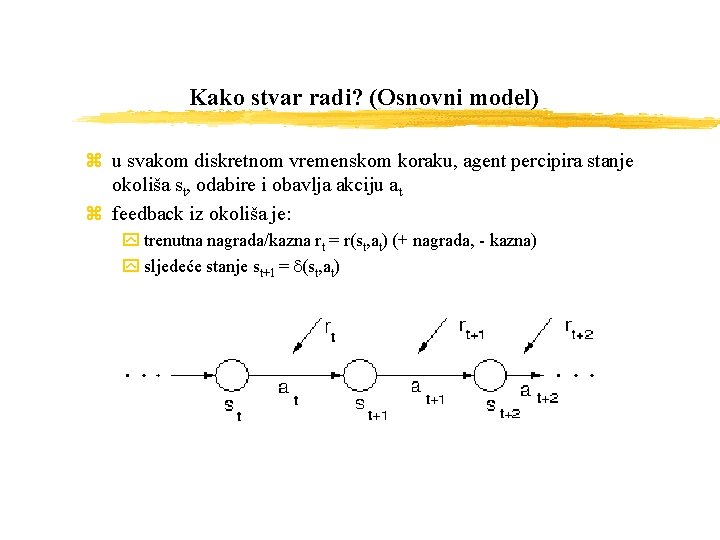

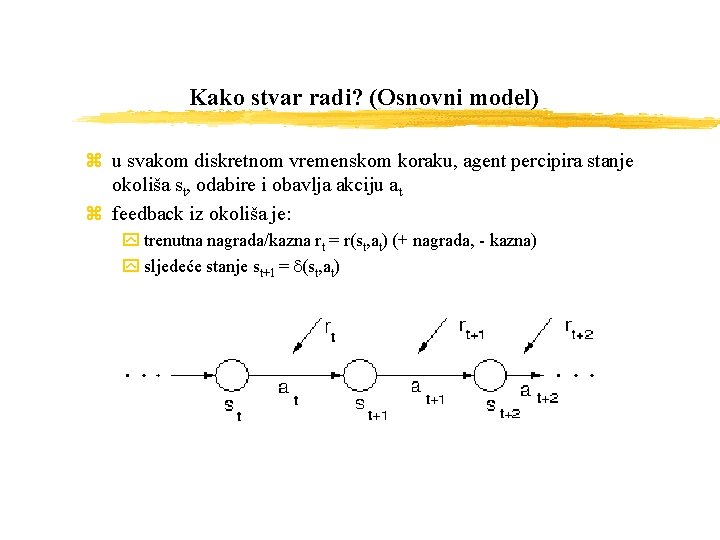

Kako stvar radi? (Osnovni model) z u svakom diskretnom vremenskom koraku, agent percipira stanje okoliša st, odabire i obavlja akciju at z feedback iz okoliša je: y trenutna nagrada/kazna rt = r(st, at) (+ nagrada, - kazna) y sljedeće stanje st+1 = d(st, at)

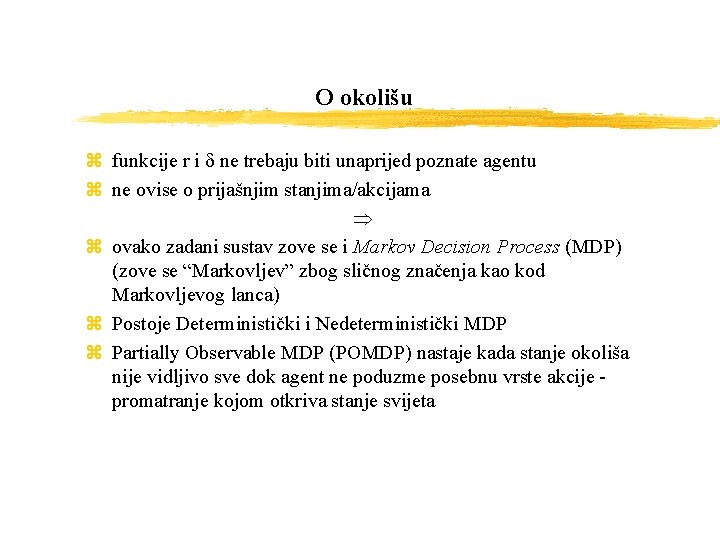

O okolišu z funkcije r i d ne trebaju biti unaprijed poznate agentu z ne ovise o prijašnjim stanjima/akcijama z ovako zadani sustav zove se i Markov Decision Process (MDP) (zove se “Markovljev” zbog sličnog značenja kao kod Markovljevog lanca) z Postoje Deterministički i Nedeterministički MDP z Partially Observable MDP (POMDP) nastaje kada stanje okoliša nije vidljivo sve dok agent ne poduzme posebnu vrste akcije - promatranje kojom otkriva stanje svijeta

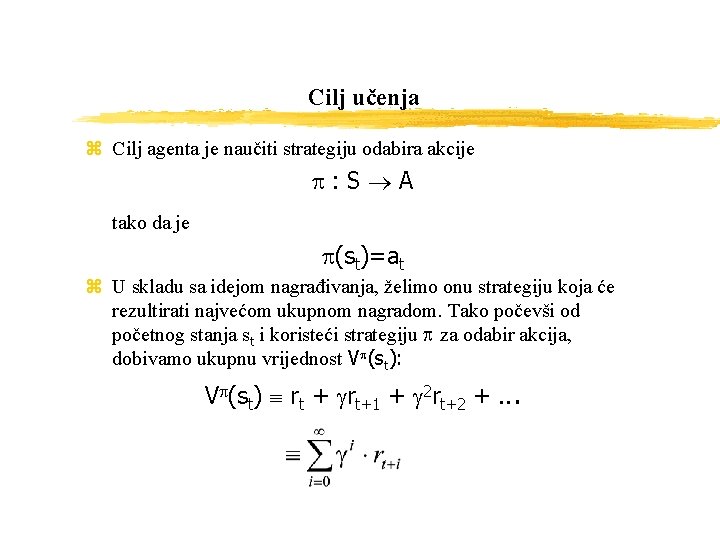

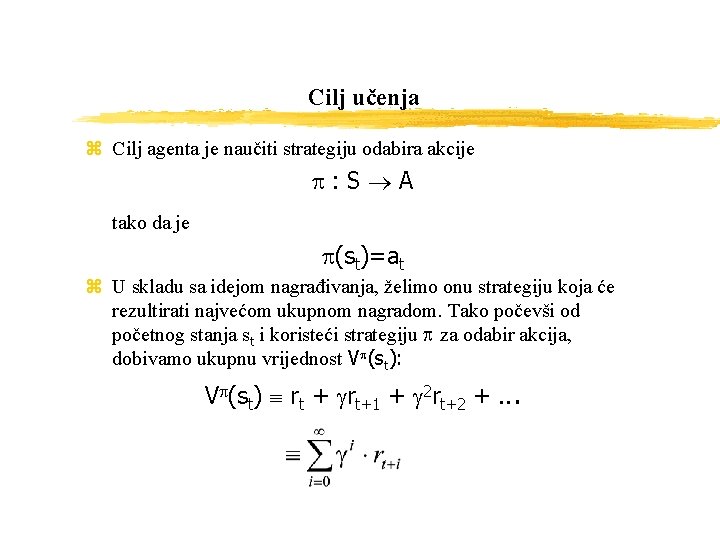

Cilj učenja z Cilj agenta je naučiti strategiju odabira akcije p: S A tako da je p(st)=at z U skladu sa idejom nagrađivanja, želimo onu strategiju koja će rezultirati najvećom ukupnom nagradom. Tako počevši od početnog stanja st i koristeći strategiju p za odabir akcija, dobivamo ukupnu vrijednost Vp(st): Vp(st) rt + grt+1 + g 2 rt+2 +. . .

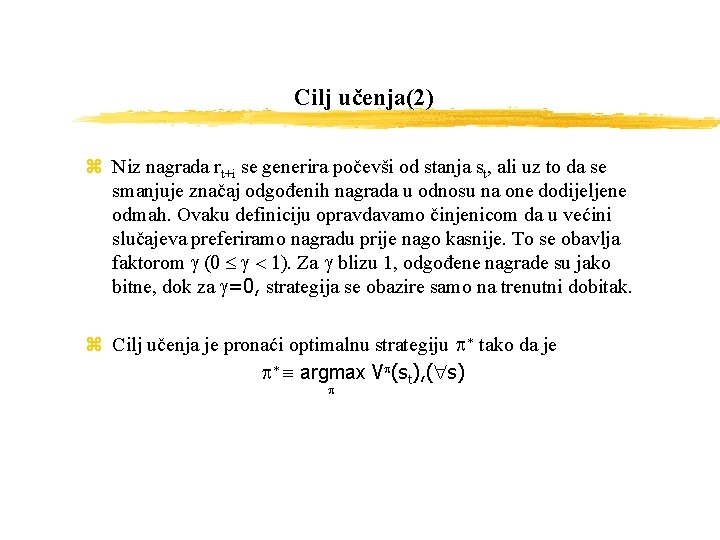

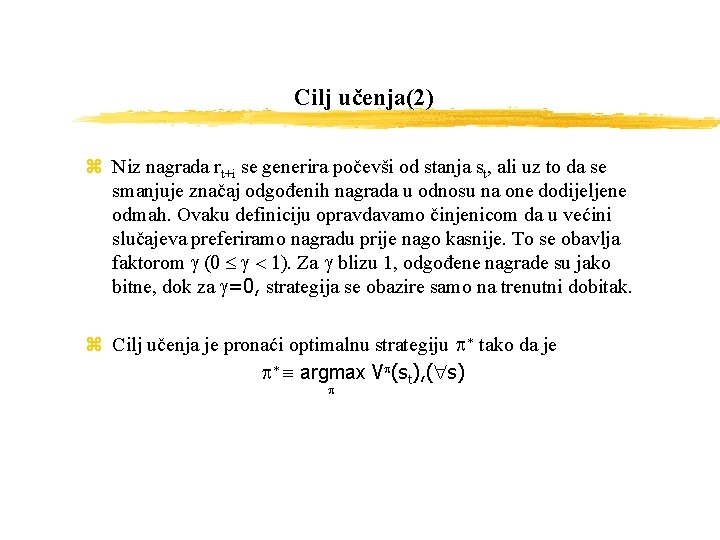

Cilj učenja(2) z Niz nagrada rt+i se generira počevši od stanja st, ali uz to da se smanjuje značaj odgođenih nagrada u odnosu na one dodijeljene odmah. Ovaku definiciju opravdavamo činjenicom da u većini slučajeva preferiramo nagradu prije nago kasnije. To se obavlja faktorom g (0 g < 1). Za g blizu 1, odgođene nagrade su jako bitne, dok za g=0, strategija se obazire samo na trenutni dobitak. z Cilj učenja je pronaći optimalnu strategiju p* tako da je p* argmax Vp(st), ( s) p

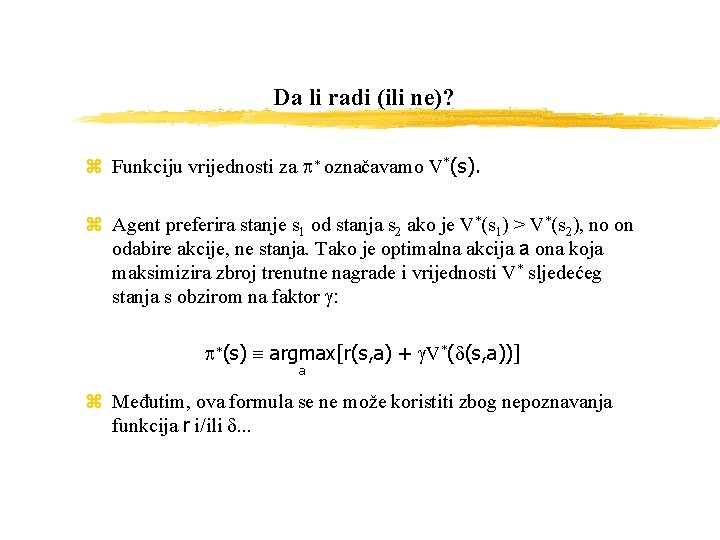

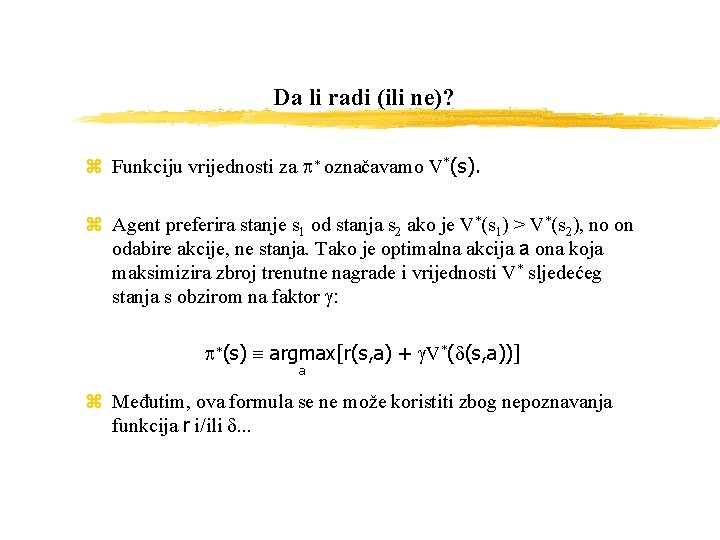

Da li radi (ili ne)? z Funkciju vrijednosti za p* označavamo V*(s). z Agent preferira stanje s 1 od stanja s 2 ako je V*(s 1) > V*(s 2), no on odabire akcije, ne stanja. Tako je optimalna akcija a ona koja maksimizira zbroj trenutne nagrade i vrijednosti V* sljedećeg stanja s obzirom na faktor g: p*(s) argmax[r(s, a) + g. V*(d(s, a))] a z Međutim, ova formula se ne može koristiti zbog nepoznavanja funkcija r i/ili d. . .

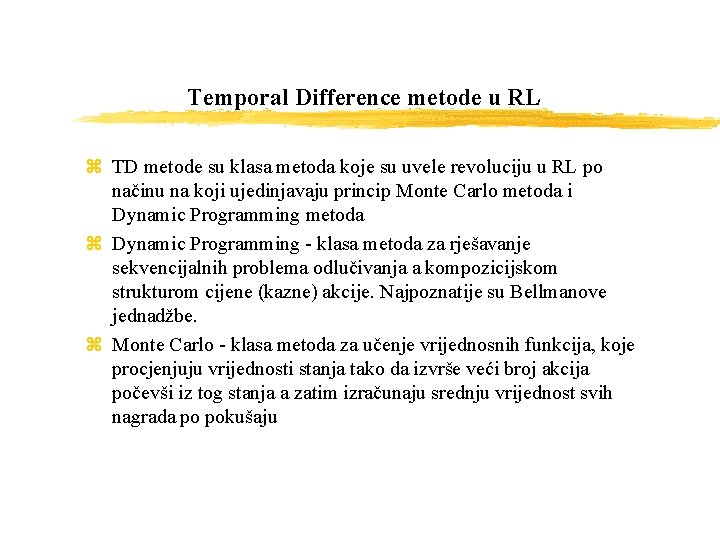

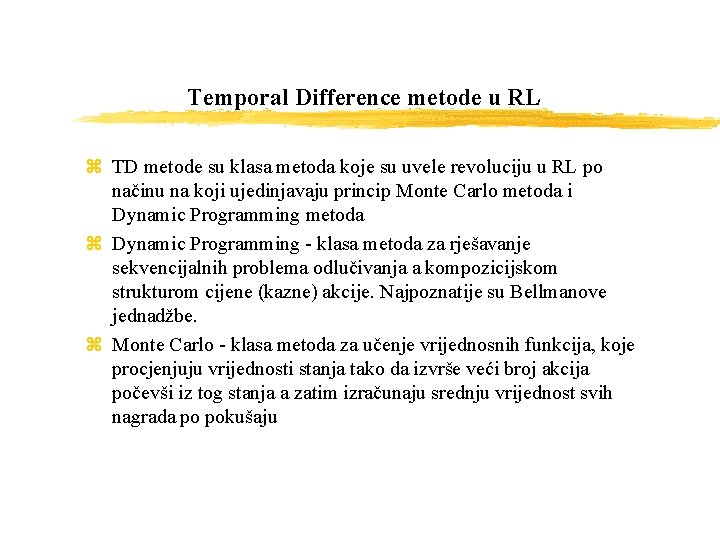

Temporal Difference metode u RL z TD metode su klasa metoda koje su uvele revoluciju u RL po načinu na koji ujedinjavaju princip Monte Carlo metoda i Dynamic Programming metoda z Dynamic Programming - klasa metoda za rješavanje sekvencijalnih problema odlučivanja a kompozicijskom strukturom cijene (kazne) akcije. Najpoznatije su Bellmanove jednadžbe. z Monte Carlo - klasa metoda za učenje vrijednosnih funkcija, koje procjenjuju vrijednosti stanja tako da izvrše veći broj akcija počevši iz tog stanja a zatim izračunaju srednju vrijednost svih nagrada po pokušaju

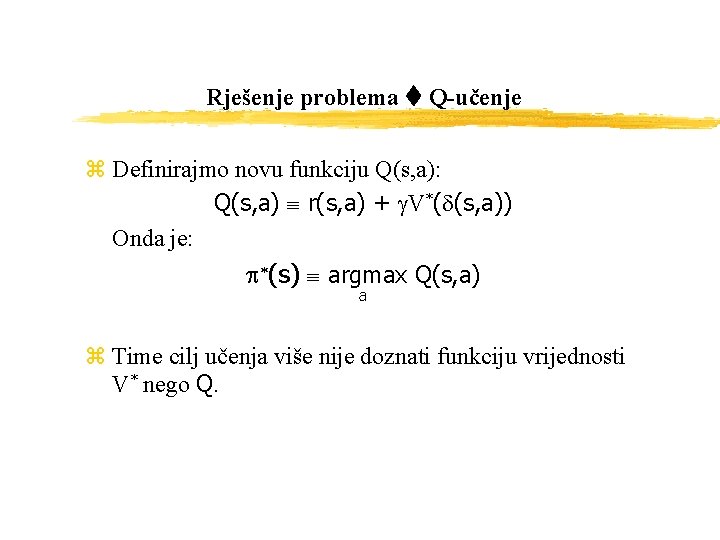

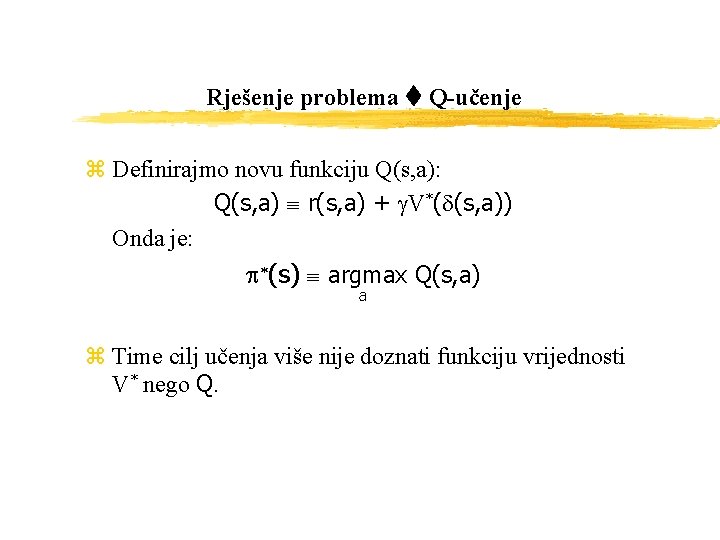

Rješenje problema Q-učenje z Definirajmo novu funkciju Q(s, a): Q(s, a) r(s, a) + g. V*(d(s, a)) Onda je: p*(s) argmax Q(s, a) a z Time cilj učenja više nije doznati funkciju vrijednosti V* nego Q.

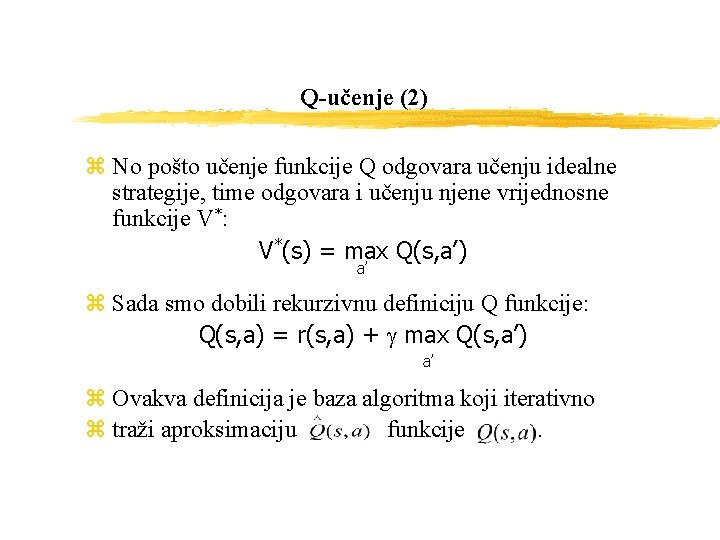

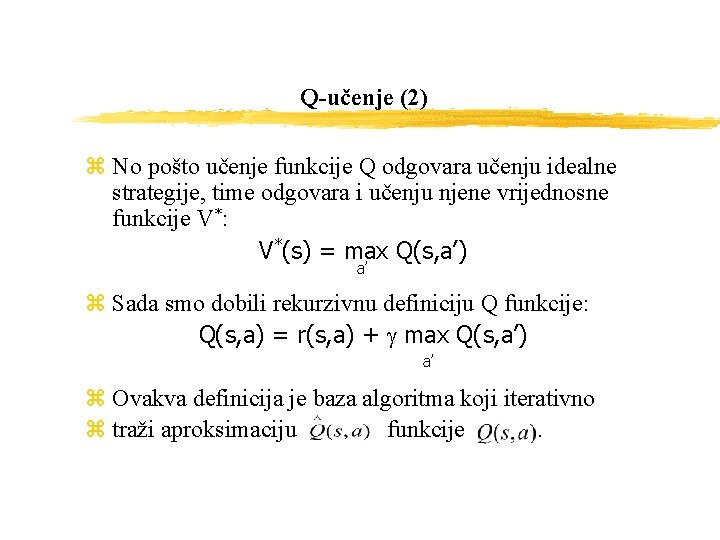

Q-učenje (2) z No pošto učenje funkcije Q odgovara učenju idealne strategije, time odgovara i učenju njene vrijednosne funkcije V*: V*(s) = max Q(s, a’) a’ z Sada smo dobili rekurzivnu definiciju Q funkcije: Q(s, a) = r(s, a) + g max Q(s, a’) a’ z Ovakva definicija je baza algoritma koji iterativno z traži aproksimaciju funkcije .

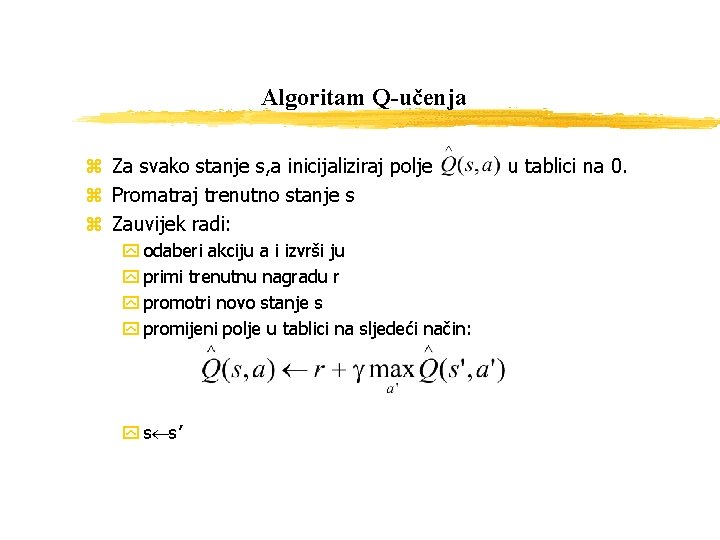

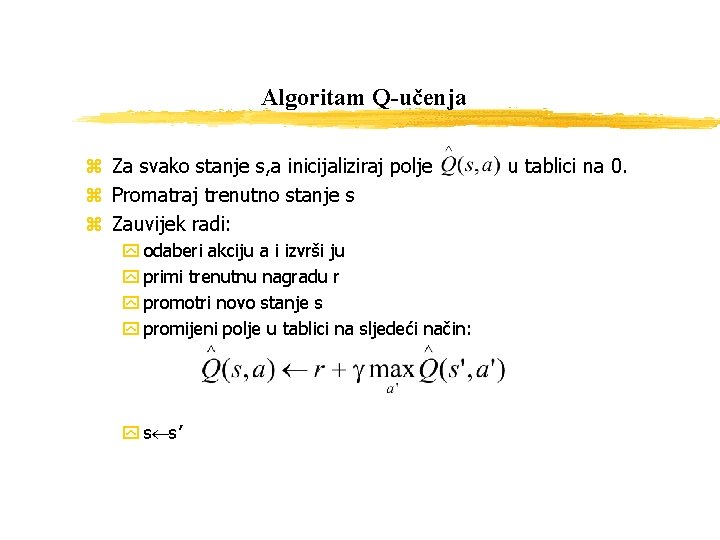

Algoritam Q-učenja z Za svako stanje s, a inicijaliziraj polje z Promatraj trenutno stanje s z Zauvijek radi: y odaberi akciju a i izvrši ju y primi trenutnu nagradu r y promotri novo stanje s y promijeni polje u tablici na sljedeći način: y s s’ u tablici na 0.

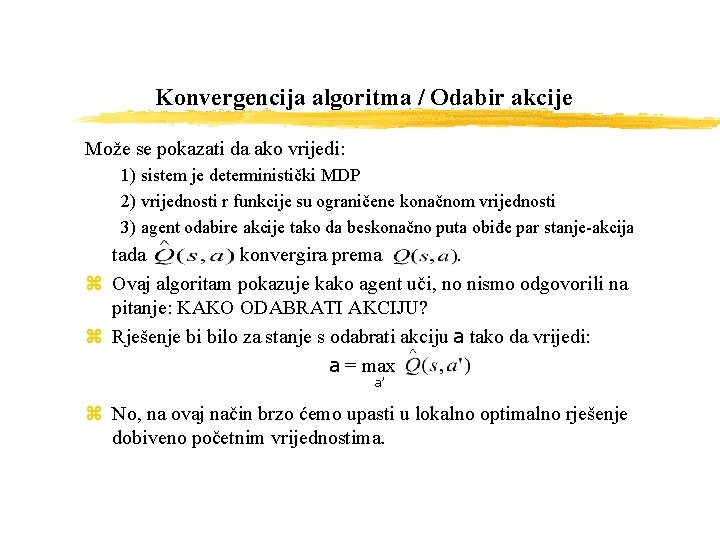

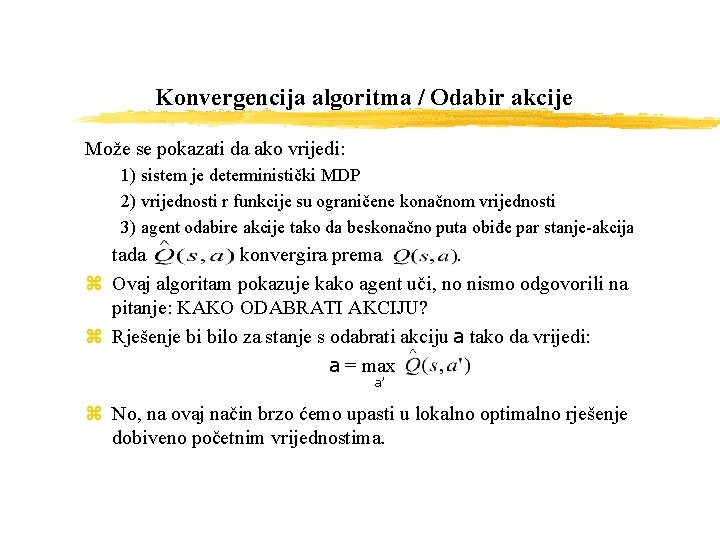

Konvergencija algoritma / Odabir akcije Može se pokazati da ako vrijedi: 1) sistem je deterministički MDP 2) vrijednosti r funkcije su ograničene konačnom vrijednosti 3) agent odabire akcije tako da beskonačno puta obiđe par stanje-akcija tada konvergira prema . z Ovaj algoritam pokazuje kako agent uči, no nismo odgovorili na pitanje: KAKO ODABRATI AKCIJU? z Rješenje bi bilo za stanje s odabrati akciju a tako da vrijedi: a = max a’ z No, na ovaj način brzo ćemo upasti u lokalno optimalno rješenje dobiveno početnim vrijednostima.

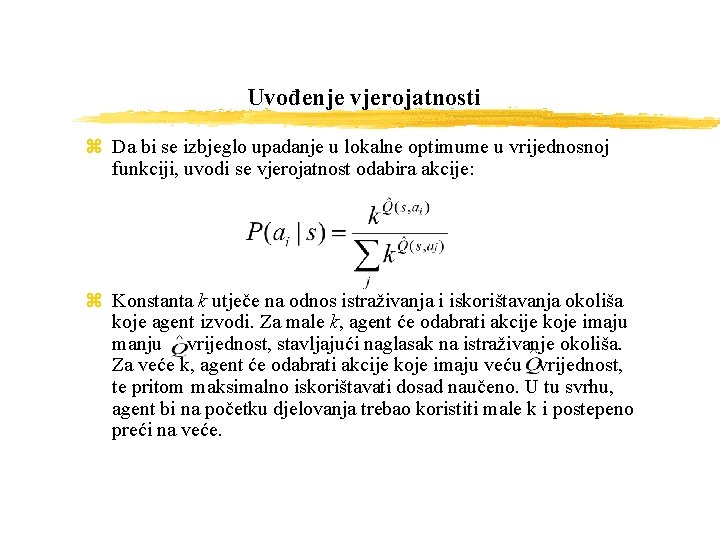

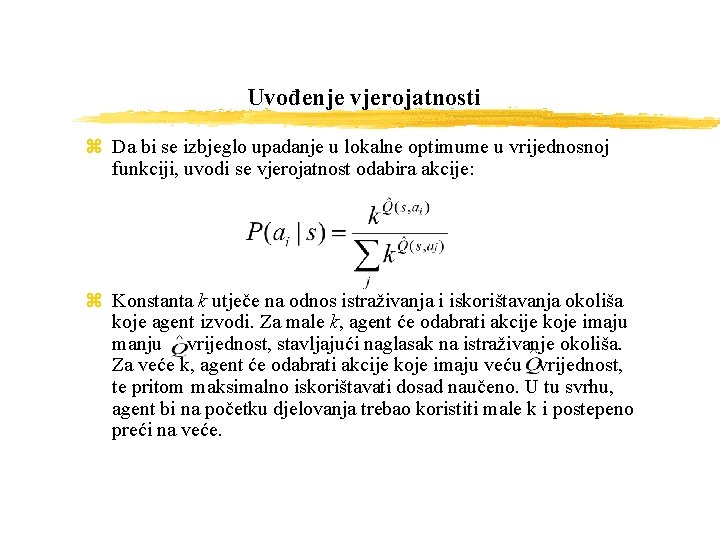

Uvođenje vjerojatnosti z Da bi se izbjeglo upadanje u lokalne optimume u vrijednosnoj funkciji, uvodi se vjerojatnost odabira akcije: z Konstanta k utječe na odnos istraživanja i iskorištavanja okoliša koje agent izvodi. Za male k, agent će odabrati akcije koje imaju manju vrijednost, stavljajući naglasak na istraživanje okoliša. Za veće k, agent će odabrati akcije koje imaju veću vrijednost, te pritom maksimalno iskorištavati dosad naučeno. U tu svrhu, agent bi na početku djelovanja trebao koristiti male k i postepeno preći na veće.

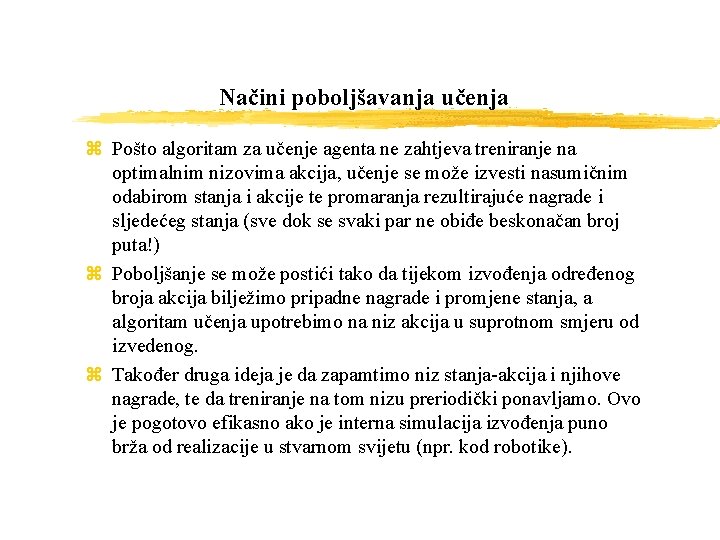

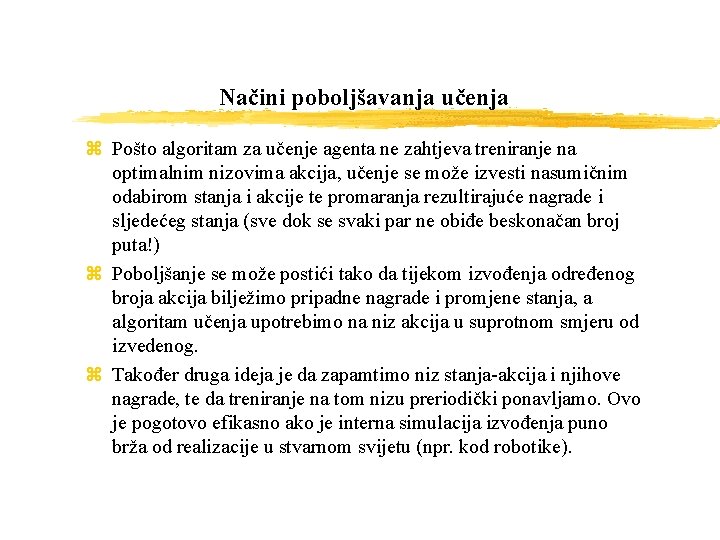

Načini poboljšavanja učenja z Pošto algoritam za učenje agenta ne zahtjeva treniranje na optimalnim nizovima akcija, učenje se može izvesti nasumičnim odabirom stanja i akcije te promaranja rezultirajuće nagrade i sljedećeg stanja (sve dok se svaki par ne obiđe beskonačan broj puta!) z Poboljšanje se može postići tako da tijekom izvođenja određenog broja akcija bilježimo pripadne nagrade i promjene stanja, a algoritam učenja upotrebimo na niz akcija u suprotnom smjeru od izvedenog. z Također druga ideja je da zapamtimo niz stanja-akcija i njihove nagrade, te da treniranje na tom nizu preriodički ponavljamo. Ovo je pogotovo efikasno ako je interna simulacija izvođenja puno brža od realizacije u stvarnom svijetu (npr. kod robotike).

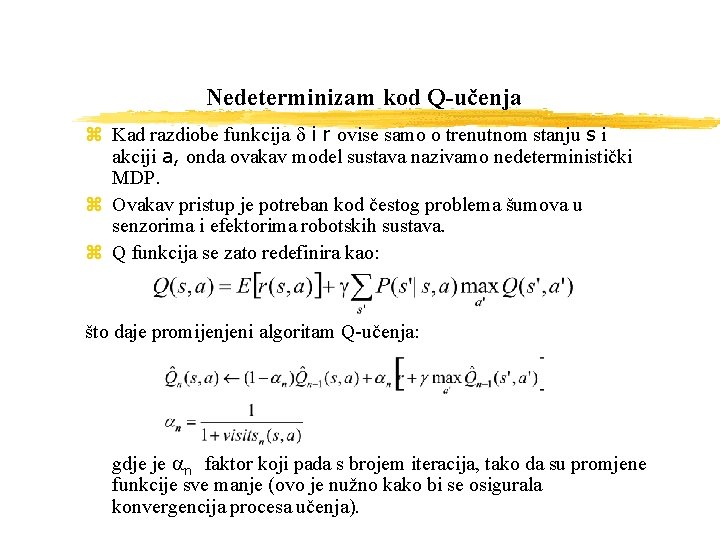

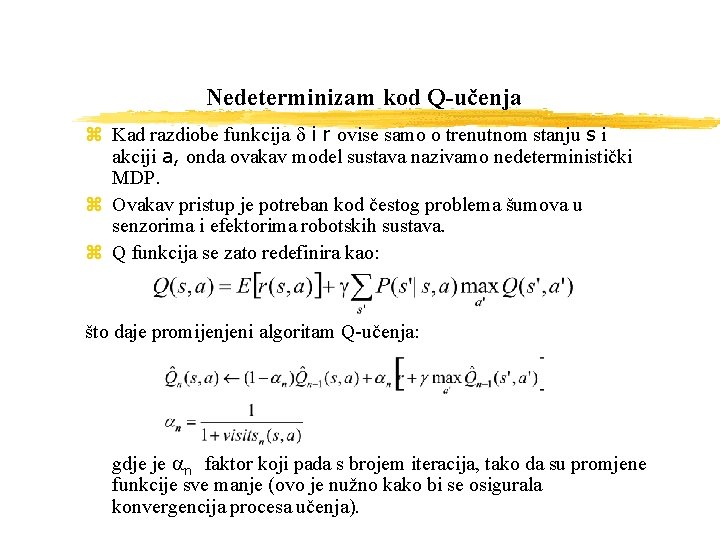

Nedeterminizam kod Q-učenja z Kad razdiobe funkcija d i r ovise samo o trenutnom stanju s i akciji a, onda ovakav model sustava nazivamo nedeterministički MDP. z Ovakav pristup je potreban kod čestog problema šumova u senzorima i efektorima robotskih sustava. z Q funkcija se zato redefinira kao: što daje promijenjeni algoritam Q-učenja: gdje je an faktor koji pada s brojem iteracija, tako da su promjene funkcije sve manje (ovo je nužno kako bi se osigurala konvergencija procesa učenja).

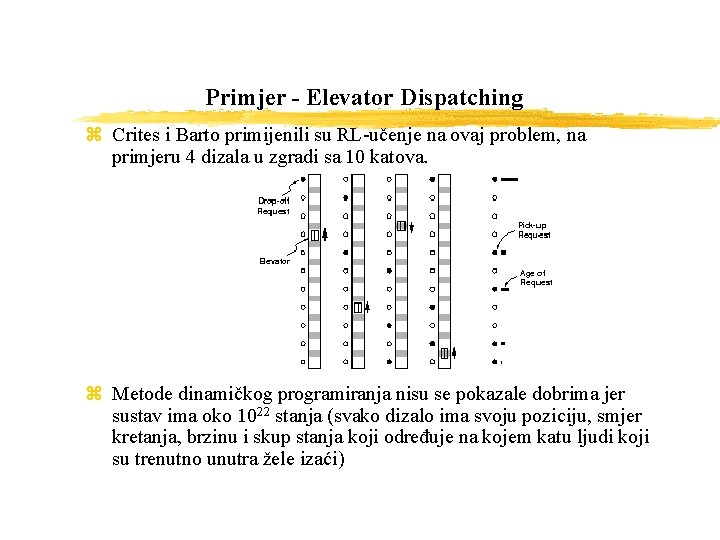

Primjer - Elevator Dispatching z Crites i Barto primijenili su RL-učenje na ovaj problem, na primjeru 4 dizala u zgradi sa 10 katova. z Metode dinamičkog programiranja nisu se pokazale dobrima jer sustav ima oko 1022 stanja (svako dizalo ima svoju poziciju, smjer kretanja, brzinu i skup stanja koji određuje na kojem katu ljudi koji su trenutno unutra žele izaći)

Elevator Dispatching (2) z Uspješnost sustava se mjeri sljedećim faktorima: y prosječno vrijeme čekanja (koliko osoba čeka da lift stigne) y prosječno sistemsko vrijeme (koliko se osoba vozi u liftu) y postotak putnika koji čekaju više od 60 sekundi z Crites i Barto koristili su one-step Q-learning uz neke dodatne početne uvjete (o smjeru kretanja, prolasku katova. . . ) z Kao nagrada agentu koristi se negativna suma kvadrata vremena čekanja svih putnika zajedno y problem: ne zna se koliko putnika čeka na nekom katu, zna se samo da netko čeka y rješeno neuronskom mrežom koja predviđa koliko je ljudi na pojedinom katu y Složena su 2 sustava: RL 1 (svako dizalo ima svoju neuronsku mrežu) i RL 2 (sva dizala imaju jednu zajedničku neuronsku mrežu)

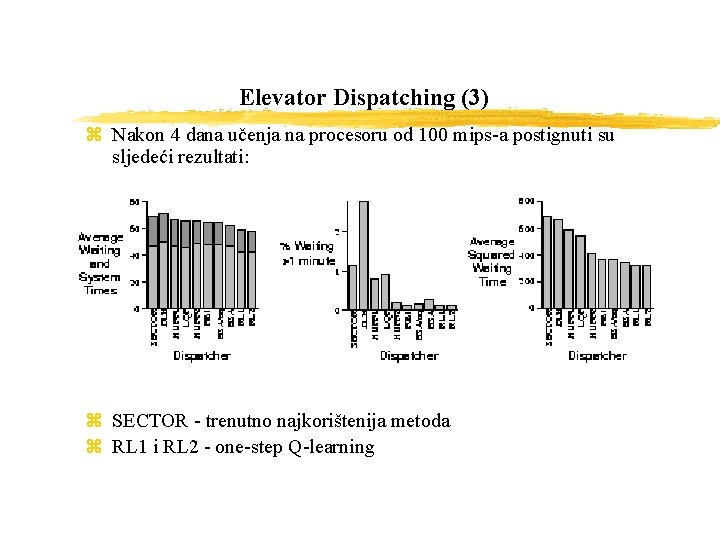

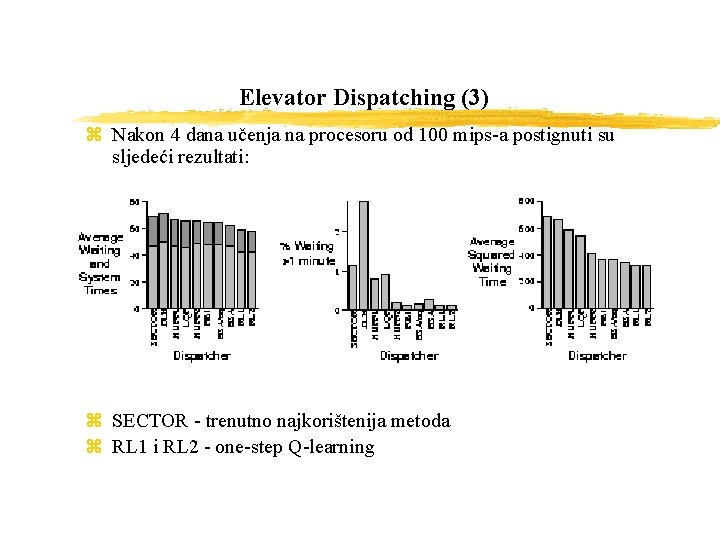

Elevator Dispatching (3) z Nakon 4 dana učenja na procesoru od 100 mips-a postignuti su sljedeći rezultati: z SECTOR - trenutno najkorištenija metoda z RL 1 i RL 2 - one-step Q-learning

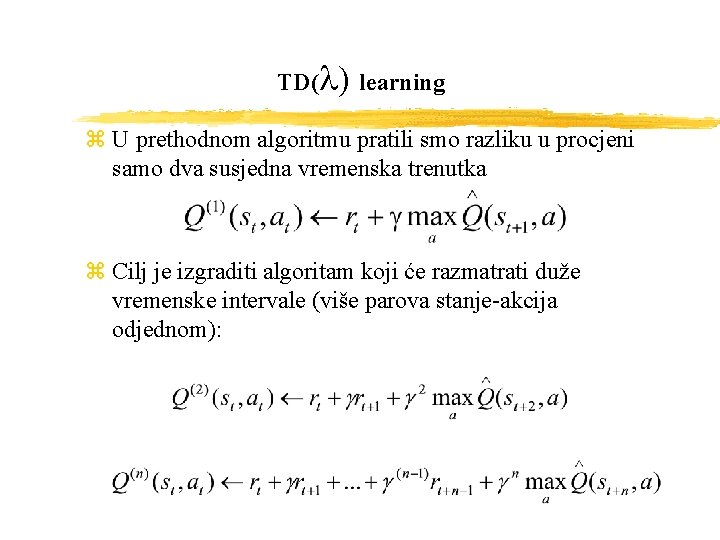

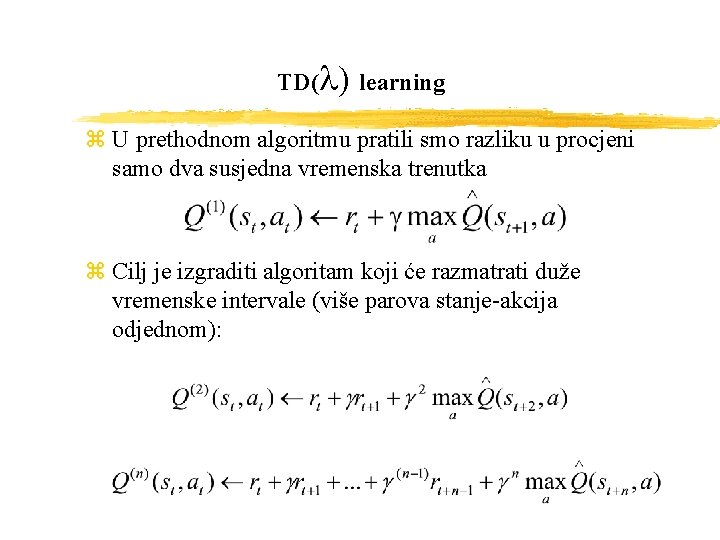

TD(l) learning z U prethodnom algoritmu pratili smo razliku u procjeni samo dva susjedna vremenska trenutka z Cilj je izgraditi algoritam koji će razmatrati duže vremenske intervale (više parova stanje-akcija odjednom):

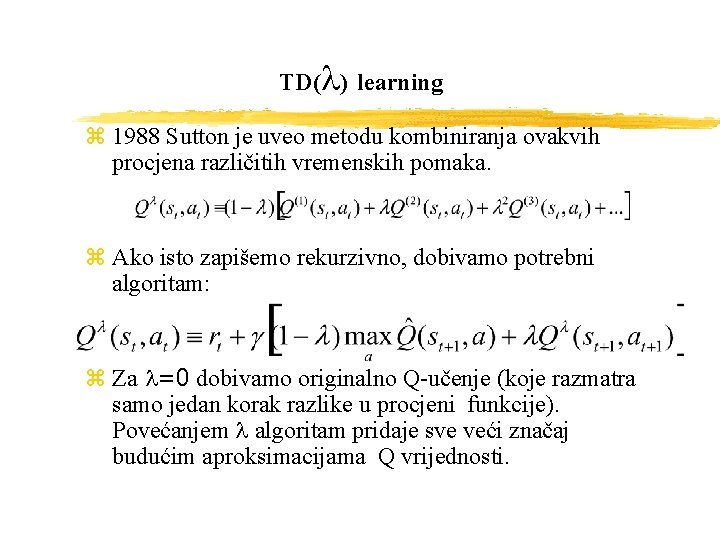

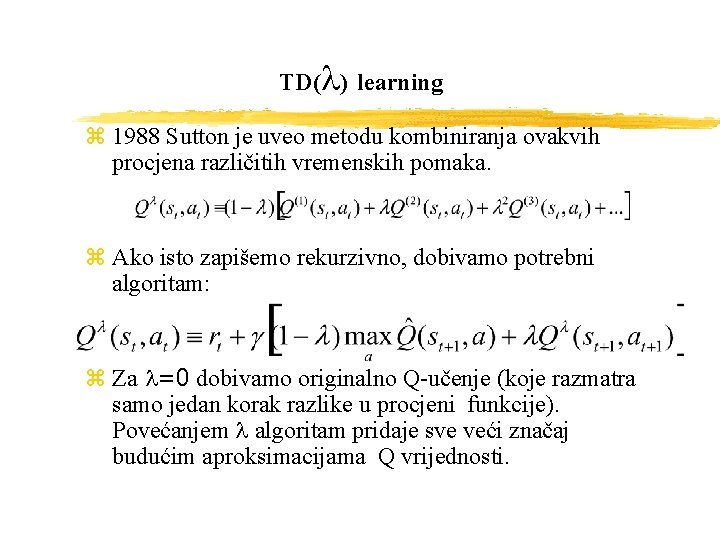

TD(l) learning z 1988 Sutton je uveo metodu kombiniranja ovakvih procjena različitih vremenskih pomaka. z Ako isto zapišemo rekurzivno, dobivamo potrebni algoritam: z Za l=0 dobivamo originalno Q-učenje (koje razmatra samo jedan korak razlike u procjeni funkcije). Povećanjem l algoritam pridaje sve veći značaj budućim aproksimacijama Q vrijednosti.

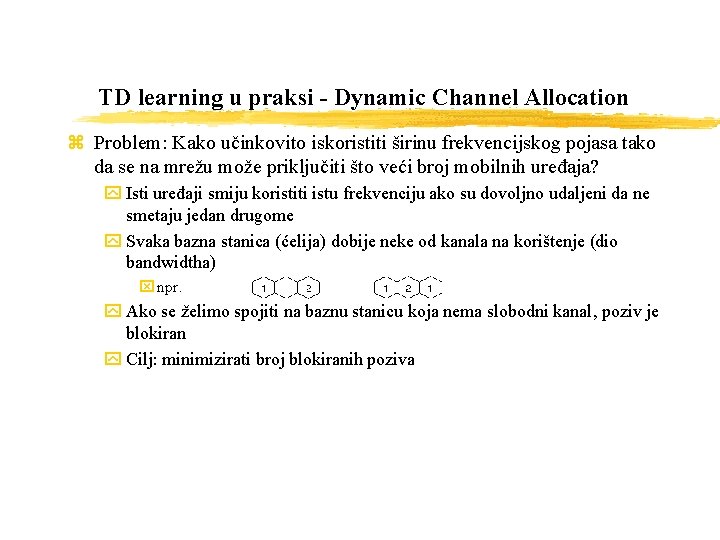

TD learning u praksi - Dynamic Channel Allocation z Problem: Kako učinkovito iskoristiti širinu frekvencijskog pojasa tako da se na mrežu može priključiti što veći broj mobilnih uređaja? y Isti uređaji smiju koristiti istu frekvenciju ako su dovoljno udaljeni da ne smetaju jedan drugome y Svaka bazna stanica (ćelija) dobije neke od kanala na korištenje (dio bandwidtha) x npr. y Ako se želimo spojiti na baznu stanicu koja nema slobodni kanal, poziv je blokiran y Cilj: minimizirati broj blokiranih poziva

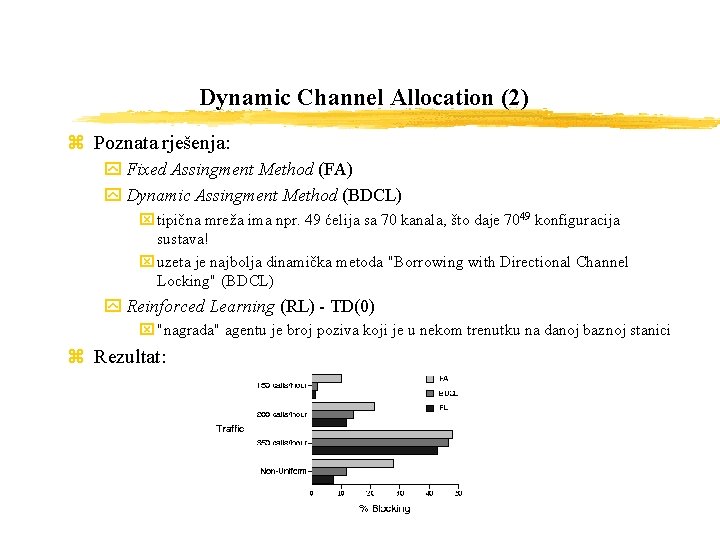

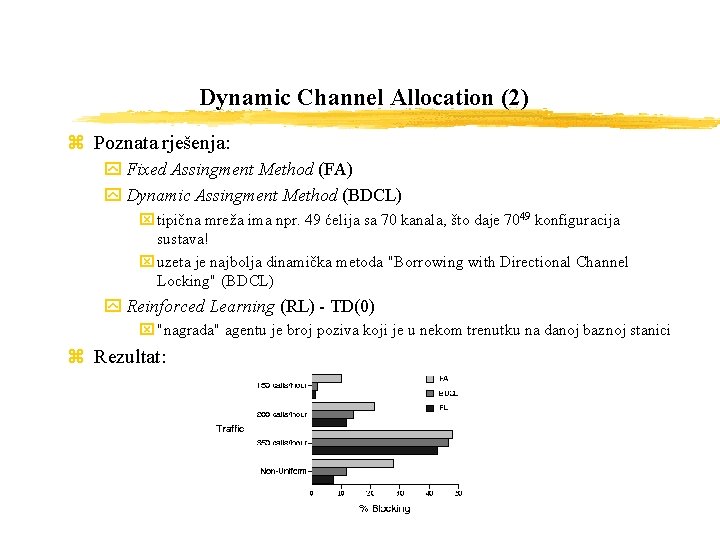

Dynamic Channel Allocation (2) z Poznata rješenja: y Fixed Assingment Method (FA) y Dynamic Assingment Method (BDCL) x tipična mreža ima npr. 49 ćelija sa 70 kanala, što daje 7049 konfiguracija sustava! x uzeta je najbolja dinamička metoda "Borrowing with Directional Channel Locking" (BDCL) y Reinforced Learning (RL) - TD(0) x "nagrada" agentu je broj poziva koji je u nekom trenutku na danoj baznoj stanici z Rezultat:

Generaliziranje iz primjera z Do sada se pretpostavilo da je ciljna funkcija Q predstavljena dvodimenzionalnim poljem stanje-akcija. To je bilo potrebno za dokaz konvergencije algoritma zbog pretpostavke da će se svaki par stanjeakcija obići beskonačno puta. z Problemi ovog pristupa su: y agent nije pokušavao induktivno procijeniti Q vrijednosti do tog trenutka neviđenog para stanje-akcija y Kartezijev produkt prostora stanja i akcija je vrlo velik u realnim primjenama (npr. samo za šah 101) y nemoguće je prikazati kontinuirane ulazne podatke z Moguće rješenje je Q funkciju prikazati: y neuronskom mrežom s Backpropagation algoritmom y stablom odlučivanja y LMS algoritmom

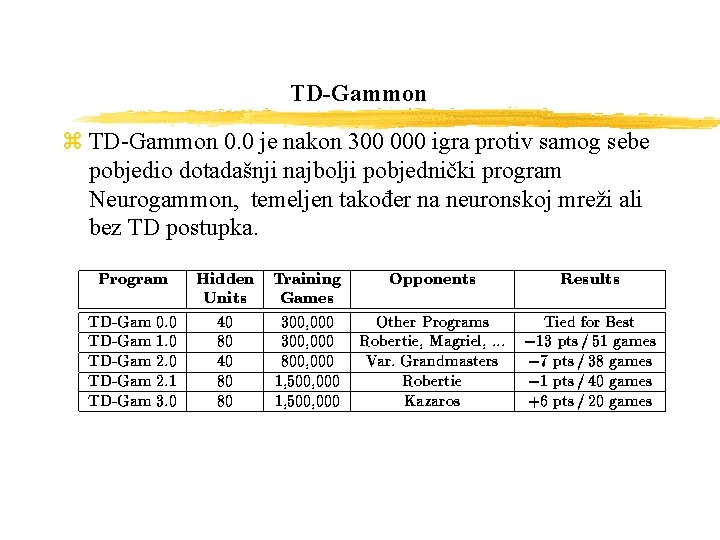

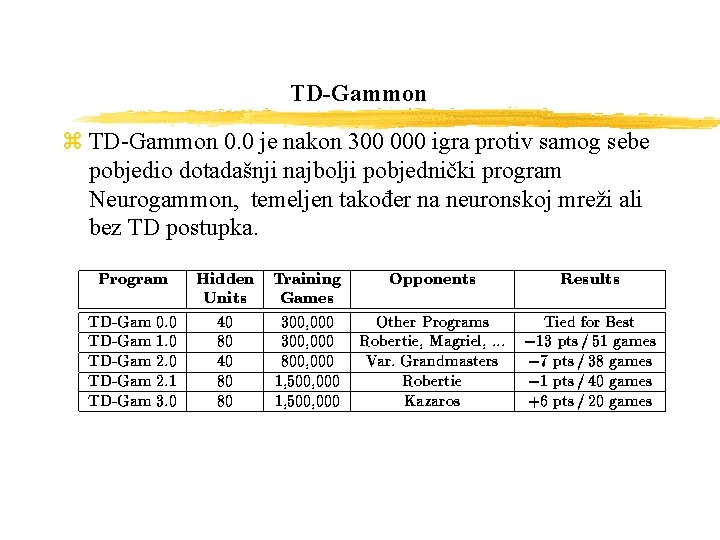

TD-Gammon z Program koji uspješno igra Backgammon na razini svjetskog prvaka z Koristi kombinaciju TD (l) učenja s nelinearnom funkcijom aproksimiranom višeslojnom neuronskom mrežom s backpropagation postupkom za TD greške z Koristi se 15 bijelih i 15 crnih žetona na 24 lokacije (26 ako se računaju i pozicije “izvan ploče”) z Prije svakog poteza, igrači bacaju dve kocke z Za tipično bacanje, postoji oko 20 odgovora, što ako uzimamo u obzir i odgovor protivnika daje faktor grananja 20*20 = 400 z Zbog toga je nemoguće koristiti EXPECTI-minimax metode, heurističke metode pretraživanja

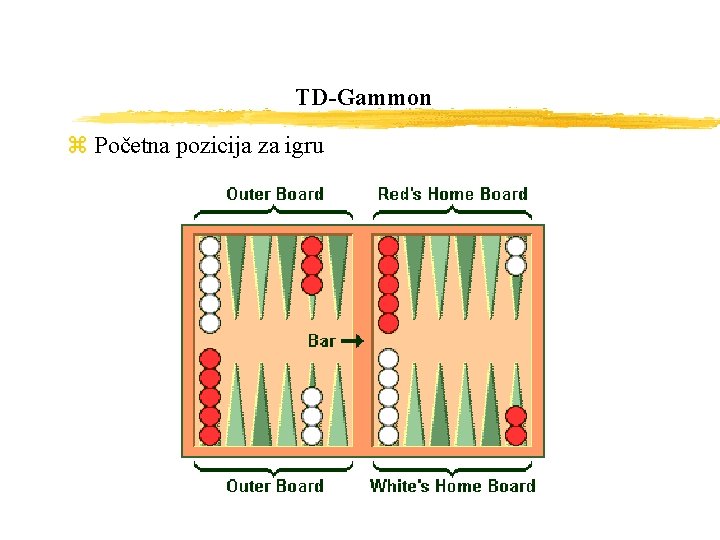

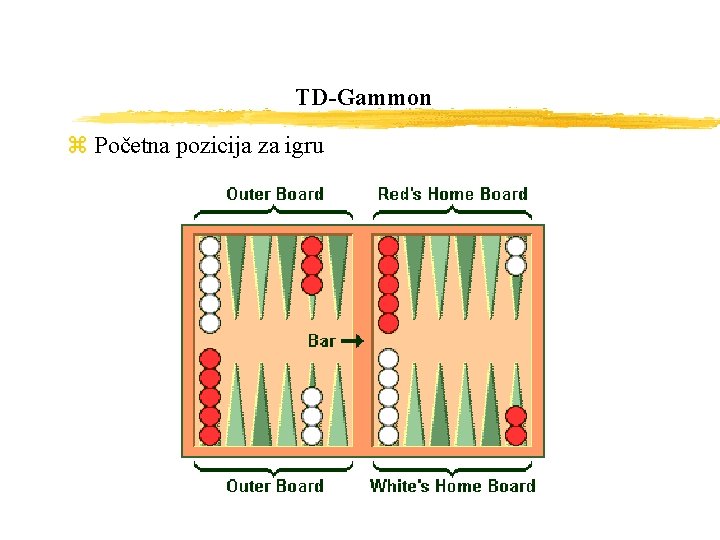

TD-Gammon z Početna pozicija za igru

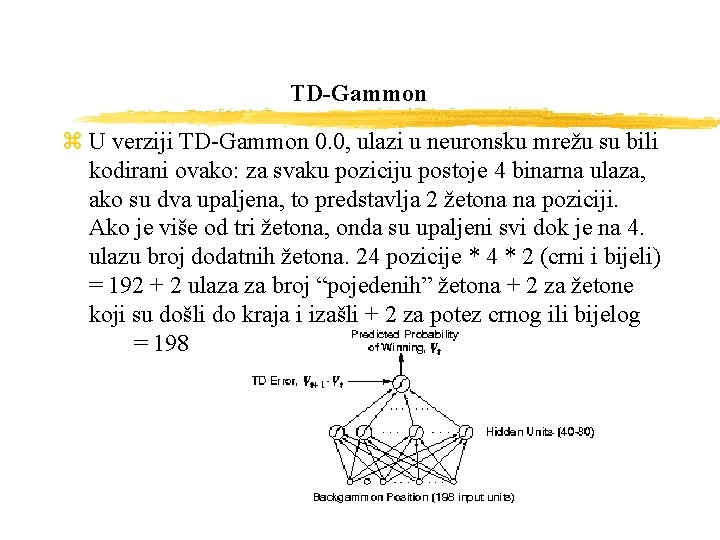

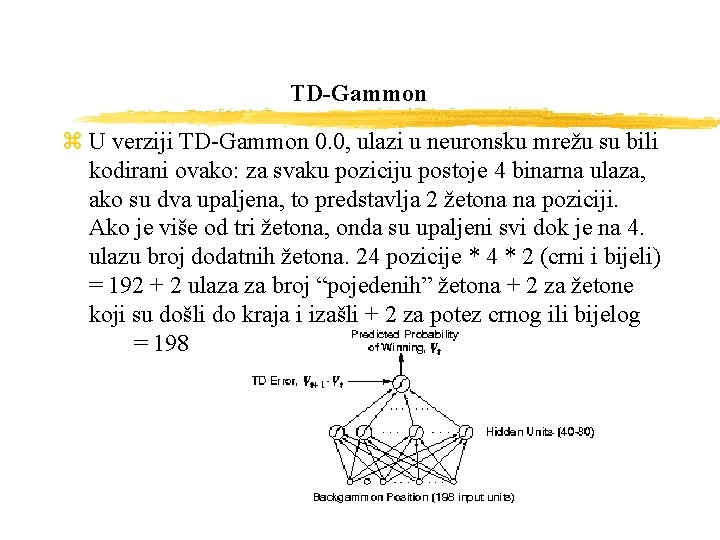

TD-Gammon z U verziji TD-Gammon 0. 0, ulazi u neuronsku mrežu su bili kodirani ovako: za svaku poziciju postoje 4 binarna ulaza, ako su dva upaljena, to predstavlja 2 žetona na poziciji. Ako je više od tri žetona, onda su upaljeni svi dok je na 4. ulazu broj dodatnih žetona. 24 pozicije * 4 * 2 (crni i bijeli) = 192 + 2 ulaza za broj “pojedenih” žetona + 2 za žetone koji su došli do kraja i izašli + 2 za potez crnog ili bijelog = 198

TD-Gammon z TD-Gammon 0. 0 je nakon 300 000 igra protiv samog sebe pobjedio dotadašnji najbolji pobjednički program Neurogammon, temeljen također na neuronskoj mreži ali bez TD postupka.

Dakle, ukratko… Reinforcement Learning je učenje iz interakcije s okolišem, iz posljedica akcije, a ne eksplicitno učenje. RL je postao popularan tijekom 90 ih unutar strojnog učenja i umjetne inteligencije, ali i u operacijskim istraživanjima, psihologiji i neurologiji. Uglavnom se koriste sustavi opisani kao Markov decision processes (MDPs) tj. sustavi gdje agent pokušava maksimizirati totalnu nagradu koju primi kroz vrijeme. Radi se o postupcima koji iterativno pokušavaju doći do bolje i bolje aproksimacije ciljne strategije. Ovo su metode koje namijenjene pitanju učenja i odlučivanja koje ljudi i životinje susreću u normalnom životu.

Literatura z S. Singh, P. Norvig, D. Cohn - How to Make Software Agents Do the Right Thing: An Introduction to Reinforcement Learning (http: //envy. cs. umass. edu/People/singh/RLMasses/RL. html) z Reinforcement Learning Repository, University of Massachusetts, Amherst (http: //www-anw. cs. umass. edu/rlr/) z R. Sutton, A. Barto - Reinforcement Learning: An Introduction (http: //www-anw. cs. umass. edu/~rich/book/the-book. html) z S. Russell, P. Norvig - Artificial Intelligence : A Modern Approach z T. Mitchell - Machine Learning z A. Gosavi - A Master's Thesis in Reinforcement Learning (http: //faculty. uscolo. edu/gosavi/rl. html) z T. Dietterich - Machine-Learning Research (Four Current Directions) z G. Tesauro - Temporal Difference Learning and TD-Gammon z R. Williams – Practical Issues in Temporal Difference Learning

Zrno ra

Zrno ra Davor zrno

Davor zrno Maja proso pravni fakultet

Maja proso pravni fakultet Druhy obilí

Druhy obilí Samoopelenie

Samoopelenie Apprenticeship learning via inverse reinforcement learning

Apprenticeship learning via inverse reinforcement learning Apprenticeship learning via inverse reinforcement learning

Apprenticeship learning via inverse reinforcement learning Active learning reinforcement learning

Active learning reinforcement learning What are primary and secondary reinforcers

What are primary and secondary reinforcers Cuadro comparativo e-learning m-learning b-learning

Cuadro comparativo e-learning m-learning b-learning Karan kathpalia

Karan kathpalia Passive reinforcement learning

Passive reinforcement learning Passive reinforcement learning

Passive reinforcement learning Coarse coding reinforcement learning

Coarse coding reinforcement learning Agent snake game

Agent snake game Direct reinforcement learning

Direct reinforcement learning Hierarchical reinforcement learning: a comprehensive survey

Hierarchical reinforcement learning: a comprehensive survey What is optimal policy in reinforcement learning

What is optimal policy in reinforcement learning Www.youtube.com

Www.youtube.com Reinforcement learning exploration vs exploitation

Reinforcement learning exploration vs exploitation Policy evaluation

Policy evaluation Jack's car rental reinforcement learning

Jack's car rental reinforcement learning Reinforcement learning blackjack

Reinforcement learning blackjack Passive reinforcement learning

Passive reinforcement learning I2a reinforcement learning

I2a reinforcement learning Positive vs negative reinforcement

Positive vs negative reinforcement Reinforcement learning slides

Reinforcement learning slides Reinforcement learning slides

Reinforcement learning slides Reinforcement learning agent environment

Reinforcement learning agent environment Reinforcement learning atari

Reinforcement learning atari Reinforcement learning exercises

Reinforcement learning exercises Policy network reinforcement learning

Policy network reinforcement learning A long peek into reinforcement learning

A long peek into reinforcement learning Using inaccurate models in reinforcement learning

Using inaccurate models in reinforcement learning Reinforcement learning lectures

Reinforcement learning lectures Vassilis athitsos

Vassilis athitsos Seq gan

Seq gan