Statystyka medyczna Piotr Kozowski email kozlamu edu pl

![Miary rozrzutu - przykład Mężczyźni Kobiety Wzrost [cm] 175 S=15 165 S=14 Masa [kg] Miary rozrzutu - przykład Mężczyźni Kobiety Wzrost [cm] 175 S=15 165 S=14 Masa [kg]](https://slidetodoc.com/presentation_image_h/e210f4c9a494c0aebd6a2b2e61a33121/image-16.jpg)

- Slides: 61

Statystyka medyczna Piotr Kozłowski e-mail: kozl@amu. edu. pl www: kozl. home. amu. edu. pl 1

Zaliczenie: • obecność na ćwiczeniach – możliwe są 2 nieobecności • praktyczne kolokwium typu otwarta książka Materiały: Strona www: kozl. home. amu. edu. pl 2

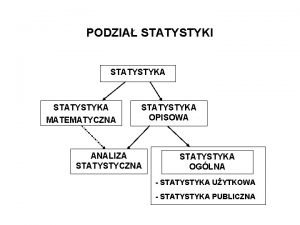

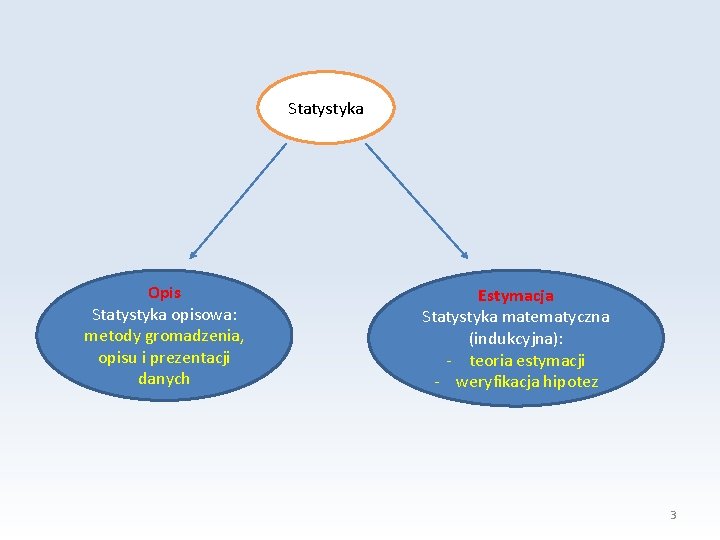

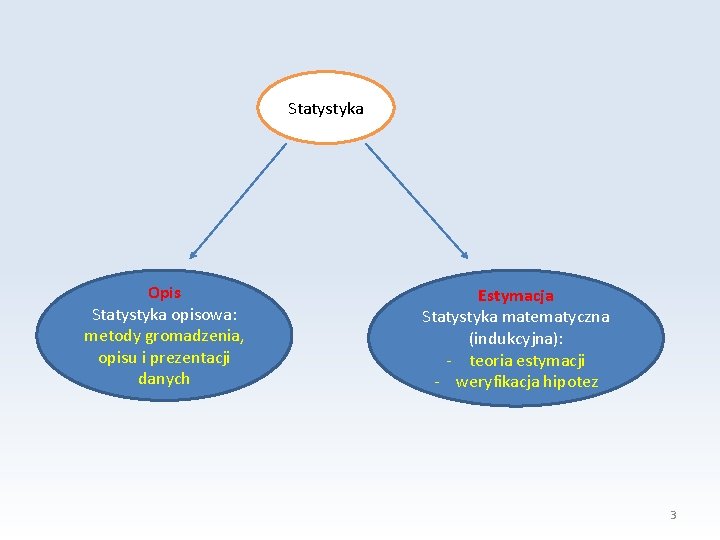

Statystyka Opis Statystyka opisowa: metody gromadzenia, opisu i prezentacji danych Estymacja Statystyka matematyczna (indukcyjna): - teoria estymacji - weryfikacja hipotez 3

Populacja Próbka reprezentatywna 4

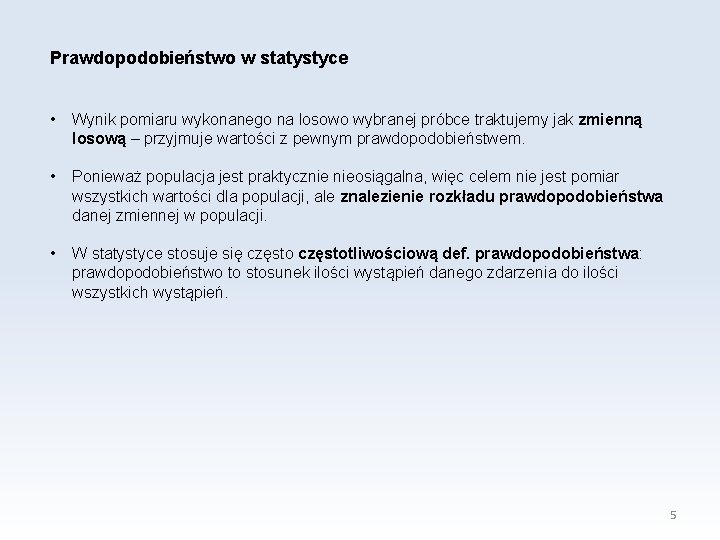

Prawdopodobieństwo w statystyce • Wynik pomiaru wykonanego na losowo wybranej próbce traktujemy jak zmienną losową – przyjmuje wartości z pewnym prawdopodobieństwem. • Ponieważ populacja jest praktycznie nieosiągalna, więc celem nie jest pomiar wszystkich wartości dla populacji, ale znalezienie rozkładu prawdopodobieństwa danej zmiennej w populacji. • W statystyce stosuje się częstotliwościową def. prawdopodobieństwa: prawdopodobieństwo to stosunek ilości wystąpień danego zdarzenia do ilości wszystkich wystąpień. 5

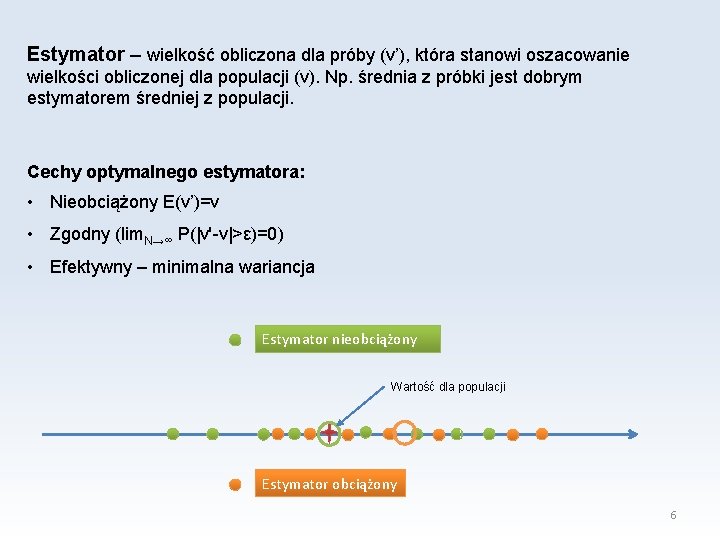

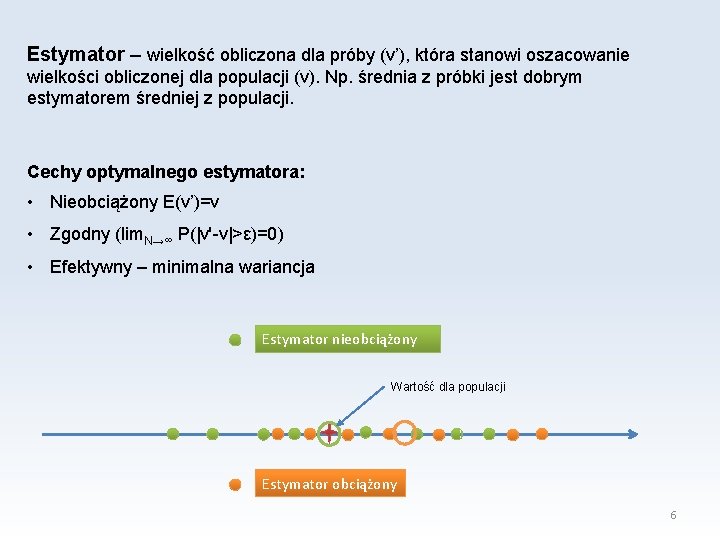

Estymator – wielkość obliczona dla próby (v’), która stanowi oszacowanie wielkości obliczonej dla populacji (v). Np. średnia z próbki jest dobrym estymatorem średniej z populacji. Cechy optymalnego estymatora: • Nieobciążony E(v’)=v • Zgodny (lim. N→∞ P(|v'-v|>ε)=0) • Efektywny – minimalna wariancja Estymator nieobciążony Wartość dla populacji Estymator obciążony 6

Skale pomiarowe • nominalna - wynikiem pomiaru jest rozłączna kategoria, np. : kolor oczu, płeć, grupa krwi, • porządkowa - podobnie jak nominalna, tylko że wyniki można jednoznacznie uporządkować, np. : stopień znajomości języka: podstawowy, średnio zaawansowany, biegły, lub masa ciała: niedowaga, norma, nadwaga, otyłość. Skala ta może być wyrażana przy pomocy cyfr, np. skala Apgar (0 -10) • przedziałowa (interwałowa, równomierna) - tak jak porządkowa, tylko że można obliczyć odległość między wynikami, większość pomiarów należy do tej skali, np. : ciśnienie krwi, masa ciała, temperatura • ilorazowa - to samo co skala przedziałowa z tym że iloraz ma sens (istnieje bezwzględne zero), np. wiek, 7

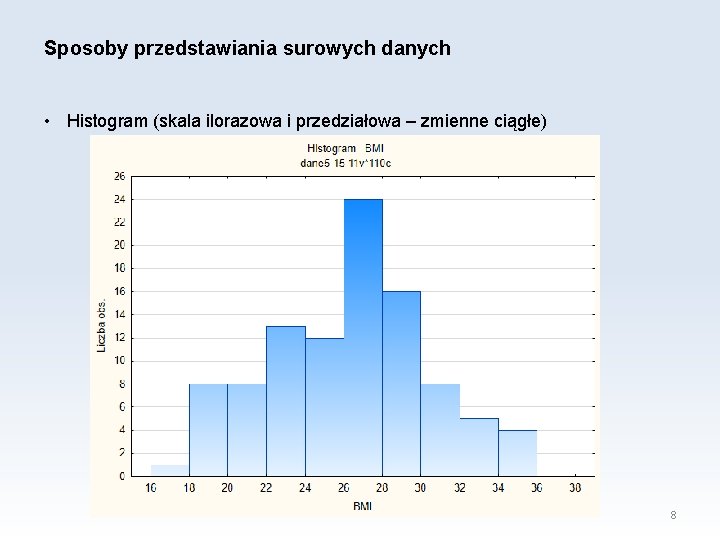

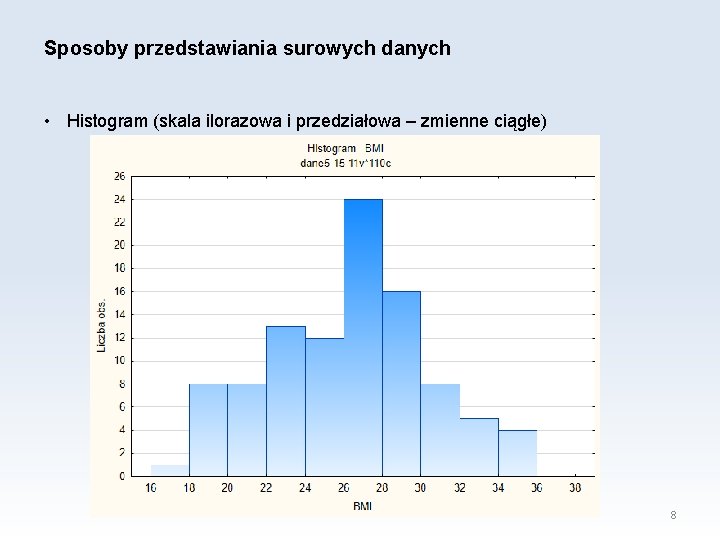

Sposoby przedstawiania surowych danych • Histogram (skala ilorazowa i przedziałowa – zmienne ciągłe) 8

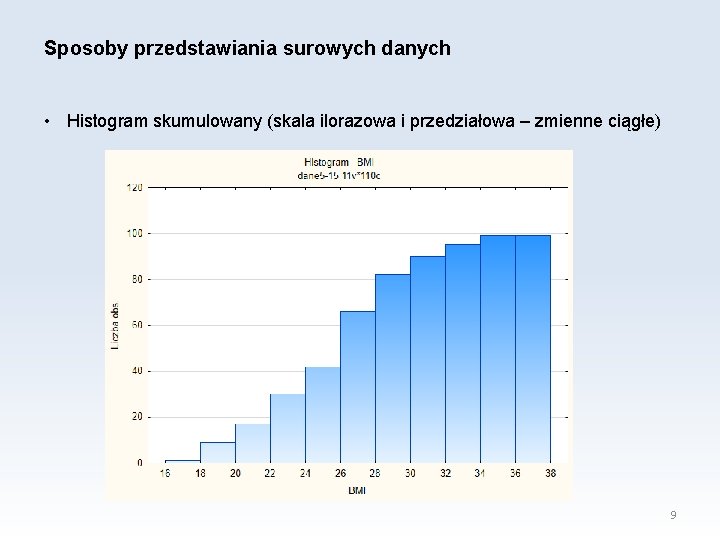

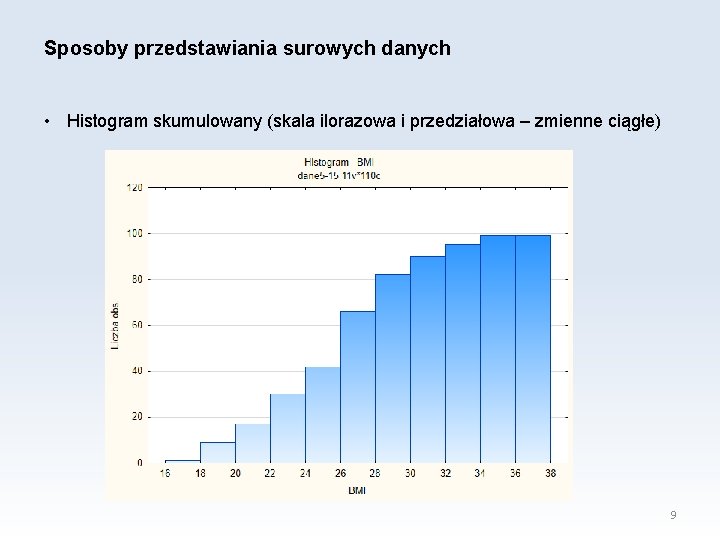

Sposoby przedstawiania surowych danych • Histogram skumulowany (skala ilorazowa i przedziałowa – zmienne ciągłe) 9

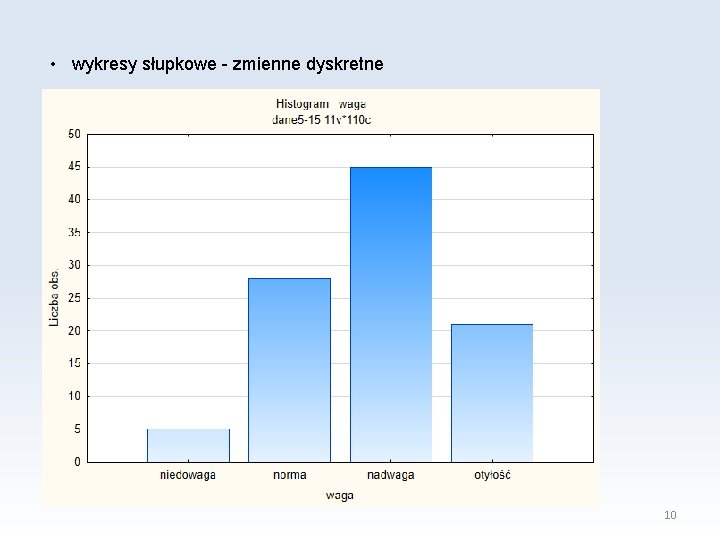

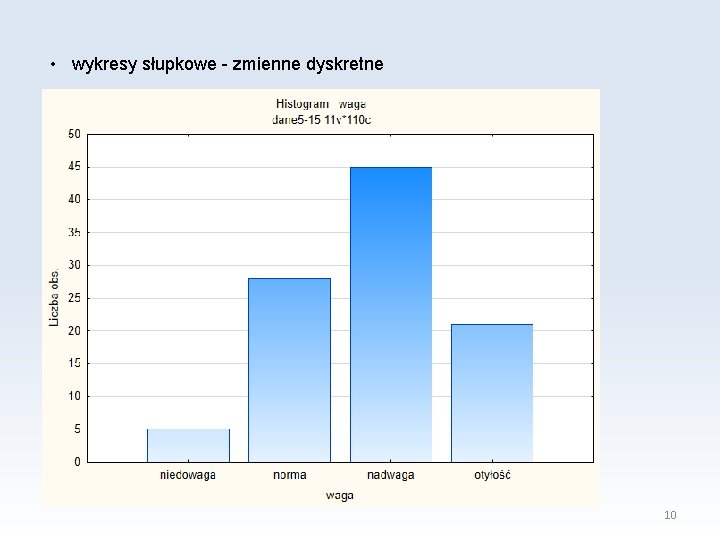

• wykresy słupkowe - zmienne dyskretne 10

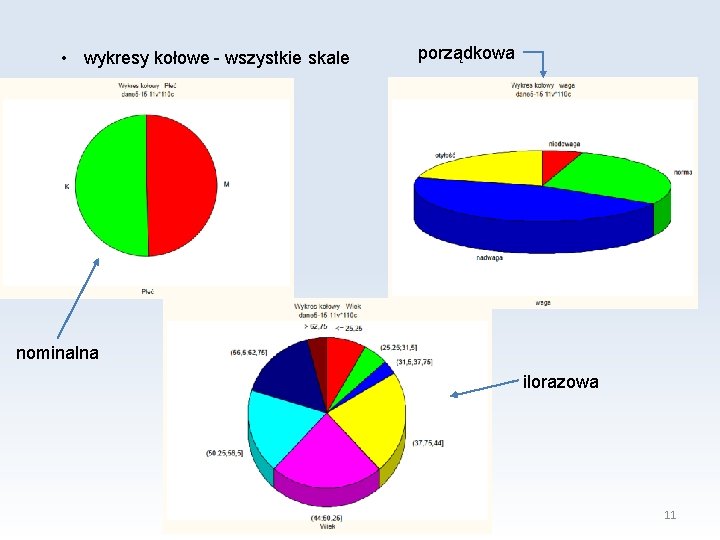

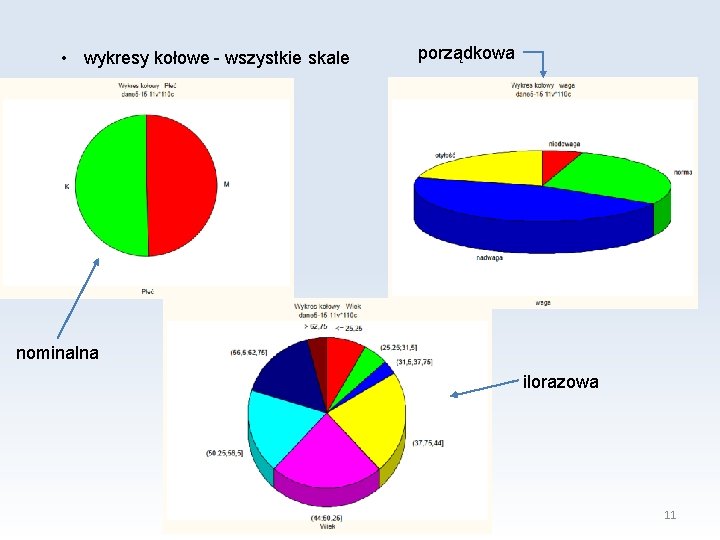

• wykresy kołowe - wszystkie skale porządkowa nominalna ilorazowa 11

• Diagram łodyga liście 12

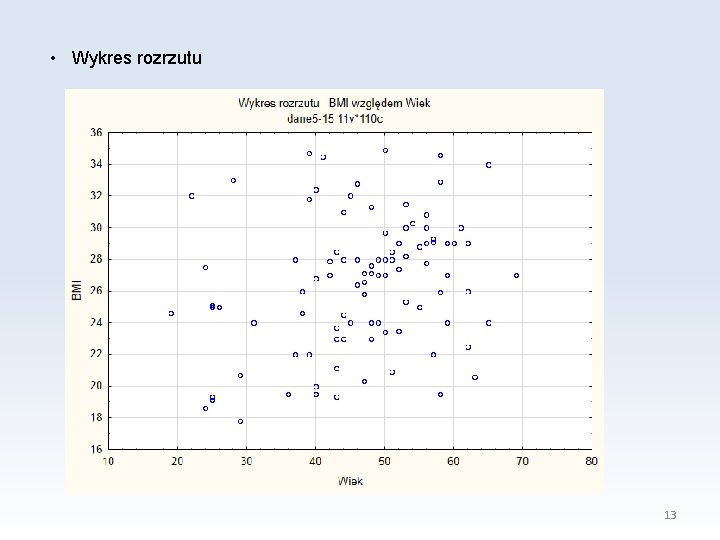

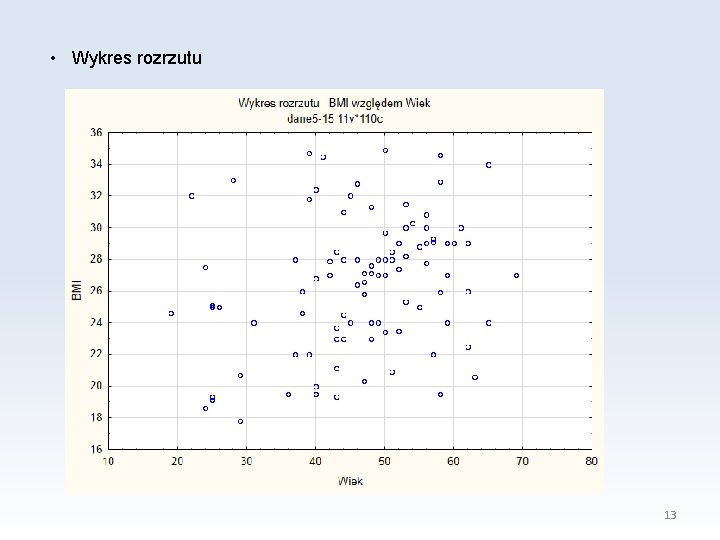

• Wykres rozrzutu 13

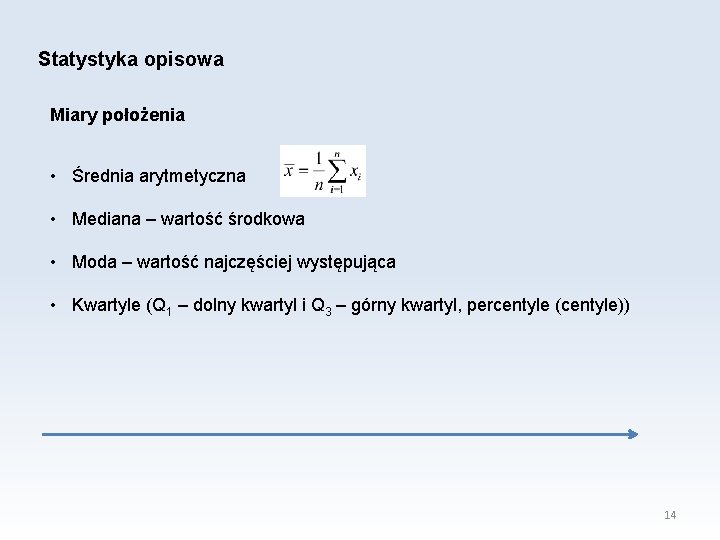

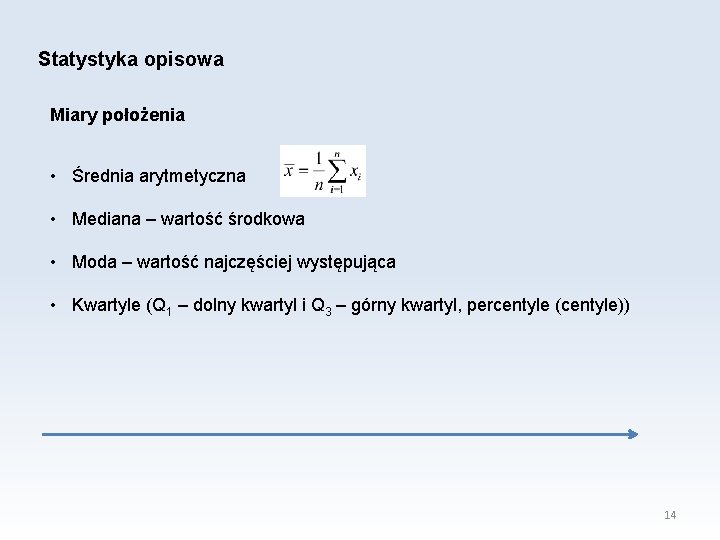

Statystyka opisowa Miary położenia • Średnia arytmetyczna • Mediana – wartość środkowa • Moda – wartość najczęściej występująca • Kwartyle (Q 1 – dolny kwartyl i Q 3 – górny kwartyl, percentyle (centyle)) 14

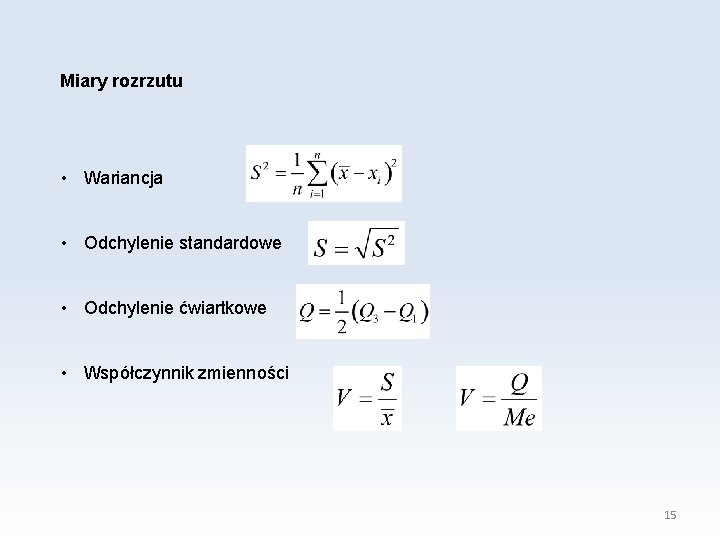

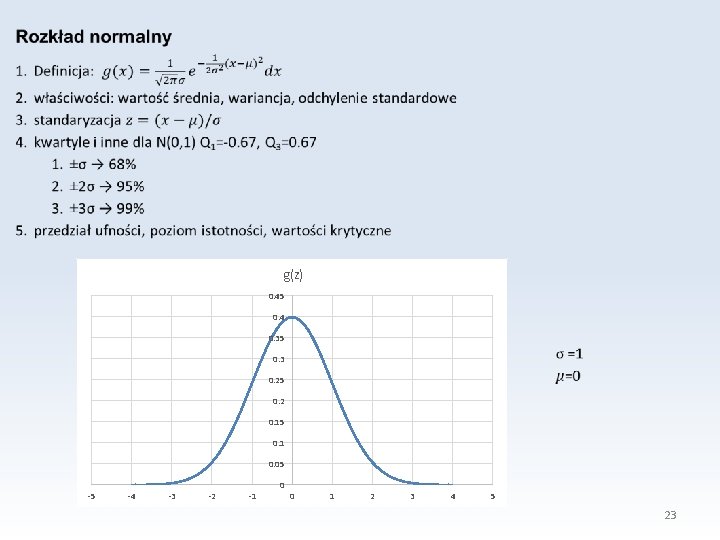

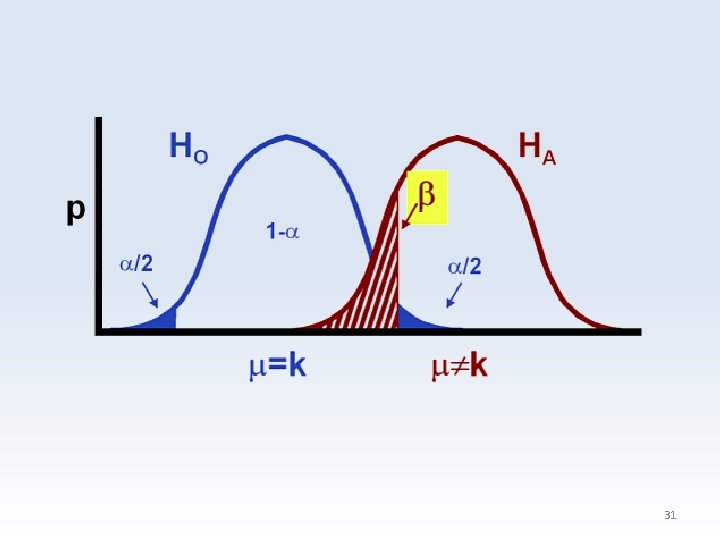

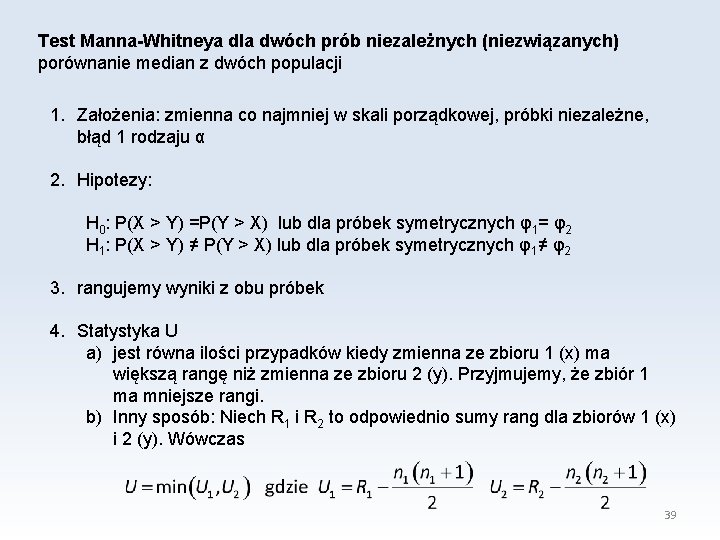

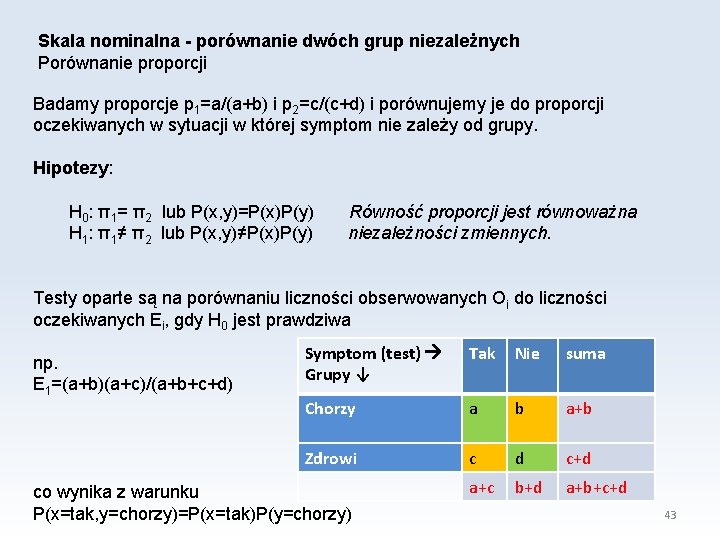

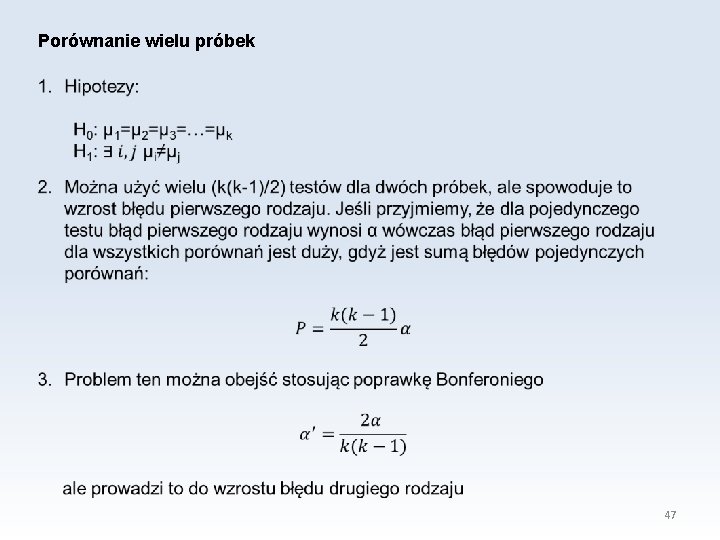

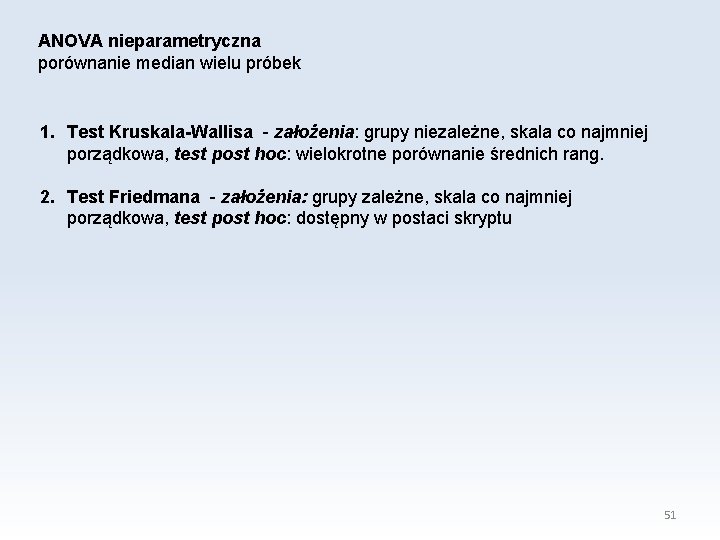

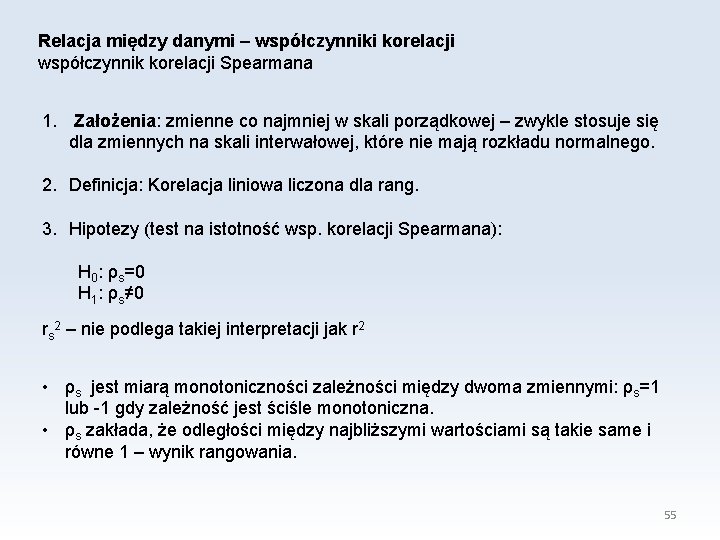

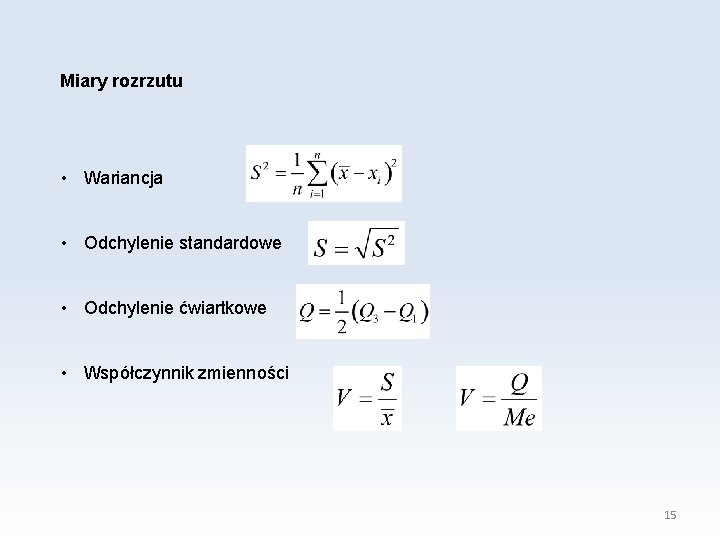

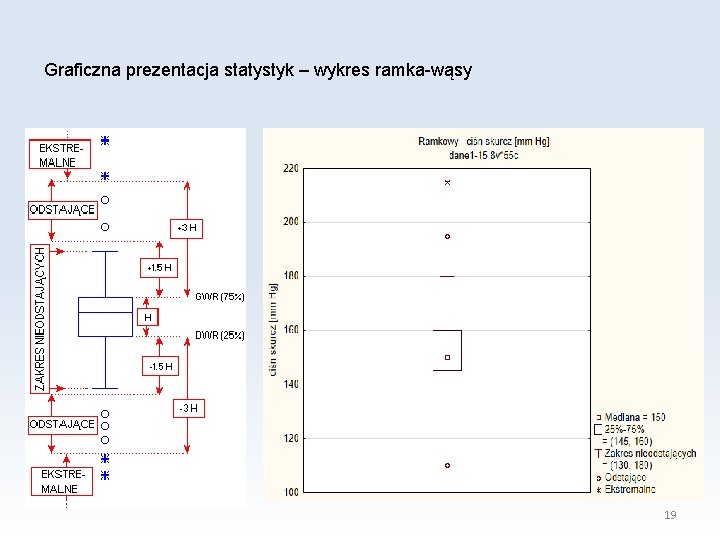

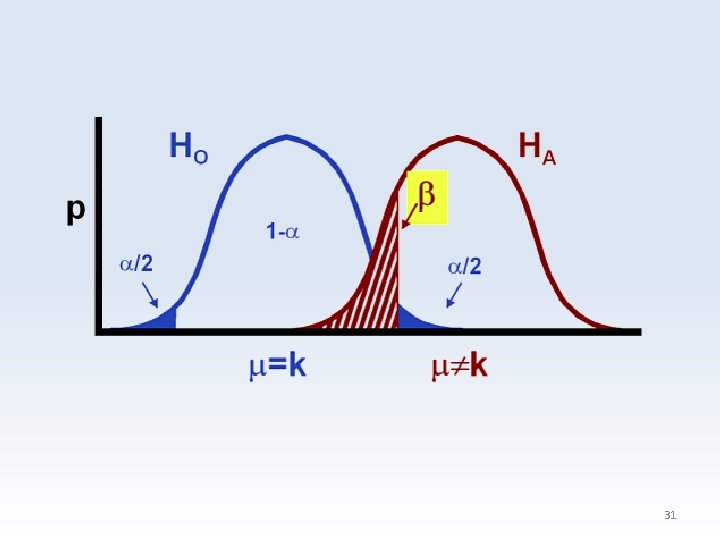

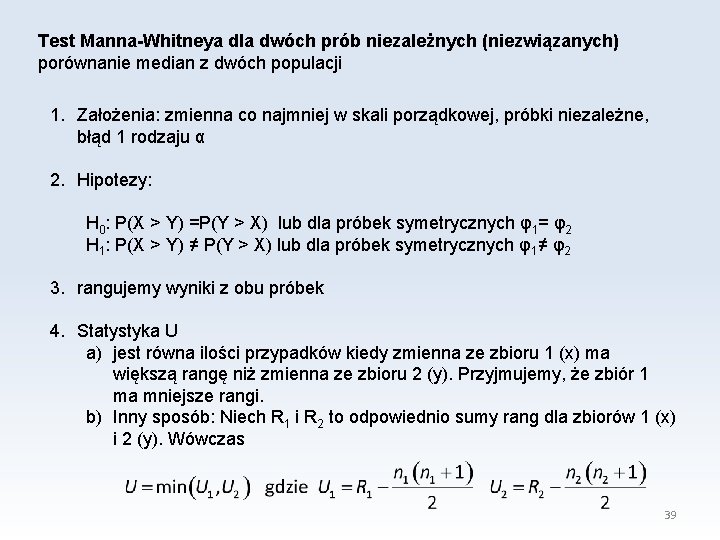

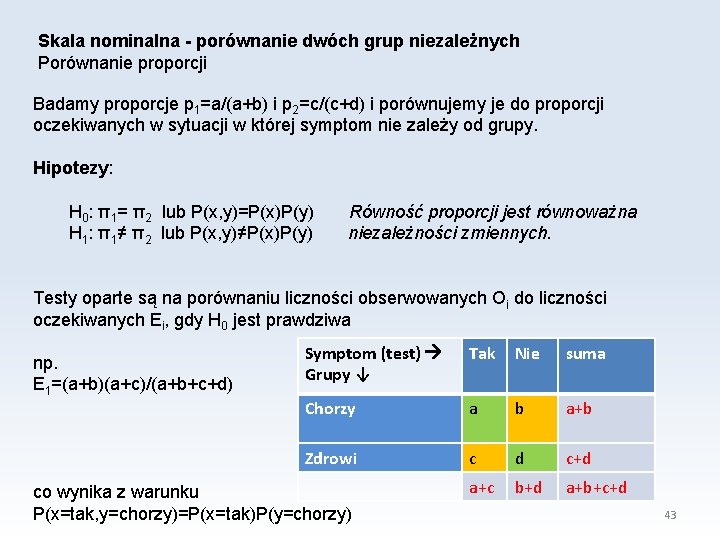

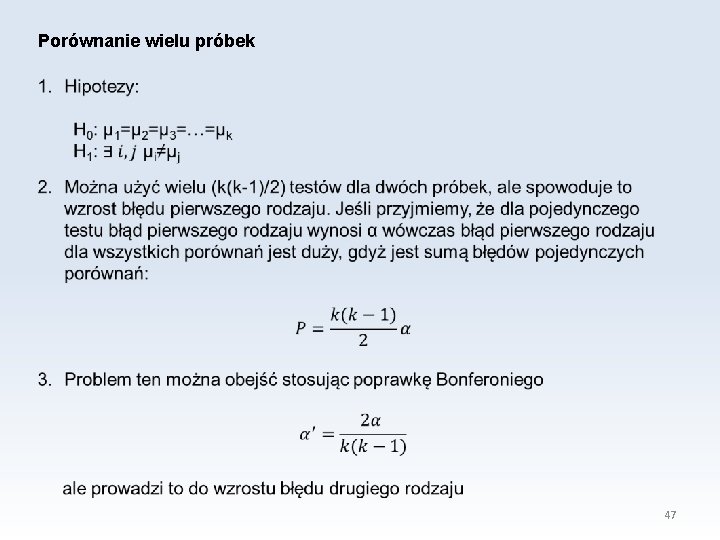

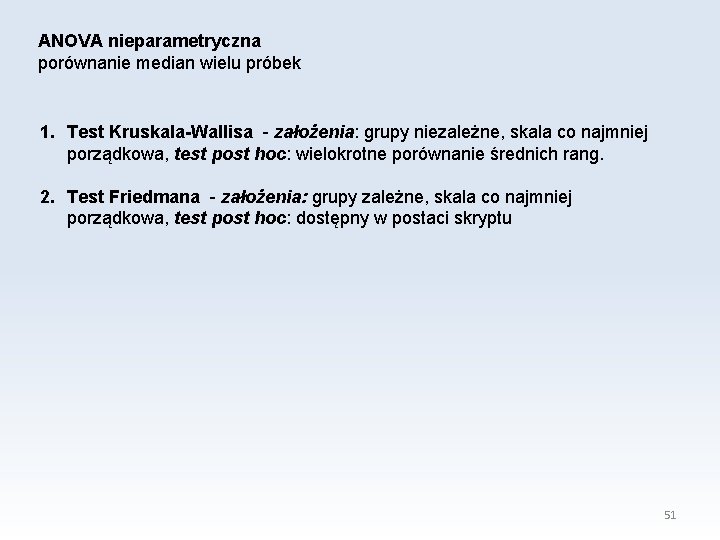

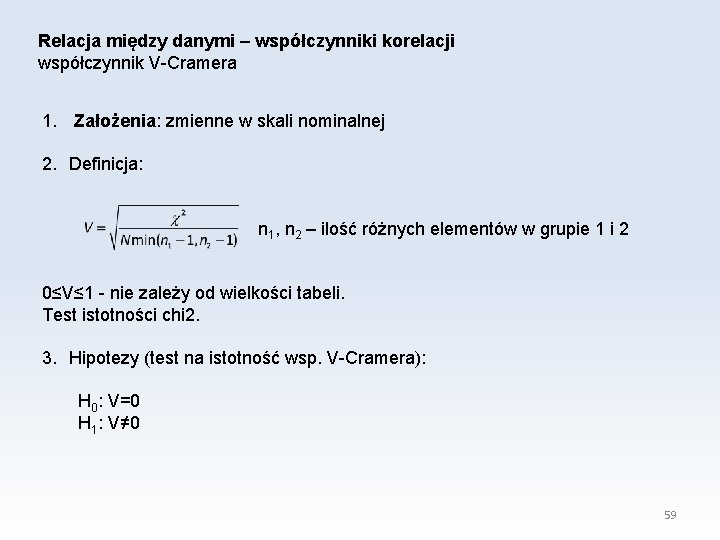

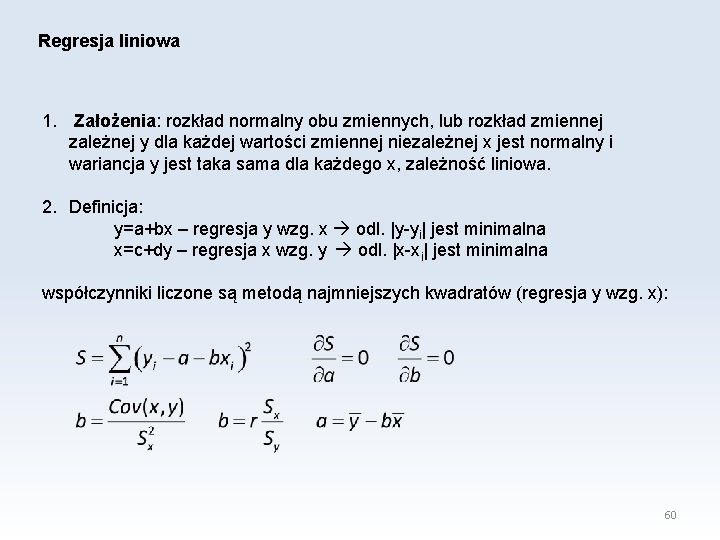

Miary rozrzutu • Wariancja • Odchylenie standardowe • Odchylenie ćwiartkowe • Współczynnik zmienności 15

![Miary rozrzutu przykład Mężczyźni Kobiety Wzrost cm 175 S15 165 S14 Masa kg Miary rozrzutu - przykład Mężczyźni Kobiety Wzrost [cm] 175 S=15 165 S=14 Masa [kg]](https://slidetodoc.com/presentation_image_h/e210f4c9a494c0aebd6a2b2e61a33121/image-16.jpg)

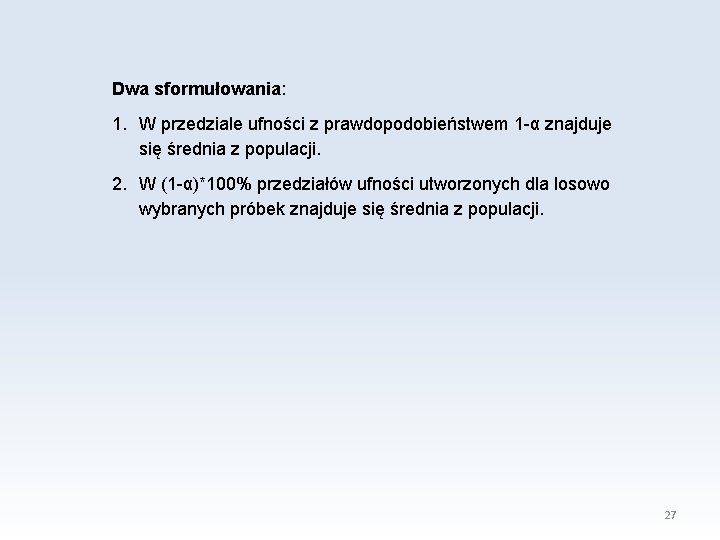

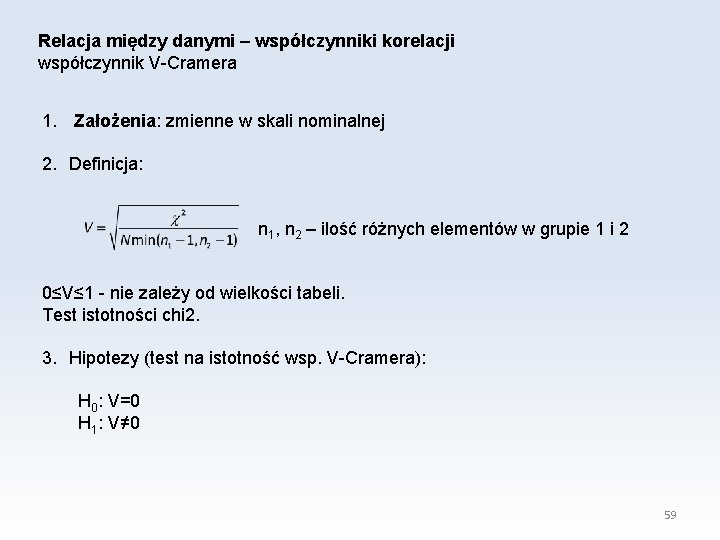

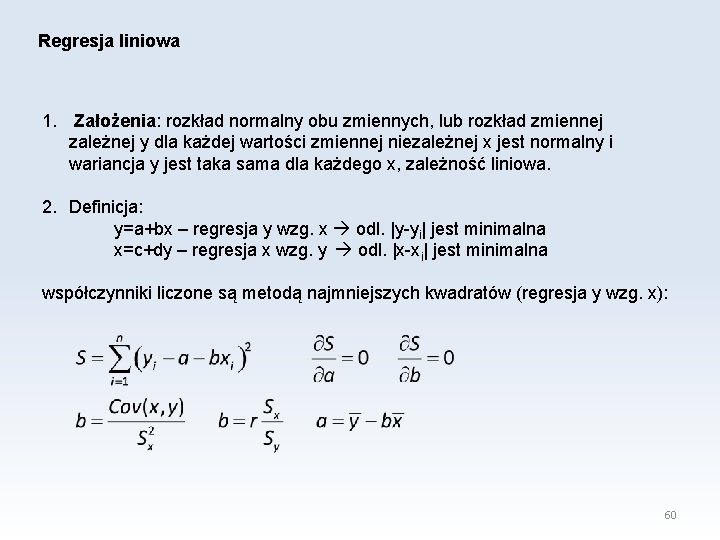

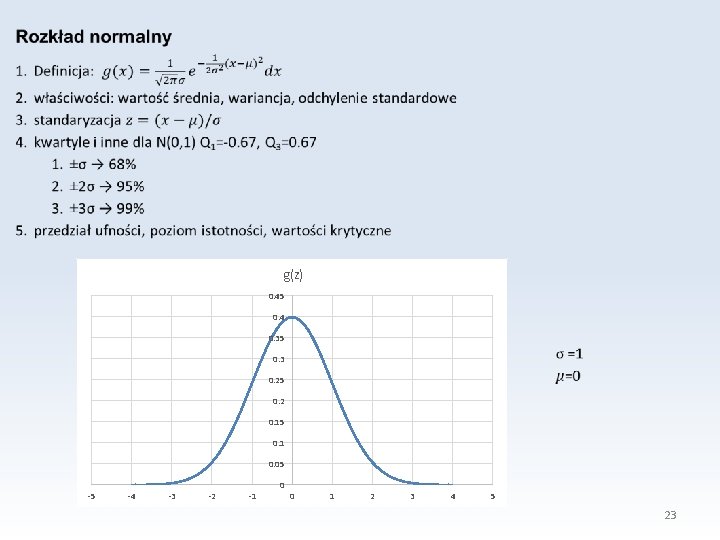

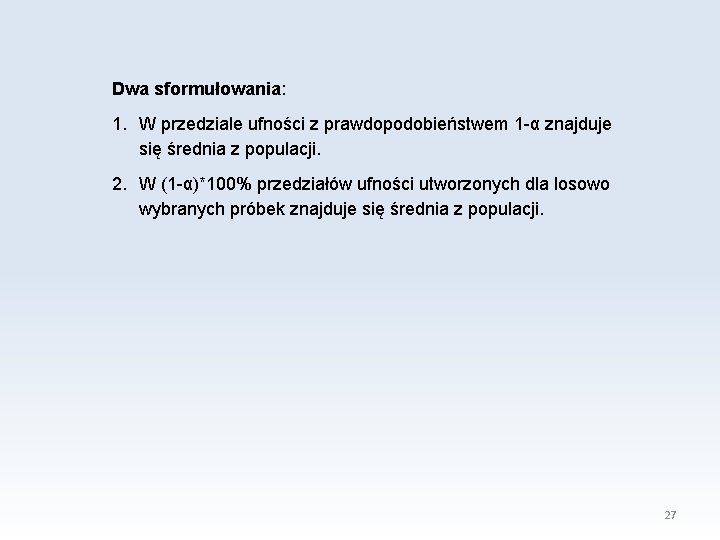

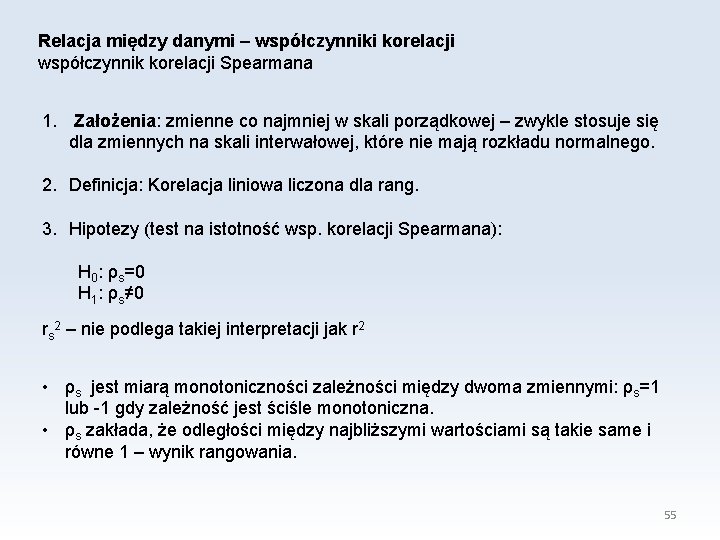

Miary rozrzutu - przykład Mężczyźni Kobiety Wzrost [cm] 175 S=15 165 S=14 Masa [kg] 75 55 S=10 S=9 Mężczyźni Kobiety Wzrost [cm] 175 V=0. 0857 165 V=0. 0848 Masa [kg] 75 55 V=0. 16 V=0. 13 16

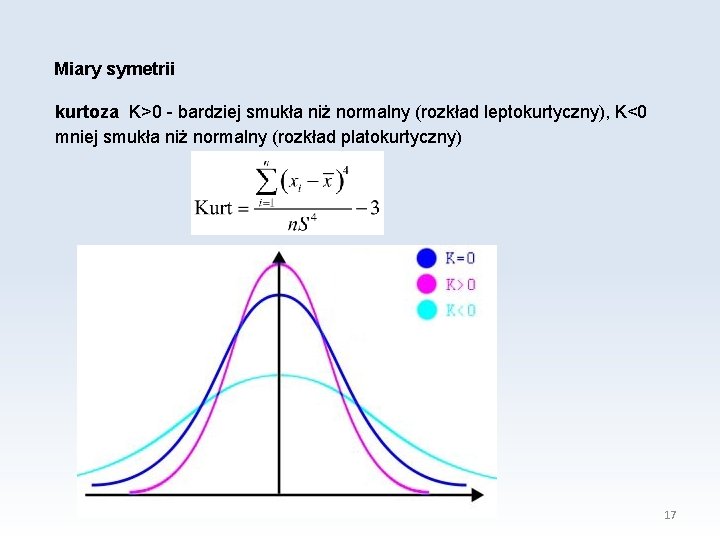

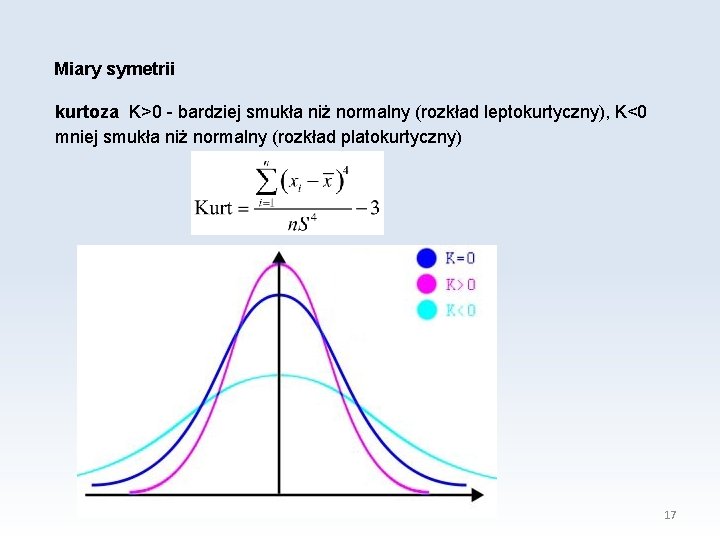

Miary symetrii kurtoza K>0 - bardziej smukła niż normalny (rozkład leptokurtyczny), K<0 mniej smukła niż normalny (rozkład platokurtyczny) 17

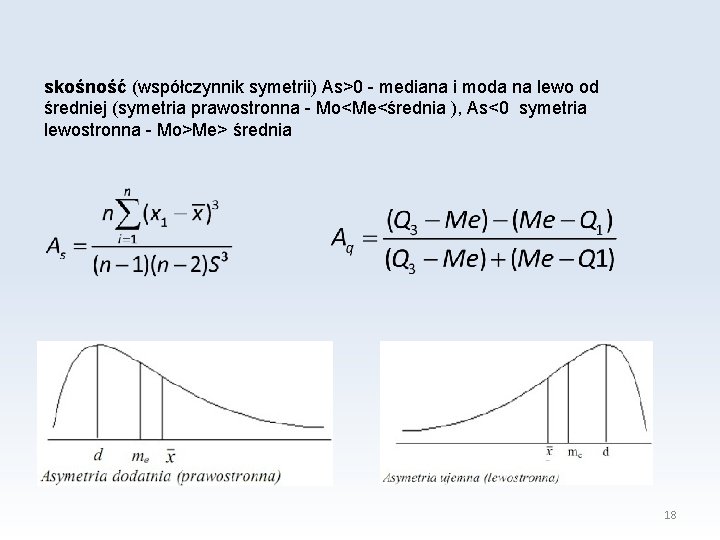

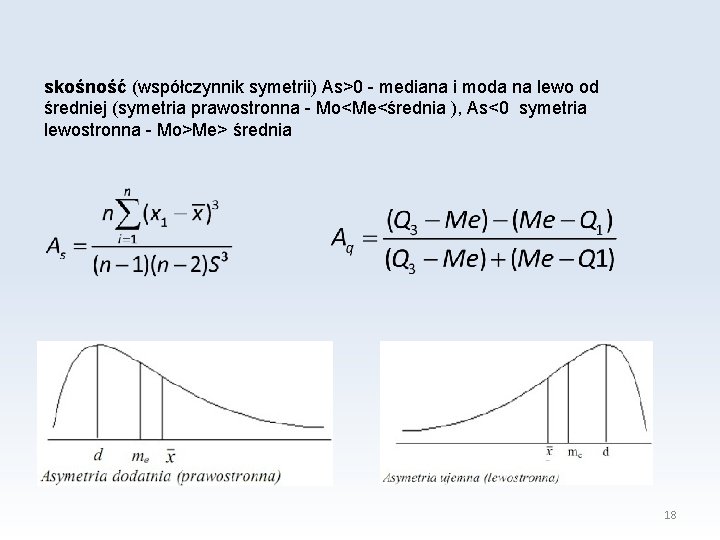

skośność (współczynnik symetrii) As>0 - mediana i moda na lewo od średniej (symetria prawostronna - Mo<Me<średnia ), As<0 symetria lewostronna - Mo>Me> średnia 18

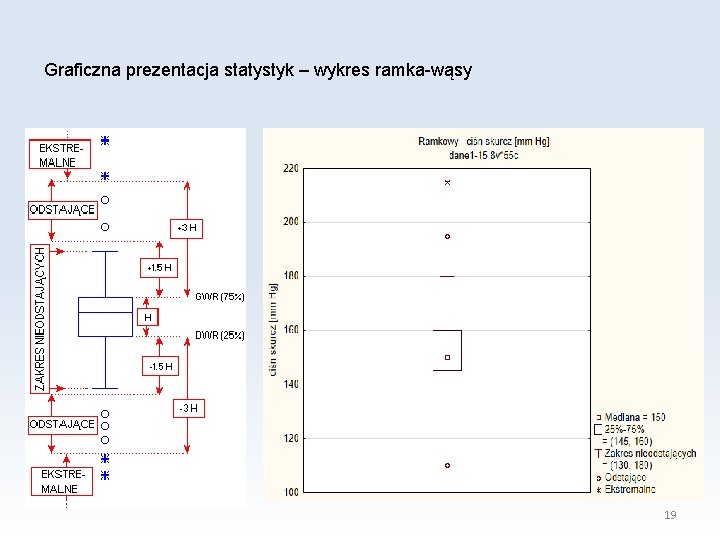

Graficzna prezentacja statystyk – wykres ramka-wąsy 19

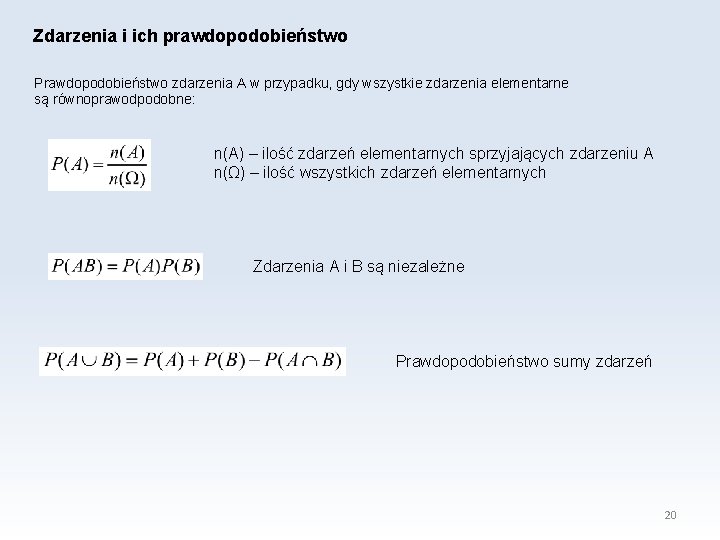

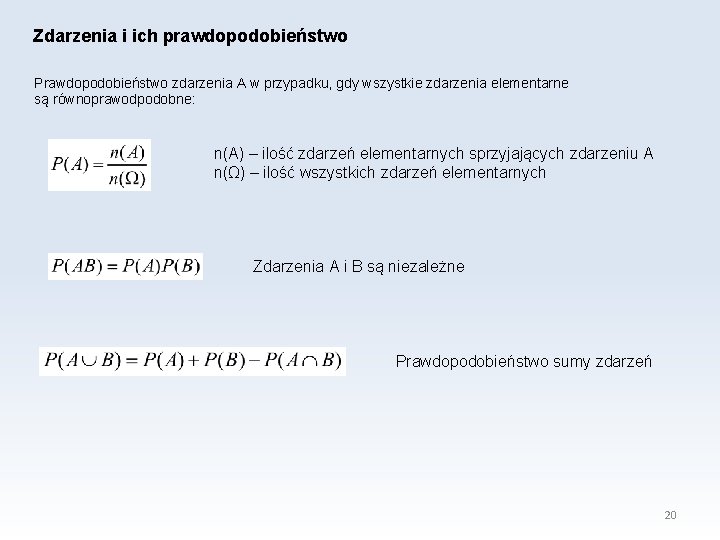

Zdarzenia i ich prawdopodobieństwo Prawdopodobieństwo zdarzenia A w przypadku, gdy wszystkie zdarzenia elementarne są równoprawodpodobne: n(A) – ilość zdarzeń elementarnych sprzyjających zdarzeniu A n(Ω) – ilość wszystkich zdarzeń elementarnych Zdarzenia A i B są niezależne Prawdopodobieństwo sumy zdarzeń 20

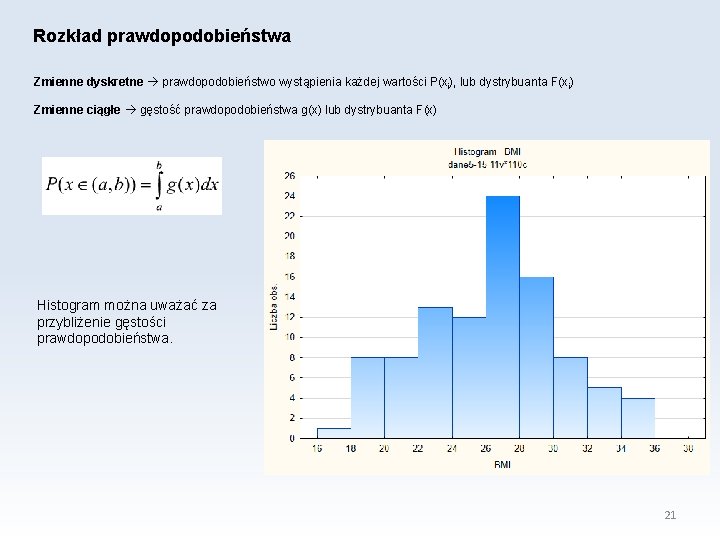

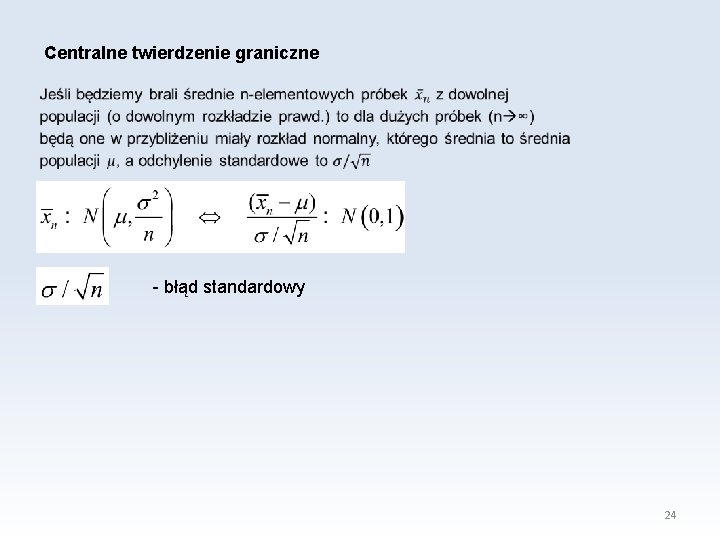

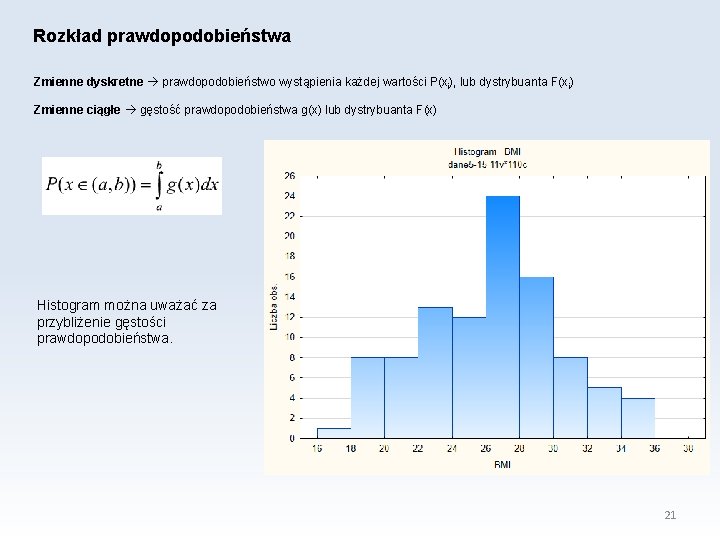

Rozkład prawdopodobieństwa Zmienne dyskretne prawdopodobieństwo wystąpienia każdej wartości P(xi), lub dystrybuanta F(xi) Zmienne ciągłe gęstość prawdopodobieństwa g(x) lub dystrybuanta F(x) Histogram można uważać za przybliżenie gęstości prawdopodobieństwa. 21

Rodzaje rozkładów prawdopodobieństwa: 1. Symetryczny 2. Asymetryczny 3. o kształcie J 4. multimodalny 22

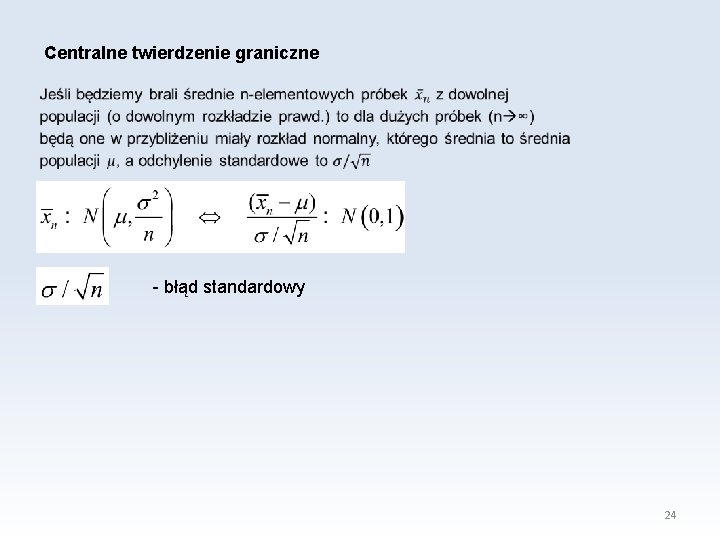

g(z) 0. 45 0. 4 0. 35 0. 3 0. 25 0. 2 0. 15 0. 1 0. 05 -5 -4 -3 -2 -1 0 0 1 2 3 4 5 23

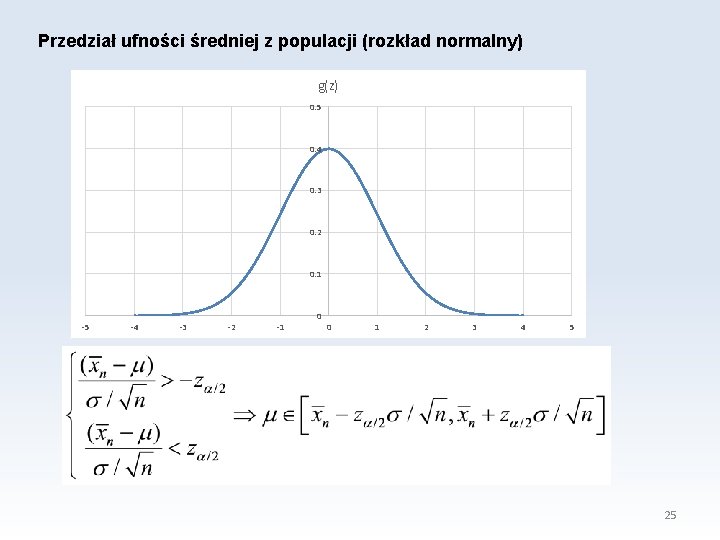

Centralne twierdzenie graniczne - błąd standardowy 24

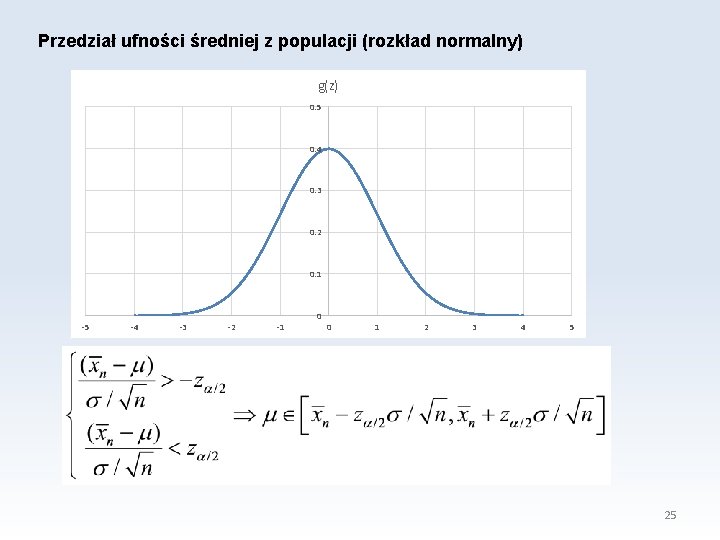

Przedział ufności średniej z populacji (rozkład normalny) g(z) 0. 5 0. 4 0. 3 0. 2 0. 1 -5 -4 -3 -2 -1 0 0 1 2 3 4 5 25

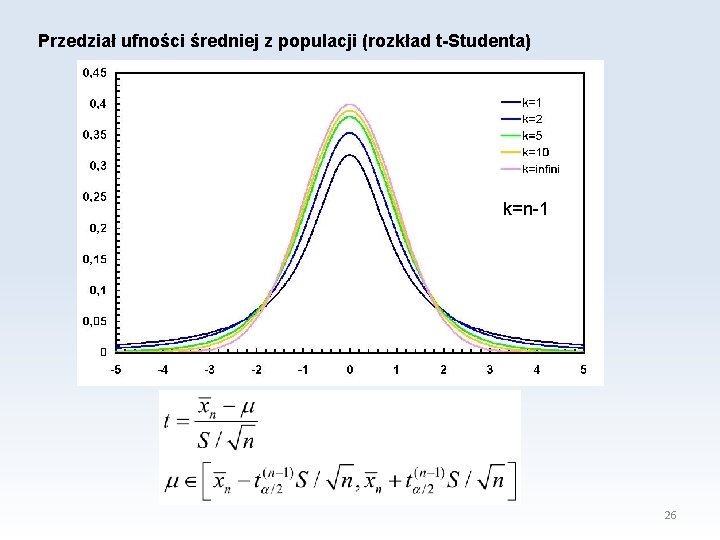

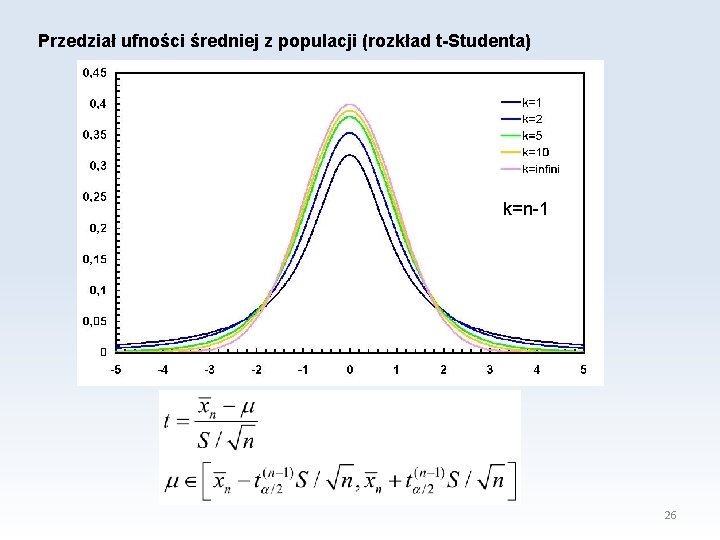

Przedział ufności średniej z populacji (rozkład t-Studenta) k=n-1 26

Dwa sformułowania: 1. W przedziale ufności z prawdopodobieństwem 1 -α znajduje się średnia z populacji. 2. W (1 -α)*100% przedziałów ufności utworzonych dla losowo wybranych próbek znajduje się średnia z populacji. 27

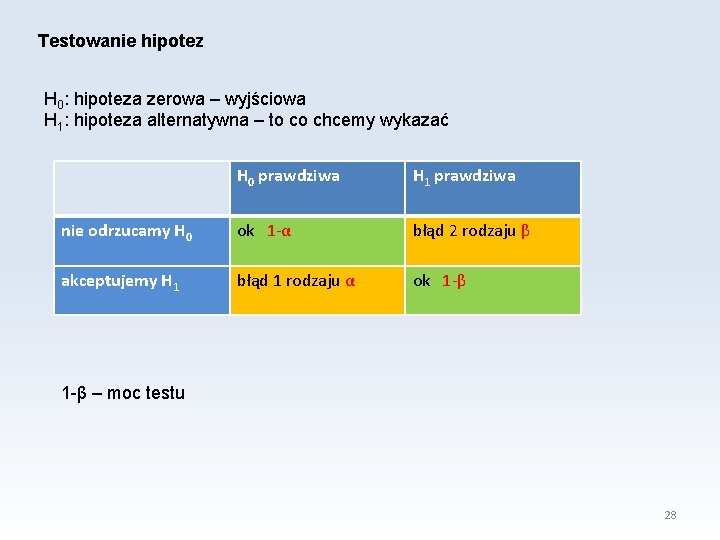

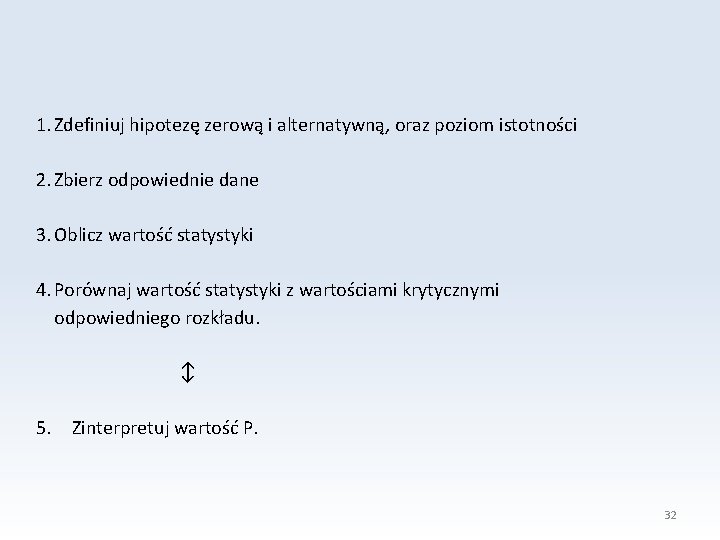

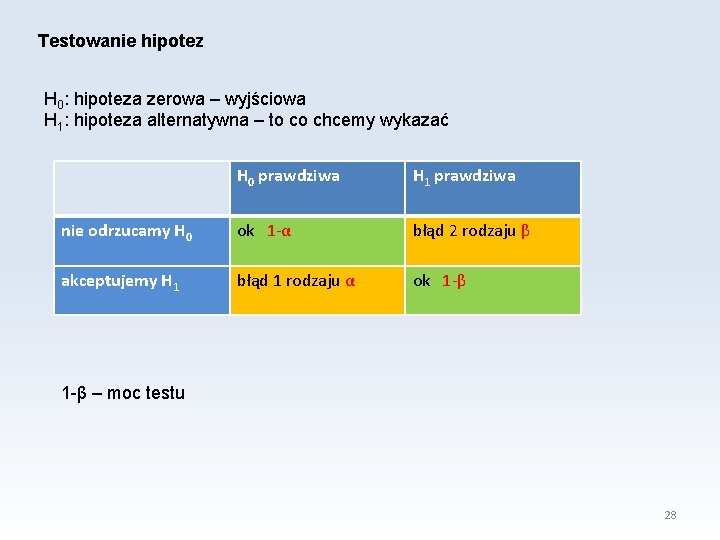

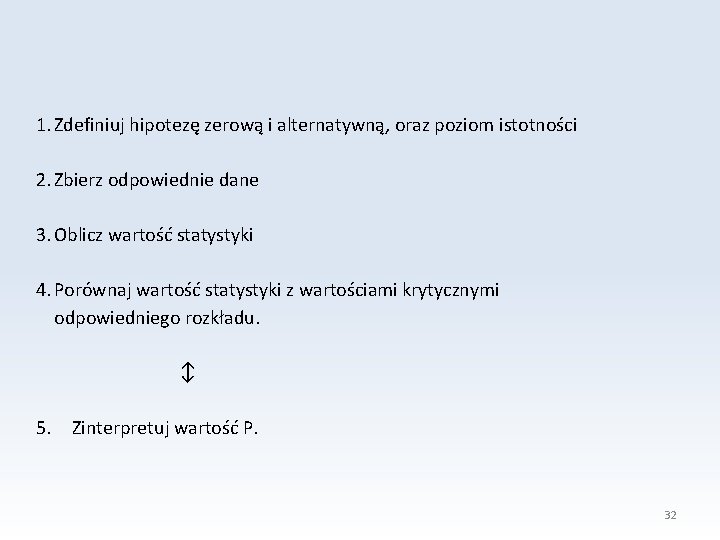

Testowanie hipotez H 0: hipoteza zerowa – wyjściowa H 1: hipoteza alternatywna – to co chcemy wykazać H 0 prawdziwa H 1 prawdziwa nie odrzucamy H 0 ok 1 -α błąd 2 rodzaju β akceptujemy H 1 błąd 1 rodzaju α ok 1 -β – moc testu 28

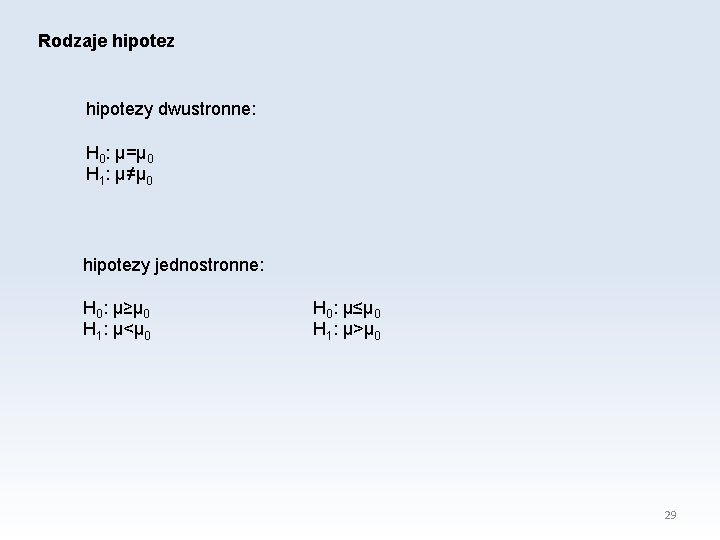

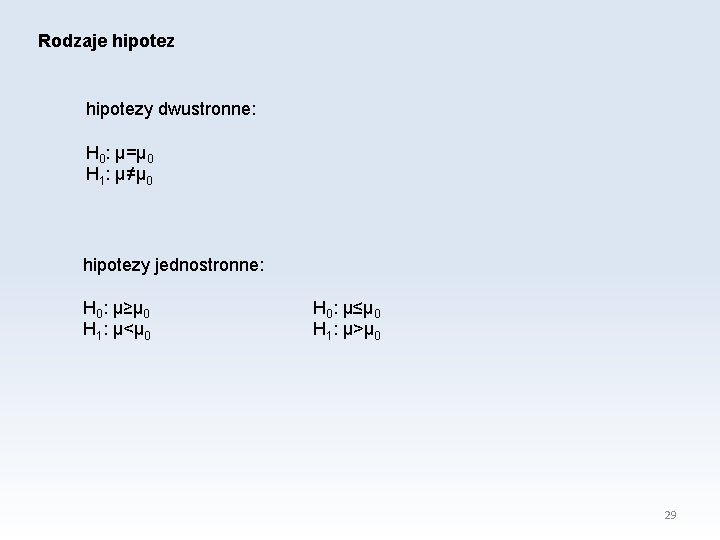

Rodzaje hipotezy dwustronne: H 0: μ=μ 0 H 1: μ≠μ 0 hipotezy jednostronne: H 0: μ≥μ 0 H 1: μ<μ 0 H 0: μ≤μ 0 H 1: μ>μ 0 29

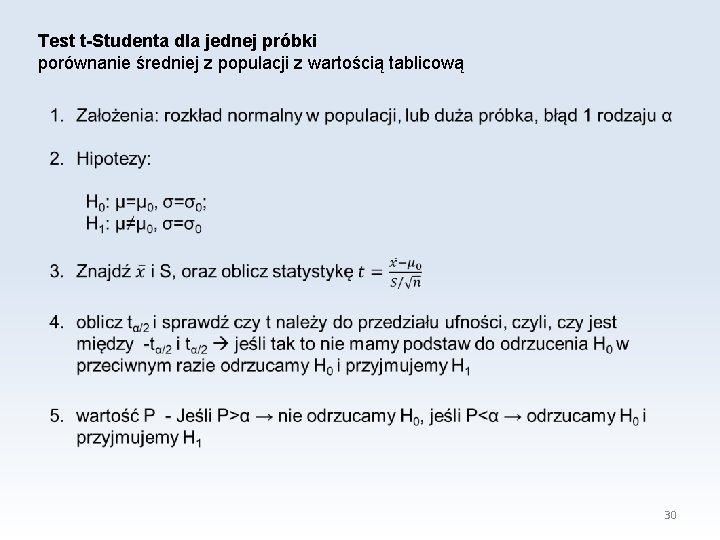

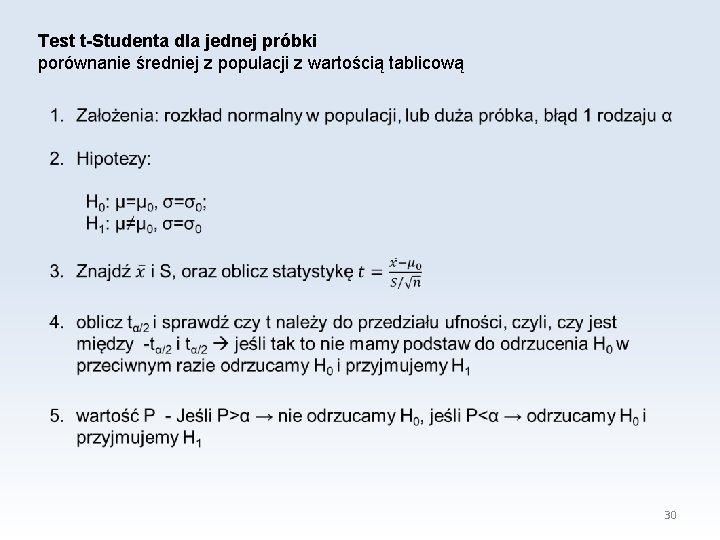

Test t-Studenta dla jednej próbki porównanie średniej z populacji z wartością tablicową 30

31

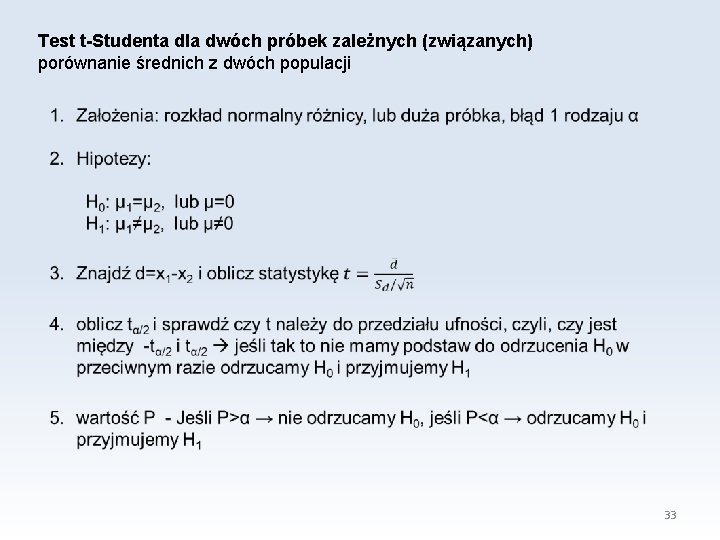

1. Zdefiniuj hipotezę zerową i alternatywną, oraz poziom istotności 2. Zbierz odpowiednie dane 3. Oblicz wartość statystyki 4. Porównaj wartość statystyki z wartościami krytycznymi odpowiedniego rozkładu. ↕ 5. Zinterpretuj wartość P. 32

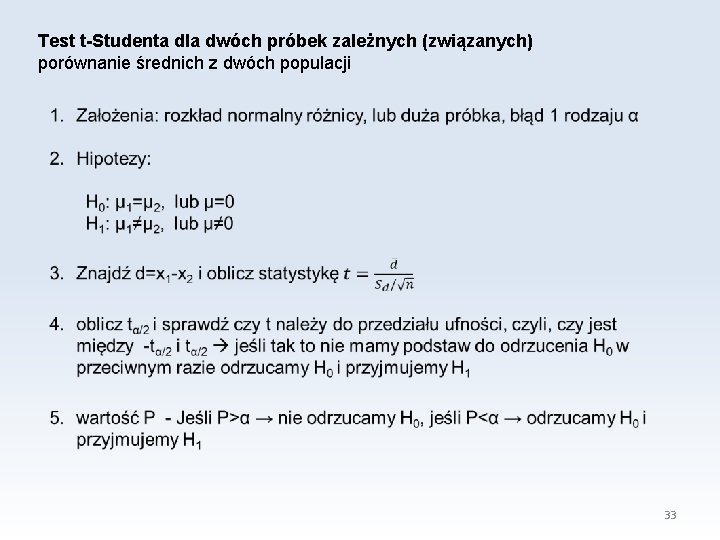

Test t-Studenta dla dwóch próbek zależnych (związanych) porównanie średnich z dwóch populacji 33

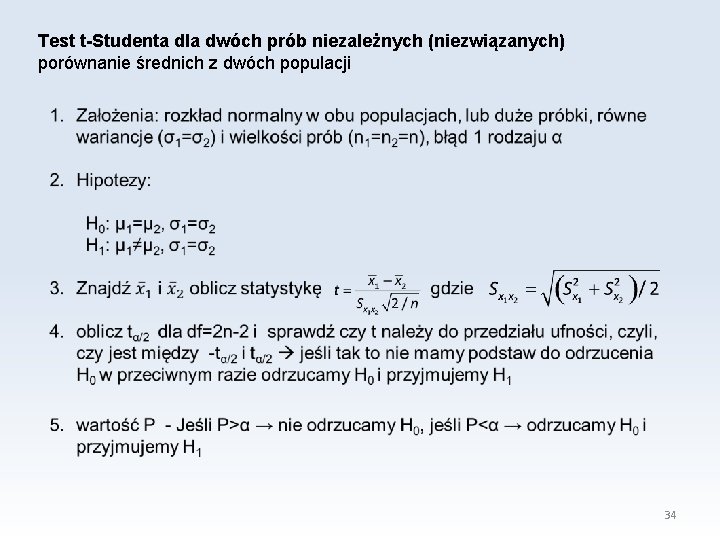

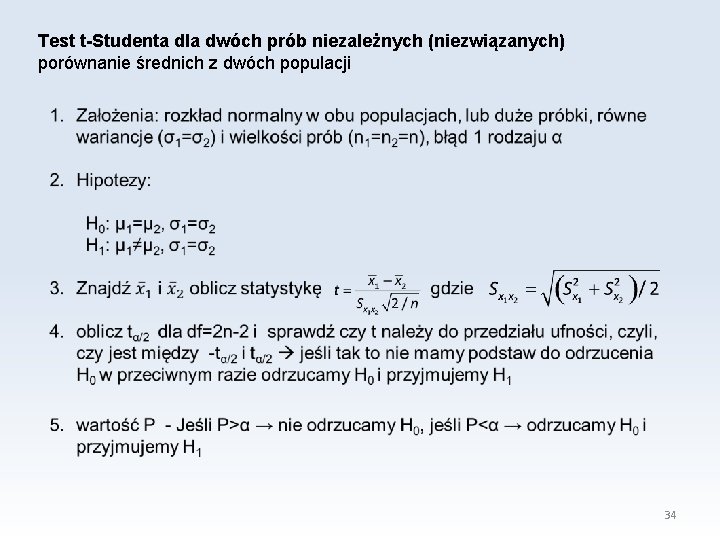

Test t-Studenta dla dwóch prób niezależnych (niezwiązanych) porównanie średnich z dwóch populacji 34

Test Shapiro-Wilka Sprawdzanie normalności rozkładu 1. Hipotezy: H 0: rozkład w populacji jest rozkładem normalnym H 1: w populacji nie ma rozkładu normalnego 2. wartość P - Jeśli P>α → nie odrzucamy H 0, jeśli P<α → odrzucamy H 0 i przyjmujemy H 1 35

Test Levene’a Sprawdzanie jednorodności wariancji 1. Hipotezy: H 0: σ1=σ2 wariancje są jednorodne H 1: σ1≠σ2 wariancje nie są jednorodne 2. wartość P - Jeśli P>α → nie odrzucamy H 0, jeśli P<α → odrzucamy H 0 i przyjmujemy H 1 36

Test znaków dla dwóch prób zależnych (związanych) porównanie median z dwóch populacji 1. Założenia: zmienna co najmniej w skali porządkowej, próbki zależne, błąd 1 rodzaju α 2. Hipotezy: H 0: φ1= φ2 H 1: φ1≠ φ2 3. Tworzymy pary wyników xi i yi 4. Statystyka W to liczba par w których xi > yi, podlega rozkładowi binomialnemu 5. wartość P - Jeśli P>α → nie odrzucamy H 0, jeśli P<α → odrzucamy H 0 i przyjmujemy H 1 37

Test Wilcoxona dla dwóch prób zależnych (związanych) porównanie median z dwóch populacji 1. Założenia: zmienna co najmniej w skali interwałowej, próbki zależne, błąd 1 rodzaju α 2. Hipotezy: H 0: φ1= φ2 H 1: φ1≠ φ2 3. Tworzymy pary wyników xi i yi. Następnie szeregujemy zi=xi - yi wg bezwzględnej wartości od najmniejszej do największej. Odrzucamy zi=0. Przypisujemy kolejne rangi, tak że 1 jest przypisana najmniejszej bezwzględnej wartości, itd. . Gdy mamy kilka takich samych wartości to przypisujemy im rangę równą średniej rozpinanych rang. 4. Statystyka 5. wartość P - Jeśli P>α → nie odrzucamy H 0, jeśli P<α → odrzucamy H 0 i przyjmujemy H 1 38

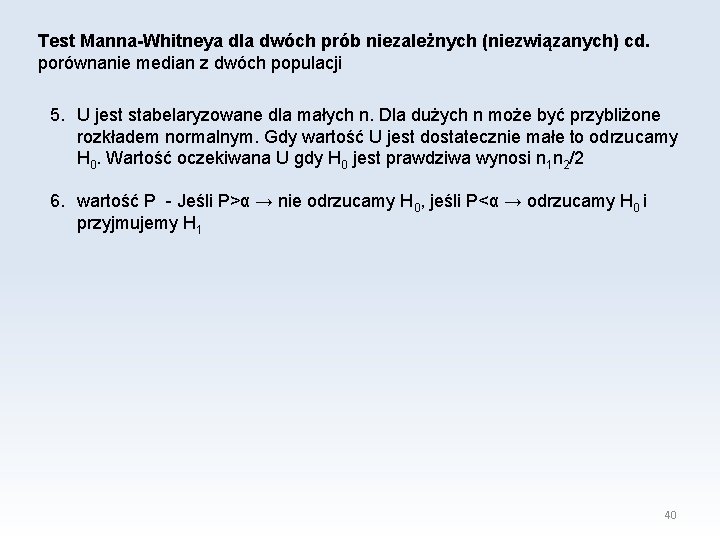

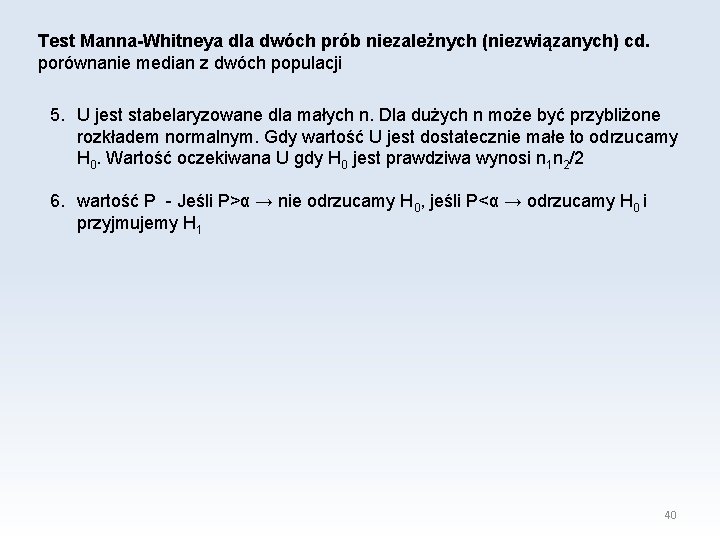

Test Manna-Whitneya dla dwóch prób niezależnych (niezwiązanych) porównanie median z dwóch populacji 1. Założenia: zmienna co najmniej w skali porządkowej, próbki niezależne, błąd 1 rodzaju α 2. Hipotezy: H 0: P(X > Y) =P(Y > X) lub dla próbek symetrycznych φ1= φ2 H 1: P(X > Y) ≠ P(Y > X) lub dla próbek symetrycznych φ1≠ φ2 3. rangujemy wyniki z obu próbek 4. Statystyka U a) jest równa ilości przypadków kiedy zmienna ze zbioru 1 (x) ma większą rangę niż zmienna ze zbioru 2 (y). Przyjmujemy, że zbiór 1 ma mniejsze rangi. b) Inny sposób: Niech R 1 i R 2 to odpowiednio sumy rang dla zbiorów 1 (x) i 2 (y). Wówczas 39

Test Manna-Whitneya dla dwóch prób niezależnych (niezwiązanych) cd. porównanie median z dwóch populacji 5. U jest stabelaryzowane dla małych n. Dla dużych n może być przybliżone rozkładem normalnym. Gdy wartość U jest dostatecznie małe to odrzucamy H 0. Wartość oczekiwana U gdy H 0 jest prawdziwa wynosi n 1 n 2/2 6. wartość P - Jeśli P>α → nie odrzucamy H 0, jeśli P<α → odrzucamy H 0 i przyjmujemy H 1 40

Schemat testów: 1. rodzaj testu: porównanie lub zależność 2. skala pomiarowa 3. wybór testu 4. hipotezy H 0 i H 1 5. wynik: P 6. Interpretacja wyniku 41

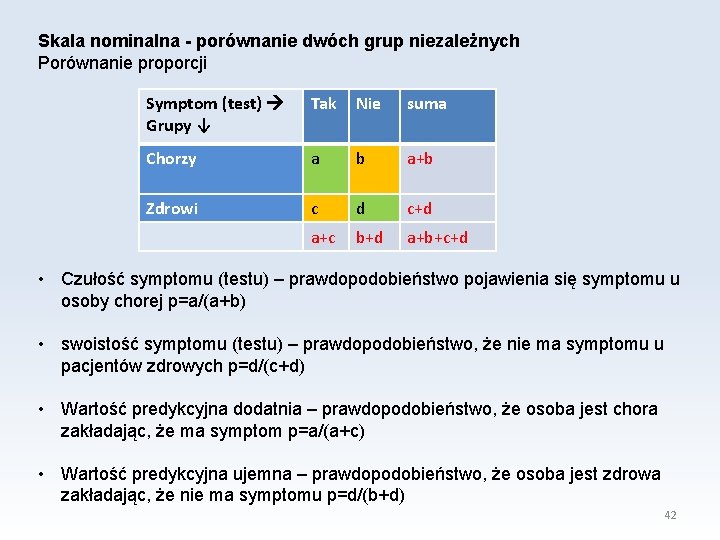

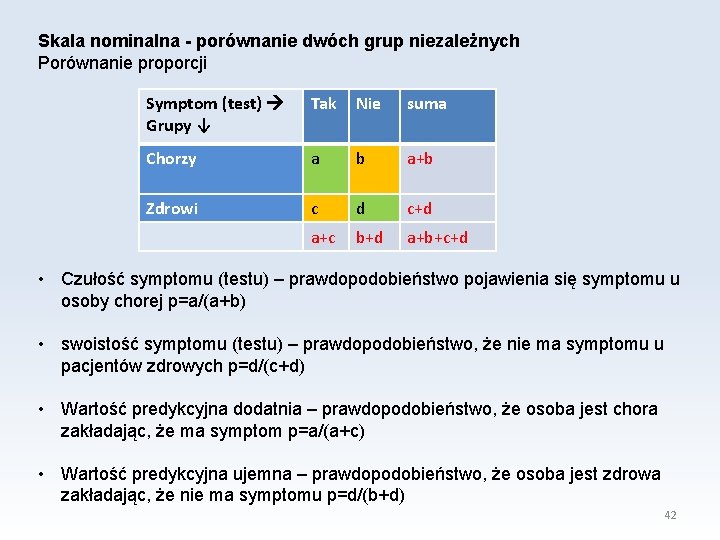

Skala nominalna - porównanie dwóch grup niezależnych Porównanie proporcji Symptom (test) Grupy ↓ Tak Nie suma Chorzy a b a+b Zdrowi c d c+d a+c b+d a+b+c+d • Czułość symptomu (testu) – prawdopodobieństwo pojawienia się symptomu u osoby chorej p=a/(a+b) • swoistość symptomu (testu) – prawdopodobieństwo, że nie ma symptomu u pacjentów zdrowych p=d/(c+d) • Wartość predykcyjna dodatnia – prawdopodobieństwo, że osoba jest chora zakładając, że ma symptom p=a/(a+c) • Wartość predykcyjna ujemna – prawdopodobieństwo, że osoba jest zdrowa zakładając, że nie ma symptomu p=d/(b+d) 42

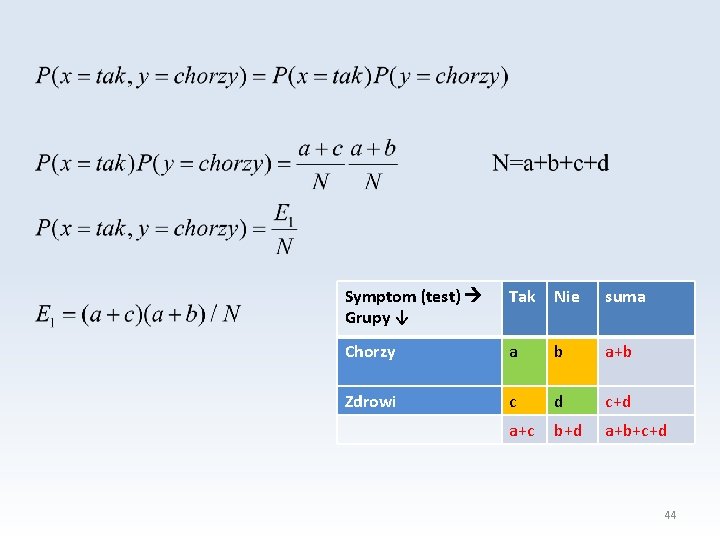

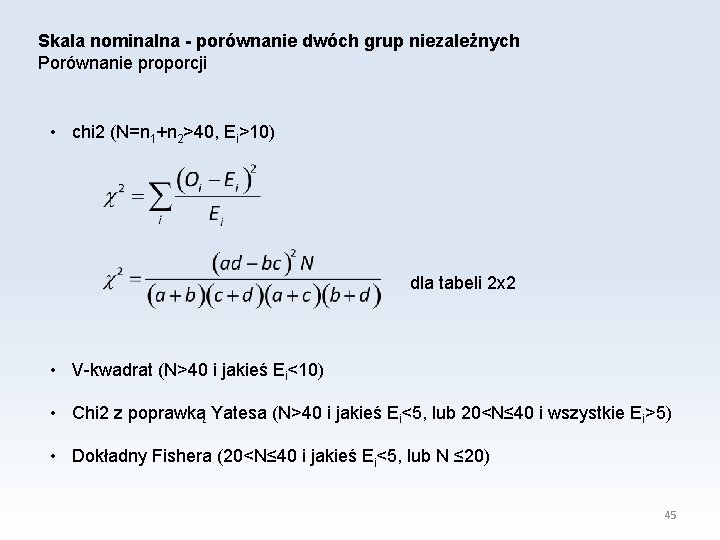

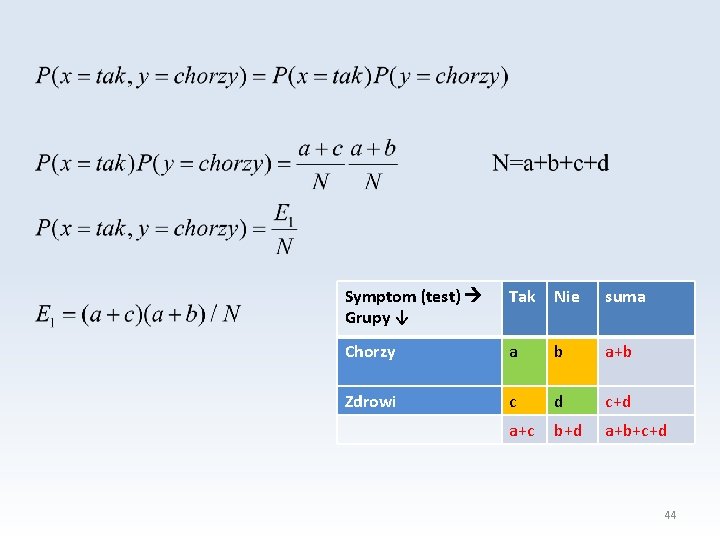

Skala nominalna - porównanie dwóch grup niezależnych Porównanie proporcji Badamy proporcje p 1=a/(a+b) i p 2=c/(c+d) i porównujemy je do proporcji oczekiwanych w sytuacji w której symptom nie zależy od grupy. Hipotezy: H 0: π1= π2 lub P(x, y)=P(x)P(y) Równość proporcji jest równoważna H 1: π1≠ π2 lub P(x, y)≠P(x)P(y) niezależności zmiennych. Testy oparte są na porównaniu liczności obserwowanych Oi do liczności oczekiwanych Ei, gdy H 0 jest prawdziwa np. E 1=(a+b)(a+c)/(a+b+c+d) Symptom (test) Grupy ↓ Tak Nie suma Chorzy a b a+b Zdrowi c d c+d a+c b+d a+b+c+d co wynika z warunku P(x=tak, y=chorzy)=P(x=tak)P(y=chorzy) 43

Symptom (test) Grupy ↓ Tak Nie suma Chorzy a b a+b Zdrowi c d c+d a+c b+d a+b+c+d 44

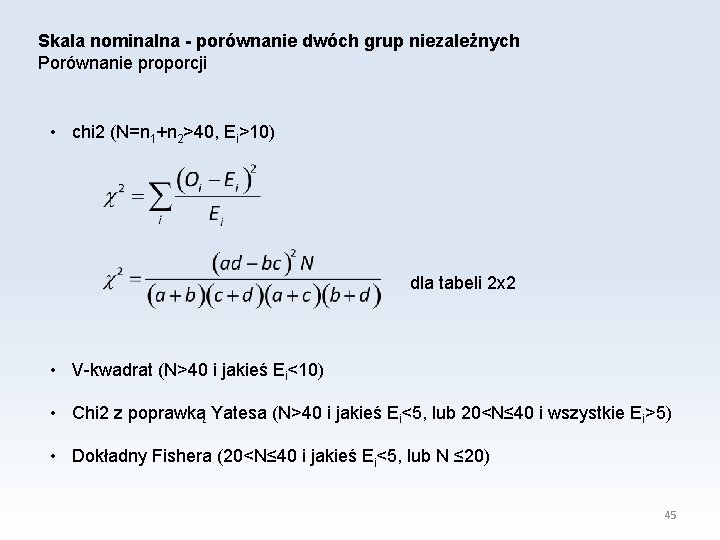

Skala nominalna - porównanie dwóch grup niezależnych Porównanie proporcji • chi 2 (N=n 1+n 2>40, Ei>10) dla tabeli 2 x 2 • V-kwadrat (N>40 i jakieś Ei<10) • Chi 2 z poprawką Yatesa (N>40 i jakieś Ei<5, lub 20<N≤ 40 i wszystkie Ei>5) • Dokładny Fishera (20<N≤ 40 i jakieś Ei<5, lub N ≤ 20) 45

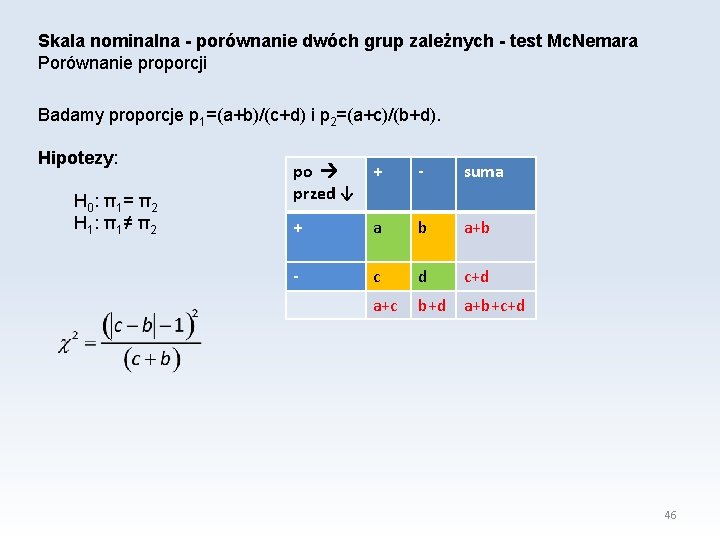

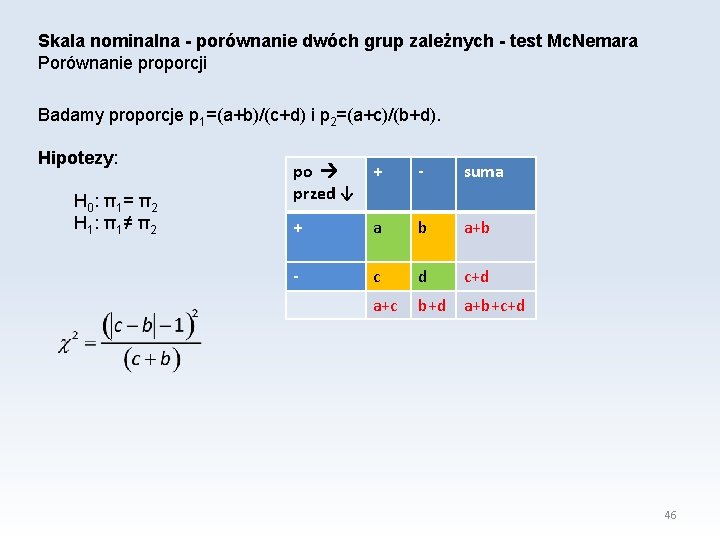

Skala nominalna - porównanie dwóch grup zależnych - test Mc. Nemara Porównanie proporcji Badamy proporcje p 1=(a+b)/(c+d) i p 2=(a+c)/(b+d). Hipotezy: H 0: π1= π2 H 1: π1≠ π2 po + przed ↓ - suma + a b a+b - c d c+d a+c b+d a+b+c+d 46

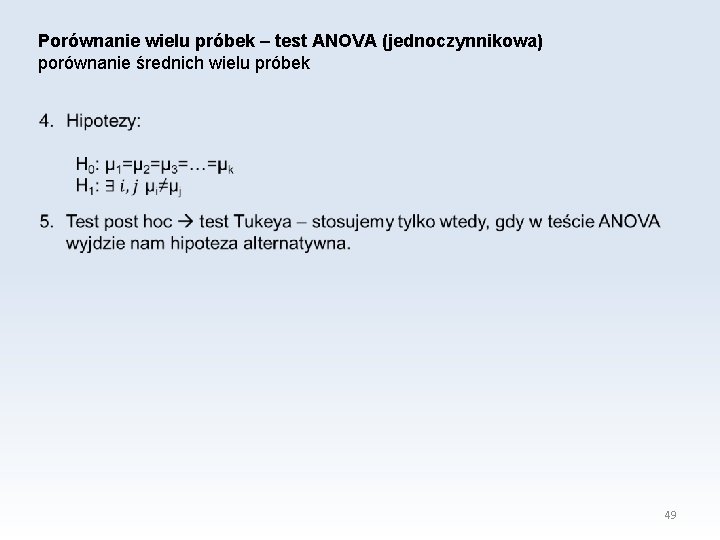

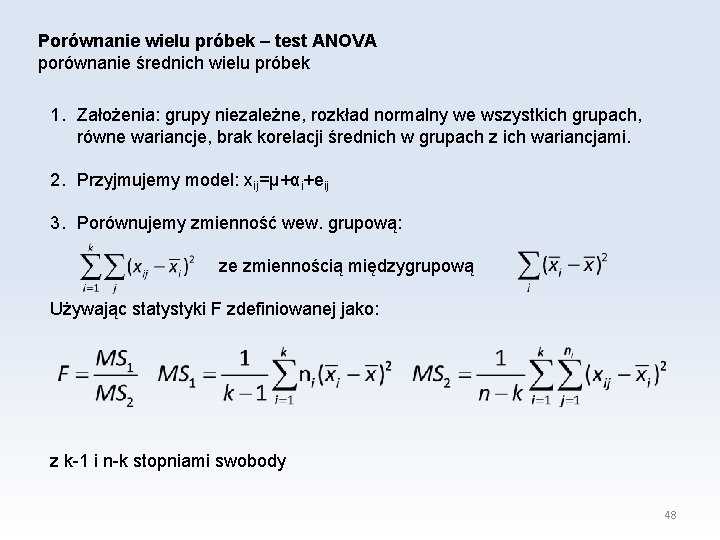

Porównanie wielu próbek 47

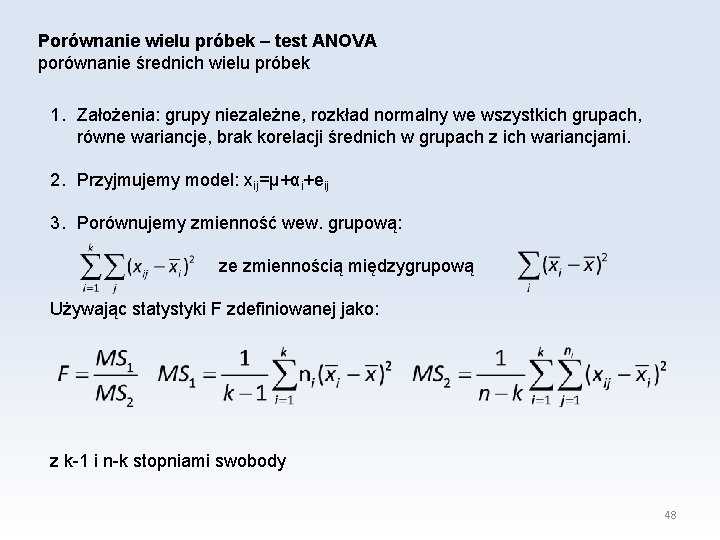

Porównanie wielu próbek – test ANOVA porównanie średnich wielu próbek 1. Założenia: grupy niezależne, rozkład normalny we wszystkich grupach, równe wariancje, brak korelacji średnich w grupach z ich wariancjami. 2. Przyjmujemy model: xij=µ+αi+eij 3. Porównujemy zmienność wew. grupową: ze zmiennością międzygrupową Używając statystyki F zdefiniowanej jako: z k-1 i n-k stopniami swobody 48

Porównanie wielu próbek – test ANOVA (jednoczynnikowa) porównanie średnich wielu próbek 49

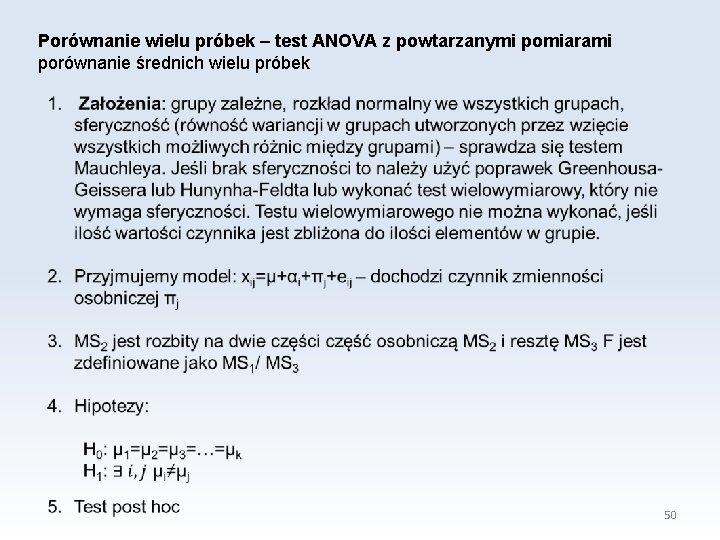

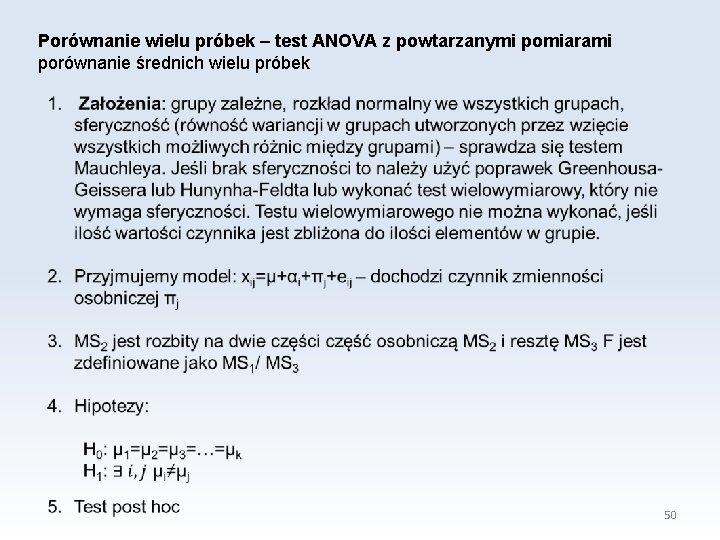

Porównanie wielu próbek – test ANOVA z powtarzanymi pomiarami porównanie średnich wielu próbek 50

ANOVA nieparametryczna porównanie median wielu próbek 1. Test Kruskala-Wallisa - założenia: grupy niezależne, skala co najmniej porządkowa, test post hoc: wielokrotne porównanie średnich rang. 2. Test Friedmana - założenia: grupy zależne, skala co najmniej porządkowa, test post hoc: dostępny w postaci skryptu 51

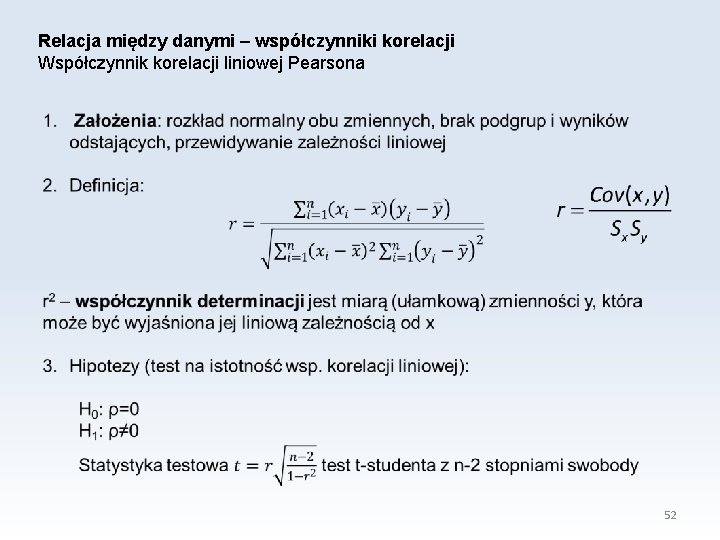

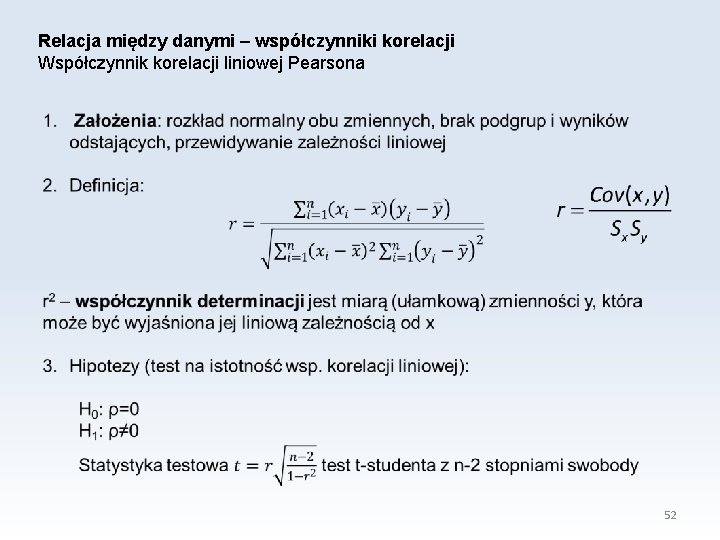

Relacja między danymi – współczynniki korelacji Współczynnik korelacji liniowej Pearsona 52

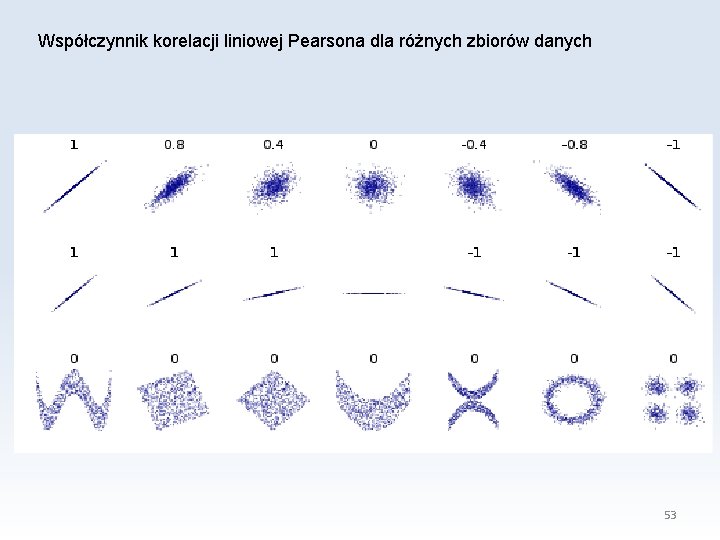

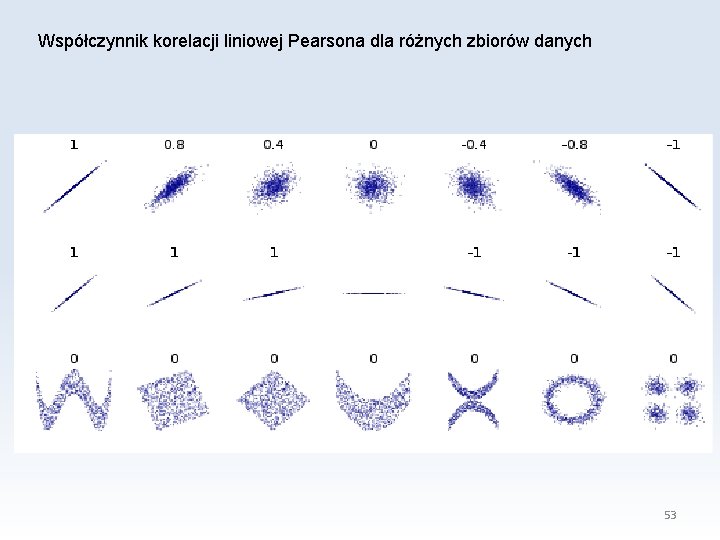

Współczynnik korelacji liniowej Pearsona dla różnych zbiorów danych 53

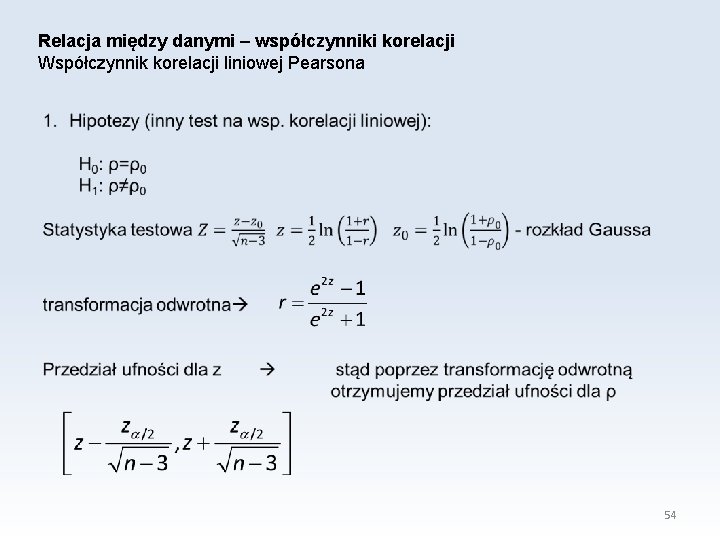

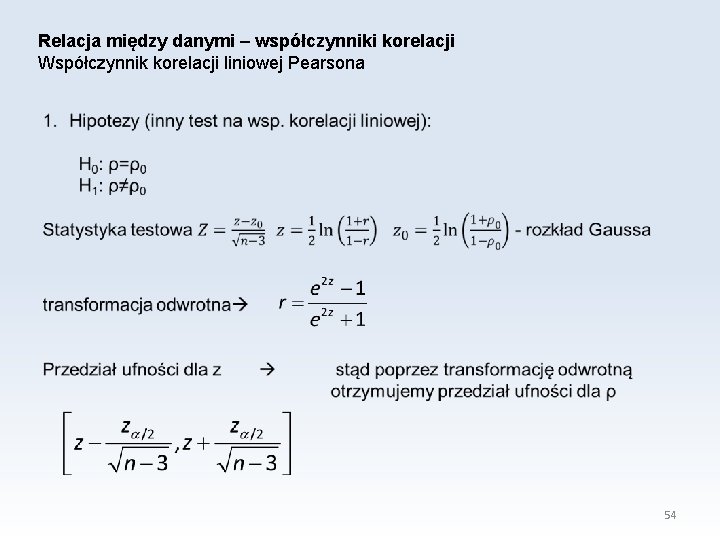

Relacja między danymi – współczynniki korelacji Współczynnik korelacji liniowej Pearsona 54

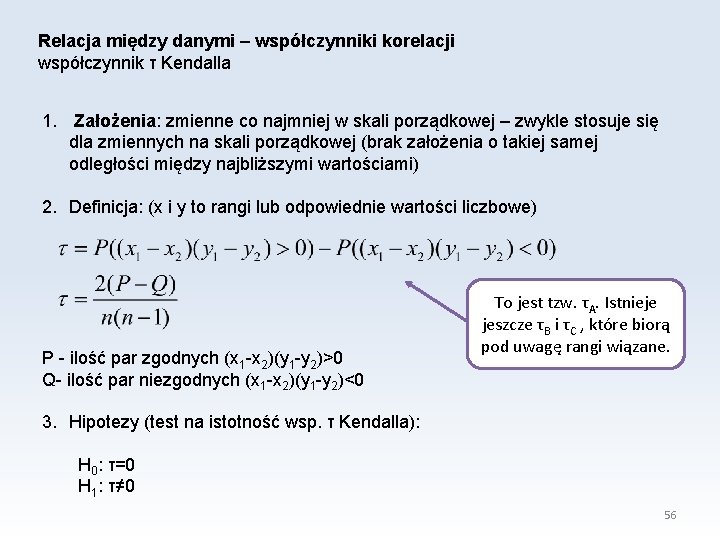

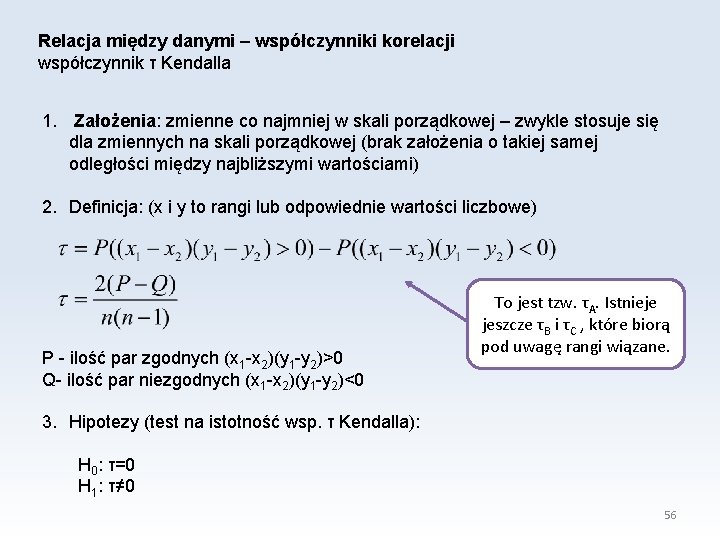

Relacja między danymi – współczynniki korelacji współczynnik korelacji Spearmana 1. Założenia: zmienne co najmniej w skali porządkowej – zwykle stosuje się dla zmiennych na skali interwałowej, które nie mają rozkładu normalnego. 2. Definicja: Korelacja liniowa liczona dla rang. 3. Hipotezy (test na istotność wsp. korelacji Spearmana): H 0: ρs=0 H 1: ρs≠ 0 rs 2 – nie podlega takiej interpretacji jak r 2 • ρs jest miarą monotoniczności zależności między dwoma zmiennymi: ρs=1 lub -1 gdy zależność jest ściśle monotoniczna. • ρs zakłada, że odległości między najbliższymi wartościami są takie same i równe 1 – wynik rangowania. 55

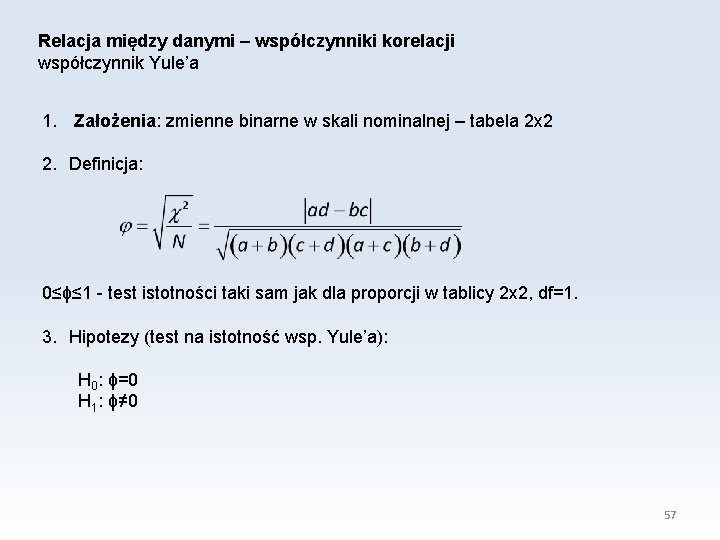

Relacja między danymi – współczynniki korelacji współczynnik τ Kendalla 1. Założenia: zmienne co najmniej w skali porządkowej – zwykle stosuje się dla zmiennych na skali porządkowej (brak założenia o takiej samej odległości między najbliższymi wartościami) 2. Definicja: (x i y to rangi lub odpowiednie wartości liczbowe) P - ilość par zgodnych (x 1 -x 2)(y 1 -y 2)>0 Q- ilość par niezgodnych (x 1 -x 2)(y 1 -y 2)<0 To jest tzw. τA. Istnieje jeszcze τB i τC , które biorą pod uwagę rangi wiązane. 3. Hipotezy (test na istotność wsp. τ Kendalla): H 0: τ=0 H 1: τ≠ 0 56

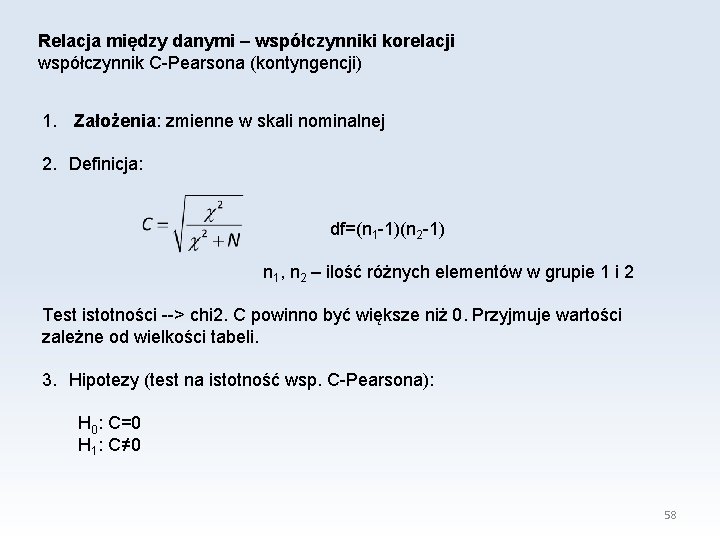

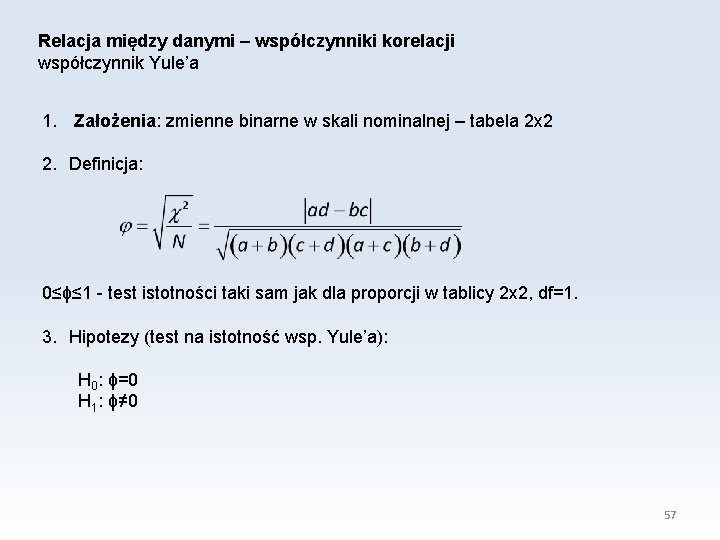

Relacja między danymi – współczynniki korelacji współczynnik Yule’a 1. Założenia: zmienne binarne w skali nominalnej – tabela 2 x 2 2. Definicja: 0≤ϕ≤ 1 - test istotności taki sam jak dla proporcji w tablicy 2 x 2, df=1. 3. Hipotezy (test na istotność wsp. Yule’a): H 0: ϕ=0 H 1: ϕ≠ 0 57

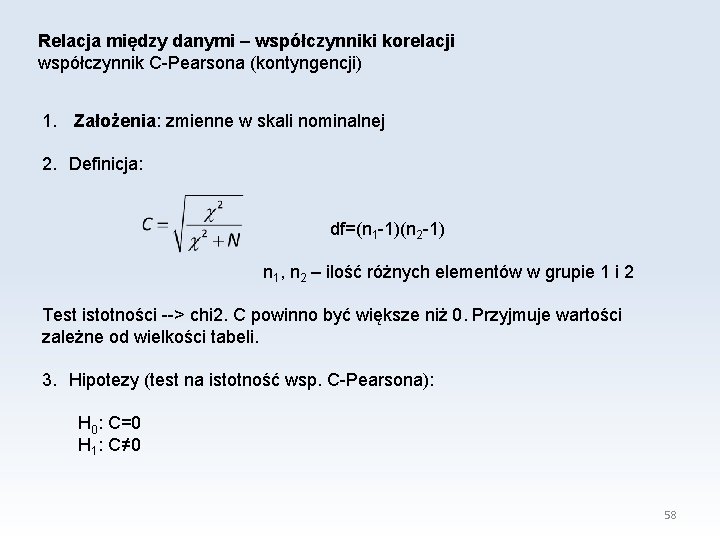

Relacja między danymi – współczynniki korelacji współczynnik C-Pearsona (kontyngencji) 1. Założenia: zmienne w skali nominalnej 2. Definicja: df=(n 1 -1)(n 2 -1) n 1, n 2 – ilość różnych elementów w grupie 1 i 2 Test istotności --> chi 2. C powinno być większe niż 0. Przyjmuje wartości zależne od wielkości tabeli. 3. Hipotezy (test na istotność wsp. C-Pearsona): H 0: C=0 H 1: C≠ 0 58

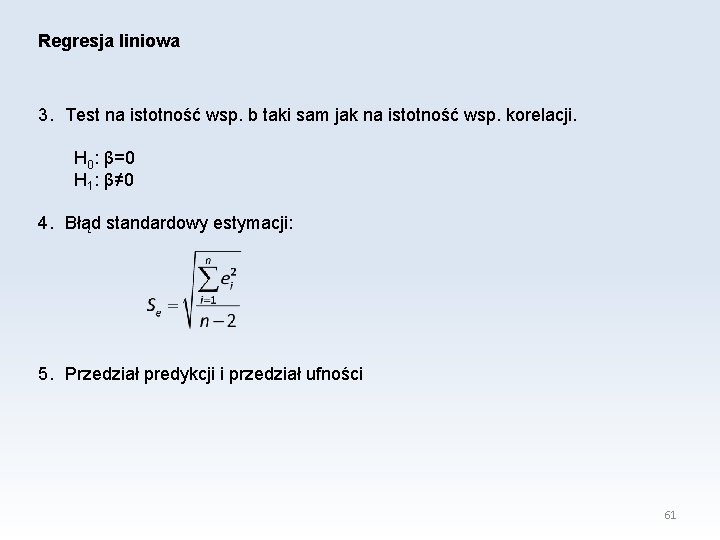

Relacja między danymi – współczynniki korelacji współczynnik V-Cramera 1. Założenia: zmienne w skali nominalnej 2. Definicja: n 1, n 2 – ilość różnych elementów w grupie 1 i 2 0≤V≤ 1 - nie zależy od wielkości tabeli. Test istotności chi 2. 3. Hipotezy (test na istotność wsp. V-Cramera): H 0: V=0 H 1: V≠ 0 59

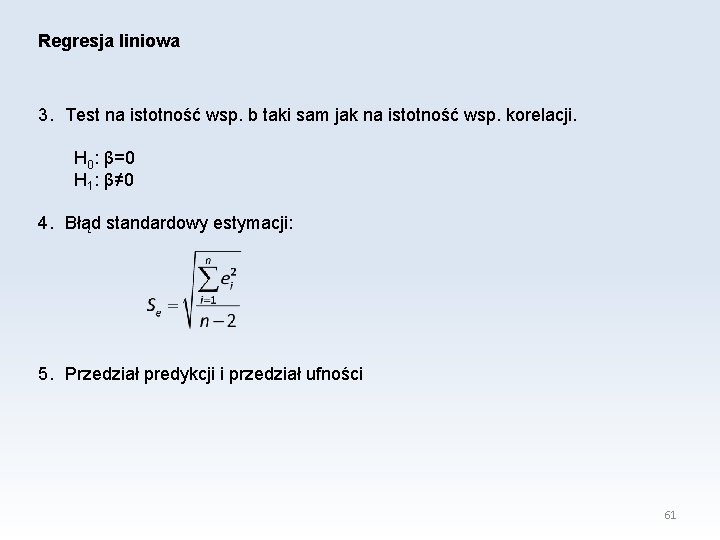

Regresja liniowa 1. Założenia: rozkład normalny obu zmiennych, lub rozkład zmiennej zależnej y dla każdej wartości zmiennej niezależnej x jest normalny i wariancja y jest taka sama dla każdego x, zależność liniowa. 2. Definicja: y=a+bx – regresja y wzg. x odl. |y-yi| jest minimalna x=c+dy – regresja x wzg. y odl. |x-xi| jest minimalna współczynniki liczone są metodą najmniejszych kwadratów (regresja y wzg. x): 60

Regresja liniowa 3. Test na istotność wsp. b taki sam jak na istotność wsp. korelacji. H 0: β=0 H 1: β≠ 0 4. Błąd standardowy estymacji: 5. Przedział predykcji i przedział ufności 61

Polska platforma medyczna

Polska platforma medyczna Elektroniczna aparatura medyczna

Elektroniczna aparatura medyczna Kamera termowizyjna medyczna

Kamera termowizyjna medyczna Ppm.edu.pl

Ppm.edu.pl Skala porządkowa przykłady

Skala porządkowa przykłady Bootstrap statystyka

Bootstrap statystyka W pewnej firmie srednia placa pracownikow produkcyjnych

W pewnej firmie srednia placa pracownikow produkcyjnych Statystyka w biznesie

Statystyka w biznesie Jednostki pola

Jednostki pola Zasoby informacyjne

Zasoby informacyjne Sas statystyka

Sas statystyka Email formal and informal

Email formal and informal Stlcc blackboard banner

Stlcc blackboard banner Nsu edu

Nsu edu Internet id umn

Internet id umn Tcl massage therapy

Tcl massage therapy Edu.sharif.edu

Edu.sharif.edu Piotr kowalski warszawa

Piotr kowalski warszawa Ks piotr wawrzyniak

Ks piotr wawrzyniak Piotr wiench

Piotr wiench Piotr goldstein

Piotr goldstein Piotr obserwuje monetę leżącą na dnie szklanki z wodą

Piotr obserwuje monetę leżącą na dnie szklanki z wodą Piotr madziar

Piotr madziar Piotr orzeł lublin

Piotr orzeł lublin Piotr zimmerman

Piotr zimmerman Piotr gibas

Piotr gibas Piotr turowicz

Piotr turowicz Piotr klecha

Piotr klecha Piotr habela

Piotr habela Piotr grudowski

Piotr grudowski Licytacja w brydżu towarzyskim

Licytacja w brydżu towarzyskim Piotr siedlecki

Piotr siedlecki Team building teoria

Team building teoria Piotr uszok

Piotr uszok Piotr winciunas

Piotr winciunas Płaski dekoracyjny filar przyścienny

Płaski dekoracyjny filar przyścienny Architektura internetu

Architektura internetu Piotr ciżkowicz

Piotr ciżkowicz Piotr bomba

Piotr bomba Piotr faliszewski

Piotr faliszewski Piotr fabian

Piotr fabian Piotr faliszewski

Piotr faliszewski Piotr jachimowicz

Piotr jachimowicz Daniela růžičková

Daniela růžičková Piotr misztal

Piotr misztal Piotr czajkowski najsłynniejsze dzieła

Piotr czajkowski najsłynniejsze dzieła Piotr kaminski foundation

Piotr kaminski foundation Piotr faliszewski

Piotr faliszewski Piotr boguradzki

Piotr boguradzki Piotr fliciński

Piotr fliciński Piotr iľjič čajkovskij

Piotr iľjič čajkovskij Kapral piotr ciach

Kapral piotr ciach Piotr turowicz

Piotr turowicz Chromatic dispersion analyzer

Chromatic dispersion analyzer Piotr sochoń

Piotr sochoń Gift serwis

Gift serwis Piotr indyk

Piotr indyk Piotr smolarkiewicz

Piotr smolarkiewicz Piotr maleszyk

Piotr maleszyk Rzeczkowski

Rzeczkowski Piotr wydrych

Piotr wydrych Piotr gibas

Piotr gibas