Kunstig intelligens IT2702 hst 2003 Forelesning 9 Emner

- Slides: 35

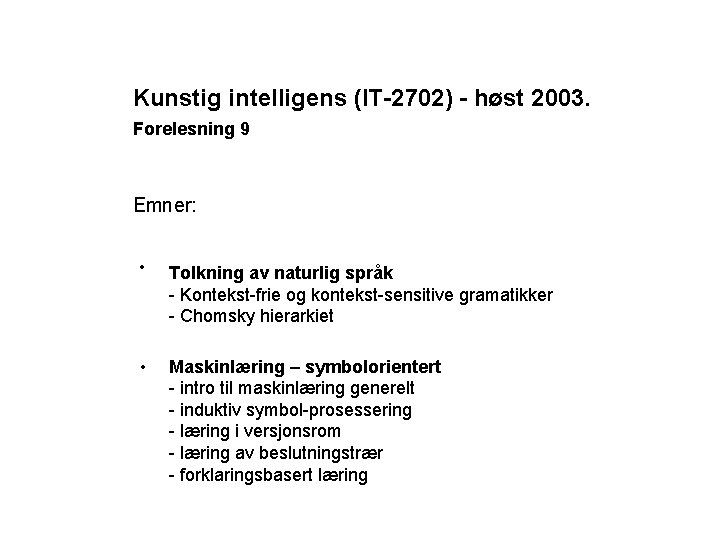

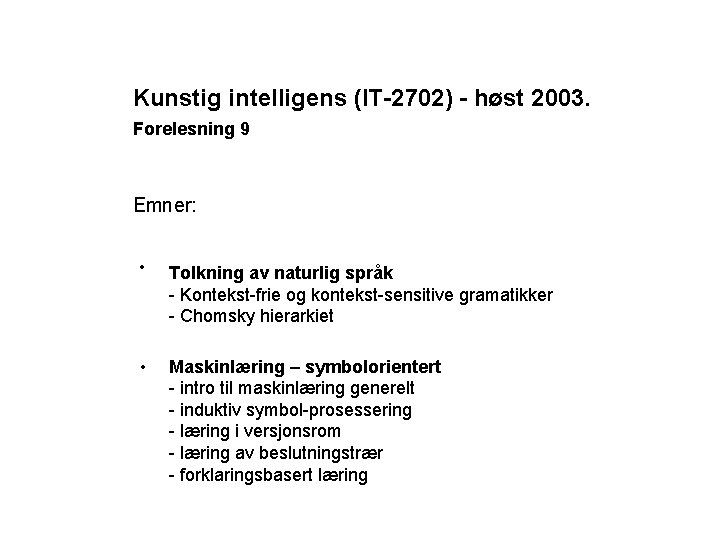

Kunstig intelligens (IT-2702) - høst 2003. Forelesning 9 Emner: • Tolkning av naturlig språk - Kontekst-frie og kontekst-sensitive gramatikker - Chomsky hierarkiet • Maskinlæring – symbolorientert - intro til maskinlæring generelt - induktiv symbol-prosessering - læring i versjonsrom - læring av beslutningstrær - forklaringsbasert læring

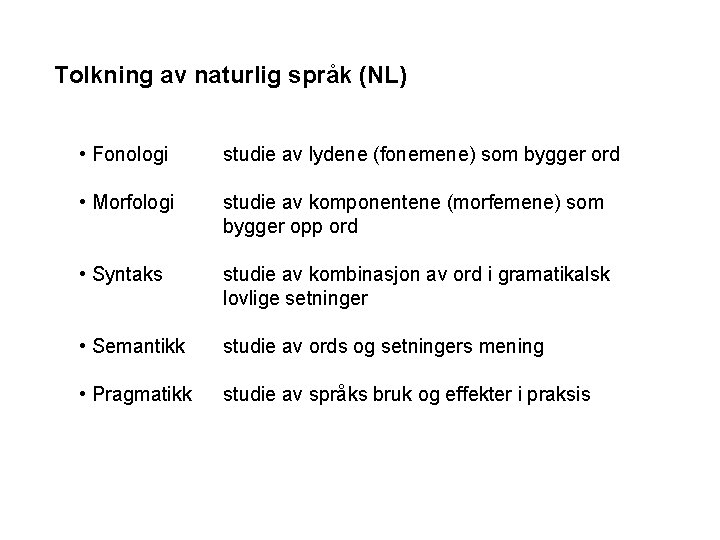

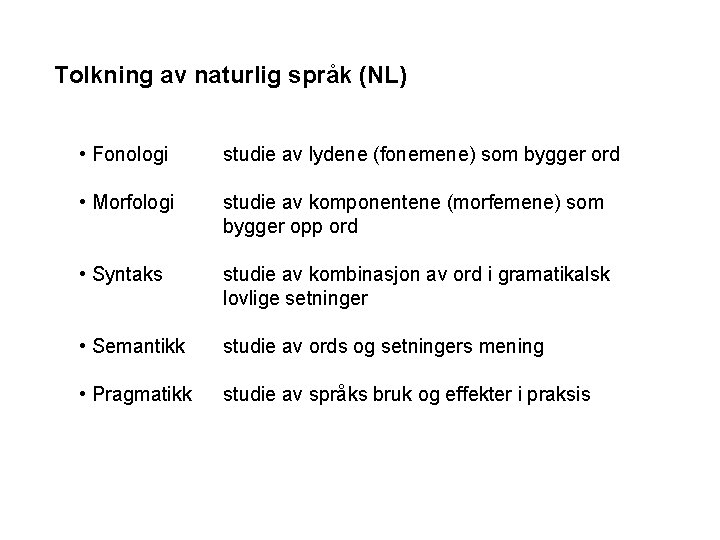

Tolkning av naturlig språk (NL) • Fonologi studie av lydene (fonemene) som bygger ord • Morfologi studie av komponentene (morfemene) som bygger opp ord • Syntaks studie av kombinasjon av ord i gramatikalsk lovlige setninger • Semantikk studie av ords og setningers mening • Pragmatikk studie av språks bruk og effekter i praksis

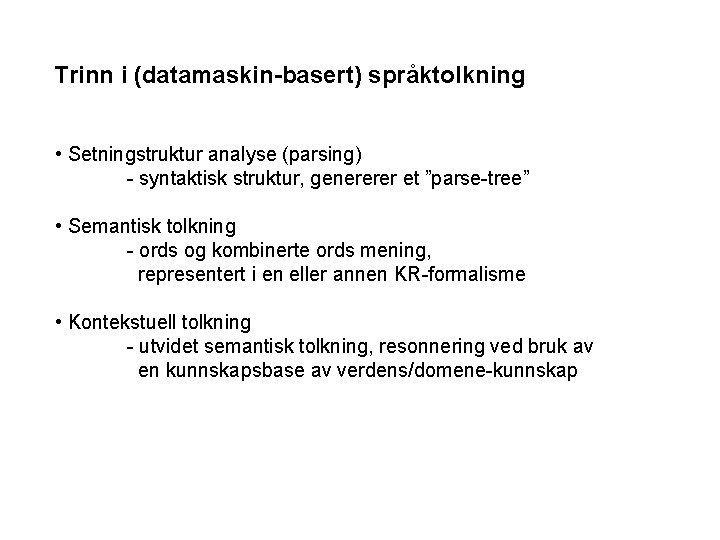

Trinn i (datamaskin-basert) språktolkning • Setningstruktur analyse (parsing) - syntaktisk struktur, genererer et ”parse-tree” • Semantisk tolkning - ords og kombinerte ords mening, representert i en eller annen KR-formalisme • Kontekstuell tolkning - utvidet semantisk tolkning, resonnering ved bruk av en kunnskapsbase av verdens/domene-kunnskap

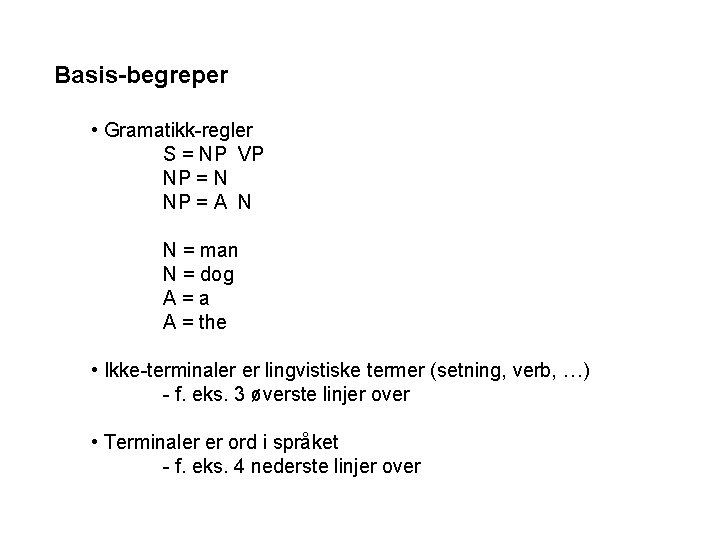

Basis-begreper • Gramatikk-regler S = NP VP NP = N NP = A N N = man N = dog A=a A = the • Ikke-terminaler er lingvistiske termer (setning, verb, …) - f. eks. 3 øverste linjer over • Terminaler er ord i språket - f. eks. 4 nederste linjer over

Parsing i transisjons-nett (Transition Networks) • Gramatikk representeres som et sett av sammenkoblede tilstandsmaskiner • Noder er tilstander, lenker er overganger (transisjoner) mellom tilstander • Hvert nett (hver tilstandsmaskin) representerer en ikke-terminal • Å tolke en setning eller del av en setning svarer til å erstatte en ikke-terminal med høyre-siden av den tilhørende gramatikkregel (høyre-siden er mer spesifikk en venstre-siden)

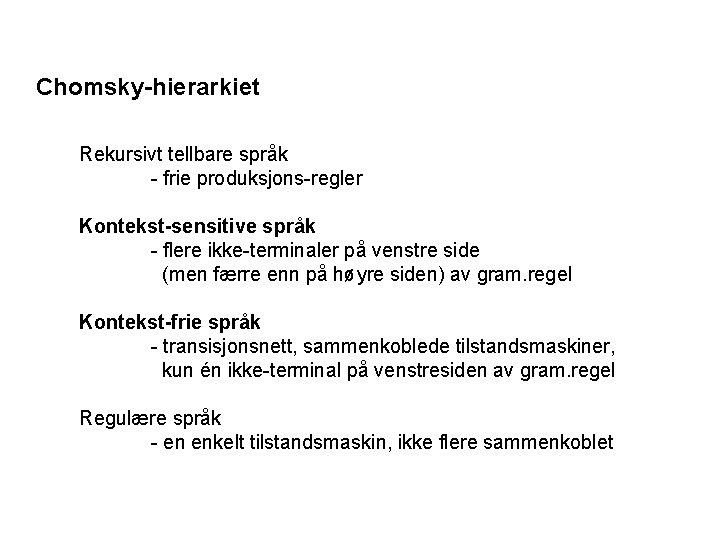

Chomsky-hierarkiet Rekursivt tellbare språk - frie produksjons-regler Kontekst-sensitive språk - flere ikke-terminaler på venstre side (men færre enn på høyre siden) av gram. regel Kontekst-frie språk - transisjonsnett, sammenkoblede tilstandsmaskiner, kun én ikke-terminal på venstresiden av gram. regel Regulære språk - en enkelt tilstandsmaskin, ikke flere sammenkoblet

Kontekst-sensitive språk • Ønskelig, men komplekse parsere • ”Augmented Transitions Networks” (ATNs) gir kontekstsensitive egenskaper ved en utvidelse av kontekst-frie gramatikk-regler • Kombinerer syntaktisk og semantisk parsing • Tillater ”procedural attachments” på lenkene i trans. nettet • Prosedyrene kan utføre tester, tilordne verdier, konstruere deler av parse-tre, etc.

Hva er læring? • Any process by which a system improves performance (H. Simon) • Making useful changes in our minds (M. Minsky) • The organisation of experience (M. Scott) • Constructing or modifying representations of what is being experienced (R. Michalski)

Hva er maskinlæring? Metoder og teknikker som gjør datasystemer i stand til selv å oppdatere sin kunnskap og problemløsnings-evne

Hvorfor maskinlæring? • Modellere menneskers læring • Studere læring og intelligens som fenomen • Automatisere utvikling av kunnskapsbaserte systemer • det siste er mest vektlagt i dette kurset

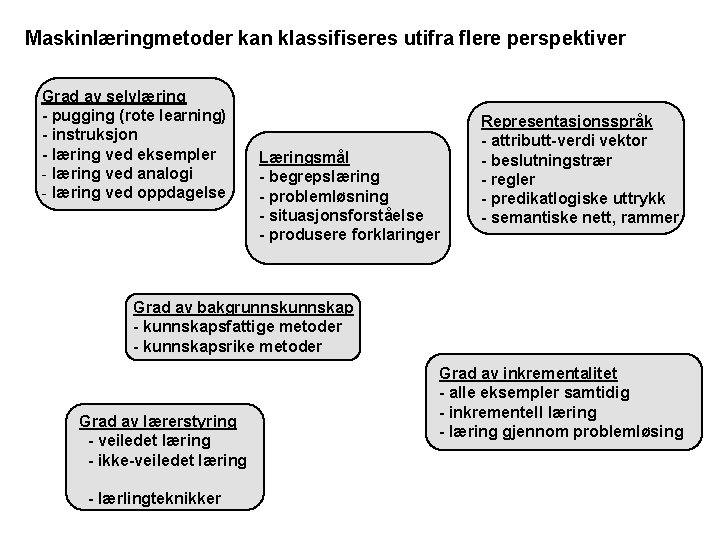

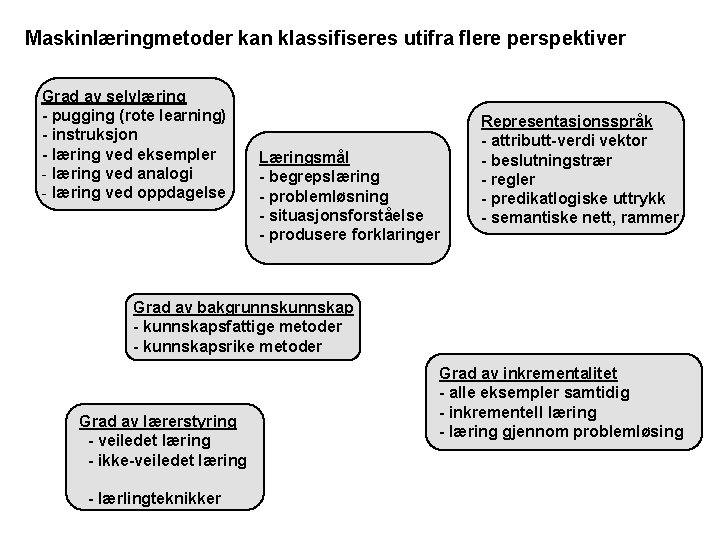

Maskinlæringmetoder kan klassifiseres utifra flere perspektiver Grad av selvlæring - pugging (rote learning) - instruksjon - læring ved eksempler - læring ved analogi - læring ved oppdagelse Læringsmål - begrepslæring - problemløsning - situasjonsforståelse - produsere forklaringer Representasjonsspråk - attributt-verdi vektor - beslutningstrær - regler - predikatlogiske uttrykk - semantiske nett, rammer Grad av bakgrunnskap - kunnskapsfattige metoder - kunnskapsrike metoder Grad av lærerstyring - veiledet læring - ikke-veiledet læring - lærlingteknikker Grad av inkrementalitet - alle eksempler samtidig - inkrementell læring - læring gjennom problemløsing

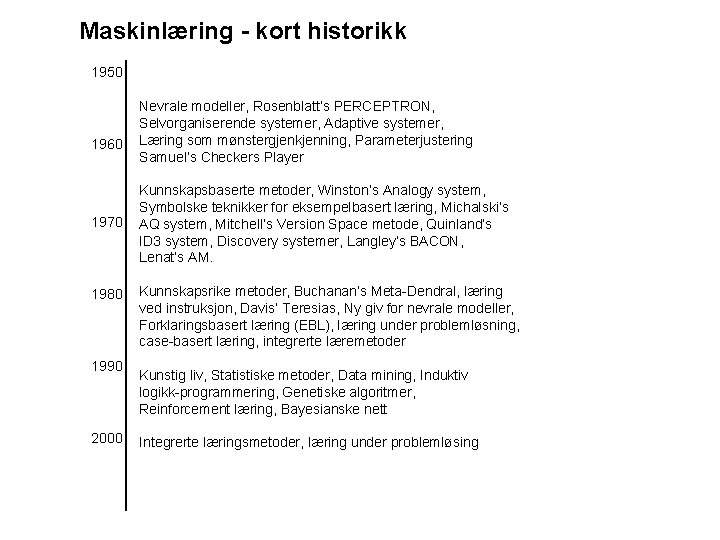

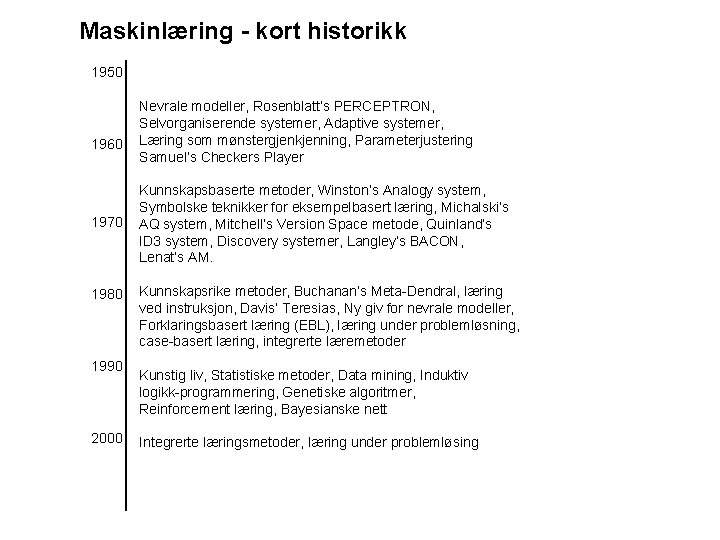

Maskinlæring - kort historikk 1950 1960 1970 1980 1990 2000 Nevrale modeller, Rosenblatt’s PERCEPTRON, Selvorganiserende systemer, Adaptive systemer, Læring som mønstergjenkjenning, Parameterjustering Samuel’s Checkers Player Kunnskapsbaserte metoder, Winston’s Analogy system, Symbolske teknikker for eksempelbasert læring, Michalski’s AQ system, Mitchell’s Version Space metode, Quinland’s ID 3 system, Discovery systemer, Langley’s BACON, Lenat’s AM. Kunnskapsrike metoder, Buchanan’s Meta-Dendral, læring ved instruksjon, Davis’ Teresias, Ny giv for nevrale modeller, Forklaringsbasert læring (EBL), læring under problemløsning, case-basert læring, integrerte læremetoder Kunstig liv, Statistiske metoder, Data mining, Induktiv logikk-programmering, Genetiske algoritmer, Reinforcement læring, Bayesianske nett Integrerte læringsmetoder, læring under problemløsing

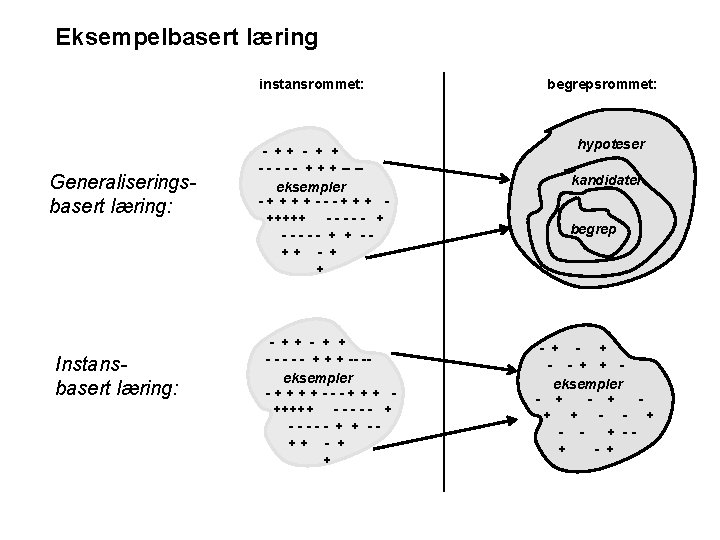

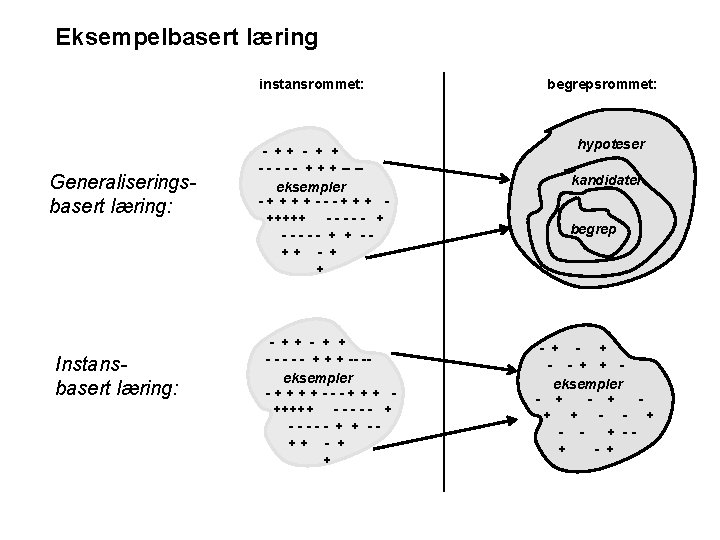

Eksempelbasert læring instansrommet: Generaliseringsbasert læring: Instansbasert læring: - ++ - + + - - - - - + + + -- -eksempler -++++---+++ +++++ - - - - - + ----- + + -++ - + + begrepsrommet: hypoteser kandidater begrep - + - - + + eksempler - + + + - - + -+ - +

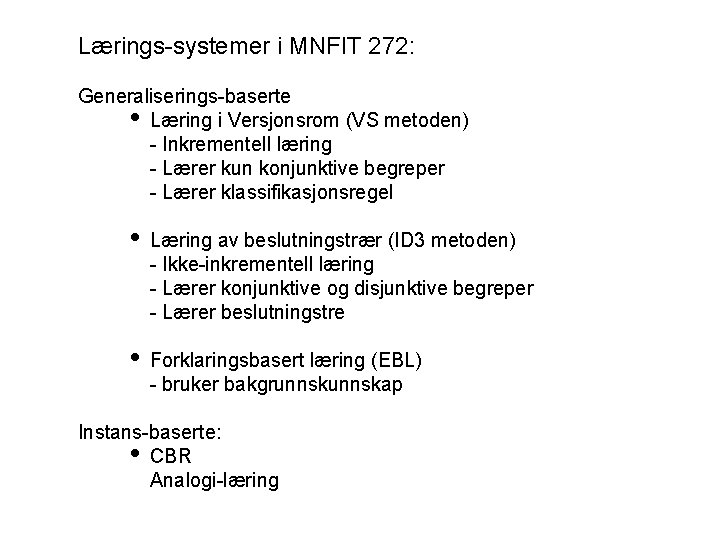

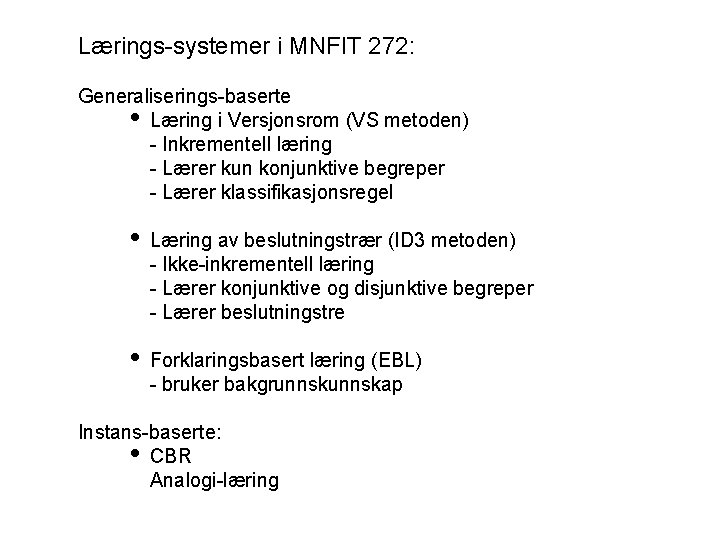

Lærings-systemer i MNFIT 272: Generaliserings-baserte Læring i Versjonsrom (VS metoden) - Inkrementell læring - Lærer kun konjunktive begreper - Lærer klassifikasjonsregel Læring av beslutningstrær (ID 3 metoden) - Ikke-inkrementell læring - Lærer konjunktive og disjunktive begreper - Lærer beslutningstre Forklaringsbasert læring (EBL) - bruker bakgrunnskap Instans-baserte: CBR Analogi-læring

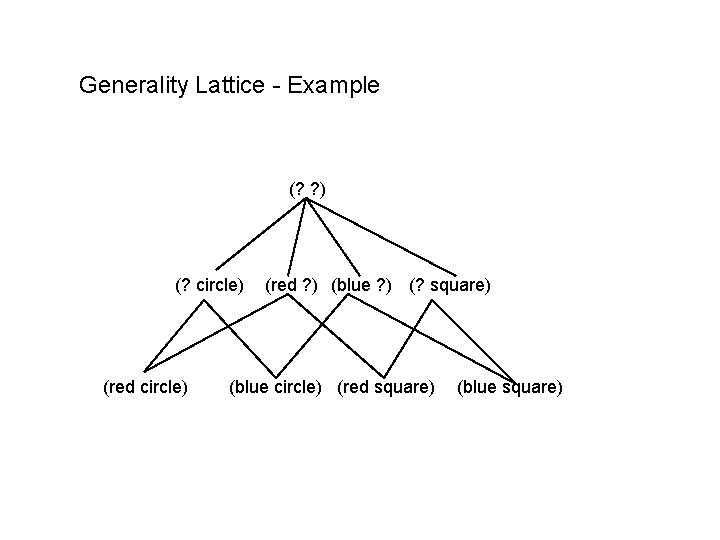

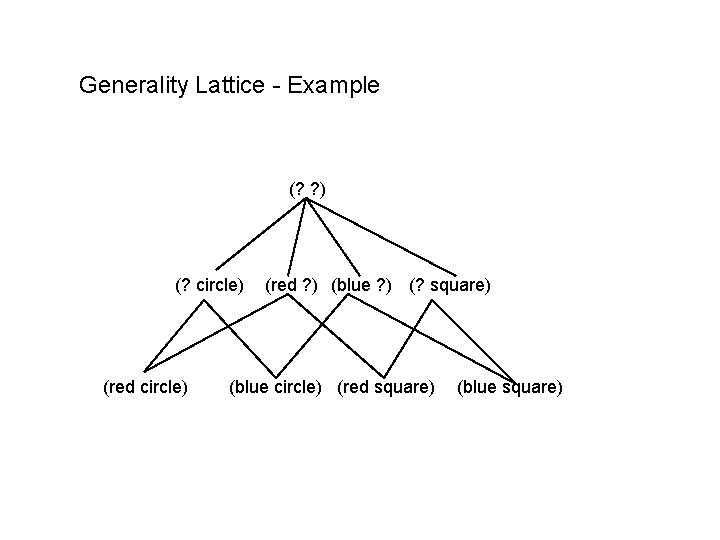

Generality Lattice - Example (? ? ) (? circle) (red ? ) (blue ? ) (? square) (blue circle) (red square) (blue square)

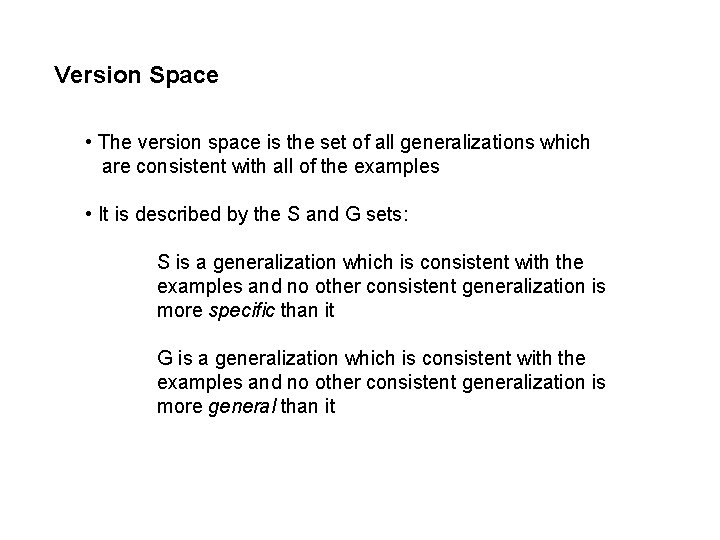

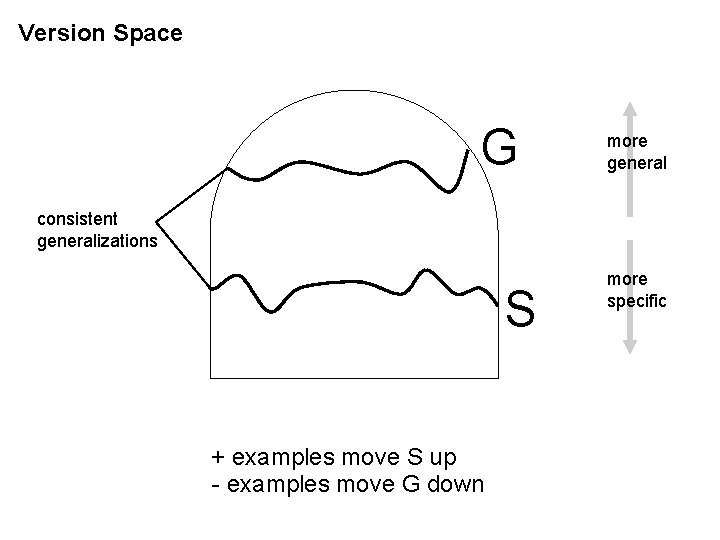

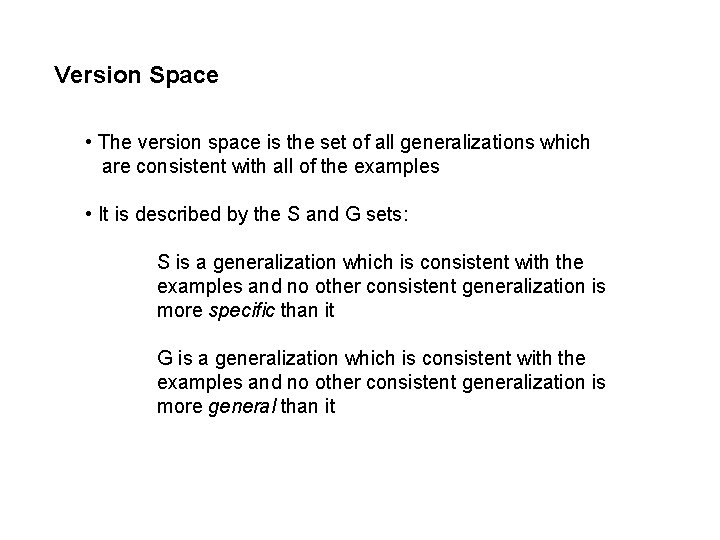

Version Space • The version space is the set of all generalizations which are consistent with all of the examples • It is described by the S and G sets: S is a generalization which is consistent with the examples and no other consistent generalization is more specific than it G is a generalization which is consistent with the examples and no other consistent generalization is more general than it

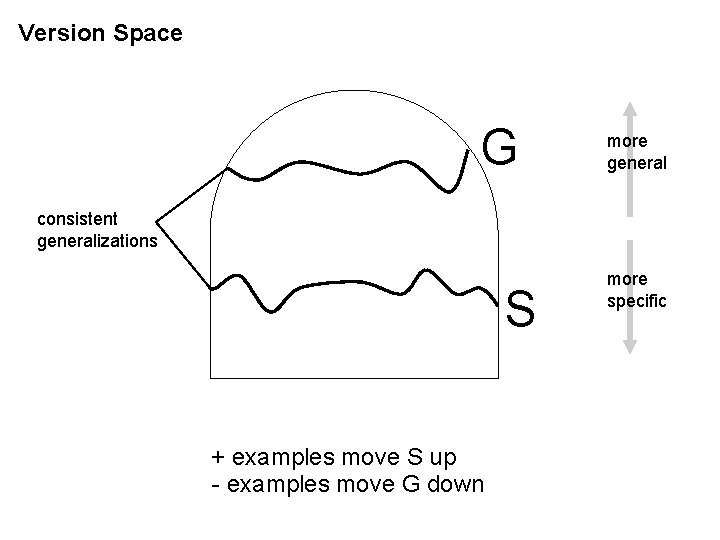

Version Space G more general consistent generalizations S + examples move S up - examples move G down more specific

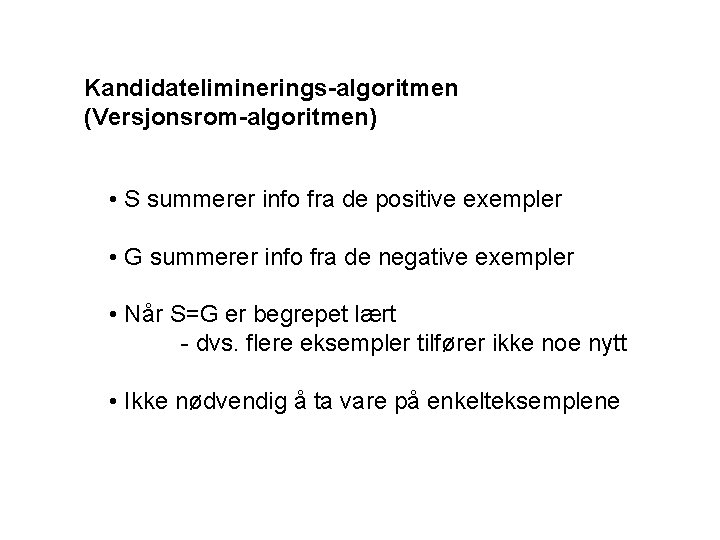

Kandidateliminerings-algoritmen (Versjonsrom-algoritmen) • S summerer info fra de positive exempler • G summerer info fra de negative exempler • Når S=G er begrepet lært - dvs. flere eksempler tilfører ikke noe nytt • Ikke nødvendig å ta vare på enkelteksemplene

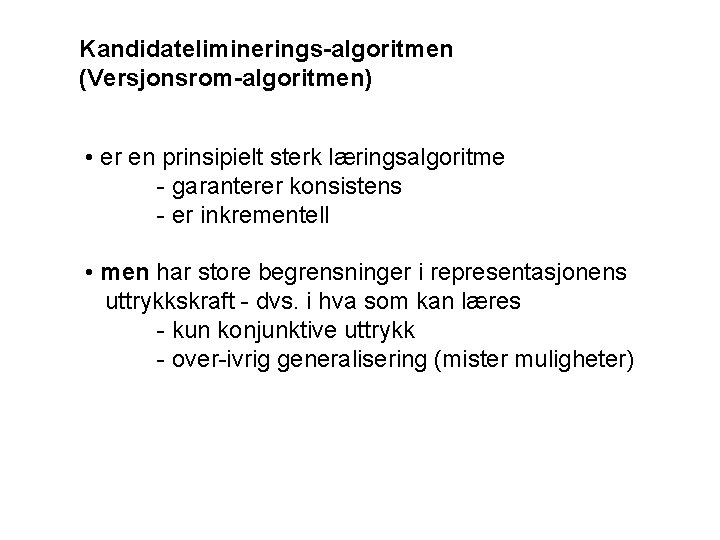

Kandidateliminerings-algoritmen (Versjonsrom-algoritmen) • er en prinsipielt sterk læringsalgoritme - garanterer konsistens - er inkrementell • men har store begrensninger i representasjonens uttrykkskraft - dvs. i hva som kan læres - kun konjunktive uttrykk - over-ivrig generalisering (mister muligheter)

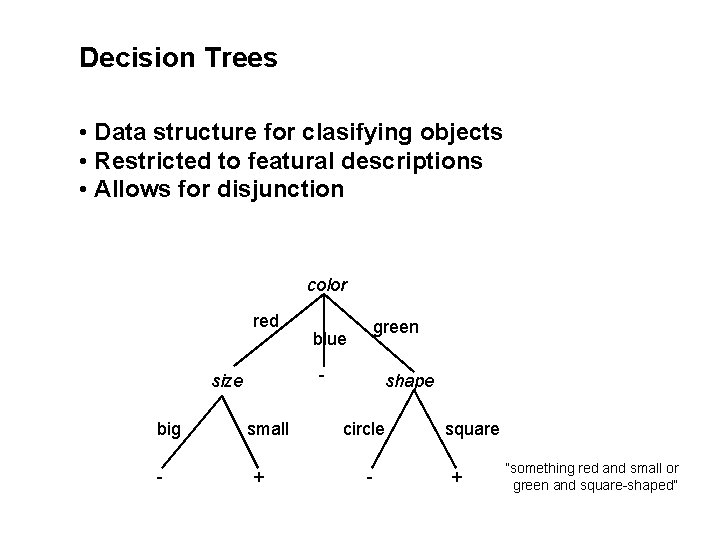

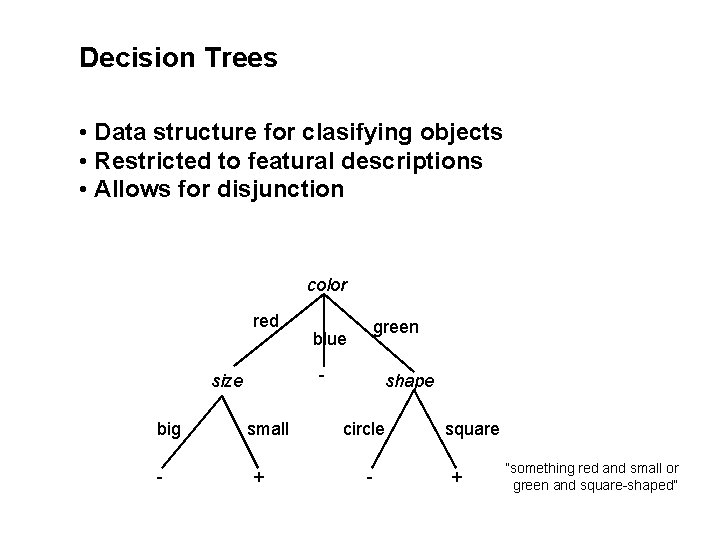

Decision Trees • Data structure for clasifying objects • Restricted to featural descriptions • Allows for disjunction color red - size big - green blue small + shape circle - square + ”something red and small or green and square-shaped”

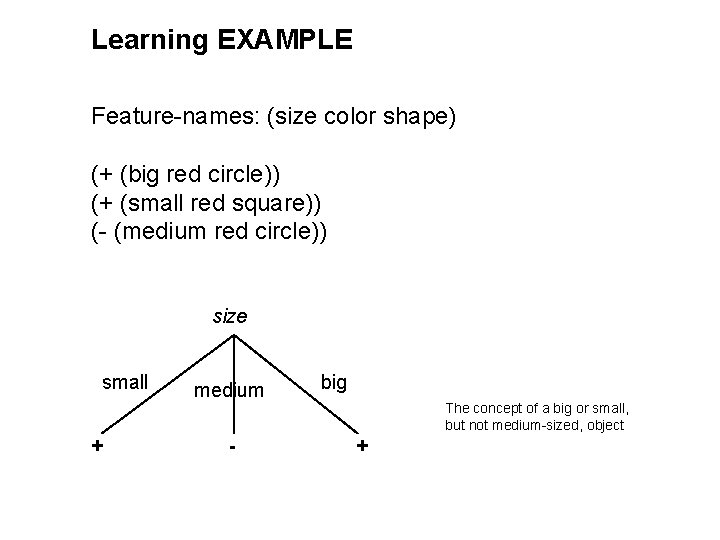

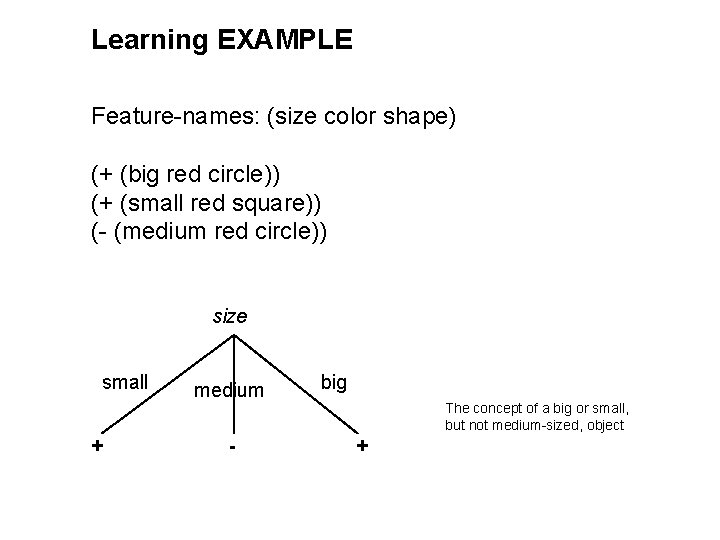

Learning EXAMPLE Feature-names: (size color shape) (+ (big red circle)) (+ (small red square)) (- (medium red circle)) size small + medium - big The concept of a big or small, but not medium-sized, object +

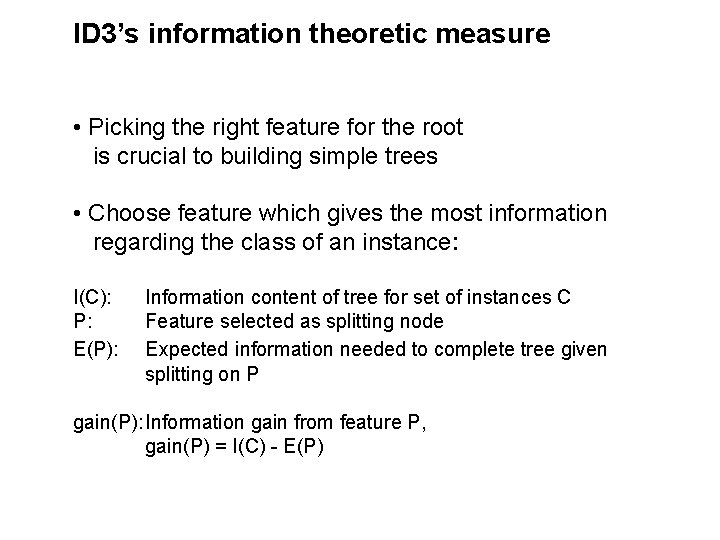

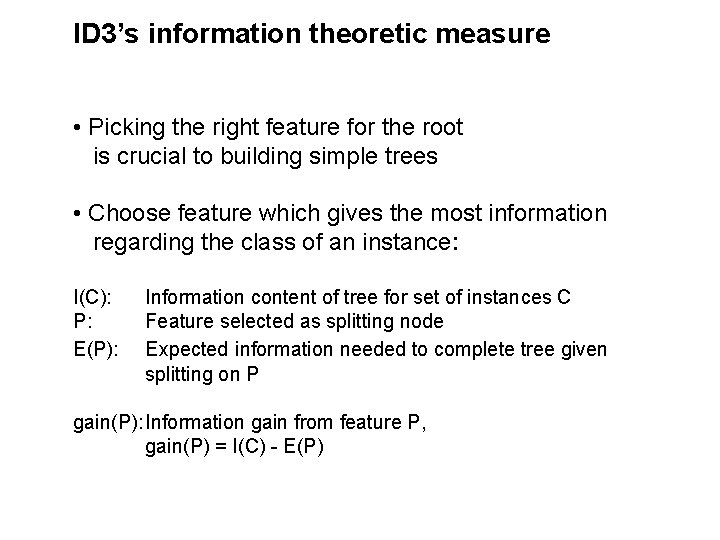

ID 3’s information theoretic measure • Picking the right feature for the root is crucial to building simple trees • Choose feature which gives the most information regarding the class of an instance: I(C): P: E(P): Information content of tree for set of instances C Feature selected as splitting node Expected information needed to complete tree given splitting on P gain(P): Information gain from feature P, gain(P) = I(C) - E(P)

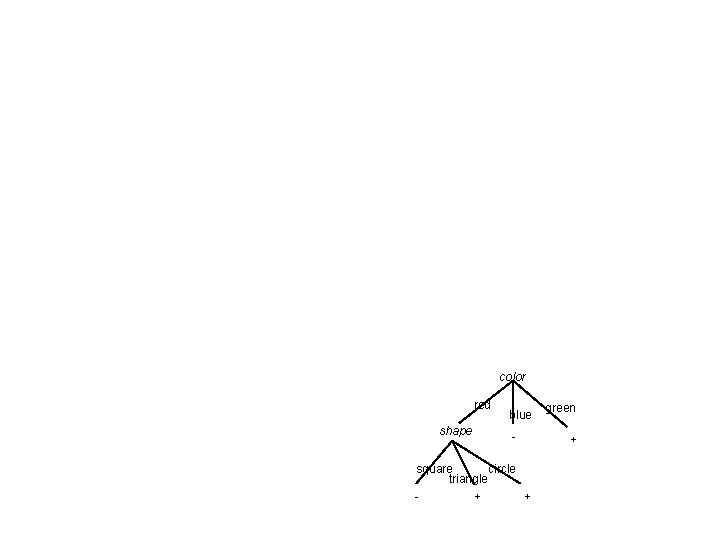

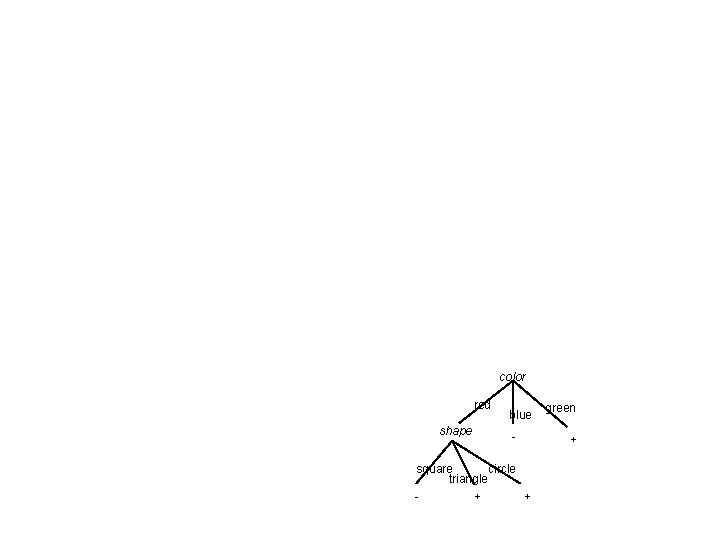

color red shape blue - square circle triangle + + green +

One way to treat missing data

Summary: Similarity-based Learning • Empirical, data-intensive • Requires many examples and counter-examples • Knowledge poor • Generates unjustified concept definitions

Alternative paradigm: - Explanation-based Learning • Analytical • Learns from 1 example • Knowledge rich • Generates justified concept definitions

Explanation-based Learning: • Use exisiting domain knowledge to explain why an example is a member of a concept or why a plan works. • Explanations determines relevant features • Generalise the explanation made, to obtain a justified (explained) operational definition of the concept

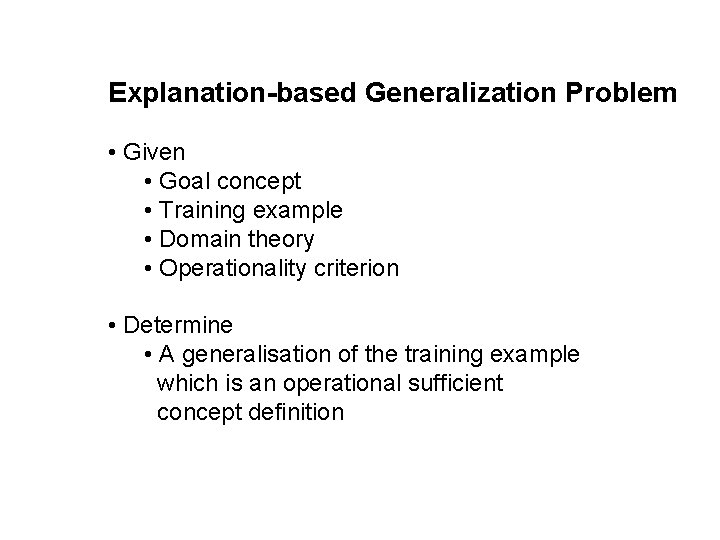

Explanation-based Generalization Problem • Given • Goal concept • Training example • Domain theory • Operationality criterion • Determine • A generalisation of the training example which is an operational sufficient concept definition

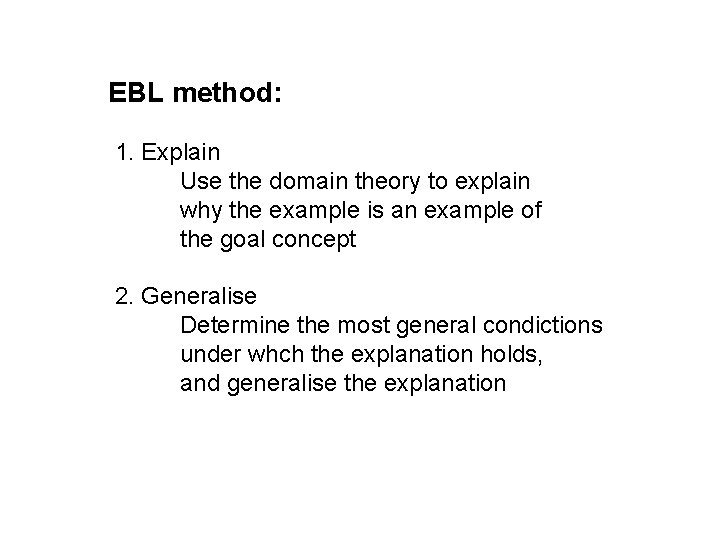

EBL method: 1. Explain Use the domain theory to explain why the example is an example of the goal concept 2. Generalise Determine the most general condictions under whch the explanation holds, and generalise the explanation