Apprentissage de reprsentation et autoorganisation modulaire pour un

- Slides: 55

Apprentissage de représentation et auto-organisation modulaire pour un agent autonome Bruno Scherrer 6 janvier 2003 Directeurs : F. Alexandre, F. Charpillet

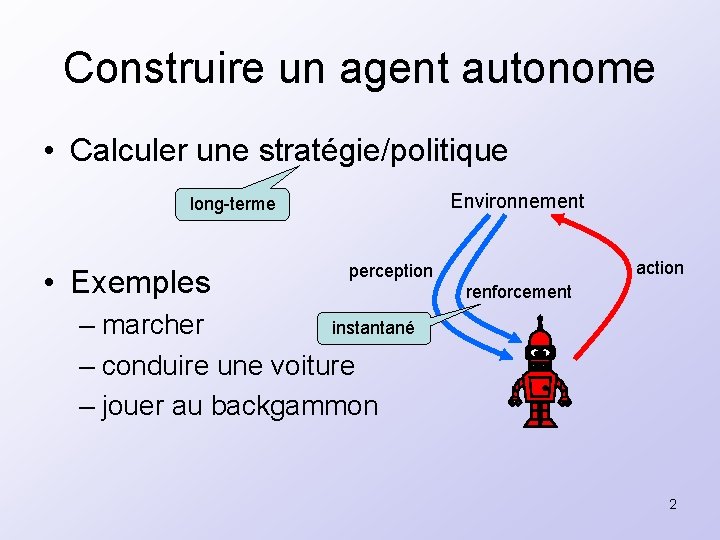

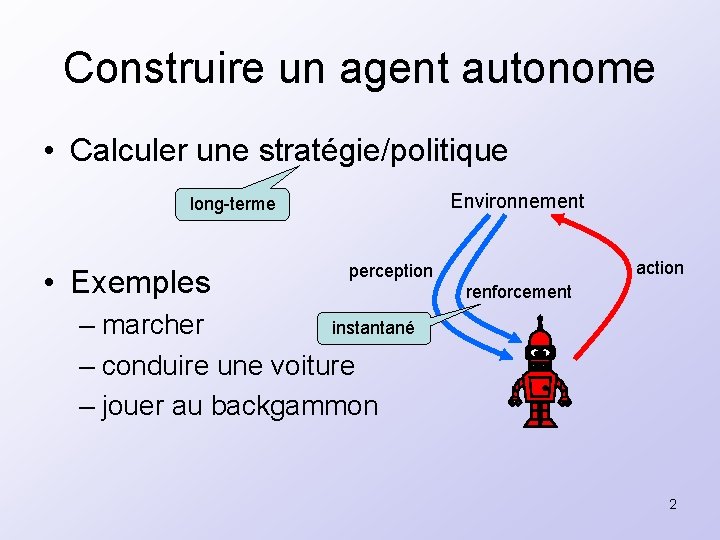

Construire un agent autonome • Calculer une stratégie/politique Environnement long-terme • Exemples action perception renforcement instantané – marcher – conduire une voiture – jouer au backgammon 2

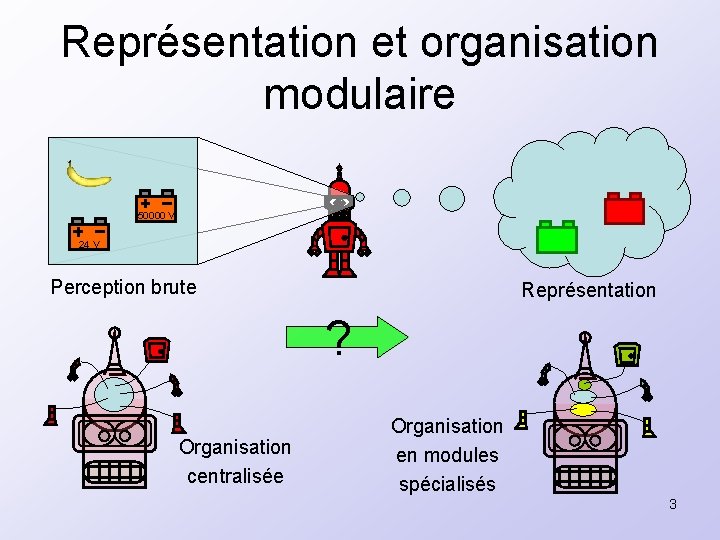

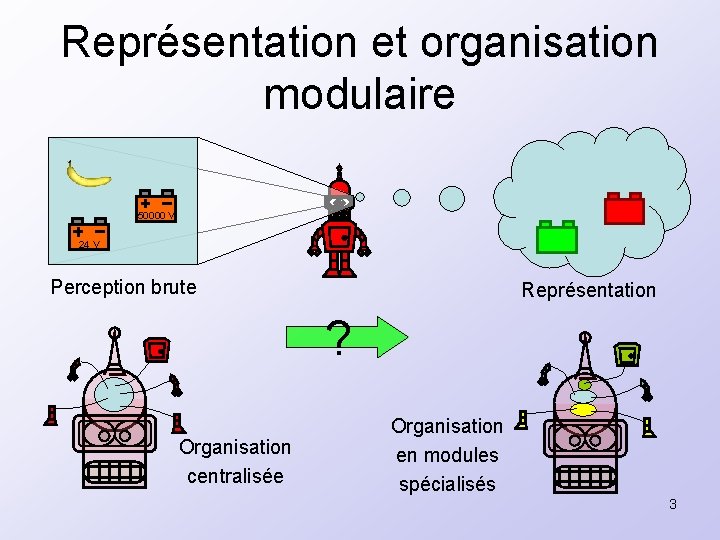

Représentation et organisation modulaire 50000 V 24 V Perception brute Représentation ? Organisation centralisée Organisation en modules spécialisés 3

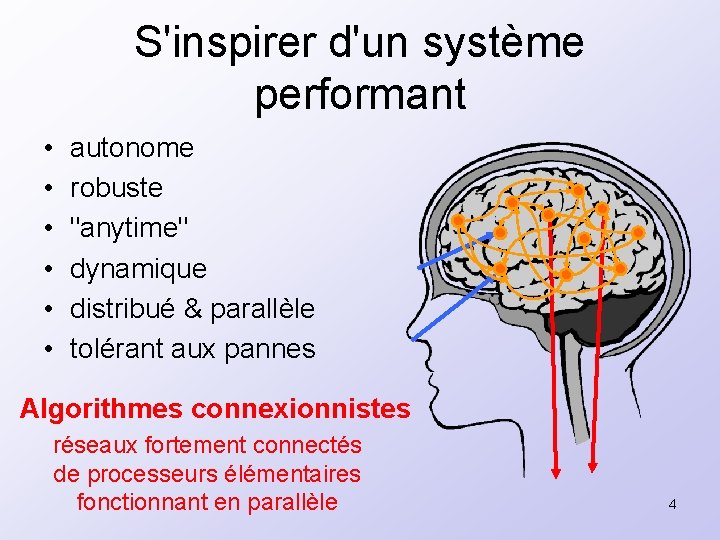

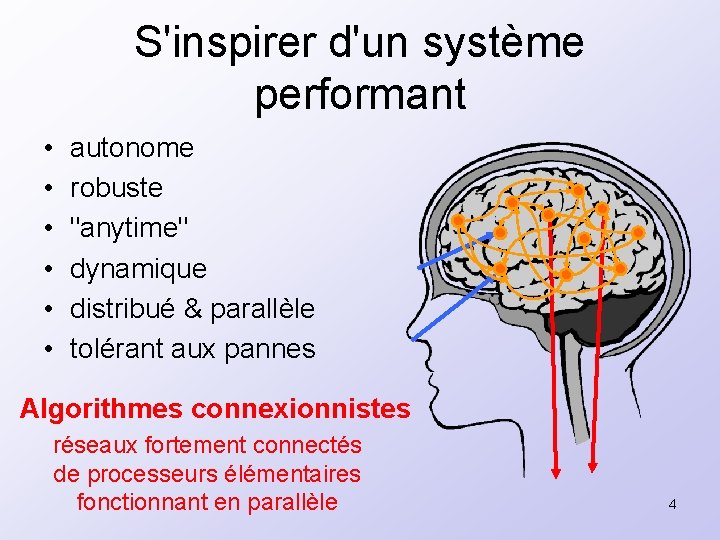

S'inspirer d'un système performant • • • autonome robuste "anytime" dynamique distribué & parallèle tolérant aux pannes Algorithmes connexionnistes réseaux fortement connectés de processeurs élémentaires fonctionnant en parallèle 4

Objectifs • Montrer que les problèmes consistant à – calculer une stratégie/politique – apprendre une représentation – organiser un système en modules admettent des solutions connexionnistes Comprendre les enjeux computationnels d'une telle approche 5

Plan • Introduction • Un calcul connexionniste • Contrôle optimal et apprentissage par renforcement • Apprentissage de représentation • Auto-organisation modulaire • Conclusions et perspectives 6

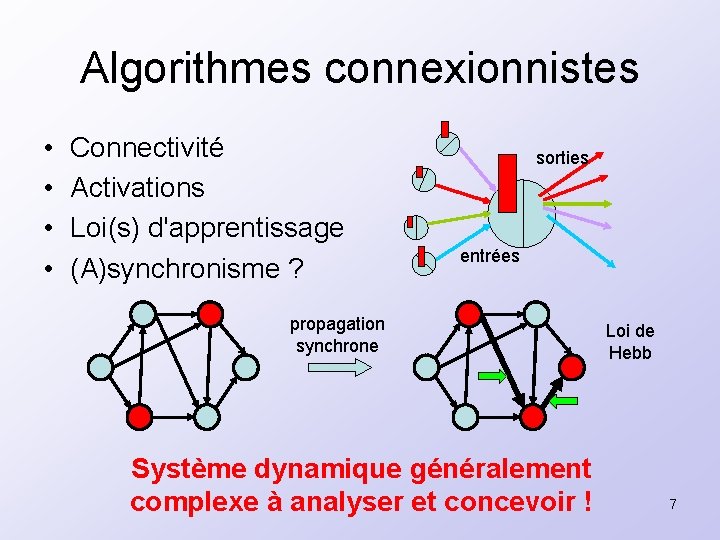

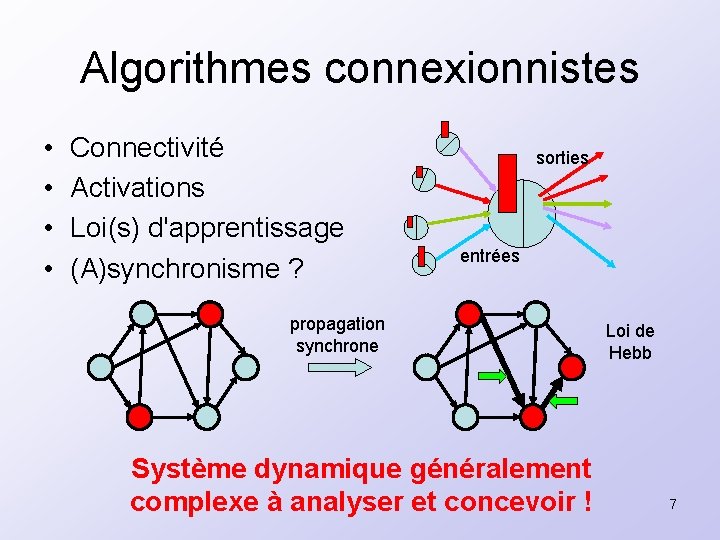

Algorithmes connexionnistes • • Connectivité Activations Loi(s) d'apprentissage (A)synchronisme ? sorties entrées propagation synchrone Système dynamique généralement complexe à analyser et concevoir ! Loi de Hebb 7

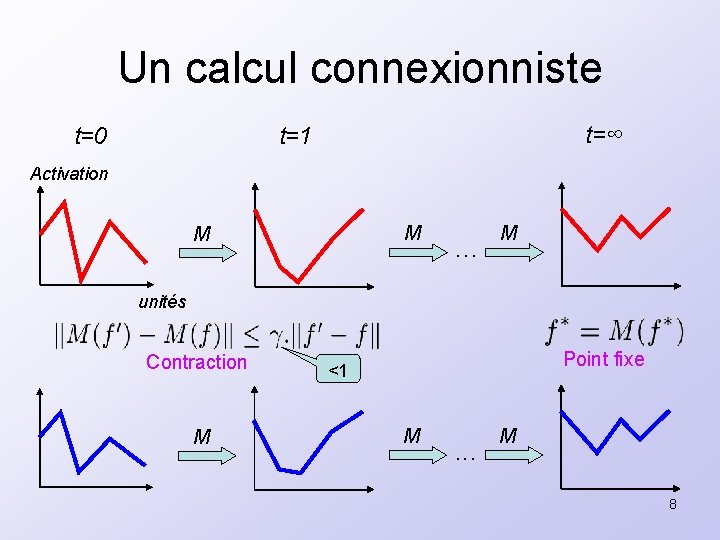

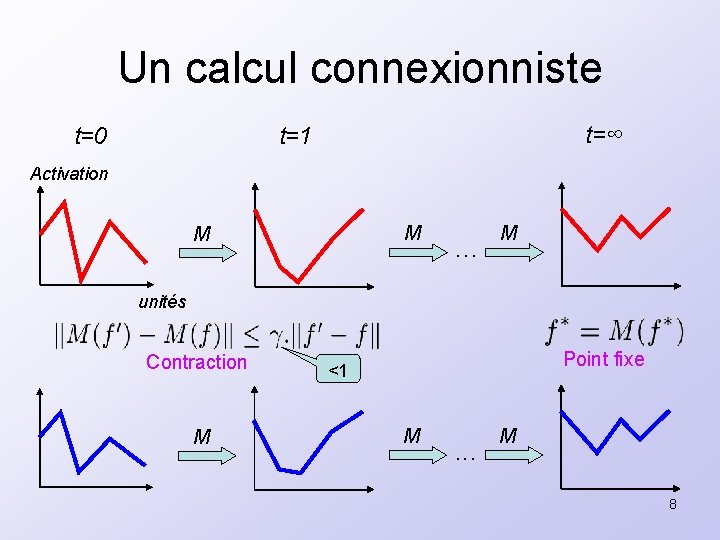

Un calcul connexionniste t=0 t=∞ t=1 Activation M M . . . M unités Contraction M Point fixe <1 M . . . M 8

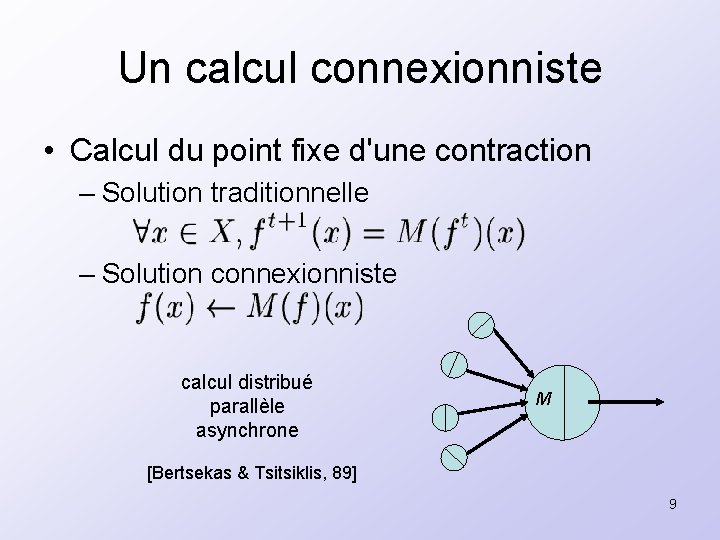

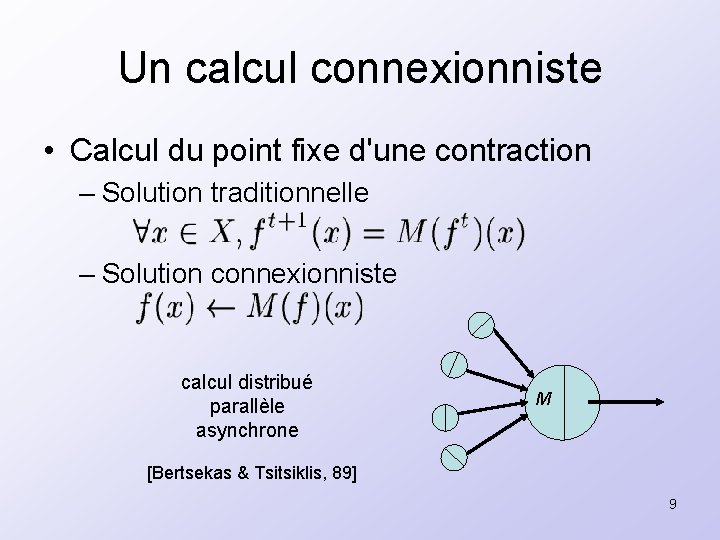

Un calcul connexionniste • Calcul du point fixe d'une contraction – Solution traditionnelle – Solution connexionniste calcul distribué parallèle asynchrone M [Bertsekas & Tsitsiklis, 89] 9

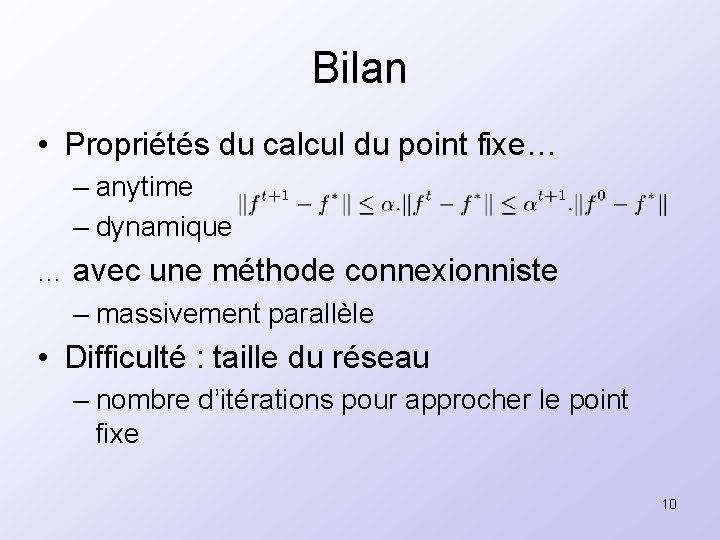

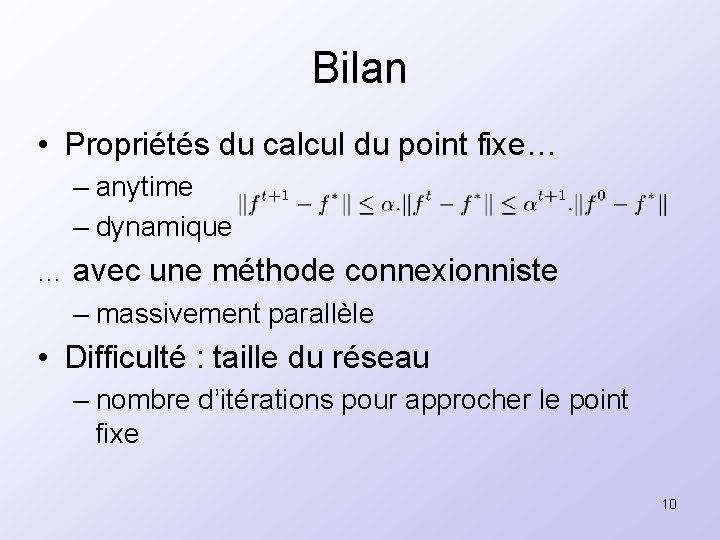

Bilan • Propriétés du calcul du point fixe… – anytime – dynamique … avec une méthode connexionniste – massivement parallèle • Difficulté : taille du réseau – nombre d’itérations pour approcher le point fixe 10

Plan • Introduction • Un calcul connexionniste • Contrôle optimal et apprentissage par renforcement • Apprentissage de représentation • Auto-organisation modulaire • Conclusions et perspectives 11

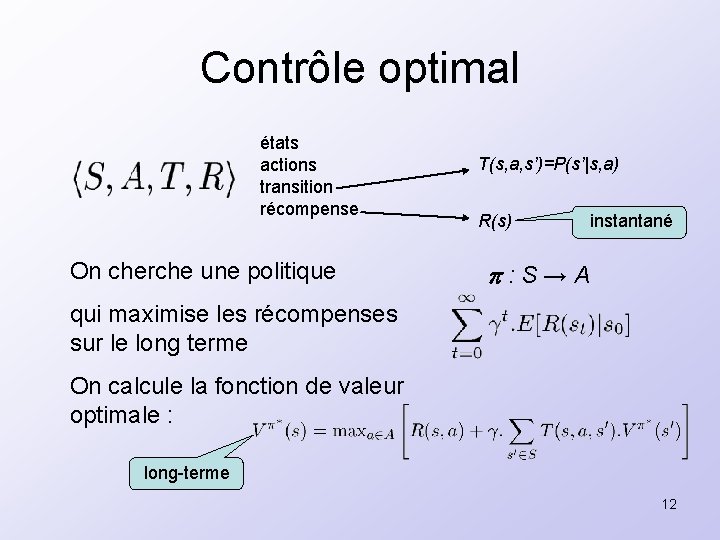

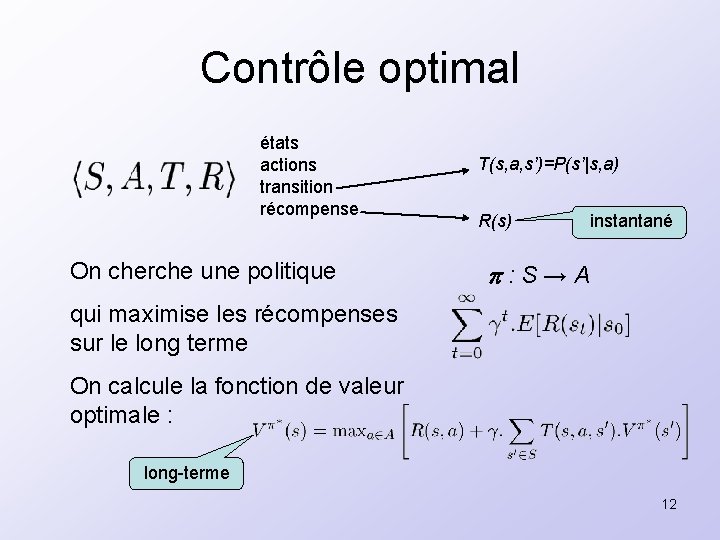

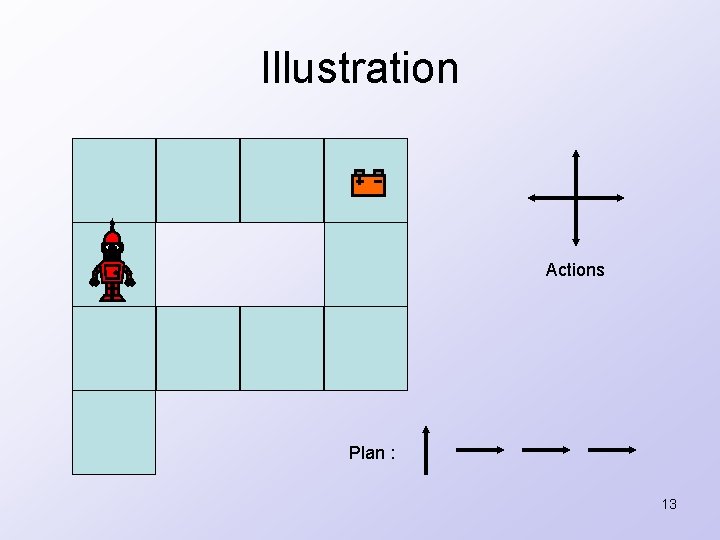

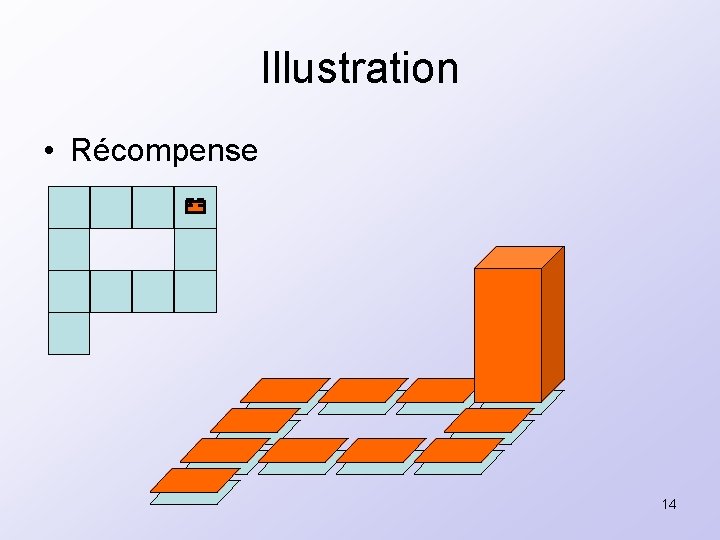

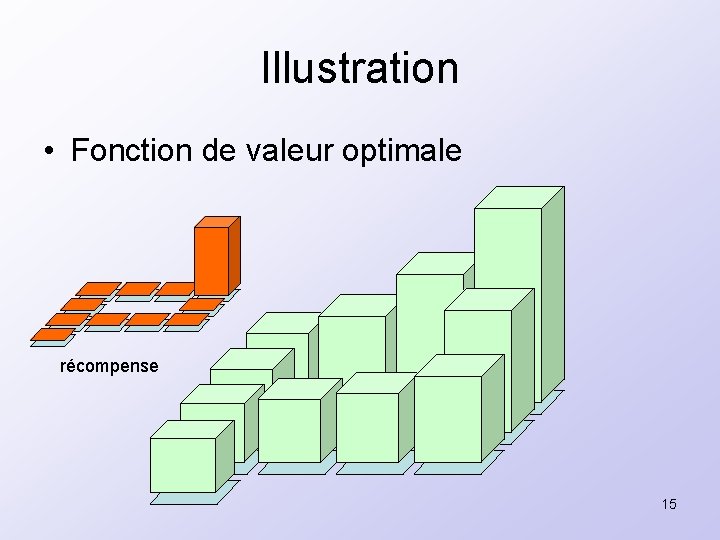

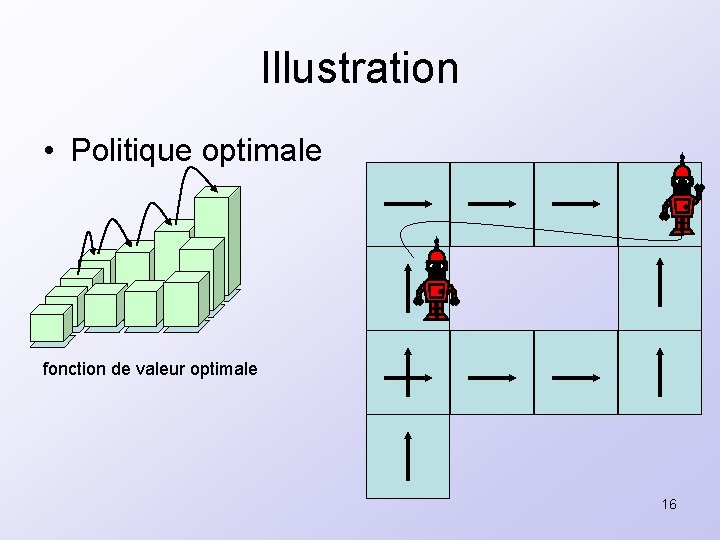

Contrôle optimal états actions transition récompense On cherche une politique T(s, a, s’)=P(s’|s, a) R(s) instantané : S→A qui maximise les récompenses sur le long terme On calcule la fonction de valeur optimale : long-terme 12

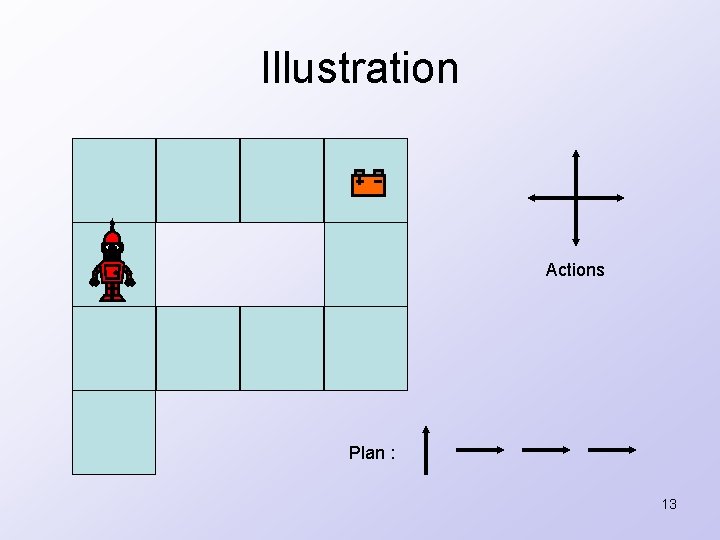

Illustration Actions Plan : 13

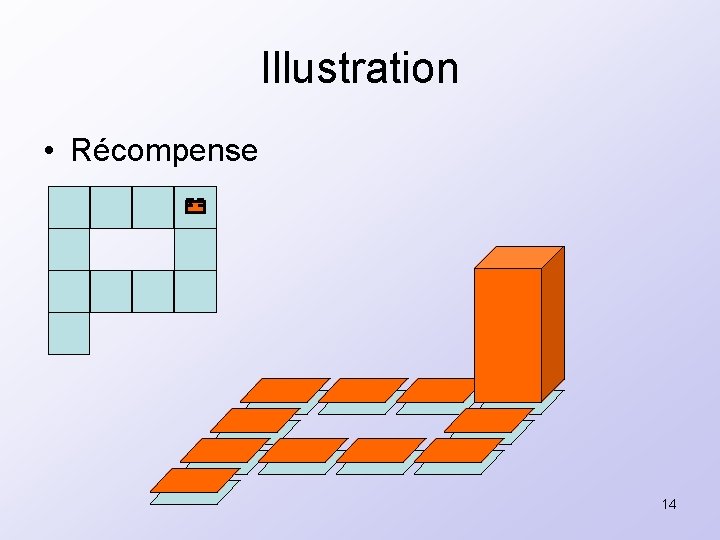

Illustration • Récompense 14

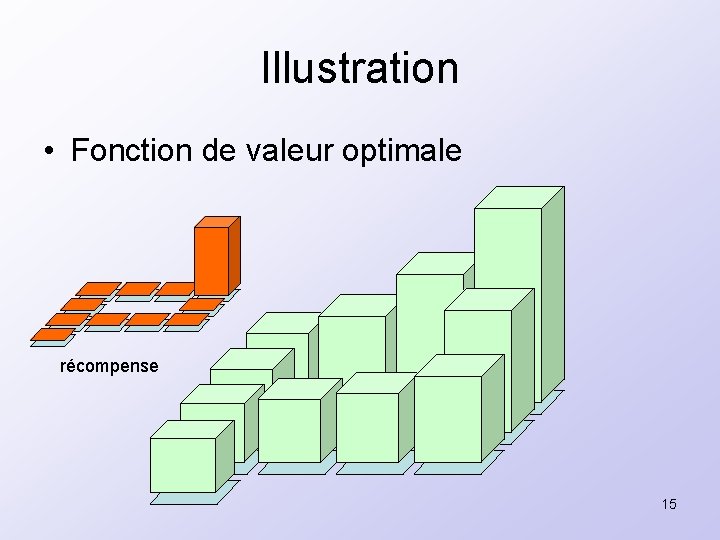

Illustration • Fonction de valeur optimale récompense 15

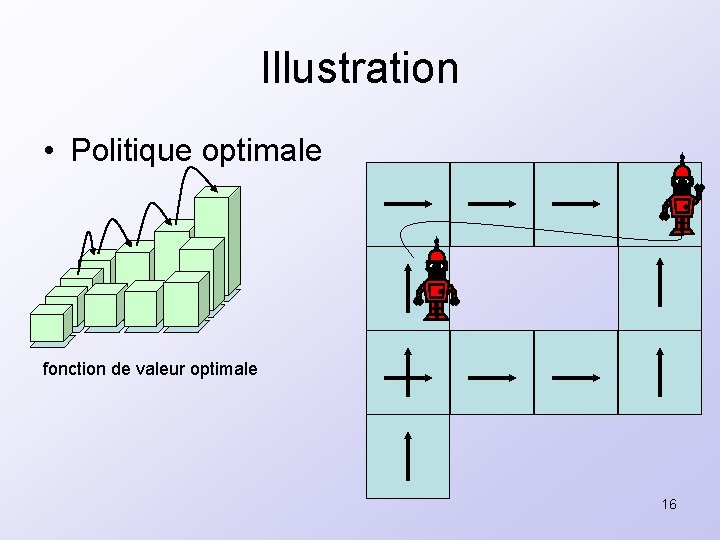

Illustration • Politique optimale fonction de valeur optimale 16

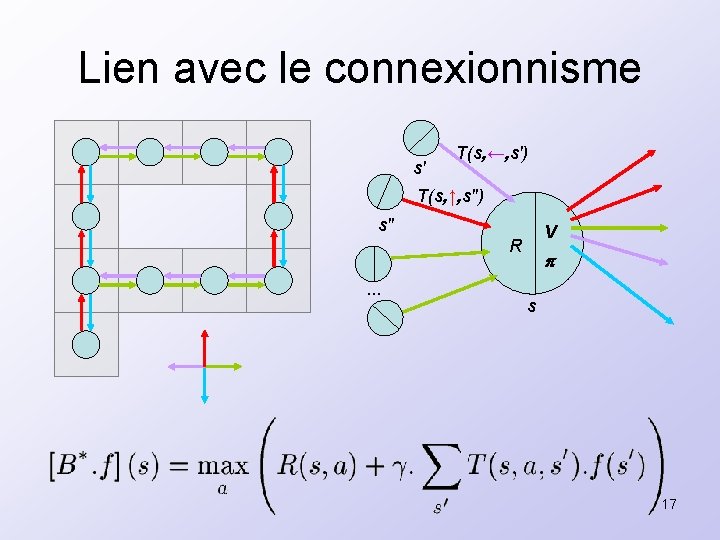

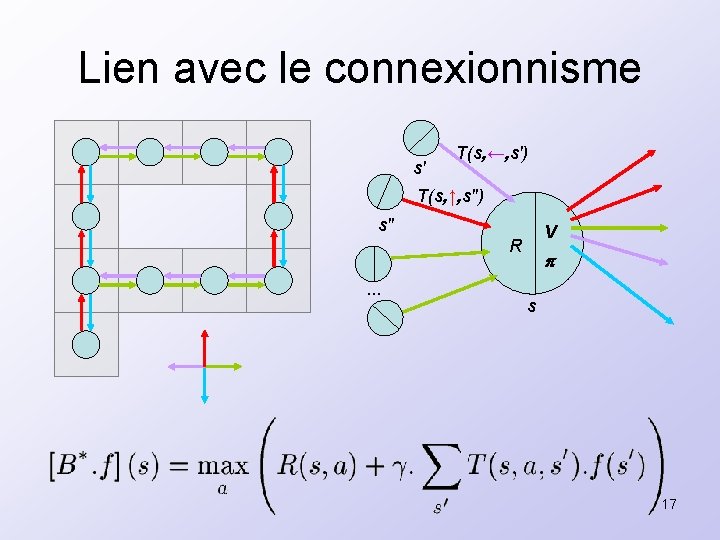

Lien avec le connexionnisme s' T(s, ←, s') T(s, ↑, s'') s'' V R. . . s 17

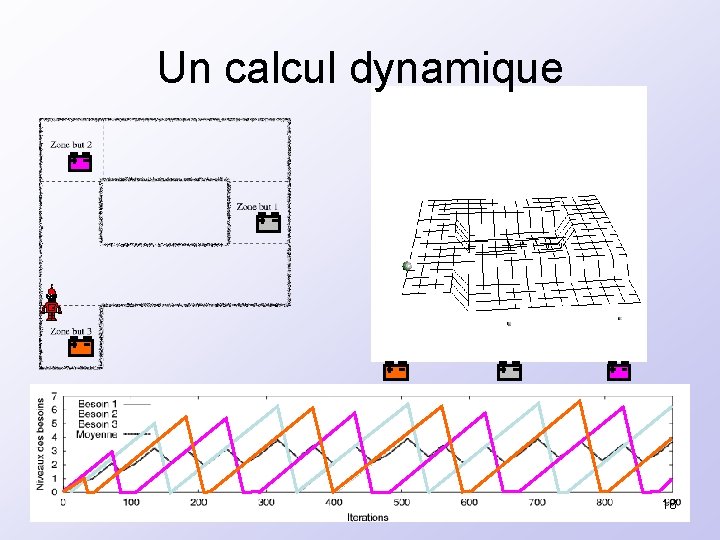

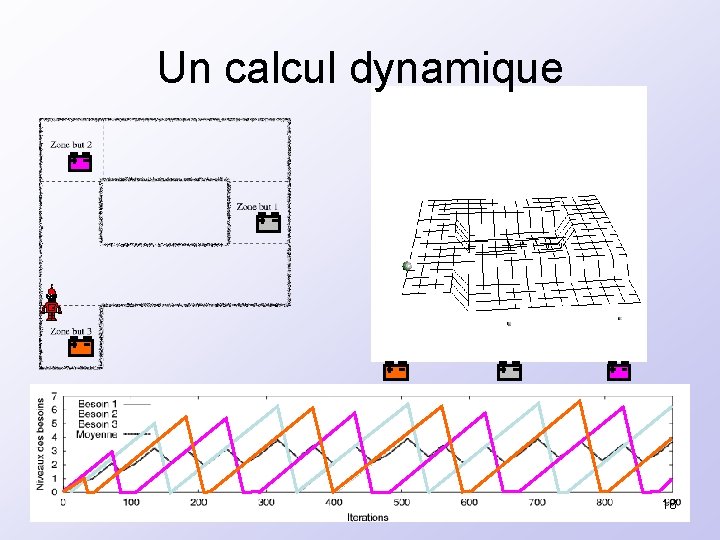

Un calcul dynamique 18

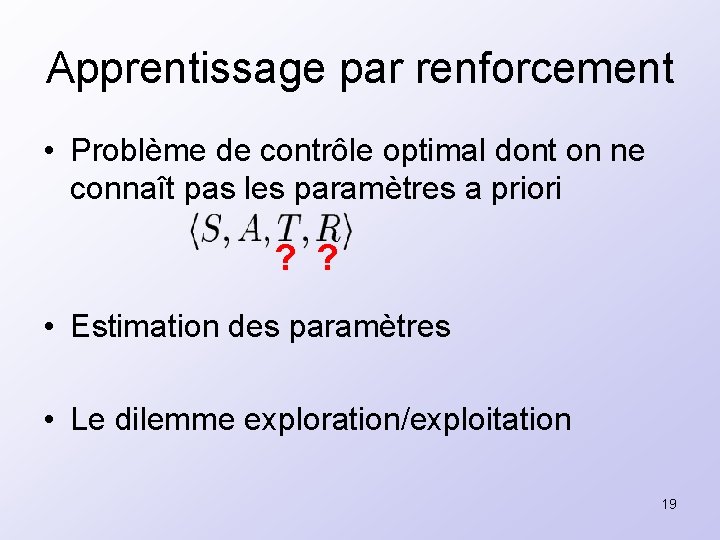

Apprentissage par renforcement • Problème de contrôle optimal dont on ne connaît pas les paramètres a priori ? ? • Estimation des paramètres • Le dilemme exploration/exploitation 19

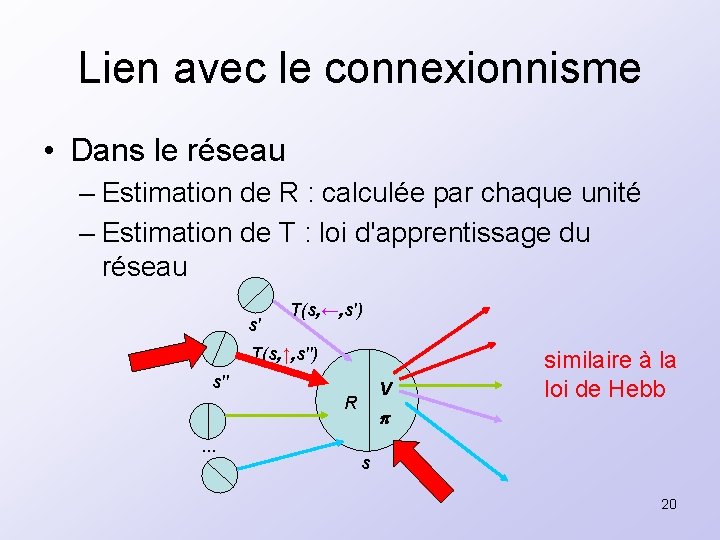

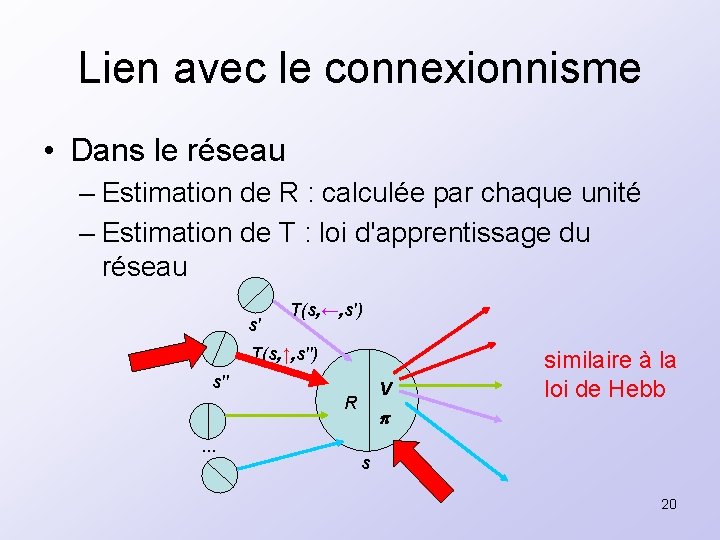

Lien avec le connexionnisme • Dans le réseau – Estimation de R : calculée par chaque unité – Estimation de T : loi d'apprentissage du réseau s' T(s, ←, s') T(s, ↑, s'') s'' V R. . . similaire à la loi de Hebb s 20

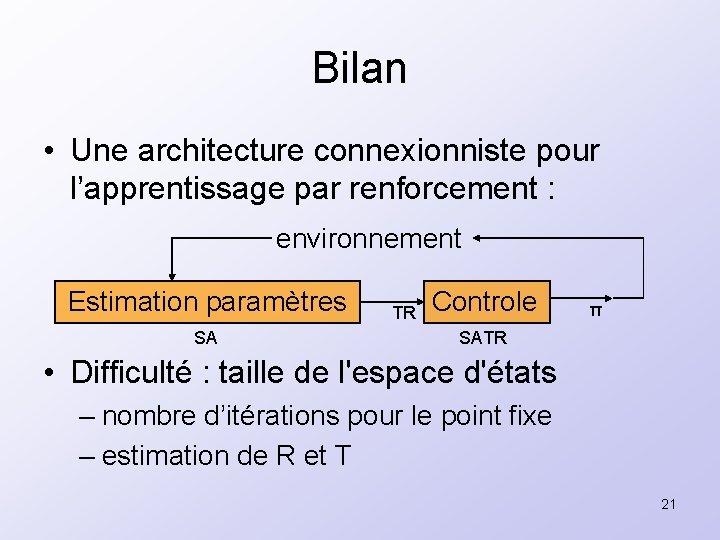

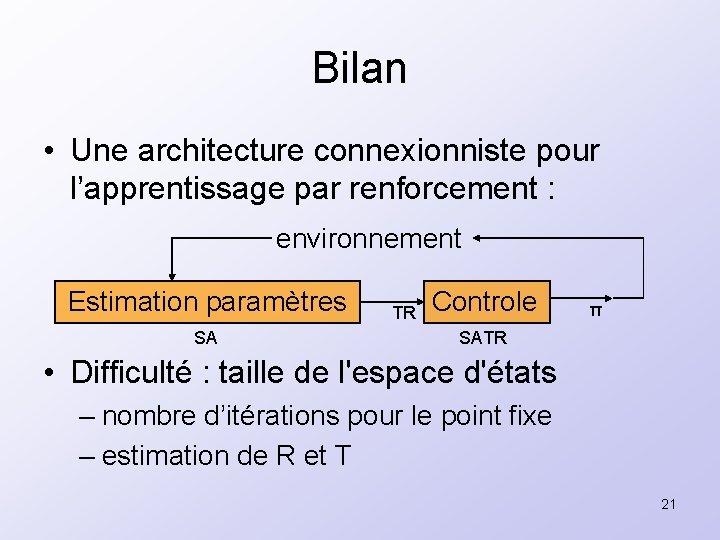

Bilan • Une architecture connexionniste pour l’apprentissage par renforcement : environnement Estimation paramètres SA TR Controle π SATR • Difficulté : taille de l'espace d'états – nombre d’itérations pour le point fixe – estimation de R et T 21

Plan • Introduction • Un calcul connexionniste • Contrôle optimal et apprentissage par renforcement • Apprentissage de représentation • Auto-organisation modulaire • Conclusions et perspectives 22

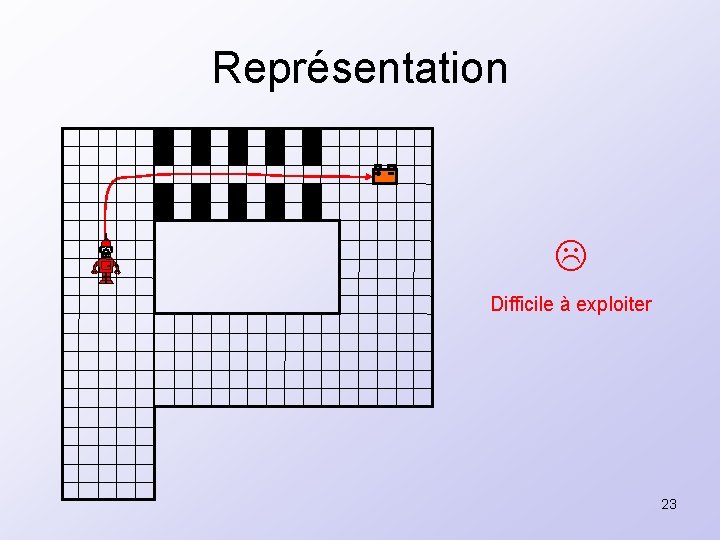

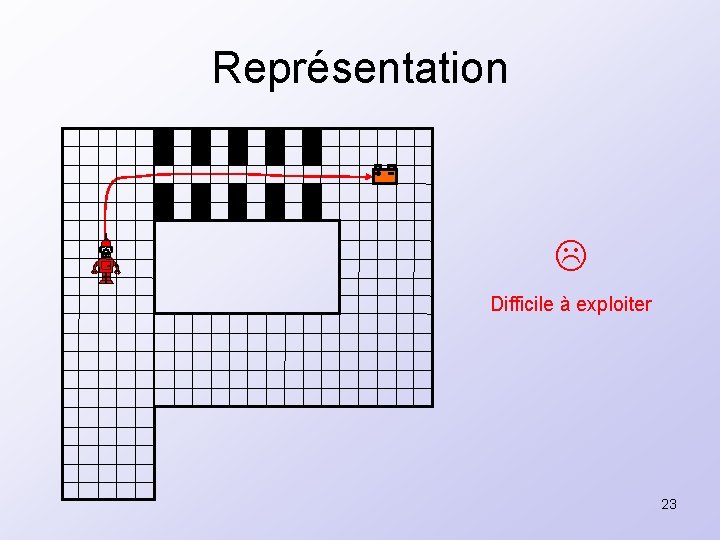

Représentation Difficile à exploiter 23

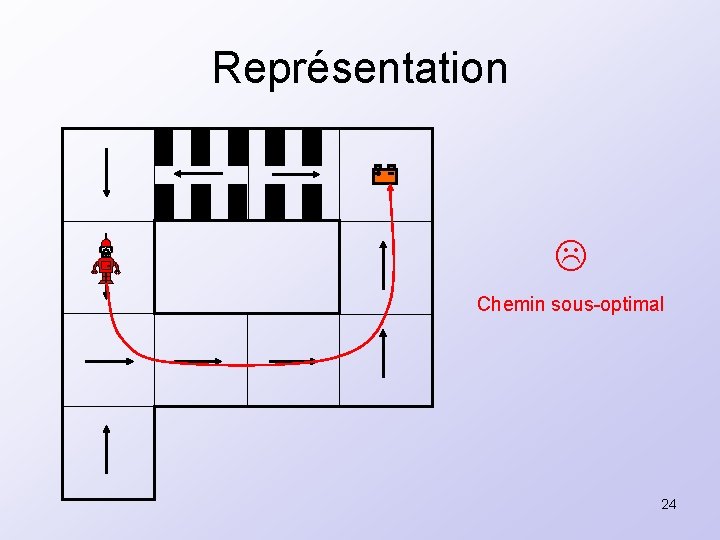

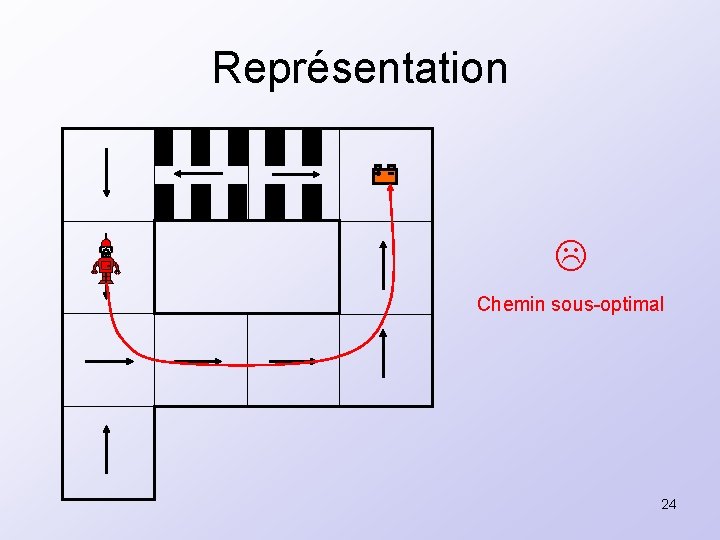

Représentation Chemin sous-optimal 24

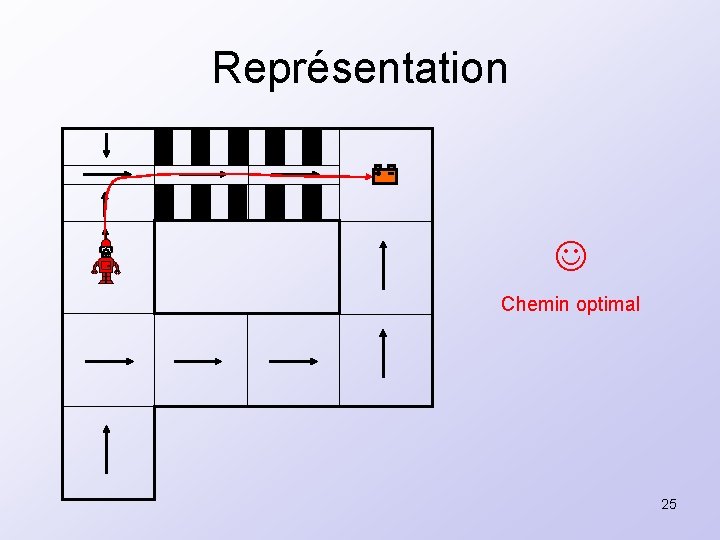

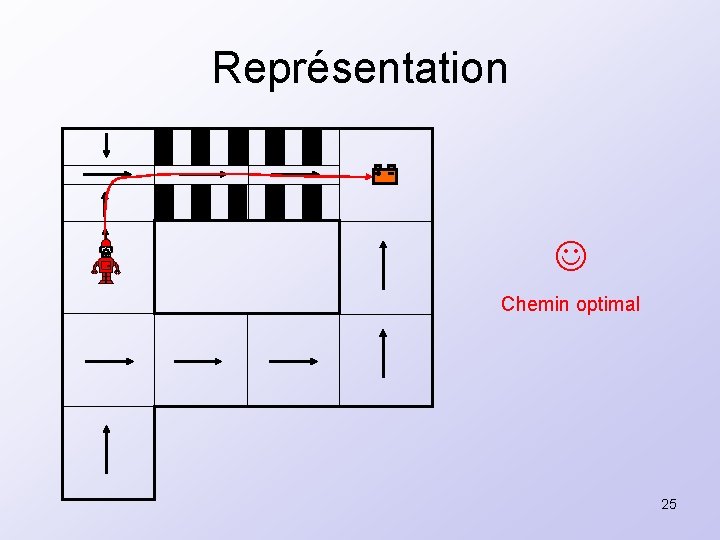

Représentation Chemin optimal 25

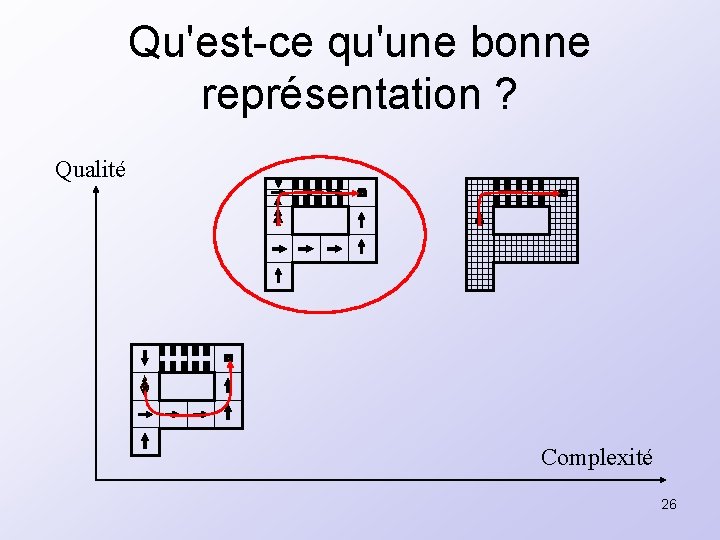

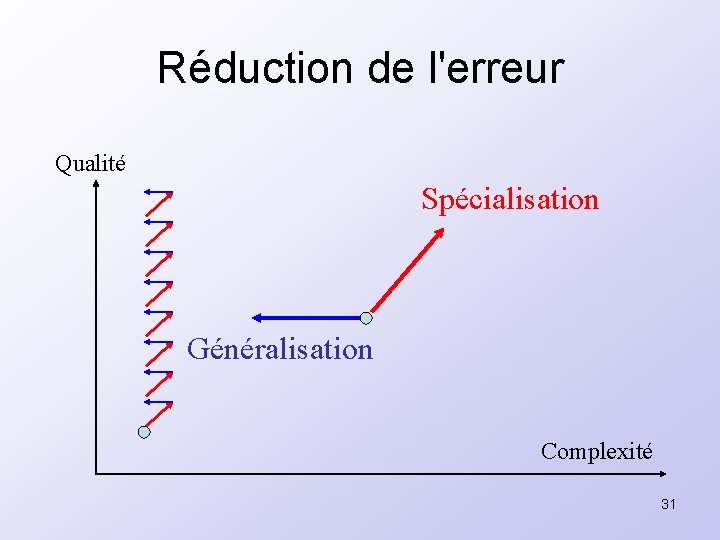

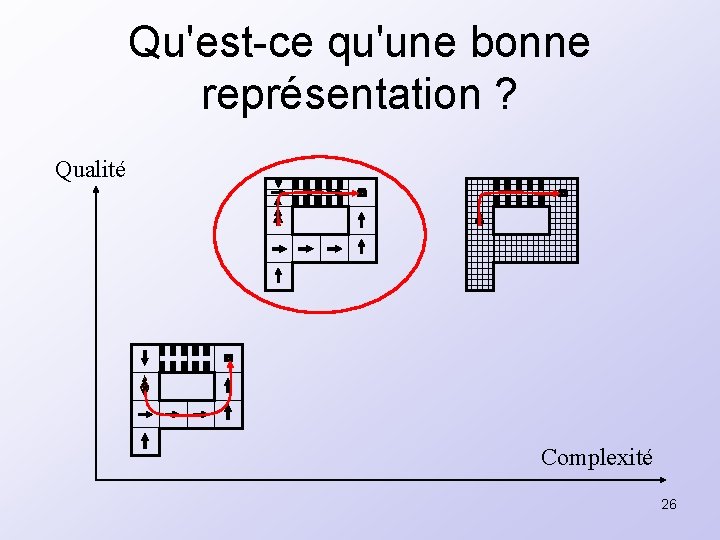

Qu'est-ce qu'une bonne représentation ? Qualité Complexité 26

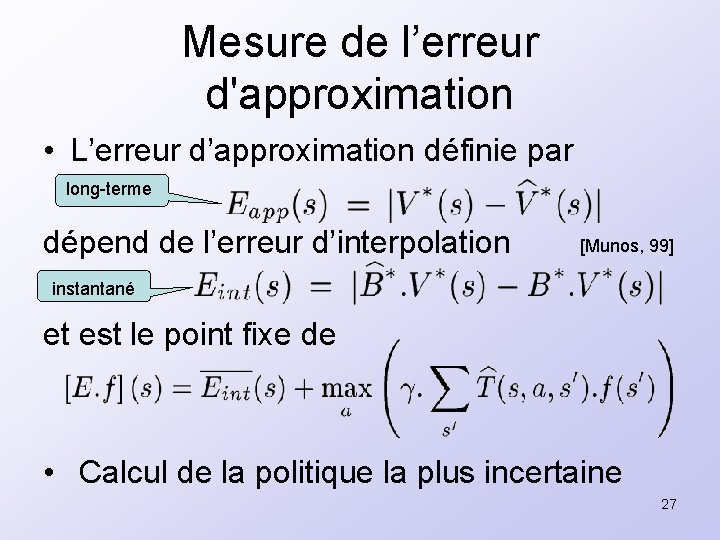

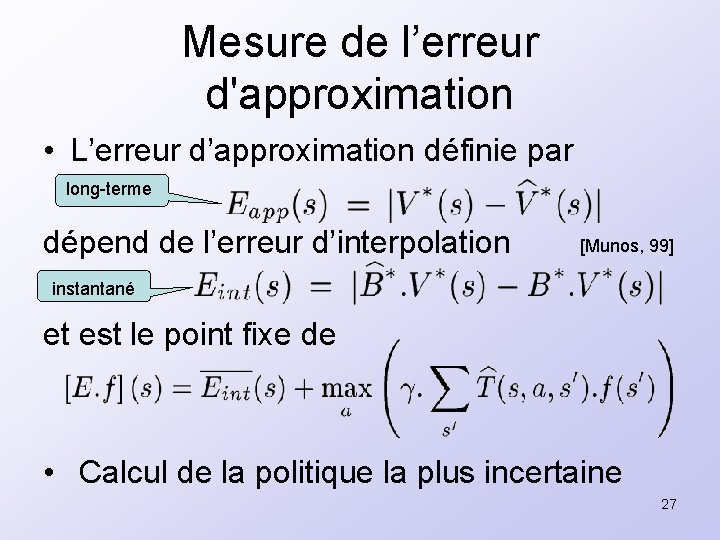

Mesure de l’erreur d'approximation • L’erreur d’approximation définie par long-terme dépend de l’erreur d’interpolation [Munos, 99] instantané et est le point fixe de • Calcul de la politique la plus incertaine 27

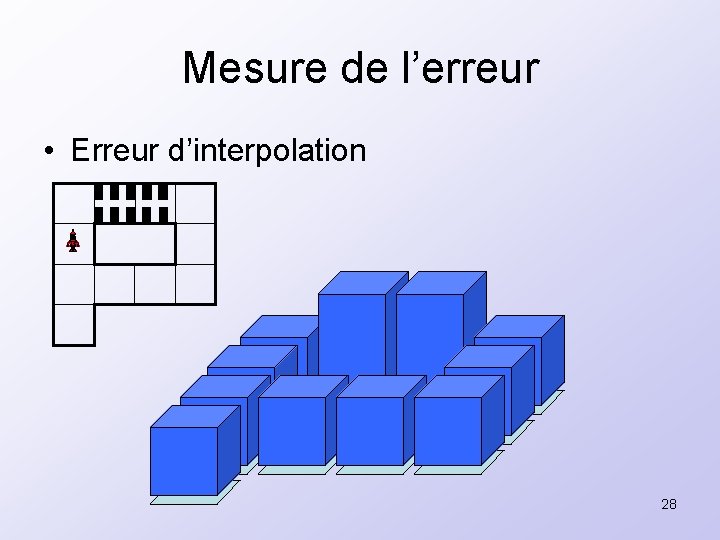

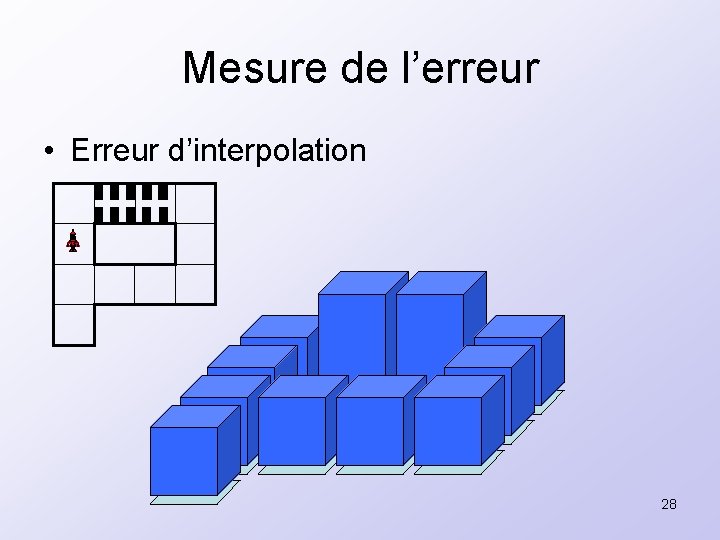

Mesure de l’erreur • Erreur d’interpolation 28

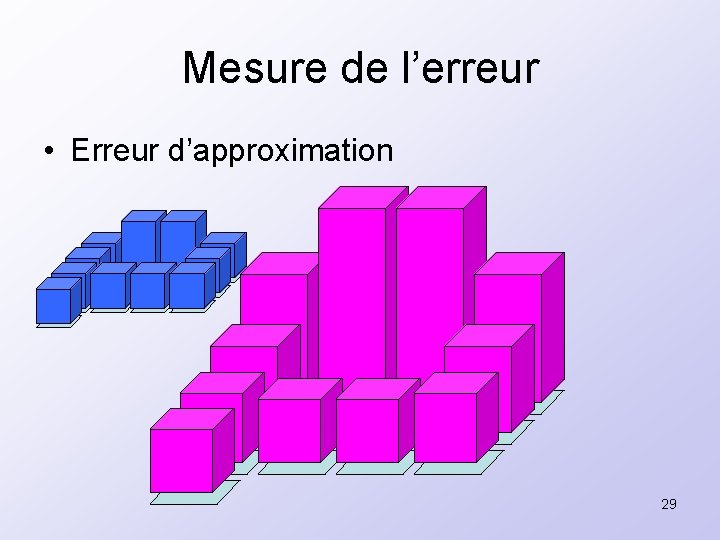

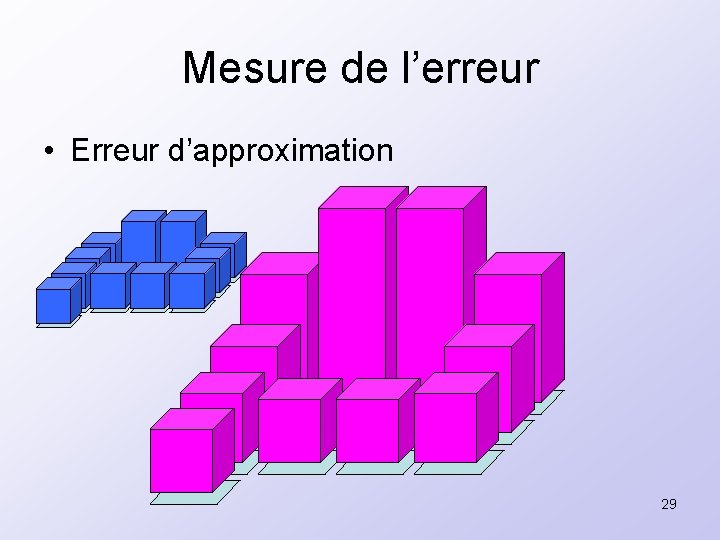

Mesure de l’erreur • Erreur d’approximation 29

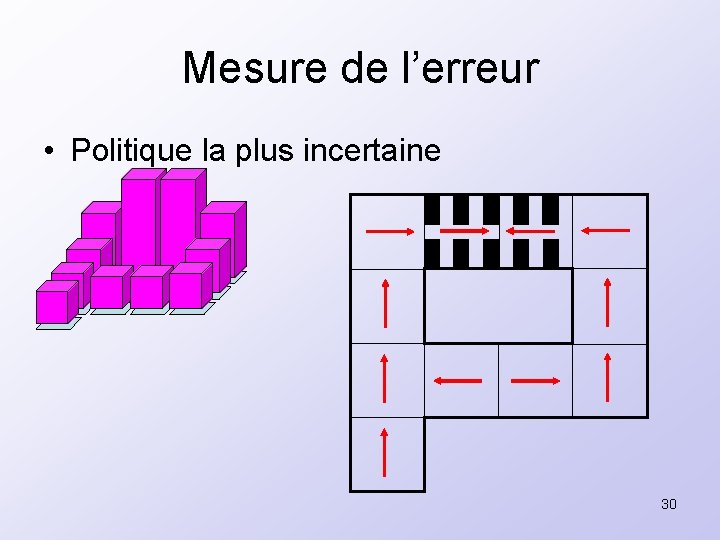

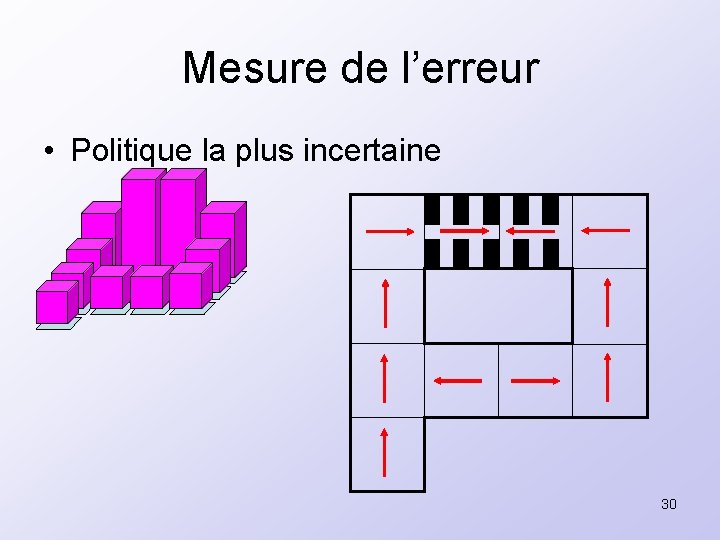

Mesure de l’erreur • Politique la plus incertaine 30

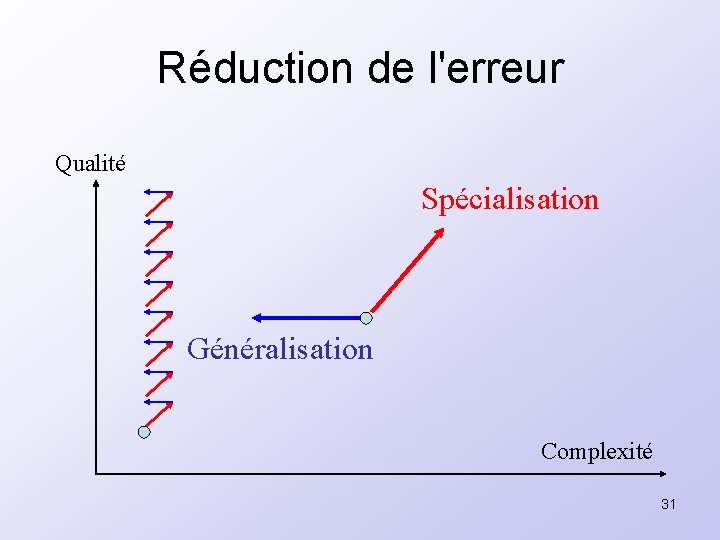

Réduction de l'erreur Qualité Spécialisation Généralisation Complexité 31

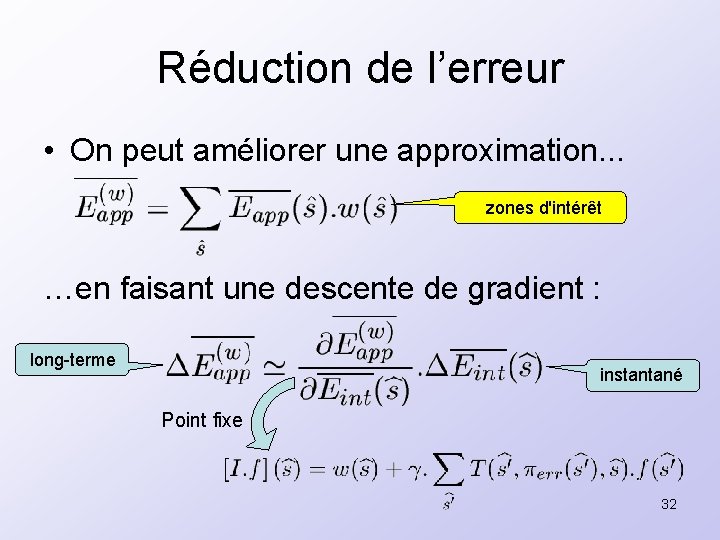

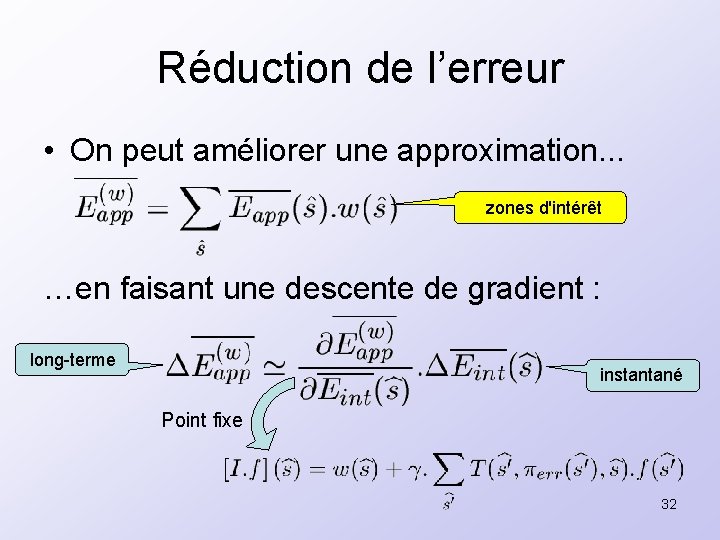

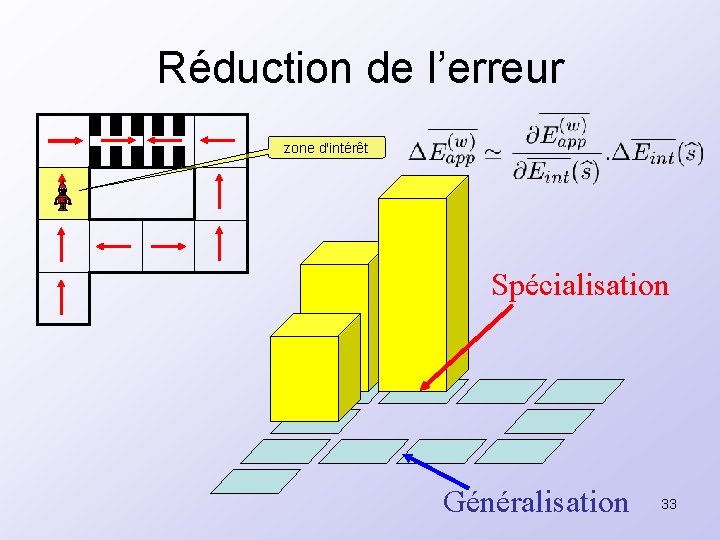

Réduction de l’erreur • On peut améliorer une approximation. . . zones d'intérêt …en faisant une descente de gradient : long-terme instantané Point fixe 32

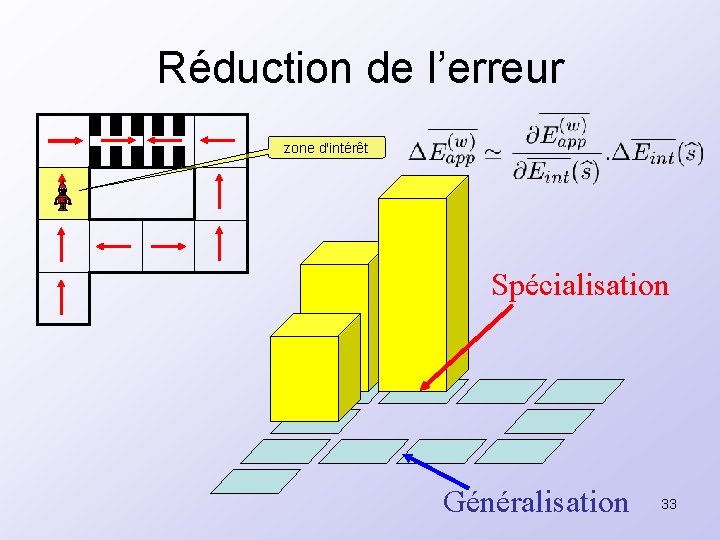

Réduction de l’erreur zone d'intérêt Spécialisation Généralisation 33

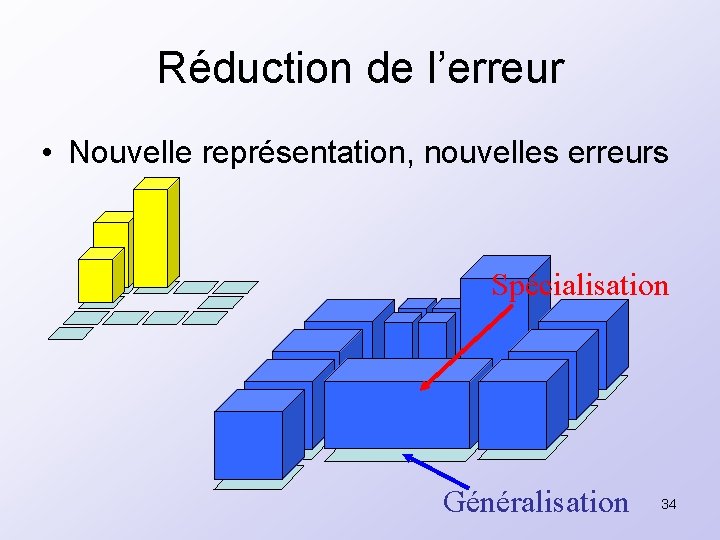

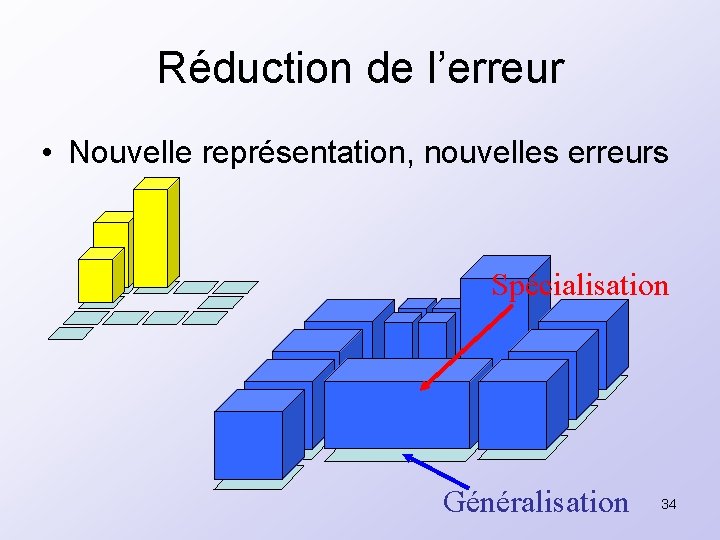

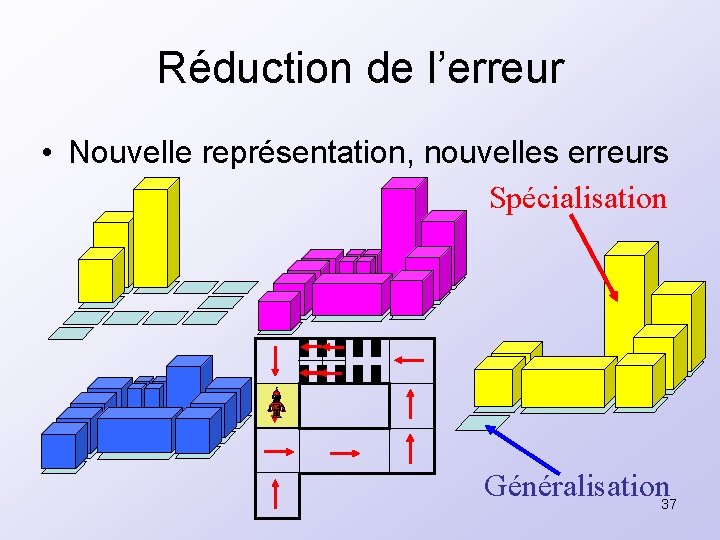

Réduction de l’erreur • Nouvelle représentation, nouvelles erreurs Spécialisation Généralisation 34

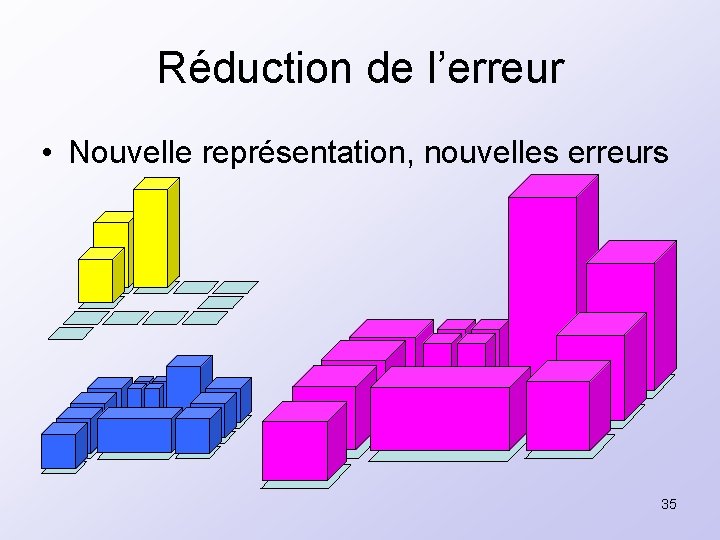

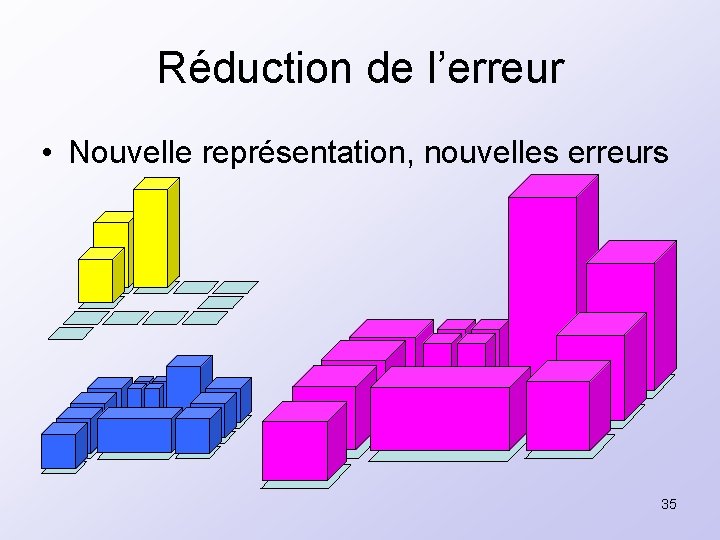

Réduction de l’erreur • Nouvelle représentation, nouvelles erreurs 35

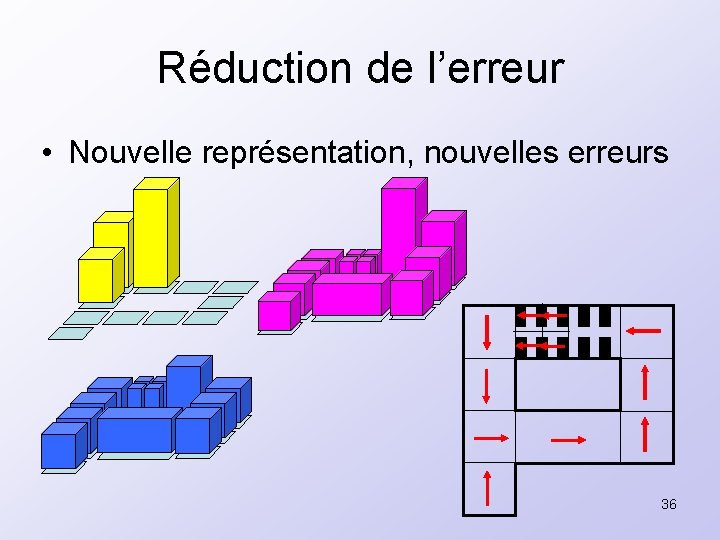

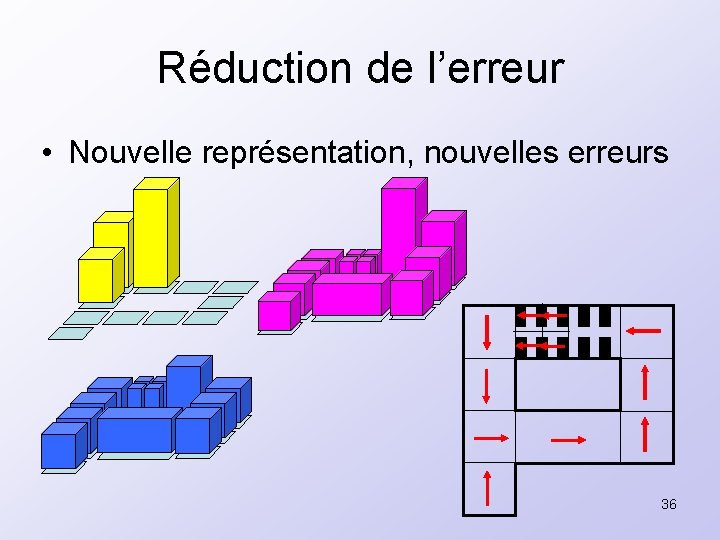

Réduction de l’erreur • Nouvelle représentation, nouvelles erreurs 36

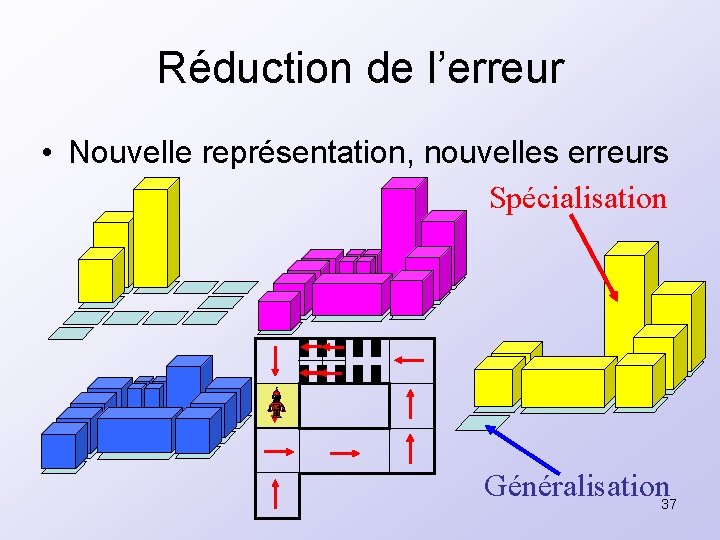

Réduction de l’erreur • Nouvelle représentation, nouvelles erreurs Spécialisation Généralisation 37

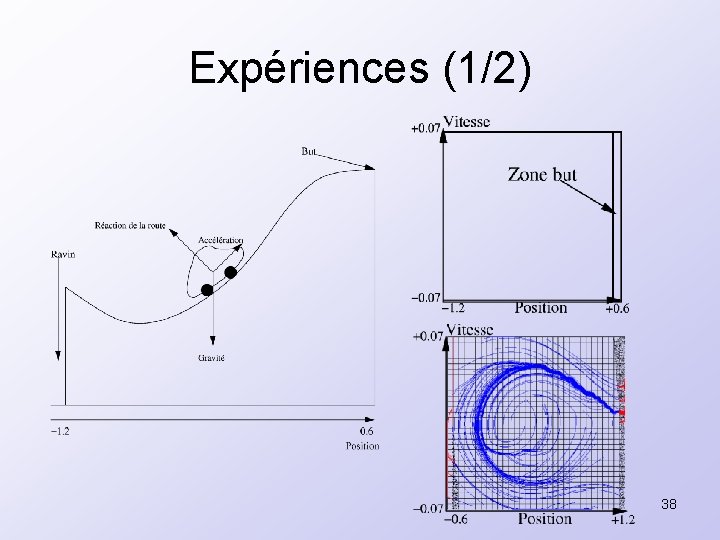

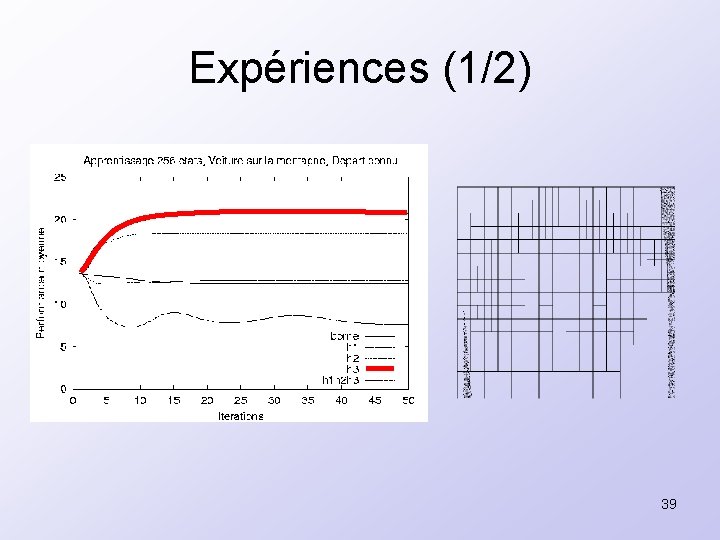

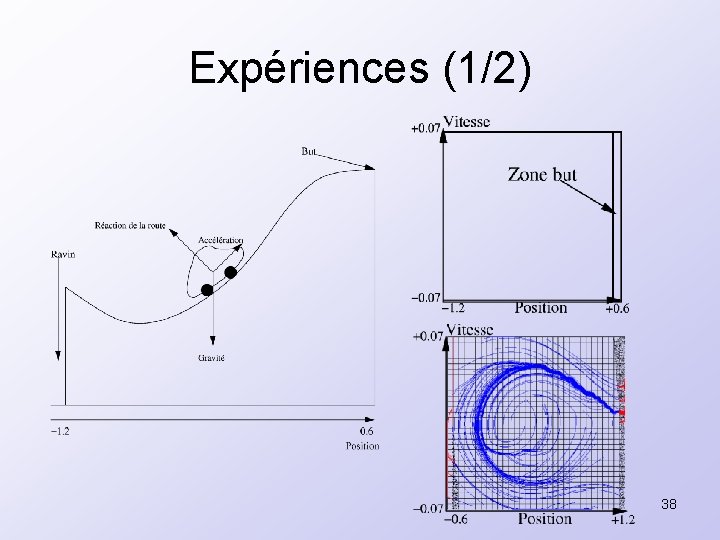

Expériences (1/2) 38

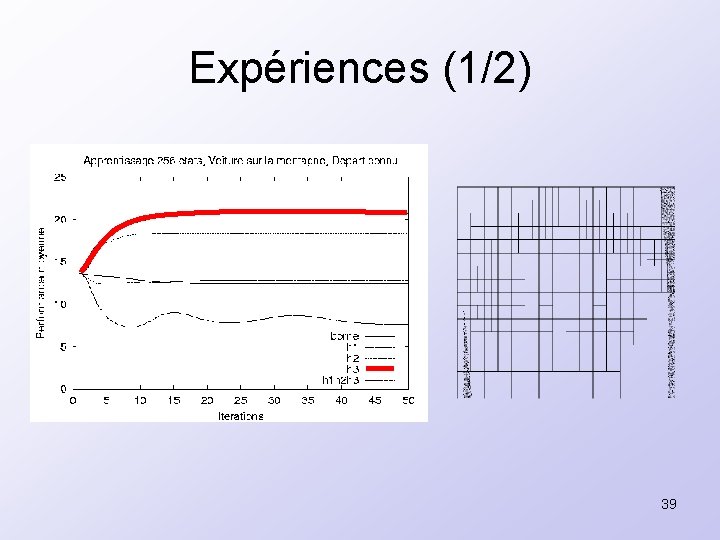

Expériences (1/2) 39

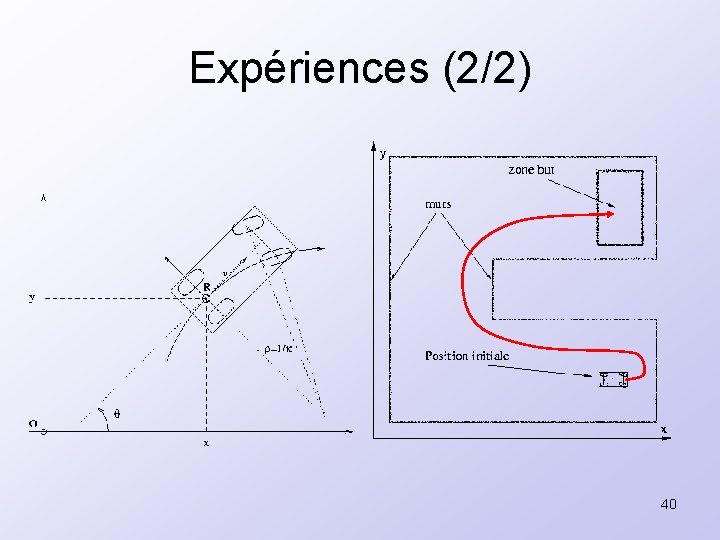

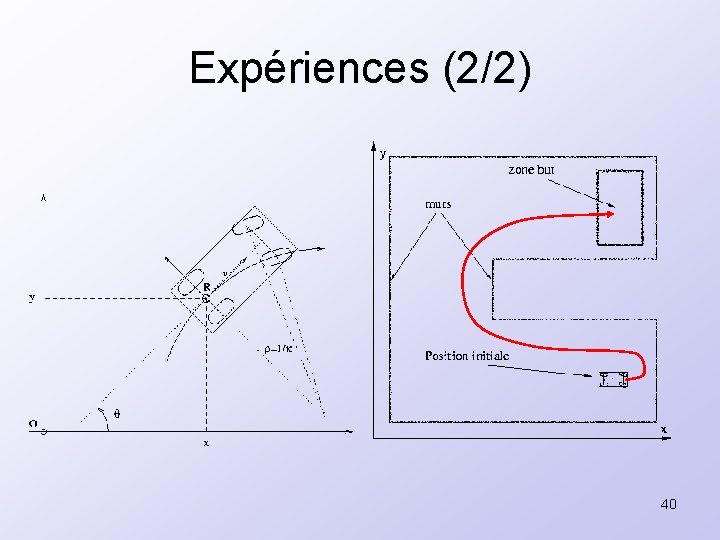

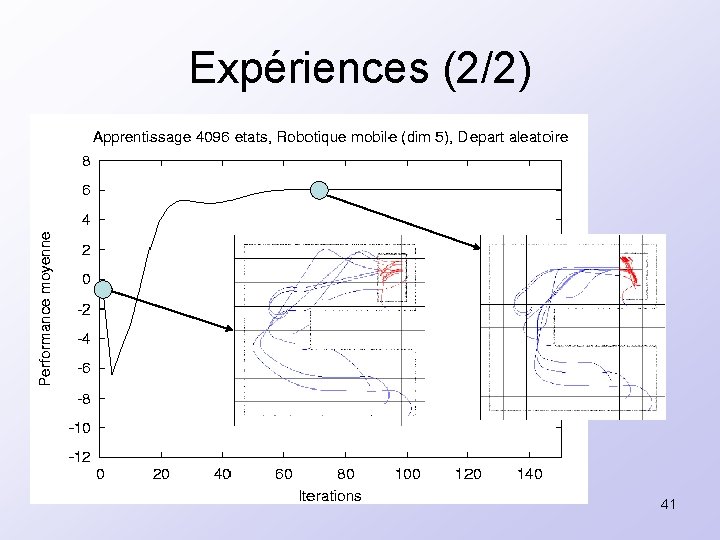

Expériences (2/2) 40

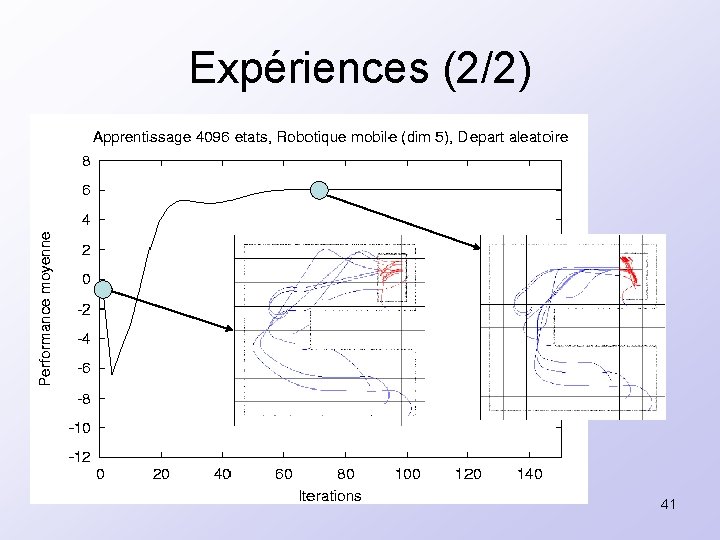

Expériences (2/2) 41

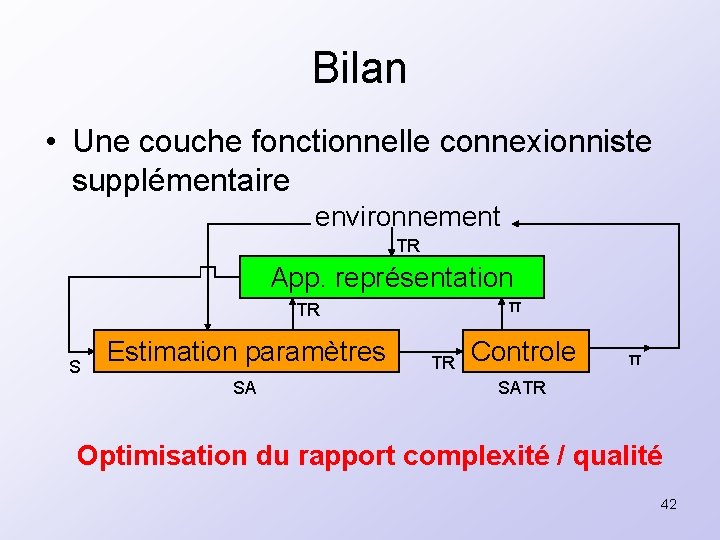

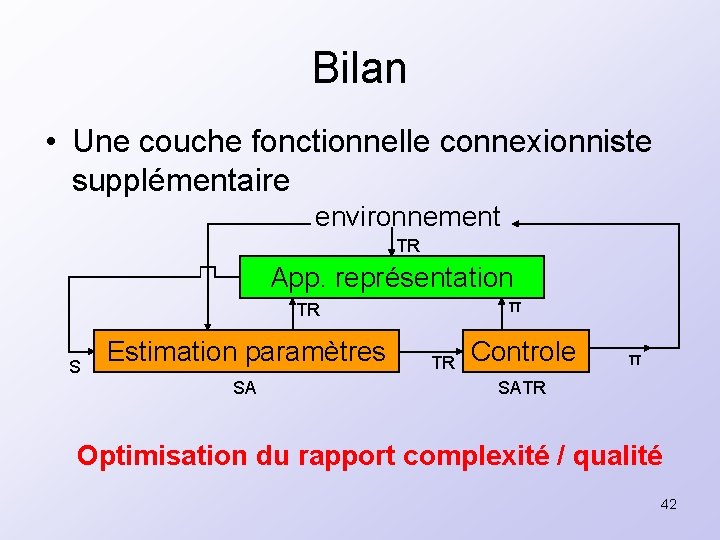

Bilan • Une couche fonctionnelle connexionniste supplémentaire environnement TR App. représentation π TR S Estimation paramètres SA TR Controle π SATR Optimisation du rapport complexité / qualité 42

Plan • Introduction • Un calcul connexionniste • Contrôle optimal et apprentissage par renforcement • Apprentissage de représentation • Auto-organisation modulaire • Conclusions et perspectives 43

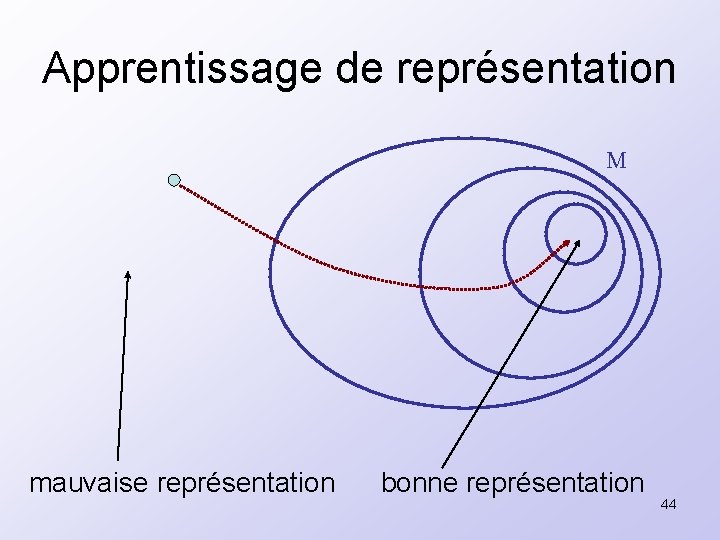

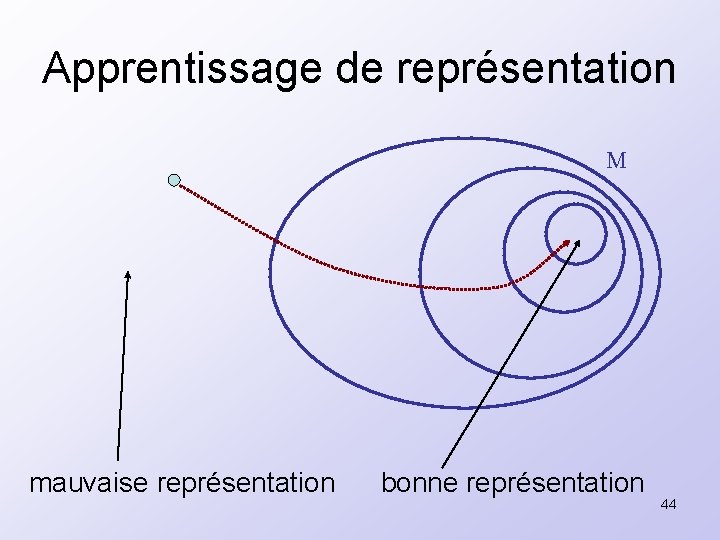

Apprentissage de représentation M mauvaise représentation bonne représentation 44

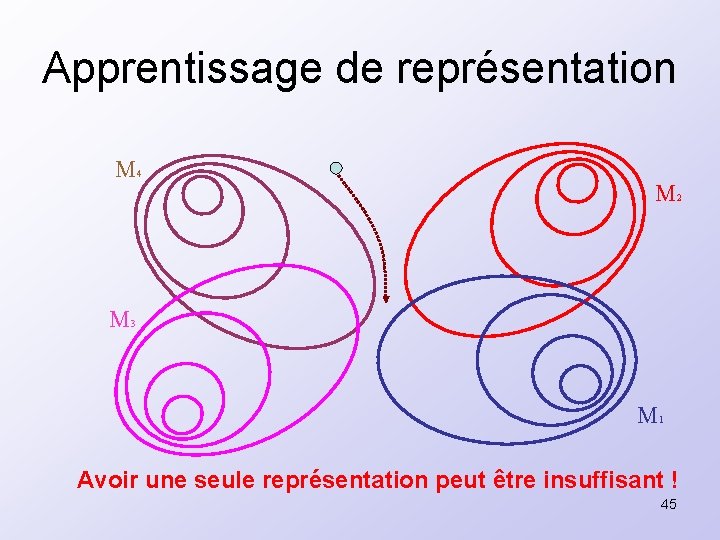

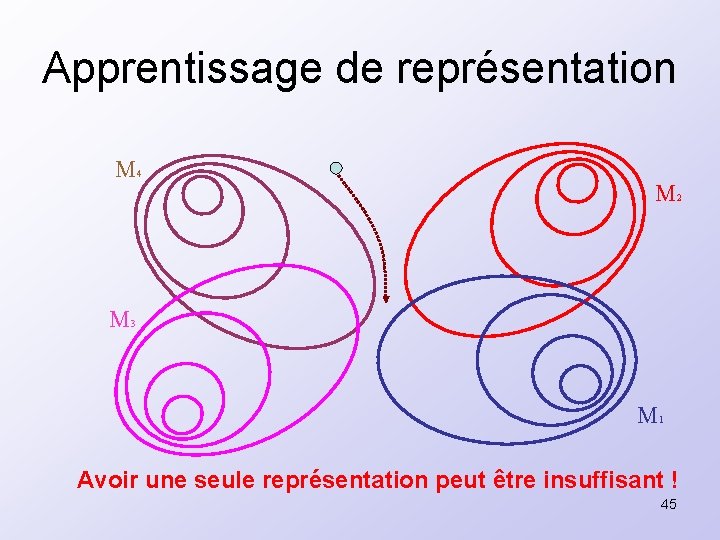

Apprentissage de représentation M 4 M 2 M 3 M 1 Avoir une seule représentation peut être insuffisant ! 45

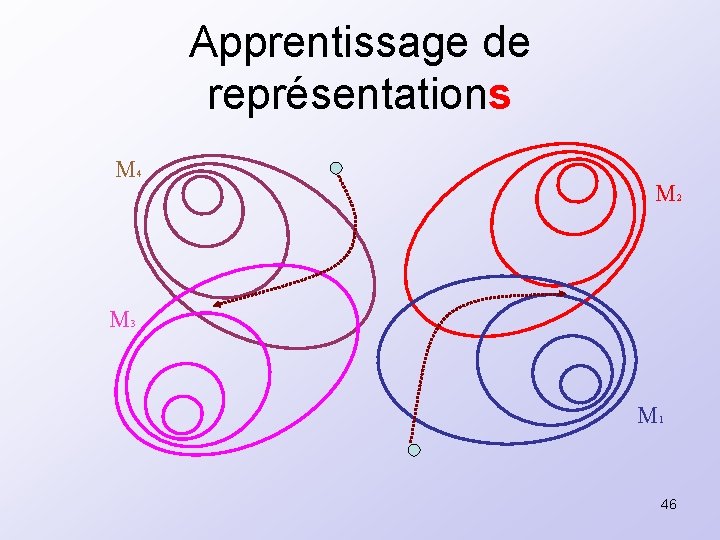

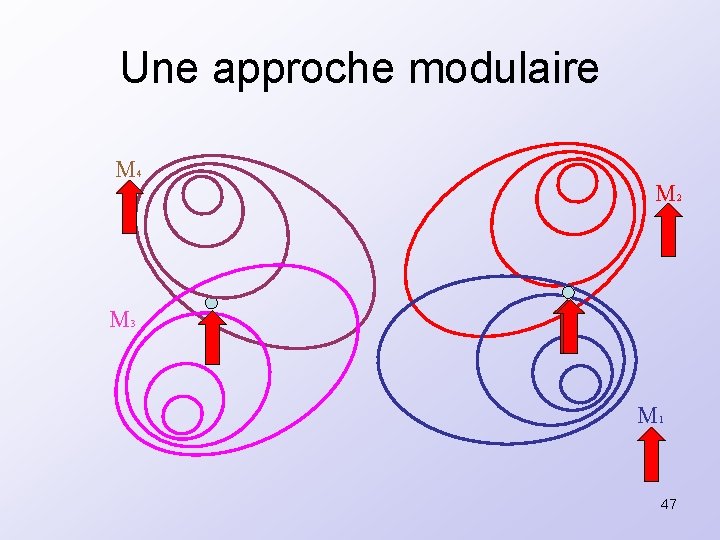

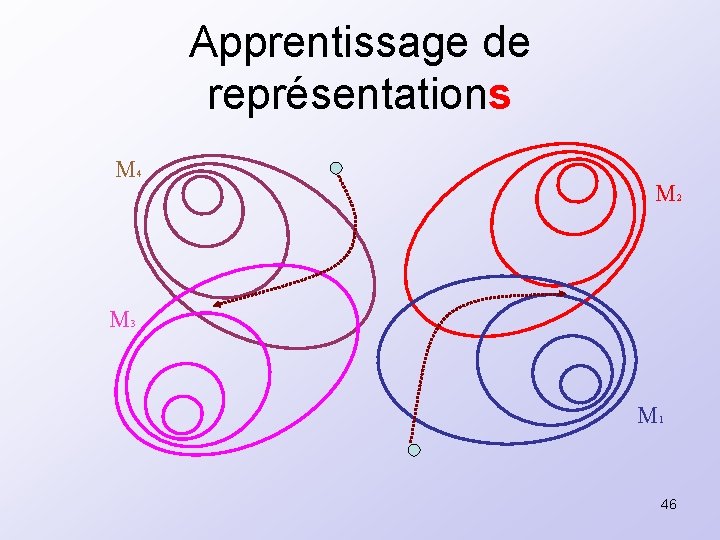

Apprentissage de représentations M 4 M 2 M 3 M 1 46

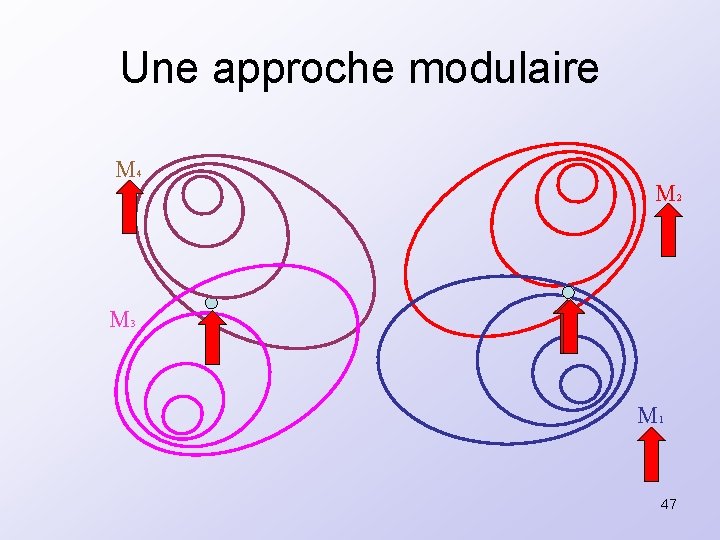

Une approche modulaire M 4 M 2 M 3 M 1 47

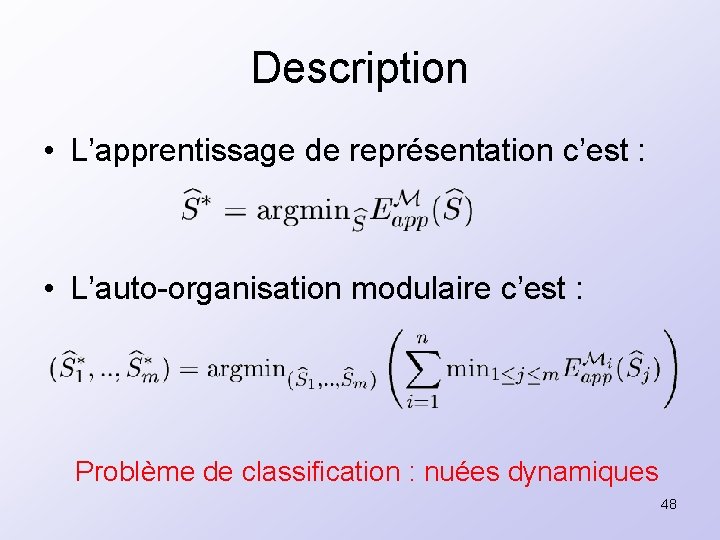

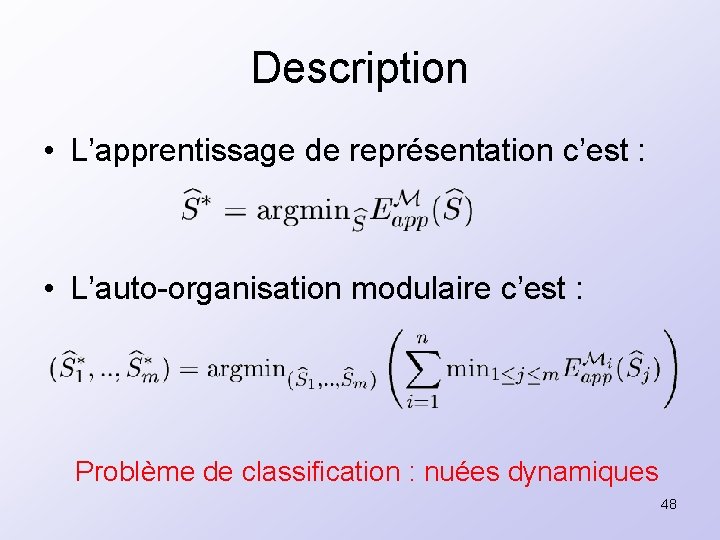

Description • L’apprentissage de représentation c’est : • L’auto-organisation modulaire c’est : Problème de classification : nuées dynamiques 48

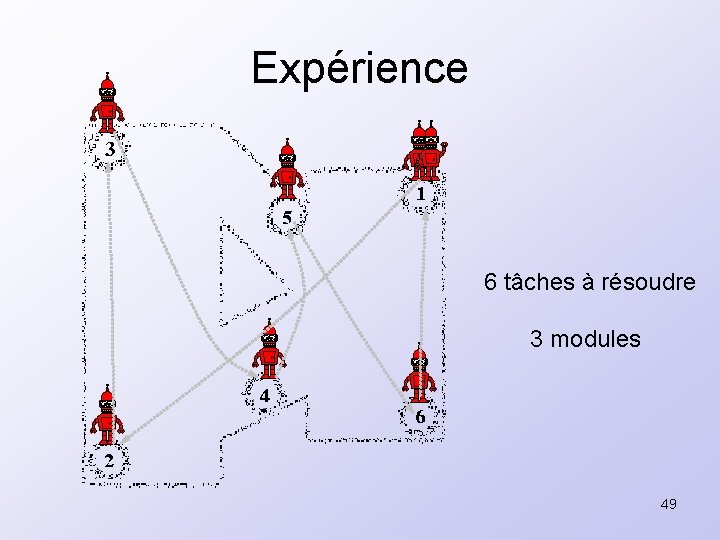

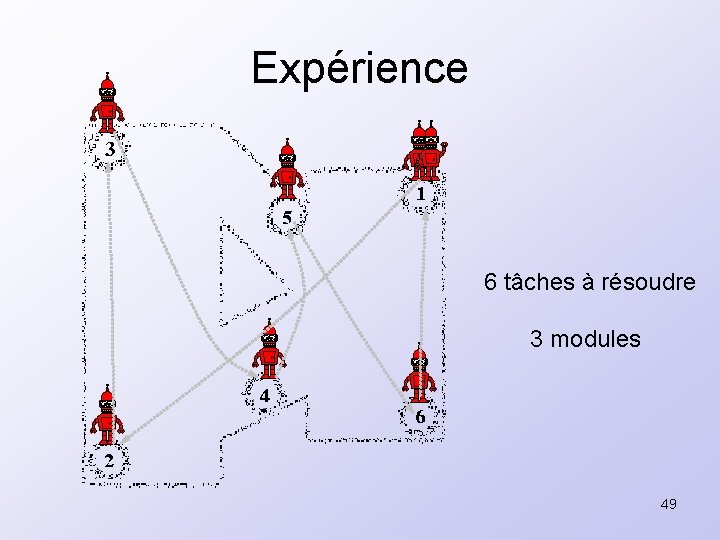

Expérience 6 tâches à résoudre 3 modules 49

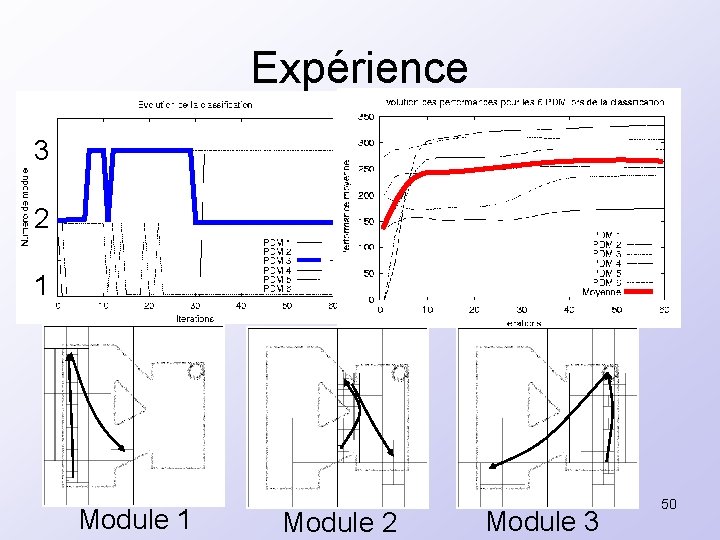

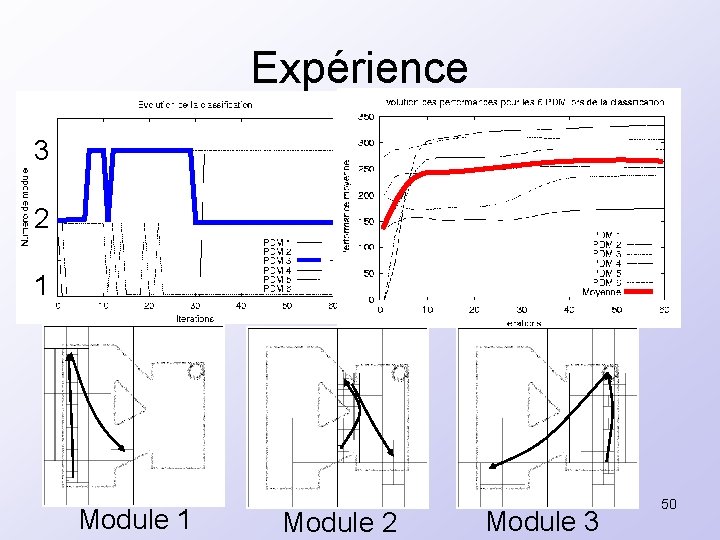

Expérience 3 2 1 Module 2 Module 3 50

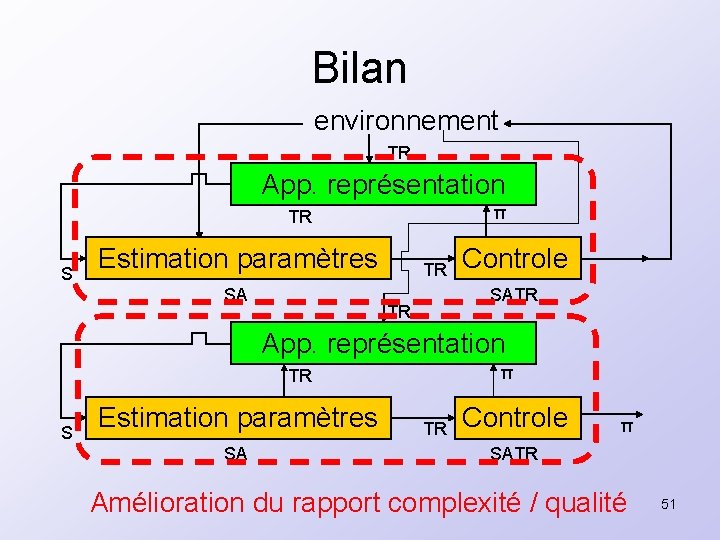

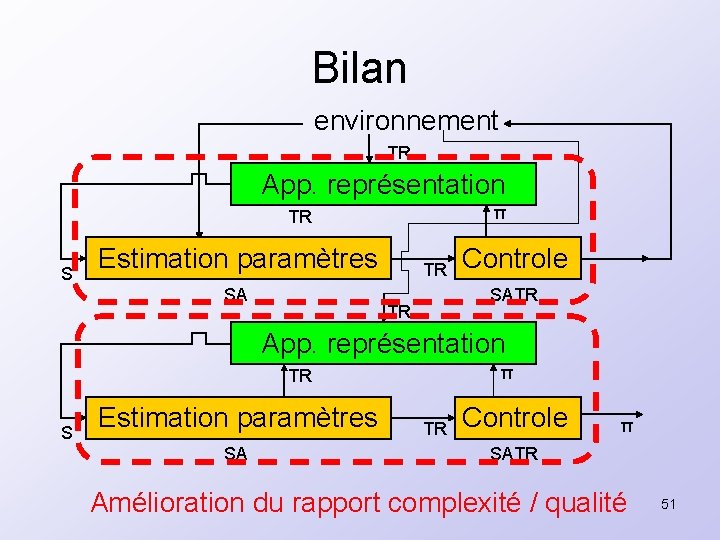

Bilan environnement TR App. représentation π TR S Estimation paramètres SA TR Controle SATR TR App. représentation π TR S Estimation paramètres SA TR Controle π SATR Amélioration du rapport complexité / qualité 51

Plan • Introduction • Un calcul connexionniste • Contrôle optimal et apprentissage par renforcement • Apprentissage de représentation • Auto-organisation modulaire • Conclusions et perspectives 52

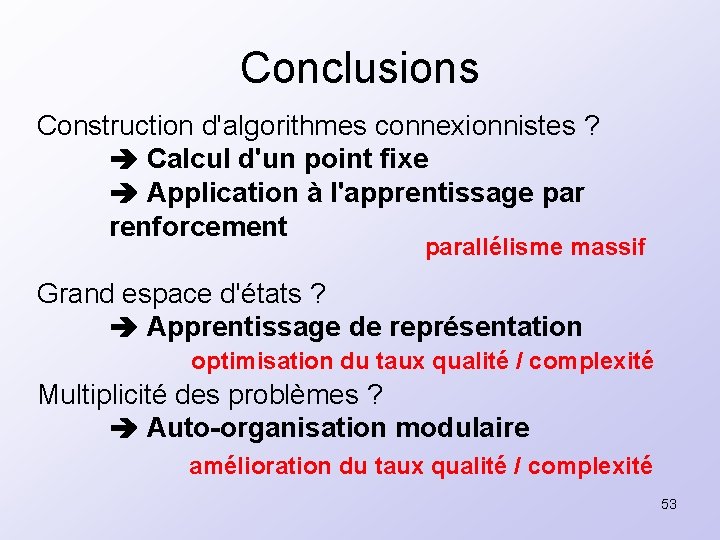

Conclusions Construction d'algorithmes connexionnistes ? Calcul d'un point fixe Application à l'apprentissage par renforcement parallélisme massif Grand espace d'états ? Apprentissage de représentation optimisation du taux qualité / complexité Multiplicité des problèmes ? Auto-organisation modulaire amélioration du taux qualité / complexité 53

Conclusions Schémas d'approximations convergents Généricité des résultats Validation sur des problèmes complexes Véhicule de type voiture Agent autonome devant résoudre une multitude de tâches 54

Perspectives • Extensions/améliorations des travaux de thèse – Gestion adaptative des ressources – Coopération des modules – Implantation matérielle parallèle – Approximateurs de fonctions plus puissants – Le dilemme exploration/exploitation • Liens avec des travaux de sciences cognitives 55

Toi et moi basel

Toi et moi basel Asi modulaire

Asi modulaire Exponentiation rapide modulaire

Exponentiation rapide modulaire Asi modulaire

Asi modulaire Parking modulaire

Parking modulaire Modular exponentiation

Modular exponentiation Conception modulaire définition

Conception modulaire définition Apprentissage par renforcement

Apprentissage par renforcement Situation d'apprentissage rugby cycle 4

Situation d'apprentissage rugby cycle 4 Théorie des attentes de vroom

Théorie des attentes de vroom Pyramide de l'apprentissage bethel

Pyramide de l'apprentissage bethel Piliers de l'apprentissage

Piliers de l'apprentissage Apprentissage synonyme

Apprentissage synonyme Les facteurs d'apprentissage

Les facteurs d'apprentissage Les modèles d'apprentissage pdf

Les modèles d'apprentissage pdf Fiche navette apprentissage

Fiche navette apprentissage Objectifs de lecture

Objectifs de lecture Apprentissage collaboratif à distance

Apprentissage collaboratif à distance Apprentissage par les pairs

Apprentissage par les pairs Les modèles d'apprentissage pdf

Les modèles d'apprentissage pdf Biathlon cycle 4

Biathlon cycle 4 Conception universelle de l'apprentissage

Conception universelle de l'apprentissage Unité didactique d'apprentissage

Unité didactique d'apprentissage La théorie de l'apprentissage social

La théorie de l'apprentissage social Apprentissage passage dizaine

Apprentissage passage dizaine Haribo c'est beau la vie pour les grand et les petit

Haribo c'est beau la vie pour les grand et les petit Nima ahmadi pour anari

Nima ahmadi pour anari Table de mac grady pour 3 tubes par dilution

Table de mac grady pour 3 tubes par dilution Quel taux de psa pour un cancer de la prostate ?

Quel taux de psa pour un cancer de la prostate ? Sphincter

Sphincter Objets liturgiques pour la messe

Objets liturgiques pour la messe Merci pour votre attention

Merci pour votre attention Mot de bienvenue pour un culte d'adoration

Mot de bienvenue pour un culte d'adoration Instrument pour observer le ciel

Instrument pour observer le ciel Morfil

Morfil Classe en soi et classe pour soi

Classe en soi et classe pour soi Tableau de perçage pour taraudage

Tableau de perçage pour taraudage Racks pour automate

Racks pour automate A nouveau réunis pour louer le seigneur

A nouveau réunis pour louer le seigneur Rendre une femme heureuse

Rendre une femme heureuse Pour la bonne tenue du dossier

Pour la bonne tenue du dossier Dmr pour les nuls

Dmr pour les nuls Tous mes péchés sont effacés

Tous mes péchés sont effacés Outils pour les cfds

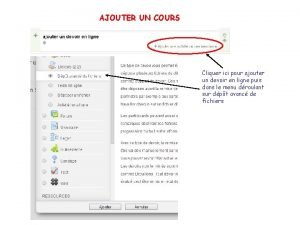

Outils pour les cfds Cliquer ici pour le finaliser

Cliquer ici pour le finaliser Travaillons tous pour notre maitre

Travaillons tous pour notre maitre Mes resolutions pour le nouvel an

Mes resolutions pour le nouvel an Fibrine pansement

Fibrine pansement Formule pour accuser réception d'un mail

Formule pour accuser réception d'un mail Listen to the pouring rain listen to it pour

Listen to the pouring rain listen to it pour Exemple de ppre pour eip

Exemple de ppre pour eip Astm d6045

Astm d6045 Fournitures pour rempaillage chaise

Fournitures pour rempaillage chaise Correspondance gicleur fioul

Correspondance gicleur fioul Phrases avec le subjonctif

Phrases avec le subjonctif Cliquez ici pour commencer

Cliquez ici pour commencer