Data Mining Merkmalsextraktion Merkmalsgenerierung Merkmalsselektion als Schlssel zum

- Slides: 58

Data Mining – Merkmalsextraktion, Merkmalsgenerierung, Merkmalsselektion als Schlüssel zum Erfolg Katharina Morik Lehrstuhl Informatik VIII Universität Dortmund www-ai. cs. uni-dortmund. de morik@ls 8. cs. uni-dortmund. de

Überblick Unterstützung des Data Mining Prozesses n Mining. Mart – direkte Datenbankintegration n – Telekommunikationsanwendung – Versicherungsanwendung n Yale – stand-alone mit Datenbank- oder Dateizugriff – automatische Merkmalsextraktion aus Musikdaten – peer 2 peer Organisation von Musiksammlungen n Credo

CRISP – Prozess der Wissensentdeckung 64% der Wissensentdecker brauchen mehr als 61% der Zeit einer Anwendung für die Vorverarbeitung (KDnuggets poll Okt. 2003). Business understanding Data preparation Modeling Deployment Evaluation DM Prozess 3

Werkzeuge für Data Mining Unterstützung des zentralen Lernschrittes (Modellierung) bereits sehr gut – Vorverarbeitung? n Dokumentation des gesamten Prozesses? n Wiederverwendbarkeit eines Prozesses? n 1. LS 8 entwickelt Werkzeuge, die den gesamten Prozess 1. unterstützen 2. dokumentieren 3. wiederverwenden lassen! DM Prozess

Vorverarbeitung n n n Fehlende Werte Zusammenstellen der Informationen aus mehreren Datenbanktabellen zu einem Beispiel (in einer Tabelle) Ausreißererkennung Sampling Erzeugen der Merkmale gemäß der Anforderung des Lernalgorithmus’. DM Prozess 5

Mining Mart Ziele n Operatoren für die Vorverarbeitung – direkt auf der Datenbank – maschinelles Lernen für die Vorverarbeitung n Dokumentation – der Daten – der Fälle n Wiederverwendung von abstrahierten Fällen Mining. Mart 6

Mining Mart Ansatz n Metadaten zur Beschreibung von – Daten, – Operatoren und – Fällen (Sequenzen von Operatoren) Compiler, der Metadaten in ausführbaren SQL-Code übersetzt n Sammlung von Fällen in Form von operationalen Metadaten n Mining. Mart 7

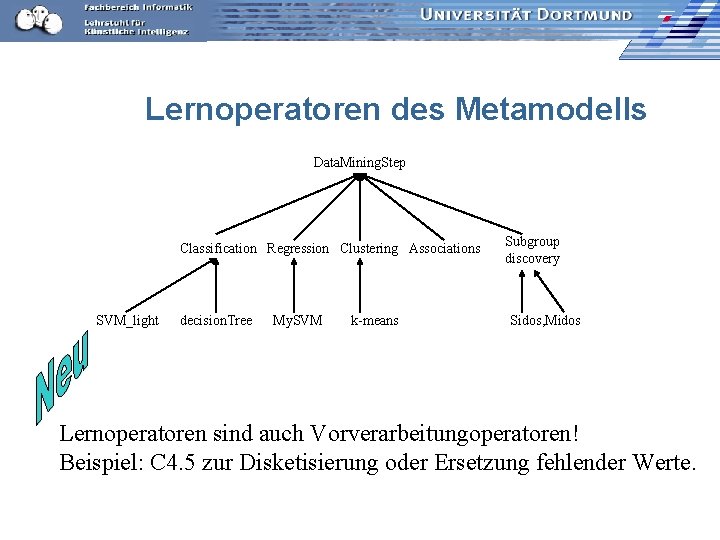

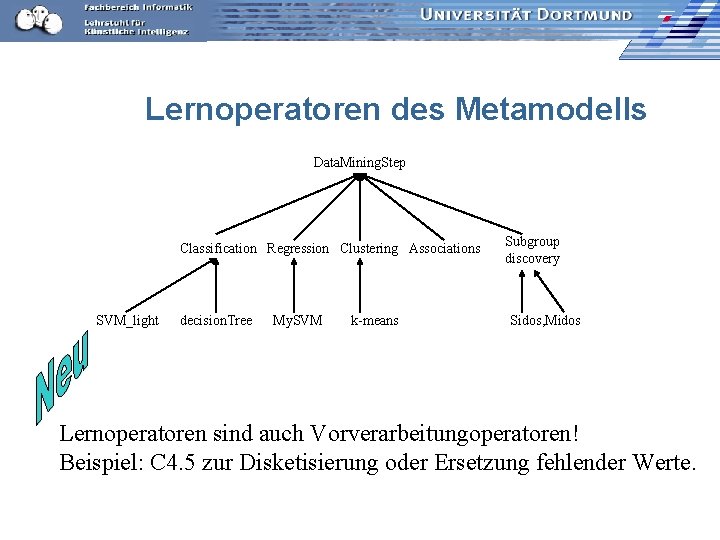

Lernoperatoren des Metamodells Data. Mining. Step Classification Regression Clustering Associations SVM_light decision. Tree My. SVM k-means Subgroup discovery Sidos, Midos NEU Lernoperatoren sind auch Vorverarbeitungoperatoren! Beispiel: C 4. 5 zur Disketisierung oder Ersetzung fehlender Werte.

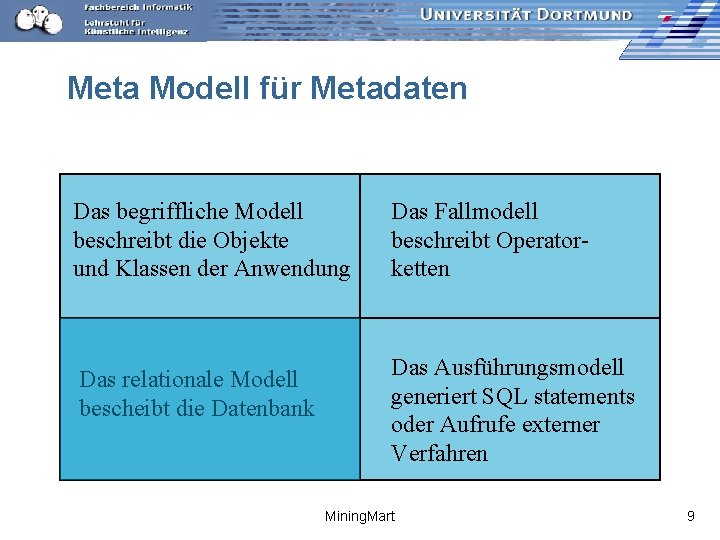

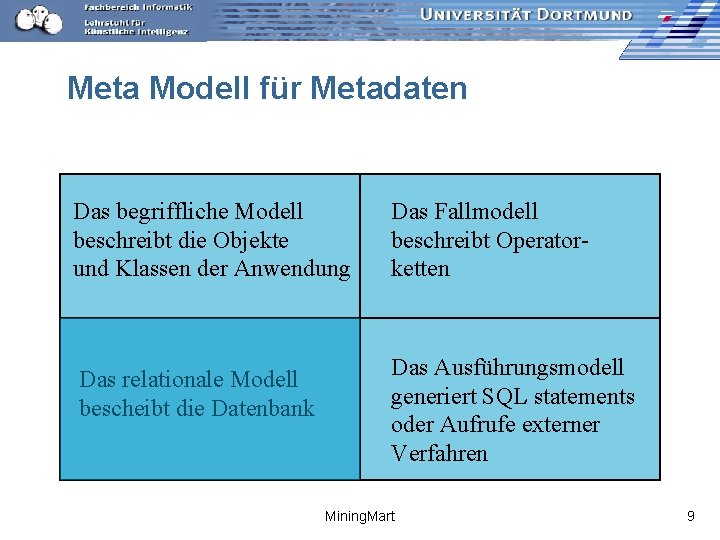

Meta Modell für Metadaten Das begriffliche Modell beschreibt die Objekte und Klassen der Anwendung Das Fallmodell beschreibt Operatorketten Das relationale Modell bescheibt die Datenbank Das Ausführungsmodell generiert SQL statements oder Aufrufe externer Verfahren Mining. Mart 9

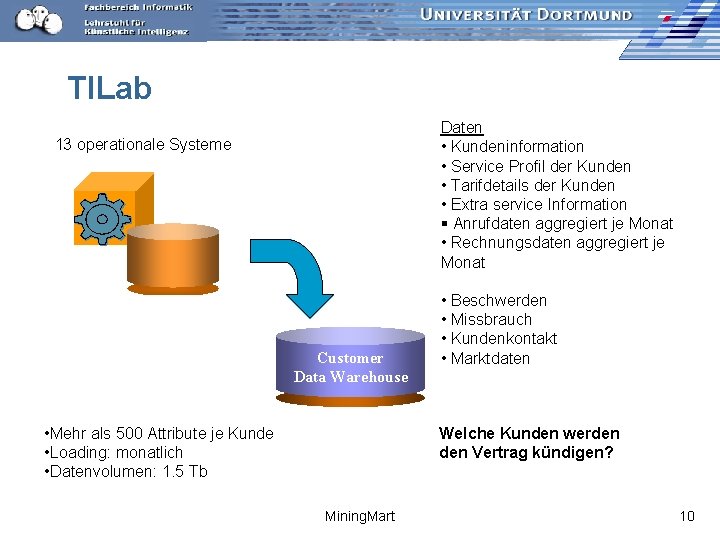

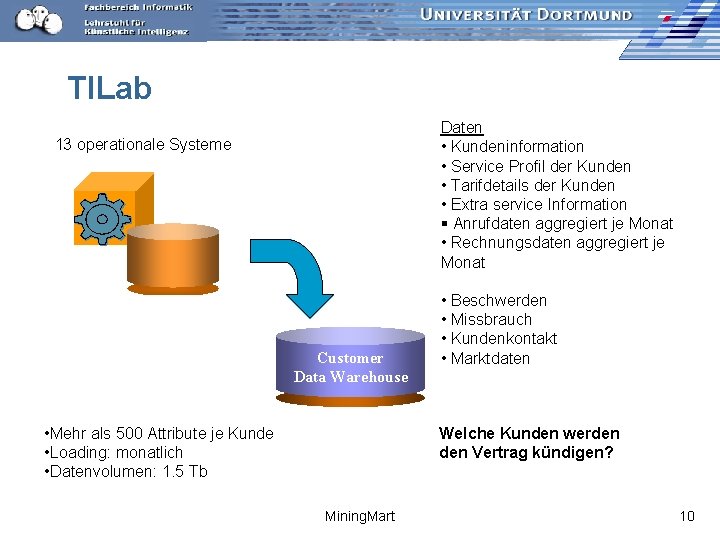

TILab Daten • Kundeninformation • Service Profil der Kunden • Tarifdetails der Kunden • Extra service Information § Anrufdaten aggregiert je Monat • Rechnungsdaten aggregiert je Monat 13 operationale Systeme Customer Data Warehouse • Mehr als 500 Attribute je Kunde • Loading: monatlich • Datenvolumen: 1. 5 Tb • Beschwerden • Missbrauch • Kundenkontakt • Marktdaten Welche Kunden werden Vertrag kündigen? Mining. Mart 10

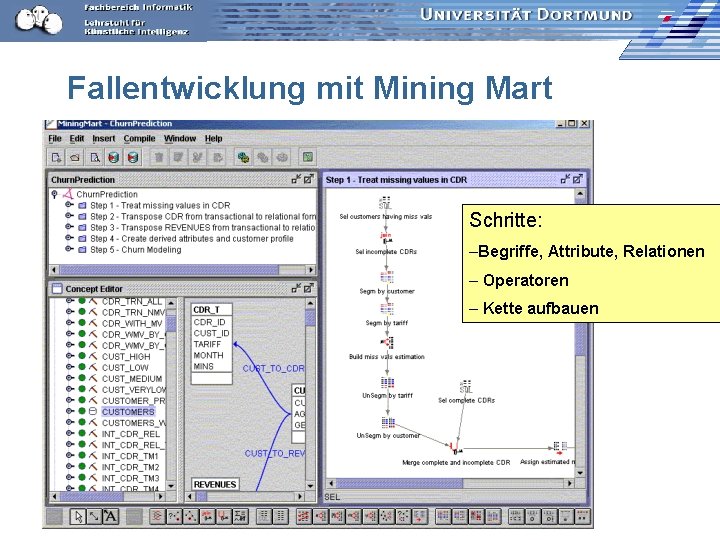

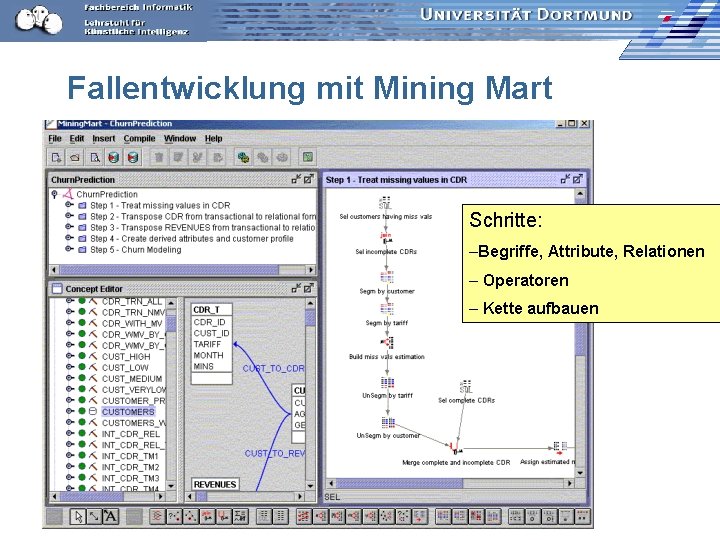

Fallentwicklung mit Mining Mart Schritte: –Begriffe, Attribute, Relationen – Operatoren – Kette aufbauen

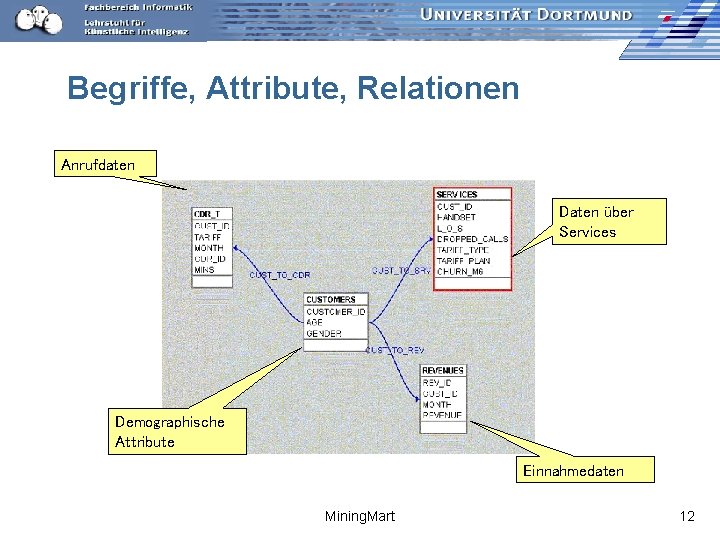

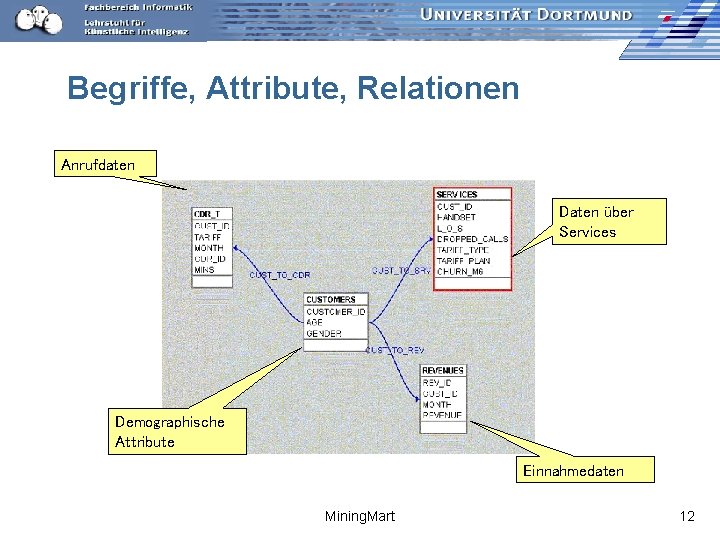

Begriffe, Attribute, Relationen Anrufdaten Daten über Services Demographische Attribute Einnahmedaten Mining. Mart 12

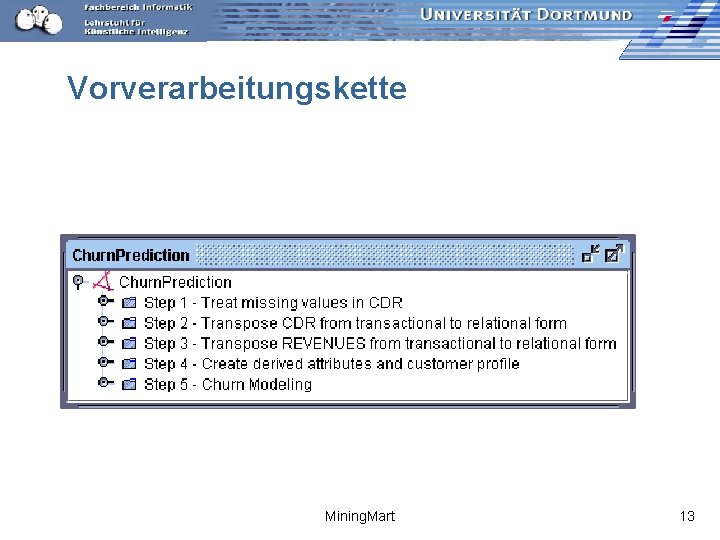

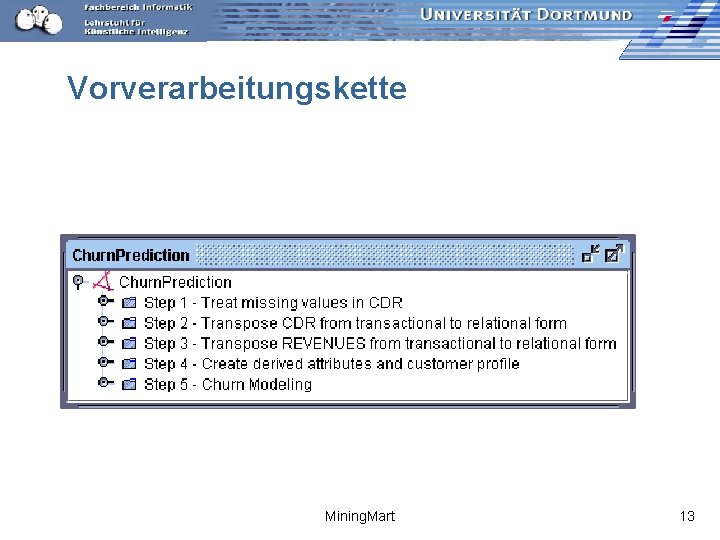

Vorverarbeitungskette Mining. Mart 13

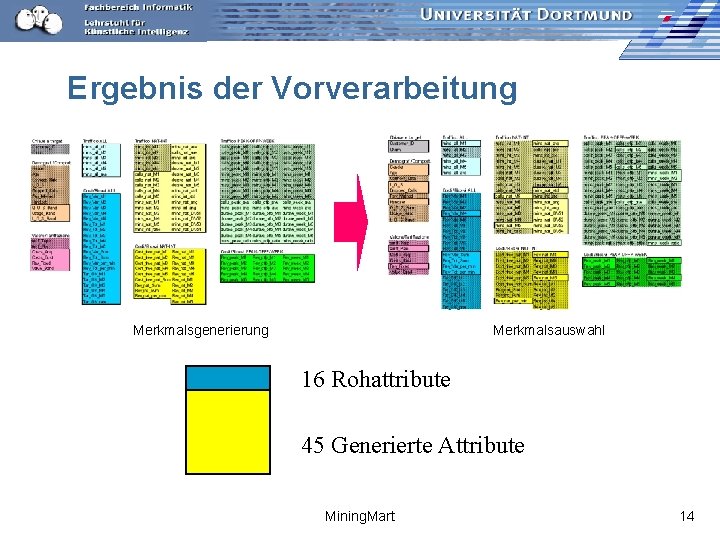

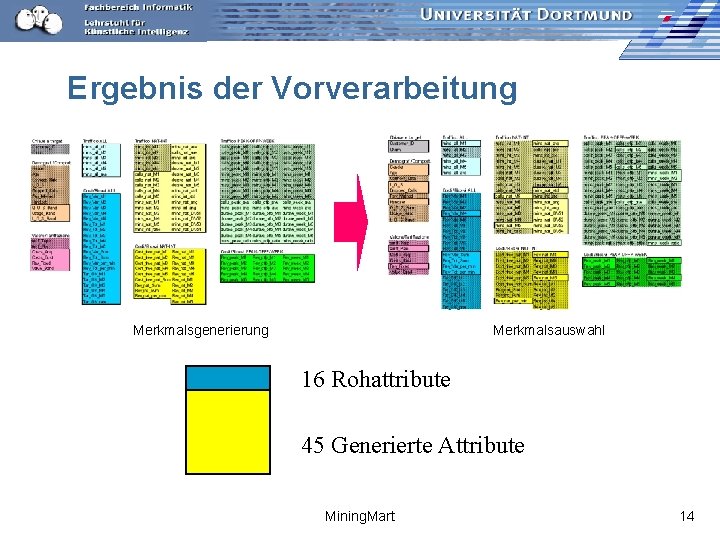

Ergebnis der Vorverarbeitung Merkmalsgenerierung Merkmalsauswahl 16 Rohattribute 45 Generierte Attribute Mining. Mart 14

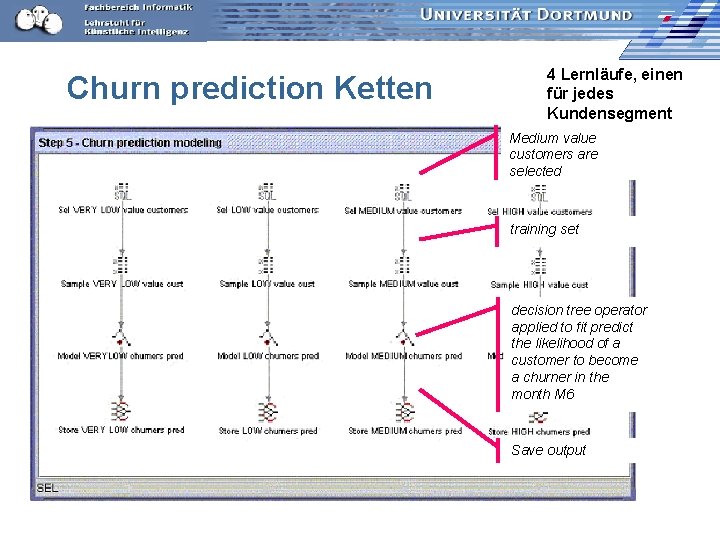

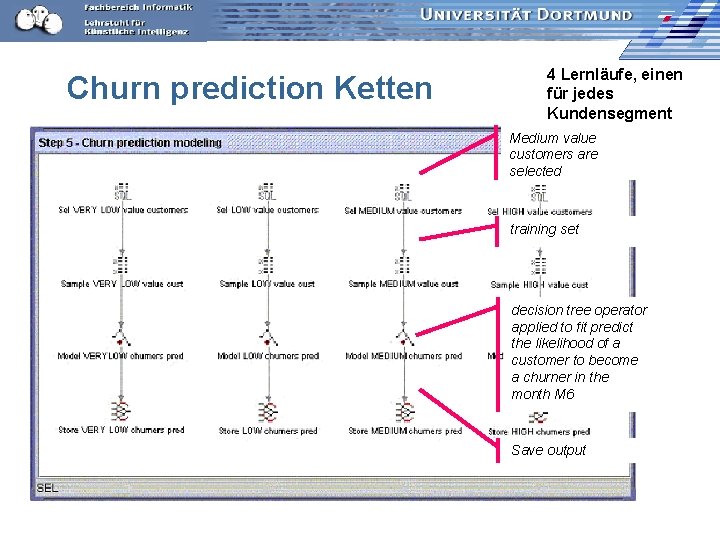

Churn prediction Ketten 4 Lernläufe, einen für jedes Kundensegment Medium value customers are selected training set decision tree operator applied to fit predict the likelihood of a customer to become a churner in the month M 6 Save output

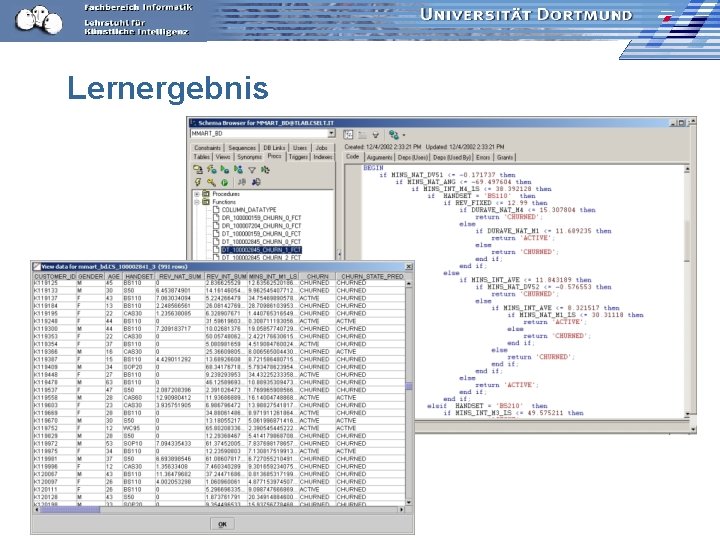

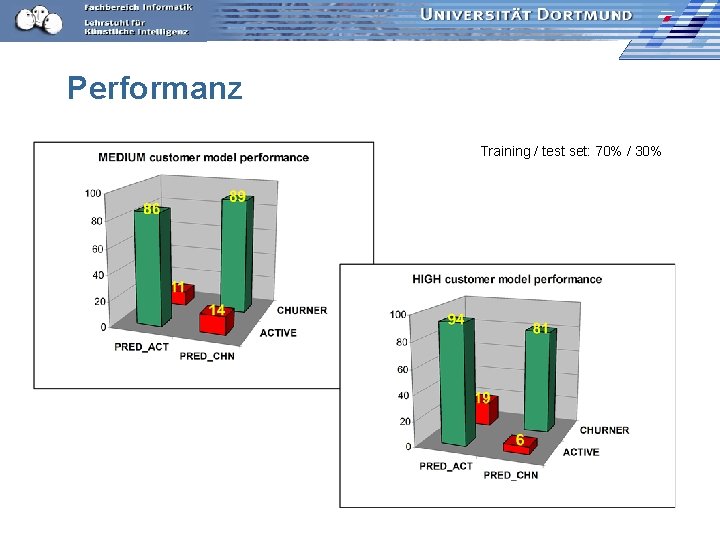

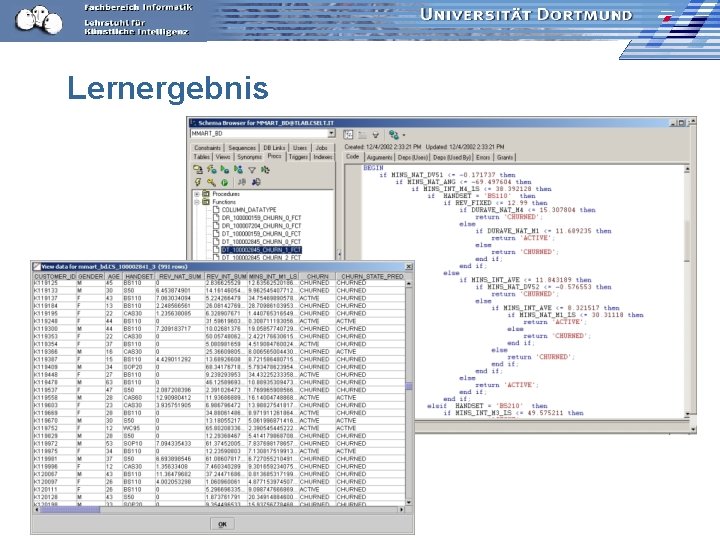

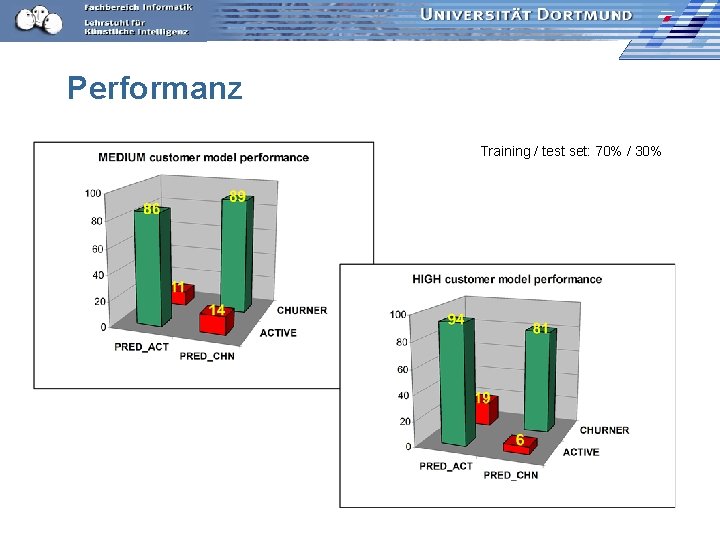

Lernergebnis

Performanz Training / test set: 70% / 30%

Schlussfolgerung von TILab: n n n Speed up for some preprocessing tasks increased by 50% at least. Power users may find Mining Mart as easy to use as the leading commercial dm platforms. It enables building libraries of predefined data mining applications that can be easily modified. Mining. Mart guarantees the highest scalability, since it exploits leading commercial db tools features. Quality of data mining output increases. Bottom line: Mining Mart supports efficiently and effectively the preprocessing stage of a data mining process. Mining. Mart 18

Versicherungsanwendung Versicherung (Swiss. Life): Analyse der Rückkäufe n Daten: n – Auszug aus dem Data Warehouse einer Versicherungsgesellschaft in anonymisierter Form – Oracle-Datenbank, 18 Tabellen und 15 Relationen – Informationen zu Versicherungsverträgen und demographische Daten zu den Partnern – 217 586 Versicherungsverträge und 163 745 Partner n Mit gegebenen Merkmalen Lernergebnis nur max. – Precision: 57% – Recall: 80% Mining. Mart 19

Auszug aus der Versicherungstabelle VVID VVAENDR VVWIVON VVWIBIS VVAENDAT VVAENDART 16423 1 1946 1998 1946 1000 16423 2 1998 27 16423 3 1998 4 16423 4 1998 54 16423 5 1998 4 16423 6 1998 9999 1998 61 5016 1 1997 1999 1997 33 5016 2 1999 2001 1999 33 5016 3 2001 33 5016 4 2001 33 5016 5 2001 2002 2001 81 5016 6 2002 9999 2001 94 . . . Mining. Mart . . . 20

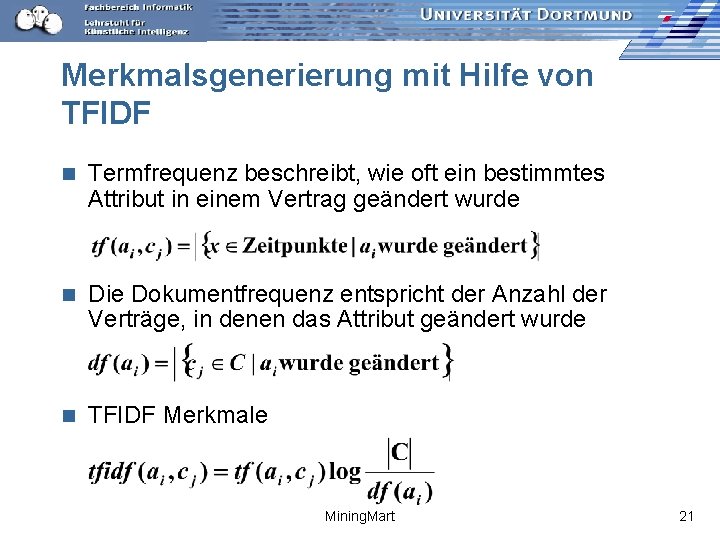

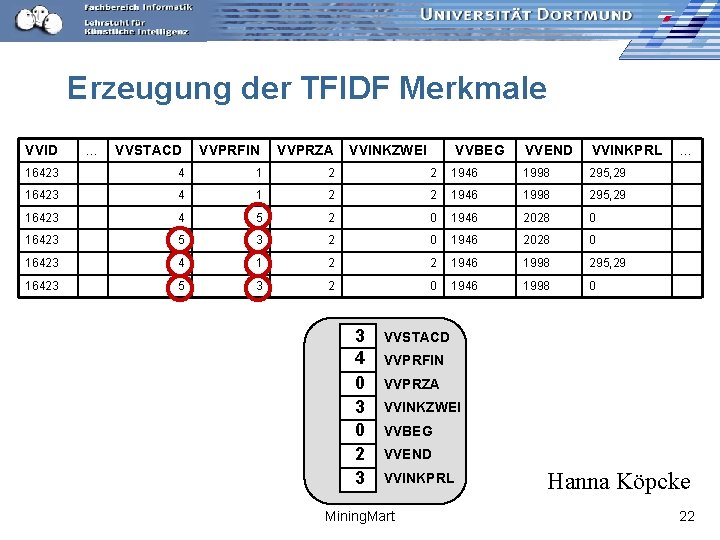

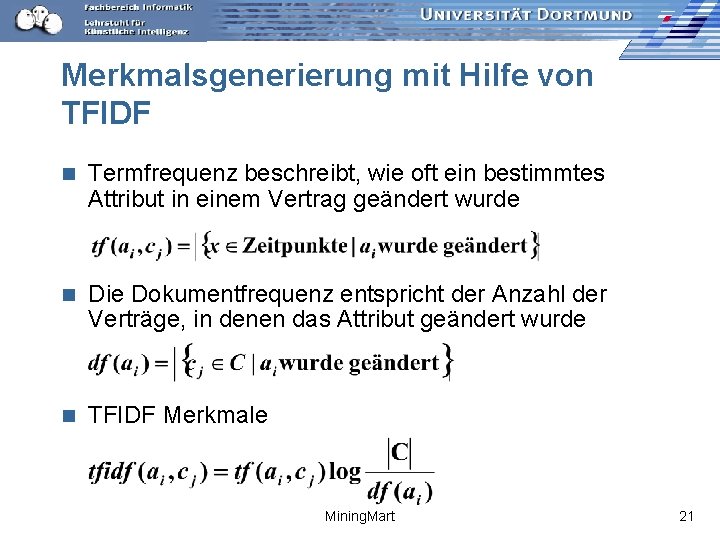

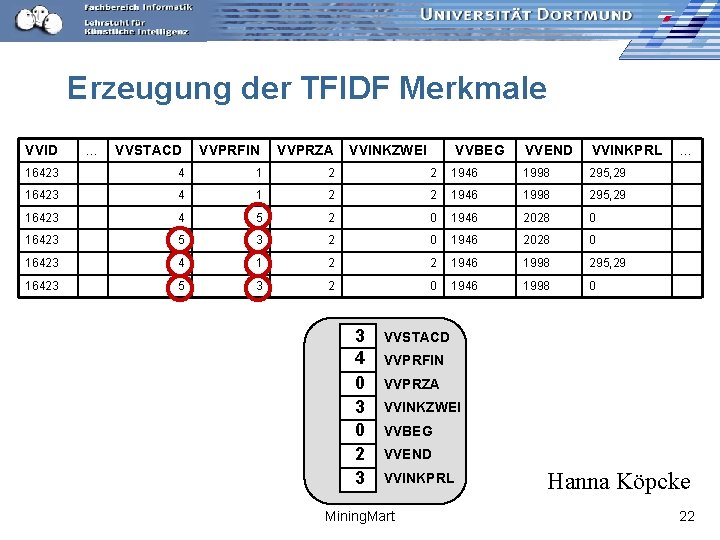

Merkmalsgenerierung mit Hilfe von TFIDF n Termfrequenz beschreibt, wie oft ein bestimmtes Attribut in einem Vertrag geändert wurde n Die Dokumentfrequenz entspricht der Anzahl der Verträge, in denen das Attribut geändert wurde n TFIDF Merkmale Mining. Mart 21

Erzeugung der TFIDF Merkmale VVID . . . VVSTACD VVPRFIN VVPRZA VVINKZWEI VVEND VVINKPRL 16423 4 1 2 2 1946 1998 295, 29 16423 4 5 2 0 1946 2028 0 16423 5 3 2 0 1946 2028 0 16423 4 1 2 2 1946 1998 295, 29 16423 5 3 2 0 1946 1998 0 3 4 0 3 0 2 3 VVBEG . . . VVSTACD VVPRFIN VVPRZA VVINKZWEI VVBEG VVEND VVINKPRL Mining. Mart Hanna Köpcke 22

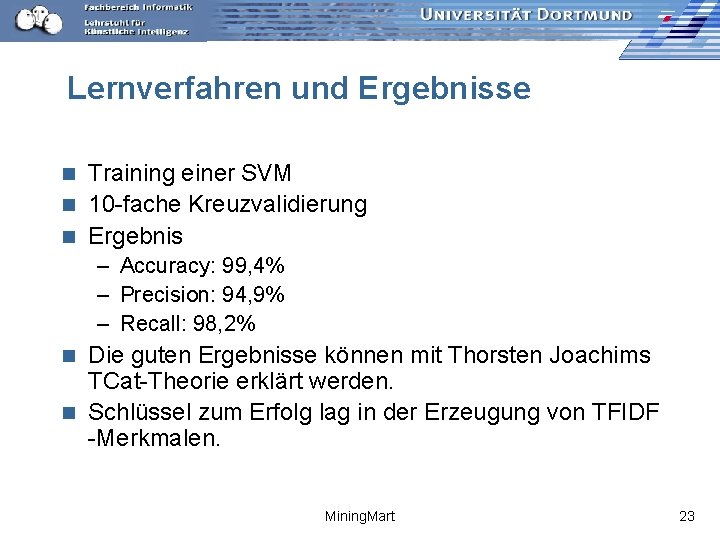

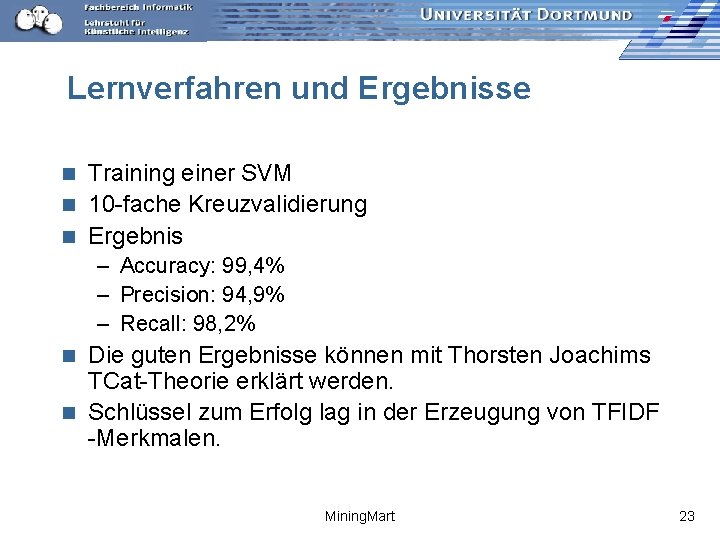

Lernverfahren und Ergebnisse Training einer SVM n 10 -fache Kreuzvalidierung n Ergebnis n – Accuracy: 99, 4% – Precision: 94, 9% – Recall: 98, 2% Die guten Ergebnisse können mit Thorsten Joachims TCat-Theorie erklärt werden. n Schlüssel zum Erfolg lag in der Erzeugung von TFIDF -Merkmalen. n Mining. Mart 23

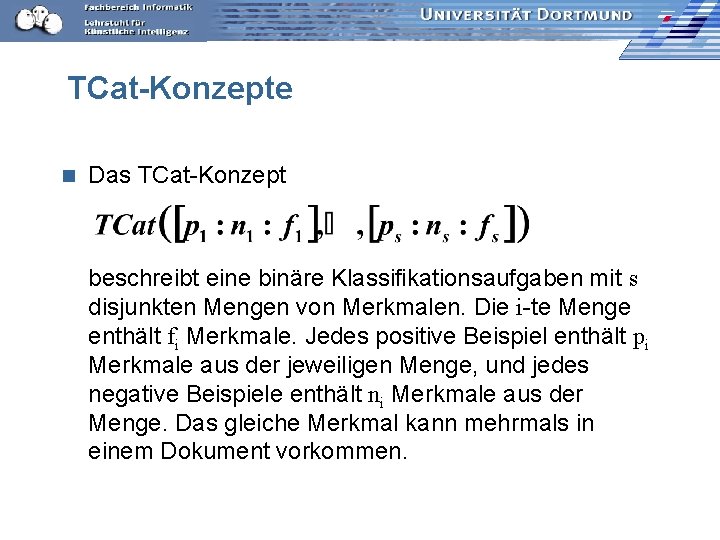

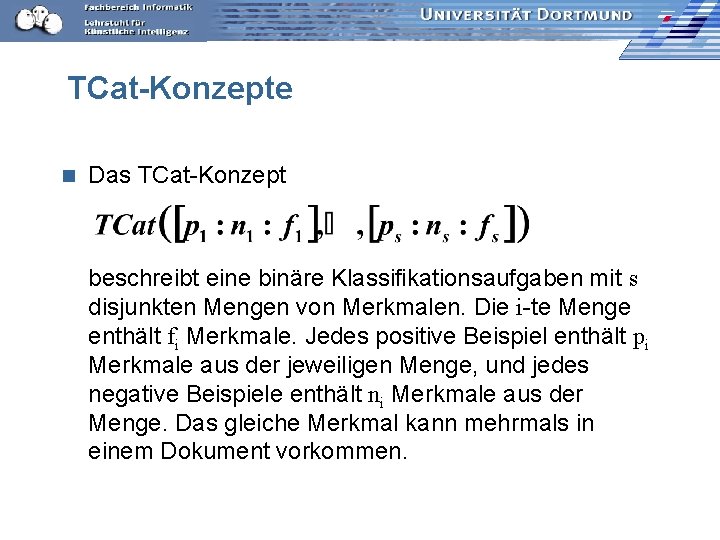

TCat-Konzepte n Das TCat-Konzept beschreibt eine binäre Klassifikationsaufgaben mit s disjunkten Mengen von Merkmalen. Die i-te Menge enthält fi Merkmale. Jedes positive Beispiel enthält pi Merkmale aus der jeweiligen Menge, und jedes negative Beispiele enthält ni Merkmale aus der Menge. Das gleiche Merkmal kann mehrmals in einem Dokument vorkommen.

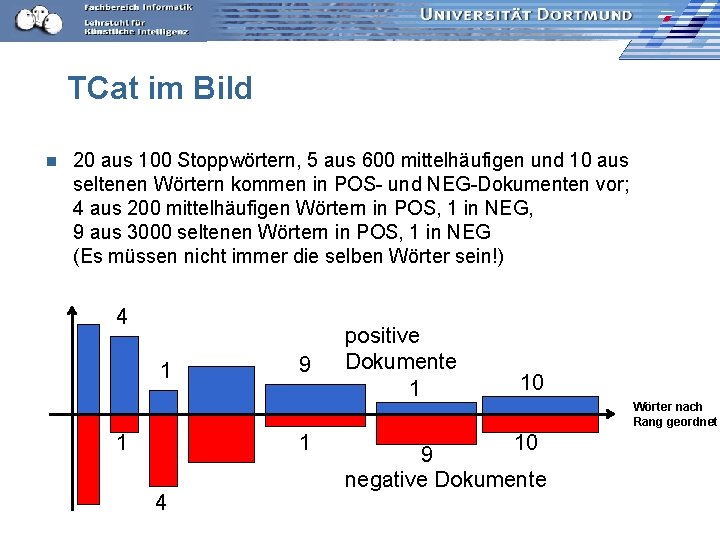

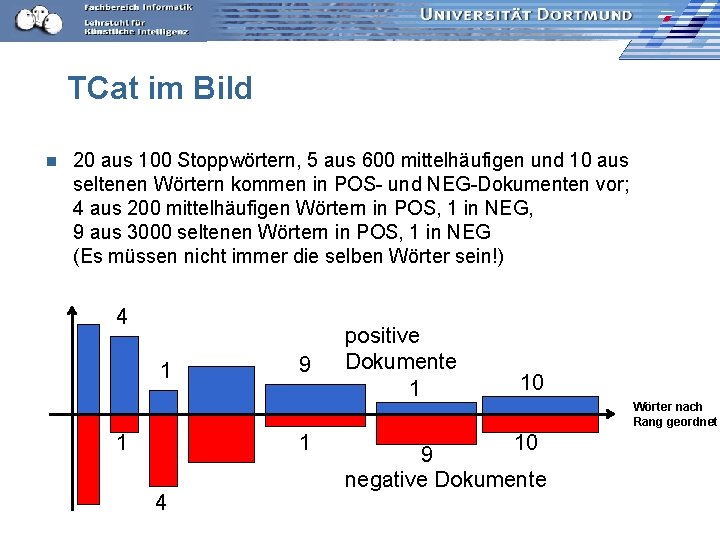

TCat im Bild n 20 aus 100 Stoppwörtern, 5 aus 600 mittelhäufigen und 10 aus seltenen Wörtern kommen in POS- und NEG-Dokumenten vor; 4 aus 200 mittelhäufigen Wörtern in POS, 1 in NEG, 9 aus 3000 seltenen Wörtern in POS, 1 in NEG (Es müssen nicht immer die selben Wörter sein!) 4 1 1 9 1 4 positive Dokumente 1 10 10 9 negative Dokumente Wörter nach Rang geordnet

Lernbarkeit von TCat-Konzepten n Schranke des erwarteten Generalisierungsfehles einer Support Vector Maschine nach Joachims mit

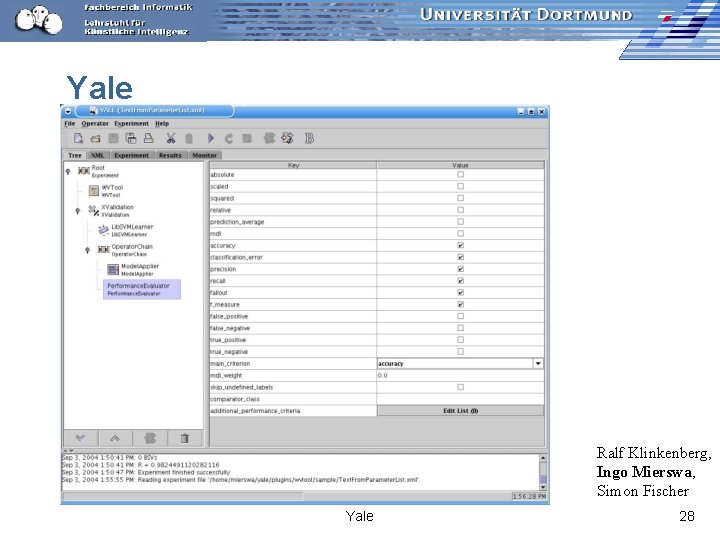

Systemunterstützung durch Yale Experimente sind (geschachtelte) Ketten von Operatoren für Vorverarbeitung, maschinelles Lernen und Evaluation. n Abspeichern der Ketten erlaubt ihre Wiederverwendung mit anderen Parametern: n – Daten: • Datenformat in XML beschrieben • Datei – Lernparameter Yale 27

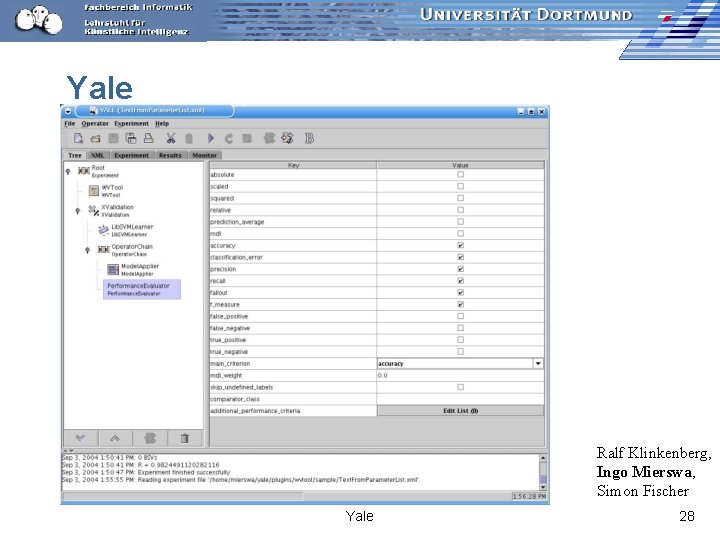

Yale Ralf Klinkenberg, Ingo Mierswa, Simon Fischer Yale 28

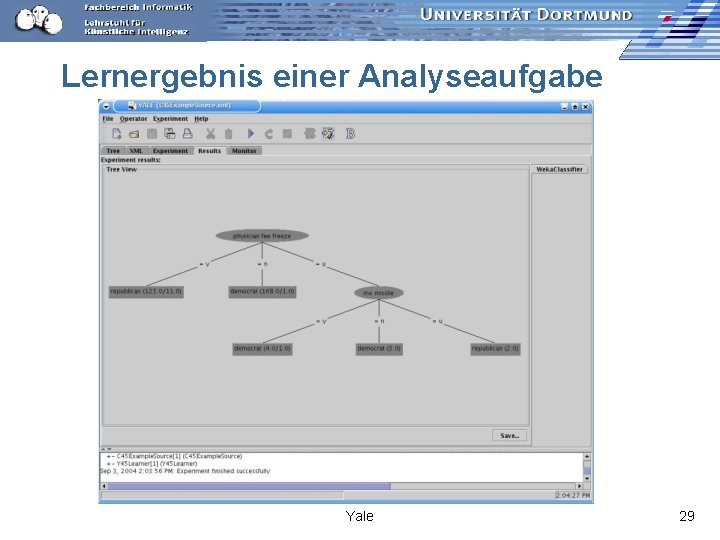

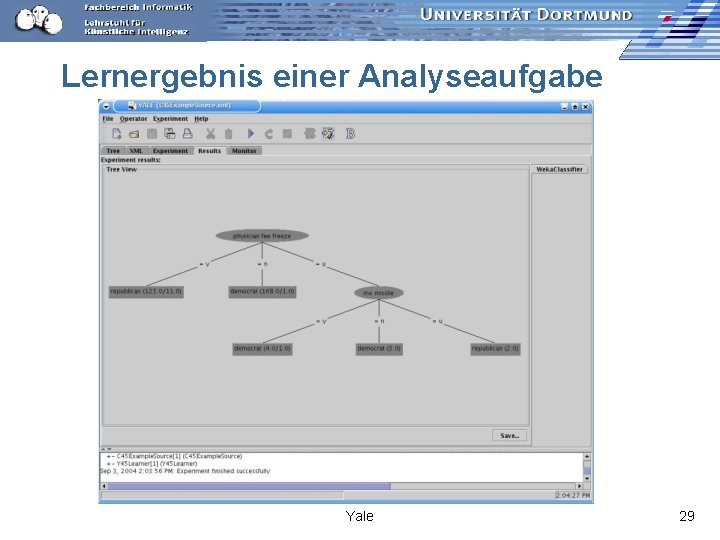

Lernergebnis einer Analyseaufgabe Yale 29

Intelligente Systeme für Musik Automatische Annotation von Musik Lernen von Metadaten n Klassifikation von Musik nach n – Genre (nur noch als benchmark) – Benutzerpräferenzen – Gelegenheiten Automatische Organisation von Sammlungen n Empfehlungen z. B. EU-Projekt SIMAC http: //www. semanticaudio. org/ n Yale 30

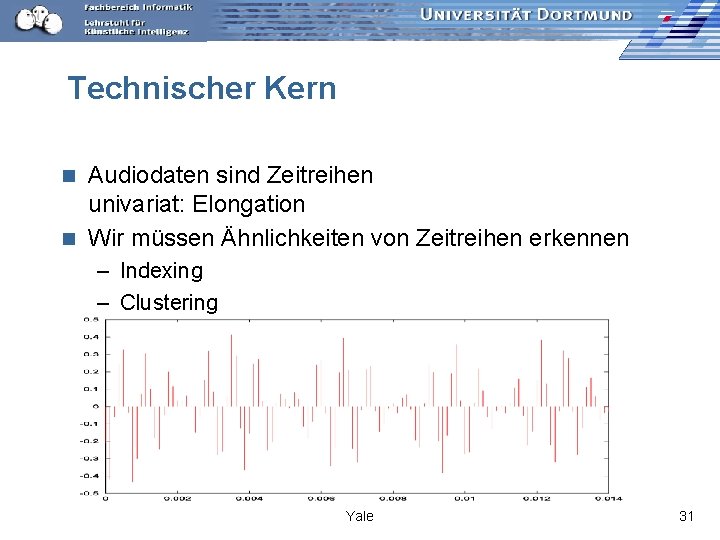

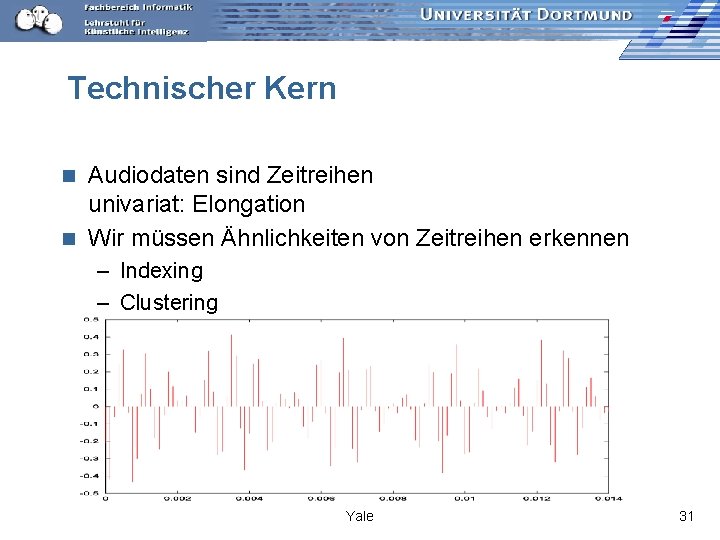

Technischer Kern Audiodaten sind Zeitreihen univariat: Elongation n Wir müssen Ähnlichkeiten von Zeitreihen erkennen n – Indexing – Clustering Yale 31

Clustering von Zeitreihen – Standard So passen ähnliche Musikstücke nicht! Yale 32

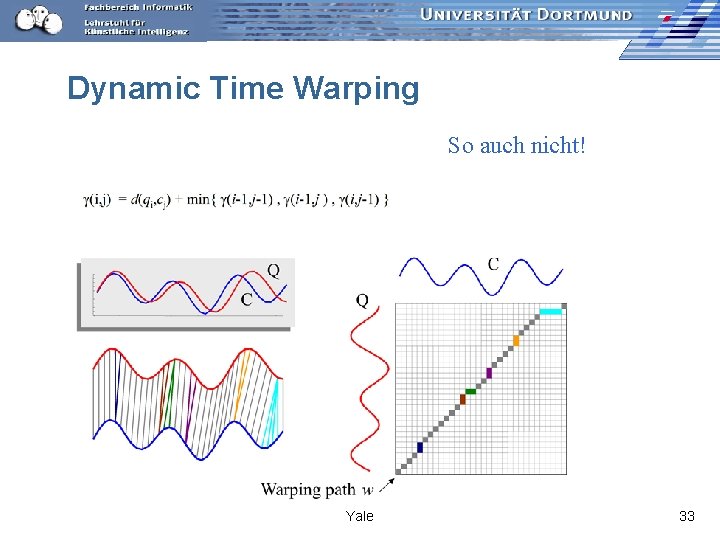

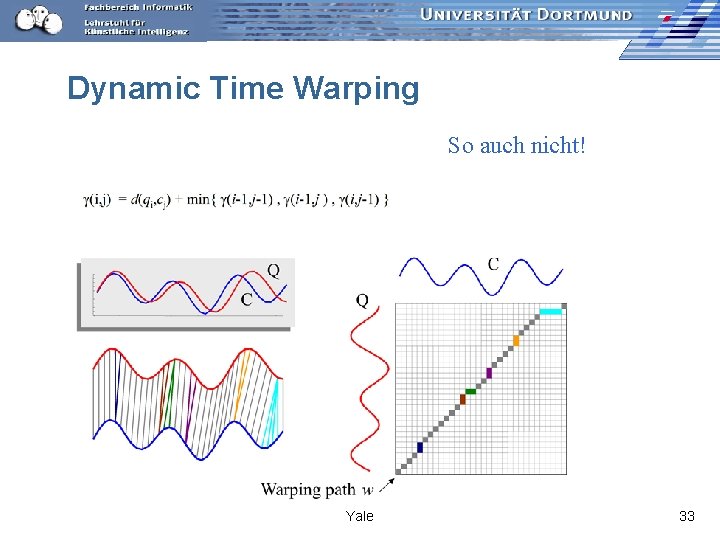

Dynamic Time Warping So auch nicht! Yale 33

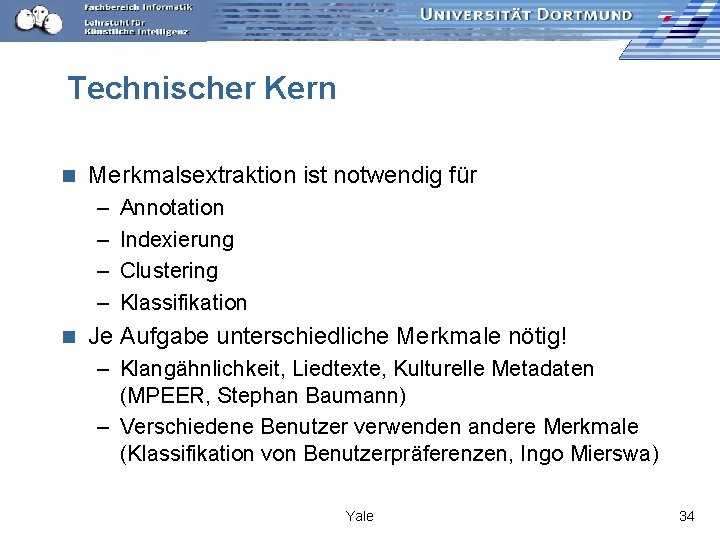

Technischer Kern n Merkmalsextraktion ist notwendig für – – n Annotation Indexierung Clustering Klassifikation Je Aufgabe unterschiedliche Merkmale nötig! – Klangähnlichkeit, Liedtexte, Kulturelle Metadaten (MPEER, Stephan Baumann) – Verschiedene Benutzer verwenden andere Merkmale (Klassifikation von Benutzerpräferenzen, Ingo Mierswa) Yale 34

Low Level Descriptors n n n Lautstärke Spectral Centroid (Cepstral) Mel Frequency Cepstral Coefficient (MFCC) Zero Crossing Rate Peaks: Amplitude, Zweithöchster/ Höchsten, Intervall zwischen Zweithöchstem und Höchstem Yale 35

High-Level Descriptors Genre n Stimmung: glücklich, traurig, neutral n Tempo: sehr langsam – sehr schnell, variierend n Komplexität: gering, mittel, hoch n Gefühl: sanft, neutral, aggressiv n Fokus: Gesang, beides, Instrument Lernaufgabe: Klassifikation nach HLD, gegeben LLD Ergebnis: klappt nicht! Pohle et al. 2005 n Yale 36

Merkmalsextraktion lernen lassen! Zils, A. Pachet, F. 2004. Automatic Extraction of Music Descriptors from Acoustic Signals. ISMIR n Mierswa, I. Morik, K. 2005. Automatic Feature Extraction for Classifying Audio Data. Machine Learning Journal, 58, 127 - 149. n Genetische Programmierung zur Optimierung der Merkmalsextraktion für eine Lernaufgabe! n Einzelbestandteile der LLD kombinieren lassen zu einem Merkmalsbaum, der ein Merkmal extrahiert. n Yale 37

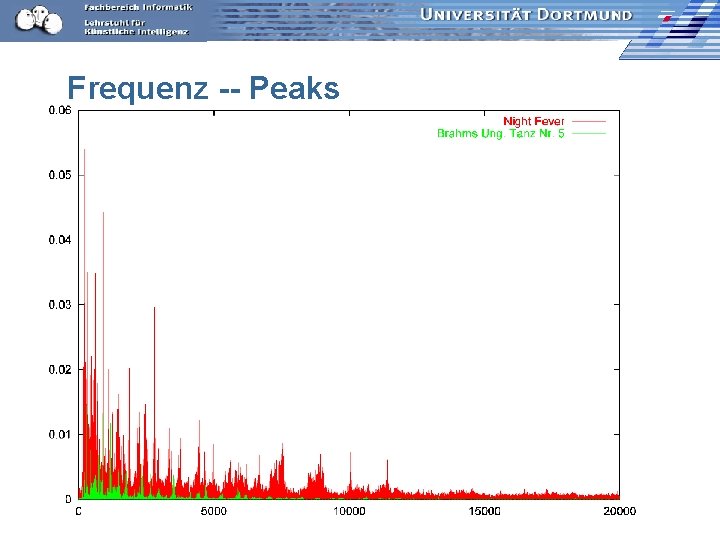

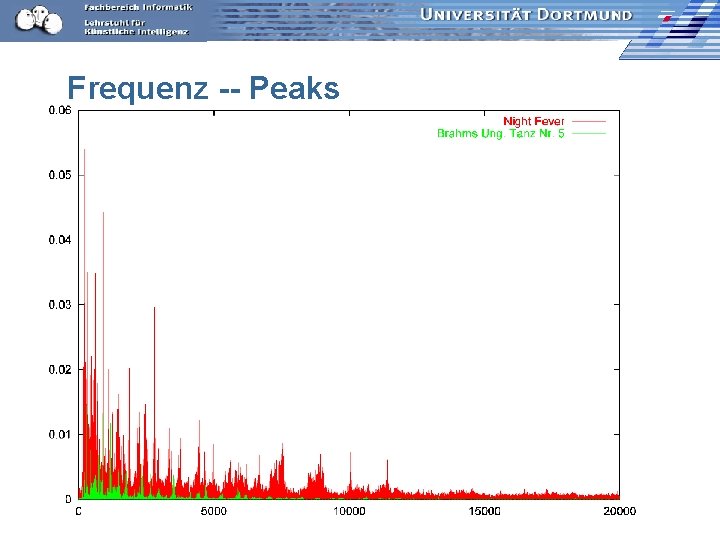

Frequenz -- Peaks

Frequenz -- Stärkste Frequenz

Intervalle im Frequenzbereich

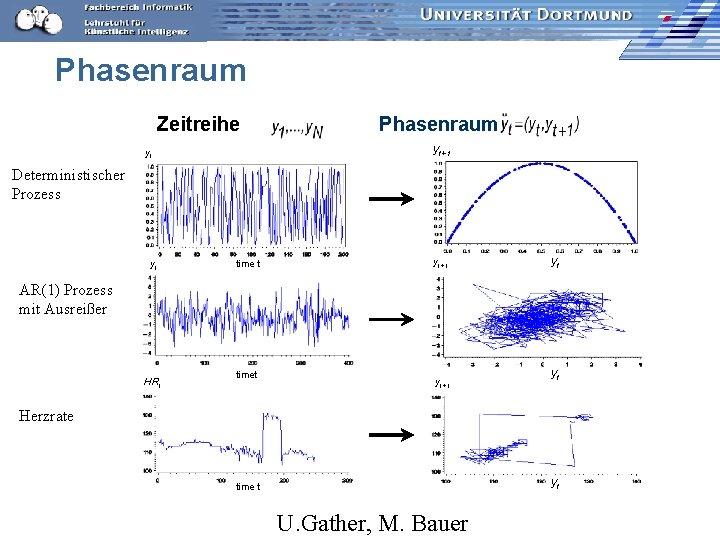

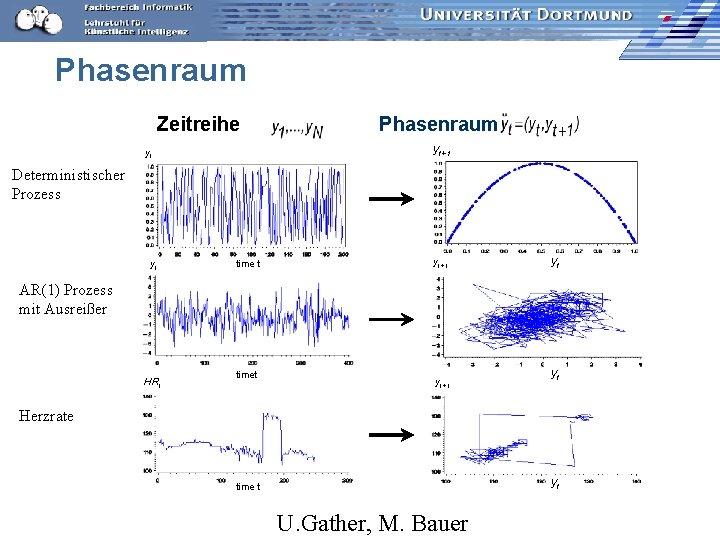

Phasenraum Zeitreihe Phasenraum yt+1 yt Deterministischer Deter. Prozess ministic Process yt time t yt+1 yt AR(1)-process AR(1) Prozess with mit outlier Ausreißer (AO) HRt timet yt+1 yt Herzrate Heart rate yt time t U. Gather, M. Bauer

Audiodaten: Phasenraum Pop

Audiodaten: Phasenraum Klassik

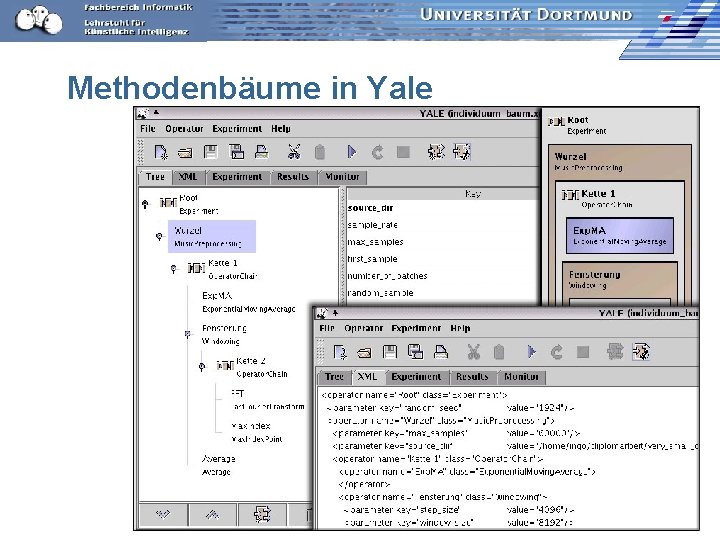

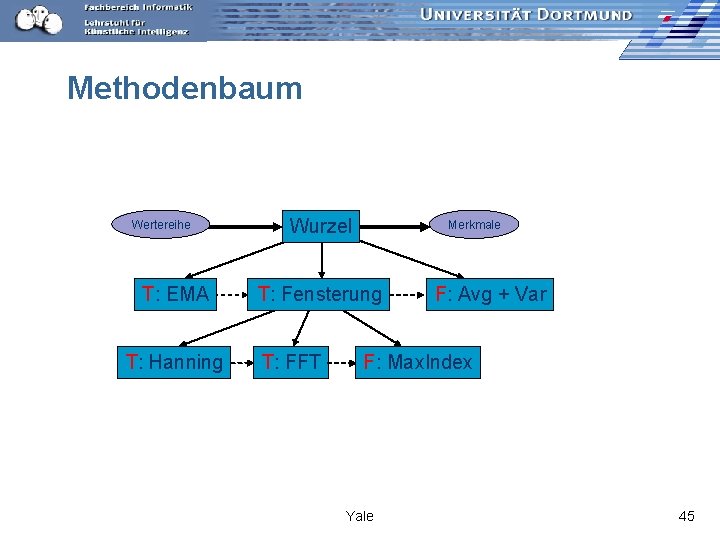

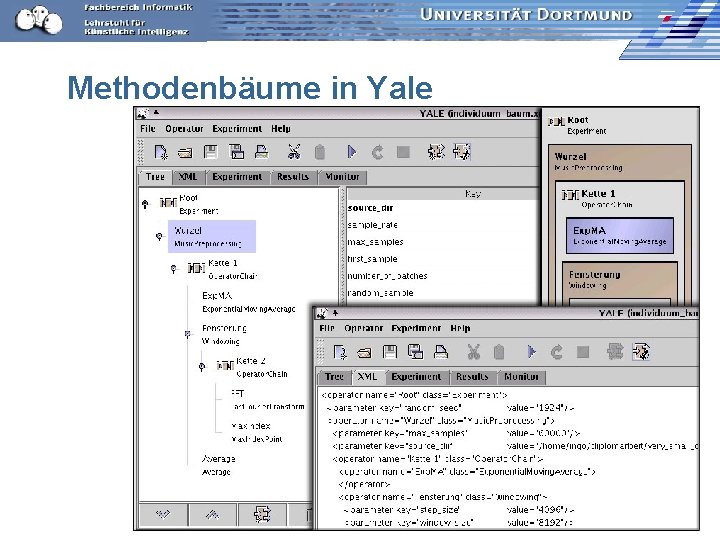

Darstellung der geeigneten Transformationen für eine Aufgabe n Methodenbaum: – Reihe von Transformationen, durch ein Funktional abgeschlossen • Transformationen von Wertereihen in Wertereihen • Transformation in einen anderen Raum – Fensterung ist eine Transformation, die selbst wieder ein Methodenbaum ist n Aufbau eines Methodenbaums: – Dynamische Fensterung erzeugt neue Teilbäume n Anwendung eines Methodenbaums erzeugt Merkmale für eine gegebene Wertereihe Yale 44

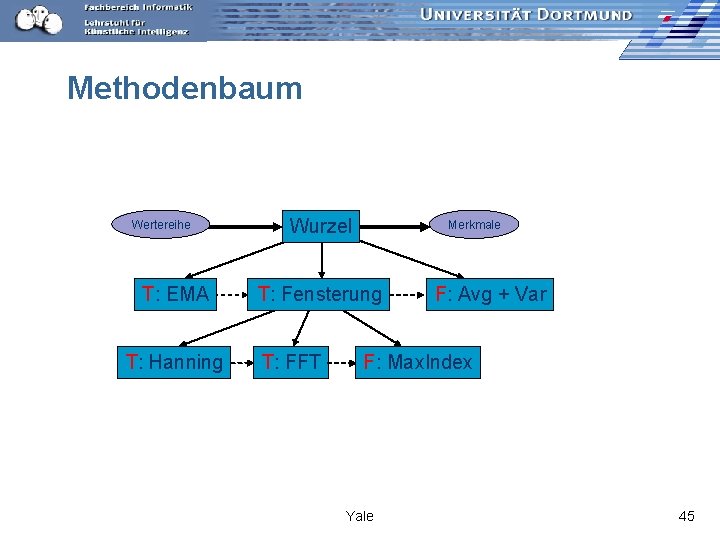

Methodenbaum Wertereihe T: EMA T: Hanning Wurzel Merkmale T: Fensterung T: FFT F: Avg + Var F: Max. Index Yale 45

Lernen eines Methodenbaums für eine Aufgabe mit genetischer Programmierung Training der Merkmalsextraktion auf Teilmenge der Daten. n Anwendung der Merkmalsextraktion auf alle Daten für die Lösung einer Lernaufgabe. n Genetische Programmierung: n – Individuen: Methodenbäume – Fitness durch Kreuzvalidierung der jeweiligen Lernaufgabe nach Vorverarbeitung durch das zu evaluierende Individuum. Yale 46

Jede Aufgabe verlangt andere Merkmale Pop vs. Klassik: durchschnittliche Länge nach einer Phasenraumtransformation bestes Merkmal; korrekte Klassifikation von 184 der 200 Instanzen n Pop vs. Techno: Varianz der Extremadifferenz als bestes Merkmal; korrekte Klassifikation von 132 der 160 Instanzen. n Benutzerpräferenzen: jeder Benutzer braucht andere Merkmale! 84, 5 -- 95, 2 accuracy 85, 9 – 98, 3 precision 83, 7 – 99, 0 recall n Yale 47

Experimente zum Lernen mit Merkmalstransformation Lernen des Methodenbaums für eine Aufgabe: Ergebnis diese Lernlaufs ist ein Yale-Experiment. n Durchführung des gelernten Yale-Experiments. n Lernen der Analyseaufgabe mit den gelernten Merkmalen. n Yale 48

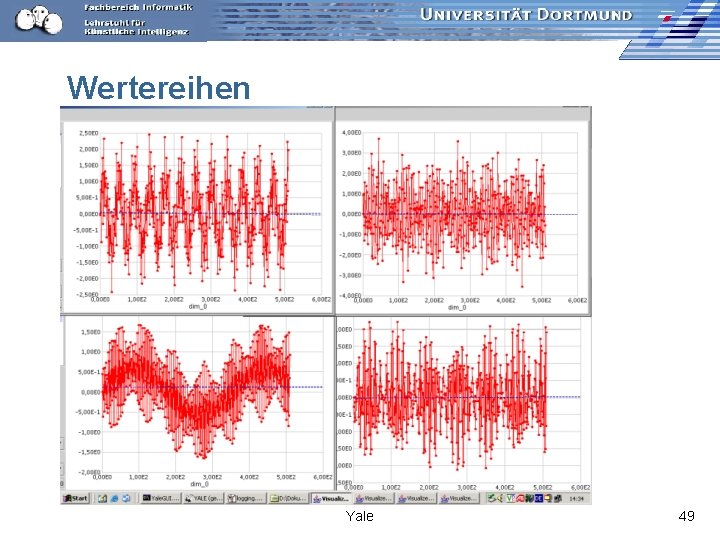

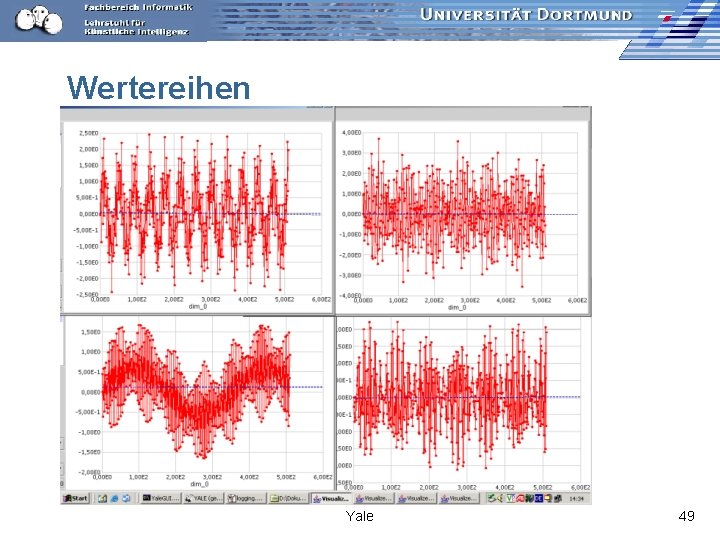

Wertereihen Yale 49

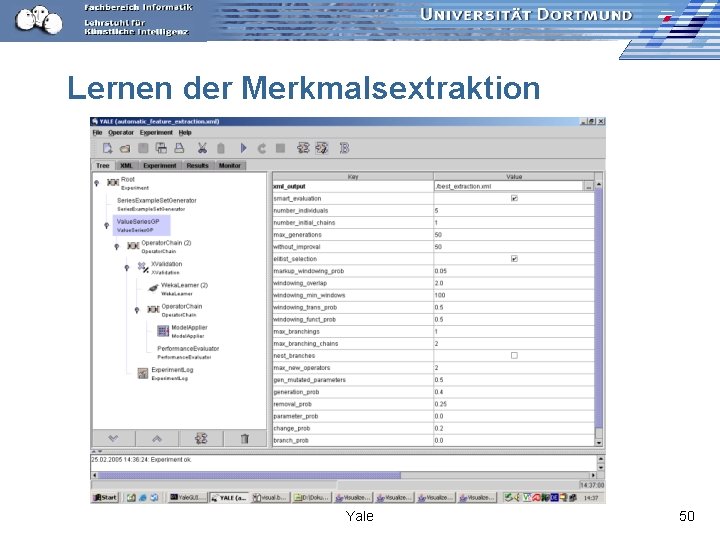

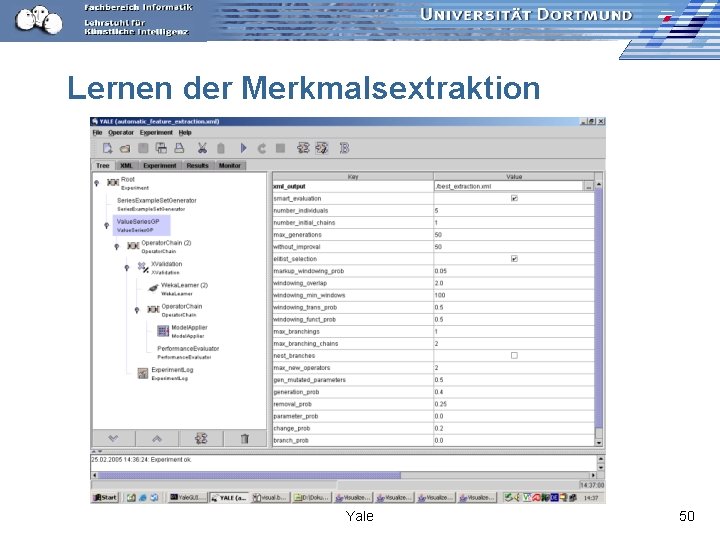

Lernen der Merkmalsextraktion Yale 50

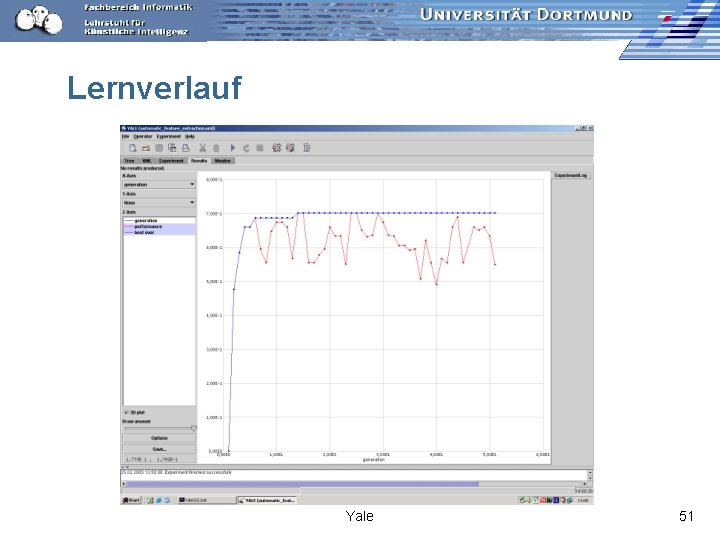

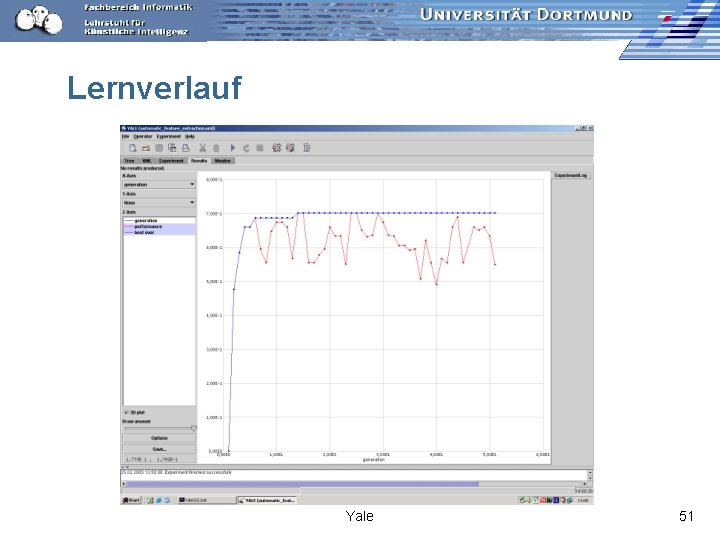

Lernverlauf Yale 51

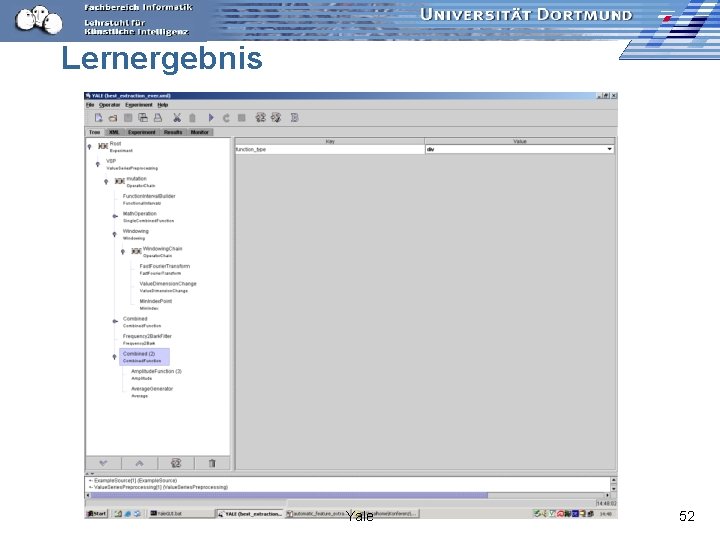

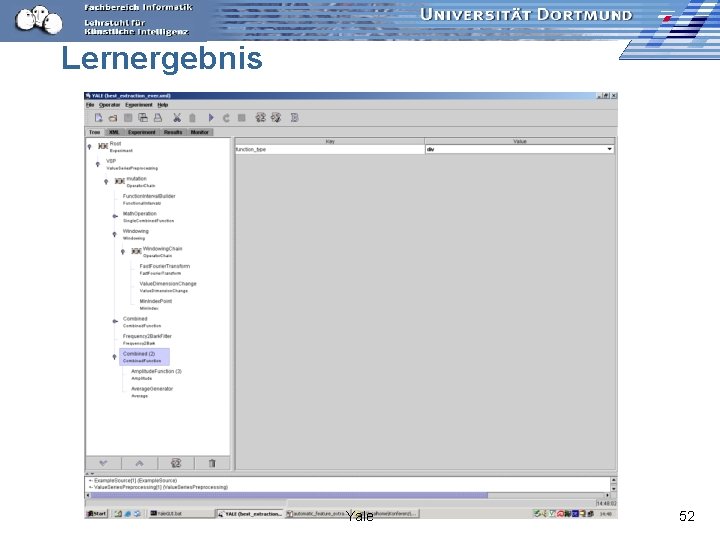

Lernergebnis Yale 52

Methodenbäume in Yale

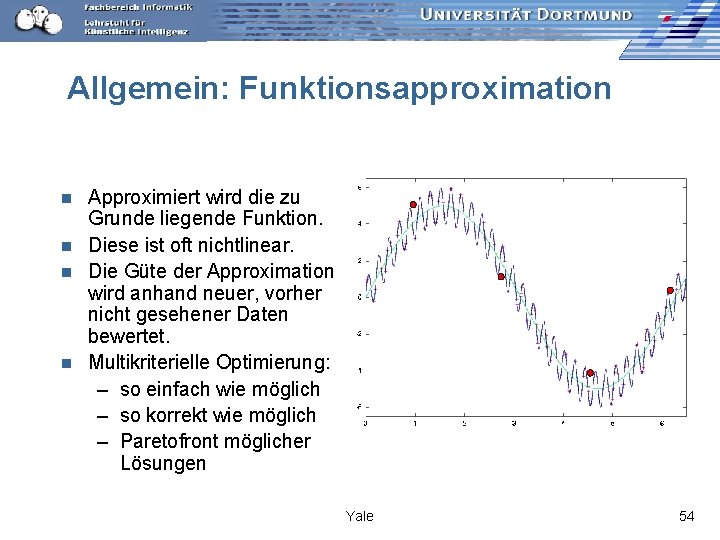

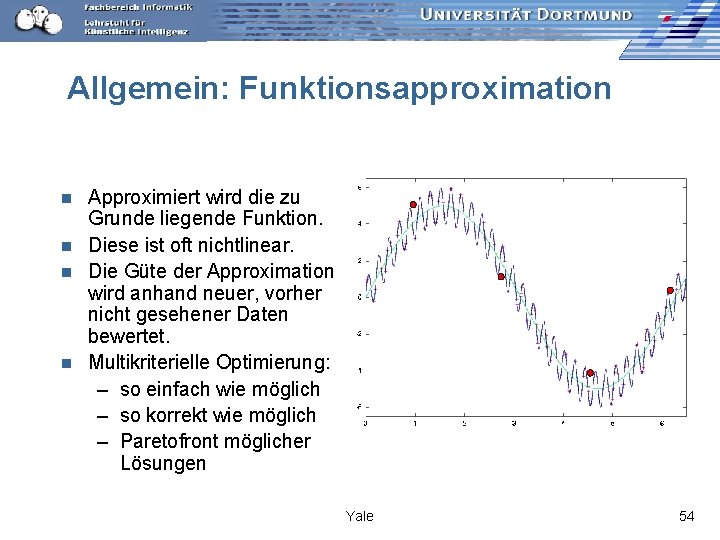

Allgemein: Funktionsapproximation Approximiert wird die zu Grunde liegende Funktion. n Diese ist oft nichtlinear. n Die Güte der Approximation wird anhand neuer, vorher nicht gesehener Daten bewertet. n Multikriterielle Optimierung: – so einfach wie möglich – so korrekt wie möglich – Paretofront möglicher Lösungen n Yale 54

Nemoz Klassifikation Clustering NEtwork Media Organi. Zer: Collaborative clustering in P 2 P networks Kopieren Einbindung von Yale Stöbern gemäß eigener Präferen zen

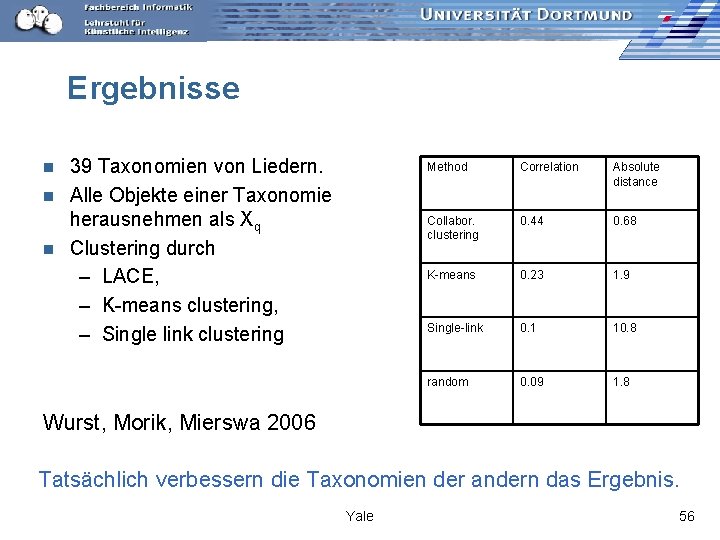

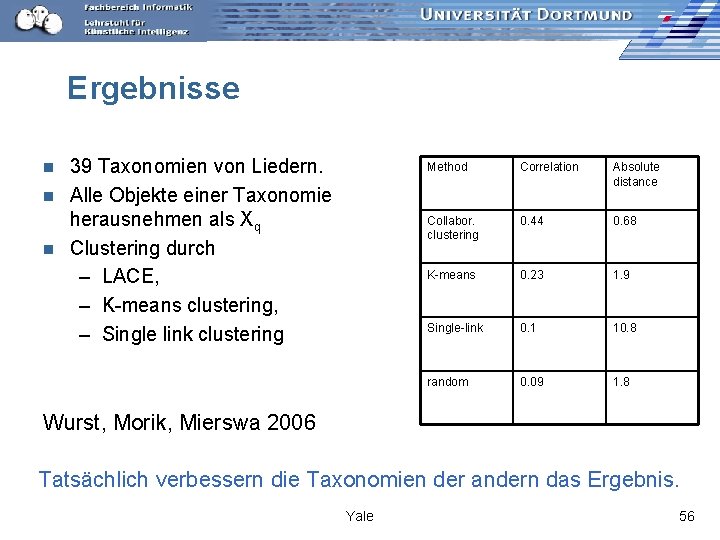

Ergebnisse 39 Taxonomien von Liedern. n Alle Objekte einer Taxonomie herausnehmen als Xq n Clustering durch – LACE, – K-means clustering, – Single link clustering n Method Correlation Absolute distance Collabor. clustering 0. 44 0. 68 K-means 0. 23 1. 9 Single-link 0. 1 10. 8 random 0. 09 1. 8 Wurst, Morik, Mierswa 2006 Tatsächlich verbessern die Taxonomien der andern das Ergebnis. Yale 56

Zusammenfassung n Erzeugte Merkmale ermöglichen erst Lernerfolg in vielen Anwendungen. – Telekommunikation – Versicherung n Musikdaten sind der Härtetest für Merkmalsextraktion – Verschiedene Merkmalsextraktion je konkreter Lernaufgabe – Komplizierte Ähnlichkeitsmaße n Lernen der Merkmalsextraktion – LLD dekomponieren zu einfachen Bausteinen – HLD als Methodenbaum

Credo Vorverarbeitung ist entscheidend für die Qualität der Wissensentdeckung. n Vorverarbeitung ist aufwändig und schwierig, daher Wiederverwendung wichtig. n – Abstraktion durch Metadaten (Mining. Mart) bzw. Experimente (Yale) Vielen Dank für Ihre Aufmerksamkeit!

Mining complex types of data in data mining

Mining complex types of data in data mining Zum fressen geboren zum kraulen bestellt

Zum fressen geboren zum kraulen bestellt Lisa lustich

Lisa lustich Mining multimedia databases in data mining

Mining multimedia databases in data mining Strip mining vs open pit mining

Strip mining vs open pit mining Chapter 13 mineral resources and mining worksheet answers

Chapter 13 mineral resources and mining worksheet answers Difference between strip mining and open pit mining

Difference between strip mining and open pit mining Difference between text mining and web mining

Difference between text mining and web mining Data reduction in data mining

Data reduction in data mining Data mining in data warehouse

Data mining in data warehouse What is missing data in data mining

What is missing data in data mining Concept hierarchy generation for nominal data

Concept hierarchy generation for nominal data Data reduction in data mining

Data reduction in data mining Data reduction in data mining

Data reduction in data mining Shell cube in data mining

Shell cube in data mining Data reduction in data mining

Data reduction in data mining Perbedaan data warehouse dan data mining

Perbedaan data warehouse dan data mining Data mining dan data warehouse

Data mining dan data warehouse Analitical cubism

Analitical cubism Mining complex data objects

Mining complex data objects Data warehousing data mining and olap

Data warehousing data mining and olap Noisy data in data mining

Noisy data in data mining Two tier architecture of data warehouse

Two tier architecture of data warehouse Markku roiha

Markku roiha Data compression in data mining

Data compression in data mining Introduction to data mining and data warehousing

Introduction to data mining and data warehousing Data warehouse dan data mining

Data warehouse dan data mining Cs 412 introduction to data mining

Cs 412 introduction to data mining Unsupervised learning in data mining

Unsupervised learning in data mining Motivation and importance of data mining

Motivation and importance of data mining Data mining concepts and techniques slides

Data mining concepts and techniques slides Query tools in data mining

Query tools in data mining Pump it up: data mining the water table

Pump it up: data mining the water table Proses data mining

Proses data mining Algoritma estimasi yang biasa digunakan adalah

Algoritma estimasi yang biasa digunakan adalah Olap stands for *

Olap stands for * Bloom filter for stream data mining

Bloom filter for stream data mining Data mining steps

Data mining steps Data mining midterm exam with solutions

Data mining midterm exam with solutions Multidimensional space in data mining

Multidimensional space in data mining Data mining roadmap

Data mining roadmap Pentaho data mining

Pentaho data mining Spatial data mining applications

Spatial data mining applications Walmart data mining

Walmart data mining Ibm data mining

Ibm data mining Ibm spss data mining

Ibm spss data mining Mining frequent itemsets using vertical data format

Mining frequent itemsets using vertical data format Gini index

Gini index Emr data mining

Emr data mining Cur decomposition in data mining

Cur decomposition in data mining Dss in data mining

Dss in data mining Data maining

Data maining Underfitting and overfitting in data mining

Underfitting and overfitting in data mining Svd data mining

Svd data mining Data mining lectures

Data mining lectures Data mining functionalities

Data mining functionalities Collection of data objects

Collection of data objects Correlation data mining

Correlation data mining Types of attributes in data mining

Types of attributes in data mining