Ajuste de curvas S 1 2 5 2

![Ajuste de curvas [S] : 1. 2 5. 2 6. 3 7. 2 v Ajuste de curvas [S] : 1. 2 5. 2 6. 3 7. 2 v](https://slidetodoc.com/presentation_image_h/24659293ed88370d07690127cf0686b7/image-1.jpg)

- Slides: 29

![Ajuste de curvas S 1 2 5 2 6 3 7 2 v Ajuste de curvas [S] : 1. 2 5. 2 6. 3 7. 2 v](https://slidetodoc.com/presentation_image_h/24659293ed88370d07690127cf0686b7/image-1.jpg)

Ajuste de curvas [S] : 1. 2 5. 2 6. 3 7. 2 v : 4. 3 5. 4 7. 2 8. 4 9. 5 v v = f[S] Modelo Empírico En matemáticas: y = f(x) Ajuste de curvas Modelo Teórico

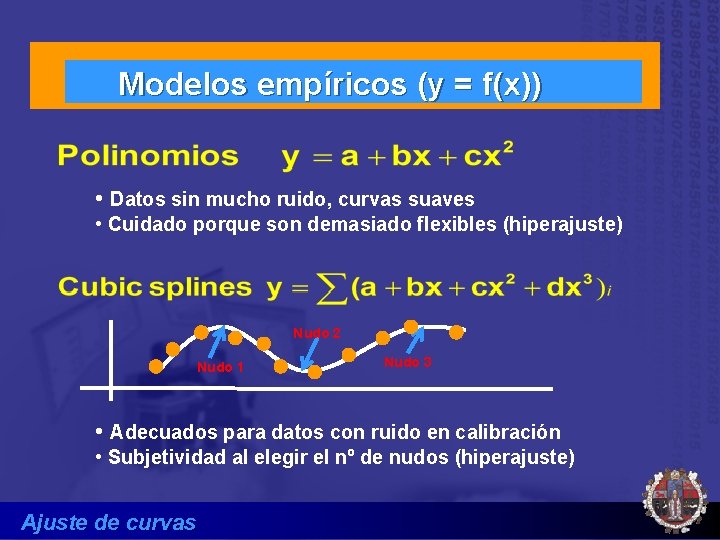

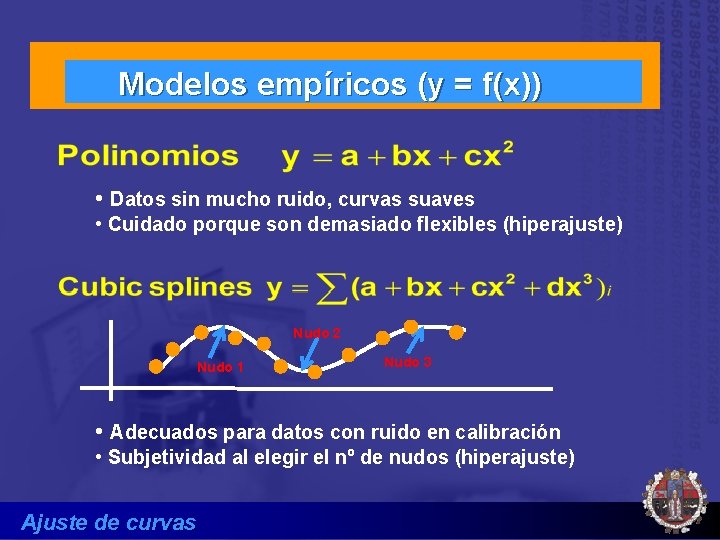

Modelos empíricos (y = f(x)) • Datos sin mucho ruido, curvas suaves • Cuidado porque son demasiado flexibles (hiperajuste) Nudo 2 Nudo 1 Nudo 3 • Adecuados para datos con ruido en calibración • Subjetividad al elegir el nº de nudos (hiperajuste) Ajuste de curvas

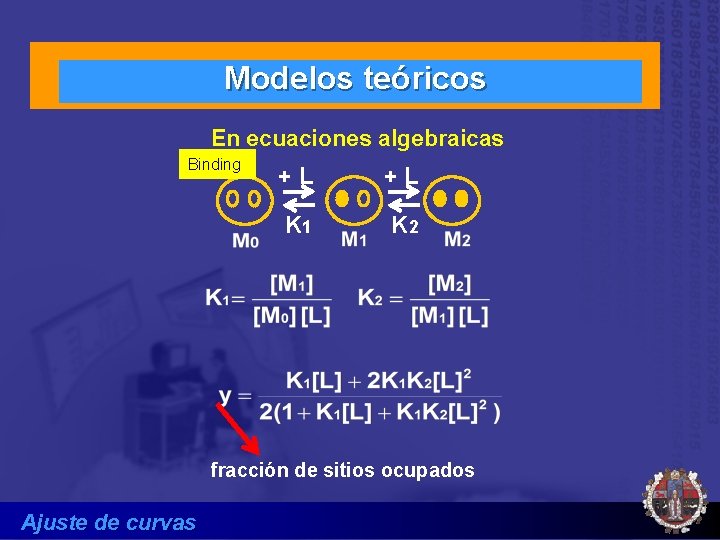

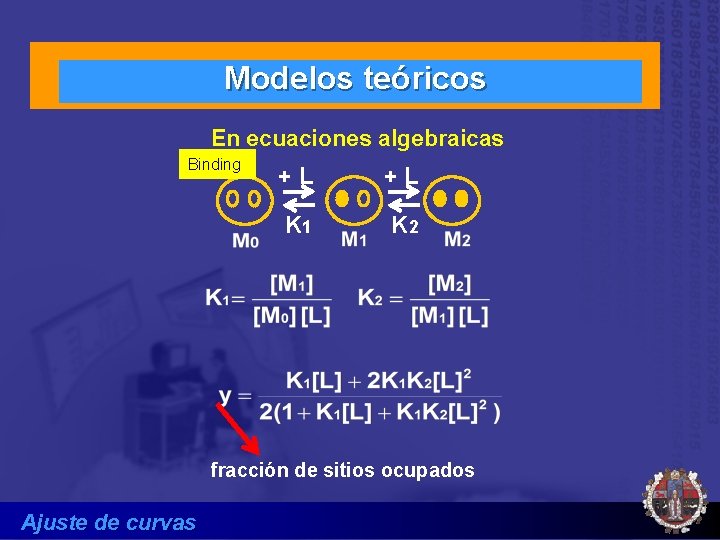

Modelos teóricos En ecuaciones algebraicas Binding +L +L K 1 K 2 fracción de sitios ocupados Ajuste de curvas

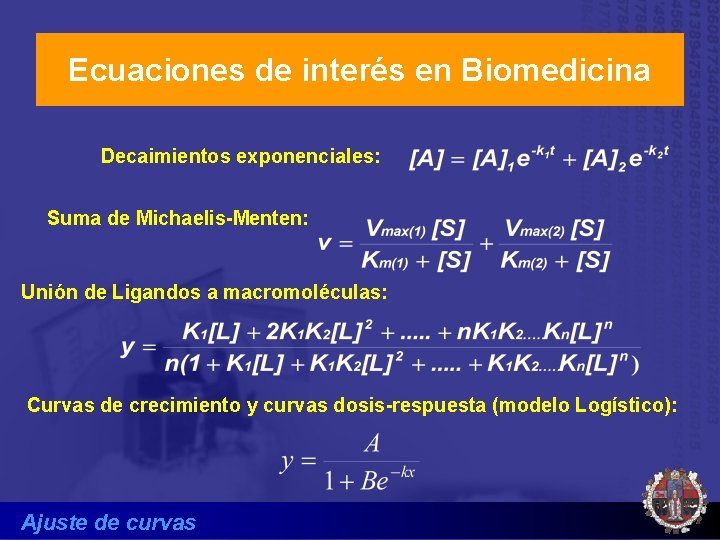

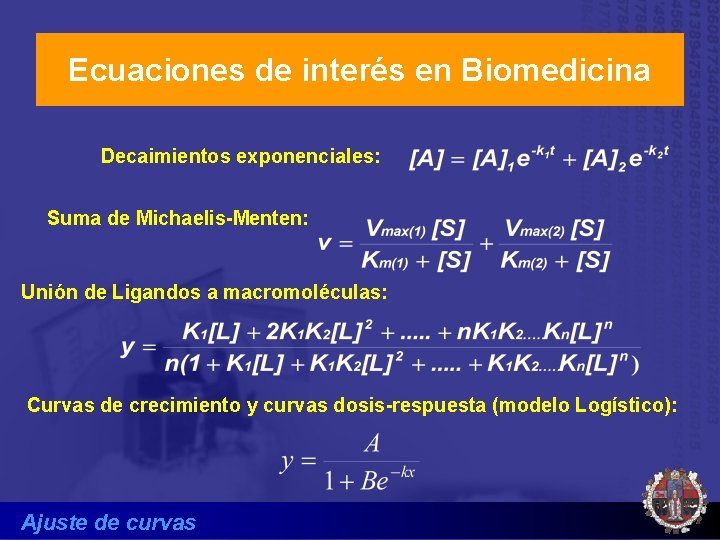

Ecuaciones de interés en Biomedicina Decaimientos exponenciales: Suma de Michaelis-Menten: Unión de Ligandos a macromoléculas: Curvas de crecimiento y curvas dosis-respuesta (modelo Logístico): Ajuste de curvas

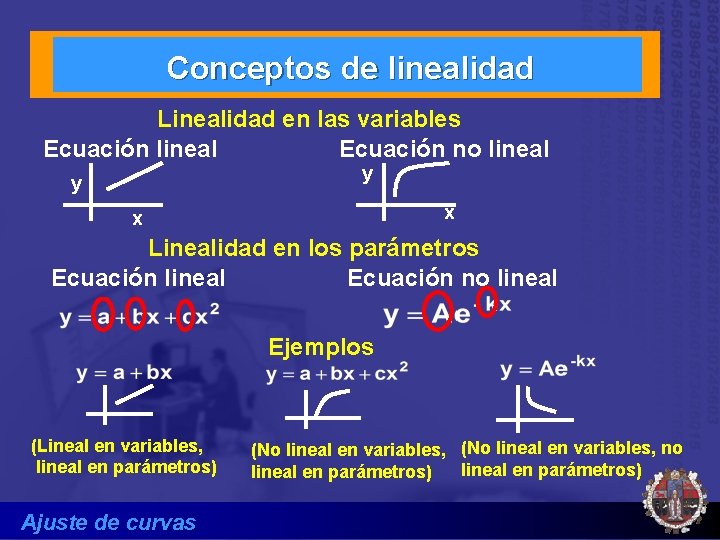

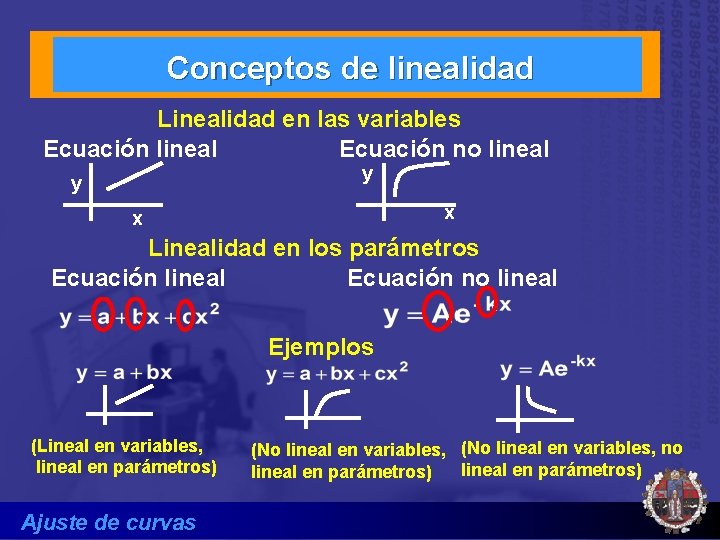

Conceptos de linealidad Linealidad en las variables Ecuación lineal Ecuación no lineal y y x x Linealidad en los parámetros Ecuación lineal Ecuación no lineal Ejemplos (Lineal en variables, lineal en parámetros) Ajuste de curvas (No lineal en variables, no lineal en parámetros)

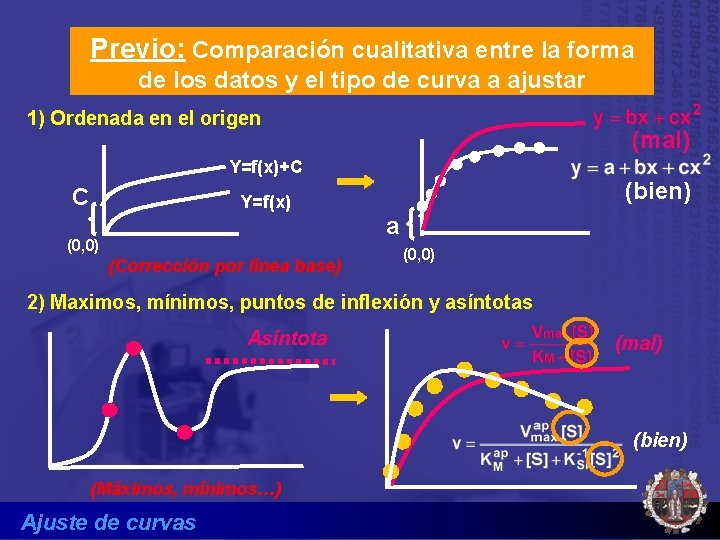

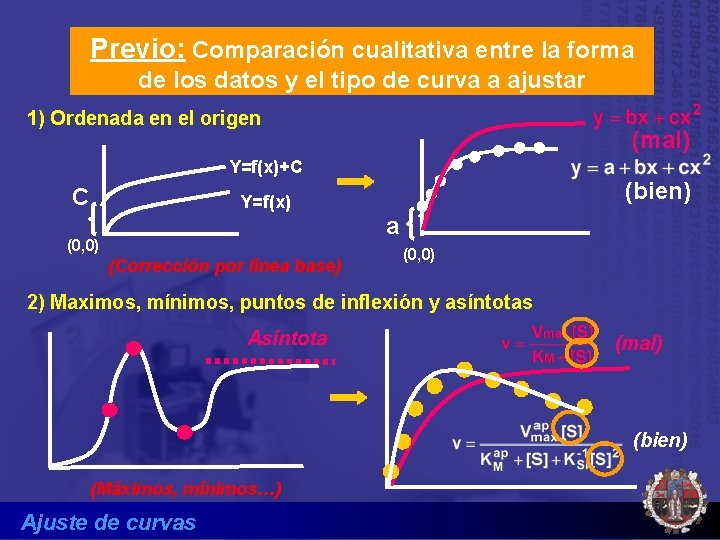

Previo: Comparación cualitativa entre la forma de los datos y el tipo de curva a ajustar 1) Ordenada en el origen (mal) Y=f(x)+C C (bien) Y=f(x) a (0, 0) (Corrección por línea base) (0, 0) 2) Maximos, mínimos, puntos de inflexión y asíntotas Asíntota (mal) (bien) (Máximos, mínimos…) Ajuste de curvas

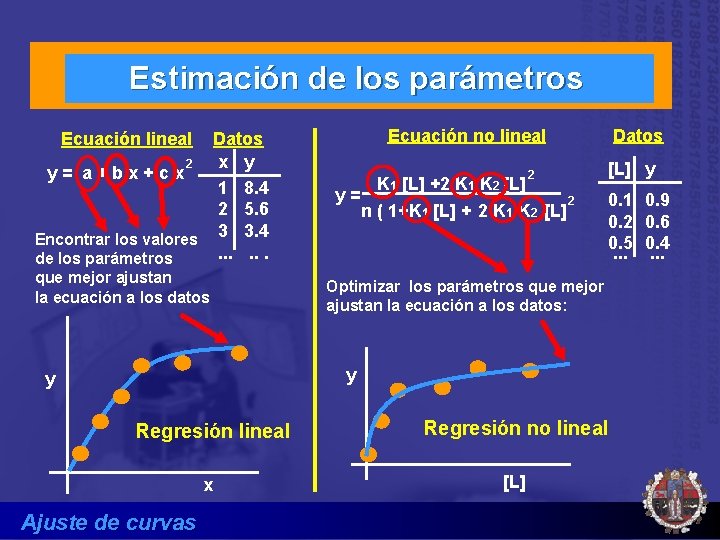

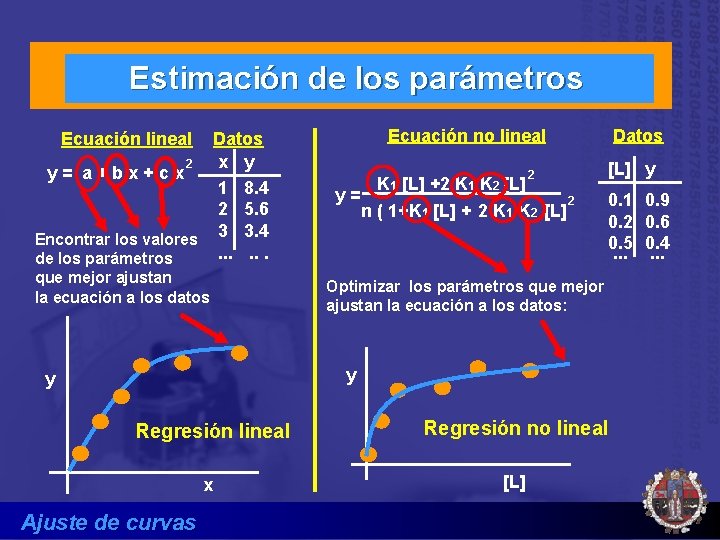

Estimación de los parámetros Datos x y 2 y= a+bx+cx 1 8. 4 2 5. 6 Encontrar los valores 3 3. 4. . . de los parámetros Ecuación no lineal Ecuación lineal que mejor ajustan la ecuación a los datos 2 y= K 1 [L] +2 K 1 K 2 [L] 2 n ( 1+K 1 [L] + 2 K 1 K 2 [L] Datos [L] y 0. 1 0. 2 0. 5. . . Optimizar los parámetros que mejor ajustan la ecuación a los datos: y y Regresión lineal x Ajuste de curvas Regresión no lineal [L] 0. 9 0. 6 0. 4. . .

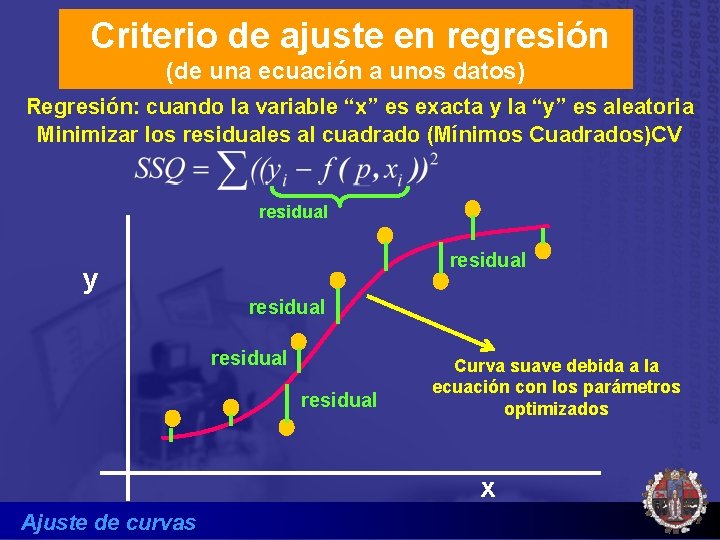

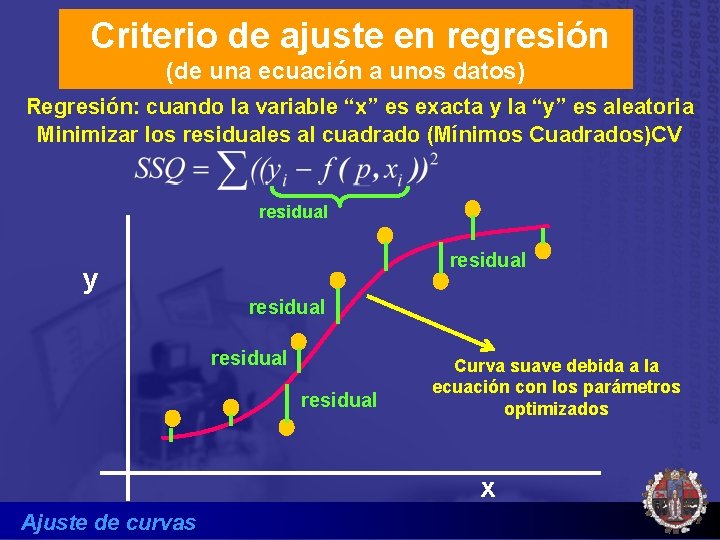

Criterio de ajuste en regresión (de una ecuación a unos datos) Regresión: cuando la variable “x” es exacta y la “y” es aleatoria Minimizar los residuales al cuadrado (Mínimos Cuadrados)CV residual y residual Curva suave debida a la ecuación con los parámetros optimizados x Ajuste de curvas

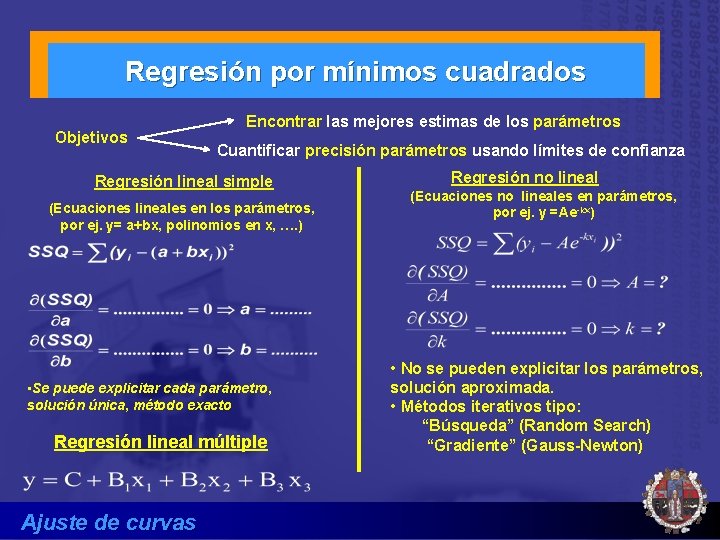

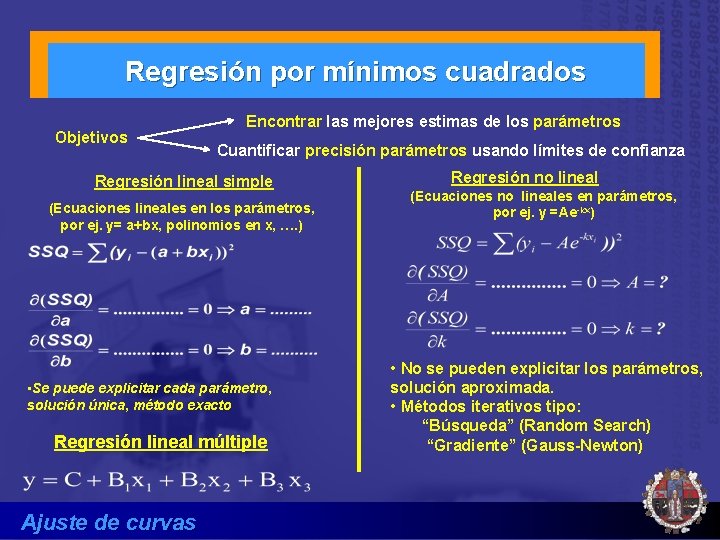

Regresión por mínimos cuadrados Objetivos Encontrar las mejores estimas de los parámetros Cuantificar precisión parámetros usando límites de confianza Regresión lineal simple (Ecuaciones lineales en los parámetros, por ej. y= a+bx, polinomios en x, …. ) • Se puede explicitar cada parámetro, solución única, método exacto Regresión lineal múltiple Ajuste de curvas Regresión no lineal (Ecuaciones no lineales en parámetros, por ej. y =Ae-kx) • No se pueden explicitar los parámetros, solución aproximada. • Métodos iterativos tipo: “Búsqueda” (Random Search) “Gradiente” (Gauss-Newton)

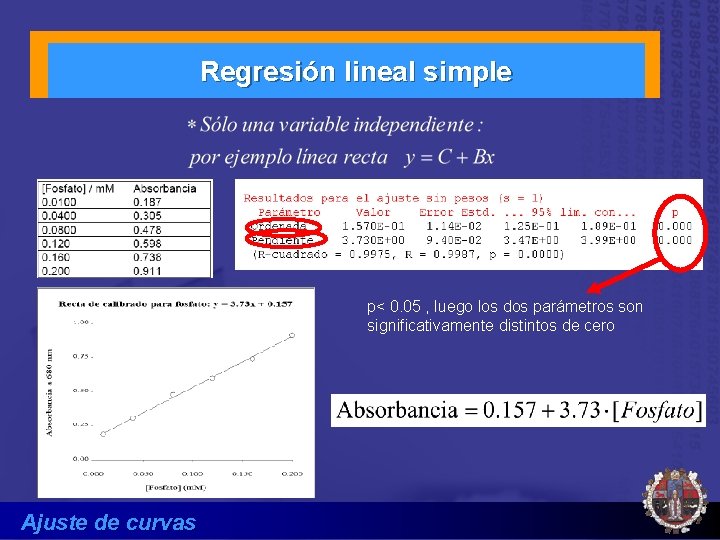

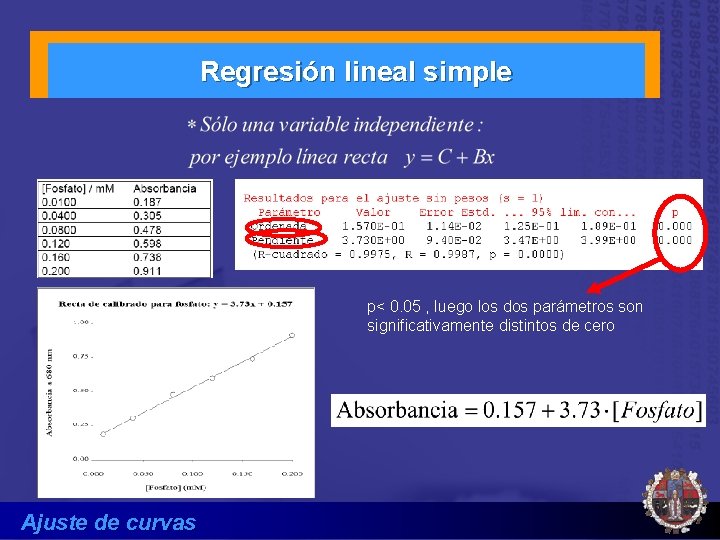

Regresión lineal simple p< 0. 05 , luego los dos parámetros son significativamente distintos de cero Ajuste de curvas

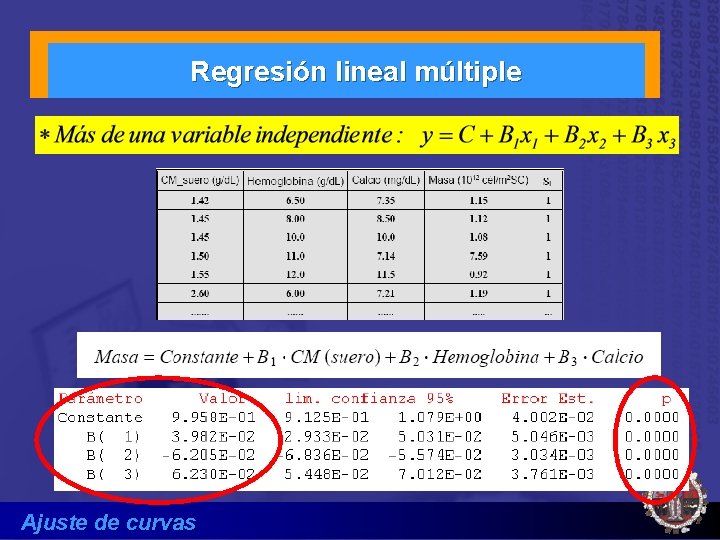

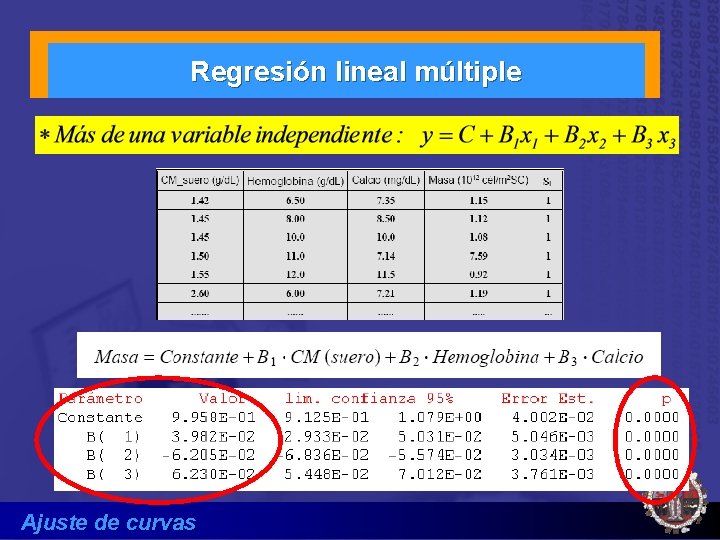

Regresión lineal múltiple Ajuste de curvas

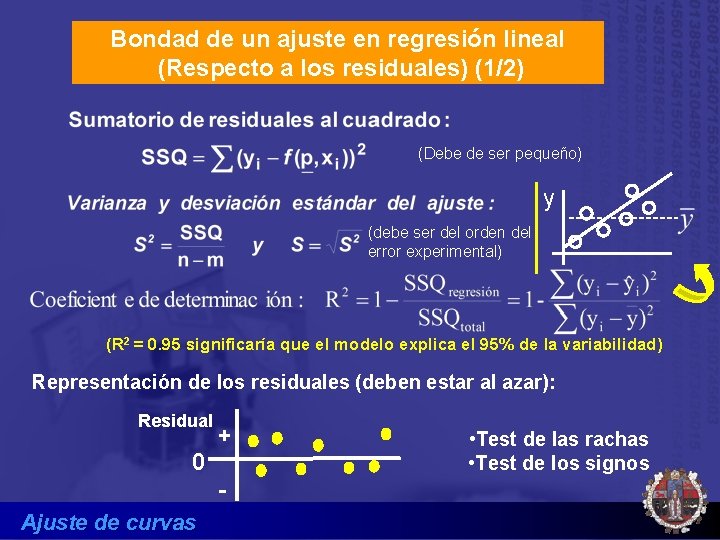

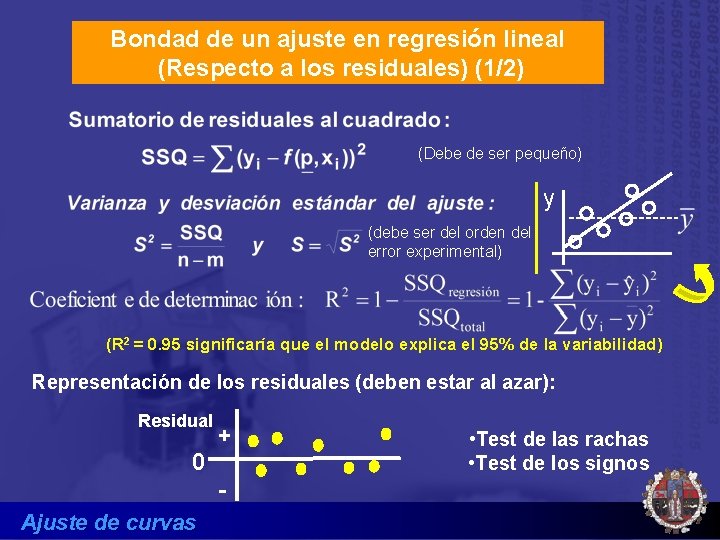

Bondad de un ajuste en regresión lineal (Respecto a los residuales) (1/2) (Debe de ser pequeño) y (debe ser del orden del error experimental) (R 2 = 0. 95 significaría que el modelo explica el 95% de la variabilidad) Representación de los residuales (deben estar al azar): Residual 0 + - Ajuste de curvas • Test de las rachas • Test de los signos

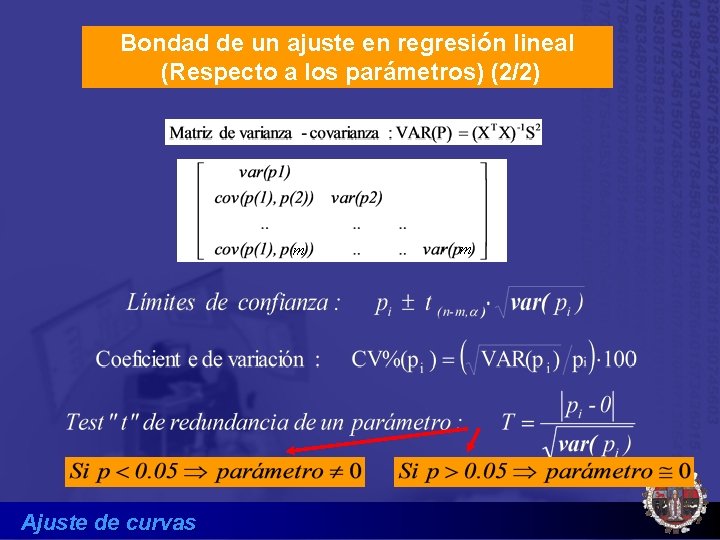

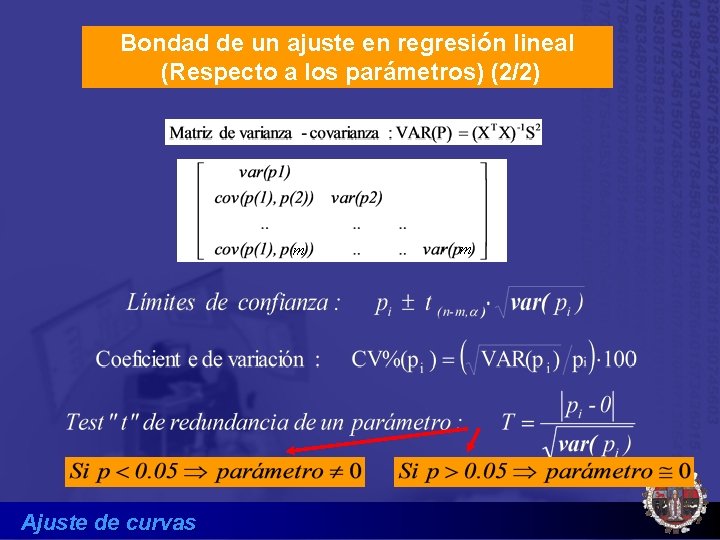

Bondad de un ajuste en regresión lineal (Respecto a los parámetros) (2/2) m Ajuste de curvas m

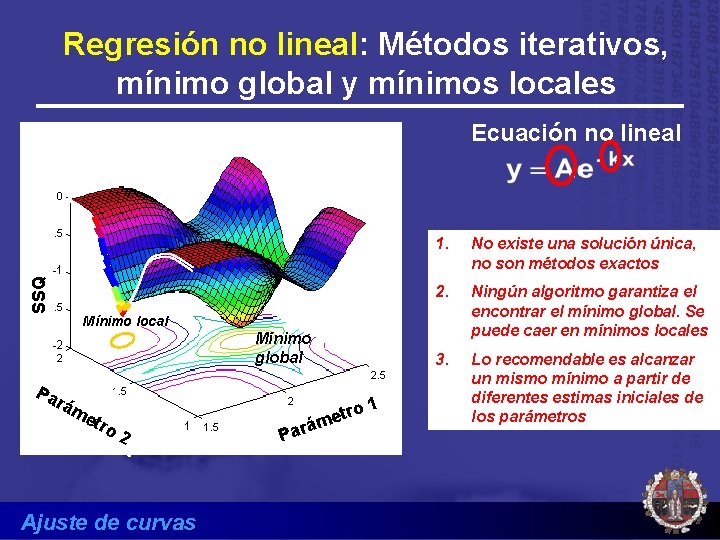

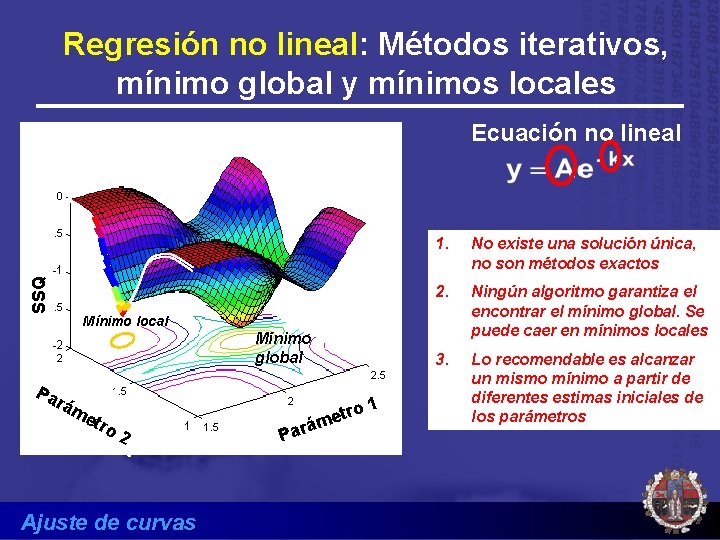

Regresión no lineal: Métodos iterativos, mínimo global y mínimos locales SSQ Ecuación no lineal 1. No existe una solución única, no son métodos exactos 2. Ningún algoritmo garantiza el encontrar el mínimo global. Se puede caer en mínimos locales 3. Lo recomendable es alcanzar un mismo mínimo a partir de diferentes estimas iniciales de los parámetros Mínimo local Mínimo global Pa rá m etr o 2 Ajuste de curvas Par tro e m á 1

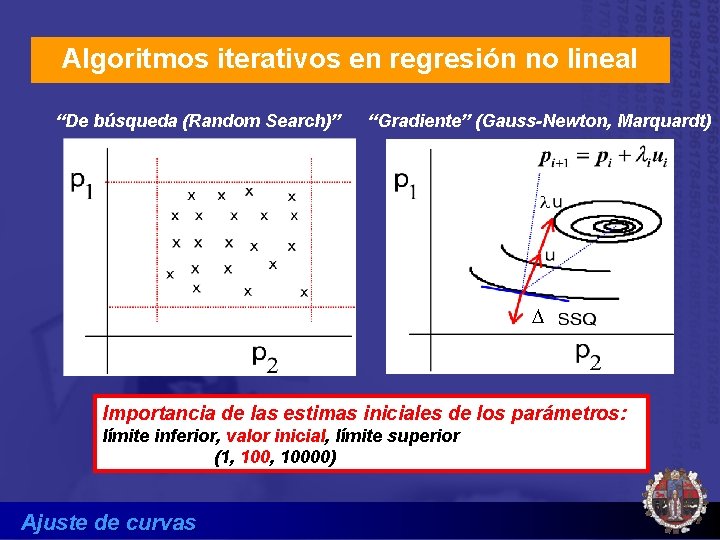

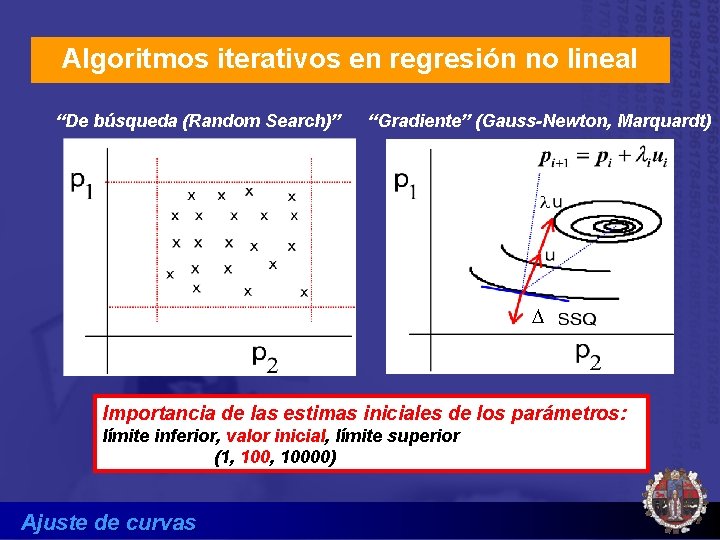

Algoritmos iterativos en regresión no lineal “De búsqueda (Random Search)” “Gradiente” (Gauss-Newton, Marquardt) D Importancia de las estimas iniciales de los parámetros: límite inferior, valor inicial, límite superior (1, 10000) Ajuste de curvas

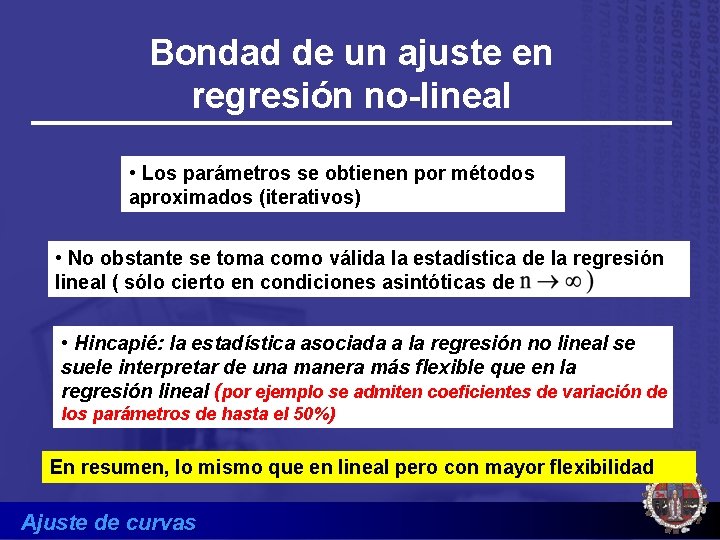

Bondad de un ajuste en regresión no-lineal • Los parámetros se obtienen por métodos aproximados (iterativos) • No obstante se toma como válida la estadística de la regresión lineal ( sólo cierto en condiciones asintóticas de • Hincapié: la estadística asociada a la regresión no lineal se suele interpretar de una manera más flexible que en la regresión lineal (por ejemplo se admiten coeficientes de variación de los parámetros de hasta el 50%) En resumen, lo mismo que en lineal pero con mayor flexibilidad Ajuste de curvas

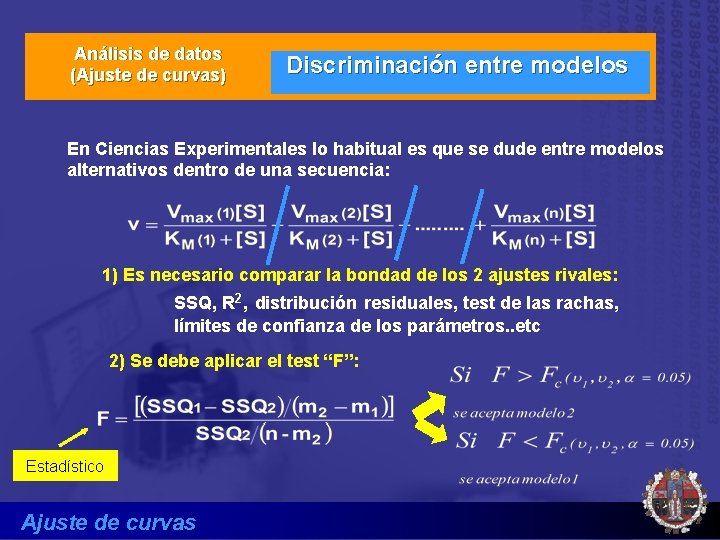

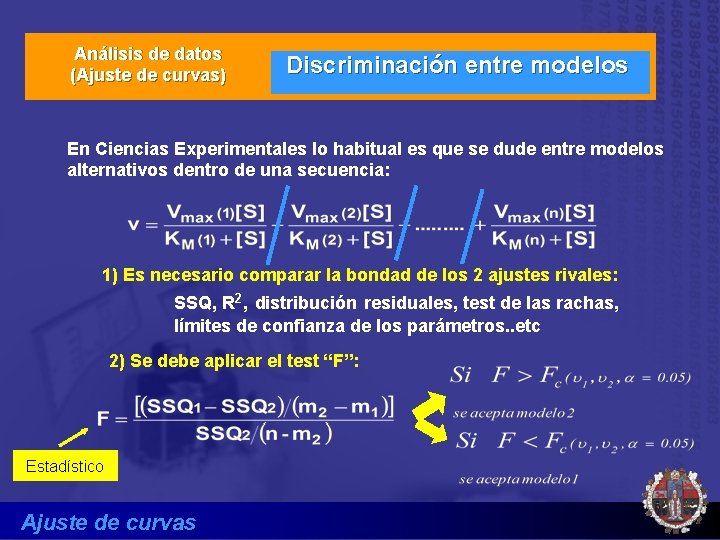

Análisis de datos (Ajuste de curvas) Discriminación entre modelos En Ciencias Experimentales lo habitual es que se dude entre modelos alternativos dentro de una secuencia: 1) Es necesario comparar la bondad de los 2 ajustes rivales: SSQ, R 2, distribución residuales, test de las rachas, límites de confianza de los parámetros. . etc 2) Se debe aplicar el test “F”: Estadístico Ajuste de curvas

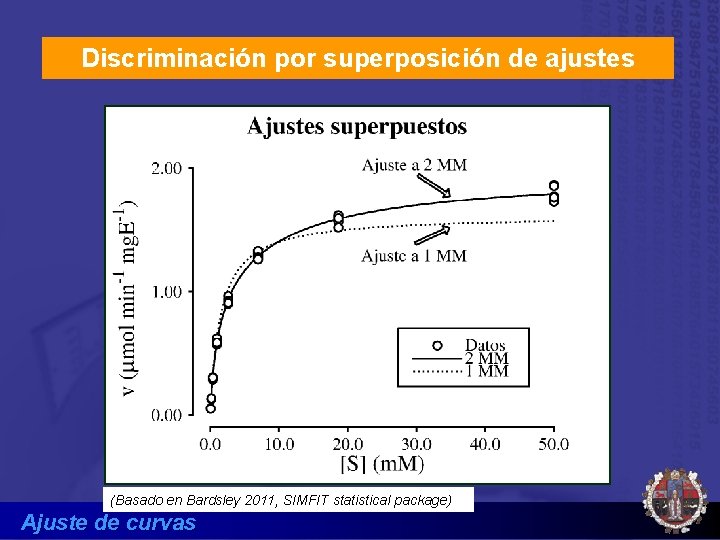

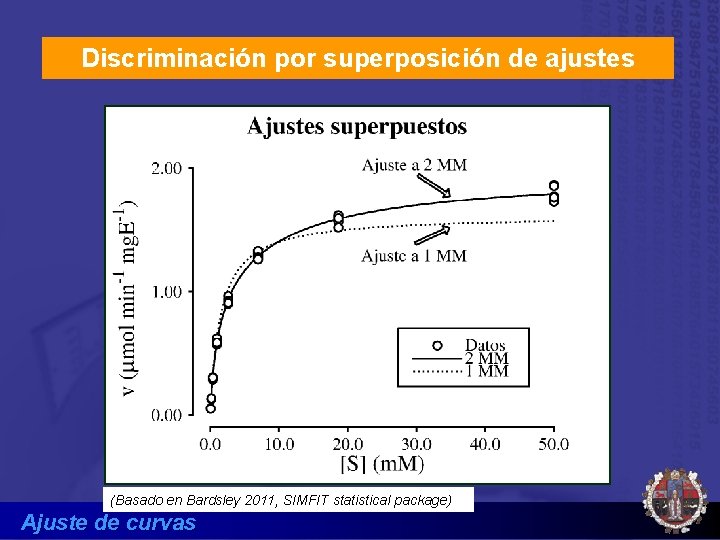

Discriminación por superposición de ajustes (Basado en Bardsley 2011, SIMFIT statistical package) Ajuste de curvas

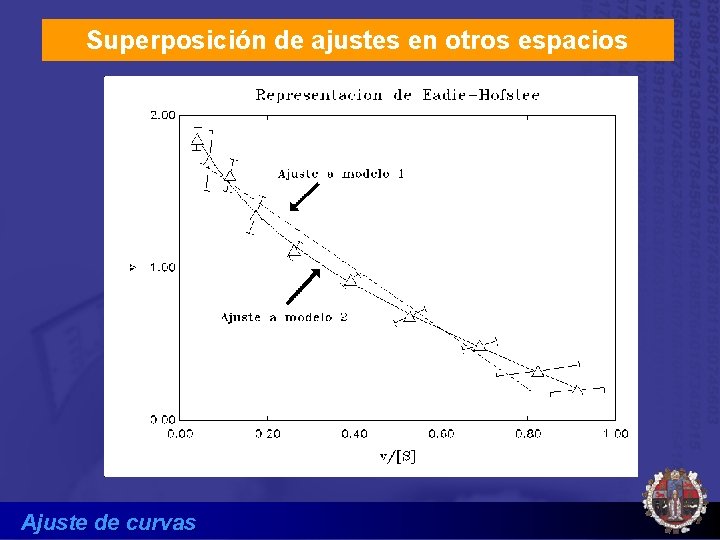

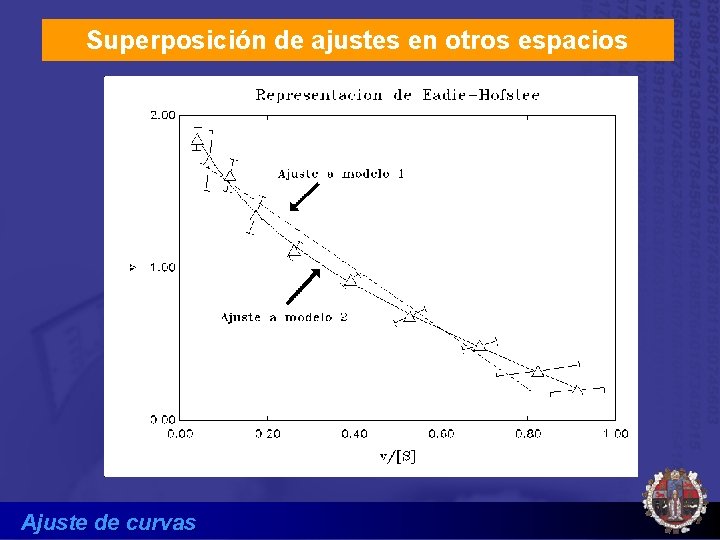

Superposición de ajustes en otros espacios Ajuste de curvas

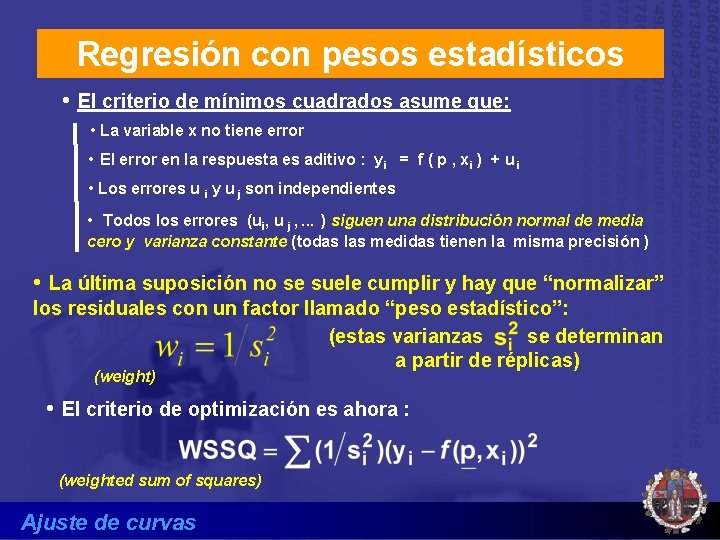

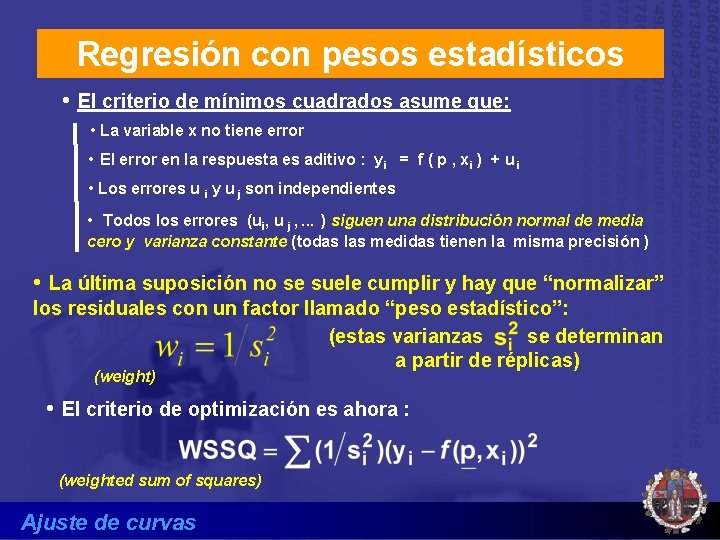

Regresión con pesos estadísticos • El criterio de mínimos cuadrados asume que: • La variable x no tiene error • El error en la respuesta es aditivo : yi = f ( p , xi ) + u i • Los errores u i y u j son independientes • Todos los errores (ui, u j , . . . ) siguen una distribución normal de media cero y varianza constante (todas las medidas tienen la misma precisión ) • La última suposición no se suele cumplir y hay que “normalizar” los residuales con un factor llamado “peso estadístico”: (estas varianzas se determinan a partir de réplicas) (weight) • El criterio de optimización es ahora : (weighted sum of squares) Ajuste de curvas

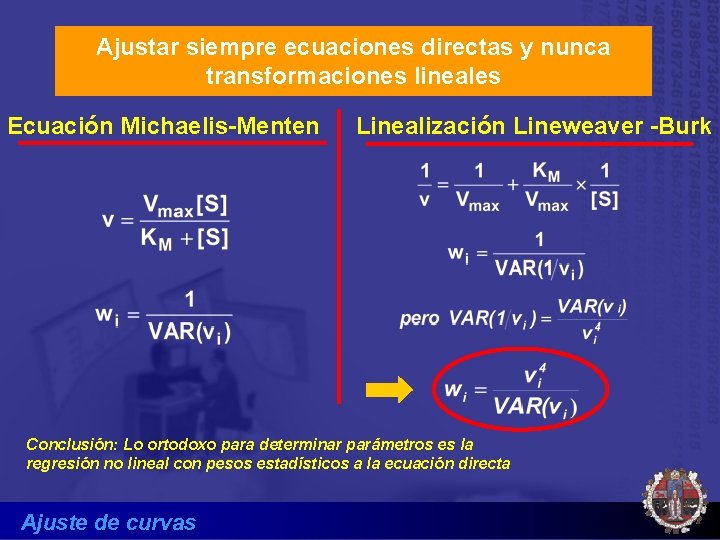

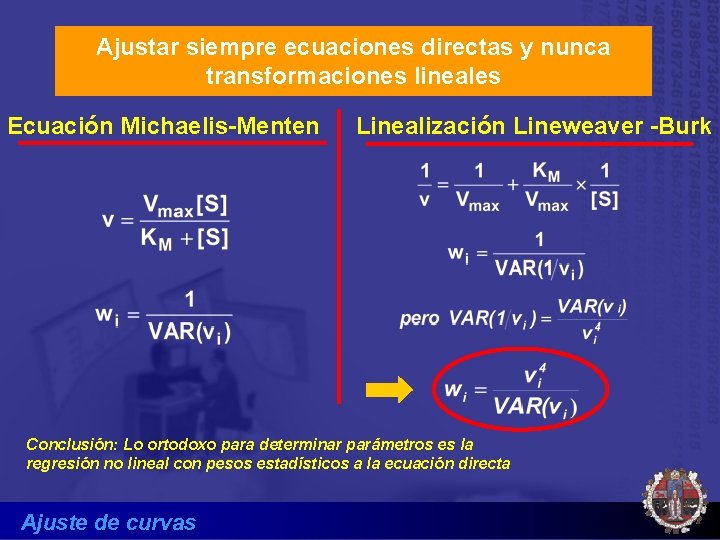

Ajustar siempre ecuaciones directas y nunca transformaciones lineales Ecuación Michaelis-Menten Linealización Lineweaver -Burk Conclusión: Lo ortodoxo para determinar parámetros es la regresión no lineal con pesos estadísticos a la ecuación directa Ajuste de curvas

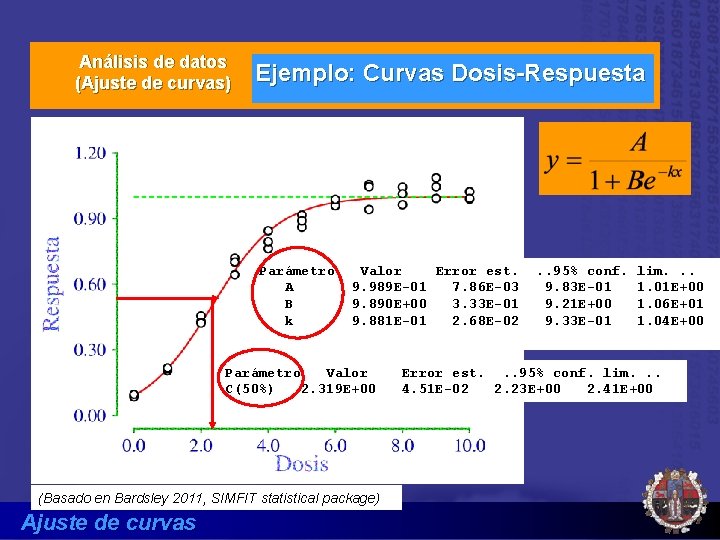

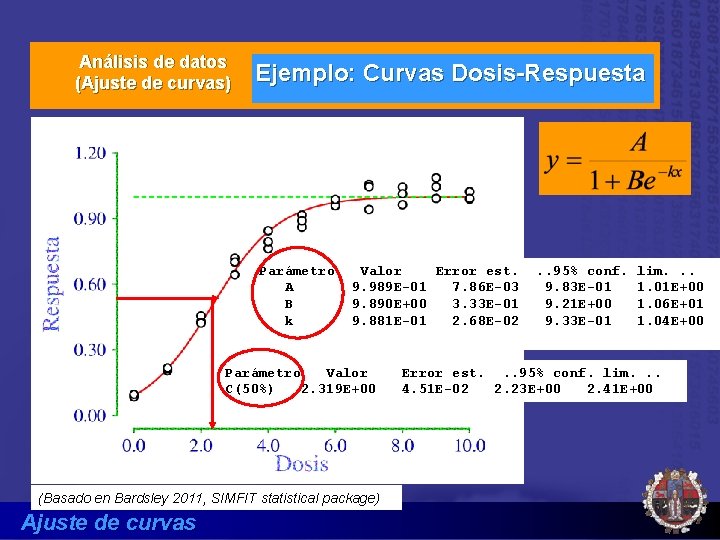

Análisis de datos (Ajuste de curvas) Ejemplo: Curvas Dosis-Respuesta Parámetro A B k Valor Error est. 9. 989 E-01 7. 86 E-03 9. 890 E+00 3. 33 E-01 9. 881 E-01 2. 68 E-02 Parámetro Valor C(50%) 2. 319 E+00 (Basado en Bardsley 2011, SIMFIT statistical package) Ajuste de curvas . . 95% conf. 9. 83 E-01 9. 21 E+00 9. 33 E-01 lim. . . 1. 01 E+00 1. 06 E+01 1. 04 E+00 Error est. . . 95% conf. lim. . . 4. 51 E-02 2. 23 E+00 2. 41 E+00

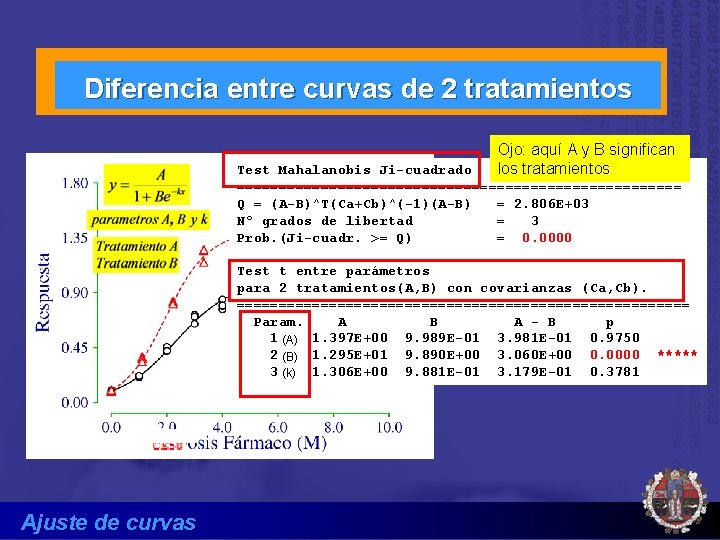

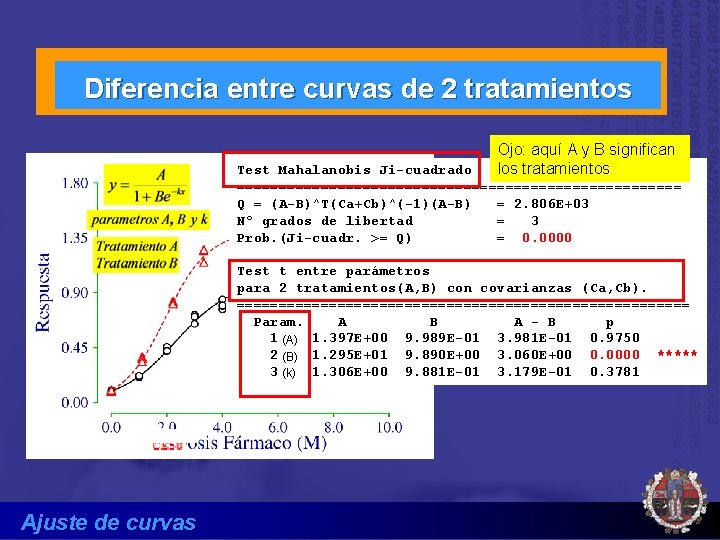

Diferencia entre curvas de 2 tratamientos Ojo: aquí A y B significan los tratamientos Test Mahalanobis Ji-cuadrado =========================== Q = (A-B)^T(Ca+Cb)^(-1)(A-B) = 2. 806 E+03 Nº grados de libertad = 3 Prob. (Ji-cuadr. >= Q) = 0. 0000 Test t entre parámetros para 2 tratamientos(A, B) con covarianzas (Ca, Cb). =========================== Param. A B A - B p 1 (A) 1. 397 E+00 9. 989 E-01 3. 981 E-01 0. 9750 2 (B) 1. 295 E+01 9. 890 E+00 3. 060 E+00 0. 0000 ***** 3 (k) 1. 306 E+00 9. 881 E-01 3. 179 E-01 0. 3781 Ajuste de curvas

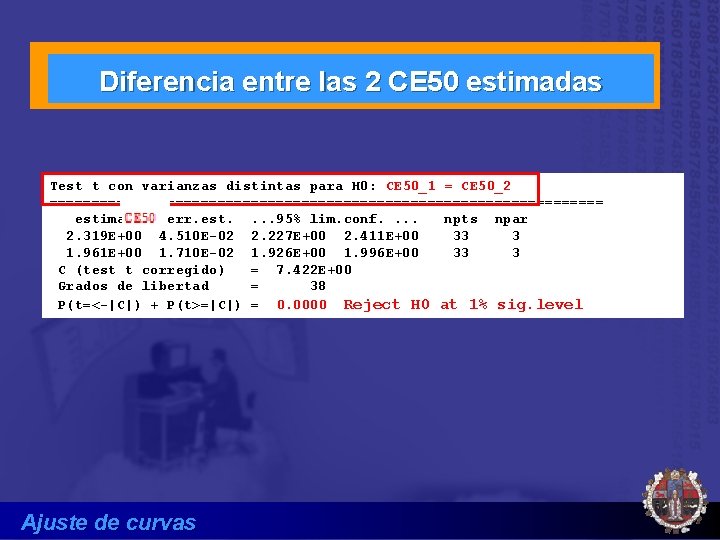

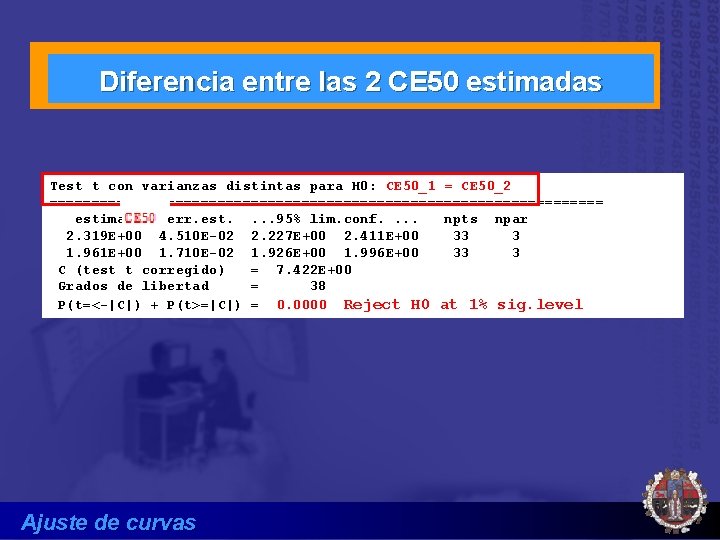

Diferencia entre las 2 CE 50 estimadas Test t con varianzas distintas para H 0: CE 50_1 = CE 50_2 ================================= estimado err. est. . 95% lim. conf. . npts npar 2. 319 E+00 4. 510 E-02 2. 227 E+00 2. 411 E+00 33 3 1. 961 E+00 1. 710 E-02 1. 926 E+00 1. 996 E+00 33 3 C (test t corregido) = 7. 422 E+00 Grados de libertad = 38 P(t=<-|C|) + P(t>=|C|) = 0. 0000 Reject H 0 at 1% sig. level Ajuste de curvas

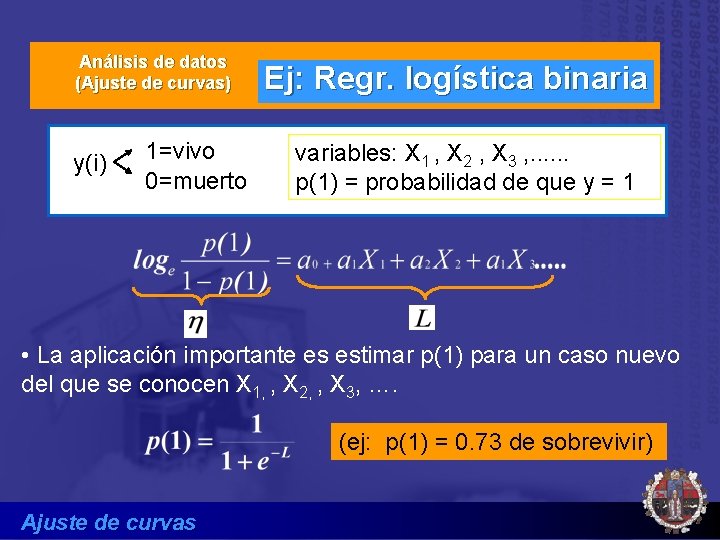

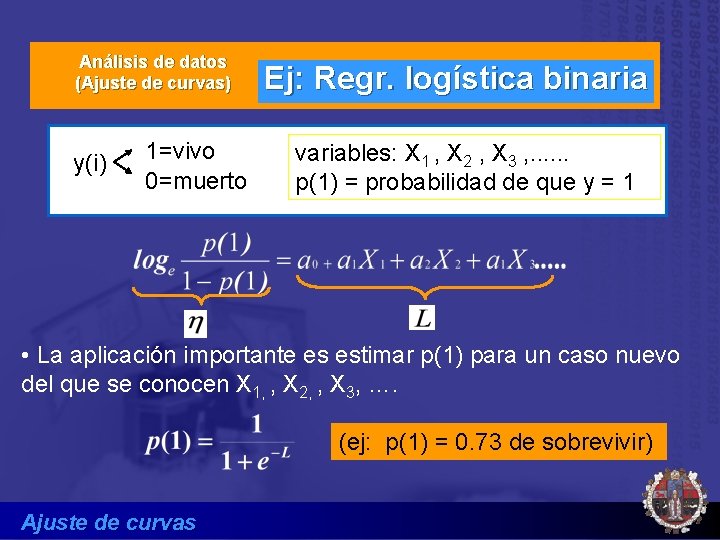

Análisis de datos (Ajuste de curvas) y(i) 1=vivo 0=muerto Ej: Regr. logística binaria variables: X 1 , X 2 , X 3 , . . . p(1) = probabilidad de que y = 1 • La aplicación importante es estimar p(1) para un caso nuevo del que se conocen X 1, , X 2, , X 3, …. (ej: p(1) = 0. 73 de sobrevivir) Ajuste de curvas

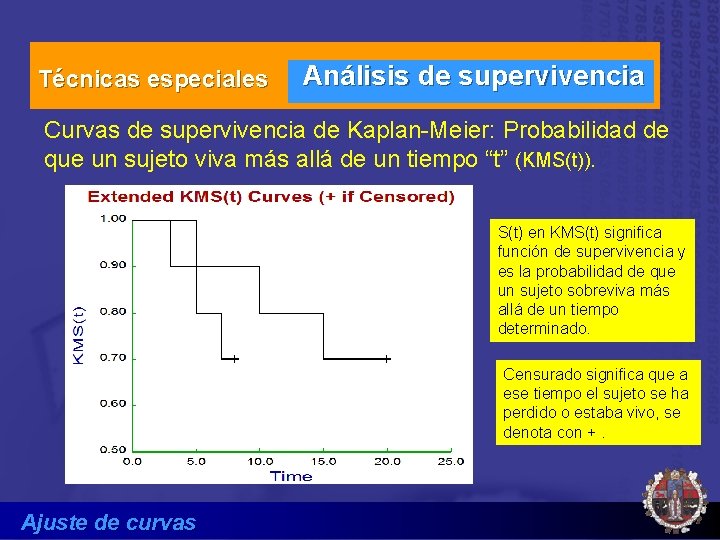

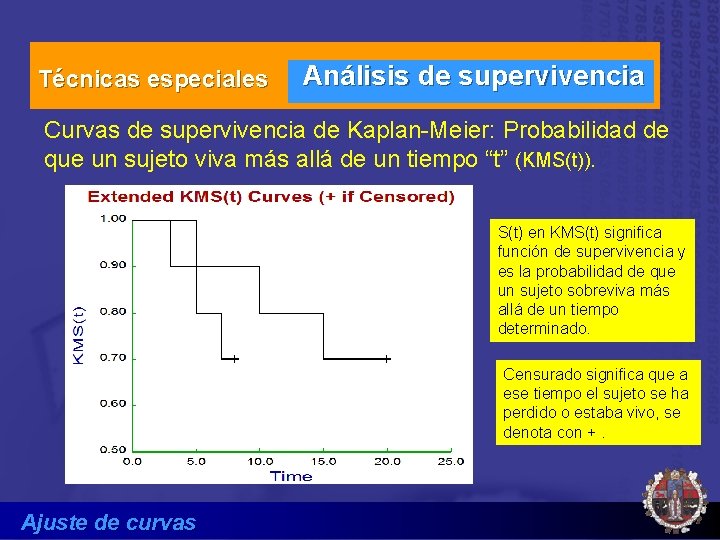

Técnicas especiales Análisis de supervivencia Curvas de supervivencia de Kaplan-Meier: Probabilidad de que un sujeto viva más allá de un tiempo “t” (KMS(t)). S(t) en KMS(t) significa función de supervivencia y es la probabilidad de que un sujeto sobreviva más allá de un tiempo determinado. Censurado significa que a ese tiempo el sujeto se ha perdido o estaba vivo, se denota con +. Ajuste de curvas

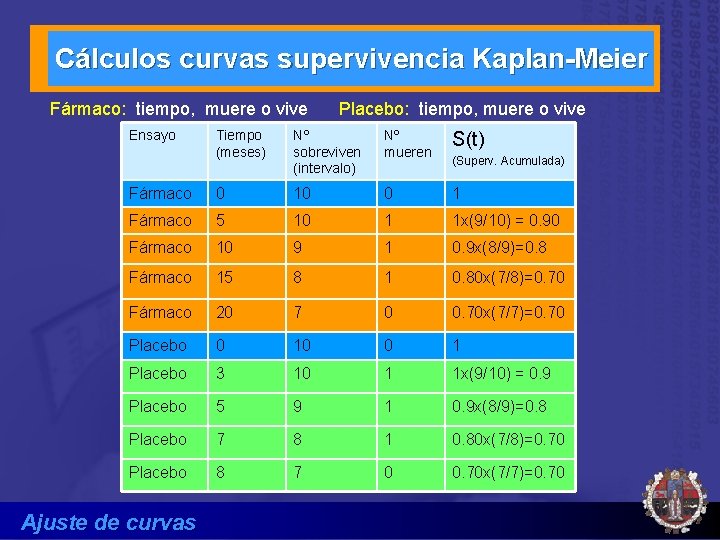

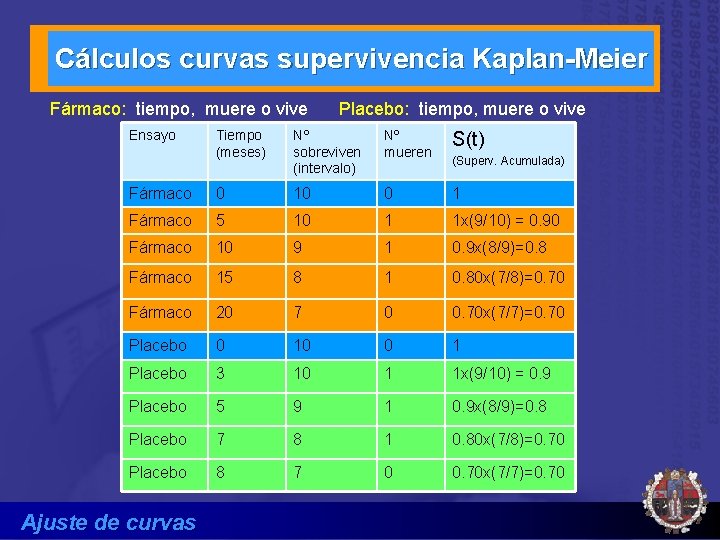

Cálculos curvas supervivencia Kaplan-Meier Fármaco: tiempo, muere o vive Ensayo Placebo: tiempo, muere o vive Tiempo (meses) Nº sobreviven (intervalo) Nº mueren S(t) Fármaco 0 10 0 1 Fármaco 5 10 1 1 x(9/10) = 0. 90 Fármaco 10 9 1 0. 9 x(8/9)=0. 8 Fármaco 15 8 1 0. 80 x(7/8)=0. 70 Fármaco 20 7 0 0. 70 x(7/7)=0. 70 Placebo 0 10 0 1 Placebo 3 10 1 1 x(9/10) = 0. 9 Placebo 5 9 1 0. 9 x(8/9)=0. 8 Placebo 7 8 1 0. 80 x(7/8)=0. 70 Placebo 8 7 0 0. 70 x(7/7)=0. 70 Ajuste de curvas (Superv. Acumulada)

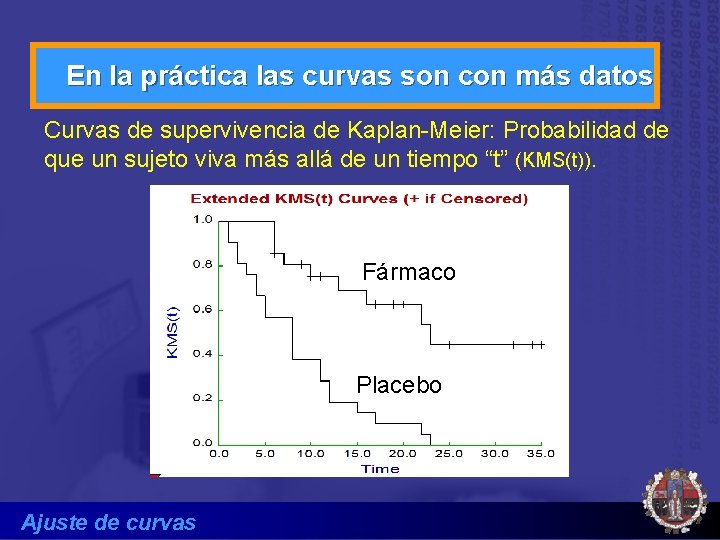

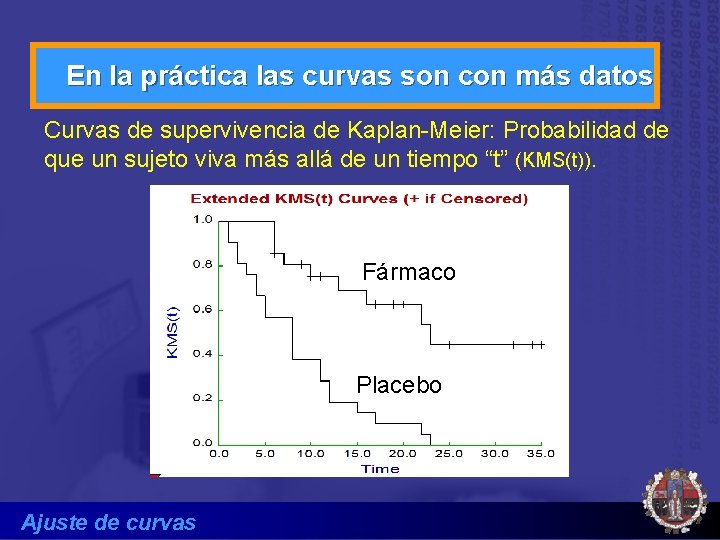

En la práctica las curvas son con más datos Curvas de supervivencia de Kaplan-Meier: Probabilidad de que un sujeto viva más allá de un tiempo “t” (KMS(t)). Fármaco Placebo Ajuste de curvas

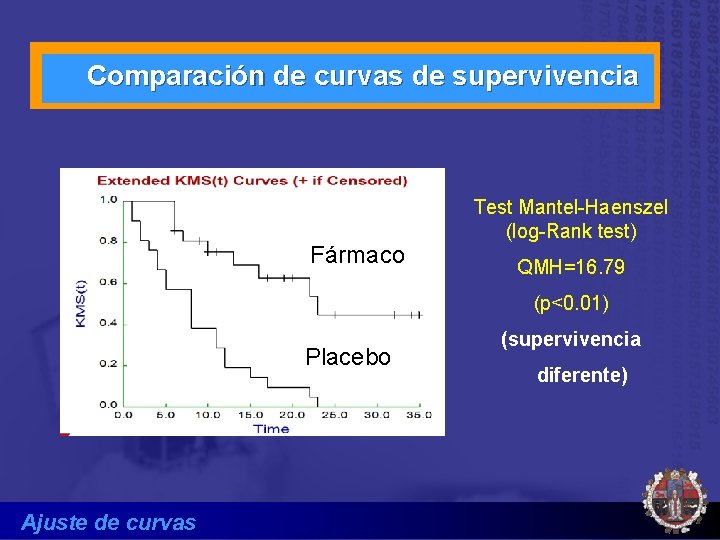

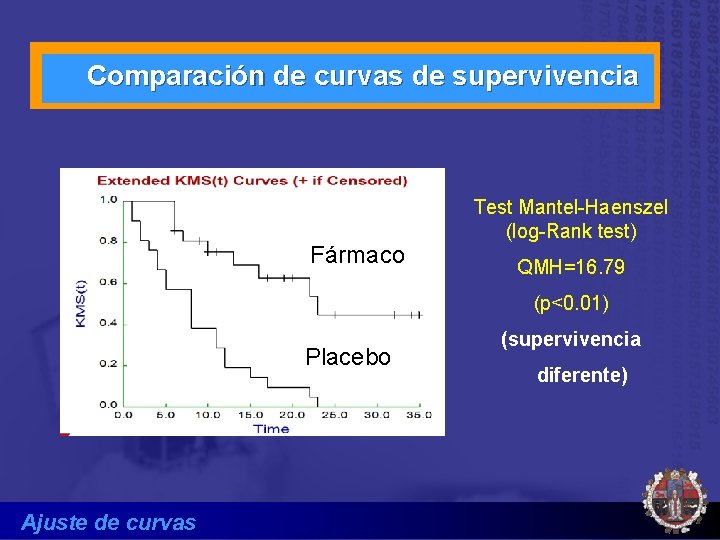

Comparación de curvas de supervivencia Fármaco Test Mantel-Haenszel (log-Rank test) QMH=16. 79 (p<0. 01) Placebo Ajuste de curvas (supervivencia diferente)