Le dispositif dvaluation des acquis des lves de

- Slides: 54

Le dispositif d’évaluation des acquis des élèves de la DEPP Séminaire Nantes 3 février 2009

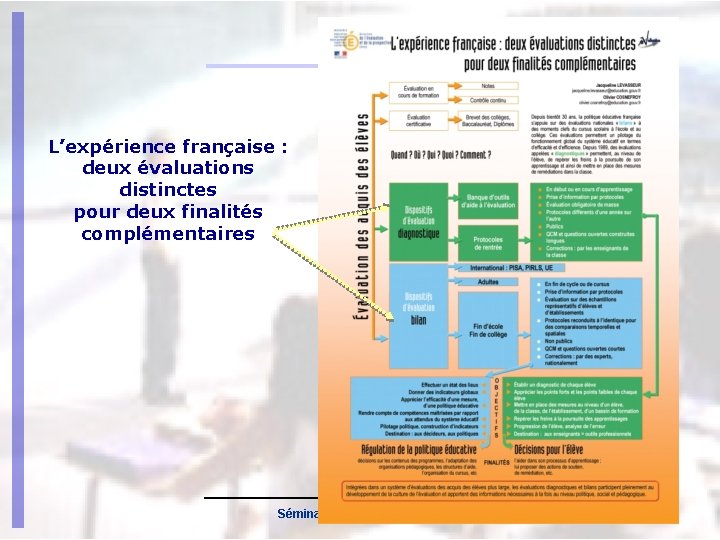

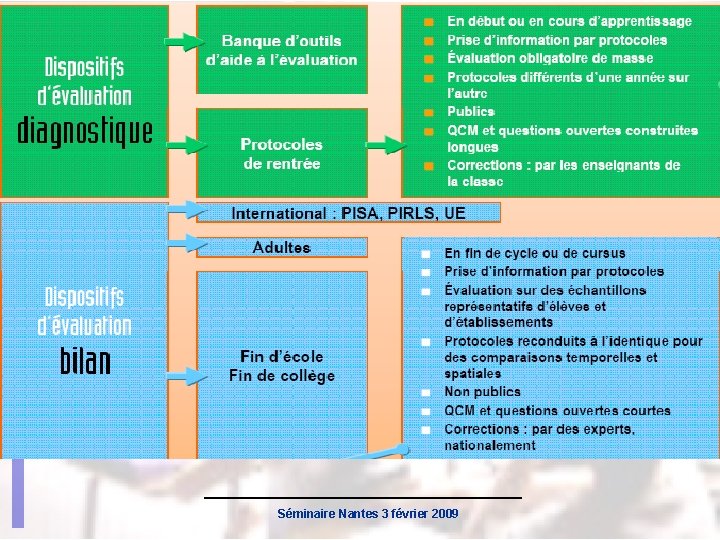

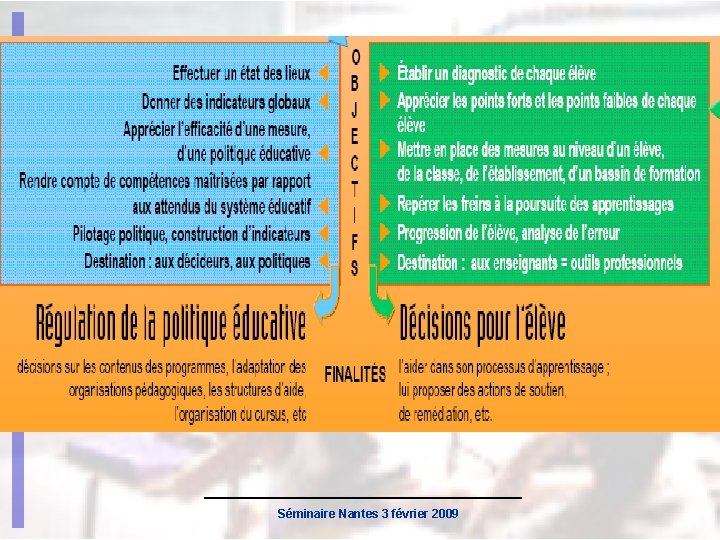

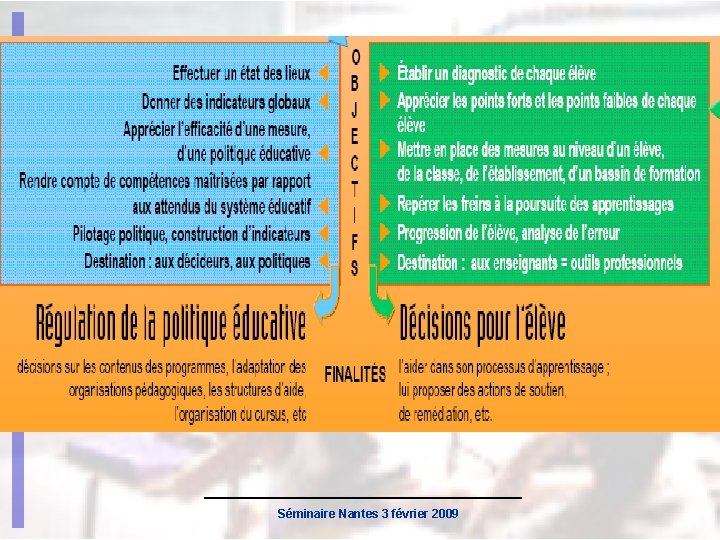

L’expérience française : deux évaluations distinctes pour deux finalités complémentaires Depuis 30 ans, la politique éducative française s’appuie sur des évaluations nationales « bilans » à des moments clefs du cursus scolaire à l’école et au collège. Ces évaluations permettent un pilotage du fonctionnement global du système éducatif en termes d’efficacité et d’efficience. Depuis 1989, des évaluations appelées « diagnostiques » permettent, au niveau de l’élève, de repérer les freins à la poursuite de son apprentissage et ainsi de mettre en place des mesures de remédiations dans la classe. Séminaire Nantes 3 février 2009

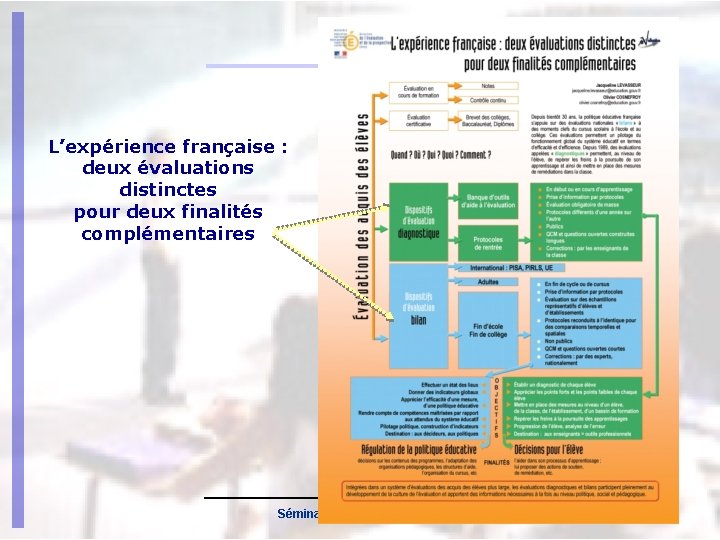

L’expérience française : deux évaluations distinctes pour deux finalités complémentaires Séminaire Nantes 3 février 2009

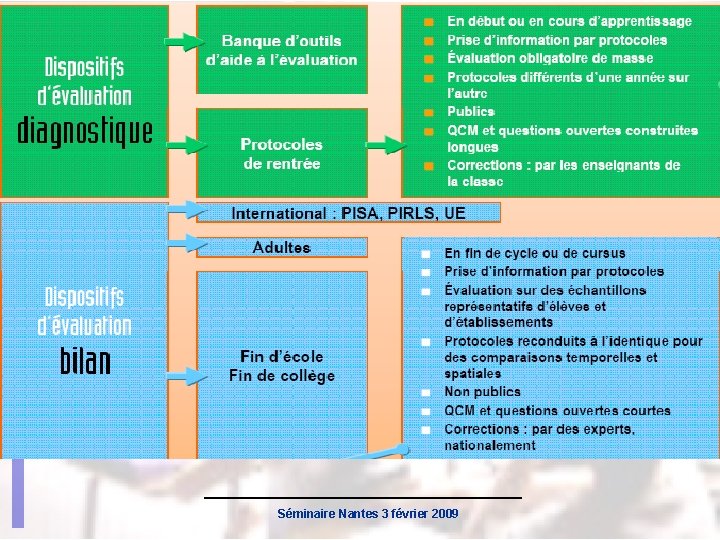

Séminaire Nantes 3 février 2009

Séminaire Nantes 3 février 2009

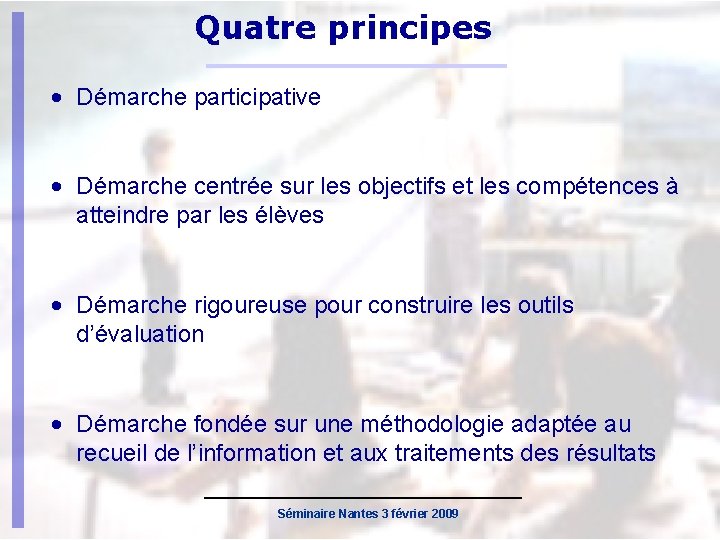

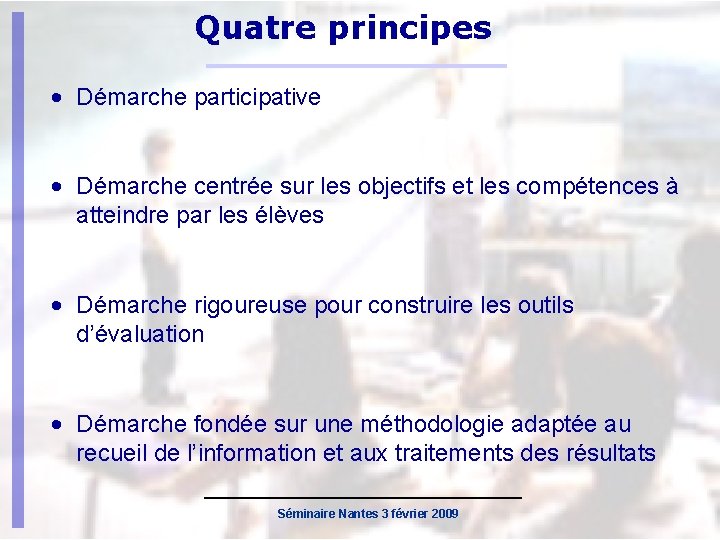

Quatre principes • Démarche participative • Démarche centrée sur les objectifs et les compétences à atteindre par les élèves • Démarche rigoureuse pour construire les outils d’évaluation • Démarche fondée sur une méthodologie adaptée au recueil de l’information et aux traitements des résultats Séminaire Nantes 3 février 2009

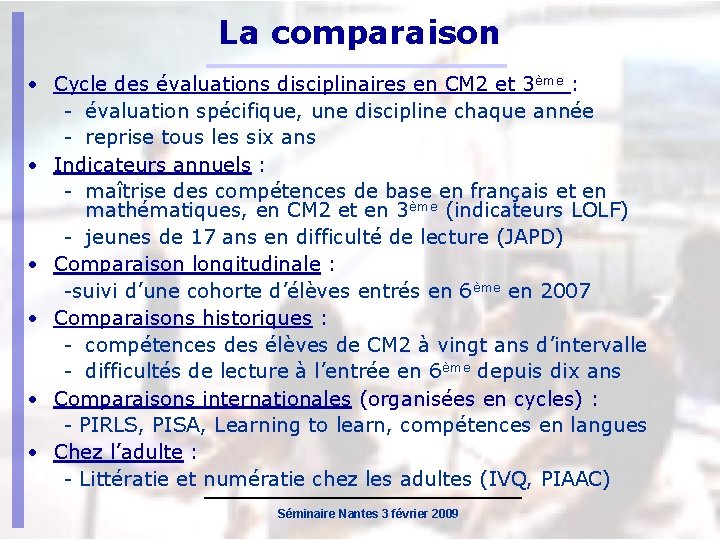

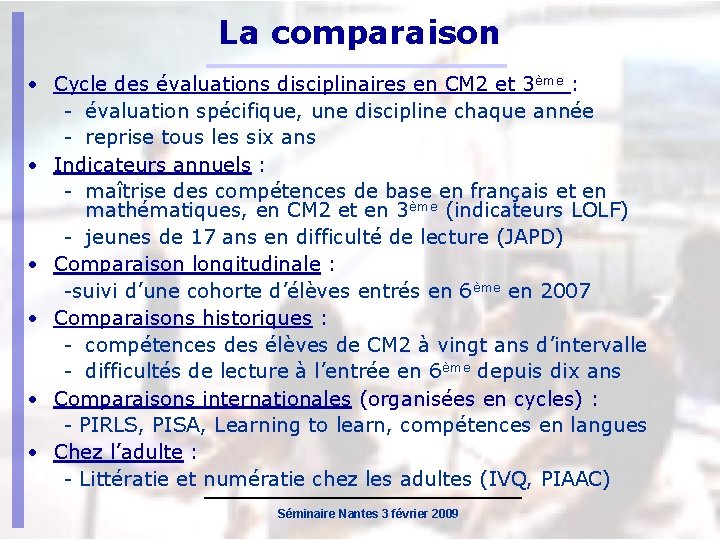

La comparaison • Cycle des évaluations disciplinaires en CM 2 et 3ème : - évaluation spécifique, une discipline chaque année - reprise tous les six ans • Indicateurs annuels : - maîtrise des compétences de base en français et en mathématiques, en CM 2 et en 3ème (indicateurs LOLF) - jeunes de 17 ans en difficulté de lecture (JAPD) • Comparaison longitudinale : -suivi d’une cohorte d’élèves entrés en 6ème en 2007 • Comparaisons historiques : - compétences des élèves de CM 2 à vingt ans d’intervalle - difficultés de lecture à l’entrée en 6ème depuis dix ans • Comparaisons internationales (organisées en cycles) : - PIRLS, PISA, Learning to learn, compétences en langues • Chez l’adulte : - Littératie et numératie chez les adultes (IVQ, PIAAC) Séminaire Nantes 3 février 2009

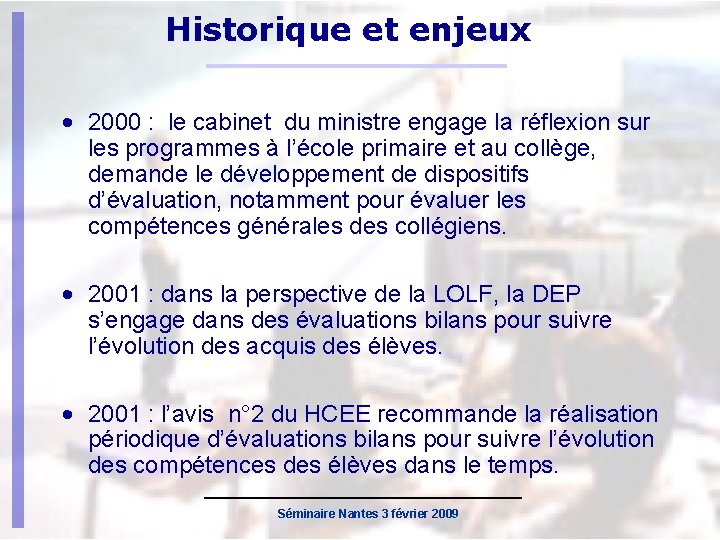

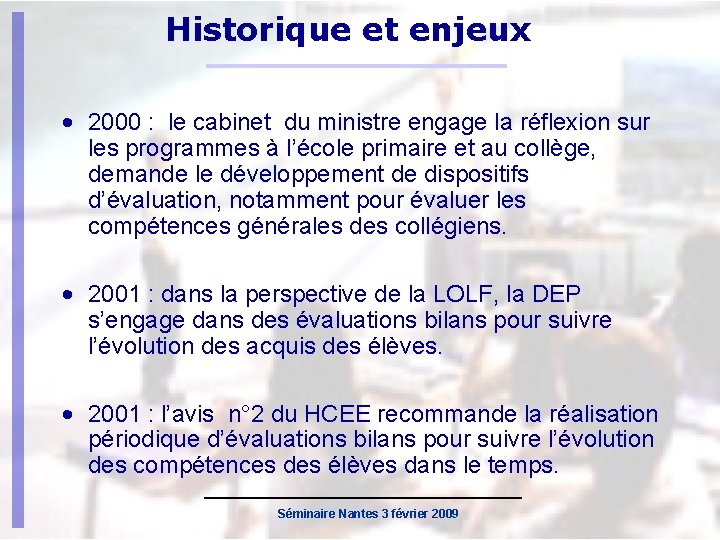

Historique et enjeux • 2000 : le cabinet du ministre engage la réflexion sur les programmes à l’école primaire et au collège, demande le développement de dispositifs d’évaluation, notamment pour évaluer les compétences générales des collégiens. • 2001 : dans la perspective de la LOLF, la DEP s’engage dans des évaluations bilans pour suivre l’évolution des acquis des élèves. • 2001 : l’avis n° 2 du HCEE recommande la réalisation périodique d’évaluations bilans pour suivre l’évolution des compétences des élèves dans le temps. Séminaire Nantes 3 février 2009

Cycle des évaluations disciplinaires • Elles sont destinées à recueillir une information sur la population entière à partir d’échantillons représentatifs dans le but d’établir une évaluation globale des compétences des élèves et de leur évolution à des moments clés de la scolarité : fin d’école primaire et fin du collège. Séminaire Nantes 3 février 2009

Cycle des évaluations disciplinaires Elles permettent de : • Piloter et rendre compte de l’évolution dans le temps (le niveau augmente-t-il ou non ? ) • Comparer les populations, les structures et les groupes caractéristiques (quid des zones défavorisées comparées aux autres ? ) • Étudier les liens entre les développements dans les compétences acquises par les élèves et les effets dus aux évolutions dans les politiques d’enseignement ou les contextes (quid de la mise en place de l’enseignement des langues étrangères à l’école primaire ? ) Séminaire Nantes 3 février 2009

Volets : cognitif - contexte - conatif • Cognitif : tests passés par les élèves. • Contexte : Fiches renseignées par le chef d’établissement. • Conatif : questionnaires renseignés par les élèves, les enseignants et le chef d’établissement Séminaire Nantes 3 février 2009

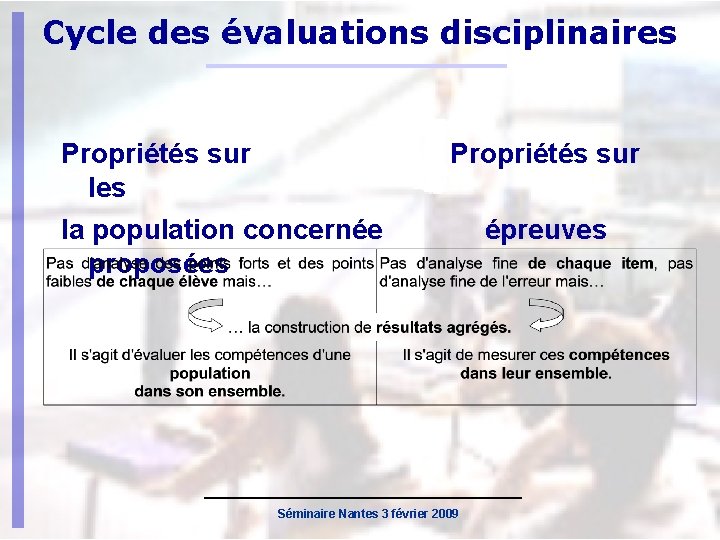

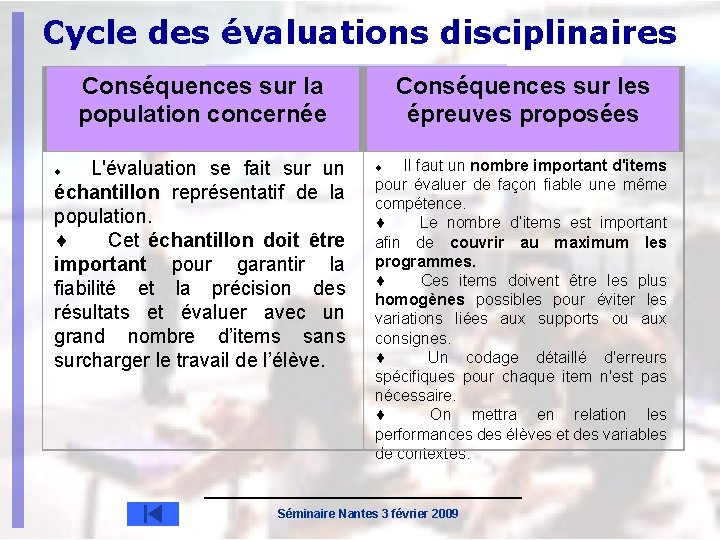

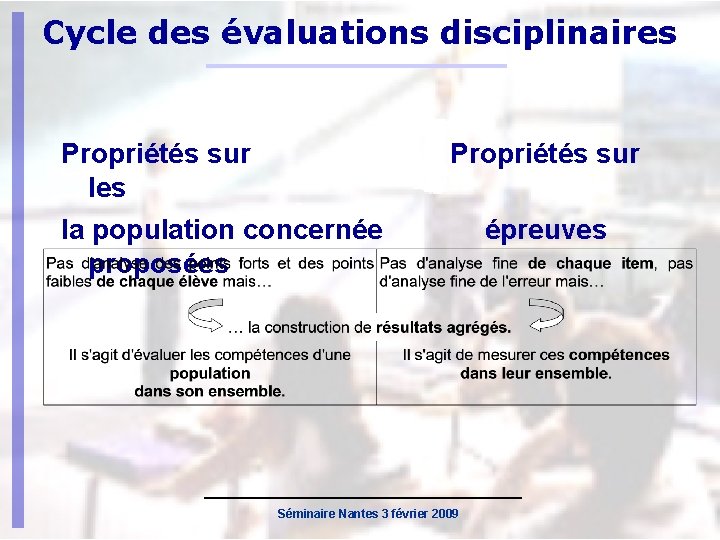

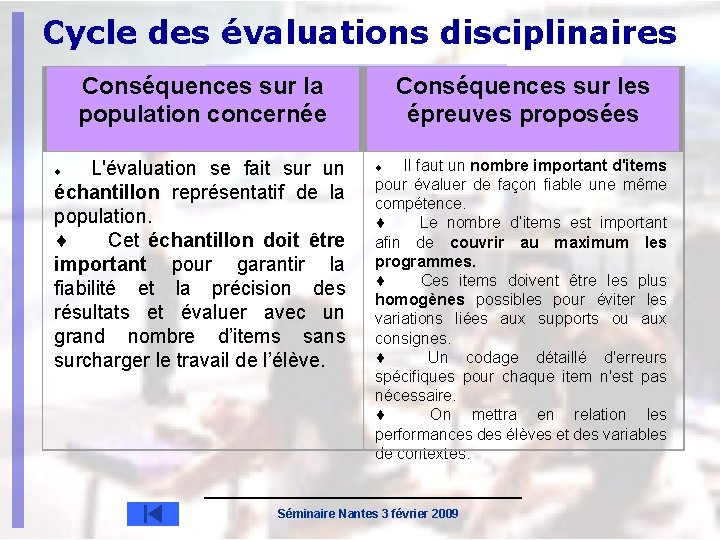

Cycle des évaluations disciplinaires Propriétés sur les la population concernée proposées Propriétés sur Séminaire Nantes 3 février 2009 épreuves

Cycle des évaluations disciplinaires Conséquences sur la population concernée L'évaluation se fait sur un échantillon représentatif de la population. ¨ Cet échantillon doit être important pour garantir la fiabilité et la précision des résultats et évaluer avec un grand nombre d’items sans surcharger le travail de l’élève. ¨ Conséquences sur les épreuves proposées Il faut un nombre important d'items pour évaluer de façon fiable une même compétence. ¨ Le nombre d’items est important afin de couvrir au maximum les programmes. ¨ Ces items doivent être les plus homogènes possibles pour éviter les variations liées aux supports ou aux consignes. ¨ Un codage détaillé d'erreurs spécifiques pour chaque item n'est pas nécessaire. ¨ On mettra en relation les performances des élèves et des variables de contextes. ¨ Séminaire Nantes 3 février 2009

Evaluation d’expérimentations • CP à effectifs réduits • EIST • Accompagnement éducatif Séminaire Nantes 3 février 2009

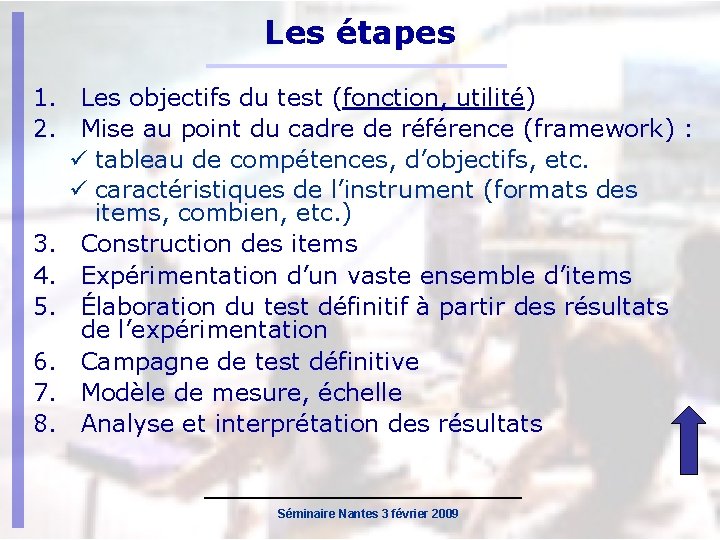

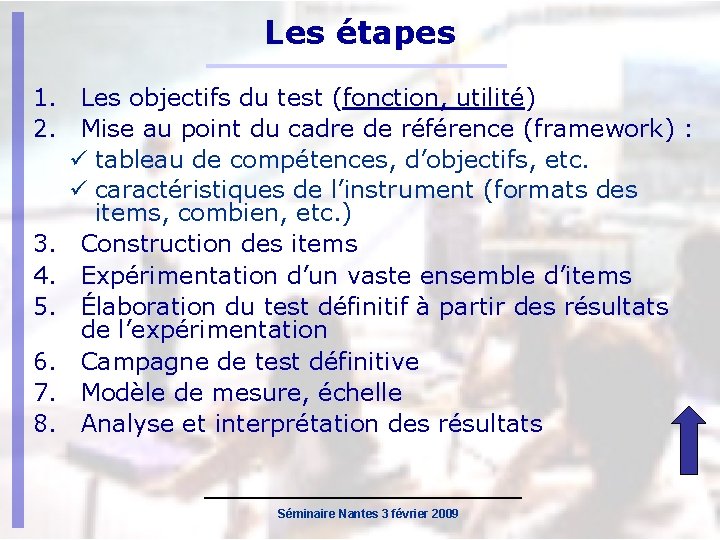

Les étapes 1. Les objectifs du test (fonction, utilité) 2. Mise au point du cadre de référence (framework) : tableau de compétences, d’objectifs, etc. caractéristiques de l’instrument (formats des items, combien, etc. ) 3. Construction des items 4. Expérimentation d’un vaste ensemble d’items 5. Élaboration du test définitif à partir des résultats de l’expérimentation 6. Campagne de test définitive 7. Modèle de mesure, échelle 8. Analyse et interprétation des résultats Séminaire Nantes 3 février 2009

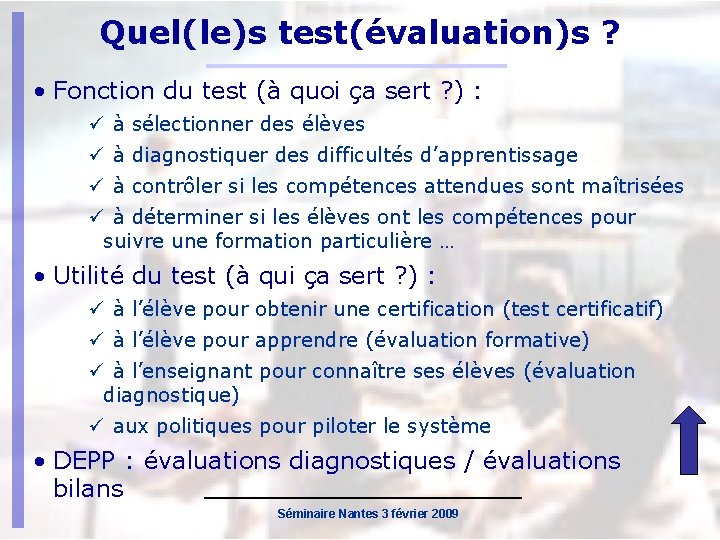

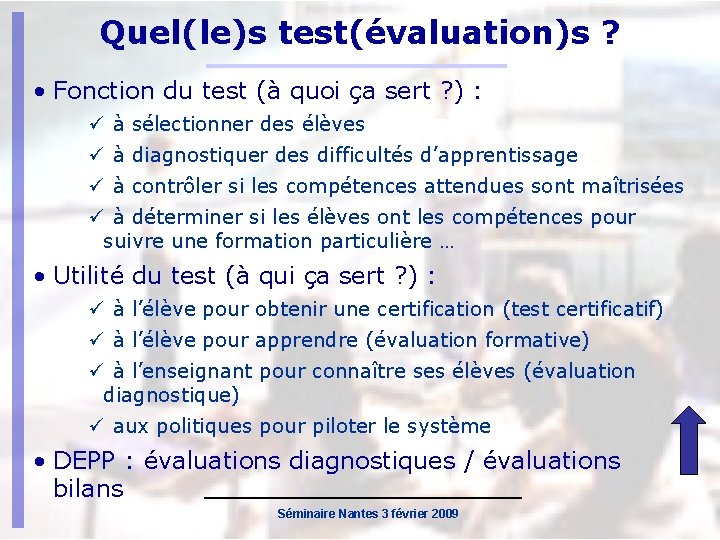

Quel(le)s test(évaluation)s ? • Fonction du test (à quoi ça sert ? ) : à sélectionner des élèves à diagnostiquer des difficultés d’apprentissage à contrôler si les compétences attendues sont maîtrisées à déterminer si les élèves ont les compétences pour suivre une formation particulière … • Utilité du test (à qui ça sert ? ) : à l’élève pour obtenir une certification (test certificatif) à l’élève pour apprendre (évaluation formative) à l’enseignant pour connaître ses élèves (évaluation diagnostique) aux politiques pour piloter le système • DEPP : évaluations diagnostiques / évaluations bilans Séminaire Nantes 3 février 2009

La validité • La validité correspond au degré de signification de l'instrument de mesure (test) et des données qu'il permet d'obtenir. • C'est le point crucial de l'évaluation d'un instrument • Différents types de validité : Validité Validité apparente de contenu critériée concomitante critériée prédictive conceptuelle Séminaire Nantes 3 février 2009

La fidélité • La fidélité d'un test renvoie à la reproductibilité des résultats obtenus à ce test, à la consistance de la mesure. Un test détecte un jeune en situation d’illettrisme aujourd’hui et bon lecteur le lendemain • Il existe différentes méthodes pour évaluer la fidélité d’un test : La La méthode des formes parallèles méthode test-retest méthode du split-half consistance interne : de Cronbach renvoie à la moyenne des corrélations entre items ( > 0. 80 = fidélité acceptable) Séminaire Nantes 3 février 2009

Les statistiques classiques • Le score des élèves • Le taux de réussite aux items • La discrimination des items point de vue « item » : corrélation entre la réussite à l’item et le score point de vue « élèves » : différence de niveau moyen entre les élèves qui ont réussi l’item et ceux qui l’ont échoué Indicateur : le r-bis Varie entre -1 et 1 (si < 0. 2 : l’item est peu discriminant) Séminaire Nantes 3 février 2009

La théorie du score vrai • Un modèle simple : score observé = score vrai + erreur de mesure • L’erreur de mesure peut provenir : du de de … dispositif d’observation la passation des tests l’instrument (longueur, formats, supports) la correction des réponses • Minimiser l’erreur de mesure à tous les niveaux = maximiser la fidélité, la précision du test Séminaire Nantes 3 février 2009

La passation des tests • Pour standardiser au maximum la passation des tests : des consignes précises l’ « administrateur de test » n’est pas un enseignant de la discipline évaluée son intervention est réduite les élèves n’ont pas les mêmes cahiers les élèves évalués ne viennent pas de la même classe • Favoriser la motivation des élèves Séminaire Nantes 3 février 2009

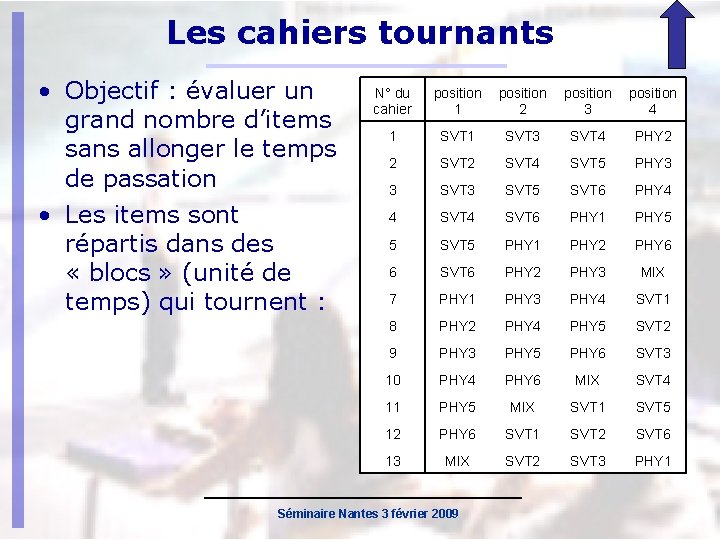

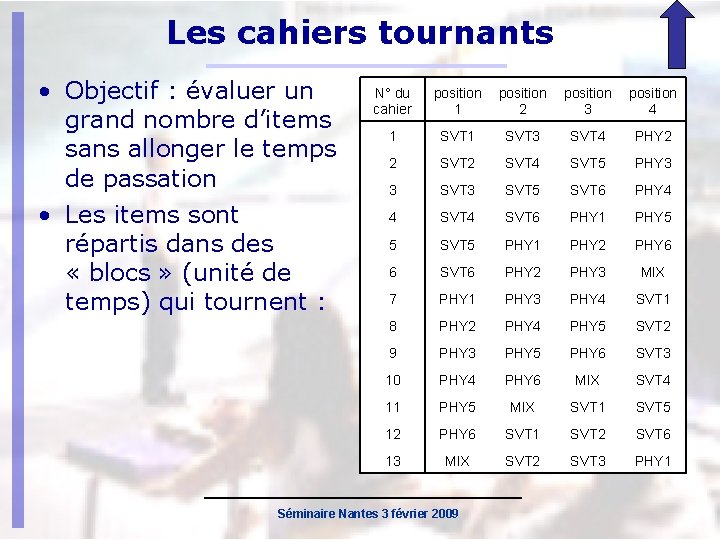

Les cahiers tournants • Objectif : évaluer un grand nombre d’items sans allonger le temps de passation • Les items sont répartis dans des « blocs » (unité de temps) qui tournent : N° du cahier position 1 position 2 position 3 position 4 1 SVT 3 SVT 4 PHY 2 2 SVT 4 SVT 5 PHY 3 3 SVT 5 SVT 6 PHY 4 4 SVT 6 PHY 1 PHY 5 5 SVT 5 PHY 1 PHY 2 PHY 6 6 SVT 6 PHY 2 PHY 3 MIX 7 PHY 1 PHY 3 PHY 4 SVT 1 8 PHY 2 PHY 4 PHY 5 SVT 2 9 PHY 3 PHY 5 PHY 6 SVT 3 10 PHY 4 PHY 6 MIX SVT 4 11 PHY 5 MIX SVT 1 SVT 5 12 PHY 6 SVT 1 SVT 2 SVT 6 13 MIX SVT 2 SVT 3 PHY 1 Séminaire Nantes 3 février 2009

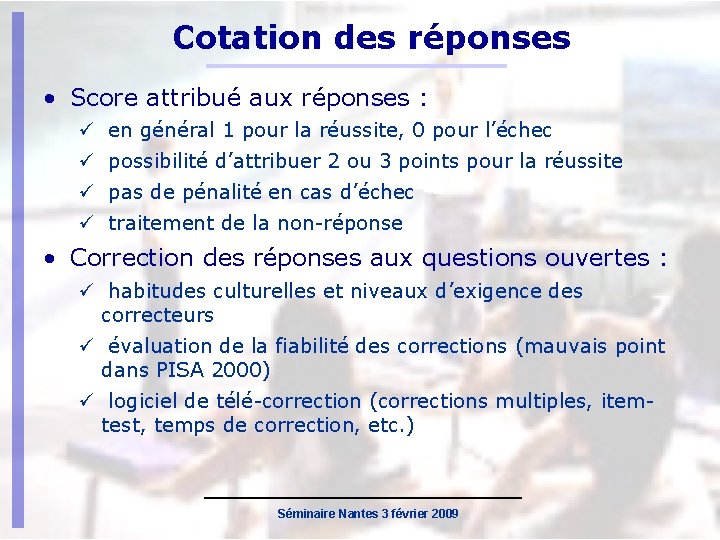

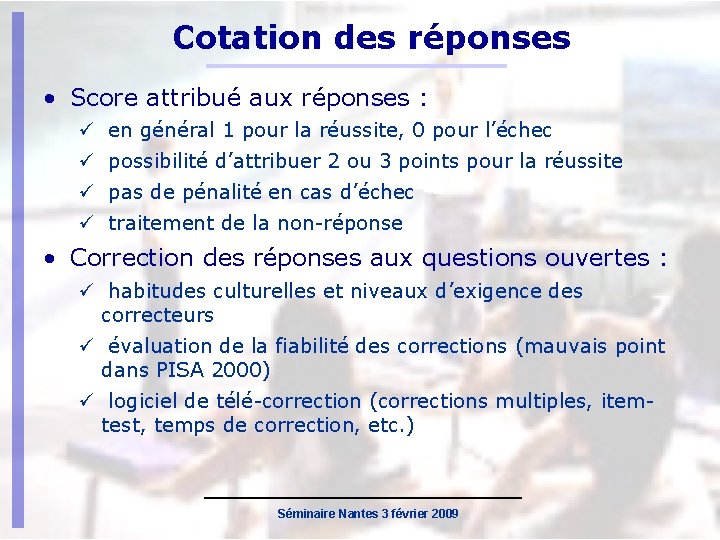

Cotation des réponses • Score attribué aux réponses : en général 1 pour la réussite, 0 pour l’échec possibilité d’attribuer 2 ou 3 points pour la réussite pas de pénalité en cas d’échec traitement de la non-réponse • Correction des réponses aux questions ouvertes : habitudes culturelles et niveaux d’exigence des correcteurs évaluation de la fiabilité des corrections (mauvais point dans PISA 2000) logiciel de télé-correction (corrections multiples, itemtest, temps de correction, etc. ) Séminaire Nantes 3 février 2009

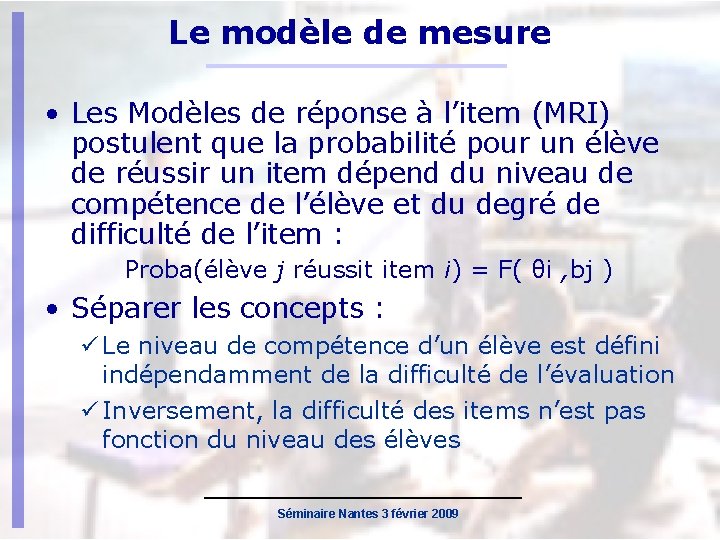

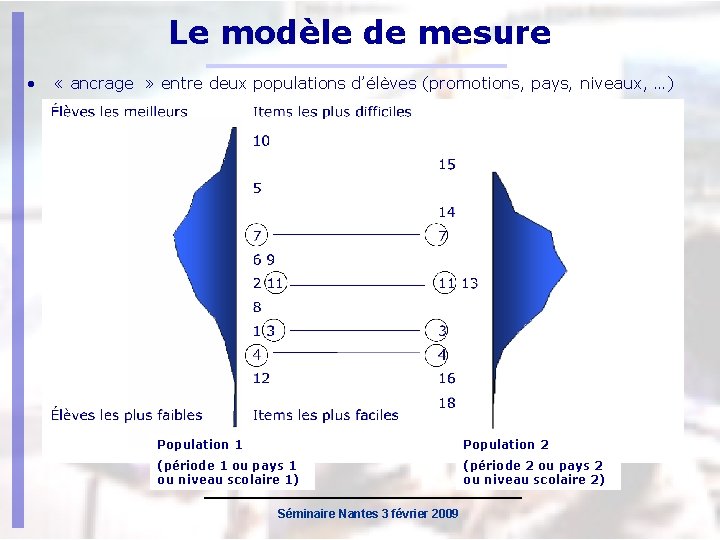

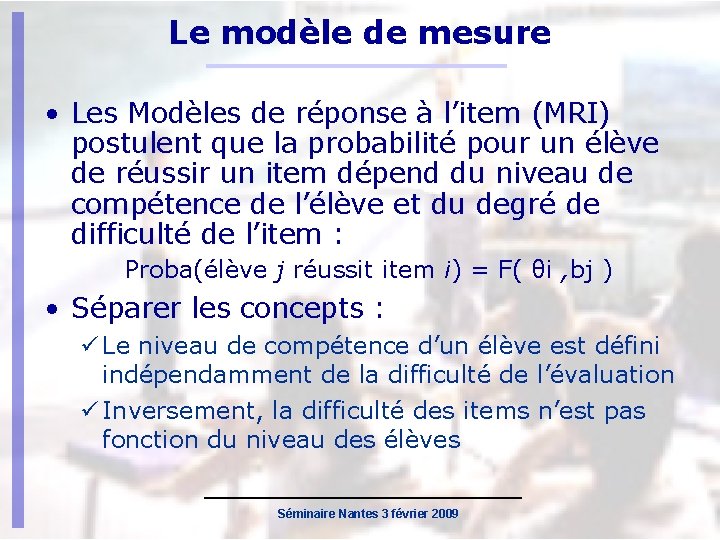

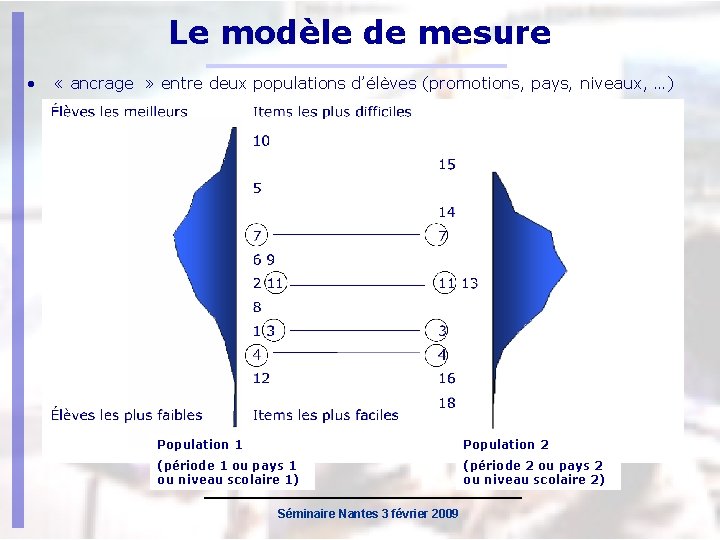

Le modèle de mesure • Les Modèles de réponse à l’item (MRI) postulent que la probabilité pour un élève de réussir un item dépend du niveau de compétence de l’élève et du degré de difficulté de l’item : Proba(élève j réussit item i) = F( θi , bj ) • Séparer les concepts : Le niveau de compétence d’un élève est défini indépendamment de la difficulté de l’évaluation Inversement, la difficulté des items n’est pas fonction du niveau des élèves Séminaire Nantes 3 février 2009

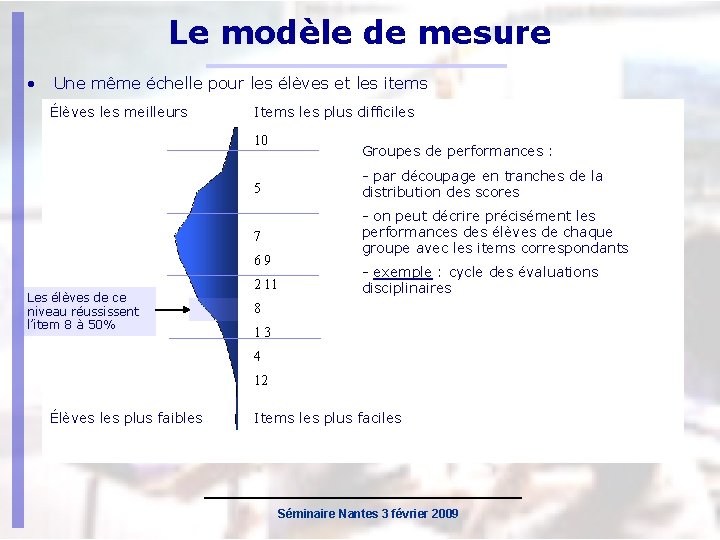

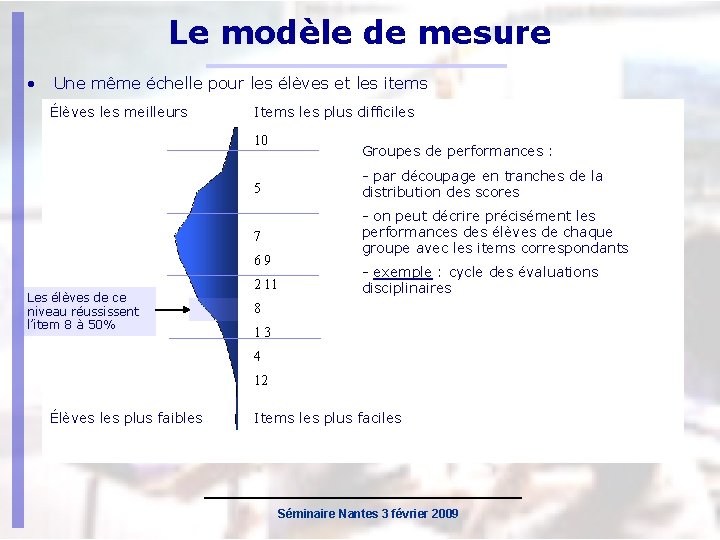

Le modèle de mesure • Une même échelle pour les élèves et les items Élèves les meilleurs Items les plus difficiles 10 5 - par découpage en tranches de la distribution des scores 7 - on peut décrire précisément les performances des élèves de chaque groupe avec les items correspondants 69 Les élèves de ce niveau réussissent l’item 8 à 50% Groupes de performances : 2 11 - exemple : cycle des évaluations disciplinaires 8 13 4 12 Élèves les plus faibles Items les plus faciles Séminaire Nantes 3 février 2009

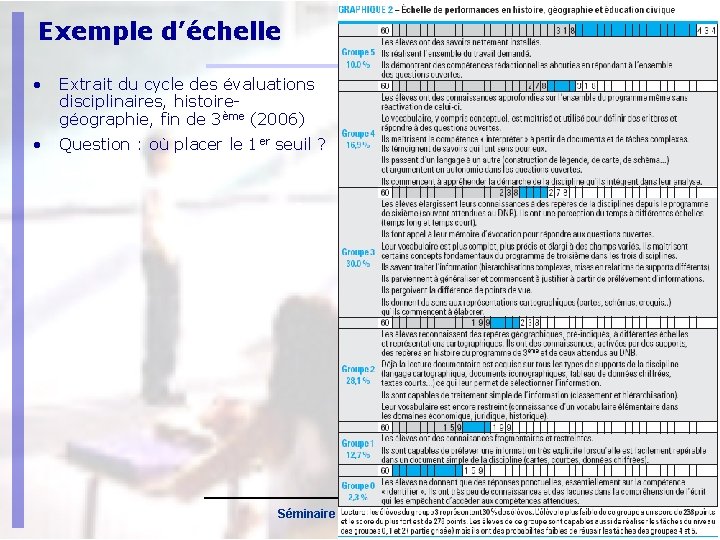

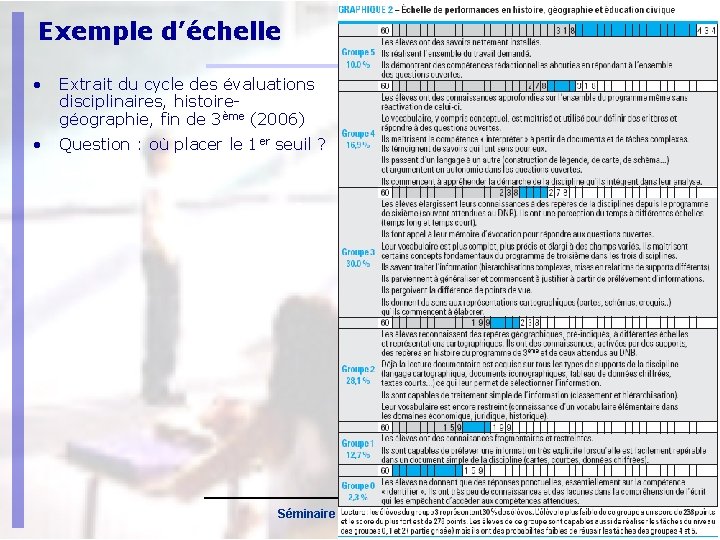

Exemple d’échelle • Extrait du cycle des évaluations disciplinaires, histoiregéographie, fin de 3ème (2006) • Question : où placer le 1 er seuil ? Séminaire Nantes 3 février 2009

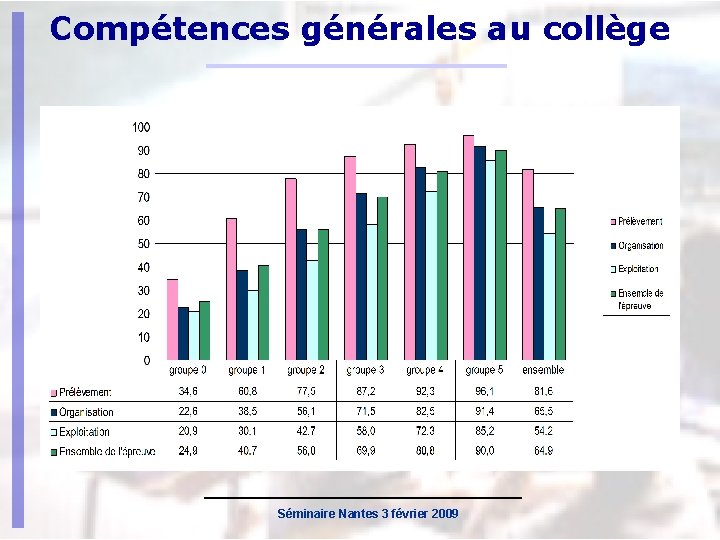

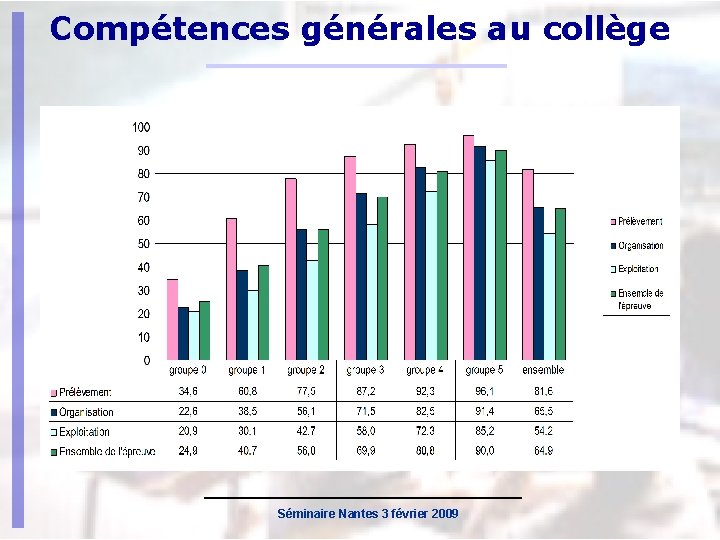

Compétences générales au collège Séminaire Nantes 3 février 2009

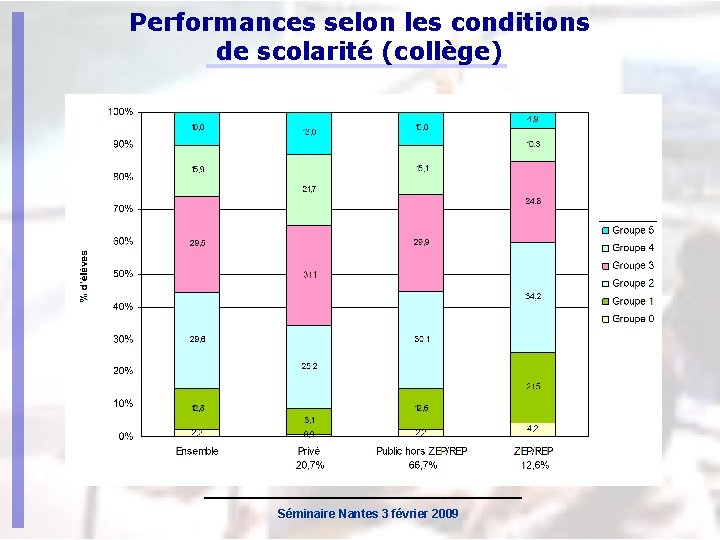

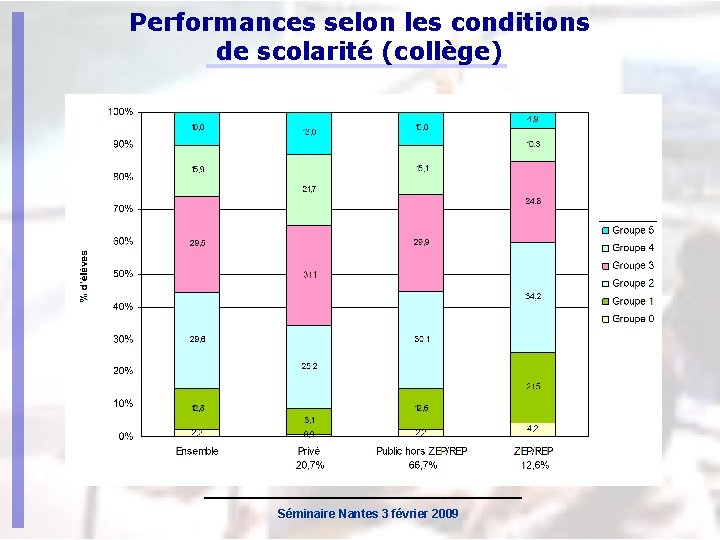

Performances selon les conditions de scolarité (collège) Séminaire Nantes 3 février 2009

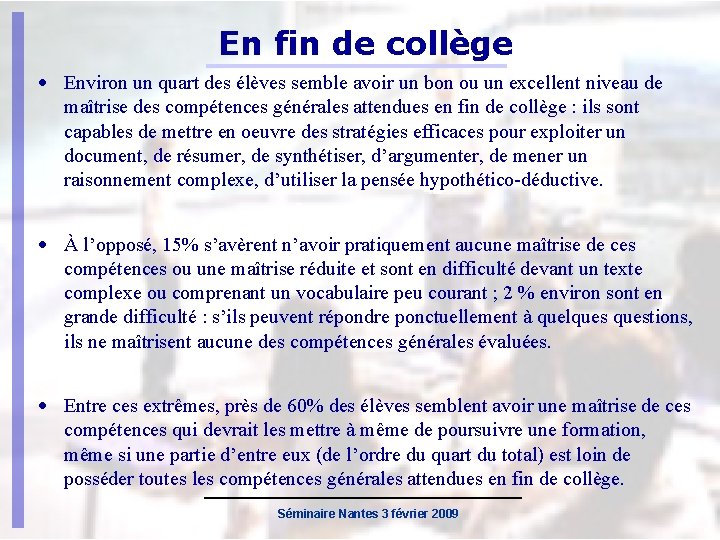

En fin de collège • Environ un quart des élèves semble avoir un bon ou un excellent niveau de maîtrise des compétences générales attendues en fin de collège : ils sont capables de mettre en oeuvre des stratégies efficaces pour exploiter un document, de résumer, de synthétiser, d’argumenter, de mener un raisonnement complexe, d’utiliser la pensée hypothético-déductive. • À l’opposé, 15% s’avèrent n’avoir pratiquement aucune maîtrise de ces compétences ou une maîtrise réduite et sont en difficulté devant un texte complexe ou comprenant un vocabulaire peu courant ; 2 % environ sont en grande difficulté : s’ils peuvent répondre ponctuellement à quelquestions, ils ne maîtrisent aucune des compétences générales évaluées. • Entre ces extrêmes, près de 60% des élèves semblent avoir une maîtrise de ces compétences qui devrait les mettre à même de poursuivre une formation, même si une partie d’entre eux (de l’ordre du quart du total) est loin de posséder toutes les compétences générales attendues en fin de collège. Séminaire Nantes 3 février 2009

Détermination d’un score-seuil • Question importante pour les indicateurs de la LOLF : « pourcentages d’élèves qui maîtrisent les compétences de base, en français et en mathématiques, en fin de CM 2 et en fin de 3ème » • En 2006, élaboration et expérimentation des épreuves • Comment fixer le seuil ? Arbitrairement, à partir des données : Par exemple, on « coupe » de manière à obtenir 15% des élèves en deçà du seuil Problème : relatif, sans rapport avec le contenu De manière subjective, sans tenir compte des données Par exemple, on décide d’un score-seuil a priori Problème : possible divergence entre ce jugement et les données • Idée : croiser le(s) jugement(s) expert(s) et les données Séminaire Nantes 3 février 2009

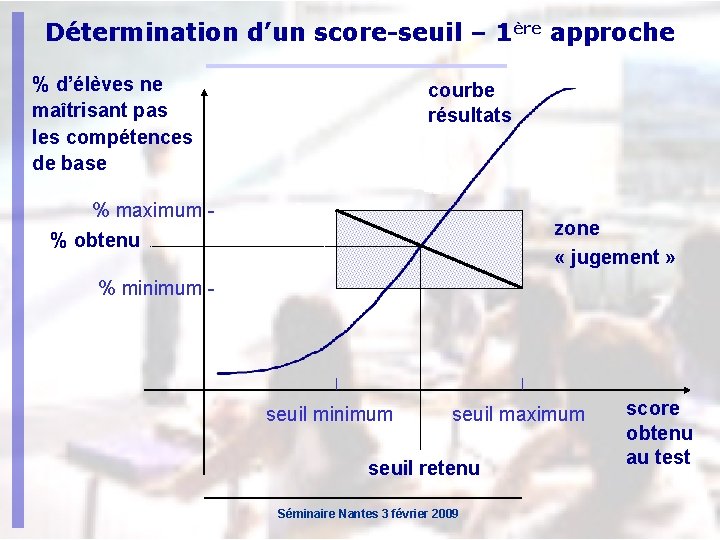

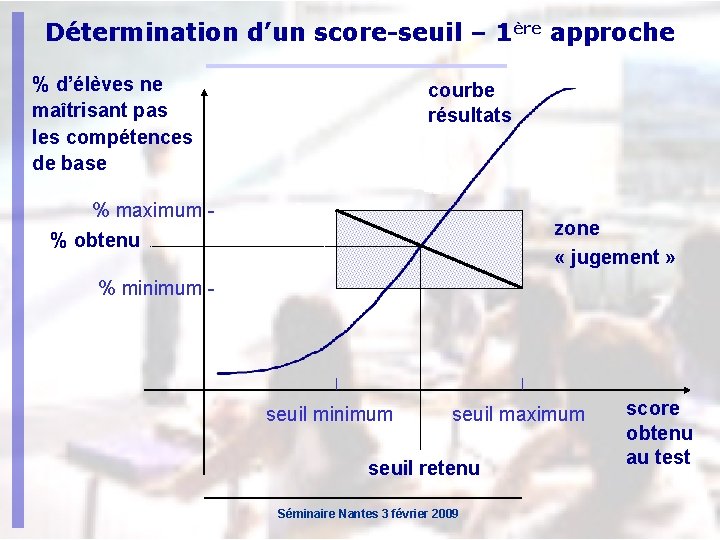

Détermination d’un score-seuil – 1ère approche % d’élèves ne maîtrisant pas les compétences de base courbe résultats % maximum % obtenu zone « jugement » % minimum - seuil minimum seuil maximum seuil retenu Séminaire Nantes 3 février 2009 score obtenu au test

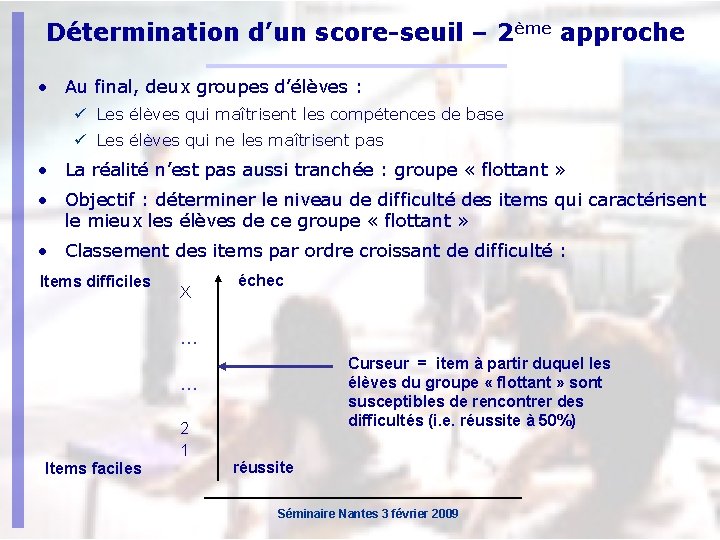

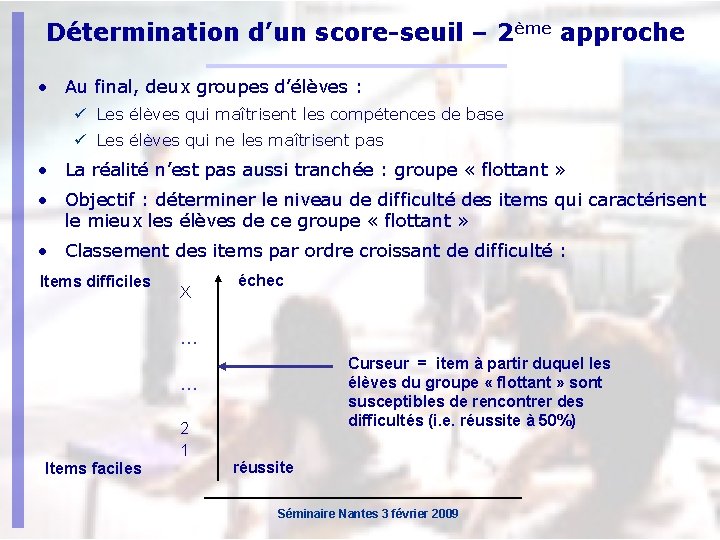

Détermination d’un score-seuil – 2ème approche • Au final, deux groupes d’élèves : Les élèves qui maîtrisent les compétences de base Les élèves qui ne les maîtrisent pas • La réalité n’est pas aussi tranchée : groupe « flottant » • Objectif : déterminer le niveau de difficulté des items qui caractérisent le mieux les élèves de ce groupe « flottant » • Classement des items par ordre croissant de difficulté : Items difficiles X échec … Curseur = item à partir duquel les élèves du groupe « flottant » sont susceptibles de rencontrer des difficultés (i. e. réussite à 50%) … 2 1 Items faciles réussite Séminaire Nantes 3 février 2009

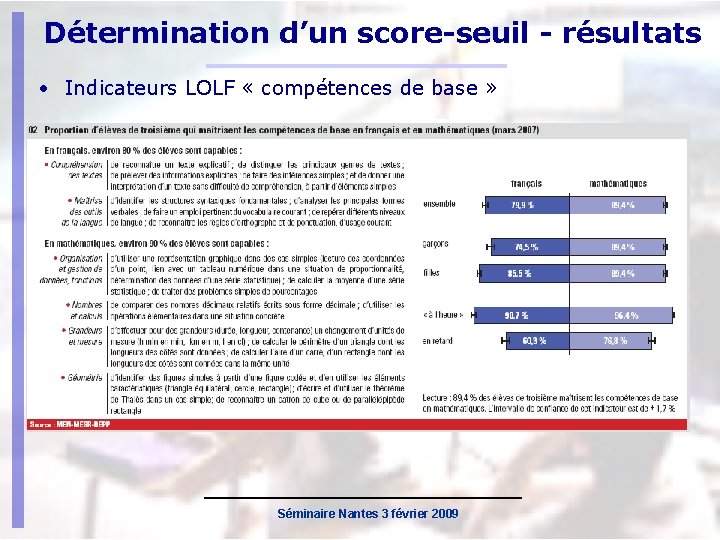

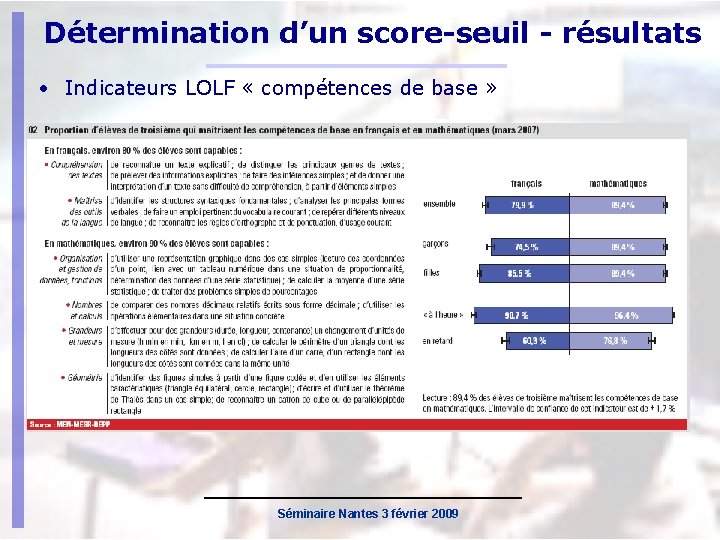

Détermination d’un score-seuil - résultats • Indicateurs LOLF « compétences de base » Séminaire Nantes 3 février 2009

Le modèle de mesure • « ancrage » entre deux populations d’élèves (promotions, pays, niveaux, …) Élèves les meilleurs Items les plus difficiles 10 15 5 14 7 7 69 11 13 2 11 8 3 13 4 4 16 18 12 Élèves les plus faibles Items les plus faciles Population 11 Population 22 Population (période 11 ou oupays 11 (période ouniveauscolaire 1) 1) ou (période 22 ou oupays 22 (période ouniveauscolaire 2) 2) ou Séminaire Nantes 3 février 2009

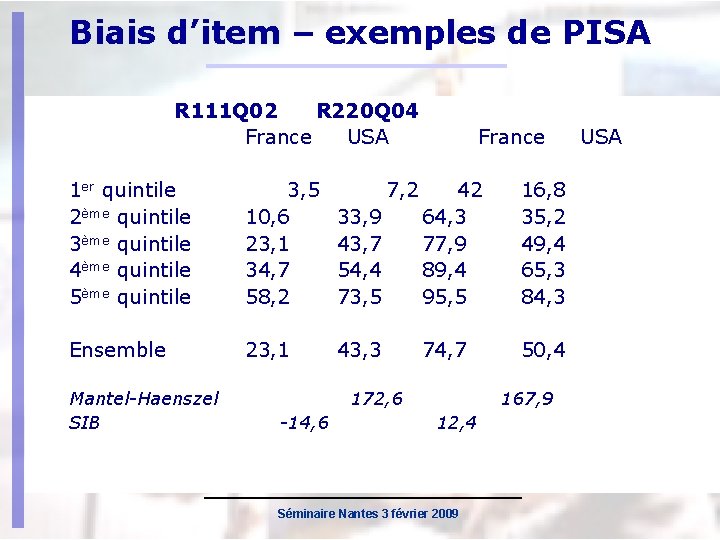

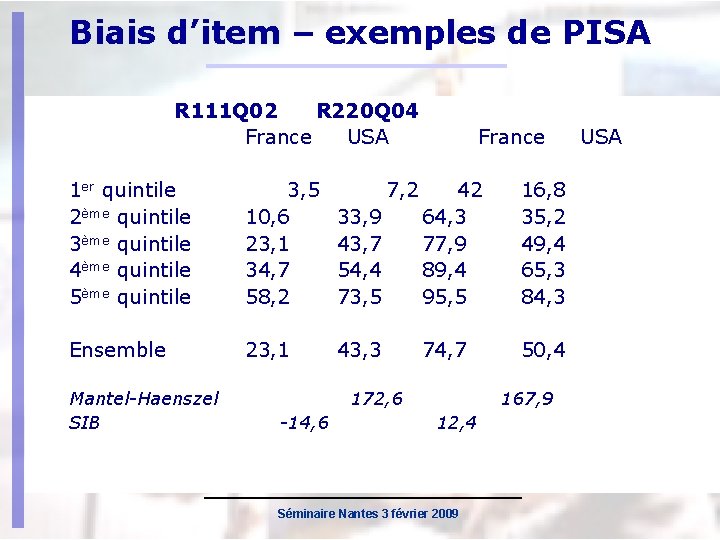

Biais d’item – exemples de PISA R 111 Q 02 R 220 Q 04 France USA 1 er quintile 2ème quintile 3ème quintile 4ème quintile 5ème quintile 3, 5 10, 6 23, 1 34, 7 58, 2 Ensemble 23, 1 Mantel-Haenszel SIB 7, 2 France 33, 9 43, 7 54, 4 73, 5 42 64, 3 77, 9 89, 4 95, 5 16, 8 35, 2 49, 4 65, 3 84, 3 43, 3 74, 7 50, 4 172, 6 -14, 6 167, 9 12, 4 Séminaire Nantes 3 février 2009 USA

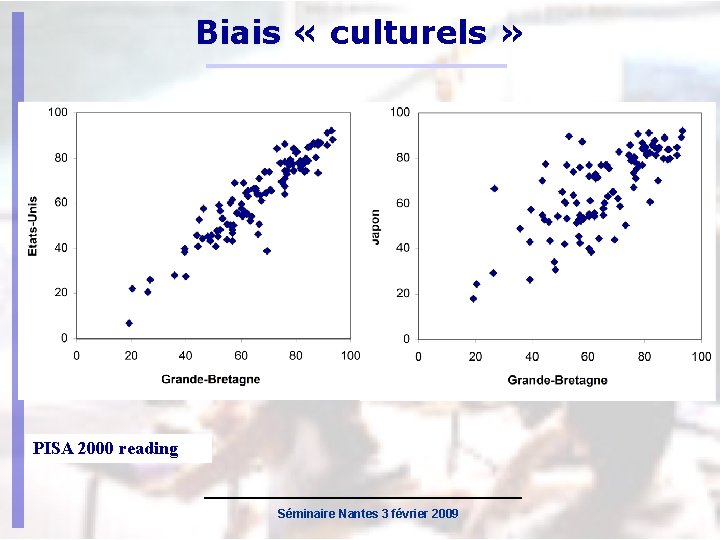

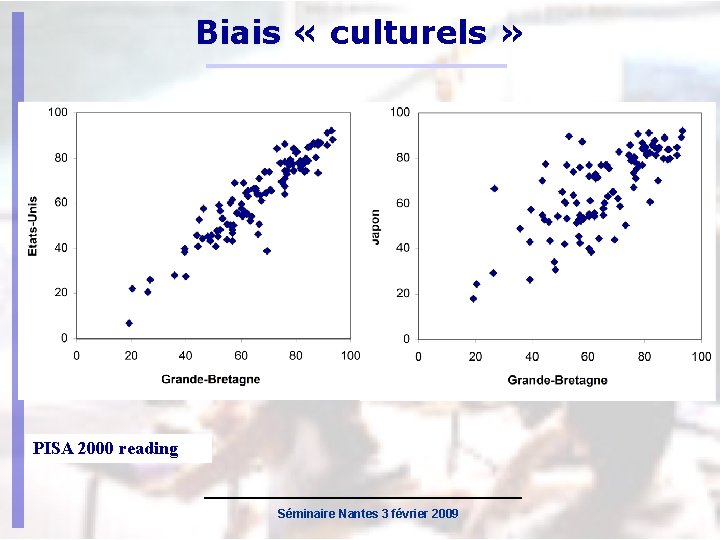

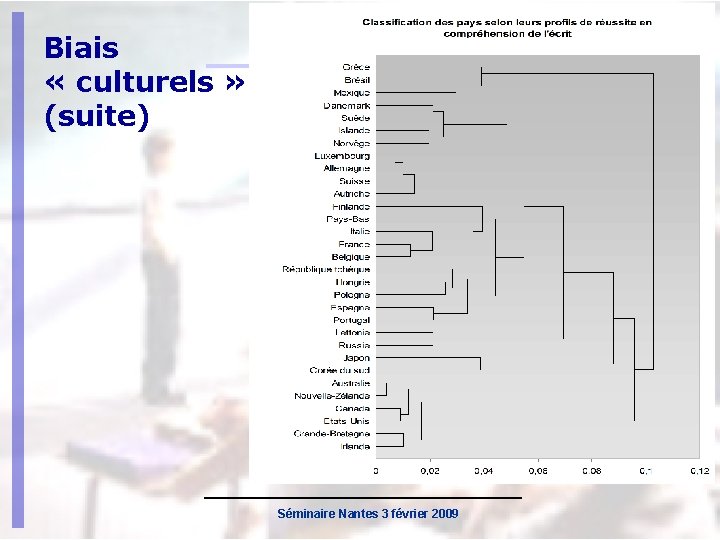

Biais « culturels » PISA 2000 reading Séminaire Nantes 3 février 2009

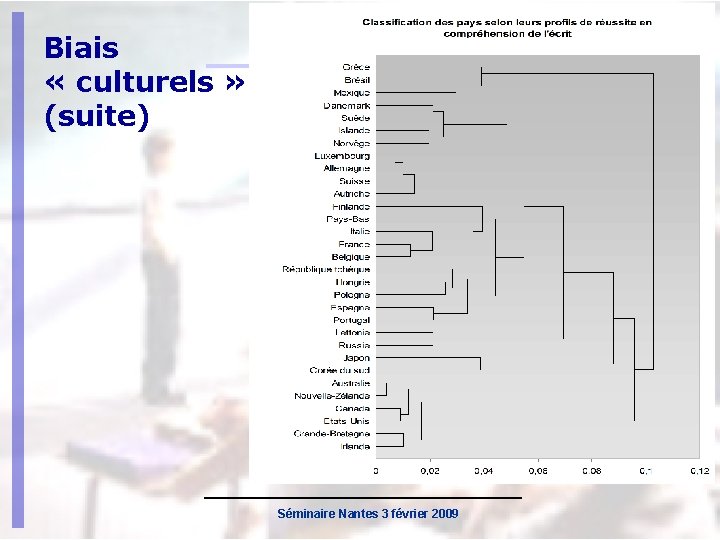

Biais « culturels » (suite) Séminaire Nantes 3 février 2009

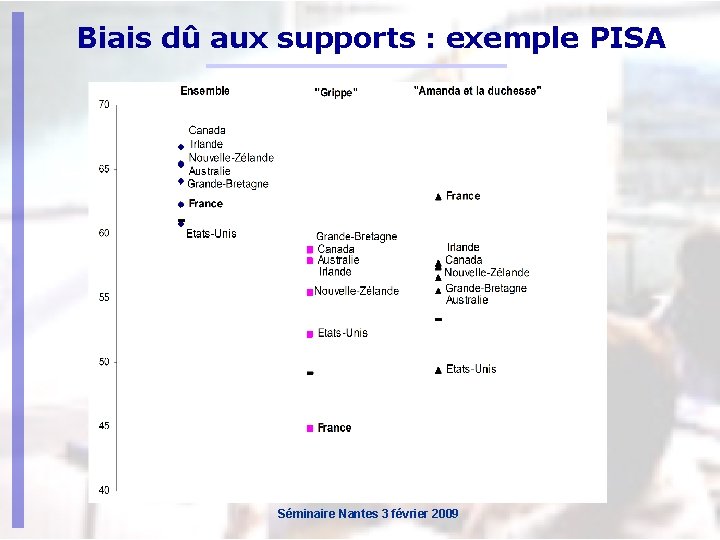

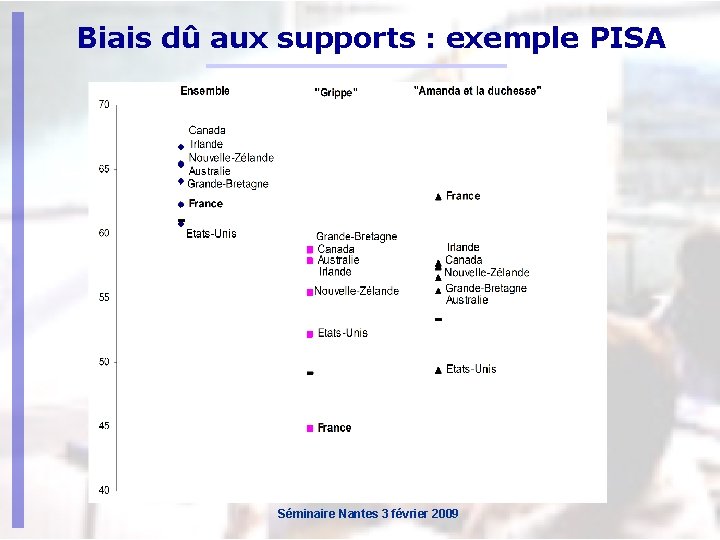

Biais dû aux supports : exemple PISA Séminaire Nantes 3 février 2009

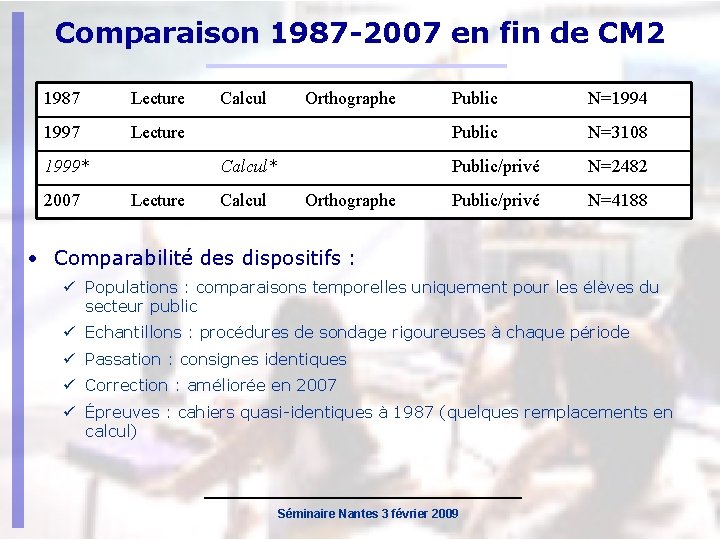

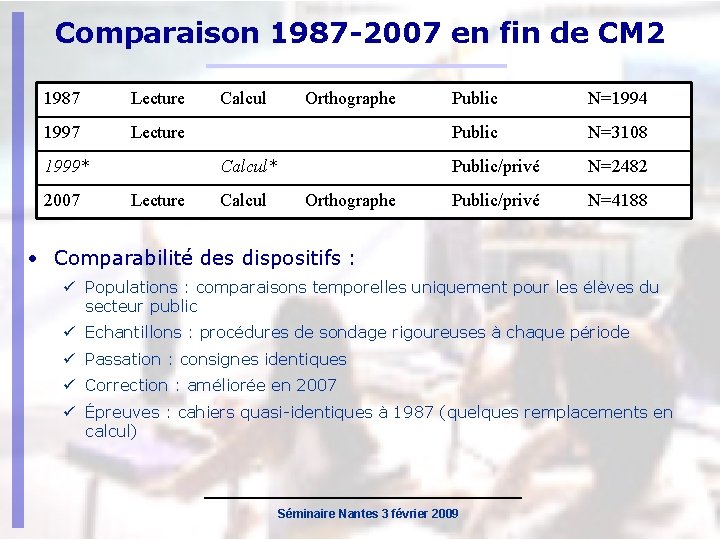

Comparaison 1987 -2007 en fin de CM 2 1987 Lecture 1999* 2007 Calcul Orthographe Calcul* Lecture Calcul Orthographe Public N=1994 Public N=3108 Public/privé N=2482 Public/privé N=4188 • Comparabilité des dispositifs : Populations : comparaisons temporelles uniquement pour les élèves du secteur public Echantillons : procédures de sondage rigoureuses à chaque période Passation : consignes identiques Correction : améliorée en 2007 Épreuves : cahiers quasi-identiques à 1987 (quelques remplacements en calcul) Séminaire Nantes 3 février 2009

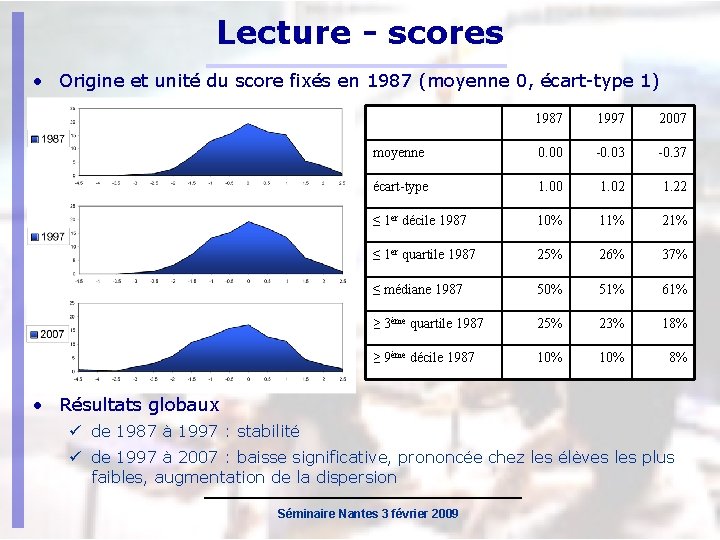

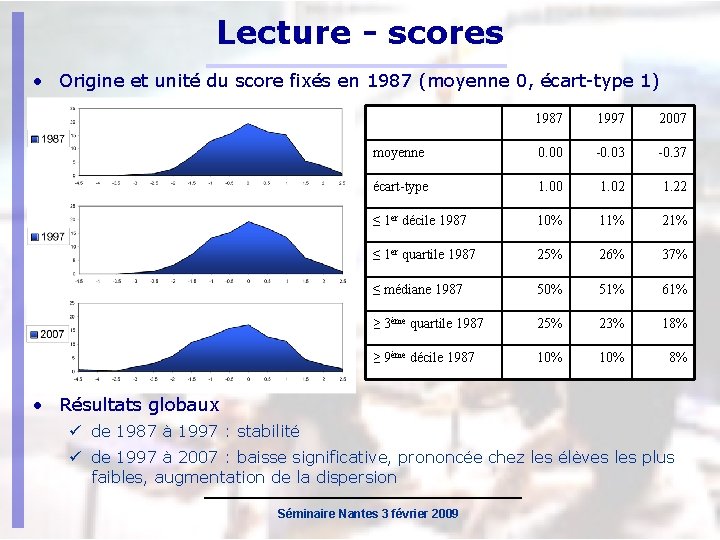

Lecture - scores • Origine et unité du score fixés en 1987 (moyenne 0, écart-type 1) 1987 1997 2007 moyenne 0. 00 -0. 03 -0. 37 écart-type 1. 00 1. 02 1. 22 ≤ 1 er décile 1987 10% 11% 21% ≤ 1 er quartile 1987 25% 26% 37% ≤ médiane 1987 50% 51% 61% ≥ 3ème quartile 1987 25% 23% 18% ≥ 9ème décile 1987 10% 8% • Résultats globaux de 1987 à 1997 : stabilité de 1997 à 2007 : baisse significative, prononcée chez les élèves les plus faibles, augmentation de la dispersion Séminaire Nantes 3 février 2009

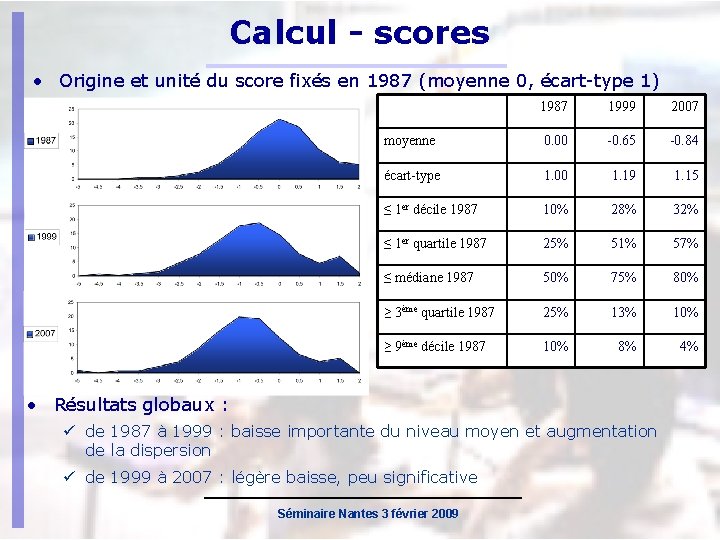

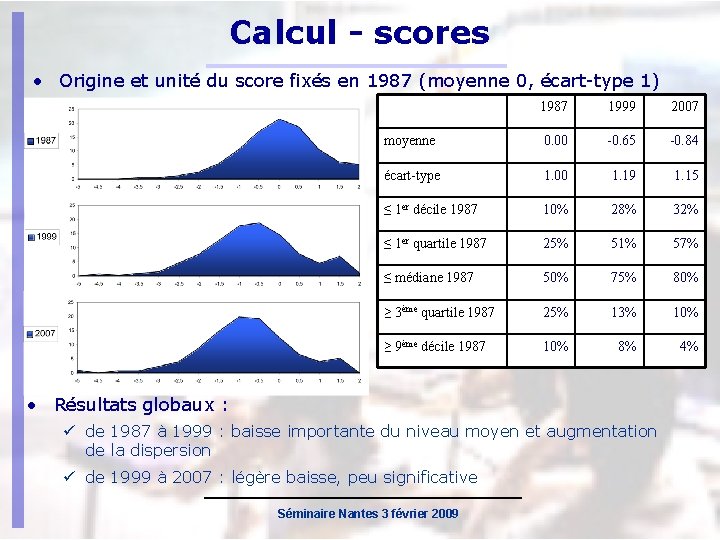

Calcul - scores • Origine et unité du score fixés en 1987 (moyenne 0, écart-type 1) 1987 1999 2007 moyenne 0. 00 -0. 65 -0. 84 écart-type 1. 00 1. 19 1. 15 ≤ 1 er décile 1987 10% 28% 32% ≤ 1 er quartile 1987 25% 51% 57% ≤ médiane 1987 50% 75% 80% ≥ 3ème quartile 1987 25% 13% 10% ≥ 9ème décile 1987 10% 8% 4% • Résultats globaux : de 1987 à 1999 : baisse importante du niveau moyen et augmentation de la dispersion de 1999 à 2007 : légère baisse, peu significative Séminaire Nantes 3 février 2009

Orthographe • Dictée Le soir tombait. Papa et maman, inquiets, se demandaient pourquoi leurs quatre garçons n’étaient pas rentrés. - Les gamins se sont certainement perdus, dit maman. S’ils n’ont pas encore retrouvé leur chemin, nous les verrons arriver très fatigués à la maison. - Pourquoi ne pas téléphoner à Martine ? Elle les a peut-être vus ! Aussitôt dit, aussitôt fait ! A ce moment, le chien se mit à aboyer. Nombre d’erreurs 1987 2007 Type d’erreurs Moyenne 10. 7 14. 7 Écart-type 8. 4 ≤ 2 erreurs 1987 2007 Erreurs lexicales 2. 1 2. 6 9. 2 Erreurs grammaticales 7. 1 10. 8 13% 6% Erreurs de ponctuation 1. 1 0. 9 ≤ 5 erreurs 31% 16% Autres (oublis, …) 0. 3 0. 4 ≥ 15 erreurs 26% 46% ≥ 25 erreurs 6% 12% Séminaire Nantes 3 février 2009

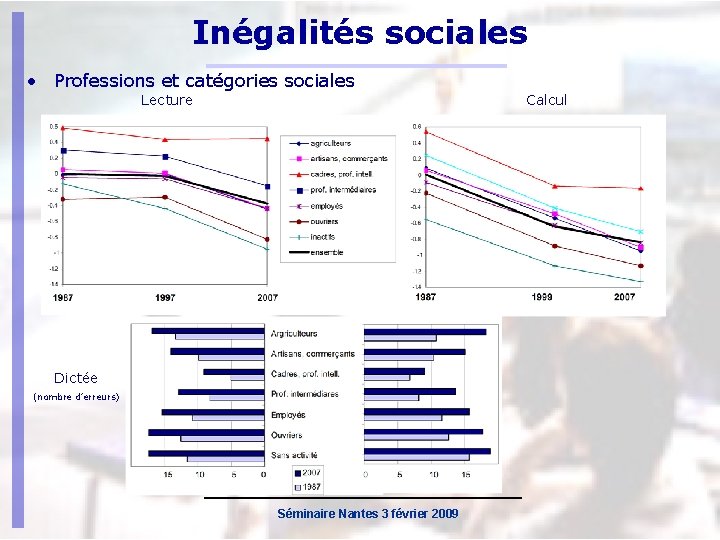

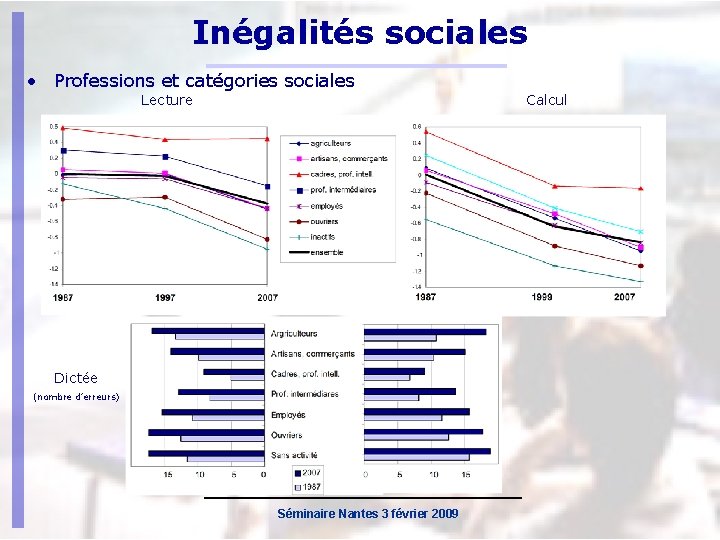

Inégalités sociales • Professions et catégories sociales Lecture Calcul Dictée (nombre d’erreurs) Séminaire Nantes 3 février 2009

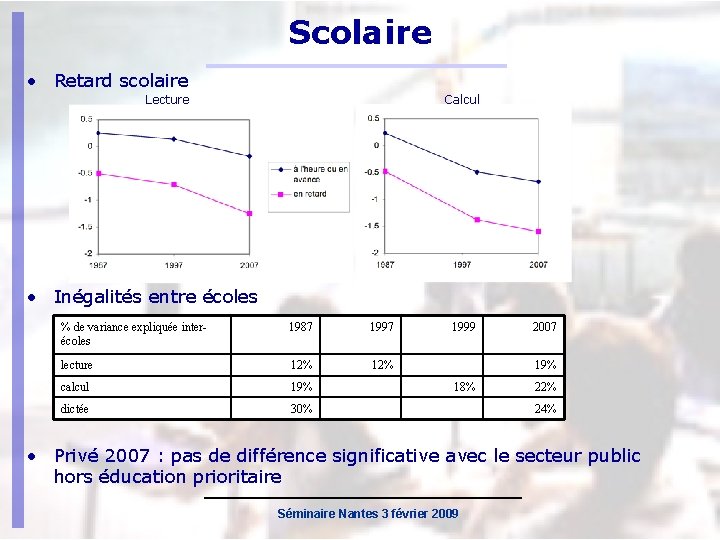

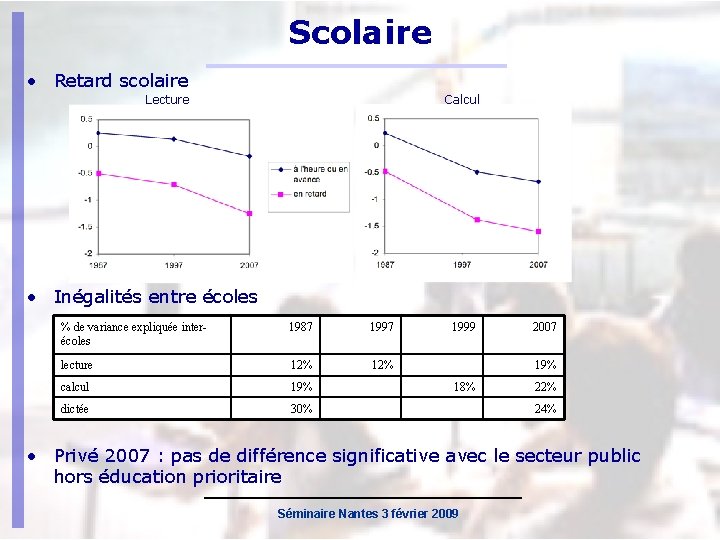

Scolaire • Retard scolaire Lecture Calcul • Inégalités entre écoles % de variance expliquée interécoles 1987 1997 lecture 12% calcul 19% dictée 30% 1999 2007 19% 18% 22% 24% • Privé 2007 : pas de différence significative avec le secteur public hors éducation prioritaire Séminaire Nantes 3 février 2009

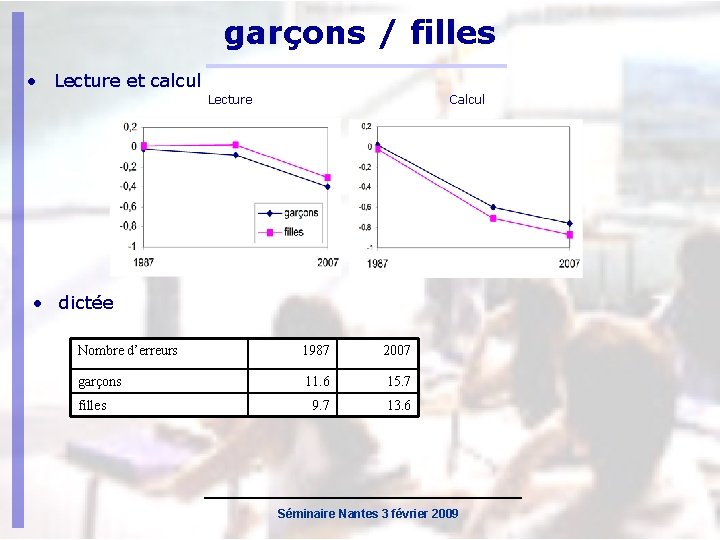

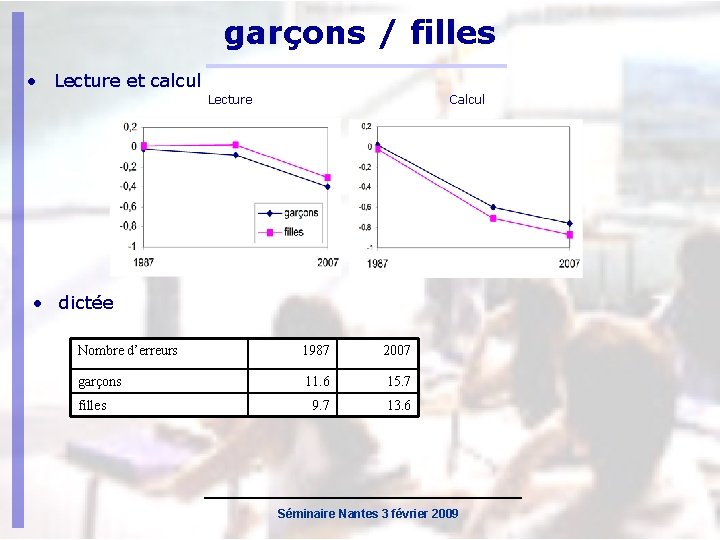

garçons / filles • Lecture et calcul Lecture Calcul • dictée Nombre d’erreurs 1987 2007 garçons 11. 6 15. 7 9. 7 13. 6 filles Séminaire Nantes 3 février 2009

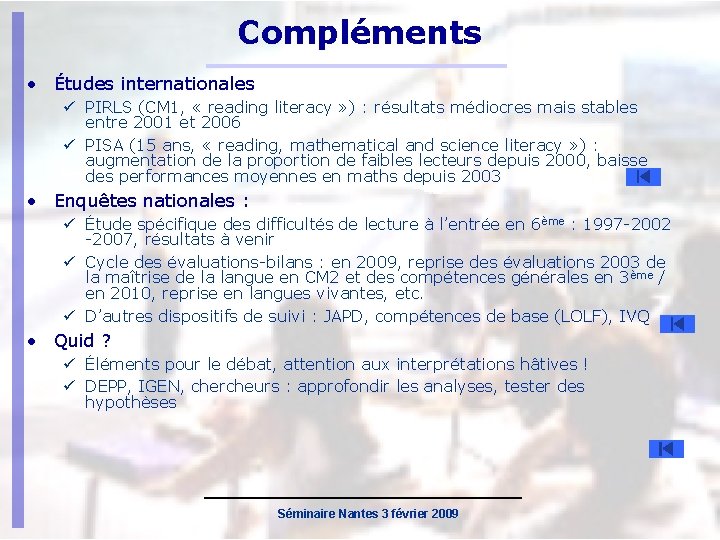

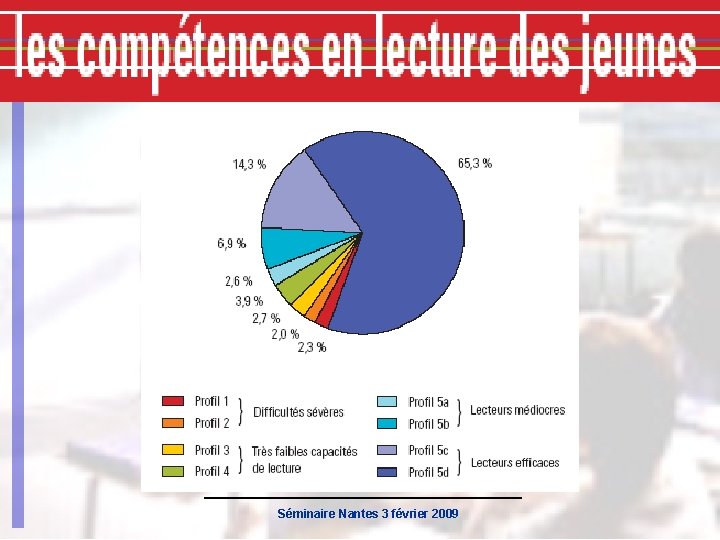

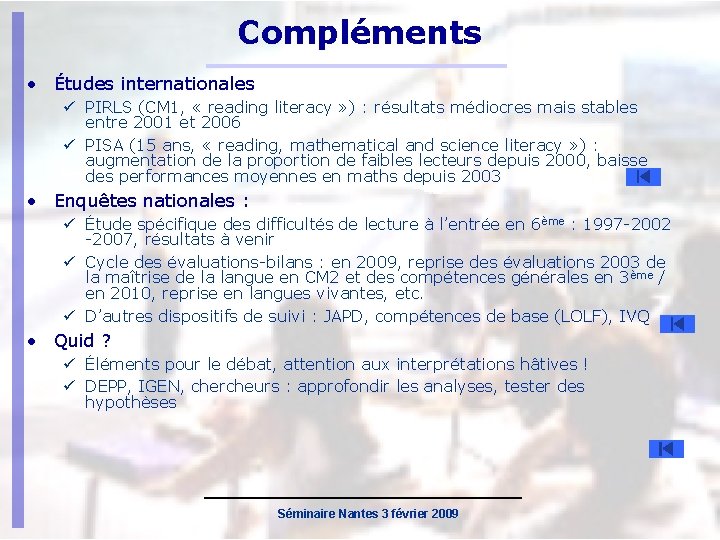

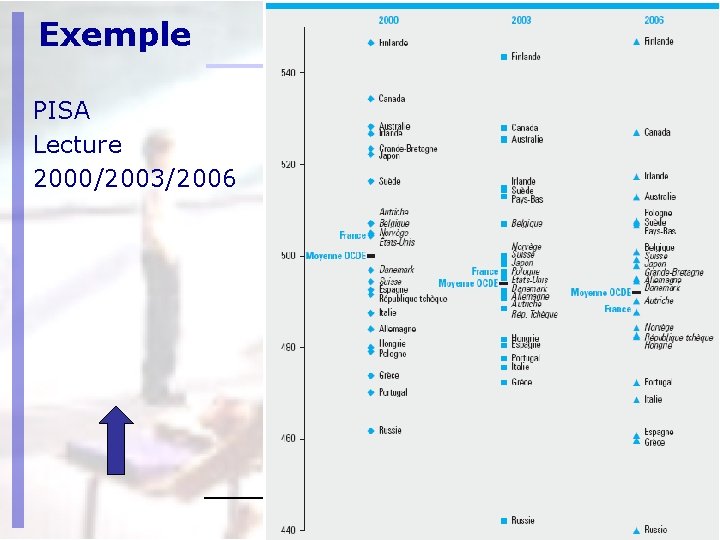

Compléments • Études internationales PIRLS (CM 1, « reading literacy » ) : résultats médiocres mais stables entre 2001 et 2006 PISA (15 ans, « reading, mathematical and science literacy » ) : augmentation de la proportion de faibles lecteurs depuis 2000, baisse des performances moyennes en maths depuis 2003 • Enquêtes nationales : Étude spécifique des difficultés de lecture à l’entrée en 6 ème : 1997 -2002 -2007, résultats à venir Cycle des évaluations-bilans : en 2009, reprise des évaluations 2003 de la maîtrise de la langue en CM 2 et des compétences générales en 3 ème / en 2010, reprise en langues vivantes, etc. D’autres dispositifs de suivi : JAPD, compétences de base (LOLF), IVQ • Quid ? Éléments pour le débat, attention aux interprétations hâtives ! DEPP, IGEN, chercheurs : approfondir les analyses, tester des hypothèses Séminaire Nantes 3 février 2009

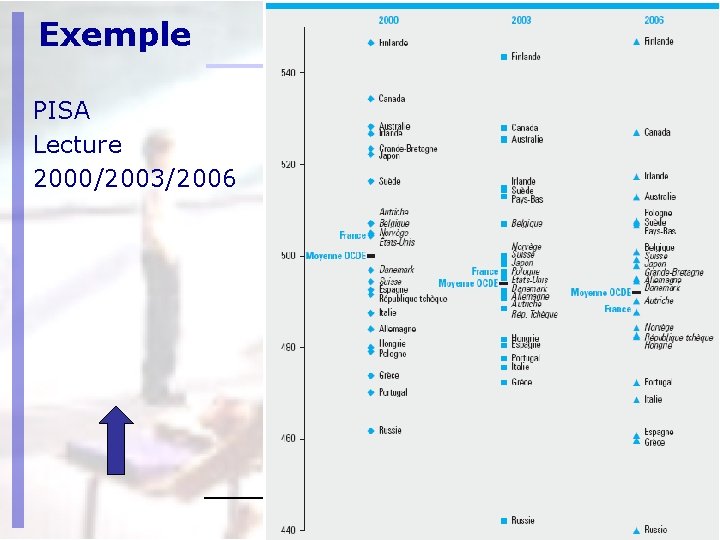

Exemple PISA Lecture 2000/2003/2006 Séminaire Nantes 3 février 2009

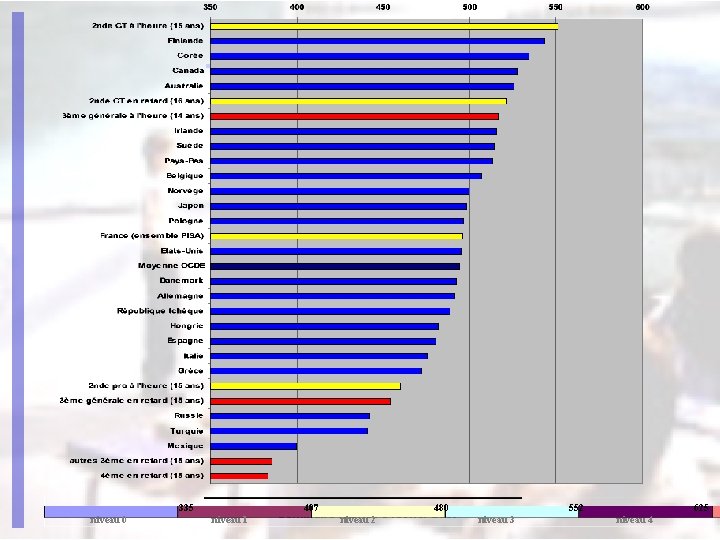

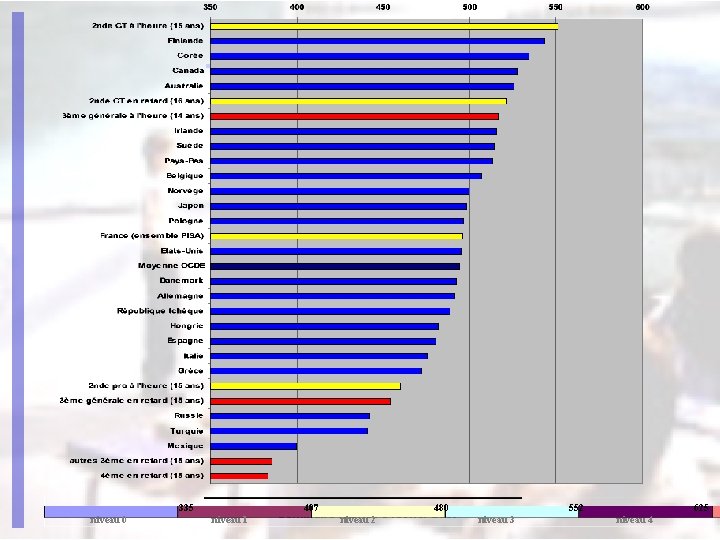

335 niveau 0 407 niveau 1 480 Séminaire Nantes 3 février 2009 niveau 2 552 niveau 3 625 niveau 4

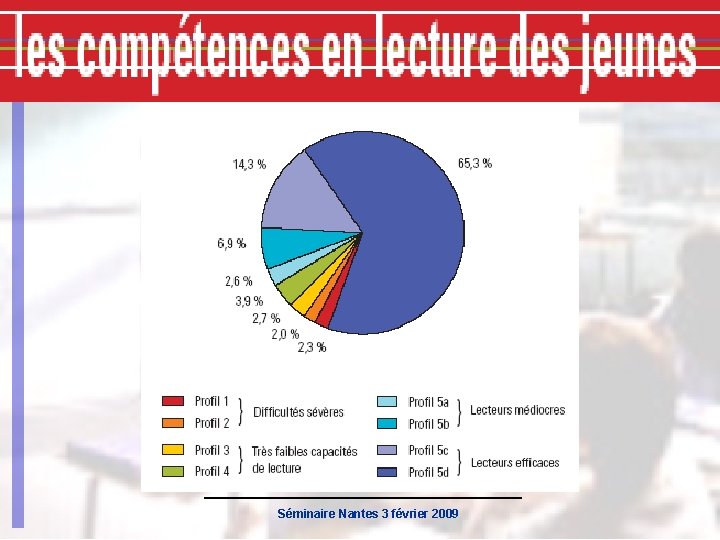

Séminaire Nantes 3 février 2009

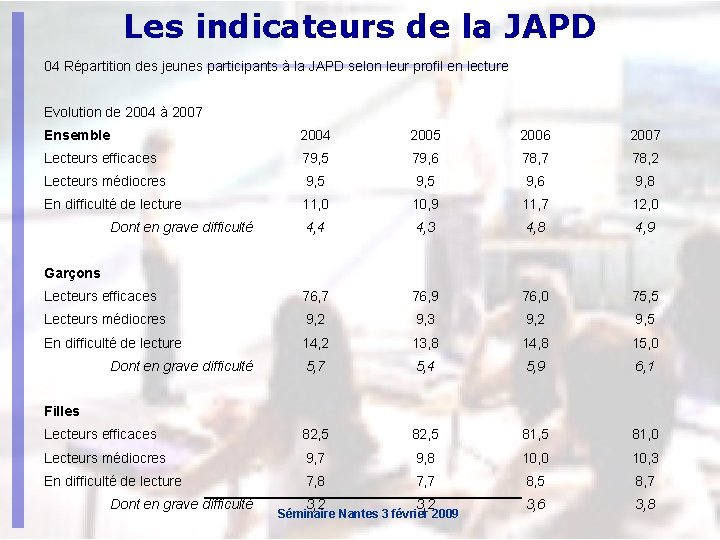

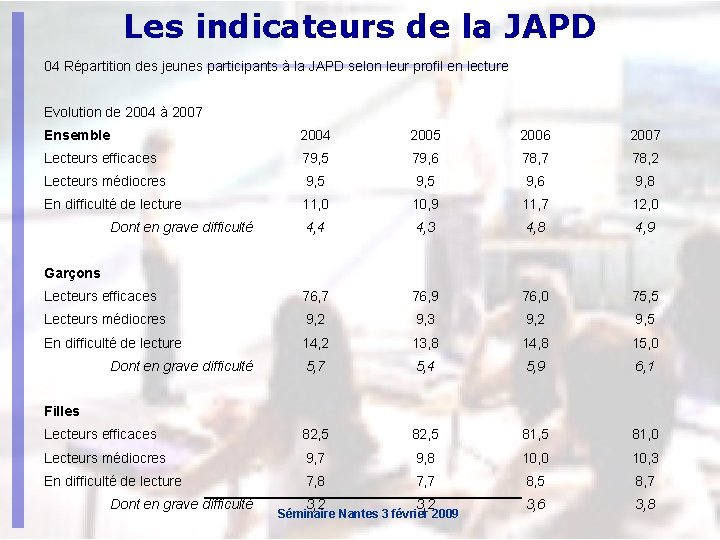

Les indicateurs de la JAPD 04 Répartition des jeunes participants à la JAPD selon leur profil en lecture Evolution de 2004 à 2007 Ensemble 2004 2005 2006 2007 Lecteurs efficaces 79, 5 79, 6 78, 7 78, 2 Lecteurs médiocres 9, 5 9, 6 9, 8 En difficulté de lecture 11, 0 10, 9 11, 7 12, 0 4, 4 4, 3 4, 8 4, 9 Lecteurs efficaces 76, 7 76, 9 76, 0 75, 5 Lecteurs médiocres 9, 2 9, 3 9, 2 9, 5 En difficulté de lecture 14, 2 13, 8 14, 8 15, 0 5, 7 5, 4 5, 9 6, 1 Lecteurs efficaces 82, 5 81, 0 Lecteurs médiocres 9, 7 9, 8 10, 0 10, 3 En difficulté de lecture 7, 8 7, 7 8, 5 8, 7 3, 2 3, 6 3, 8 Dont en grave difficulté Garçons Dont en grave difficulté Filles Dont en grave difficulté Séminaire Nantes 3 février 2009

Sites à consulter http: //educ-eval. education. fr portail de l’évaluation des acquis des élèves http: //cisad. adc. education. fr/eval évaluations diagnostiques de rentrée http: //www. banqoutils. education. gouv. fr banque d’outils d’aide à l’évaluation http: //www. education. gouv. fr/pid 53/evaluation-etstatistiques. html site de la DEPP Séminaire Nantes 3 février 2009

Séminaire Nantes 3 février 2009

Séminaire Nantes 3 février 2009

Séminaire Nantes 3 février 2009