Rseaux de Neurones Formels Commande de processus Groupe

![Méthode des ‘copies’ [ESPCI] · 1 : Représenter le réseau sous forme canonique (tous Méthode des ‘copies’ [ESPCI] · 1 : Représenter le réseau sous forme canonique (tous](https://slidetodoc.com/presentation_image_h/220fe488df0c464214d8d969d7635cf4/image-16.jpg)

![Chaîne logistique : unité de production [P. Massotte] Unité de production ORDRES Processus Chaîne logistique : unité de production [P. Massotte] Unité de production ORDRES Processus](https://slidetodoc.com/presentation_image_h/220fe488df0c464214d8d969d7635cf4/image-21.jpg)

![Architecture du réseau [A. Johannet ] · · Les neurones calculent la probabilité d’effectuer Architecture du réseau [A. Johannet ] · · Les neurones calculent la probabilité d’effectuer](https://slidetodoc.com/presentation_image_h/220fe488df0c464214d8d969d7635cf4/image-26.jpg)

![Approximation de variétés par réseaux de neurones auto-organisés [Michael Aupetit 98 -2001] Modèle discret Approximation de variétés par réseaux de neurones auto-organisés [Michael Aupetit 98 -2001] Modèle discret](https://slidetodoc.com/presentation_image_h/220fe488df0c464214d8d969d7635cf4/image-29.jpg)

- Slides: 34

Réseaux de Neurones Formels Commande de processus Groupe Heuristiques et Systèmes complexes Centre de recherche LGI 2 P 1

Plan · · Introduction Axes de recherche sur les RNF au LGI 2 P Applications à la commande de processus Perspectives Centre de recherche LGI 2 P 2

Introduction Centre de recherche LGI 2 P 3

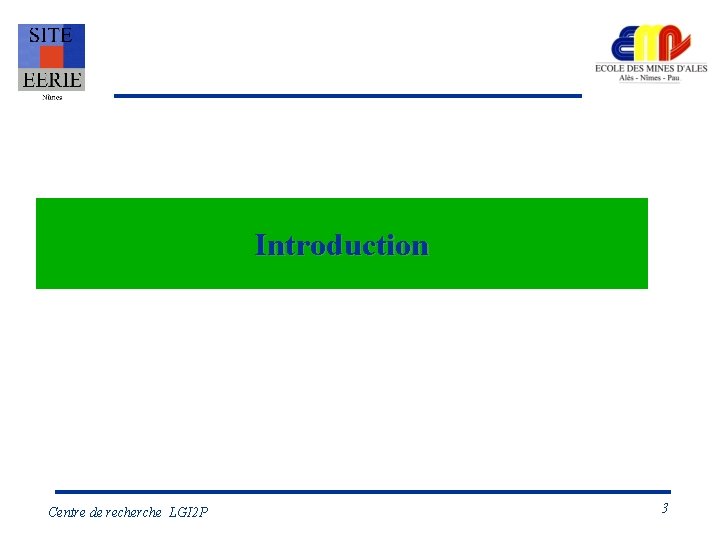

Réseaux de neurones formels · Neurone formel Propriétés des réseaux de neurones formels : – Approximation universelle – Apprentissage – Généralisation v : potentiel neuronal f : fonction dévaluation sorties sortie retards . . . entrées Réseau multicouche (statique) Centre de recherche LGI 2 P entrées Réseau bouclé Cartes Auto-organisatrices Kohonen 4

Approximation · Approximation universelle – Un réseau statique à une couche cachée à fonction d'évaluation sigmoïde peut approcher toute fonction continue avec la précision désirée (Hornik[89], Cybenko[89]). · Mais : – Comment choisir les entrées ? – Combien de neurones ? – Comment calculer les coefficients synaptiques ? Centre de recherche LGI 2 P 5

Apprentissage · Apprentissage C'est la phase de calcul des poids synaptiques à partir de données afin que le réseau associe convenablement entrées et sorties du réseau. · Apprentissage supervisé : Le "professeur"connaît les sorties désirées et corrige le réseau en fonction des erreurs commises. · Apprentissage par renforcement : Le "professeur" ne connaît pas les sorties désirées mais est capable de guider l'ajustement des poids par une forme de "critique". · Apprentissage non supervisé : Pas de "professeur", le réseau s'auto-organise en fonction des données et d'une règle de modification des poids synaptiques. Centre de recherche LGI 2 P 6

Généralisation · Généralisation : C'est la capacité du réseau à interpoler, c'est à dire à traiter correctement des données "proches" de celle rencontrées pendant l'apprentissage. · Un réseau ne peut pas a priori extrapoler : Sa réponse à des entrées éloignées de celles présentées pendant l'apprentissage est a priori incorrecte. Centre de recherche LGI 2 P 7

Applications des RNF · · · Approximation de fonction, Classification, Traitement du signal, Modélisation et commande de processus non linéaires, Simulation et prédiction de phénomènes : physiques, économiques. . . Centre de recherche LGI 2 P 8

Axes de recherche sur les RNF au LGI 2 P Centre de recherche LGI 2 P 9

Axes de recherche - Choix d’un modèle neuronal Architectures - Approches locales/globales - Apprentissage supervisé (réseaux bouclés) RNF Apprentissage - Apprentissage par renforcement - Apprentissage non supervisé (voisinage g obs) - Classification, prédiction, commande Applications - Systèmes des production, environnement, services, biotechnologies Outils - Test de cartes neuronales : ZISC - Développement de logiciels Centre de recherche LGI 2 P 10

Travaux menés en laboratoire · Thèses : 4 + 1 en cours – – – · DEA : 5 – · Séparation de source de signaux présentant des retards purs Contribution a l’étude et au développement de modèles connexionnistes à apprentissage par renforcement : application à l’acquisition de comportements adaptatifs Commande par Réseaux de Neurones : Application au Contrôle d’un Préhenseur Pneumatique Approximation de variétés par réseaux auto-organisés Apprentissage par renforcement et systèmes distribués Thèmes : Classification, Identification de processus dynamiques, Apprentissage par renforcement Travaux personnels d’étudiants (IR, stages…) : – Thèmes : Apprentissage par renforcement (Hexapode), apprentissage de réseaux bouclés (modélisation de systèmes karstiques, méthodes copies), reconnaissance de formes Centre de recherche LGI 2 P 11

Projets · Projets Européens (ESPRIT) – · Projets Nationaux – – – · IMRA [|99 -00] : Détection d’obstacles par radar ultrasonore. SABATE[99] : classification de bouchons QUALIFLOW [00] : Conception d’un contrôleur de débit massique. Convention de collaboration – · QUETA [Esprit, 1996 -1999] : Quality Engineering Tools for Assembly and Small Batches Manufacturing IBM (carte ZISC) [00 -…] Projets d ’étudiants en entreprise et encadrés par le LGI 2 P – – CVI : Maintenance conditionnelle : Diagnostic de défaut sur machine tournante SNR : Analyse qualité sur des roulements à bille [00 -02] Centre de recherche LGI 2 P 12

Applications à la commande de processus Centre de recherche LGI 2 P 13

Apprentissage supervisé de Réseaux de neurones bouclés · Application à la commande en position d’un actionneur pneumatique · Analyse et calcul de paramètres d’une chaîne logistique Metal bellows Centre de recherche LGI 2 P 14

Apprentissage supervisé de réseau bouclés : problème e 1 k Sf e 2 k s k-1 Sf Sf 1 + d k Fonction réalisée par le RNF : s k Fonction de coût : Règle d’apprentissage (descente de gradient) Problème : le gradient à l’itération k dépend de toutes les valeurs de gradient passées. avec Centre de recherche LGI 2 P => complexité de calcul croissante 15

![Méthode des copies ESPCI 1 Représenter le réseau sous forme canonique tous Méthode des ‘copies’ [ESPCI] · 1 : Représenter le réseau sous forme canonique (tous](https://slidetodoc.com/presentation_image_h/220fe488df0c464214d8d969d7635cf4/image-16.jpg)

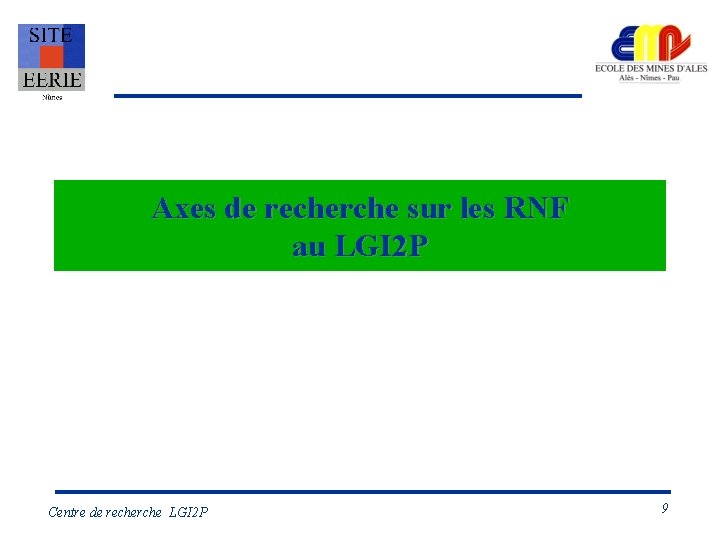

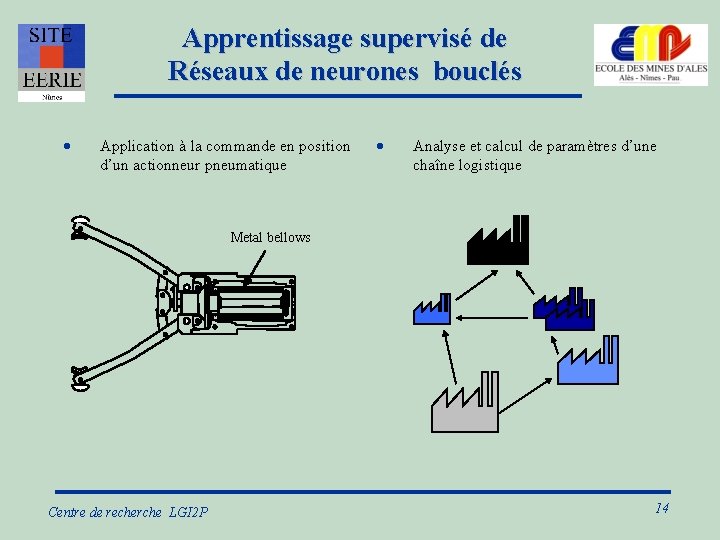

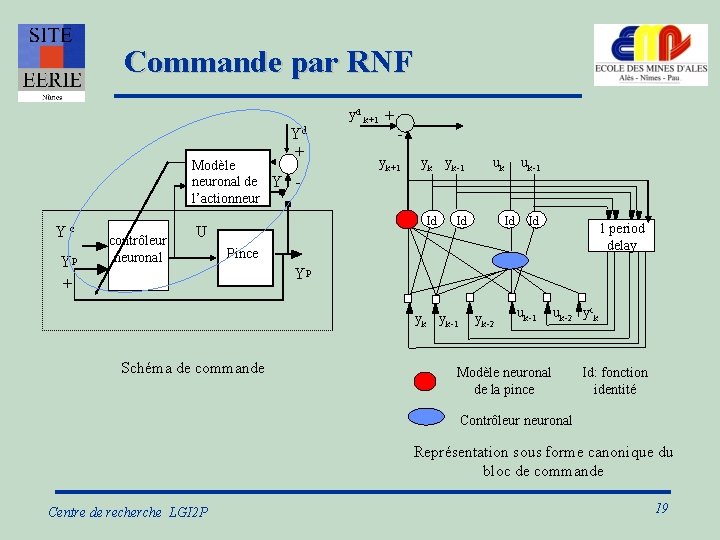

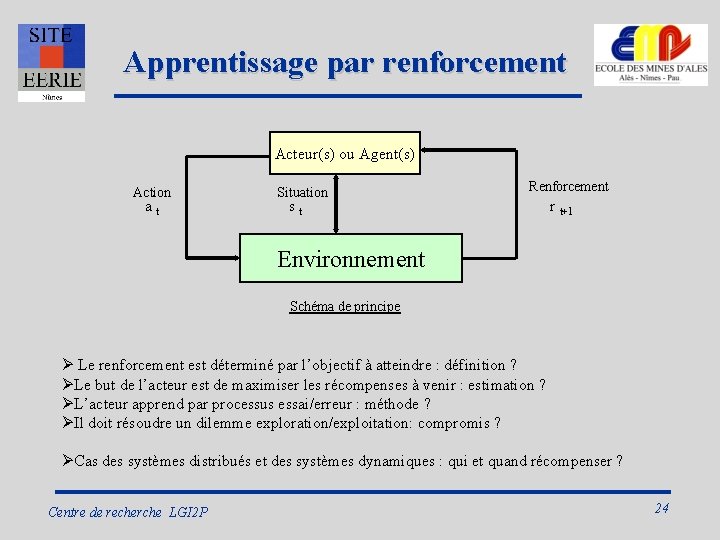

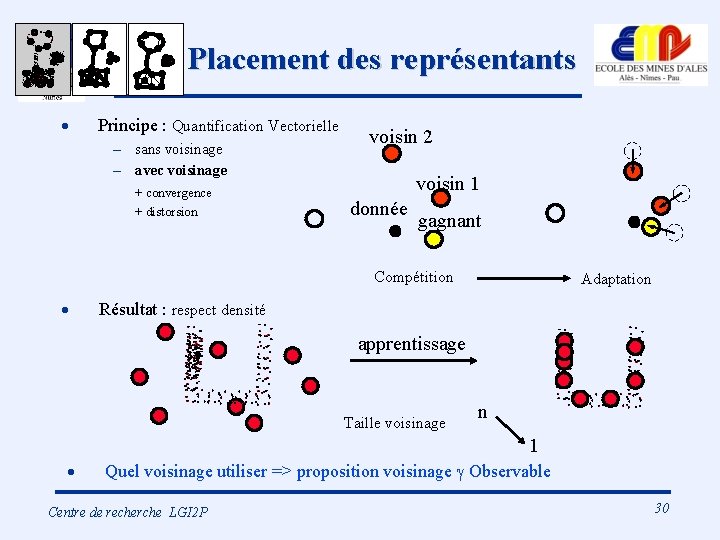

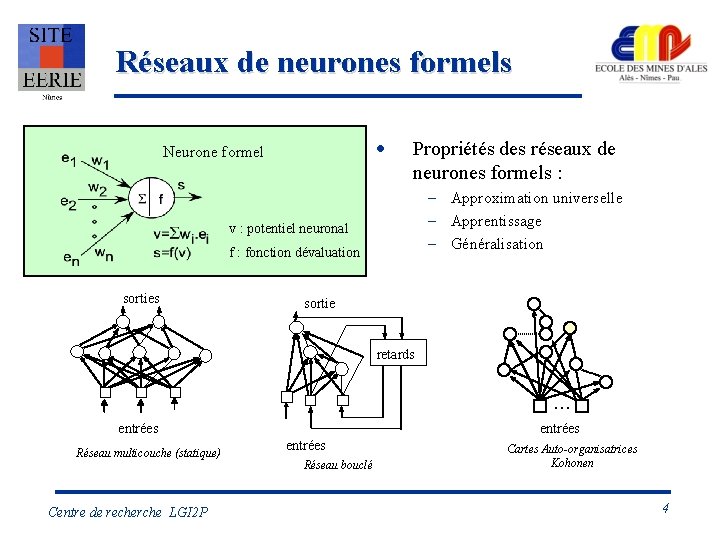

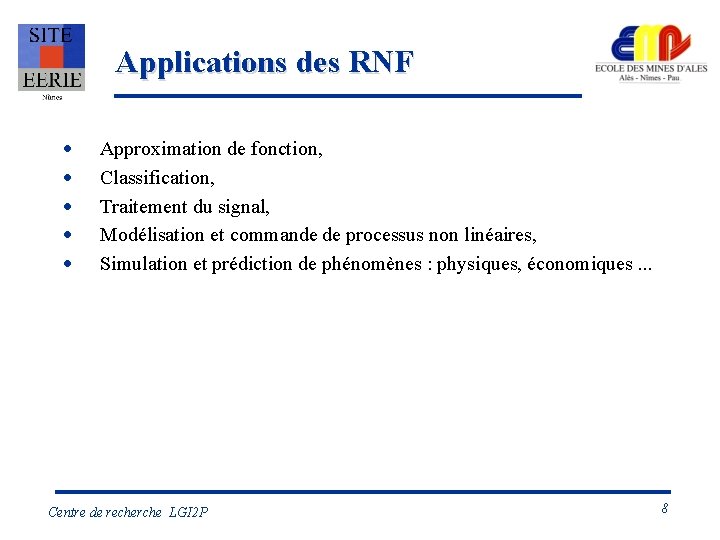

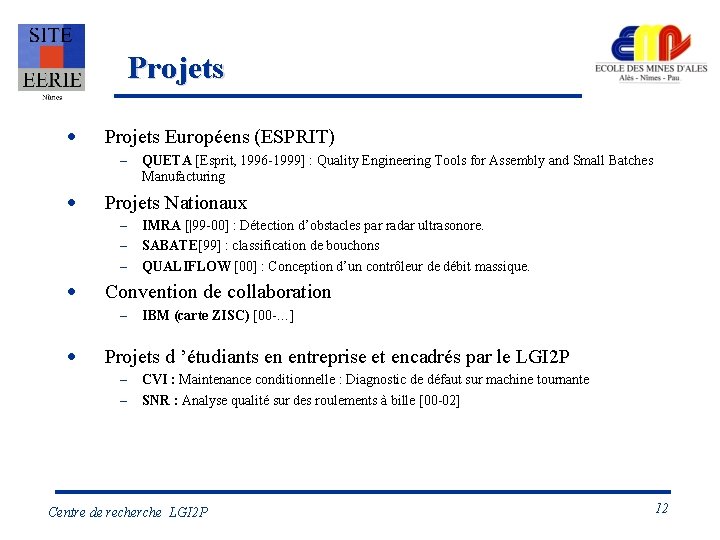

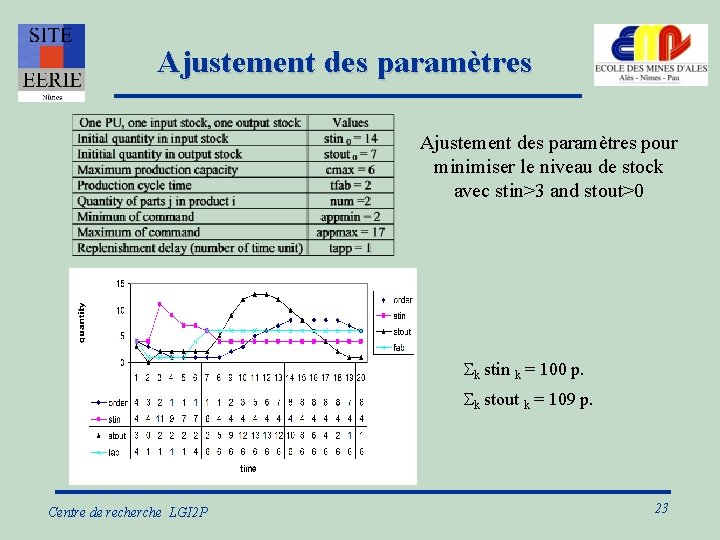

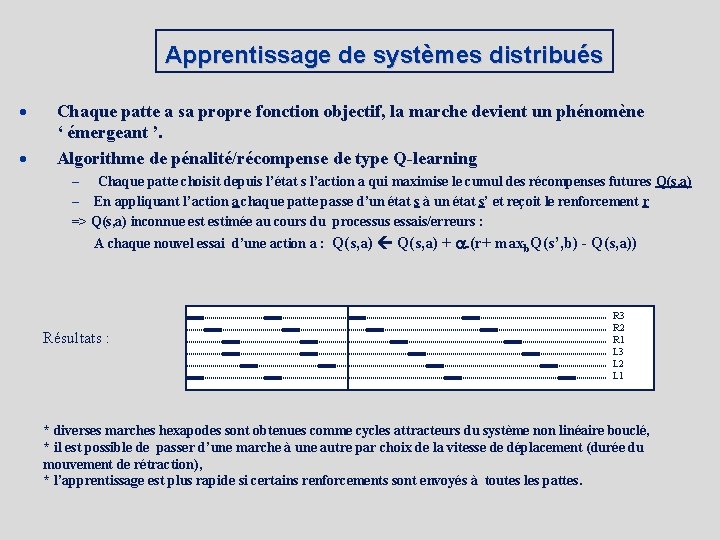

Méthode des ‘copies’ [ESPCI] · 1 : Représenter le réseau sous forme canonique (tous les retours sont externes au réseau et présentent un retard unitaire) · 2 : Ouvrir les boucles et dupliquer le réseau dans le temps sur une fenêtre temporelle de longueur fixe. · 3 : Ajuster les coefficients par rétropropagation sur le réseau déplié et considéré comme statique Contribution du LGI 2 P : adaptation de la méthode au calcul de contrôleurs récursifs en commande de processus Centre de recherche LGI 2 P 16

Méthode des copies 1 1)Représentation canonique sk-2 2) Les boucles sont ouvertes et le réseau est dupliqué sk-1 3) Rétropropagation à travers la fenêtre temporelle e 2 k sk-Nt e 3 k-Nt+1 S f Id S f Sf Copy Nt S f sk Sf e 1 k Id sk-2 e 3 k-1 sk-1 sk-2 sk-3 . . e 2 k-Nt+1 e 1 k-Nt+1 . sk-1 Id e 3 k Variantes sk-Nt-1 selon initialisation 1 S f Sf Id sk-1 e 3 k e 2 k-1 e 2 k e 1 k-1 e 1 k Copy 2 S f sk Sf Copy 1 Nt copies du réseau dans la fenêtre de Nt périodes d’échantillonnage Centre de recherche LGI 2 P 17

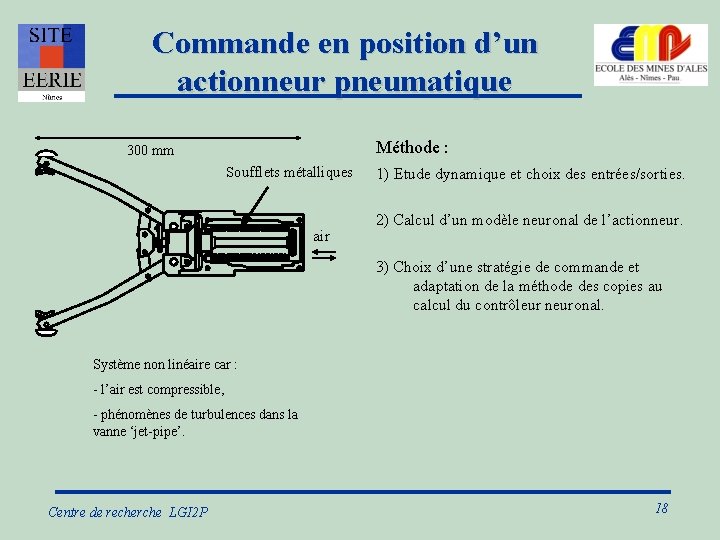

Commande en position d’un actionneur pneumatique 300 mm Soufflets métalliques air Méthode : 1) Etude dynamique et choix des entrées/sorties. 2) Calcul d’un modèle neuronal de l’actionneur. 3) Choix d’une stratégie de commande et adaptation de la méthode des copies au calcul du contrôleur neuronal. Système non linéaire car : - l’air est compressible, - phénomènes de turbulences dans la vanne ‘jet-pipe’. Centre de recherche LGI 2 P 18

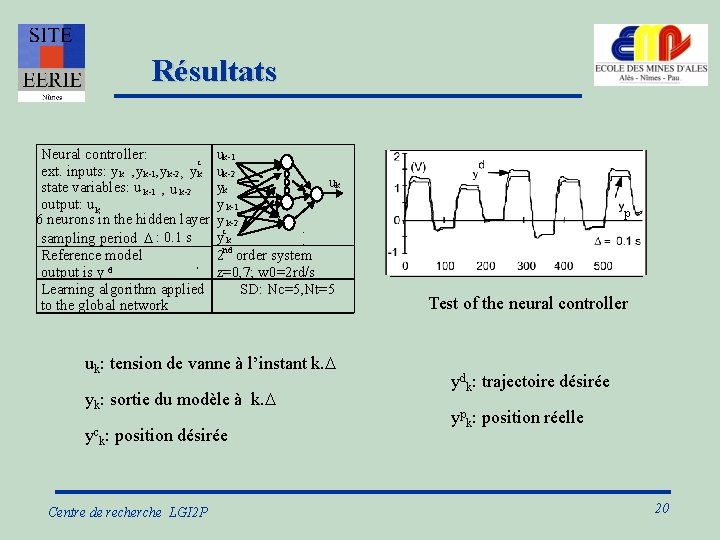

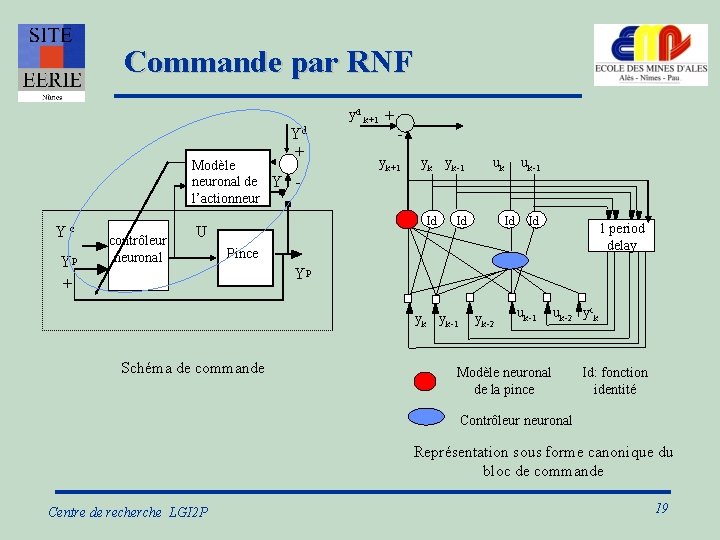

Commande par RNF yd k+1 + Yd + U n Modèle neuronal de Y l’actionneur Y c Yp + contrôleur neuronal yk+1 yk yk-1 Id U Pince U Id uk-1 Id Id 1 period delay Yp y k Schéma de commande uk yk-1 yk-2 uk-1 uk-2 yck Modèle neuronal de la pince Id: fonction identité Contrôleur neuronal Représentation sous forme canonique du bloc de commande Centre de recherche LGI 2 P 19

Résultats Neural controller: c ext. inputs: y k , y k-1, y k-2, y k state variables: u k-1 , u k-2 output: u k 6 neurons in the hidden layer sampling period D : 0. 1 s Reference model output is y d Learning algorithm applied to the global network uk-1 uk-2 uk yk y k-1 y k-2 c yk 2 nd order system z=0, 7; w 0=2 rd/s SD: Nc=5, Nt=5 uk: tension de vanne à l’instant k. D yk: sortie du modèle à k. D yck: position désirée Centre de recherche LGI 2 P p Test of the neural controller ydk: trajectoire désirée ypk: position réelle 20

![Chaîne logistique unité de production P Massotte Unité de production ORDRES Processus Chaîne logistique : unité de production [P. Massotte] Unité de production ORDRES Processus](https://slidetodoc.com/presentation_image_h/220fe488df0c464214d8d969d7635cf4/image-21.jpg)

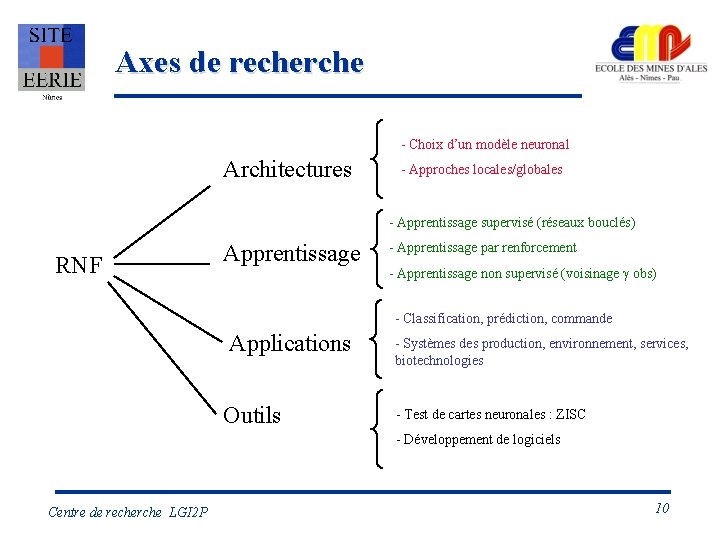

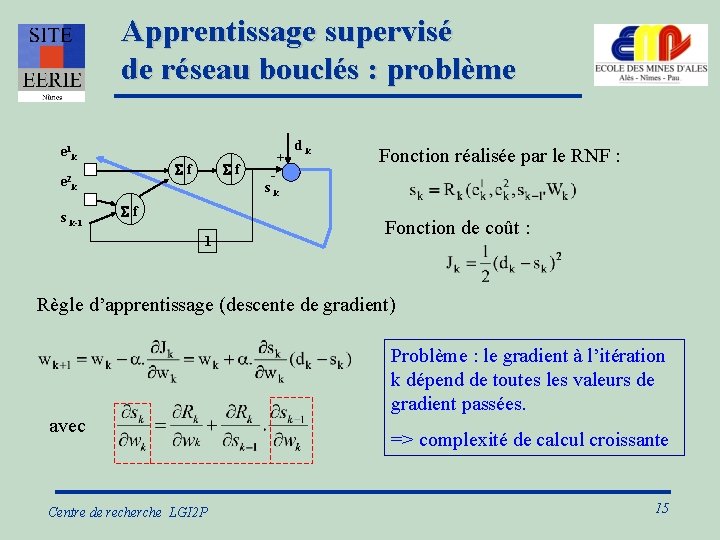

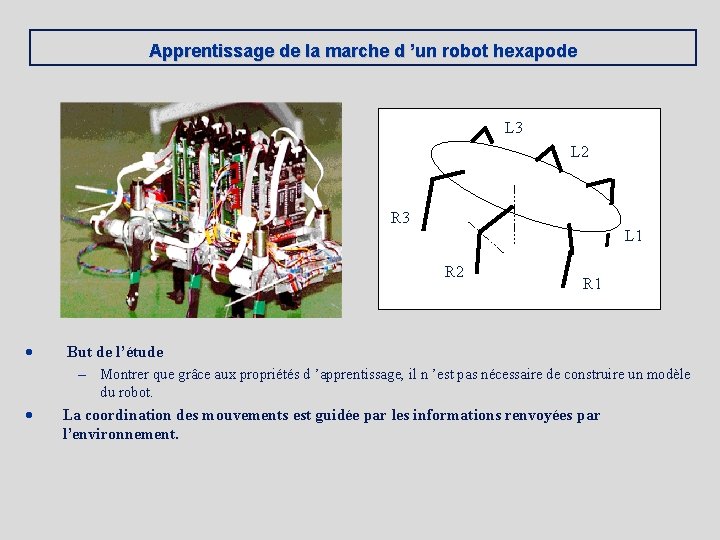

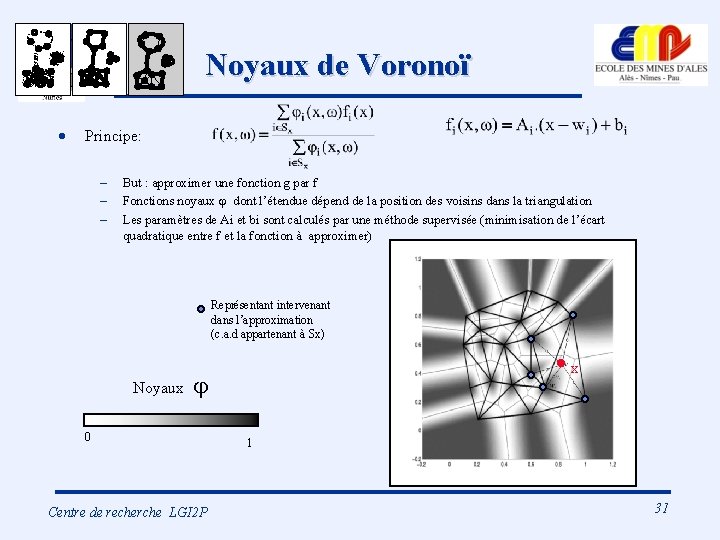

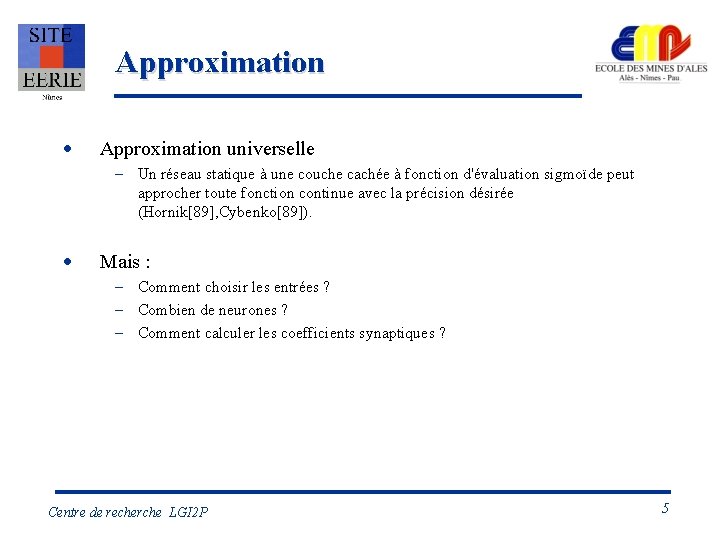

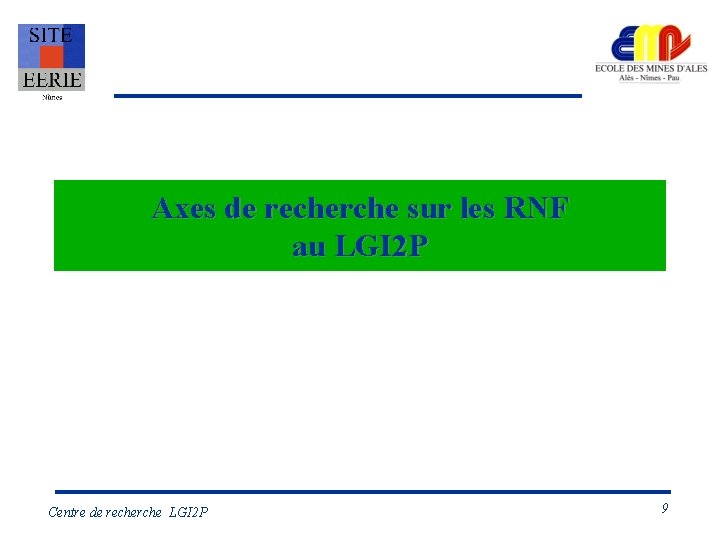

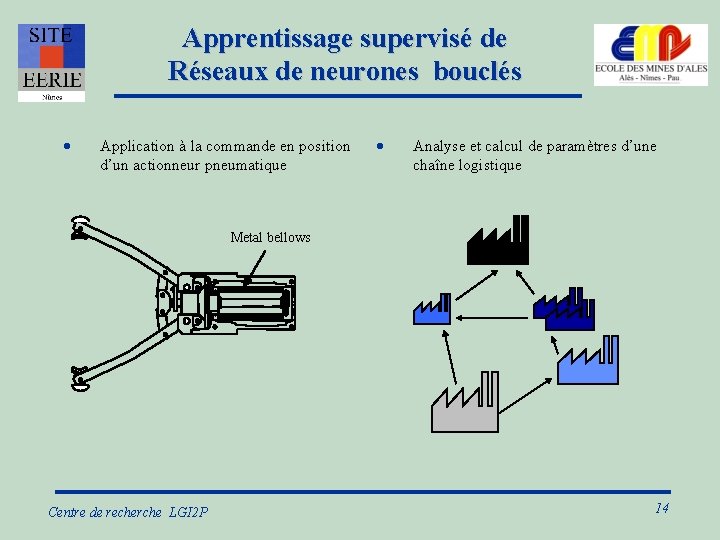

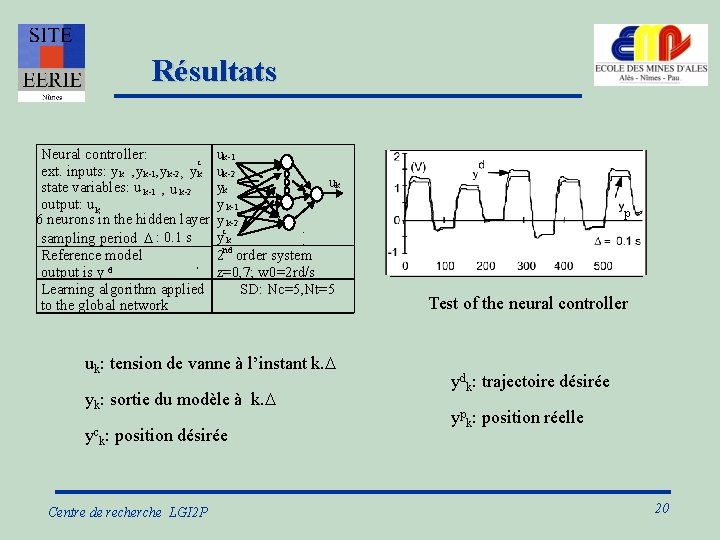

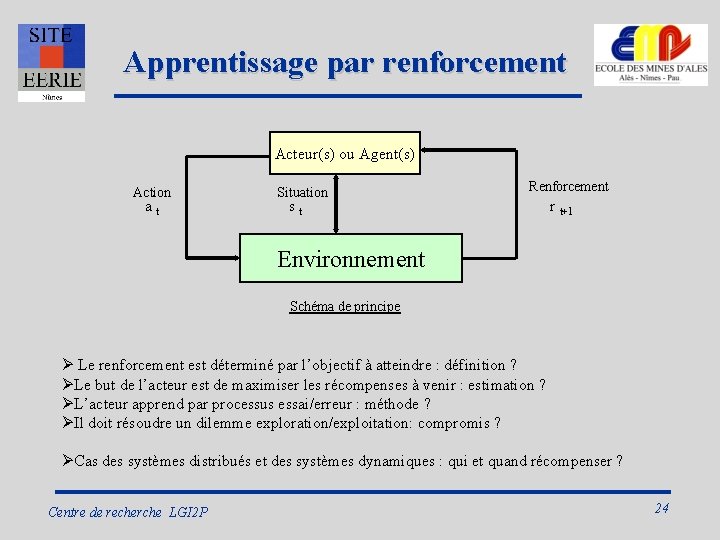

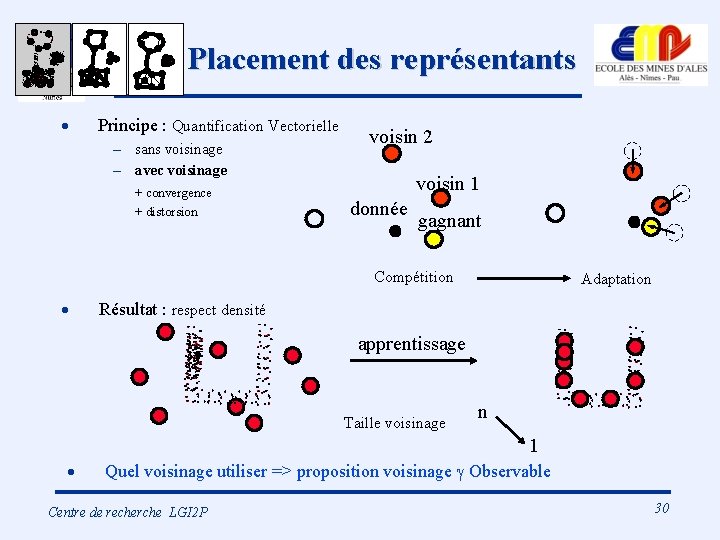

Chaîne logistique : unité de production [P. Massotte] Unité de production ORDRES Processus d’assemblage Commande d’approvisionnement: app Ordre de fabrication: fab rth PRODUITS Stocks en entrés Seuil de réapprovisionnement : rth Minimum d’appro : appmin Maximum d’appro : appmax pth Stock de sortie PRODUITS Seuil de mis en fabrication : pth Capacité de production : cmax Nombre de composants pour fabriquer un produit final : num Temps de réappro. : tapp Niveau de stock en entrée : stin If (rth-stin) >0 app =Max[appmin, Min[appmax, (rth-stin)]] else app=0 Centre de recherche LGI 2 P ORDRES Temps de fabrication : tfab Niveau de stock en sortie : stout fab = Max[0, Min[cmax, (pth-stout)]] Paramètres: rth, pth 21

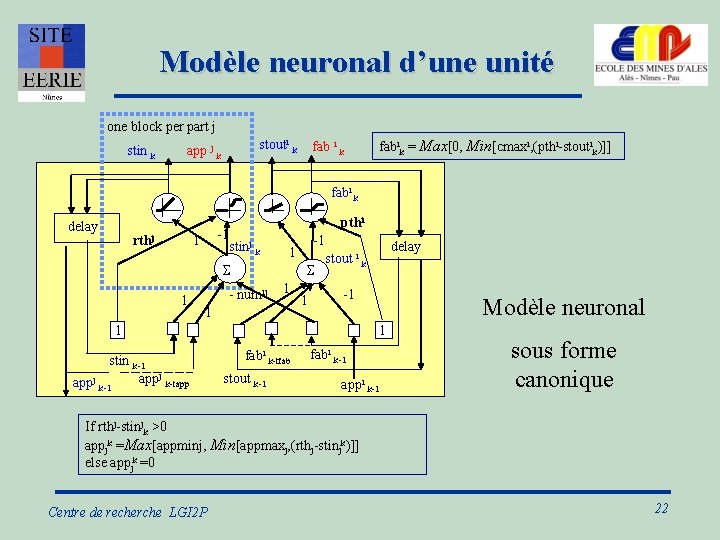

Modèle neuronal d’une unité one block per part j stin k stouti k app j k fab i k fabik = Max[0, Min[cmaxi, (pthi-stoutik)]] fabi k delay rthj -1 1 pthi stinj k S 1 -1 1 S - numij 1 1 1 -1 Modèle neuronal 1 1 stin k-1 appj k-tapp appj k-1 delay stout i k fabi k-tfab stout k-1 fabi k-1 appi k-1 sous forme canonique If rthj-stinjk >0 appjk =Max[appminj, Min[appmaxj, (rthj-stinjk)]] else appjk =0 Centre de recherche LGI 2 P 22

Ajustement des paramètres pour minimiser le niveau de stock avec stin>3 and stout>0 Sk stin k = 100 p. Sk stout k = 109 p. Centre de recherche LGI 2 P 23

Apprentissage par renforcement Acteur(s) ou Agent(s) Action a t Situation s t Renforcement r t+1 Environnement Schéma de principe Ø Le renforcement est déterminé par l’objectif à atteindre : définition ? ØLe but de l’acteur est de maximiser les récompenses à venir : estimation ? ØL’acteur apprend par processus essai/erreur : méthode ? ØIl doit résoudre un dilemme exploration/exploitation: compromis ? ØCas des systèmes distribués et des systèmes dynamiques : qui et quand récompenser ? Centre de recherche LGI 2 P 24

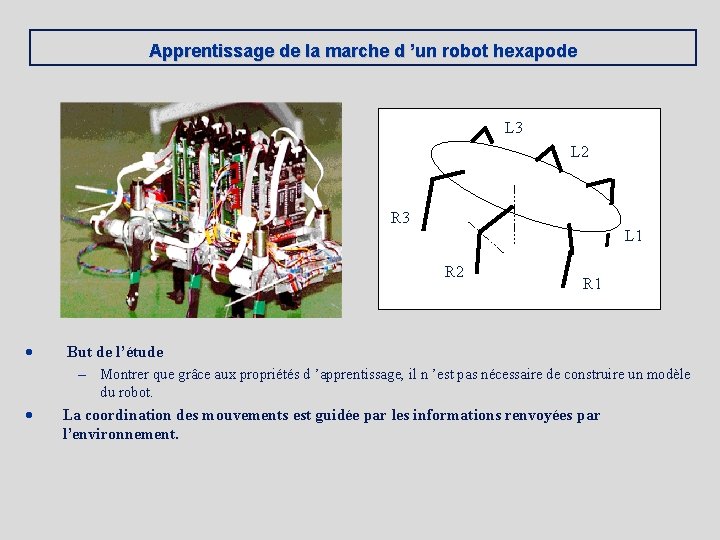

Apprentissage de la marche d ’un robot hexapode L 3 L 2 R 3 L 1 R 2 · · R 1 But de l’étude – Montrer que grâce aux propriétés d ’apprentissage, il n ’est pas nécessaire de construire un modèle du robot. La coordination des mouvements est guidée par les informations renvoyées par l’environnement.

![Architecture du réseau A Johannet Les neurones calculent la probabilité deffectuer Architecture du réseau [A. Johannet ] · · Les neurones calculent la probabilité d’effectuer](https://slidetodoc.com/presentation_image_h/220fe488df0c464214d8d969d7635cf4/image-26.jpg)

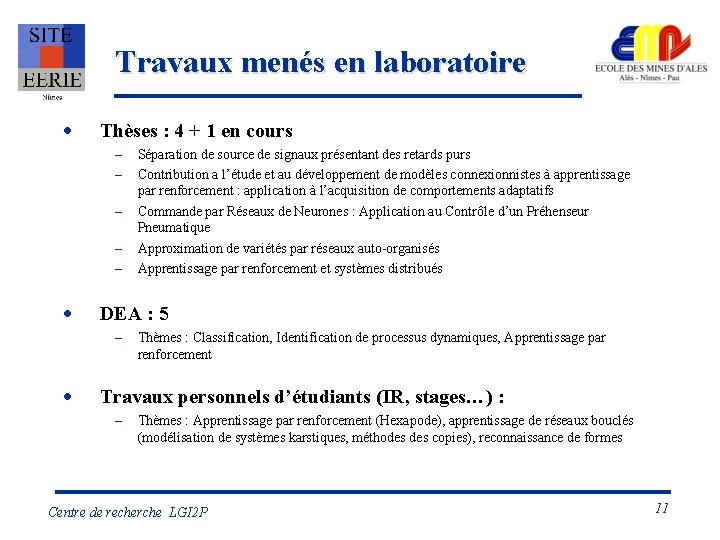

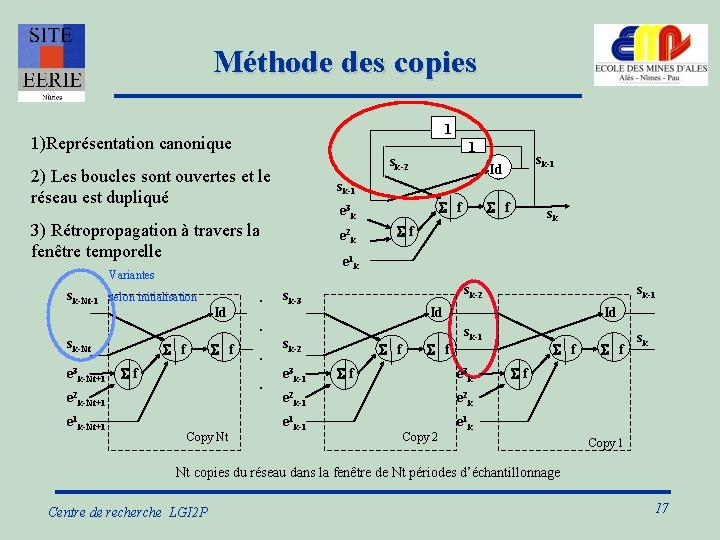

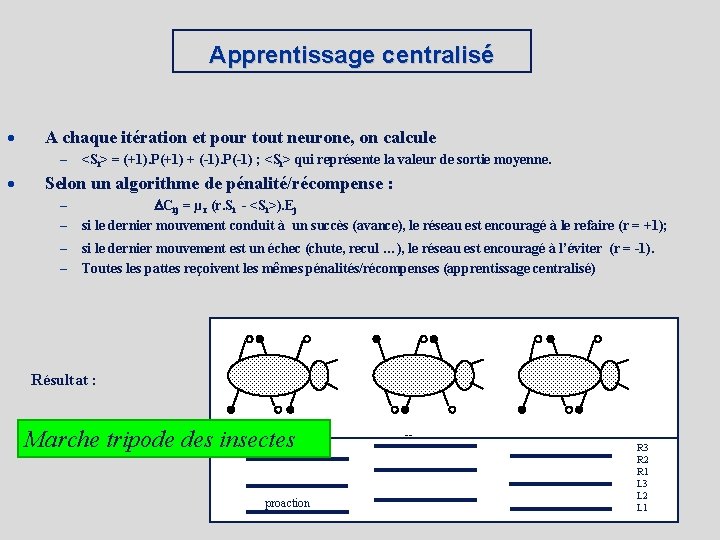

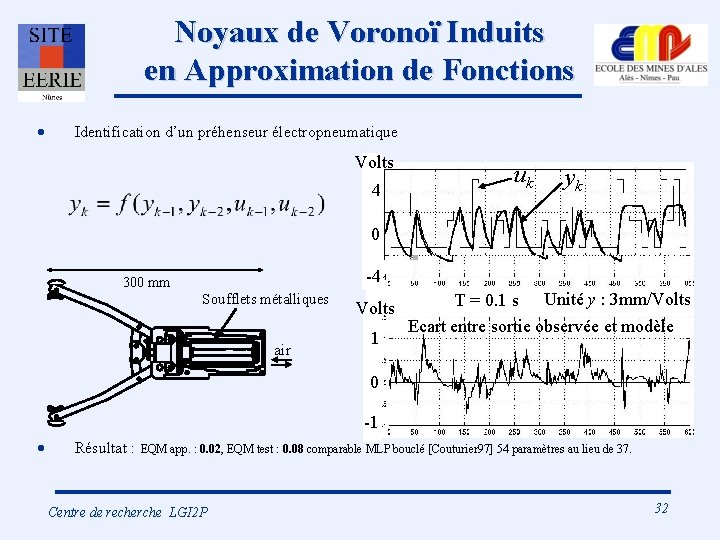

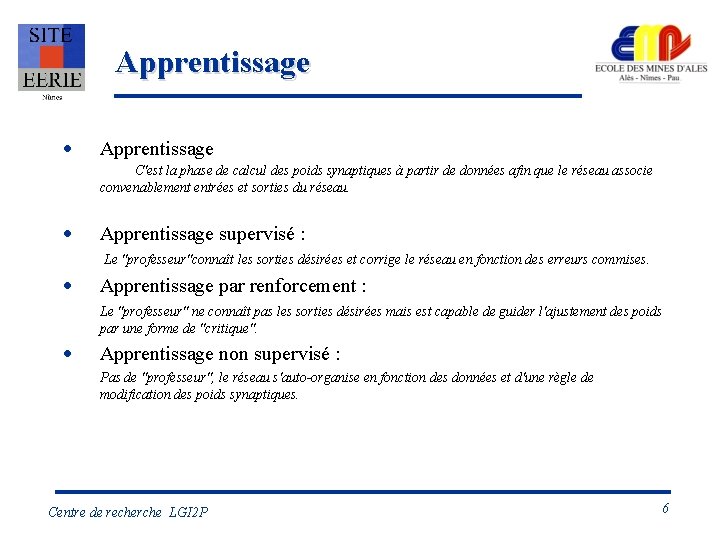

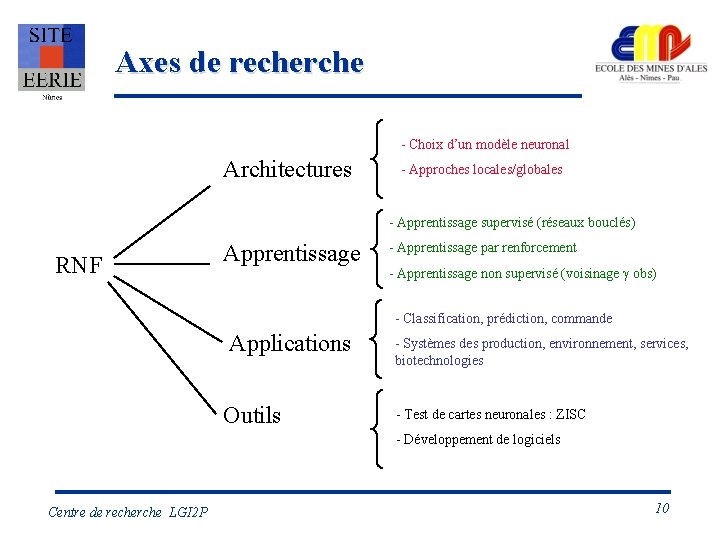

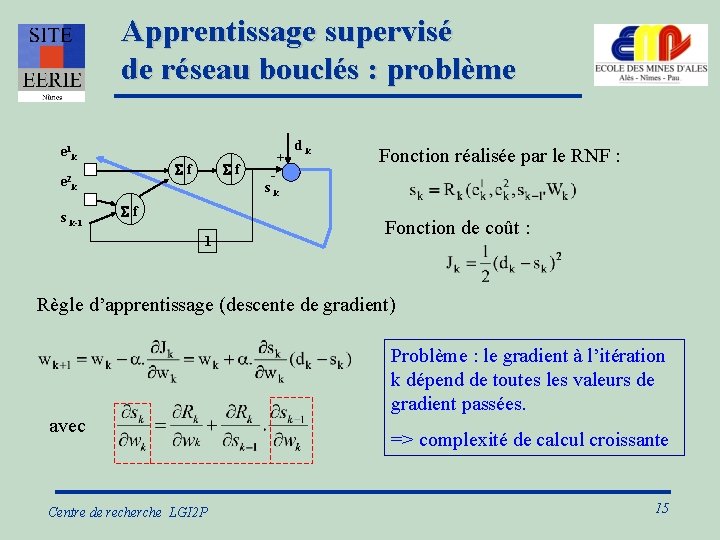

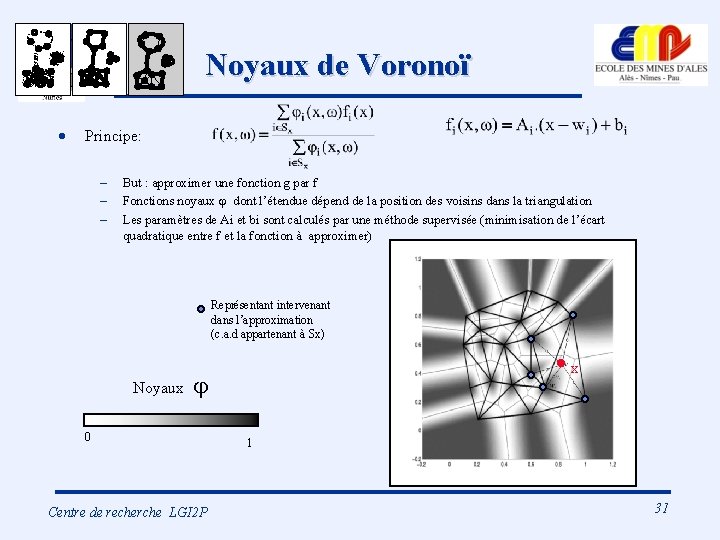

Architecture du réseau [A. Johannet ] · · Les neurones calculent la probabilité d’effectuer une poussée L’action Si est binaire – – · 1 : la patte exerce une poussée vers l ’arrière 0 : la patte est ramenée en position avant Les traitements sont distribués : un neurone par patte mais l’apprentissage est centralisé (même renforcement pour toutes les pattes).

Apprentissage centralisé · A chaque itération et pour tout neurone, on calcule – · <Si> = (+1). P(+1) + (-1). P(-1) ; <Si> qui représente la valeur de sortie moyenne. Selon un algorithme de pénalité/récompense : – – DCij = µ r (r. Si - <Si>). Ej si le dernier mouvement conduit à un succès (avance), le réseau est encouragé à le refaire (r = +1); – – si le dernier mouvement est un échec (chute, recul …), le réseau est encouragé à l’éviter (r = -1). Toutes les pattes reçoivent les mêmes pénalités/récompenses (apprentissage centralisé) Résultat : Marche tripode des insectes proaction -R 3 R 2 R 1 L 3 L 2 L 1

Apprentissage de systèmes distribués · · Chaque patte a sa propre fonction objectif, la marche devient un phénomène ‘ émergeant ’. Algorithme de pénalité/récompense de type Q-learning – Chaque patte choisit depuis l’état s l’action a qui maximise le cumul des récompenses futures Q(s, a) – En appliquant l’action a chaque patte passe d’un état s à un état s’ et reçoit le renforcement r => Q(s, a) inconnue estimée au cours du processus essais/erreurs : A chaque nouvel essai d’une action a : Q(s, a) + a. (r+ maxb. Q(s’, b) - Q(s, a)) Résultats : R 3 R 2 R 1 L 3 L 2 L 1 * diverses marches hexapodes sont obtenues comme cycles attracteurs du système non linéaire bouclé, * il est possible de passer d’une marche à une autre par choix de la vitesse de déplacement (durée du mouvement de rétraction), * l’apprentissage est plus rapide si certains renforcements sont envoyés à toutes les pattes.

![Approximation de variétés par réseaux de neurones autoorganisés Michael Aupetit 98 2001 Modèle discret Approximation de variétés par réseaux de neurones auto-organisés [Michael Aupetit 98 -2001] Modèle discret](https://slidetodoc.com/presentation_image_h/220fe488df0c464214d8d969d7635cf4/image-29.jpg)

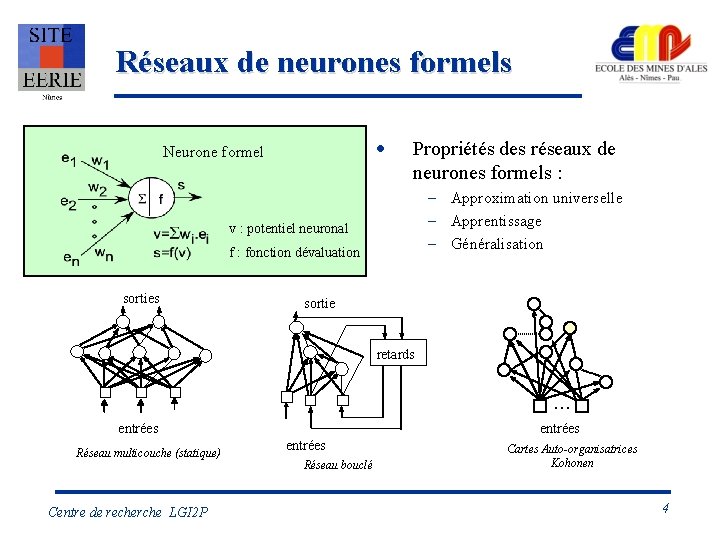

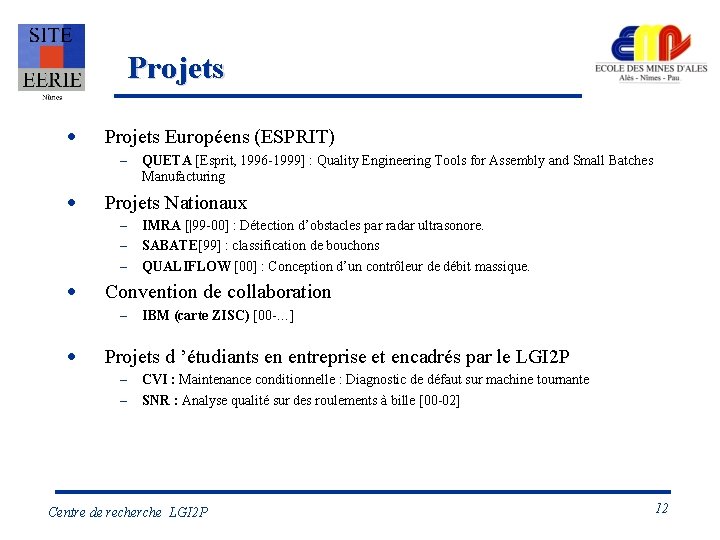

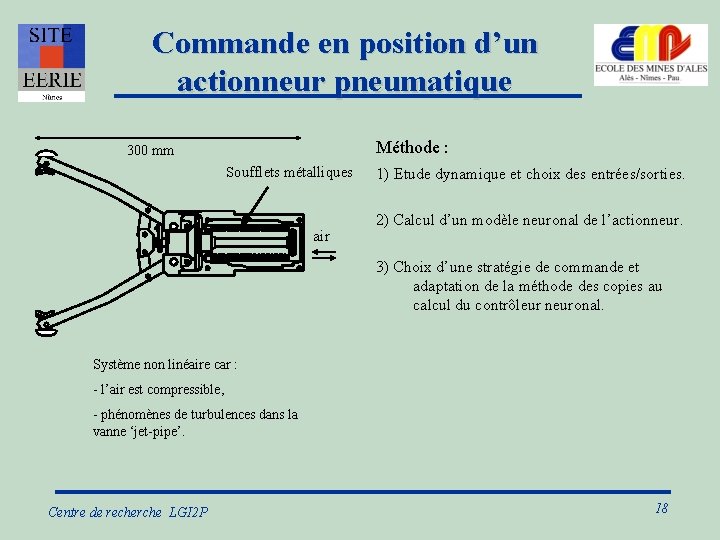

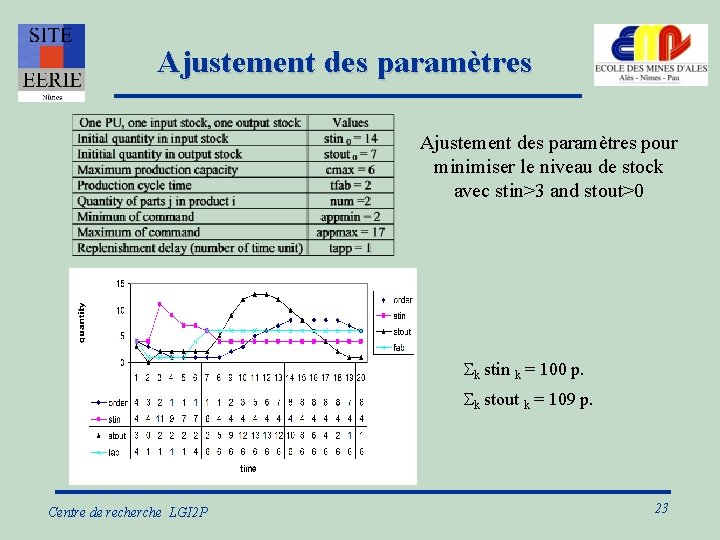

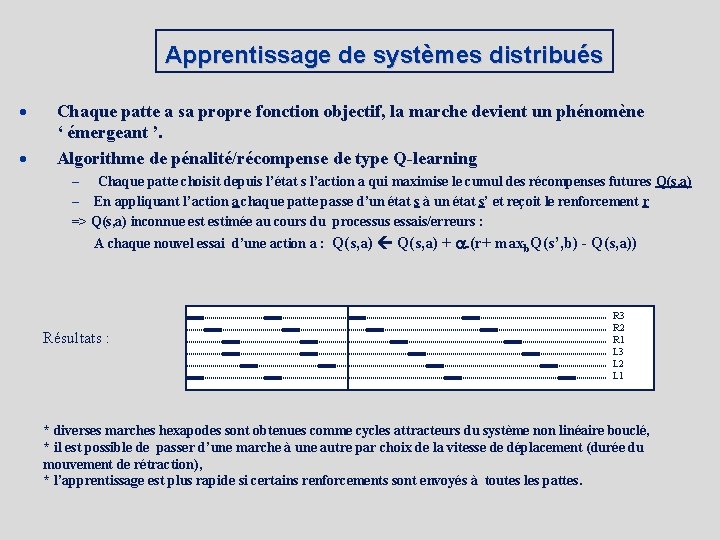

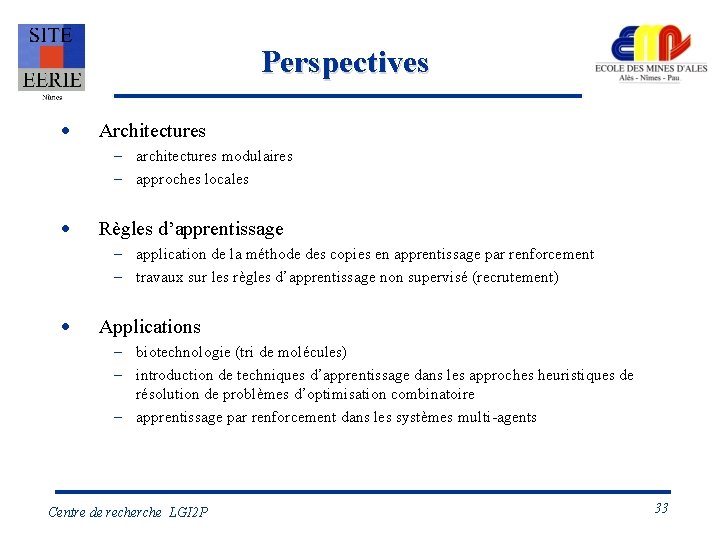

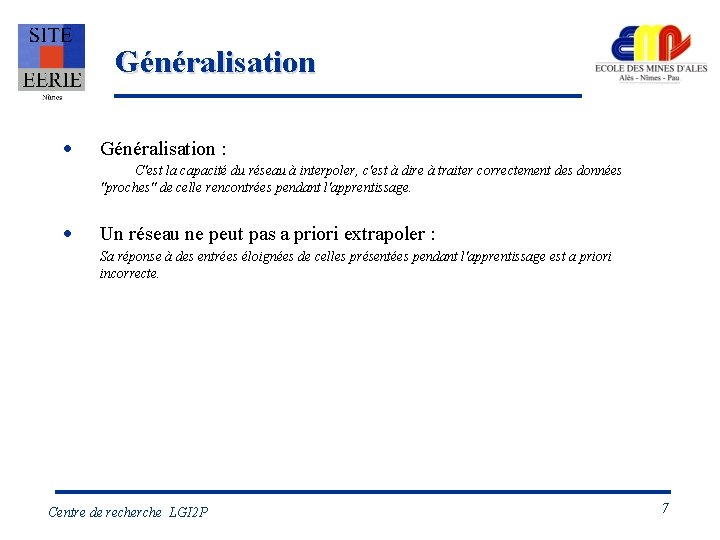

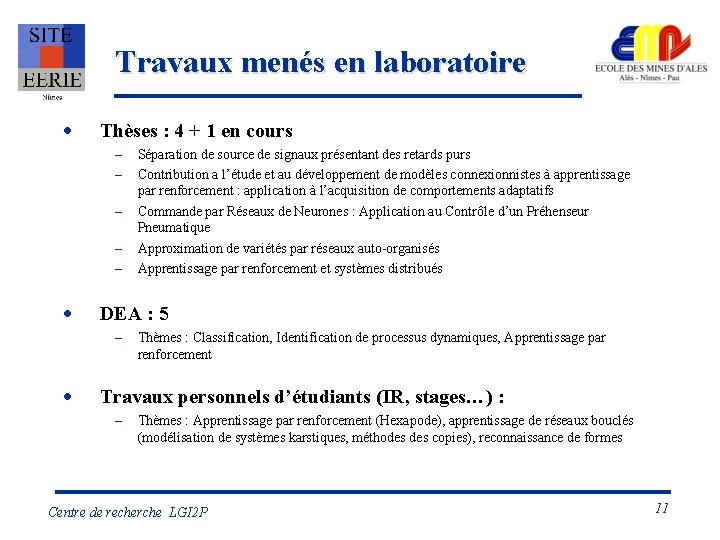

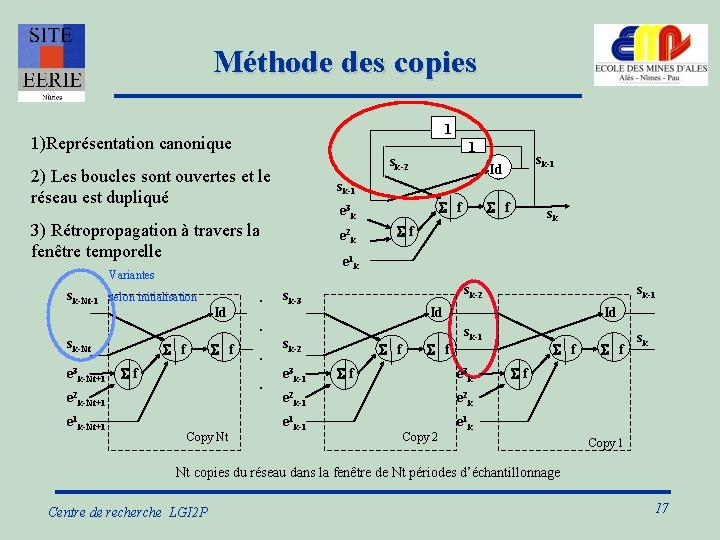

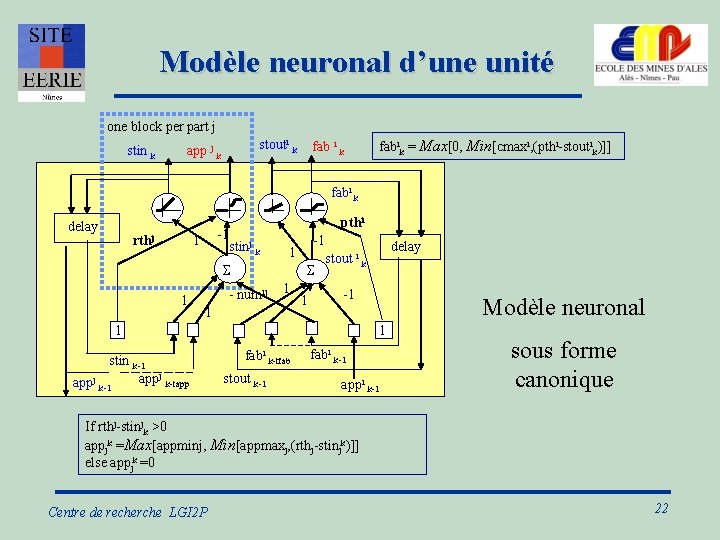

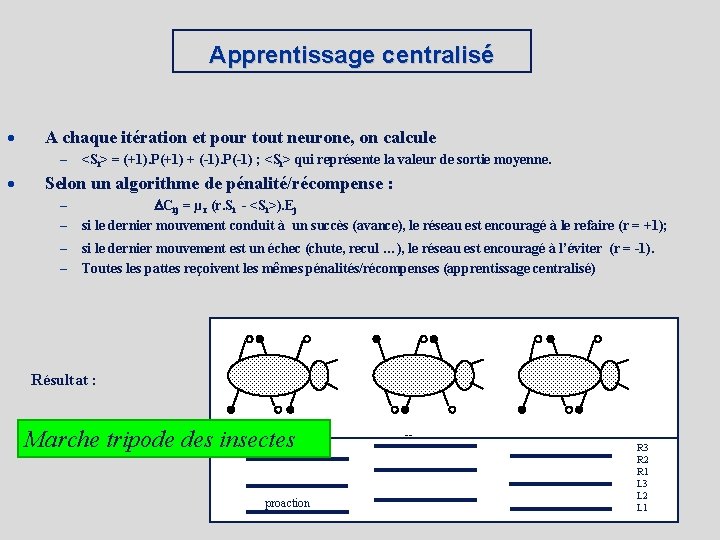

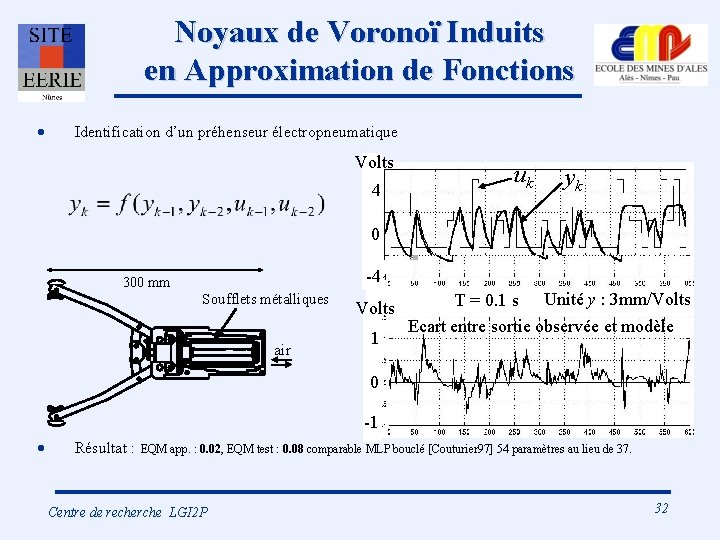

Approximation de variétés par réseaux de neurones auto-organisés [Michael Aupetit 98 -2001] Modèle discret Position des sommets (Représentants) Modèle linéaire Topologie (TDI) Modèle non linéaire Interpolation CHL [Martinetz 94] Centre de recherche LGI 2 P 29

Placement des représentants · Principe : Quantification Vectorielle – sans voisinage – avec voisinage + convergence + distorsion voisin 2 voisin 1 donnée gagnant Compétition · Adaptation Résultat : respect densité apprentissage Taille voisinage n 1 · Quel voisinage utiliser => proposition voisinage g Observable Centre de recherche LGI 2 P 30

Noyaux de Voronoï · Principe: – – – But : approximer une fonction g par f Fonctions noyaux j dont l’étendue dépend de la position des voisins dans la triangulation Les paramètres de Ai et bi sont calculés par une méthode supervisée (minimisation de l’écart quadratique entre f et la fonction à approximer) Représentant intervenant dans l’approximation (c. a. d appartenant à Sx) x Noyaux j 0 Centre de recherche LGI 2 P 1 31

Noyaux de Voronoï Induits en Approximation de Fonctions · Identification d’un préhenseur électropneumatique Volts 4 uk yk 0 -4 300 mm Soufflets métalliques air Volts 1 T = 0. 1 s Unité y : 3 mm/Volts Ecart entre sortie observée et modèle 0 -1 · Résultat : EQM app. : 0. 02, EQM test : 0. 08 comparable MLP bouclé [Couturier 97] 54 paramètres au lieu de 37. Centre de recherche LGI 2 P 32

Perspectives · Architectures – architectures modulaires – approches locales · Règles d’apprentissage – application de la méthode des copies en apprentissage par renforcement – travaux sur les règles d’apprentissage non supervisé (recrutement) · Applications – biotechnologie (tri de molécules) – introduction de techniques d’apprentissage dans les approches heuristiques de résolution de problèmes d’optimisation combinatoire – apprentissage par renforcement dans les systèmes multi-agents Centre de recherche LGI 2 P 33

Biblographie · JOHANNET A. , SARDA I. , Goal-directed behaviours by renforcement learning , Neuro-computing, Elsevier, pp 107 -125, 1999 · COUTURIER, P. , JOHANNET, A. and BÉTEMPS, M. Neural Controllers: Tracking and Regulation of a Nonlinear Pneumatic Plant, International Journal of Knowledge-Based Intelligent Engineering Systems, October 1998. Vol 2, N° 4, p 233 -246. · AUPETIT, M. , Lepetz, D. , Nemoz-Gaillard, M. , Couturier, P. , Massotte, P. , Réseaux de Neurones et Traitement de Données: la Notion de Voisinage g-Observable, Valgo 2001 (ISSN 1625 -9661), n. 1, March 2001 · AUPETIT, M. , COUTURIER, P. , MASSOTTE, P. , Induced Voronoï Kernels for Principal Manifolds Approximation , Workshop on Self-Organizing Maps (WSOM 2001), Lincoln, England, June 13 -15, 2001. · AUPETIT, M. , COUTURIER, P. , MASSOTTE, P. , Vector Quantization with g-Observable Neighbors , Workshop on Self-Organizing Maps (WSOM 2001), Lincoln, England, June 13 -15, 2001. · COUTURIER P. , Modelling and control of mecatronics systems using recurrent neural networks, MECATRONICS'01, Actes électroniques, Besançon, France, pp 219 -224, octobre 2001. Centre de recherche LGI 2 P 34