11 Corrlation et rgression linaire Version 1 2

- Slides: 43

- 11 Corrélation et régression linéaire Version 1. 2 1

Sujets abordés v v v Corrélation de Pearson et de Spearman Régression linéaire simple Régression linéaire multiple Hétéroscédasticité Autocorrélation Multicolinéarité 2

Lien de dépendance L’analyse de la dépendance entre deux variables se fait généralement via : v Un nuage de points v L’analyse de corrélation v Coefficient de Pearson (linéaire) v Corrélation de Spearman (basée sur les rangs) 3

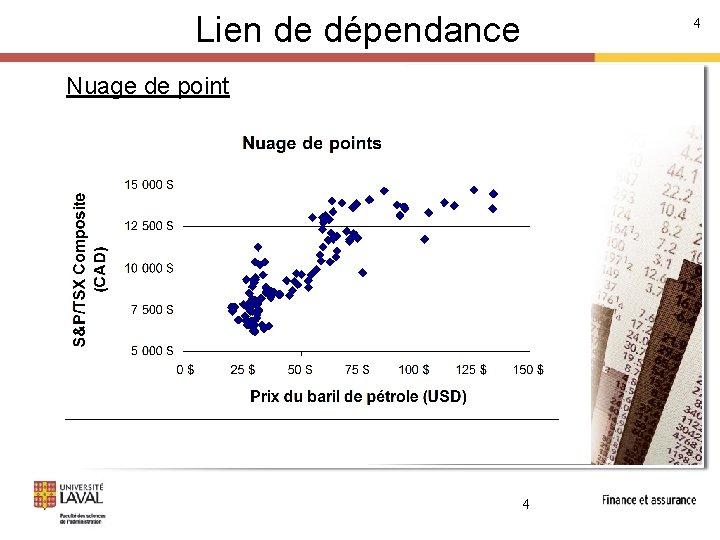

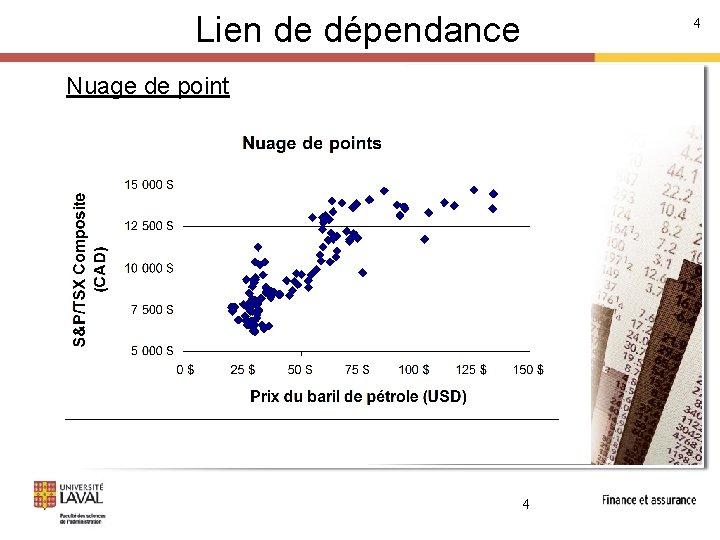

Lien de dépendance 4 Nuage de point 4

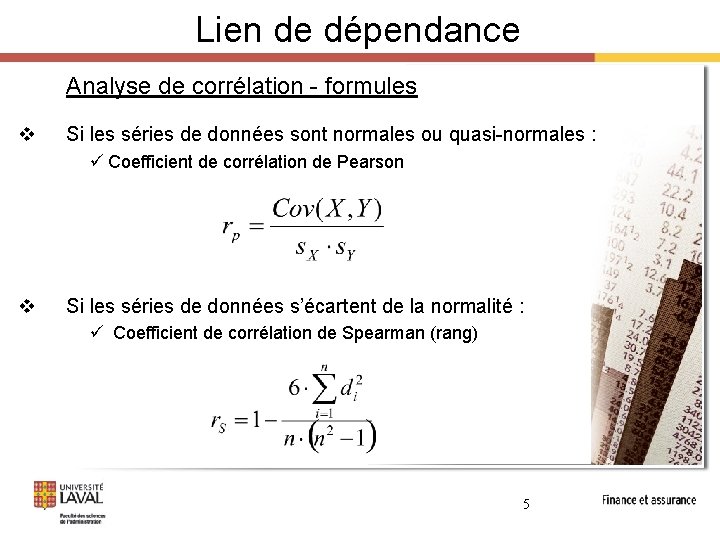

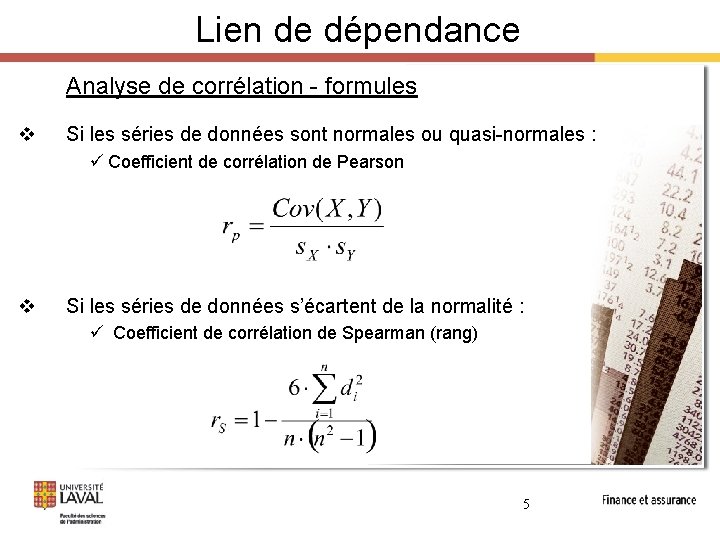

Lien de dépendance Analyse de corrélation - formules v Si les séries de données sont normales ou quasi-normales : ü Coefficient de corrélation de Pearson v Si les séries de données s’écartent de la normalité : ü Coefficient de corrélation de Spearman (rang) 5

Lien de dépendance Analyse de corrélation - limites v Présence d’un lien de dépendance non-linéaire v Présence de données aberrantes (extrêmes) v Biais de corrélation illusoire ( « Spurious correlation » ) ü La dépendance est le fruit du hasard d’échantillonage ü Les deux variables dépendent elles-mêmes d’une 3 ième variable commune 6

Analyse de régression L’analyse de régression permet : v D’utiliser une (ou plusieurs) variable pour prévoir l’évolution d’une autre variable v De tester des hypothèses concernant la relation entre deux variables v De quantifier la force de la relation entre 2 variables 7

Analyse de régression Deux types de données sont souvent utilisés: v Données en coupe instantanée Exemple : Les rendements de 500 titres boursiers v Séries chronologiques Exemple : Les rendements d’une action de 2000 à 2008 8

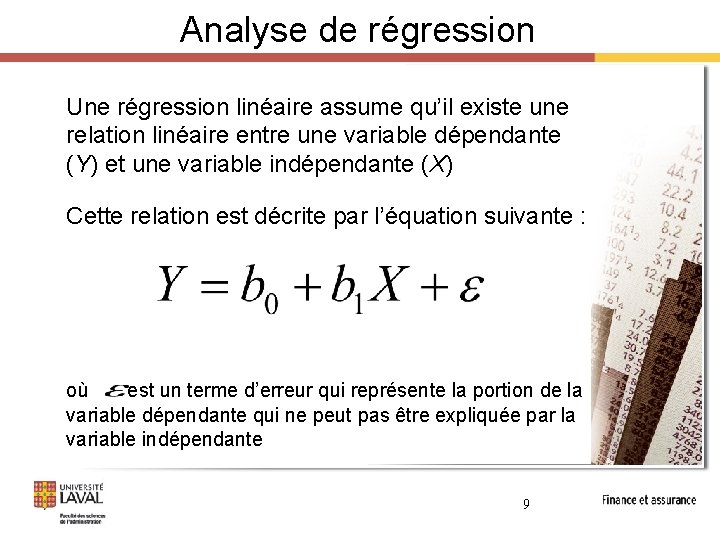

Analyse de régression Une régression linéaire assume qu’il existe une relation linéaire entre une variable dépendante (Y) et une variable indépendante (X) Cette relation est décrite par l’équation suivante : où est un terme d’erreur qui représente la portion de la variable dépendante qui ne peut pas être expliquée par la variable indépendante 9

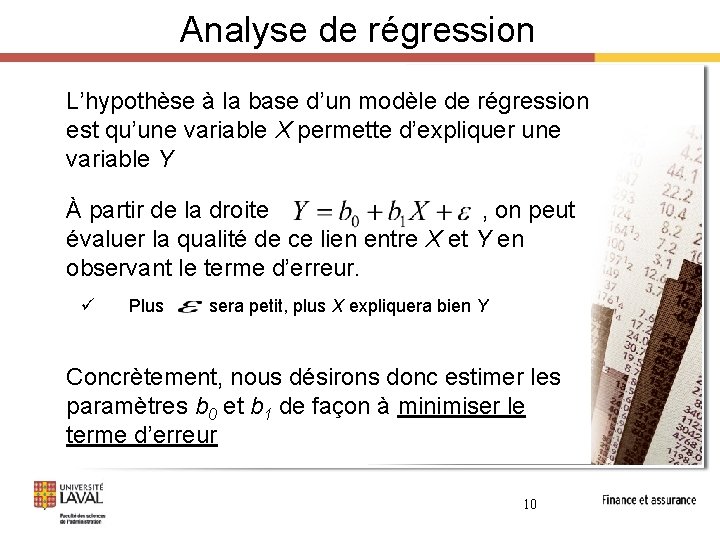

Analyse de régression L’hypothèse à la base d’un modèle de régression est qu’une variable X permette d’expliquer une variable Y À partir de la droite , on peut évaluer la qualité de ce lien entre X et Y en observant le terme d’erreur. ü Plus sera petit, plus X expliquera bien Y Concrètement, nous désirons donc estimer les paramètres b 0 et b 1 de façon à minimiser le terme d’erreur 10

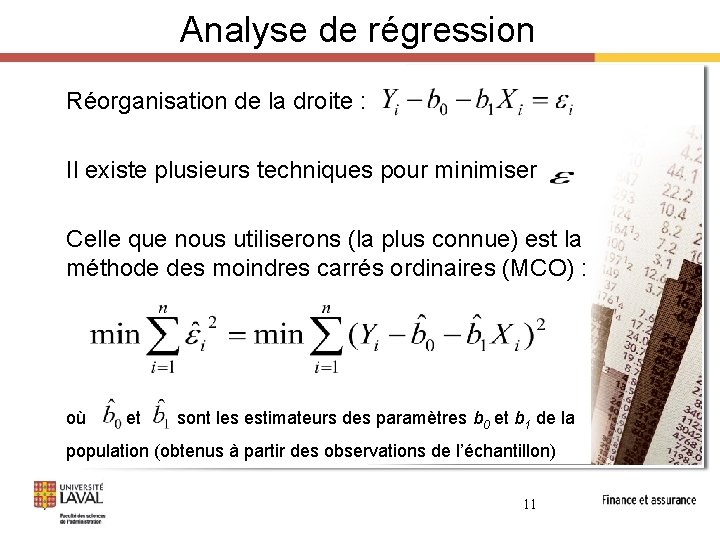

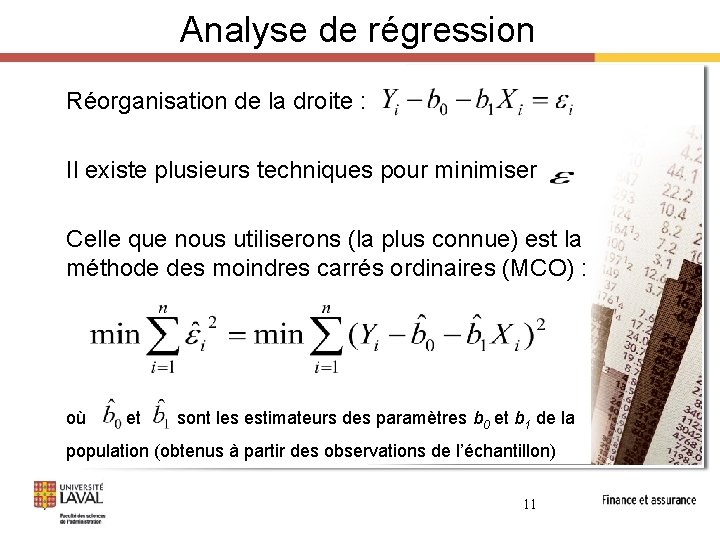

Analyse de régression Réorganisation de la droite : Il existe plusieurs techniques pour minimiser Celle que nous utiliserons (la plus connue) est la méthode des moindres carrés ordinaires (MCO) : où et sont les estimateurs des paramètres b 0 et b 1 de la population (obtenus à partir des observations de l’échantillon) 11

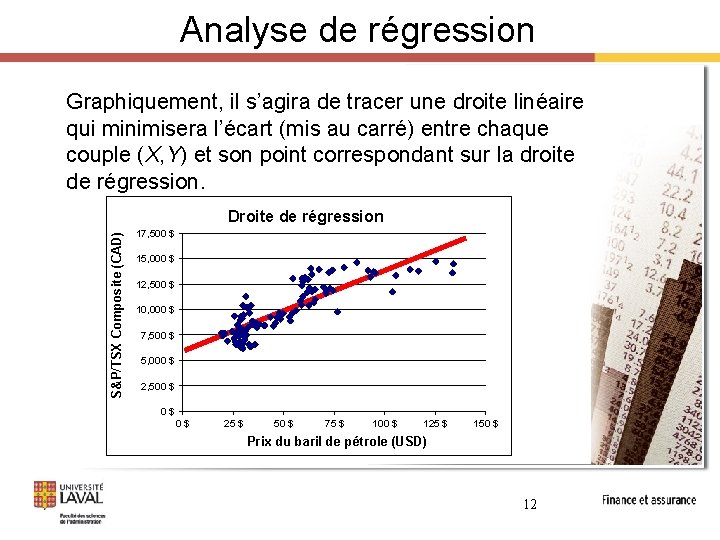

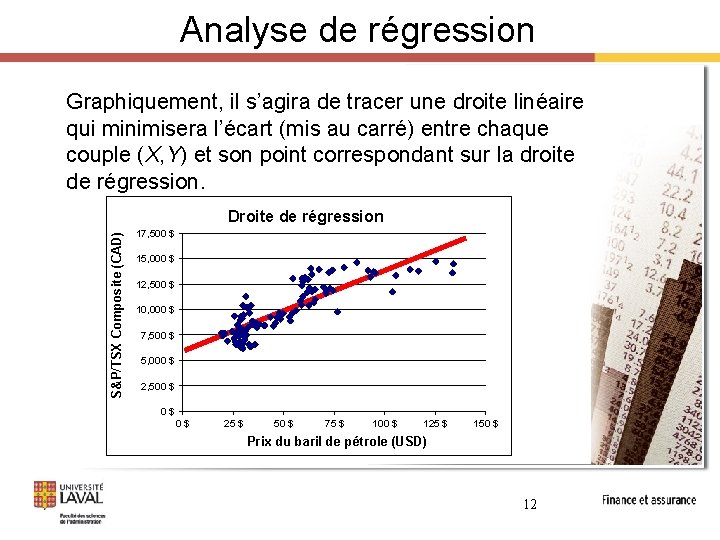

Analyse de régression Graphiquement, il s’agira de tracer une droite linéaire qui minimisera l’écart (mis au carré) entre chaque couple (X, Y) et son point correspondant sur la droite de régression. S&P/TSX Composite (CAD) Droite de régression 17, 500 $ 15, 000 $ 12, 500 $ 10, 000 $ 7, 500 $ 5, 000 $ 2, 500 $ 0$ 0$ 25 $ 50 $ 75 $ 100 $ 125 $ 150 $ Prix du baril de pétrole (USD) 12

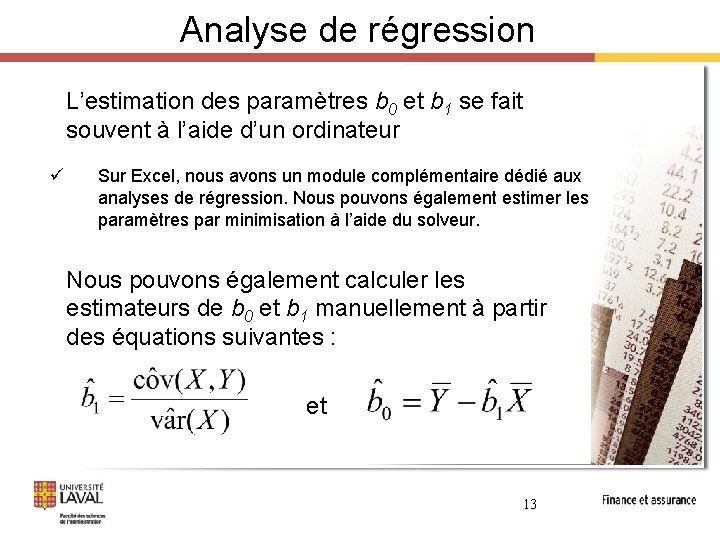

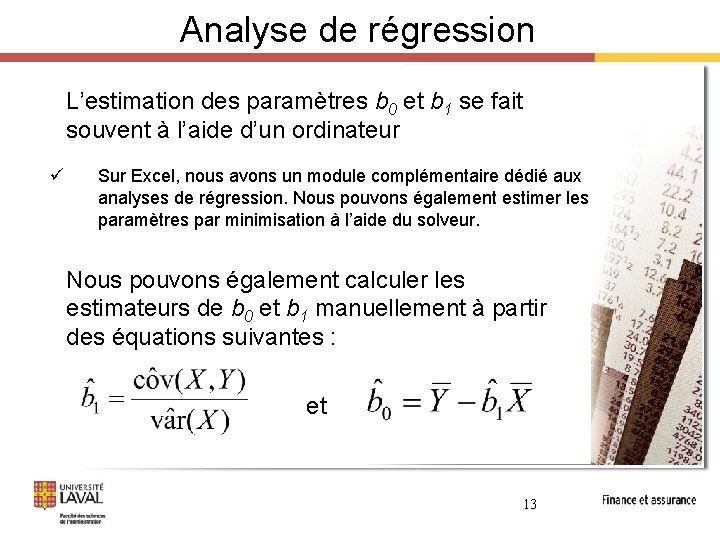

Analyse de régression L’estimation des paramètres b 0 et b 1 se fait souvent à l’aide d’un ordinateur ü Sur Excel, nous avons un module complémentaire dédié aux analyses de régression. Nous pouvons également estimer les paramètres par minimisation à l’aide du solveur. Nous pouvons également calculer les estimateurs de b 0 et b 1 manuellement à partir des équations suivantes : et 13

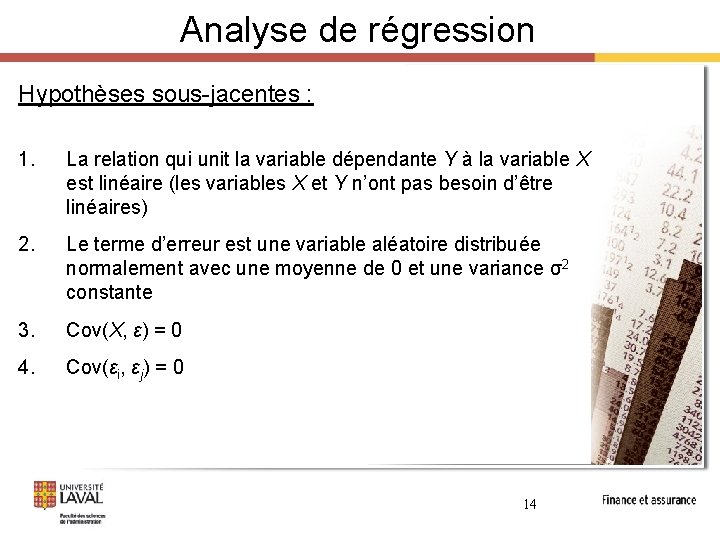

Analyse de régression Hypothèses sous-jacentes : 1. La relation qui unit la variable dépendante Y à la variable X est linéaire (les variables X et Y n’ont pas besoin d’être linéaires) 2. Le terme d’erreur est une variable aléatoire distribuée normalement avec une moyenne de 0 et une variance σ2 constante 3. Cov(X, ε) = 0 4. Cov(εi, εj) = 0 14

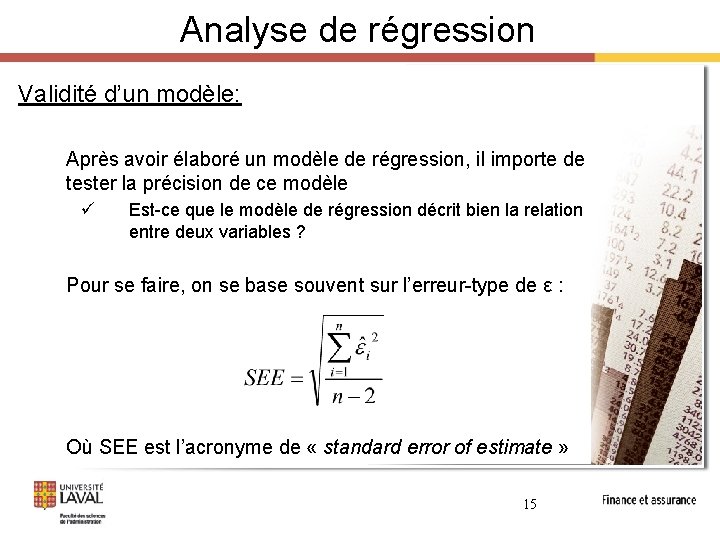

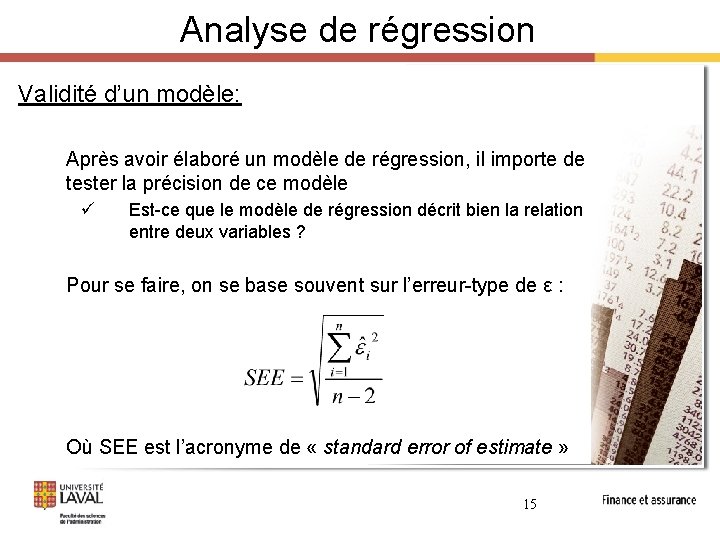

Analyse de régression Validité d’un modèle: Après avoir élaboré un modèle de régression, il importe de tester la précision de ce modèle ü Est-ce que le modèle de régression décrit bien la relation entre deux variables ? Pour se faire, on se base souvent sur l’erreur-type de ε : Où SEE est l’acronyme de « standard error of estimate » 15

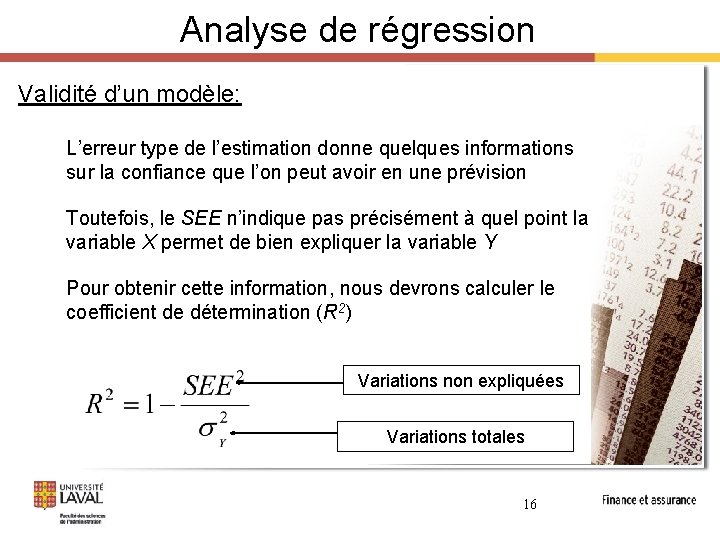

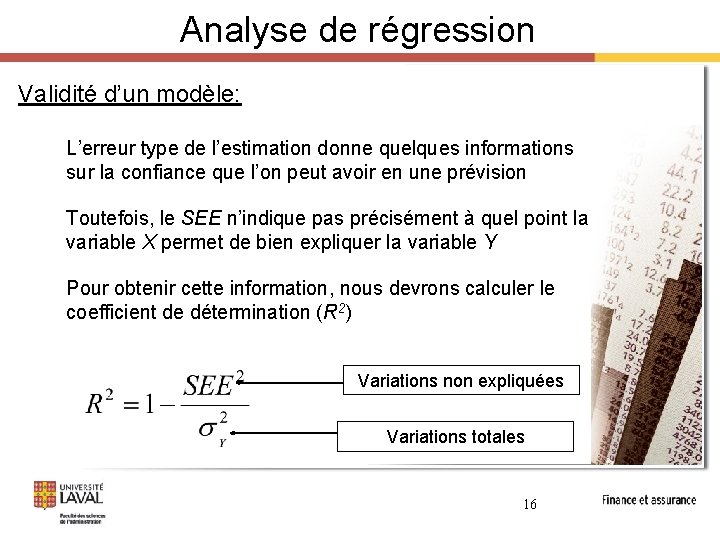

Analyse de régression Validité d’un modèle: L’erreur type de l’estimation donne quelques informations sur la confiance que l’on peut avoir en une prévision Toutefois, le SEE n’indique pas précisément à quel point la variable X permet de bien expliquer la variable Y Pour obtenir cette information, nous devrons calculer le coefficient de détermination (R 2) Variations non expliquées Variations totales 16

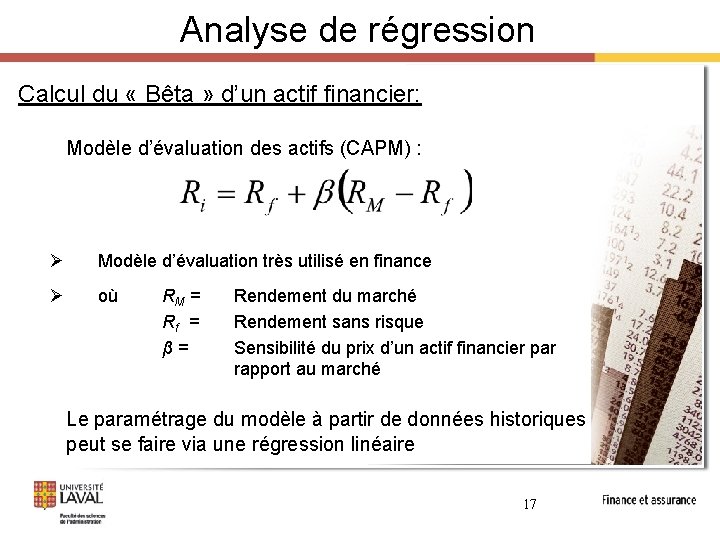

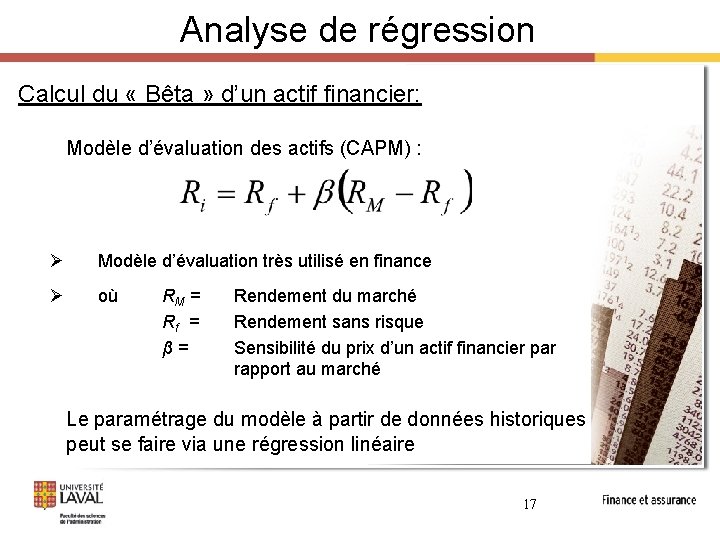

Analyse de régression Calcul du « Bêta » d’un actif financier: Modèle d’évaluation des actifs (CAPM) : Ø Modèle d’évaluation très utilisé en finance Ø où RM = Rf = β= Rendement du marché Rendement sans risque Sensibilité du prix d’un actif financier par rapport au marché Le paramétrage du modèle à partir de données historiques peut se faire via une régression linéaire 17

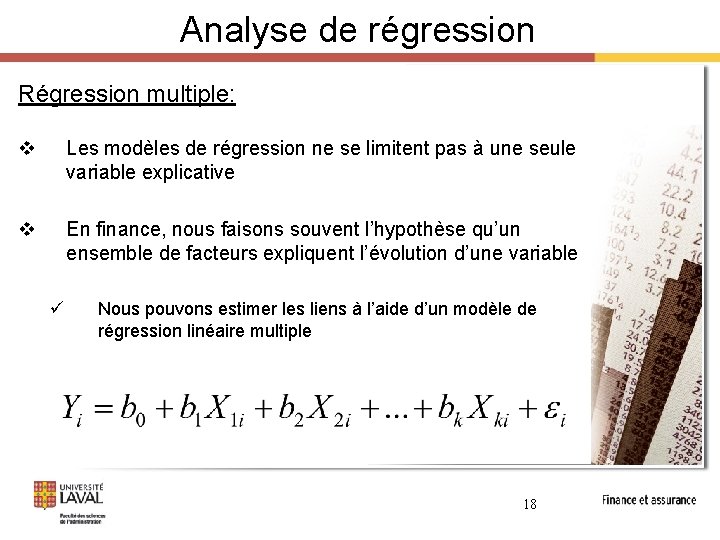

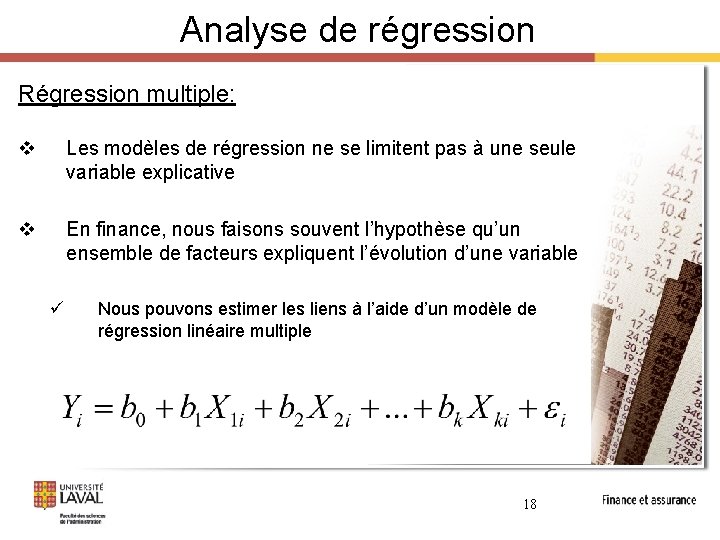

Analyse de régression Régression multiple: v Les modèles de régression ne se limitent pas à une seule variable explicative v En finance, nous faisons souvent l’hypothèse qu’un ensemble de facteurs expliquent l’évolution d’une variable ü Nous pouvons estimer les liens à l’aide d’un modèle de régression linéaire multiple 18

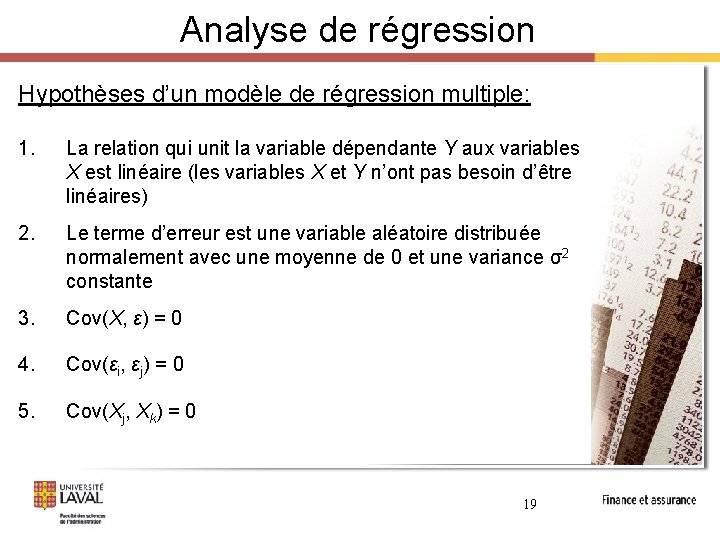

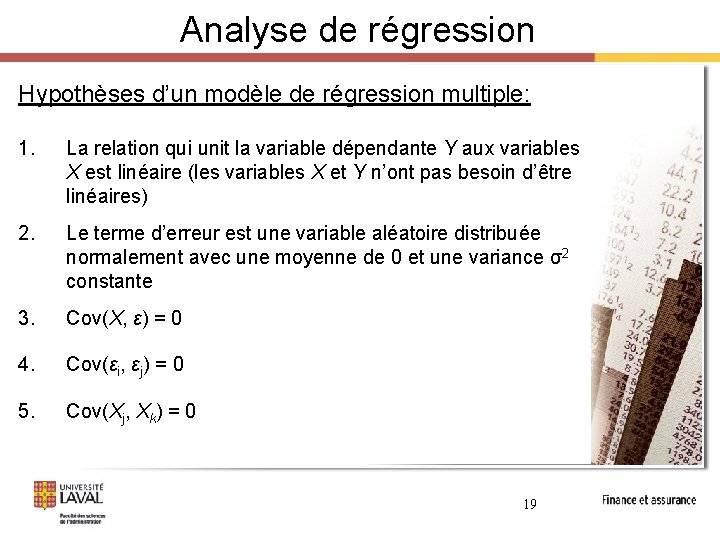

Analyse de régression Hypothèses d’un modèle de régression multiple: 1. La relation qui unit la variable dépendante Y aux variables X est linéaire (les variables X et Y n’ont pas besoin d’être linéaires) 2. Le terme d’erreur est une variable aléatoire distribuée normalement avec une moyenne de 0 et une variance σ2 constante 3. Cov(X, ε) = 0 4. Cov(εi, εj) = 0 5. Cov(Xj, Xk) = 0 19

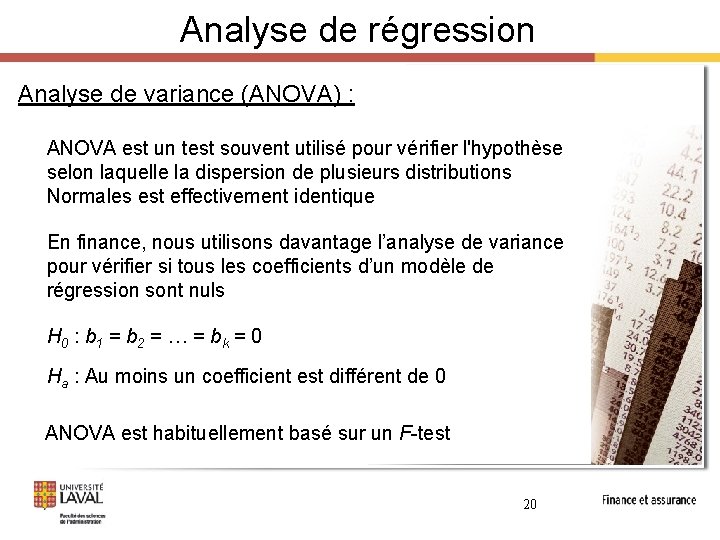

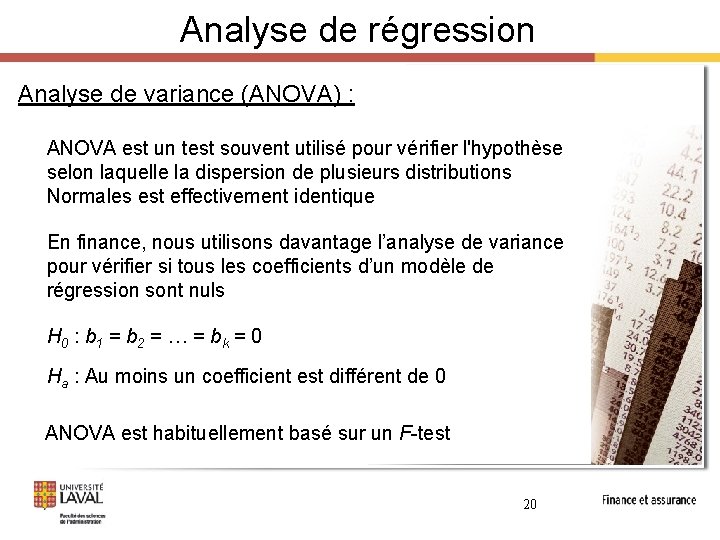

Analyse de régression Analyse de variance (ANOVA) : ANOVA est un test souvent utilisé pour vérifier l'hypothèse selon laquelle la dispersion de plusieurs distributions Normales est effectivement identique En finance, nous utilisons davantage l’analyse de variance pour vérifier si tous les coefficients d’un modèle de régression sont nuls H 0 : b 1 = b 2 = … = bk = 0 Ha : Au moins un coefficient est différent de 0 ANOVA est habituellement basé sur un F-test 20

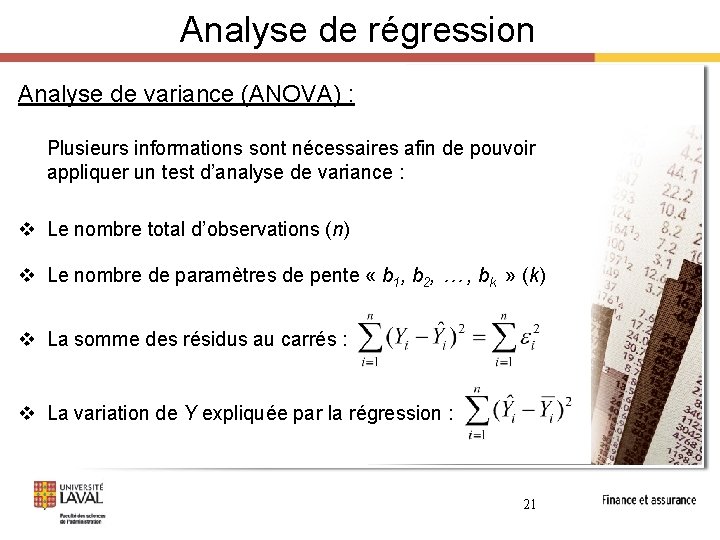

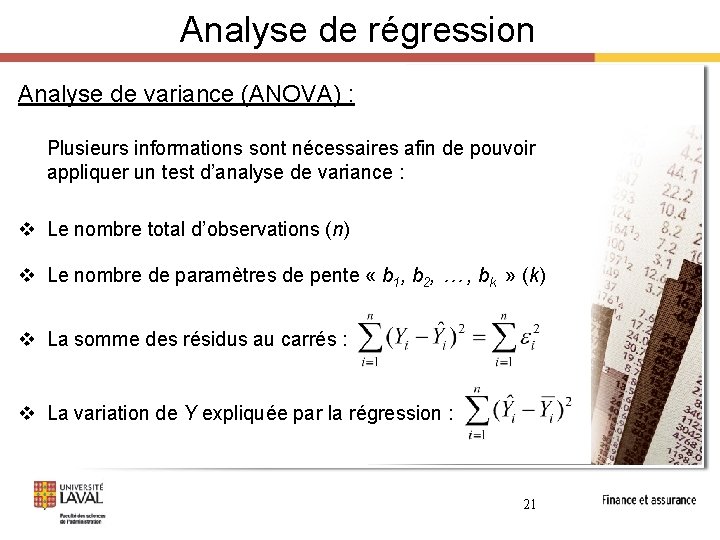

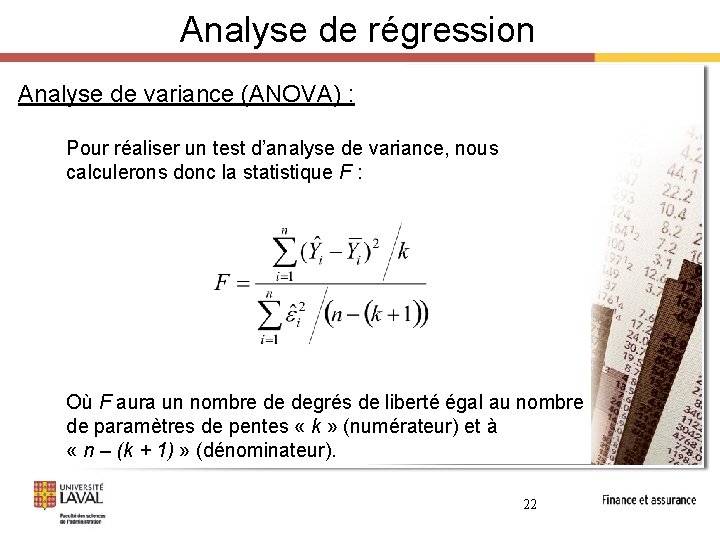

Analyse de régression Analyse de variance (ANOVA) : Plusieurs informations sont nécessaires afin de pouvoir appliquer un test d’analyse de variance : v Le nombre total d’observations (n) v Le nombre de paramètres de pente « b 1, b 2, … , bk » (k) v La somme des résidus au carrés : v La variation de Y expliquée par la régression : 21

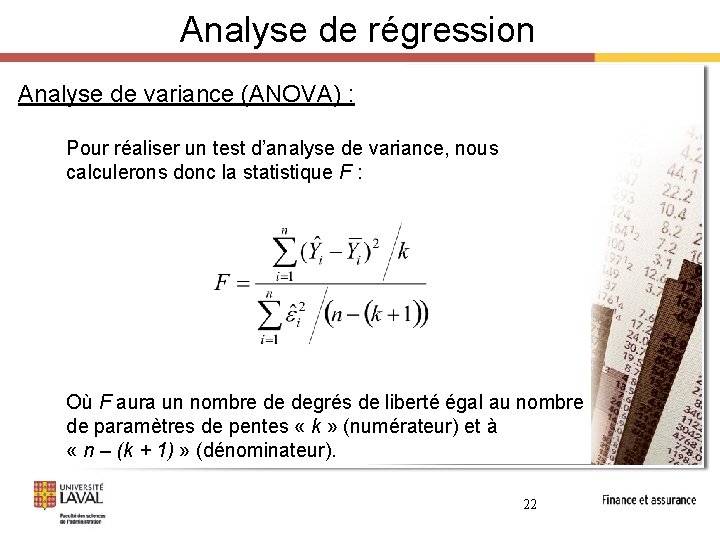

Analyse de régression Analyse de variance (ANOVA) : Pour réaliser un test d’analyse de variance, nous calculerons donc la statistique F : Où F aura un nombre de degrés de liberté égal au nombre de paramètres de pentes « k » (numérateur) et à « n – (k + 1) » (dénominateur). 22

Analyse de régression Analyse de variance (ANOVA) : v ANOVA est habituellement utilisé pour tester des modèles de régression multiple. S’il n’y a qu’une seule variable à tester, il sera plus simple d’utiliser un t-test v Plus la valeur de F sera élevée, plus les pentes des paramètres permettront d’expliquer la variable Y 23

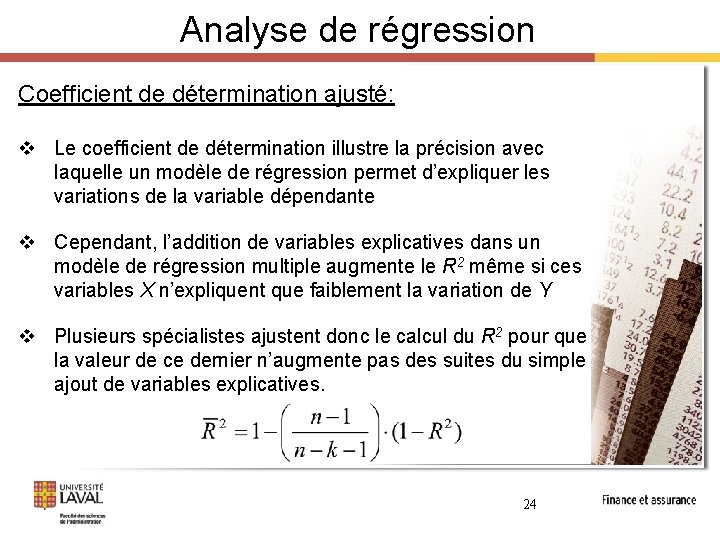

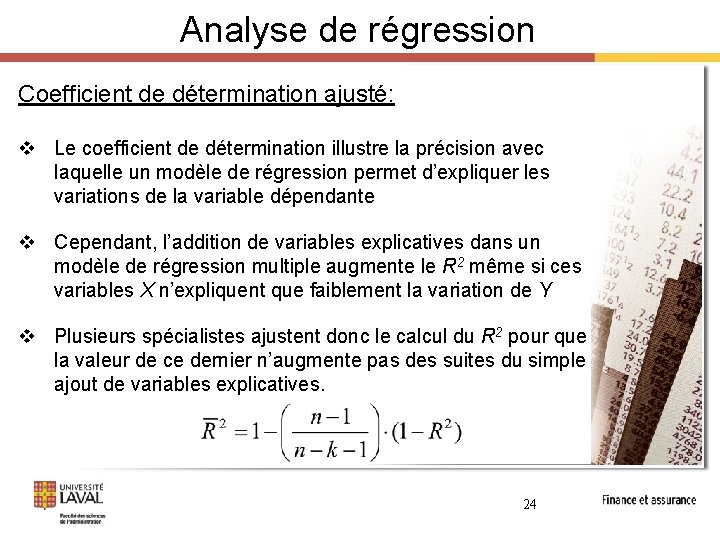

Analyse de régression Coefficient de détermination ajusté: v Le coefficient de détermination illustre la précision avec laquelle un modèle de régression permet d’expliquer les variations de la variable dépendante v Cependant, l’addition de variables explicatives dans un modèle de régression multiple augmente le R 2 même si ces variables X n’expliquent que faiblement la variation de Y v Plusieurs spécialistes ajustent donc le calcul du R 2 pour que la valeur de ce dernier n’augmente pas des suites du simple ajout de variables explicatives. 24

Analyse de régression Limites: v La valeur des paramètres estimés d’un modèle de régression peuvent évoluer dans le temps v Les prédictions basées sur un modèle de régression ne seront pas valides si les hypothèses du modèle ne tiennent pas ü La variance des termes d’erreur n’est pas toujours stable, ce qui entraîne un problème d’hétéroscédasticité ü Si les termes d’erreur sont corrélés entres-eux, alors il y a un problème d’autocorrélation ü Si les variables indépendantes sont corrélées entres-elles, alors il y a un problème de multicollinéarité 25

Problèmes associés à l’analyse de régression 26

Hypothèses 1. La relation qui unit la variable dépendante Y aux variables X est linéaire (les variables X et Y n’ont pas besoin d’être linéaires) 2. Le terme d’erreur est une variable aléatoire distribuée normalement avec une moyenne de 0 et une variance σ2 constante. • 3. Variance pas constante Hétéroscédasticité Cov(X, ε) = 0 • 4. Termes d’erreurs corrélés avec les variables explicatives Endogénéïté Cov(εi, εj) = 0 • 5. Termes d’erreurs corrélés entre eux Autocorrélation Cov(Xj, Xk) = 0 • Variables indépendantes corrélées Multicollinéarité 27

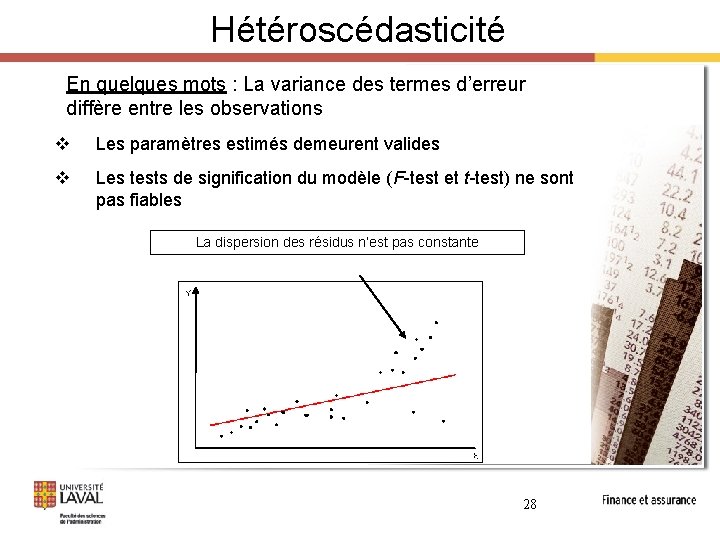

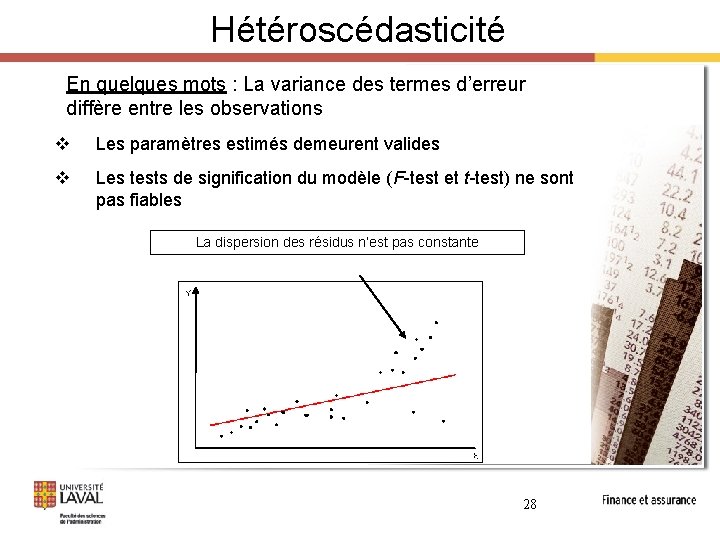

Hétéroscédasticité En quelques mots : La variance des termes d’erreur diffère entre les observations v Les paramètres estimés demeurent valides v Les tests de signification du modèle (F-test et t-test) ne sont pas fiables La dispersion des résidus n’est pas constante 28

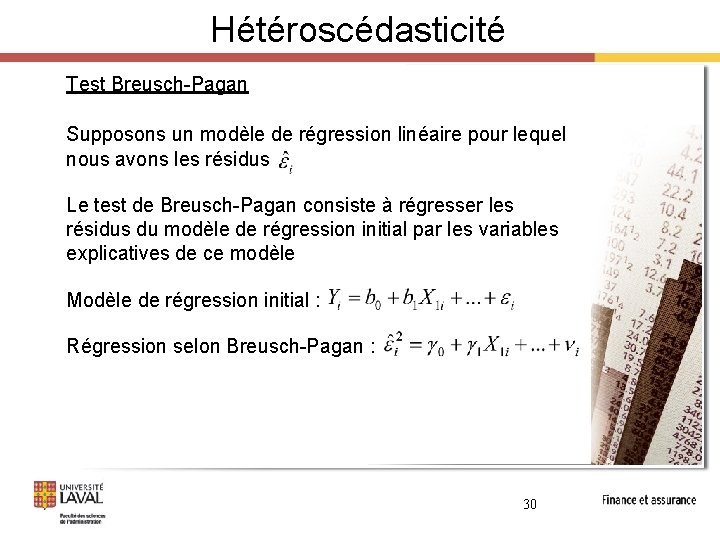

Hétéroscédasticité v En présence d’hétéroscédasticité, la valeur du statistique t et du statistique F seront surestimés ü v Nous aurons donc tendance à rejeter plus souvent qu’il ne le faudrait l’hypothèse nulle Test pour détecter l’hétéroscédasticité conditionnelle : ü Test Breusch-Pagan Cette méthode examine si la variance estimée des résidus d’une régression dépend de la valeur des variables explicatives. 29

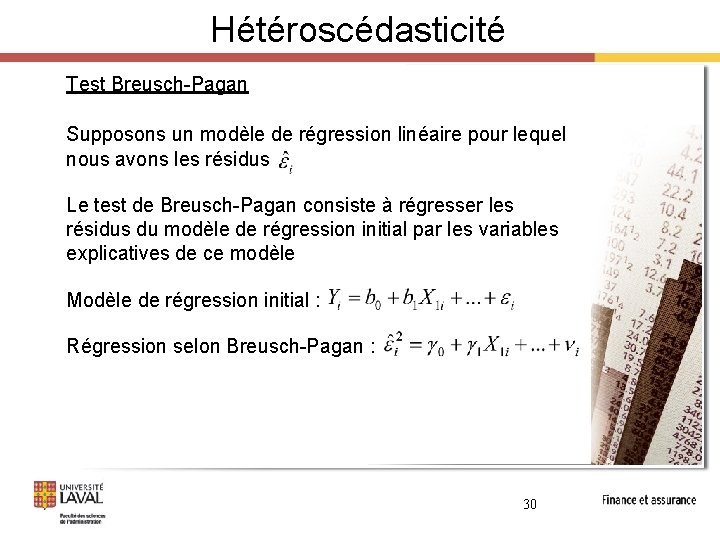

Hétéroscédasticité Test Breusch-Pagan Supposons un modèle de régression linéaire pour lequel nous avons les résidus Le test de Breusch-Pagan consiste à régresser les résidus du modèle de régression initial par les variables explicatives de ce modèle Modèle de régression initial : Régression selon Breusch-Pagan : 30

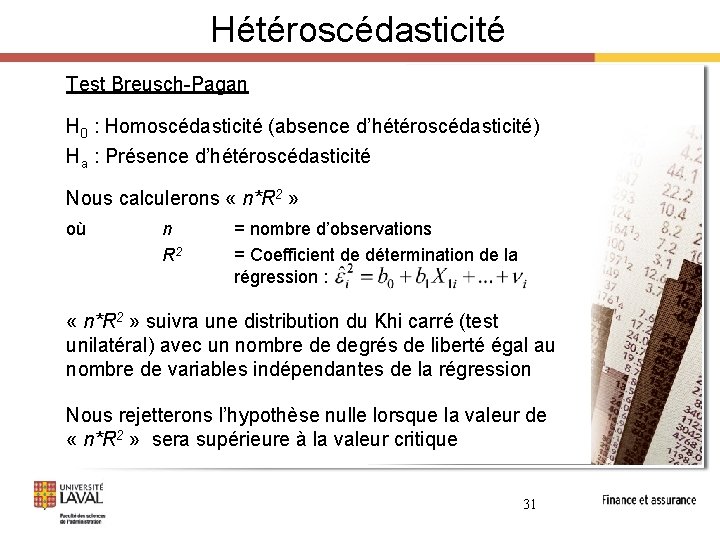

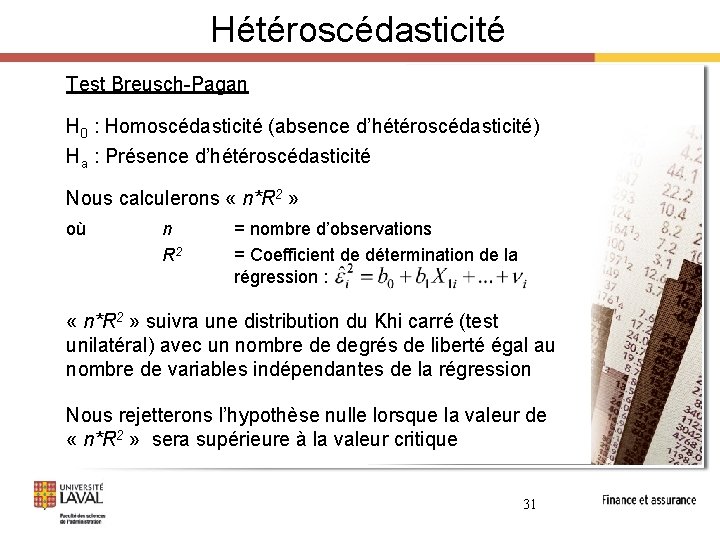

Hétéroscédasticité Test Breusch-Pagan H 0 : Homoscédasticité (absence d’hétéroscédasticité) Ha : Présence d’hétéroscédasticité Nous calculerons « n*R 2 » où n R 2 = nombre d’observations = Coefficient de détermination de la régression : « n*R 2 » suivra une distribution du Khi carré (test unilatéral) avec un nombre de degrés de liberté égal au nombre de variables indépendantes de la régression Nous rejetterons l’hypothèse nulle lorsque la valeur de « n*R 2 » sera supérieure à la valeur critique 31

Hétéroscédasticité Méthode de correction Les méthode de correction pour l’hétéroscédasticité les plus populaires sont : ü ü ü Régression robustes (méthode de White) Les moindres-carrés pondérés Les moindres-carrés quasi-généralisés 32

Autocorrélation En quelques mots : Les résidus sont corrélés entre eux. C’est un problème fréquent des séries chronologiques v Les paramètres estimés demeurent valides (sauf si une variable X est un « lag » de la variable Y) v Les tests de signification du modèle (F-test et t-test) ne sont pas fiables 33

Autocorrélation positive : un résidu positif pour une observation accroît les probabilités d’obtenir un résidu positif pour l’observation suivante. C’est le type d’autocorrélation le plus fréquent. Autocorrélation négative : un résidu positif pour une observation accroît les probabilités d’obtenir un résidu négatif pour l’observation suivante v En présence d’autocorrélation positive, la valeur du statistique t et du statistique F seront surestimés ü Nous aurons donc tendance à rejeter plus souvent qu’il ne le faudrait l’hypothèse nulle 34

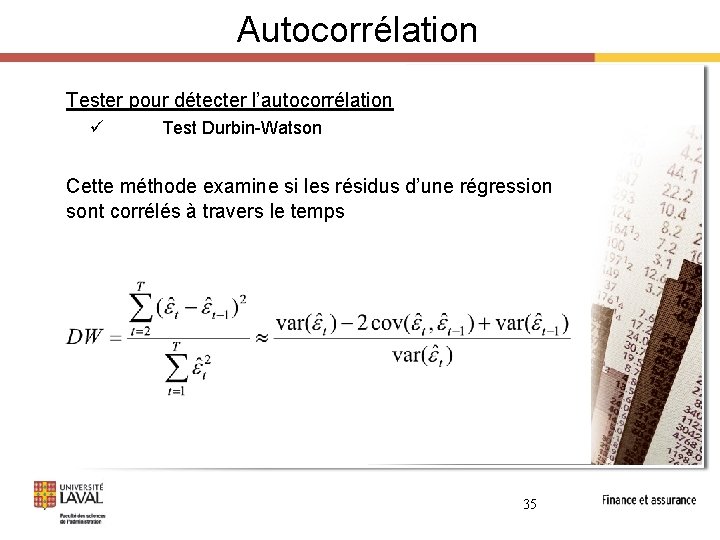

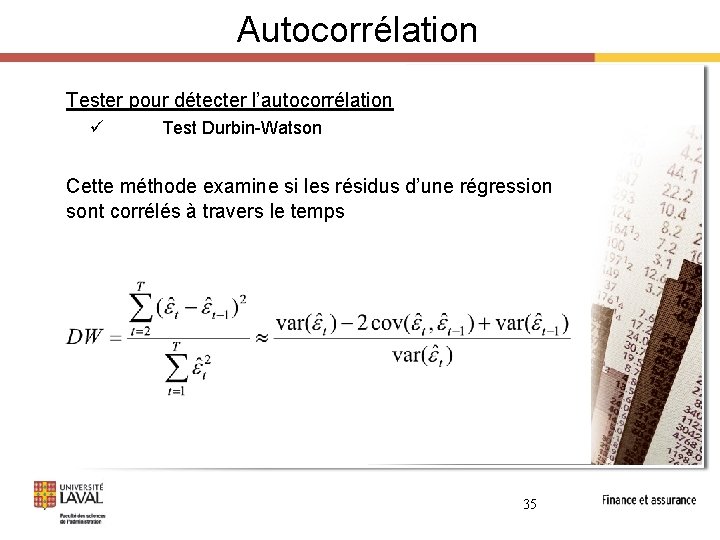

Autocorrélation Tester pour détecter l’autocorrélation ü Test Durbin-Watson Cette méthode examine si les résidus d’une régression sont corrélés à travers le temps 35

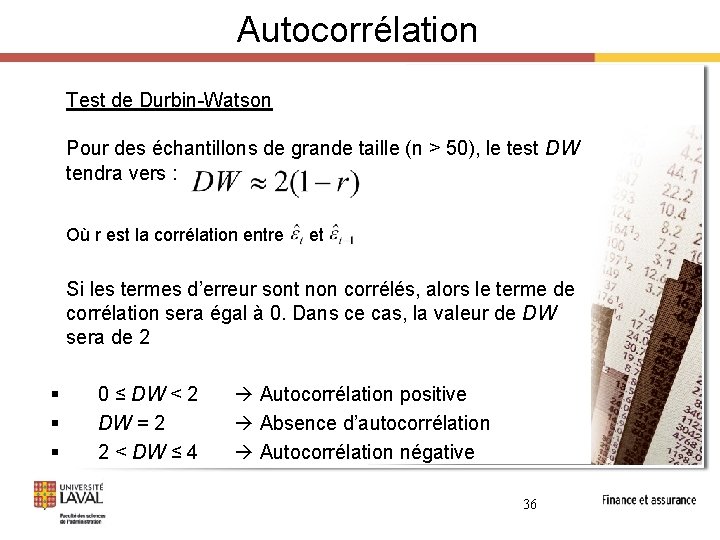

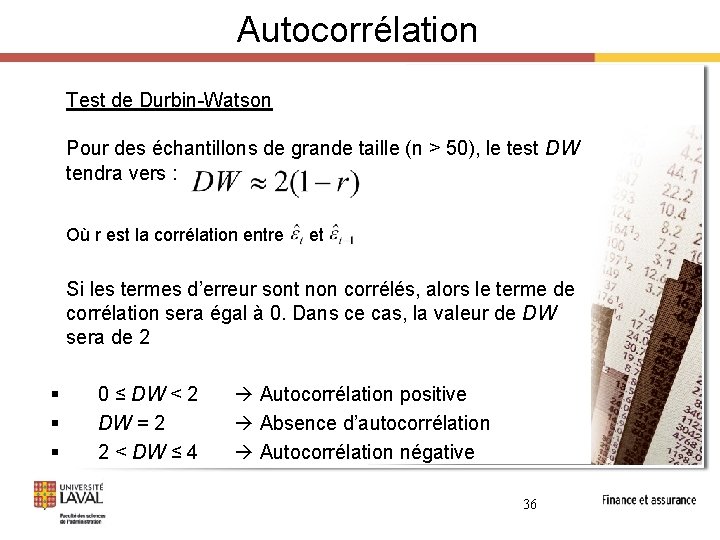

Autocorrélation Test de Durbin-Watson Pour des échantillons de grande taille (n > 50), le test DW tendra vers : Où r est la corrélation entre et Si les termes d’erreur sont non corrélés, alors le terme de corrélation sera égal à 0. Dans ce cas, la valeur de DW sera de 2 § § § 0 ≤ DW < 2 DW = 2 2 < DW ≤ 4 Autocorrélation positive Absence d’autocorrélation Autocorrélation négative 36

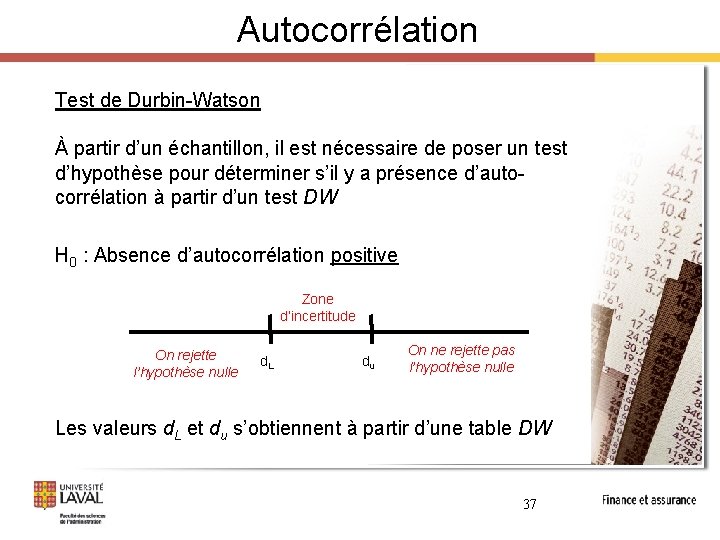

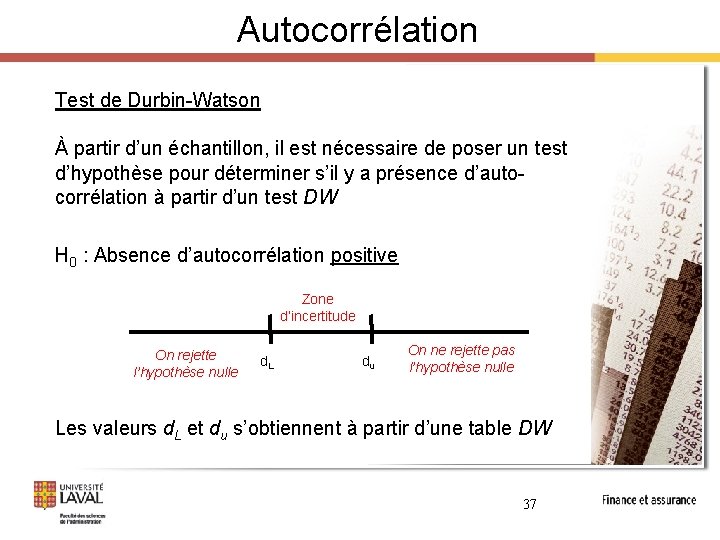

Autocorrélation Test de Durbin-Watson À partir d’un échantillon, il est nécessaire de poser un test d’hypothèse pour déterminer s’il y a présence d’autocorrélation à partir d’un test DW H 0 : Absence d’autocorrélation positive Zone d’incertitude On rejette l’hypothèse nulle d. L du On ne rejette pas l’hypothèse nulle Les valeurs d. L et du s’obtiennent à partir d’une table DW 37

Autocorrélation Test de Durbin-Watson Plusieurs facteurs doivent être réunis pour qu’il soit possible d’appliquer un test de Durbin-Watson : 1. Le modèle doit posséder une constante (b 0 ≠ 0) 2. Le nombre d’observations doit être supérieur ou égal à 15 3. Le modèle estimé ne doit pas contenir la variable dépendante retardée ( « laggée » ) dans les variables explicatives 4. Le test DW permet uniquement de tester l’autocorrélation d’ordre 1 38

Autocorrélation Méthode de correction Les méthode de correction pour l’autocorrélation les plus populaires sont : ü ü ü Modèles autorégressifs Les moindres-carrés généralisés La procédure Cochrane-Orcutt 39

Multicollinéarité En quelques mots : Deux ou plusieurs variables indépendantes sont corrélées entre-elles v Bien qu’il soit possible d’estimer les paramètres de régression, la multicollinéarité complique l’interprétation que l’on peut faire des résultats v Il devient pratiquement impossible de distinguer l’impact individuel d’une variable indépendante v On rejette plus rarement l’hypothèse nulle de signification des paramètres des variables indépendantes 40

Multicollinéarité v Il n’existe pas de test statistique formel pour détecter la présence de multicollinéarité v En pratique, ce n’est pas tant la présence/absence multicollinéarité qui nous intéresse que la force de cette relation v Le coefficient de corrélation entre deux variables n’est pas un bon indicateur de la multicollinéarité ü ü v Un faible coefficient de corrélation n’exclut pas la présence d’un problème de multicollinéarité r est un bon indicateur si seulement 2 variables explicatives Obtenir un R 2 élevé, un F-test significatif et des t-test non significatifs = symptôme commun de la multicollinéarité 41

Multicollinéarité v Lorsqu’on soupçonne un problème de multicollinéarité, la solution la plus simple consiste à exclure une ou plusieurs variables indépendantes d’un modèle ü Supprimer une variable d’un modèle n’est cependant pas une solution miracle : exclure une variable explicative peut être une cause de mauvaise spécification d’un modèle et entraîner divers problèmes tels que l’hétéroscédasticité 42

Spécification d’un modèle Quelques principes de base peuvent aider à guider le choix d’un modèle de régression : 1. Le modèle doit être cohérent avec l’intuition économique 2. La forme des variables dans la régression doit être conséquente avec la nature de ces variables 3. Le modèle doit permettre d’obtenir des résultats fiables avec le plus petit nombre possible de variables. Ceci signifie que chaque variable doit jouer un rôle essentiel. 4. Il est important de vérifier si les hypothèses propres aux modèles de régression tiennent avant d’accepter un modèle 5. Tout modèle doit être testé au-delà des données de l’échantillon initial avant d’être accepté 43