La rgression simple Michel Tenenhaus 1 La rgression

- Slides: 37

La régression simple Michel Tenenhaus 1

La régression simple Étude de la liaison linéaire entre deux variables numériques : - une variable explicative X - une variable à expliquer Y 2

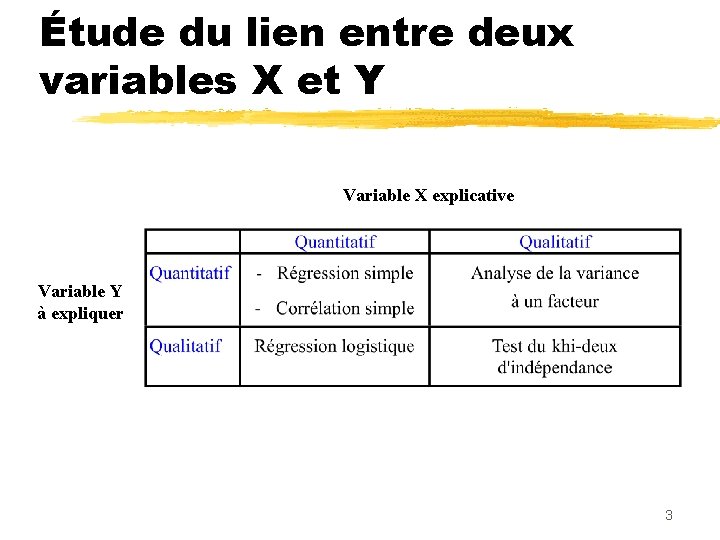

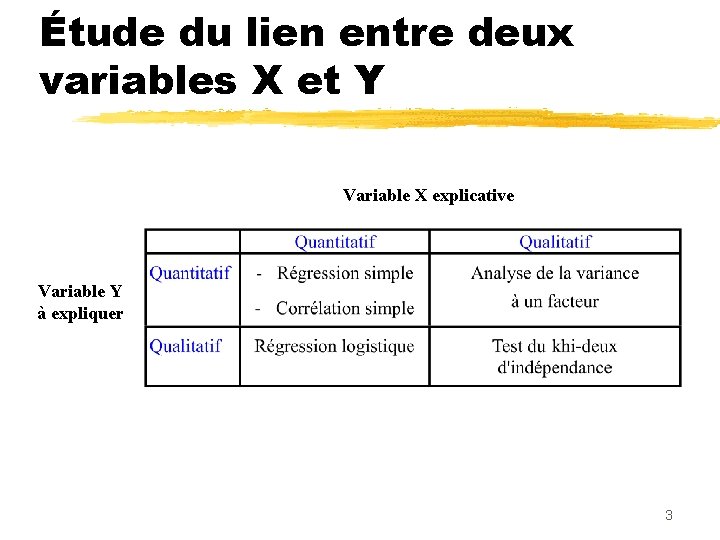

Étude du lien entre deux variables X et Y Variable X explicative Variable Y à expliquer 3

Cas Prix d’un appartement 4

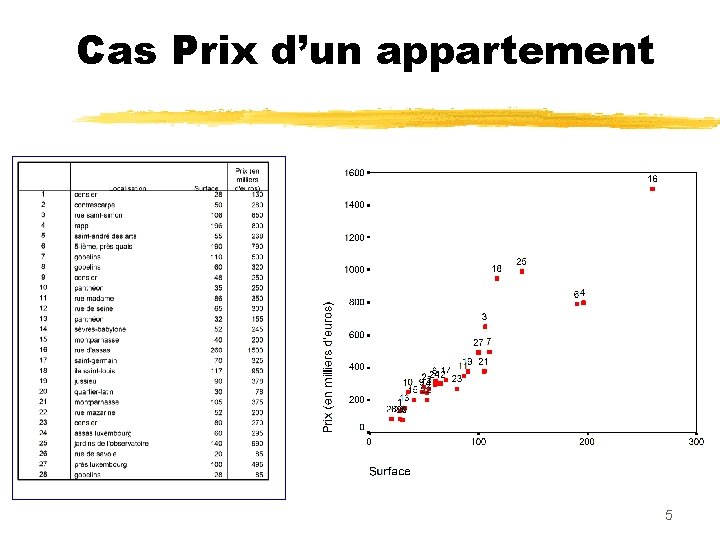

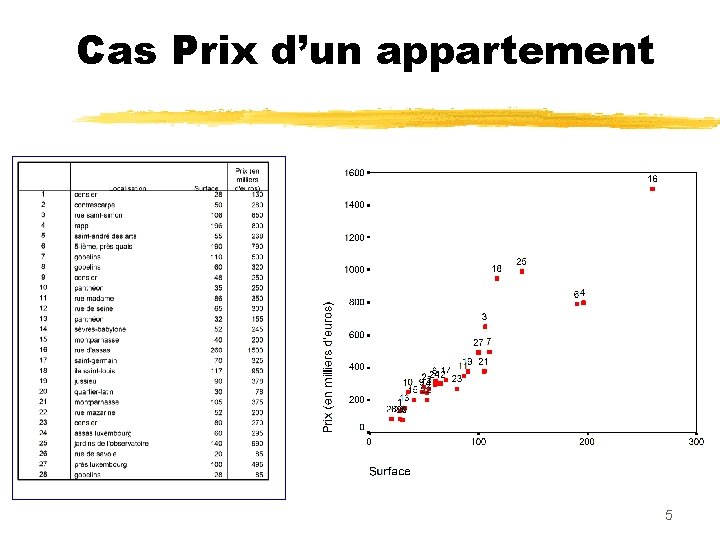

Cas Prix d’un appartement 5

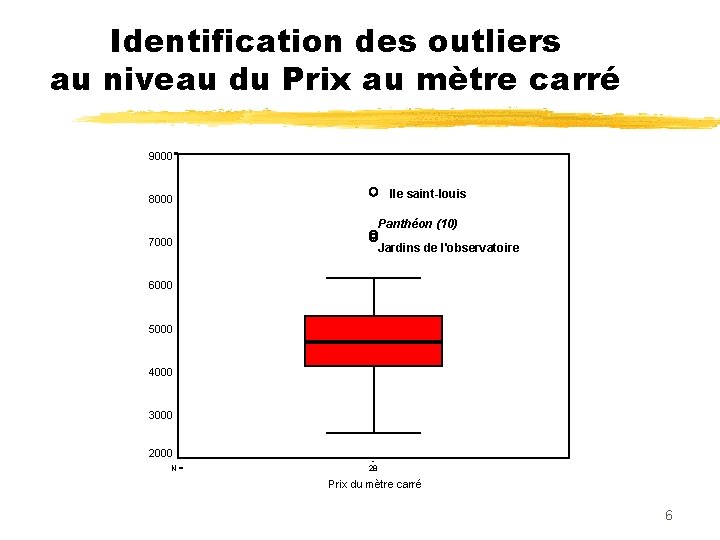

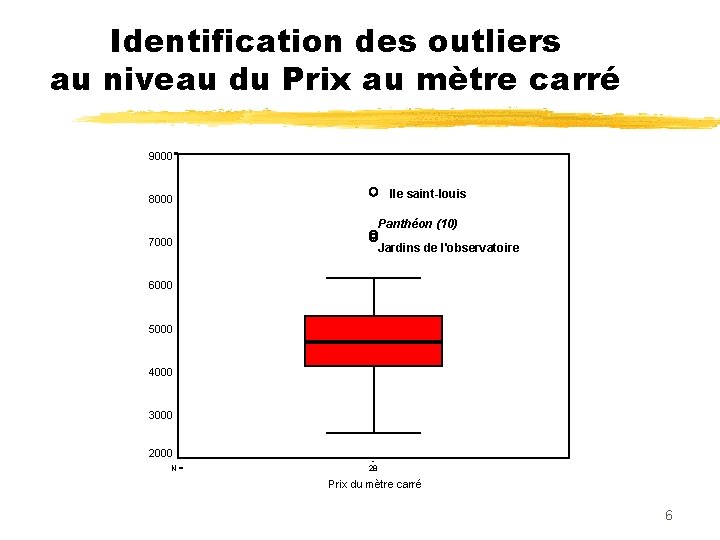

Identification des outliers au niveau du Prix au mètre carré 9000 Ile saint-louis 8000 Panthéon (10) 7000 Jardins de l'observatoire 6000 5000 4000 3000 2000 N= 28 Prix du mètre carré 6

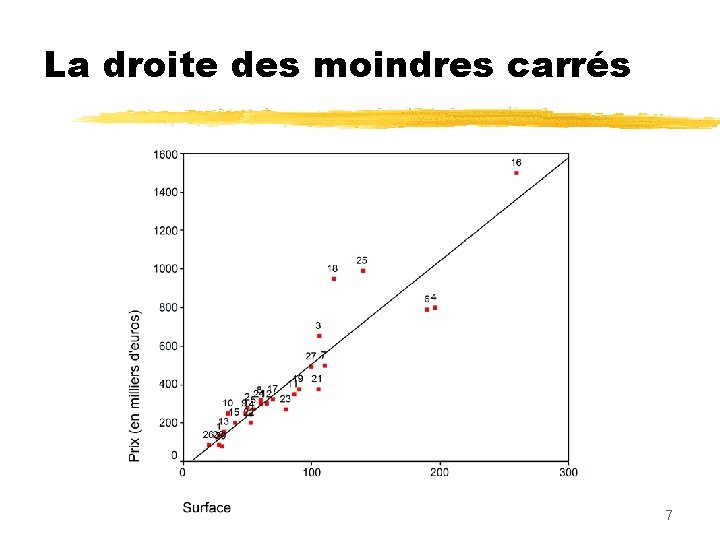

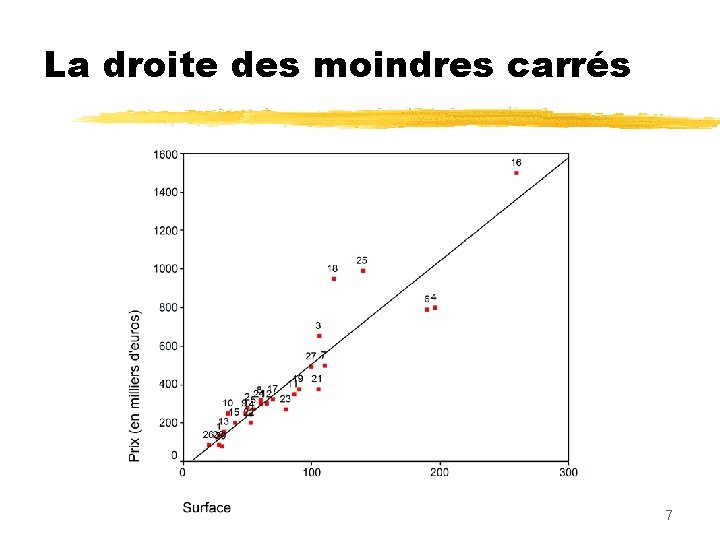

La droite des moindres carrés 7

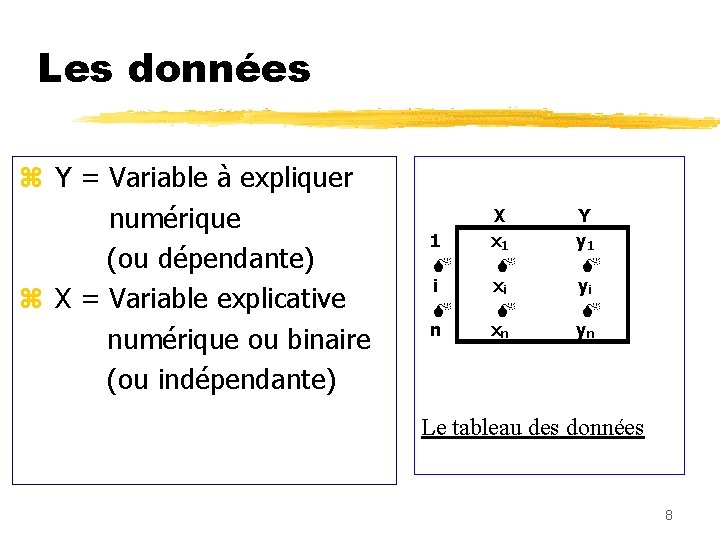

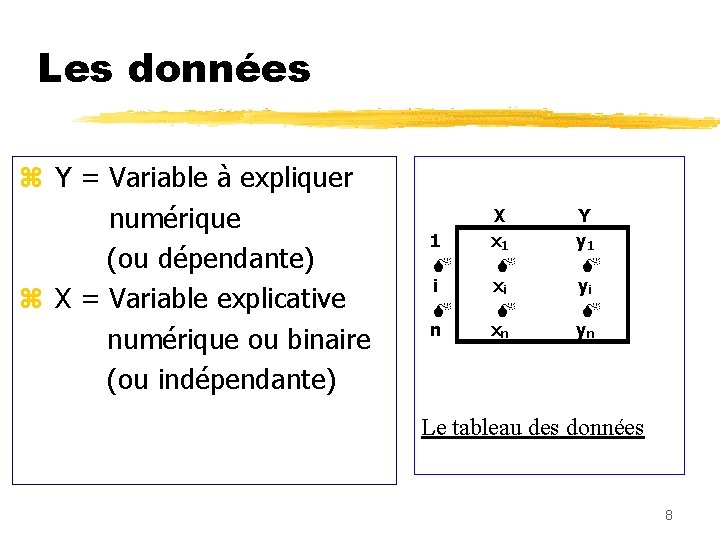

Les données z Y = Variable à expliquer numérique (ou dépendante) z X = Variable explicative numérique ou binaire (ou indépendante) 1 M i M n X x 1 M xi M xn Y y 1 M yi M yn Le tableau des données 8

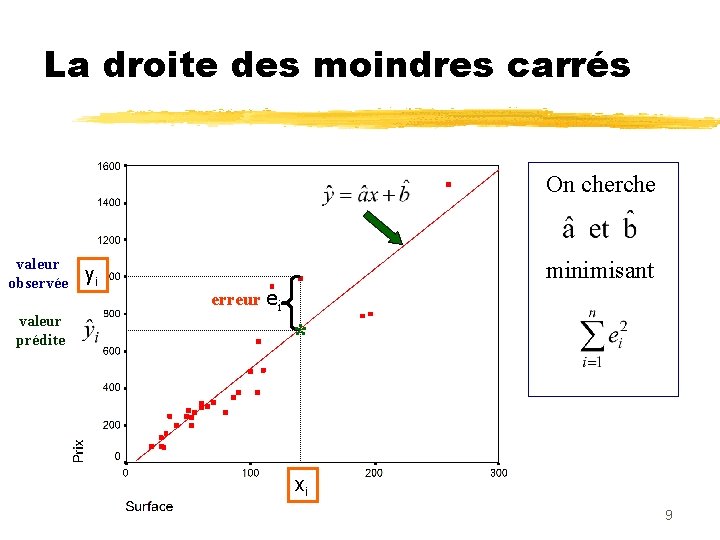

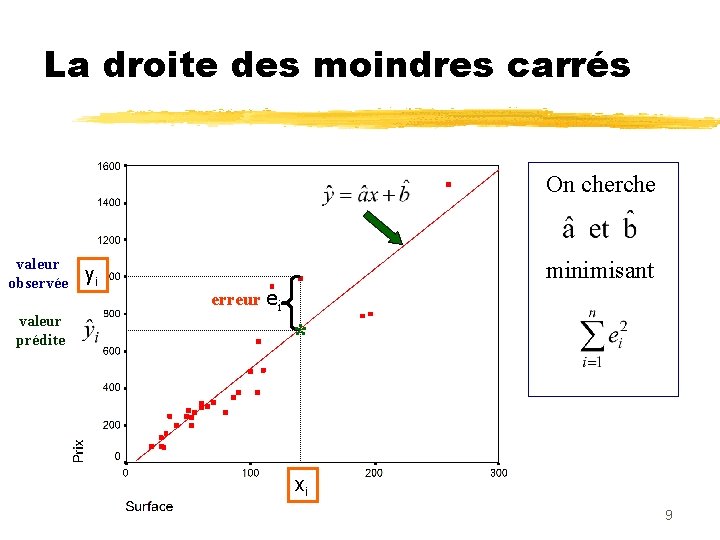

La droite des moindres carrés On cherche valeur observée valeur prédite yi minimisant erreur ei * xi 9

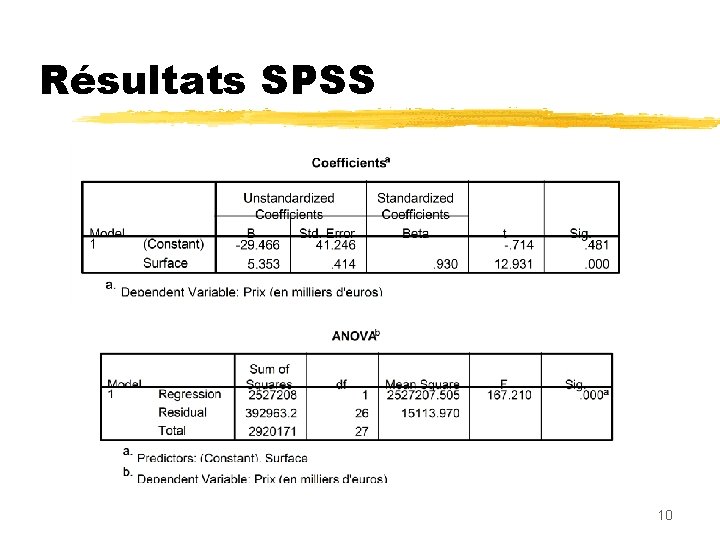

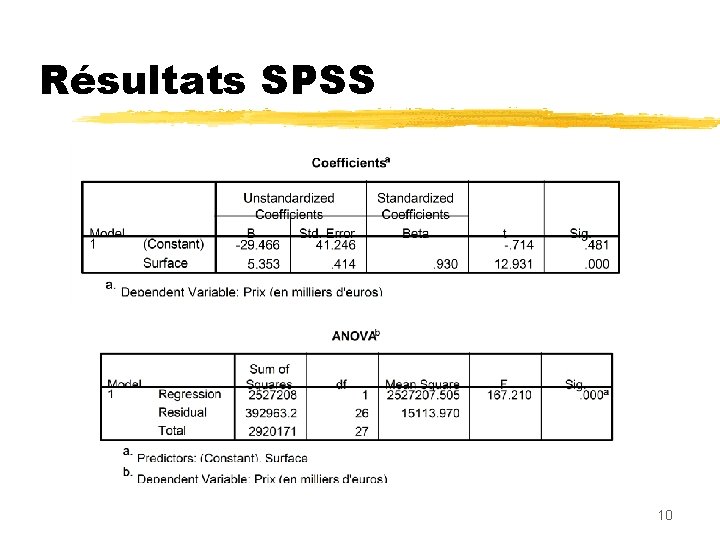

Résultats SPSS 10

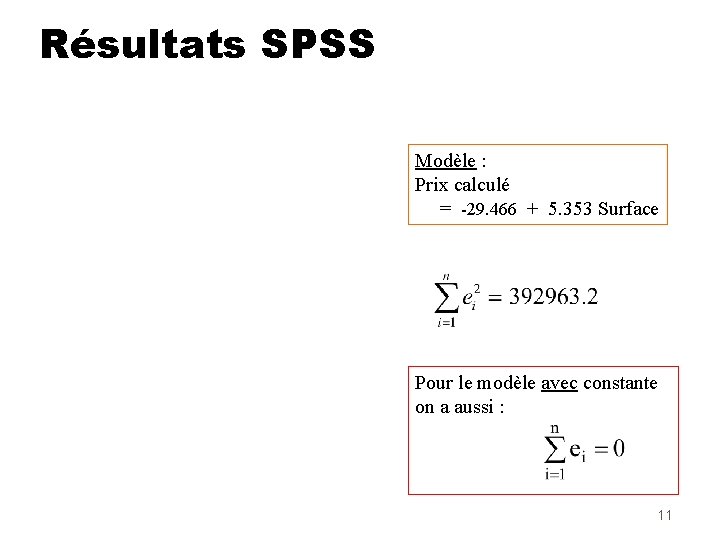

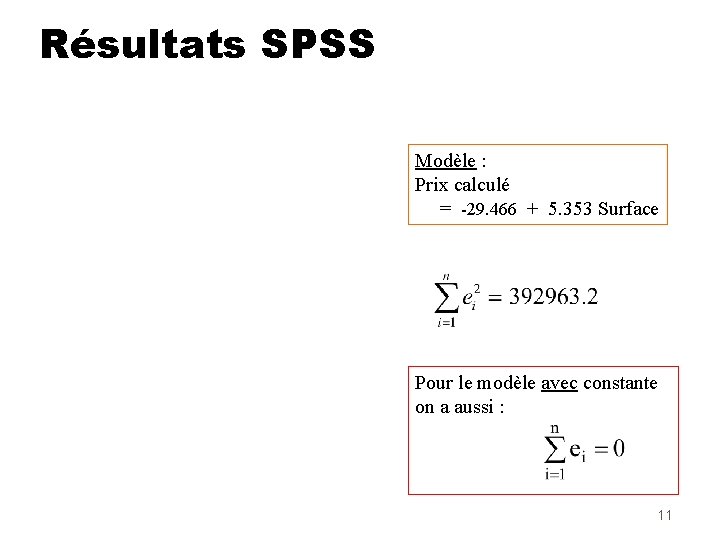

Résultats SPSS Modèle : Prix calculé = -29. 466 + 5. 353 Surface Pour le modèle avec constante on a aussi : 11

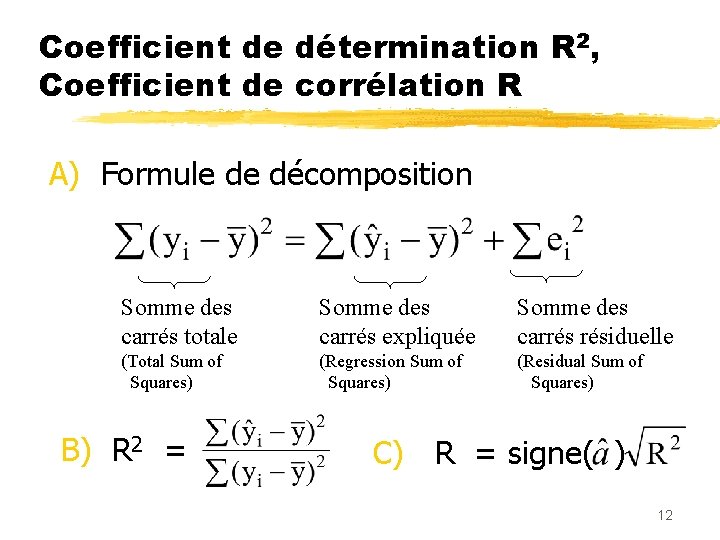

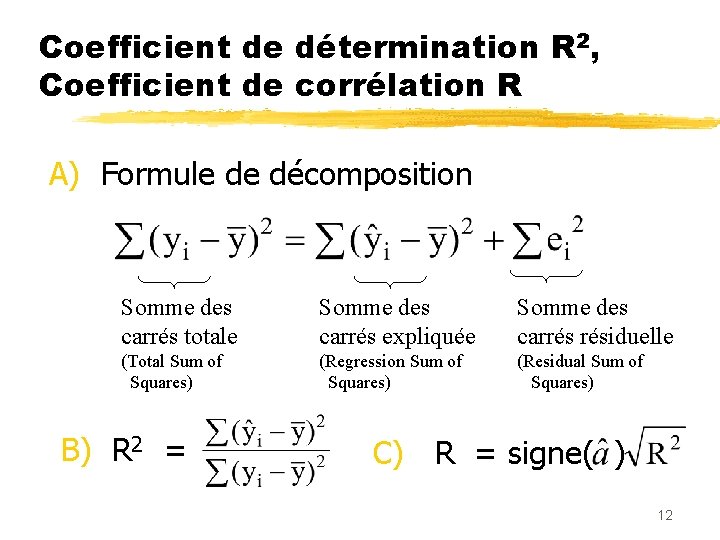

Coefficient de détermination R 2, Coefficient de corrélation R A) Formule de décomposition Somme des carrés totale Somme des carrés expliquée Somme des carrés résiduelle (Total Sum of Squares) (Regression Sum of Squares) (Residual Sum of Squares) B) R 2 = C) R = signe( ) 12

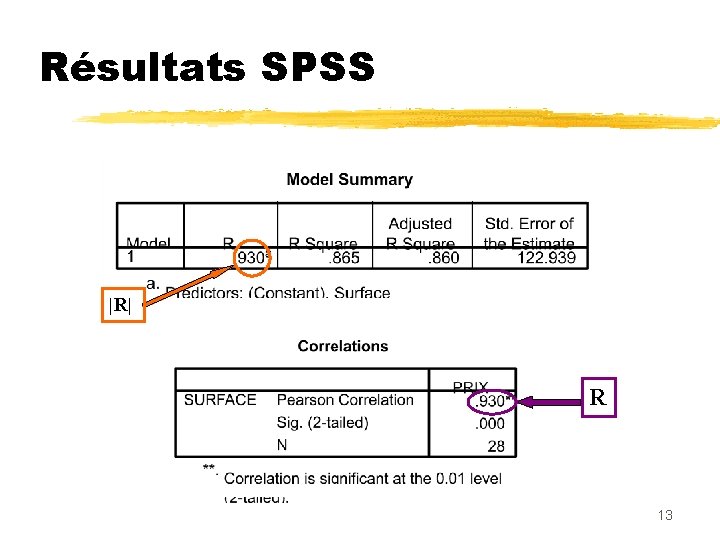

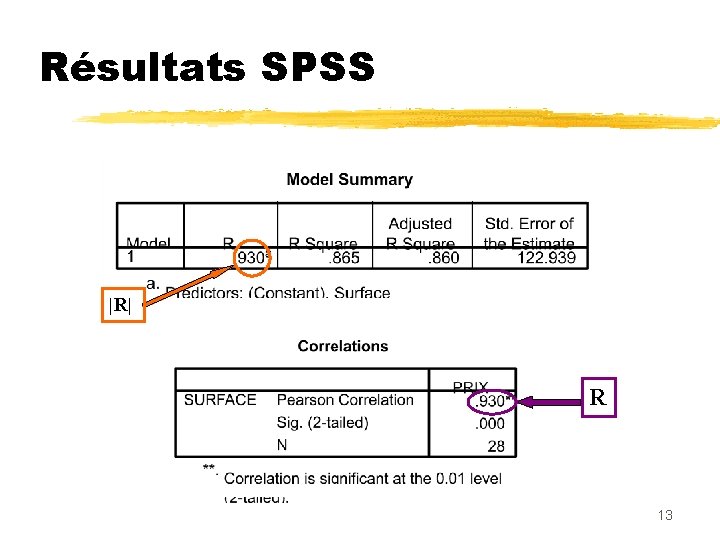

Résultats SPSS |R| R 13

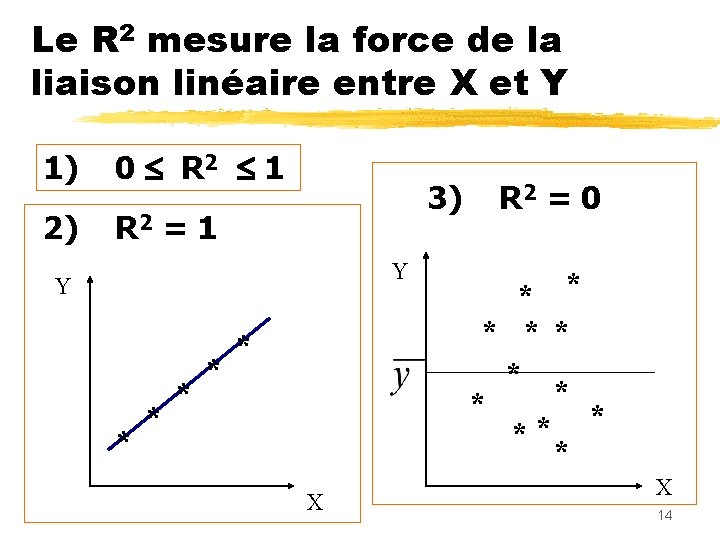

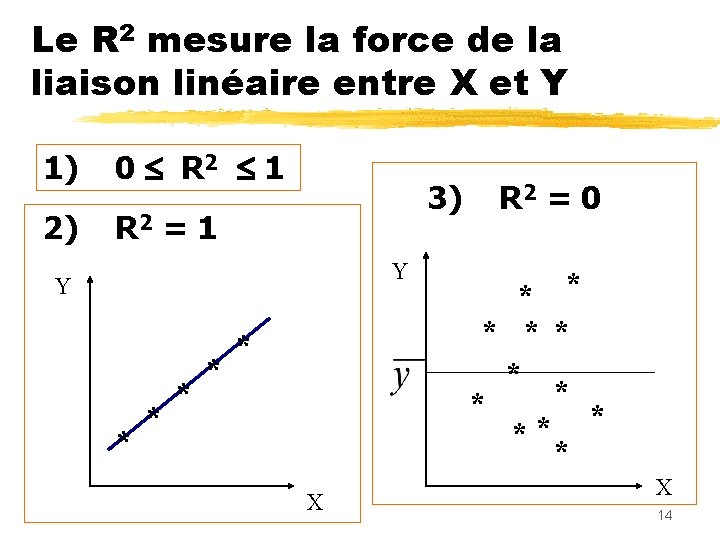

Le R 2 mesure la force de la liaison linéaire entre X et Y 1) 0 R 2 1 2) R 2 = 1 3) Y Y * * * X R 2 = 0 * * * X 14

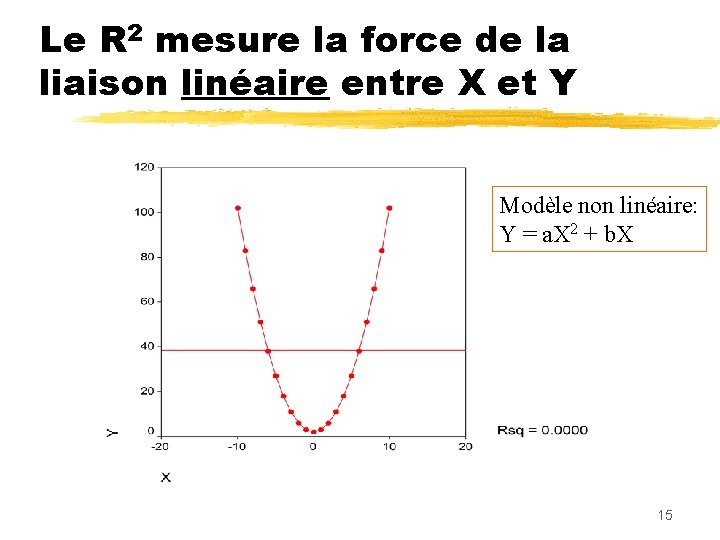

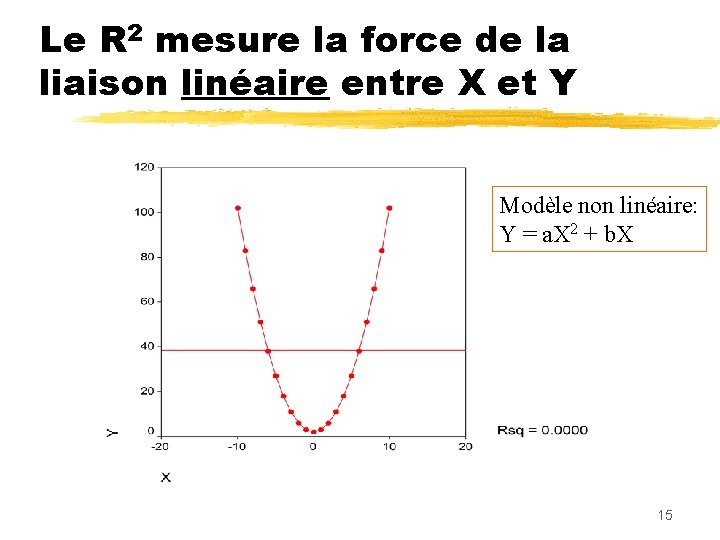

Le R 2 mesure la force de la liaison linéaire entre X et Y Modèle non linéaire: Y = a. X 2 + b. X 15

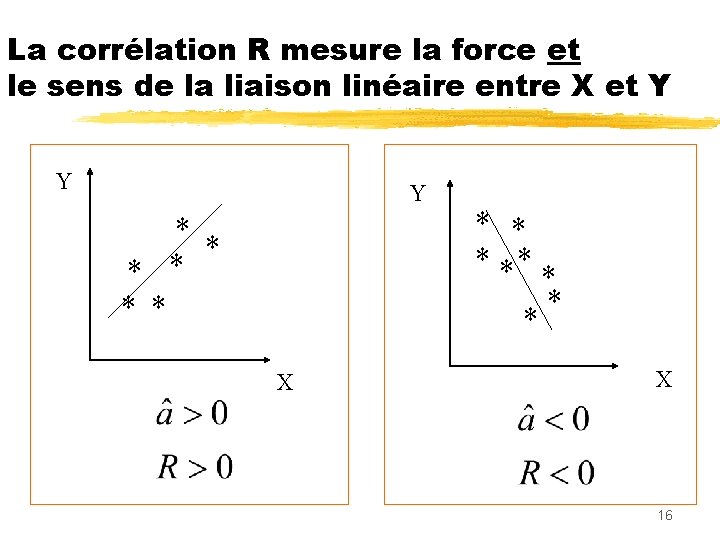

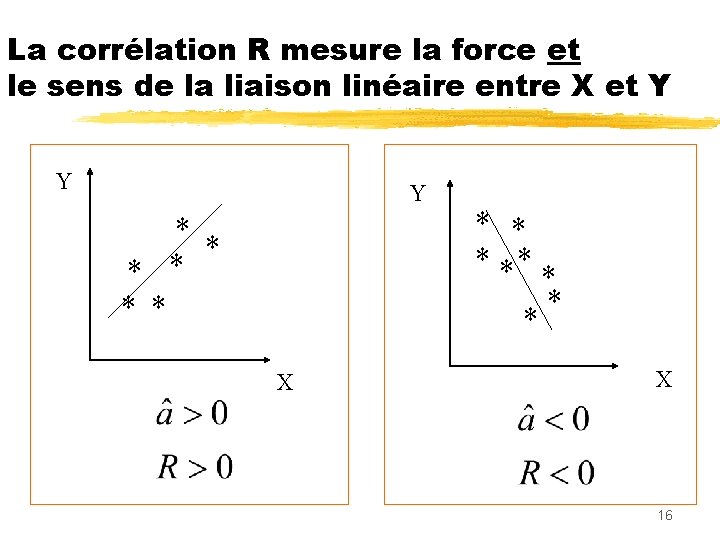

La corrélation R mesure la force et le sens de la liaison linéaire entre X et Y Y Y * * * * ** * X 16

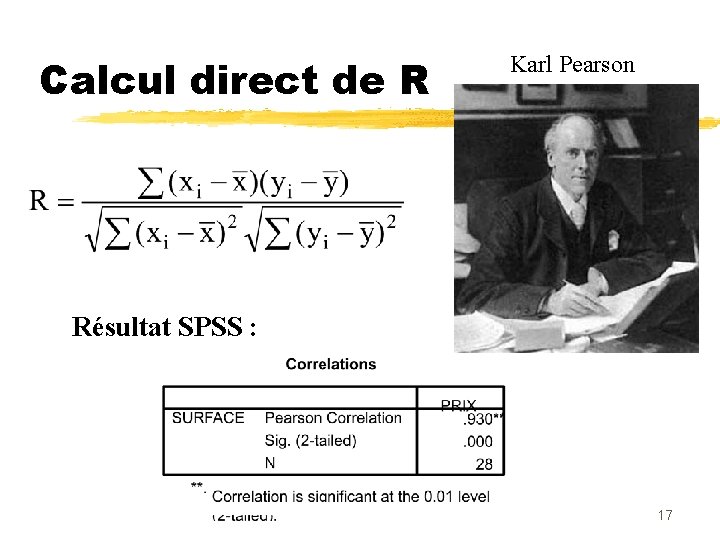

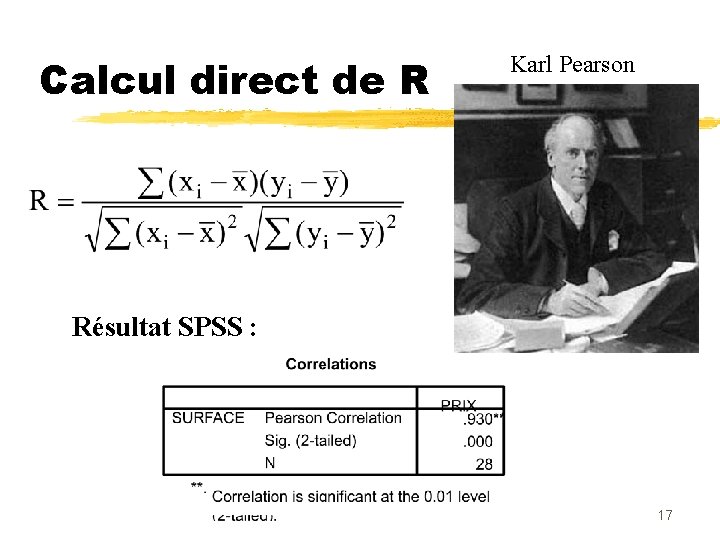

Calcul direct de R Karl Pearson Résultat SPSS : 17

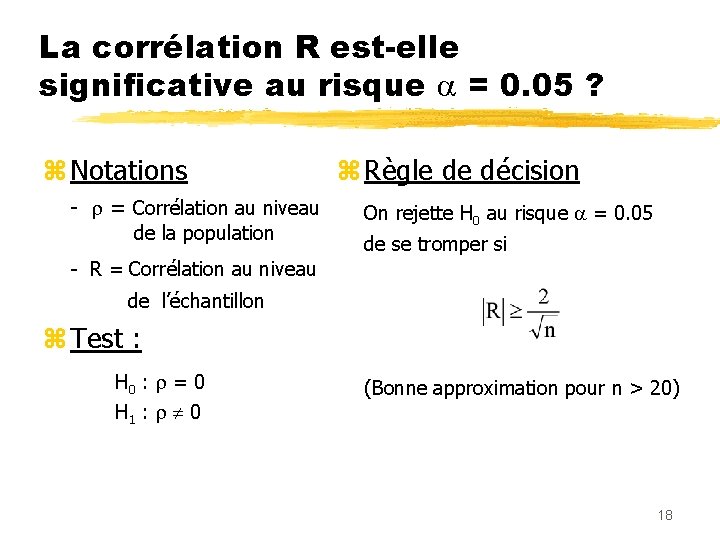

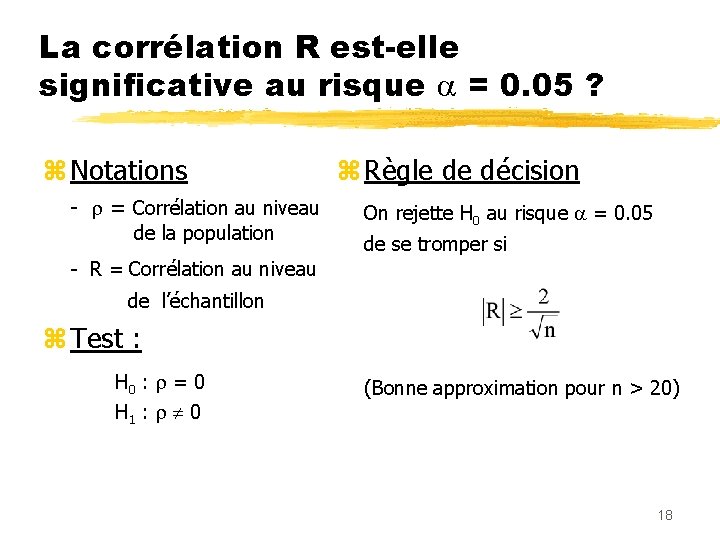

La corrélation R est-elle significative au risque = 0. 05 ? z Notations - = Corrélation au niveau de la population z Règle de décision On rejette H 0 au risque = 0. 05 de se tromper si - R = Corrélation au niveau de l’échantillon z Test : H 0 : = 0 (Bonne approximation pour n > 20) H 1 : 0 18

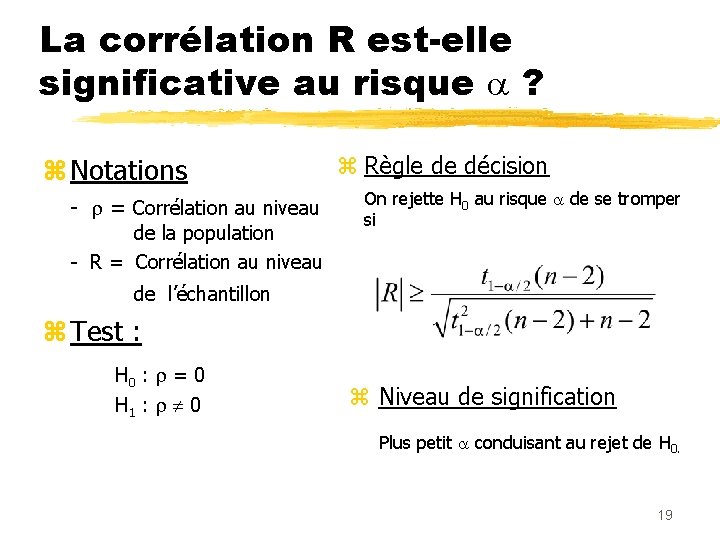

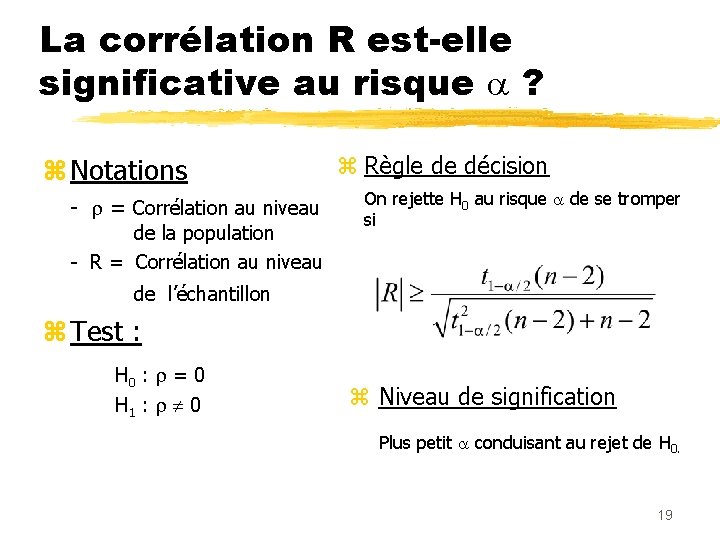

La corrélation R est-elle significative au risque ? z Notations - = Corrélation au niveau de la population - R = Corrélation au niveau z Règle de décision On rejette H 0 au risque de se tromper si de l’échantillon z Test : H 0 : = 0 H 1 : 0 z Niveau de signification Plus petit conduisant au rejet de H 0. 19

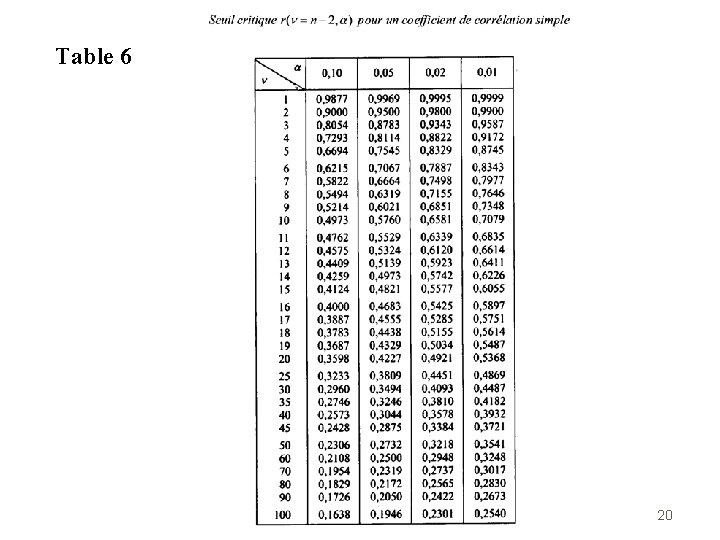

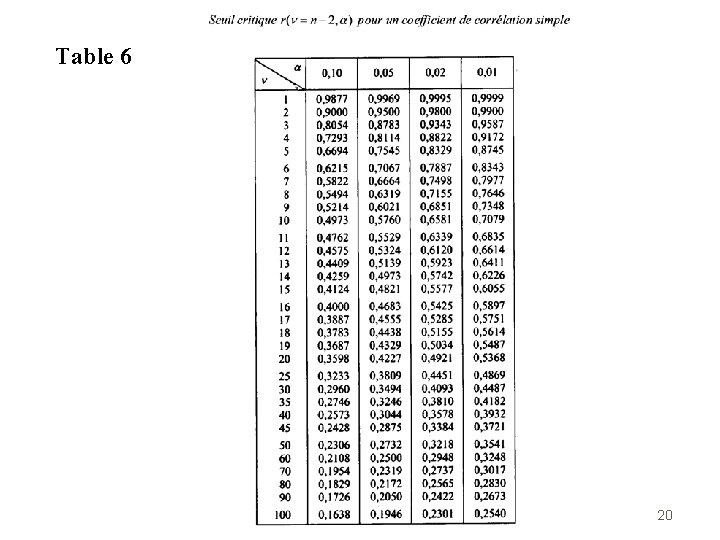

Table 6 20

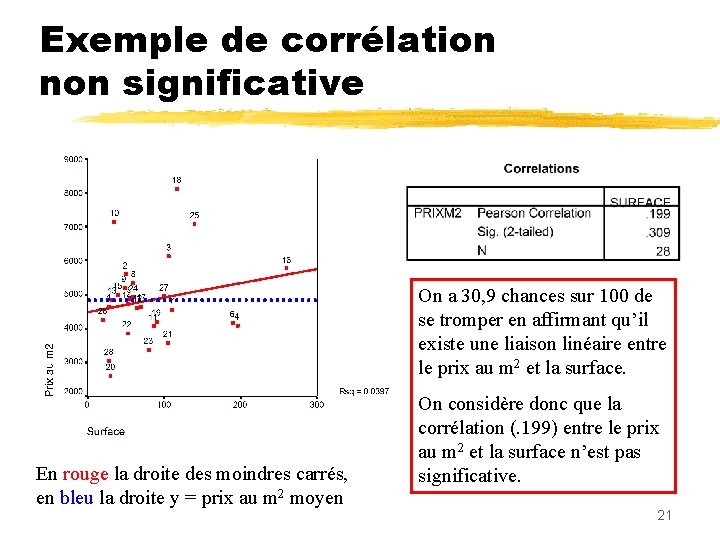

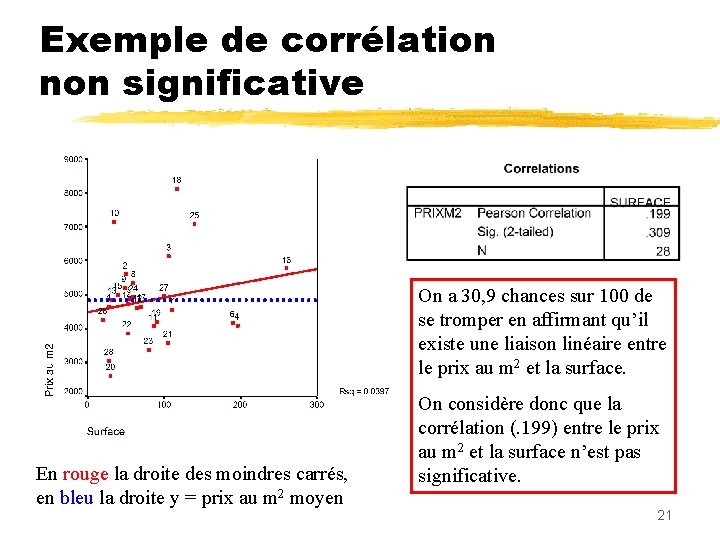

Exemple de corrélation non significative On a 30, 9 chances sur 100 de se tromper en affirmant qu’il existe une liaison linéaire entre le prix au m 2 et la surface. En rouge la droite des moindres carrés, en bleu la droite y = prix au m 2 moyen On considère donc que la corrélation (. 199) entre le prix au m 2 et la surface n’est pas significative. 21

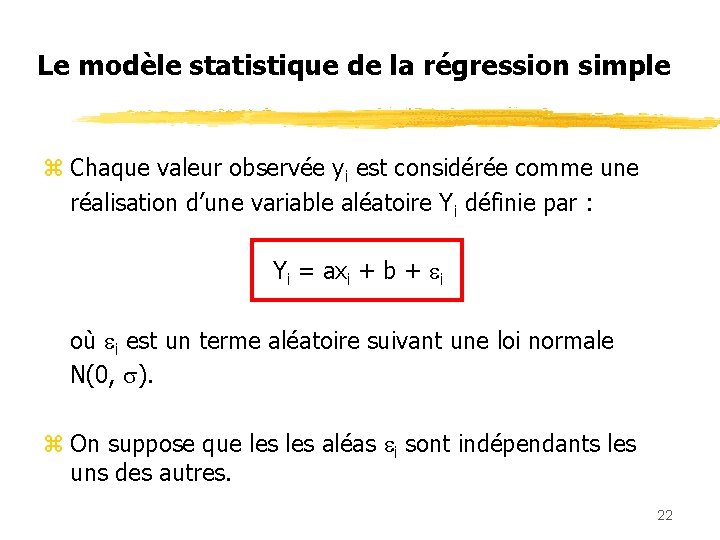

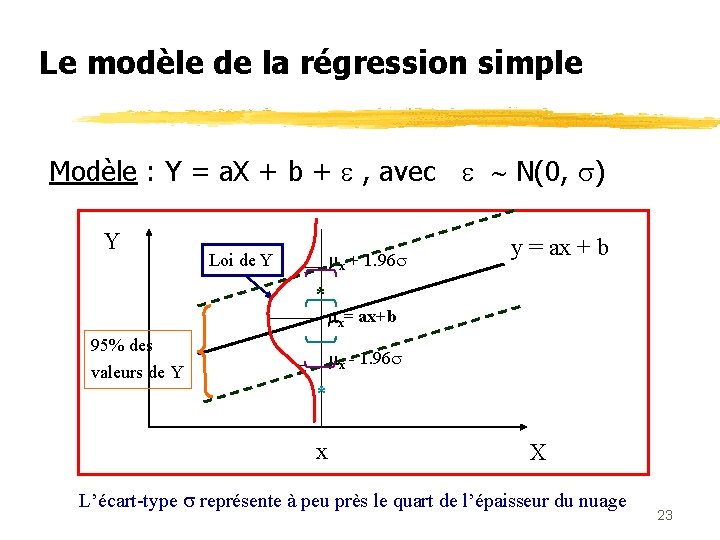

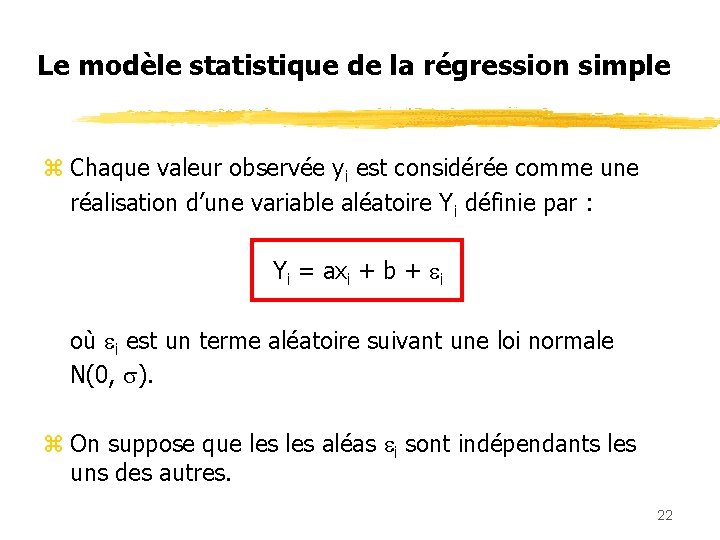

Le modèle statistique de la régression simple z Chaque valeur observée yi est considérée comme une réalisation d’une variable aléatoire Yi définie par : Yi = axi + b + i où i est un terme aléatoire suivant une loi normale N(0, ). z On suppose que les aléas i sont indépendants les uns des autres. 22

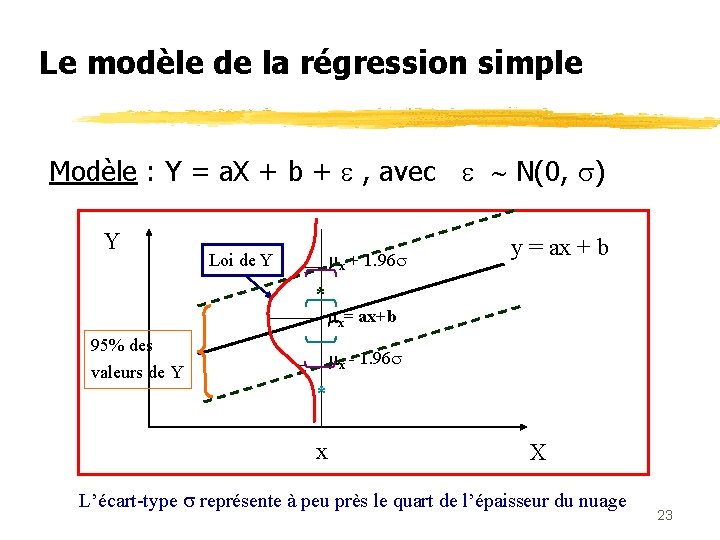

Le modèle de la régression simple Modèle : Y = a. X + b + , avec N(0, ) Y x + 1. 96 Loi de Y * x= ax+b 95% des valeurs de Y y = ax + b x - 1. 96 * x X L’écart-type représente à peu près le quart de l’épaisseur du nuage 23

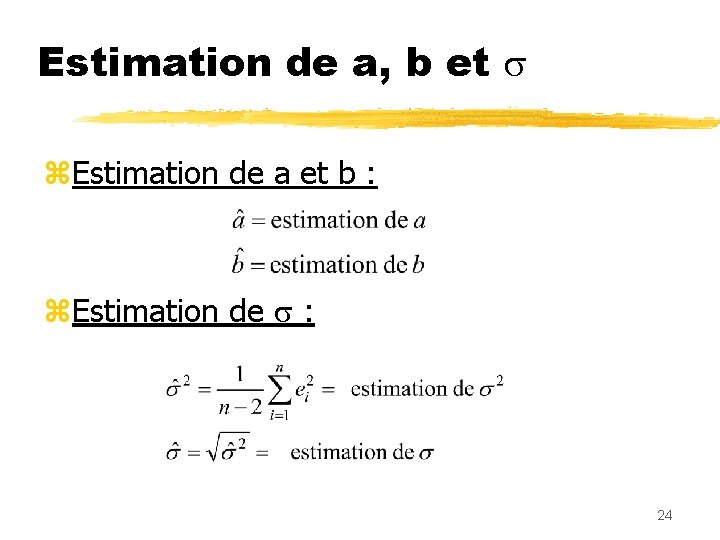

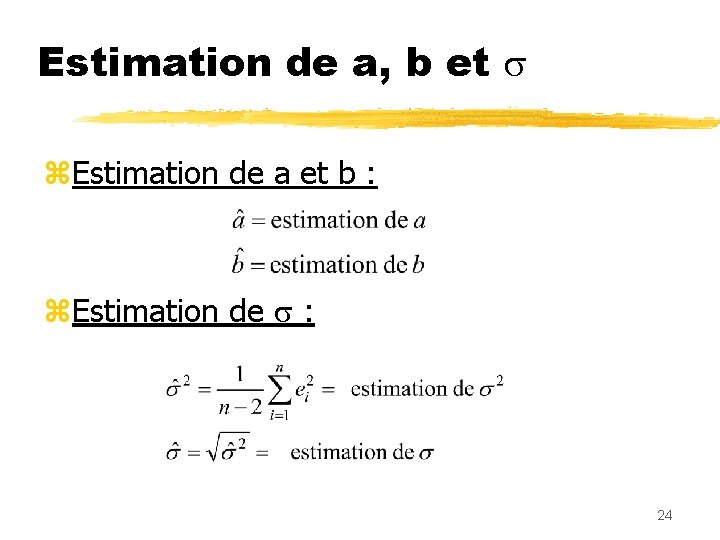

Estimation de a, b et z. Estimation de a et b : z. Estimation de : 24

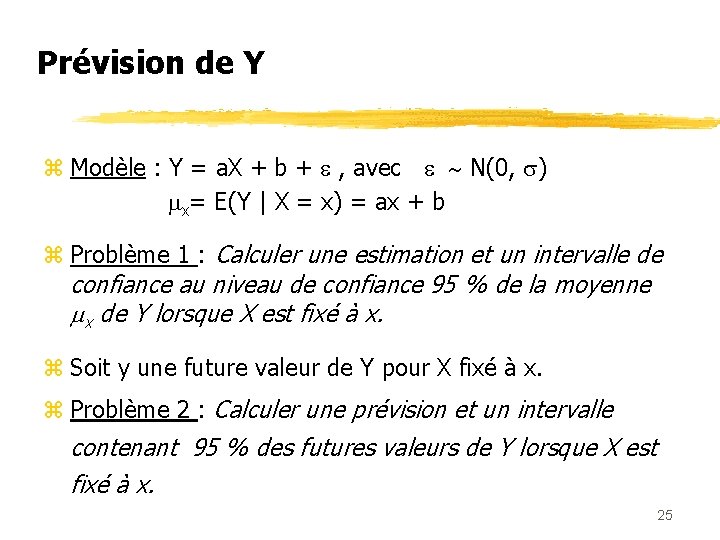

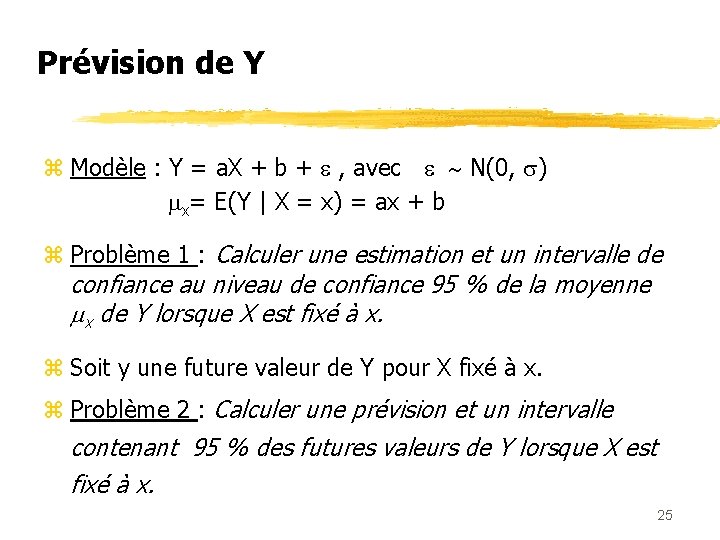

Prévision de Y z Modèle : Y = a. X + b + , avec N(0, ) x= E(Y | X = x) = ax + b z Problème 1 : Calculer une estimation et un intervalle de confiance au niveau de confiance 95 % de la moyenne x de Y lorsque X est fixé à x. z Soit y une future valeur de Y pour X fixé à x. z Problème 2 : Calculer une prévision et un intervalle contenant 95 % des futures valeurs de Y lorsque X est fixé à x. 25

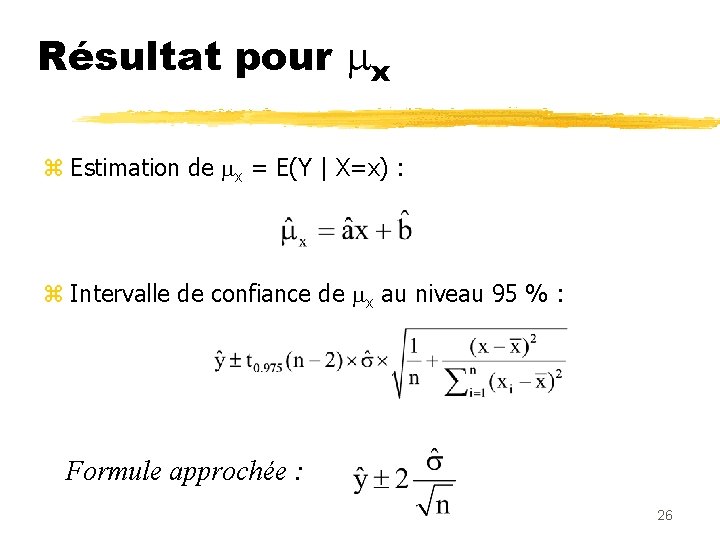

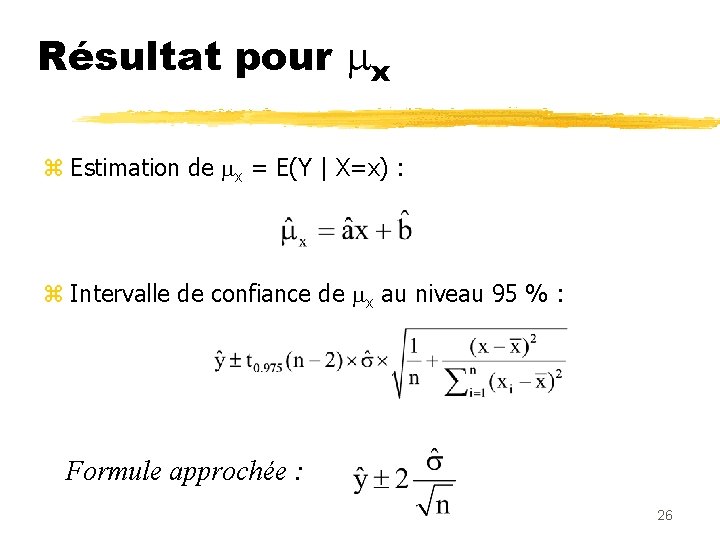

Résultat pour x z Estimation de x = E(Y | X=x) : z Intervalle de confiance de x au niveau 95 % : Formule approchée : 26

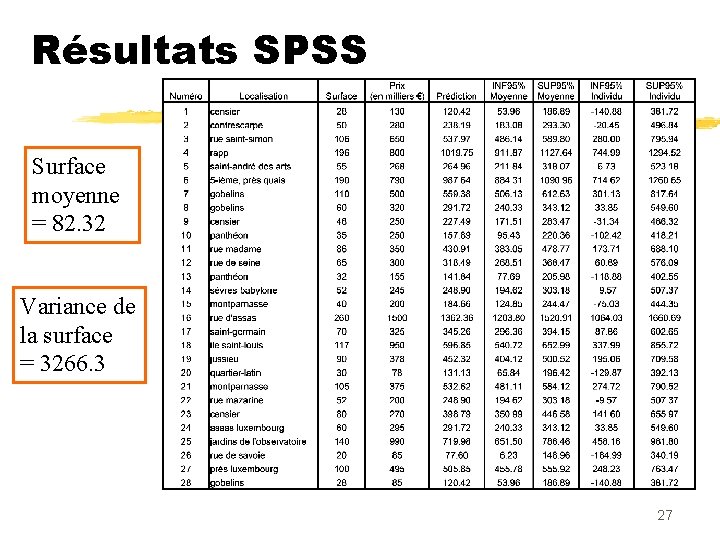

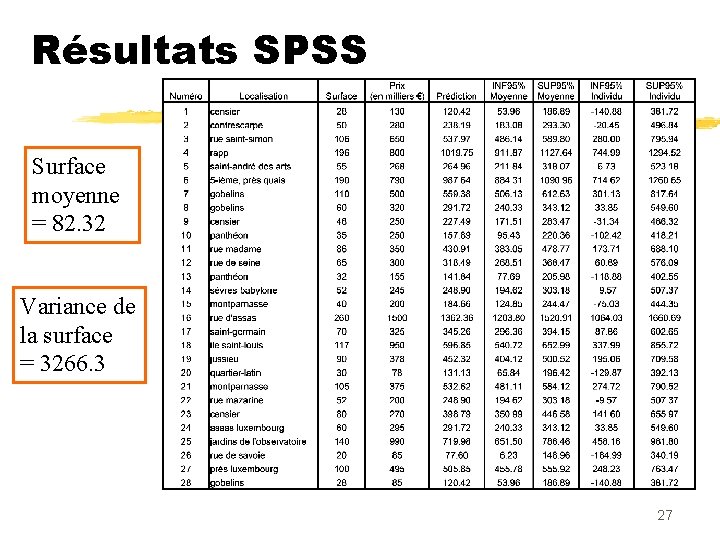

Résultats SPSS Surface moyenne = 82. 32 Variance de la surface = 3266. 3 27

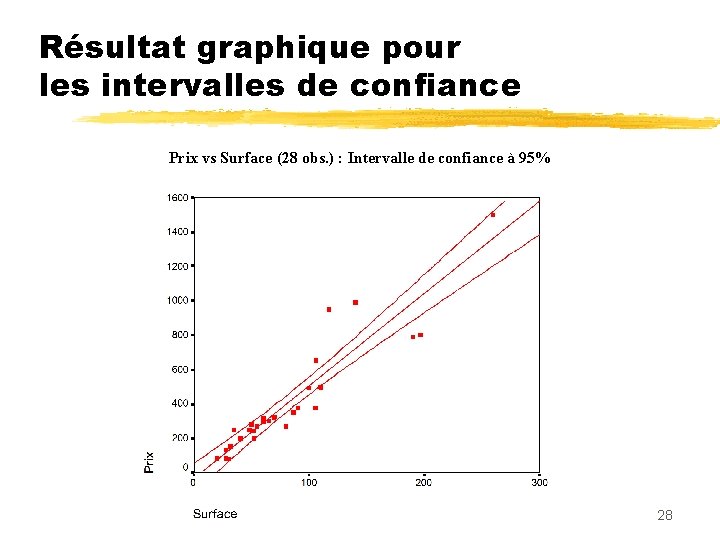

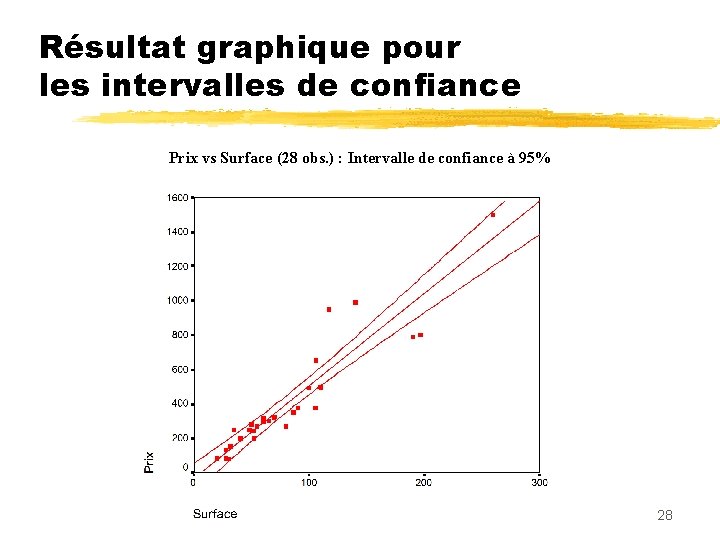

Résultat graphique pour les intervalles de confiance Prix vs Surface (28 obs. ) : Intervalle de confiance à 95% 28

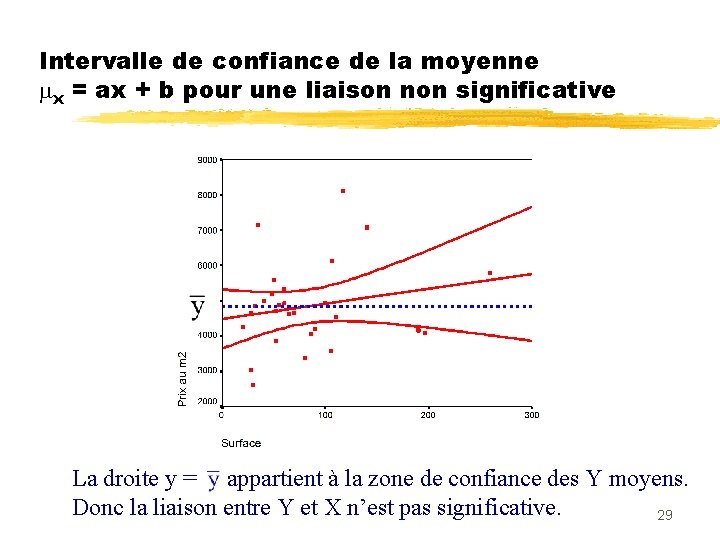

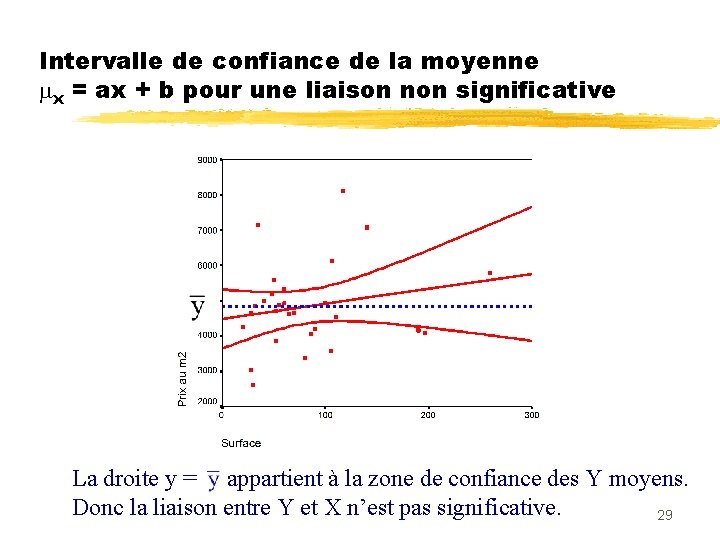

Intervalle de confiance de la moyenne x = ax + b pour une liaison non significative La droite y = appartient à la zone de confiance des Y moyens. Donc la liaison entre Y et X n’est pas significative. 29

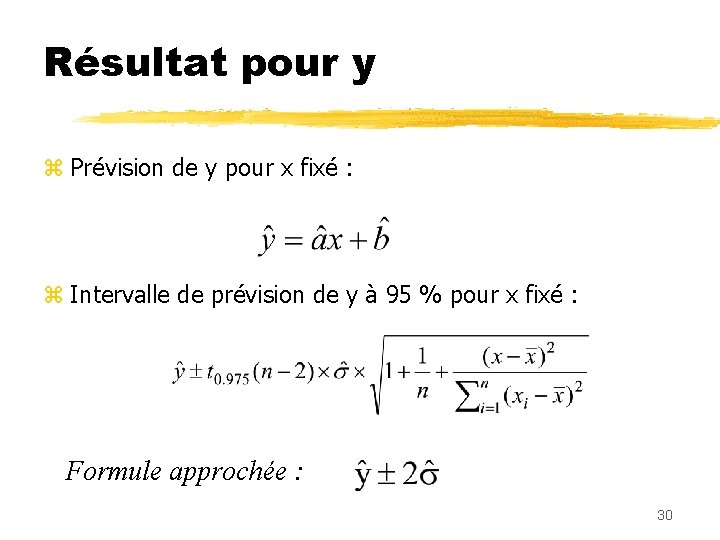

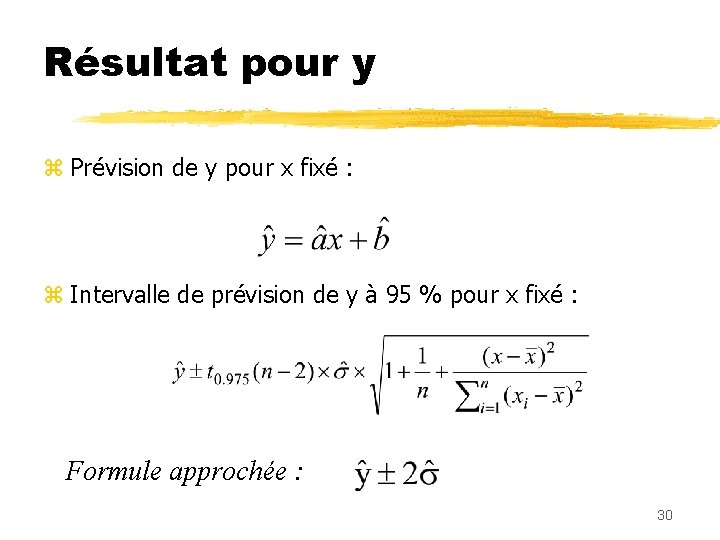

Résultat pour y z Prévision de y pour x fixé : z Intervalle de prévision de y à 95 % pour x fixé : Formule approchée : 30

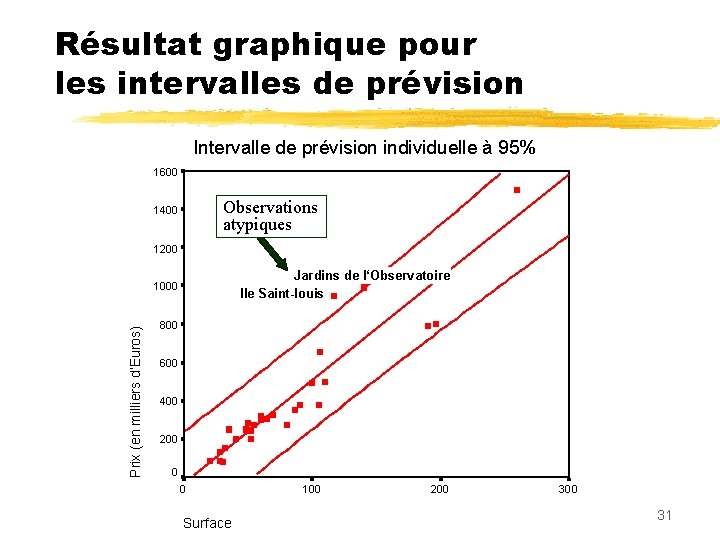

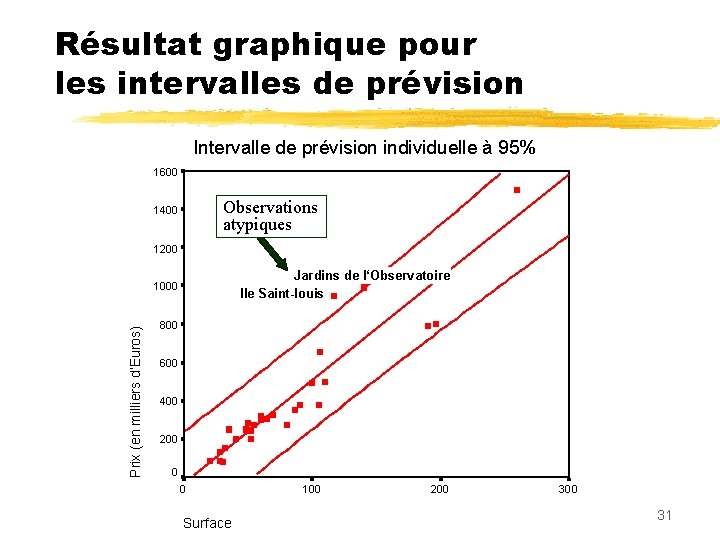

Résultat graphique pour les intervalles de prévision Intervalle de prévision individuelle à 95% 1600 Observations atypiques 1400 1200 Jardins de l‘Observatoire Ile Saint-louis Prix (en milliers d‘Euros) 1000 800 600 400 200 0 0 Surface 100 200 31

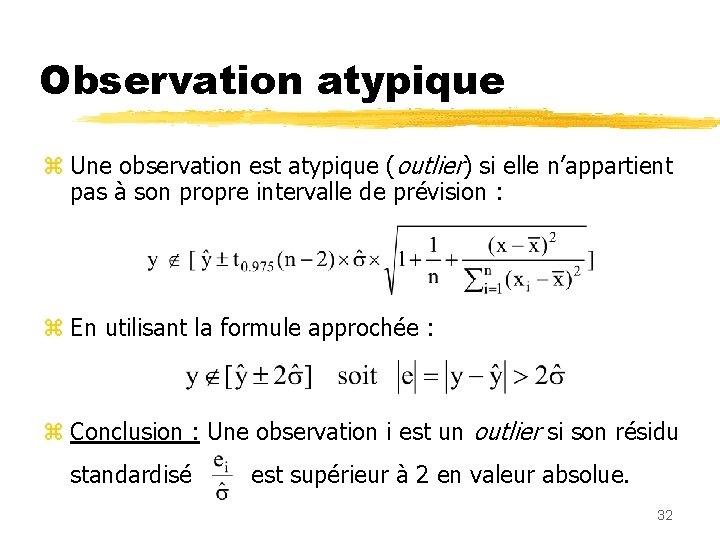

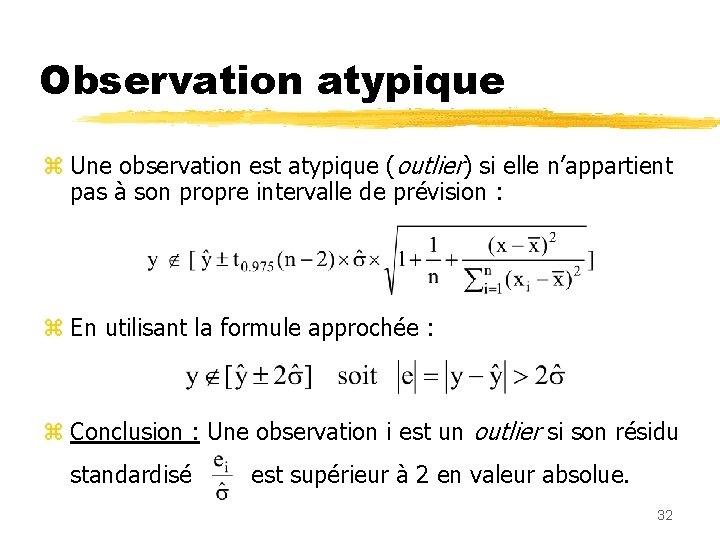

Observation atypique z Une observation est atypique (outlier) si elle n’appartient pas à son propre intervalle de prévision : z En utilisant la formule approchée : z Conclusion : Une observation i est un outlier si son résidu standardisé est supérieur à 2 en valeur absolue. 32

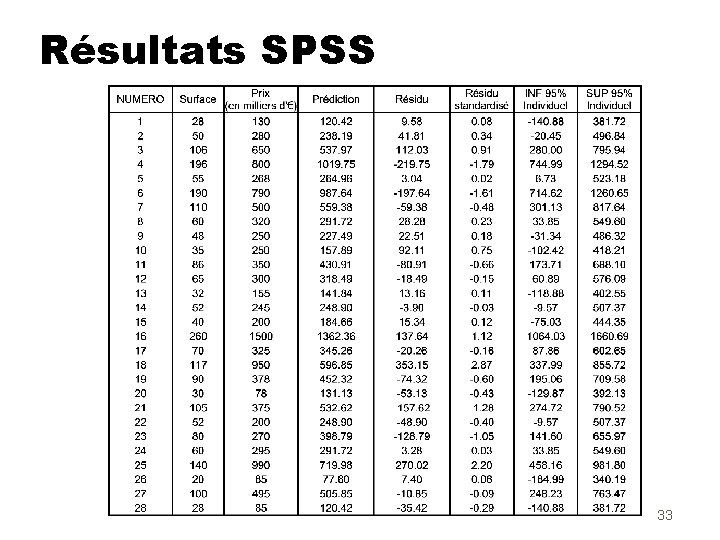

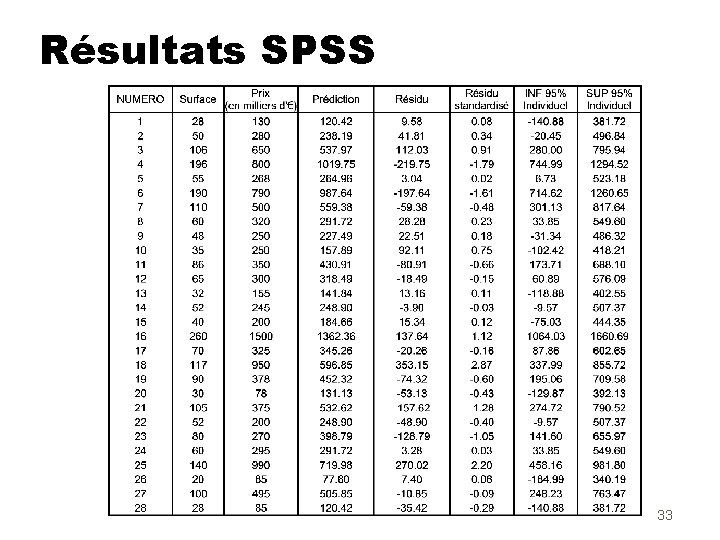

Résultats SPSS 33

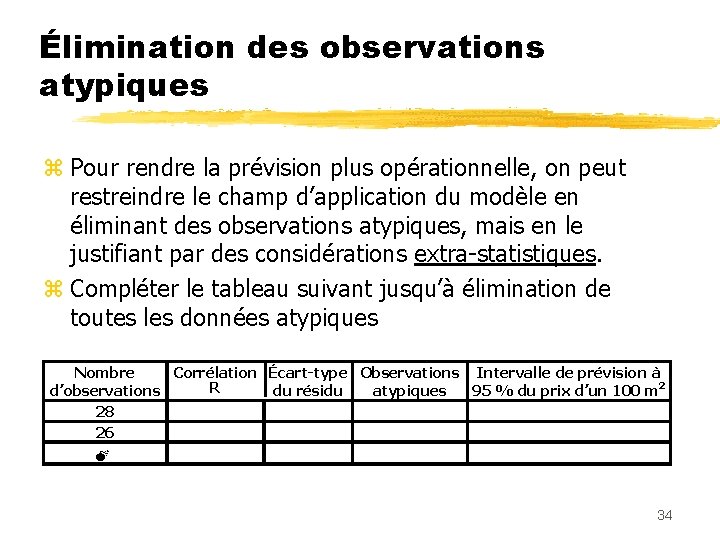

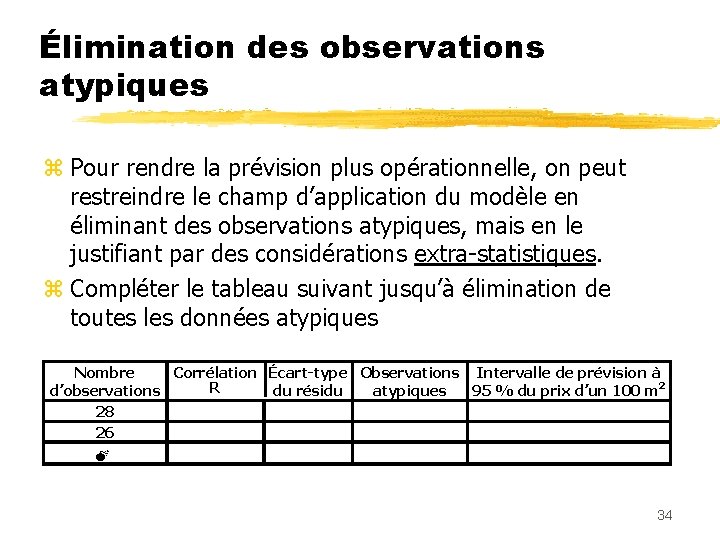

Élimination des observations atypiques z Pour rendre la prévision plus opérationnelle, on peut restreindre le champ d’application du modèle en éliminant des observations atypiques, mais en le justifiant par des considérations extra-statistiques. z Compléter le tableau suivant jusqu’à élimination de toutes les données atypiques Nombre Corrélation Écart-type Observations Intervalle de prévision à R d’observations du résidu atypiques 95 % du prix d’un 100 m 2 28 26 M 34

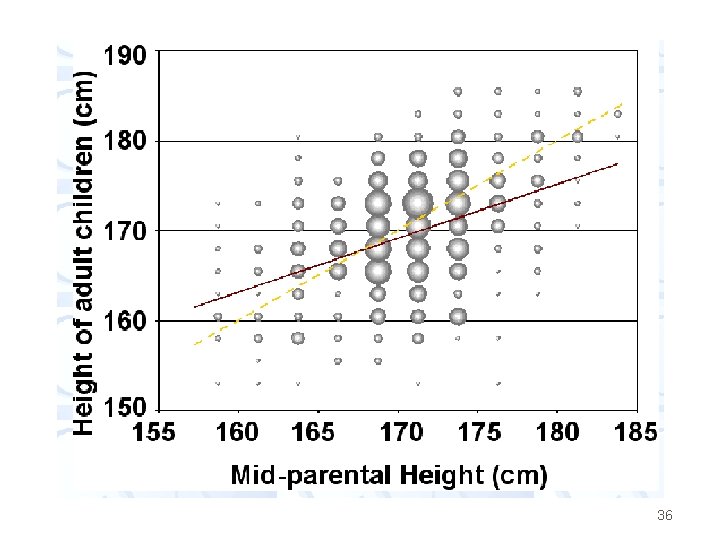

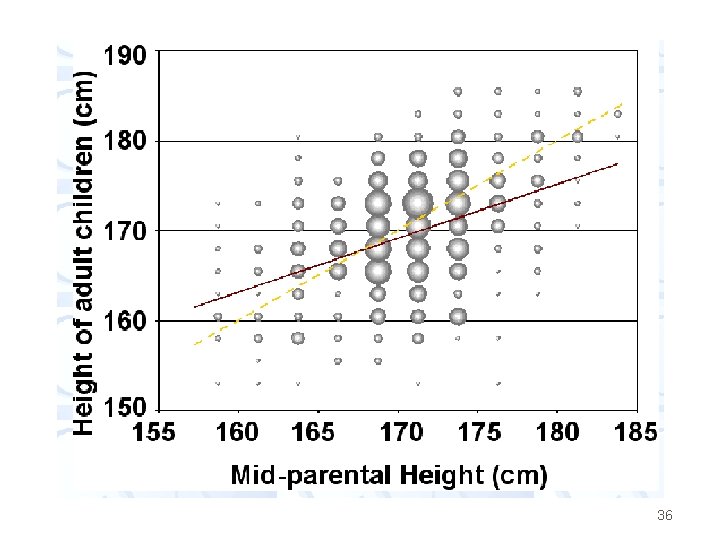

REGRESSION TO THE MEAN Regression to the mean was first identified by Sir Francis Galton: half-cousin of Charles Darwin, geographer, meteorologist, tropical explorer, founder of differential psychology, inventor of fingerprint identification, pioneer of statistical correlation and regression, convinced hereditarian, eugenicist, proto-geneticist, and best-selling author (1822 -1911). He correlated the heights of 930 adult children and their respective 250 parents, "correcting" for sex by increasing female heights by a factor of 1. 08. 35

36

He accounted for genetic contribution of both parents by taking their mean (corrected) heights. He plotted the data (see below) and performed a least squares straight line fit (red line), but found that its slope was less than that expected if the height of children was on average the same as that of their parents (yellow line). He observed: "It appeared from these experiments that the offspring did not tend to resemble their parents in size, but always to be more mediocre than they - to be smaller than the parents, if the parents were large; - to be larger than the parents, if the parents were small. " 37

Moindres carrés

Moindres carrés Past future simple

Past future simple Present simple future simple past simple

Present simple future simple past simple Present simple present continuous past simple future simple

Present simple present continuous past simple future simple Present simple, past simple, future simple

Present simple, past simple, future simple Simple present simple past and simple future

Simple present simple past and simple future Present simple past simple future simple exercises

Present simple past simple future simple exercises Present past future simple

Present past future simple Simple present negativo

Simple present negativo Future simple present simple

Future simple present simple Biografia michel de montaigne

Biografia michel de montaigne Alexander aplazisi

Alexander aplazisi Foucault poststructuralism

Foucault poststructuralism Programmation lineaire

Programmation lineaire Michel lodolo

Michel lodolo Michel grangeat

Michel grangeat Lisanne veraart

Lisanne veraart Communication michel et augustin

Communication michel et augustin Michel de montagne

Michel de montagne Michel beaugrand

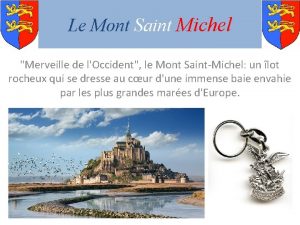

Michel beaugrand Mont saint michel merveille du monde

Mont saint michel merveille du monde Olivia hauser

Olivia hauser Michel grenier uqam

Michel grenier uqam Michel bor

Michel bor Büllöz mirinjit etkeni

Büllöz mirinjit etkeni Michel siffre cave study psychology

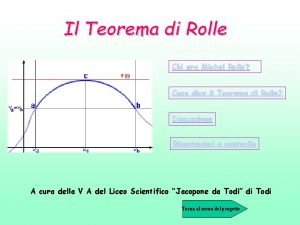

Michel siffre cave study psychology Teorema di rolle

Teorema di rolle Michel daney

Michel daney Gamemaker michel fiege

Gamemaker michel fiege Discontinuidad

Discontinuidad Alfred le petit

Alfred le petit Michel mazzalongo

Michel mazzalongo Nervenarzt bielefeld

Nervenarzt bielefeld Jean-michel hupé

Jean-michel hupé Michel gagner

Michel gagner Roland michel tremblay

Roland michel tremblay Daprs bean

Daprs bean Bac g sardou

Bac g sardou