Stage URFIST de Paris 1 2 avril 2019

- Slides: 43

Stage URFIST de Paris 1 & 2 avril 2019 Médiatiser la bibliométrie auprès des chercheurs : Au-delà de l’évaluation Solenn Bihan Université de Lille, Direction Valorisation de la recherche Plateforme Lillometrics Solenn Bihan, Lillometrics

Objectifs du stage • • S’approprier une démarche pour expliquer la bibliométrie et ses usages aux publics de son établissement 2 Page 2

Déroulement du stage 1. Définition, objectifs et usages : controverses autour de l’évaluation 2. Méthodes, compétences et outils: retour aux sources, vers une bibliométrie scientifique 3. Bibliométrie et science ouverte : amies ou ennemies ? 4. Synthèse et stratégie : concevoir une offre de services adaptée à son public 3 Page 3

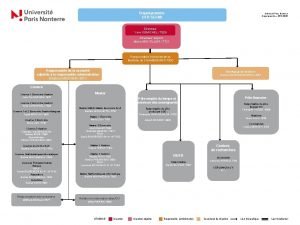

Se présenter V fiche stagiaire Présenter son établissement (taille, type de recherche, pratiques de publications), Présenter les outils et ressources Présenter la stratégie science ouverte Place et rôles des services d’appui à la recherche 4 Page 4

1. Définition, objectifs et usages Page 5

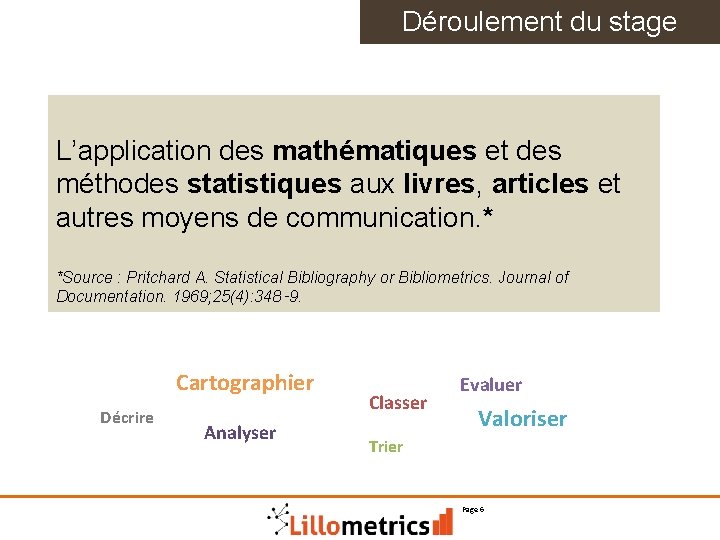

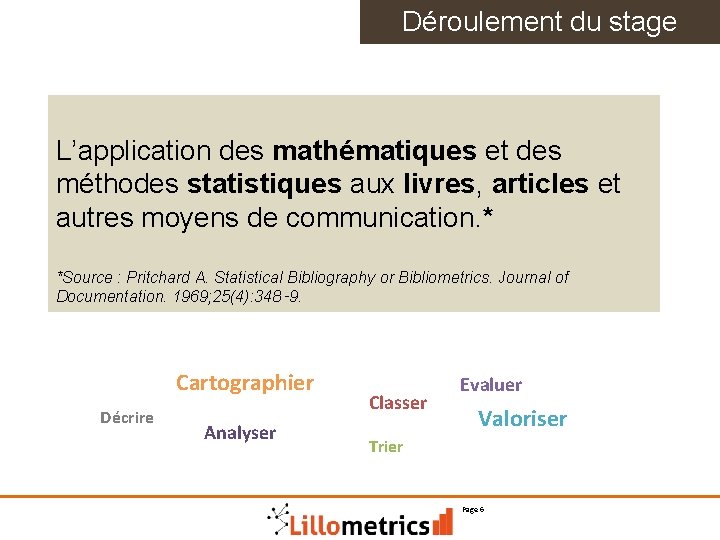

Déroulement du stage L’application des mathématiques et des méthodes statistiques aux livres, articles et autres moyens de communication. * *Source : Pritchard A. Statistical Bibliography or Bibliometrics. Journal of Documentation. 1969; 25(4): 348‑ 9. Cartographier Décrire Analyser Classer Evaluer Valoriser Trier 6 Page 6

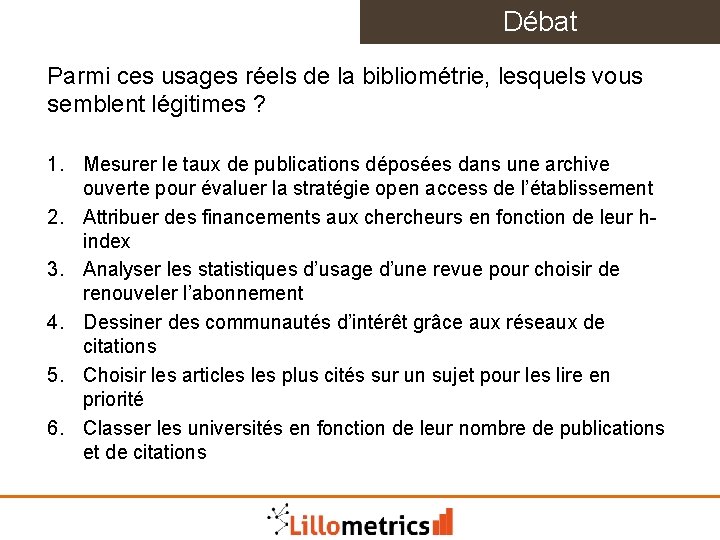

Débat Parmi ces usages réels de la bibliométrie, lesquels vous semblent légitimes ? 1. Mesurer le taux de publications déposées dans une archive ouverte pour évaluer la stratégie open access de l’établissement 2. Attribuer des financements aux chercheurs en fonction de leur hindex 3. Analyser les statistiques d’usage d’une revue pour choisir de renouveler l’abonnement 4. Dessiner des communautés d’intérêt grâce aux réseaux de citations 5. Choisir les articles plus cités sur un sujet pour les lire en priorité 6. Classer les universités en fonction de leur nombre de publications et de citations 7

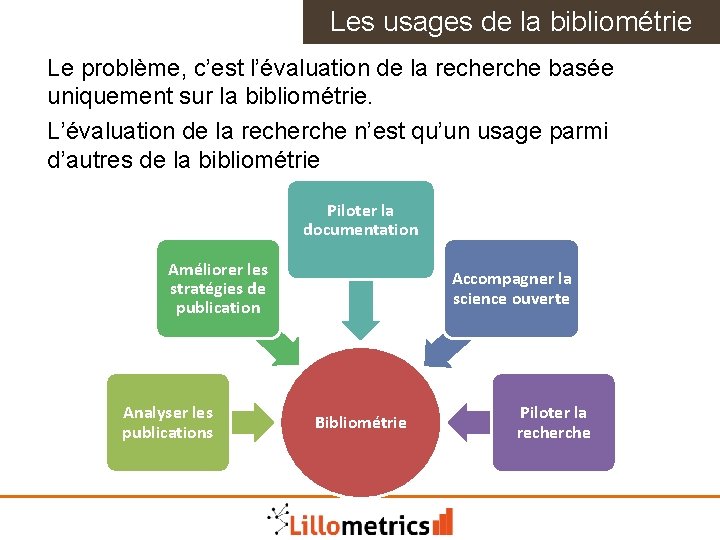

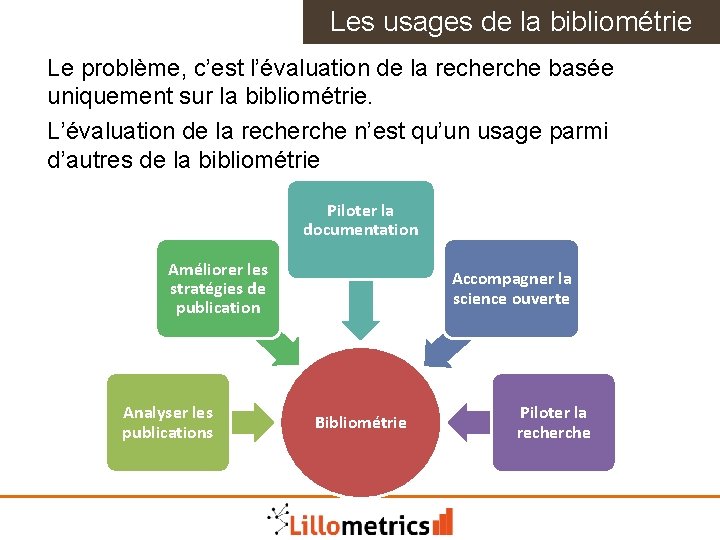

Les usages de la bibliométrie Le problème, c’est l’évaluation de la recherche basée uniquement sur la bibliométrie. L’évaluation de la recherche n’est qu’un usage parmi d’autres de la bibliométrie Piloter la documentation Améliorer les stratégies de publication Analyser les publications Accompagner la science ouverte Bibliométrie 8 Piloter la recherche

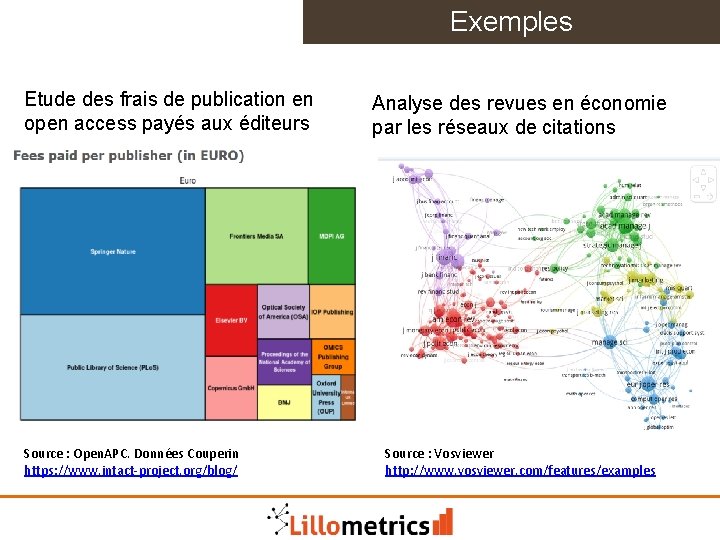

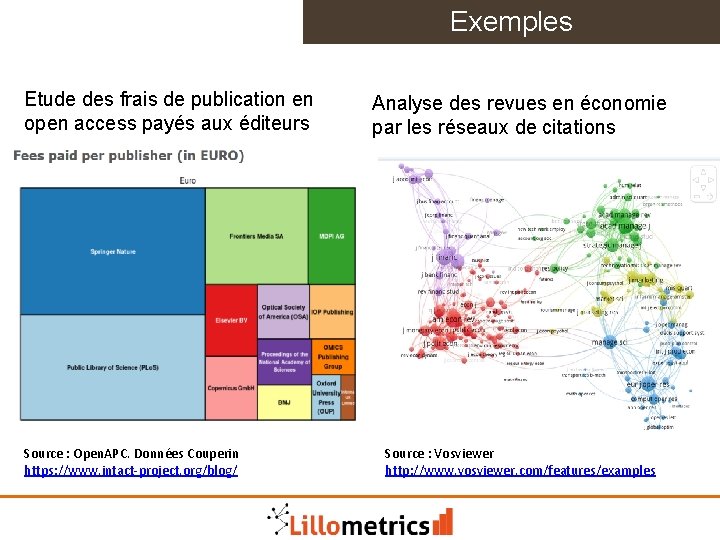

Exemples Etude des frais de publication en open access payés aux éditeurs Source : Open. APC. Données Couperin https: //www. intact-project. org/blog/ Analyse des revues en économie par les réseaux de citations Source : Vosviewer http: //www. vosviewer. com/features/examples 9

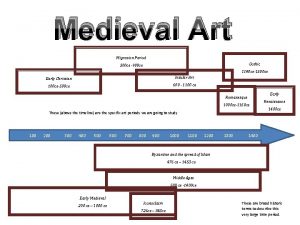

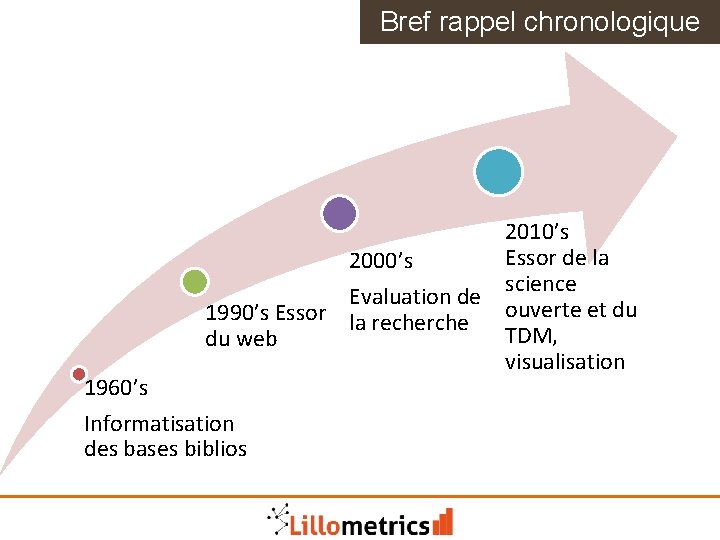

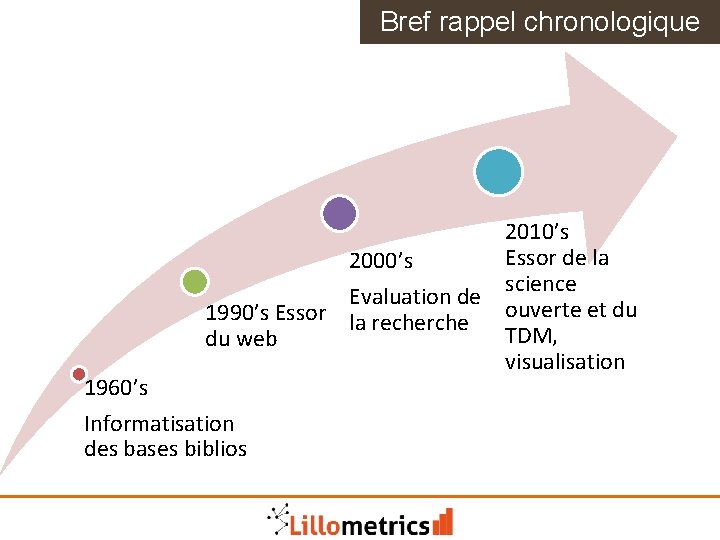

Bref rappel chronologique 2010’s Essor de la 2000’s science Evaluation de 1990’s Essor la recherche ouverte et du TDM, du web visualisation 1960’s Informatisation des bases biblios 10

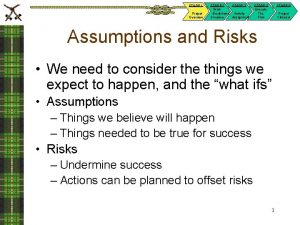

Réflexions sur l’évaluation 1. Comment améliorer l’évaluation de la recherche grâce à une « meilleure bibliométrie » ? (cf Leiden Manifesto) 2. Comment améliorer l’évaluation de la recherche en supprimant/sans utiliser la bibliométrie ? 3. Comment faire autre chose avec la bibliométrie qu’évaluer la recherche ? 11

A propos de l’évaluation Ne pas sous-estimer la fascination pour l’évaluation 12

Comment résister à l’évaluation ? Questionner l’évaluation : • Pourquoi évaluer ? • Qui évalue ? • Quels sont les effets pervers ? • Combien coûte l’évaluation ? Changer de système de valeurs, restaurer la confiance dans la recherche : • Ethique scientifique, transparence • Stabilité, travail au long cours • Partage et collaboration • Ouverture, débat démocratique sur la science 13

2. Méthodes, outils et compétences Page 14

La bibliométrie scientifique Yves Gingras définit la bibliométrie scientifique : • Outil indispensable d’analyse des sciences et de leurs évolutions • Qui suppose une démarche rigoureuse et validée • Et une connaissance fine des modes de production 15 Photo : Émilie Tournevache

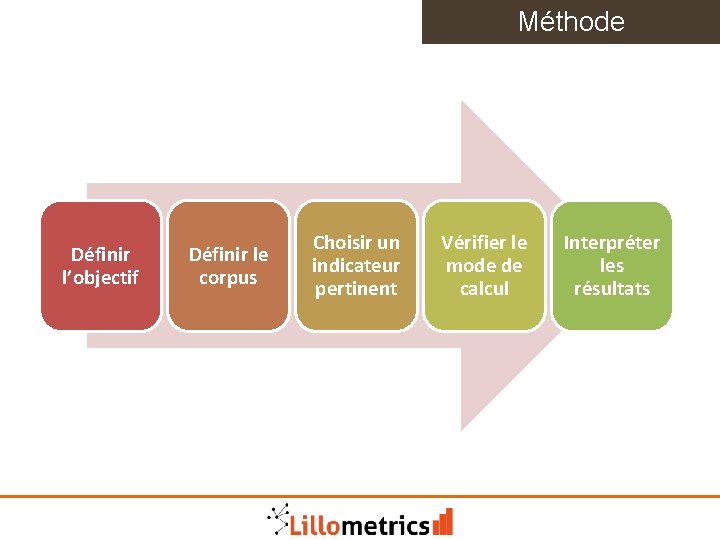

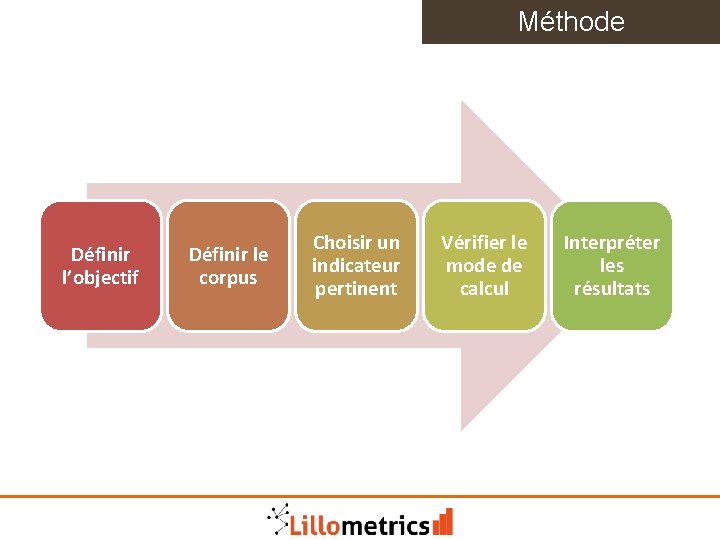

Méthode Définir l’objectif Définir le corpus Choisir un indicateur pertinent 16 Vérifier le mode de calcul Interpréter les résultats

Conditions à réunir 1. 2. 3. 4. Des données accessibles et de qualité Des indicateurs fiables Des outils pour collecter et traiter les données Des compétences-clés 17

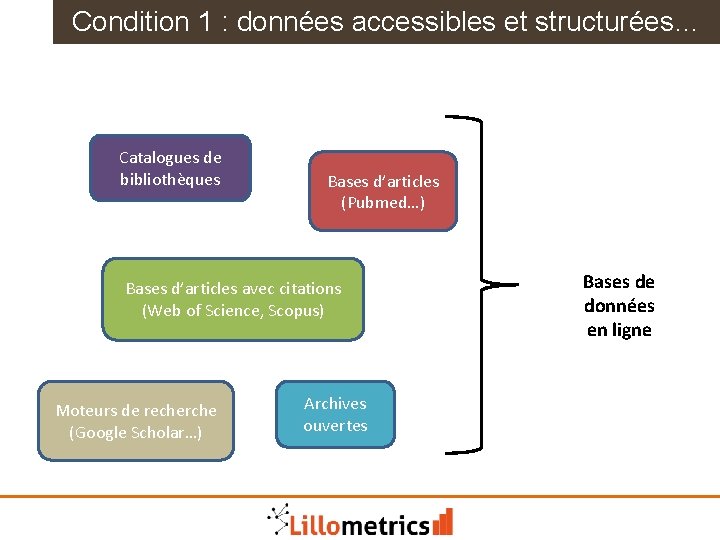

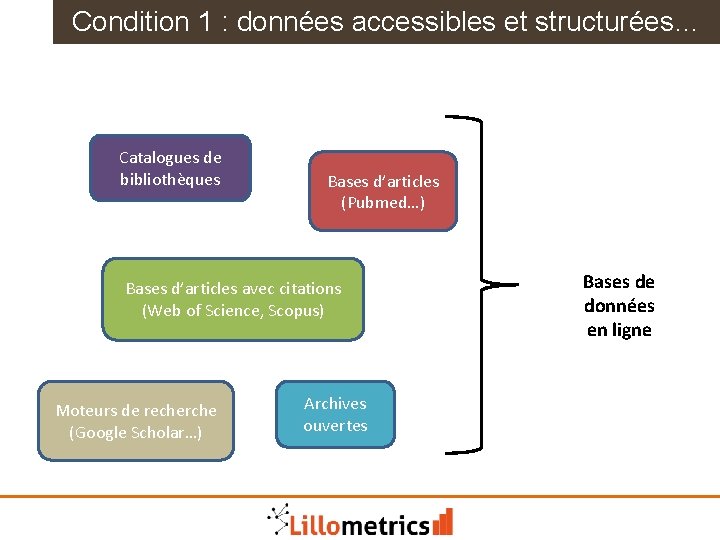

Condition 1 : données accessibles et structurées… Catalogues de bibliothèques Bases d’articles (Pubmed…) Bases de données en ligne Bases d’articles avec citations (Web of Science, Scopus) Moteurs de recherche (Google Scholar…) Archives ouvertes 18

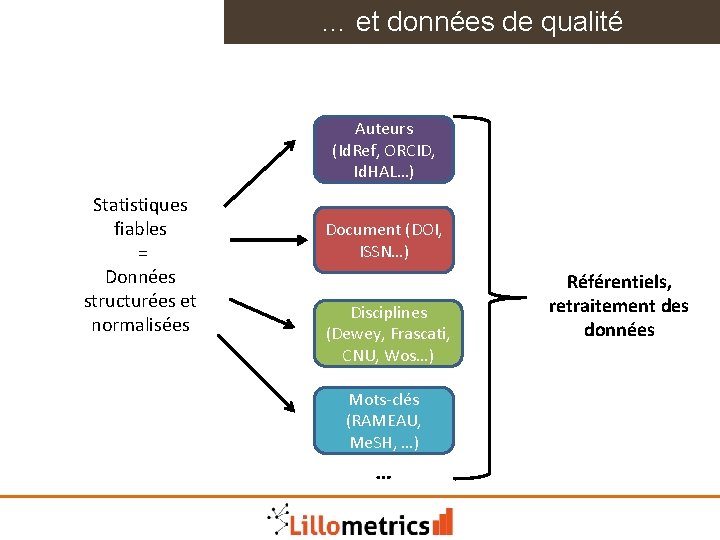

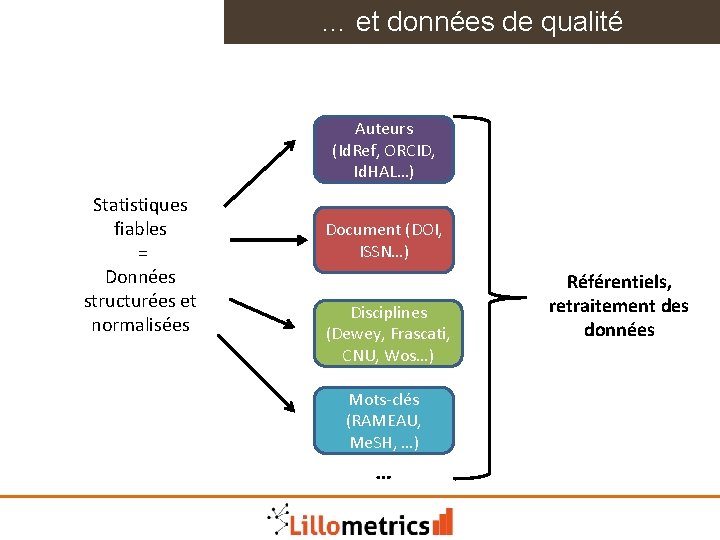

… et données de qualité Auteurs (Id. Ref, ORCID, Id. HAL…) Statistiques fiables = Données structurées et normalisées Document (DOI, ISSN…) Disciplines (Dewey, Frascati, CNU, Wos…) Mots-clés (RAMEAU, Me. SH, …) … 19 Référentiels, retraitement des données

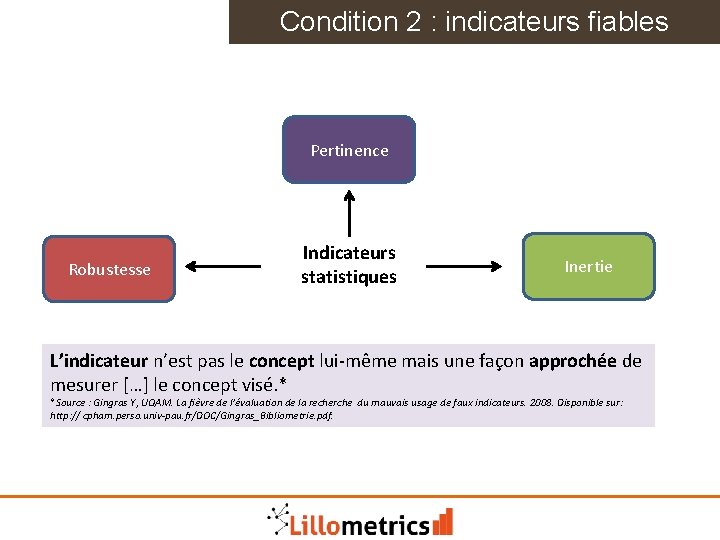

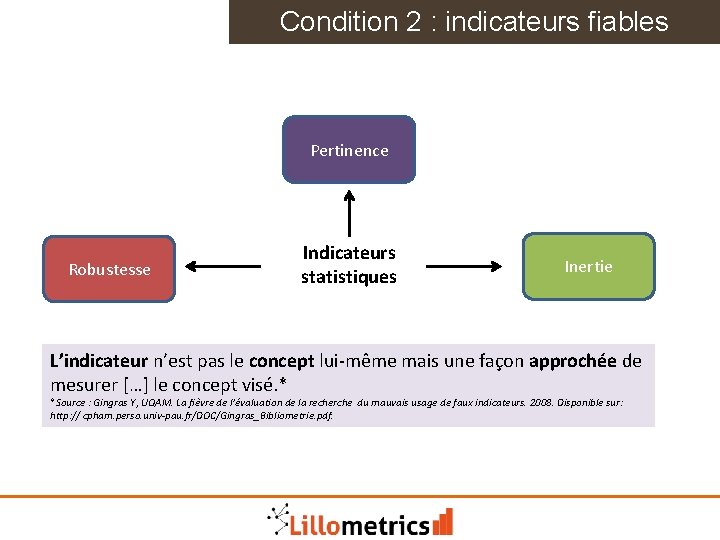

Condition 2 : indicateurs fiables Pertinence Robustesse Indicateurs statistiques Inertie L’indicateur n’est pas le concept lui-même mais une façon approchée de mesurer […] le concept visé. * *Source : Gingras Y, UQAM. La fièvre de l’évaluation de la recherche du mauvais usage de faux indicateurs. 2008. Disponible sur: http: // cpham. perso. univ-pau. fr/DOC/Gingras_Bibliometrie. pdf. 20

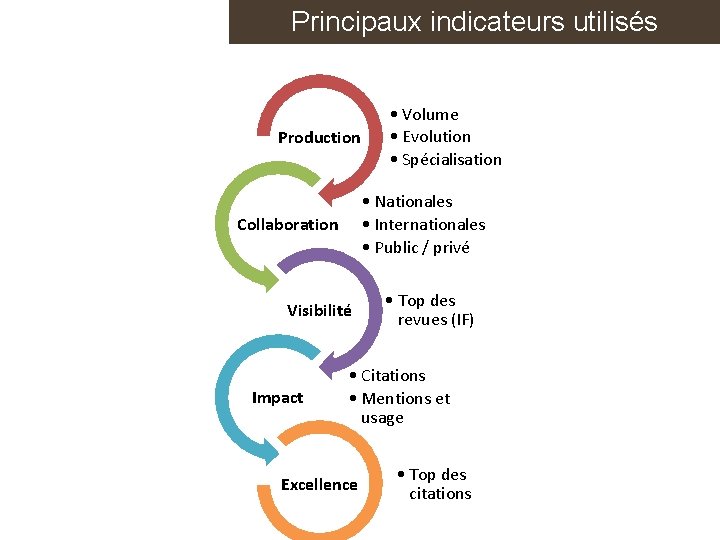

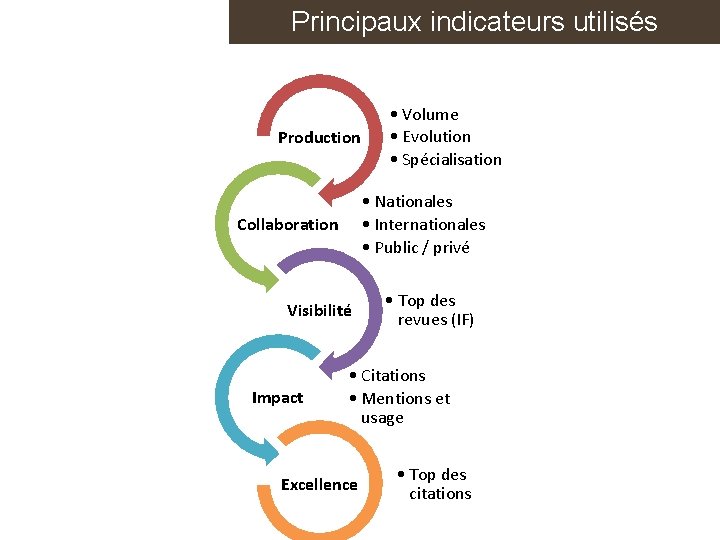

Principaux indicateurs utilisés Production • Nationales • Internationales • Public / privé Collaboration Visibilité Impact • Volume • Evolution • Spécialisation • Top des revues (IF) • Citations • Mentions et usage • Top des citations Excellence 21 Solenn Bihan

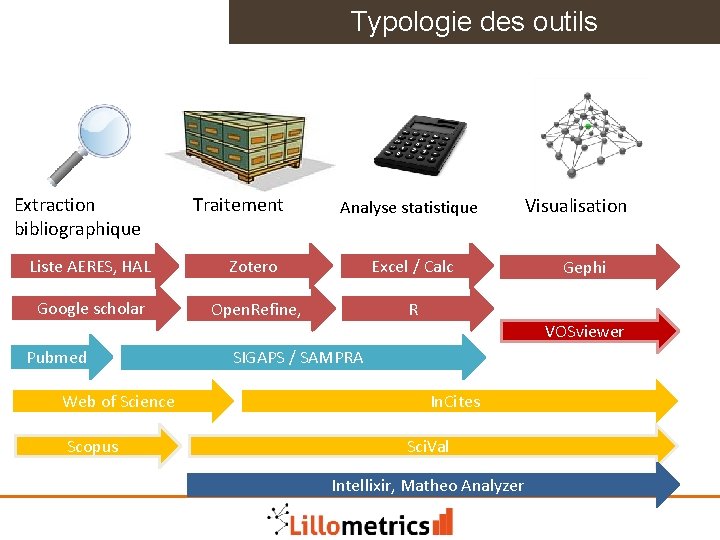

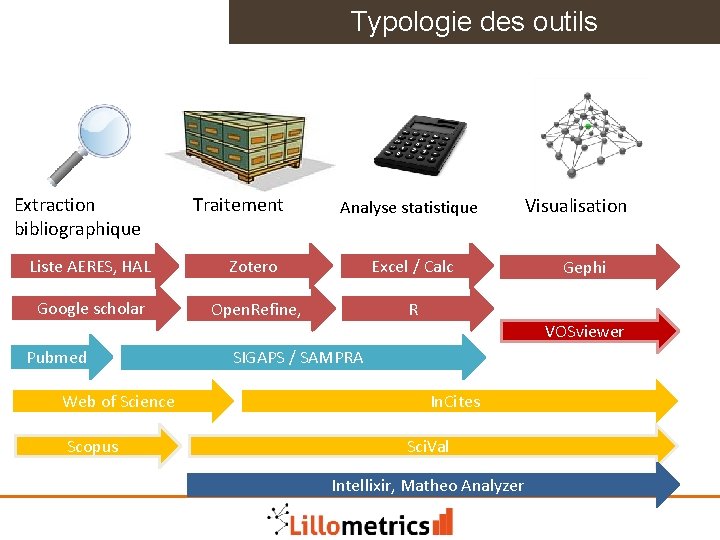

Typologie des outils Extraction bibliographique Traitement Analyse statistique Liste AERES, HAL Zotero Excel / Calc Google scholar Open. Refine, R Visualisation Gephi VOSviewer Pubmed SIGAPS / SAMPRA Web of Science In. Cites Scopus Sci. Val Intellixir, Matheo Analyzer 22

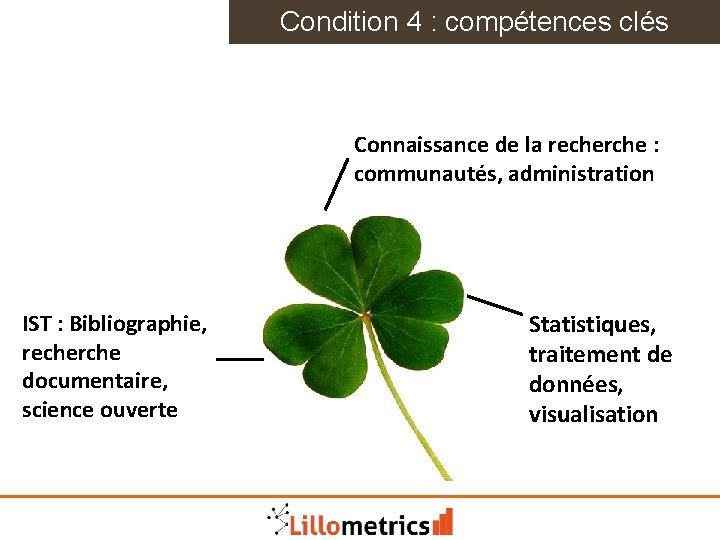

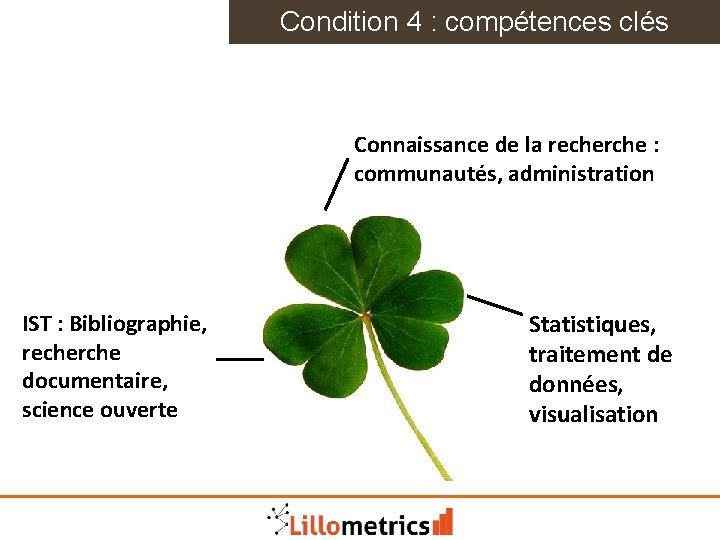

Condition 4 : compétences clés Connaissance de la recherche : communautés, administration Statistiques, traitement de données, visualisation IST : Bibliographie, recherche documentaire, science ouverte 23

Exercice sur les indicateurs Etudions un labo de recherche médicale INSERM, dont les publications sont bien référencées dans les bases de données. Voici une liste d’indicateurs utilisés par les principaux organismes bibliométriques (OST, INSERM, SIGAPS, classements internationaux…) Parmi cette liste (voir doc), quel(s) indicateur(s) choisissez-vous pour mesurer l’intensité de sa recherche et son évolution dans le temps (2008 -2018) ? Justifiez votre choix. - Indicateurs de production - Indicateurs d’impact moyen - Indicateurs d’impact exceptionnel ou excellence 24

Etudes de cas Comment répondez-vous à ces demandes ? 1. De quand date la question de l’archivage des logiciels informatiques (software heritage) dans la recherche en informatique ? Quel est la place de l’INRIA et de la France dans cet essor ? 2. Les études de genre : objet de recherche pluridisciplinaire (psychologie, anthropologie, biologie, langage…) ou nouvelle discipline (méthodologie propre) ? 25

Comment améliorer les données Multiplier et diversifier les sources bibliographiques pour une meilleure couverture disciplinaire : Inclure davantage de revues : DOAJ Inclure les ouvrages : DOAB, Worldcat Inclure les archives ouvertes : HAL, Arxiv Rendre les bases de citation ouvertes : Open. Citations Mais difficulté pour harmoniser et dédoublonner les informations issues de sources différentes 26

Améliorer les données Désambiguisation et unification : • Types de Documents : problèmes de définition et différence entre les bases de données • Auteurs : homonymes et variantes • Organismes : variantes • Noms géographiques : lacunes • Termes : langage naturel, à la fois imprécis et redondant, polysémie • Références citées : nombreuses erreurs et inadéquations 27

Données de qualité = Référentiels Un référentiel, c'est un ensemble de bases de données contenant les « références » d'un système d'information. Un référentiel clair, logique et précis est un des gages de bonne interopérabilité d'un système d'information. * *Source : Wikipedia. Un référentiel est partagé entre plusieurs applications. C’est le garant de la qualité des données. Un référentiel inclut des références (=un fichier d’autorités) qui sont administrées (=suivi, dédoublonnage…) + des services (=applications pour produire/réutiliser) Ex : Id. Ref est le Référentiel des autorités Sudoc, Calames, Theses. fr, ISTEX, Persée… 28

Le Text and Data mining (TDM) Au-delà des statistiques classiques, l’analyse de données s’enrichit de nouvelles méthodes qui viennent du TDM : cartographie, d’analyse de réseaux, de regroupements de mots-clés. Utile pour caractériser sans hiérarchiser - Analyser des collaborations effectives, voire de pointer des collaborations potentielles - Analyser des réseaux de citations et d’influence - Analyser des évolutions et la proximité de thématiques - Utile au niveau des chercheurs, des articles, revues, mots-clés, établissements… 29

3. Bibliométrie et science ouverte Page 30

Rappel science ouverte Se mettre d’accord sur une définition : pas seulement gratuité, mais transparence, réutilisation, modèle éco équitable… « La science ouverte est la diffusion sans entrave des publications et des données de la recherche. Elle s’appuie sur l’opportunité que représente la mutation numérique pour développer l’accès ouvert aux publications et -autant que possible- aux données de la recherche. » « Le mouvement de la Science ouverte vise à construire un écosystème dans lequel la science sera plus cumulative, plus fortement étayée par des données, plus transparente, plus rapide et d’accès universel. » (Source : https: //www. ouvrirlascience. fr/category/science_ouverte/) 31

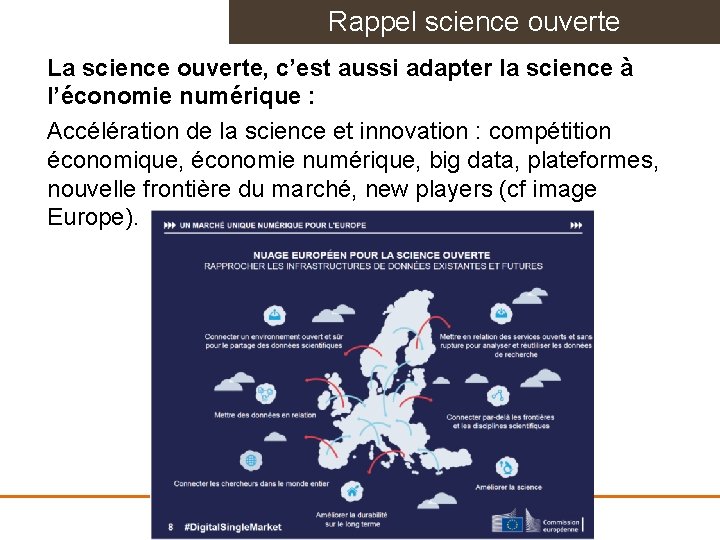

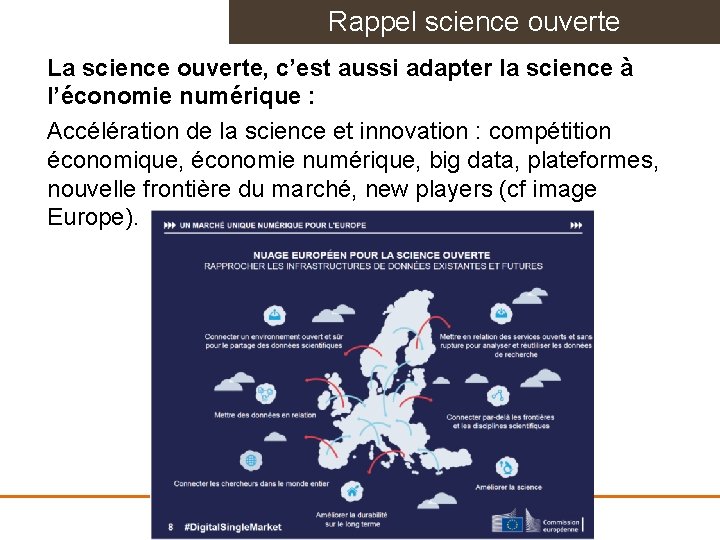

Rappel science ouverte La science ouverte, c’est aussi adapter la science à l’économie numérique : Accélération de la science et innovation : compétition économique, économie numérique, big data, plateformes, nouvelle frontière du marché, new players (cf image Europe). 32

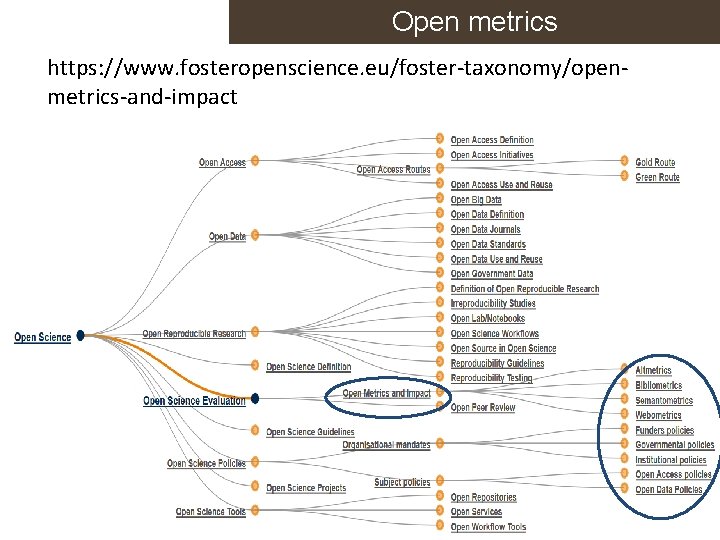

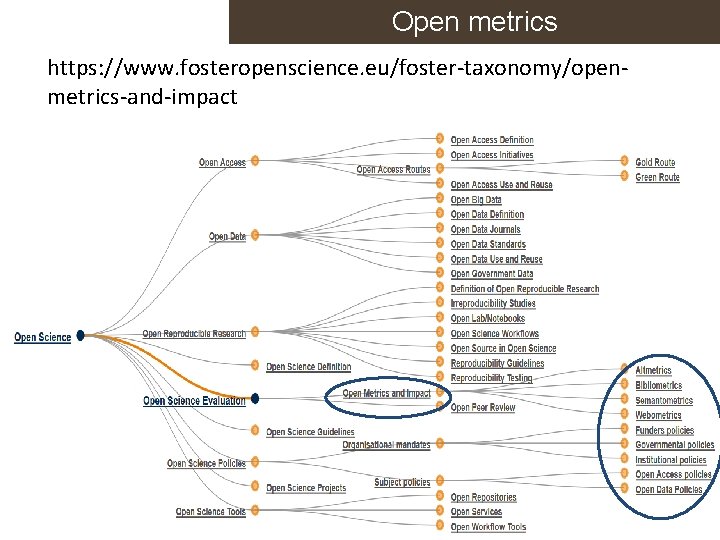

Open metrics https: //www. fosteropenscience. eu/foster-taxonomy/openmetrics-and-impact 33 Solenn Bihan

Débat 2 sous-groupes - Le premier présente tous les arguments qui montrent que la science ouverte et la bibliométrie vont de pair - Le deuxième présente tous les arguments qui montrent que les deux sont incompatibles A quelles conditions c’est un risque ou une opportunité ? Mobiliser ce qu’on a vu hier : source, qualité des données, indicateurs, outils, usages… 34

Exercice sur Web of science Calculer la proportion de publications en open access de l’université de Lorraine depuis 5 ans. Comment interprétez-vous ce résultat ? 35

Exercice sur HAL Comparer le résultat issu du Web of Science avec le nombre de documents déposés dans HAL. Comment interprétez-vous ce résultat ? Quelles sont les statistiques d’usage disponibles à partir d’un portail HAL ? Comment peut-on les exploiter ? https: //www. ccsd. cnrs. fr/2019/02/refonte-du-modulestatistiques-ou-en-est-on/ 36

La science ouverte a besoin de bibliométrie Besoin d’indicateurs pour monitorer la progression de la science ouverte, l’impact des politiques publiques… (cf Larivière) Besoin de nouveaux indicateurs pour inciter à la science ouverte, pour justifier les financements accordés à l’open science (Coalition S, H 2020). Open metrics 37 Solenn Bihan

4. Synthèse et stratégie Page 38

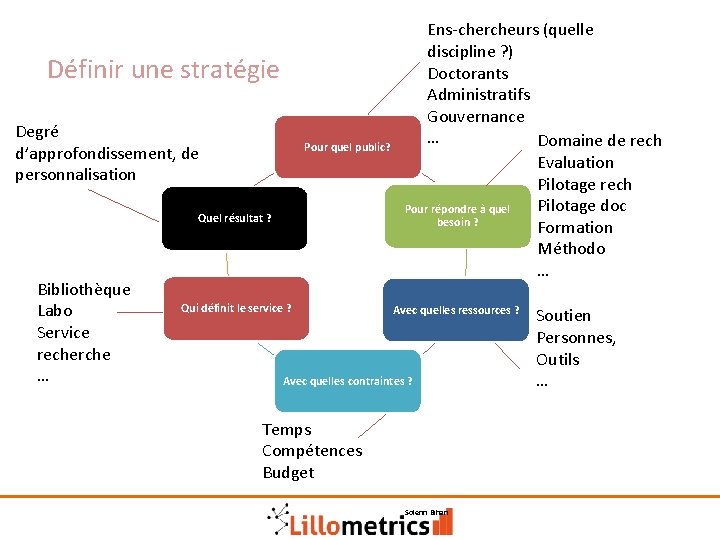

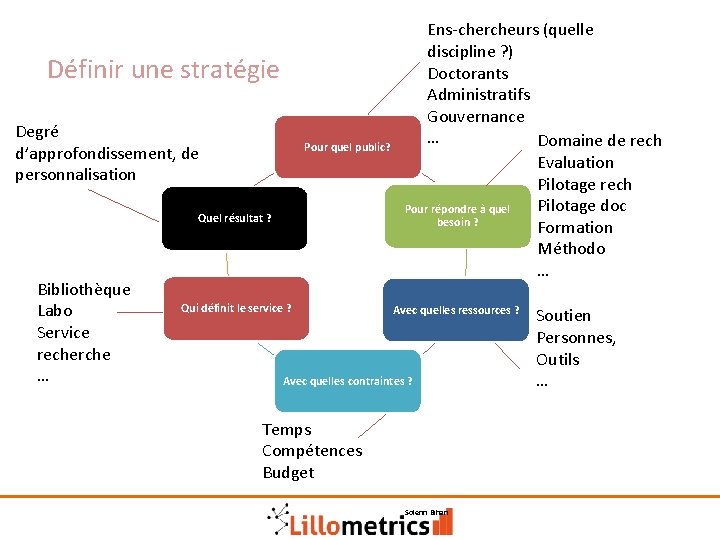

Définir une stratégie Degré d’approfondissement, de personnalisation Pour quel public? Quel résultat ? Bibliothèque Labo Service recherche … Qui définit le service ? Ens-chercheurs (quelle discipline ? ) Doctorants Administratifs Gouvernance … Domaine de rech Evaluation Pilotage rech Pilotage doc Pour répondre à quel besoin ? Formation Méthodo … Avec quelles ressources ? Avec quelles contraintes ? Temps Compétences Budget 39 Solenn Bihan Soutien Personnes, Outils …

Etudes de cas Des offres de services à construire 1. Une grande université scientifique et médicale recrute un ingénieur en bibliométrie. Moyens : abonnements Wo. S/In. Cites, service de statistiques, archive ouverte. Quelles seront ses missions ? 2. Dans une petite université multidisciplinaire, la bibliothèque veut proposer des formations à la bibliométrie. Moyens : pas d’abonnement Wos/Scopus, pas de compétence préalable. Comment procéder ? 3. Dans un EPST doté d’un service IST compétent en bibliométrie traditionnelle, il faut répondre à la demande d’un laboratoire de sciences de l’information avec une collection HAL complète et à jour, concernant la mesure de l’impact de la recherche du labo (ex: rapport des universités suisses). 4. Dans une université multidisciplinaire, l’université vient de valider une charte de signature des publications. Comment la mettre en place et suivre son utilisation. Moyens : abonnement Scopus, portail HAL, compétences en bibliométrie (formation URFIST). 40 Solenn Bihan

Réflexion individuelle A partir de la fiche que vous avez remplie au début du stage sur le profil de votre établissement, vos publics et leurs besoins Définissez une stratégie adaptée à vos besoins et vos contraintes Ne pas tout faire, mais « d’où je pars » et « par où commencer » 41 Solenn Bihan

Pour aller plus loin The London School of Economics – Impact Blog Responsible Metrics @LSEImpact. Blog @Res. Metrics 42 Solenn Bihan

lillometrics@isite-ulne. fr Solenn Bihan Laurence Crohem David Bélart Patrick Devos Hélène Lefranc Sylvain Vandamme

Olivia avril

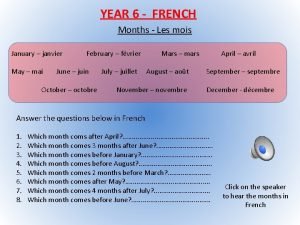

Olivia avril Janvier fevrier mars avril months in french

Janvier fevrier mars avril months in french Sicile avril

Sicile avril Excutif

Excutif Sindrome anticolinergico tratamiento

Sindrome anticolinergico tratamiento Avril halstead

Avril halstead Avril joffe

Avril joffe Jade avril kine

Jade avril kine Janvier month

Janvier month Le poisson davril

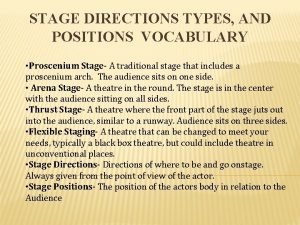

Le poisson davril 3/4 thrust stage

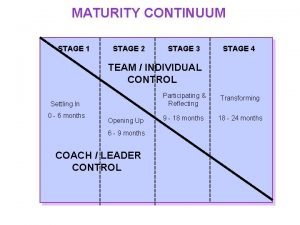

3/4 thrust stage Two stage tendering process

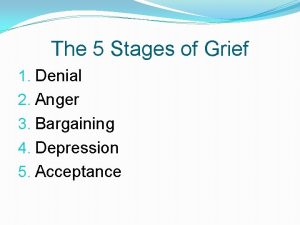

Two stage tendering process Phase one denial

Phase one denial House left vs stage left

House left vs stage left What is drama

What is drama Stage left and right

Stage left and right How does the nurse describe paris?

How does the nurse describe paris? Enp paris

Enp paris Languge cert

Languge cert Tertiary economic activities in the paris basin

Tertiary economic activities in the paris basin Spermoculture paris 11

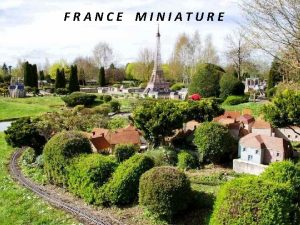

Spermoculture paris 11 La petite france paris

La petite france paris Inserm paris 11

Inserm paris 11 Hudi paris

Hudi paris F-75008 paris

F-75008 paris Paris in the spring once in a lifetime bird in the hand

Paris in the spring once in a lifetime bird in the hand Odisej trojanski rat

Odisej trojanski rat Paris traceroute

Paris traceroute Université paris 1

Université paris 1 What is the purpose of a flying buttress?

What is the purpose of a flying buttress? Dans un coin pourri du pauvre paris

Dans un coin pourri du pauvre paris Nicolas buge

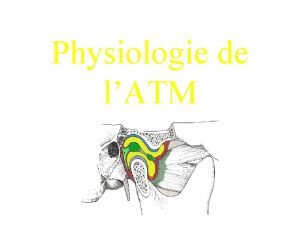

Nicolas buge Condyle travaillant et non travaillant

Condyle travaillant et non travaillant Fa-ti timp sa traiesti

Fa-ti timp sa traiesti Coulommiers pronunciation

Coulommiers pronunciation Rue du coq d'or paris

Rue du coq d'or paris Chagall paris through the window

Chagall paris through the window Séjour scolaire paris

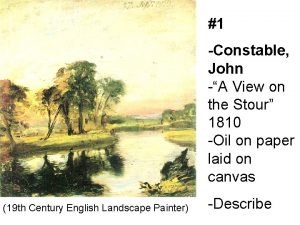

Séjour scolaire paris Van gogh self-portrait (1889)

Van gogh self-portrait (1889) Max beckmann party in paris

Max beckmann party in paris Esit paris

Esit paris Paris by night

Paris by night Isabey paris

Isabey paris Romeo and juliet act 4 questions

Romeo and juliet act 4 questions