Qualitt einer Erschlieung Relevanz und Vollstndigkeitsrate Zur Erinnerung

- Slides: 10

Qualität einer Erschließung Relevanz- und Vollständigkeitsrate Zur Erinnerung: Zweck der Erschließung von Dokumenten/Texten ist nicht in erster Linie das Speichern, sondern das Wiederauffinden von Dokumenten und Informationen Die Qualität der Erschließung ist also daran zu messen, inwiefern alle für den Benutzer relevanten Dokumente vom Informationsanbieter wiedergefunden werden. Spree So. Se 2011

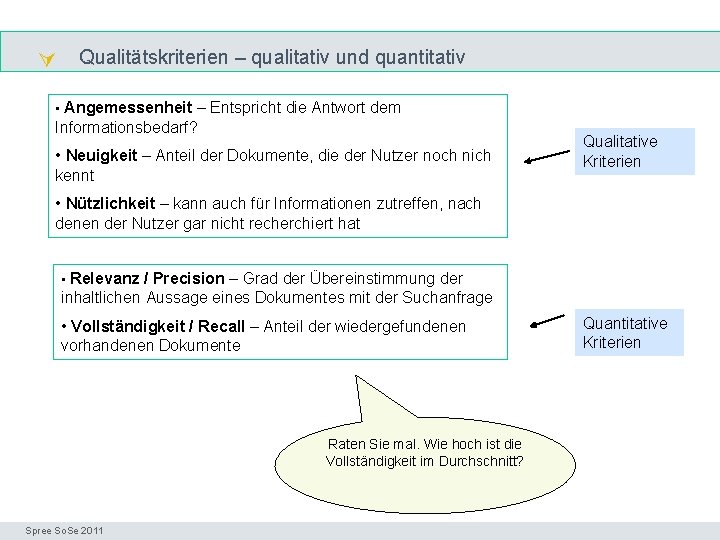

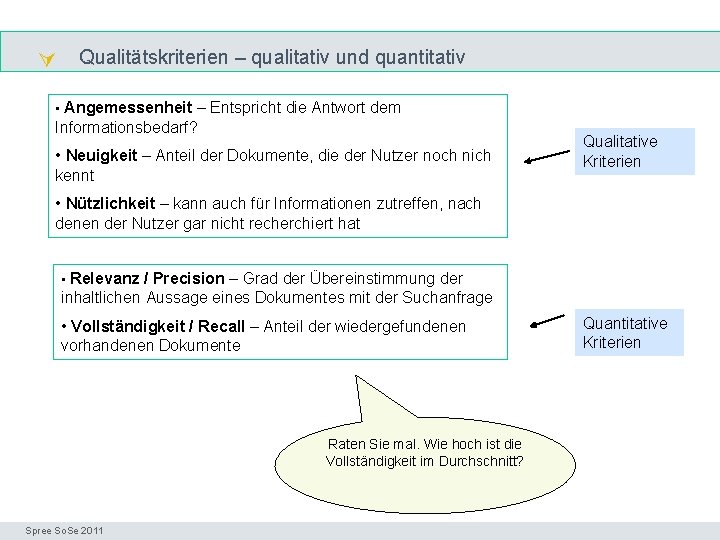

Qualitätskriterien – qualitativ und quantitativ Precision & recall • Angemessenheit – Entspricht die Antwort dem Informationsbedarf? • Neuigkeit – Anteil der Dokumente, die der Nutzer noch nich kennt Qualitative Kriterien • Nützlichkeit – kann auch für Informationen zutreffen, nach denen der Nutzer gar nicht recherchiert hat • Relevanz / Precision – Grad der Übereinstimmung der inhaltlichen Aussage eines Dokumentes mit der Suchanfrage • Vollständigkeit / Recall – Anteil der wiedergefundenen vorhandenen Dokumente Quantitative Kriterien Raten Sie mal. Wie hoch ist die Vollständigkeit im Durchschnitt? Spree So. Se 2011 Seminar I-Prax: Inhaltserschließung visueller Medien, 5. 10. 2004

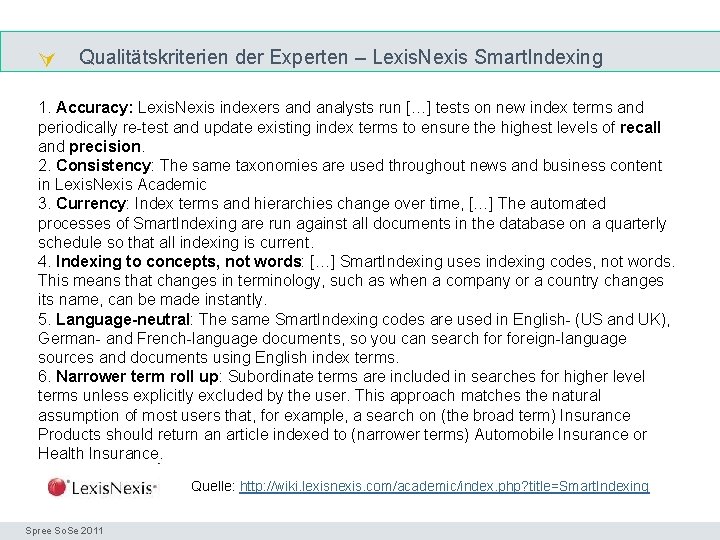

Qualitätskriterien der Experten – Lexis. Nexis Smart. Indexing Precision & recall 1. Accuracy: Lexis. Nexis indexers and analysts run […] tests on new index terms and periodically re-test and update existing index terms to ensure the highest levels of recall and precision. 2. Consistency: The same taxonomies are used throughout news and business content in Lexis. Nexis Academic 3. Currency: Index terms and hierarchies change over time, […] The automated processes of Smart. Indexing are run against all documents in the database on a quarterly schedule so that all indexing is current. 4. Indexing to concepts, not words: […] Smart. Indexing uses indexing codes, not words. This means that changes in terminology, such as when a company or a country changes its name, can be made instantly. 5. Language-neutral: The same Smart. Indexing codes are used in English- (US and UK), German- and French-language documents, so you can search foreign-language sources and documents using English index terms. 6. Narrower term roll up: Subordinate terms are included in searches for higher level terms unless explicitly excluded by the user. This approach matches the natural assumption of most users that, for example, a search on (the broad term) Insurance Products should return an article indexed to (narrower terms) Automobile Insurance or Health Insurance. Quelle: http: //wiki. lexisnexis. com/academic/index. php? title=Smart. Indexing Spree So. Se 2011 Seminar I-Prax: Inhaltserschließung visueller Medien, 5. 10. 2004

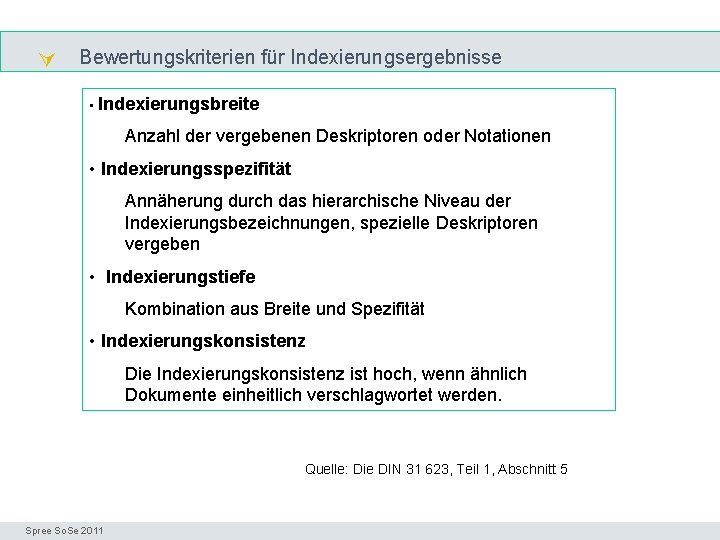

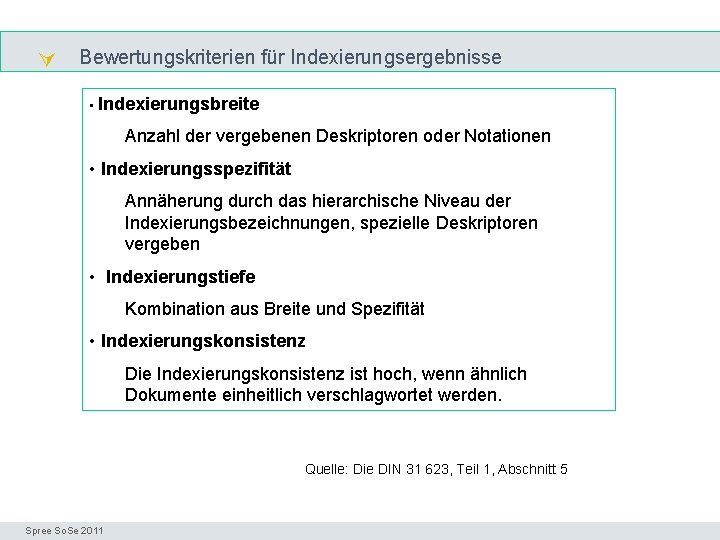

Bewertungskriterien für Indexierungsergebnisse Precision & recall • Indexierungsbreite Anzahl der vergebenen Deskriptoren oder Notationen • Indexierungsspezifität Annäherung durch das hierarchische Niveau der Indexierungsbezeichnungen, spezielle Deskriptoren vergeben • Indexierungstiefe Kombination aus Breite und Spezifität • Indexierungskonsistenz Die Indexierungskonsistenz ist hoch, wenn ähnlich Dokumente einheitlich verschlagwortet werden. Quelle: Die DIN 31 623, Teil 1, Abschnitt 5 Spree So. Se 2011 Seminar I-Prax: Inhaltserschließung visueller Medien, 5. 10. 2004

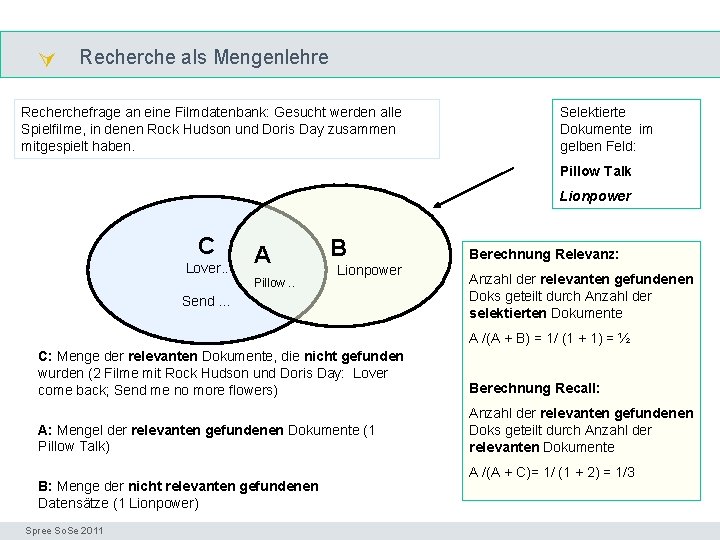

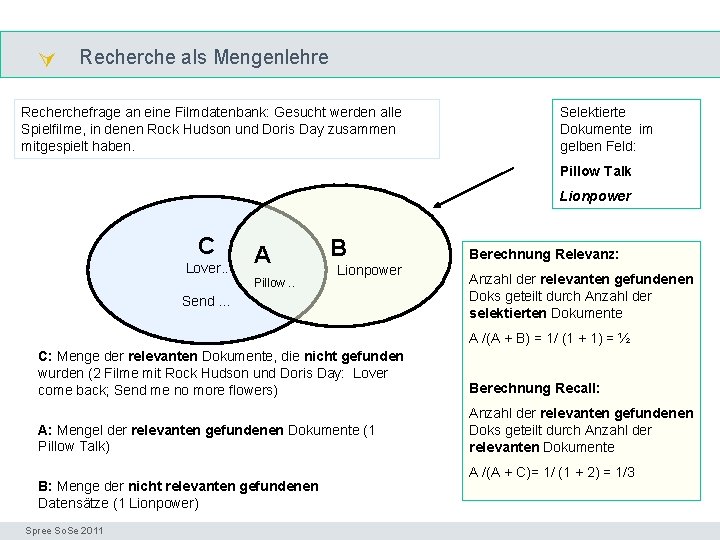

Recherche als Mengenlehre vollständig Recherchefrage an eine Filmdatenbank: Gesucht werden alle Spielfilme, in denen Rock Hudson und Doris Day zusammen mitgespielt haben. Selektierte Dokumente im gelben Feld: Pillow Talk Lionpower C Lover. . B A Lionpower Pillow. . Send … Berechnung Relevanz: Anzahl der relevanten gefundenen Doks geteilt durch Anzahl der selektierten Dokumente A /(A + B) = 1/ (1 + 1) = ½ C: Menge der relevanten Dokumente, die nicht gefunden wurden (2 Filme mit Rock Hudson und Doris Day: Lover come back; Send me no more flowers) Berechnung Recall: A: Mengel der relevanten gefundenen Dokumente (1 Pillow Talk) Anzahl der relevanten gefundenen Doks geteilt durch Anzahl der relevanten Dokumente B: Menge der nicht relevanten gefundenen Datensätze (1 Lionpower) Spree So. Se 2011 A /(A + C)= 1/ (1 + 2) = 1/3 Seminar I-Prax: Inhaltserschließung visueller Medien, 5. 10. 2004

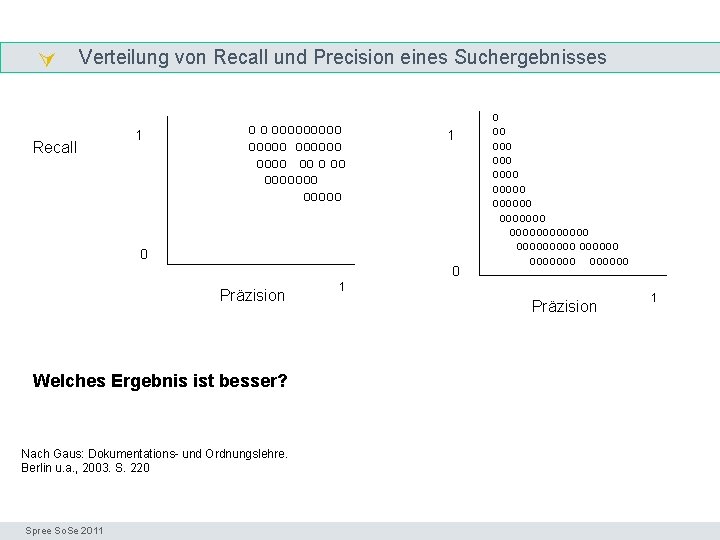

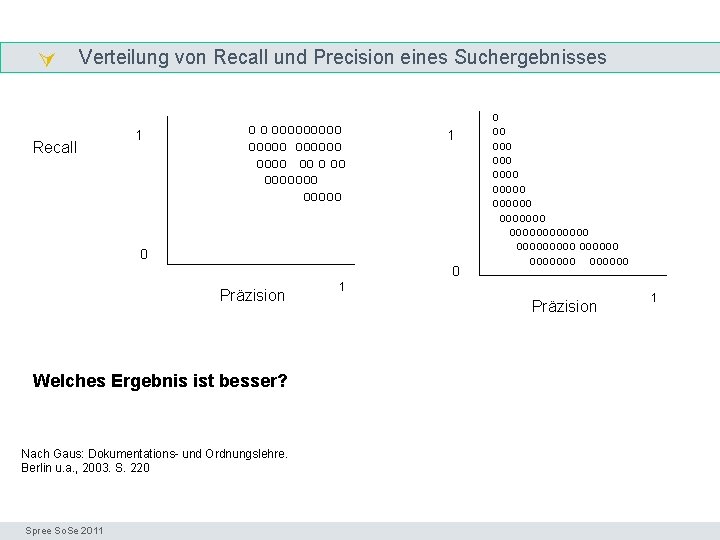

Verteilung von Recall und Precision eines Suchergebnisses Recall 1 o o oooooo oo ooooo 1 0 0 Präzision o oo ooo ooooooo ooooooooo oooooo 1 Präzision Welches Ergebnis ist besser? Nach Gaus: Dokumentations- und Ordnungslehre. Berlin u. a. , 2003. S. 220 Spree So. Se 2011 Seminar I-Prax: Inhaltserschließung visueller Medien, 5. 10. 2004 1

Zusammenhang von Recall und Precision Die Qualität ist hoch, wenn viele relevante Dokumente gefunden wurden. Verteilung von Recall und Präzision bei Recherchen in einer Datenbank von relativ guter Indexierungsqualität. Beide Werte liegen dicht an 1. vollständig Die Qualität ist niedrig, wenn wenige allgemeine, also unpräzise Dokumente gefunden wurden. Verteilung von Recall und Präzision bei Recherchen in einer Datenbank von relativ schlechter Indexierungsqualität. Beide Werte liegen dicht an 0. Nach Gaus: Dokumentations- und Ordnungslehre. Berlin u. a. , 2003. S. 220 Spree So. Se 2011 Seminar I-Prax: Inhaltserschließung visueller Medien, 5. 10. 2004

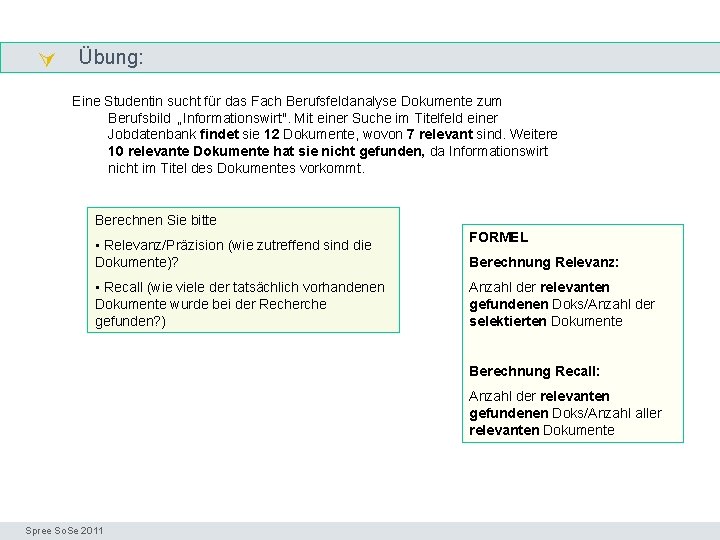

Übung: genau Eine Studentin sucht für das Fach Berufsfeldanalyse Dokumente zum Berufsbild „Informationswirt". Mit einer Suche im Titelfeld einer Jobdatenbank findet sie 12 Dokumente, wovon 7 relevant sind. Weitere 10 relevante Dokumente hat sie nicht gefunden, da Informationswirt nicht im Titel des Dokumentes vorkommt. Berechnen Sie bitte • Relevanz/Präzision (wie zutreffend sind die Dokumente)? • Recall (wie viele der tatsächlich vorhandenen Dokumente wurde bei der Recherche gefunden? ) FORMEL Berechnung Relevanz: Anzahl der relevanten gefundenen Doks/Anzahl der selektierten Dokumente Berechnung Recall: Anzahl der relevanten gefundenen Doks/Anzahl aller relevanten Dokumente Spree So. Se 2011 Seminar I-Prax: Inhaltserschließung visueller Medien, 5. 10. 2004

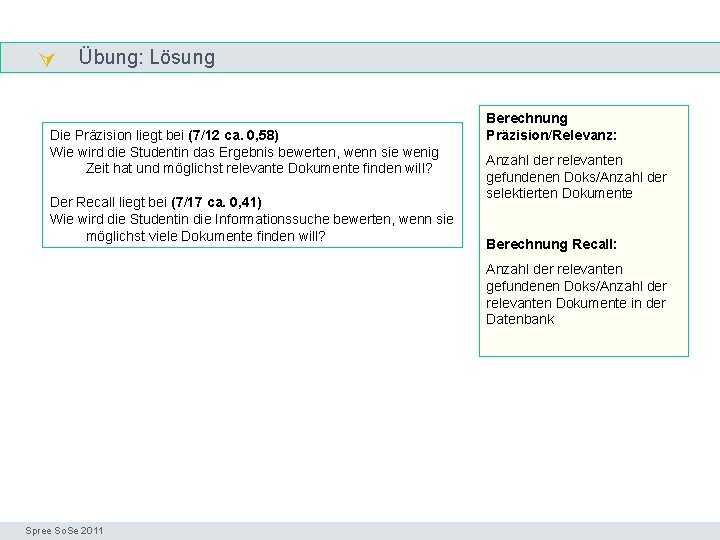

Übung: Lösung genau Die Präzision liegt bei (7/12 ca. 0, 58) Wie wird die Studentin das Ergebnis bewerten, wenn sie wenig Zeit hat und möglichst relevante Dokumente finden will? Der Recall liegt bei (7/17 ca. 0, 41) Wie wird die Studentin die Informationssuche bewerten, wenn sie möglichst viele Dokumente finden will? Berechnung Präzision/Relevanz: Anzahl der relevanten gefundenen Doks/Anzahl der selektierten Dokumente Berechnung Recall: Anzahl der relevanten gefundenen Doks/Anzahl der relevanten Dokumente in der Datenbank Spree So. Se 2011 Seminar I-Prax: Inhaltserschließung visueller Medien, 5. 10. 2004

Literatur genau DIN 31 623: Indexierung zur inhaltlichen Erschließung von Dokumenten; Teil 1: Begriffe, Grundlagen. Stand: September 1988 Gaus, Wilhelm: Dokumentations- und Ordnungslehre. Berlin: Springer, 2003 Stock, Wolfgang G. : Information Retrieval : Informationen suchen und finden. München, Wien : R. Oldenbourg Verlag, 2007 Spree So. Se 2011 Seminar I-Prax: Inhaltserschließung visueller Medien, 5. 10. 2004