valuation des logiciels interactifs 1 Cours 5 partie

![Combien d’experts ? [Nielsen 1993] % Problèmes 100 détectés 90 80 70 60 50 Combien d’experts ? [Nielsen 1993] % Problèmes 100 détectés 90 80 70 60 50](https://slidetodoc.com/presentation_image_h/8a0f246eea0929af8394e038a63bc329/image-20.jpg)

![ROI (Return On Investment) problems found [Canny 2004] benefits / cost 21 ROI (Return On Investment) problems found [Canny 2004] benefits / cost 21](https://slidetodoc.com/presentation_image_h/8a0f246eea0929af8394e038a63bc329/image-21.jpg)

- Slides: 29

Évaluation des logiciels interactifs (1) Cours 5 (partie 1) (Cf. cours 1 bis) Méthodes d’Inspection (évaluation sans utilisateur) M 2 -IFL/DU-TICE, UPMC Elisabeth. Delozanne@upmc. fr 1

Plan du cours Cours 5 : Évaluation des logiciels interactifs (partie 1) § Évaluer ? § Votre projet IHM • Évaluation heuristique (septembre) • Mise en place d’une revue de conception (aujourd’hui) • Évaluation coopérative (atelier fin janv. ) § Méthodes d’inspection ? • Revue de conception • Évaluation heuristiques Cours 5 : évaluation des logiciels interactifs (partie 2) § Méthodes tests utilisateurs § Quelles méthodes choisir ? 2

(Rappel) Cours 1 : Facteurs de succès Cycle de conception Conception centrée usager L’analyse des tâches et les analyses en contexte de travail usuel Le prototypage rapide L’évaluation constante Conception itérative La qualité de la programmation 3

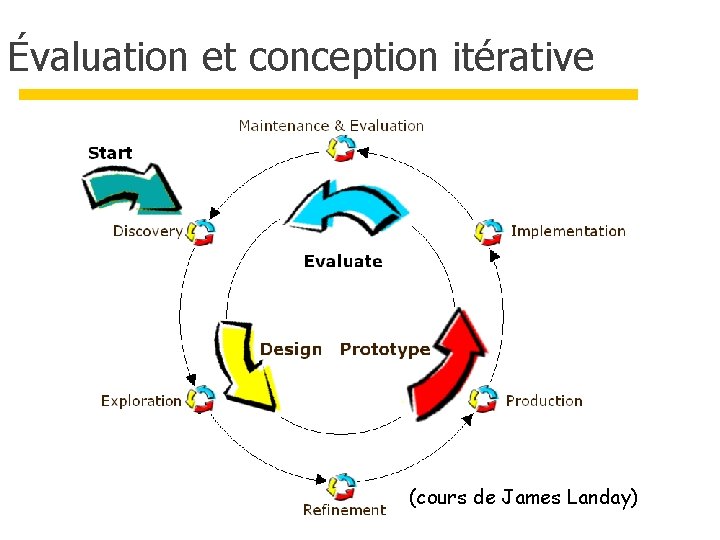

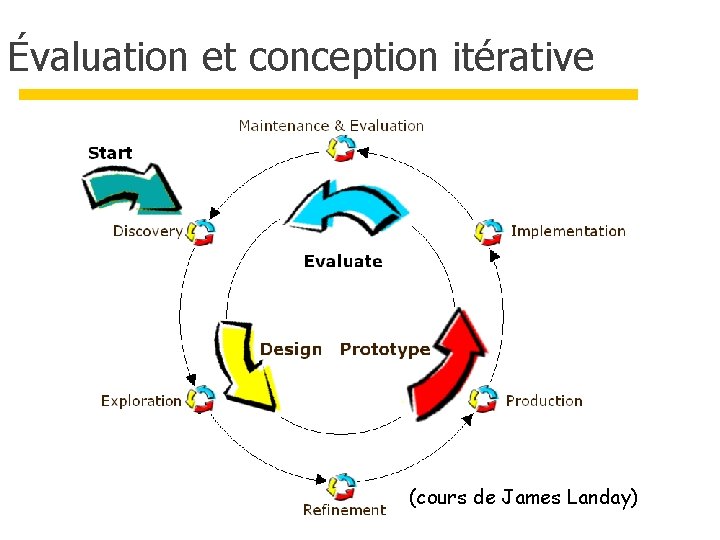

Évaluation et conception itérative (cours de James Landay)

Projet 1 : Évaluer la concurrence Quand ? § Moments d'évaluation : en amont (sept. Cours 2) Pourquoi ? § Objectifs : lister les bonnes et mauvaises pratiques Quoi ? § Variables cibles : rapidité de prise en main, temps de saisie des informations, résumé des saisies Comment ? § Inspection heuristique (critères, scénarios) § Évaluation coopérative À quel coût ? § Rapide : quelques heures § Bon marché 5

Projet 2 : Évaluer un scénario de conception Quand ? § Moments d'évaluation : en cours de conception (aujourd’hui) Pourquoi ? § Objectifs : détecter des problèmes d’utilisabilité Quoi ? § Un scénario de conception, logique de travail Comment ? § Revue de conception (Design Walkthrough) § Évaluation par des pairs À quel coût ? § Rapide : une heure § Bon marché 6

Projet 3 : Évaluer un prototype Quand ? § Moments d'évaluation : fin d’une itération (Fin Janvier) Pourquoi ? § Objectifs : tester l’utilisabilité Quoi ? § Variables cibles : temps de prise en main, nombre de tâches complétées/abandonnées, nombre d’erreurs/hésitation, satisfaction Comment ? § Évaluation coopérative À quel coût ? § Rapide : quelques heures § Assez bon marché 7

Évaluation : Définitions étudier les rapports entre la conception et l'utilisation a priori, formative (conception) § identifier ou prévoir les besoins, les scénarios d’utilisation, les difficultés potentielles ou réelles des utilisateurs § donner et évaluer des idées a posteriori, sommative (usage) § caractériser les points forts et les points faibles d'un système interactif § préparer les évolutions § produire des connaissances 8

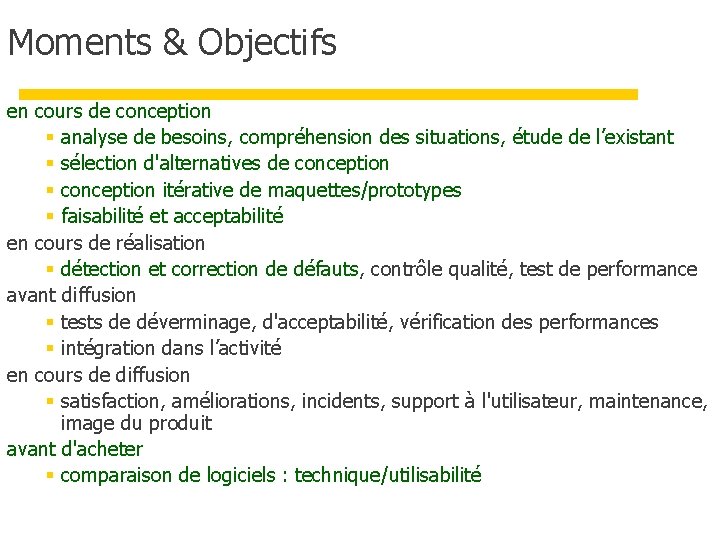

Moments & Objectifs en cours de conception § analyse de besoins, compréhension des situations, étude de l’existant § sélection d'alternatives de conception § conception itérative de maquettes/prototypes § faisabilité et acceptabilité en cours de réalisation § détection et correction de défauts, contrôle qualité, test de performance avant diffusion § tests de déverminage, d'acceptabilité, vérification des performances § intégration dans l’activité en cours de diffusion § satisfaction, améliorations, incidents, support à l'utilisateur, maintenance, image du produit avant d'acheter § comparaison de logiciels : technique/utilisabilité

Évaluer quoi ? Les dimensions d'évaluation dépendent des objectifs et du contexte utilité § la fiabilité, la qualité technique § les temps de réponse utilisabilité § la facilité d'apprentissage, la flexibilité, la robustesse § l’utilisation des fonctions § la tolérance aux erreurs § la qualité de la documentation et de l’assistance § la logique du travail § les opinions ou les attitudes

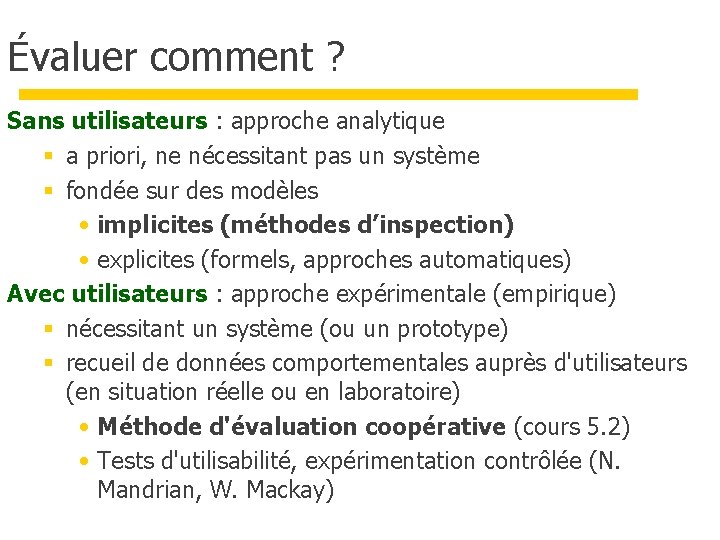

Évaluer comment ? Sans utilisateurs : approche analytique § a priori, ne nécessitant pas un système § fondée sur des modèles • implicites (méthodes d’inspection) • explicites (formels, approches automatiques) Avec utilisateurs : approche expérimentale (empirique) § nécessitant un système (ou un prototype) § recueil de données comportementales auprès d'utilisateurs (en situation réelle ou en laboratoire) • Méthode d'évaluation coopérative (cours 5. 2) • Tests d'utilisabilité, expérimentation contrôlée (N. Mandrian, W. Mackay)

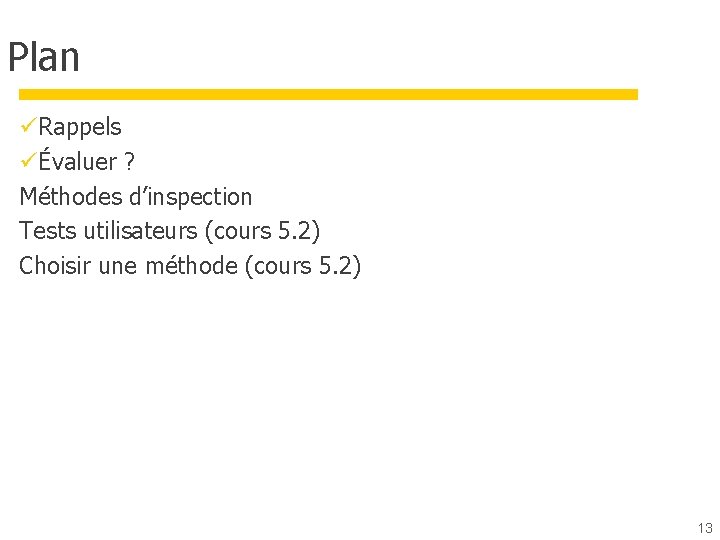

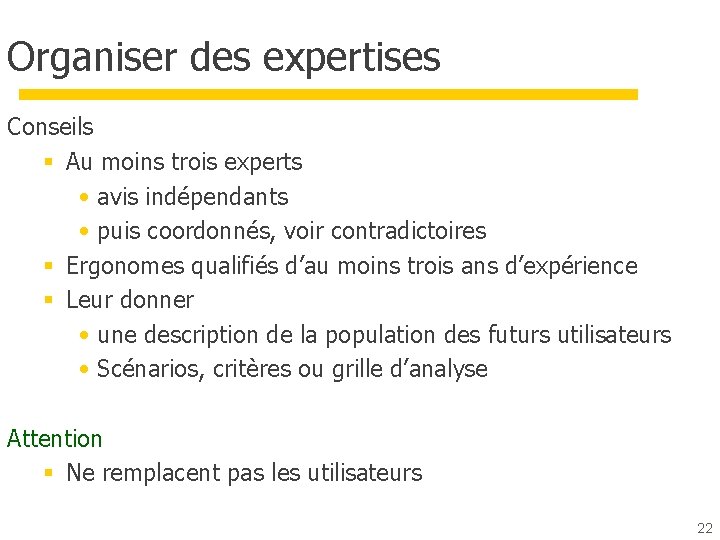

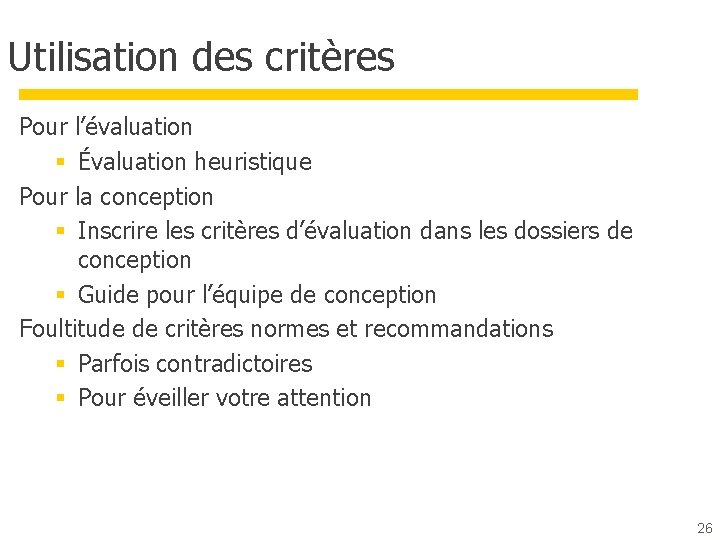

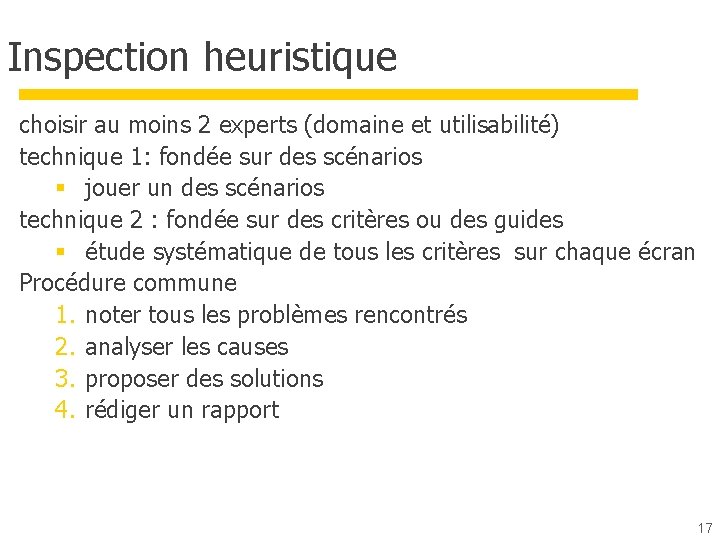

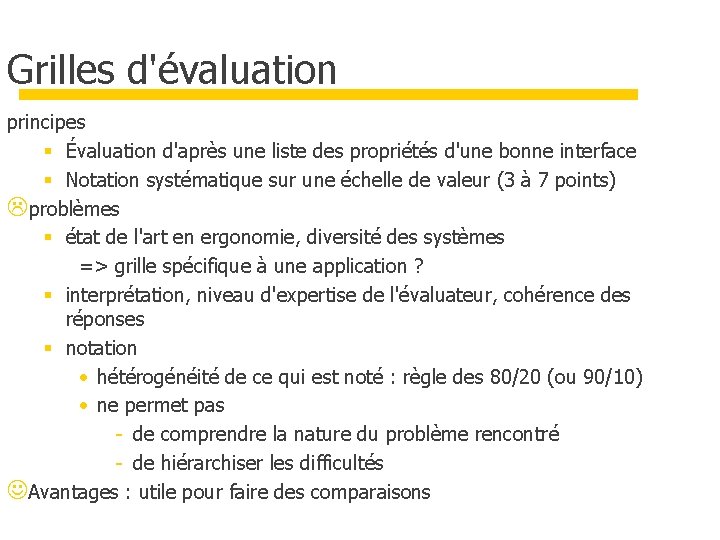

Évaluer à quel prix ? Temps, argent, compétences § Méthodes « low cost » • Culture de l’évaluation chez les informaticiens • Détection des gros problèmes, pas les problèmes subtils • Informelles, qualitatives, évaluation formative § Méthodes scientifiques et rigoureuses • Gros projets, projets à risques, recherche • Informations fiables, quantitatives Quel retour sur investissement pour les études d’utilisabilité ? (ROI) 12

Plan üRappels üÉvaluer ? Méthodes d’inspection Tests utilisateurs (cours 5. 2) Choisir une méthode (cours 5. 2) 13

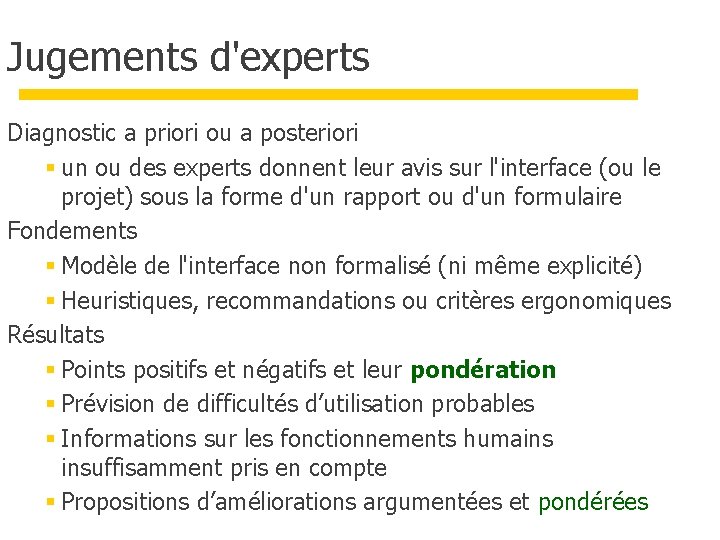

Approches analytiques Comparaison avec un "modèle de référence" Modèles implicites : approches informelles § Méthodes d’inspection (cours 1) • Méthodes « low cost » Modèles explicites : approches formelles (ou semi-formelles) § modèles prédictifs • analyse de tâches (KLM et GOMS) • modèle linguistique (ALG et CLG) • modèle de complexité cognitive (Kieras et Polson) § modèles de qualité de l'interface • approche cognitive • recherche des qualités optimales

Les méthodes d’inspection Inventaire § jugements d’experts § grilles d’évaluation § revues de conception (design walkthrough) Techniques § scénarios § heuristiques, des recommandations ou des critères Avantages § Pas cher et rapides (~ une journée) § Faciles à utiliser (détecter les erreurs flagrantes en 2 à 4 h) Inconvénients § Ne permettent pas de détecter des erreurs subtiles (liées à l'analyse du travail, au contexte) 15

Jugements d'experts Diagnostic a priori ou a posteriori § un ou des experts donnent leur avis sur l'interface (ou le projet) sous la forme d'un rapport ou d'un formulaire Fondements § Modèle de l'interface non formalisé (ni même explicité) § Heuristiques, recommandations ou critères ergonomiques Résultats § Points positifs et négatifs et leur pondération § Prévision de difficultés d’utilisation probables § Informations sur les fonctionnements humains insuffisamment pris en compte § Propositions d’améliorations argumentées et pondérées

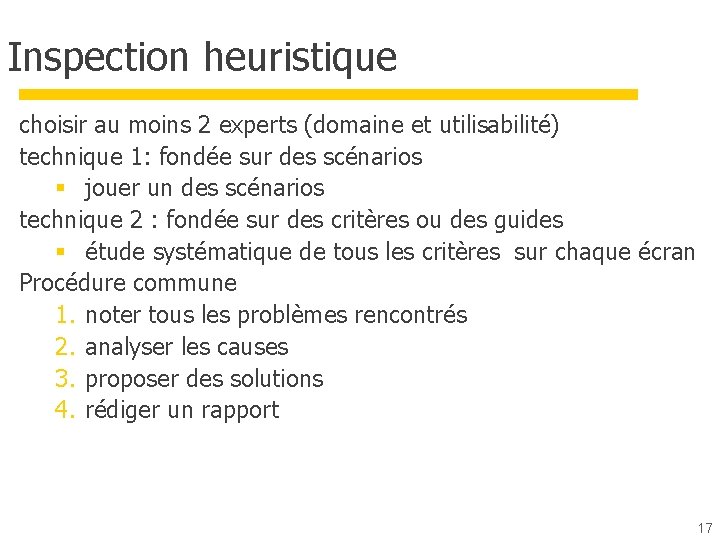

Inspection heuristique choisir au moins 2 experts (domaine et utilisabilité) technique 1: fondée sur des scénarios § jouer un des scénarios technique 2 : fondée sur des critères ou des guides § étude systématique de tous les critères sur chaque écran Procédure commune 1. noter tous les problèmes rencontrés 2. analyser les causes 3. proposer des solutions 4. rédiger un rapport 17

Pour/contre Biais : § Experts : vue plus générale, sources potentielles de dysfonctionnement § Novices : difficultés matérielles et conceptuelles de bas niveau § Biais de focalisation • fonctionnement particulier (e. g. d'utilisateurs novices), sur les "marottes" de l'expert • domaine d'expertise (domaine, IHM, graphisme) Intérêt § Pas cher, rapide et efficace, peut intervenir très tôt dans le cycle de conception § Plusieurs experts 18

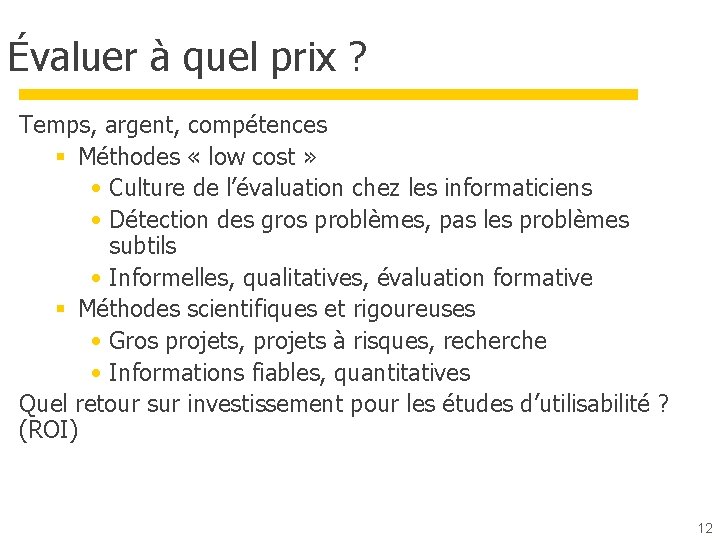

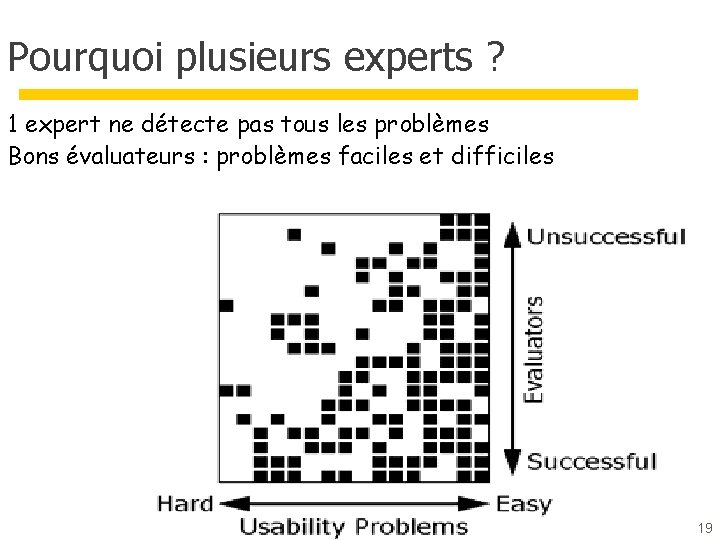

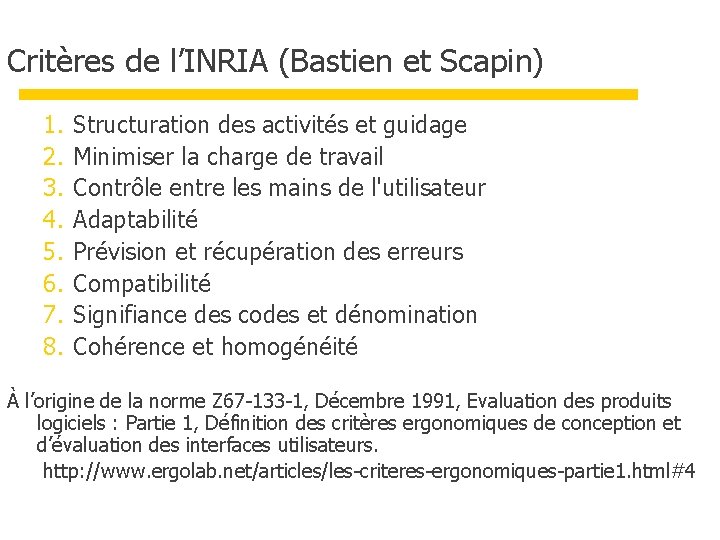

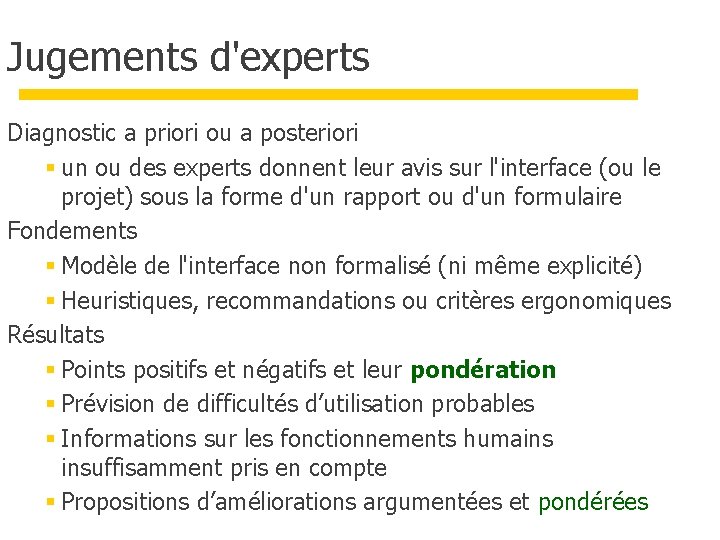

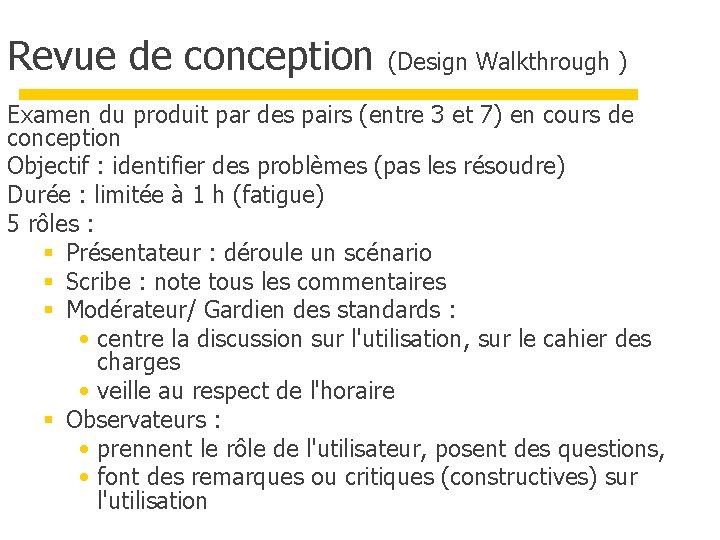

Pourquoi plusieurs experts ? 1 expert ne détecte pas tous les problèmes Bons évaluateurs : problèmes faciles et difficiles 19

![Combien dexperts Nielsen 1993 Problèmes 100 détectés 90 80 70 60 50 Combien d’experts ? [Nielsen 1993] % Problèmes 100 détectés 90 80 70 60 50](https://slidetodoc.com/presentation_image_h/8a0f246eea0929af8394e038a63bc329/image-20.jpg)

Combien d’experts ? [Nielsen 1993] % Problèmes 100 détectés 90 80 70 60 50 Évaluateurs spécialistes du domaine 40 Évaluateurs généralistes 30 Évaluateurs novices 20 Nombre d ’évaluate 10 0 1 2 3 4 5 6 7 8 9 10 11 12 13 20 20

![ROI Return On Investment problems found Canny 2004 benefits cost 21 ROI (Return On Investment) problems found [Canny 2004] benefits / cost 21](https://slidetodoc.com/presentation_image_h/8a0f246eea0929af8394e038a63bc329/image-21.jpg)

ROI (Return On Investment) problems found [Canny 2004] benefits / cost 21

Organiser des expertises Conseils § Au moins trois experts • avis indépendants • puis coordonnés, voir contradictoires § Ergonomes qualifiés d’au moins trois ans d’expérience § Leur donner • une description de la population des futurs utilisateurs • Scénarios, critères ou grille d’analyse Attention § Ne remplacent pas les utilisateurs 22

Revue de conception (Design Walkthrough ) Examen du produit par des pairs (entre 3 et 7) en cours de conception Objectif : identifier des problèmes (pas les résoudre) Durée : limitée à 1 h (fatigue) 5 rôles : § Présentateur : déroule un scénario § Scribe : note tous les commentaires § Modérateur/ Gardien des standards : • centre la discussion sur l'utilisation, sur le cahier des charges • veille au respect de l'horaire § Observateurs : • prennent le rôle de l'utilisateur, posent des questions, • font des remarques ou critiques (constructives) sur l'utilisation

Grilles d'évaluation principes § Évaluation d'après une liste des propriétés d'une bonne interface § Notation systématique sur une échelle de valeur (3 à 7 points) problèmes § état de l'art en ergonomie, diversité des systèmes => grille spécifique à une application ? § interprétation, niveau d'expertise de l'évaluateur, cohérence des réponses § notation • hétérogénéité de ce qui est noté : règle des 80/20 (ou 90/10) • ne permet pas - de comprendre la nature du problème rencontré - de hiérarchiser les difficultés Avantages : utile pour faire des comparaisons

Critères de l’INRIA (Bastien et Scapin) 1. 2. 3. 4. 5. 6. 7. 8. Structuration des activités et guidage Minimiser la charge de travail Contrôle entre les mains de l'utilisateur Adaptabilité Prévision et récupération des erreurs Compatibilité Signifiance des codes et dénomination Cohérence et homogénéité À l’origine de la norme Z 67 -133 -1, Décembre 1991, Evaluation des produits logiciels : Partie 1, Définition des critères ergonomiques de conception et d’évaluation des interfaces utilisateurs. http: //www. ergolab. net/articles/les-criteres-ergonomiques-partie 1. html#4

Utilisation des critères Pour l’évaluation § Évaluation heuristique Pour la conception § Inscrire les critères d’évaluation dans les dossiers de conception § Guide pour l’équipe de conception Foultitude de critères normes et recommandations § Parfois contradictoires § Pour éveiller votre attention 26

Conclusion sur les critères En évaluation § Art délicat de l’évaluation heuristique • Évaluateurs moyens : subtiles § Permet d’établir des rapports évaluation sur l’aspect utilisabilité En conception : § Très utile de les avoir en tête lors de la conception § Compromis entre différentes recommandations contradictoires en fonction de la tâche, de l'activité ou du public cible § Mais • ne pas introduire de gadget ni multiplier les fonctions • étudier de nombreuses interfaces d'un regard critique et piquer les bonnes idées • regarder de nombreux guides et critères (Cf. le web)

Retenir Les différentes méthodes d’évaluation sans utilisateurs § Jugement d’experts § Inspection heuristique (critères) § Revue de conception (scénarios) Au moins un jeu de critères ergonomiques § Par exemple ceux de l’INRIA Exercez-vous à étudier les interfaces que vous utilisez du point de vue utilisabilité et faites-vous des catalogues 28

Take home messages (partie 1) Méthodes d’évaluation sans utilisateurs Indispensables en cours de conception évaluer les maquettes et prototypes Rapides, pas chères et efficaces Permettent d’éliminer les erreurs de conception de type « amateur » En projet § Évaluation heuristique (inspection avec un jeu de critères) § Revue de conception (scénarios) Méthodes d’évaluation avec utilisateurs Indispensables pour les problèmes liés au domaine, à l’activité, aux usages 29

Logiciels interactifs

Logiciels interactifs Classification des logiciels

Classification des logiciels Fixed income introduction

Fixed income introduction Des des des

Des des des Pyxvital

Pyxvital @mimiryudo

@mimiryudo Proxmox live migration

Proxmox live migration Exposé sur les logiciels

Exposé sur les logiciels La gestion internationale des ressources humaines

La gestion internationale des ressources humaines Traitement automatique des langues

Traitement automatique des langues La tectonique des plaques - cours

La tectonique des plaques - cours Réponse

Réponse La route de chlifa résumé partie 2

La route de chlifa résumé partie 2 Epigastre

Epigastre Races de dauphins

Races de dauphins Fonction en escalier

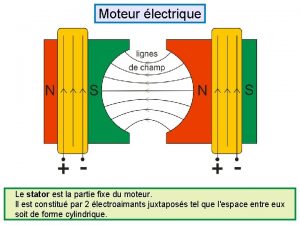

Fonction en escalier Partie fixe d'un moteur

Partie fixe d'un moteur Plan zatrudnienia wzór

Plan zatrudnienia wzór Partie de poisson

Partie de poisson Chimie partie 2

Chimie partie 2 Partie de campagne renoir

Partie de campagne renoir Partie prenante management

Partie prenante management Glisse nombre

Glisse nombre Prendre la partie pour le tout

Prendre la partie pour le tout Partie théorique et pratique

Partie théorique et pratique 85

85 Où se trouve le centre de la terre

Où se trouve le centre de la terre Je t'offrirai des fleurs et des nappes en couleurs

Je t'offrirai des fleurs et des nappes en couleurs Volume des liquides et des solides

Volume des liquides et des solides Valeur de l'imparfait

Valeur de l'imparfait