NEURONSKE MREE 2 predavanje dr Zoran evarac sevaracgmail

- Slides: 20

NEURONSKE MREŽE 2. predavanje dr Zoran Ševarac sevarac@gmail. com

Zаšto neuronske mreže? Omogućavaju napredu obradu podataka bez prethodno definisanog modela ili algoritma već na osnovu podataka o ponašanju nekog sistema Efikasno mogu da rešavaju veoma složene probleme koji bi inače bili teško rešivi nekim algoritamskim postpupkom. Primenjive su na širok spektar problema

KADA SE KORISTE NM • Kada nema jasno definisanog matematičkog modela ili drugog rešenja • Kada je potrebna otpornost na nepotpun ili pogrešan ulaz • Kada je potrebna sposobnost učenja • Visokodimenzionalnost • Kada se sa NM postižu bolji rezultati nego sa alternativnim rešenjima (npr. odziv u realnom vremenu, tolerancija na greške)

NAJVAŽNIJE KARAKTERISTIKE VNM 1. Imaju sposobnost učenja 2. Imaju sposobnost generalizacije 3. Otporne na pogrešan ulaz i šum

VRSTE PROBLEMA ZA KOJE SE KORISTE VNM • • Klasifikacija Prepoznavanje (oblika, govora, vektora. . . ) Aproksimacija Optimizacija Obrada signala Modeliranje sistema Predviđanje Kontrola i upravljanje

PRIMERI PRIMENE • Predviđanje na berzi • Klasifikacija i prepoznavanje objekata na radaru • Prepoznavanje slika, slova, lica, otisaka prstiju • Dijagnostika u medicini • Filtriranje šuma u signalu • Aerodinamična konfiguracija ploča kod F-117

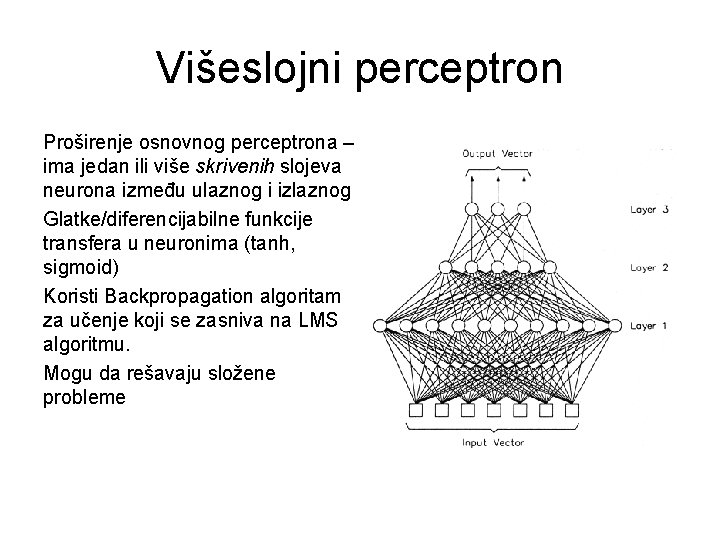

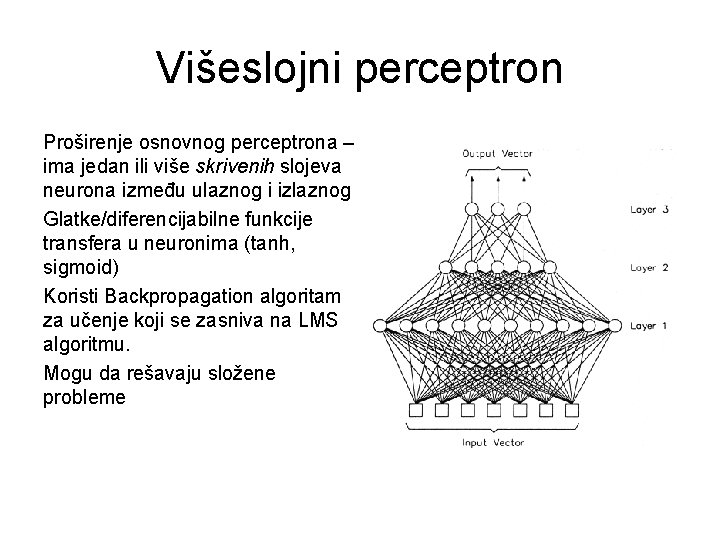

Višeslojni perceptron Proširenje osnovnog perceptrona – ima jedan ili više skrivenih slojeva neurona između ulaznog i izlaznog Glatke/diferencijabilne funkcije transfera u neuronima (tanh, sigmoid) Koristi Backpropagation algoritam za učenje koji se zasniva na LMS algoritmu. Mogu da rešavaju složene probleme

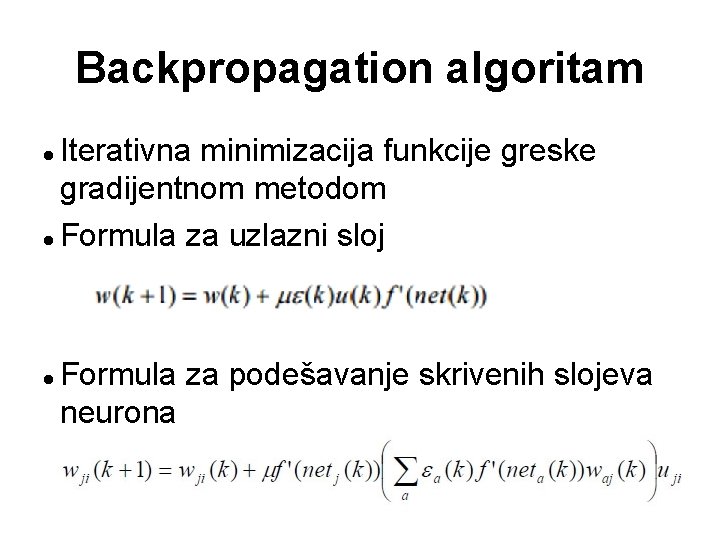

Backpropagation algoritam Služi za trening višeslojnog perceptrona – može da podešava težine u skrivenim slojevima Predstavlja supervizorni algoritam koji se zasniva na LMS algoritmu Višeslojni perceptron sa BP algoritmom predstavlja univerzalni aproksimator

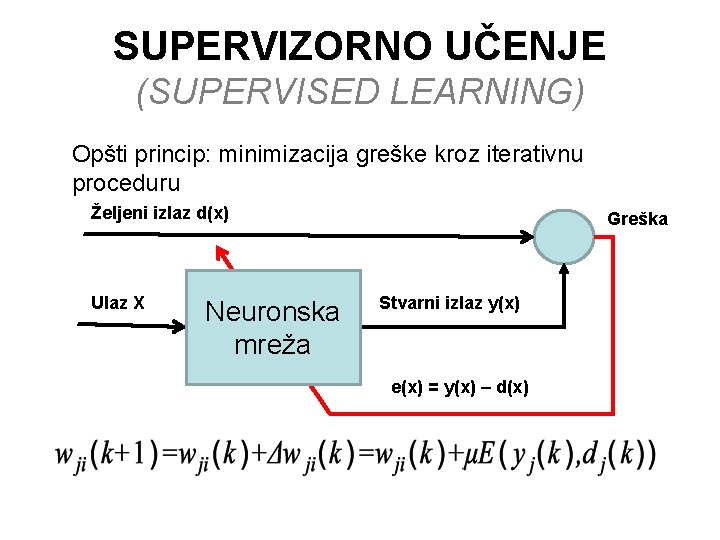

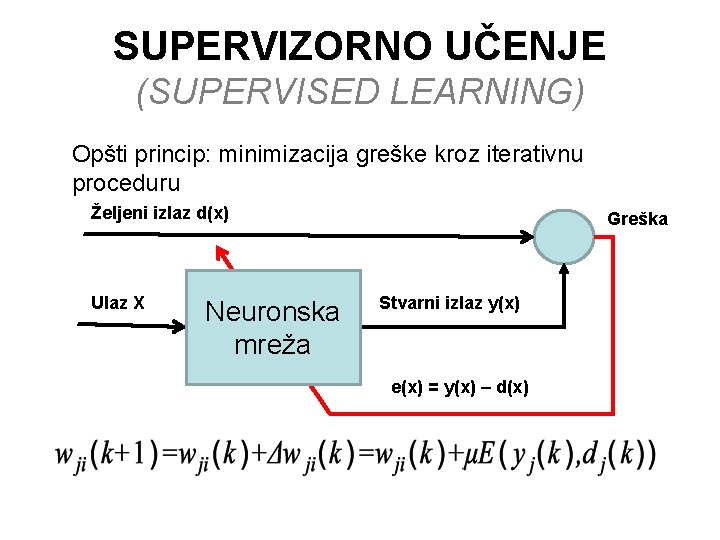

SUPERVIZORNO UČENJE (SUPERVISED LEARNING) Opšti princip: minimizacija greške kroz iterativnu proceduru Željeni izlaz d(x) Ulaz X Neuronska mreža Greška Stvarni izlaz y(x) e(x) = y(x) – d(x)

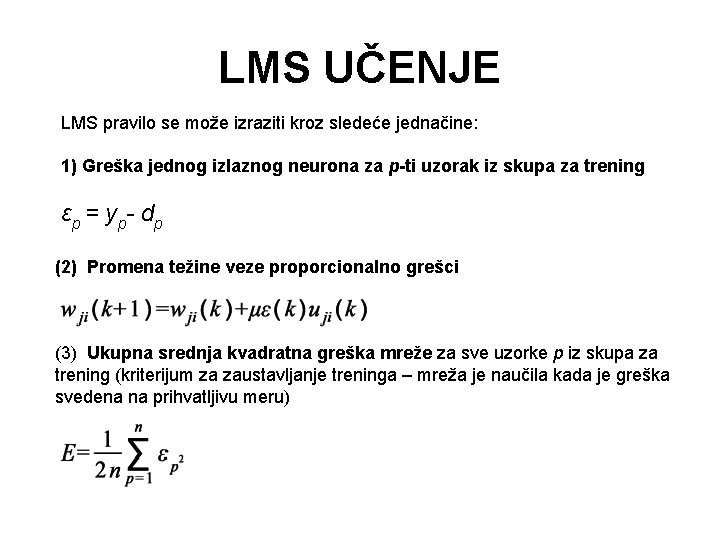

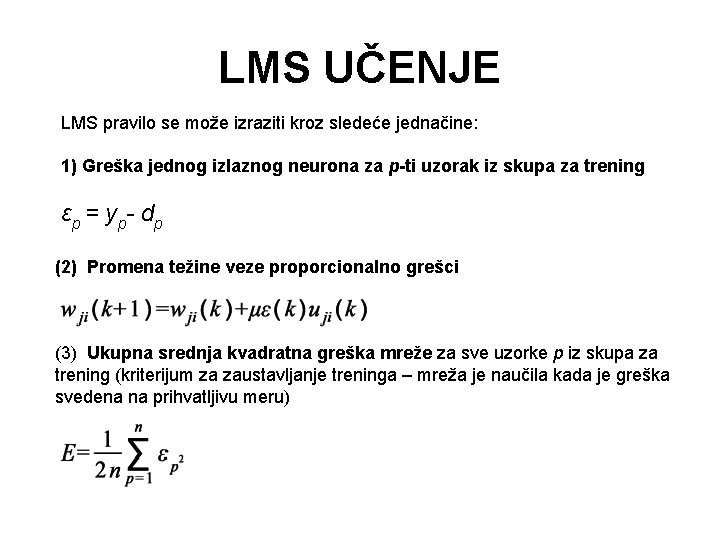

LMS UČENJE LMS pravilo se može izraziti kroz sledeće jednačine: 1) Greška jednog izlaznog neurona za p-ti uzorak iz skupa za trening ε p = y p- d p (2) Promena težine veze proporcionalno grešci (3) Ukupna srednja kvadratna greška mreže za sve uzorke p iz skupa za trening (kriterijum za zaustavljanje treninga – mreža je naučila kada je greška svedena na prihvatljivu meru)

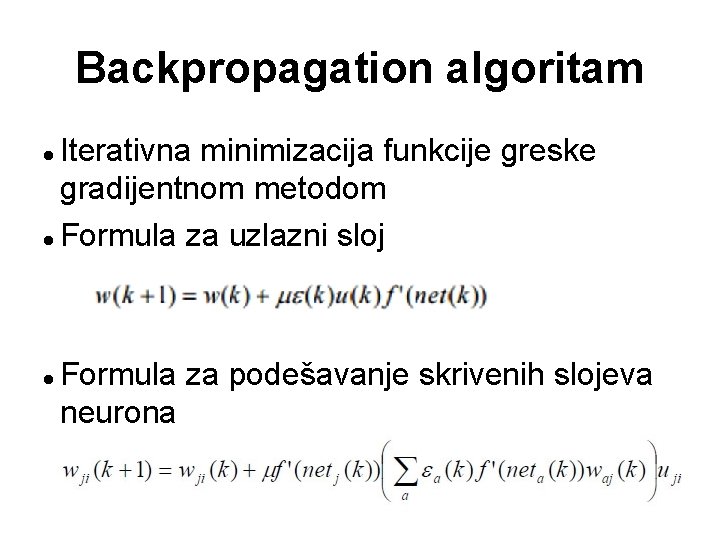

Backpropagation algoritam Iterativna minimizacija funkcije greske gradijentnom metodom Formula za uzlazni sloj Formula za podešavanje skrivenih slojeva neurona

Parametri backpropagation algoritam Max error Max iterations Learning rate Momentum Batch mode, mini-batch

Backpropagation algoritam Problem lokalnog minimuma Problem saturacije gradijenta Problem nestajućih gradijenta Zaustavljanje algoritma: – broj iteracija, – greška ispod definisanog min, – spora konvergencija – rano zaustavljanje - greška za određeni data set, izbegavanje overfittinga

Varijacije backpropagation algoritma Standardni backpropagation Momentum Quick propagation Resilient propagation Delta bar delta I razni drugi

Procedura rešavanje problema pomoću NM Prikupljanje i priprema podataka (normalizacija, filtriranje, . . . ) Trening mreže Testiranje mreže Određivanje optimalnih parametara mreže i treninga eksperimentalnim putem (broj neurona, broj slojeva neurona, parametri algoritma za učenje, podaci za trening) Trening, test i validation set

Priprema podataka Filtriranje Normalizacija, standardizacija Redukcija dimenzionalnosti (PCA) Uspeh rešavanja u potpunosti zavisi od podataka koji se koriste za trening mreže Voditi računa o teorijskoj opravdansti – reprezentativnosti korišćenih podataka za određeni problem. Ovo je vrlo specifično u zavisnosti od problema koji se rešava. Npr. Za klasifikaciju je balansiranost data seta čest problem

Trening mreže Određivanje optimalnih parametara mreže i algoritma za trening Broj skrivenih slojeva i broj neurona u svakom sloju (više ne znači bolje, cilj je imati što manje) Learning rate i momentum Dinamičko podešavanje parametara Validacija parametara (sa probnim skupom) Trening i test set Pretreniravanje i generalizacija

PROBLEMI U PRIMENI VNM • Nedostatak semantike u strukturi • Da li je neki problem uopšte rešiv sa NM? • Problemi sa određivanjem arhitekture, parametara algoritma za učenje i treningom za određenu primenu • Plastičnost / stabilnost

Rešenja za pojedine probleme napredne neuronske mreže • Kombinacija NM, fuzzy logike i genetskih algoritama – computational intelligence • Fuzzy logika uvodi semantiku i strukturu • Gen. algoritmi pomažu u odredjivanju i optimizaciji parametara mreže i algoritma za učenje

Linkovi Aplikacioni okvir za razvoj neuronskih mreža, Zoran Ševarac – diplomski rad http: //ai. fon. bg. ac. rs/wpcontent/uploads/2015/07/Diplomski-rad. Aplikacioni-okvir-za-razvoj-neuronskihmreza-Zoran-Sevarac. pdf