FILTRI ANALOGICI E DIGITALI Modulo del Corso Integrato

- Slides: 23

FILTRI ANALOGICI E DIGITALI Modulo del Corso Integrato di: Progetto di Circuiti per il Trattamento dei Segnali

SISTEMI ADATTATIVI

SA-1 INTRODUCONO UN MODO INNOVATIVO DI CONCEPIRE IL PROGETTO: OUTPUT DESIDERATO SISTEMA ADATTATIVO OUTPUT MODIFICA DEI PARAMETRI ALGORITMO DI TRAINING ERRORE FUNZIONE COSTO INPUT piuttosto che costruire il sistema con specifiche stabilite a priori, i dati esterni al sistema vengono utilizzati per settare i parametri TRA I DIVERSI SISTEMI ADATTATIVI VI SONO LE RETI NEURALI: nelle reti neurali supervisionate l’addestramento è condotto utilizzando un training set spesso costituito dalle coppie di valori d’ingresso e di uscita desiderata

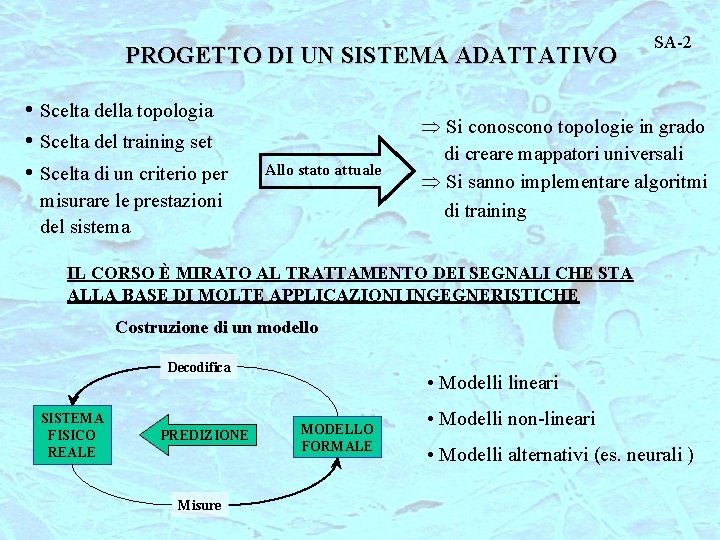

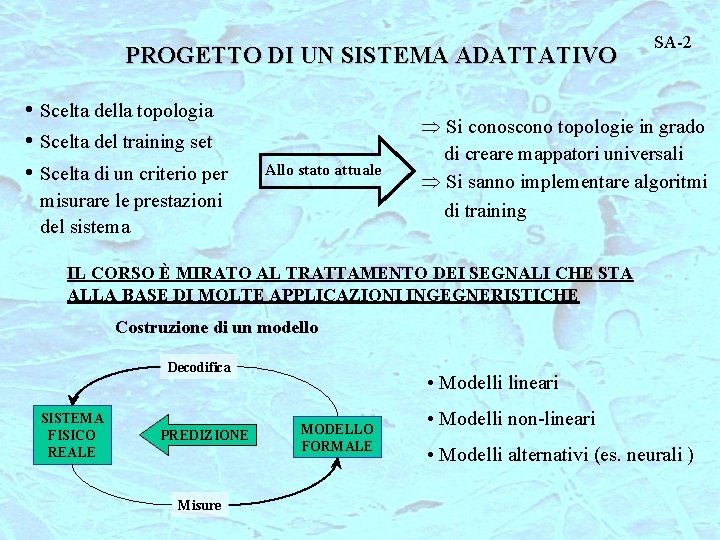

PROGETTO DI UN SISTEMA ADATTATIVO • Scelta della topologia • Scelta del training set • Scelta di un criterio per Allo stato attuale misurare le prestazioni del sistema SA-2 Þ Si conoscono topologie in grado di creare mappatori universali Þ Si sanno implementare algoritmi di training IL CORSO È MIRATO AL TRATTAMENTO DEI SEGNALI CHE STA ALLA BASE DI MOLTE APPLICAZIONI INGEGNERISTICHE Costruzione di un modello Decodifica SISTEMA FISICO REALE PREDIZIONE Misure • Modelli lineari MODELLO FORMALE • Modelli non-lineari • Modelli alternativi (es. neurali )

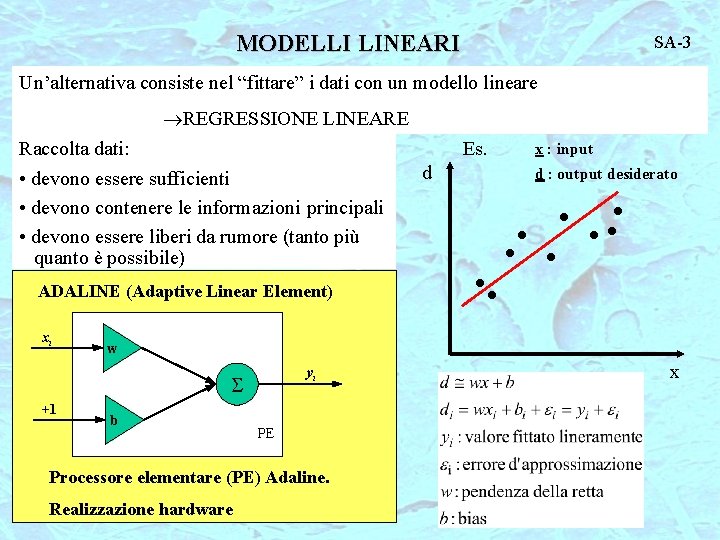

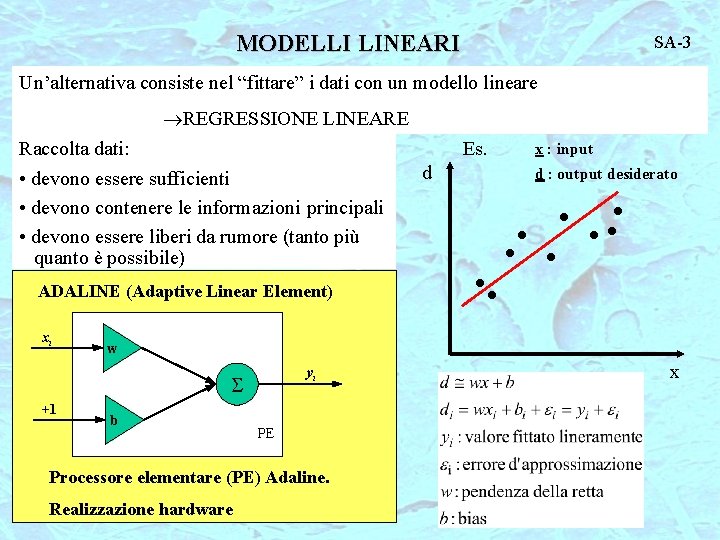

MODELLI LINEARI SA-3 Un’alternativa consiste nel “fittare” i dati con un modello lineare REGRESSIONE LINEARE Raccolta dati: Es. • devono essere sufficienti • devono contenere le informazioni principali • devono essere liberi da rumore (tanto più quanto è possibile) ADALINE (Adaptive Linear Element) xi d d : output desiderato • • • w yi S +1 x : input b PE Processore elementare (PE) Adaline. Realizzazione hardware x

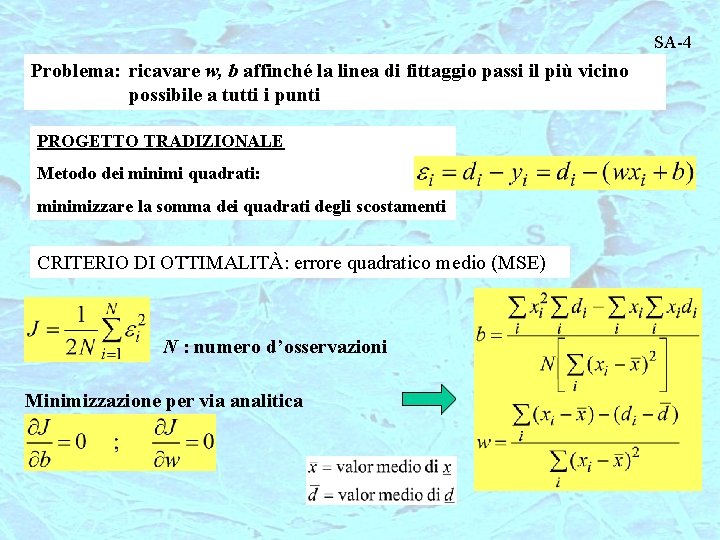

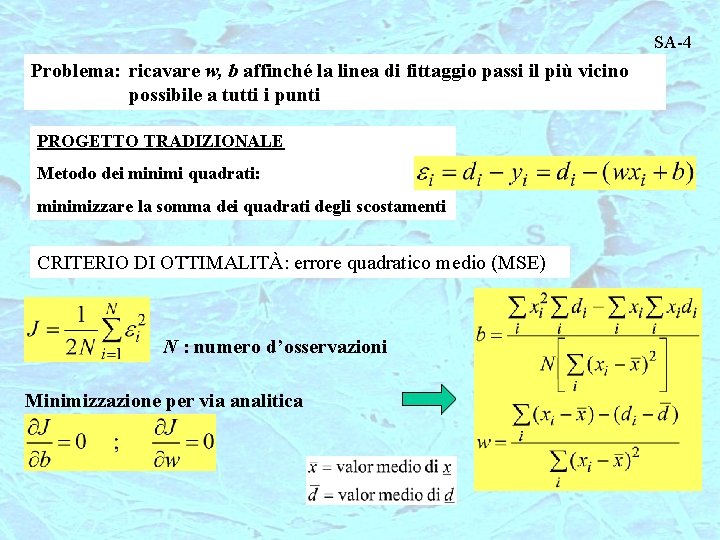

SA-4 Problema: ricavare w, b affinché la linea di fittaggio passi il più vicino possibile a tutti i punti PROGETTO TRADIZIONALE Metodo dei minimi quadrati: minimizzare la somma dei quadrati degli scostamenti CRITERIO DI OTTIMALITÀ: errore quadratico medio (MSE) N : numero d’osservazioni Minimizzazione per via analitica

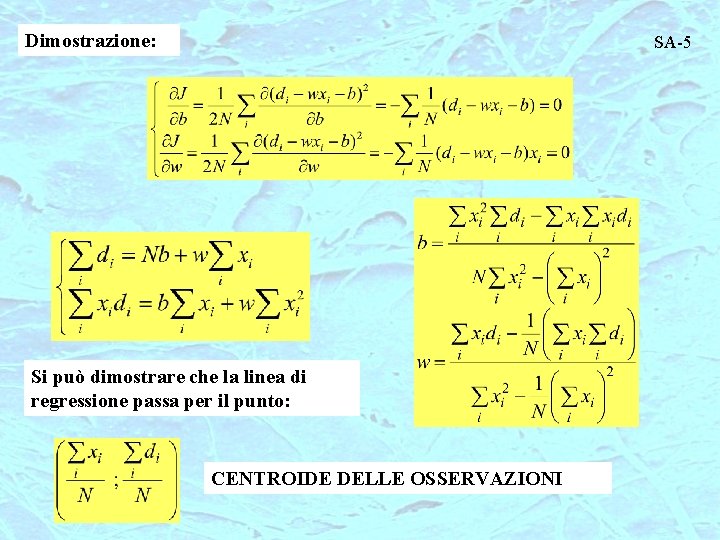

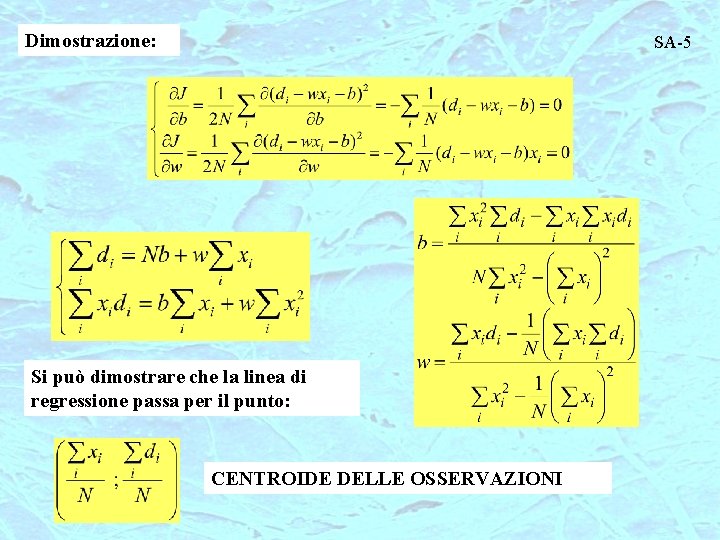

Dimostrazione: SA-5 Si può dimostrare che la linea di regressione passa per il punto: CENTROIDE DELLE OSSERVAZIONI

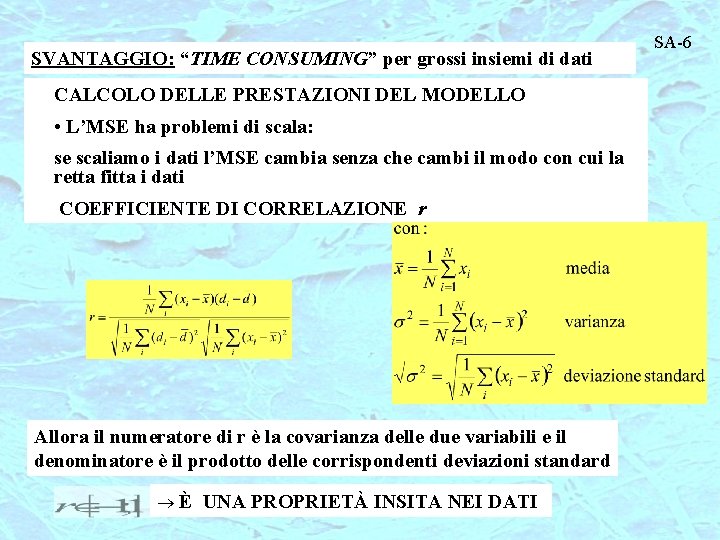

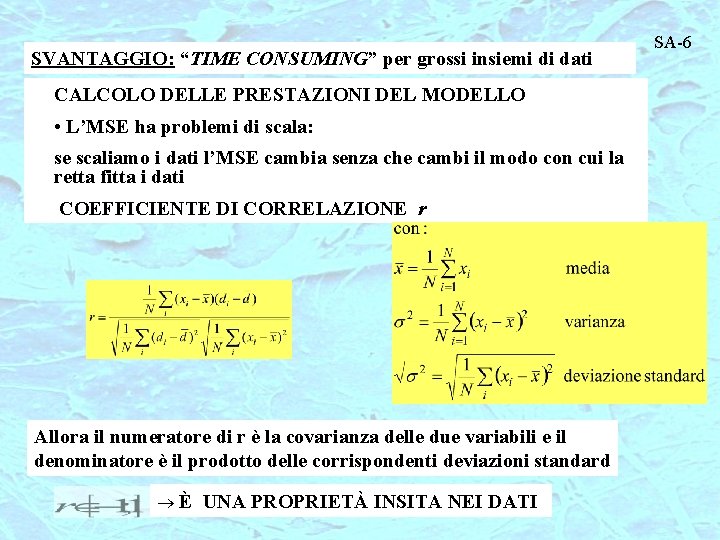

SVANTAGGIO: “TIME CONSUMING” per grossi insiemi di dati CALCOLO DELLE PRESTAZIONI DEL MODELLO • L’MSE ha problemi di scala: se scaliamo i dati l’MSE cambia senza che cambi il modo con cui la retta fitta i dati COEFFICIENTE DI CORRELAZIONE r Allora il numeratore di r è la covarianza delle due variabili e il denominatore è il prodotto delle corrispondenti deviazioni standard È UNA PROPRIETÀ INSITA NEI DATI SA-6

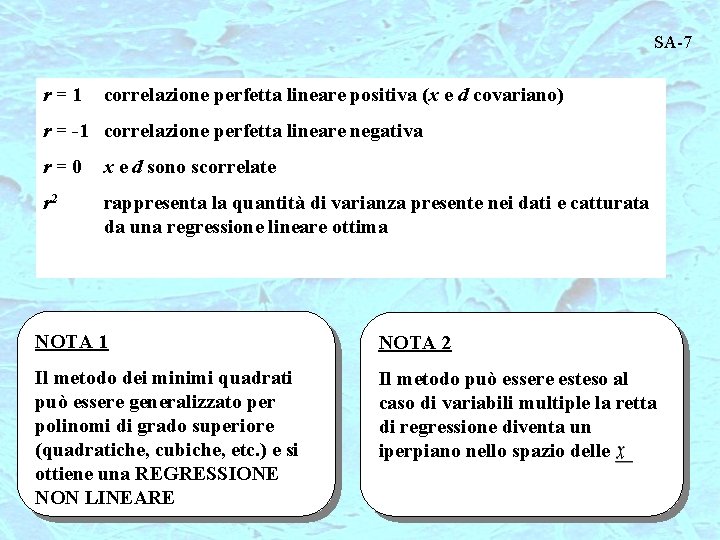

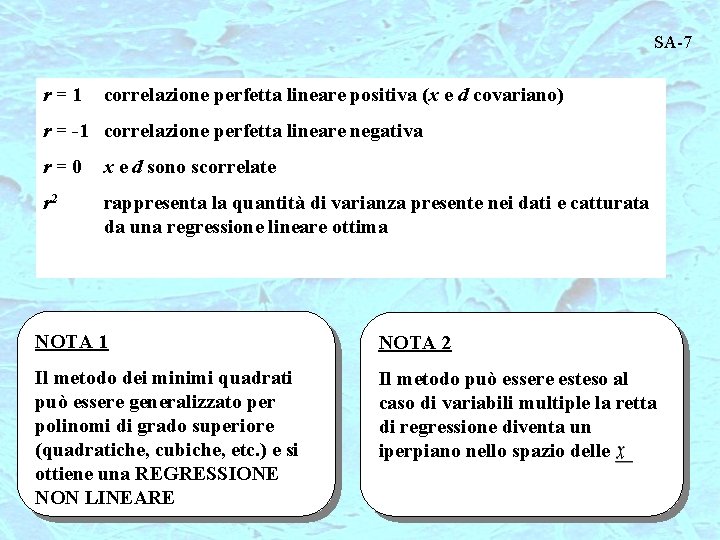

SA-7 r=1 correlazione perfetta lineare positiva (x e d covariano) r = -1 correlazione perfetta lineare negativa r=0 x e d sono scorrelate r 2 rappresenta la quantità di varianza presente nei dati e catturata da una regressione lineare ottima NOTA 1 NOTA 2 Il metodo dei minimi quadrati può essere generalizzato per polinomi di grado superiore (quadratiche, cubiche, etc. ) e si ottiene una REGRESSIONE NON LINEARE Il metodo può essere esteso al caso di variabili multiple la retta di regressione diventa un iperpiano nello spazio delle

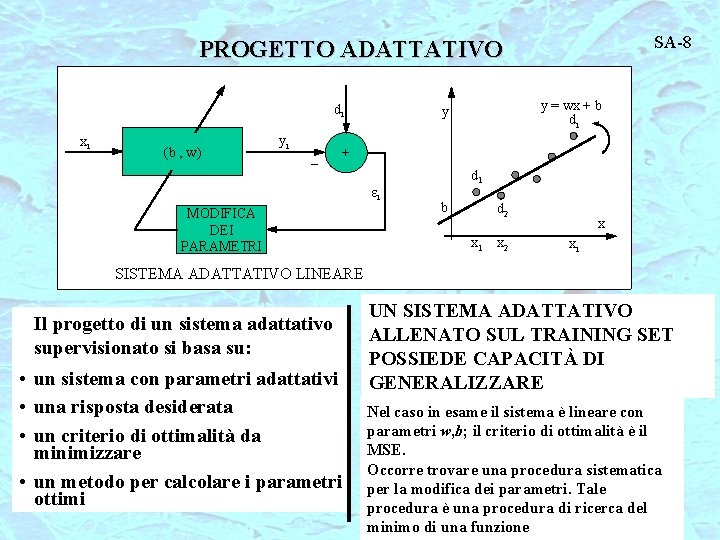

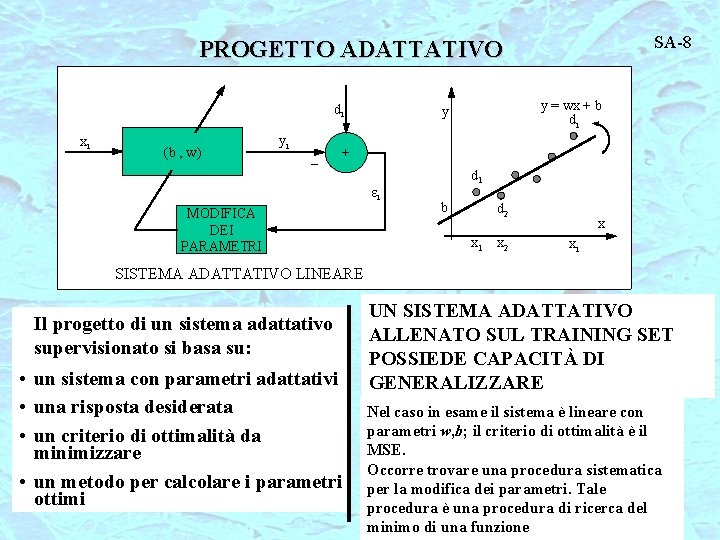

SA-8 PROGETTO ADATTATIVO di (b , w) yi _ + xi y = wx + b di y ei MODIFICA DEI PARAMETRI d 1 b d 2 x 1 x 2 x xi SISTEMA ADATTATIVO LINEARE Il progetto di un sistema adattativo supervisionato si basa su: • un sistema con parametri adattativi • una risposta desiderata • un criterio di ottimalità da minimizzare • un metodo per calcolare i parametri ottimi UN SISTEMA ADATTATIVO ALLENATO SUL TRAINING SET POSSIEDE CAPACITÀ DI GENERALIZZARE Nel caso in esame il sistema è lineare con parametri w, b; il criterio di ottimalità è il MSE. Occorre trovare una procedura sistematica per la modifica dei parametri. Tale procedura è una procedura di ricerca del minimo di una funzione

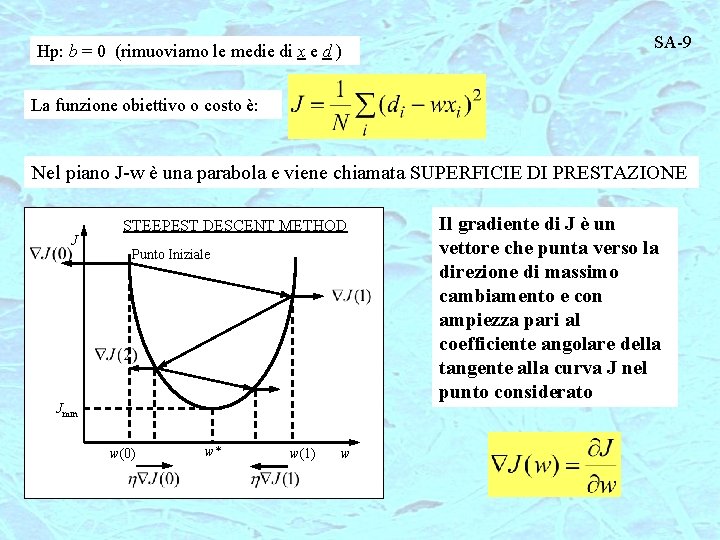

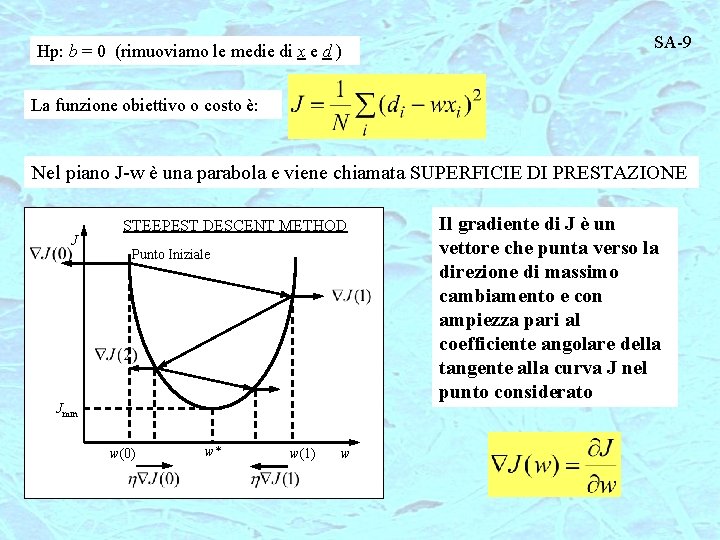

Hp: b = 0 (rimuoviamo le medie di x e d ) SA-9 La funzione obiettivo o costo è: Nel piano J-w è una parabola e viene chiamata SUPERFICIE DI PRESTAZIONE J STEEPEST DESCENT METHOD Punto Iniziale Jmin w(0) w* w(1) w Il gradiente di J è un vettore che punta verso la direzione di massimo cambiamento e con ampiezza pari al coefficiente angolare della tangente alla curva J nel punto considerato

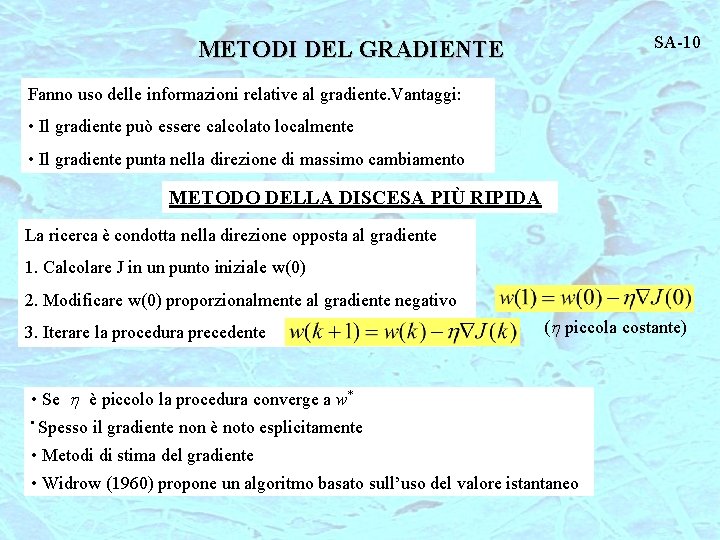

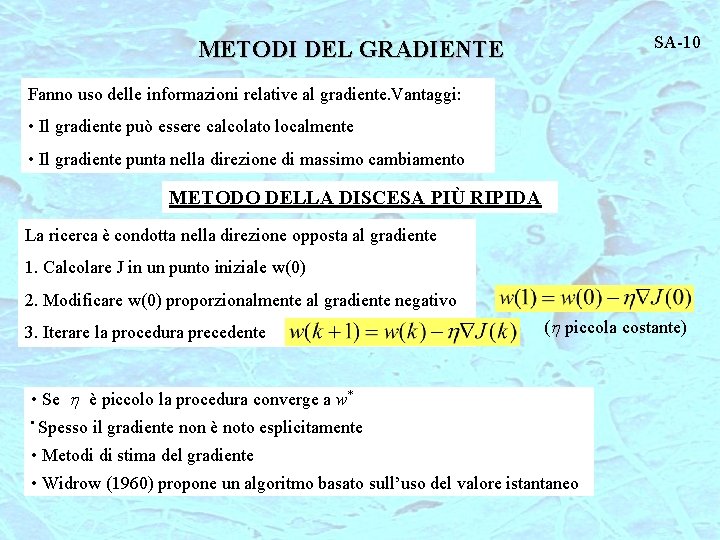

SA-10 METODI DEL GRADIENTE Fanno uso delle informazioni relative al gradiente. Vantaggi: • Il gradiente può essere calcolato localmente • Il gradiente punta nella direzione di massimo cambiamento METODO DELLA DISCESA PIÙ RIPIDA La ricerca è condotta nella direzione opposta al gradiente 1. Calcolare J in un punto iniziale w(0) 2. Modificare w(0) proporzionalmente al gradiente negativo 3. Iterare la procedura precedente (h piccola costante) • Se h è piccolo la procedura converge a w* • Spesso il gradiente non è noto esplicitamente • Metodi di stima del gradiente • Widrow (1960) propone un algoritmo basato sull’uso del valore istantaneo

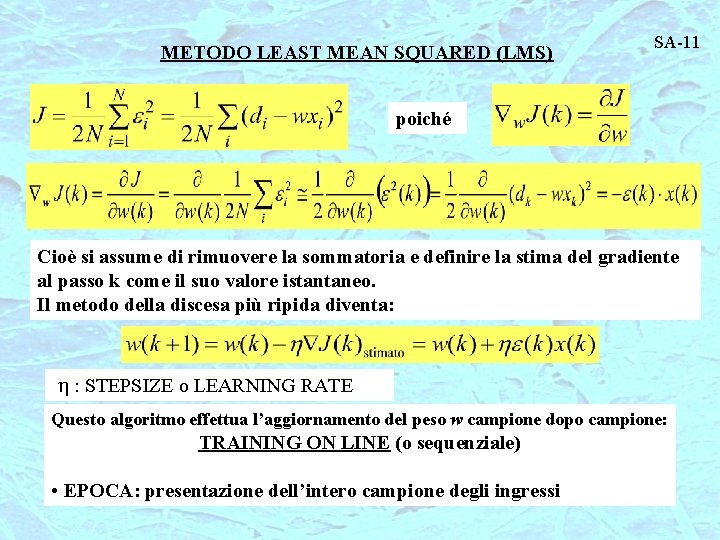

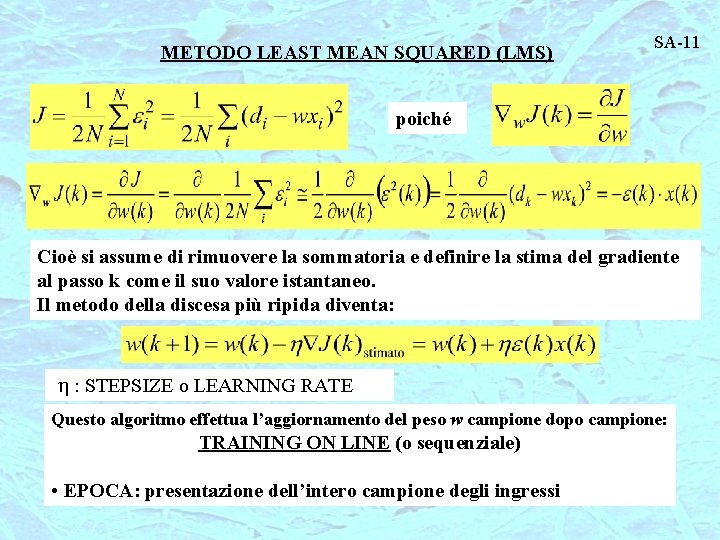

METODO LEAST MEAN SQUARED (LMS) SA-11 poiché Cioè si assume di rimuovere la sommatoria e definire la stima del gradiente al passo k come il suo valore istantaneo. Il metodo della discesa più ripida diventa: h : STEPSIZE o LEARNING RATE Questo algoritmo effettua l’aggiornamento del peso w campione dopo campione: TRAINING ON LINE (o sequenziale) • EPOCA: presentazione dell’intero campione degli ingressi

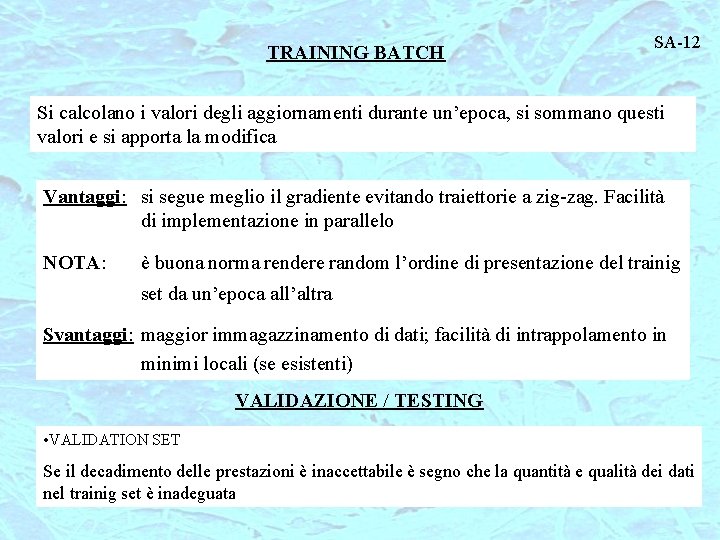

TRAINING BATCH SA-12 Si calcolano i valori degli aggiornamenti durante un’epoca, si sommano questi valori e si apporta la modifica Vantaggi: si segue meglio il gradiente evitando traiettorie a zig-zag. Facilità di implementazione in parallelo NOTA: è buona norma rendere random l’ordine di presentazione del trainig set da un’epoca all’altra Svantaggi: maggior immagazzinamento di dati; facilità di intrappolamento in minimi locali (se esistenti) VALIDAZIONE / TESTING • VALIDATION SET Se il decadimento delle prestazioni è inaccettabile è segno che la quantità e qualità dei dati nel trainig set è inadeguata

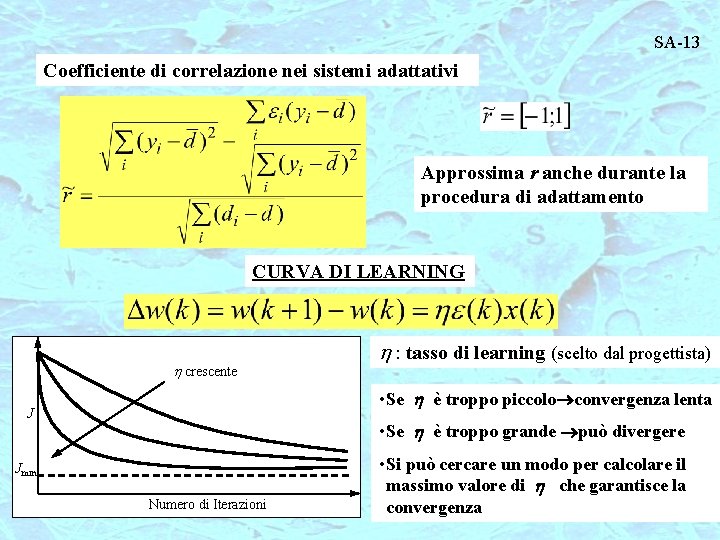

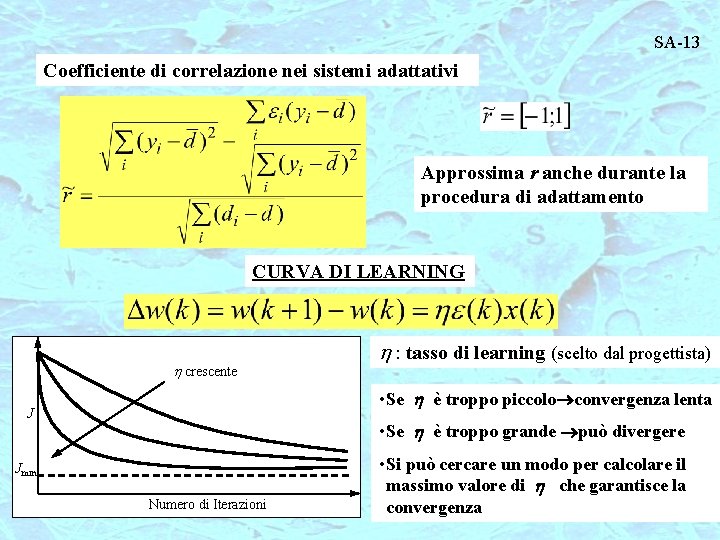

SA-13 Coefficiente di correlazione nei sistemi adattativi Approssima r anche durante la procedura di adattamento CURVA DI LEARNING h crescente h : tasso di learning (scelto dal progettista) • Se h è troppo piccolo convergenza lenta J • Se h è troppo grande può divergere Jmin Numero di Iterazioni • Si può cercare un modo per calcolare il massimo valore di h che garantisce la convergenza

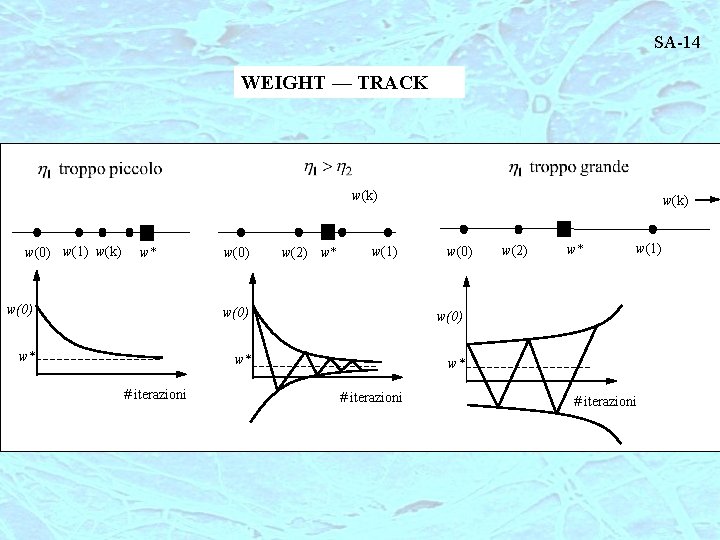

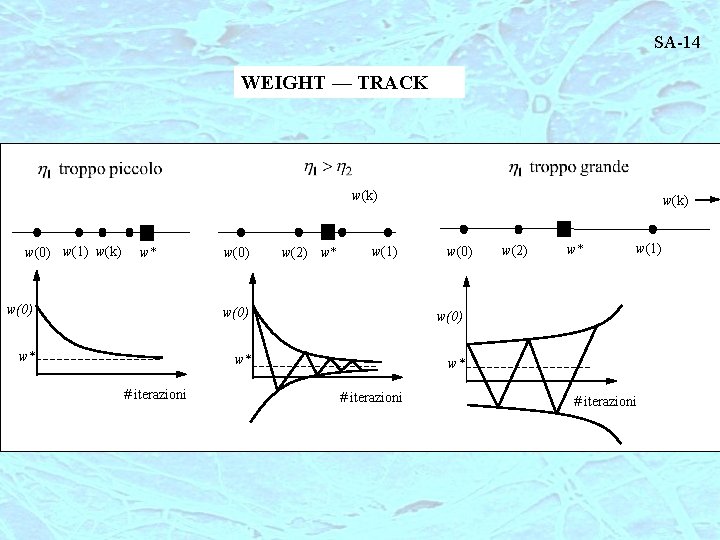

SA-14 WEIGHT — TRACK w(k) w(0) w(1) w(k) w* w(0) w(2) w* w(1) w(k) w(0) w* w* w* # iterazioni w(2) w* w(1) # iterazioni

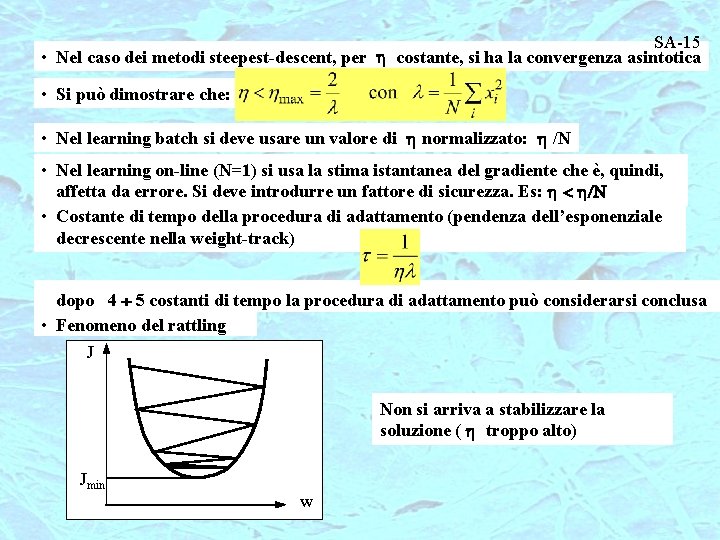

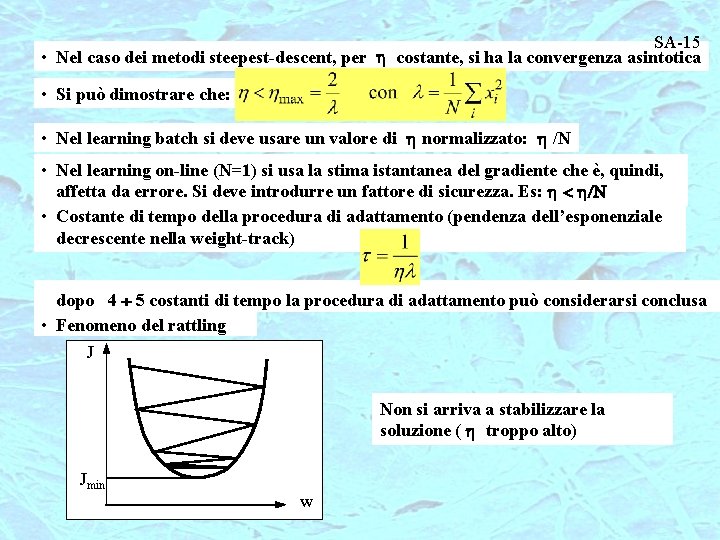

SA-15 • Nel caso dei metodi steepest-descent, per h costante, si ha la convergenza asintotica • Si può dimostrare che: • Nel learning batch si deve usare un valore di h normalizzato: h /N • Nel learning on-line (N=1) si usa la stima istantanea del gradiente che è, quindi, affetta da errore. Si deve introdurre un fattore di sicurezza. Es: h < h/N • Costante di tempo della procedura di adattamento (pendenza dell’esponenziale decrescente nella weight-track) dopo 4 5 costanti di tempo la procedura di adattamento può considerarsi conclusa • Fenomeno del rattling J Non si arriva a stabilizzare la soluzione ( h troppo alto) Jmin w

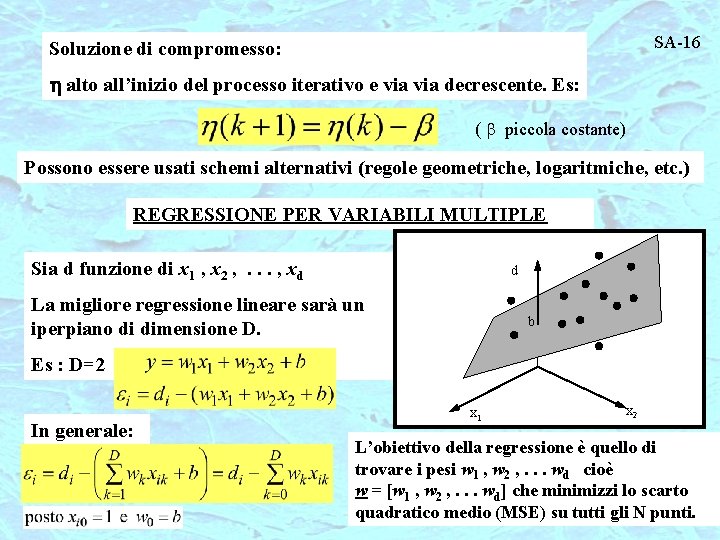

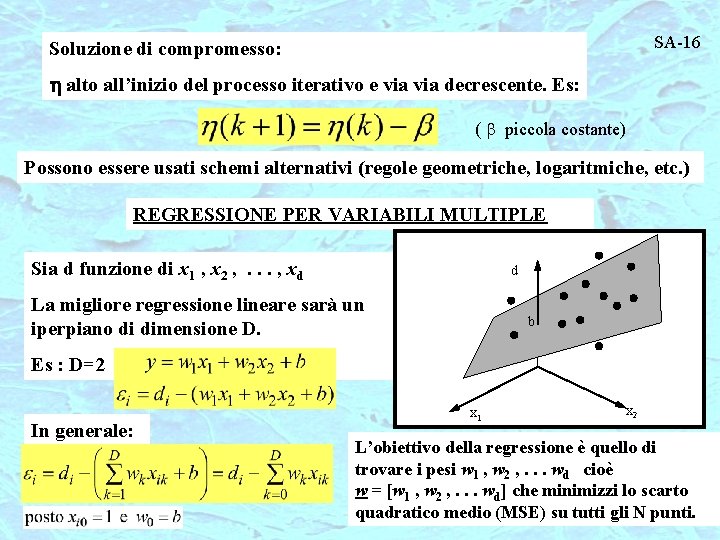

SA-16 Soluzione di compromesso: h alto all’inizio del processo iterativo e via decrescente. Es: ( b piccola costante) Possono essere usati schemi alternativi (regole geometriche, logaritmiche, etc. ) REGRESSIONE PER VARIABILI MULTIPLE Sia d funzione di x 1 , x 2 , . . . , xd d La migliore regressione lineare sarà un iperpiano di dimensione D. b Es : D=2 In generale: x 1 x 2 L’obiettivo della regressione è quello di trovare i pesi w 1 , w 2 , . . . wd cioè w = [w 1 , w 2 , . . . wd] che minimizzi lo scarto quadratico medio (MSE) su tutti gli N punti.

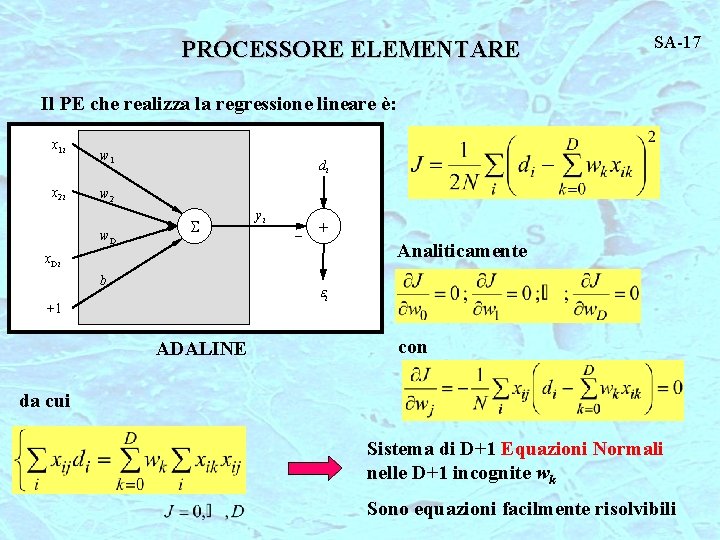

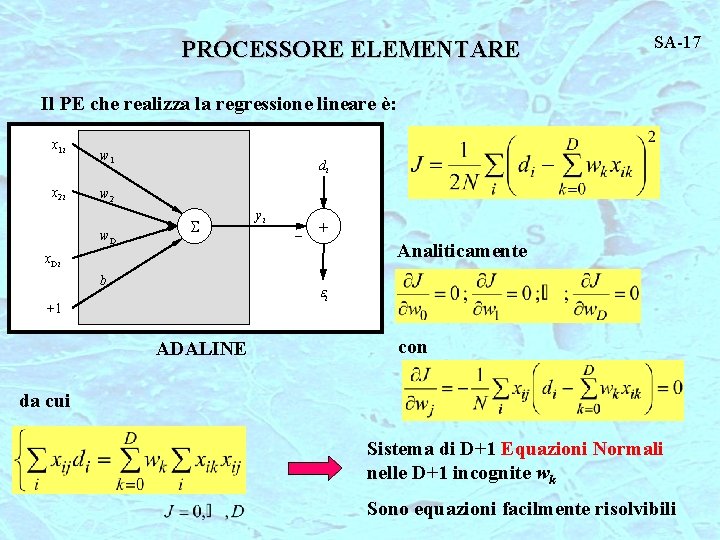

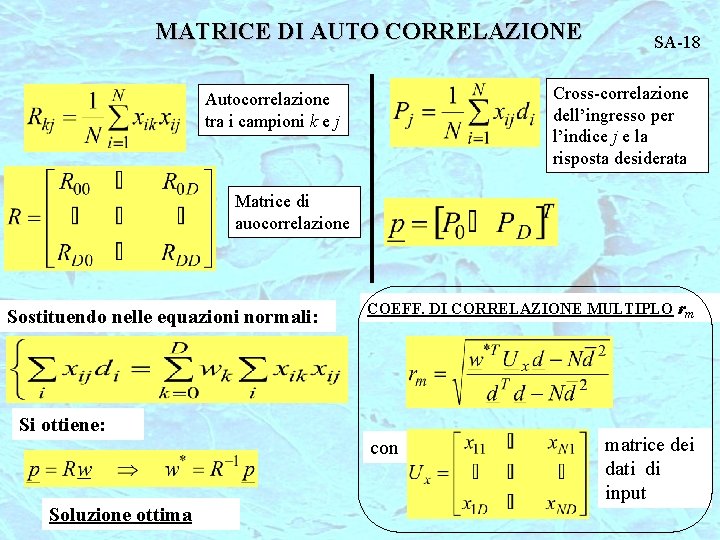

PROCESSORE ELEMENTARE SA-17 Il PE che realizza la regressione lineare è: x 1 i x 2 i w 1 di w 2 w. D S yi _ + Analiticamente x. Di b ei +1 ADALINE con da cui Sistema di D+1 Equazioni Normali nelle D+1 incognite wk Sono equazioni facilmente risolvibili

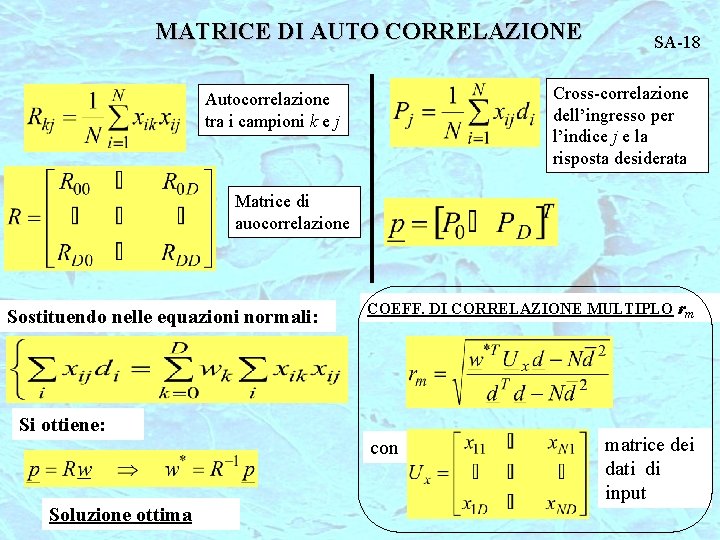

MATRICE DI AUTO CORRELAZIONE SA-18 Cross-correlazione dell’ingresso per l’indice j e la risposta desiderata Autocorrelazione tra i campioni k e j Matrice di auocorrelazione Sostituendo nelle equazioni normali: COEFF. DI CORRELAZIONE MULTIPLO rm Si ottiene: con Soluzione ottima matrice dei dati di input

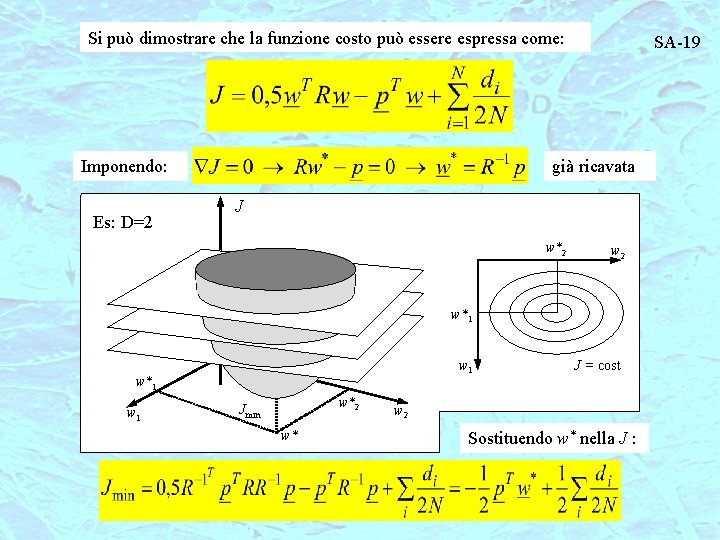

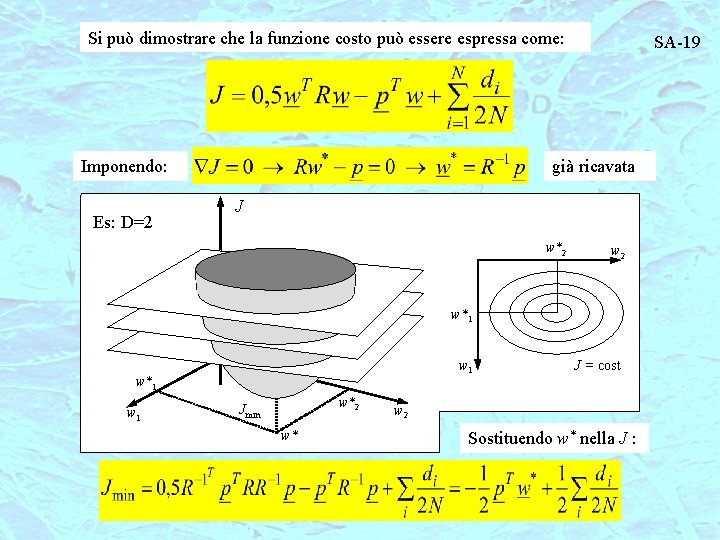

Si può dimostrare che la funzione costo può essere espressa come: Imponendo: Es: D=2 SA-19 già ricavata J w*2 w 2 w*1 w 1 w*2 Jmin w* J = cost w 2 Sostituendo w* nella J :

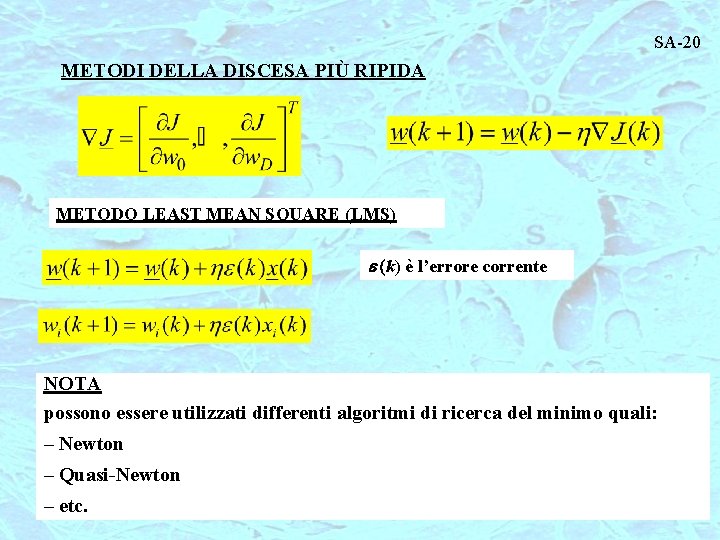

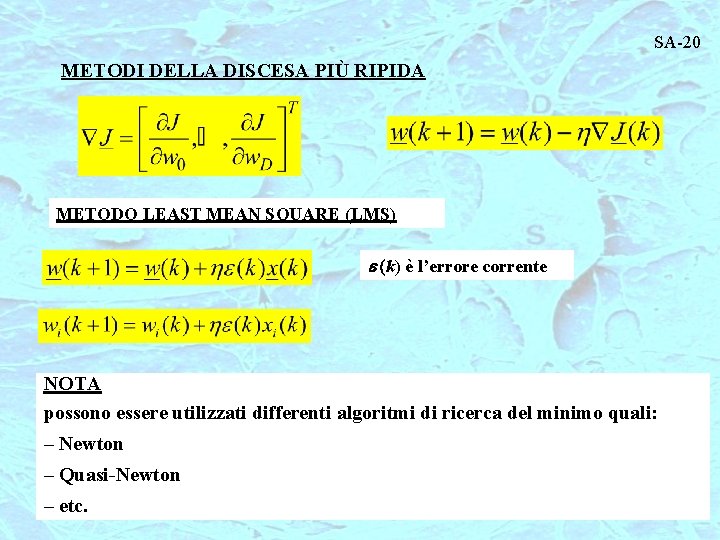

SA-20 METODI DELLA DISCESA PIÙ RIPIDA METODO LEAST MEAN SQUARE (LMS) e (k) è l’errore corrente NOTA possono essere utilizzati differenti algoritmi di ricerca del minimo quali: – Newton – Quasi-Newton – etc.

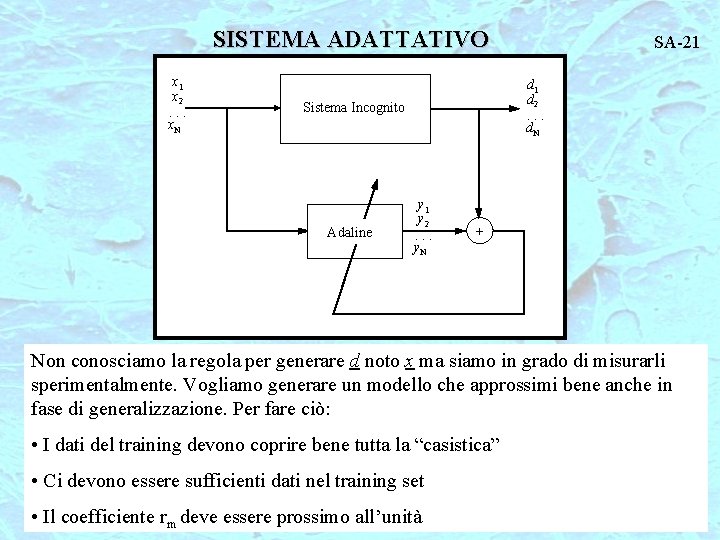

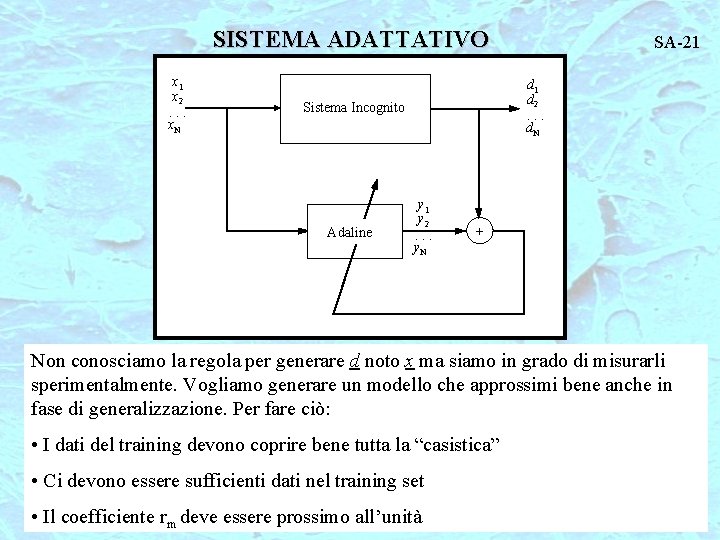

SISTEMA ADATTATIVO x 1 x 2. . . x. N d 1 d 2. . . d. N Sistema Incognito Adaline SA-21 y 2. . . y. N + Non conosciamo la regola per generare d noto x ma siamo in grado di misurarli sperimentalmente. Vogliamo generare un modello che approssimi bene anche in fase di generalizzazione. Per fare ciò: • I dati del training devono coprire bene tutta la “casistica” • Ci devono essere sufficienti dati nel training set • Il coefficiente rm deve essere prossimo all’unità