Cadeias de Markov Andrei Andreyevich Markov 1856 Ryazan

- Slides: 10

Cadeias de Markov Andrei Andreyevich Markov (*1856, Ryazan, Russia; 1922, São Petersburgo, Russia). Fernando Nogueira Cadeias de Markov 1

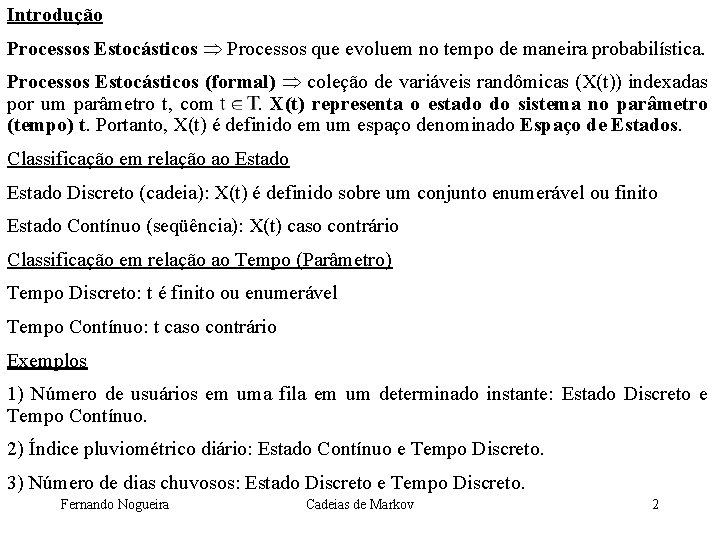

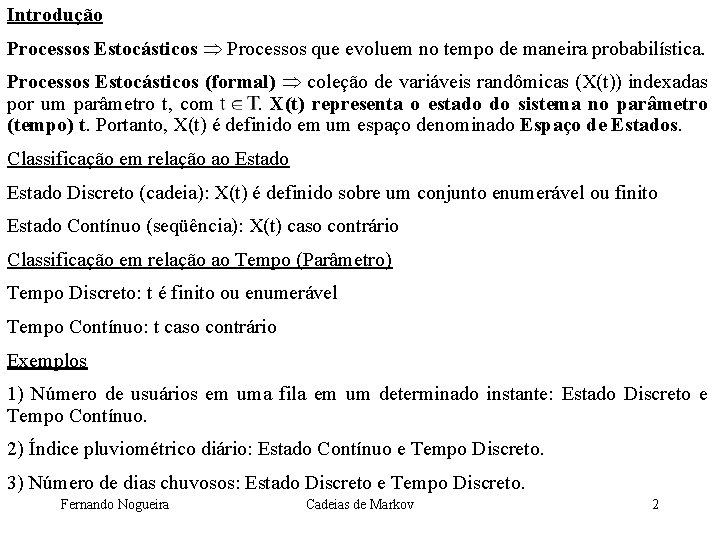

Introdução Processos Estocásticos Processos que evoluem no tempo de maneira probabilística. Processos Estocásticos (formal) coleção de variáveis randômicas (X(t)) indexadas por um parâmetro t, com . X(t) representa o estado do sistema no parâmetro (tempo) t. Portanto, X(t) é definido em um espaço denominado Espaço de Estados. Classificação em relação ao Estado Discreto (cadeia): X(t) é definido sobre um conjunto enumerável ou finito Estado Contínuo (seqüência): X(t) caso contrário Classificação em relação ao Tempo (Parâmetro) Tempo Discreto: t é finito ou enumerável Tempo Contínuo: t caso contrário Exemplos 1) Número de usuários em uma fila em um determinado instante: Estado Discreto e Tempo Contínuo. 2) Índice pluviométrico diário: Estado Contínuo e Tempo Discreto. 3) Número de dias chuvosos: Estado Discreto e Tempo Discreto. Fernando Nogueira Cadeias de Markov 2

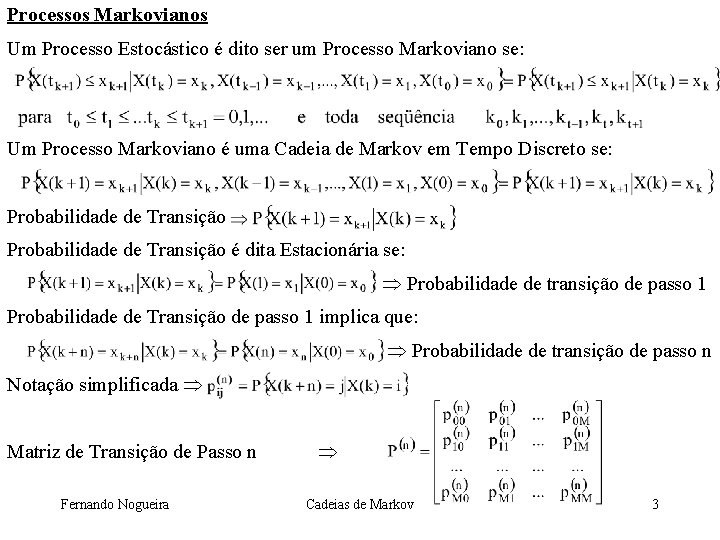

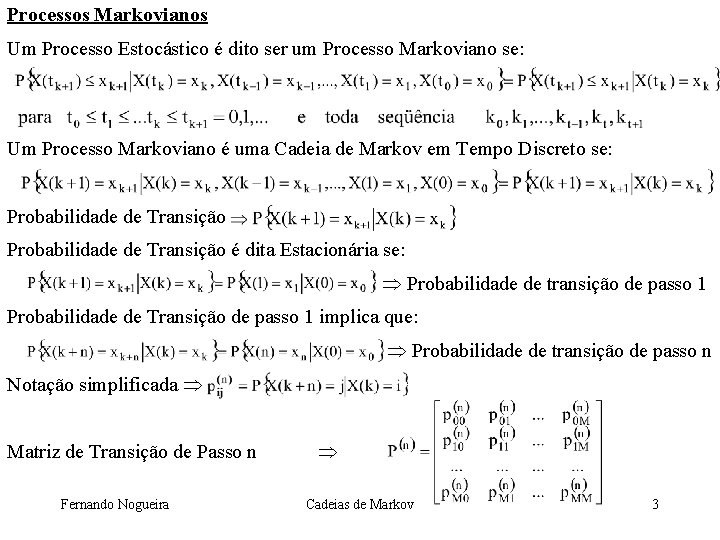

Processos Markovianos Um Processo Estocástico é dito ser um Processo Markoviano se: Um Processo Markoviano é uma Cadeia de Markov em Tempo Discreto se: Probabilidade de Transição é dita Estacionária se: Probabilidade de transição de passo 1 Probabilidade de Transição de passo 1 implica que: Probabilidade de transição de passo n Notação simplificada Matriz de Transição de Passo n Fernando Nogueira Cadeias de Markov 3

Exemplo 1 O estado no ano de 1993 do uso da terra em uma cidade de 50 Km 2 de área é: Vetor de Estados Vetor de Probabilidade de Estado Matriz de Transição O estado no ano de 1998 do uso da terra é Fernando Nogueira Cadeias de Markov 4

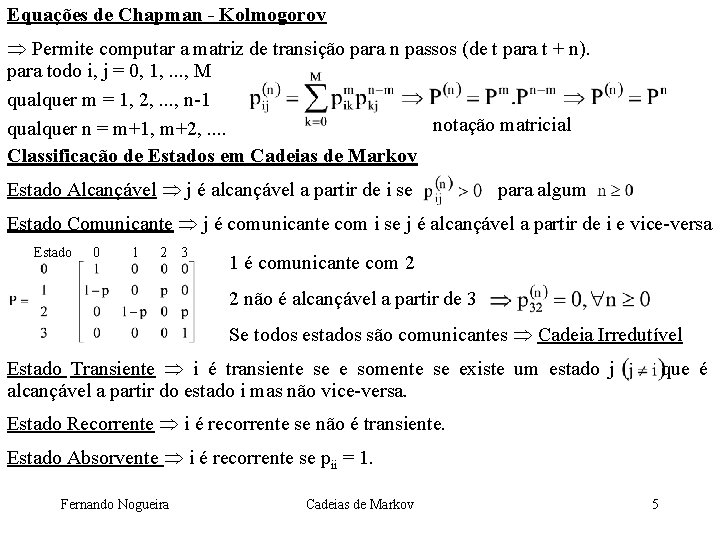

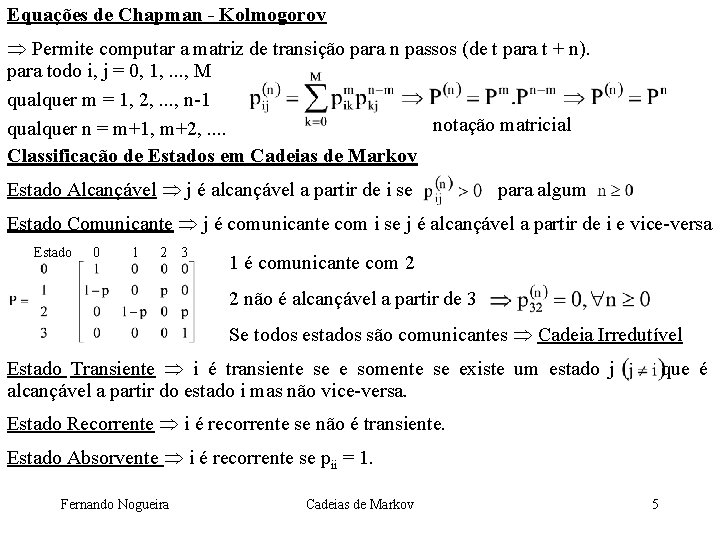

Equações de Chapman - Kolmogorov Permite computar a matriz de transição para n passos (de t para t + n). para todo i, j = 0, 1, . . . , M qualquer m = 1, 2, . . . , n-1 notação matricial qualquer n = m+1, m+2, . . Classificação de Estados em Cadeias de Markov Estado Alcançável j é alcançável a partir de i se para algum Estado Comunicante j é comunicante com i se j é alcançável a partir de i e vice-versa Estado 0 1 2 3 1 é comunicante com 2 2 não é alcançável a partir de 3 Se todos estados são comunicantes Cadeia Irredutível Estado Transiente i é transiente se e somente se existe um estado j que é alcançável a partir do estado i mas não vice-versa. Estado Recorrente i é recorrente se não é transiente. Estado Absorvente i é recorrente se pii = 1. Fernando Nogueira Cadeias de Markov 5

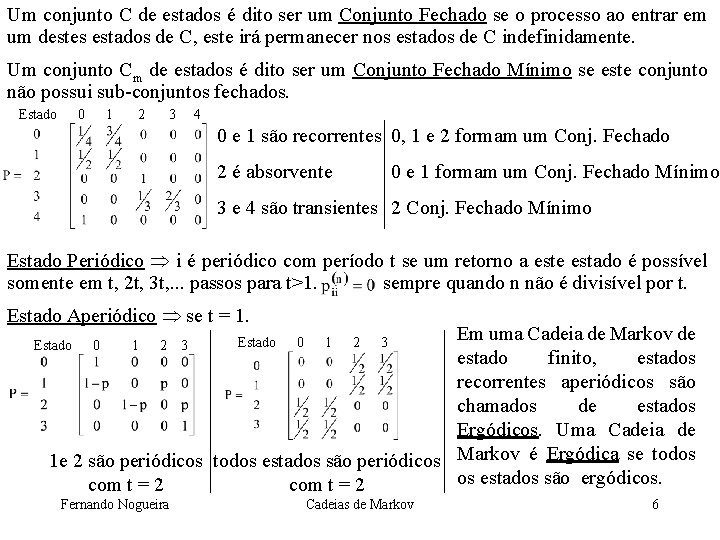

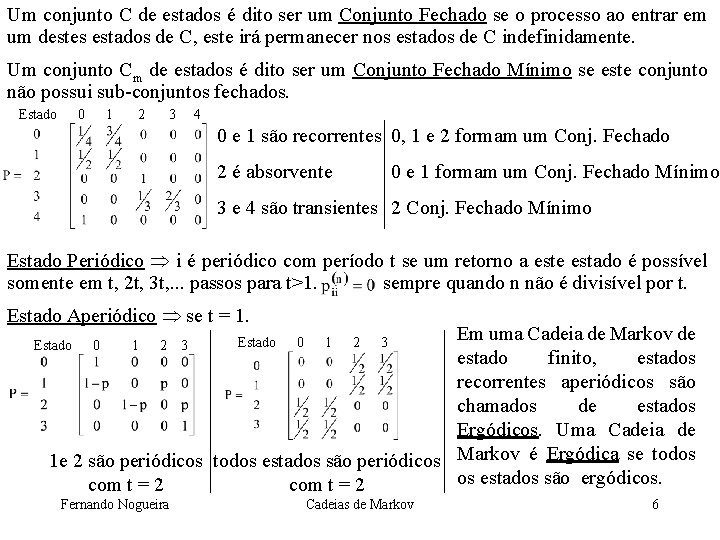

Um conjunto C de estados é dito ser um Conjunto Fechado se o processo ao entrar em um destes estados de C, este irá permanecer nos estados de C indefinidamente. Um conjunto Cm de estados é dito ser um Conjunto Fechado Mínimo se este conjunto não possui sub-conjuntos fechados. Estado 0 1 2 3 4 0 e 1 são recorrentes 0, 1 e 2 formam um Conj. Fechado 2 é absorvente 0 e 1 formam um Conj. Fechado Mínimo 3 e 4 são transientes 2 Conj. Fechado Mínimo Estado Periódico i é periódico com período t se um retorno a este estado é possível somente em t, 2 t, 3 t, . . . passos para t>1. sempre quando n não é divisível por t. Estado Aperiódico se t = 1. Em uma Cadeia de Markov de estado finito, estados recorrentes aperiódicos são chamados de estados Ergódicos. Uma Cadeia de 1 e 2 são periódicos todos estados são periódicos Markov é Ergódica se todos os estados são ergódicos. com t = 2 Estado 0 1 2 3 Fernando Nogueira Estado 0 1 2 3 Cadeias de Markov 6

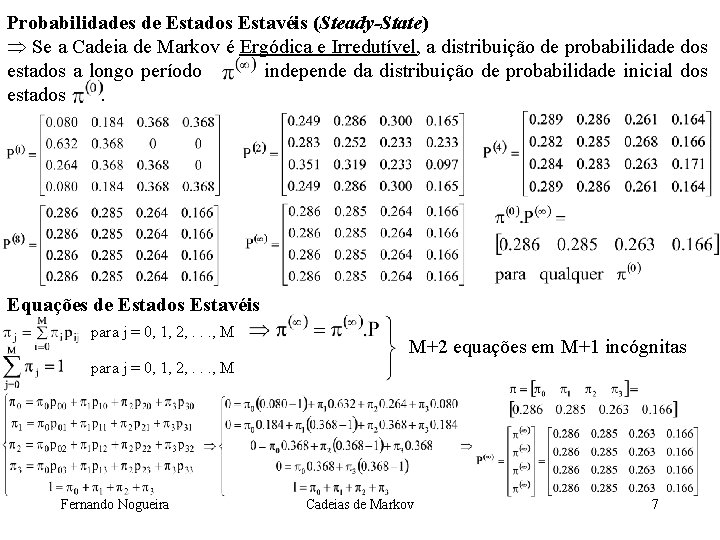

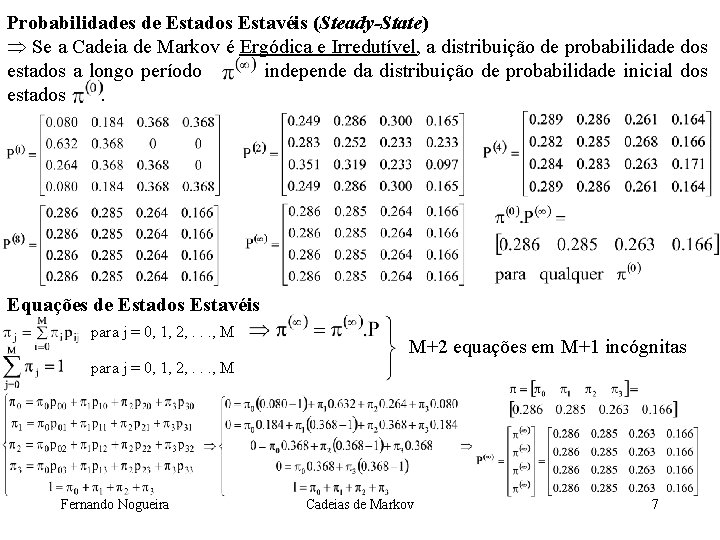

Probabilidades de Estados Estavéis (Steady-State) Se a Cadeia de Markov é Ergódica e Irredutível, a distribuição de probabilidade dos estados a longo período independe da distribuição de probabilidade inicial dos estados . Equações de Estados Estavéis para j = 0, 1, 2, . . . , M M+2 equações em M+1 incógnitas para j = 0, 1, 2, . . . , M Fernando Nogueira Cadeias de Markov 7

Custo Médio Esperado por Unidade de Tempo Se a Cadeia de Markov é Irredutível, o limite sempre irá existir. Seja C(Xt) uma função de custo (C( ) é uma variável randômica independente de t). O custo médio esperado por unidade de tempo é: Exemplo custo médio esperado do estoque por semana Fração do tempo em que o processo está no estado j Tempos de Primeira Passagem tempo demandado para o processo atingir o estado j a partir do estado i. Quando j = i Tempo de Recorrência para o estado i. Denominando a probabilidade do Tempo de Primeira Passagem a partir do estado i para o estado j ser n, pode-se escrever que: Exemplo: Probabilidade do Tempo de Primeira Passagem a partir do estado 3 (estoque cheio) para o estado 0 (estoque vazio) ser n: Fernando Nogueira Cadeias de Markov 8

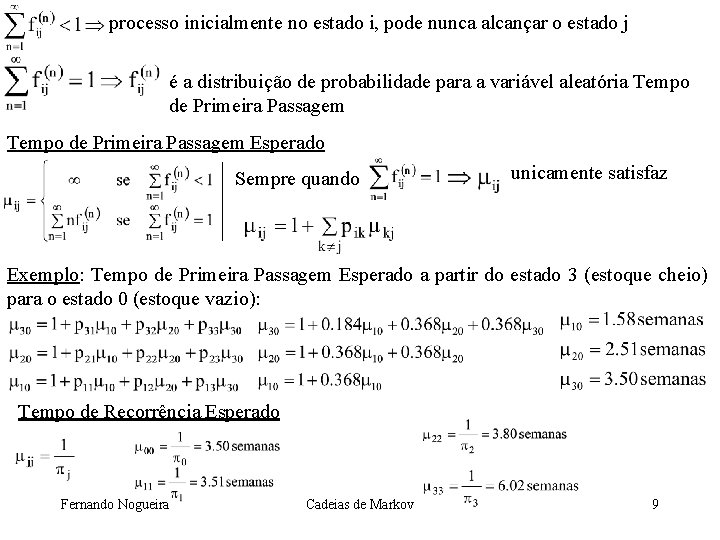

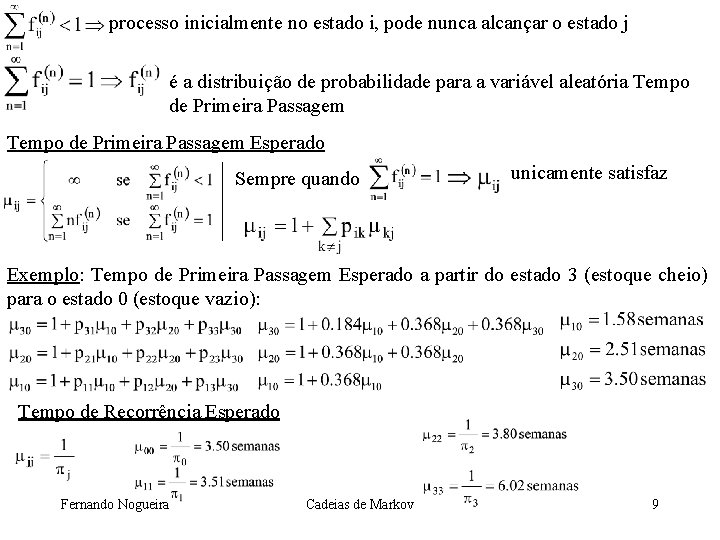

processo inicialmente no estado i, pode nunca alcançar o estado j é a distribuição de probabilidade para a variável aleatória Tempo de Primeira Passagem Esperado Sempre quando unicamente satisfaz Exemplo: Tempo de Primeira Passagem Esperado a partir do estado 3 (estoque cheio) para o estado 0 (estoque vazio): Tempo de Recorrência Esperado Fernando Nogueira Cadeias de Markov 9

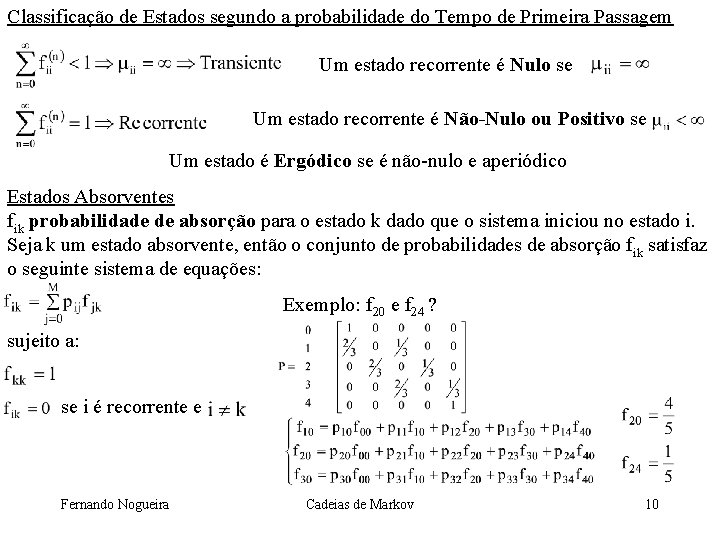

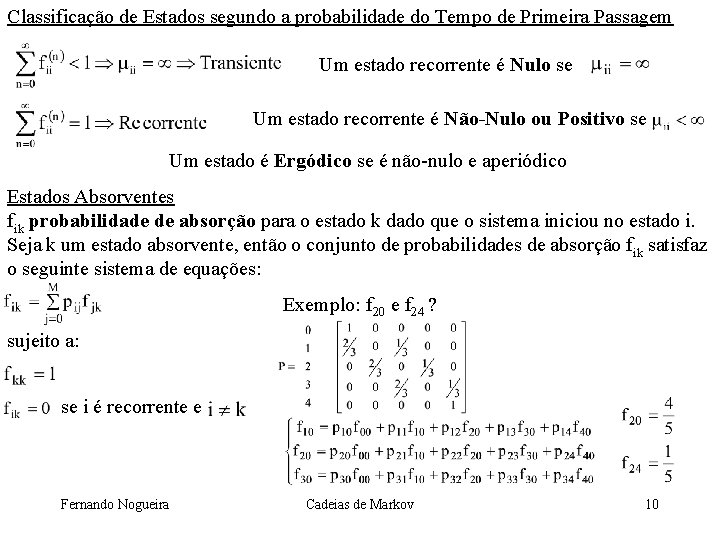

Classificação de Estados segundo a probabilidade do Tempo de Primeira Passagem Um estado recorrente é Nulo se Um estado recorrente é Não-Nulo ou Positivo se Um estado é Ergódico se é não-nulo e aperiódico Estados Absorventes fik probabilidade de absorção para o estado k dado que o sistema iniciou no estado i. Seja k um estado absorvente, então o conjunto de probabilidades de absorção fik satisfaz o seguinte sistema de equações: Exemplo: f 20 e f 24 ? sujeito a: se i é recorrente e Fernando Nogueira Cadeias de Markov 10