AMD 2017 Esercitazione 2 Giulio Costantini 1 Regressione

- Slides: 39

AMD 2017 - Esercitazione 2 Giulio Costantini 1

Regressione lineare semplice 2

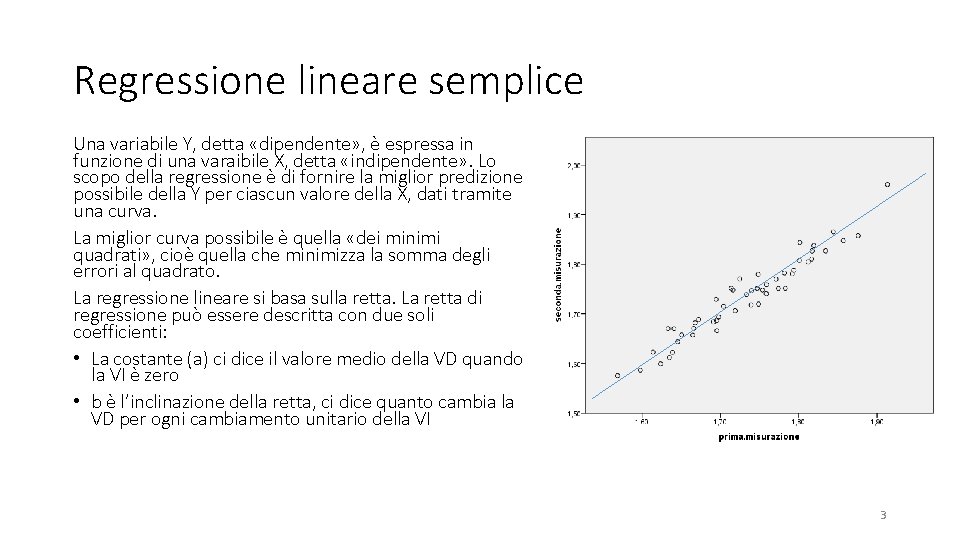

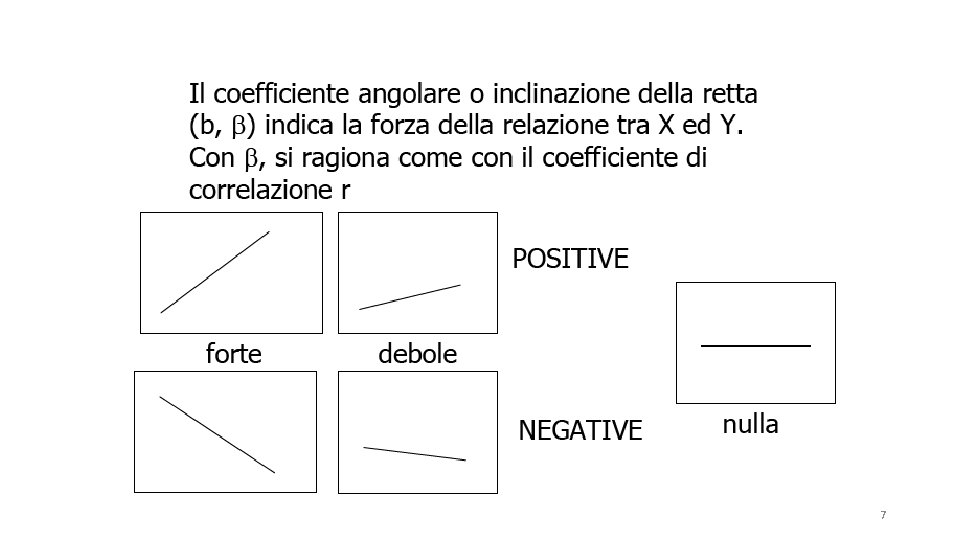

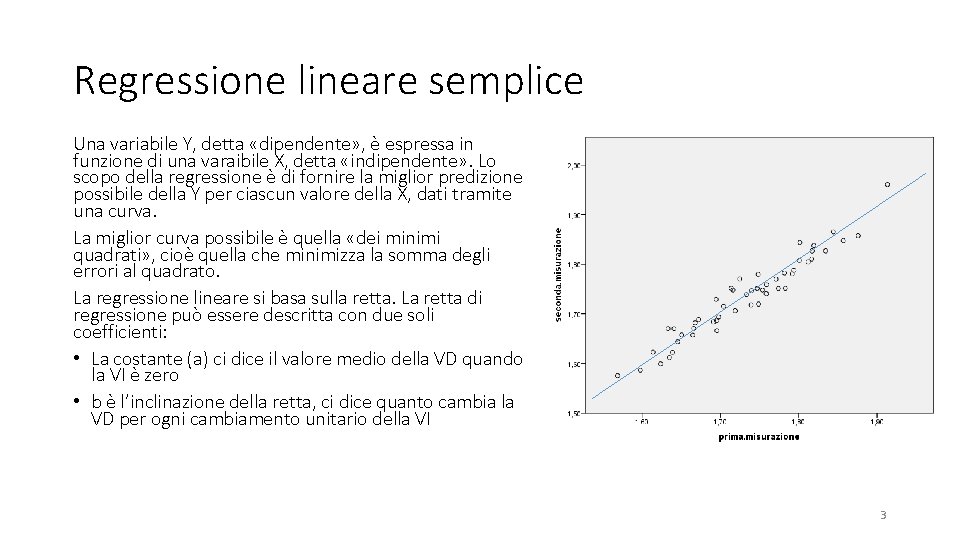

Regressione lineare semplice Una variabile Y, detta «dipendente» , è espressa in funzione di una varaibile X, detta «indipendente» . Lo scopo della regressione è di fornire la miglior predizione possibile della Y per ciascun valore della X, dati tramite una curva. La miglior curva possibile è quella «dei minimi quadrati» , cioè quella che minimizza la somma degli errori al quadrato. La regressione lineare si basa sulla retta. La retta di regressione può essere descritta con due soli coefficienti: • La costante (a) ci dice il valore medio della VD quando la VI è zero • b è l’inclinazione della retta, ci dice quanto cambia la VD per ogni cambiamento unitario della VI 3

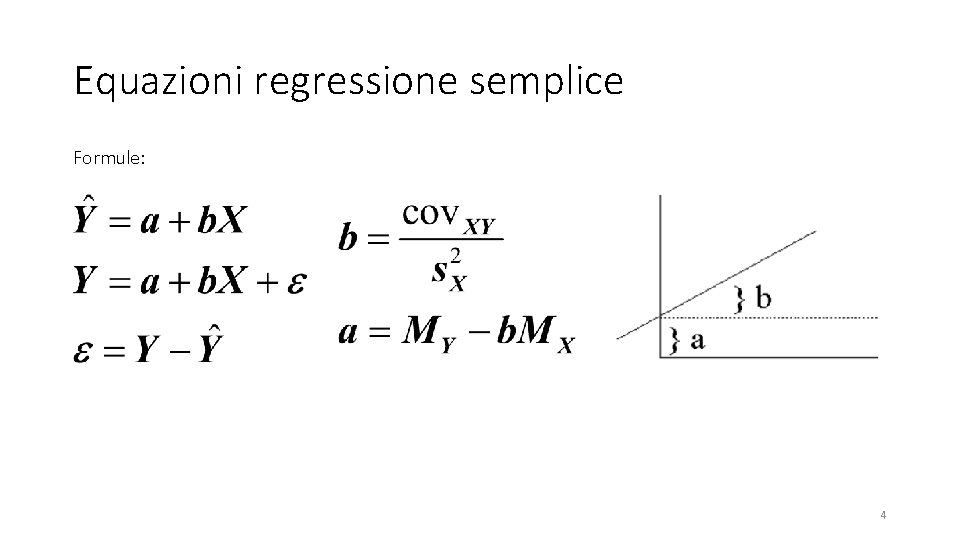

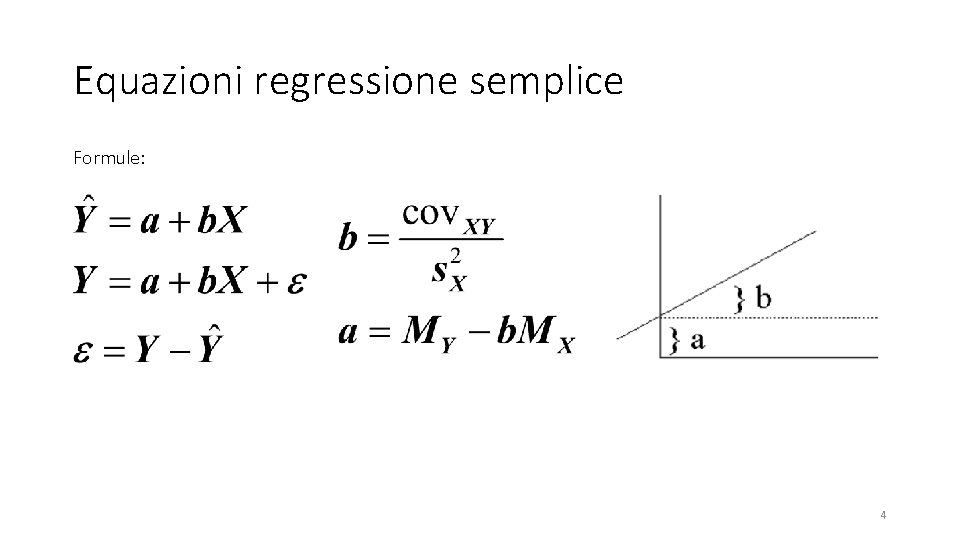

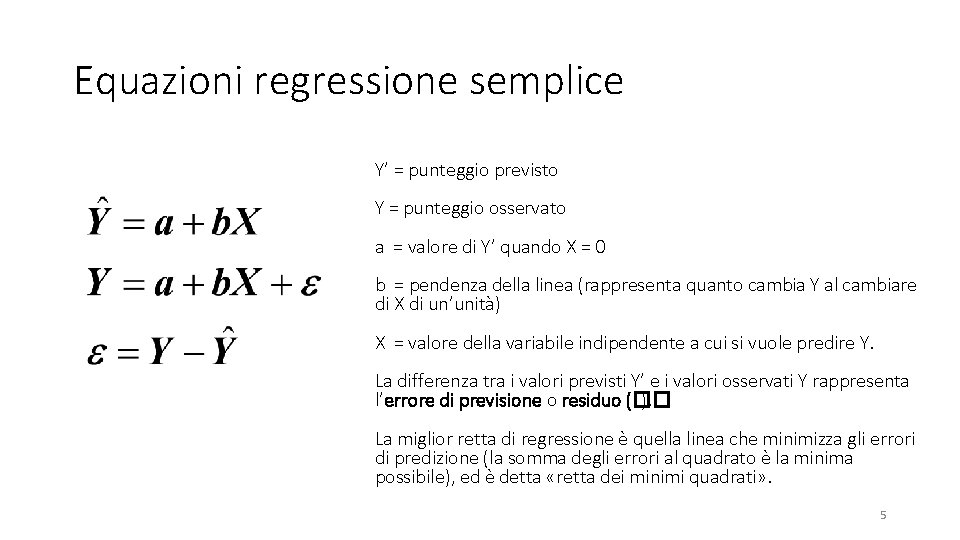

Equazioni regressione semplice Formule: 4

Equazioni regressione semplice Y’ = punteggio previsto Y = punteggio osservato a = valore di Y’ quando X = 0 b = pendenza della linea (rappresenta quanto cambia Y al cambiare di X di un’unità) X = valore della variabile indipendente a cui si vuole predire Y. La differenza tra i valori previsti Y’ e i valori osservati Y rappresenta l’errore di previsione o residuo (�� ). La miglior retta di regressione è quella linea che minimizza gli errori di predizione (la somma degli errori al quadrato è la minima possibile), ed è detta «retta dei minimi quadrati» . 5

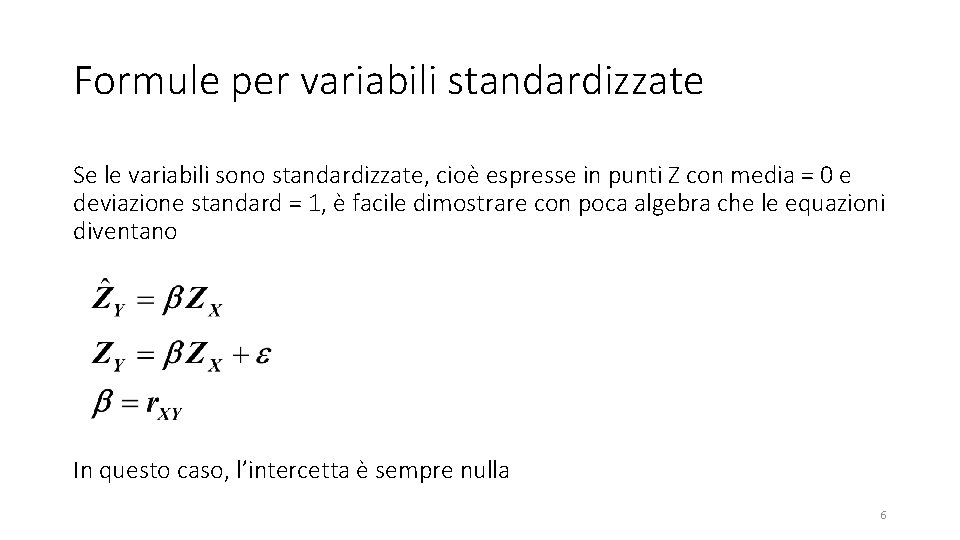

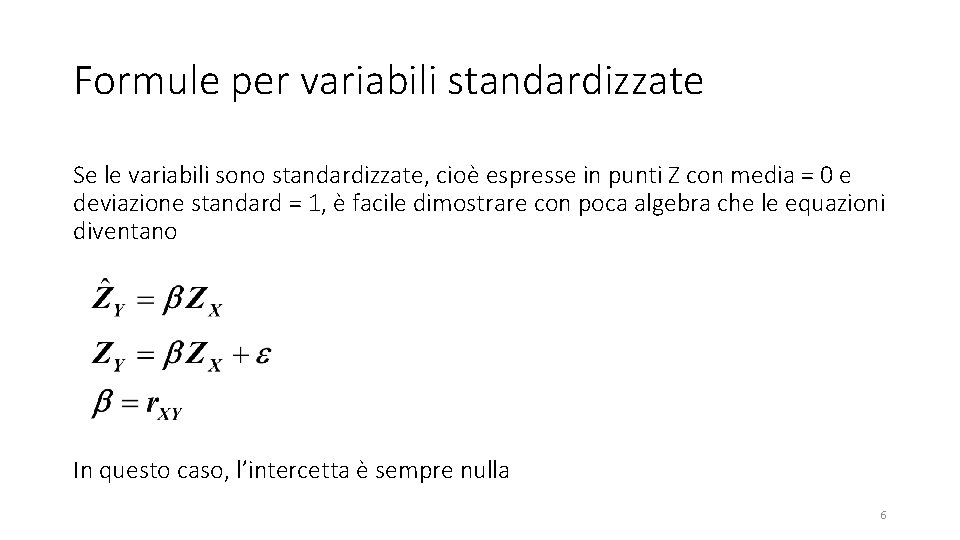

Formule per variabili standardizzate Se le variabili sono standardizzate, cioè espresse in punti Z con media = 0 e deviazione standard = 1, è facile dimostrare con poca algebra che le equazioni diventano In questo caso, l’intercetta è sempre nulla 6

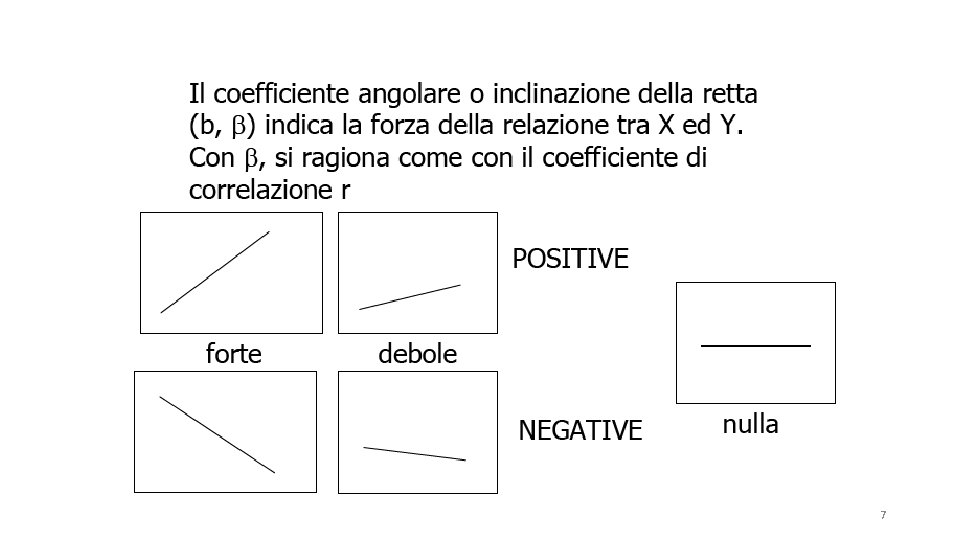

7

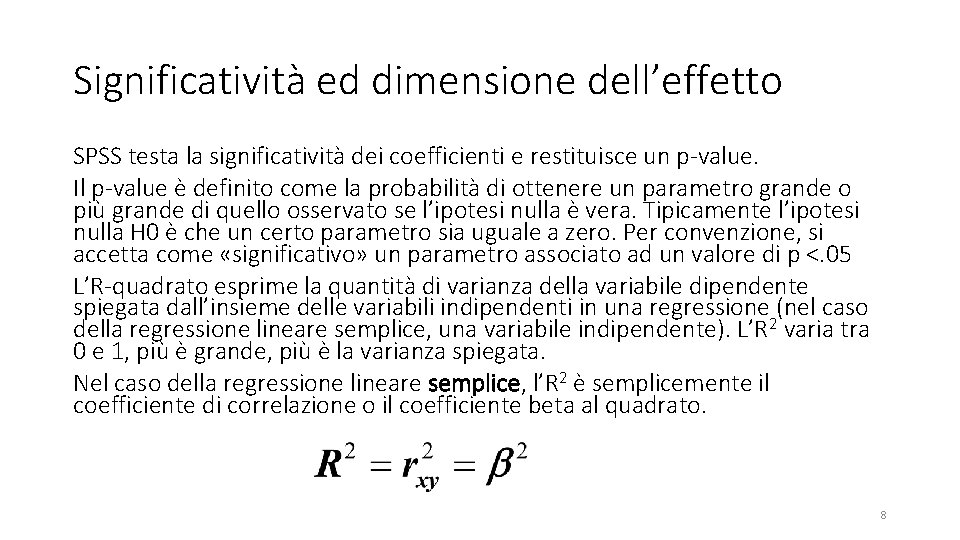

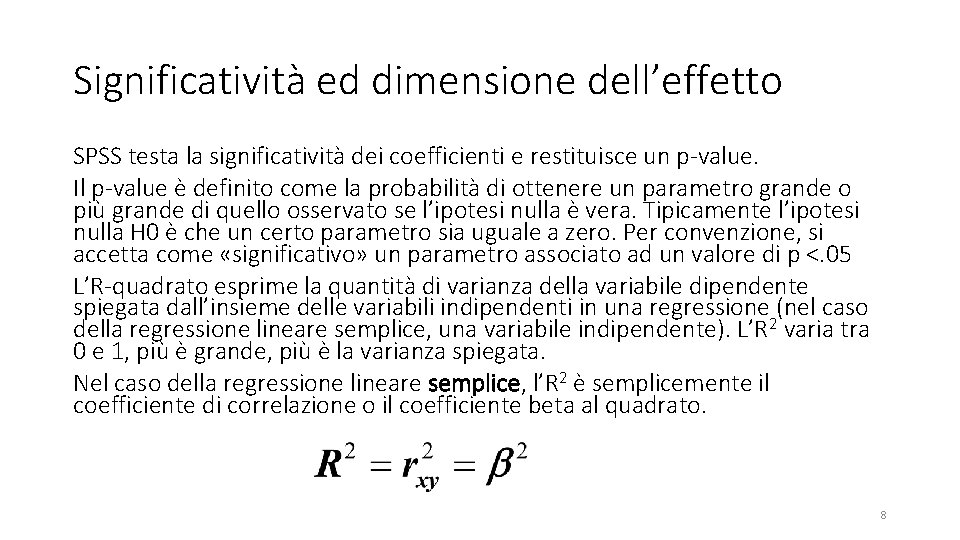

Significatività ed dimensione dell’effetto SPSS testa la significatività dei coefficienti e restituisce un p-value. Il p-value è definito come la probabilità di ottenere un parametro grande o più grande di quello osservato se l’ipotesi nulla è vera. Tipicamente l’ipotesi nulla H 0 è che un certo parametro sia uguale a zero. Per convenzione, si accetta come «significativo» un parametro associato ad un valore di p <. 05 L’R-quadrato esprime la quantità di varianza della variabile dipendente spiegata dall’insieme delle variabili indipendenti in una regressione (nel caso della regressione lineare semplice, una variabile indipendente). L’R 2 varia tra 0 e 1, più è grande, più è la varianza spiegata. Nel caso della regressione lineare semplice, l’R 2 è semplicemente il coefficiente di correlazione o il coefficiente beta al quadrato. 8

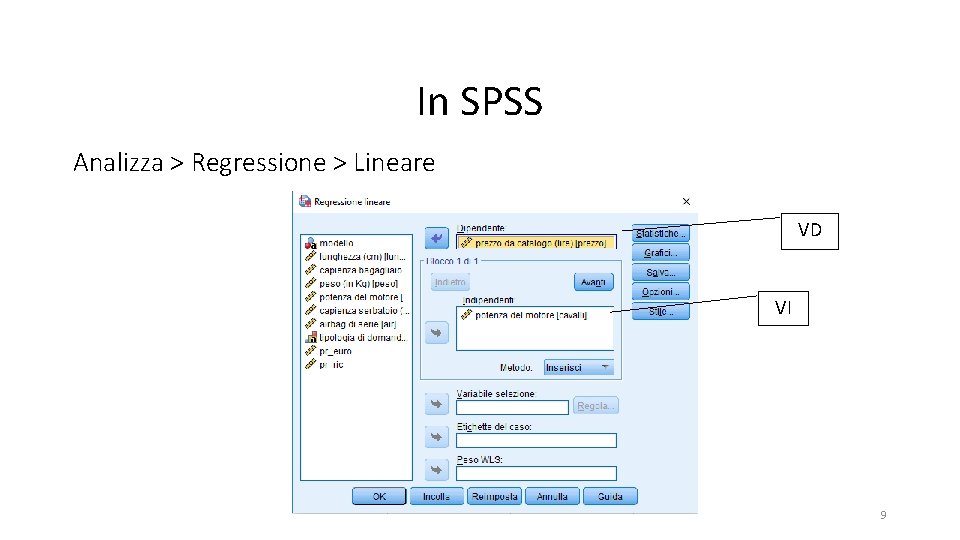

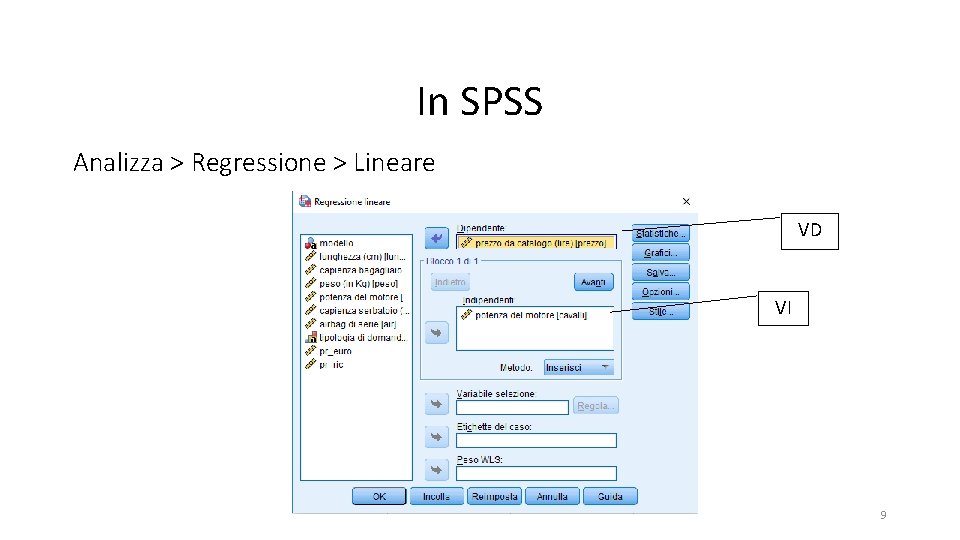

In SPSS Analizza > Regressione > Lineare VD VI 9

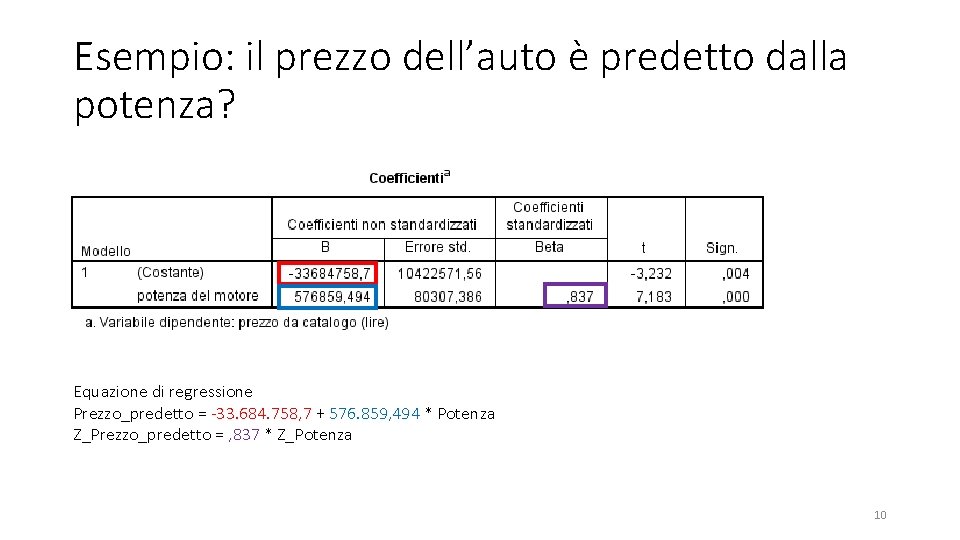

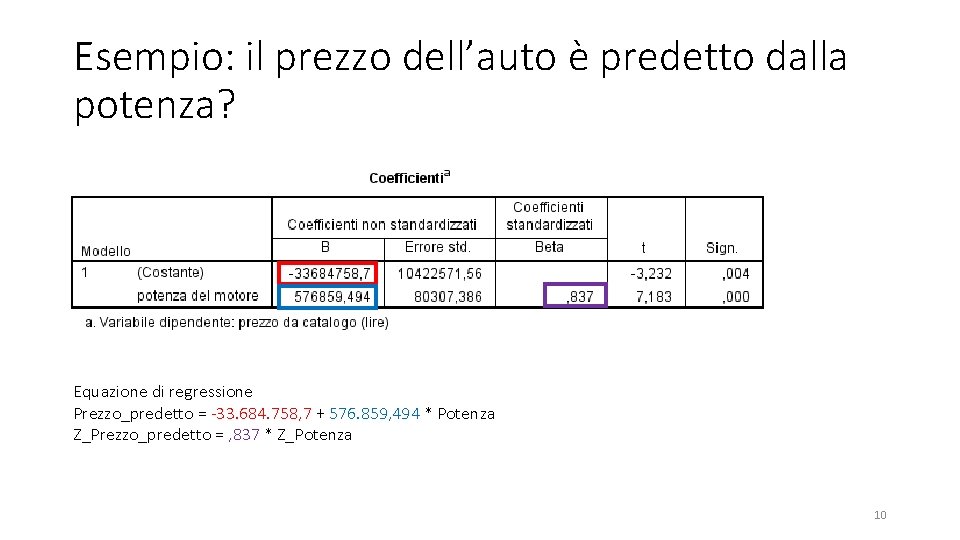

Esempio: il prezzo dell’auto è predetto dalla potenza? Equazione di regressione Prezzo_predetto = -33. 684. 758, 7 + 576. 859, 494 * Potenza Z_Prezzo_predetto = , 837 * Z_Potenza 10

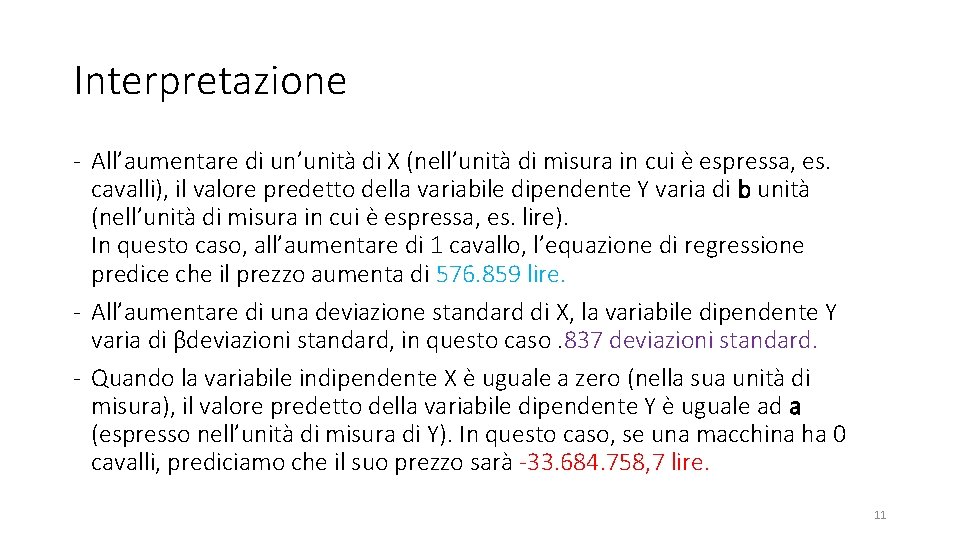

Interpretazione - All’aumentare di un’unità di X (nell’unità di misura in cui è espressa, es. cavalli), il valore predetto della variabile dipendente Y varia di b unità (nell’unità di misura in cui è espressa, es. lire). In questo caso, all’aumentare di 1 cavallo, l’equazione di regressione predice che il prezzo aumenta di 576. 859 lire. - All’aumentare di una deviazione standard di X, la variabile dipendente Y varia di βdeviazioni standard, in questo caso. 837 deviazioni standard. - Quando la variabile indipendente X è uguale a zero (nella sua unità di misura), il valore predetto della variabile dipendente Y è uguale ad a (espresso nell’unità di misura di Y). In questo caso, se una macchina ha 0 cavalli, prediciamo che il suo prezzo sarà -33. 684. 758, 7 lire. 11

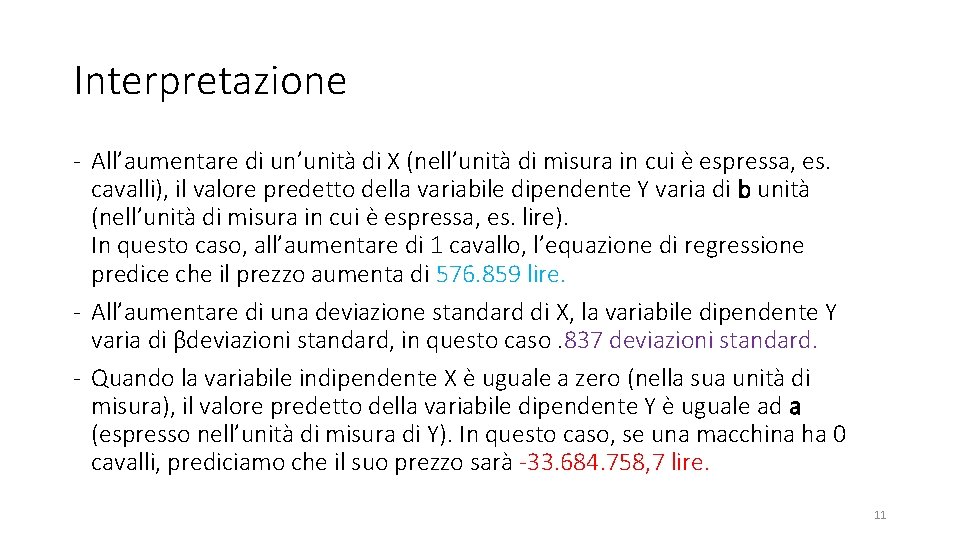

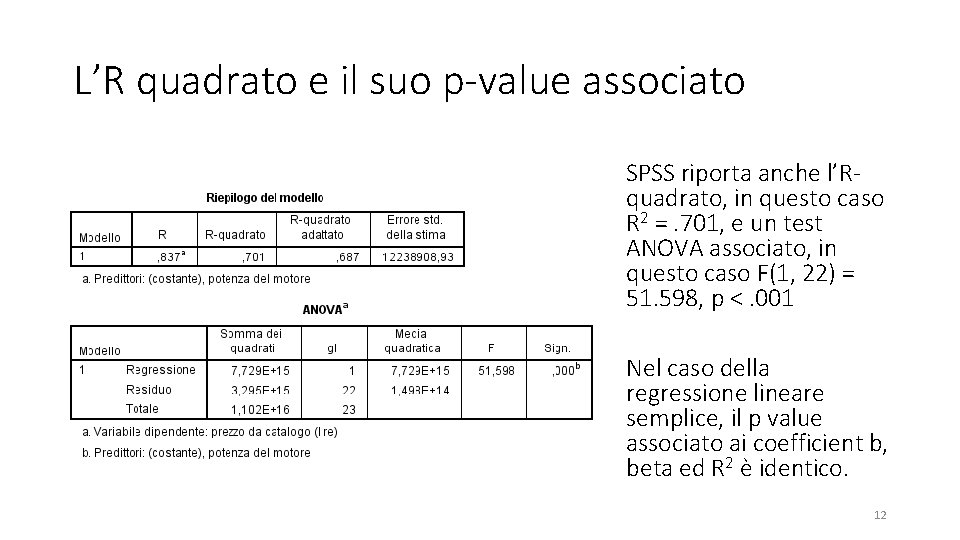

L’R quadrato e il suo p-value associato SPSS riporta anche l’Rquadrato, in questo caso R 2 =. 701, e un test ANOVA associato, in questo caso F(1, 22) = 51. 598, p <. 001 Nel caso della regressione lineare semplice, il p value associato ai coefficient b, beta ed R 2 è identico. 12

Riassumere i risultati in modo discorsivo Ho svolto un’analisi di regressione lineare semplice per predire il prezzo delle auto a partire dalla loro potenza in cavalli. La Potenza prediceva in modo significativo il prezzo, β=. 837, p <. 001. La potenza spiega il 70. 1 % della varianza del prezzo (R 2 =. 701, p <. 001) 13

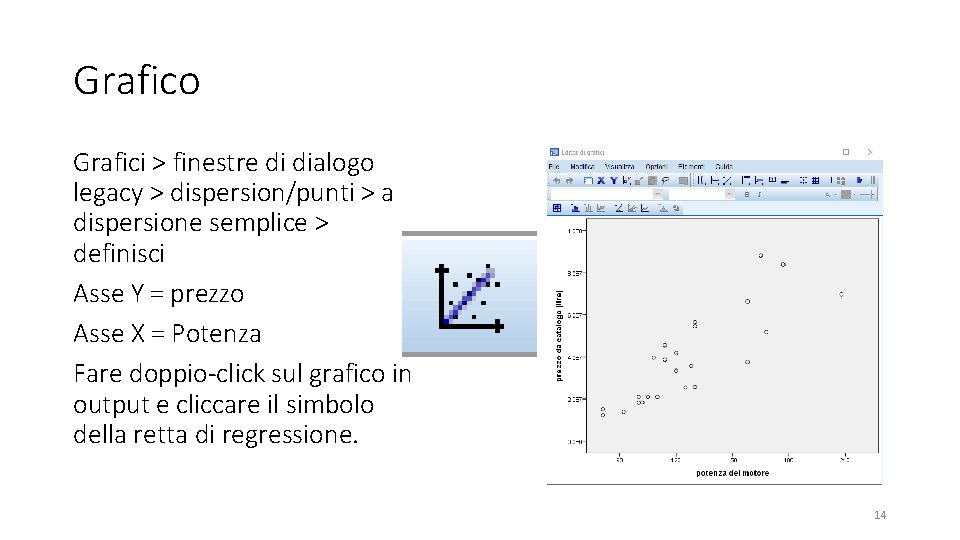

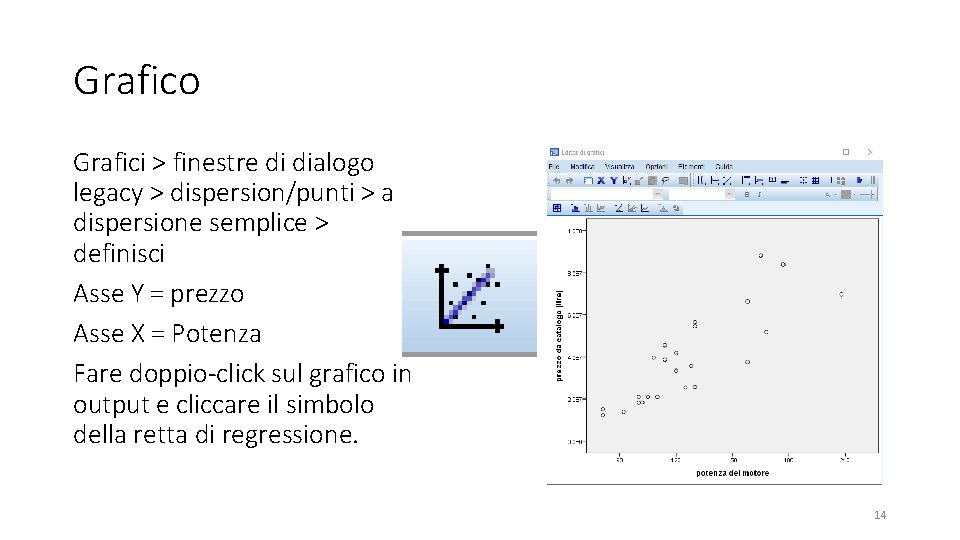

Grafico Grafici > finestre di dialogo legacy > dispersion/punti > a dispersione semplice > definisci Asse Y = prezzo Asse X = Potenza Fare doppio-click sul grafico in output e cliccare il simbolo della retta di regressione. 14

Esercizi - Predire il peso dell’auto a partire dalla lunghezza - Predire il prezzo dell’auto a partire dal peso - Predire il peso dell’auto a partire dal prezzo Annotare le rette di regressione, standardizzate e non. 15

Soluzione Peso_predetto = -927, 675 + 4. 874 * Lunghezza Z_Peso_predetto =, 762*Z_lunghezza Prezzo_predetto = -84300345, 6 + 98422, 176 * Peso Z_Prezzo_predetto = , 770* Z_Peso_predetto = -1018, 092+ (6, 017*10 -6) * Prezzo Z_Peso_predetto = , 770* Z_Prezzo 16

Regressione lineare multipla 17

Differenza tra regressione semplice e multipla • Cosa cambia: • Numero di predittori: Regressione semplice: un solo predittore X; Regressione multipla: tanti predittori X 1, X 2, …, Xk • Interpretazione dei coefficienti, • L’ R 2 indica la porzione di varianza spiegata da tutte le variabili dipendenti insieme. Nella regressione multipla ci sono anche altri indici di dimensione dell’effetto, le correlazioni parziale e semiparziale al quadrato, che riguardano i singoli predittori. È fondamentale capire le differenze tra questi indici. • La relazione tra le variabili non si può più visualizzare in un solo grafico a due dimensioni: geometricamente non si ha più una retta nel piano, ma da un (iper-)piano a k dimensioni in uno spazio a k+1 dimensioni. • Cosa non cambia: • l’input in SPSS è quasi identico, basta inserire più predittori invece di uno solo • Modelliamo solo relazioni lineari tra indipendenti e dipendente 18

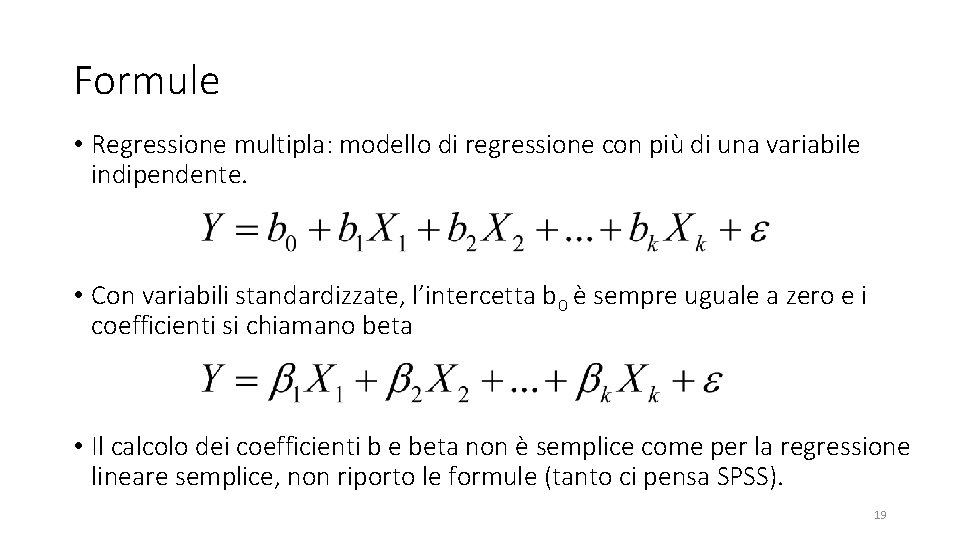

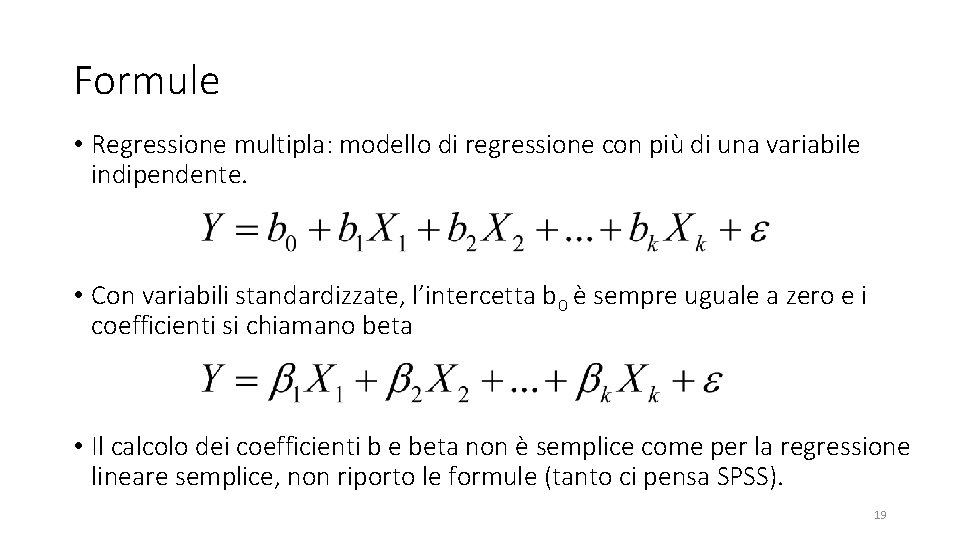

Formule • Regressione multipla: modello di regressione con più di una variabile indipendente. • Con variabili standardizzate, l’intercetta b 0 è sempre uguale a zero e i coefficienti si chiamano beta • Il calcolo dei coefficienti b e beta non è semplice come per la regressione lineare semplice, non riporto le formule (tanto ci pensa SPSS). 19

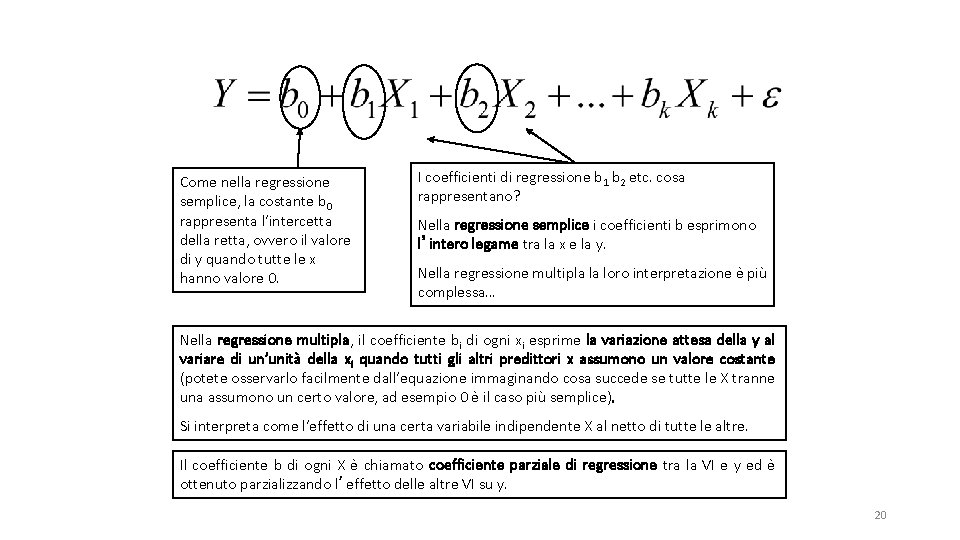

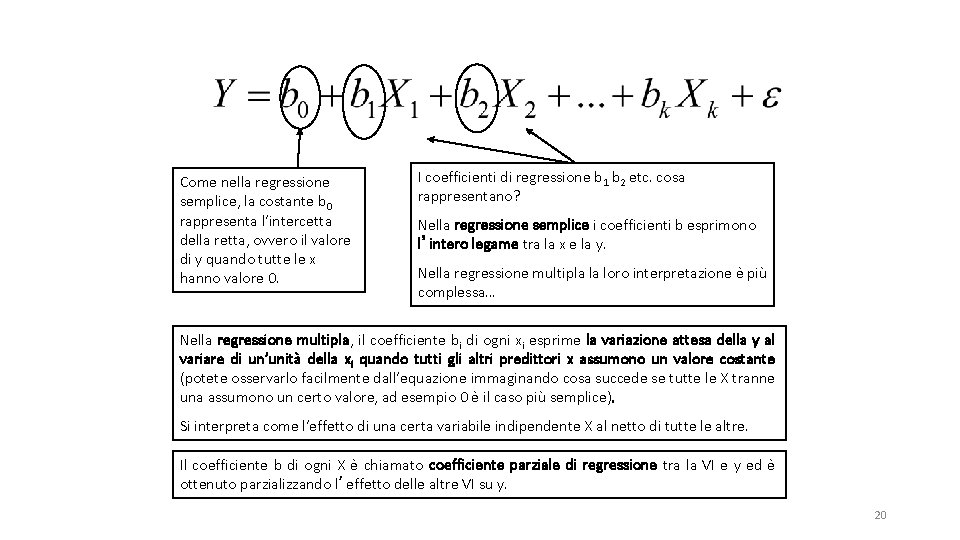

Come nella regressione semplice, la costante b 0 rappresenta l’intercetta della retta, ovvero il valore di y quando tutte le x hanno valore 0. I coefficienti di regressione b 1 b 2 etc. cosa rappresentano? Nella regressione semplice i coefficienti b esprimono l’intero legame tra la x e la y. Nella regressione multipla la loro interpretazione è più complessa… Nella regressione multipla, il coefficiente bi di ogni xi esprime la variazione attesa della y al variare di un’unità della xi quando tutti gli altri predittori x assumono un valore costante (potete osservarlo facilmente dall’equazione immaginando cosa succede se tutte le X tranne una assumono un certo valore, ad esempio 0 è il caso più semplice). Si interpreta come l’effetto di una certa variabile indipendente X al netto di tutte le altre. Il coefficiente b di ogni X è chiamato coefficiente parziale di regressione tra la VI e y ed è ottenuto parzializzando l’effetto delle altre VI su y. 20

Interpretazione dei coefficienti (1) • Intercetta b 0: valore predetto della variabile dipendente Y quando tutte le variabili indipendenti X 1. . . Xk sono uguali a 0. • Coefficiente bi: variazione predetta della variabile dipendente Y al variare di un’unità di una variabile indipendente Xi, quando tutte le altre variabili indipendenti x sono mantenute costanti. I coefficienti b Risentono dell’unità di misura (es. alla variabile lunghezza corrisponderà un b differente se la misurate in cm o in metri). 21

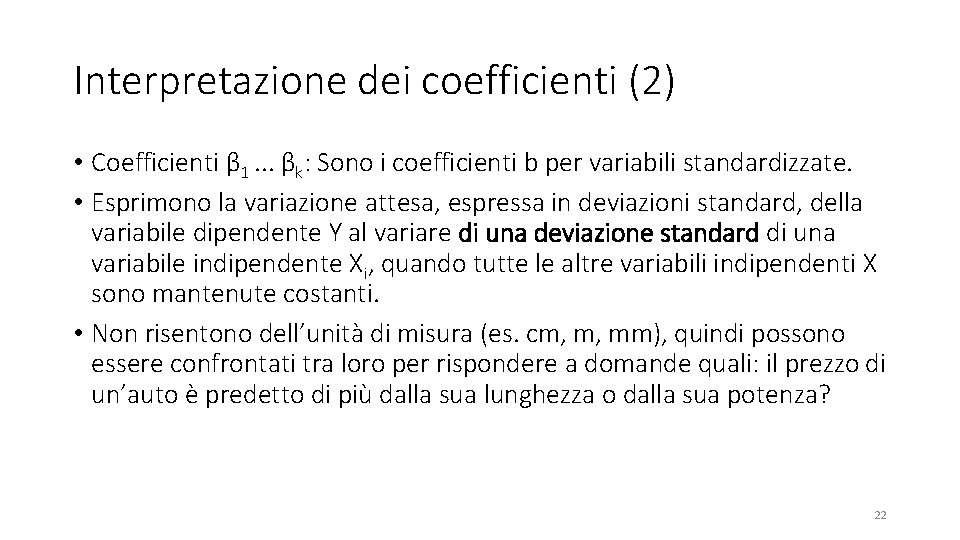

Interpretazione dei coefficienti (2) • Coefficienti β 1. . . βk: Sono i coefficienti b per variabili standardizzate. • Esprimono la variazione attesa, espressa in deviazioni standard, della variabile dipendente Y al variare di una deviazione standard di una variabile indipendente Xi, quando tutte le altre variabili indipendenti X sono mantenute costanti. • Non risentono dell’unità di misura (es. cm, m, mm), quindi possono essere confrontati tra loro per rispondere a domande quali: il prezzo di un’auto è predetto di più dalla sua lunghezza o dalla sua potenza? 22

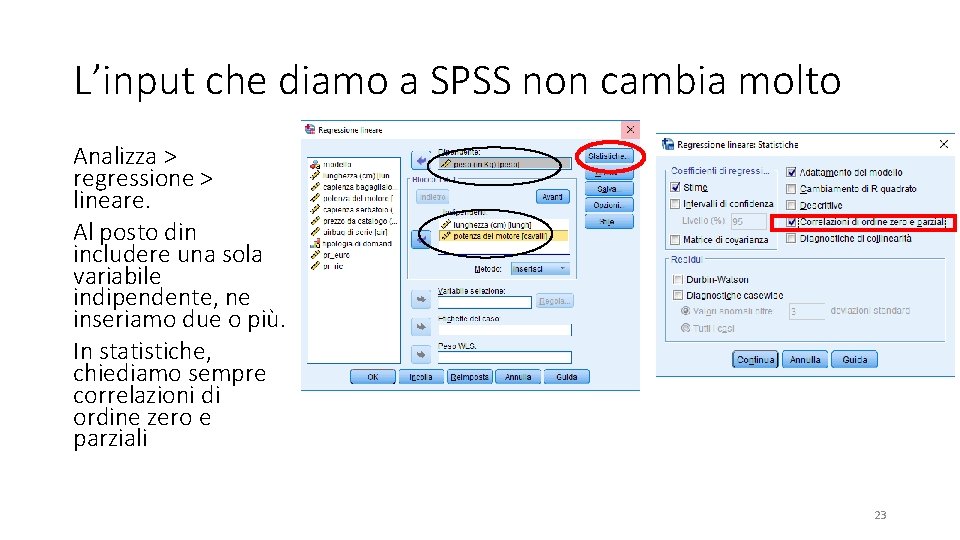

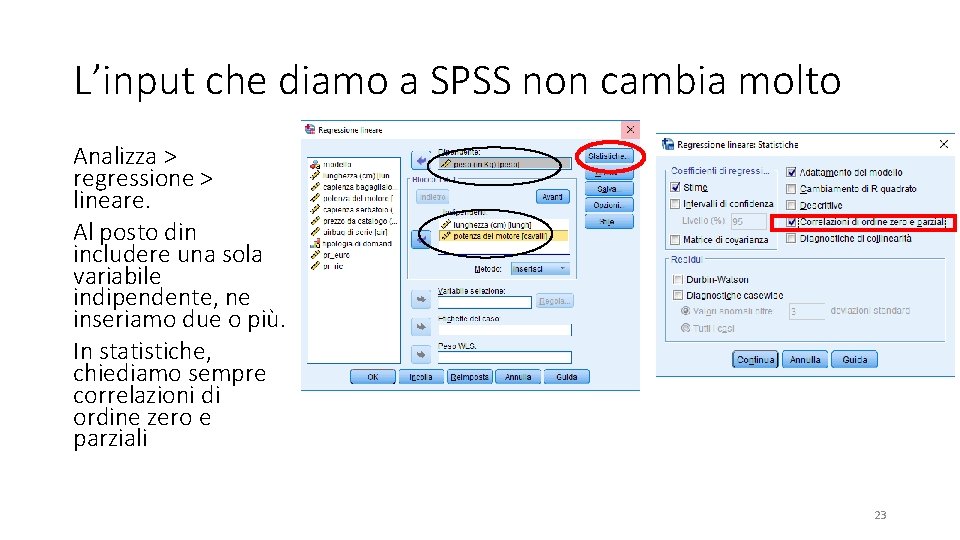

L’input che diamo a SPSS non cambia molto Analizza > regressione > lineare. Al posto din includere una sola variabile indipendente, ne inseriamo due o più. In statistiche, chiediamo sempre correlazioni di ordine zero e parziali 23

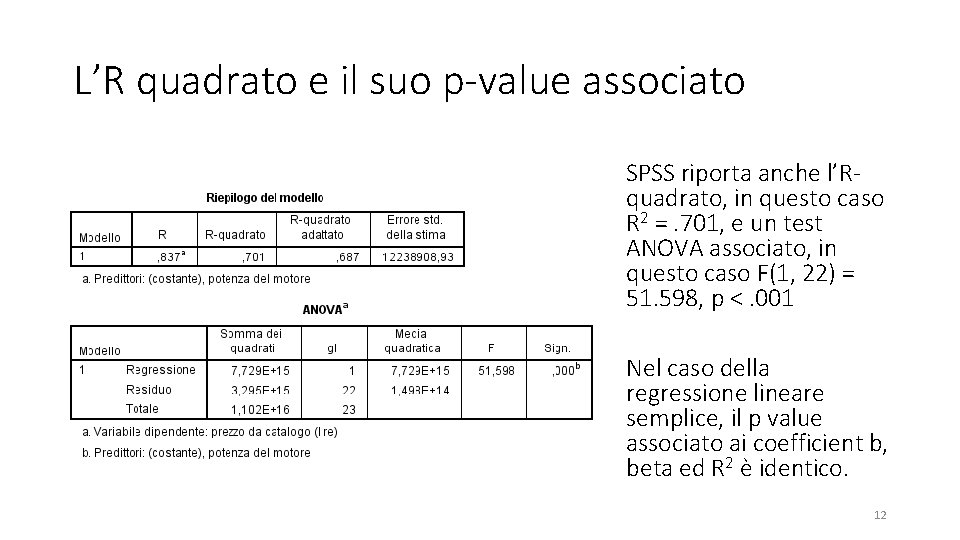

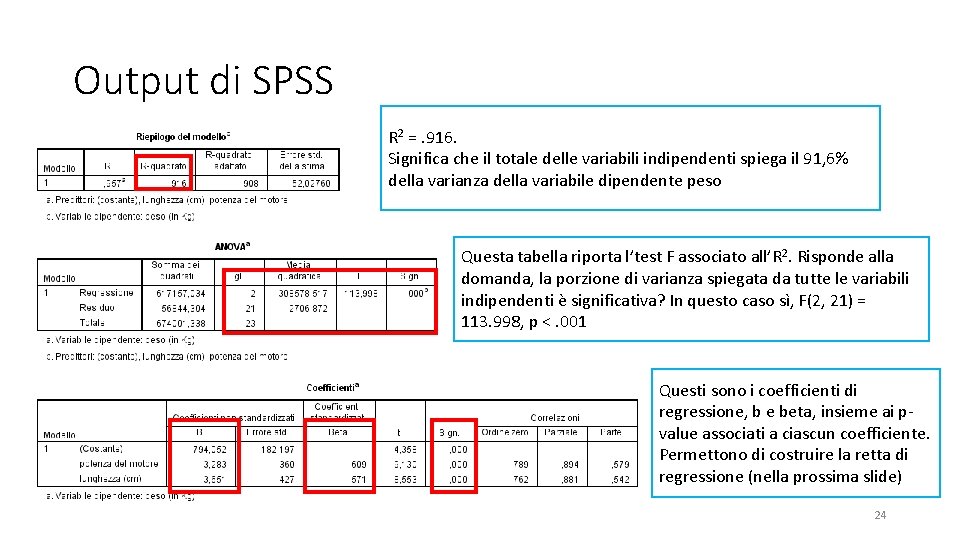

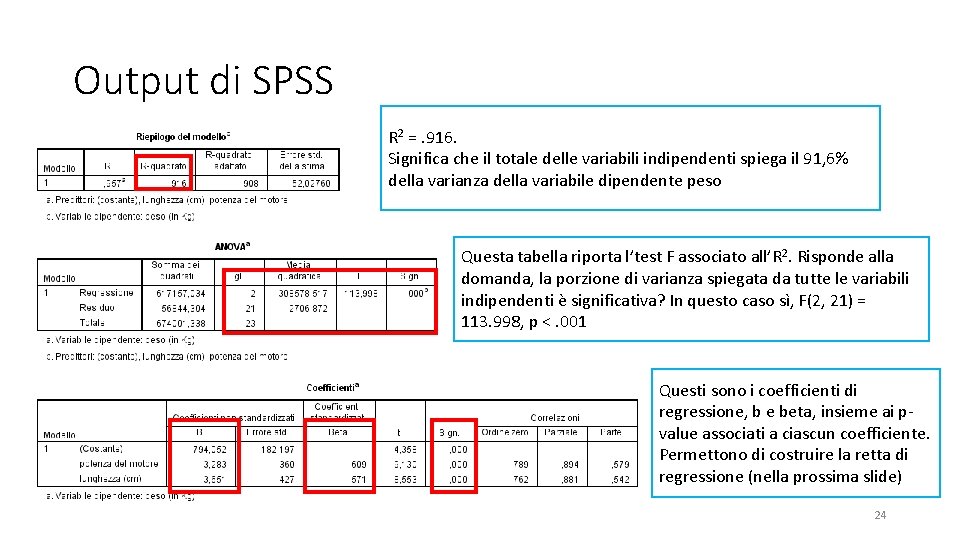

Output di SPSS R 2 =. 916. Significa che il totale delle variabili indipendenti spiega il 91, 6% della varianza della variabile dipendente peso Questa tabella riporta l’test F associato all’R 2. Risponde alla domanda, la porzione di varianza spiegata da tutte le variabili indipendenti è significativa? In questo caso sì, F(2, 21) = 113. 998, p <. 001 Questi sono i coefficienti di regressione, b e beta, insieme ai pvalue associati a ciascun coefficiente. Permettono di costruire la retta di regressione (nella prossima slide) 24

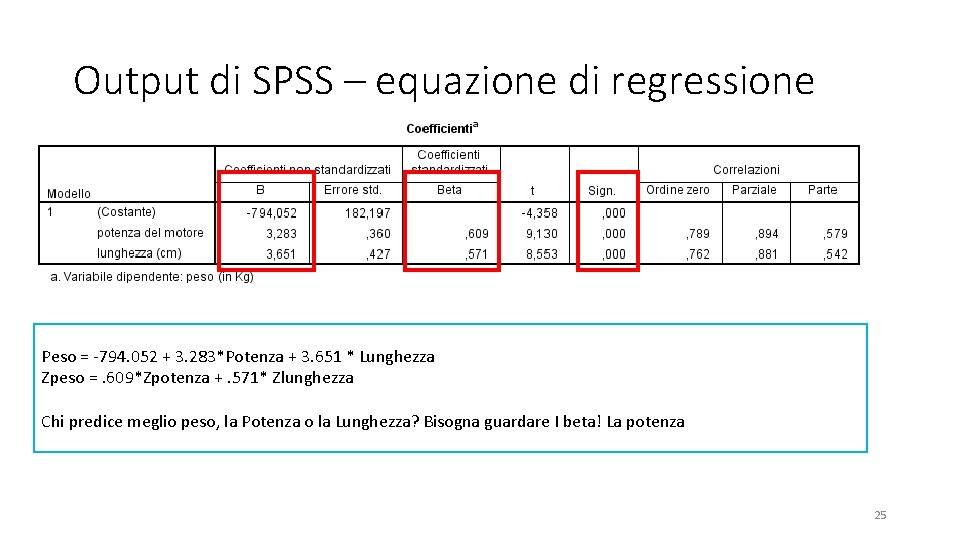

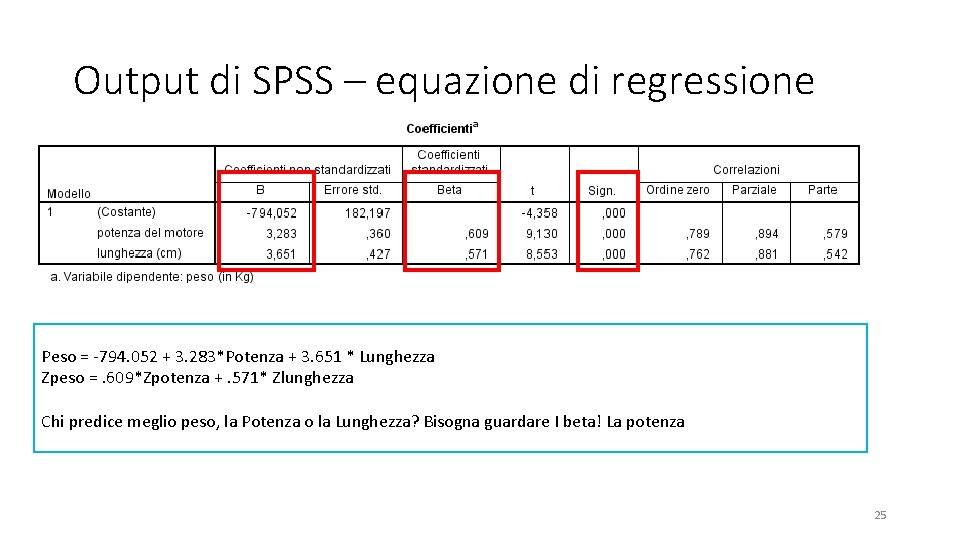

Output di SPSS – equazione di regressione Peso = -794. 052 + 3. 283*Potenza + 3. 651 * Lunghezza Zpeso =. 609*Zpotenza +. 571* Zlunghezza Chi predice meglio peso, la Potenza o la Lunghezza? Bisogna guardare I beta! La potenza 25

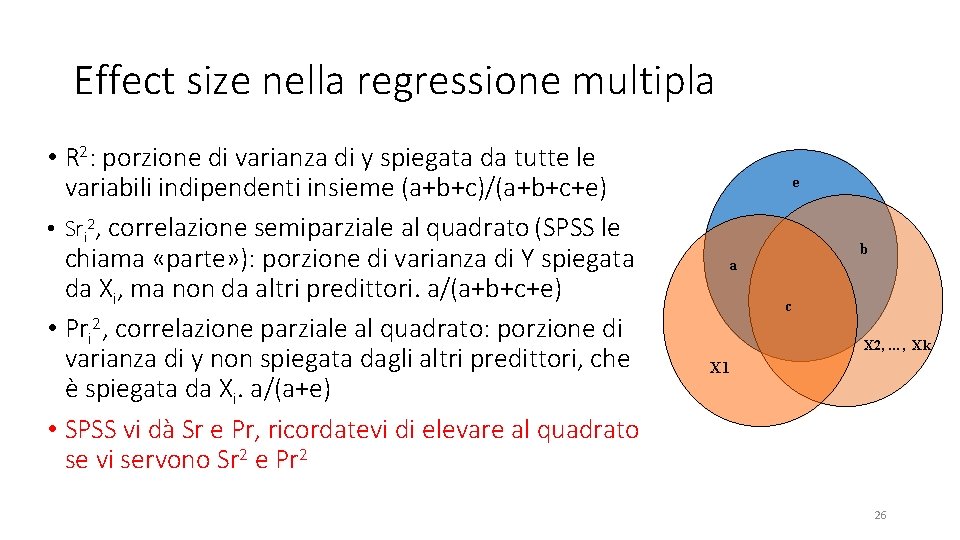

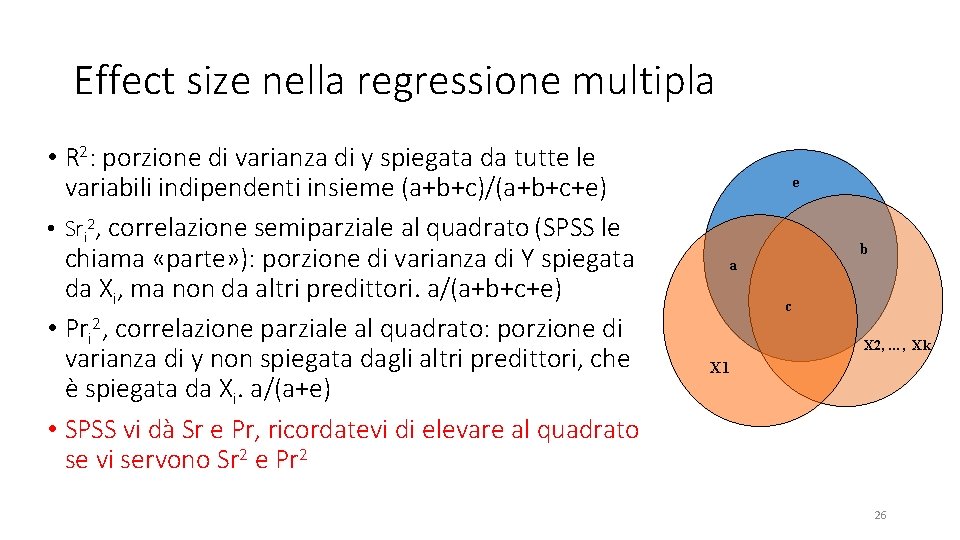

Effect size nella regressione multipla • R 2: porzione di varianza di y spiegata da tutte le variabili indipendenti insieme (a+b+c)/(a+b+c+e) • Sri 2, correlazione semiparziale al quadrato (SPSS le chiama «parte» ): porzione di varianza di Y spiegata da Xi, ma non da altri predittori. a/(a+b+c+e) • Pri 2, correlazione parziale al quadrato: porzione di varianza di y non spiegata dagli altri predittori, che è spiegata da Xi. a/(a+e) • SPSS vi dà Sr e Pr, ricordatevi di elevare al quadrato se vi servono Sr 2 e Pr 2 e b a c X 2, …, Xk X 1 26

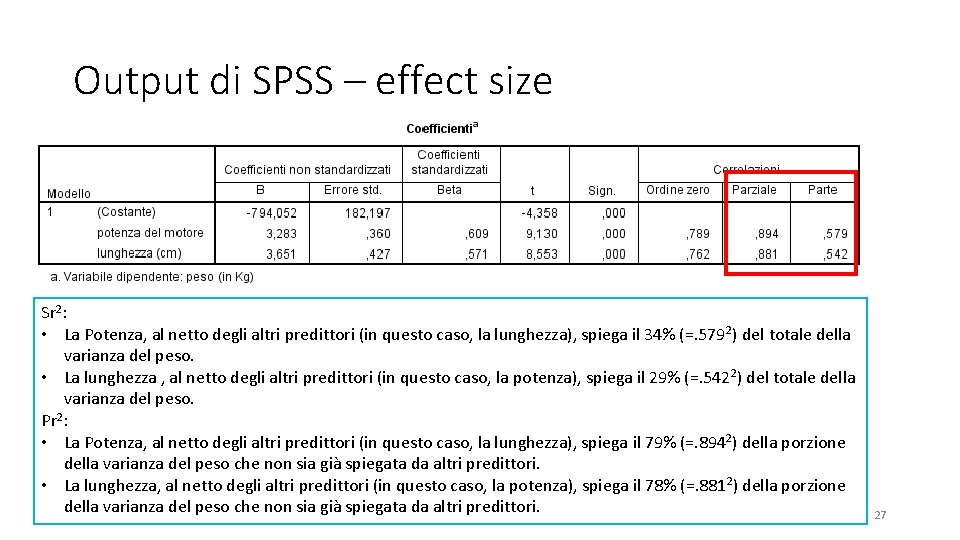

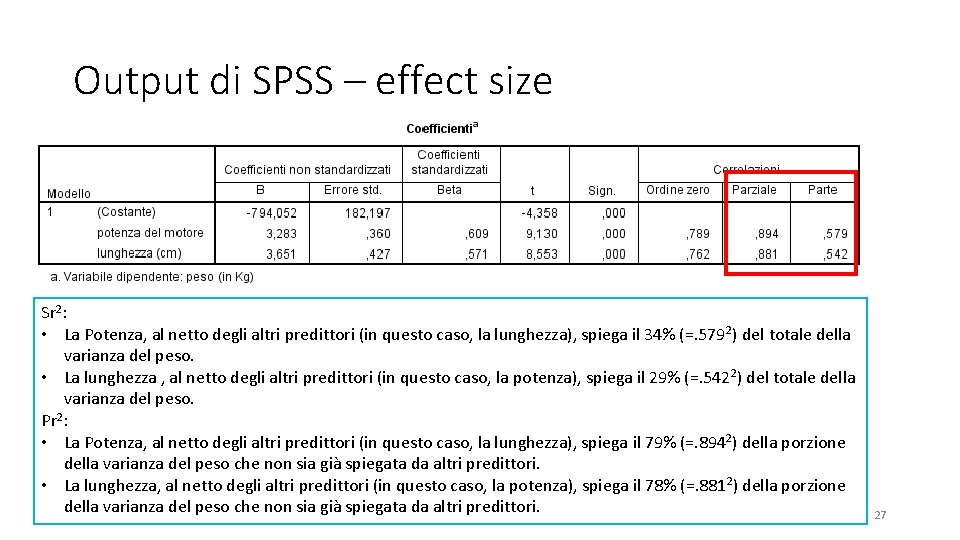

Output di SPSS – effect size Sr 2: • La Potenza, al netto degli altri predittori (in questo caso, la lunghezza), spiega il 34% (=. 579 2) del totale della varianza del peso. • La lunghezza , al netto degli altri predittori (in questo caso, la potenza), spiega il 29% (=. 5422) del totale della varianza del peso. Pr 2: • La Potenza, al netto degli altri predittori (in questo caso, la lunghezza), spiega il 79% (=. 8942) della porzione della varianza del peso che non sia già spiegata da altri predittori. • La lunghezza, al netto degli altri predittori (in questo caso, la potenza), spiega il 78% (=. 8812) della porzione della varianza del peso che non sia già spiegata da altri predittori. 27

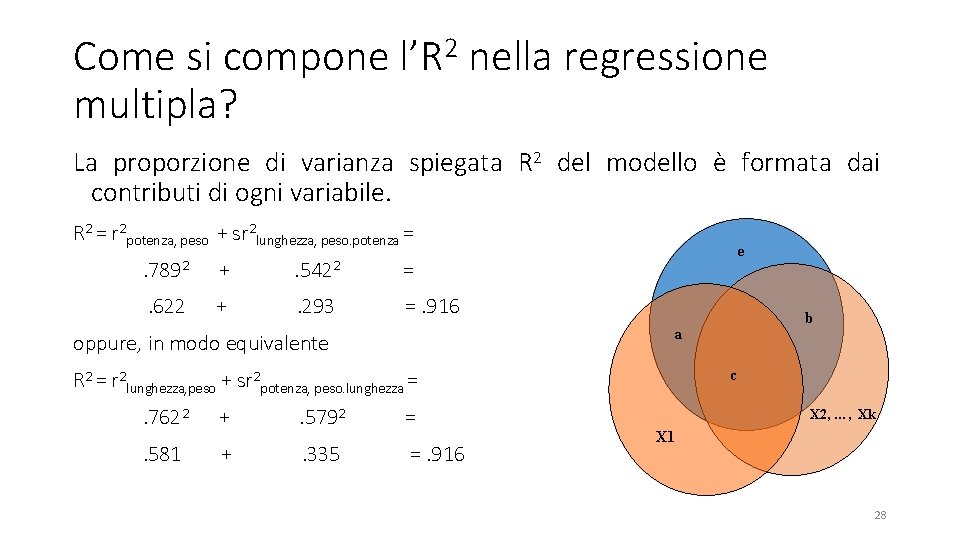

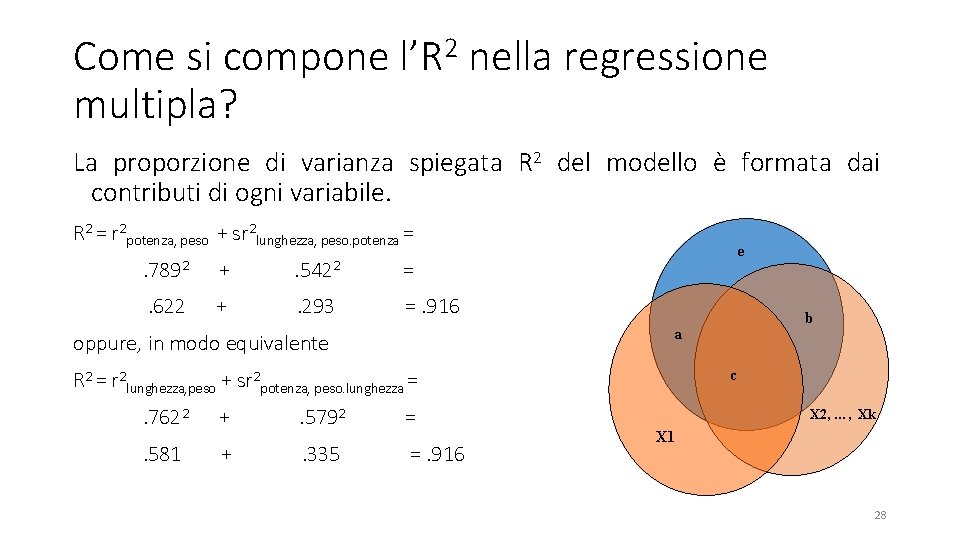

Come si compone l’R 2 nella regressione multipla? La proporzione di varianza spiegata R 2 del modello è formata dai contributi di ogni variabile. R 2 = r 2 potenza, peso + sr 2 lunghezza, peso. potenza = e . 7892 + . 5422 = . 622 + . 293 =. 916 oppure, in modo equivalente a c R 2 = r 2 lunghezza, peso + sr 2 potenza, peso. lunghezza = . 7622 + . 5792 = . 581 + . 335 =. 916 b X 2, …, Xk X 1 28

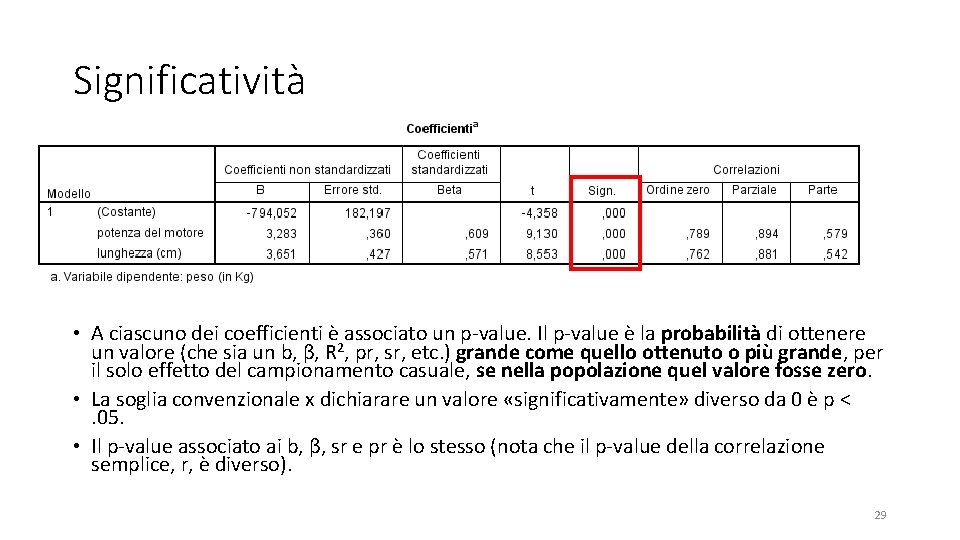

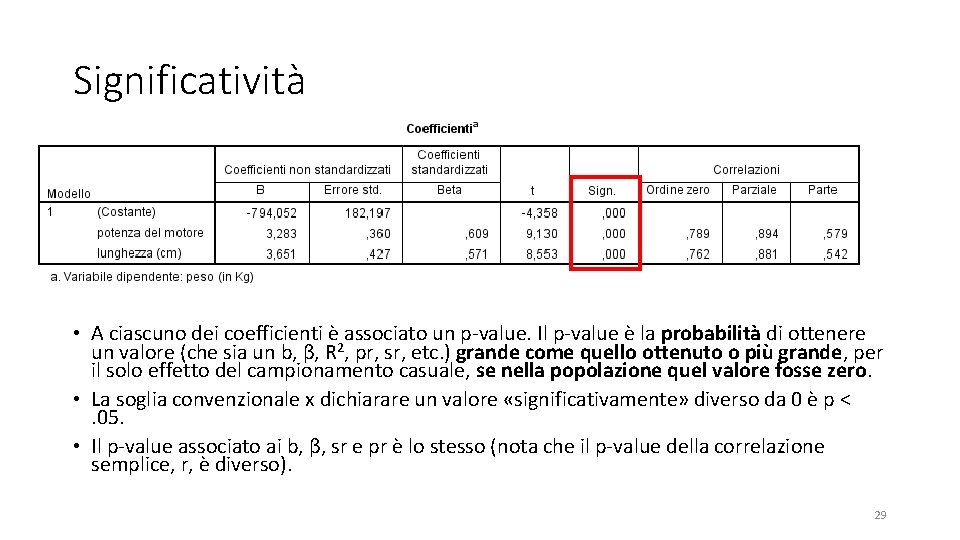

Significatività • A ciascuno dei coefficienti è associato un p-value. Il p-value è la probabilità di ottenere un valore (che sia un b, β, R 2, pr, sr, etc. ) grande come quello ottenuto o più grande, per il solo effetto del campionamento casuale, se nella popolazione quel valore fosse zero. • La soglia convenzionale x dichiarare un valore «significativamente» diverso da 0 è p <. 05. • Il p-value associato ai b, β, sr e pr è lo stesso (nota che il p-value della correlazione semplice, r, è diverso). 29

Riassumere i risultati in modo discorsivo Ho svolto un’analisi di regressione lineare multipla per predire il peso delle auto a partire dalla loro potenza e dalla loro lunghezza. Entrambe le variabili indipendenti predicevano in modo significativo il peso, βpotenza =. 609, p < 001, βlunghezza =. 571, p < 001. In totale, i predittori spiegavano il 91. 6% della varianza della variabile dipendente (R 2 =. 901, p <. 001). A questo punto di solito potete riportare una tra la Sr 2 e la Pr 2, a seconda della domanda che vi viene posta. A volte avete la libertà di scegliere. La Potenza, al netto degli altri predittori (in questo caso, la lunghezza), spiegava il 34% (=. 5792) del totale della varianza del peso. La lunghezza, al netto degli altri predittori (in questo caso, la potenza), spiegava il 29% (=. 5792) del totale della varianza del peso. oppure La Potenza, al netto degli altri predittori (in questo caso, la lunghezza), spiegava il 79% (=. 8942) della porzione della varianza del peso non spiegata da altri predittori. La lunghezza, al netto degli altri predittori (in questo caso, la potenza), spiegava il 78% (=. 8812) della porzione della varianza del peso non spiegata da altri predittori. 30

Metodi di inserimento variabili • Immetti (enter). tutte le variabili in un blocco sono inserite insieme. • Stepwise, rimuovi, all’indietro, in avanti. SPSS cerca il miglior insieme di predittori tra quelli da voi proposti e li inserisce, scartando gli altri, usando diversi metodi. Metodo molto criticato (es. se avete voglia date un’occhiata qui https: //en. wikipedia. org/wiki/Stepwise_regression oppure qui http: //andrewgelman. com/2014/06/02/hate-stepwise-regression/). 31

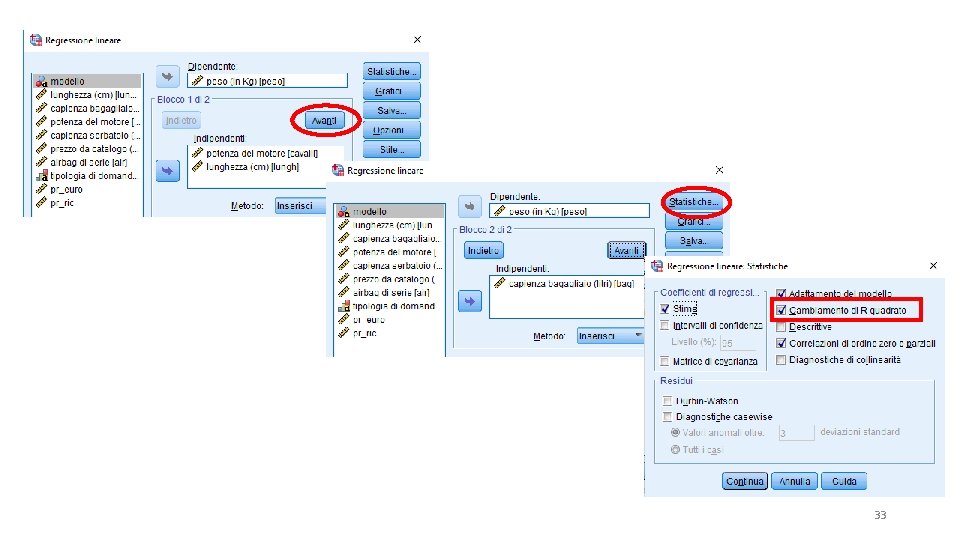

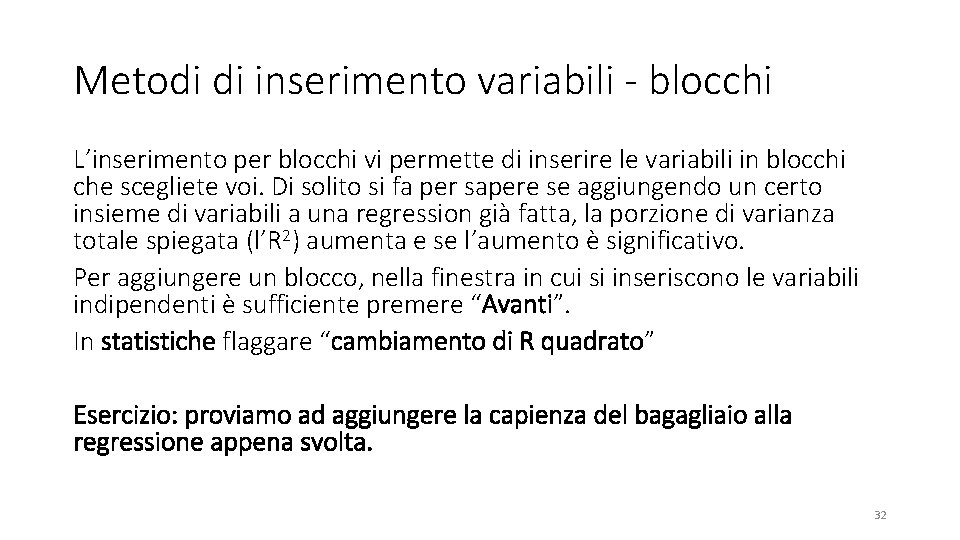

Metodi di inserimento variabili - blocchi L’inserimento per blocchi vi permette di inserire le variabili in blocchi che scegliete voi. Di solito si fa per sapere se aggiungendo un certo insieme di variabili a una regression già fatta, la porzione di varianza totale spiegata (l’R 2) aumenta e se l’aumento è significativo. Per aggiungere un blocco, nella finestra in cui si inseriscono le variabili indipendenti è sufficiente premere “Avanti”. In statistiche flaggare “cambiamento di R quadrato” Esercizio: proviamo ad aggiungere la capienza del bagagliaio alla regressione appena svolta. 32

33

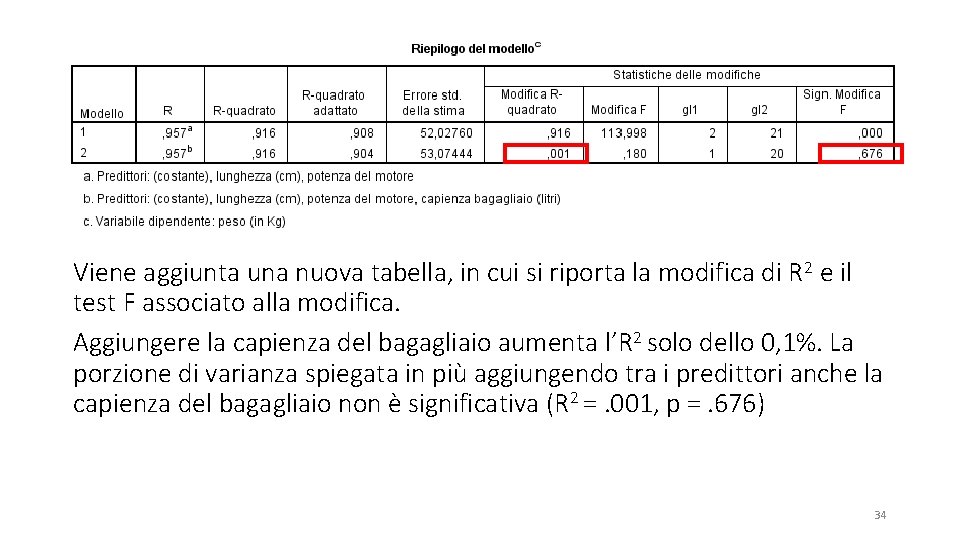

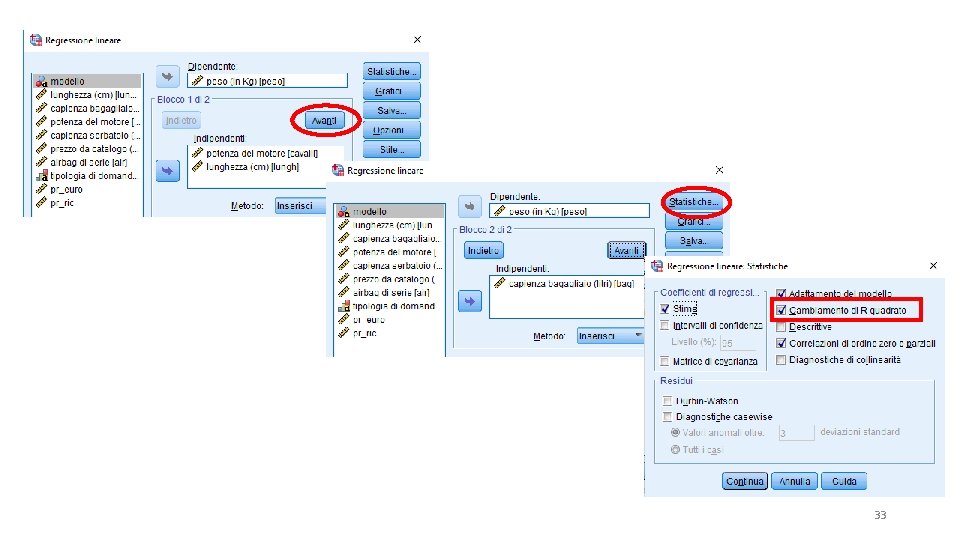

Viene aggiunta una nuova tabella, in cui si riporta la modifica di R 2 e il test F associato alla modifica. Aggiungere la capienza del bagagliaio aumenta l’R 2 solo dello 0, 1%. La porzione di varianza spiegata in più aggiungendo tra i predittori anche la capienza del bagagliaio non è significativa (R 2 =. 001, p =. 676) 34

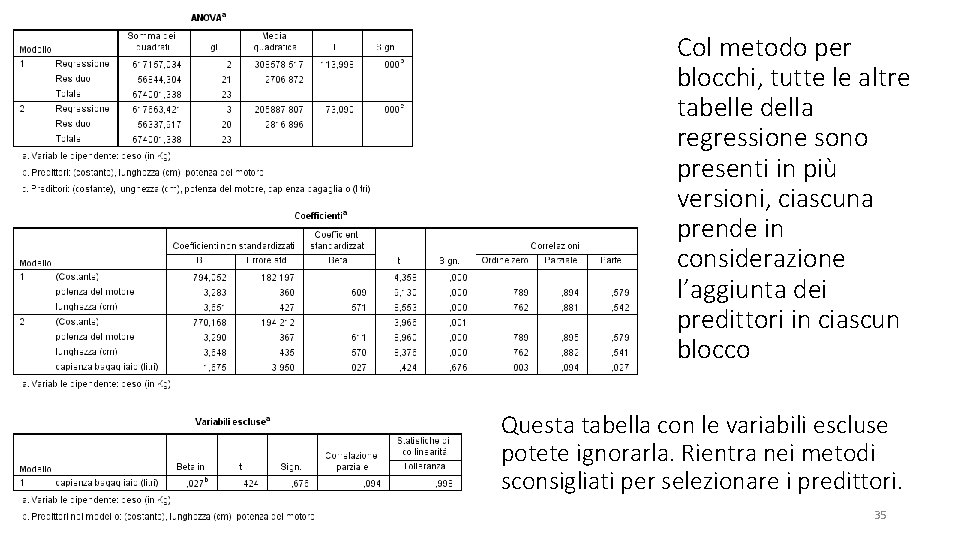

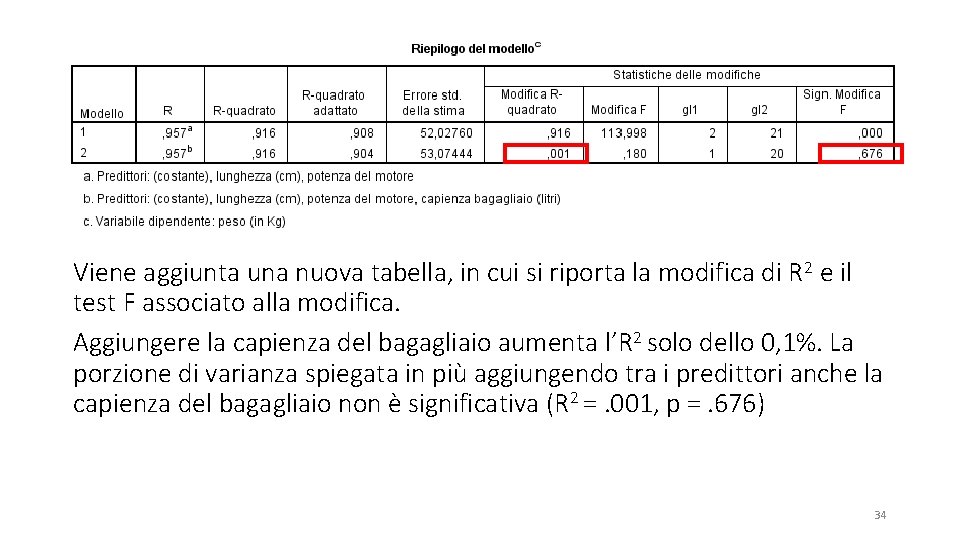

Col metodo per blocchi, tutte le altre tabelle della regressione sono presenti in più versioni, ciascuna prende in considerazione l’aggiunta dei predittori in ciascun blocco Questa tabella con le variabili escluse potete ignorarla. Rientra nei metodi sconsigliati per selezionare i predittori. 35

Correlazione, regressione e causalità Correlazione e regressione testano solo relazioni funzionali, NON relazioni causali. es. Il beta associato alle regressioni di prezzo su peso e di peso su prezzo è identico. 36

Esercizio Svolgere la regressione del prezzo dell’auto su potenza e capienza serbatoio (soluzione nella prossima slide) 37

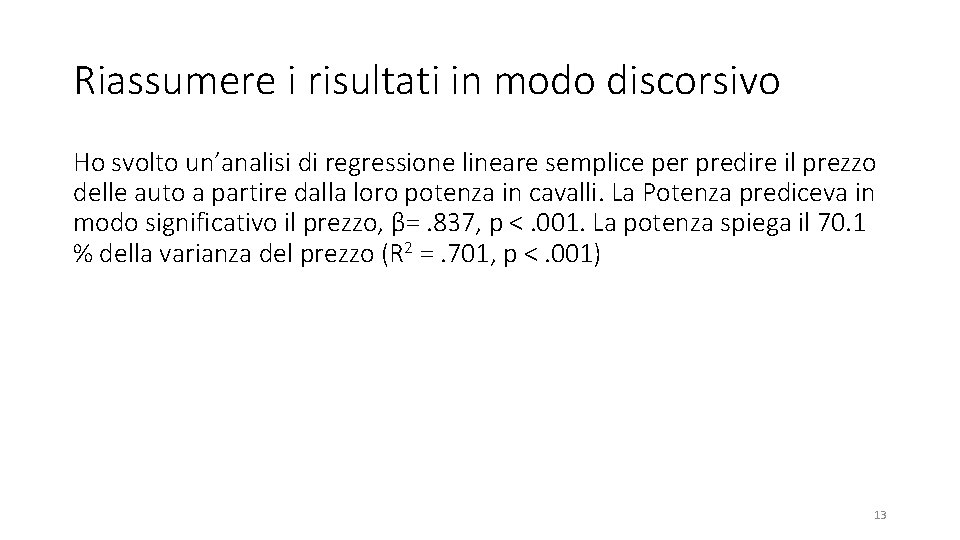

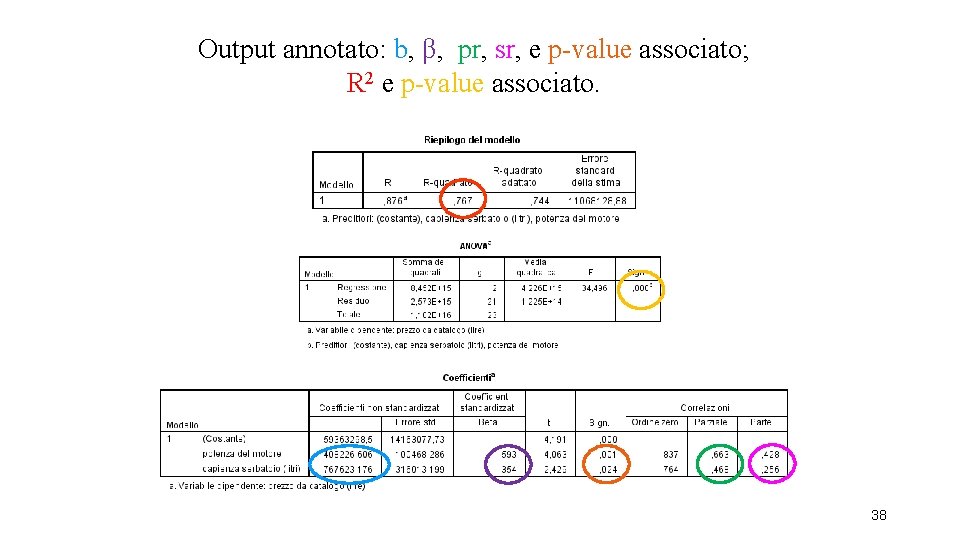

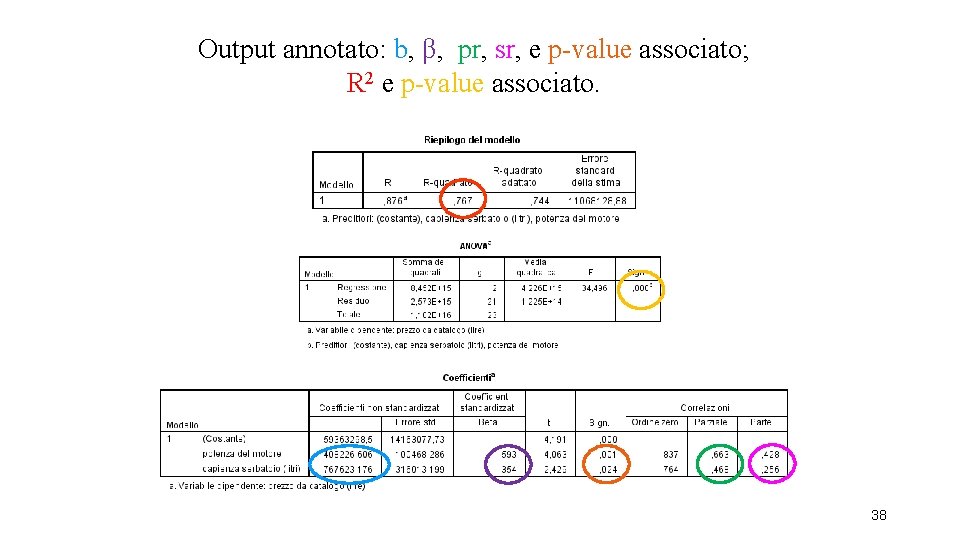

Output annotato: b, β, pr, sr, e p-value associato; R 2 e p-value associato. 38

Riportare i risultati È stata svolta l’analisi di regressione multipla del prezzo dell’auto su potenza e capienza del serbatoio. Dai risultati si evince che sia potenza (β =. 59, p =. 001) sia capienza (β =. 35, p =. 024) sono predittori significativi e che insieme spiegano circa il 77% della varianza del prezzo dell’auto (R 2 =. 767 e p <. 001). La varianza unicamente spiegata da potenza sul totale della varianza della variabile dipendente è il 18% (=. 4282), mentre la varianza unicamente spiegata da capienza è circa il 7% (=. 2562). La varianza unicamente spiegata da potenza sulla porzione della varianza della variabile dipendente non spiegata da altri predittori è il 44% (= , 6632), mentre quella spiegata da capienza è il 22% (= , 4682). 39