Les mthodes non paramtriques Lecture Notes for E

- Slides: 23

Les méthodes non paramétriques Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

Les méthodes non paramétriques n n Estimation d’une densité de probabilité pour laquelle aucune régularité fonctionnelle n’est connue a priori. Hypothèse : les densités recherchées sont localement régulières. 2 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

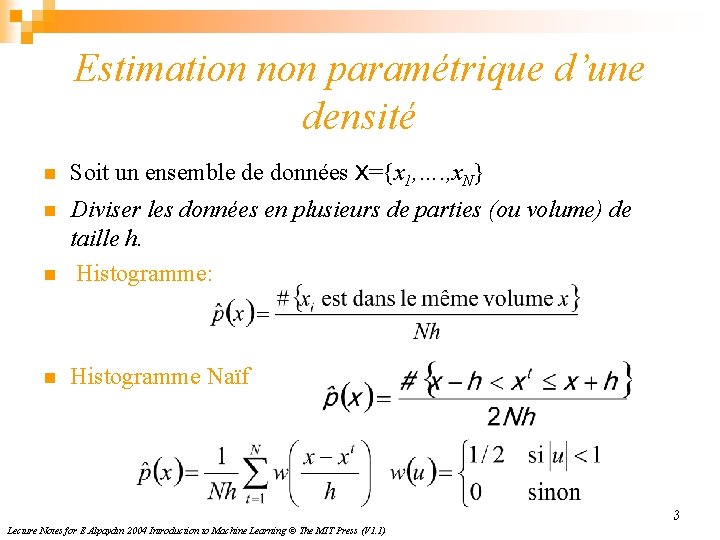

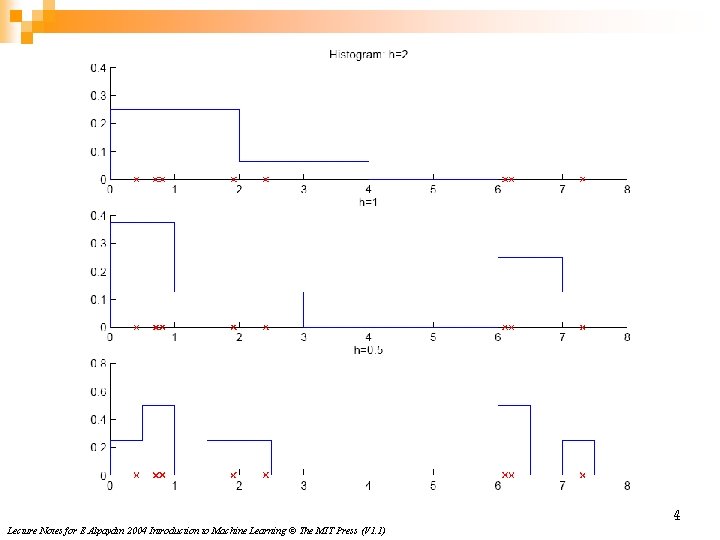

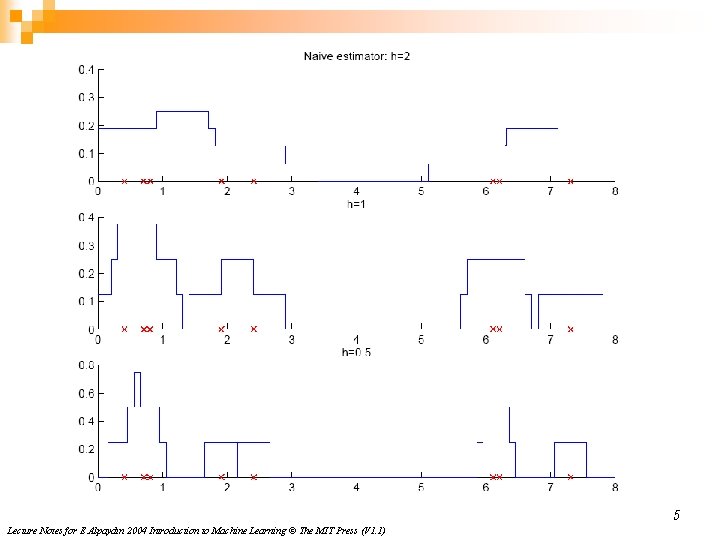

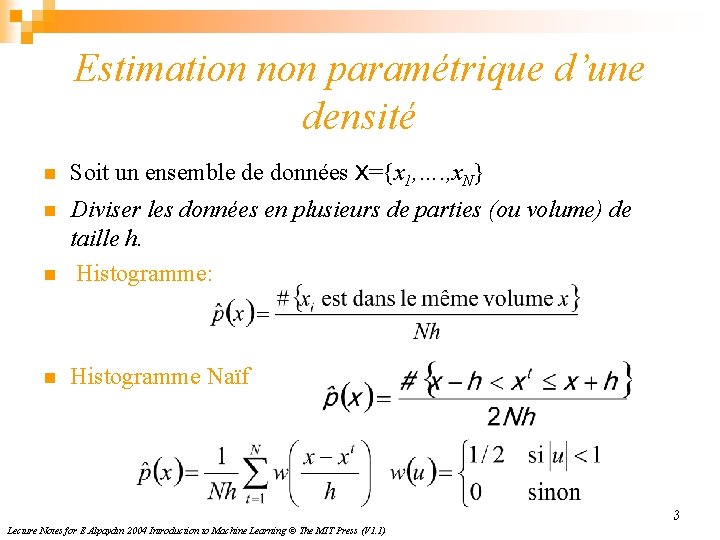

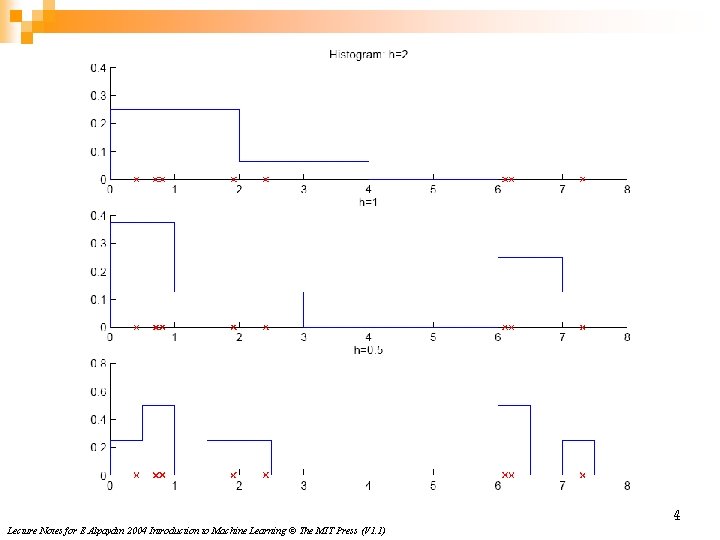

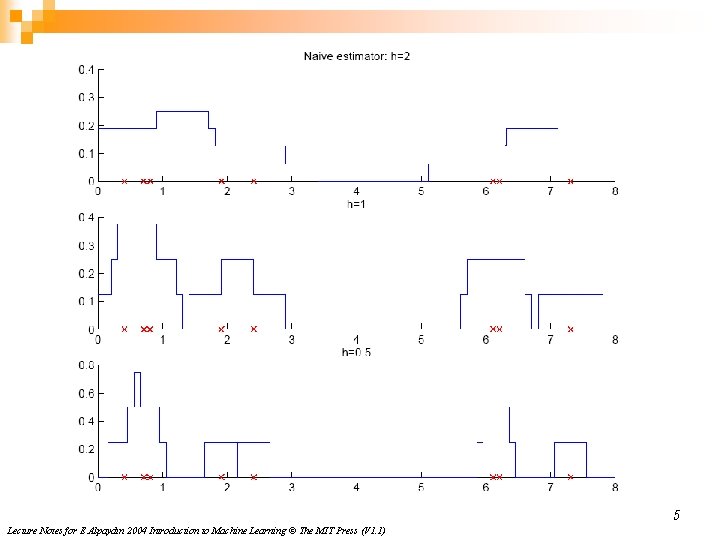

Estimation non paramétrique d’une densité n Soit un ensemble de données X={x 1, …. , x. N} n n Diviser les données en plusieurs de parties (ou volume) de taille h. Histogramme: n Histogramme Naïf 3 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

4 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

5 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

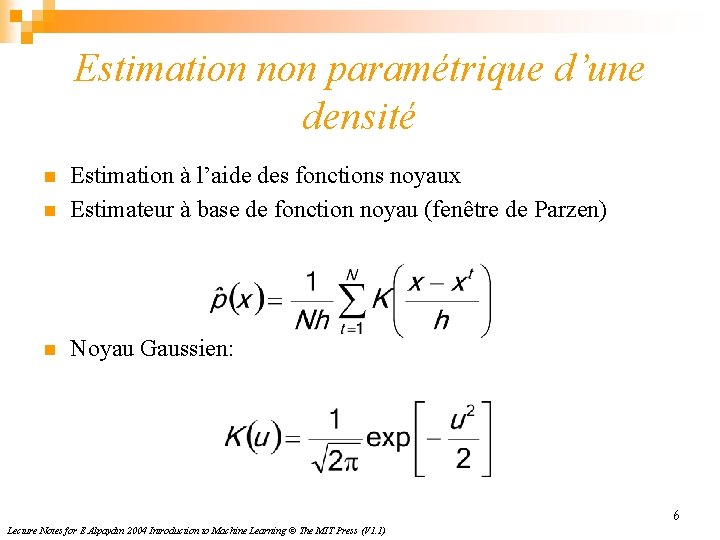

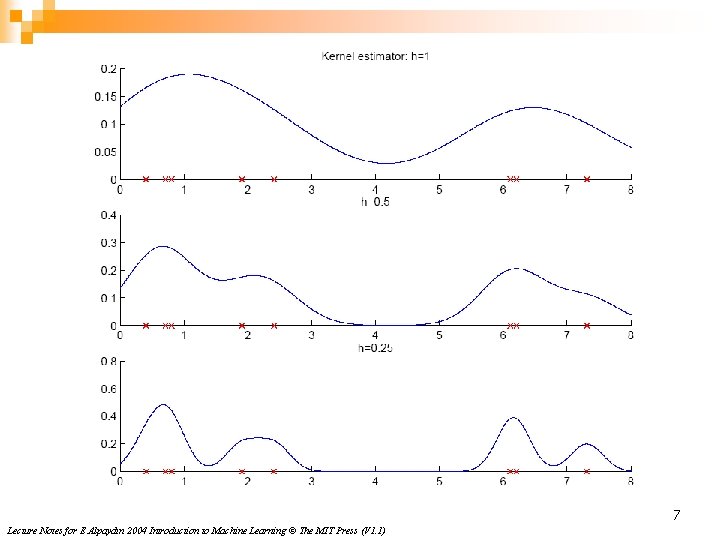

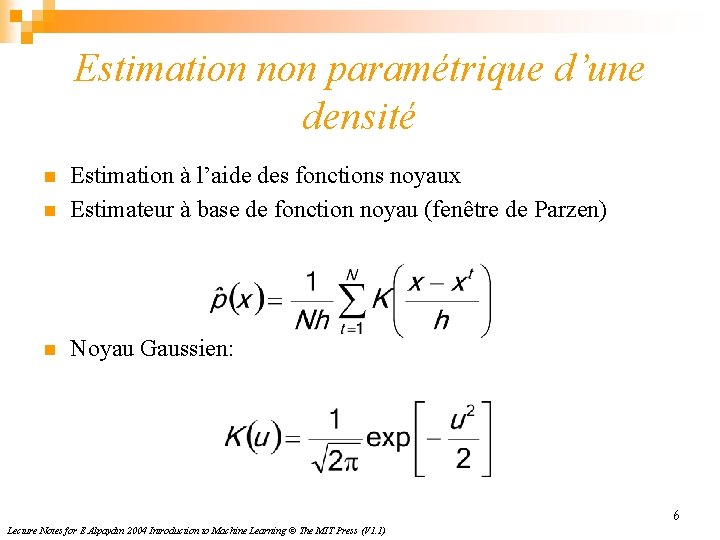

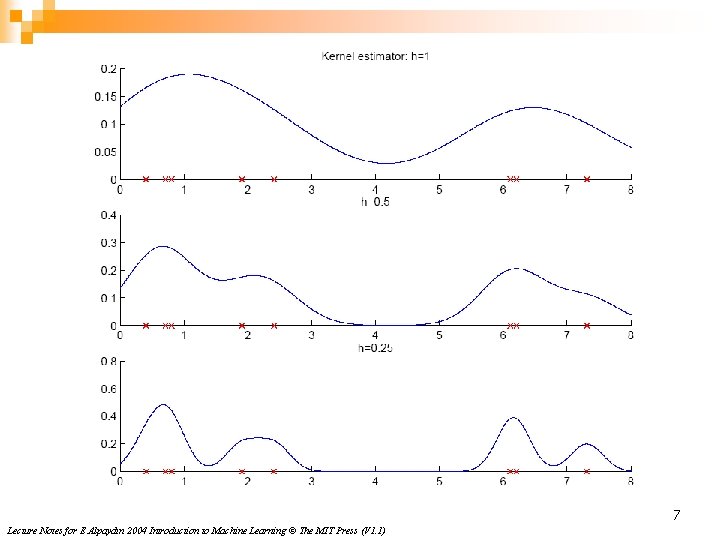

Estimation non paramétrique d’une densité n Estimation à l’aide des fonctions noyaux Estimateur à base de fonction noyau (fenêtre de Parzen) n Noyau Gaussien: n 6 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

7 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

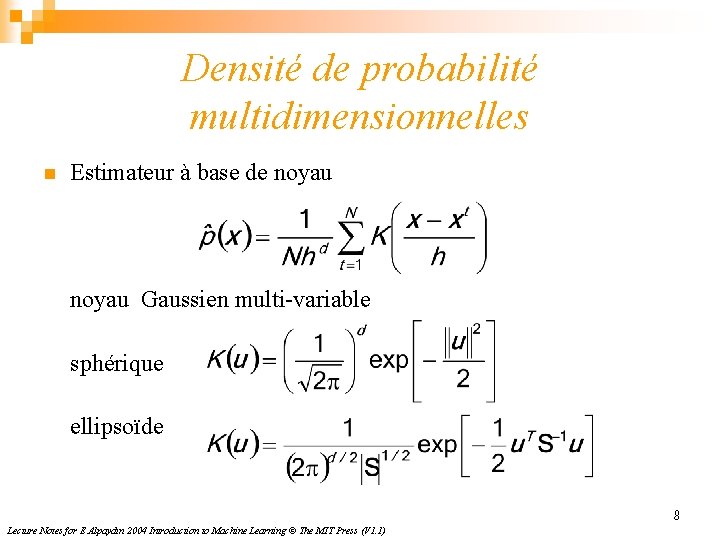

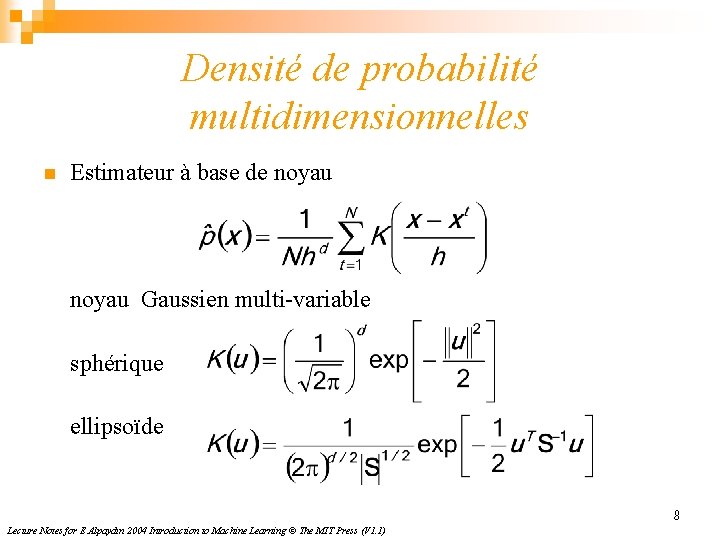

Densité de probabilité multidimensionnelles n Estimateur à base de noyau Gaussien multi-variable sphérique ellipsoïde 8 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

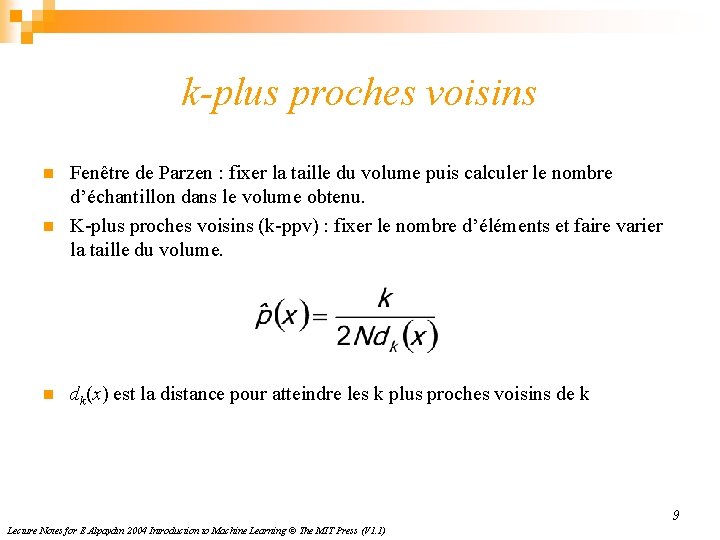

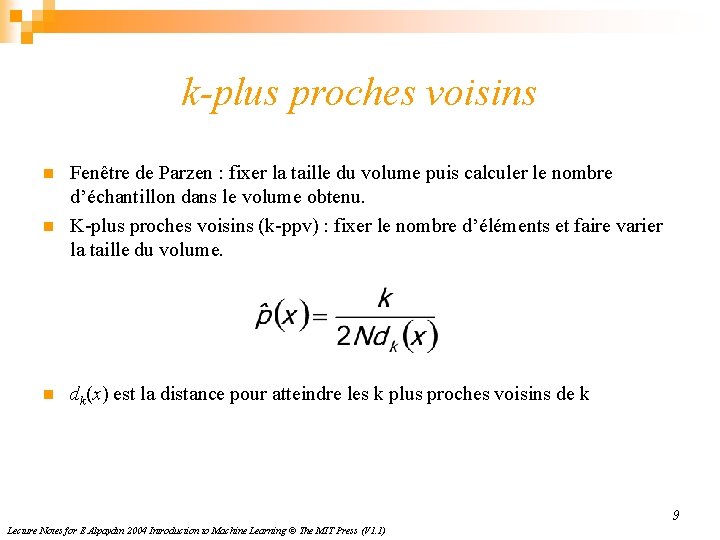

k-plus proches voisins n n n Fenêtre de Parzen : fixer la taille du volume puis calculer le nombre d’échantillon dans le volume obtenu. K-plus proches voisins (k-ppv) : fixer le nombre d’éléments et faire varier la taille du volume. dk(x) est la distance pour atteindre les k plus proches voisins de k 9 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

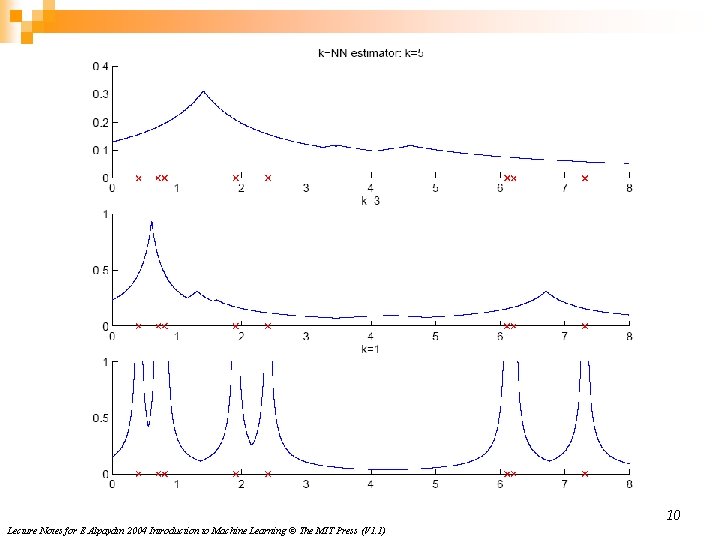

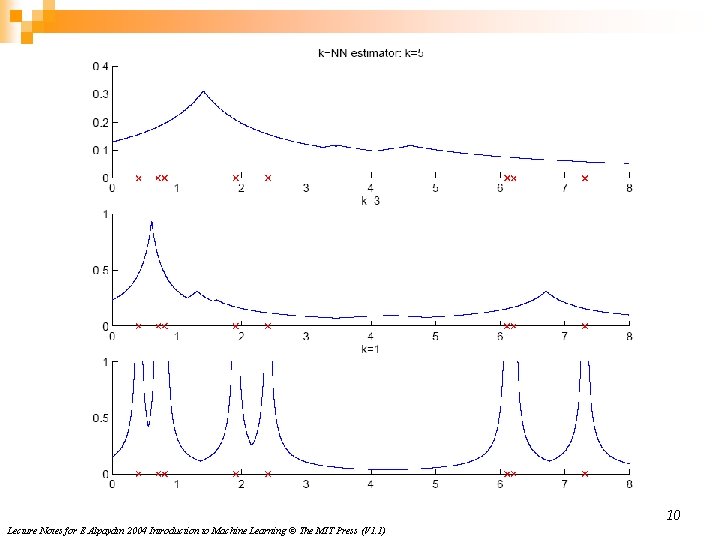

10 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

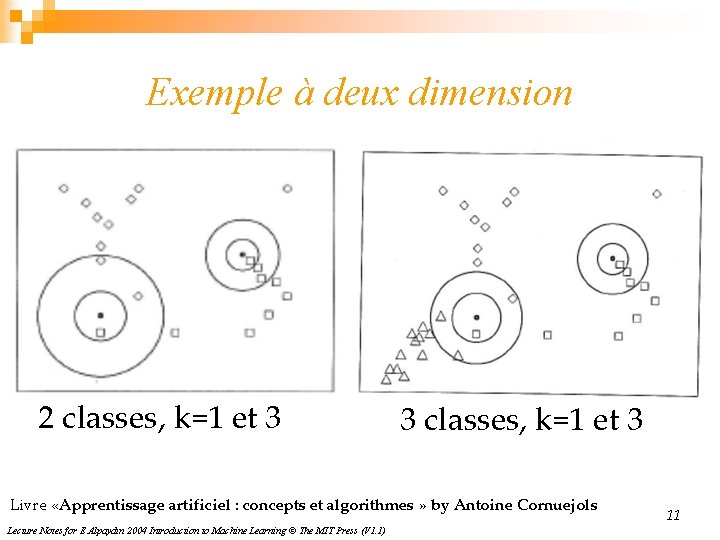

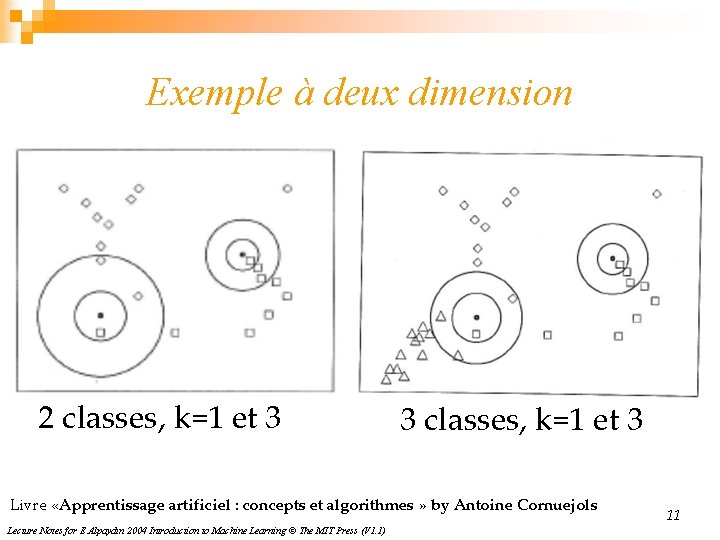

Exemple à deux dimension 2 classes, k=1 et 3 3 classes, k=1 et 3 Livre «Apprentissage artificiel : concepts et algorithmes » by Antoine Cornuejols Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1) 11

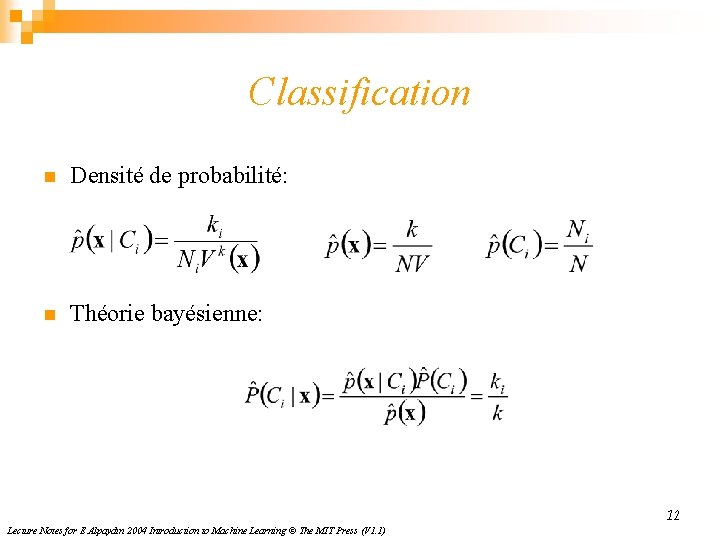

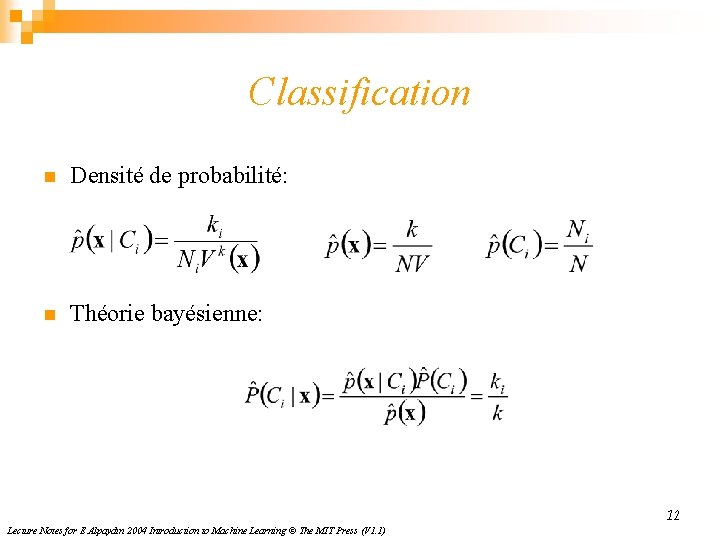

Classification n Densité de probabilité: n Théorie bayésienne: 12 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

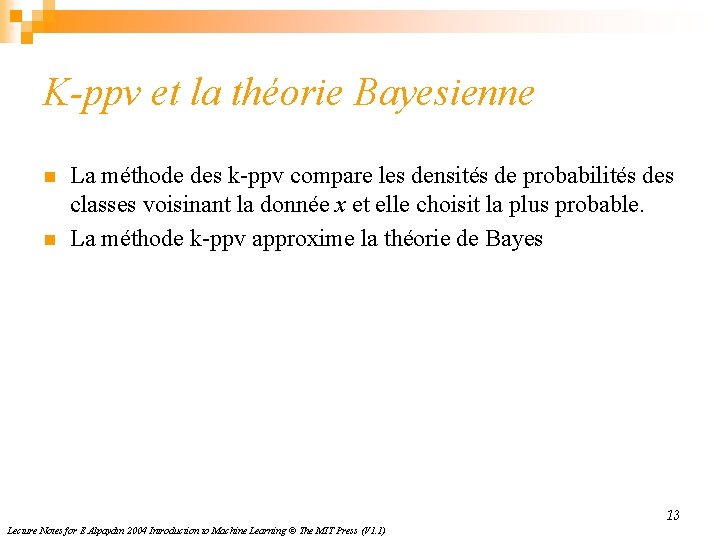

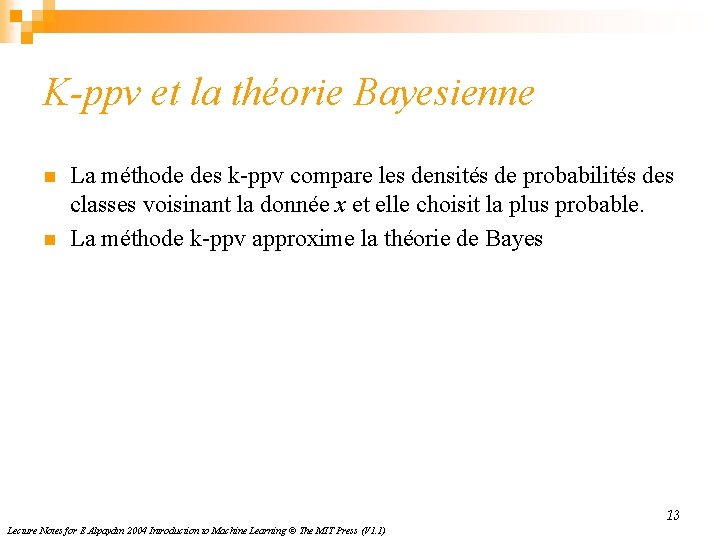

K-ppv et la théorie Bayesienne n n La méthode des k-ppv compare les densités de probabilités des classes voisinant la donnée x et elle choisit la plus probable. La méthode k-ppv approxime la théorie de Bayes 13 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

Les surfaces séparatrices de la règle de décision du k-ppv n n n Pavage de Voronoi Exécuter l’algorithme 1 -ppv Regrouper les zones de la même classe. 14 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

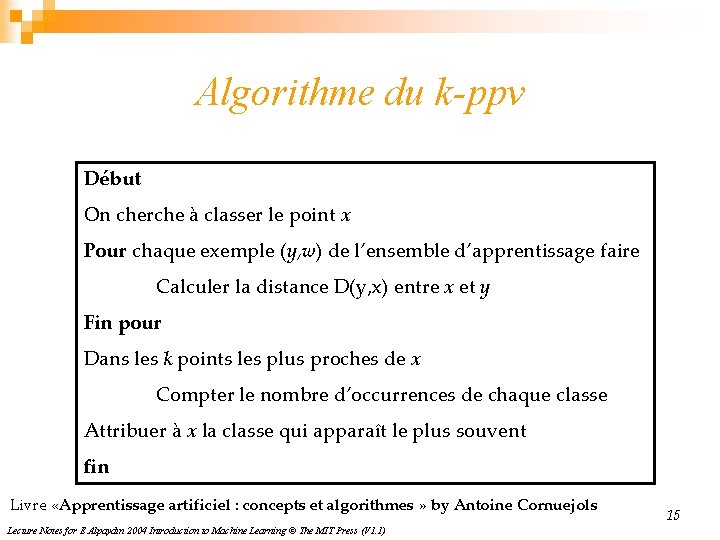

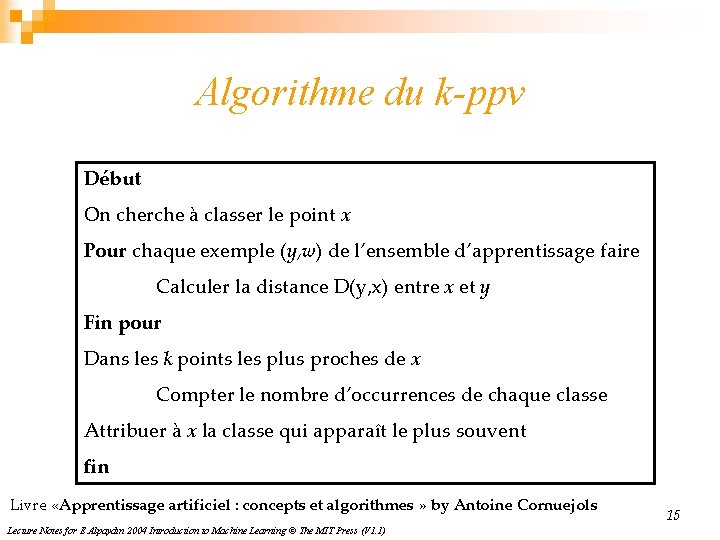

Algorithme du k-ppv Début On cherche à classer le point x Pour chaque exemple (y, w) de l’ensemble d’apprentissage faire Calculer la distance D(y, x) entre x et y Fin pour Dans les k points les plus proches de x Compter le nombre d’occurrences de chaque classe Attribuer à x la classe qui apparaît le plus souvent fin Livre «Apprentissage artificiel : concepts et algorithmes » by Antoine Cornuejols Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1) 15

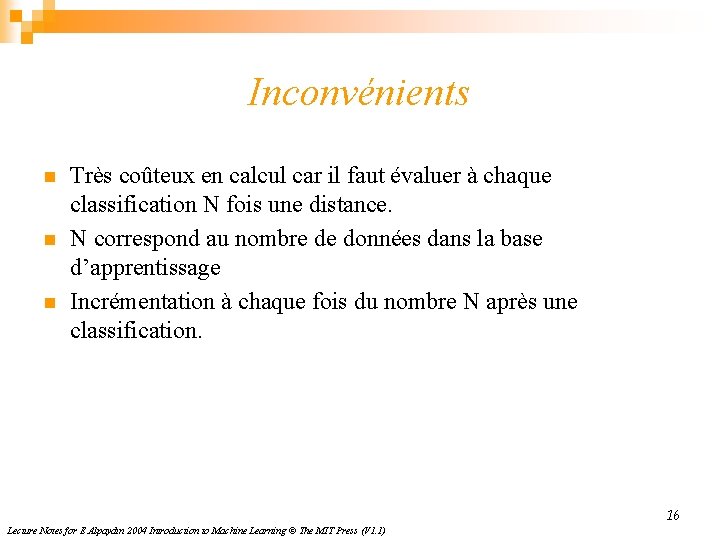

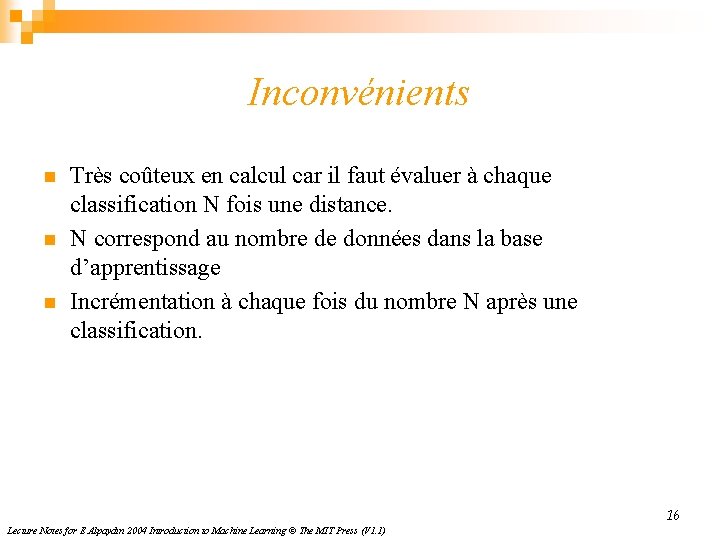

Inconvénients n n n Très coûteux en calcul car il faut évaluer à chaque classification N fois une distance. N correspond au nombre de données dans la base d’apprentissage Incrémentation à chaque fois du nombre N après une classification. 16 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

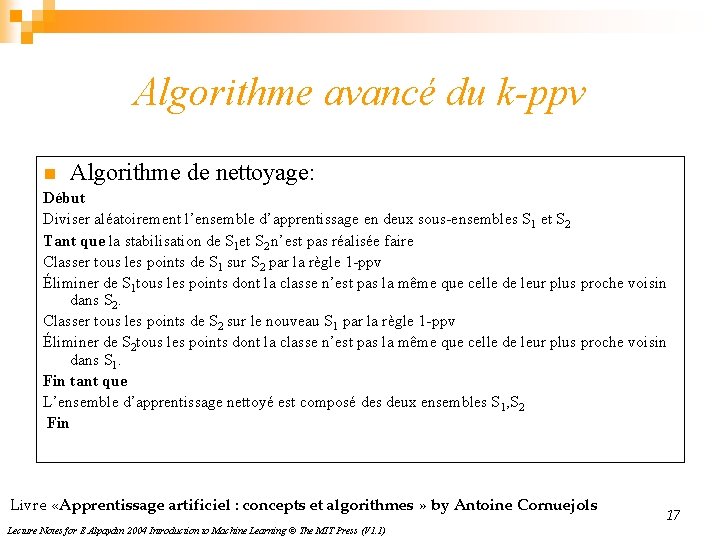

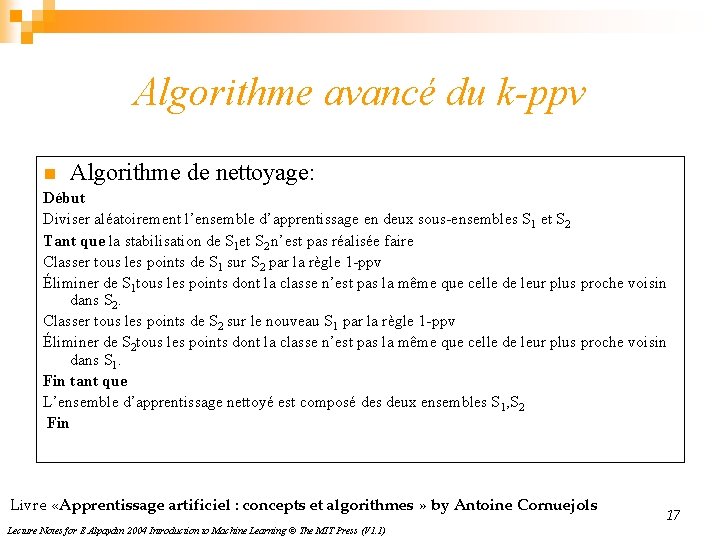

Algorithme avancé du k-ppv n Algorithme de nettoyage: Début Diviser aléatoirement l’ensemble d’apprentissage en deux sous-ensembles S 1 et S 2 Tant que la stabilisation de S 1 et S 2 n’est pas réalisée faire Classer tous les points de S 1 sur S 2 par la règle 1 -ppv Éliminer de S 1 tous les points dont la classe n’est pas la même que celle de leur plus proche voisin dans S 2. Classer tous les points de S 2 sur le nouveau S 1 par la règle 1 -ppv Éliminer de S 2 tous les points dont la classe n’est pas la même que celle de leur plus proche voisin dans S 1. Fin tant que L’ensemble d’apprentissage nettoyé est composé des deux ensembles S 1, S 2 Fin Livre «Apprentissage artificiel : concepts et algorithmes » by Antoine Cornuejols Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1) 17

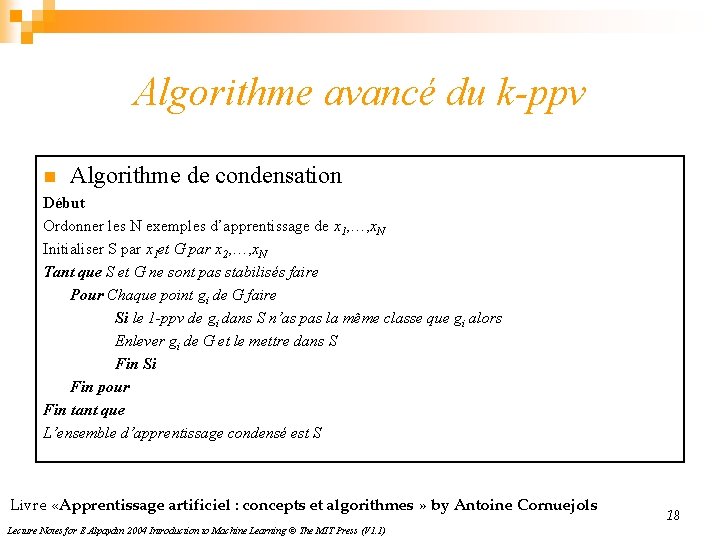

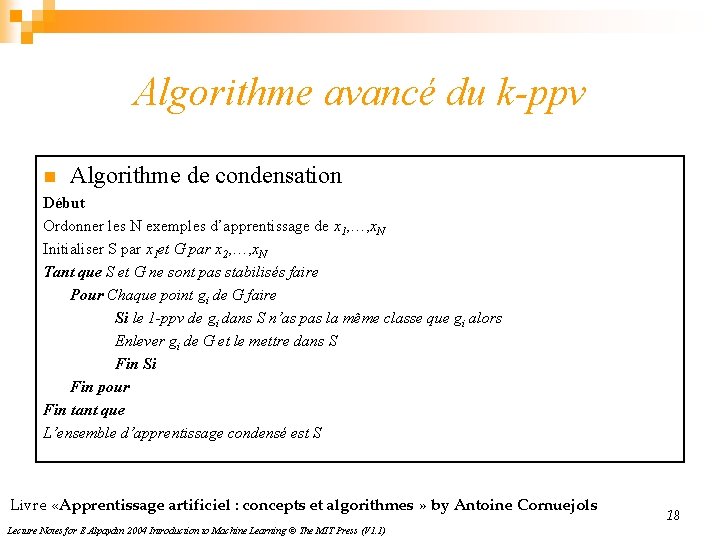

Algorithme avancé du k-ppv n Algorithme de condensation Début Ordonner les N exemples d’apprentissage de x 1, …, x. N Initialiser S par x 1 et G par x 2, …, x. N Tant que S et G ne sont pas stabilisés faire Pour Chaque point gi de G faire Si le 1 -ppv de gi dans S n’as pas la même classe que gi alors Enlever gi de G et le mettre dans S Fin Si Fin pour Fin tant que L’ensemble d’apprentissage condensé est S Livre «Apprentissage artificiel : concepts et algorithmes » by Antoine Cornuejols Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1) 18

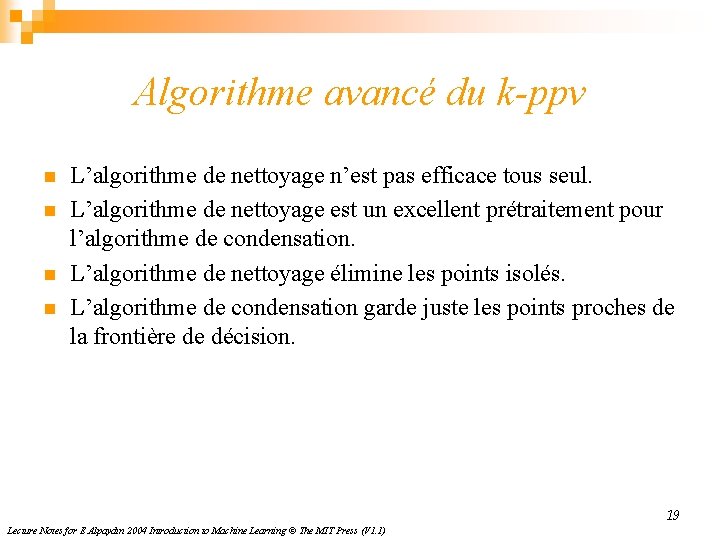

Algorithme avancé du k-ppv n n L’algorithme de nettoyage n’est pas efficace tous seul. L’algorithme de nettoyage est un excellent prétraitement pour l’algorithme de condensation. L’algorithme de nettoyage élimine les points isolés. L’algorithme de condensation garde juste les points proches de la frontière de décision. 19 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

Après condensation Après nettoyage et condensation Livre «Apprentissage artificiel : concepts et algorithmes » by Antoine Cornuejols Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1) 20

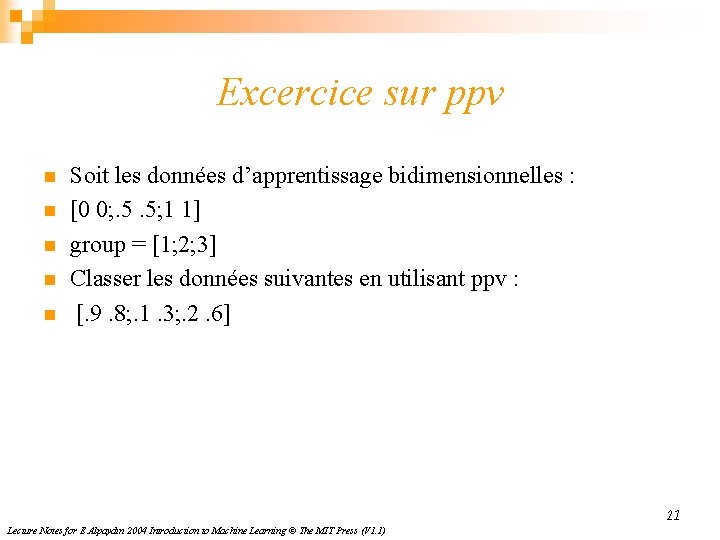

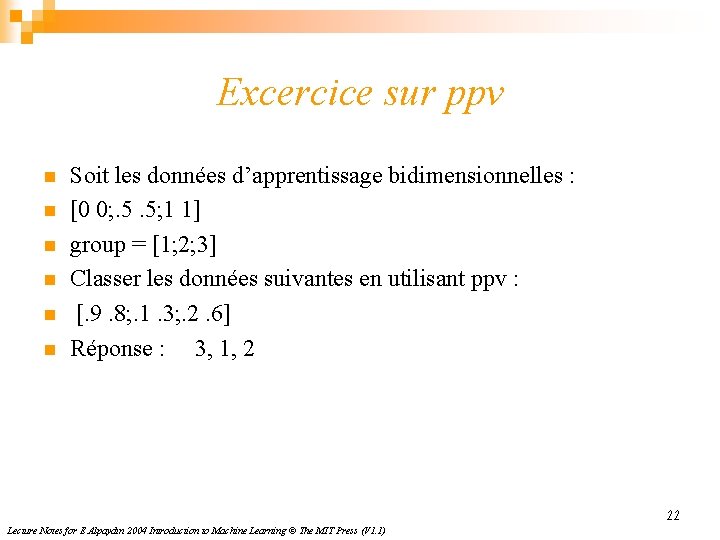

Excercice sur ppv n n n Soit les données d’apprentissage bidimensionnelles : [0 0; . 5. 5; 1 1] group = [1; 2; 3] Classer les données suivantes en utilisant ppv : [. 9. 8; . 1. 3; . 2. 6] 21 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

Excercice sur ppv n n n Soit les données d’apprentissage bidimensionnelles : [0 0; . 5. 5; 1 1] group = [1; 2; 3] Classer les données suivantes en utilisant ppv : [. 9. 8; . 1. 3; . 2. 6] Réponse : 3, 1, 2 22 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)

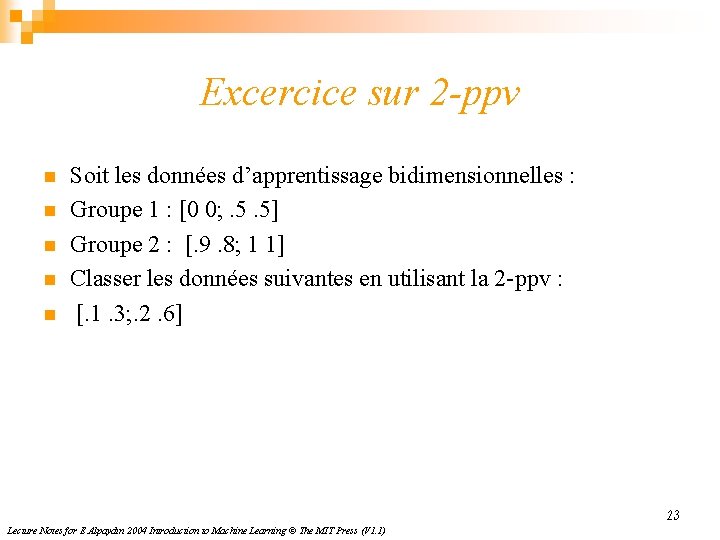

Excercice sur 2 -ppv n n n Soit les données d’apprentissage bidimensionnelles : Groupe 1 : [0 0; . 5. 5] Groupe 2 : [. 9. 8; 1 1] Classer les données suivantes en utilisant la 2 -ppv : [. 1. 3; . 2. 6] 23 Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V 1. 1)