INTELLIGENT AGENT Nelly Indriani Widiastuti S Si M

- Slides: 34

INTELLIGENT AGENT

Nelly Indriani Widiastuti S. Si. , M. T. Nelly Indriani nelly. indriani@email. unikom. ac. id

1 MATERI DEFINISI RASIONALITAS AGEN TIPE AGEN LINGKUNGAN

“ DEFINISI

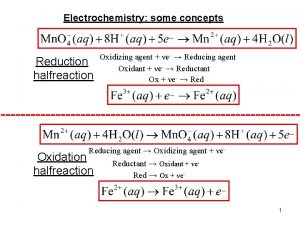

INTELLIGENT AGENT IS… RUSSEL&NORVIG, 1955 OKAMOTO & TAKAOKA, 1997 Sesuatu yang memiliki kemampuan merasakan pengaruh lingkungan melalui sensor dan mampu melakukan respon balik kepada lingkungan tsb melalui effector Mempunyai tujuan Memberdayakan resource Memecahkan masalah Action Sensors Environment Actuator Perceipt HUMAN AGENT (agen yang menyerupai manusia) Sensor : mata, telinga. Effector : tangan, kaki, mulut dan lain-lain. .

“ The process by which intelligent agents sense, perceive, and interpret their external worlds, called domains. Agents use built-in sensors in order to obtain sensory data Intelligent Agent Perceptions

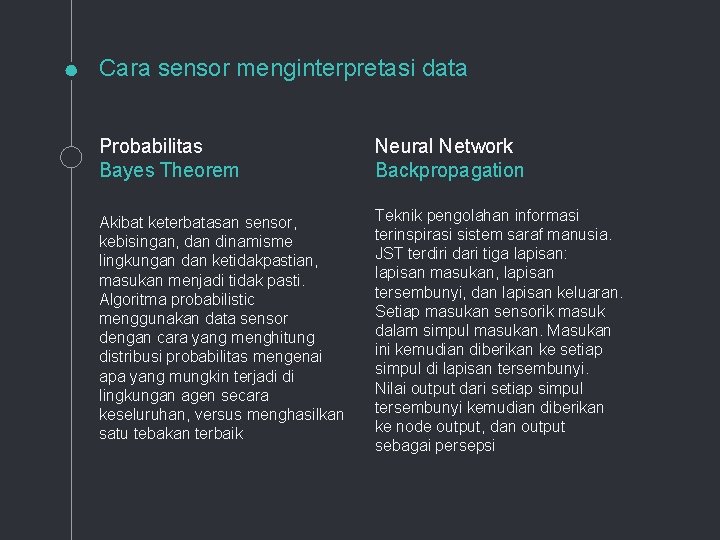

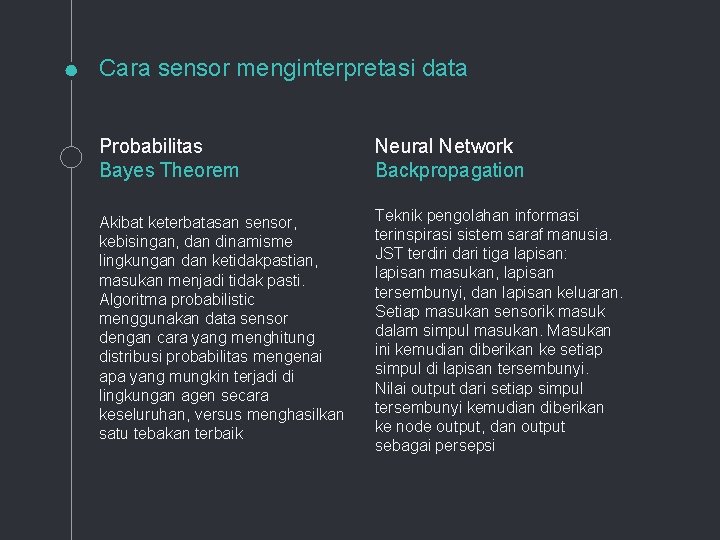

Cara sensor menginterpretasi data Probabilitas Bayes Theorem Neural Network Backpropagation Akibat keterbatasan sensor, kebisingan, dan dinamisme lingkungan dan ketidakpastian, masukan menjadi tidak pasti. Algoritma probabilistic menggunakan data sensor dengan cara yang menghitung distribusi probabilitas mengenai apa yang mungkin terjadi di lingkungan agen secara keseluruhan, versus menghasilkan satu tebakan terbaik Teknik pengolahan informasi terinspirasi sistem saraf manusia. JST terdiri dari tiga lapisan: lapisan masukan, lapisan tersembunyi, dan lapisan keluaran. Setiap masukan sensorik masuk dalam simpul masukan. Masukan ini kemudian diberikan ke setiap simpul di lapisan tersembunyi. Nilai output dari setiap simpul tersembunyi kemudian diberikan ke node output, dan output sebagai persepsi

“ RASIONALITAS AGEN

“ Agent yg rasional : sesuatu yang melakukan dengan benar

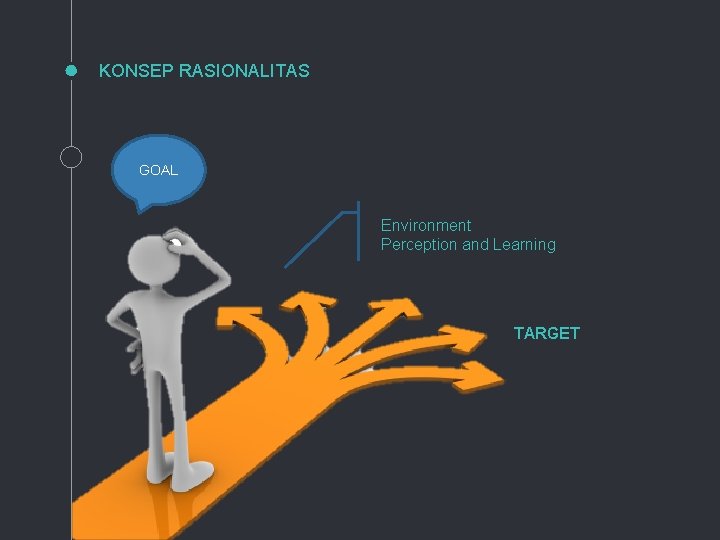

KONSEP RASIONALITAS GOAL Environment Perception and Learning TARGET

RATIONALITAS Prior Performace Knowledge Measures of environment ACTIONS Percept Sequence

PERFORMANCE MEASURES (PM) Dalam setiap rangkaian persepsi yang memungkinkan, Agen rasional seharusnya memilih aksi yang diharapkan memaksimalkan PM, dengan memiliki bukti persepsi dan pengetahuan apapun yang ada dalam agen. .

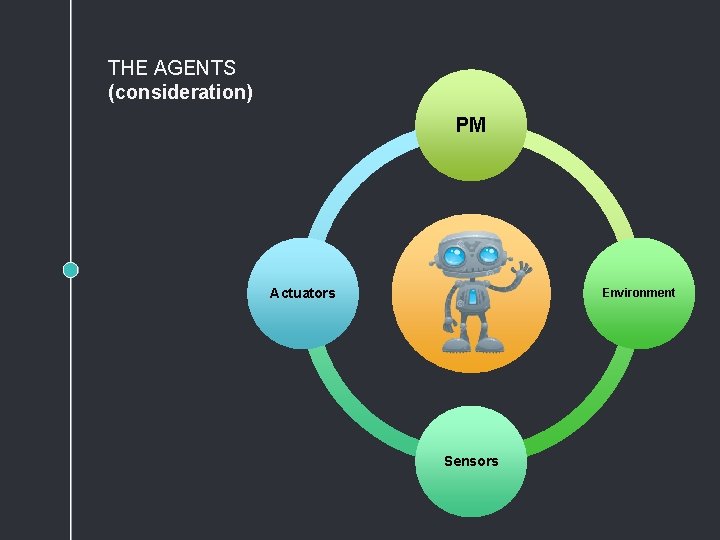

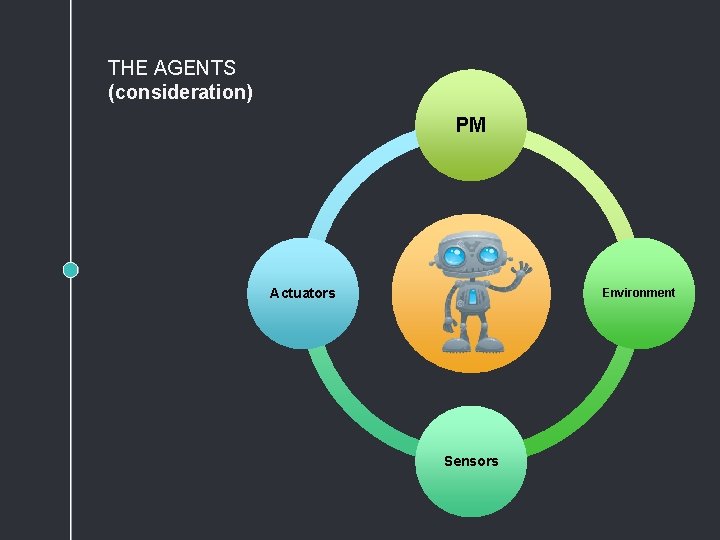

THE AGENTS (consideration) PM Actuators Environment Sensors

TIPE-TIPE AGEN

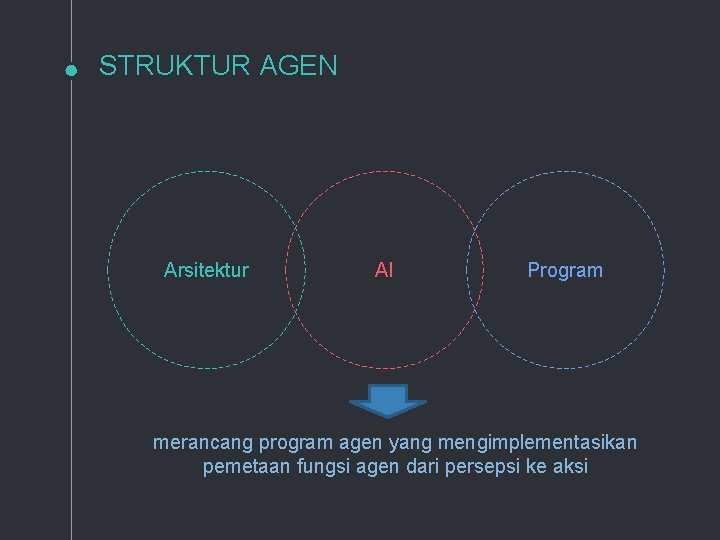

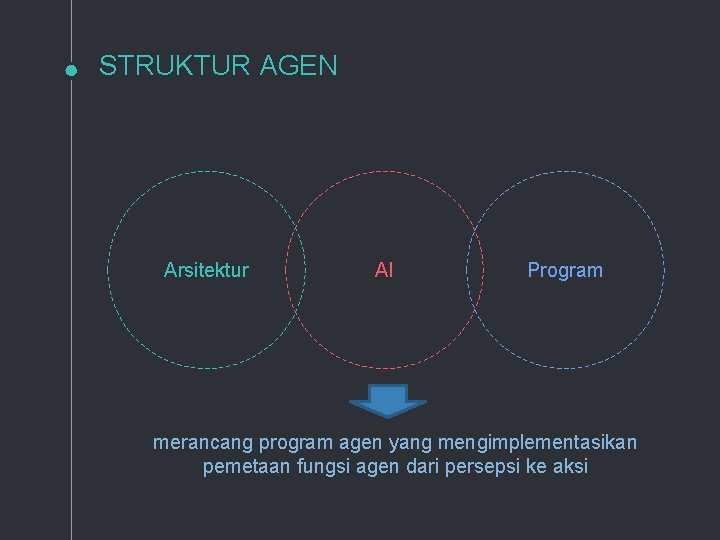

STRUKTUR AGEN Arsitektur AI Program merancang program agen yang mengimplementasikan pemetaan fungsi agen dari persepsi ke aksi

SIMPLE REFLEX AGENT ◦Memilih aksi berdasarkan persepsi saat ini, dan mengabaikan persepsi yang lalu ◦Contoh : agen penyedot debu hanya memutuskan menyalakan alat sedot saat terindikasi ada kotoran. If car-in-front-is-braking then initiate-braking

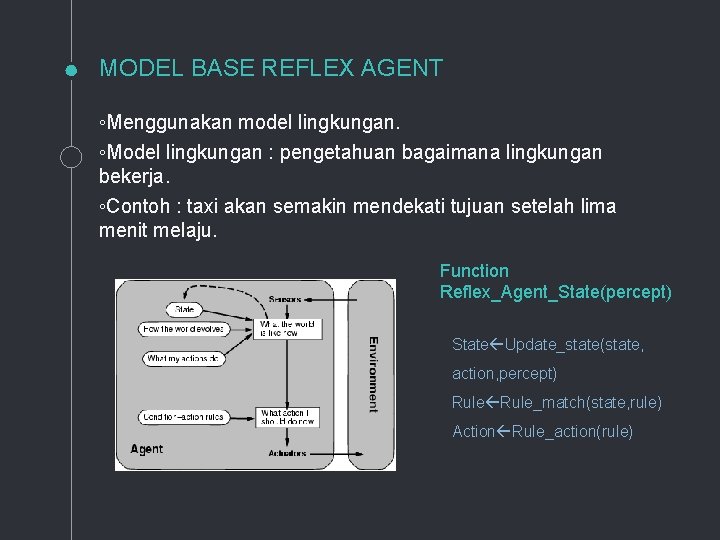

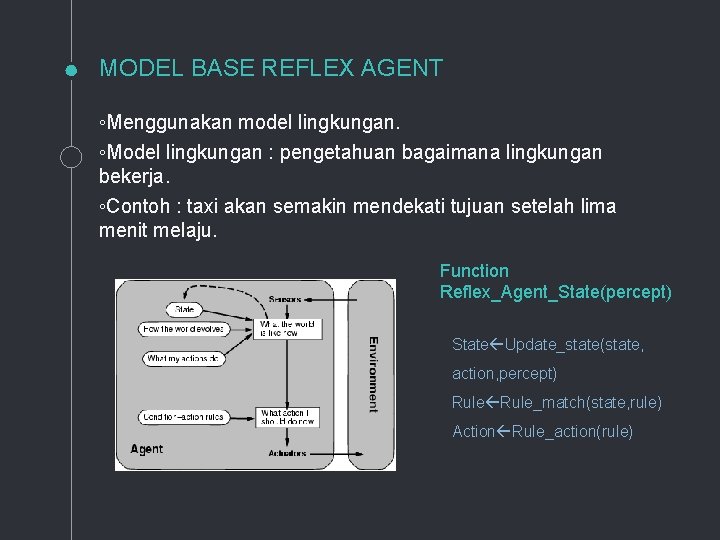

MODEL BASE REFLEX AGENT ◦Menggunakan model lingkungan. ◦Model lingkungan : pengetahuan bagaimana lingkungan bekerja. ◦Contoh : taxi akan semakin mendekati tujuan setelah lima menit melaju. Function Reflex_Agent_State(percept) State Update_state(state, action, percept) Rule_match(state, rule) Action Rule_action(rule)

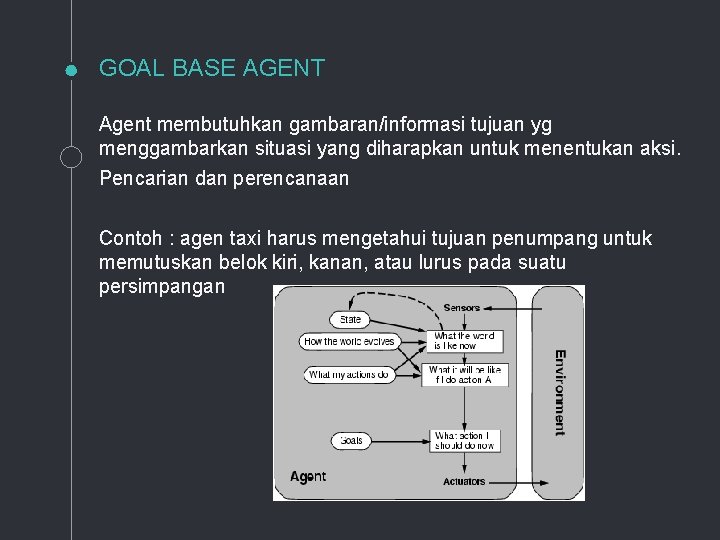

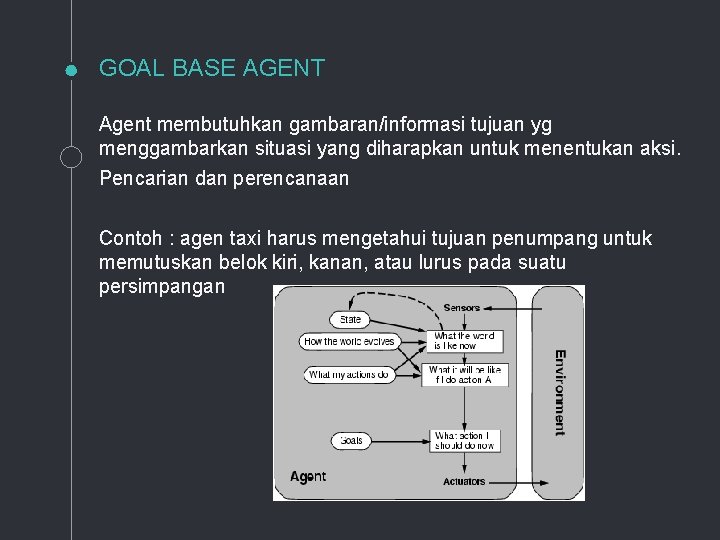

GOAL BASE AGENT Agent membutuhkan gambaran/informasi tujuan yg menggambarkan situasi yang diharapkan untuk menentukan aksi. Pencarian dan perencanaan Contoh : agen taxi harus mengetahui tujuan penumpang untuk memutuskan belok kiri, kanan, atau lurus pada suatu persimpangan

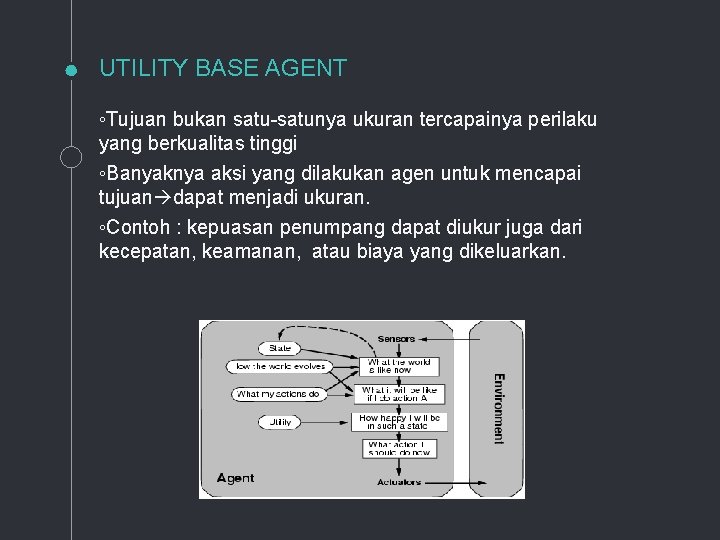

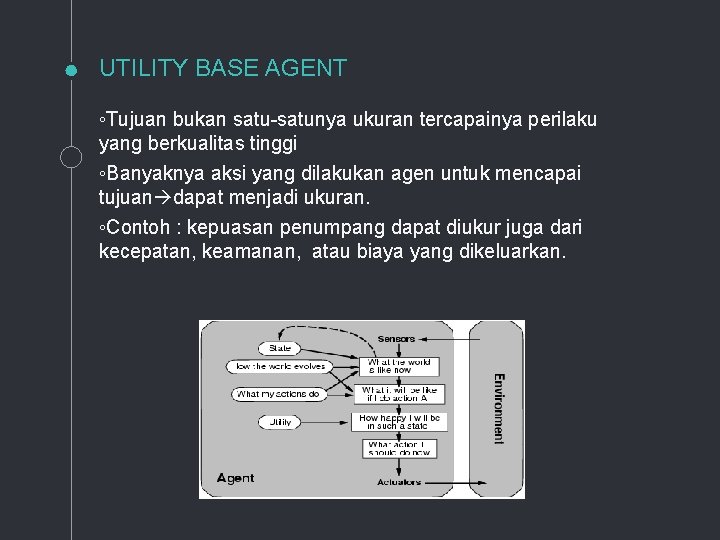

UTILITY BASE AGENT ◦Tujuan bukan satu-satunya ukuran tercapainya perilaku yang berkualitas tinggi ◦Banyaknya aksi yang dilakukan agen untuk mencapai tujuan dapat menjadi ukuran. ◦Contoh : kepuasan penumpang dapat diukur juga dari kecepatan, keamanan, atau biaya yang dikeluarkan.

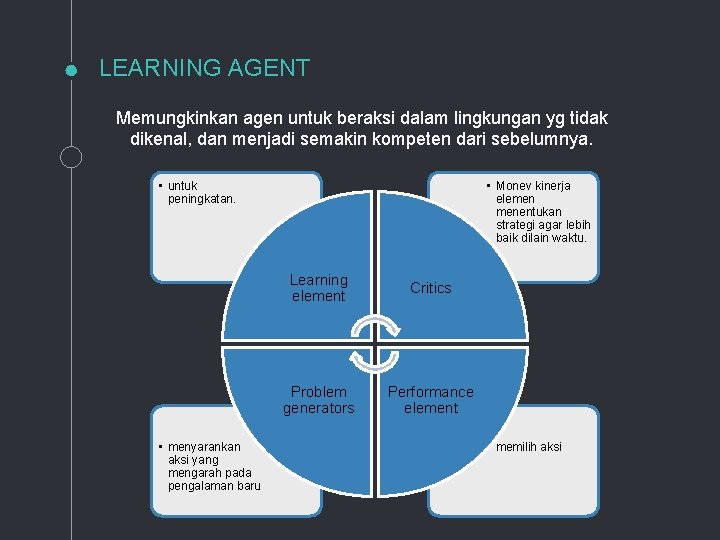

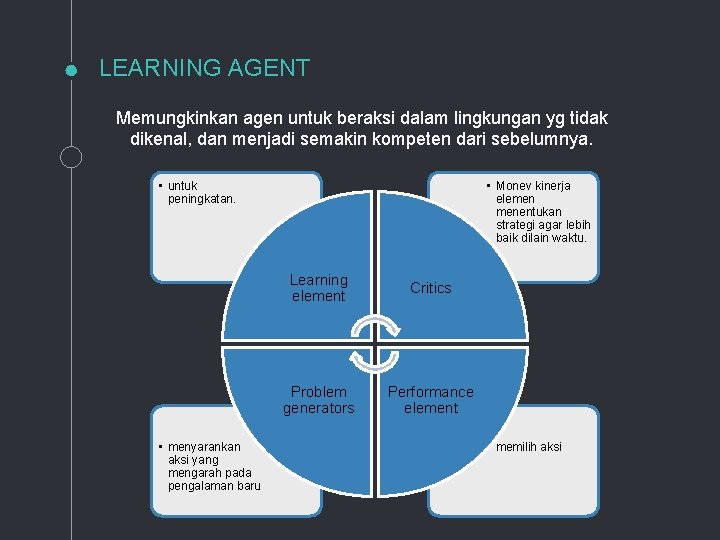

LEARNING AGENT Memungkinkan agen untuk beraksi dalam lingkungan yg tidak dikenal, dan menjadi semakin kompeten dari sebelumnya. • untuk peningkatan. • menyarankan aksi yang mengarah pada pengalaman baru • Monev kinerja elemen menentukan strategi agar lebih baik dilain waktu. Learning element Critics Problem generators Performance element • memilih aksi

“ LINGKUNGAN

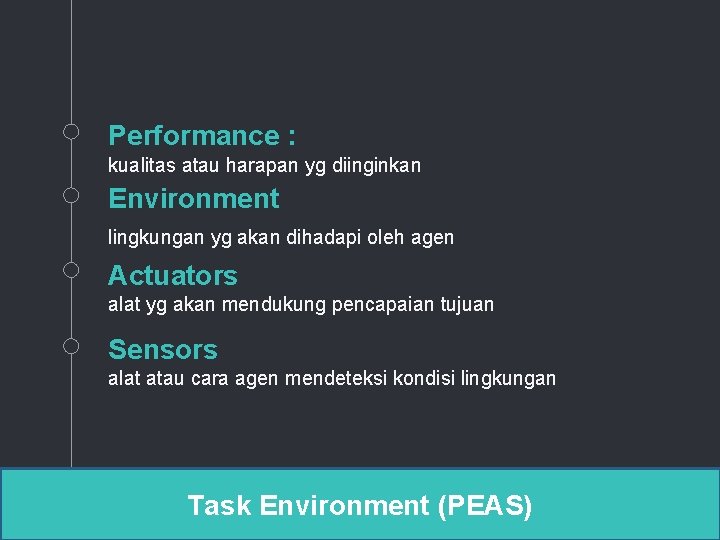

Performance : kualitas atau harapan yg diinginkan Environment lingkungan yg akan dihadapi oleh agen Actuators alat yg akan mendukung pencapaian tujuan Sensors alat atau cara agen mendeteksi kondisi lingkungan Task Environment (PEAS)

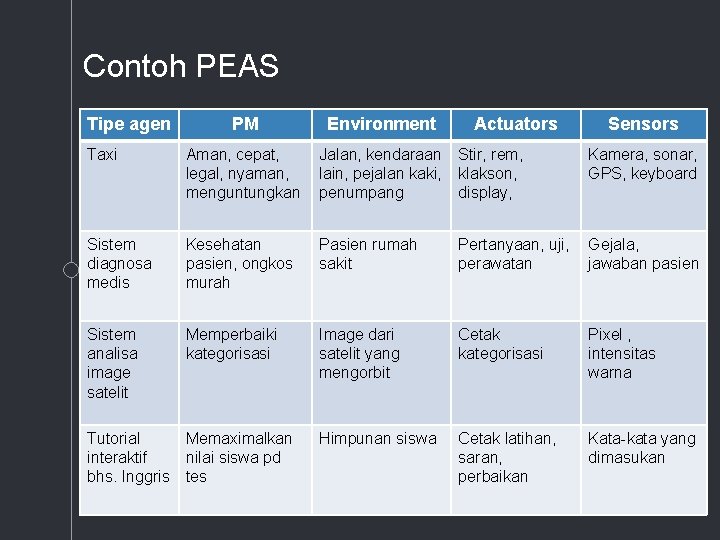

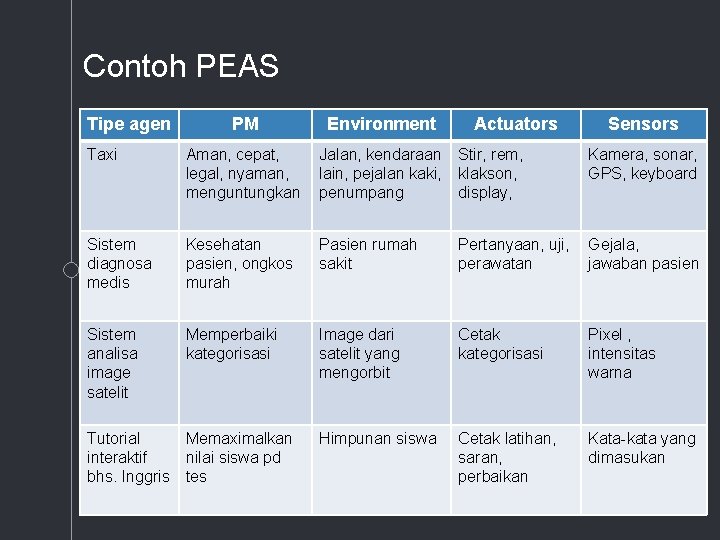

Contoh PEAS Tipe agen PM Environment Taxi Aman, cepat, legal, nyaman, menguntungkan Jalan, kendaraan lain, pejalan kaki, penumpang Stir, rem, klakson, display, Kamera, sonar, GPS, keyboard Sistem diagnosa medis Kesehatan pasien, ongkos murah Pasien rumah sakit Pertanyaan, uji, perawatan Gejala, jawaban pasien Sistem analisa image satelit Memperbaiki kategorisasi Image dari satelit yang mengorbit Cetak kategorisasi Pixel , intensitas warna Himpunan siswa Cetak latihan, saran, perbaikan Kata-kata yang dimasukan Tutorial Memaximalkan interaktif nilai siswa pd bhs. Inggris tes Actuators Sensors

Lingkungan & sifatnya Agen dipengaruhi juga oleh lingkungan dimana agen digunakan.

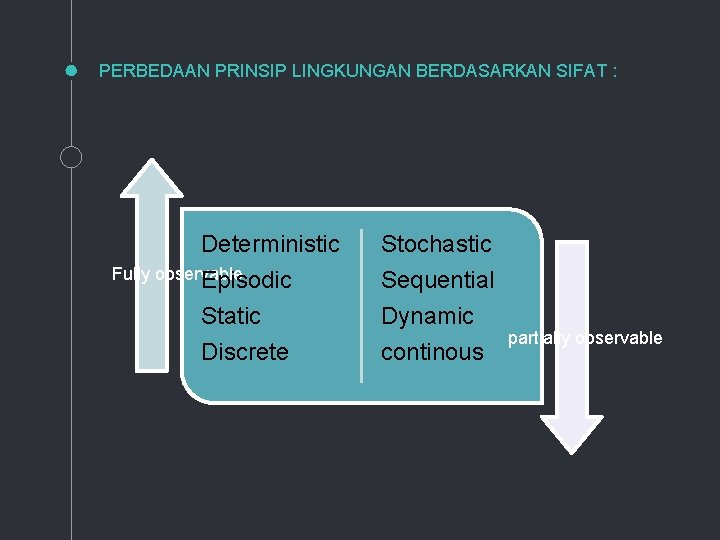

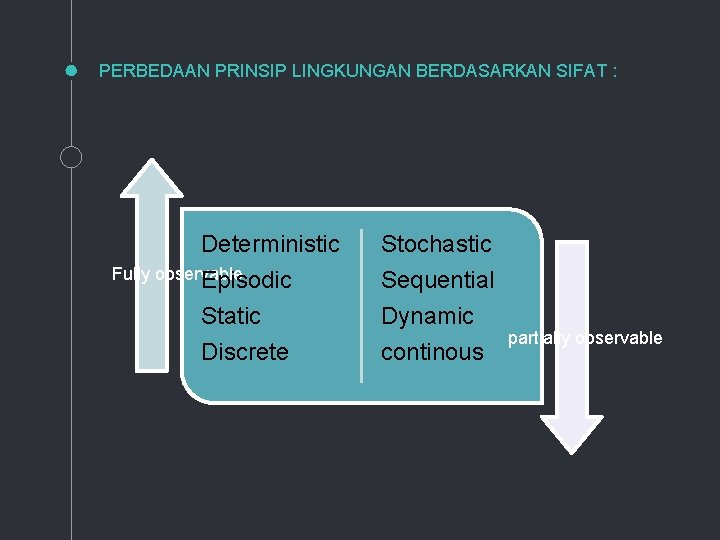

PERBEDAAN PRINSIP LINGKUNGAN BERDASARKAN SIFAT : Deterministic Fully observable Episodic Static Discrete Stochastic Sequential Dynamic continous partially observable

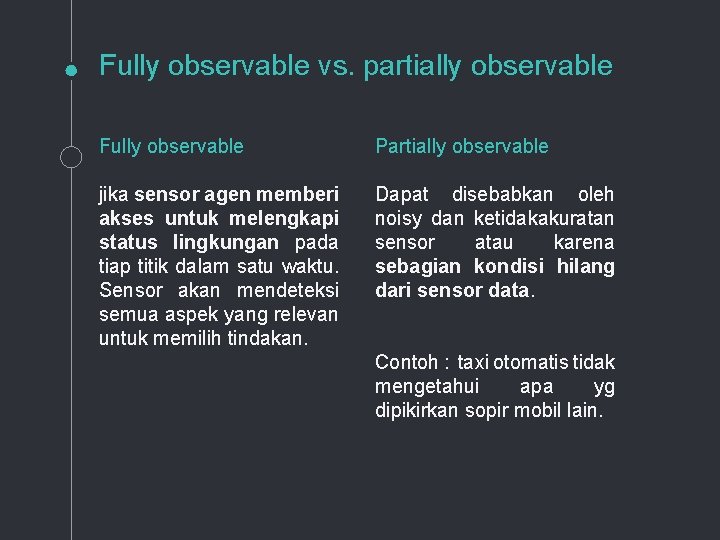

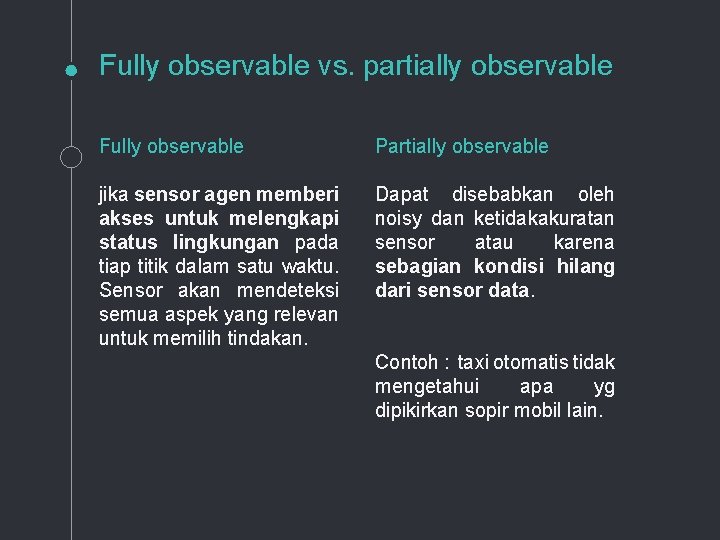

Fully observable vs. partially observable Fully observable Partially observable jika sensor agen memberi akses untuk melengkapi status lingkungan pada tiap titik dalam satu waktu. Sensor akan mendeteksi semua aspek yang relevan untuk memilih tindakan. Dapat disebabkan oleh noisy dan ketidakakuratan sensor atau karena sebagian kondisi hilang dari sensor data. Contoh : taxi otomatis tidak mengetahui apa yg dipikirkan sopir mobil lain.

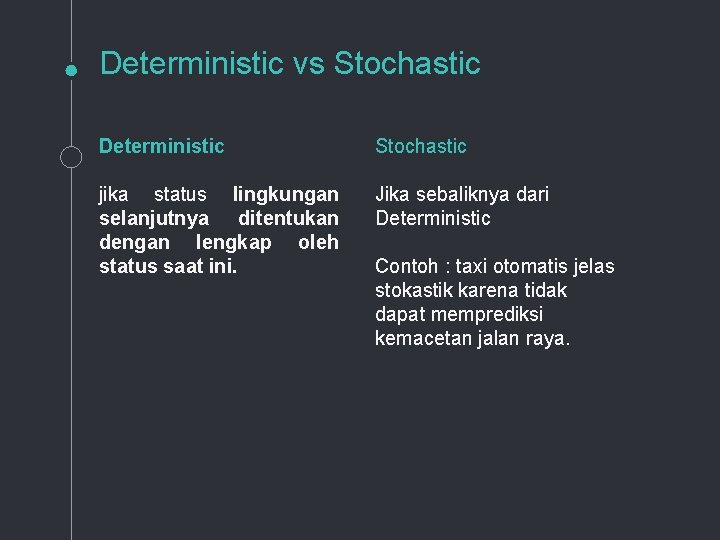

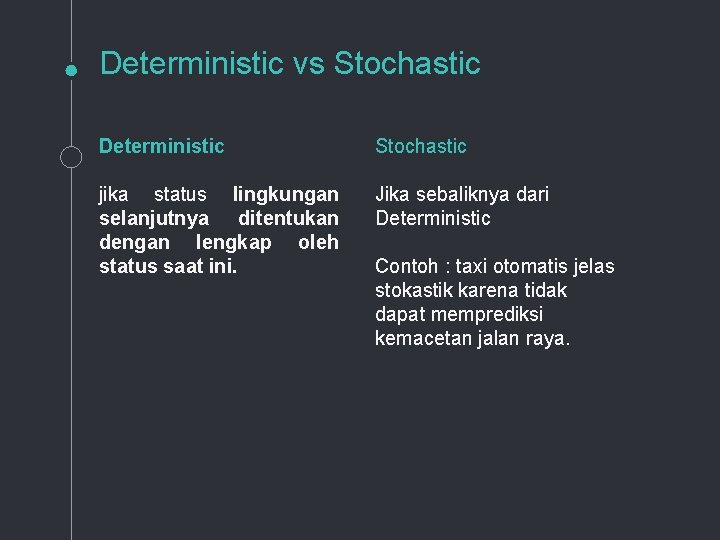

Deterministic vs Stochastic Deterministic Stochastic jika status lingkungan selanjutnya ditentukan dengan lengkap oleh status saat ini. Jika sebaliknya dari Deterministic Contoh : taxi otomatis jelas stokastik karena tidak dapat memprediksi kemacetan jalan raya.

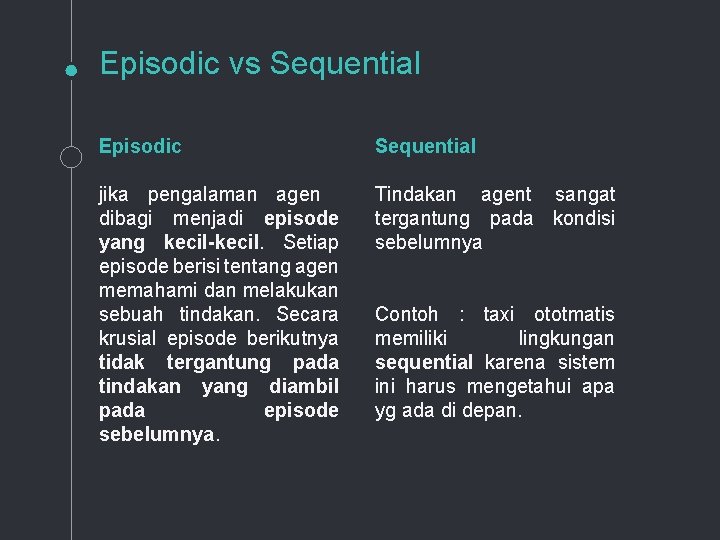

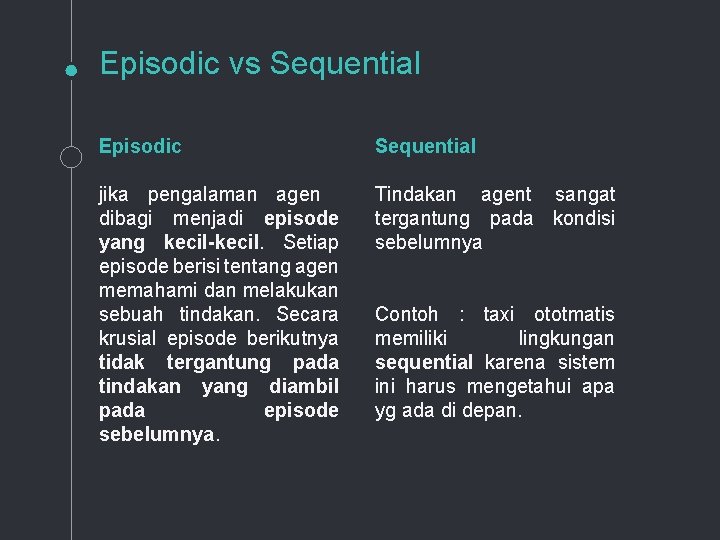

Episodic vs Sequential Episodic Sequential jika pengalaman agen dibagi menjadi episode yang kecil-kecil. Setiap episode berisi tentang agen memahami dan melakukan sebuah tindakan. Secara krusial episode berikutnya tidak tergantung pada tindakan yang diambil pada episode sebelumnya. Tindakan agent sangat tergantung pada kondisi sebelumnya Contoh : taxi ototmatis memiliki lingkungan sequential karena sistem ini harus mengetahui apa yg ada di depan.

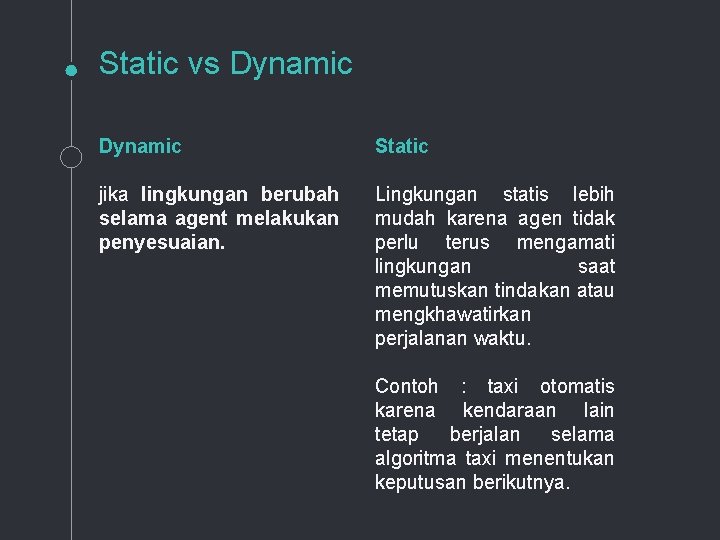

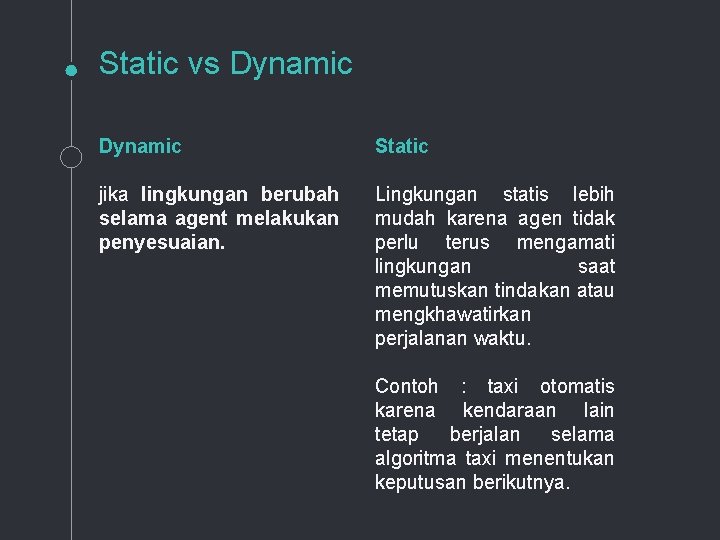

Static vs Dynamic Static jika lingkungan berubah selama agent melakukan penyesuaian. Lingkungan statis lebih mudah karena agen tidak perlu terus mengamati lingkungan saat memutuskan tindakan atau mengkhawatirkan perjalanan waktu. Contoh : taxi otomatis karena kendaraan lain tetap berjalan selama algoritma taxi menentukan keputusan berikutnya.

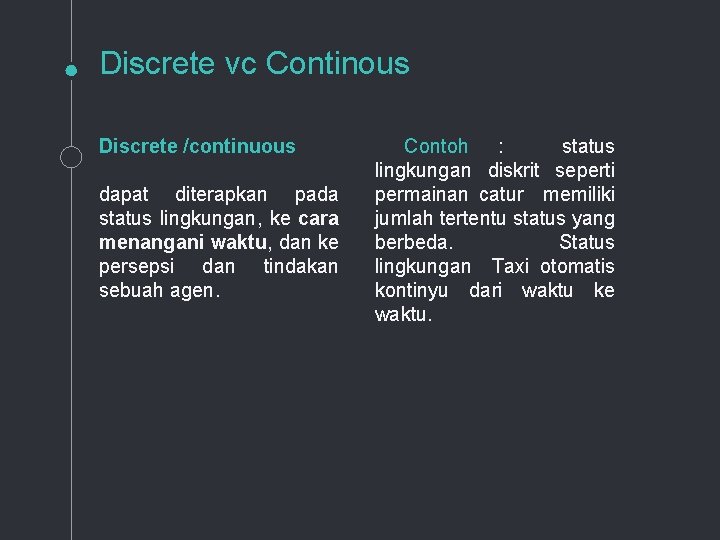

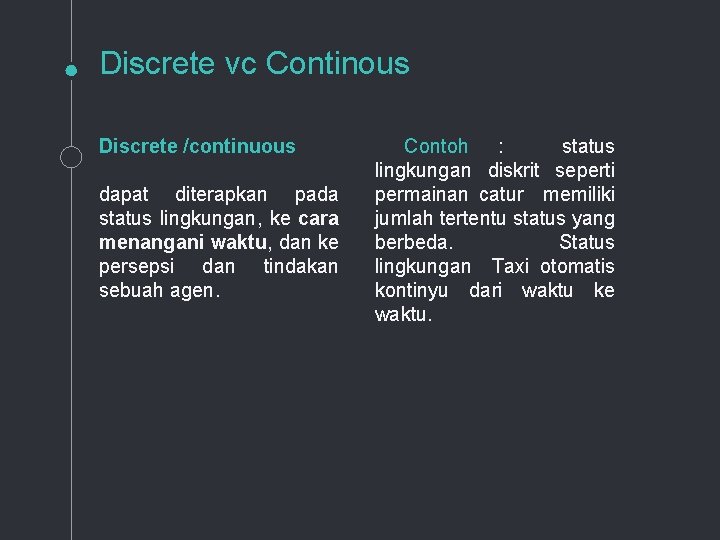

Discrete vc Continous Discrete /continuous dapat diterapkan pada status lingkungan, ke cara menangani waktu, dan ke persepsi dan tindakan sebuah agen. Contoh : status lingkungan diskrit seperti permainan catur memiliki jumlah tertentu status yang berbeda. Status lingkungan Taxi otomatis kontinyu dari waktu ke waktu.

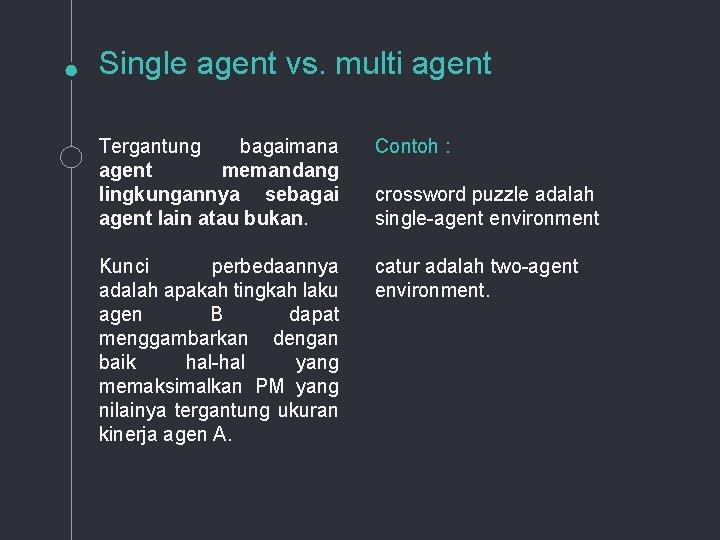

Single agent vs. multi agent Tergantung bagaimana agent memandang lingkungannya sebagai agent lain atau bukan. Contoh : Kunci perbedaannya adalah apakah tingkah laku agen B dapat menggambarkan dengan baik hal-hal yang memaksimalkan PM yang nilainya tergantung ukuran kinerja agen A. catur adalah two-agent environment. crossword puzzle adalah single-agent environment

Thanks! ANY QUESTIONS?

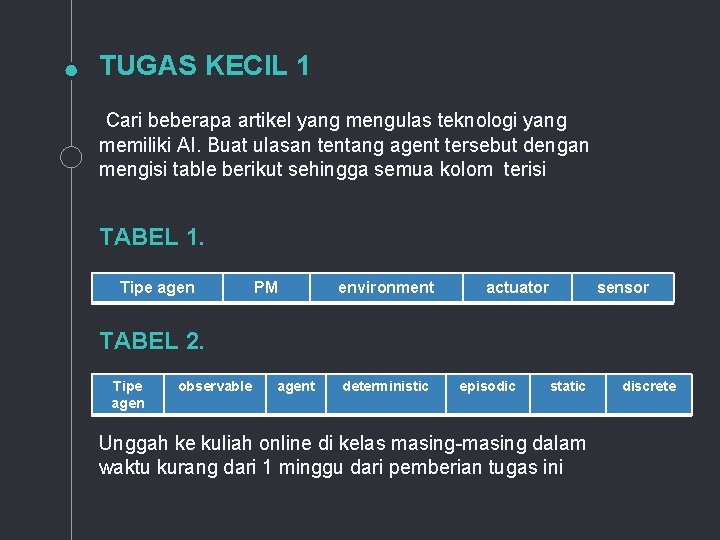

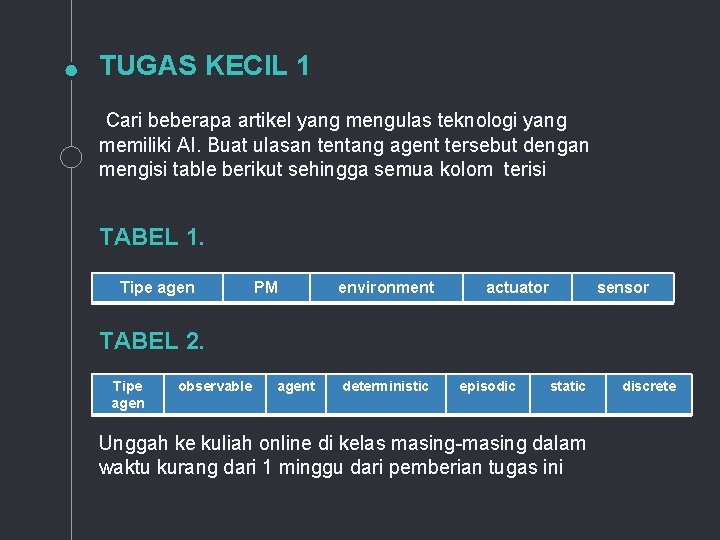

TUGAS KECIL 1 Cari beberapa artikel yang mengulas teknologi yang memiliki AI. Buat ulasan tentang agent tersebut dengan mengisi table berikut sehingga semua kolom terisi TABEL 1. Tipe agen PM environment actuator sensor TABEL 2. Tipe agen observable agent deterministic episodic static Unggah ke kuliah online di kelas masing-masing dalam waktu kurang dari 1 minggu dari pemberian tugas ini discrete

Indriani widiastuti

Indriani widiastuti Indriani widiastuti

Indriani widiastuti Indriani widiastuti

Indriani widiastuti Contoh peas dalam ai

Contoh peas dalam ai Peas description for interactive english tutor

Peas description for interactive english tutor Contoh agen kecerdasan buatan

Contoh agen kecerdasan buatan Peas agent examples

Peas agent examples Rdlm society logo

Rdlm society logo Nelly barn

Nelly barn Nelly baeza tapia

Nelly baeza tapia Who is nelly dean

Who is nelly dean Isabella's letter to nelly dean

Isabella's letter to nelly dean Matriks relasi

Matriks relasi Iveta kolářová matka lucie

Iveta kolářová matka lucie Novri nelly

Novri nelly Reducing agent vs oxidizing agent

Reducing agent vs oxidizing agent Agent function vs agent program

Agent function vs agent program What is oxidation

What is oxidation Interactive english tutor peas

Interactive english tutor peas Oxidizing and reducing agents

Oxidizing and reducing agents Hipomoklion

Hipomoklion Diah indriani

Diah indriani Dr anin indriani spog

Dr anin indriani spog Inersia uteri

Inersia uteri Indriani noor hapsari

Indriani noor hapsari Intelligent systems for molecular biology

Intelligent systems for molecular biology Vni4140

Vni4140 Form of intelligent humor

Form of intelligent humor Types of intelligent storage system

Types of intelligent storage system Intelligent techniques adalah

Intelligent techniques adalah Turing intelligent machinery

Turing intelligent machinery Intelligent traffic solutions

Intelligent traffic solutions Famous adjective comparative

Famous adjective comparative Intelligent business unit 1

Intelligent business unit 1 Sql server intelligent query processing

Sql server intelligent query processing