Informatsiooniteooria ehk kui huvitav on huvitav 30 10

- Slides: 16

Informatsiooniteooria ehk kui huvitav on “huvitav”? 30. 10. 2020 T. Lepikult

Huvitav ja ebahuvitav w Ebahuvitav teade: koer hammustas inimest. w Huvitav teade: inimene hammustas koera. 30. 10. 2020 T. Lepikult

Mis on informatsioon? “Informatsiooni” all mõistame teavet selle kohta, kas tegelikult toimus või ei toimunud mingi sündmus, mis sõltub juhusest. “Sündmus” on üks võimalikest katse (eksperimendi) tulemustest. Sündmuse A suhtelist esinemissagedust rohkearvulistes katsetes nimetatakse tema tõenäosuseks ja tähistatakse P(A). 30. 10. 2020 T. Lepikult

Eeldused ja tähistused Eeldame, et sündmuse toimumise kohta saadava informatsiooni hulk sõltub üksnes sündmuse tõenäosusest. Tähistame: f (P ) – funktsioon, mis mõõdab informatsiooni sündmusest. Teisiti öeldes – funktsioon f (P ) mõõdab meie “üllatust”, kui kuuleme sündmuse toimumisest. 30. 10. 2020 T. Lepikult

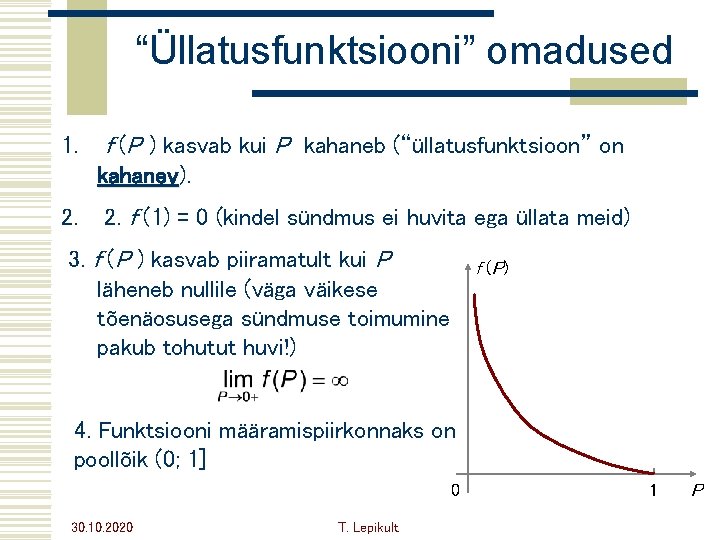

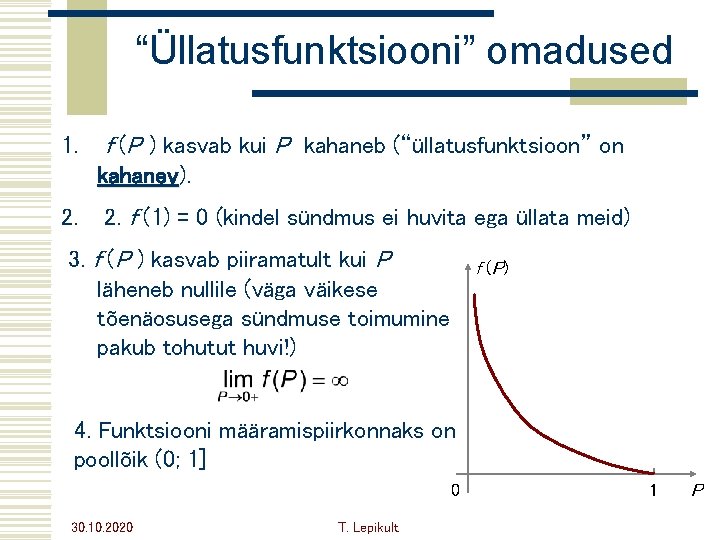

“Üllatusfunktsiooni” omadused 1. f (P ) kasvab kui P kahaneb (“üllatusfunktsioon” on kahanev). kahanev 2. f (1) = 0 (kindel sündmus ei huvita ega üllata meid) 3. f (P ) kasvab piiramatult kui P läheneb nullile (väga väikese tõenäosusega sündmuse toimumine pakub tohutut huvi!) f ( P) 4. Funktsiooni määramispiirkonnaks on poollõik (0; 1] 0 30. 10. 2020 T. Lepikult 1 P

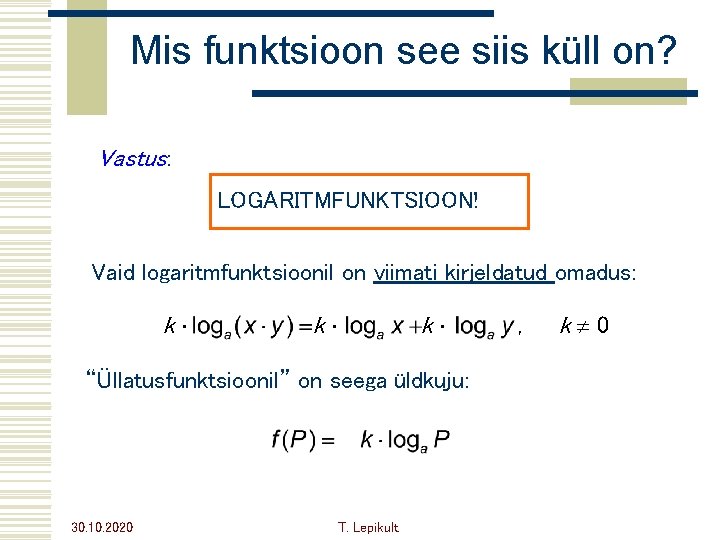

Veel üks omadus Kui sündmused A ja B on sõltumatud, siis P(AB ) = P(A) P (B ) = p q Informatsiooni kogus, mis saame, kui meieni jõuab sõnum A ja B koostoimumisest, on sel juhul sama kui A ja B eraldi toimumisest saadavate informatsioonihulkade summa. Seega peab “üllatusfunktsioonil” olema veel üks huvitav omadus: f ( p q ) = f ( p) + f ( q) 30. 10. 2020 T. Lepikult

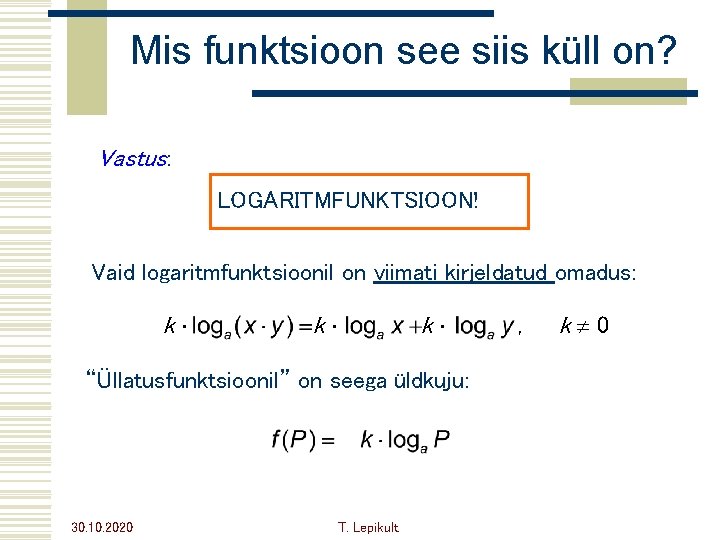

Mis funktsioon see siis küll on? Vastus: LOGARITMFUNKTSIOON! Vaid logaritmfunktsioonil on viimati kirjeldatud omadus: k k k “Üllatusfunktsioonil” on seega üldkuju: 30. 10. 2020 T. Lepikult , k 0

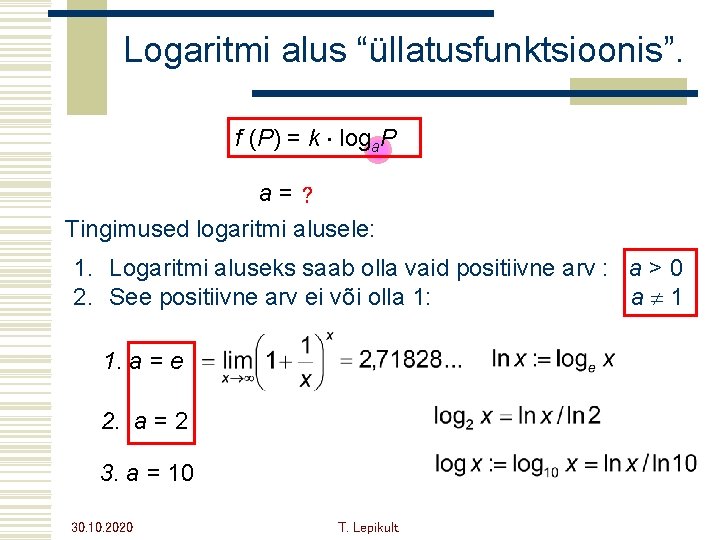

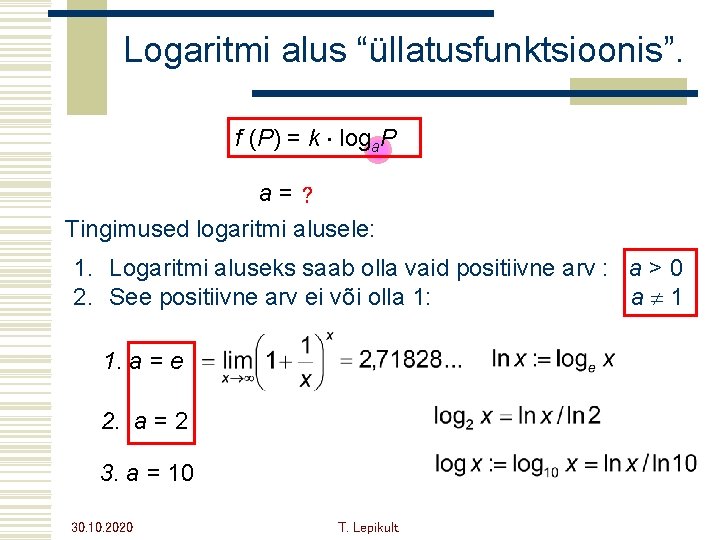

Logaritmi alus “üllatusfunktsioonis”. f (P) = k loga. P a= ? Tingimused logaritmi alusele: 1. Logaritmi aluseks saab olla vaid positiivne arv : a > 0 2. See positiivne arv ei või olla 1: a 1 1. a = e 2. a = 2 3. a = 10 30. 10. 2020 T. Lepikult

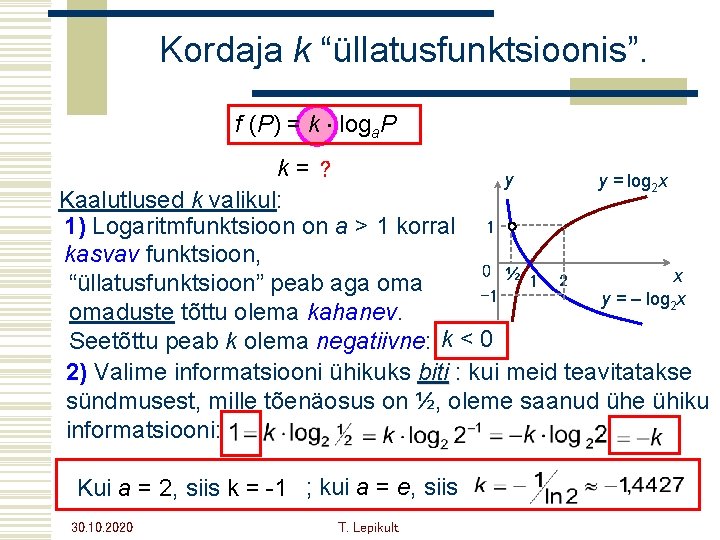

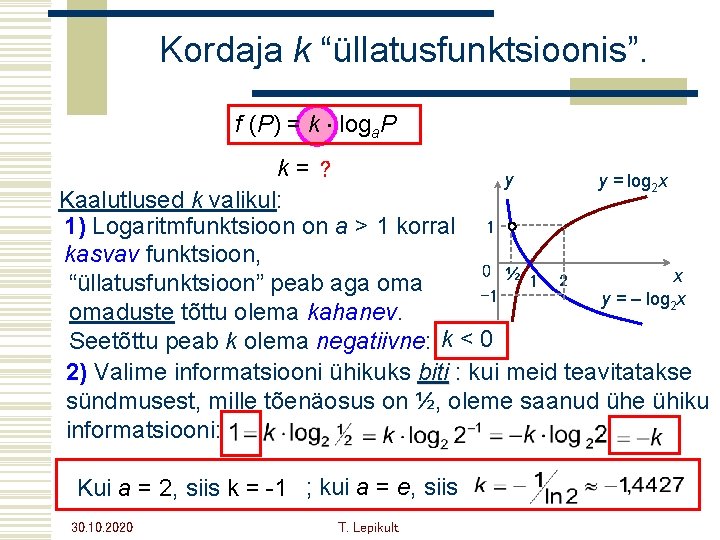

Kordaja k “üllatusfunktsioonis”. f (P) = k loga. P k= ? y y = log 2 x Kaalutlused k valikul: 1) Logaritmfunktsioon on a > 1 korral 1 kasvav funktsioon, 0 ½ x 1 2 “üllatusfunktsioon” peab aga oma -1 y = – log 2 x omaduste tõttu olema kahanev. Seetõttu peab k olema negatiivne: k < 0 2) Valime informatsiooni ühikuks biti : kui meid teavitatakse sündmusest, mille tõenäosus on ½, oleme saanud ühe ühiku informatsiooni: Kui a = 2, siis k = -1 ; kui a = e, siis 30. 10. 2020 T. Lepikult

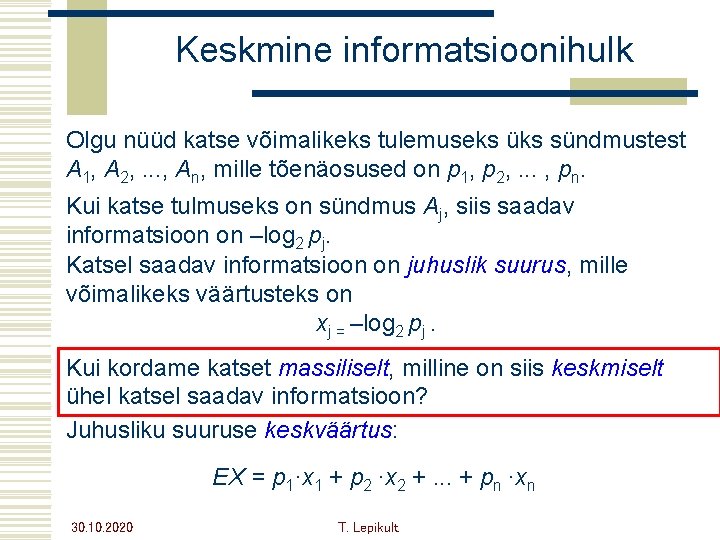

Keskmine informatsioonihulk Olgu nüüd katse võimalikeks tulemuseks üks sündmustest A 1, A 2, . . . , An, mille tõenäosused on p 1, p 2, . . . , pn. Kui katse tulmuseks on sündmus Aj, siis saadav informatsioon on –log 2 pj. Katsel saadav informatsioon on juhuslik suurus, mille võimalikeks väärtusteks on xj = –log 2 pj. Kui kordame katset massiliselt, milline on siis keskmiselt ühel katsel saadav informatsioon? Juhusliku suuruse keskväärtus: EX = p 1·x 1 + p 2 ·x 2 +. . . + pn ·xn 30. 10. 2020 T. Lepikult

Shannoni valem EX = p 1·x 1 + p 2 ·x 2 +. . . + pn ·xn –log 2 p 1 –log 2 p 2 –log 2 pn Massiliselt korratud katsete korral tuleb ühel katsel keskmiselt saadavaks informatsiooniks: Informatsiooniteooria looja Claude E. Shannoni auks nimetatakse viimast valemit Shannoni valemiks. 30. 10. 2020 T. Lepikult

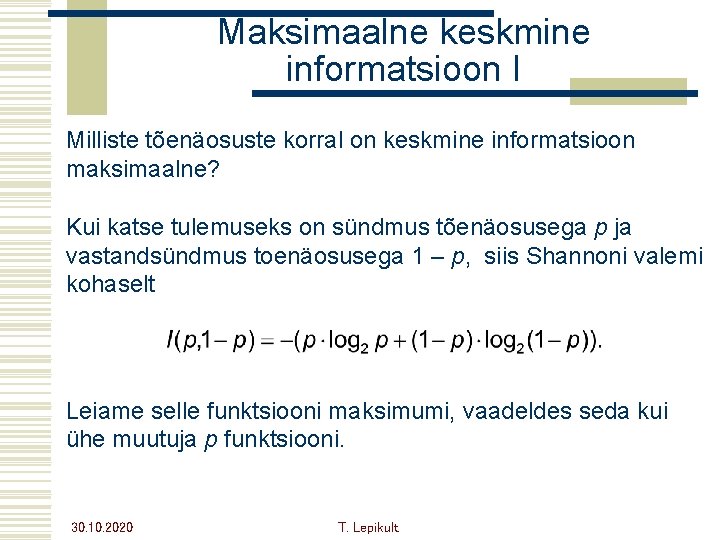

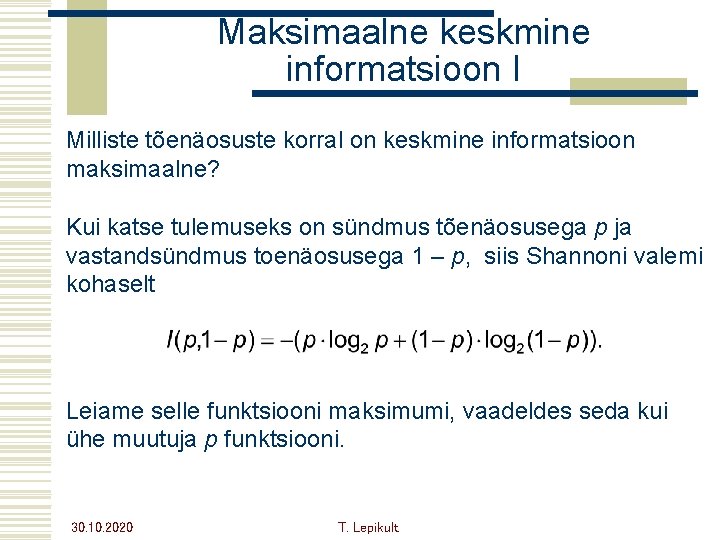

Maksimaalne keskmine informatsioon I Milliste tõenäosuste korral on keskmine informatsioon maksimaalne? Kui katse tulemuseks on sündmus tõenäosusega p ja vastandsündmus toenäosusega 1 – p, siis Shannoni valemi kohaselt Leiame selle funktsiooni maksimumi, vaadeldes seda kui ühe muutuja p funktsiooni. 30. 10. 2020 T. Lepikult

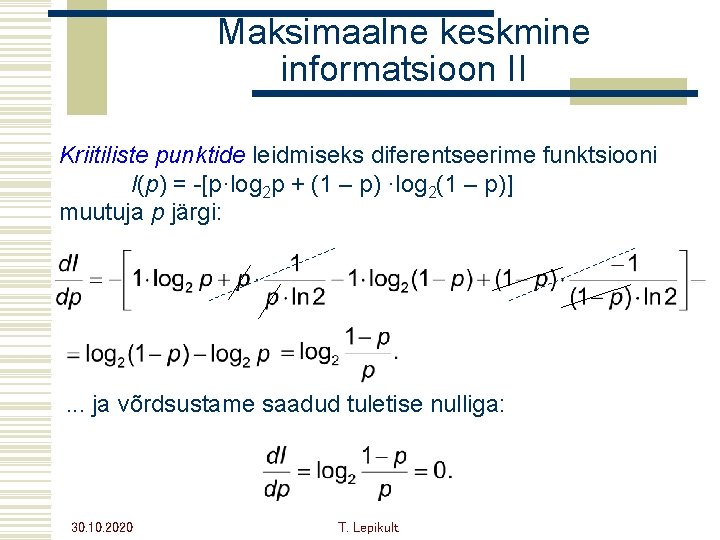

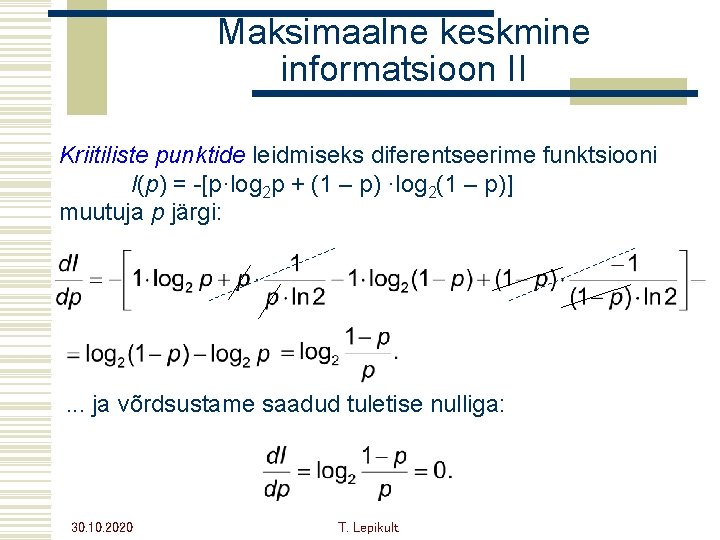

Maksimaalne keskmine informatsioon II Kriitiliste punktide leidmiseks diferentseerime funktsiooni I(p) = -[p·log 2 p + (1 – p) ·log 2(1 – p)] muutuja p järgi: . . . ja võrdsustame saadud tuletise nulliga: 30. 10. 2020 T. Lepikult

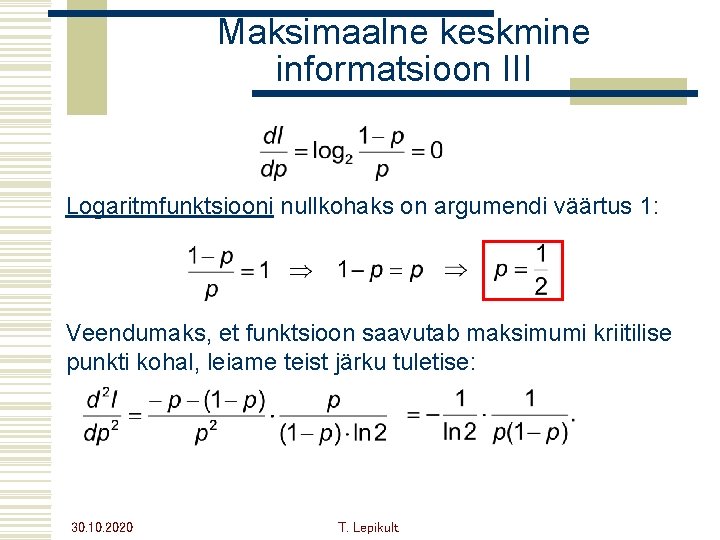

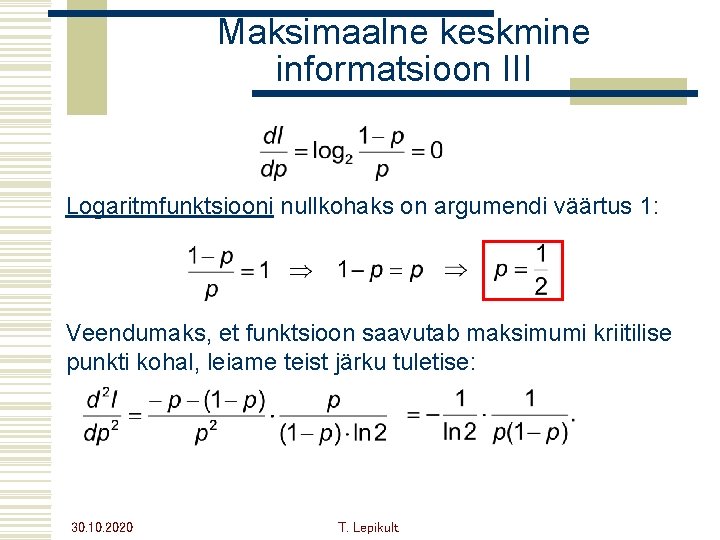

Maksimaalne keskmine informatsioon III Logaritmfunktsiooni nullkohaks on argumendi väärtus 1: Veendumaks, et funktsioon saavutab maksimumi kriitilise punkti kohal, leiame teist järku tuletise: 30. 10. 2020 T. Lepikult

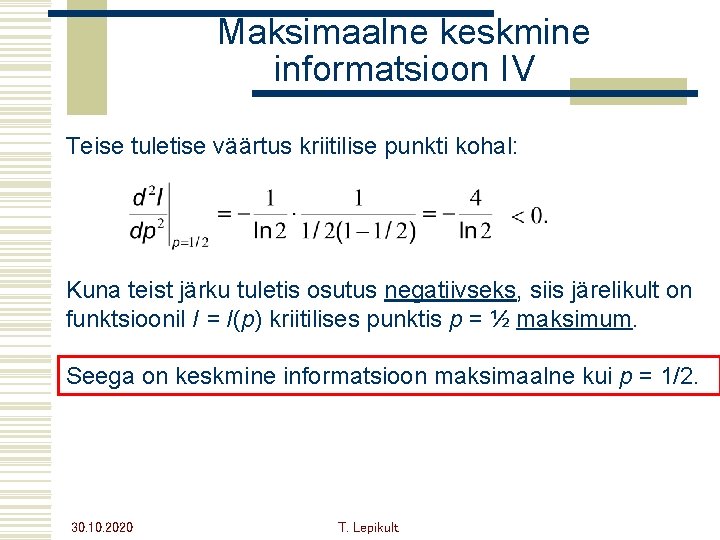

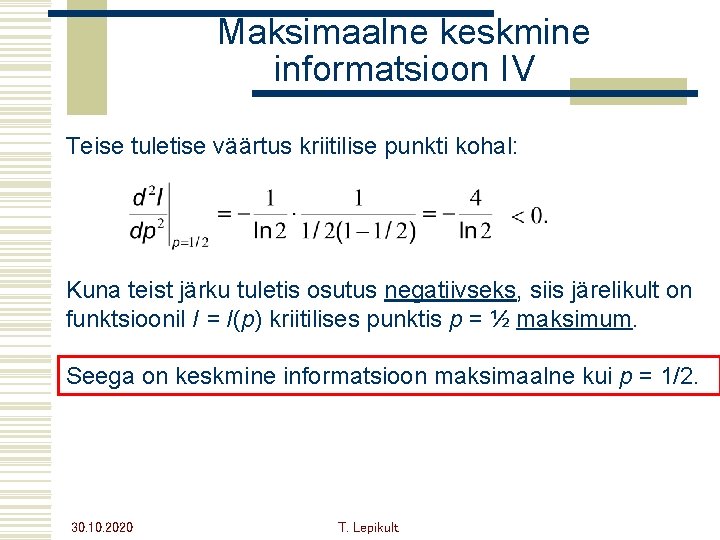

Maksimaalne keskmine informatsioon IV Teise tuletise väärtus kriitilise punkti kohal: Kuna teist järku tuletis osutus negatiivseks, siis järelikult on funktsioonil I = I(p) kriitilises punktis p = ½ maksimum. Seega on keskmine informatsioon maksimaalne kui p = 1/2. 30. 10. 2020 T. Lepikult

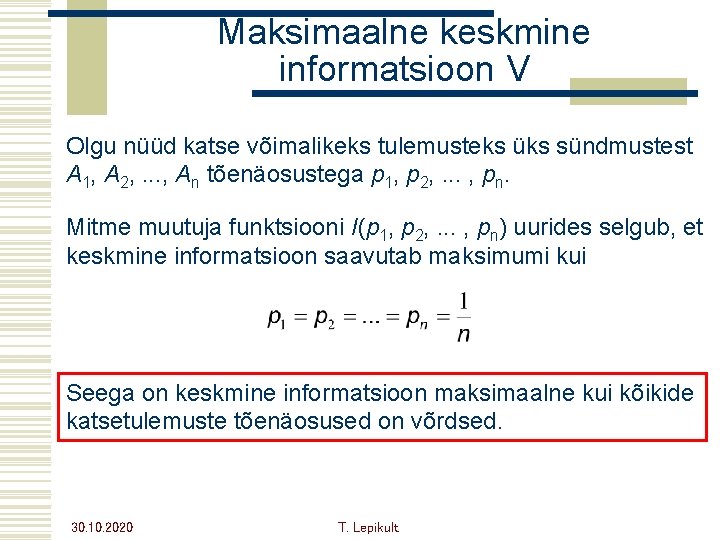

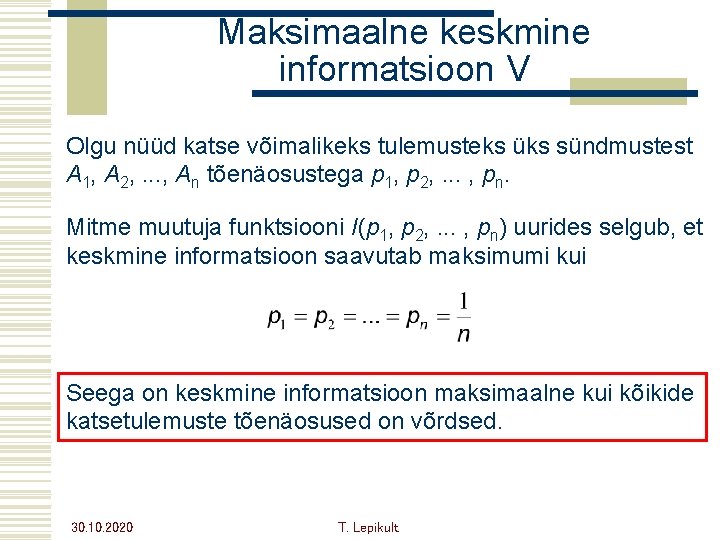

Maksimaalne keskmine informatsioon V Olgu nüüd katse võimalikeks tulemusteks üks sündmustest A 1, A 2, . . . , An tõenäosustega p 1, p 2, . . . , pn. Mitme muutuja funktsiooni I(p 1, p 2, . . . , pn) uurides selgub, et keskmine informatsioon saavutab maksimumi kui Seega on keskmine informatsioon maksimaalne kui kõikide katsetulemuste tõenäosused on võrdsed. 30. 10. 2020 T. Lepikult

Negatiivsete arvude korrutamine

Negatiivsete arvude korrutamine Miks on hea kui keha on soe

Miks on hea kui keha on soe Koma kui ees

Koma kui ees Targem kui 5b

Targem kui 5b Kera

Kera Arvu numbrite summa

Arvu numbrite summa Keelemärgid

Keelemärgid Koma siis ees

Koma siis ees Kui negatiivse arvu aste on negatiivne, siis

Kui negatiivse arvu aste on negatiivne, siis Arvu kujutava punkti kaugus nullpunktist

Arvu kujutava punkti kaugus nullpunktist Metsatööstuse klaster

Metsatööstuse klaster Neerupealise hormoon ehk

Neerupealise hormoon ehk Mudel ehk

Mudel ehk Soor ehk

Soor ehk Grete müürisepp

Grete müürisepp Kausshuulik

Kausshuulik Uhtorg ehk

Uhtorg ehk