KVM n KVM q q q n CPU

- Slides: 21

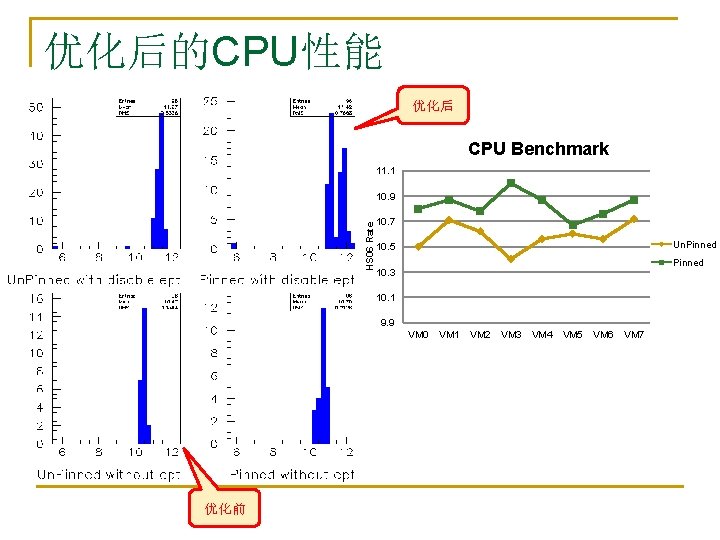

KVM虚拟机的性能测试 n KVM性能测试 q q q n CPU 磁盘IO 网络IO 基准测试 具 q q q CPU benchmarks: HEPSPEC 06 I/O benchmarks: IOZONE Network benchmarks: IPERF

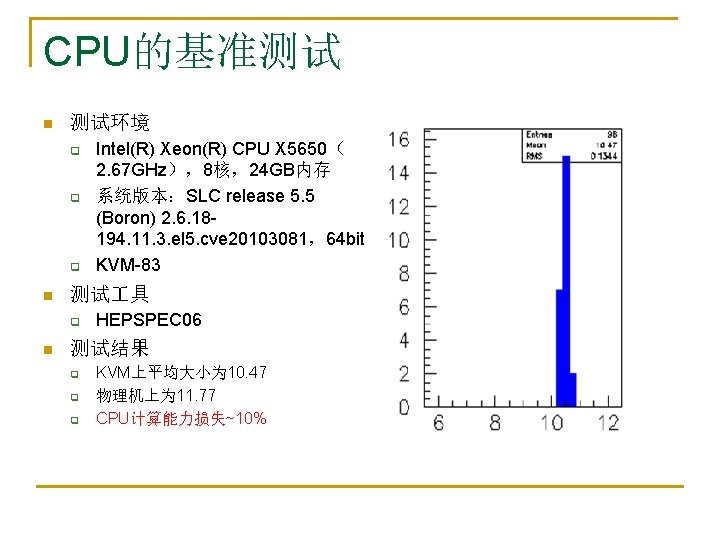

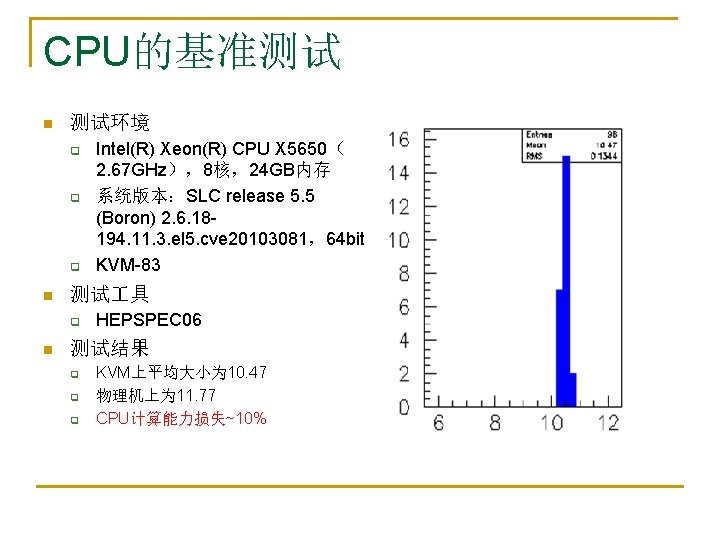

CPU的基准测试 n 测试环境 q q q n 测试 具 q n Intel(R) Xeon(R) CPU X 5650( 2. 67 GHz),8核,24 GB内存 系统版本:SLC release 5. 5 (Boron) 2. 6. 18194. 11. 3. el 5. cve 20103081,64 bit KVM-83 HEPSPEC 06 测试结果 q q q KVM上平均大小为 10. 47 物理机上为 11. 77 CPU计算能力损失~10%

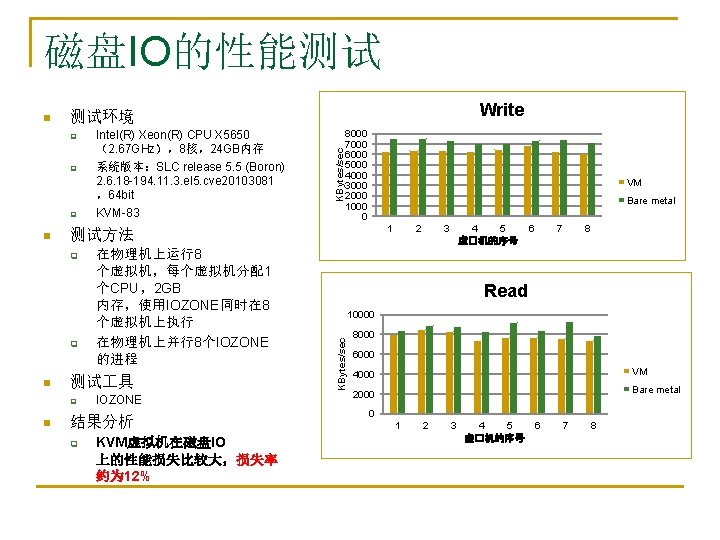

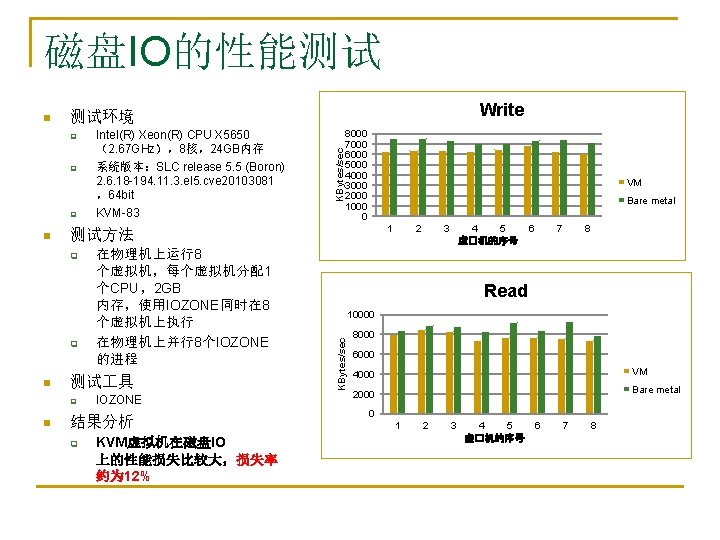

磁盘IO的性能测试 q q q 在物理机上运行8 个虚拟机,每个虚拟机分配1 个CPU,2 GB 内存,使用IOZONE同时在 8 个虚拟机上执行 在物理机上并行8个IOZONE 的进程 测试 具 q n 8000 7000 6000 5000 4000 3000 2000 1000 0 VM Bare metal 1 测试方法 q n Intel(R) Xeon(R) CPU X 5650 (2. 67 GHz),8核,24 GB内存 系统版本:SLC release 5. 5 (Boron) 2. 6. 18 -194. 11. 3. el 5. cve 20103081 ,64 bit KVM-83 KBytes/sec q n Write 测试环境 IOZONE 结果分析 q KVM虚拟机在磁盘IO 上的性能损失比较大,损失率 约为 12% 2 3 4 5 虚�机的序号 6 7 8 Read 10000 KBytes/sec n 8000 6000 4000 VM 2000 Bare metal 0 1 2 3 4 5 虚�机的序号 6 7 8

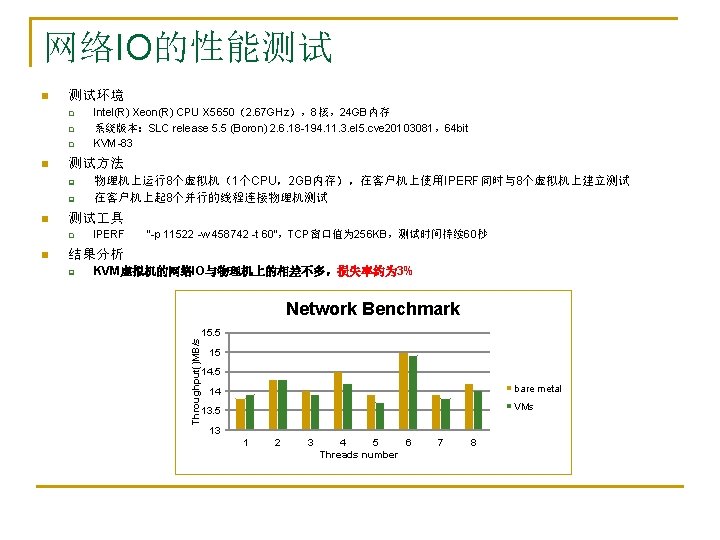

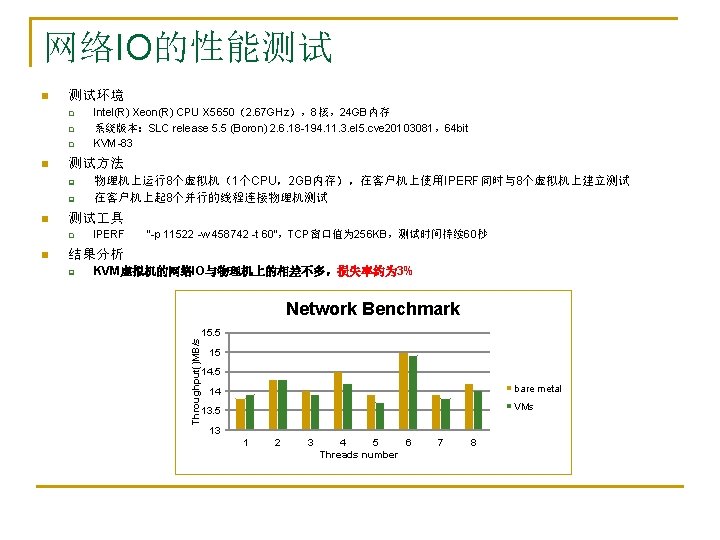

网络IO的性能测试 测试环境 q q q n 测试方法 q q n 物理机上运行8个虚拟机(1个CPU,2 GB内存),在客户机上使用IPERF同时与8个虚拟机上建立测试 在客户机上起 8个并行的线程连接物理机测试 测试 具 q n Intel(R) Xeon(R) CPU X 5650(2. 67 GHz),8核,24 GB内存 系统版本:SLC release 5. 5 (Boron) 2. 6. 18 -194. 11. 3. el 5. cve 20103081,64 bit KVM-83 IPERF “-p 11522 -w 458742 -t 60”,TCP窗口值为 256 KB,测试时间持续 60秒 结果分析 q KVM虚拟机的网络IO与物理机上的相差不多,损失率约为 3% Network Benchmark Throughput()MB/s n 15. 5 15 14. 5 bare metal 14 VMs 13. 5 13 1 2 3 4 5 6 Threads number 7 8

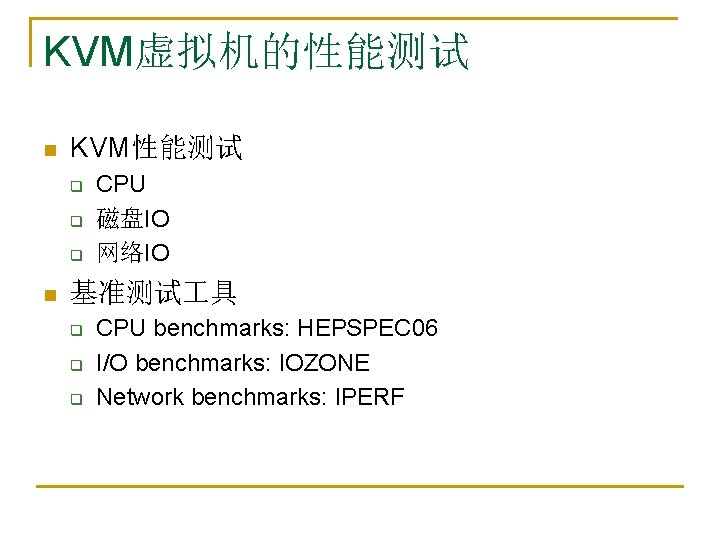

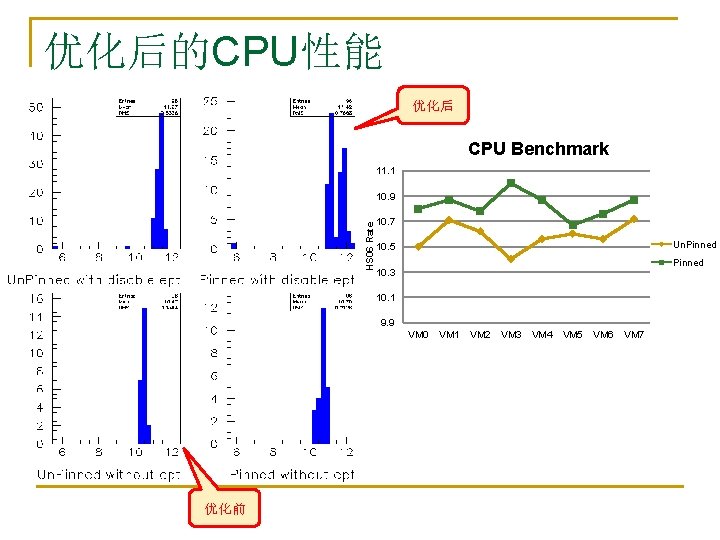

优化后的CPU性能 优化后 CPU Benchmark 11. 1 HS 06 Rate 10. 9 10. 7 Un. Pinned 10. 5 Pinned 10. 3 10. 1 9. 9 VM 0 优化前 VM 1 VM 2 VM 3 VM 4 VM 5 VM 6 VM 7

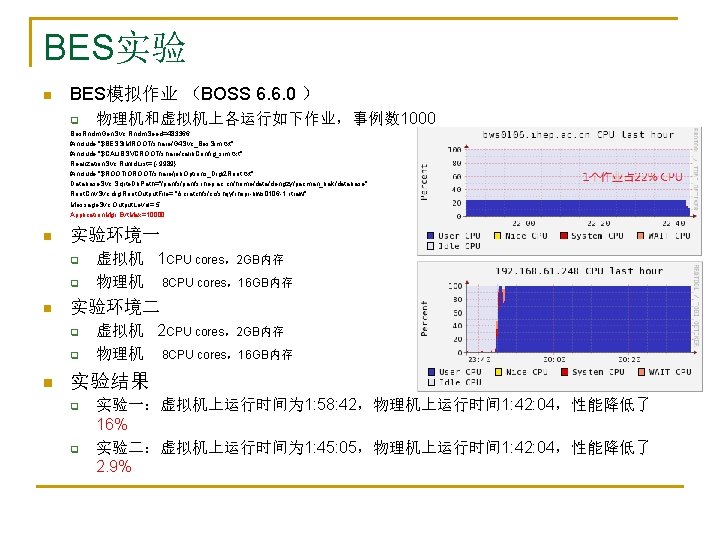

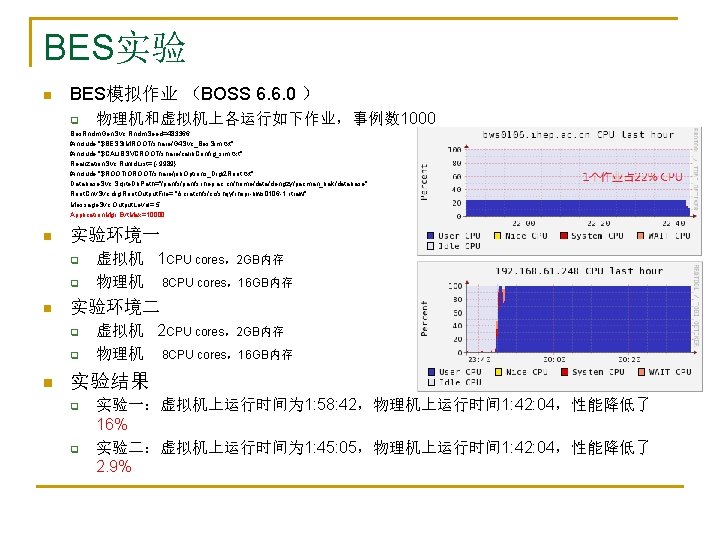

BES实验 n BES模拟作业 (BOSS 6. 6. 0 ) q 物理机和虚拟机上各运行如下作业,事例数 1000 Bes. Rndm. Gen. Svc. Rndm. Seed=483366; #include "$BESSIMROOT/share/G 4 Svc_Bes. Sim. txt" #include "$CALIBSVCROOT/share/calib. Config_sim. txt" Realization. Svc. Run. Id. List= {-9989}; #include "$ROOTIOROOT/share/job. Options_Digi 2 Root. txt" Database. Svc. Sqlite. Db. Path="/panfs. ihep. ac. cn/home/data/dengzy/pacman_bak/database"; Root. Cnv. Svc. digi. Root. Output. File= "/scratchfs/cc/shijy/rhopi-bws 0106 -1. rtraw"; Message. Svc. Output. Level= 5; Application. Mgr. Evt. Max=10000; n 实验环境一 q q n 实验环境二 q q n 虚拟机 1 CPU cores,2 GB内存 物理机 8 CPU cores,16 GB内存 虚拟机 2 CPU cores,2 GB内存 物理机 8 CPU cores,16 GB内存 实验结果 q q 实验一:虚拟机上运行时间为 1: 58: 42,物理机上运行时间 1: 42: 04,性能降低了 16% 实验二:虚拟机上运行时间为 1: 45: 05,物理机上运行时间 1: 42: 04,性能降低了 2. 9%

BES实验 n BES分析作业 (BOSS 6. 6. 2 ) q 物理机和虚拟机上各运行如下作业,Application. Mgr. Evt. Max = 1 E 9 "/besfs 2/offline/data/663 -1/jpsi/tmp 2/120520/run_0028145_All_file 006_SFO-1. dst", "/besfs 2/offline/data/663 -1/jpsi/tmp 2/120520/run_0028145_All_file 006_SFO-2. dst" }; // Set output level threshold (2=DEBUG, 3=INFO, 4=WARNING, 5=ERROR, 6=FATAL ) Message. Svc. Output. Level = 6; // Number of events to be processed (default is 10) Application. Mgr. Evt. Max = 1 E 9; Application. Mgr. Histogram. Persistency = "ROOT"; n 实验环境 q q n 虚拟机 物理机 1 CPU cores,2 GB内存 8 CPU cores,16 GB内存 实验结果 q 虚拟机上作业运行时间为 8: 04: 47,物理机上运行时间 7: 48: 32,虚拟上运行时间 多了975 s,性能降低约为 3%