Information Calcul Communication 2 Information Communication Leon 3

- Slides: 10

Information, Calcul, Communication 2. Information & Communication – Leçon 3: Entropie Clip 3: Calcul O. Lévêque, commentaire: P. Janson 1 / 10 2. Information & Communication – 3. Entropie – 3. Calcul

Plan de la leçon Introduction à la compression ● Notion d’entropie ● Calcul d’entropie ● http: //moodle. epfl. ch/mod/url/view. php? id=873014 Compression sans perte ● Algorithme de Shannon-Fano ● 2 / 10 2. Information & Communication – 3. Entropie – 3. Calcul

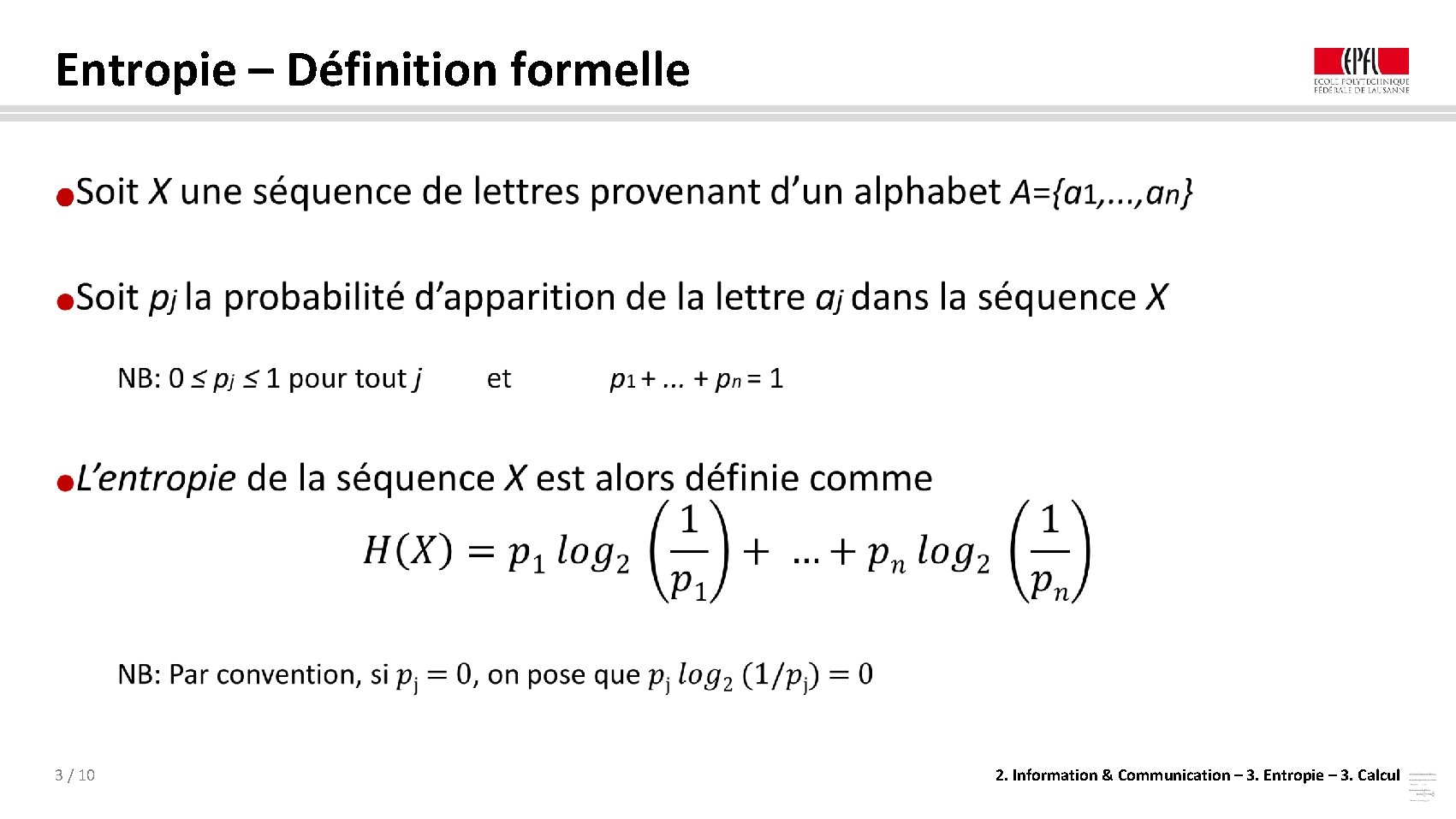

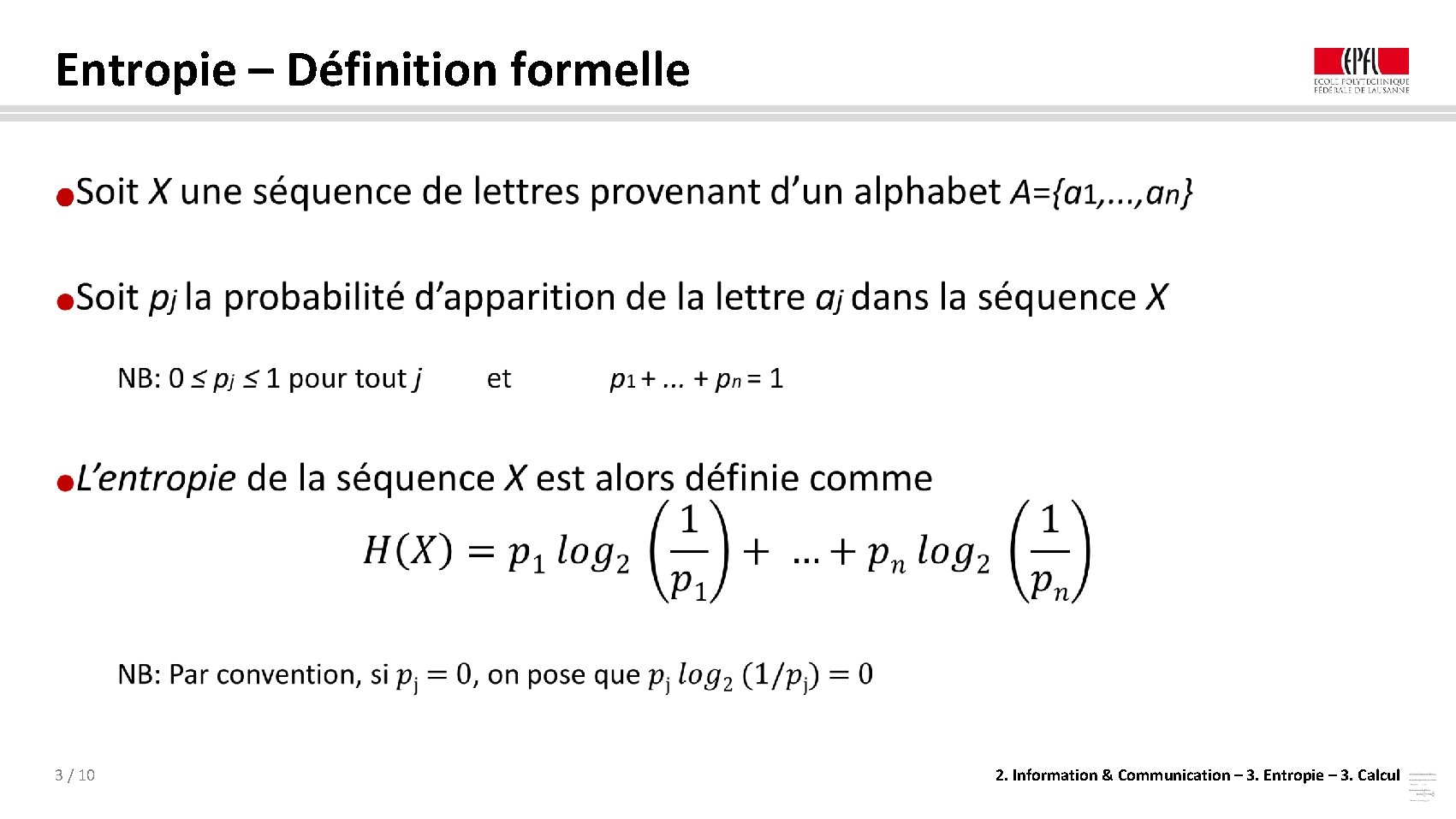

Entropie – Définition formelle ● 3 / 10 2. Information & Communication – 3. Entropie – 3. Calcul

Entropie – Remarques La formule précédente reste valable même si les pj ne sont pas estimées sur la séquence X elle-même p. ex. si elles proviennent d’un texte quelconque ou du procédé (p. ex. le langage naturel) de génération de X => Seules comptent les probabilités pj, peu importe d’où elles proviennent ● L’entropie calculée ici est simplement celle du « jeu » consistant à tirer au hasard une lettre de la séquence X donnée En général la définition de l’entropie est bien plus complexe et intègre dépendances entre sous-séquences de lettres mais ceci nécessite des outils mathématiques plus avancés. . . probabilités conditionnelles et limites … etc. ● 4 / 10 2. Information & Communication – 3. Entropie – 3. Calcul

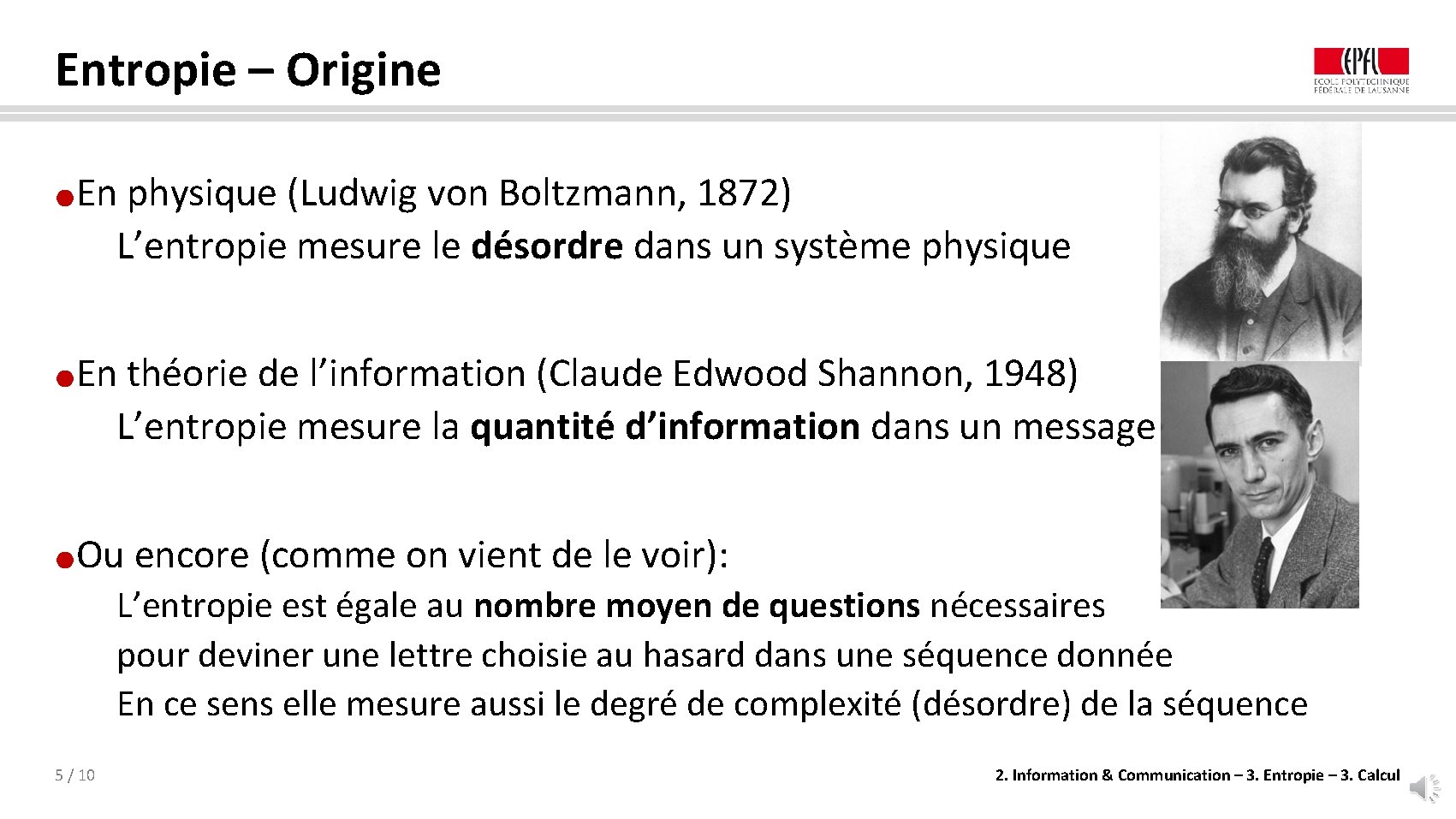

Entropie – Origine En physique (Ludwig von Boltzmann, 1872) L’entropie mesure le désordre dans un système physique ● En théorie de l’information (Claude Edwood Shannon, 1948) L’entropie mesure la quantité d’information dans un message ● Ou encore (comme on vient de le voir): ● L’entropie est égale au nombre moyen de questions nécessaires pour deviner une lettre choisie au hasard dans une séquence donnée En ce sens elle mesure aussi le degré de complexité (désordre) de la séquence 5 / 10 2. Information & Communication – 3. Entropie – 3. Calcul

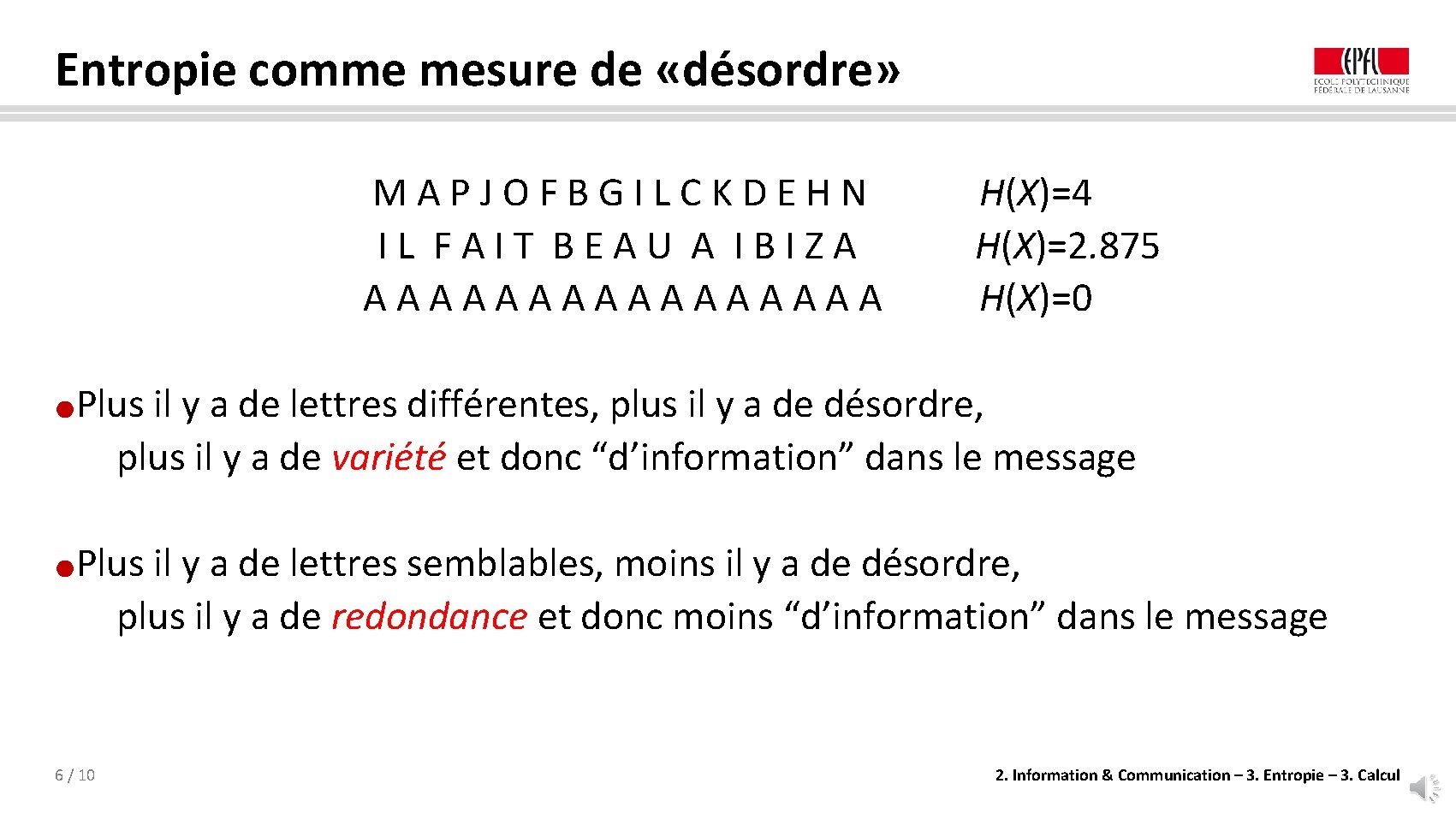

Entropie comme mesure de «désordre» MAPJOFBGILCKDEHN IL FAIT BEAU A IBIZA AAAAAAAA H(X)=4 H(X)=2. 875 H(X)=0 Plus il y a de lettres différentes, plus il y a de désordre, plus il y a de variété et donc “d’information” dans le message ● Plus il y a de lettres semblables, moins il y a de désordre, plus il y a de redondance et donc moins “d’information” dans le message ● 6 / 10 2. Information & Communication – 3. Entropie – 3. Calcul

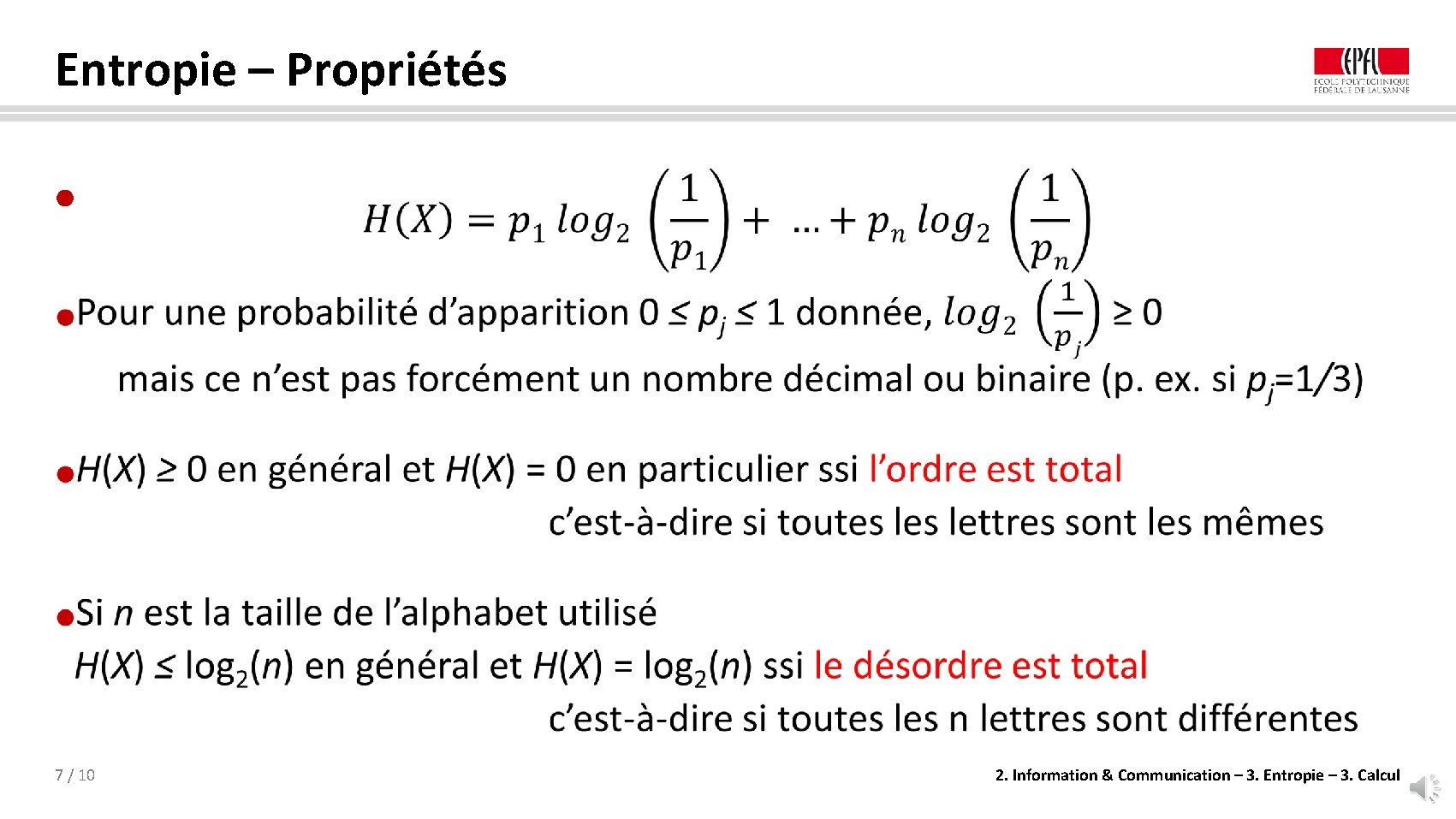

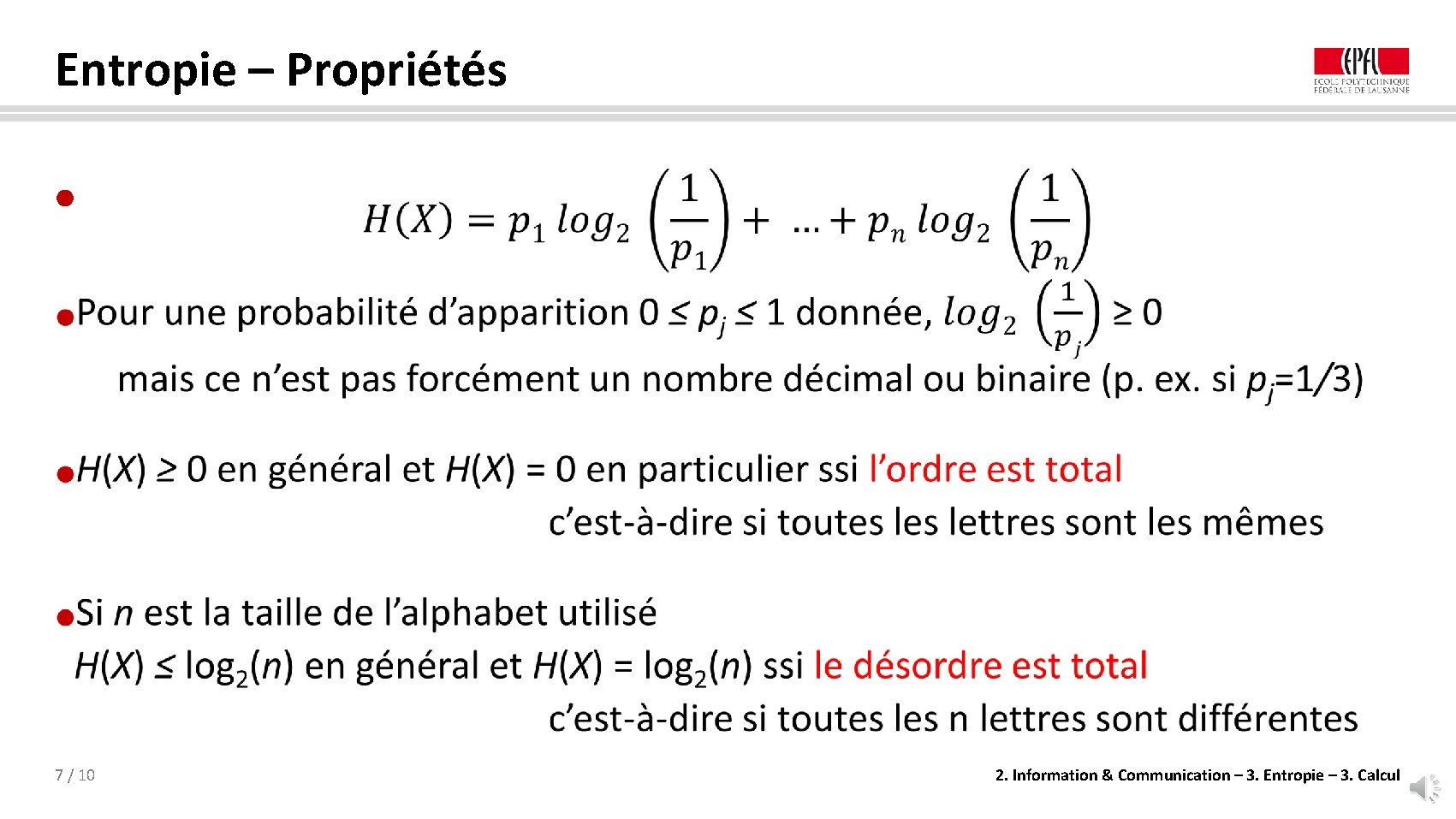

Entropie – Propriétés ● 7 / 10 2. Information & Communication – 3. Entropie – 3. Calcul

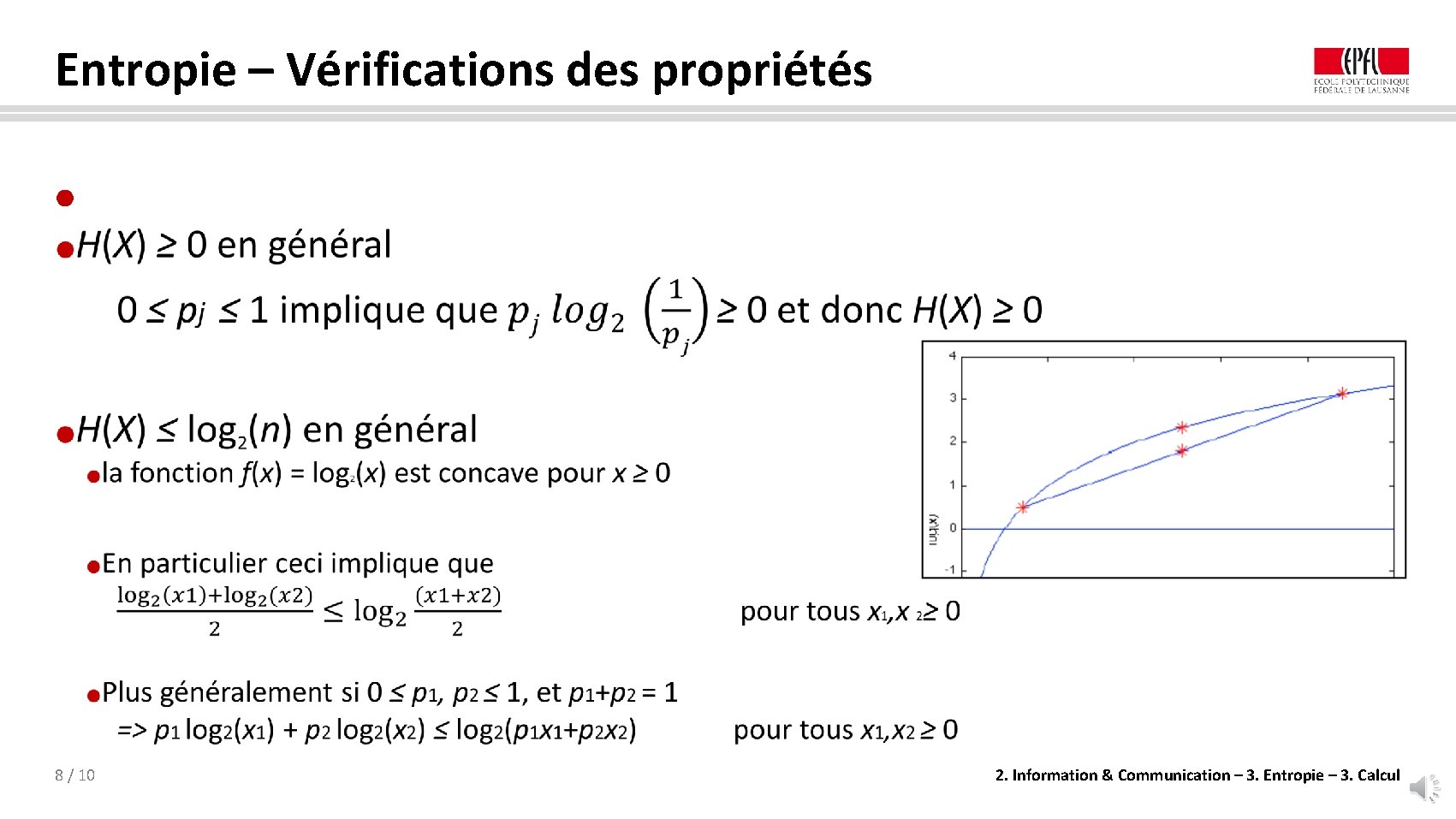

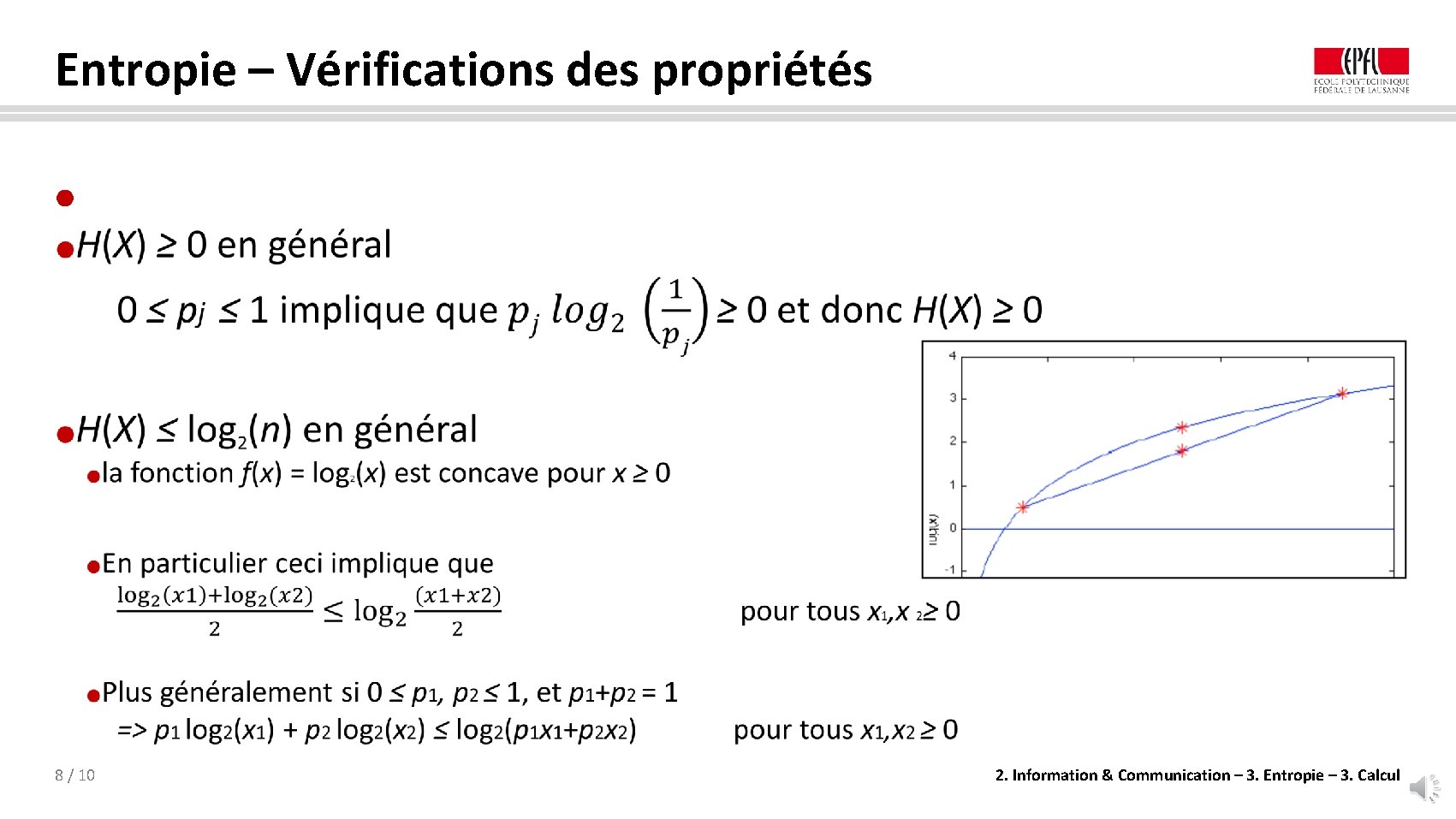

Entropie – Vérifications des propriétés ● 8 / 10 2. Information & Communication – 3. Entropie – 3. Calcul

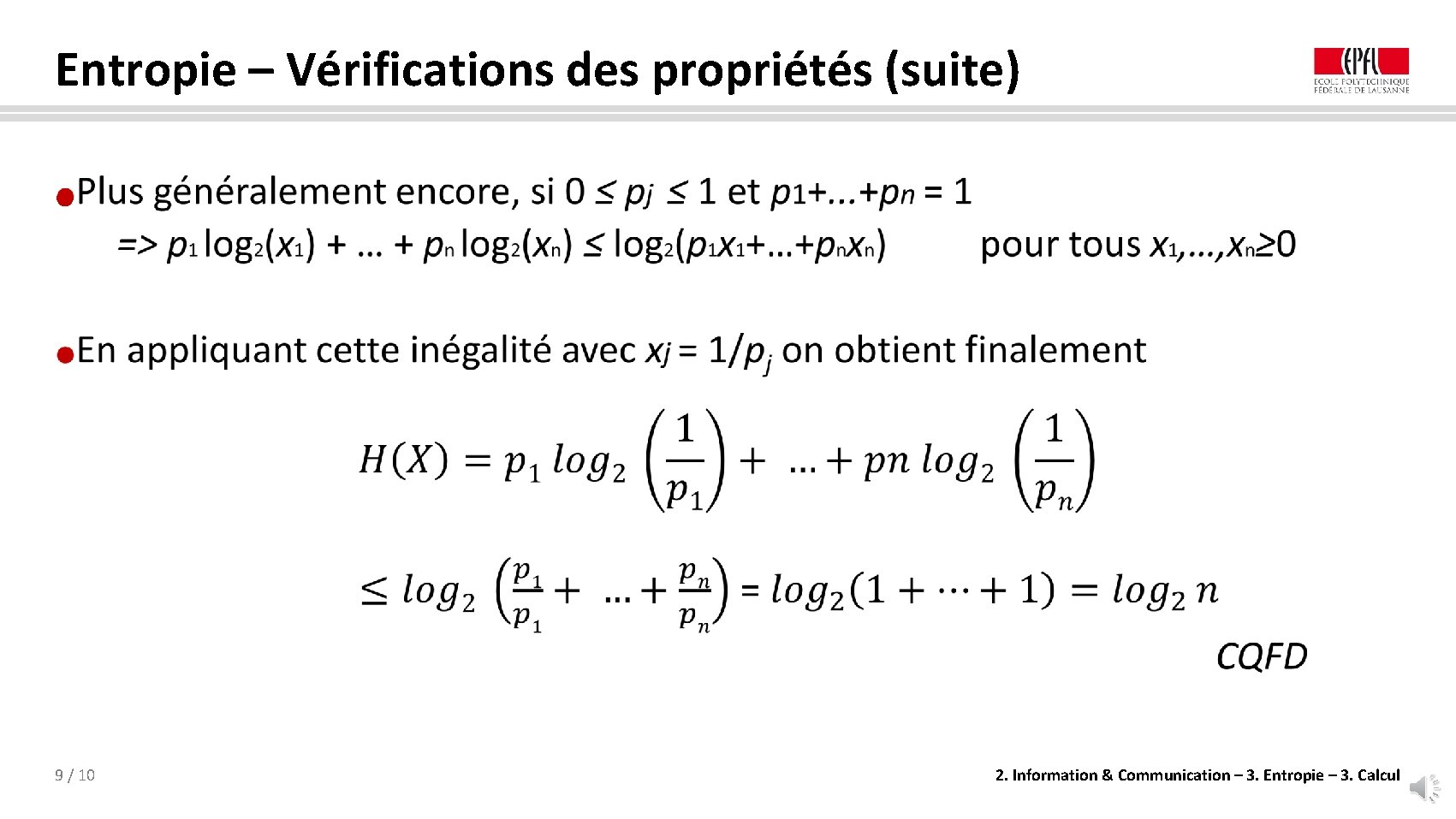

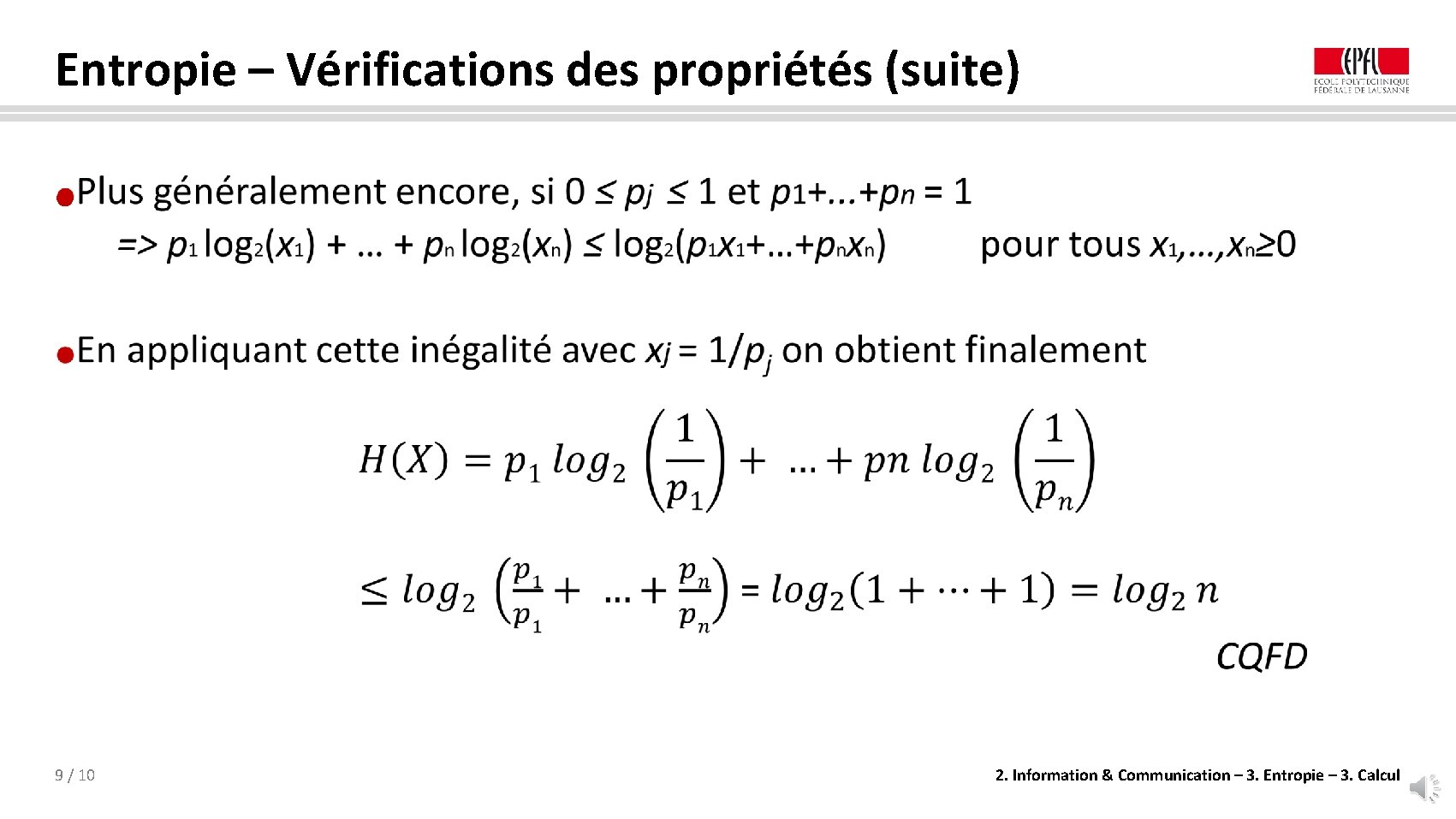

Entropie – Vérifications des propriétés (suite) ● 9 / 10 2. Information & Communication – 3. Entropie – 3. Calcul

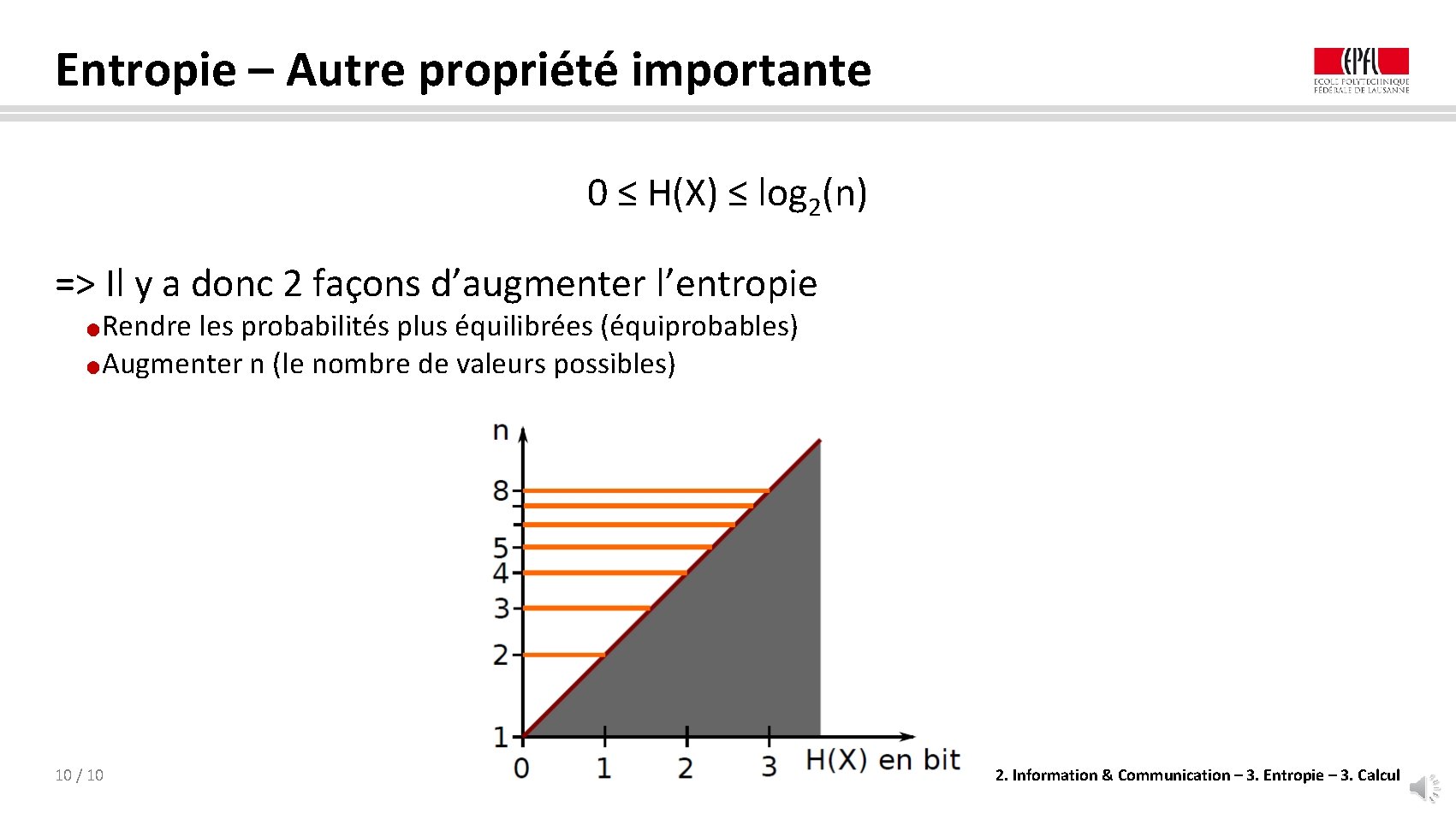

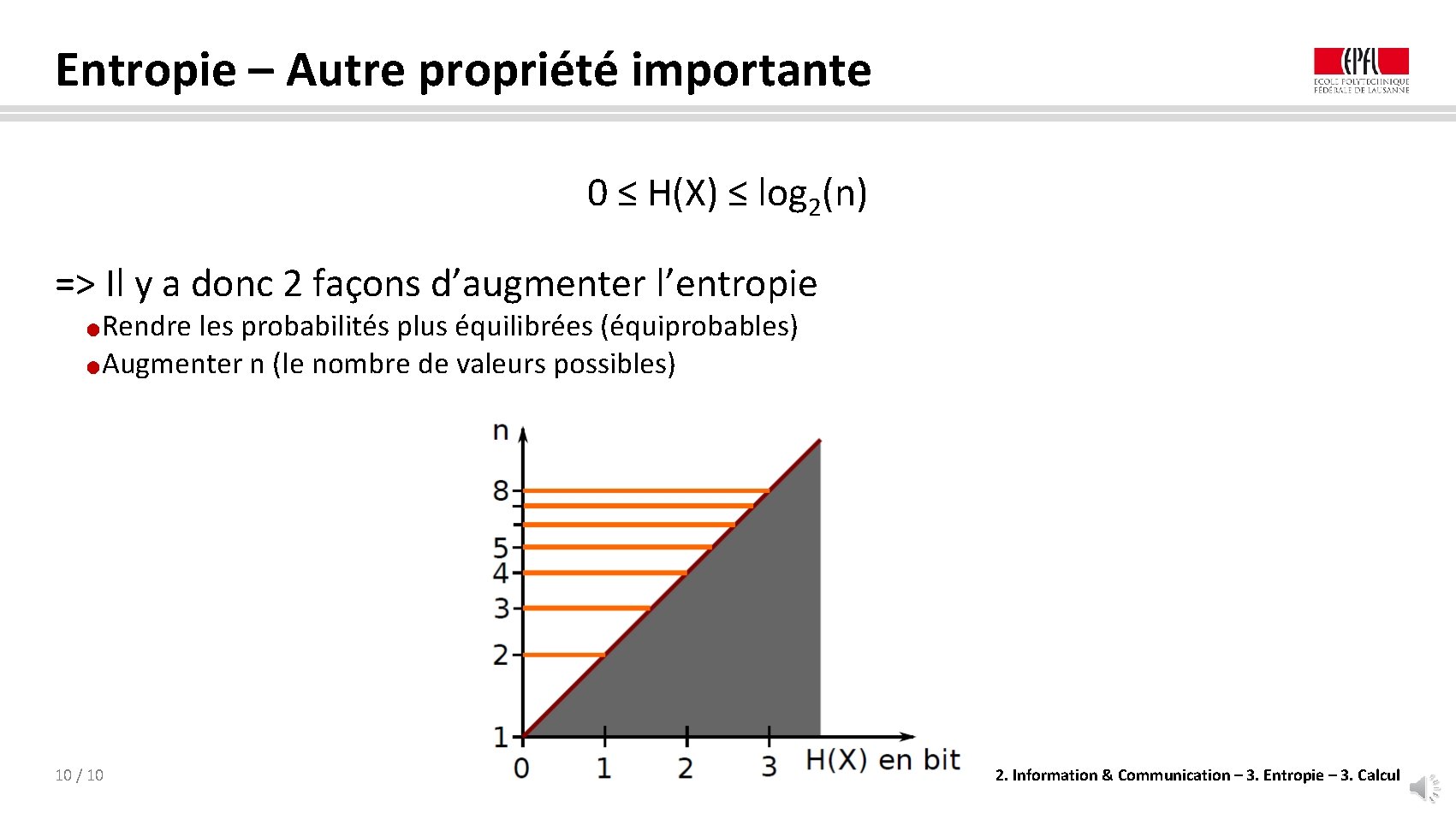

Entropie – Autre propriété importante 0 ≤ H(X) ≤ log 2(n) => Il y a donc 2 façons d’augmenter l’entropie Rendre les probabilités plus équilibrées (équiprobables) ●Augmenter n (le nombre de valeurs possibles) ● 10 / 10 2. Information & Communication – 3. Entropie – 3. Calcul