Como funciona o Map Reduce E para compreender

- Slides: 19

Como funciona o Map. Reduce

E para compreender como é feito o processamento, a análise e o armazenamento de grandes quantidade de dados, é importante conhecer o Map. Reduce, um modelo de programação criado pelo Google. Map. Reduce Hoje, ele é utilizado em várias aplicações e em empresas de todo tipo de setor, inclusive grandes companhias de tecnologia como Yahoo!, Amazon Web Services (AWS), Intel, Microsoft e IBM.

Uma analogia que ajuda a entender tanto o conceito do Map. Reduce, quanto da computação paralela é imaginar que existe uma tarefa: contar o número de laranjas maduras em um cesto muito grande. Para entender o conceito do Map. Reduce No método tradicional em que uma pessoa faz tudo, ela levaria muito tempo para contar as laranjas. Tanto tempo que, ao terminar o trabalho, outras laranjas teriam amadurecido no cesto.

No modelo do Map. Reduce, um coordenador responsável pela tarefa pode dividir as laranjas em 20 cestos. Map. Reduce Por exemplo, e vinte pessoas contam o que há em cada um deles e entregam o resultado de laranjas maduras em menor tempo. Cabe então ao coordenador reduzir os vinte resultados em apenas uma saída e somar os valores retornados pelos contadores.

Map. Reduce Se alguma pessoa não comparecer, a tarefa é redistribuída entre os presentes e continua sem nenhuma perda de informação ou performance, o que representa a tolerância a falhas do Map. Reduce.

Como o próprio nome revela, o Map. Reduce é baseado nas funções Map() e Reduce(). Fase 1: Mapeamento Sua operação se divide em duas etapas: Na primeira fase, chamada de Map (mapeamento), os dados são separados em pares de chave e valor, divididos em fragmentos (cestos) e distribuídos para os nodes (pessoas), onde serão processados (contadas).

Depois disso, pode ocorrer outras fases, por exemplo, Shuffle. Fase 2: Shuffle Essa fase agrupa os dados intermediários pela chave e produz um conjunto de tuplas (k 2, list(v 2)). Assim todos os valores associados a uma determinada chave serão agrupados em uma lista. Após essa fase intermediária, o arcabouço também se encarrega de dividir e replicar os conjuntos de tuplas para as tarefas Reduce que serão executadas.

A etapa de Reduce (redução), que é a combinação dos processamentos dos nodes por um master node. Fase 3 Reduce É ele que entregará uma resposta única à requisição realizada pelo usuário.

Tolerância a Falhas em Haddop A tolerância a falhas mencionada anteriormente aparece aqui. Caso um sistema ou disco de armazenamento falhe por algum motivo, a tarefa é redistribuída pelo master node e não há perda significativa de dados ou de performance no processo.

Por que utilizar o Map. Reduce para analisar dados em larga escala? Uma das vantagens do paradigma do Map. Reduce é a velocidade da análise dos dados. Em ferramentas tradicionais de processamento de dados, é comum que eles sejam movidos do armazenamento para o processamento, o que é lento e inviável para grandes volumes.

Por que utilizar o Map. Reduce para analisar dados em larga escala? Outra vantagem é que, como o processamento é paralelo e fragmentado, pode acontecer mesmo em clusters de máquinas com configurações modestas – não é preciso ter um supercomputador.

Por que utilizar o Map. Reduce para analisar dados em larga escala? Por essa razão, o Map. Reduce toma o caminho oposto e leva o processamento para os locais em que os dados estão armazenados, o que traz mais agilidade e eficiência à análise.

Por que utilizar o Map. Reduce para analisar dados em larga escala? O Map. Reduce também é relativamente simples e tem uma boa curva de aprendizado, mesmo quando comparado com outras soluções adotadas para lidar com big data, como o Spark ou o Mesos. Essa facilidade de utilização e implementação, em grande parte graças ao alto engajamento da comunidade de Hadoop, se reflete na adoção maior desse modelo de programação.

Map. Reduce Essa técnica não só reduz riscos de perda de dados devido a falhas das máquinas como também facilita a combinação das informações processadas pelos diversos equipamentos em uma única resposta. A importância de big data para os negócios.

Hadoop se aplica a Big Data No trabalho de um cientista de dados, muitas vezes, é preciso lidar com Big Data, nome dado aos conjuntos de dados que, devido ao seu volume ou complexidade, não podem ser processados por ferramentas tradicionais. Big Data pode ser resolvido com Hadoop.

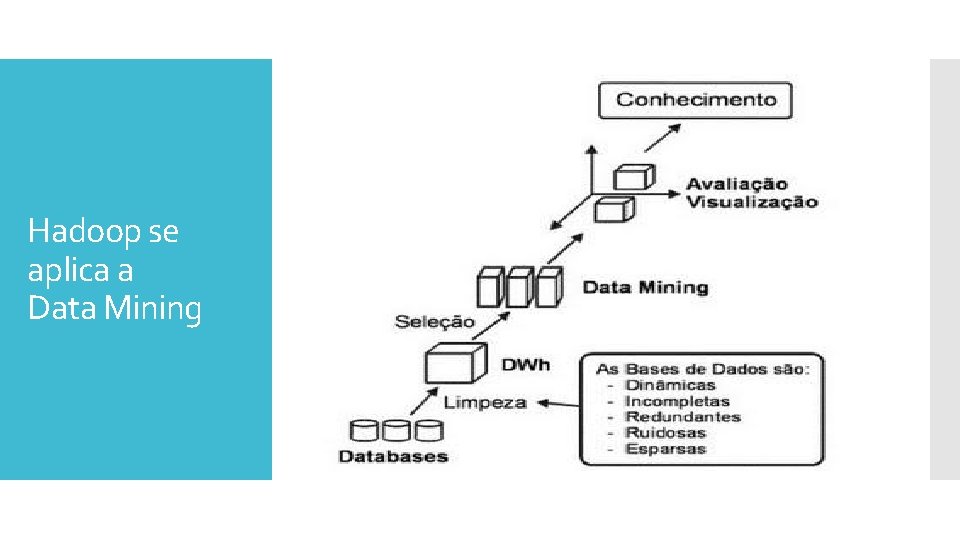

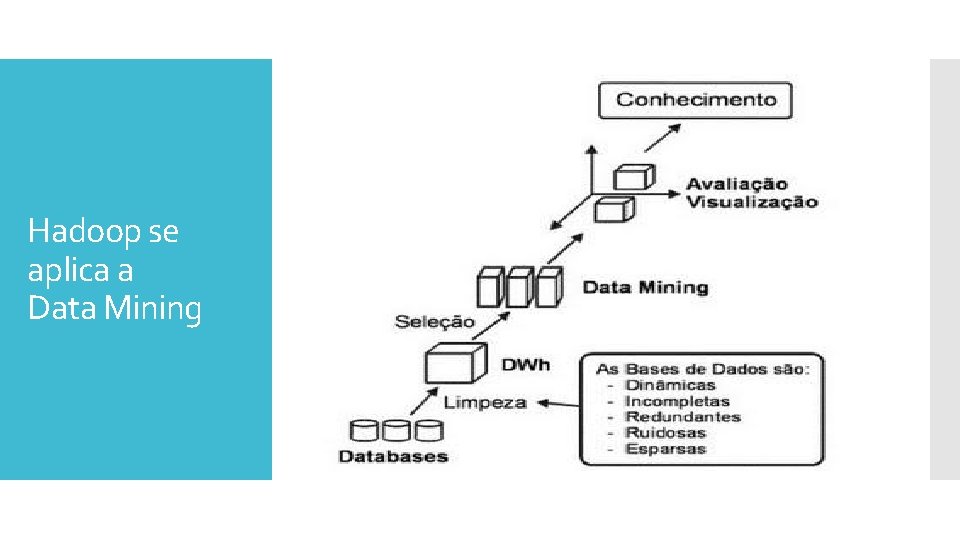

Data Mining consiste em um processo analítico projetado para explorar grandes quantidades de dados (tipicamente relacionados a negócios, mercado ou pesquisas científicas), na busca de padrões consistentes e/ou relacionamentos sistemáticos entre variáveis e, então, validá-los aplicando os padrões detectados a novos subconjuntos de dados. O processo consiste basicamente em 3 etapas: exploração, construção de modelo ou definição do padrão e validação/verificação. Data Mining se beneficia com Hadoop.

Hadoop se aplica a Data Mining

The Basic of Map. Reduce Video in https: //youtu. be/g. I 4 HN 0 Jh. Pmo

No Hadoop, o resultado final é escrito em HDFS (Hadoop Distributed File System), o sistema de arquivos da plataforma que lida com grandes volumes de dados.