Captulo 5 Counterpropagation Networks CPN Redes de Contrapropagacin

- Slides: 30

Capítulo 5 Counterpropagation Networks (CPN) Redes de Contrapropagación Robert Hecht-Nielsen ( 1987) Creación de Subredes mediante memorias Hetereoasociativas Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 1

La Arquitectura CPN • Dado el conjunto de pares de vectores (x 1, y 1), . . , (x. P, y. P), donde xi RN ; yi RK estos clasifican en diferentes clases: C 1, C 2, …. , CH. • El CPN asocia un vector de la capa de entrada x, con un <y>k Ck, k= 1, . . H para el cúal el correspondiente <x>k es el más cercano a x. • <x>k e <y>k son los promedios de xp e yp que pertenecen a una misma clase. • CPN puede trabajar tb en reversa: dado y se obtiene <x>k Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 2

La Arquitectura CPN • Consiste en 5 capas y 3 niveles: – El nivel de entrada contiene dos capas x e y: • El 1 er nivel normaliza el vector de entrada. – El nivel medio contiene la capa oculta: • Clasifica el vector de entrada, eligiendo uno de los K códigos de clasificación. • Las salidas de todas las neuronas de la capa escondida son ceros excepto una, y dicha salida clasifica al correspondiente vector de entrada con una clase Ck. – El nivel de salida tienen dos capas x’ e y’: • Basado en la clasificación efectuada en la capa oculta, la capa de salida recupera el vector representativo. • Las tres subredes son cuasi-independientes y el entrenamiento de un nivel se ejecuta solo cuando se ha terminado el nivel anterior. Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 3

La Arquitectura CPN Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 4

La Arquitectura CPN • Forma de trabajar: – Considerar que se tiene una red entrenada, tal que cuando se aplican vectores: x e y = 0 , en el nivel de entrada, entonces se obtiene <y>k. – En forma inversa (reversa), cuando se aplican vector y , x = 0, y se obtiene <x>k Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 5

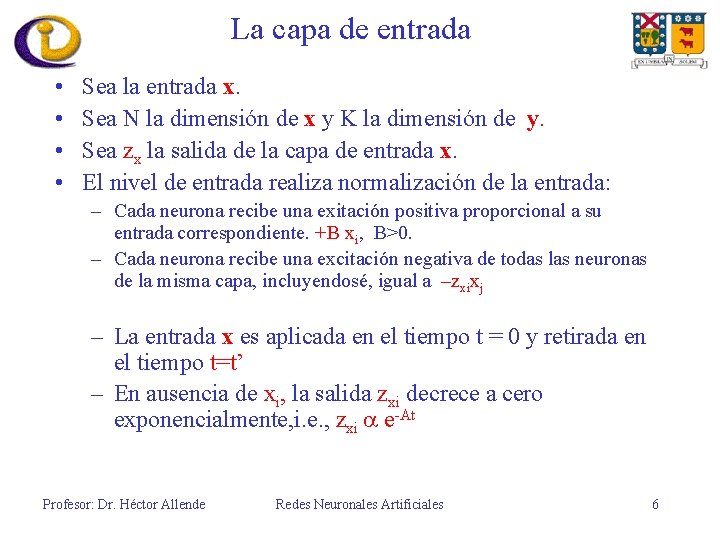

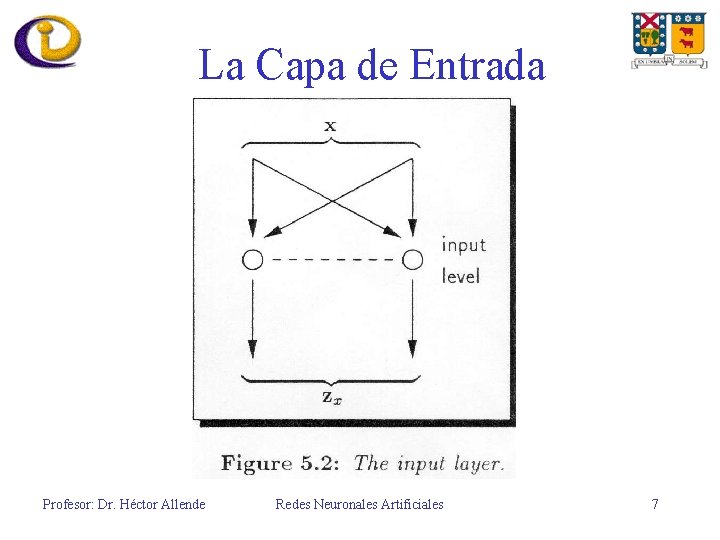

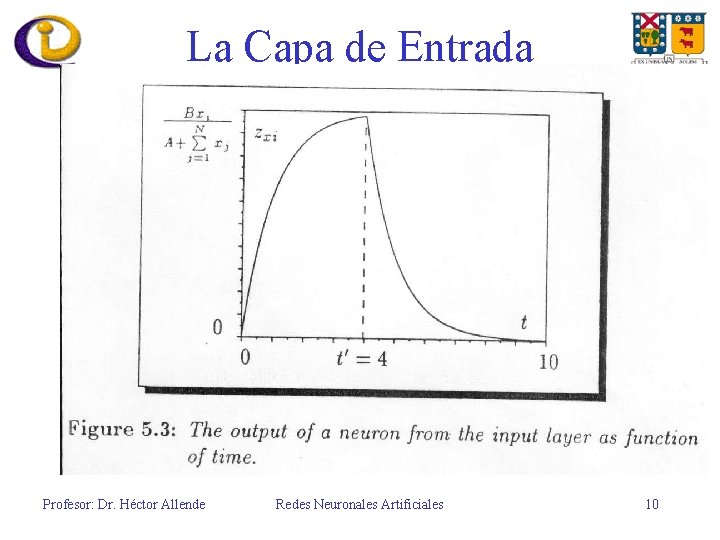

La capa de entrada • • Sea la entrada x. Sea N la dimensión de x y K la dimensión de y. Sea zx la salida de la capa de entrada x. El nivel de entrada realiza normalización de la entrada: – Cada neurona recibe una exitación positiva proporcional a su entrada correspondiente. +B xi, B>0. – Cada neurona recibe una excitación negativa de todas las neuronas de la misma capa, incluyendosé, igual a –zxixj – La entrada x es aplicada en el tiempo t = 0 y retirada en el tiempo t=t’ – En ausencia de xi, la salida zxi decrece a cero exponencialmente, i. e. , zxi e-At Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 6

La Capa de Entrada Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 7

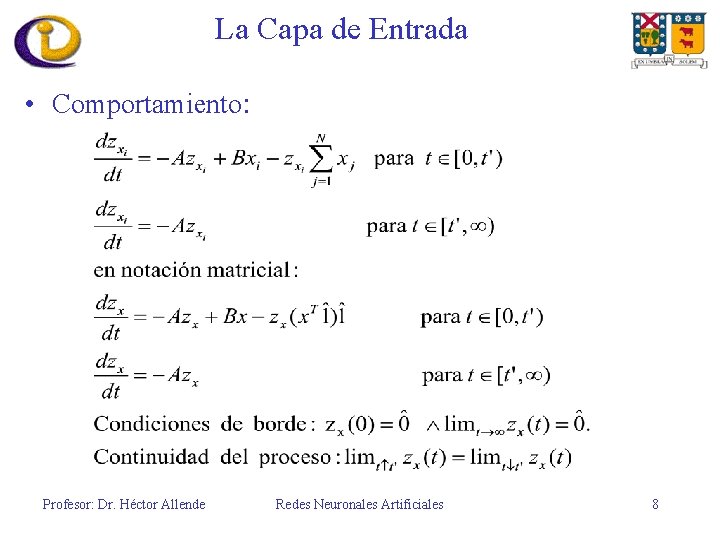

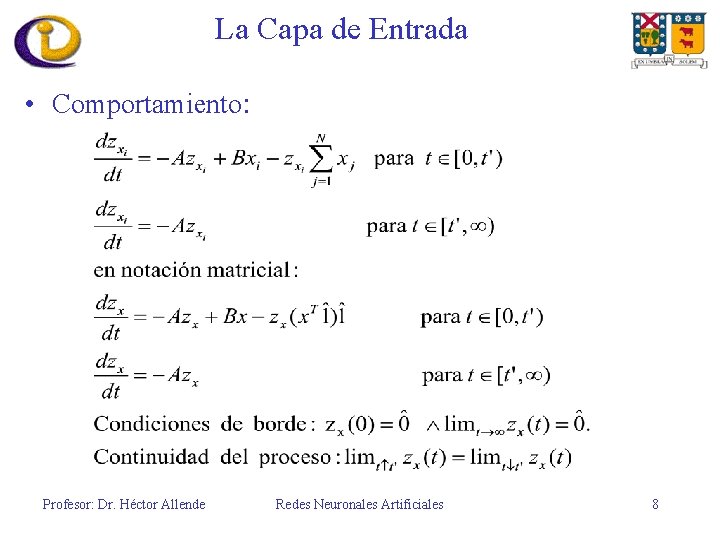

La Capa de Entrada • Comportamiento: Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 8

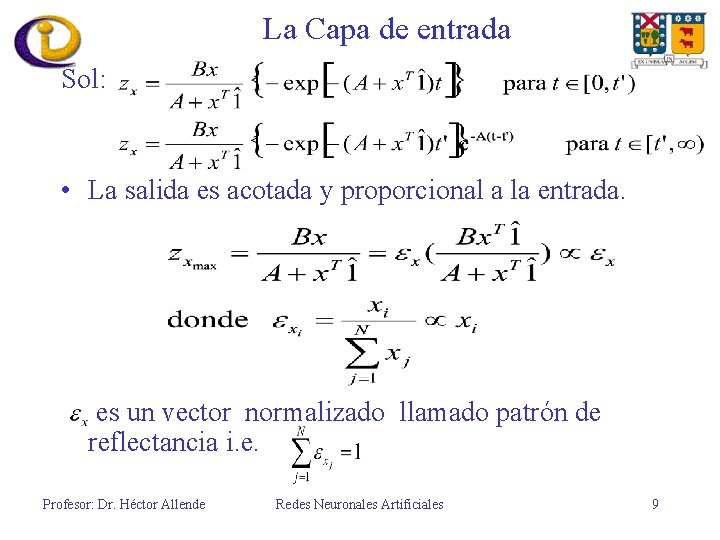

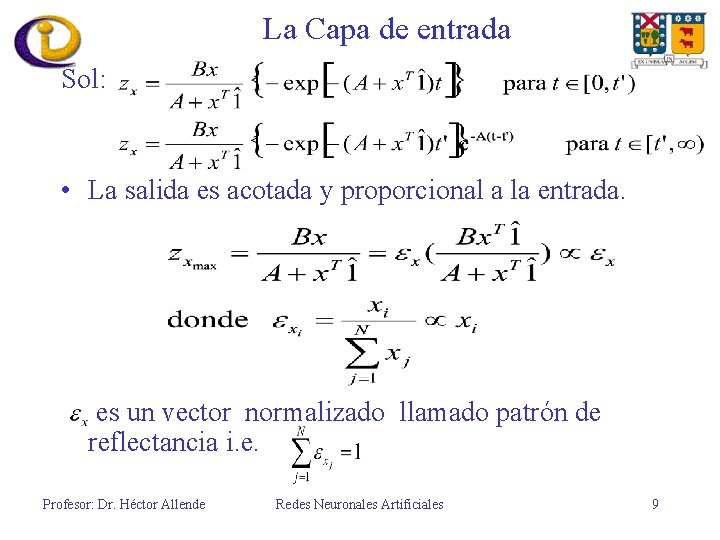

La Capa de entrada Sol: • La salida es acotada y proporcional a la entrada. es un vector normalizado llamado patrón de reflectancia i. e. Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 9

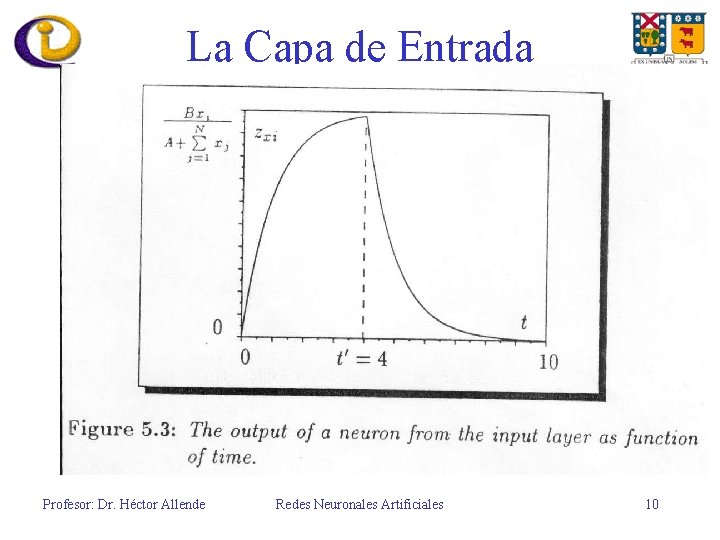

La Capa de Entrada Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 10

La Capa oculta • El Instar: – La capa oculta consta de un conjunto de Instar. – Los Instar pueden clasificar la dirección de los vectores de entrada. – El vector de entrada es z ={zi}I=1, . . , N+K, contiene los outputs de xey – Sea H la dimensión de la capa oculta: z. H={ZHk}k=1, H , el output del vector de la capa oculta. – Sea W la matriz peso, W= {wki}k=1, H ; i=1, N+K , tal que la entrada a la neurona k de la capa oculta es W(k, : ) z = Neto Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 11

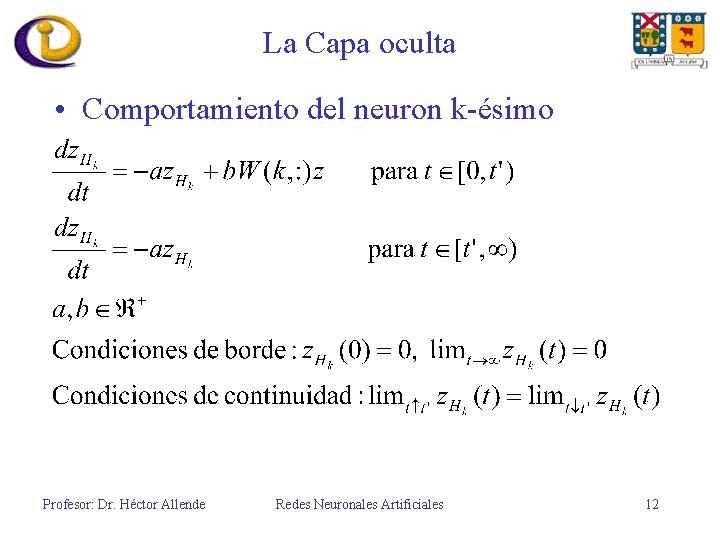

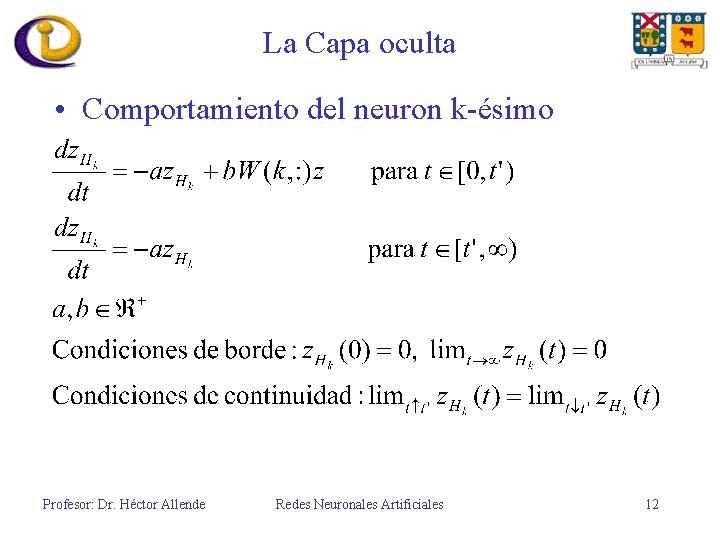

La Capa oculta • Comportamiento del neuron k-ésimo Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 12

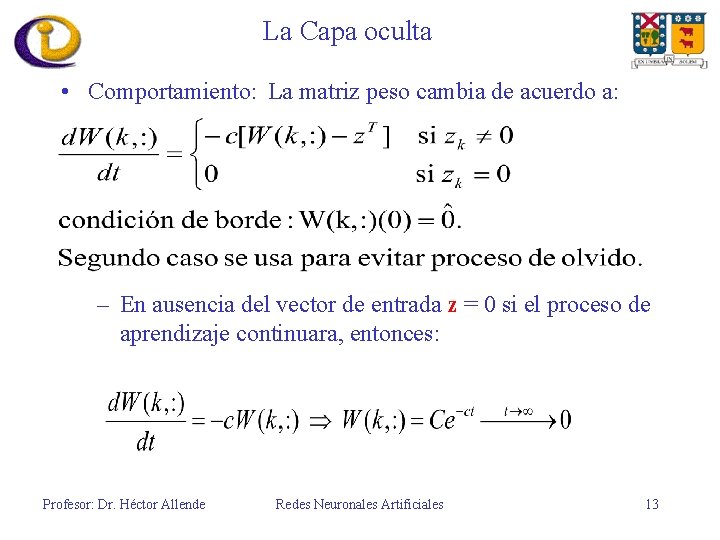

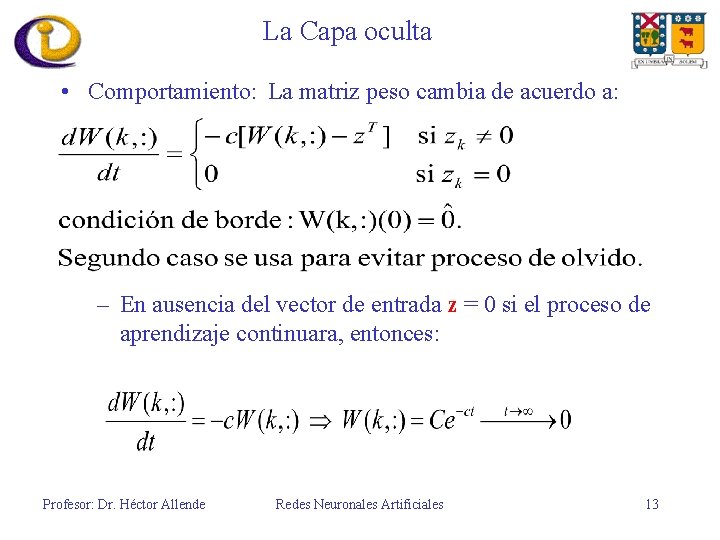

La Capa oculta • Comportamiento: La matriz peso cambia de acuerdo a: – En ausencia del vector de entrada z = 0 si el proceso de aprendizaje continuara, entonces: Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 13

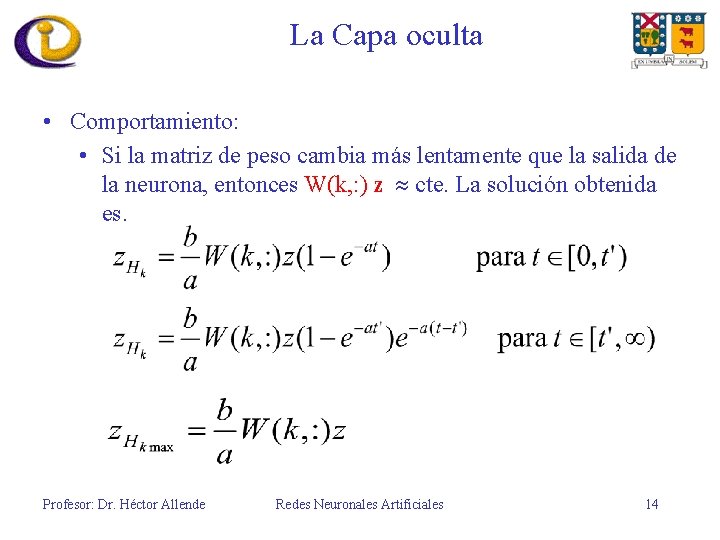

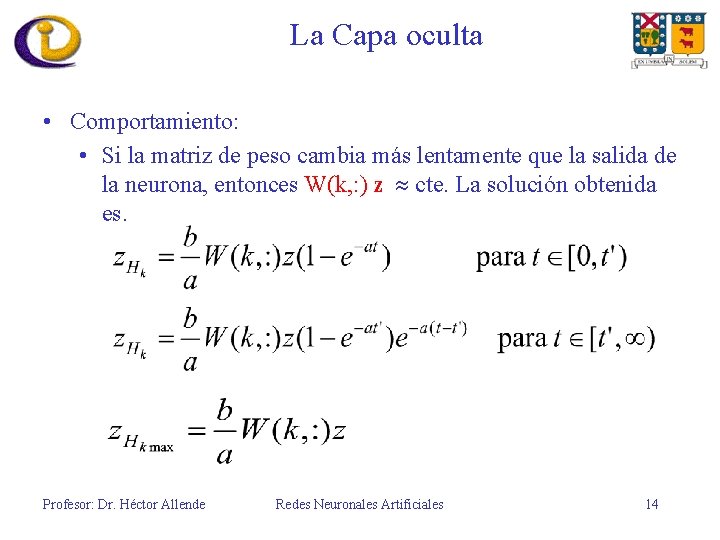

La Capa oculta • Comportamiento: • Si la matriz de peso cambia más lentamente que la salida de la neurona, entonces W(k, : ) z cte. La solución obtenida es. Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 14

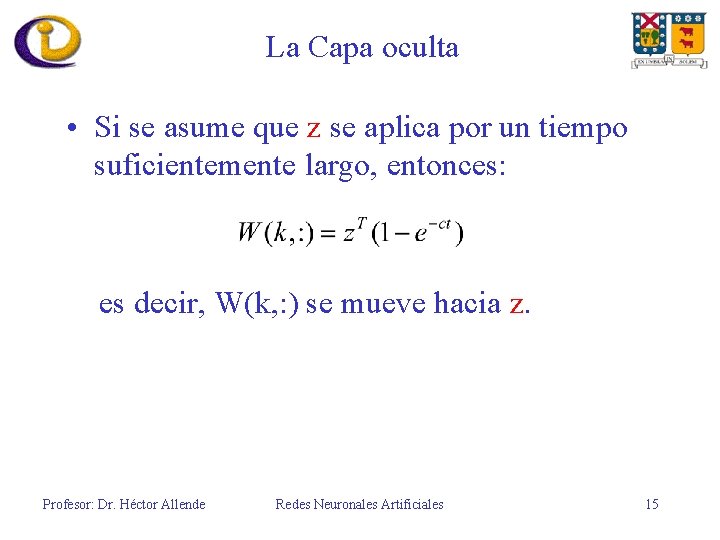

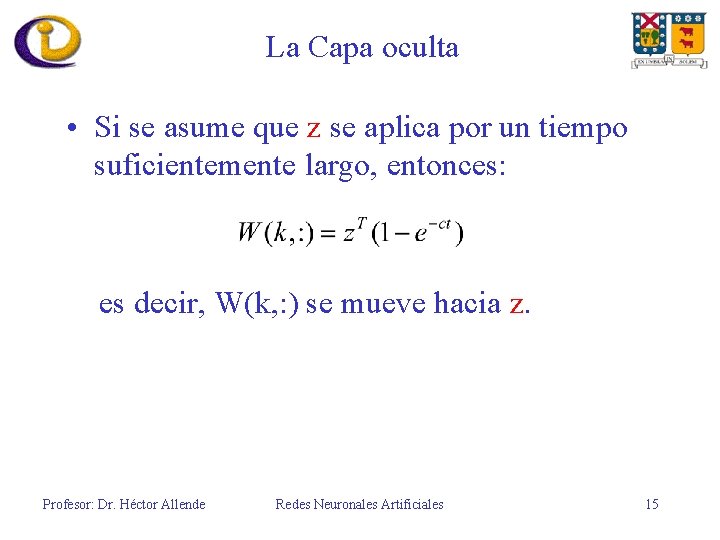

La Capa oculta • Si se asume que z se aplica por un tiempo suficientemente largo, entonces: es decir, W(k, : ) se mueve hacia z. Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 15

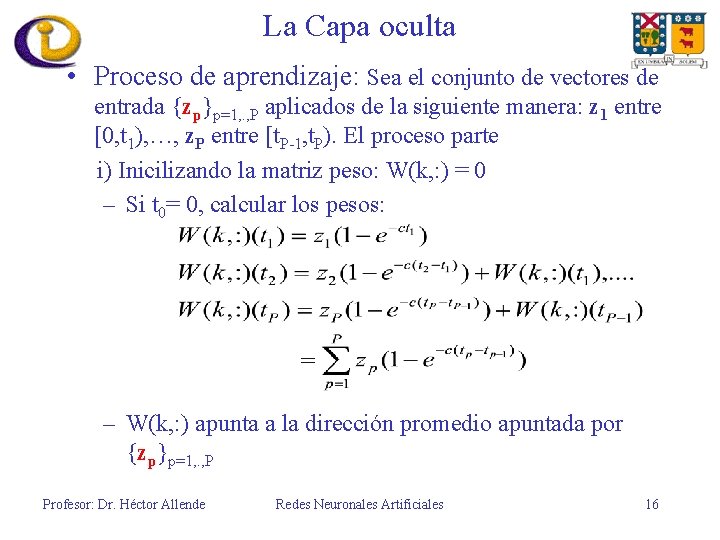

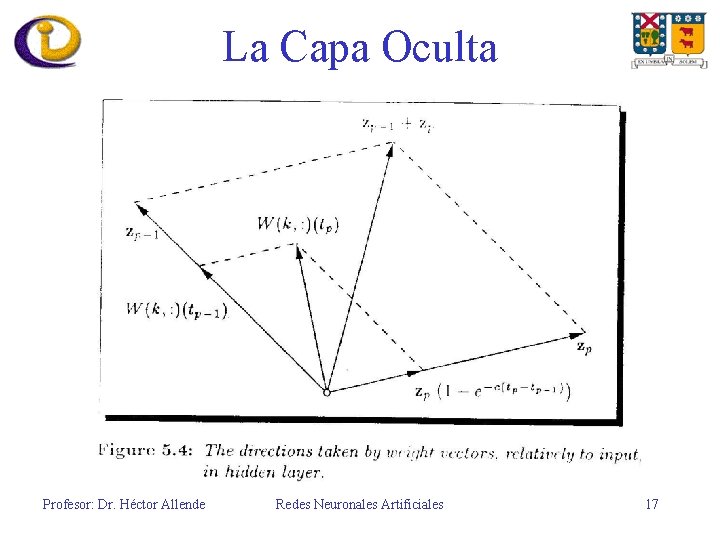

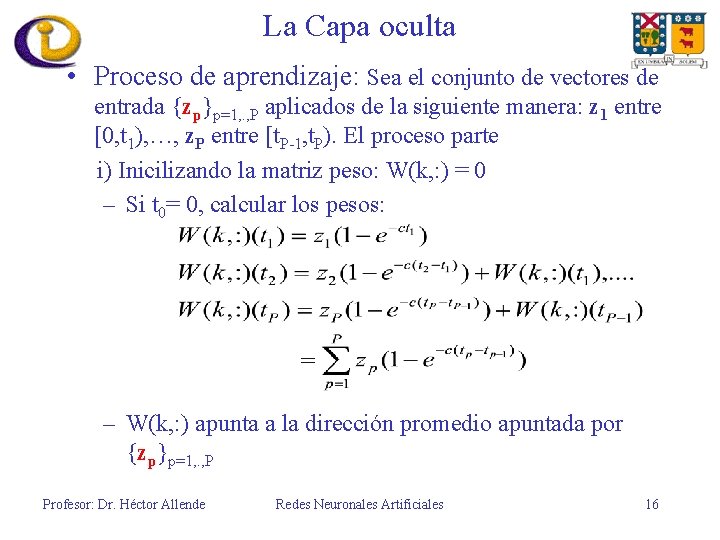

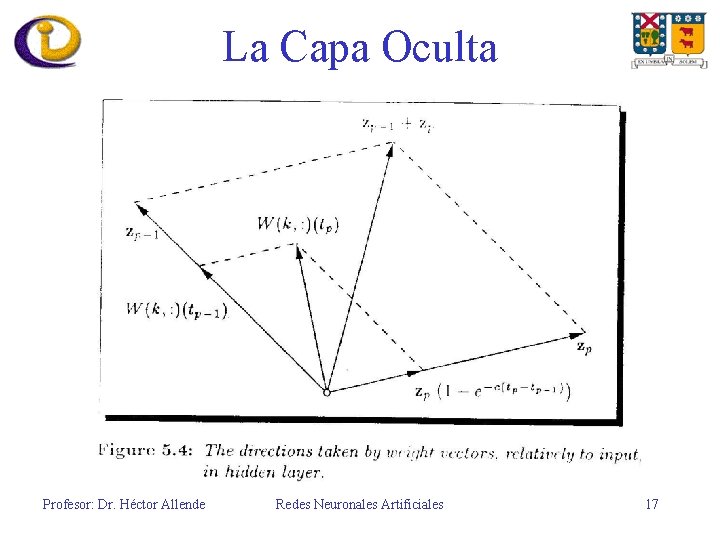

La Capa oculta • Proceso de aprendizaje: Sea el conjunto de vectores de entrada {zp}p=1, . , P aplicados de la siguiente manera: z 1 entre [0, t 1), …, z. P entre [t. P-1, t. P). El proceso parte i) Inicilizando la matriz peso: W(k, : ) = 0 – Si t 0= 0, calcular los pesos: – W(k, : ) apunta a la dirección promedio apuntada por {zp}p=1, . , P Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 16

La Capa Oculta Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 17

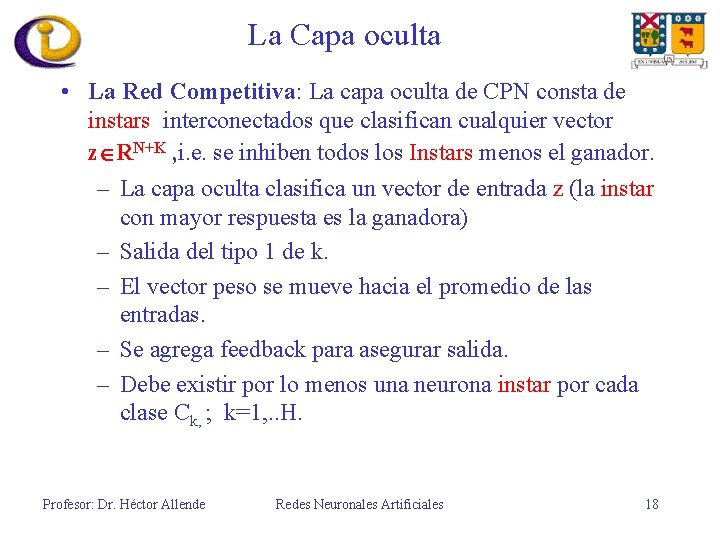

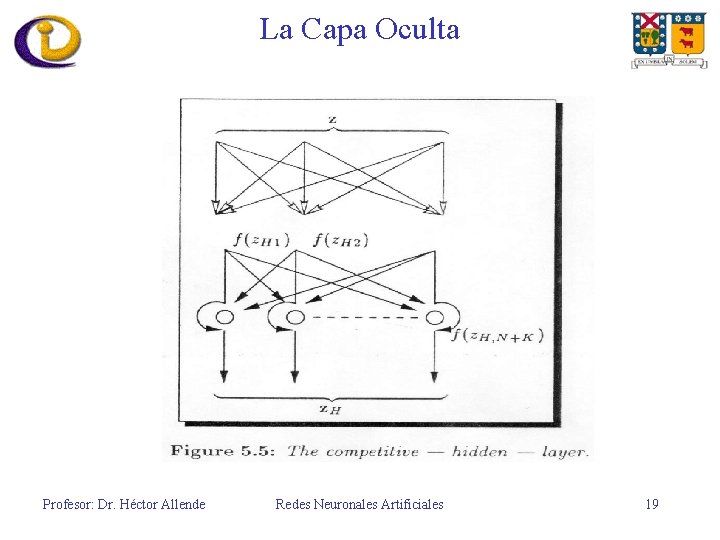

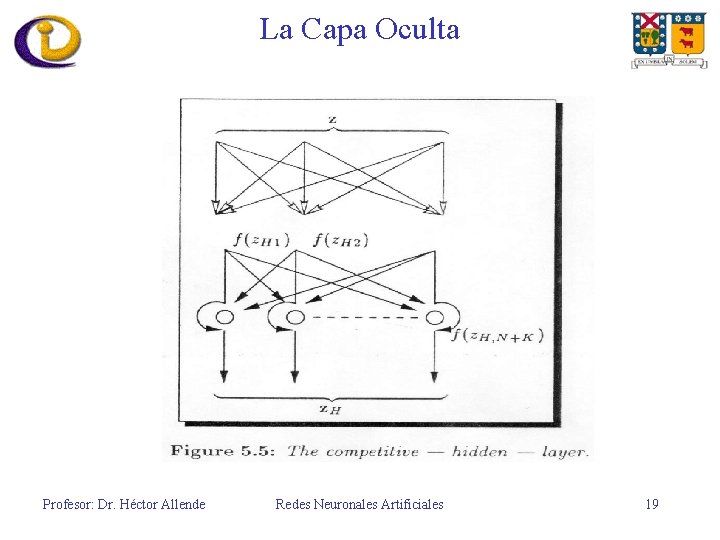

La Capa oculta • La Red Competitiva: La capa oculta de CPN consta de instars interconectados que clasifican cualquier vector z RN+K , i. e. se inhiben todos los Instars menos el ganador. – La capa oculta clasifica un vector de entrada z (la instar con mayor respuesta es la ganadora) – Salida del tipo 1 de k. – El vector peso se mueve hacia el promedio de las entradas. – Se agrega feedback para asegurar salida. – Debe existir por lo menos una neurona instar por cada clase Ck, ; k=1, . . H. Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 18

La Capa Oculta Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 19

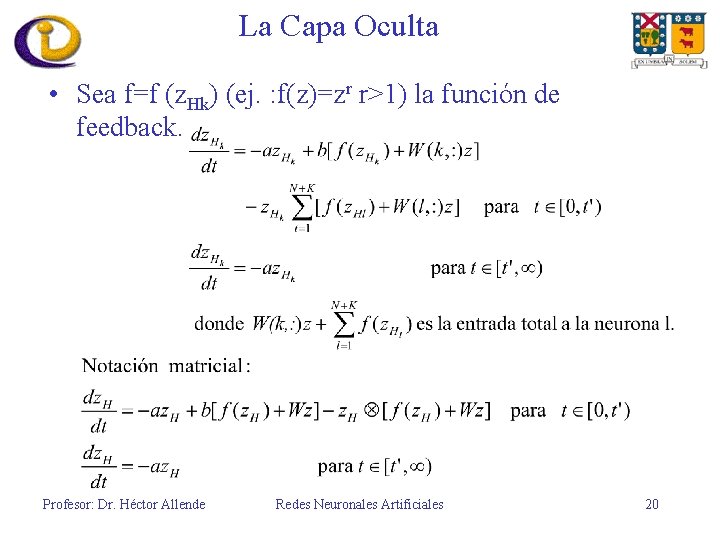

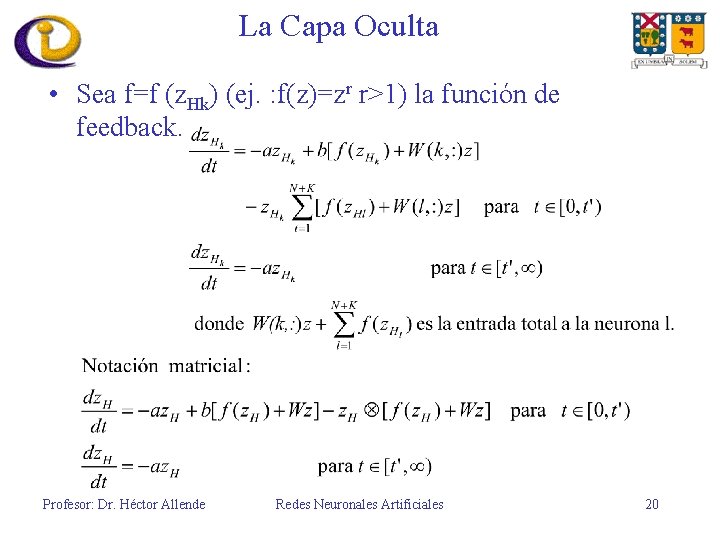

La Capa Oculta • Sea f=f (z. Hk) (ej. : f(z)=zr r>1) la función de feedback. Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 20

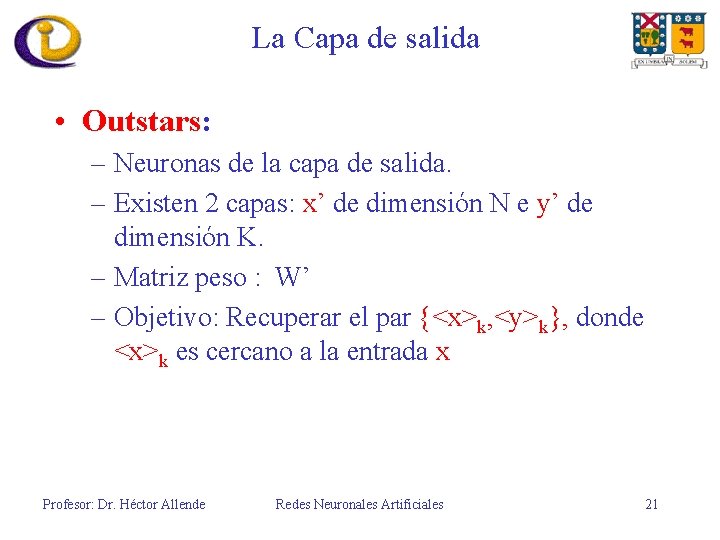

La Capa de salida • Outstars: – Neuronas de la capa de salida. – Existen 2 capas: x’ de dimensión N e y’ de dimensión K. – Matriz peso : W’ – Objetivo: Recuperar el par {<x>k, <y>k}, donde <x>k es cercano a la entrada x Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 21

La Capa de salida • Comportamiento: Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 22

La Capa de salida • Cambio en la matriz peso: – Solo una columna de W’ cambia. Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 23

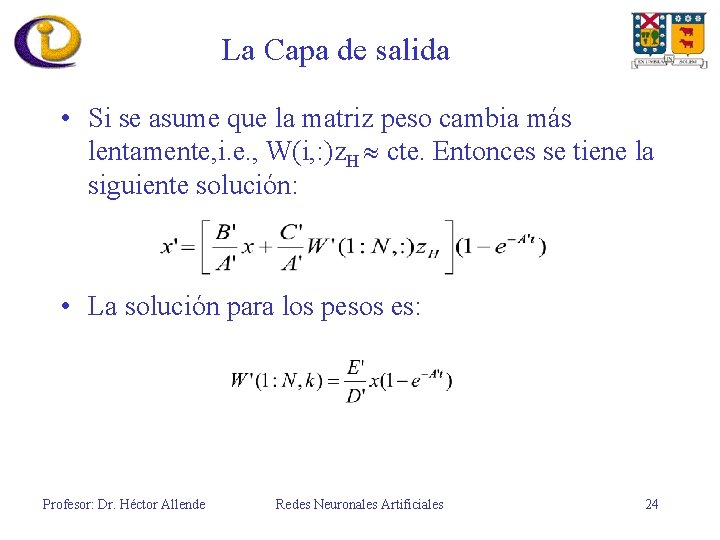

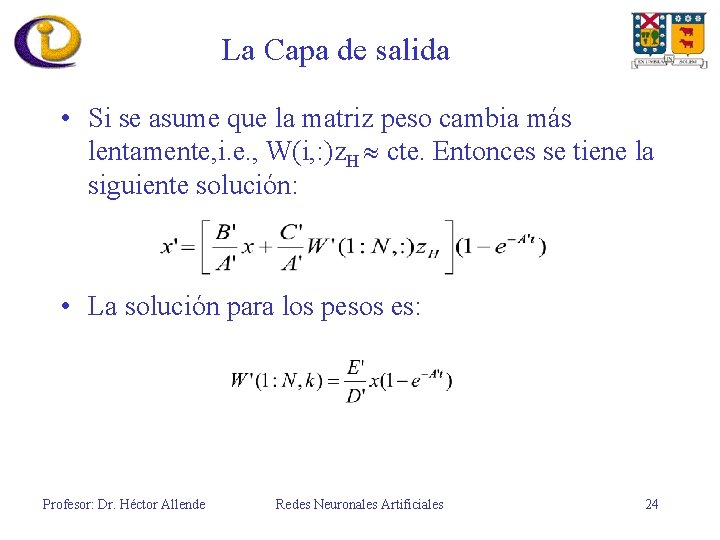

La Capa de salida • Si se asume que la matriz peso cambia más lentamente, i. e. , W(i, : )z. H cte. Entonces se tiene la siguiente solución: • La solución para los pesos es: Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 24

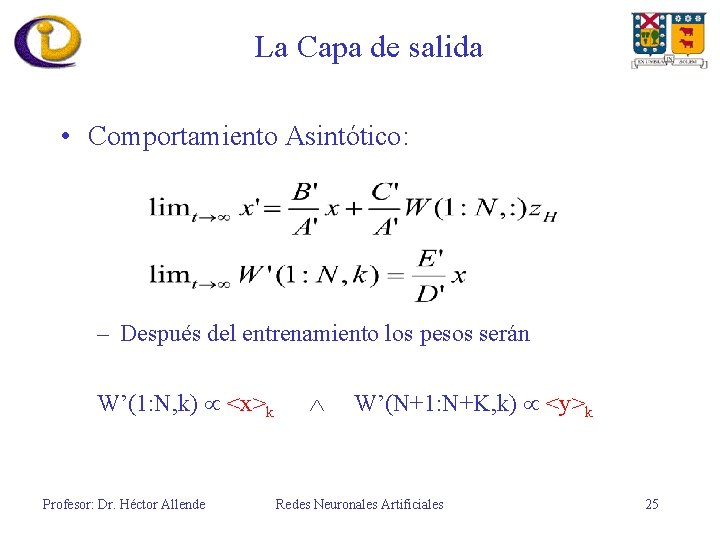

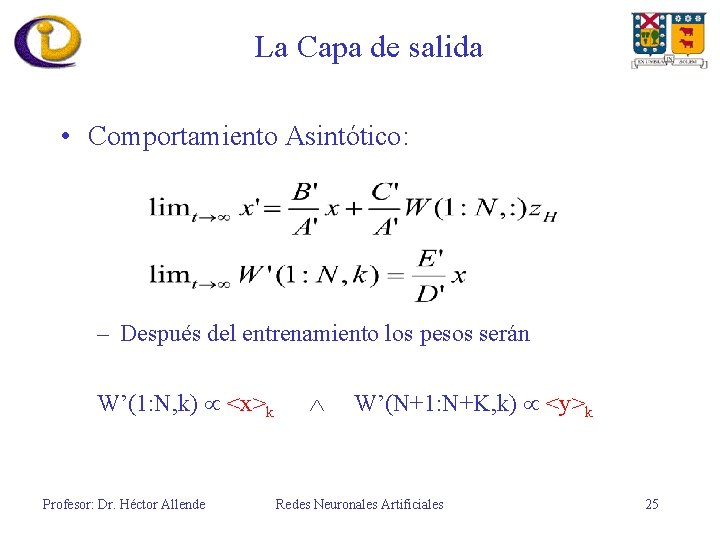

La Capa de salida • Comportamiento Asintótico: – Después del entrenamiento los pesos serán W’(1: N, k) <x>k Profesor: Dr. Héctor Allende W’(N+1: N+K, k) <y>k Redes Neuronales Artificiales 25

Dinámica de la CPN • Ejecución de la red: – Capa de entrada: Normalización de la entrada. – La capa oculta es del tipo ganador se lleva todo. • Se calcula las salidas de las neuronas ocultas: z. Hl W(l, : )z. • Sea k tal que • – Capa de Salida • La ecuación : • Hacer y = 0, C’=A’ y E’=D’, entonces la salida de la capa y’ es y’ =W’(N+1, N+K, k) Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 26

Dinámica de la CPN • Algoritmo de aprendizaje: – Un vector de entrada se elige aleatoriamente. – La capa de entrada normaliza la entrada: Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 27

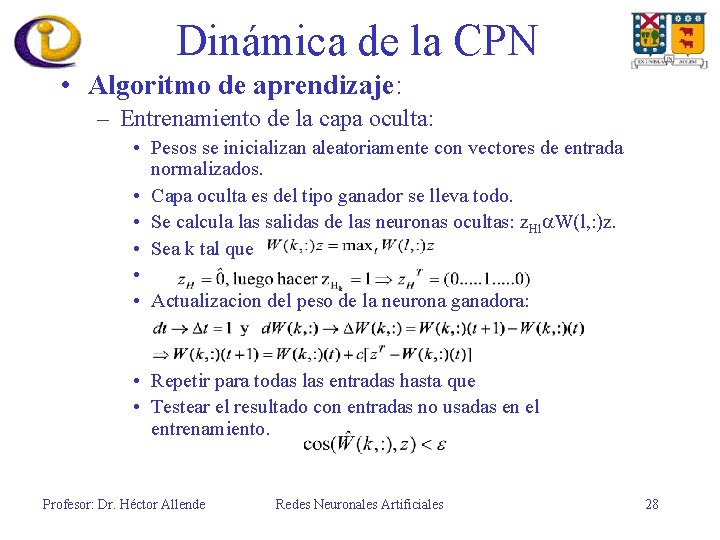

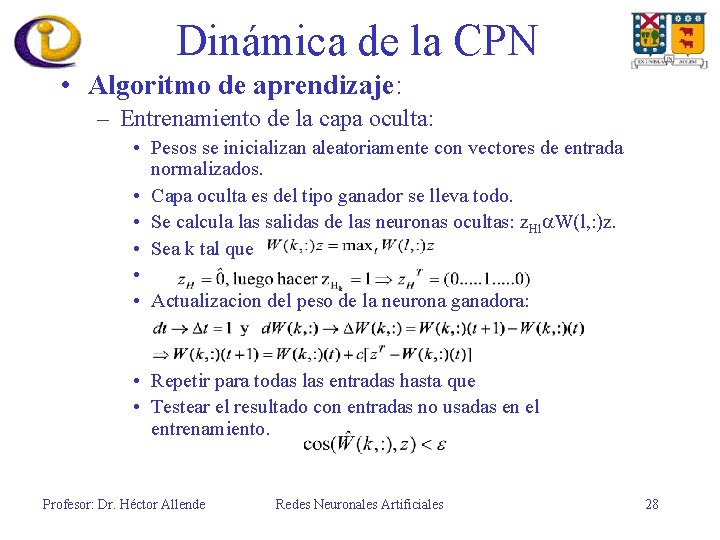

Dinámica de la CPN • Algoritmo de aprendizaje: – Entrenamiento de la capa oculta: • Pesos se inicializan aleatoriamente con vectores de entrada normalizados. • Capa oculta es del tipo ganador se lleva todo. • Se calcula las salidas de las neuronas ocultas: z. Hl W(l, : )z. • Sea k tal que • • Actualizacion del peso de la neurona ganadora: • Repetir para todas las entradas hasta que • Testear el resultado con entradas no usadas en el entrenamiento. Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 28

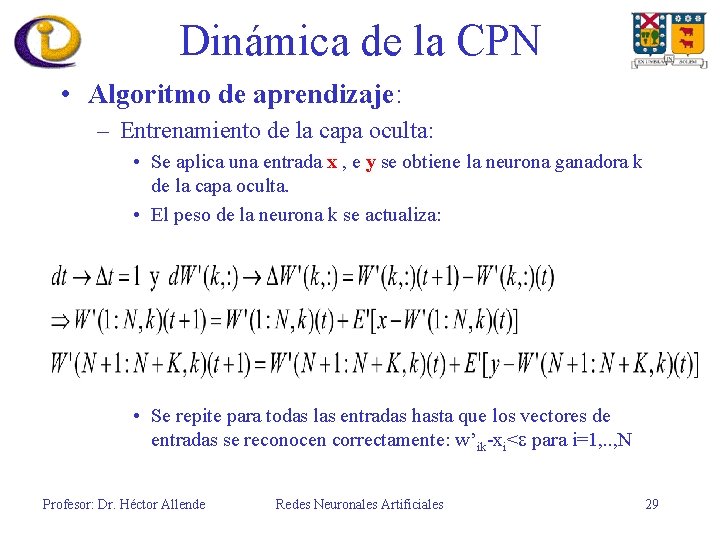

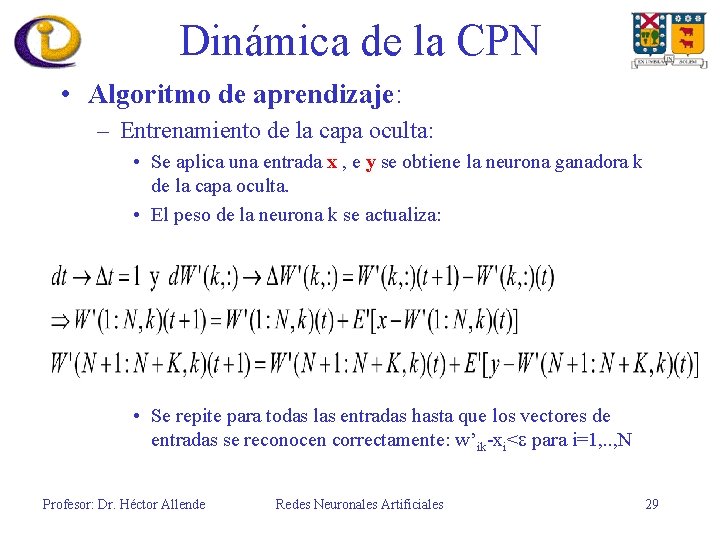

Dinámica de la CPN • Algoritmo de aprendizaje: – Entrenamiento de la capa oculta: • Se aplica una entrada x , e y se obtiene la neurona ganadora k de la capa oculta. • El peso de la neurona k se actualiza: • Se repite para todas las entradas hasta que los vectores de entradas se reconocen correctamente: w’ik-xi< para i=1, . . , N Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 29

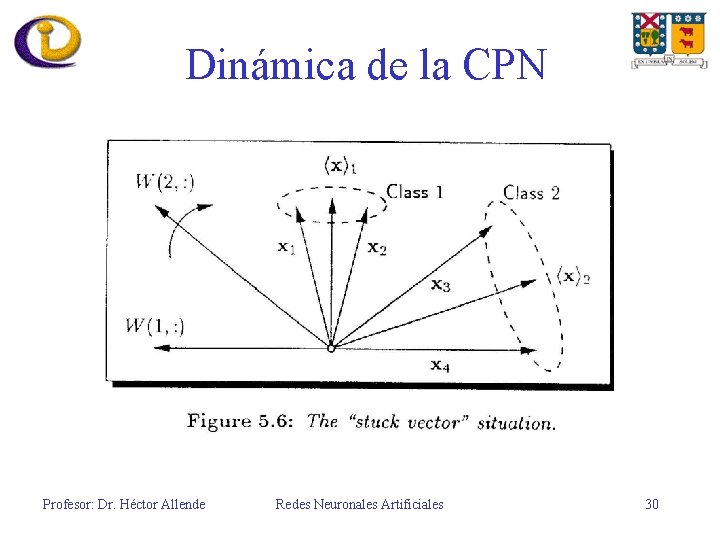

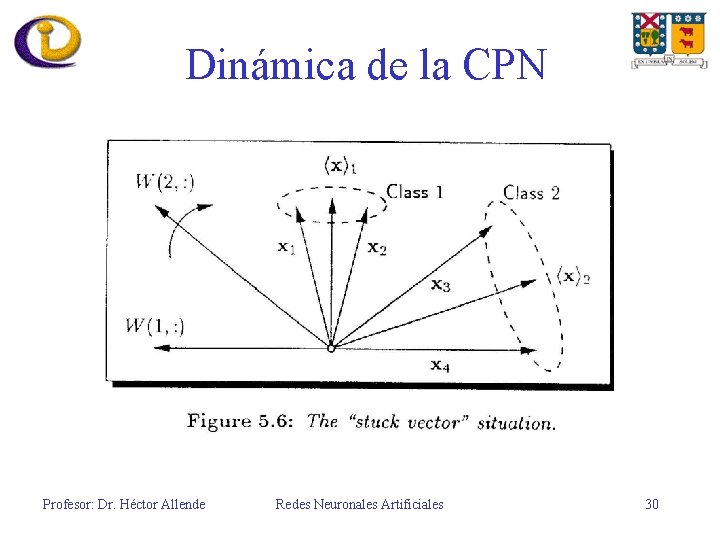

Dinámica de la CPN Profesor: Dr. Héctor Allende Redes Neuronales Artificiales 30

Https://slidetodoc.com/captulo-2-o-sudeste-e-o-sul-do/

Https://slidetodoc.com/captulo-2-o-sudeste-e-o-sul-do/ Https://slidetodoc.com/captulo-2-o-sudeste-e-o-sul-do/

Https://slidetodoc.com/captulo-2-o-sudeste-e-o-sul-do/ Basestore iptv

Basestore iptv Datagram network

Datagram network Cpn software

Cpn software Color cpn s

Color cpn s Cpn certification requirements

Cpn certification requirements Fieldbus history

Fieldbus history Validated cpn numbers

Validated cpn numbers Computer information development llc

Computer information development llc Badoobadoo

Badoobadoo Teorema de redes

Teorema de redes Que son las redes sociales genericas

Que son las redes sociales genericas Rdsi caracteristicas

Rdsi caracteristicas Objetivos del uso de las redes sociales

Objetivos del uso de las redes sociales Atm redes

Atm redes Que es rsvp en redes

Que es rsvp en redes Buscar personas en facebook por foto

Buscar personas en facebook por foto David rose dua

David rose dua Redes wpan

Redes wpan Que es una red empresarial

Que es una red empresarial Propuesta para redes sociales

Propuesta para redes sociales Dot

Dot Componentes básicos de una red de computadoras

Componentes básicos de una red de computadoras Nacimiento redes sociales

Nacimiento redes sociales Qué es la interconexión de redes

Qué es la interconexión de redes Cableado estructurado ejemplos

Cableado estructurado ejemplos Color 03062003

Color 03062003 Redes neurais

Redes neurais Redes e fluxos geográficos são

Redes e fluxos geográficos são Imagens de sinapses neurais

Imagens de sinapses neurais