Wykad 10 Neuropsychologia komputerowa Percepcja II Postrzeganie niezmiennicze

- Slides: 18

Wykład 10 Neuropsychologia komputerowa Percepcja II: Postrzeganie niezmiennicze Włodzisław Duch UMK Toruń Google: W Duch

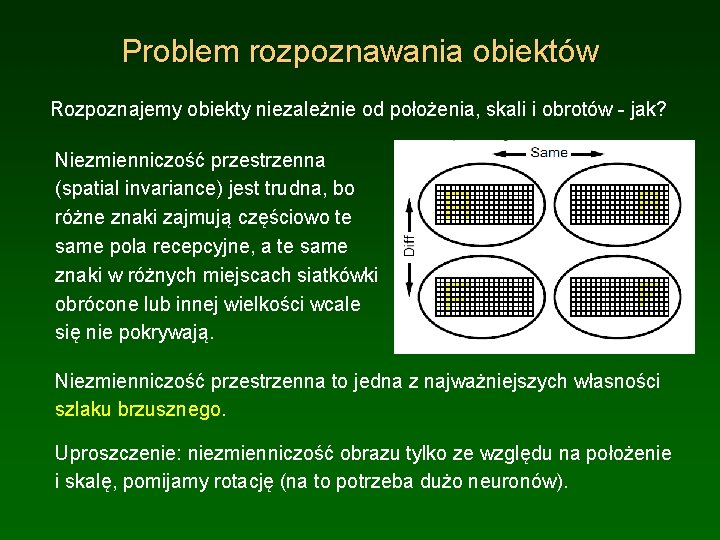

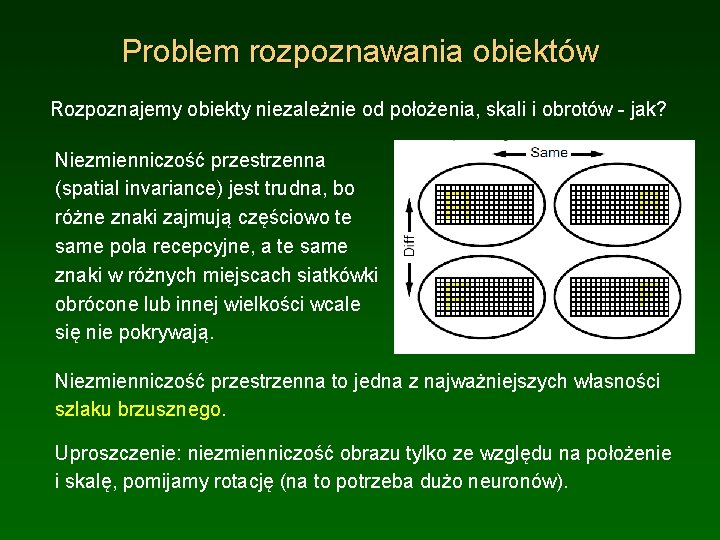

Problem rozpoznawania obiektów Rozpoznajemy obiekty niezależnie od położenia, skali i obrotów - jak? Niezmienniczość przestrzenna (spatial invariance) jest trudna, bo różne znaki zajmują częściowo te same pola recepcyjne, a te same znaki w różnych miejscach siatkówki obrócone lub innej wielkości wcale się nie pokrywają. Niezmienniczość przestrzenna to jedna z najważniejszych własności szlaku brzusznego. Uproszczenie: niezmienniczość obrazu tylko ze względu na położenie i skalę, pomijamy rotację (na to potrzeba dużo neuronów).

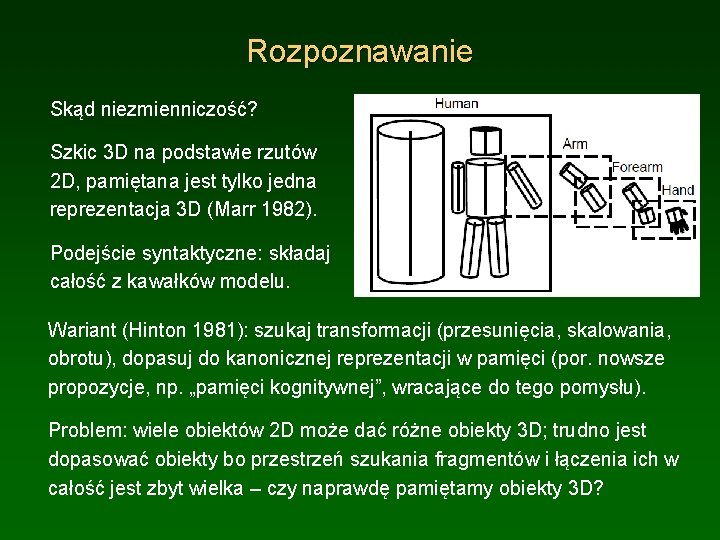

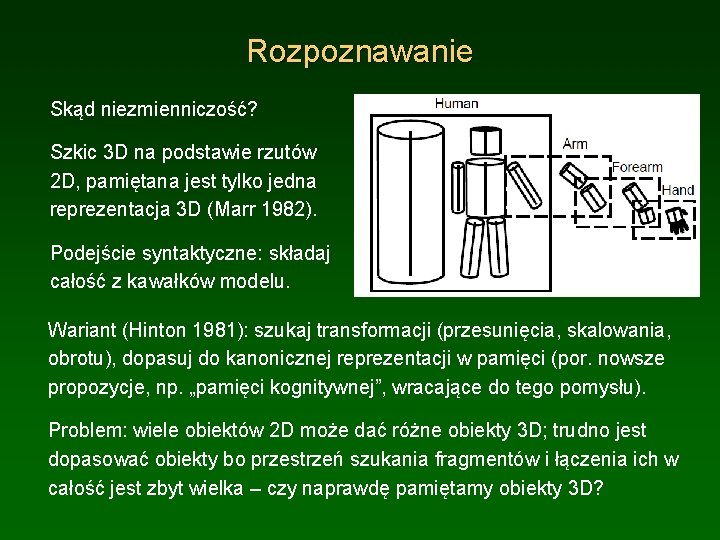

Rozpoznawanie Skąd niezmienniczość? Szkic 3 D na podstawie rzutów 2 D, pamiętana jest tylko jedna reprezentacja 3 D (Marr 1982). Podejście syntaktyczne: składaj całość z kawałków modelu. Wariant (Hinton 1981): szukaj transformacji (przesunięcia, skalowania, obrotu), dopasuj do kanonicznej reprezentacji w pamięci (por. nowsze propozycje, np. „pamięci kognitywnej”, wracające do tego pomysłu). Problem: wiele obiektów 2 D może dać różne obiekty 3 D; trudno jest dopasować obiekty bo przestrzeń szukania fragmentów i łączenia ich w całość jest zbyt wielka – czy naprawdę pamiętamy obiekty 3 D?

Stopniowe transformacje Niezmienniczość obróconych obrazów jest mocno ograniczona – np. rozpoznawanie obróconych twarzy jest trudne. Ograniczoną niezmienniczość rozpoznawania obiektów można uzyskać dzięki stopniowym hierarchicznym równoległym transformacjom, zwiększającym niezmienniczość i tworzącym coraz bardziej złożone cechy rozproszonych reprezentacji. Cel: nie 3 D, ale zachować wystarczająco dużo szczegółów by dało się rozpoznać obiekty w niezmienniczy sposób po transformacjach. Efekt: pamięć na poziomie niezmienniczym to nie pamięć 3 D. . .

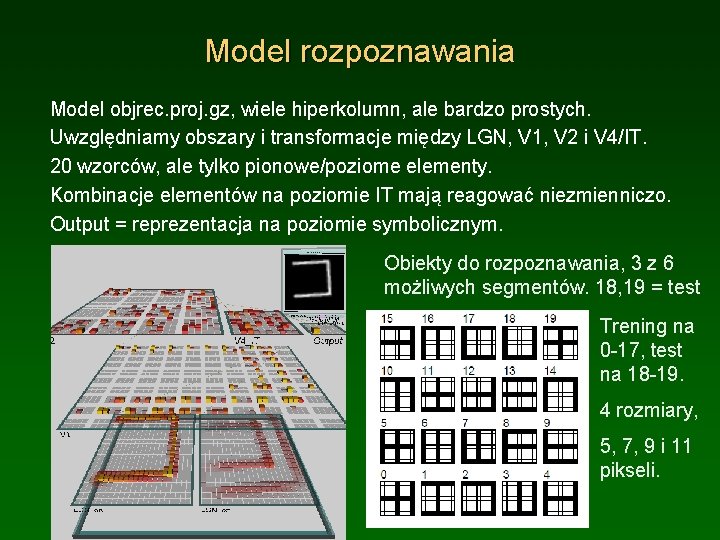

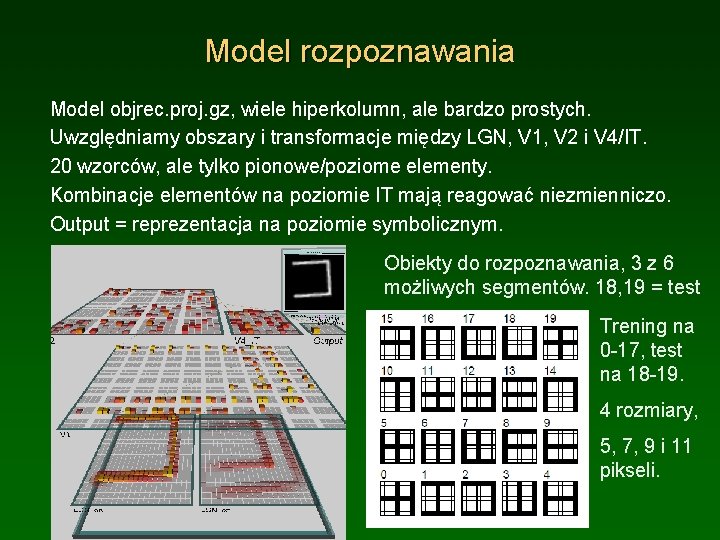

Model rozpoznawania Model objrec. proj. gz, wiele hiperkolumn, ale bardzo prostych. Uwzględniamy obszary i transformacje między LGN, V 1, V 2 i V 4/IT. 20 wzorców, ale tylko pionowe/poziome elementy. Kombinacje elementów na poziomie IT mają reagować niezmienniczo. Output = reprezentacja na poziomie symbolicznym. Obiekty do rozpoznawania, 3 z 6 możliwych segmentów. 18, 19 = test Trening na 0 -17, test na 18 -19. 4 rozmiary, 5, 7, 9 i 11 pikseli.

Własności modelu rozpoznawania Hiperkolumna: te same sygnały, przesunięte i częściowo się pokrywające. Elementy wewnątrz hiperkolumny konkurują, k. WTA, elementy w warstwie również konkurują – hamowanie na większym obszarze. Całkowite hamowanie = max (lokalnego, z całej warstwy). Hiperkolumny dokują ekstrakcji cech w całym polu widzenia => wystarczą te same wagi (weight sharing) dla każdej hiperkolumny. Obiekty reprezentowane są za pomocą krawędzi w warstwie LGN On/Off, każda 22 x 22, zawinięte brzegi (geometria sferyczna). V 1: 10 x 10 kolumn po 2 x 4 elementy, wyuczone reprezentacje krawędzi pionowych i poziomych, pola recepcyjne 4 x 4 w LGN, jest 8 pionowych i poziomych krawędzi dla on i 8 dla off, razem 16 = 4 x 4 jednostki. V 2: 4 x 4 hiperkolumn, w matrycy 6 x 6, sygnały z kolumn 4 x 4, nakrywanie. V 4/IT: 10 x 10, całe pole wzrokowe, dla tak prostych obiektów wystarczy.

Więcej własności Symulacje bez wspólnych wag dla hiperkolumn dają te same rezultaty, chociaż są znacznie bardziej kosztowne; Hebbowski mechanizm prowadzi do jednakowych wag dla kolumny o tych samych (xi, yi). Bez Hebba sama korekcja błędów daje całkiem różne reprezentacje dla hiperkolumn, bo nie wykrywa korelacji wejść. Brak połączeń horyzontalnych – rep. V 1 jest już ustalona, więc nie są konieczne a spowalniają uczenie; te połączenia są ważne w procesach wypełniania braków, iluzjach, rozpoznawaniu przysłoniętych obiektów. Parametry: Hebb =0. 005, ale pomiędzy V 1/V 2 jest tylko 0. 001 bo współdzielenie wag daje częstsze pobudzenia = wiec zmian. Uczenie: szybkość 0. 01 => 0. 001 po 150 epokach by stabilizować uczenie i przyspieszyć początkowe. Budowa sieci: Build. Net, sprawdzić własności połączeń, r. wt.

Eksploracja sieci Step. Train, faza – i Step. Train, faza + Całość trenowania wymaga wielu godzin; jeden obiekt może być w 4 rozmiarach i 256 pozycjach w siatce 16 x 16, razem są 1024 obrazy jednego obiektu, 18 obiektów treningowych, 18 432 wzorce. Wytrenowana sieć po 460 epokach x 150 obiektów na epokę, po 30 000 prezentacji osiąga dobre wyniki, mniej niż 2 prezentacje/wzorzec. net_updt => cycle_updt pokaże uczenie dla całego cyklu, na wytrenowanej sieci fazy – i + są takie same. Jak koreluje się aktywność V 2 i V 4 z wejściami w LGN? Pola recepcyjne wynikające z uśrednionej aktywacji można obejrzeć patrząc na korelacje xi z LGN, yj z V 2 lub V 4, dla każdego elementu hiperkolumny 8 x 8 przedstawiamy wszystkie ri

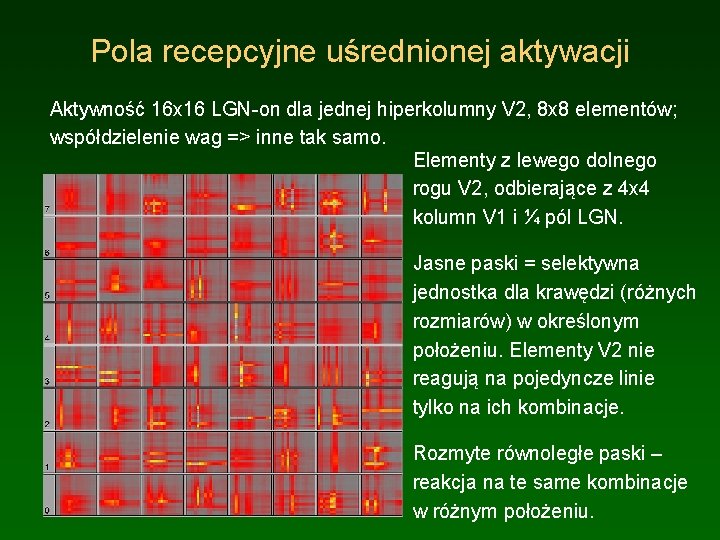

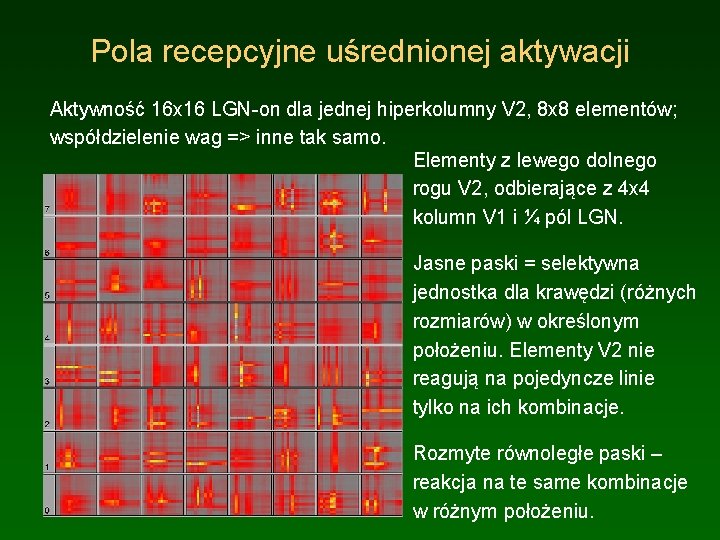

Pola recepcyjne uśrednionej aktywacji Aktywność 16 x 16 LGN-on dla jednej hiperkolumny V 2, 8 x 8 elementów; współdzielenie wag => inne tak samo. Elementy z lewego dolnego rogu V 2, odbierające z 4 x 4 kolumn V 1 i ¼ pól LGN. Jasne paski = selektywna jednostka dla krawędzi (różnych rozmiarów) w określonym położeniu. Elementy V 2 nie reagują na pojedyncze linie tylko na ich kombinacje. Rozmyte równoległe paski – reakcja na te same kombinacje w różnym położeniu.

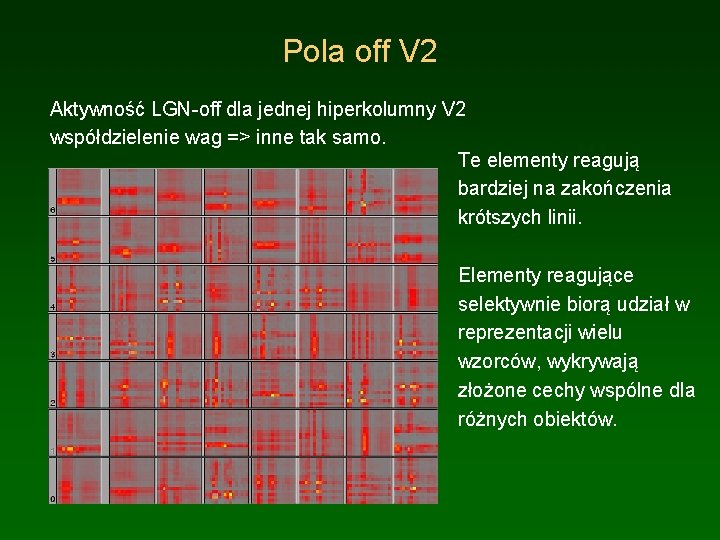

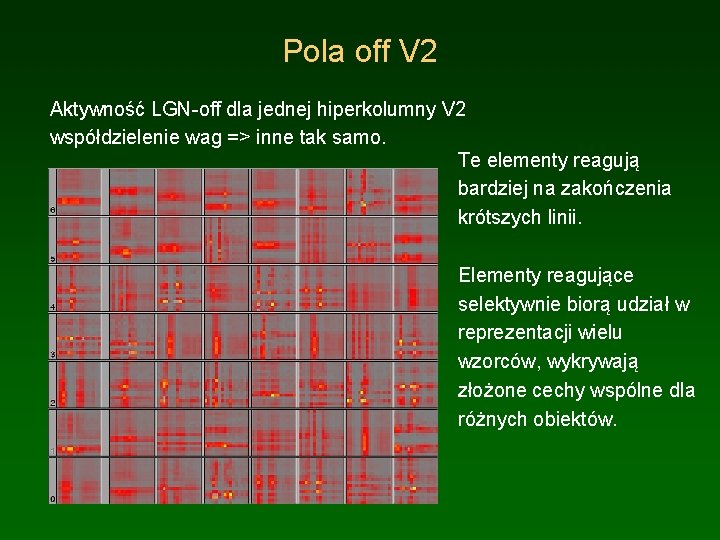

Pola off V 2 Aktywność LGN-off dla jednej hiperkolumny V 2 współdzielenie wag => inne tak samo. Te elementy reagują bardziej na zakończenia krótszych linii. Elementy reagujące selektywnie biorą udział w reprezentacji wielu wzorców, wykrywają złożone cechy wspólne dla różnych obiektów.

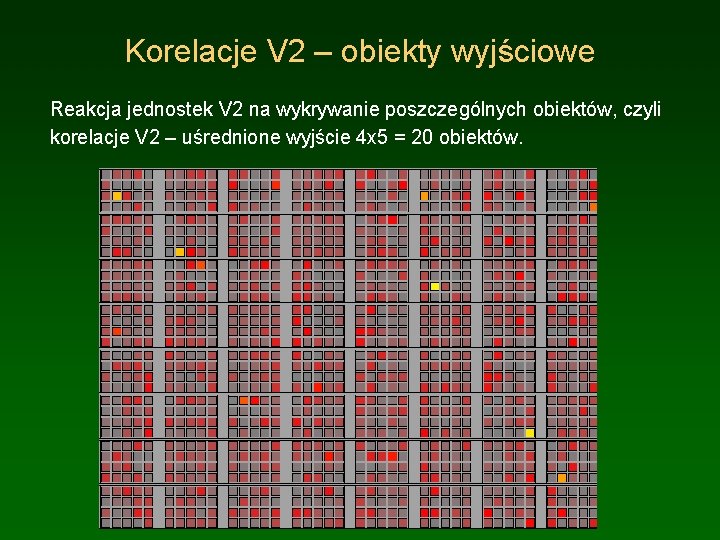

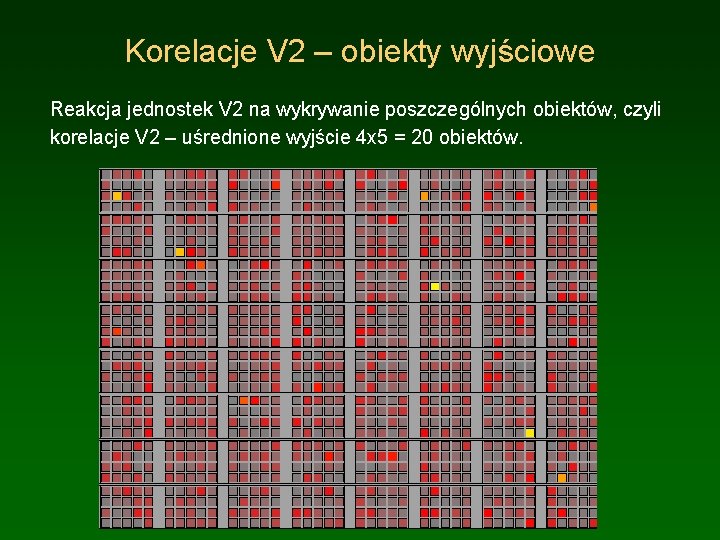

Korelacje V 2 – obiekty wyjściowe Reakcja jednostek V 2 na wykrywanie poszczególnych obiektów, czyli korelacje V 2 – uśrednione wyjście 4 x 5 = 20 obiektów.

Korelacje V 4 – obiekty wyjściowe Uśredniona reakcja jednostek V 4 na wykrywanie poszczególnych obiektów, czyli korelacje V 4 – uśrednione wyjście 4 x 5. Większa selektywność niż w V 2, bo większa niezmienniczość i reakcja na bardziej złożone cechy.

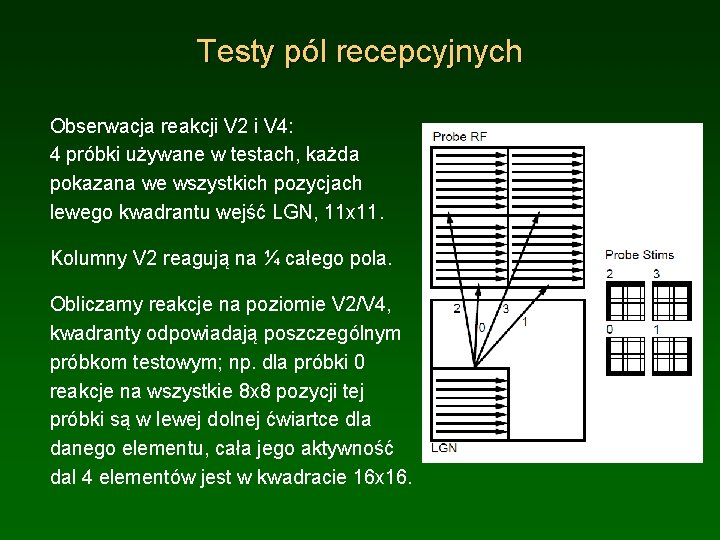

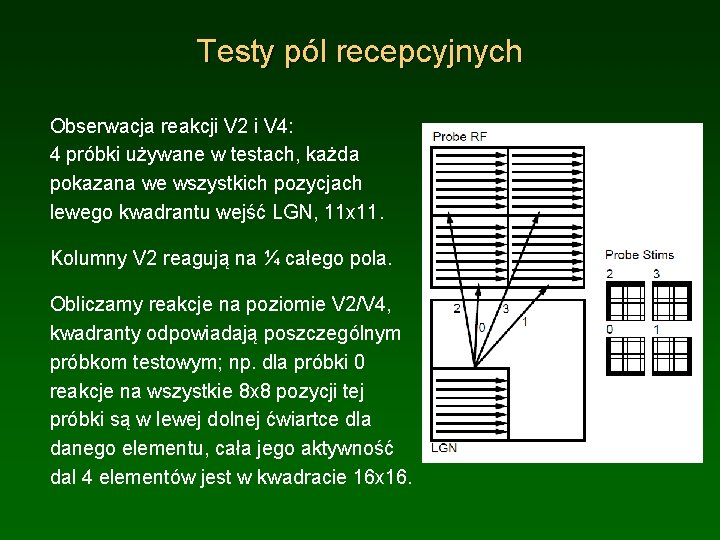

Testy pól recepcyjnych Obserwacja reakcji V 2 i V 4: 4 próbki używane w testach, każda pokazana we wszystkich pozycjach lewego kwadrantu wejść LGN, 11 x 11. Kolumny V 2 reagują na ¼ całego pola. Obliczamy reakcje na poziomie V 2/V 4, kwadranty odpowiadają poszczególnym próbkom testowym; np. dla próbki 0 reakcje na wszystkie 8 x 8 pozycji tej próbki są w lewej dolnej ćwiartce dla danego elementu, cała jego aktywność dal 4 elementów jest w kwadracie 16 x 16.

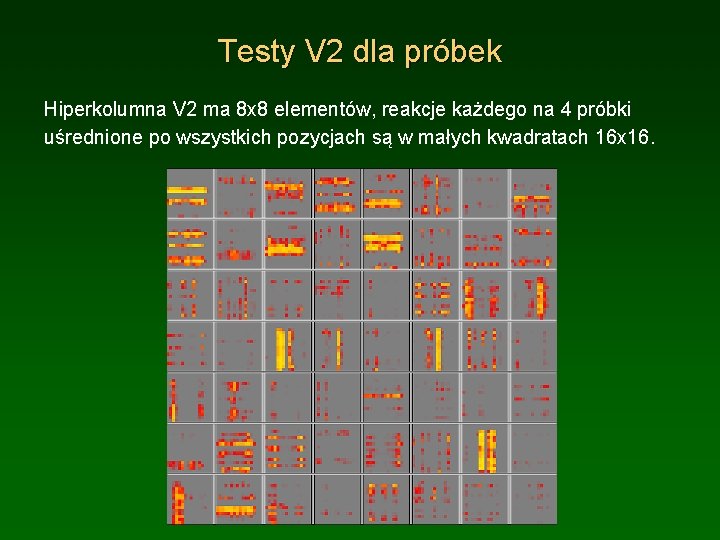

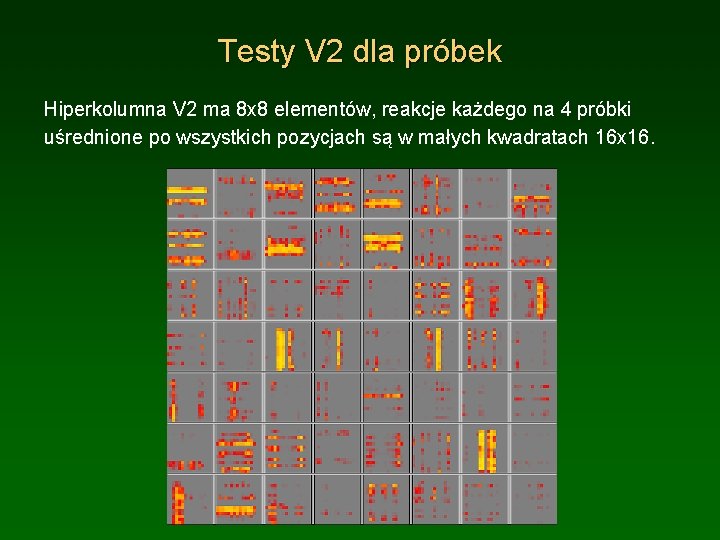

Testy V 2 dla próbek Hiperkolumna V 2 ma 8 x 8 elementów, reakcje każdego na 4 próbki uśrednione po wszystkich pozycjach są w małych kwadratach 16 x 16.

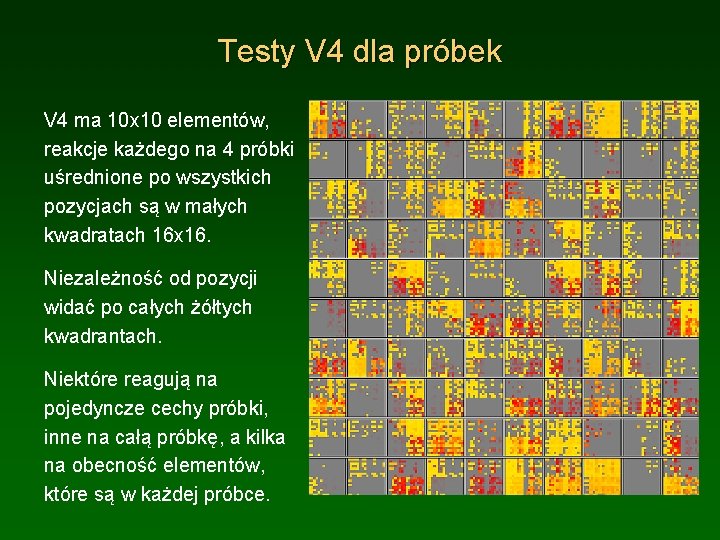

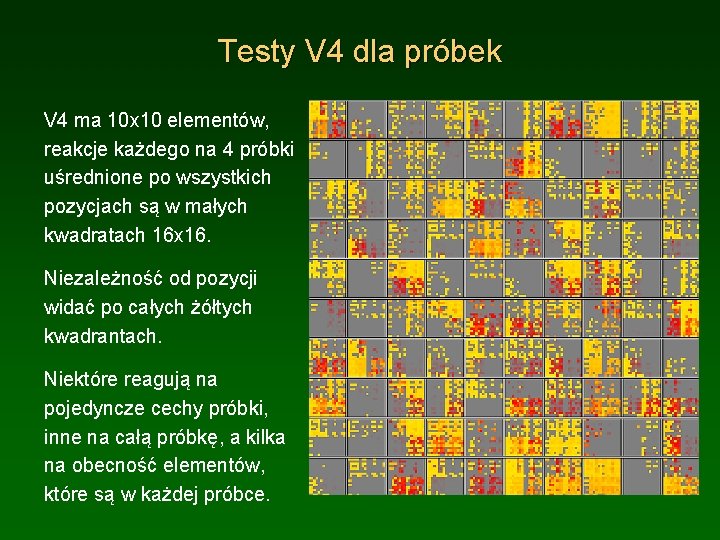

Testy V 4 dla próbek V 4 ma 10 x 10 elementów, reakcje każdego na 4 próbki uśrednione po wszystkich pozycjach są w małych kwadratach 16 x 16. Niezależność od pozycji widać po całych żółtych kwadrantach. Niektóre reagują na pojedyncze cechy próbki, inne na całą próbkę, a kilka na obecność elementów, które są w każdej próbce.

Testy statystyczne Tabela na następnym slajdzie podsumowuje wyniki testu prezentacji 20 obiektów we wszystkich pozycjach i reakcji (dla progu >0. 5) elementów V 4 na te prezentacje. Dla jednego obiektu w 256 możliwych pozycjach i 4 rozmiarach (1024 wzorce) na poziomie V 4 jest średnio 10 różnych aktywacji. Szczegółowe wyniki są w objrec. swp_pre. err. Dwa nieznane obiekty 18, 19 dają same błędy. Trenowanie w celu określenia generalizacji: prezentacja nowego obiektu raz na 4 prezentacje; w 36 z 256 możliwych pozycji, rozmiary 5 lub 9 pikseli, więc 14% pozycji i 50% rozmiarów, 72 wzorce (7%). Po 60 epokach treningu, 150 obiektów/epokę, stała uczenia 0. 001, obiekt 18 dał 85% poprawnych odpowiedzi na 1024 wzorce; obiekt 19 dał 66% poprawnych odpowiedzi, dla małych rozmiarów.

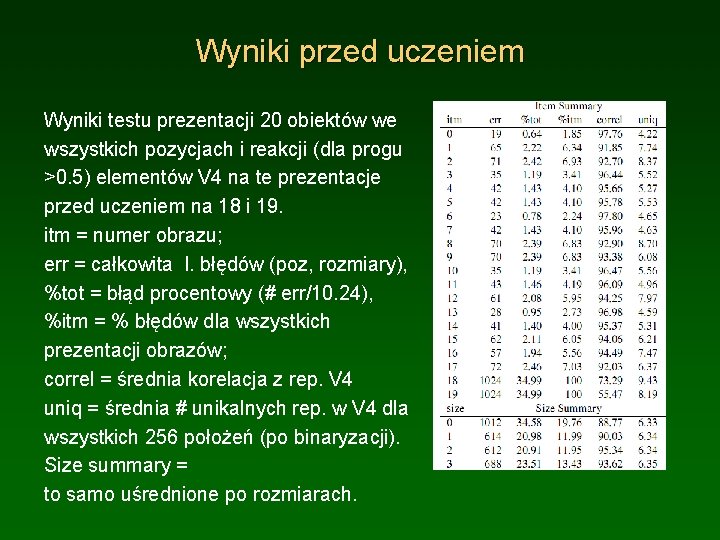

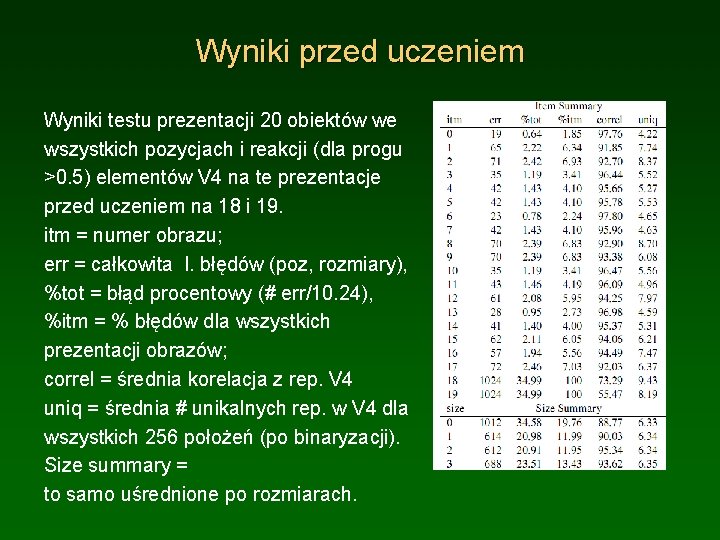

Wyniki przed uczeniem Wyniki testu prezentacji 20 obiektów we wszystkich pozycjach i reakcji (dla progu >0. 5) elementów V 4 na te prezentacje przed uczeniem na 18 i 19. itm = numer obrazu; err = całkowita l. błędów (poz, rozmiary), %tot = błąd procentowy (# err/10. 24), %itm = % błędów dla wszystkich prezentacji obrazów; correl = średnia korelacja z rep. V 4 uniq = średnia # unikalnych rep. w V 4 dla wszystkich 256 położeń (po binaryzacji). Size summary = to samo uśrednione po rozmiarach.

Parę odpowiedzi • Dlaczego pierwotna kora wzrokowa reaguje na zorientowane krawędzie? Bo uczenie korelacyjne w naturalnym środowisku prowadzi do tego typu detektorów; szczegółowe modele dość wiernie oddają strukturę kolumn wzrokowych jak i pokazują, że jest ona optymalna dla naturalnych tekstur i obrazów. • Dlaczego układ wzrokowy rozdziela informacje na szlak grzbietowy i szlak brzuszny? Bo transformacje sygnału wydobywają jakościowo różne informacje, wzmacniając jedne kontrasty a zmniejszając inne. Bo pomoże to w skupianiu uwagi na kolejnych obiektach.