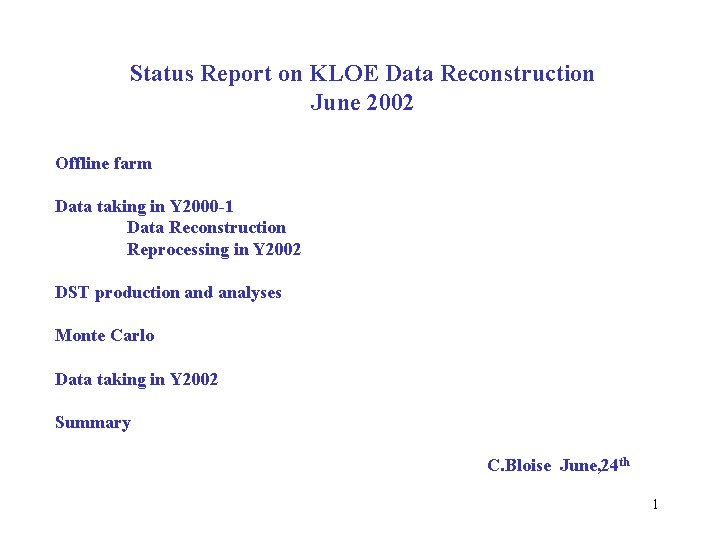

Status Report on KLOE Data Reconstruction June 2002

- Slides: 22

Status Report on KLOE Data Reconstruction June 2002 Offline farm Data taking in Y 2000 -1 Data Reconstruction Reprocessing in Y 2002 DST production and analyses Monte Carlo Data taking in Y 2002 Summary C. Bloise June, 24 th 1

2

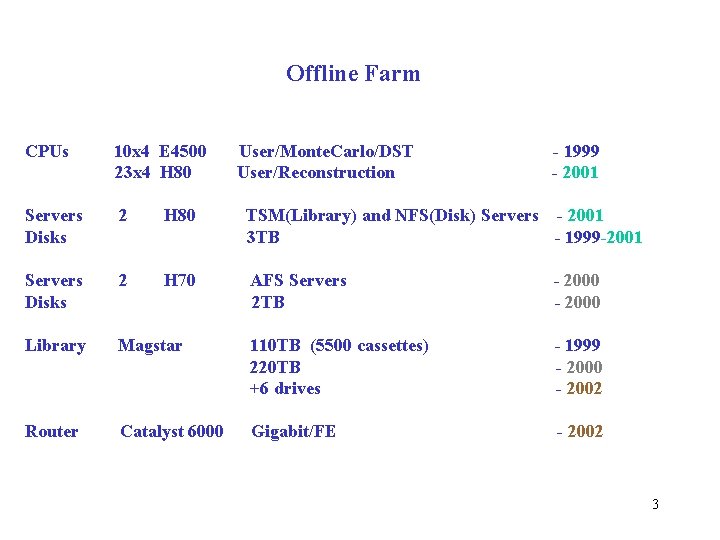

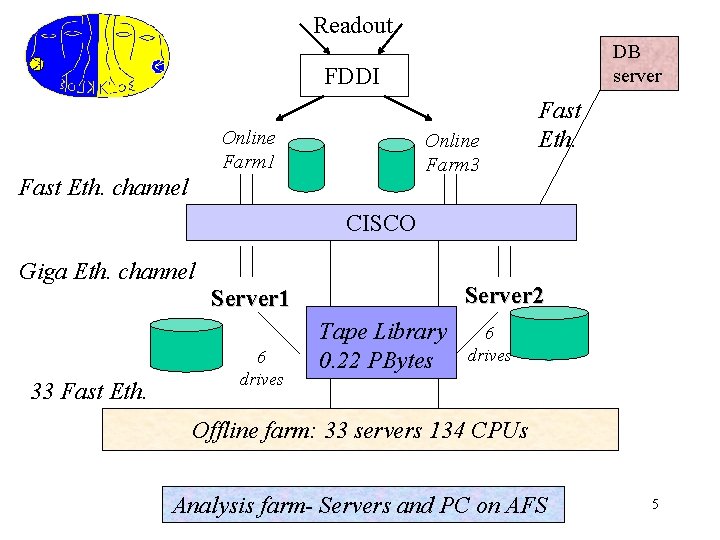

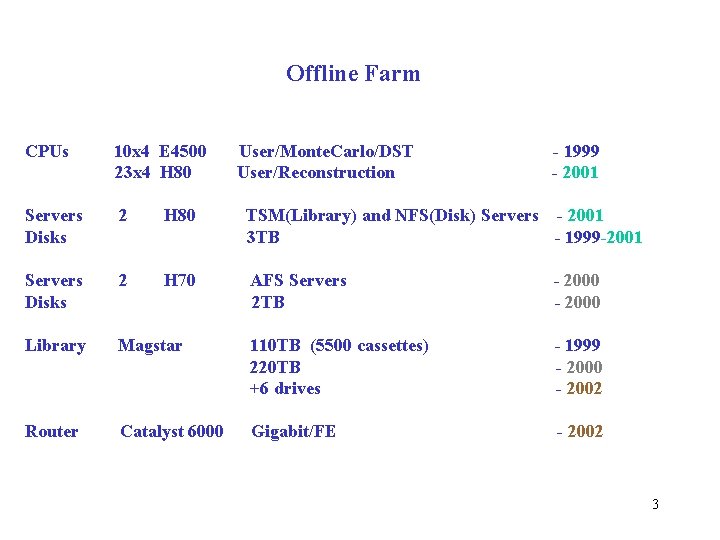

Offline Farm CPUs 10 x 4 E 4500 23 x 4 H 80 User/Monte. Carlo/DST User/Reconstruction - 1999 - 2001 Servers Disks 2 H 80 TSM(Library) and NFS(Disk) Servers - 2001 3 TB - 1999 -2001 Servers Disks 2 H 70 AFS Servers 2 TB - 2000 Library Magstar 110 TB (5500 cassettes) 220 TB +6 drives - 1999 - 2000 - 2002 Router Catalyst 6000 Gigabit/FE - 2002 3

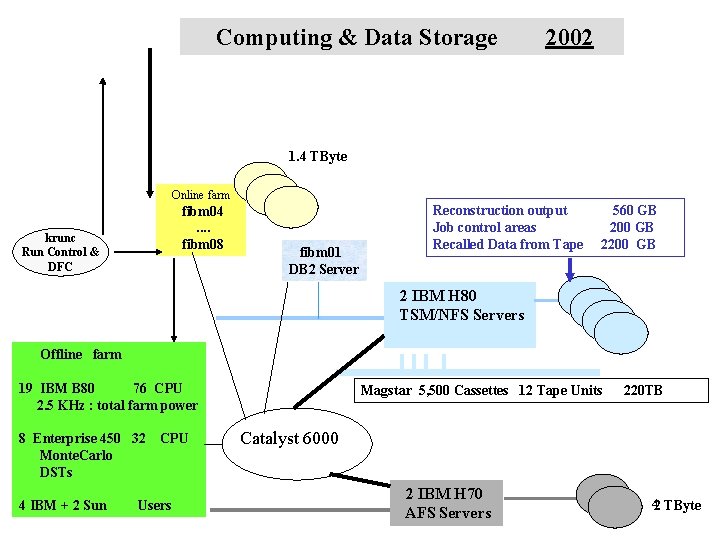

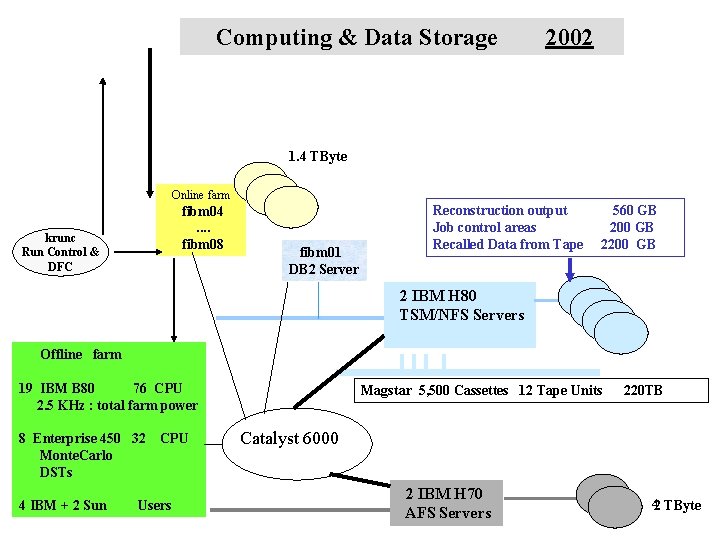

Computing & Data Storage 2002 1. 4 TByte Online farm fibm 04. . fibm 08 krunc Run Control & DFC fibm 01 DB 2 Server Reconstruction output Job control areas Recalled Data from Tape 560 GB 200 GB 2 IBM H 80 TSM/NFS Servers Offline farm 19 IBM B 80 76 CPU 2. 5 KHz : total farm power 8 Enterprise 450 32 Monte. Carlo DSTs 4 IBM + 2 Sun CPU Users Magstar 5, 500 Cassettes 12 Tape Units 220 TB Catalyst 6000 2 IBM H 70 AFS Servers 42 TByte

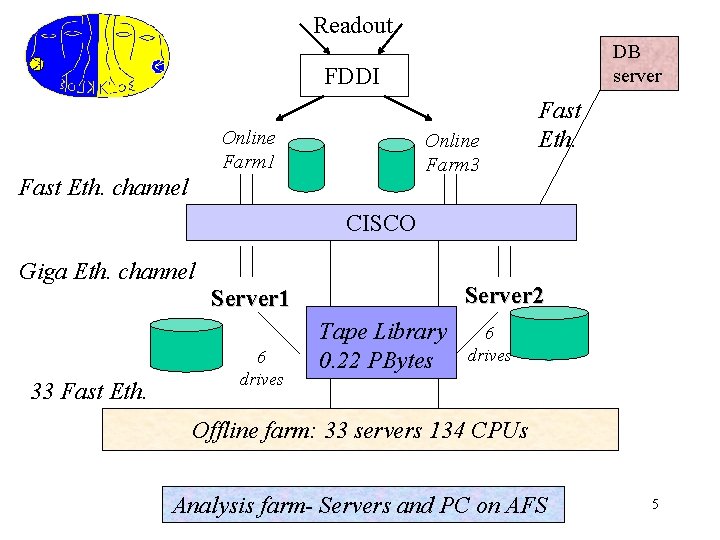

Readout DB server FDDI Online Farm 1 Online Farm 3 Fast Eth. channel Fast Eth. CISCO Giga Eth. channel Server 2 Server 1 33 Fast Eth. 6 drives Tape Library 0. 22 PBytes 6 drives Offline farm: 33 servers 134 CPUs Analysis farm- Servers and PC on AFS 5

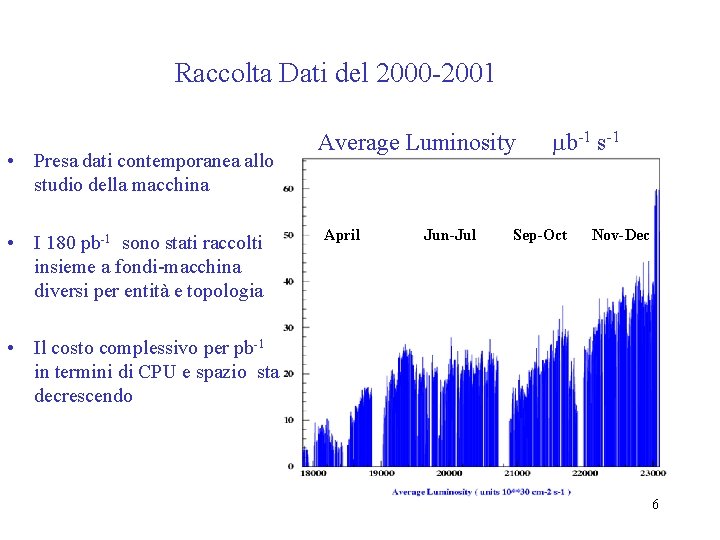

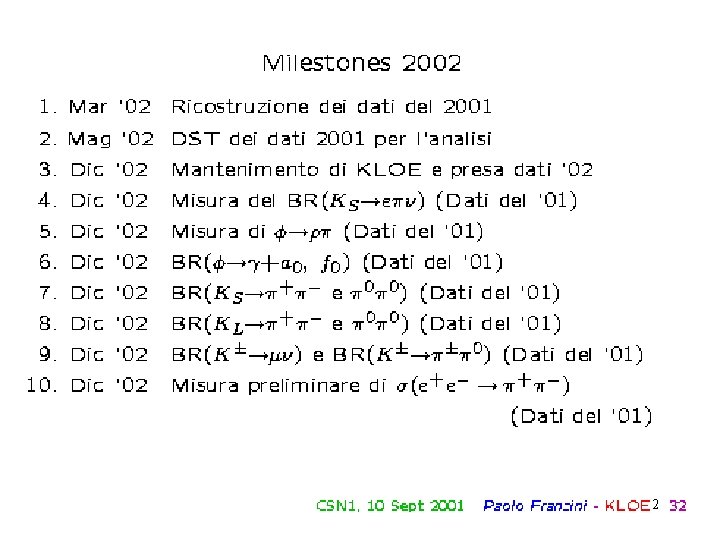

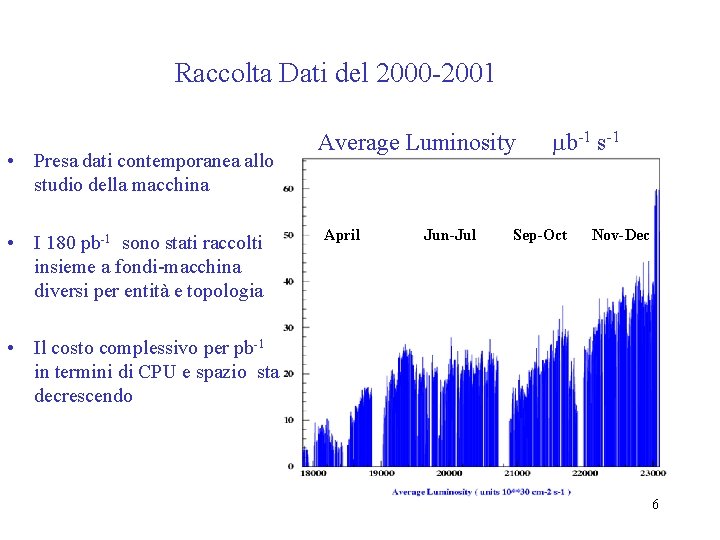

Raccolta Dati del 2000 -2001 • Presa dati contemporanea allo studio della macchina • I 180 pb-1 sono stati raccolti insieme a fondi-macchina diversi per entità e topologia Average Luminosity April Jun-Jul mb-1 s-1 Sep-Oct Nov-Dec • Il costo complessivo per pb-1 in termini di CPU e spazio sta decrescendo 6

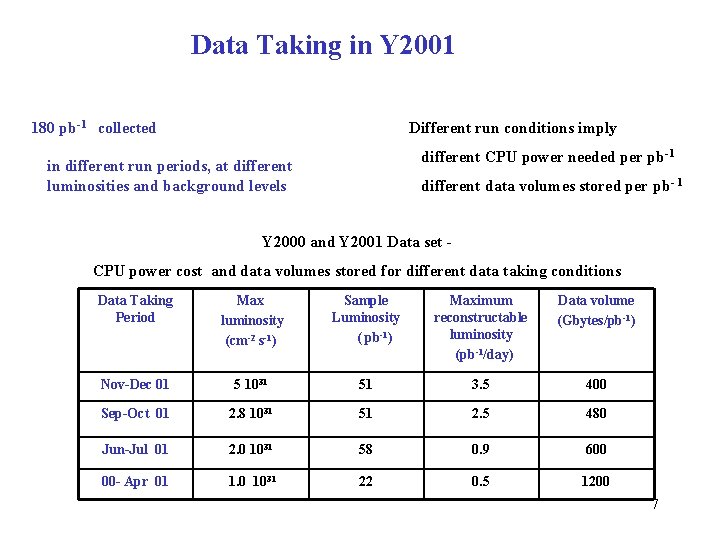

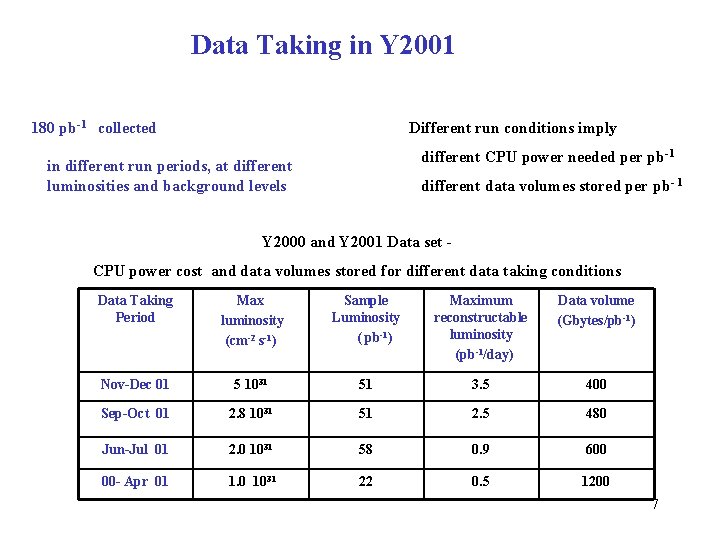

Data Taking in Y 2001 180 pb-1 collected Different run conditions imply different CPU power needed per pb-1 in different run periods, at different luminosities and background levels different data volumes stored per pb- 1 Y 2000 and Y 2001 Data set CPU power cost and data volumes stored for different data taking conditions Data Taking Period Max luminosity (cm-2 s-1) Sample Luminosity ( pb-1) Maximum reconstructable luminosity (pb-1/day) Data volume (Gbytes/pb-1) Nov-Dec 01 5 1031 51 3. 5 400 Sep-Oct 01 2. 8 1031 51 2. 5 480 Jun-Jul 01 2. 0 1031 58 0. 9 600 00 - Apr 01 1. 0 1031 22 0. 5 1200 7

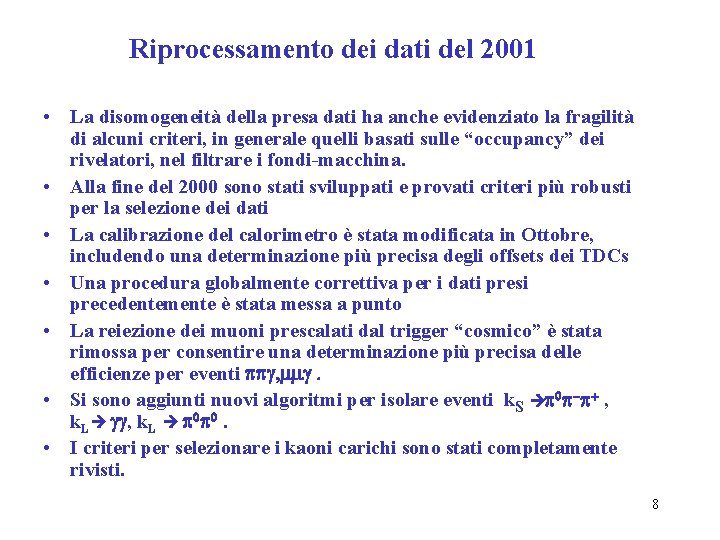

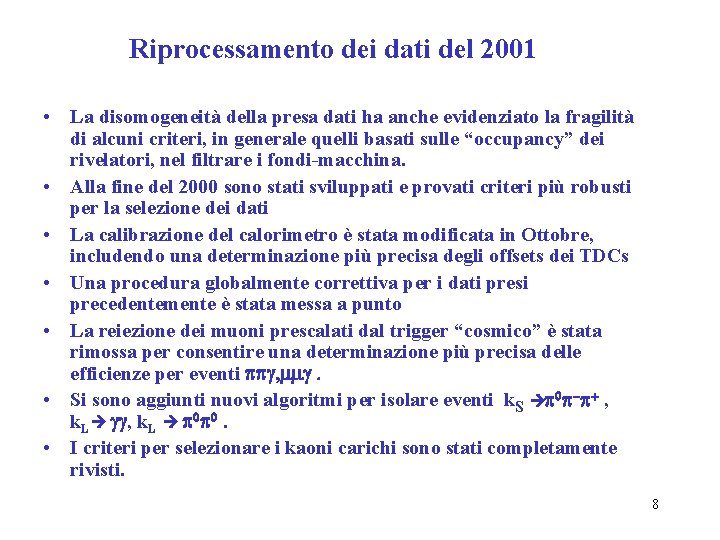

Riprocessamento dei dati del 2001 • La disomogeneità della presa dati ha anche evidenziato la fragilità di alcuni criteri, in generale quelli basati sulle “occupancy” dei rivelatori, nel filtrare i fondi-macchina. • Alla fine del 2000 sono stati sviluppati e provati criteri più robusti per la selezione dei dati • La calibrazione del calorimetro è stata modificata in Ottobre, includendo una determinazione più precisa degli offsets dei TDCs • Una procedura globalmente correttiva per i dati presi precedentemente è stata messa a punto • La reiezione dei muoni prescalati dal trigger “cosmico” è stata rimossa per consentire una determinazione più precisa delle efficienze per eventi ppg, mmg. • Si sono aggiunti nuovi algoritmi per isolare eventi k. S p 0 p-p+ , k. L gg, k. L p 0 p 0. • I criteri per selezionare i kaoni carichi sono stati completamente rivisti. 8

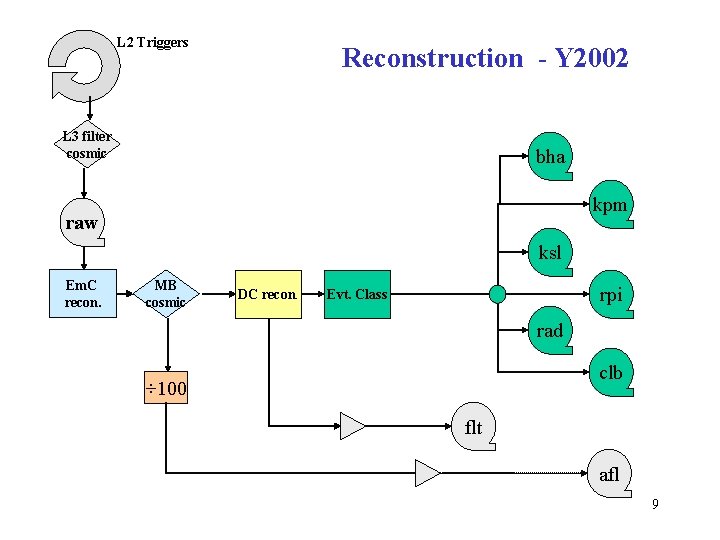

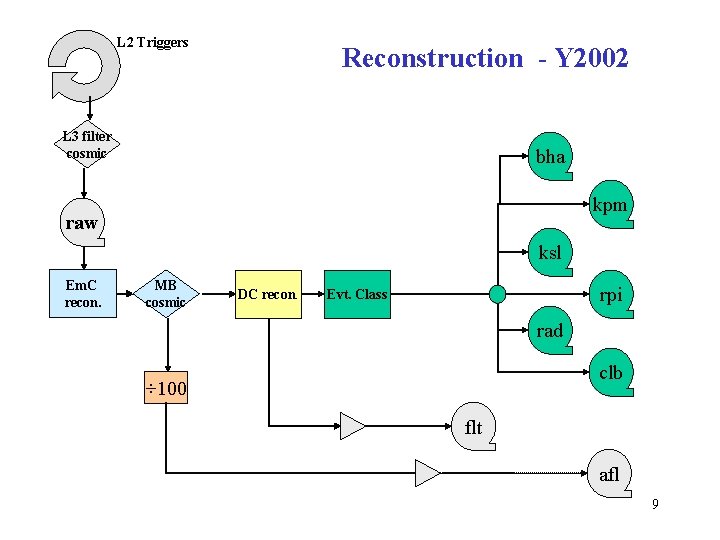

L 2 Triggers Reconstruction - Y 2002 L 3 filter cosmic bha kpm raw ksl Em. C recon. MB cosmic DC recon. rpi Evt. Class rad clb ÷ 100 flt afl 9

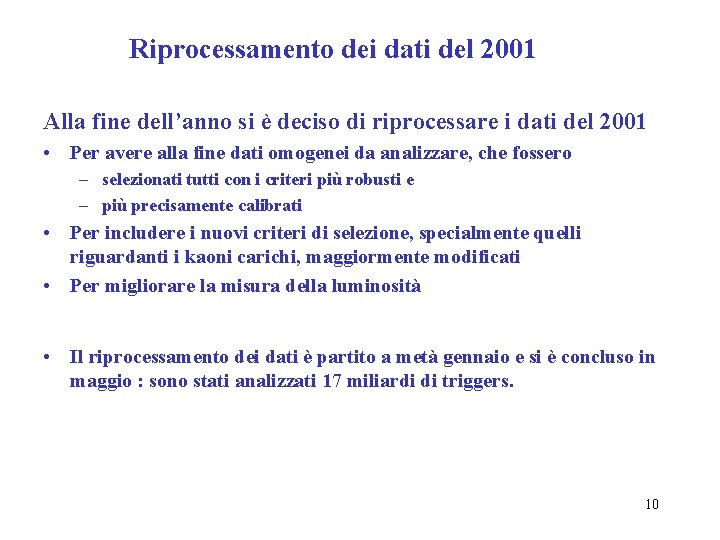

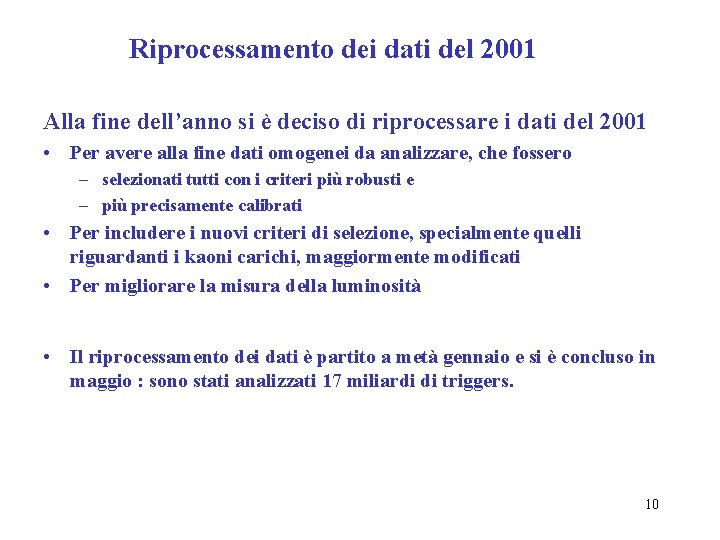

Riprocessamento dei dati del 2001 Alla fine dell’anno si è deciso di riprocessare i dati del 2001 • Per avere alla fine dati omogenei da analizzare, che fossero – selezionati tutti con i criteri più robusti e – più precisamente calibrati • Per includere i nuovi criteri di selezione, specialmente quelli riguardanti i kaoni carichi, maggiormente modificati • Per migliorare la misura della luminosità • Il riprocessamento dei dati è partito a metà gennaio e si è concluso in maggio : sono stati analizzati 17 miliardi di triggers. 10

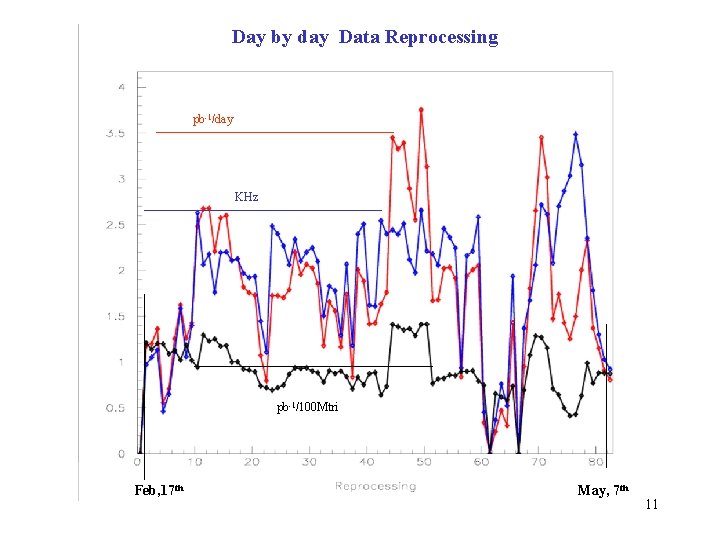

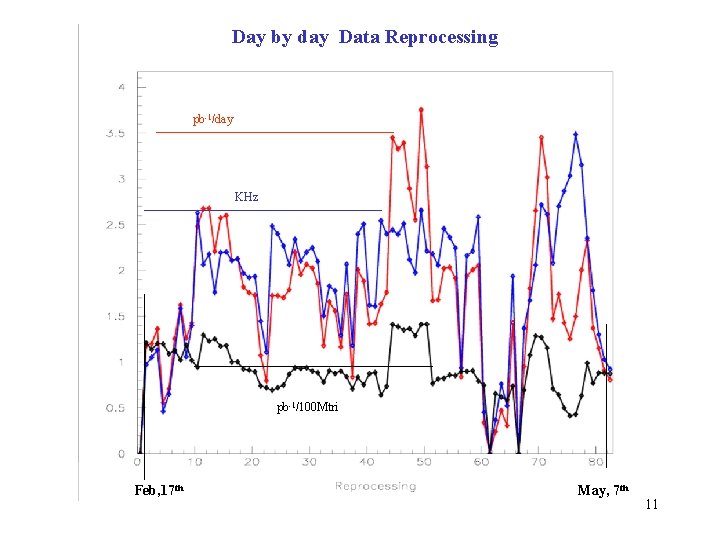

Day by day Data Reprocessing pb-1/day KHz pb-1/100 Mtri Feb, 17 th May, 7 th 11

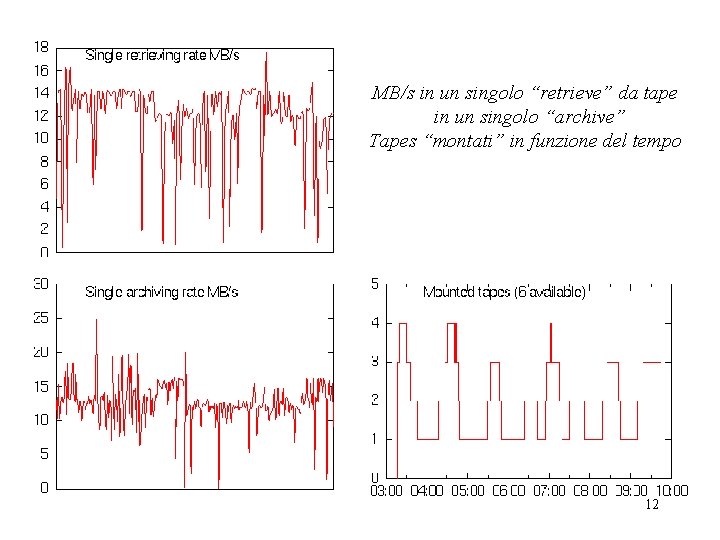

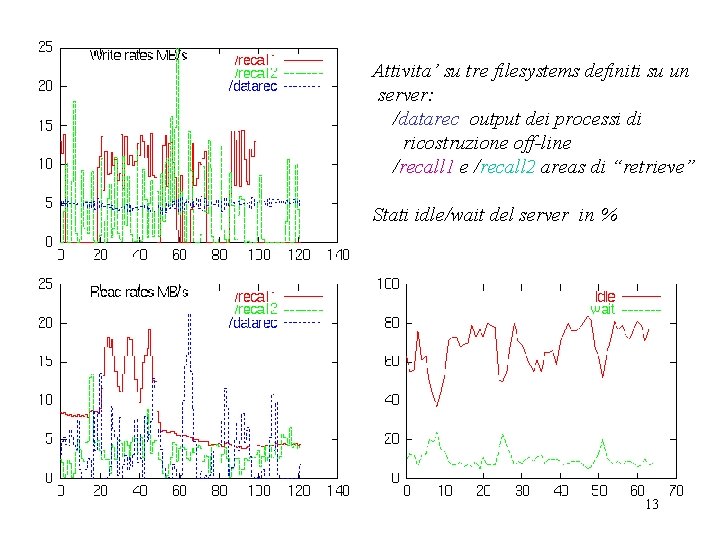

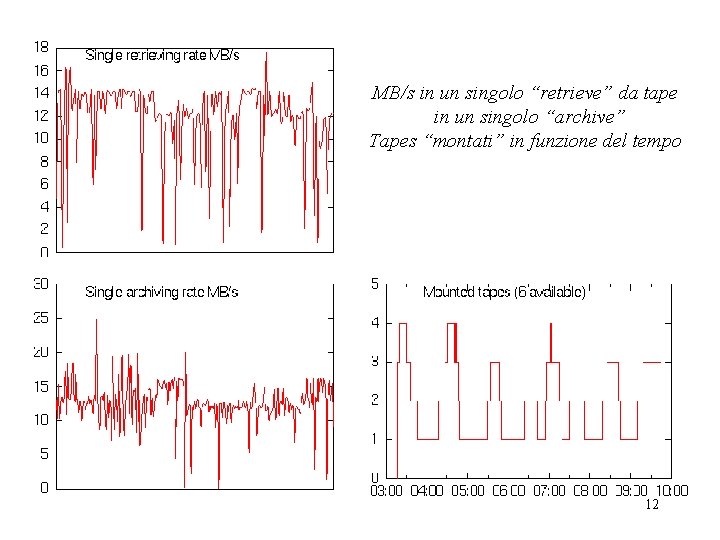

MB/s in un singolo “retrieve” da tape in un singolo “archive” Tapes “montati” in funzione del tempo 12

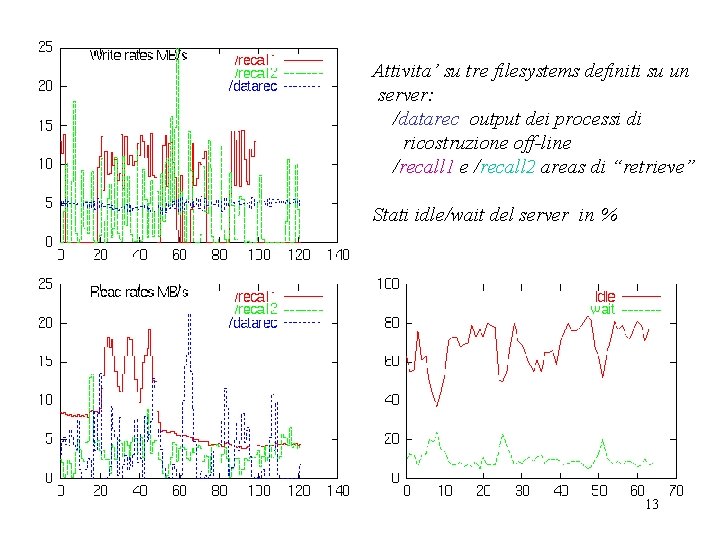

Attivita’ su tre filesystems definiti su un server: /datarec output dei processi di ricostruzione off-line /recall 1 e /recall 2 areas di “retrieve” Stati idle/wait del server in % 13

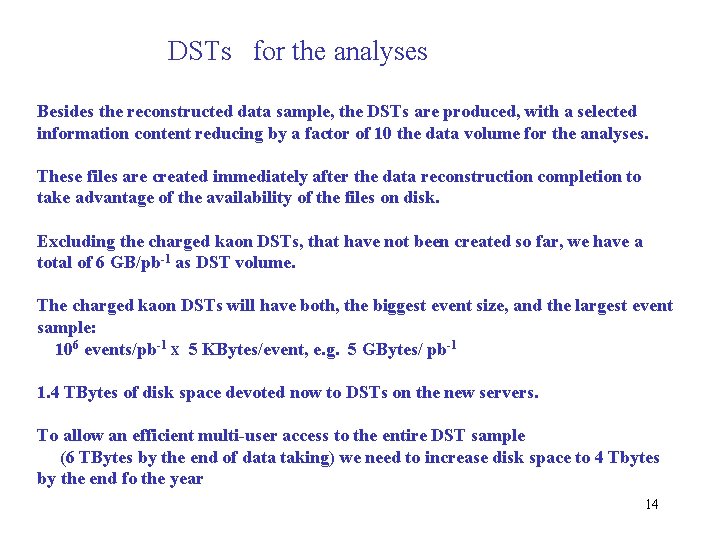

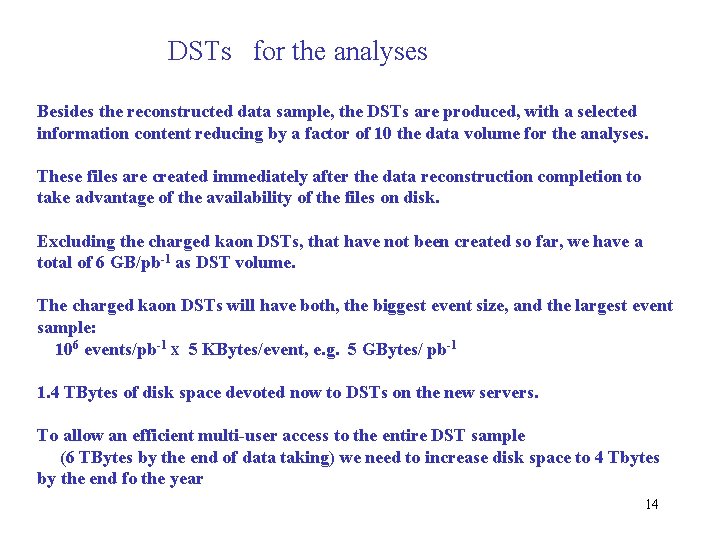

DSTs for the analyses Besides the reconstructed data sample, the DSTs are produced, with a selected information content reducing by a factor of 10 the data volume for the analyses. These files are created immediately after the data reconstruction completion to take advantage of the availability of the files on disk. Excluding the charged kaon DSTs, that have not been created so far, we have a total of 6 GB/pb-1 as DST volume. The charged kaon DSTs will have both, the biggest event size, and the largest event sample: 106 events/pb-1 X 5 KBytes/event, e. g. 5 GBytes/ pb-1 1. 4 TBytes of disk space devoted now to DSTs on the new servers. To allow an efficient multi-user access to the entire DST sample (6 TBytes by the end of data taking) we need to increase disk space to 4 Tbytes by the end fo the year 14

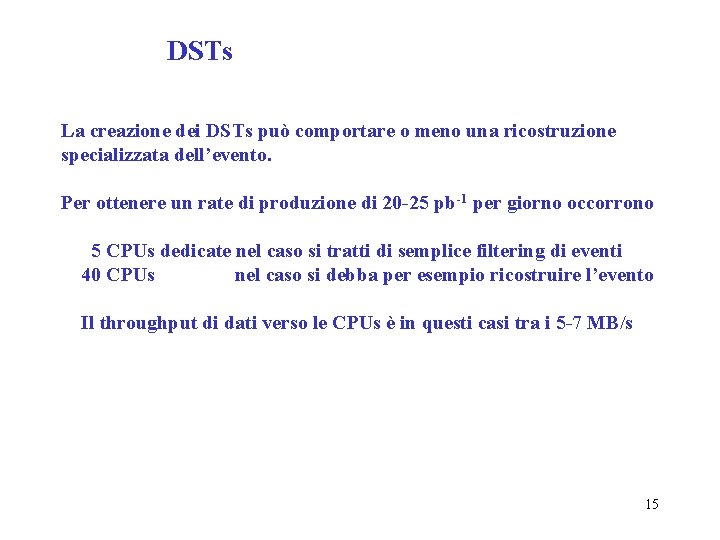

DSTs La creazione dei DSTs può comportare o meno una ricostruzione specializzata dell’evento. Per ottenere un rate di produzione di 20 -25 pb-1 per giorno occorrono 5 CPUs dedicate nel caso si tratti di semplice filtering di eventi 40 CPUs nel caso si debba per esempio ricostruire l’evento Il throughput di dati verso le CPUs è in questi casi tra i 5 -7 MB/s 15

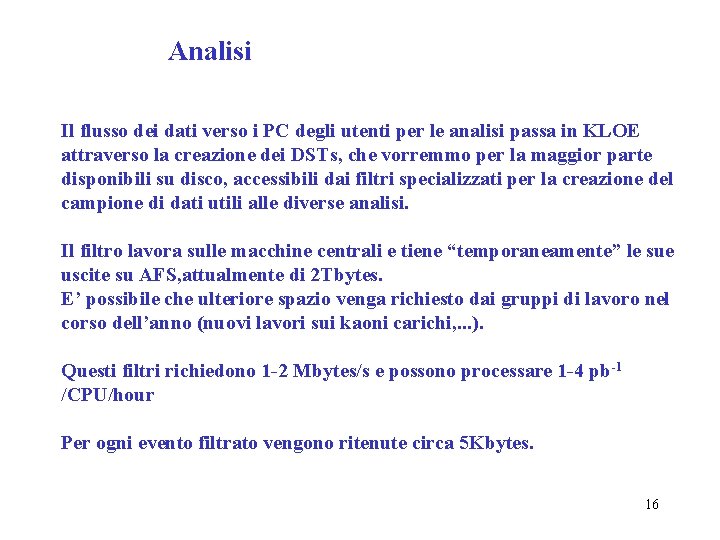

Analisi Il flusso dei dati verso i PC degli utenti per le analisi passa in KLOE attraverso la creazione dei DSTs, che vorremmo per la maggior parte disponibili su disco, accessibili dai filtri specializzati per la creazione del campione di dati utili alle diverse analisi. Il filtro lavora sulle macchine centrali e tiene “temporaneamente” le sue uscite su AFS, attualmente di 2 Tbytes. E’ possibile che ulteriore spazio venga richiesto dai gruppi di lavoro nel corso dell’anno (nuovi lavori sui kaoni carichi, . . . ). Questi filtri richiedono 1 -2 Mbytes/s e possono processare 1 -4 pb-1 /CPU/hour Per ogni evento filtrato vengono ritenute circa 5 Kbytes. 16

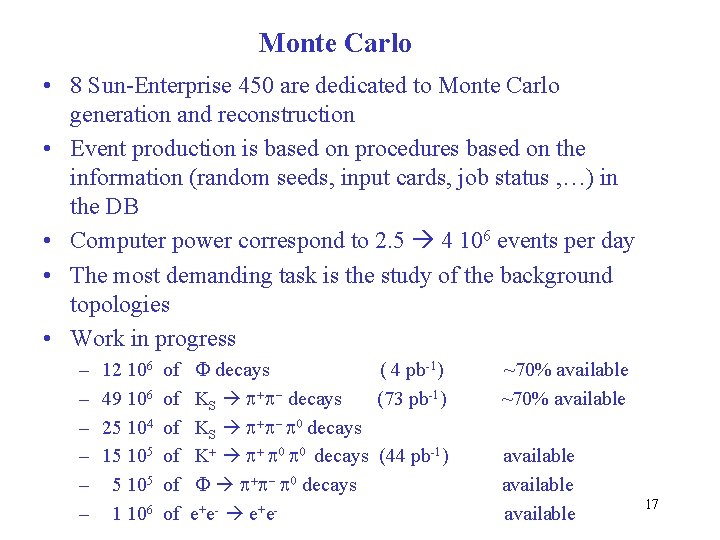

Monte Carlo • 8 Sun-Enterprise 450 are dedicated to Monte Carlo generation and reconstruction • Event production is based on procedures based on the information (random seeds, input cards, job status , …) in the DB • Computer power correspond to 2. 5 4 106 events per day • The most demanding task is the study of the background topologies • Work in progress – – – 12 106 49 106 25 104 15 105 1 106 of of of F decays ( 4 pb-1) KS p+p- decays (73 pb-1) KS p+p- p 0 decays K+ p+ p 0 decays (44 pb-1) F p+p- p 0 decays e+ e- ~70% available available 17

Monte Carlo • Anche per il Monte. Carlo verranno creati dei DSTs • Il campione sarà presumibilmente di qualche centinaio di milione di eventi, con 10 -15 Kbytes/evento • 1. 2 Tbytes/108 eventi è lo spazio richiesto per rendere disponibile alle analisi questi campioni • 2 MB/s verranno richiesti in lettura da ciascun processo • Circa 200, 000 eventi possono esseri processati in un’ora. 18

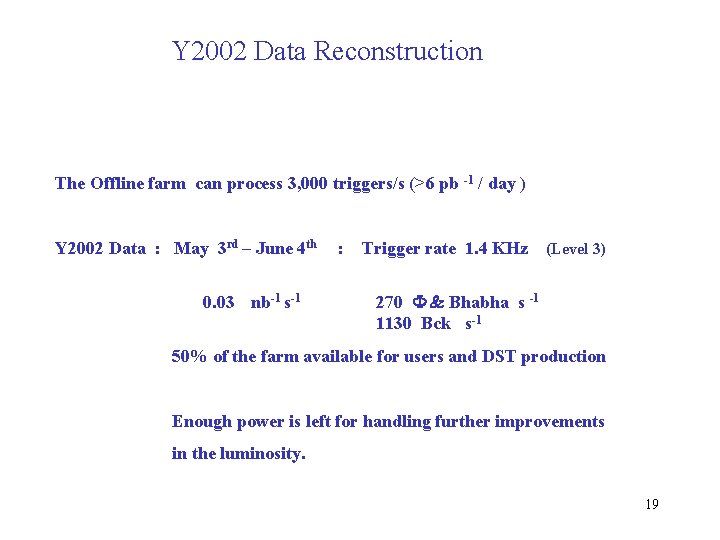

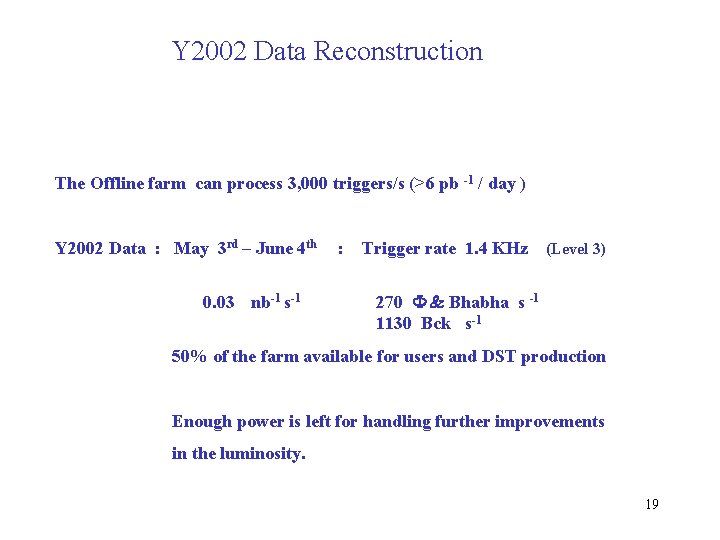

Y 2002 Data Reconstruction The Offline farm can process 3, 000 triggers/s (>6 pb -1 / day ) Y 2002 Data : May 3 rd – June 4 th 0. 03 nb-1 s-1 : Trigger rate 1. 4 KHz (Level 3) 270 F & Bhabha s -1 1130 Bck s-1 50% of the farm available for users and DST production Enough power is left for handling further improvements in the luminosity. 19

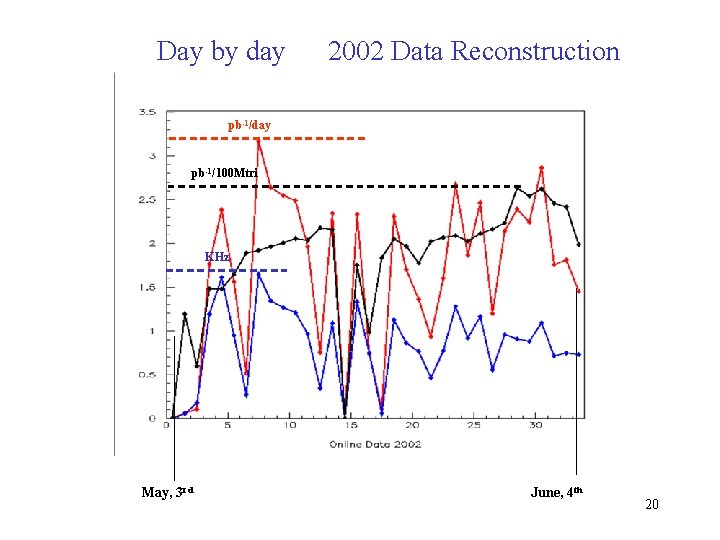

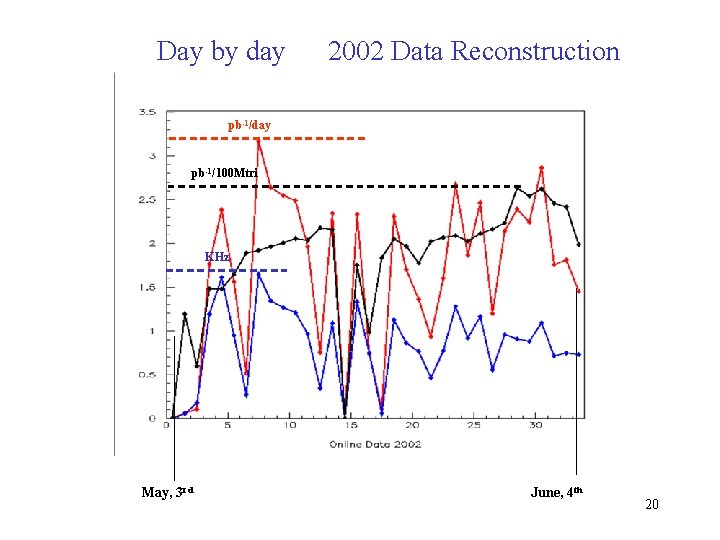

Day by day 2002 Data Reconstruction pb-1/day pb-1/100 Mtri KHz May, 3 rd June, 4 th 20

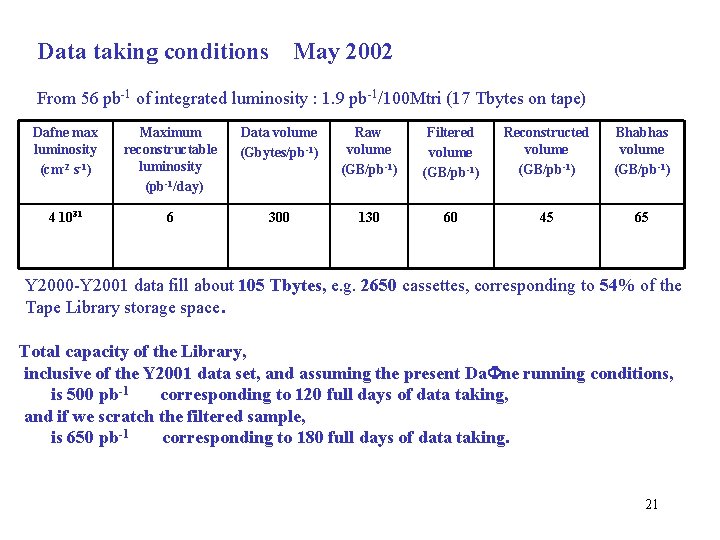

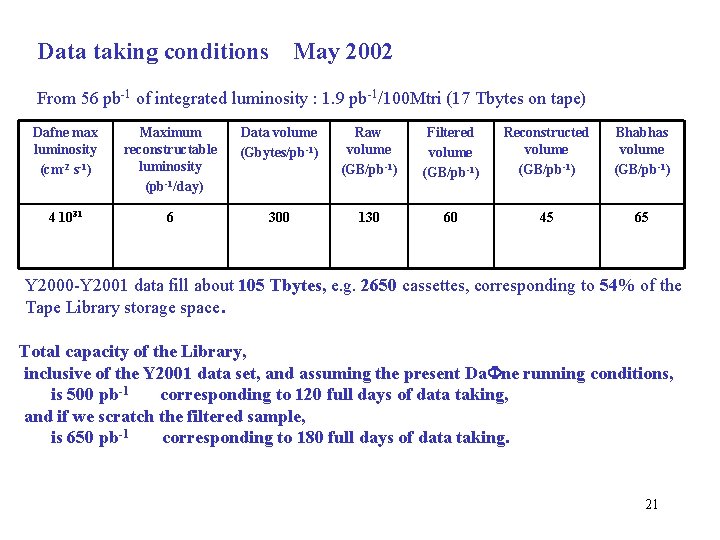

Data taking conditions May 2002 From 56 pb-1 of integrated luminosity : 1. 9 pb-1/100 Mtri (17 Tbytes on tape) Dafne max luminosity (cm-2 s-1) Maximum reconstructable luminosity (pb-1/day) Data volume (Gbytes/pb-1) Raw volume (GB/pb-1) Filtered volume (GB/pb-1) Reconstructed volume (GB/pb-1) Bhabhas volume (GB/pb-1) 4 1031 6 300 130 60 45 65 Y 2000 -Y 2001 data fill about 105 Tbytes, e. g. 2650 cassettes, corresponding to 54% of the Tape Library storage space. Total capacity of the Library, inclusive of the Y 2001 data set, and assuming the present Da. Fne running conditions, is 500 pb-1 corresponding to 120 full days of data taking, and if we scratch the filtered sample, is 650 pb-1 corresponding to 180 full days of data taking. 21

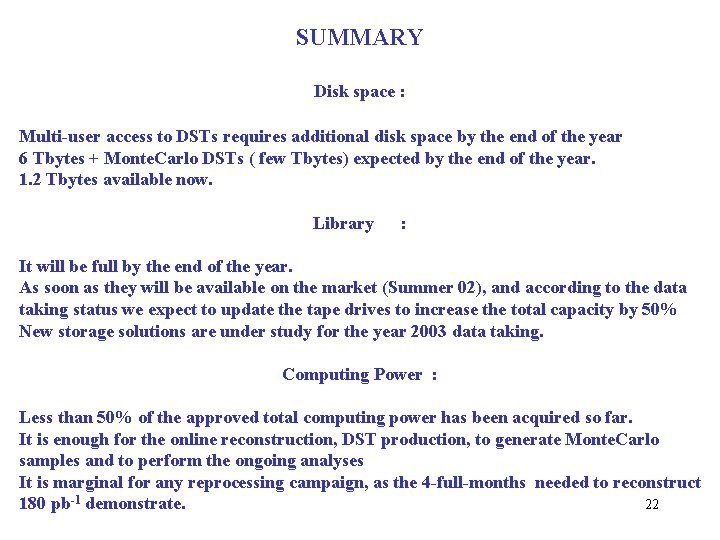

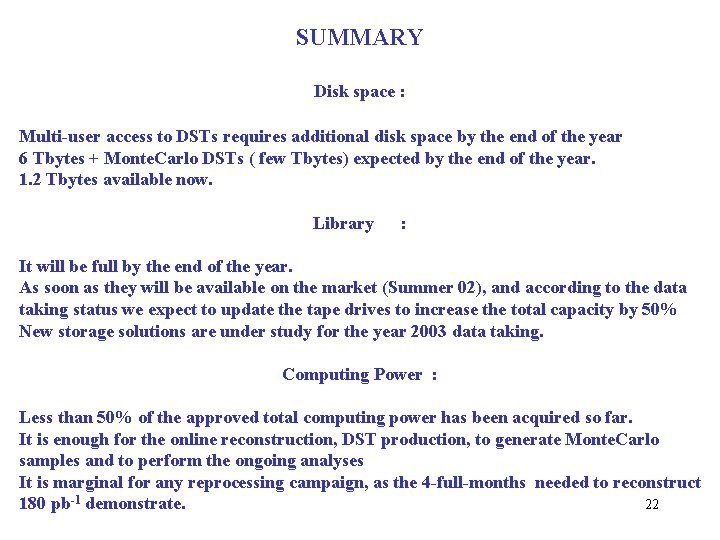

SUMMARY Disk space : Multi-user access to DSTs requires additional disk space by the end of the year 6 Tbytes + Monte. Carlo DSTs ( few Tbytes) expected by the end of the year. 1. 2 Tbytes available now. Library : It will be full by the end of the year. As soon as they will be available on the market (Summer 02), and according to the data taking status we expect to update the tape drives to increase the total capacity by 50% New storage solutions are under study for the year 2003 data taking. Computing Power : Less than 50% of the approved total computing power has been acquired so far. It is enough for the online reconstruction, DST production, to generate Monte. Carlo samples and to perform the ongoing analyses It is marginal for any reprocessing campaign, as the 4 -full-months needed to reconstruct 22 180 pb-1 demonstrate.