Redes Neurais Uso de Redes Neurais MLP para

- Slides: 17

Redes Neurais Uso de Redes Neurais MLP para resolver problemas de reconhecimento de padrões Alexandre de Oliveira Stauffer

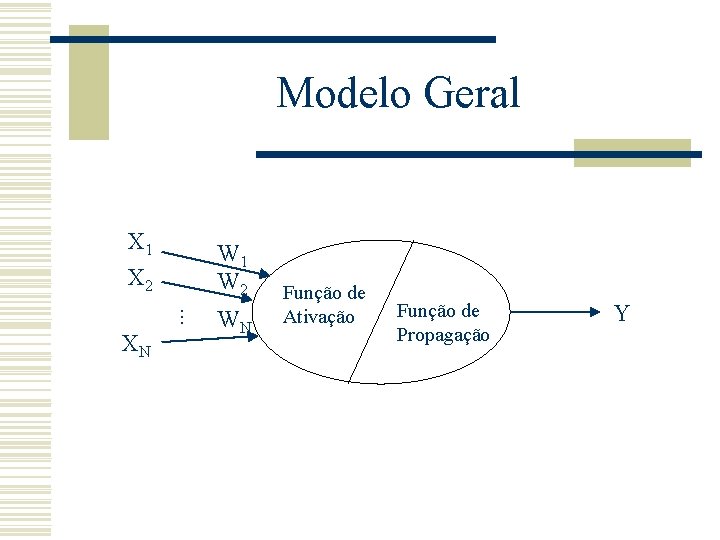

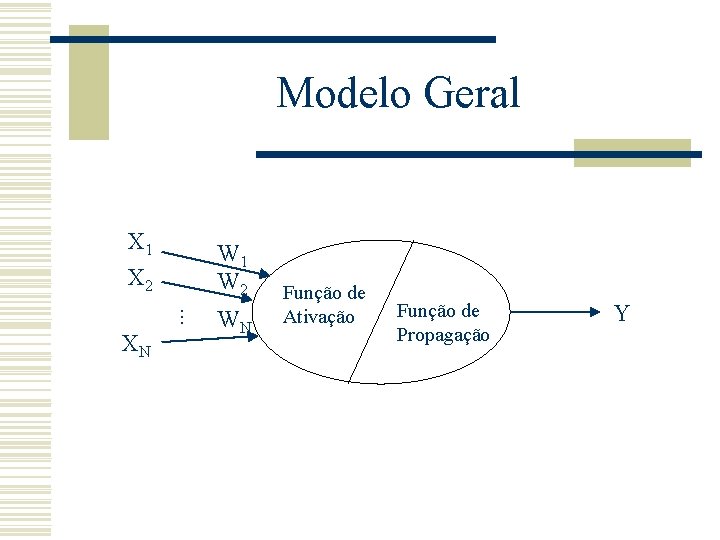

Modelo Geral X 1 X 2 W 1 W 2. . . XN WN Função de Ativação Função de Propagação Y

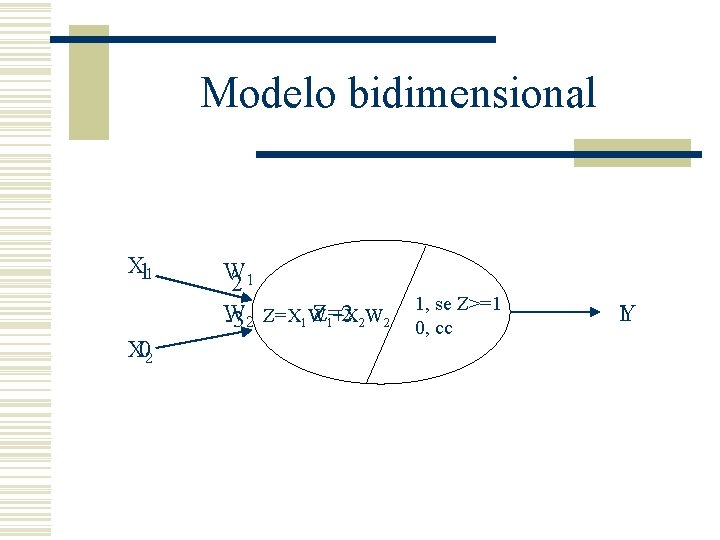

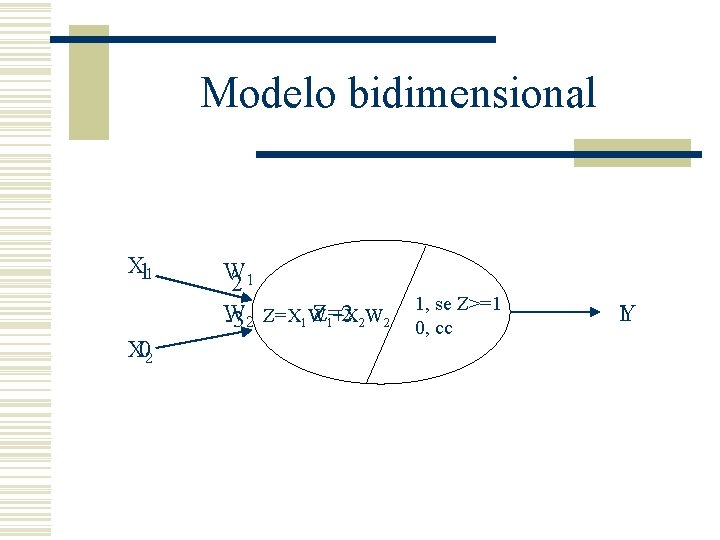

Modelo bidimensional X 11 X 02 W 21 W Z=2 1+X 2 W 2 -3 2 Z=X 1 W 1, se Z>=1 0, cc 1 Y

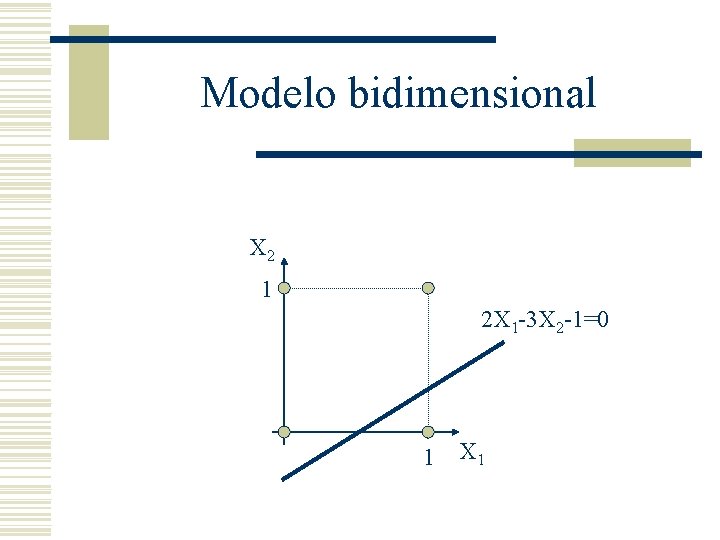

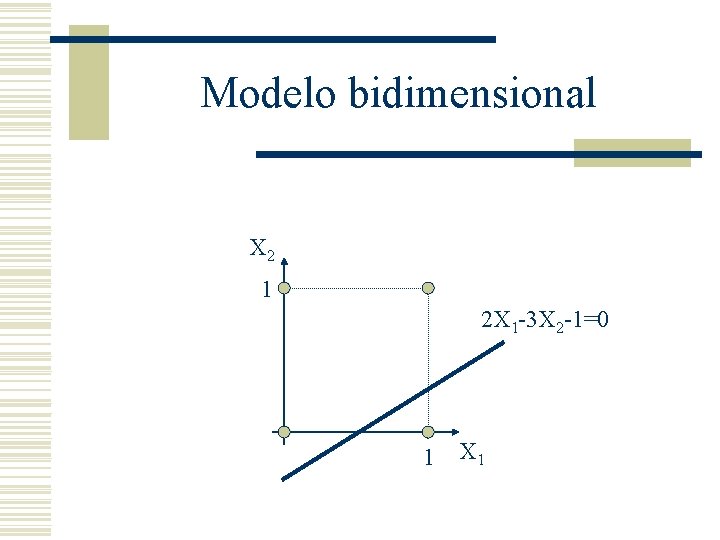

Modelo bidimensional X 2 1 2 X 1 -3 X 2 -1=0 1 X 1

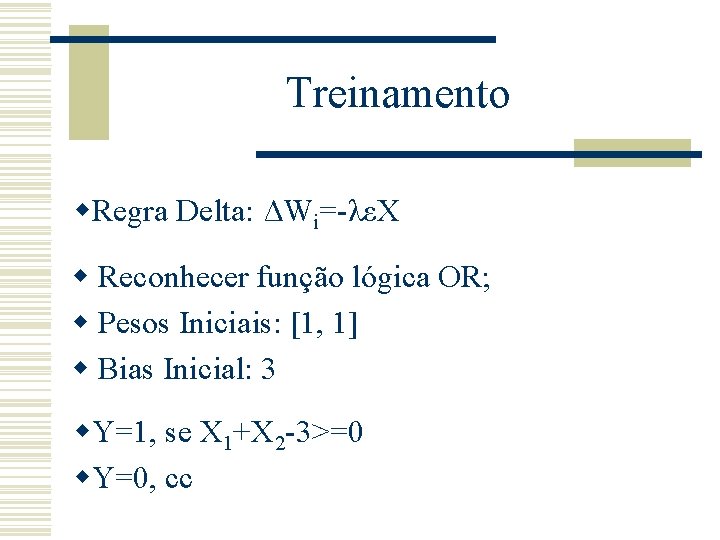

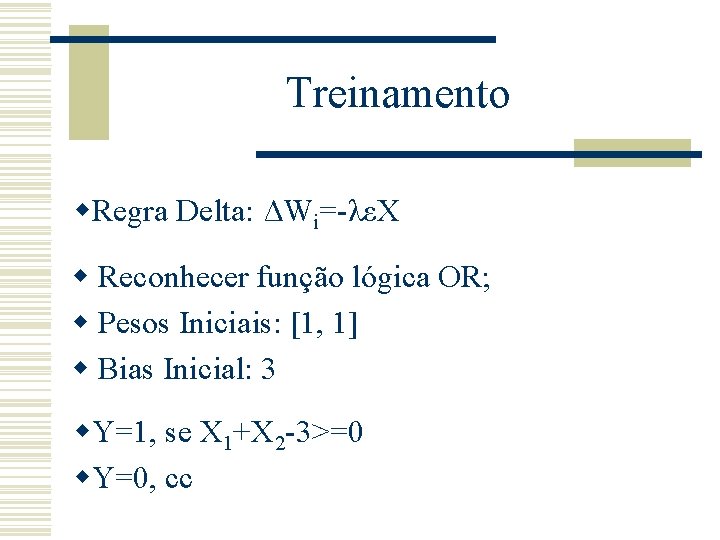

Treinamento w. Regra Delta: ΔWi=-λεX w Reconhecer função lógica OR; w Pesos Iniciais: [1, 1] w Bias Inicial: 3 w. Y=1, se X 1+X 2 -3>=0 w. Y=0, cc

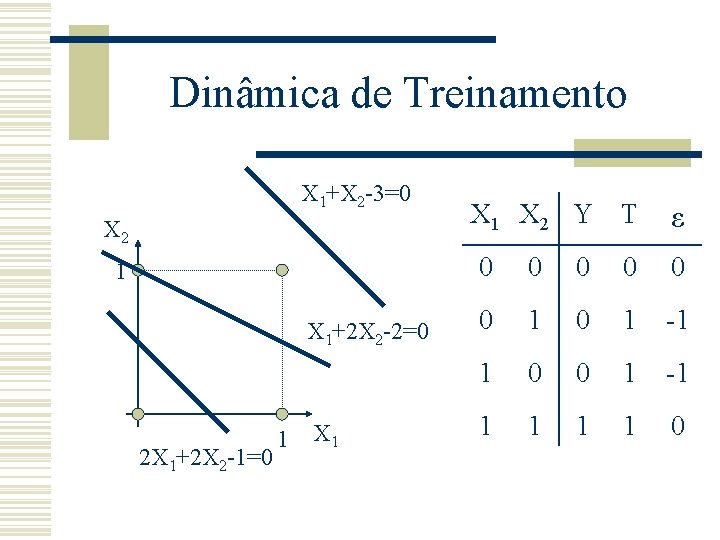

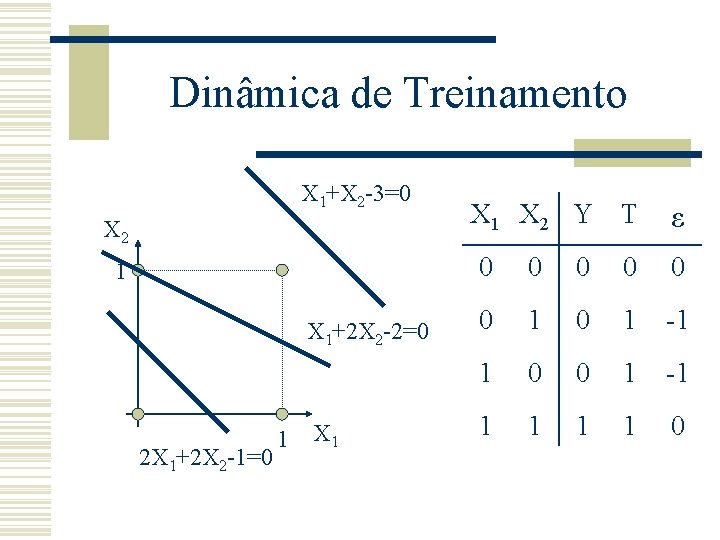

Dinâmica de Treinamento X 1+X 2 -3=0 X 2 1 X 1+2 X 2 -2=0 2 X 1+2 X 2 -1=0 1 X 1 X 2 Y T ε 0 0 0 1 0 1 -1 1 0 0 1 -1 1 1 0

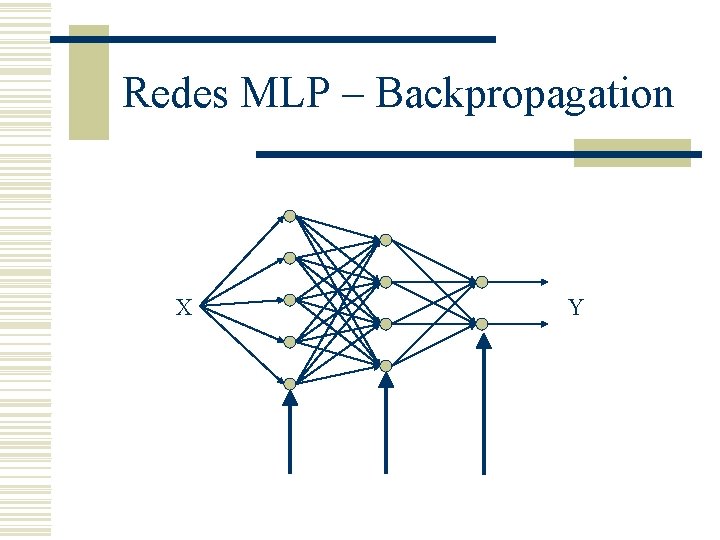

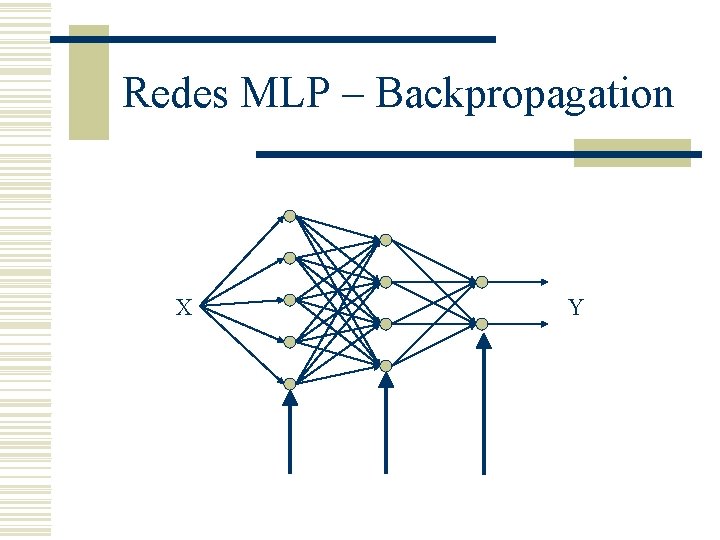

Redes MLP – Backpropagation X Y

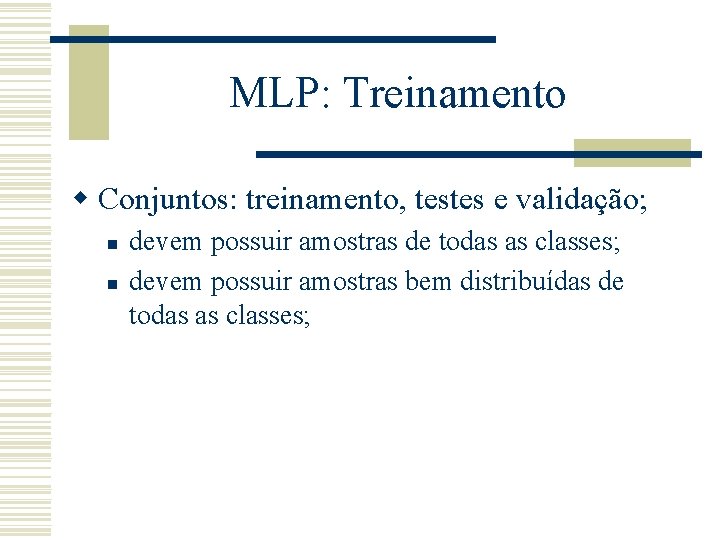

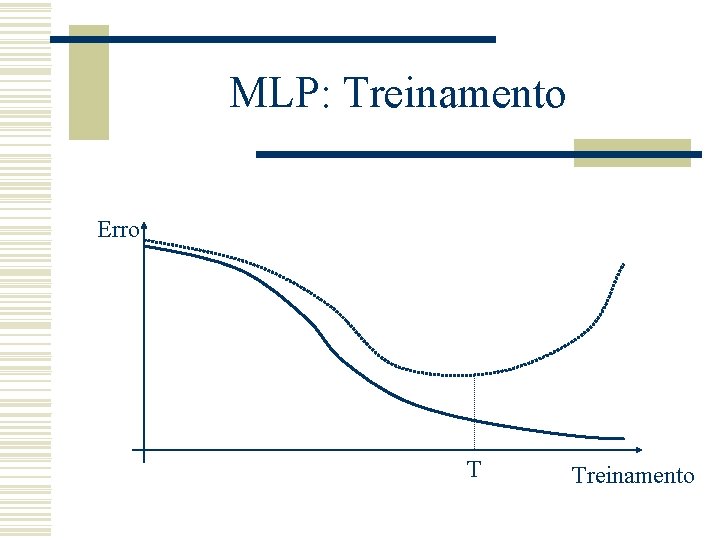

MLP: Treinamento w Conjuntos: treinamento, testes e validação; n n devem possuir amostras de todas as classes; devem possuir amostras bem distribuídas de todas as classes;

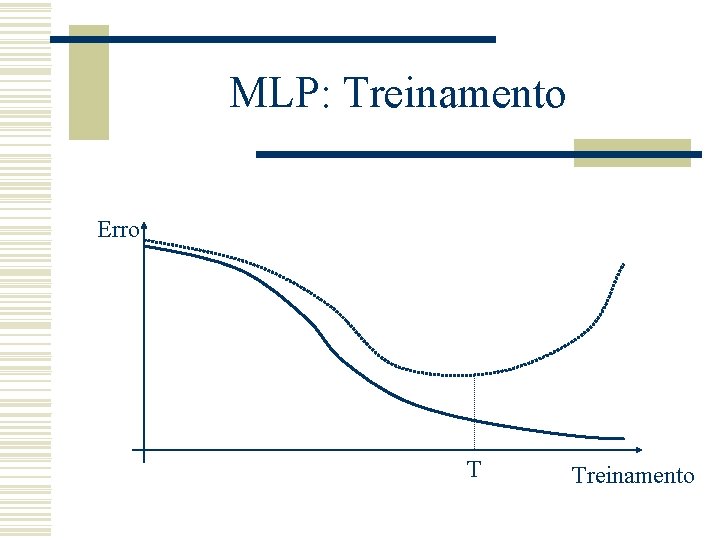

MLP: Treinamento Erro T Treinamento

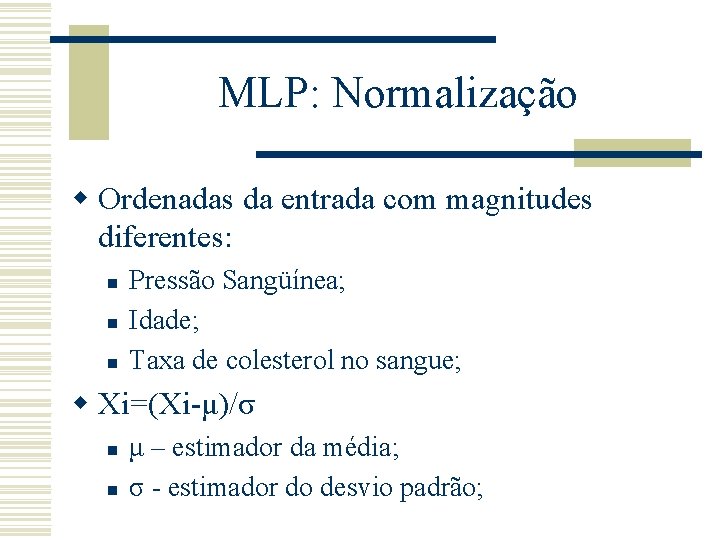

MLP: Normalização w Ordenadas da entrada com magnitudes diferentes: n n n Pressão Sangüínea; Idade; Taxa de colesterol no sangue; w Xi=(Xi-μ)/σ n n μ – estimador da média; σ - estimador do desvio padrão;

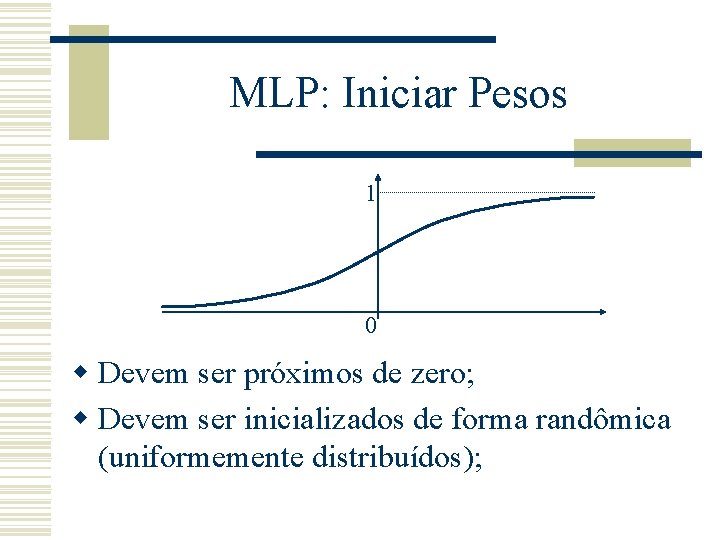

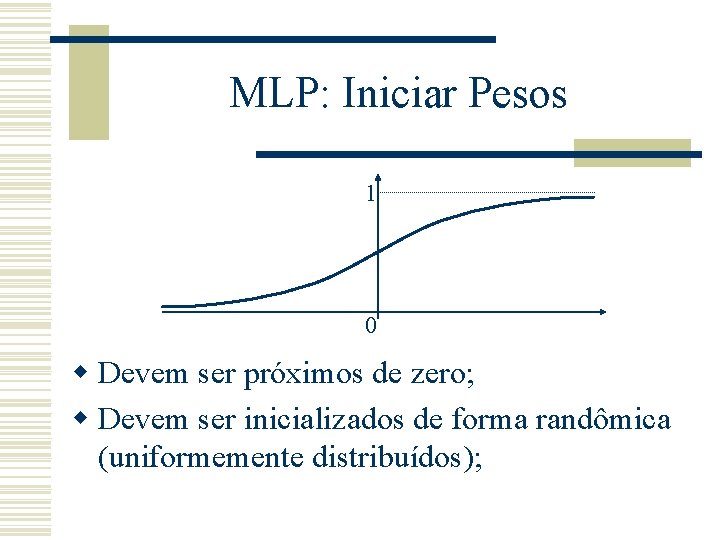

MLP: Iniciar Pesos 1 0 w Devem ser próximos de zero; w Devem ser inicializados de forma randômica (uniformemente distribuídos);

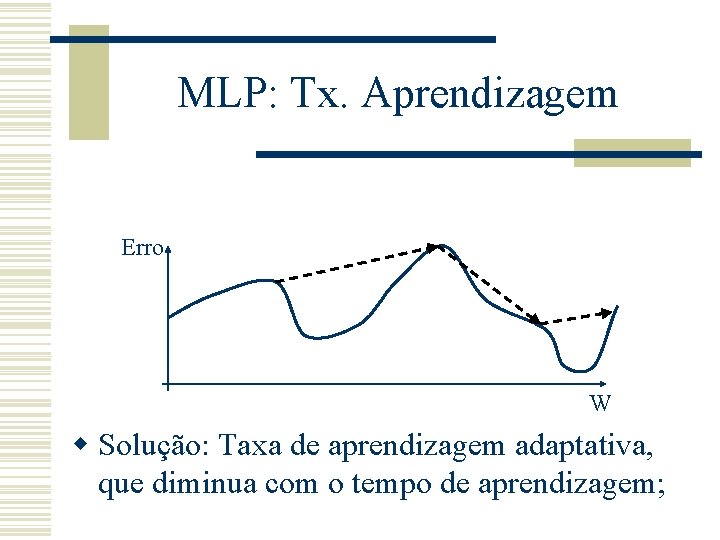

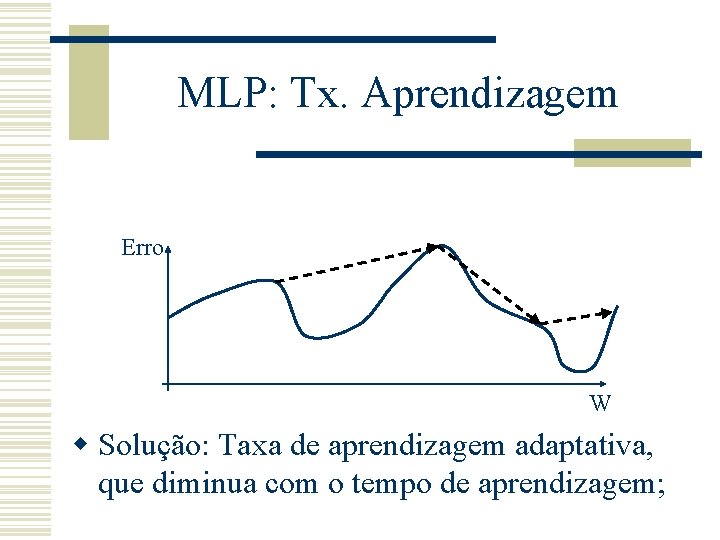

MLP: Tx. Aprendizagem Erro W w Solução: Taxa de aprendizagem adaptativa, que diminua com o tempo de aprendizagem;

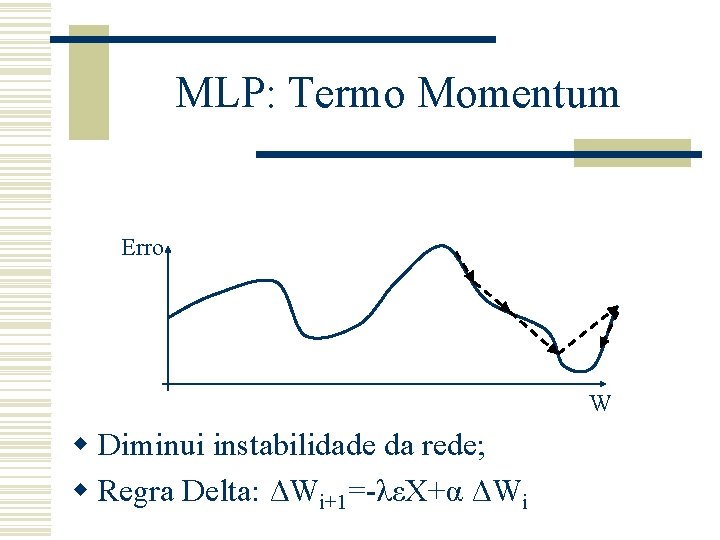

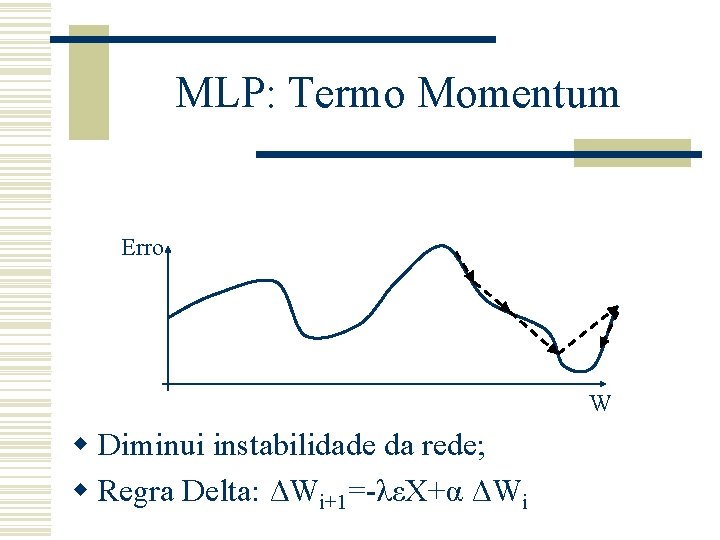

MLP: Termo Momentum Erro W w Diminui instabilidade da rede; w Regra Delta: ΔWi+1=-λεX+α ΔWi

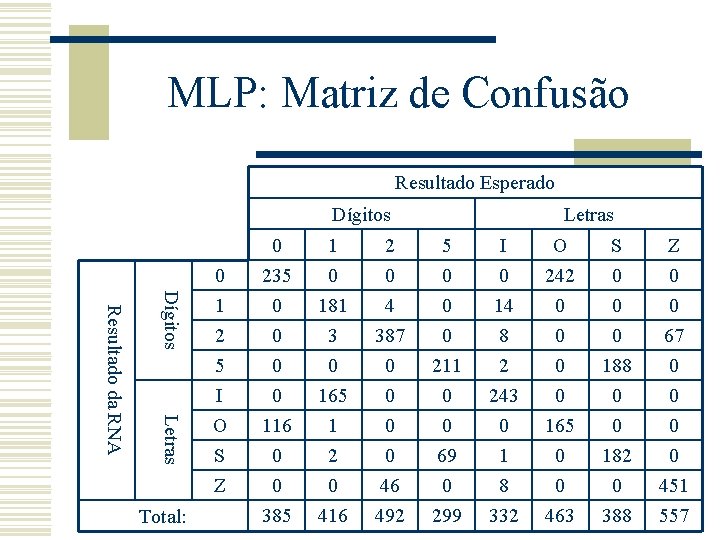

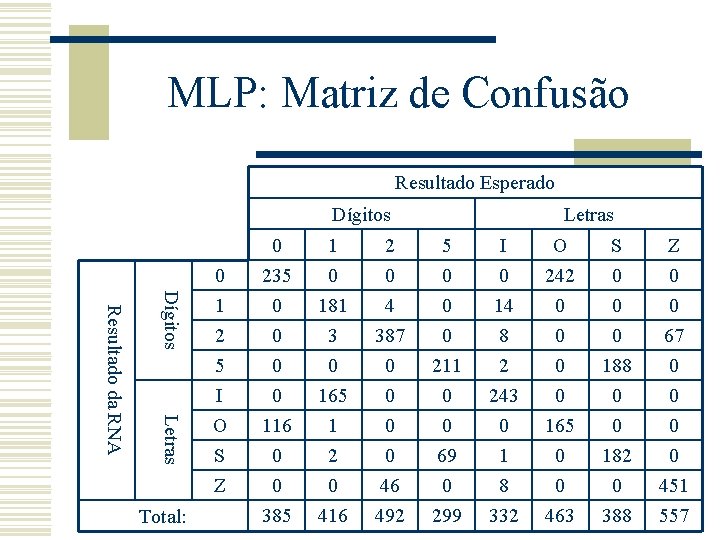

MLP: Matriz de Confusão Resultado Esperado Dígitos Letras Resultado da RNA Total: Letras 0 1 2 5 I O S Z 0 1 235 0 0 181 0 4 0 0 0 14 242 0 0 0 2 5 I O S Z 0 0 0 116 0 0 385 3 0 165 1 2 0 416 387 0 0 46 492 0 211 0 0 69 0 299 8 2 243 0 1 8 332 0 0 0 165 0 0 463 0 188 0 0 182 0 388 67 0 0 451 557

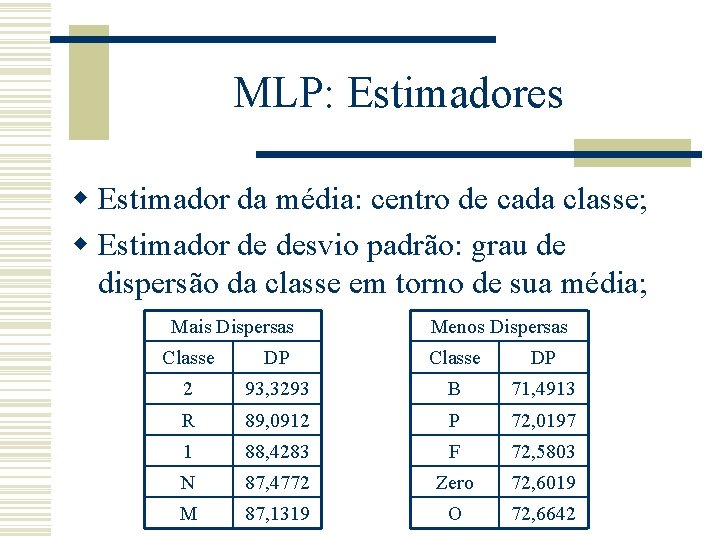

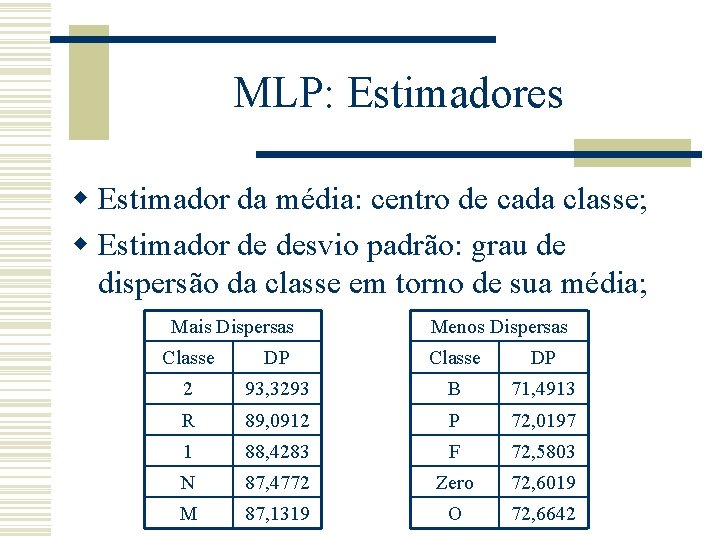

MLP: Estimadores w Estimador da média: centro de cada classe; w Estimador de desvio padrão: grau de dispersão da classe em torno de sua média; Mais Dispersas Menos Dispersas Classe DP 2 93, 3293 B 71, 4913 R 89, 0912 P 72, 0197 1 88, 4283 F 72, 5803 N 87, 4772 Zero 72, 6019 M 87, 1319 O 72, 6642

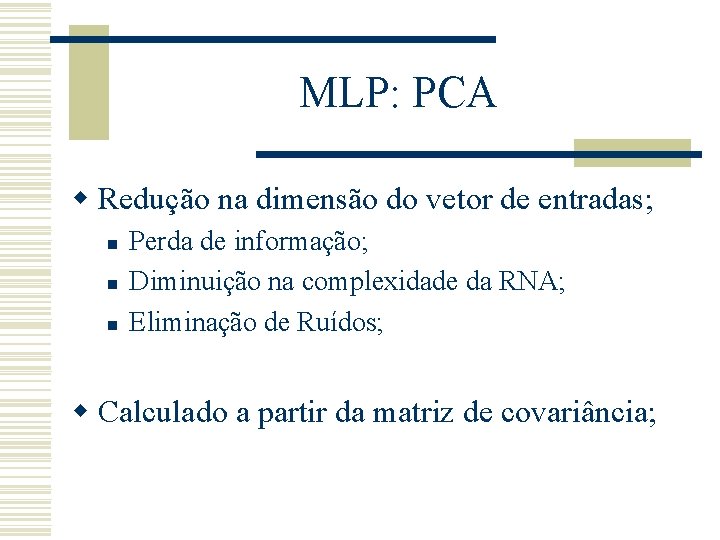

MLP: PCA w Redução na dimensão do vetor de entradas; n n n Perda de informação; Diminuição na complexidade da RNA; Eliminação de Ruídos; w Calculado a partir da matriz de covariância;

Referências w C. M. Bishop, Neural Network for Pattern Recognition, Oxford University, 1995. w A. P. Braga, A. P. L. F. Carvalho, T. B. Ludemir, Fundamentos de Redes Neurais Artificiais, XI Escola de Computação, 1998. w http: //ltc. nutes. ufrj. br/stauffer/rna w stauffer@centroin. com. br

Redes neurais

Redes neurais Redes neurais cin ufpe

Redes neurais cin ufpe Imagens de sinapses neurais

Imagens de sinapses neurais Redes

Redes Objetivos del uso de las redes sociales

Objetivos del uso de las redes sociales Obra de teatro sobre el mal uso de las redes sociales

Obra de teatro sobre el mal uso de las redes sociales Uso de imagens de pacientes em redes sociais

Uso de imagens de pacientes em redes sociais Taller de uso responsable de las redes sociales

Taller de uso responsable de las redes sociales Lazo fonologico

Lazo fonologico Accuracy

Accuracy Mlp topology workbench

Mlp topology workbench Mlp

Mlp Weka mlp

Weka mlp Doctor who mlp

Doctor who mlp Mlp

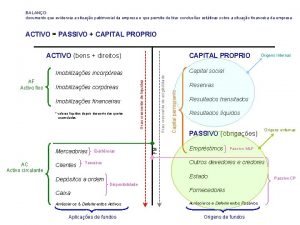

Mlp Passivo mlp

Passivo mlp Proyecto inco ubicacion

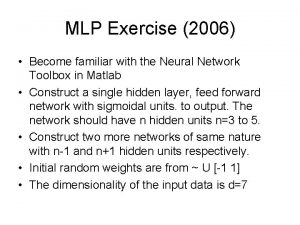

Proyecto inco ubicacion Mlp exercise

Mlp exercise