CLASSIFICATION DES SONS COMMENT CA MARCHE Slim ESSID

![Amplitude Spectral Flatness (ASF) [MPEG 7] Partitionnement du spectre d’amplitude ( ) en 23 Amplitude Spectral Flatness (ASF) [MPEG 7] Partitionnement du spectre d’amplitude ( ) en 23](https://slidetodoc.com/presentation_image_h2/628ee034348756f51cd7c5e644d32642/image-4.jpg)

- Slides: 16

CLASSIFICATION DES SONS, “COMMENT CA MARCHE ? ” Slim ESSID Journée GSAM/SFA – Juin 2005 E-mail : slim. essid@enst. fr Page web : http: //www. tsi. enst. fr/~essid

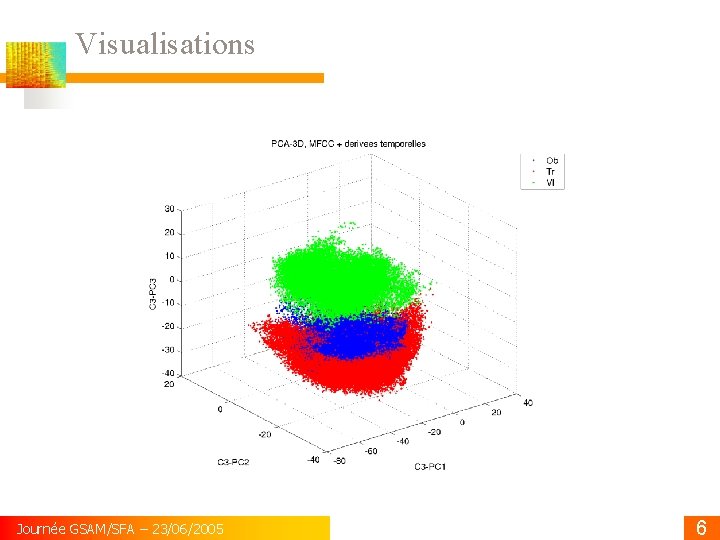

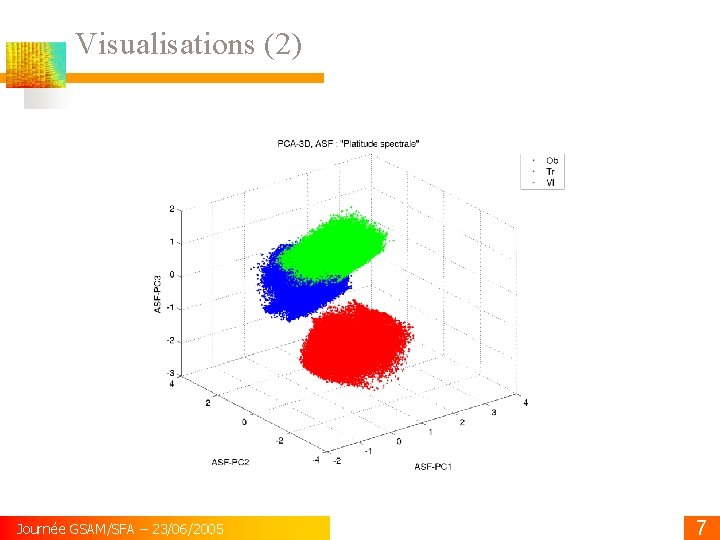

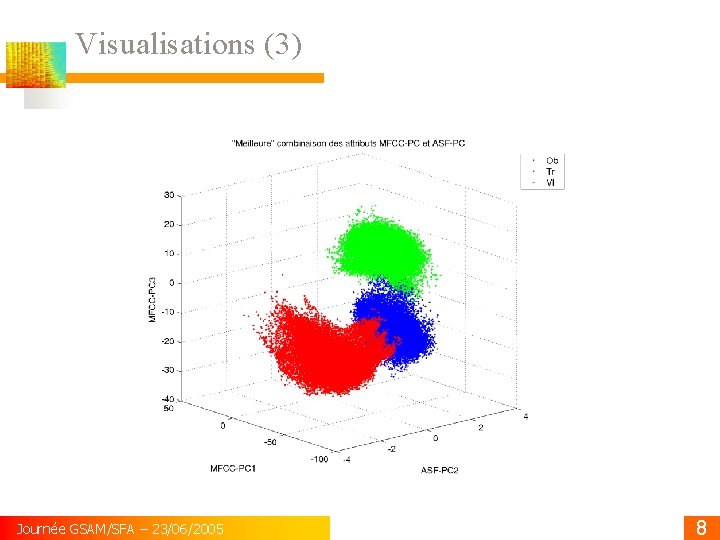

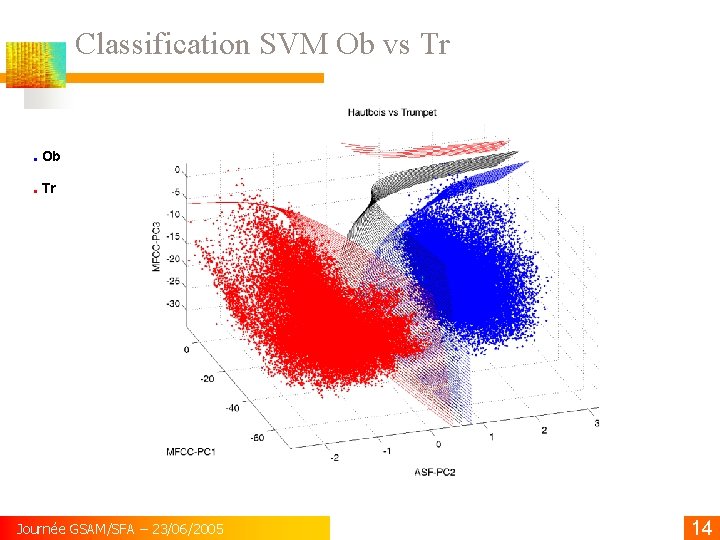

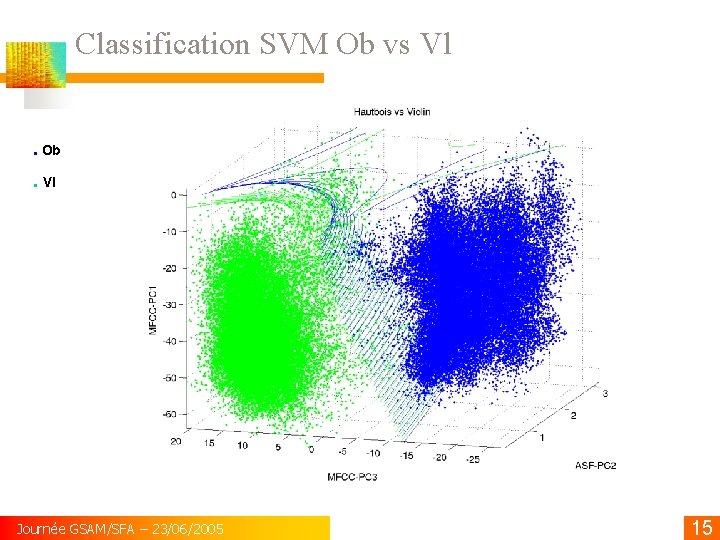

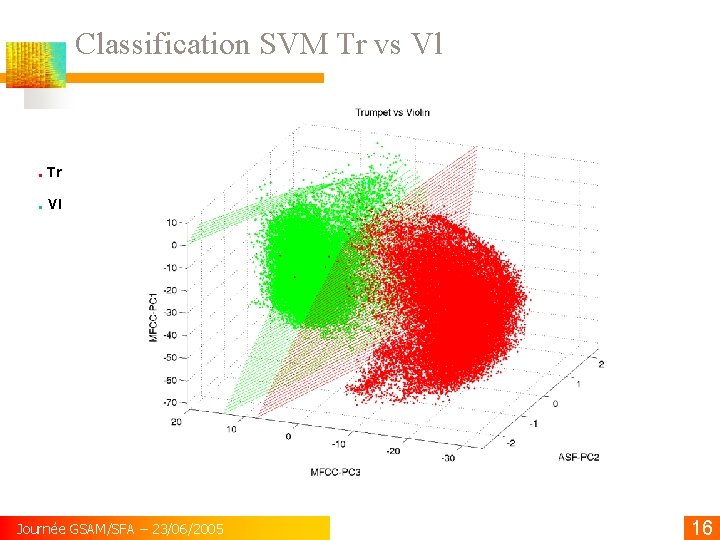

Contenu Visualisation 3 D descripteurs MFCC & ASF pour hautbois, trompette et violon. Calcul descripteurs Utilisation de la PCA (Analyse en Composantes Principales) Visualisations Classification par SVM (Machines à Vecteurs Supports) Principe des SVM Visualisations 3 D des surfaces de décision dans classification hautbois/trompette. Journée GSAM/SFA – 23/06/2005 2

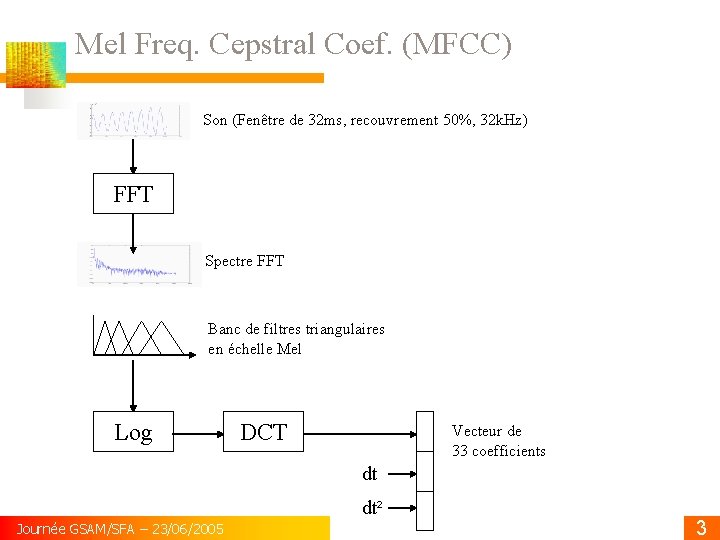

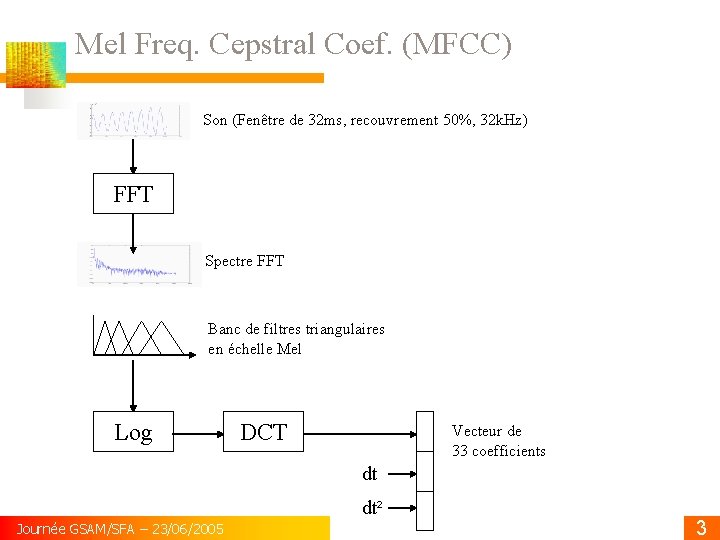

Mel Freq. Cepstral Coef. (MFCC) Son (Fenêtre de 32 ms, recouvrement 50%, 32 k. Hz) FFT Spectre FFT Banc de filtres triangulaires en échelle Mel Log DCT Vecteur de 33 coefficients dt dt² Journée GSAM/SFA – 23/06/2005 3

![Amplitude Spectral Flatness ASF MPEG 7 Partitionnement du spectre damplitude en 23 Amplitude Spectral Flatness (ASF) [MPEG 7] Partitionnement du spectre d’amplitude ( ) en 23](https://slidetodoc.com/presentation_image_h2/628ee034348756f51cd7c5e644d32642/image-4.jpg)

Amplitude Spectral Flatness (ASF) [MPEG 7] Partitionnement du spectre d’amplitude ( ) en 23 sous-bandes (en échelle logarithmique) Dans chaque sous-bande Spectre plat : ASF Journée GSAM/SFA – 23/06/2005 , 0 < ASF < 1 4

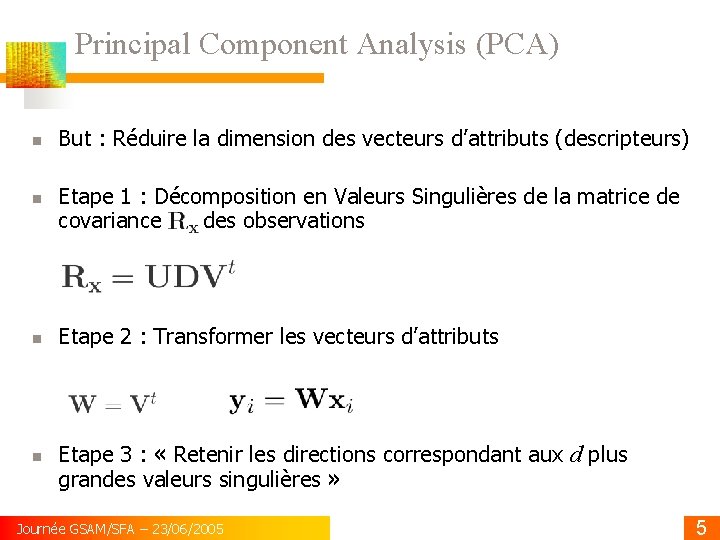

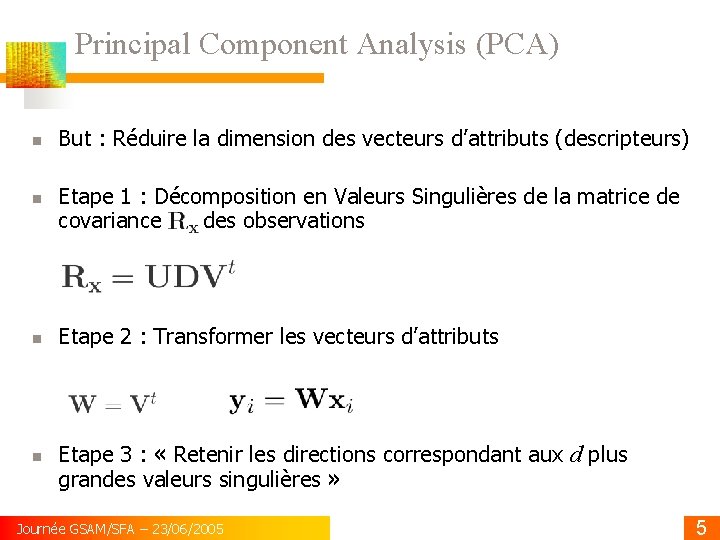

Principal Component Analysis (PCA) But : Réduire la dimension des vecteurs d’attributs (descripteurs) Etape 1 : Décomposition en Valeurs Singulières de la matrice de covariance des observations Etape 2 : Transformer les vecteurs d’attributs Etape 3 : « Retenir les directions correspondant aux d plus grandes valeurs singulières » Journée GSAM/SFA – 23/06/2005 5

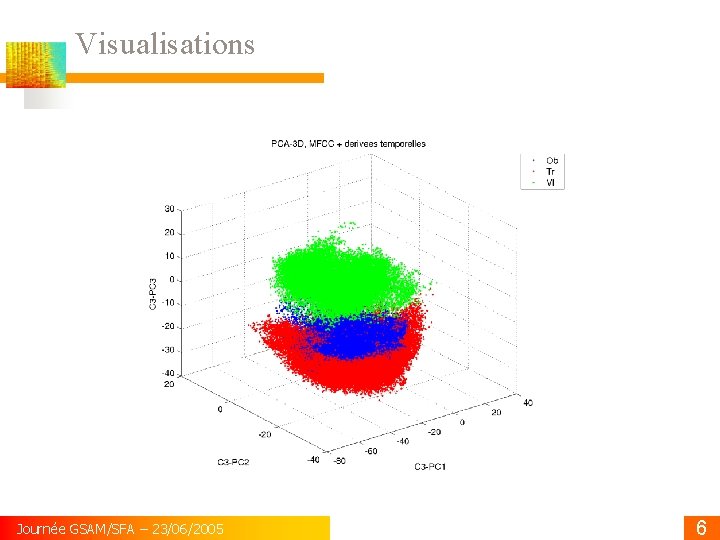

Visualisations Journée GSAM/SFA – 23/06/2005 6

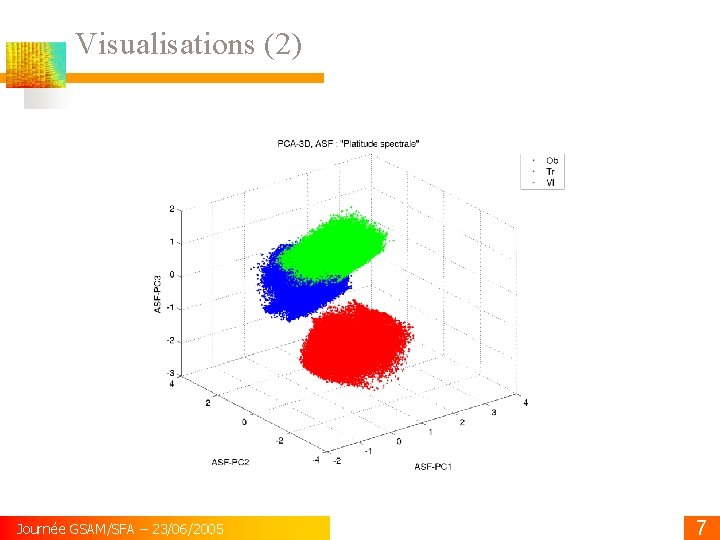

Visualisations (2) Journée GSAM/SFA – 23/06/2005 7

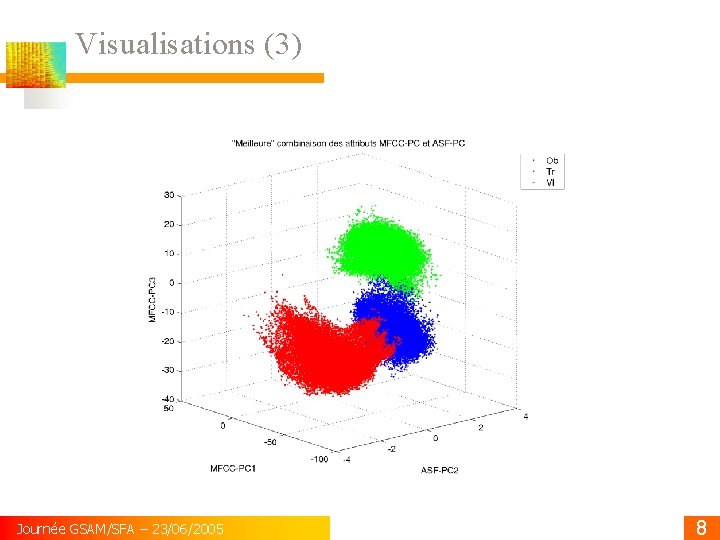

Visualisations (3) Journée GSAM/SFA – 23/06/2005 8

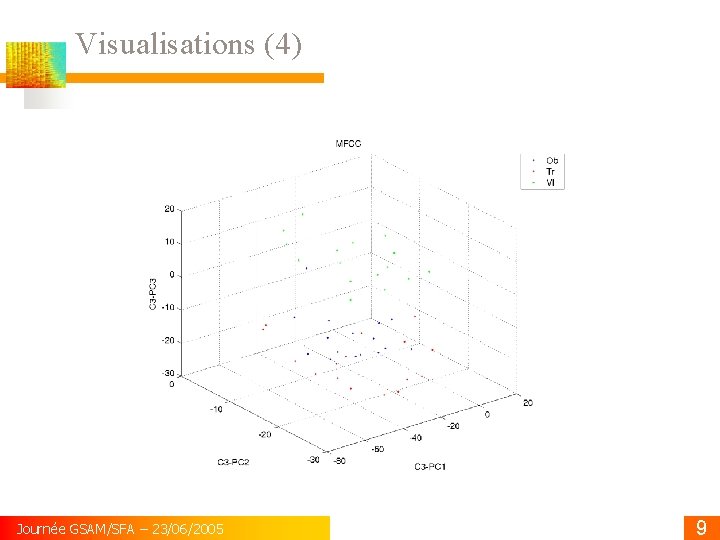

Visualisations (4) Journée GSAM/SFA – 23/06/2005 9

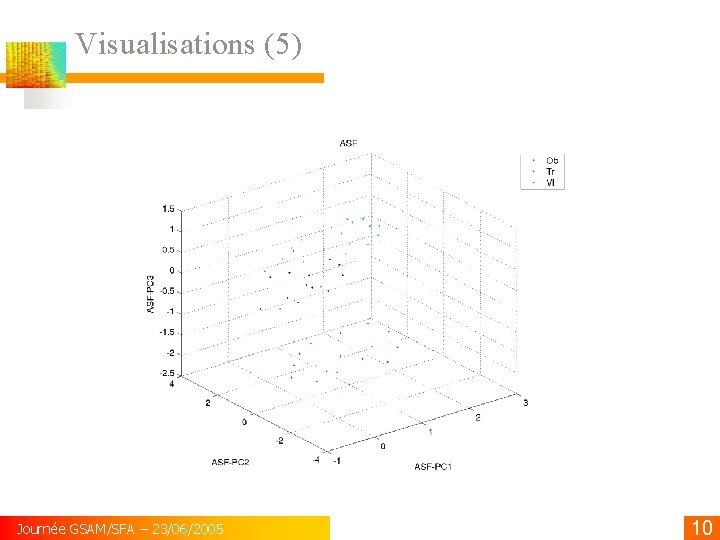

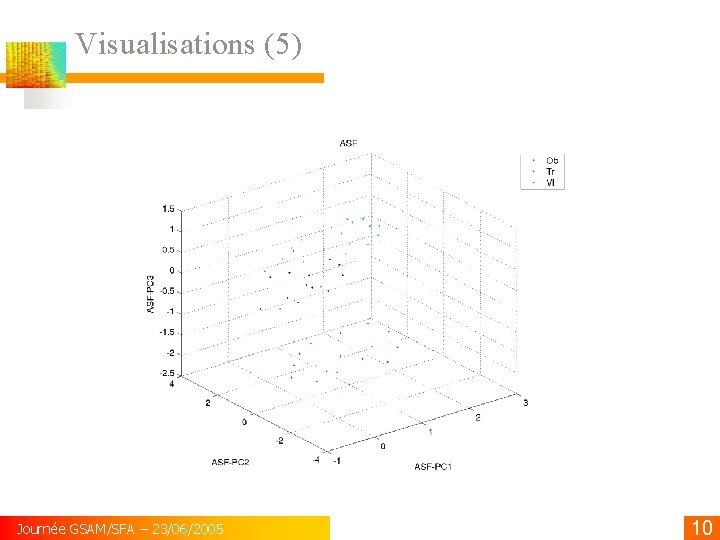

Visualisations (5) Journée GSAM/SFA – 23/06/2005 10

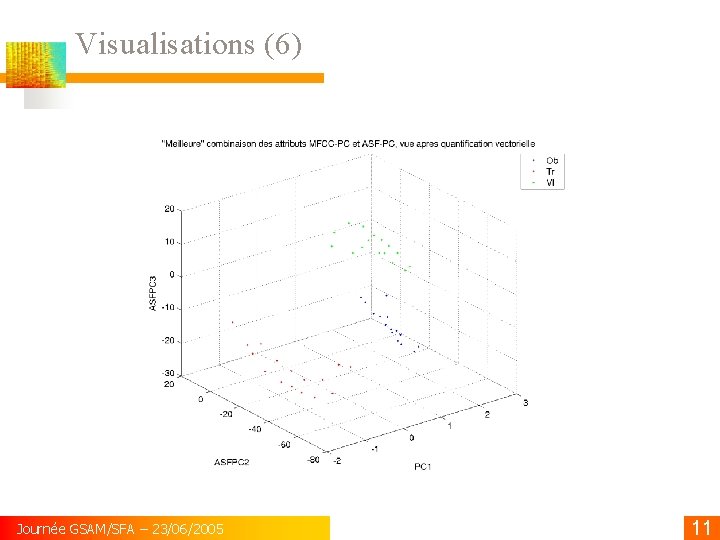

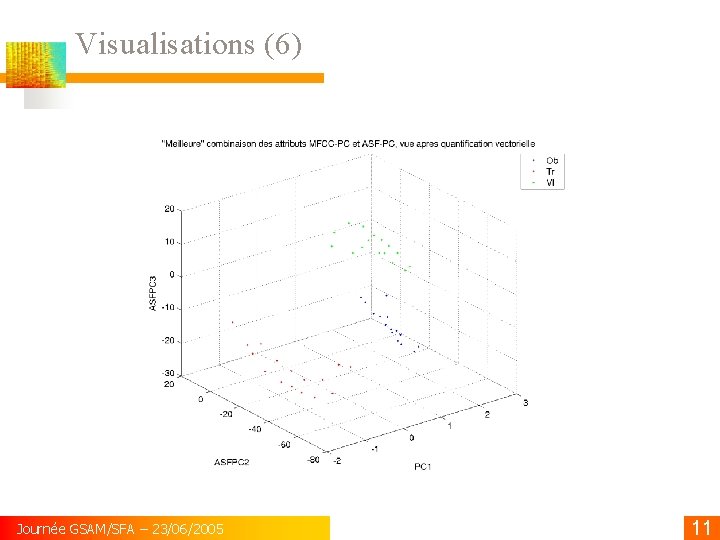

Visualisations (6) Journée GSAM/SFA – 23/06/2005 11

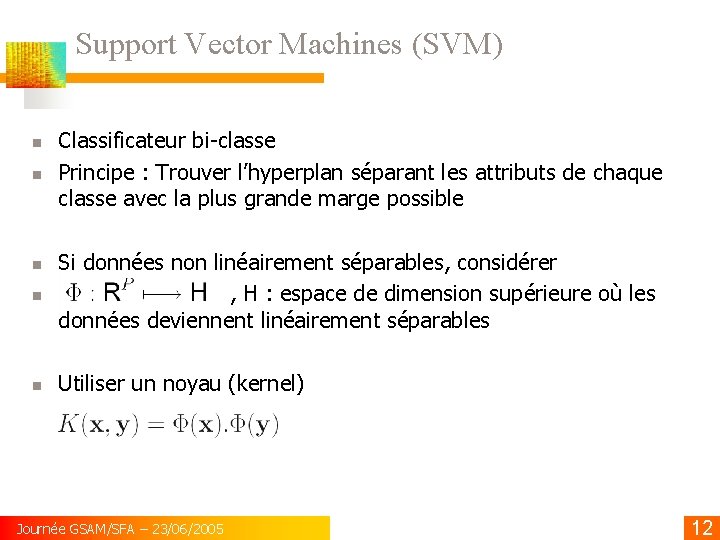

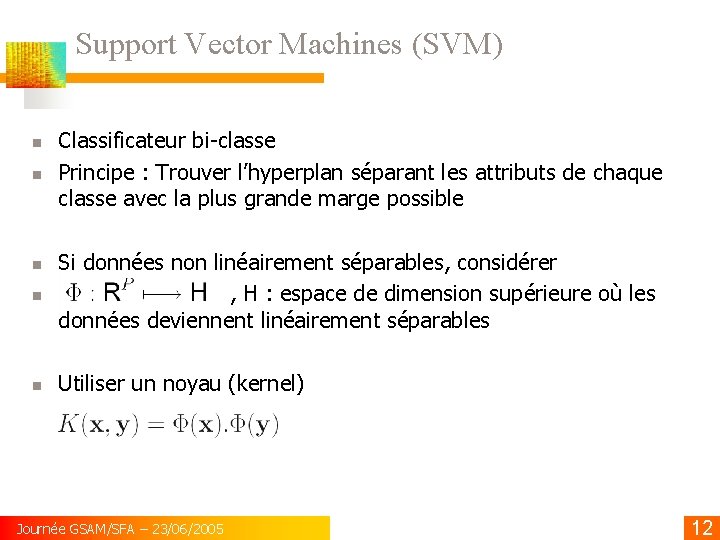

Support Vector Machines (SVM) Classificateur bi-classe Principe : Trouver l’hyperplan séparant les attributs de chaque classe avec la plus grande marge possible Si données non linéairement séparables, considérer , H : espace de dimension supérieure où les données deviennent linéairement séparables Utiliser un noyau (kernel) Journée GSAM/SFA – 23/06/2005 12

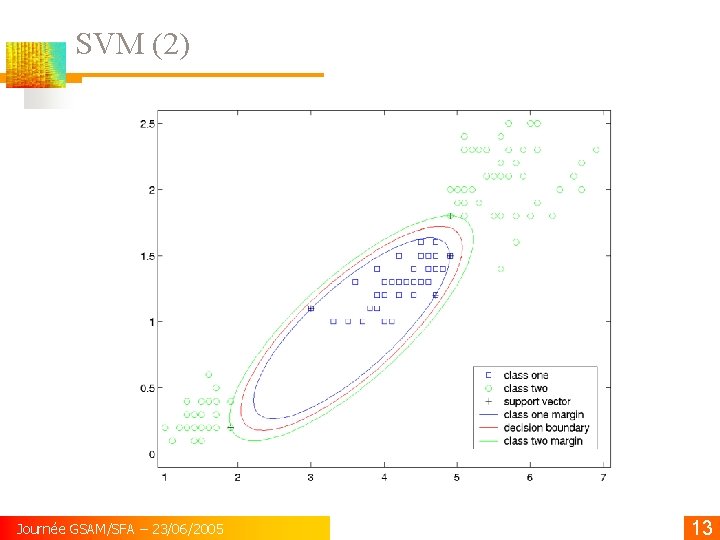

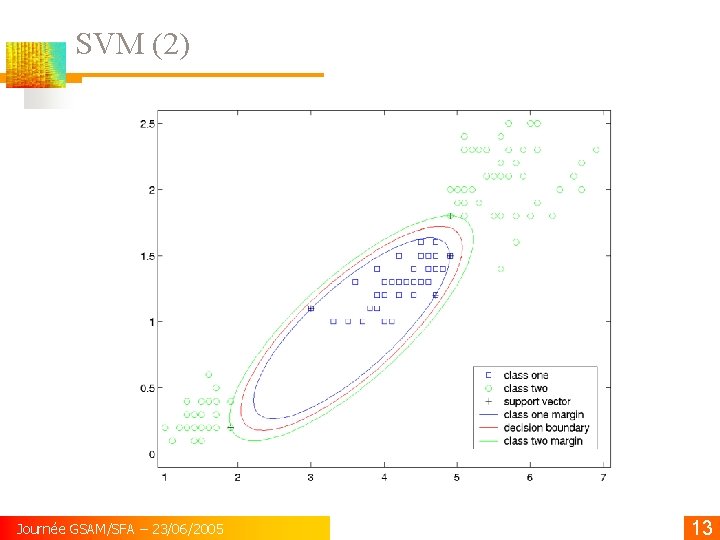

SVM (2) Journée GSAM/SFA – 23/06/2005 13

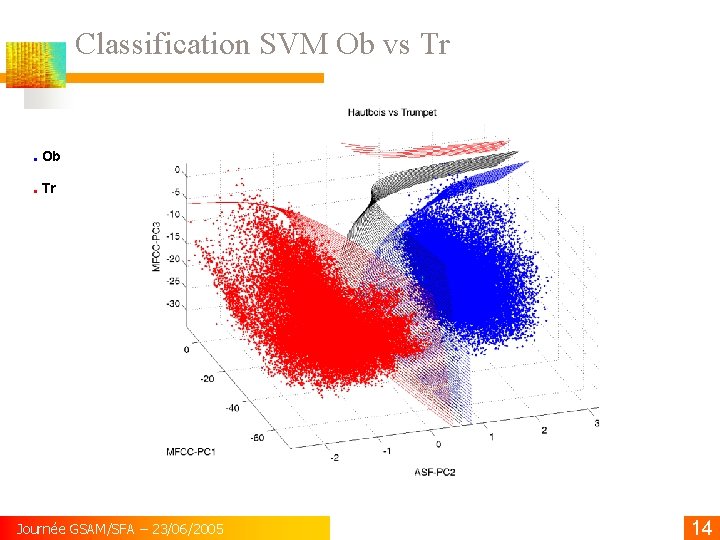

Classification SVM Ob vs Tr . Ob. Tr Journée GSAM/SFA – 23/06/2005 14

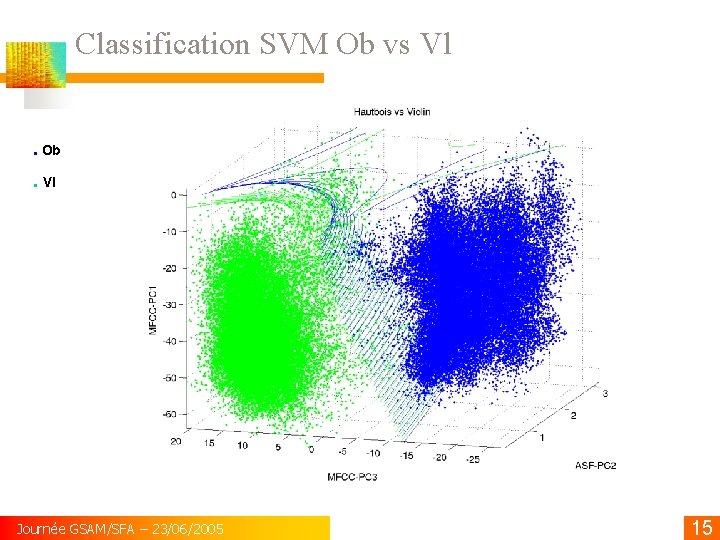

Classification SVM Ob vs Vl. Ob. Vl Journée GSAM/SFA – 23/06/2005 15

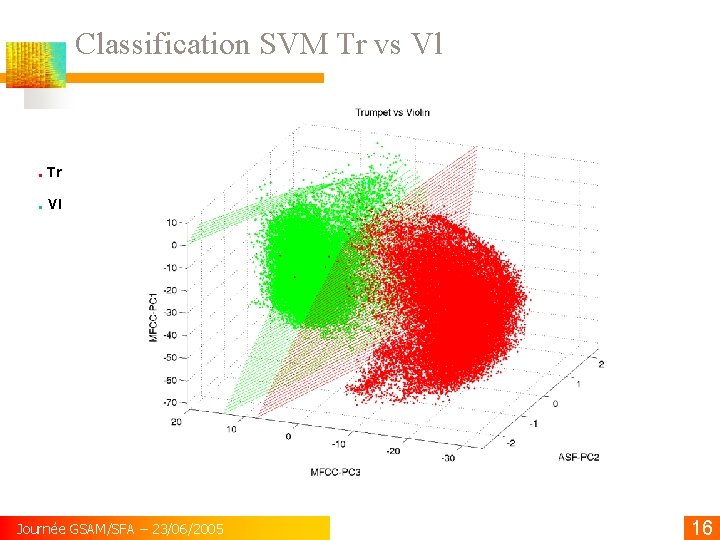

Classification SVM Tr vs Vl . Tr. Vl Journée GSAM/SFA – 23/06/2005 16