CADENAS DE MARKOV APLICACIN DE LA CADENA DE

- Slides: 15

CADENAS DE MARKOV

APLICACIÓN DE LA CADENA DE MARKOV El análisis de Markov, llamado así en honor de un matemático ruso que desarrollo el método en 1907, permite encontrar la probabilidad de que un sistema se encuentre en un estado en particular en un momento dado. Algo más importante aún, es que permite encontrar el promedio a la larga o las probabilidades de estado estable para cada estado. Con esta información se puede predecir comportamiento del sistema a través del tiempo el Su introducción de la cadena de Markov como un modelo para el estudio de variables aleatorias hecho enormes cantidades de investigación posible en los procesos estocásticos [un proceso estocástico es una familia o una colección de variables aleatorias indexadas por un proceso de parámetros también se le llama suerte o azar

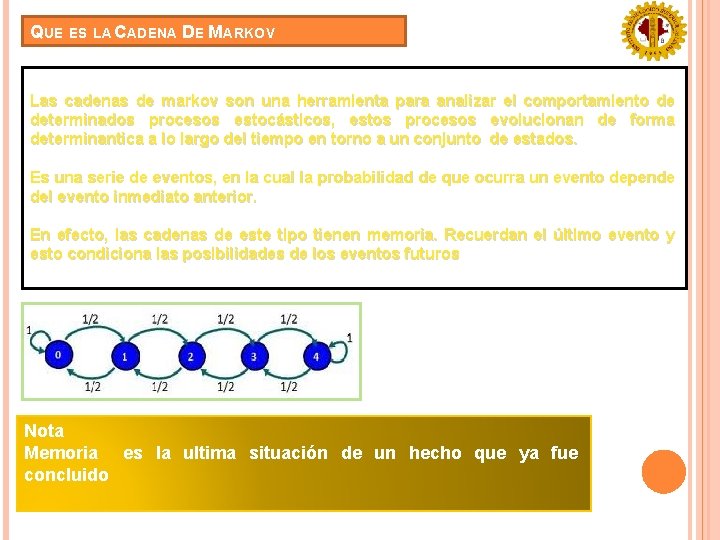

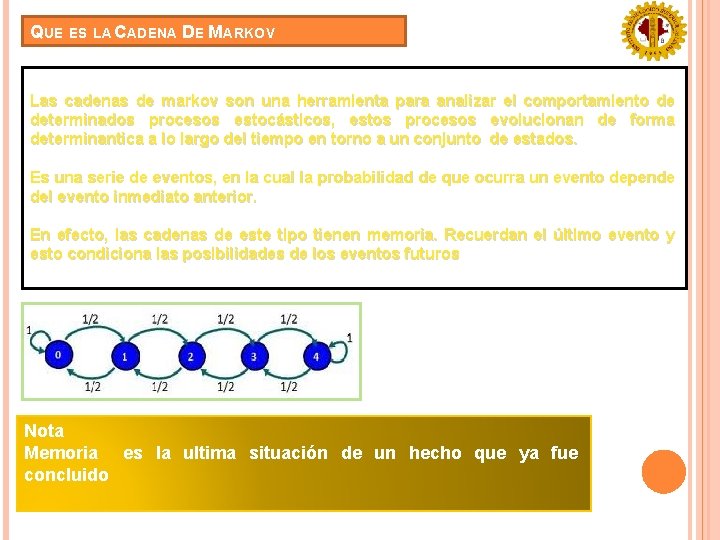

QUE ES LA CADENA DE MARKOV Las cadenas de markov son una herramienta para analizar el comportamiento de determinados procesos estocásticos, estos procesos evolucionan de forma determinantica a lo largo del tiempo en torno a un conjunto de estados. Es una serie de eventos, en la cual la probabilidad de que ocurra un evento depende del evento inmediato anterior. En efecto, las cadenas de este tipo tienen memoria. Recuerdan el último evento y esto condiciona las posibilidades de los eventos futuros Nota Memoria es la ultima situación de un hecho que ya fue concluido

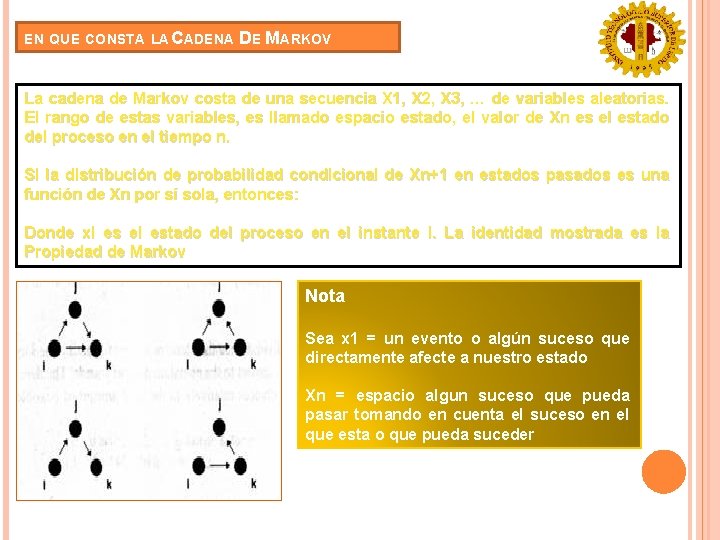

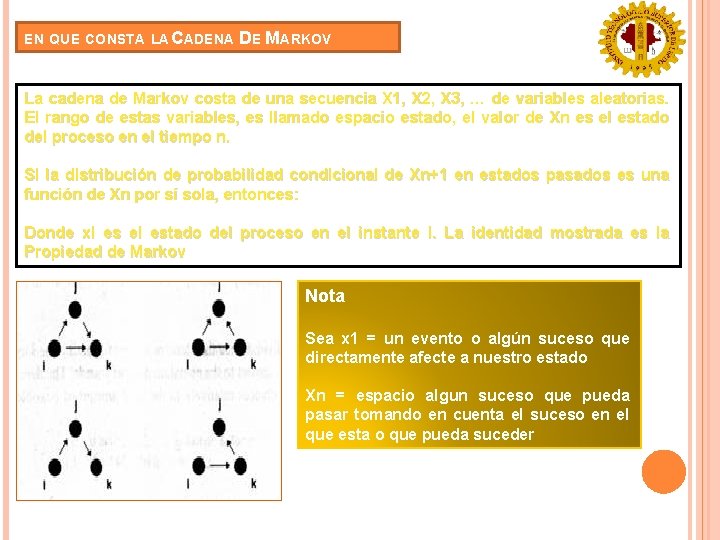

EN QUE CONSTA LA CADENA DE MARKOV La cadena de Markov costa de una secuencia X 1, X 2, X 3, … de variables aleatorias. El rango de estas variables, es llamado espacio estado, el valor de Xn es el estado del proceso en el tiempo n. Si la distribución de probabilidad condicional de Xn+1 en estados pasados es una función de Xn por sí sola, entonces: Donde xi es el estado del proceso en el instante i. La identidad mostrada es la Propiedad de Markov Nota Sea x 1 = un evento o algún suceso que directamente afecte a nuestro estado Xn = espacio algun suceso que pueda pasar tomando en cuenta el suceso en el que esta o que pueda suceder

APLICACIÓN DE LA CADENA DE MARKOV Las cadenas de markov se usan en muchos campos de la industria entre estos el reparto del mercado entre marcas, dinámica de las averías de máquinas para decidir politica de mantenimiento, evolución de una enfermedad, etc. Otra de las aplicaciones de las cadenas de markov es la administración Dentro del las cadenas de markov existen dos categorías las cuales son • Continuas • Discretas

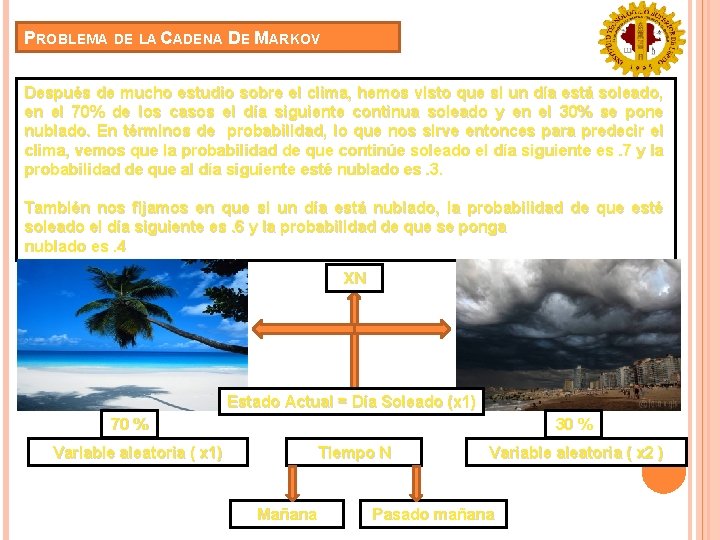

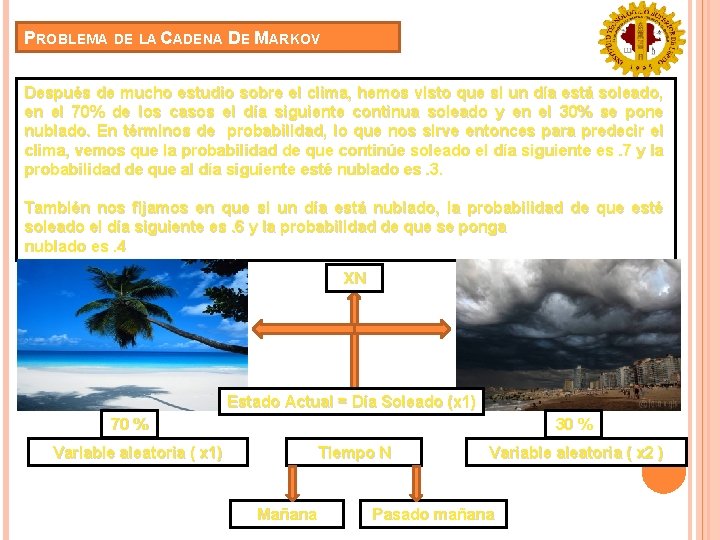

PROBLEMA DE LA CADENA DE MARKOV Después de mucho estudio sobre el clima, hemos visto que si un día está soleado, en el 70% de los casos el día siguiente continua soleado y en el 30% se pone nublado. En términos de probabilidad, lo que nos sirve entonces para predecir el clima, vemos que la probabilidad de que continúe soleado el día siguiente es. 7 y la probabilidad de que al día siguiente esté nublado es. 3. También nos fijamos en que si un día está nublado, la probabilidad de que esté soleado el día siguiente es. 6 y la probabilidad de que se ponga nublado es. 4 XN Estado Actual = Día Soleado (x 1) 70 % 30 % Variable aleatoria ( x 1) Tiempo N Mañana Variable aleatoria ( x 2 ) Pasado mañana

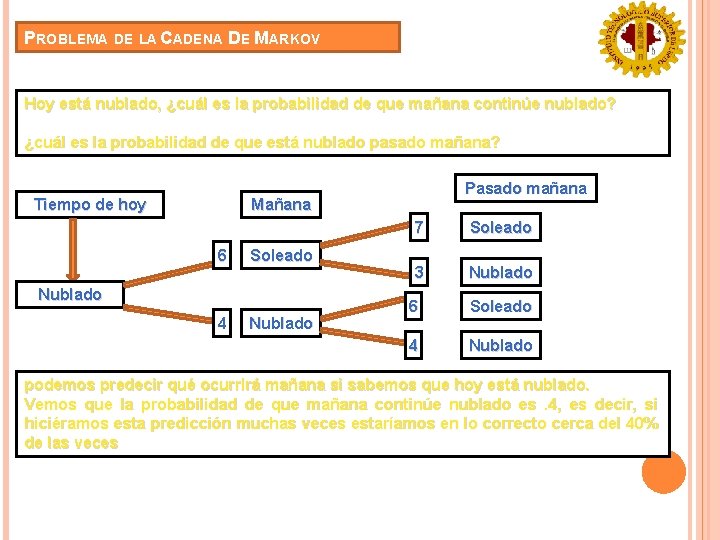

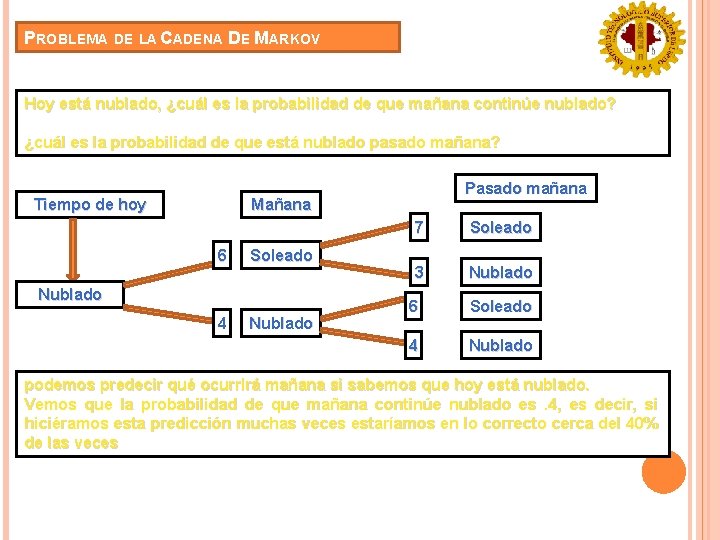

PROBLEMA DE LA CADENA DE MARKOV Hoy está nublado, ¿cuál es la probabilidad de que mañana continúe nublado? ¿cuál es la probabilidad de que está nublado pasado mañana? Tiempo de hoy Pasado mañana Mañana 6 Soleado Nublado 4 Nublado 7 Soleado 3 Nublado 6 Soleado 4 Nublado podemos predecir qué ocurrirá mañana si sabemos que hoy está nublado. Vemos que la probabilidad de que mañana continúe nublado es. 4, es decir, si hiciéramos esta predicción muchas veces estaríamos en lo correcto cerca del 40% de las veces

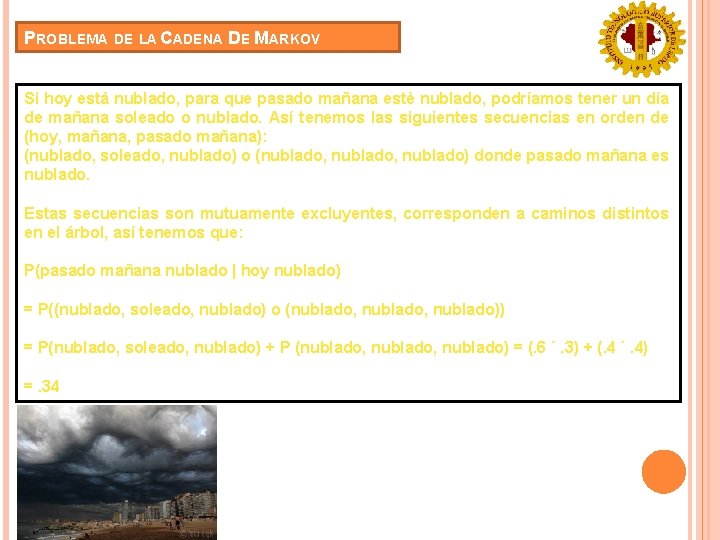

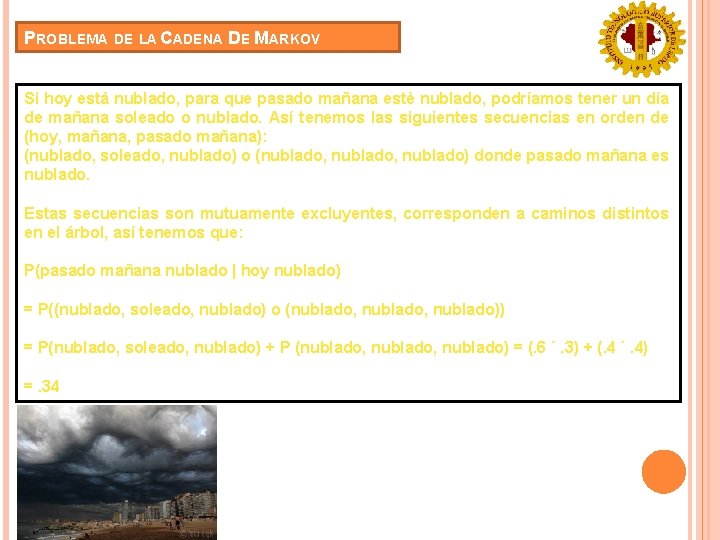

PROBLEMA DE LA CADENA DE MARKOV Si hoy está nublado, para que pasado mañana esté nublado, podríamos tener un día de mañana soleado o nublado. Así tenemos las siguientes secuencias en orden de (hoy, mañana, pasado mañana): (nublado, soleado, nublado) o (nublado, nublado) donde pasado mañana es nublado. Estas secuencias son mutuamente excluyentes, corresponden a caminos distintos en el árbol, así tenemos que: P(pasado mañana nublado | hoy nublado) = P((nublado, soleado, nublado) o (nublado, nublado)) = P(nublado, soleado, nublado) + P (nublado, nublado) = (. 6 ´. 3) + (. 4 ´. 4) =. 34

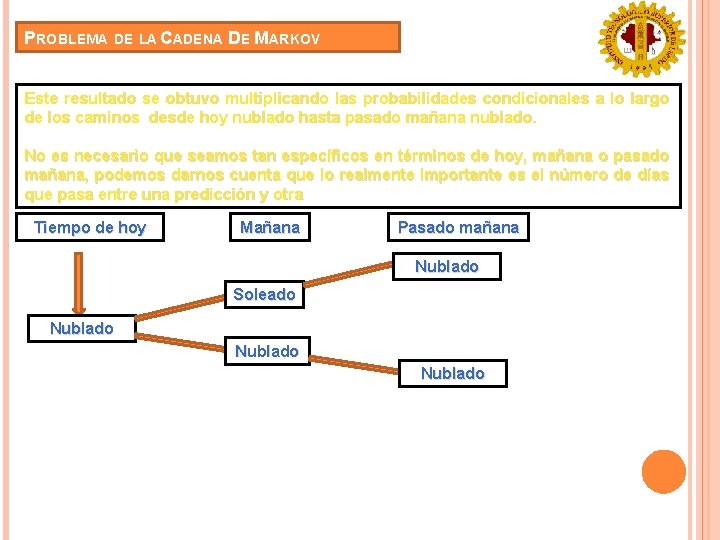

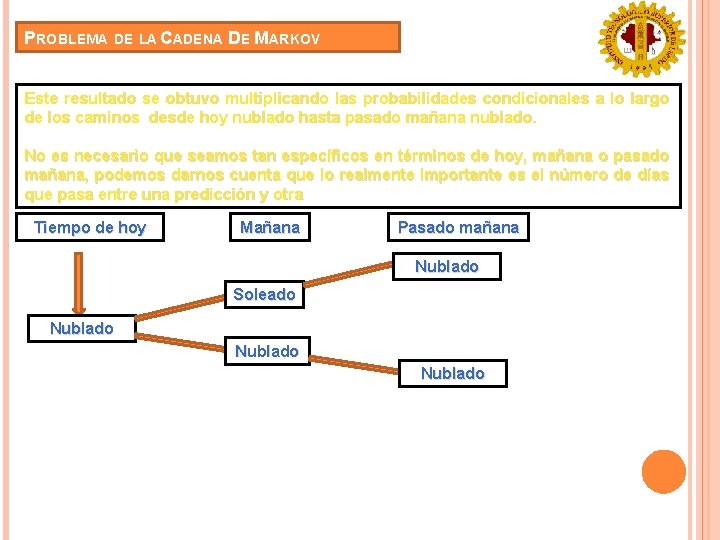

PROBLEMA DE LA CADENA DE MARKOV Este resultado se obtuvo multiplicando las probabilidades condicionales a lo largo de los caminos desde hoy nublado hasta pasado mañana nublado. No es necesario que seamos tan específicos en términos de hoy, mañana o pasado mañana, podemos darnos cuenta que lo realmente importante es el número de días que pasa entre una predicción y otra Tiempo de hoy Mañana Pasado mañana Nublado Soleado Nublado

PROBLEMA DE LA CADENA DE MARKOV Hoy está nublado, ¿cuál es la probabilidad de que esté nublado tres días después? El proceso de este ejemplo sólo puede adquirir uno de dos estados posibles x 1 = nublado y x 2 = soleado. La probabilidad con que se va de un estado a otro depende del estado en que estamos en el presente. Dejemos que X 1 represente el estado del clima del día número 1, X 2 el estado del clima del día número 2 y así sucesivamente. En general, para n = 1, 2, . . . sea Xn el estado del clima La sucesión de observaciones X 1, X 2, . . . se llama un proceso estocástico o proceso aleatorio. La primera observación X 1 se conoce como el estado inicial del proceso y para n = 2, 3, . . . , Xn es el estado del proceso en el tiempo n

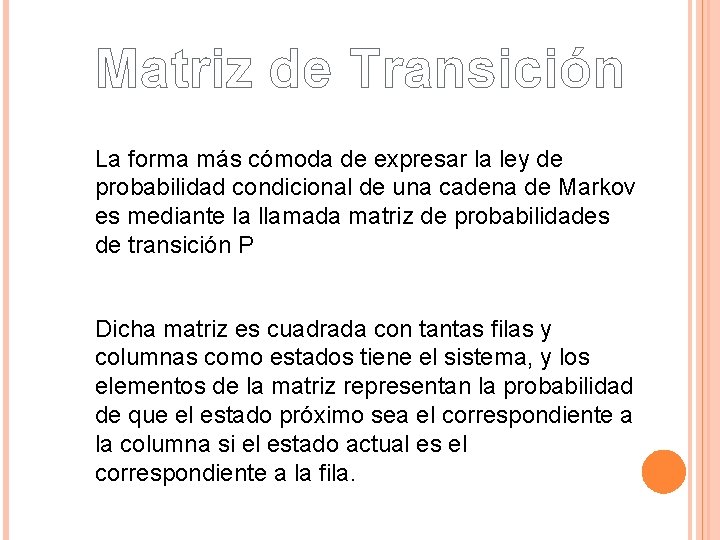

Matriz de Transición La forma más cómoda de expresar la ley de probabilidad condicional de una cadena de Markov es mediante la llamada matriz de probabilidades de transición P Dicha matriz es cuadrada con tantas filas y columnas como estados tiene el sistema, y los elementos de la matriz representan la probabilidad de que el estado próximo sea el correspondiente a la columna si el estado actual es el correspondiente a la fila.

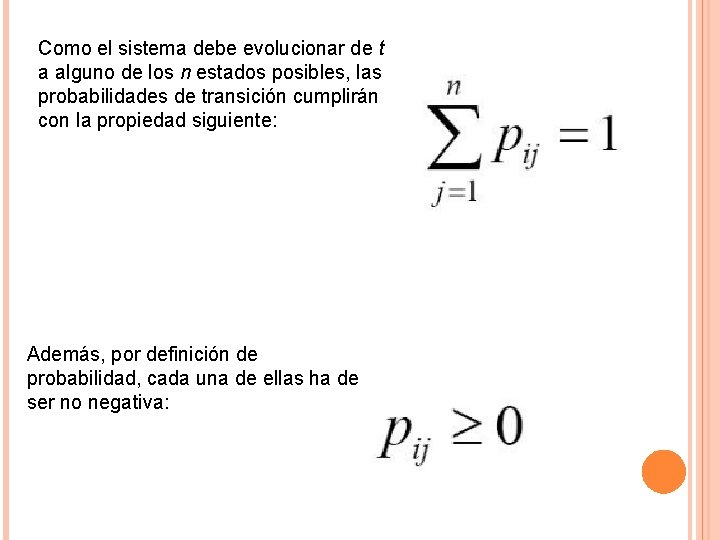

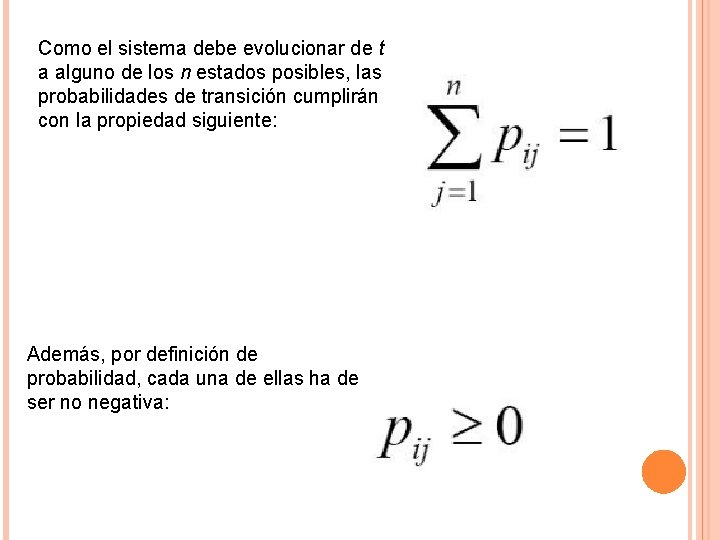

Como el sistema debe evolucionar de t a alguno de los n estados posibles, las probabilidades de transición cumplirán con la propiedad siguiente: Además, por definición de probabilidad, cada una de ellas ha de ser no negativa:

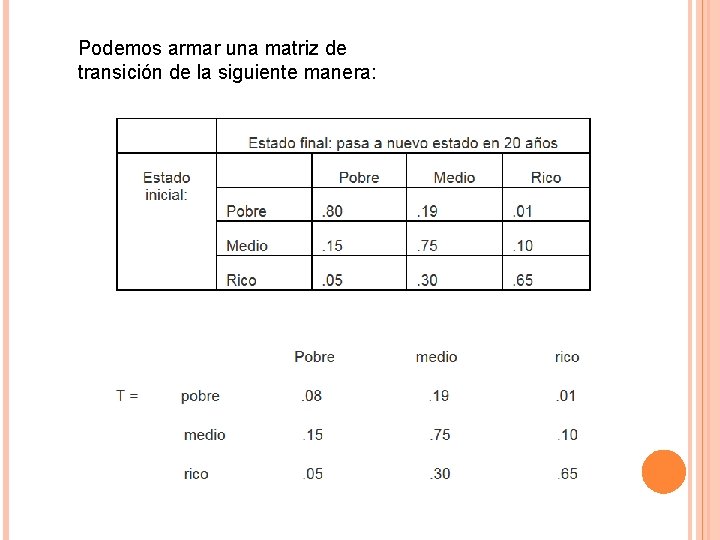

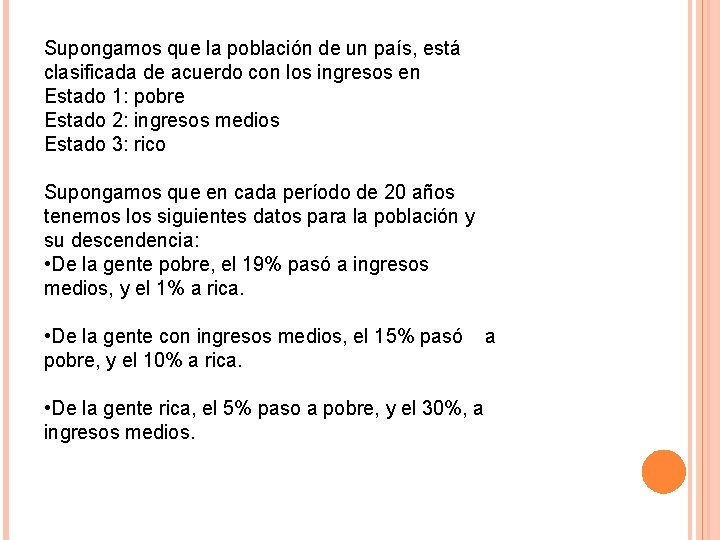

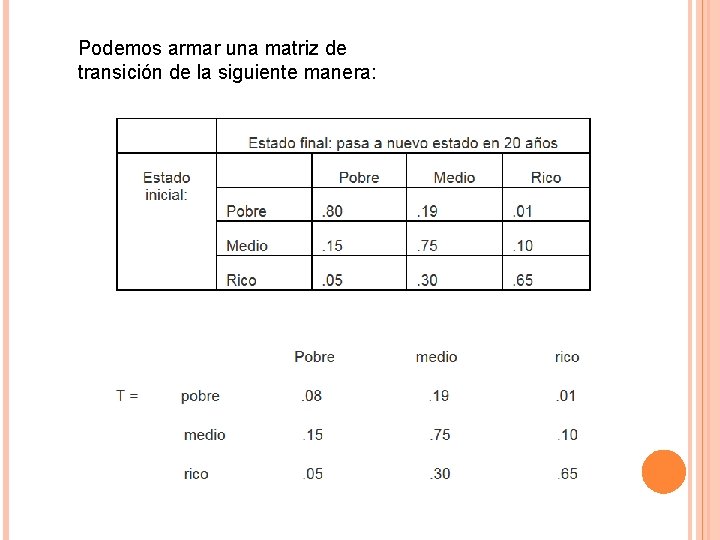

Supongamos que la población de un país, está clasificada de acuerdo con los ingresos en Estado 1: pobre Estado 2: ingresos medios Estado 3: rico Supongamos que en cada período de 20 años tenemos los siguientes datos para la población y su descendencia: • De la gente pobre, el 19% pasó a ingresos medios, y el 1% a rica. • De la gente con ingresos medios, el 15% pasó pobre, y el 10% a rica. • De la gente rica, el 5% paso a pobre, y el 30%, a ingresos medios. a

Podemos armar una matriz de transición de la siguiente manera:

Ejemplo de hay

Ejemplo de hay Cadenas de markov caracteristicas

Cadenas de markov caracteristicas Aplicacin

Aplicacin Cadenas en php

Cadenas en php Ejemplos de cadenas homociclicas

Ejemplos de cadenas homociclicas Niveles troficos de la cadena alimenticia

Niveles troficos de la cadena alimenticia Cadenas yugulocarotideas

Cadenas yugulocarotideas Nucletidos

Nucletidos Cadenas troficas y seguridad alimentaria en venezuela

Cadenas troficas y seguridad alimentaria en venezuela Ataduras generacionales

Ataduras generacionales Las cadenas del adn

Las cadenas del adn Comercio asociado

Comercio asociado Hidden markov map matching through noise and sparseness

Hidden markov map matching through noise and sparseness Djevojka nadmudrila marka

Djevojka nadmudrila marka Gene finding

Gene finding Contoh kasus, analisis markov

Contoh kasus, analisis markov