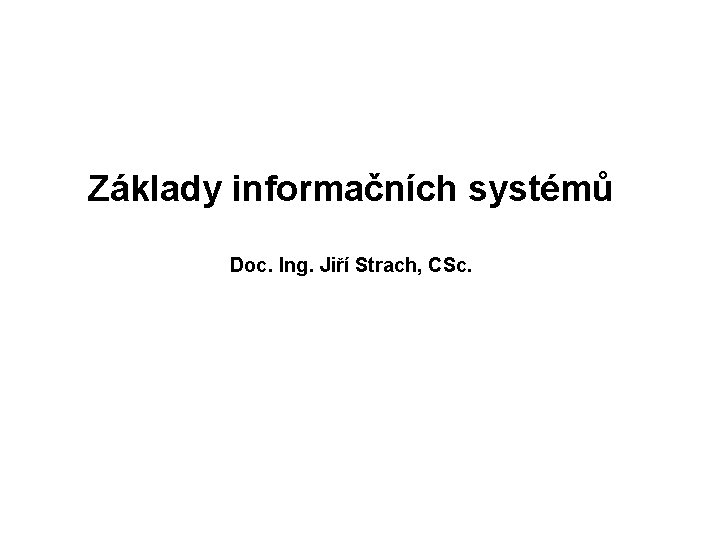

Prvn semestr Nzev pedmtu Rozsah Zps zak Kred

![Shenonova věta definuje propustnost kanálu pro bílý šum C= Df *log 2 [(P+N)/N] P. Shenonova věta definuje propustnost kanálu pro bílý šum C= Df *log 2 [(P+N)/N] P.](https://slidetodoc.com/presentation_image_h2/a13dee49d33fca1ffb2dd32ebf577bff/image-22.jpg)

- Slides: 30

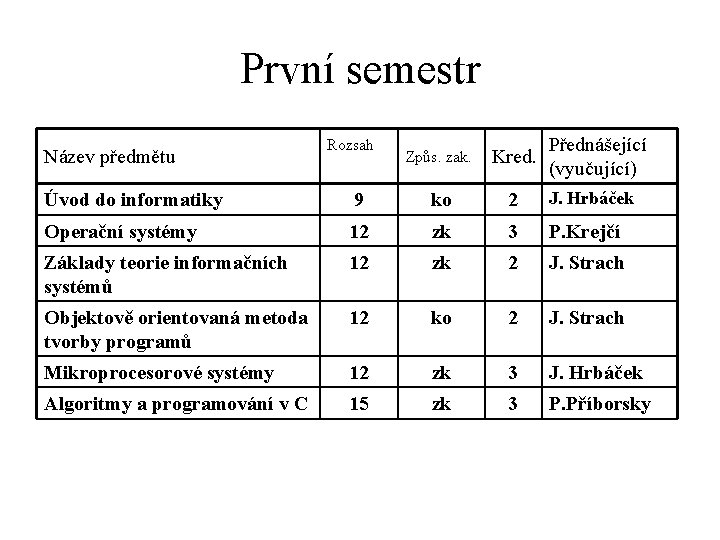

První semestr Název předmětu Rozsah Způs. zak. Kred. Přednášející (vyučující) Úvod do informatiky 9 ko 2 J. Hrbáček Operační systémy 12 zk 3 P. Krejčí Základy teorie informačních systémů 12 zk 2 J. Strach Objektově orientovaná metoda tvorby programů 12 ko 2 J. Strach Mikroprocesorové systémy 12 zk 3 J. Hrbáček Algoritmy a programování v C 15 zk 3 P. Příborsky

Základy informačních systémů Doc. Ing. Jiří Strach, CSc.

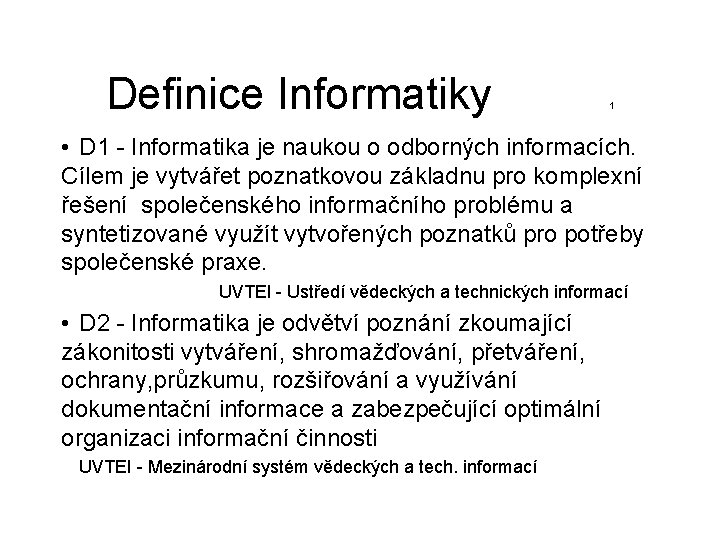

Definice Informatiky 1 • D 1 - Informatika je naukou o odborných informacích. Cílem je vytvářet poznatkovou základnu pro komplexní řešení společenského informačního problému a syntetizované využít vytvořených poznatků pro potřeby společenské praxe. UVTEI - Ustředí vědeckých a technických informací • D 2 - Informatika je odvětví poznání zkoumající zákonitosti vytváření, shromažďování, přetváření, ochrany, průzkumu, rozšiřování a využívání dokumentační informace a zabezpečující optimální organizaci informační činnosti UVTEI - Mezinárodní systém vědeckých a tech. informací

• Informatika je soubor vědeckých disciplin a speciálních postupů při zpracování informací ČSN 36 9001. • Informatika je vědní obor zabývající se strukturou, vlast -nostmi (ale ne obsahem), zpracováním, a využitím infor -mací. V informatice se studují zákonitosti, teorie, metody zpracování informací a organizace práce s nimi. Cílem Informatiky je propracovat optimální způsoby a prostředky pro zobrazení, shromažďování, a rozšiřování informací. Oborová encyklopedie SNTL 1994

Informační systém, informační technologie S vývojem informačních systémů se postupně měnilo jeho vymezení od : · sytému pro zpracování dat, přes · systém pravidel a způsobů řízení , až po · systémy zahrnující složitý konglomerát různých aspektů datových, organizačních, procesních, metodických, technologických, ekonomických a obchodně podnikatelských. Informační technologii rozumíme soubor všech prostředků , kterých se využívá k pořízení, uchování , zpracování presentaci a přenosu dat. Informační technologie zahrnují dvě základní kategorie : · technické prostředky (HW) - zařízení na pořizování, uchování, přenos, zpracování a přenos dat · programové prostředky (SW) - algoritmizované postupy vyjádřené ve formě , ve které jsou srozumitelné (použitelné) pro používaná technická zařízení. Na rozdíl od HW který má vždy povahu fyzického produktu , má SW povahu nemateriální a musí být ve formě informací- dat uložen na nějakém fyzickém nosiči dat.

V teorii informačních systémů se budeme zabývat : • Teorie systémů • Teorie informace. • Teorie signálu • Teorie automatů • Logika • Logické obvody a systémy • Umělá inteligence

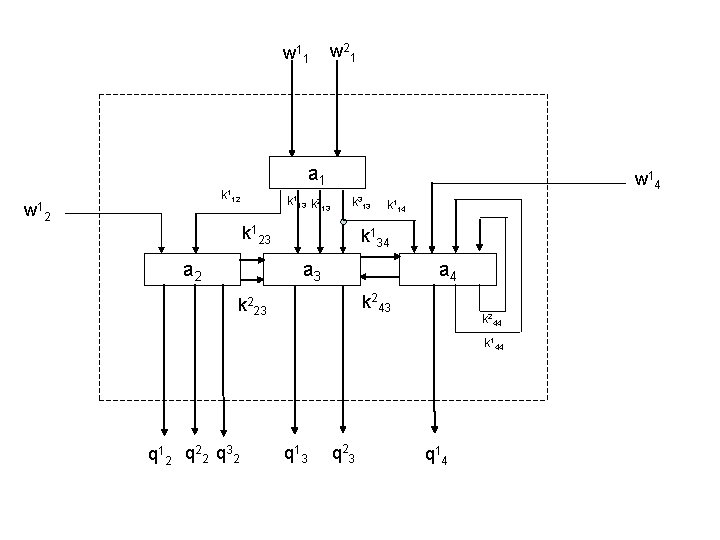

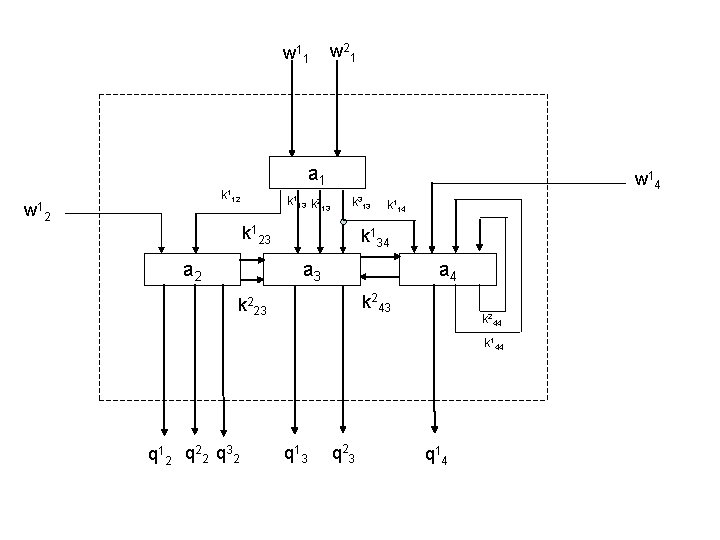

Teorie systémů Systémem rozumíme abstraktní popis určité části reality vytvořený za účelem studia vazeb jednotlivých elementárních částí (prvků systému) této reality a popis chování systému jako celku pří změně působící z okolí systému. Systém je tedy definován 1. Strukturou systému, charakterizující jeho vnitřní funkční vztahy; strukturou systému rozumíme jednak způsob uspořádání (organizace) vzájemných vazeb mezi prvky systému : S = { A, W, K, Q} Kde S je systém, A je množina prvků systému W je množina vstupních stavů, K množina vnitřních stavů, Q množina výstupních stavů. přechodová a f výstupní funkce

w 1 1 w 2 1 a 1 w 1 k 112 2 k 113 k 2 13 w 1 4 k 313 k 123 a 2 k 114 k 134 a 3 a 4 k 243 k 223 k 244 k 144 q 1 2 q 2 2 q 3 2 q 1 3 q 2 3 q 1 4

Chování systému Chováním systému rozumíme osmici: S = ( T, X, V, W, Z, Q, f, g) V chování systému S je spjat čas, charakterizovaný množinou T, která je podmnožinou reálných čísel R Jestliže T je tvořena intervalem (konečným nebo nekonečným), je S dynamickým systémem se spojitým časem. Jestliže T je podmnožina celých čísel, je systém S dynamickým systémem s diskrétním časem. V každém časovém okamžiku t Î T získává relativně uzavřený systém S chování, které je popsáno vztahem S , na vstupu je podnět W – vstupní vektor jehož složky činí soubor okamžitých hodnot w(tk). Na časový průběh složek vstupního vektoru X lze pohlížet jako na vstupní funkci w : T ® V tak že W = {w : T ® V } Q je výstupní vektor q : t ® Z tak že Q = {q : T ® Z } Vnitřní stav systému Z je určen souborem okamžitých hodnot tzv. . Vnitřních proměnných systému a představuje úplnou informaci, kterou systém zaznamenal během předchozí činnosti. Okamžitý vnitřní stav k a podnět W určují u deterministického systému celkový stav systému.

Tradiční klasifikace systémů Uveďme dvě tradiční klasifikace: Peter Checkland člení systémy do čtyř skupin: 1. Přirozené systémy (systémy živé, systémy neživé). 2. Navrhované umělé systémy (systémy vytvářené člověkem s určitým záměrem, např. stroje, automobily, počítače, knihy apod. ). 3. Systémy lidských aktivit (stát, státní instituce, hospodářské organizace, zájmové organizace - existuje v nich interakce lidí). 4. Transcendentální systémy (systémy přesahující hranice lidského chápání). Kenneth Boulding rozlišuje devět typů systémů: 1. Transcendentální systémy. 2. Sociální systémy. 3. Člověk se svou inteligencí. 4. Živočichové. 5. Genetické systémy (mají společný genetický kód). 6. Otevřené systémy (spojeny s existencí života, např. buňka). 7. Kybernetické systémy (systémy se zpětnou vazbou). 8. Mechanické systémy (např. stroje, technická zařízení). 9. Fyzikální systémy.

Nebo dělení vhodnější pro naše účely 1. tvrdé systémy - popisují dobře strukturované problémy , lze u nich exaktně vyjádřit vztah mezi vstupními a výstupními daty, která mají převážně kvantitativní charakter. řešení těchto systémů je prakticky vždy algoritmiziovatelné a tedy může být svěřeno počítači 2. měkké systémy - popisují špatně strukturované problémy - jsou to složité systémy , kde do vzájemných vztahů mezi prvky systému vstupují faktory obtížně kvantifikovatelné, ve kterých se vyskytují neurčitosti , rizika, nejistoty. Vstupní informace do těchto systémů nemusí být vždy věrohodné, často se využívá přibližných hodnot. Měkké systémy se vyznačují tím, že jejich chování je často ovlivňováno člověkem a jeho individualitou. Příkladem jsou sociální systémy jako hospodářské organizace, ministrstva apod.

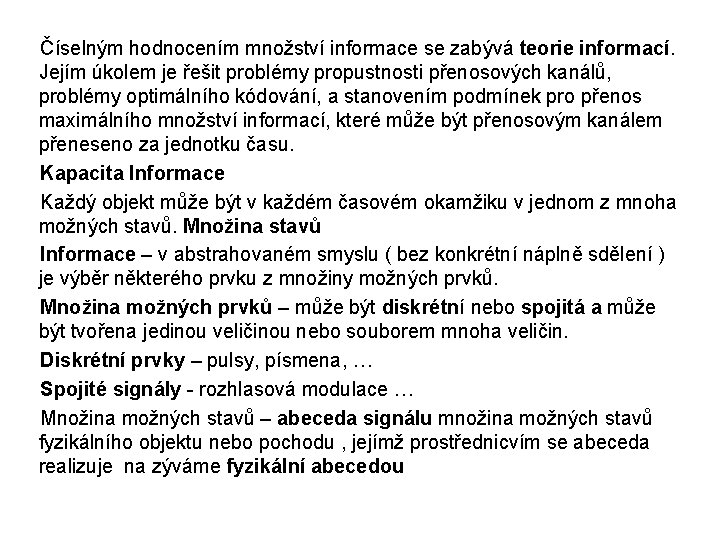

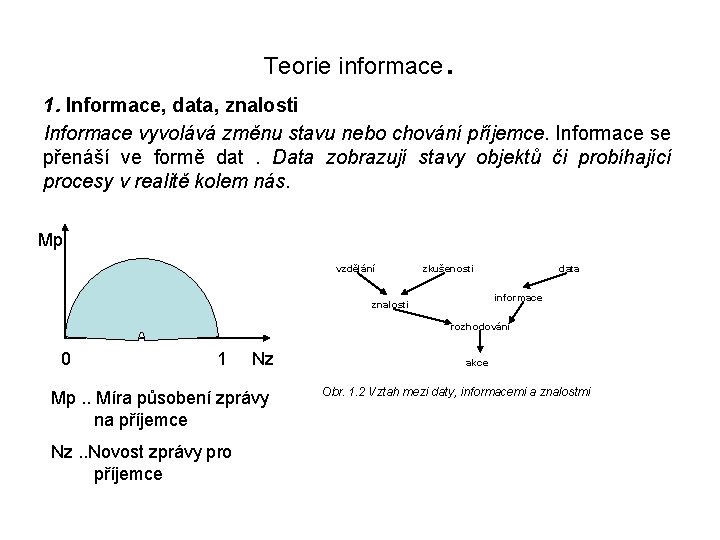

Teorie informace . 1. Informace, data, znalosti Informace vyvolává změnu stavu nebo chování příjemce. Informace se přenáší ve formě dat. Data zobrazují stavy objektů či probíhající procesy v realitě kolem nás. Mp vzdělání zkušenosti data informace znalosti rozhodování 0 1 Nz Mp. . Míra působení zprávy na příjemce Nz. . Novost zprávy pro příjemce akce Obr. 1. 2 Vztah mezi daty, informacemi a znalostmi

Číselným hodnocením množství informace se zabývá teorie informací. Jejím úkolem je řešit problémy propustnosti přenosových kanálů, problémy optimálního kódování, a stanovením podmínek pro přenos maximálního množství informací, které může být přenosovým kanálem přeneseno za jednotku času. Kapacita Informace Každý objekt může být v každém časovém okamžiku v jednom z mnoha možných stavů. Množina stavů Informace – v abstrahovaném smyslu ( bez konkrétní náplně sdělení ) je výběr některého prvku z množiny možných prvků. Množina možných prvků – může být diskrétní nebo spojitá a může být tvořena jedinou veličinou nebo souborem mnoha veličin. Diskrétní prvky – pulsy, písmena, … Spojité signály - rozhlasová modulace … Množina možných stavů – abeceda signálu množina možných stavů fyzikálního objektu nebo pochodu , jejímž prostřednicvím se abeceda realizuje na zýváme fyzikální abecedou

U diskrétních abeced obsahuje-li abeceda N různých písmen je z této abecedy možno vytvořit Nn všech n - místných slov. U spojitých abeced je počet všech možných sdělení nekonečně veliký. Stanovení informační kapacity systému. Podle Hartlyho může - li systém mít N různých vzájemně nezávislých stavů jej jeho kapacita dána vztahem k – je počet prvků abecedy C 1 = logk N Spojíme –li dva takové systémy kapacita takového spojeni je C 2 = logk N 2 = 2*logk N = 2*C 1 Z toho plyne že informační kapacita je vlastnost aditivní. U logických obvodů používáme k = 2 Míra množství informace Každé sdělení přenášené kanálem nebo vložené v paměťovém zařízení přísluší některému stavu vnějšího jevu, o němž příslušné sdělení vydávají. Vnější jev je přitom zdrojem těchto sdělení, i zdrojem informací.

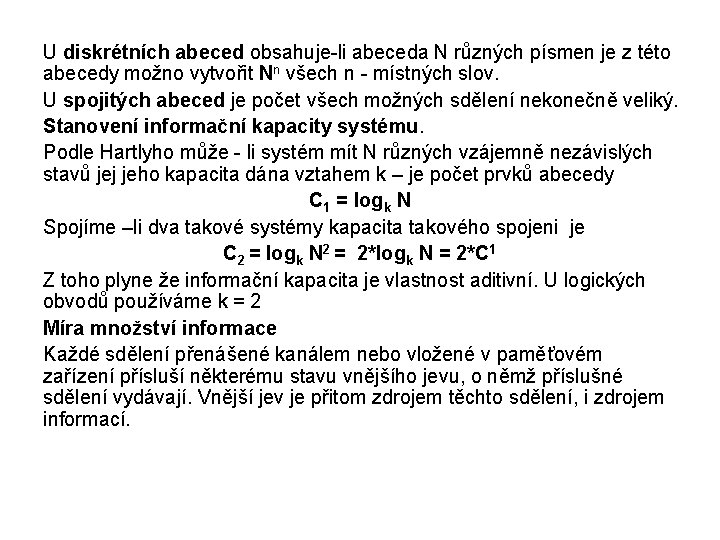

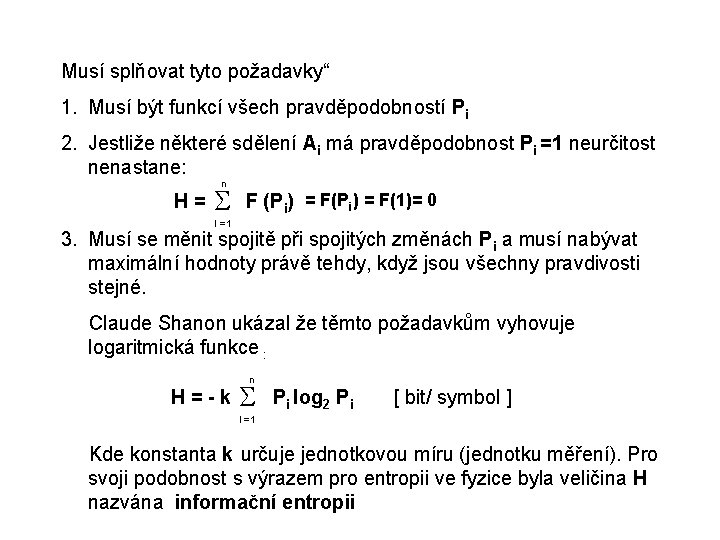

Rozložíme-li všechna možná sdělení Ai v určitém pořadí a přidělíme každému pravděpodobnost Pi , která je rovna pravděpodobnosti výskytu tohoto sdělení při skutečném přenosu. A 1 A 2 A 3 …. Ai …. An P 1 P 2 P 3. . Pi …. Pn Přičemž platí n S Pi = P 1 + P 2+ P 3 +. . Pi +…. + Pn = 1 I =1 Každé konečné schéma vyjadřuje jistou neurčitost výběru jeho prvků, která zaniká po uskutečnění vlastního výběru. Informační entropie Stupeň neurčitosti je různý pro různá schémata. Roste-li počet prvků schématu při rovnoměrném rozložení pravděpodobnosti, neurčitost se zvětšuje. Míra neurčitosti výběru v daném konečném schématu je zřejmě zároveň mírou množství informace pro jeden výběr a lze ji funkčně n vyjádřit: H = S F (Pi) I =1

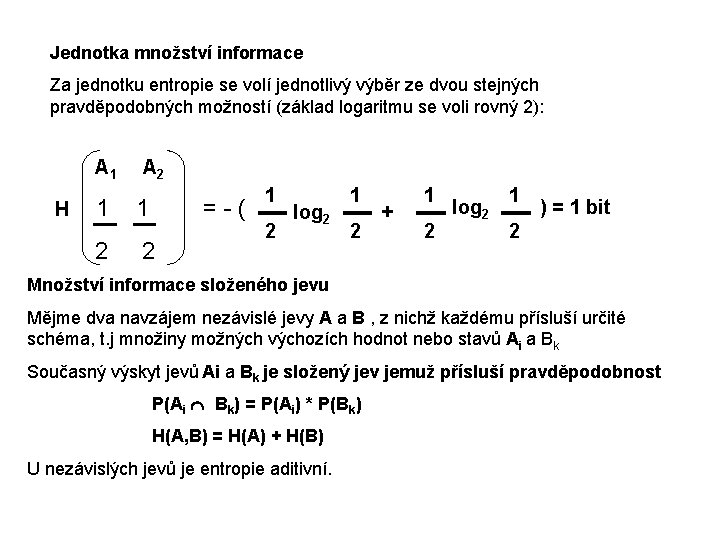

Musí splňovat tyto požadavky“ 1. Musí být funkcí všech pravděpodobností Pi 2. Jestliže některé sdělení Ai má pravděpodobnost Pi =1 neurčitost nenastane: n H= S F (Pi) = F(1)= 0 I =1 3. Musí se měnit spojitě při spojitých změnách Pi a musí nabývat maximální hodnoty právě tehdy, když jsou všechny pravdivosti stejné. Claude Shanon ukázal že těmto požadavkům vyhovuje logaritmická funkce : n H=-k S Pi log 2 Pi [ bit/ symbol ] I =1 Kde konstanta k určuje jednotkovou míru (jednotku měření). Pro svoji podobnost s výrazem pro entropii ve fyzice byla veličina H nazvána informační entropii

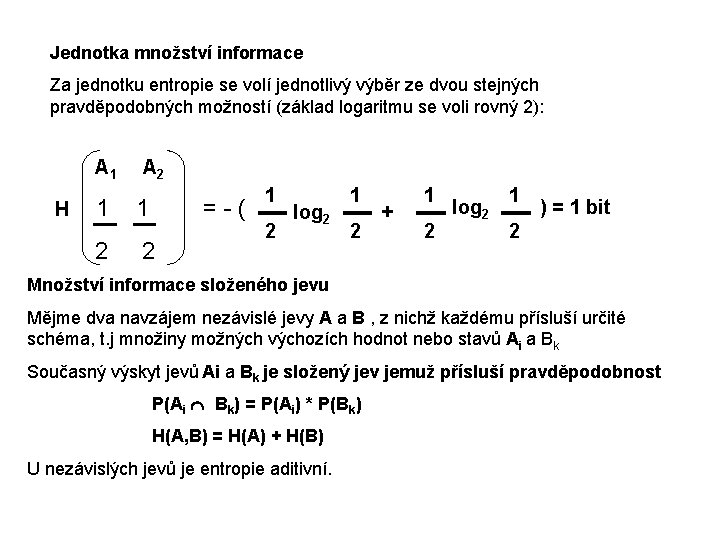

Jednotka množství informace Za jednotku entropie se volí jednotlivý výběr ze dvou stejných pravděpodobných možností (základ logaritmu se voli rovný 2): A 1 H A 2 1 1 =-( 2 2 1 2 log 2 1 2 + 1 2 log 2 1 ) = 1 bit 2 Množství informace složeného jevu Mějme dva navzájem nezávislé jevy A a B , z nichž každému přísluší určité schéma, t. j množiny možných výchozích hodnot nebo stavů Ai a Bk Současný výskyt jevů Ai a Bk je složený jev jemuž přísluší pravděpodobnost P(Ai Ç Bk) = P(Ai) * P(Bk) H(A, B) = H(A) + H(B) U nezávislých jevů je entropie aditivní.

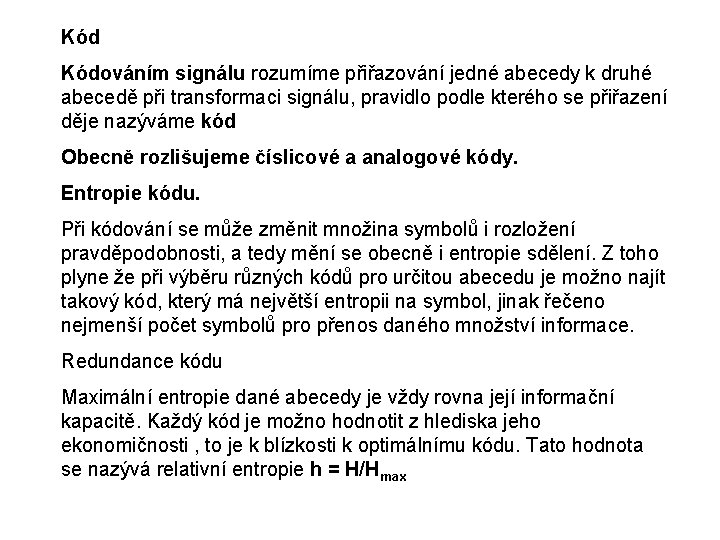

Kód Kódováním signálu rozumíme přiřazování jedné abecedy k druhé abecedě při transformaci signálu, pravidlo podle kterého se přiřazení děje nazýváme kód Obecně rozlišujeme číslicové a analogové kódy. Entropie kódu. Při kódování se může změnit množina symbolů i rozložení pravděpodobnosti, a tedy mění se obecně i entropie sdělení. Z toho plyne že při výběru různých kódů pro určitou abecedu je možno najít takový kód, který má největší entropii na symbol, jinak řečeno nejmenší počet symbolů pro přenos daného množství informace. Redundance kódu Maximální entropie dané abecedy je vždy rovna její informační kapacitě. Každý kód je možno hodnotit z hlediska jeho ekonomičnosti , to je k blízkosti k optimálnímu kódu. Tato hodnota se nazývá relativní entropie h = H/Hmax

Odečteme- li relativní entropii od její maximální hodnoty dostaneme tzv. nadbytečnost čili redundanci kódu“ r=1–h= Hmax - H (0 £ r £ 1) H max Samoopravné kódy Samoopravé kódy samočině indikují případně opravují chyby. Rozdělujeme je na detekční a korekční. Mezi detekční patří na příklad ködy se stálým počtem jedniček, zabezpečení paritou Korekční kódy jsou složitější a je u nich třeba zvýšit proti detekčním zvýšit redundanci to pak umožňuje opravu chyb. Rychlost přenosu sdělovacím kanálem Přenosový kanál přejímá informaci na vstupu z nějakého zdroje informací v podobě signálu. Tyto signály projdou kanálem k jeho výstupu, kde se předají adresátovi. Při průchodu kanálem působí na signál různé rušivé vlivy, které se projevují jako šumy nebo poruchy takže adresát obdrží signál porušený. Tedy entropie signálu na výstupu je větší než na vstupu. Množství informace tedy vcelku vzrostlo, ale její obsah se nezvětšil, neboť doplňková informace je porucha, která nesouvisí s popisovaným jevem.

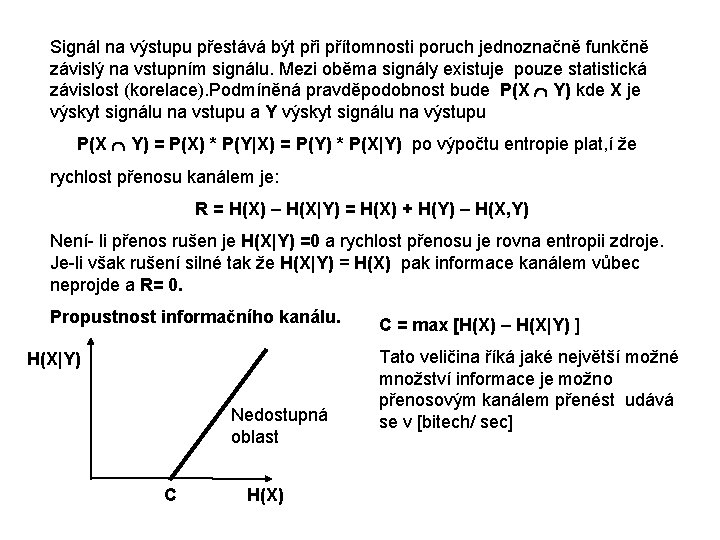

Signál na výstupu přestává být při přítomnosti poruch jednoznačně funkčně závislý na vstupním signálu. Mezi oběma signály existuje pouze statistická závislost (korelace). Podmíněná pravděpodobnost bude P(X Ç Y) kde X je výskyt signálu na vstupu a Y výskyt signálu na výstupu P(X Ç Y) = P(X) * P(Y|X) = P(Y) * P(X|Y) po výpočtu entropie plat, í že rychlost přenosu kanálem je: R = H(X) – H(X|Y) = H(X) + H(Y) – H(X, Y) Není- li přenos rušen je H(X|Y) =0 a rychlost přenosu je rovna entropii zdroje. Je-li však rušení silné tak že H(X|Y) = H(X) pak informace kanálem vůbec neprojde a R= 0. Propustnost informačního kanálu. H(X|Y) Nedostupná oblast C H(X) C = max [H(X) – H(X|Y) ] Tato veličina říká jaké největší možné množství informace je možno přenosovým kanálem přenést udává se v [bitech/ sec]

![Shenonova věta definuje propustnost kanálu pro bílý šum C Df log 2 PNN P Shenonova věta definuje propustnost kanálu pro bílý šum C= Df *log 2 [(P+N)/N] P.](https://slidetodoc.com/presentation_image_h2/a13dee49d33fca1ffb2dd32ebf577bff/image-22.jpg)

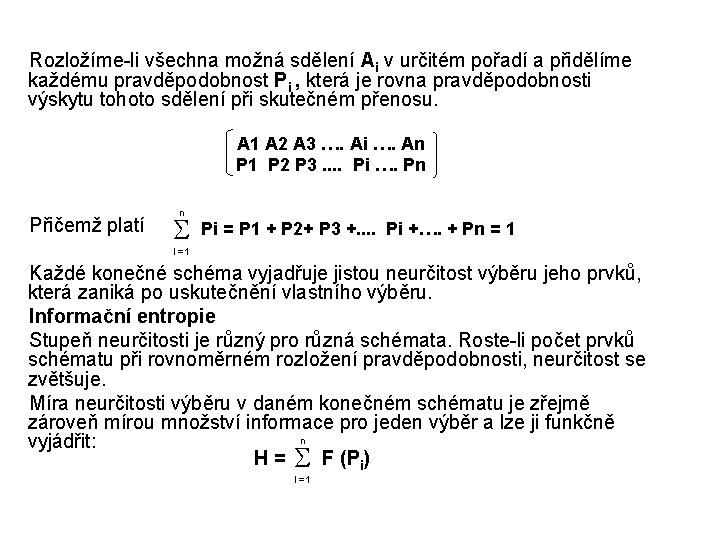

Shenonova věta definuje propustnost kanálu pro bílý šum C= Df *log 2 [(P+N)/N] P. . je střední výkon signálu N. . je střední výkon šumu Df je šíře pásma propustnosti kanálu Přenos signálu Modulace Modulací rozumíme časovou změnu jednho z parametrů, tj. veličin charakterizujících fyzikální pochod nesoucí informaci. Nejčastěji to bývá změna výkonu přenášeného vlněním.

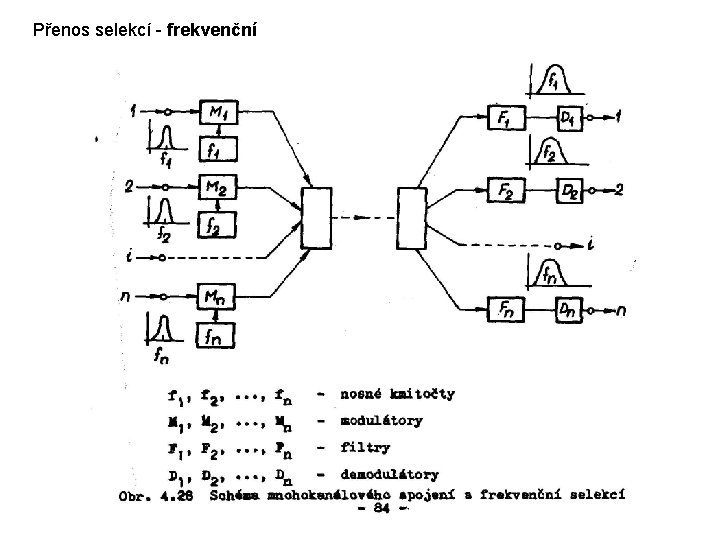

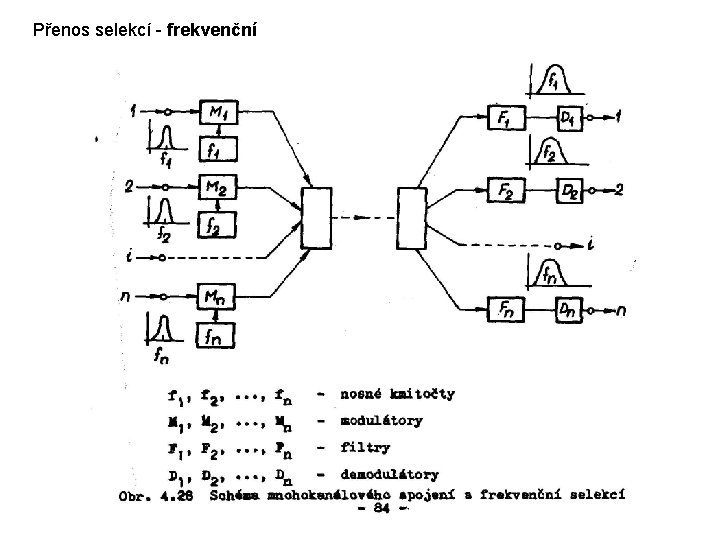

Přenos selekcí - frekvenční

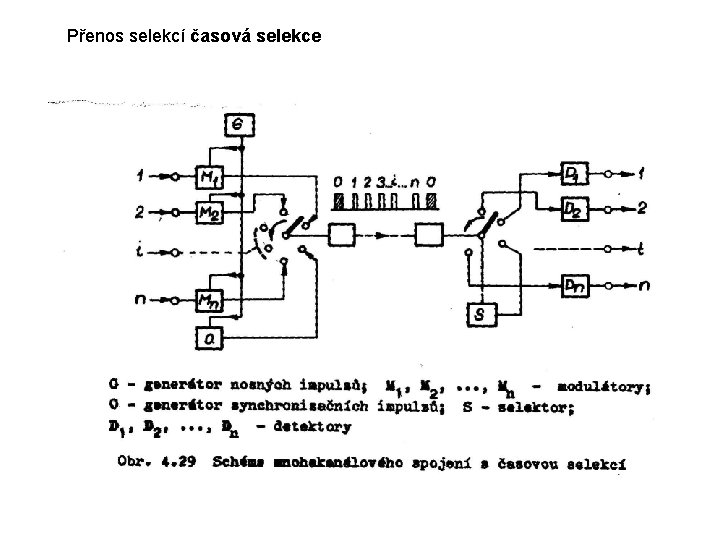

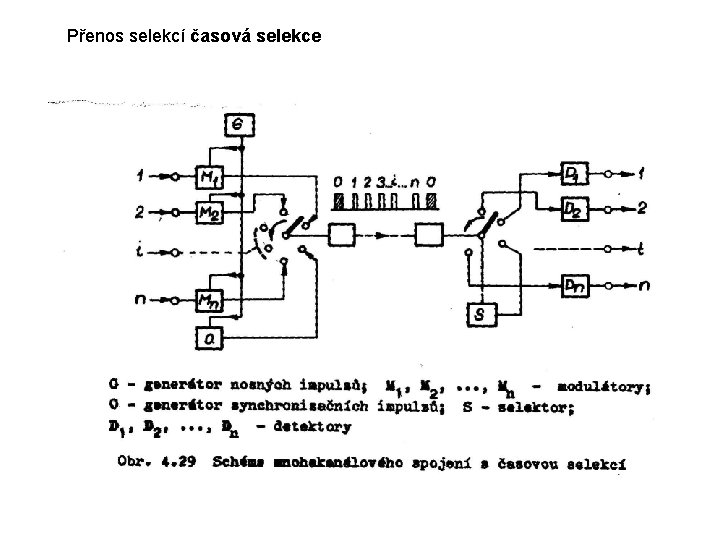

Přenos selekcí časová selekce

Klasifikace automatů Technický automatem rozumíme zařízení schopné samostatné činnosti, které ve větší nebo menší míře má vlastnost samostatně řídit. Technicky automaty dělíme na: 1. automaty nižších stupňů , jejichž činnost je přesně determinována, proto bývají nazývány automaty deterministické; • automaty které pracují s otevřeným obvodem řízení – automatické ovládání; • Automaty, které pracují s uzavřeným obvodem řízení - regulátory 2. automaty vyšších stupňů, které jsou schopny samočinně vyhledávat cestu ke splnění úkolu, resp. samočinně se přizpůsobit změněným podmínkám činnosti. Jsou charakterizovány těmito vlastnostmi: • jsou to složité systémy, které pracují vždy v uzavřeném obvodu řízení. • Jejich činnost není přesně determinována Ke své činnosti potřebují : • obvody logické povahy; • Paměť; • Zařízení pro vyhledávání cesty k řešení úkolů, čímž se kvalitativně liší od automatů s detrminovannou činností.

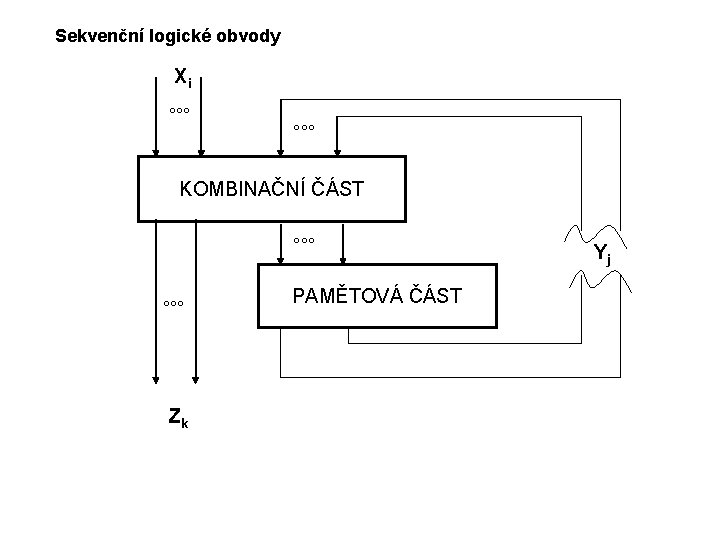

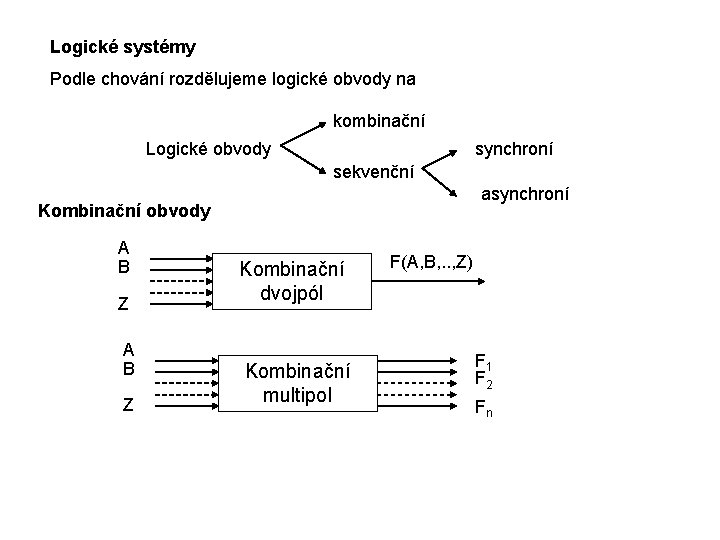

Logické systémy Podle chování rozdělujeme logické obvody na kombinační Logické obvody synchroní sekvenční asynchroní Kombinační obvody A B Z Kombinační dvojpól Kombinační multipol F(A, B, . . , Z) F 1 F 2 Fn

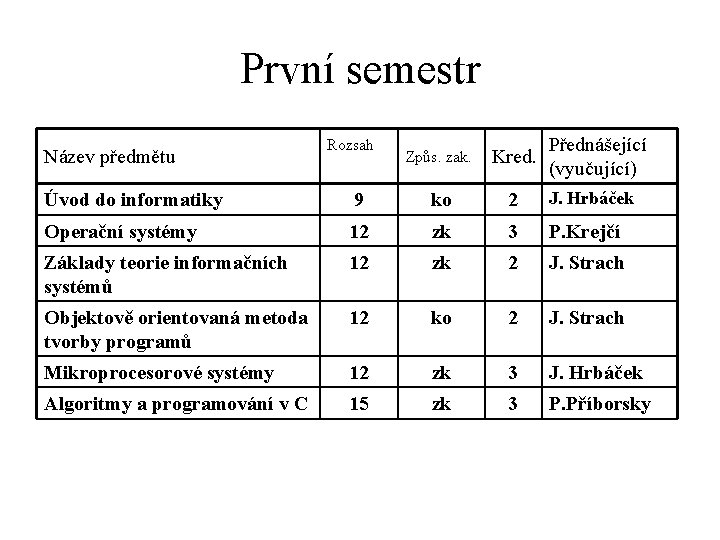

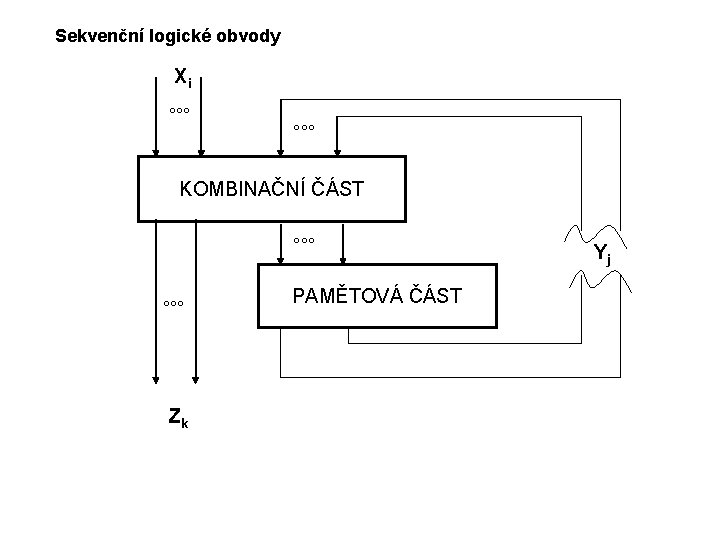

Sekvenční logické obvody Xi °°° KOMBINAČNÍ ČÁST °°° Zk PAMĚTOVÁ ČÁST Yj