SVMs Sparateurs Vastes Marges et Mthodes noyaux Laurent

- Slides: 63

SVMs (Séparateurs à Vastes Marges) et Méthodes à noyaux Laurent Orseau Agro. Paris. Tech laurent. orseau@agroparistech. fr à partir des transparents d'Antoine Cornuéjols Cours SVM

Plan 1 - Induction Les SVMs • Principe 2 - • Problème associé Méthodes à noyaux • Fonctions noyau 3 - . Illustration. Marge douce Mise en œuvre 4 - • Validation Induction Les SVMs Les méthodes à noyau Mise en œuvre • Construction de noyaux 5 - Applications 6 - Bilan Applications Bilan Cours SVM (L. Orseau) 2/86

Apprentissage inductif supervisé Induction Les SVMs • Principe À partir de l’échantillon d’apprentissage S = {(xi, ui)}1, m on cherche à identifier une loi de dépendance sous-jacente • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration m . Marge douce (fonction cible) tq : ui = f(xi) Mise en œuvre • Validation • Construction de Par exemple une fonction h aussi proche possible de f m noyaux Ou bien de la distribution de probabilités P(xi, ui) Applications Bilan afin de prédire l’avenir Cours SVM (L. Orseau) 3/86

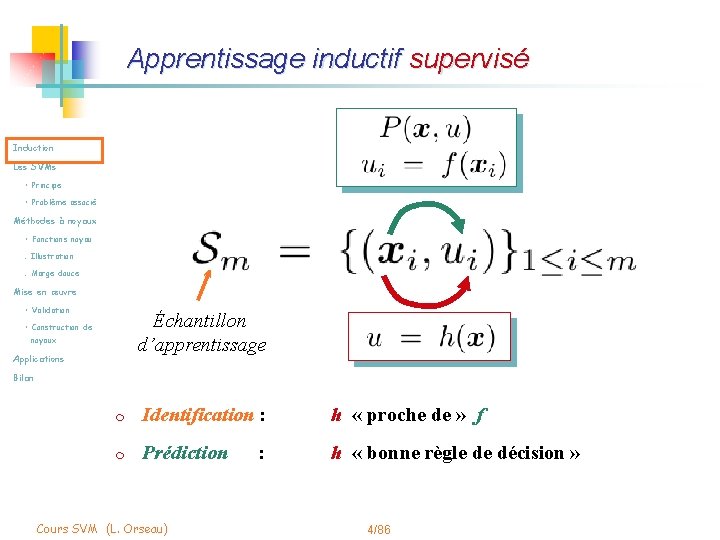

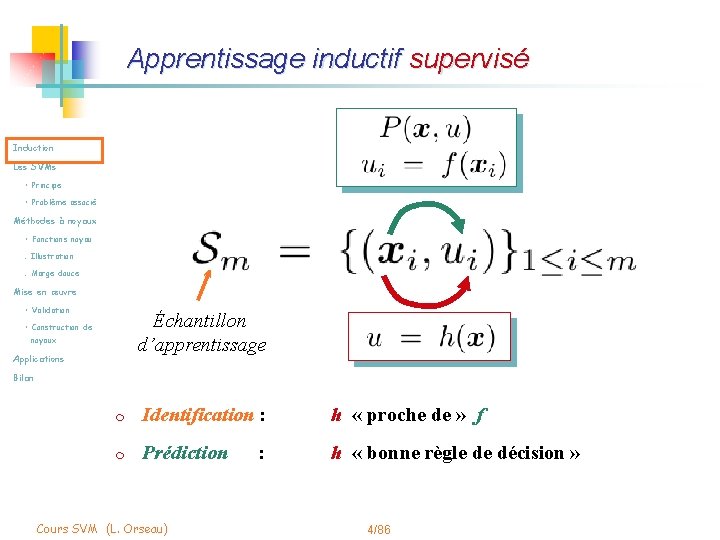

Apprentissage inductif supervisé Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation Échantillon d’apprentissage • Construction de noyaux Applications Bilan m Identification : h « proche de » f m Prédiction : h « bonne règle de décision » Cours SVM (L. Orseau) 4/86

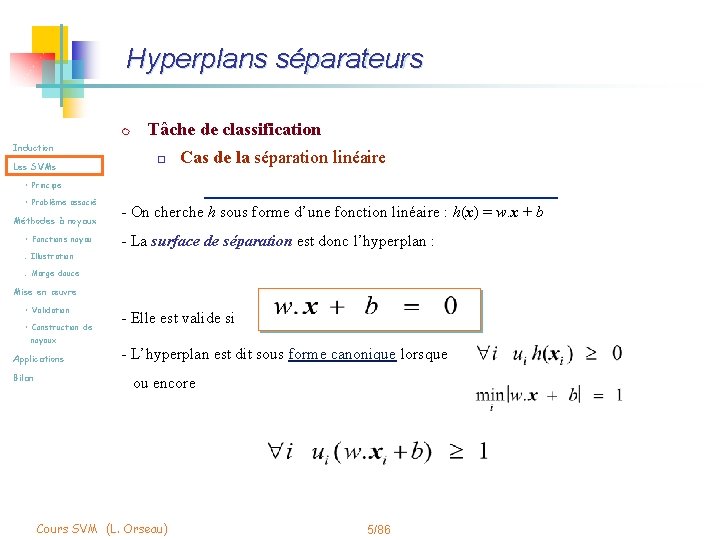

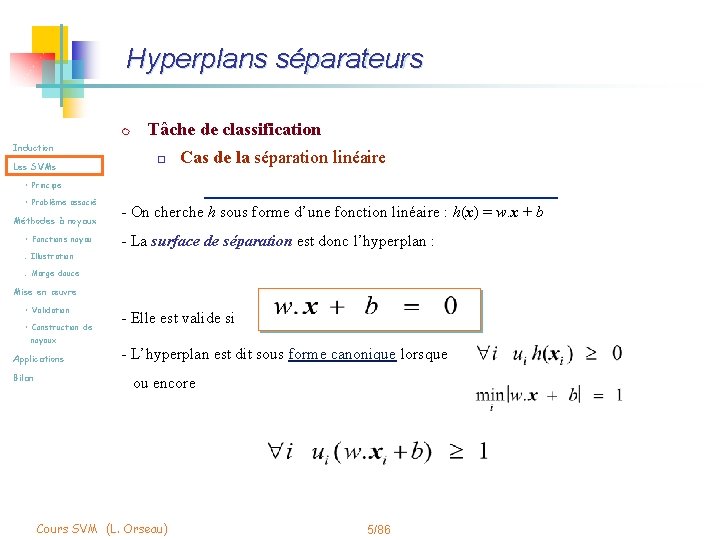

Hyperplans séparateurs m Tâche de classification Induction Les SVMs o Cas de la séparation linéaire • Principe • Problème associé Méthodes à noyaux • Fonctions noyau - On cherche h sous forme d’une fonction linéaire : h(x) = w. x + b - La surface de séparation est donc l’hyperplan : . Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan - Elle est valide si - L’hyperplan est dit sous forme canonique lorsque ou encore Cours SVM (L. Orseau) 5/86

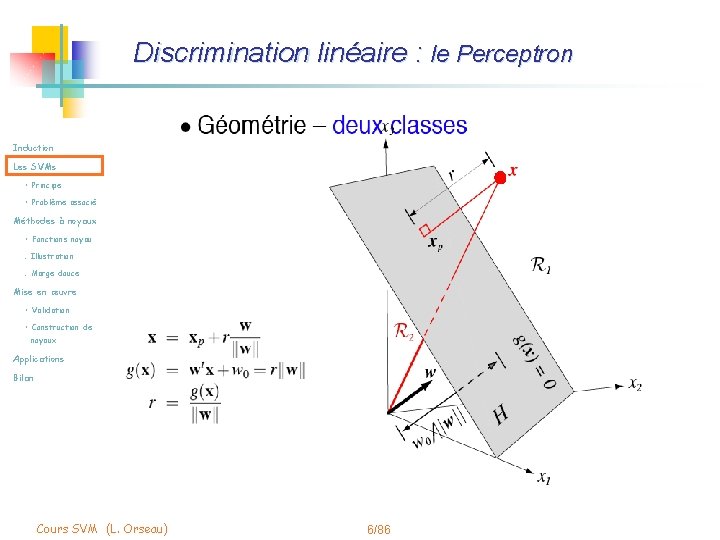

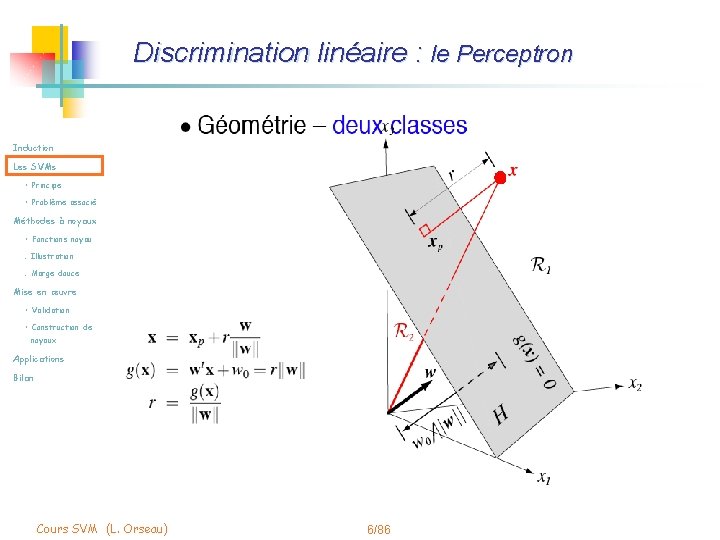

Discrimination linéaire : le Perceptron Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 6/86

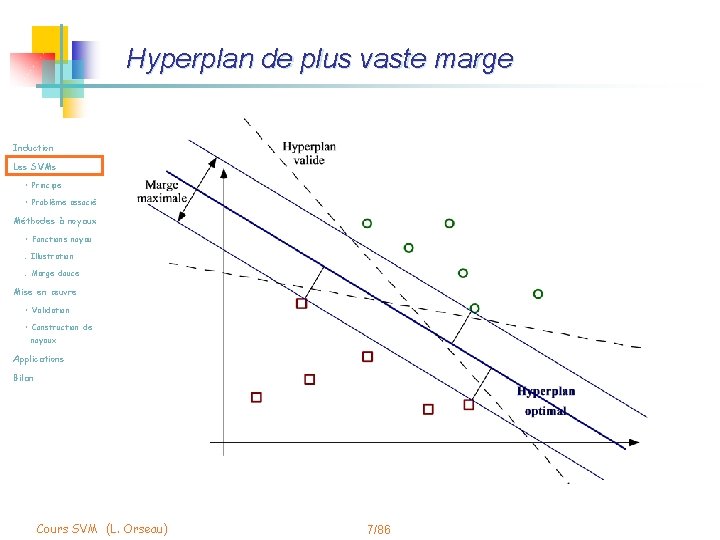

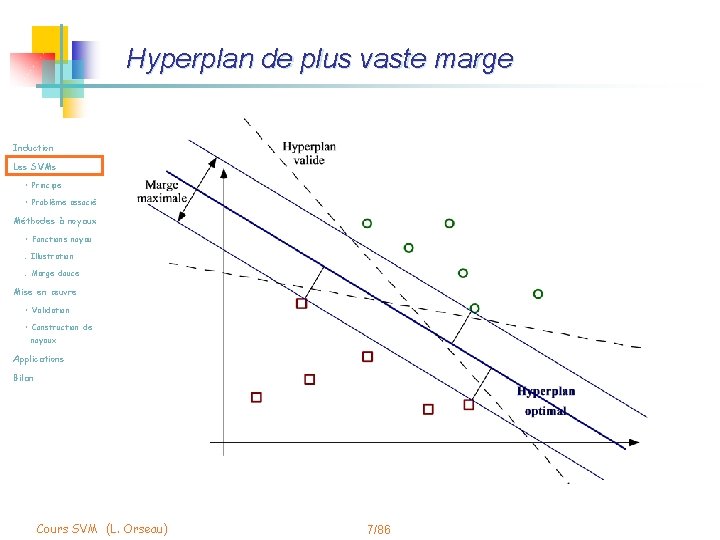

Hyperplan de plus vaste marge Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 7/86

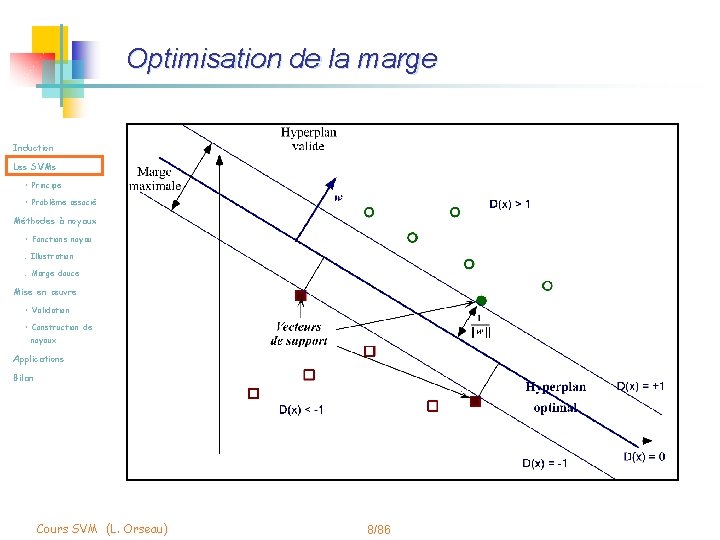

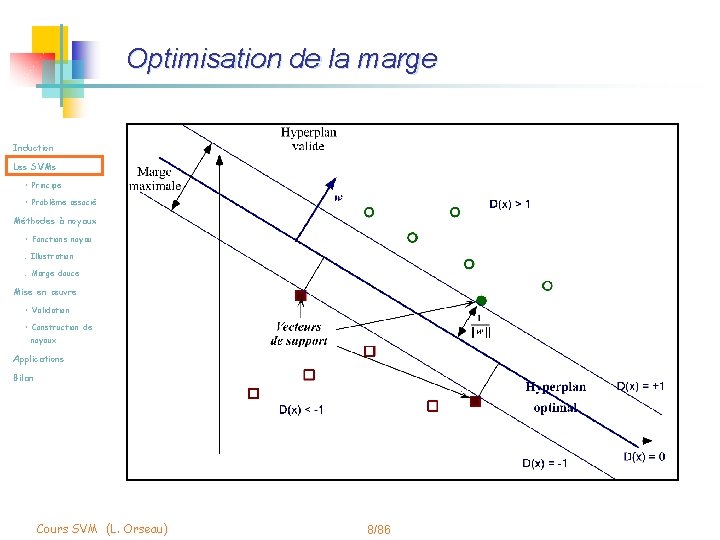

Optimisation de la marge Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 8/86

Optimisation de la marge m La distance d’un point à l’hyperplan est : m L’hyperplan optimal est celui pour lequel la distance aux points les plus Induction Les SVMs • Principe • Problème associé proches (marge) est maximale. Cette distance vaut Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce m Maximiser la marge revient donc à minimiser ||w|| sous contraintes: Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 9/86

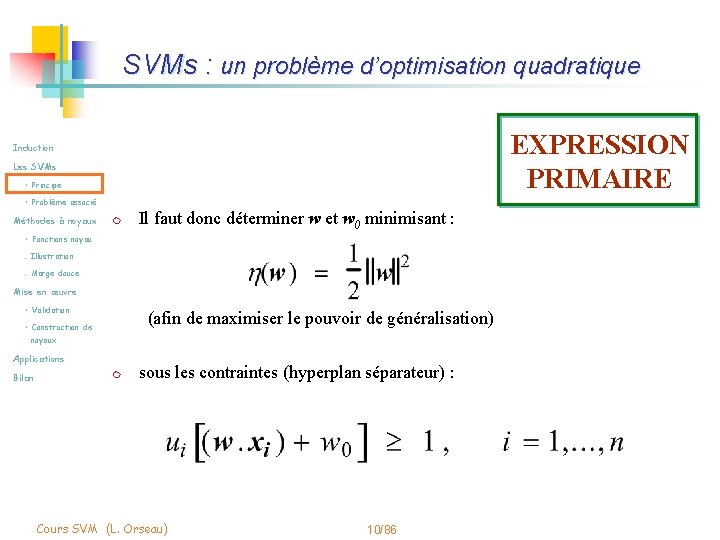

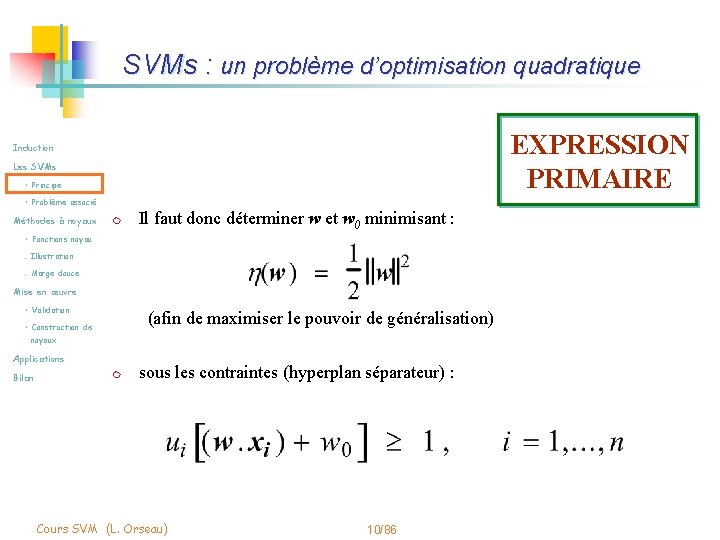

SVMs : un problème d’optimisation quadratique EXPRESSION PRIMAIRE Induction Les SVMs • Principe • Problème associé Méthodes à noyaux m • Fonctions noyau Il faut donc déterminer w et w 0 minimisant : . Illustration. Marge douce Mise en œuvre • Validation (afin de maximiser le pouvoir de généralisation) • Construction de noyaux Applications Bilan m sous les contraintes (hyperplan séparateur) : Cours SVM (L. Orseau) 10/86

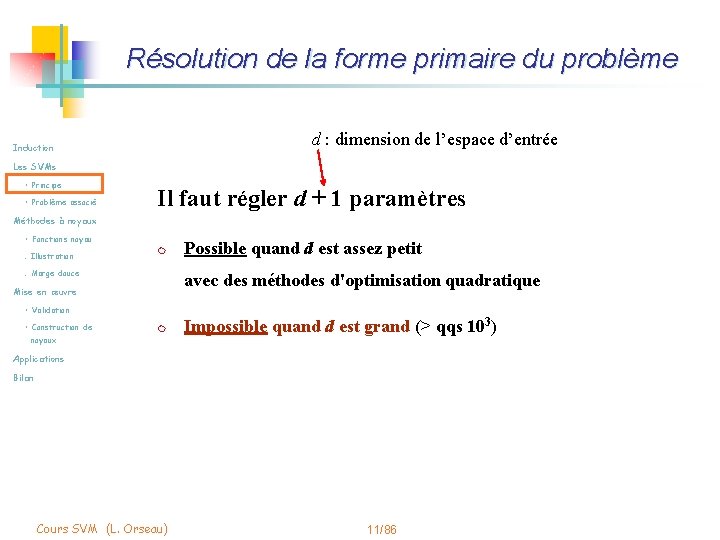

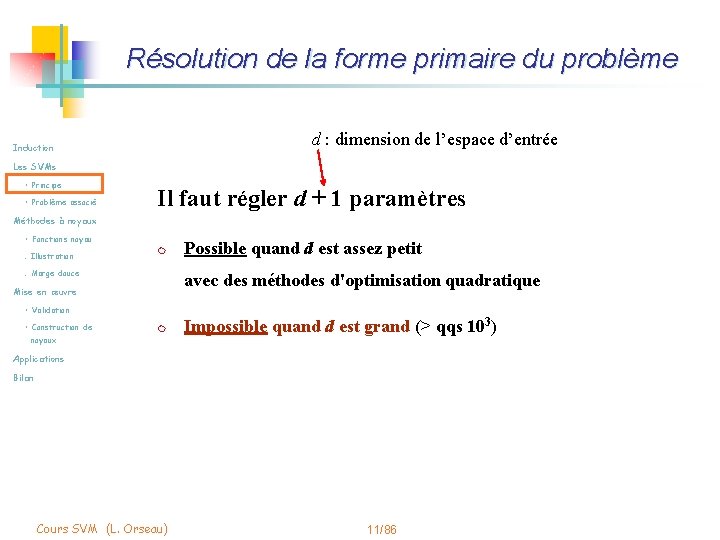

Résolution de la forme primaire du problème d : dimension de l’espace d’entrée Induction Les SVMs • Principe • Problème associé Il faut régler d + 1 paramètres Méthodes à noyaux • Fonctions noyau. Illustration m . Marge douce Possible quand d est assez petit avec des méthodes d'optimisation quadratique Mise en œuvre • Validation • Construction de m noyaux Impossible quand d est grand (> qqs 103) Applications Bilan Cours SVM (L. Orseau) 11/86

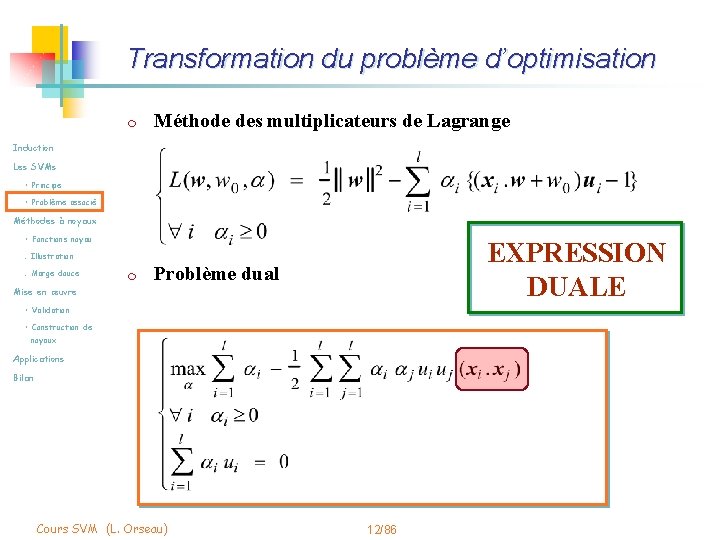

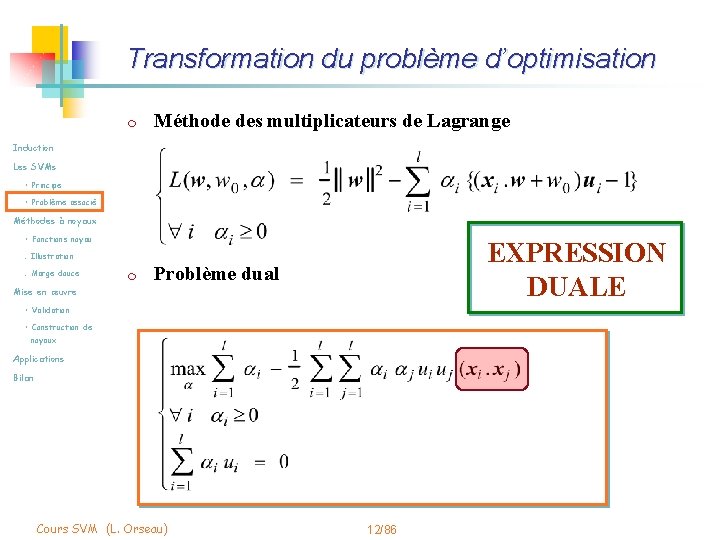

Transformation du problème d’optimisation m Méthode des multiplicateurs de Lagrange Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau EXPRESSION DUALE . Illustration. Marge douce m Problème dual Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 12/86

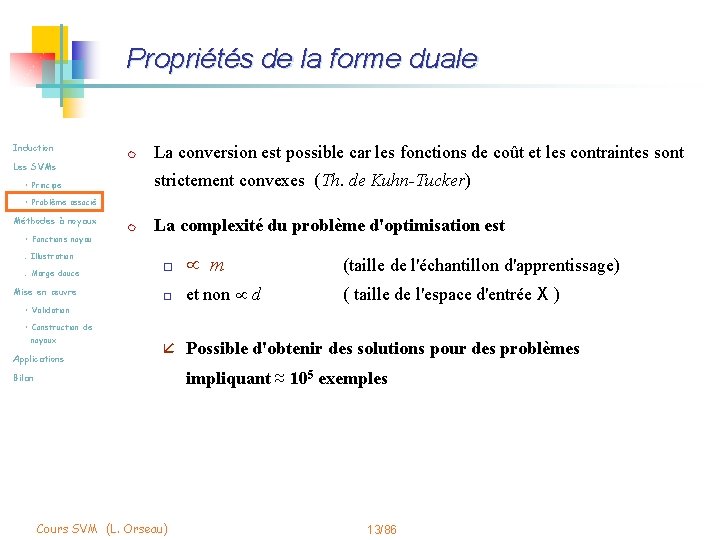

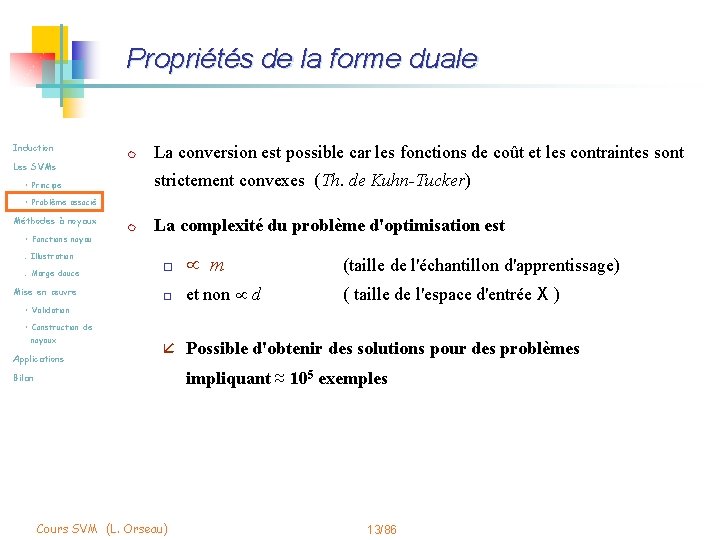

Propriétés de la forme duale Induction m Les SVMs La conversion est possible car les fonctions de coût et les contraintes sont strictement convexes (Th. de Kuhn-Tucker) • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre m La complexité du problème d'optimisation est o µ m (taille de l'échantillon d'apprentissage) o et non µ d ( taille de l'espace d'entrée X ) • Validation • Construction de noyaux Applications å Possible d'obtenir des solutions pour des problèmes impliquant ≈ 105 exemples Bilan Cours SVM (L. Orseau) 13/86

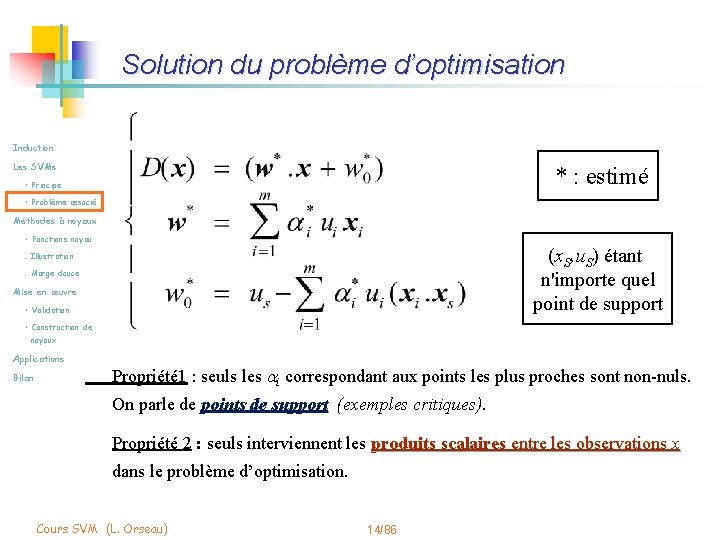

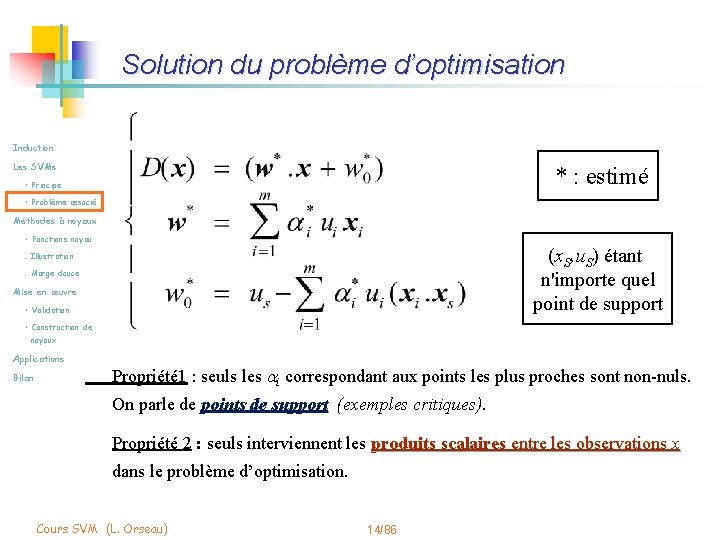

Solution du problème d’optimisation Induction Les SVMs * : estimé • Principe • Problème associé Méthodes à noyaux • Fonctions noyau (x. S, u. S) étant n'importe quel point de support . Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Propriété 1 : seuls les i correspondant aux points les plus proches sont non-nuls. On parle de points de support (exemples critiques). Propriété 2 : seuls interviennent les produits scalaires entre les observations x dans le problème d’optimisation. Cours SVM (L. Orseau) 14/86

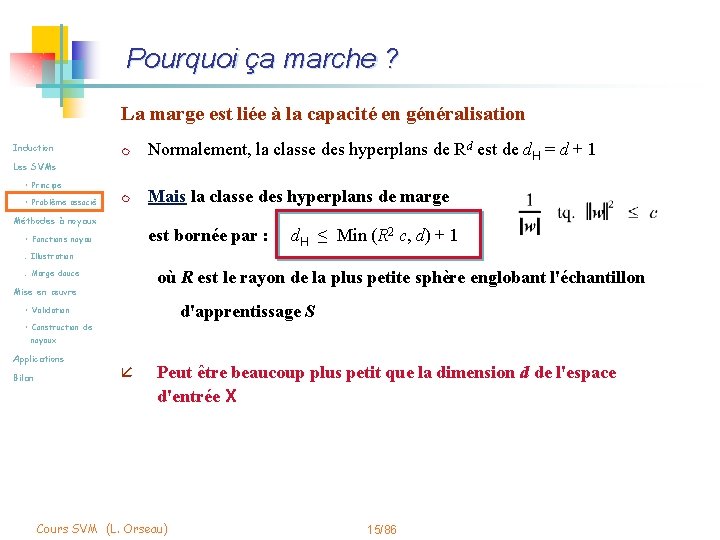

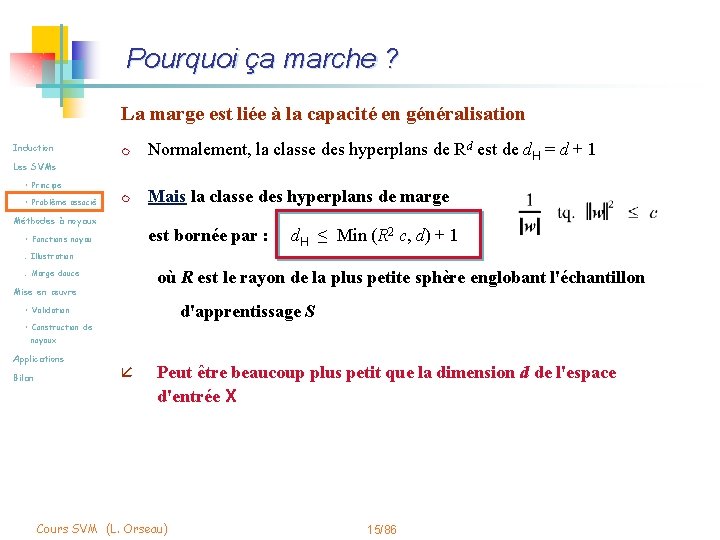

Pourquoi ça marche ? La marge est liée à la capacité en généralisation Induction m Normalement, la classe des hyperplans de Rd est de d. H = d + 1 m Mais la classe des hyperplans de marge Les SVMs • Principe • Problème associé Méthodes à noyaux est bornée par : d. H ≤ Min (R 2 c, d) + 1 • Fonctions noyau. Illustration où R est le rayon de la plus petite sphère englobant l'échantillon . Marge douce Mise en œuvre d'apprentissage S • Validation • Construction de noyaux Applications Bilan å Peut être beaucoup plus petit que la dimension d de l'espace d'entrée X Cours SVM (L. Orseau) 15/86

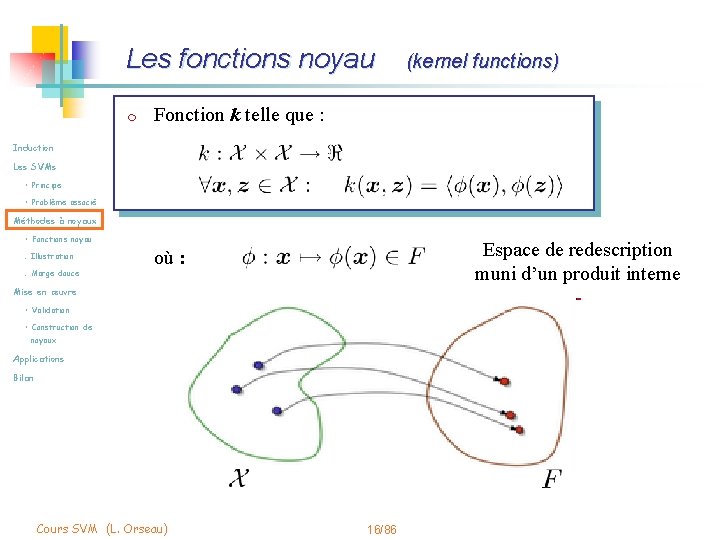

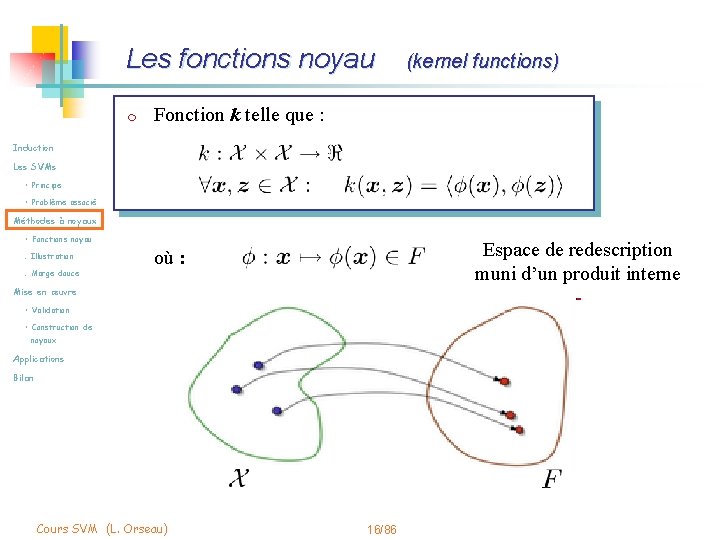

Les fonctions noyau m (kernel functions) Fonction k telle que : Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Espace de redescription muni d’un produit interne où : Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 16/86

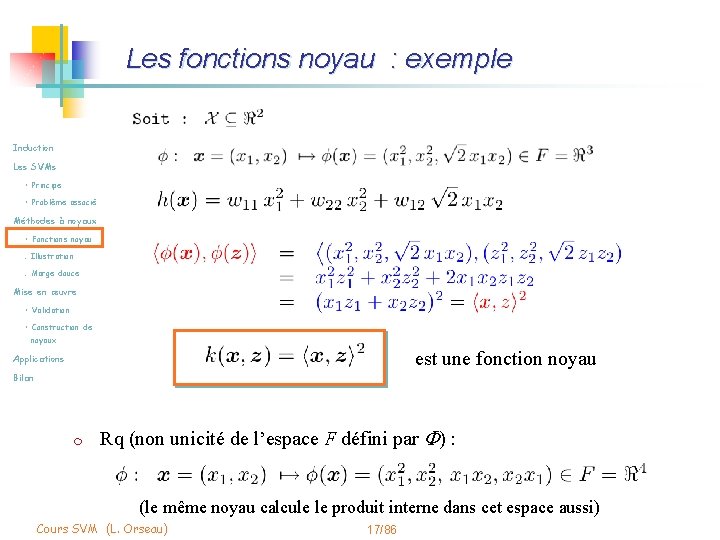

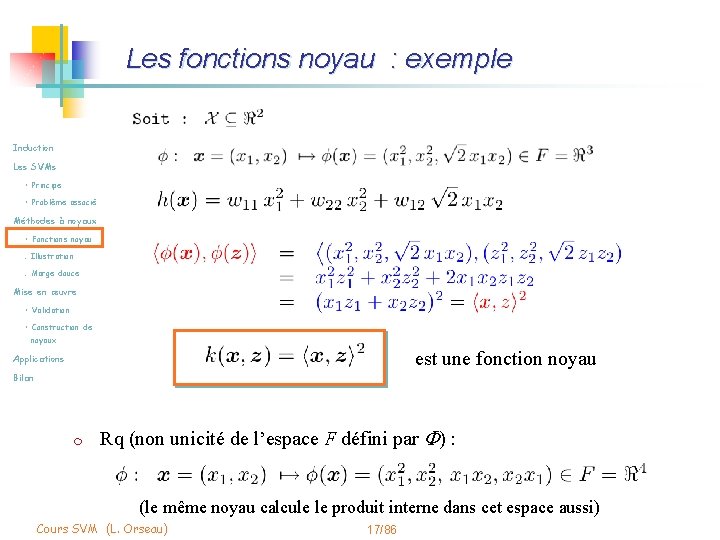

Les fonctions noyau : exemple Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux est une fonction noyau Applications Bilan m Rq (non unicité de l’espace F défini par F) : (le même noyau calcule le produit interne dans cet espace aussi) Cours SVM (L. Orseau) 17/86

Les méthodes à noyau m Induction Modularité o Les SVMs • Principe • Problème associé Découplage entre m Les algorithmes (linéaires) m La description des données Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 18/86

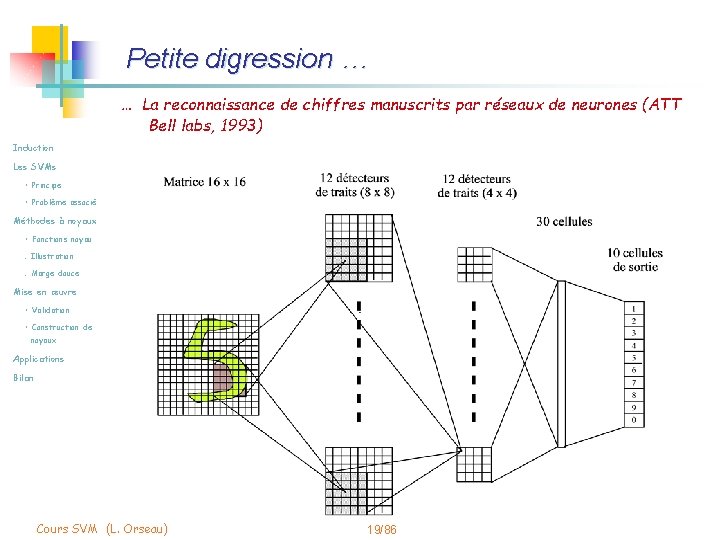

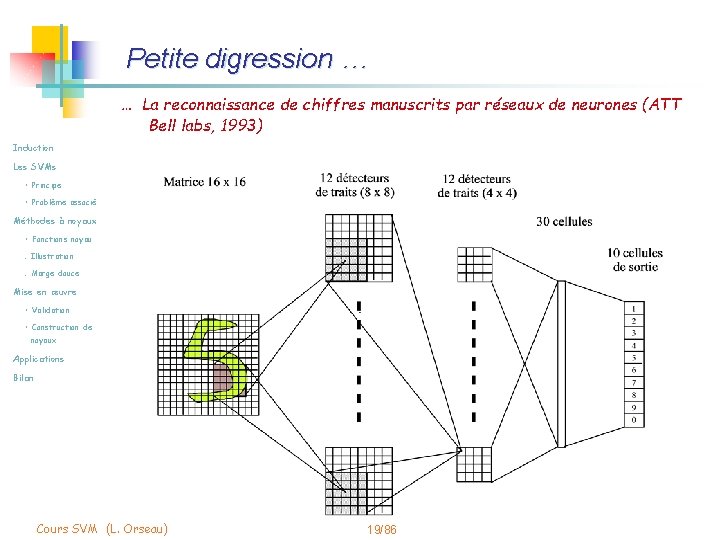

Petite digression … … La reconnaissance de chiffres manuscrits par réseaux de neurones (ATT Bell labs, 1993) Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 19/86

Leçons (provisoires) Induction Les SVMs L’emploi de fonctions noyau permet : • Principe • Problème associé o Méthodes à noyaux D’utiliser les algorithmes de recherche de régularités linéaires pour la recherche de régularités non linéaires • Fonctions noyau. Illustration. Marge douce Mise en œuvre o D’employer ces algorithmes même sur des données non vectorielles (du moment que l’on sait trouver une fonction • Validation • Construction de noyaux noyau adéquate) Applications Bilan o De redécrire implicitement les données dans des espaces de grande dimension sans en avoir le coût computationnel dimension Cours SVM (L. Orseau) 20/86

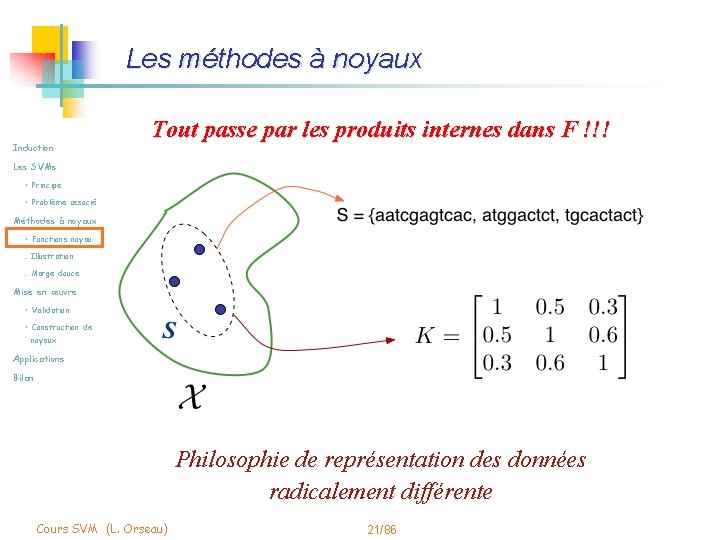

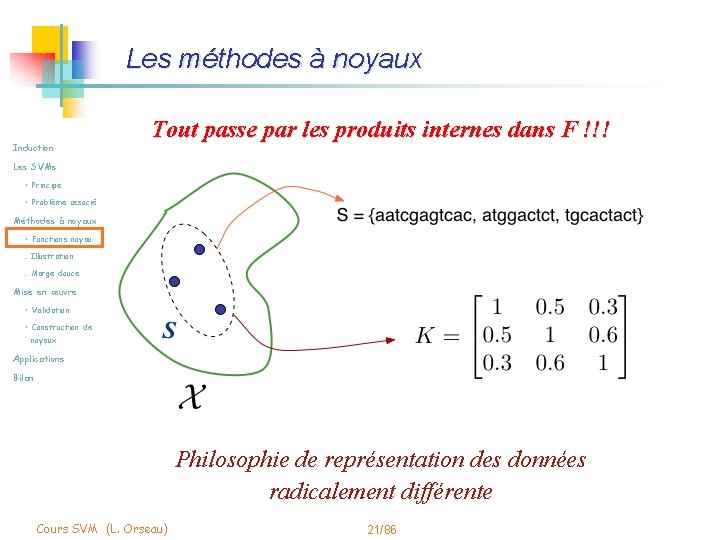

Les méthodes à noyaux Induction Tout passe par les produits internes dans F !!! Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Philosophie de représentation des données radicalement différente Cours SVM (L. Orseau) 21/86

Conséquences d’une représentation par noyau Induction Les SVMs m Des informations sont perdues • Principe • Problème associé o Orientation (invariance de la matrice K par rotation) o Alignement des données avec les axes (idem) Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 22/86

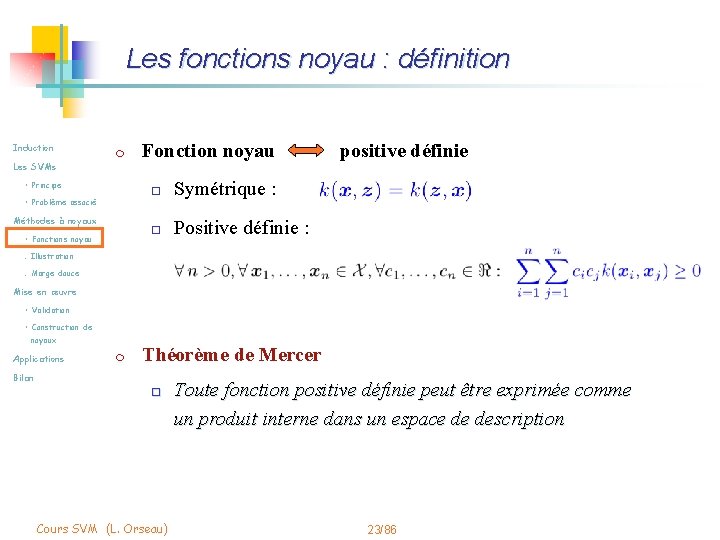

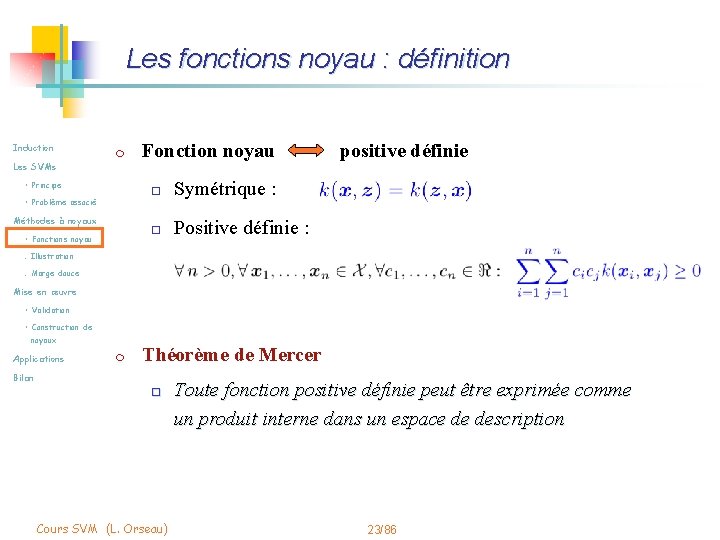

Les fonctions noyau : définition Induction m Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau Fonction noyau positive définie o Symétrique : o Positive définie : . Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications m Théorème de Mercer Bilan o Cours SVM (L. Orseau) Toute fonction positive définie peut être exprimée comme un produit interne dans un espace de description 23/86

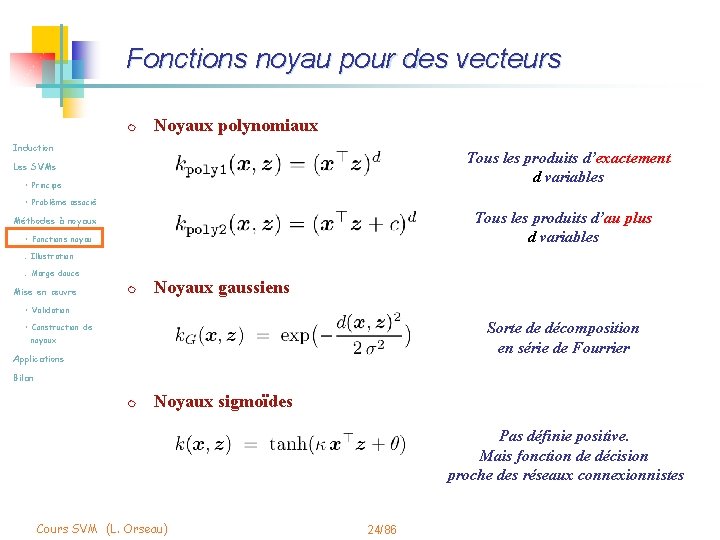

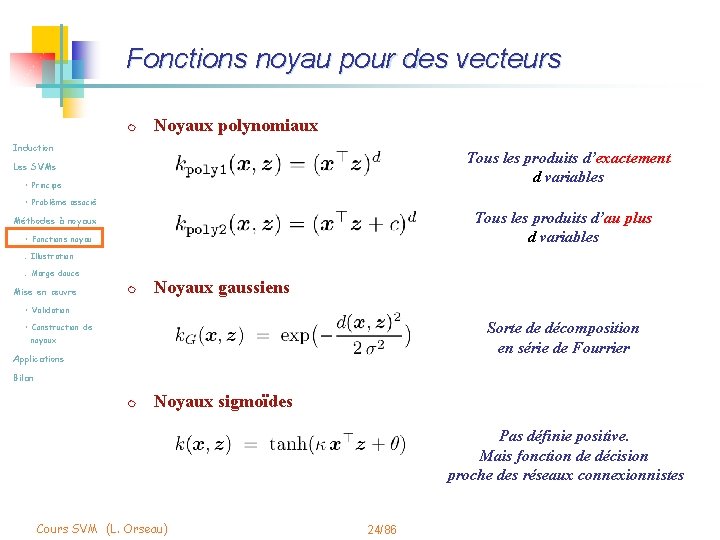

Fonctions noyau pour des vecteurs m Noyaux polynomiaux Induction Tous les produits d’exactement d variables Les SVMs • Principe • Problème associé Tous les produits d’au plus d variables Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre m Noyaux gaussiens • Validation Sorte de décomposition en série de Fourrier • Construction de noyaux Applications Bilan m Noyaux sigmoïdes Pas définie positive. Mais fonction de décision proche des réseaux connexionnistes Cours SVM (L. Orseau) 24/86

Morale Induction Les SVMs • Principe m Les données s’expriment à travers la matrice noyau • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de m La matrice noyau contrôle la régularisation du risque noyaux Applications Bilan Cours SVM (L. Orseau) 25/86

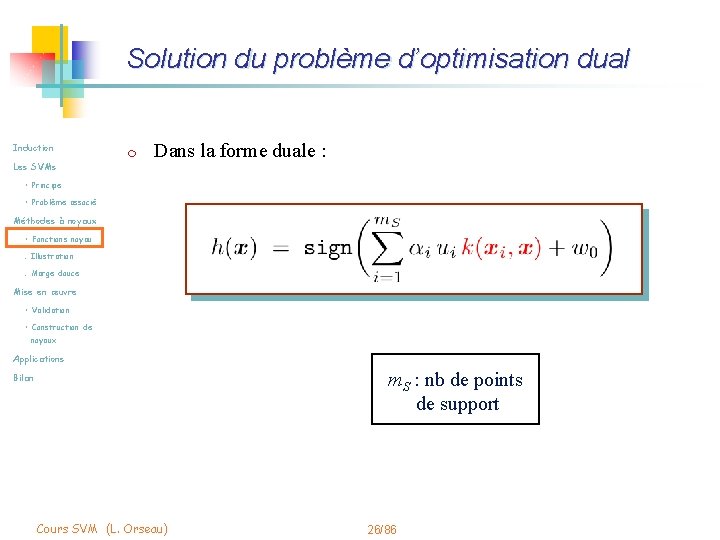

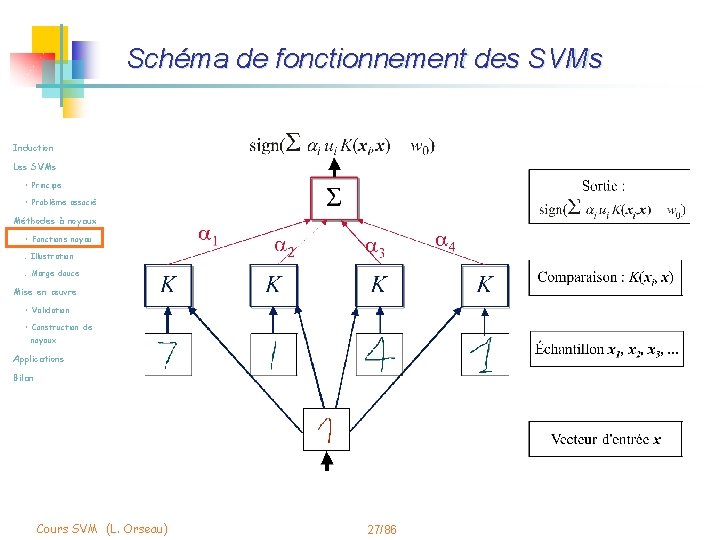

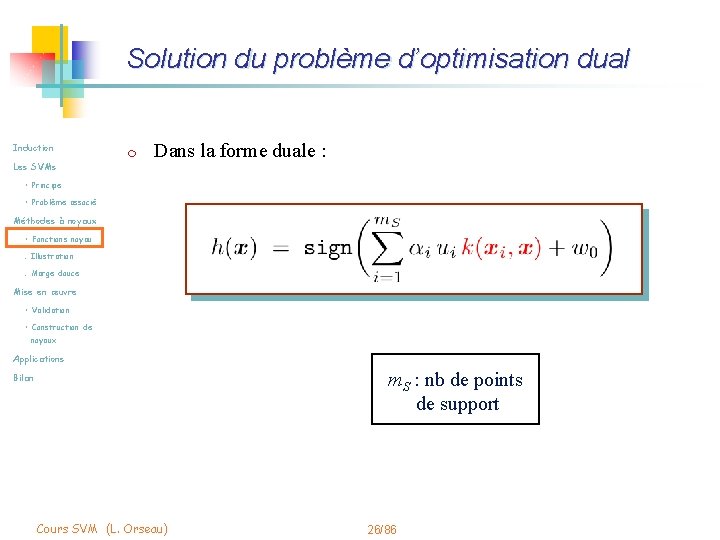

Solution du problème d’optimisation dual Induction Les SVMs m Dans la forme duale : • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications m. S : nb de points de support Bilan Cours SVM (L. Orseau) 26/86

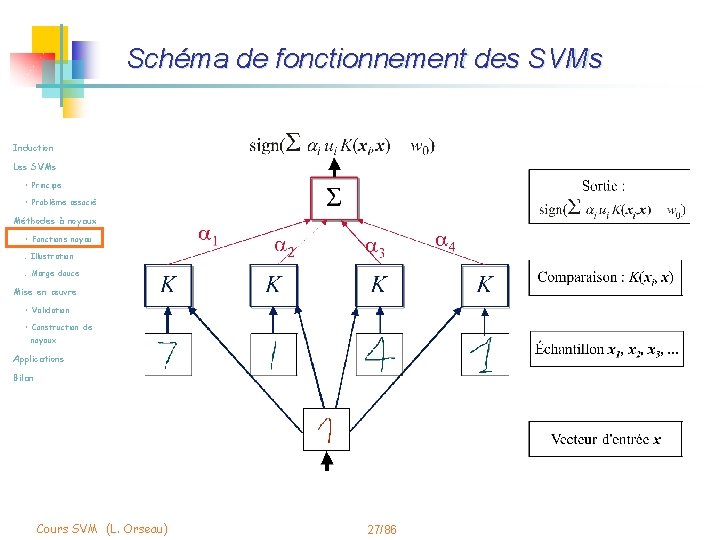

Schéma de fonctionnement des SVMs Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 27/86

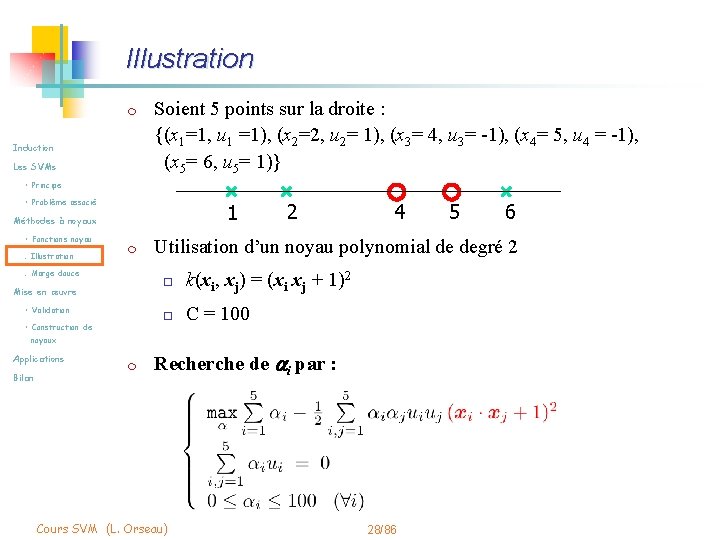

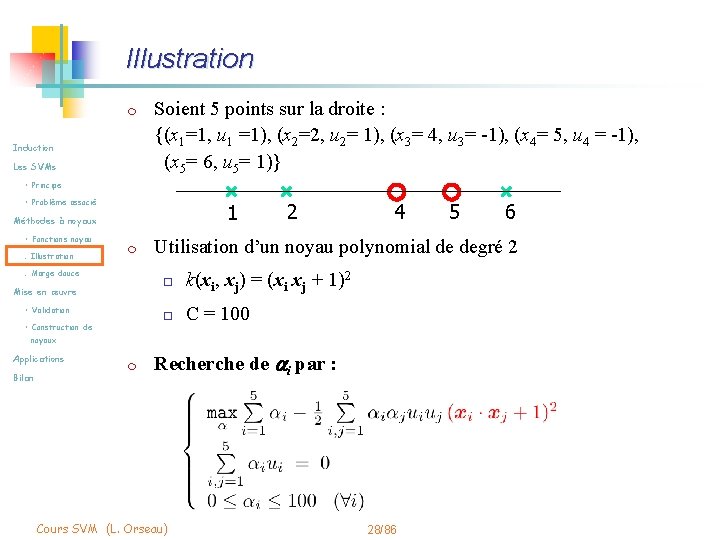

Illustration m Induction Les SVMs Soient 5 points sur la droite : {(x 1=1, u 1 =1), (x 2=2, u 2= 1), (x 3= 4, u 3= -1), (x 4= 5, u 4 = -1), (x 5= 6, u 5= 1)} • Principe • Problème associé 1 Méthodes à noyaux • Fonctions noyau. Illustration m . Marge douce Mise en œuvre • Validation • Construction de 2 4 Bilan m 6 Utilisation d’un noyau polynomial de degré 2 o k(xi, xj) = (xi xj + 1)2 o C = 100 noyaux Applications 5 Recherche de ai par : Cours SVM (L. Orseau) 28/86

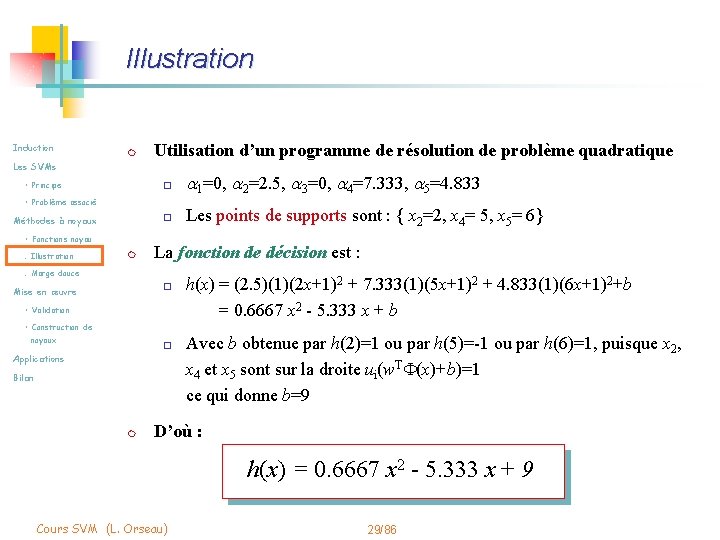

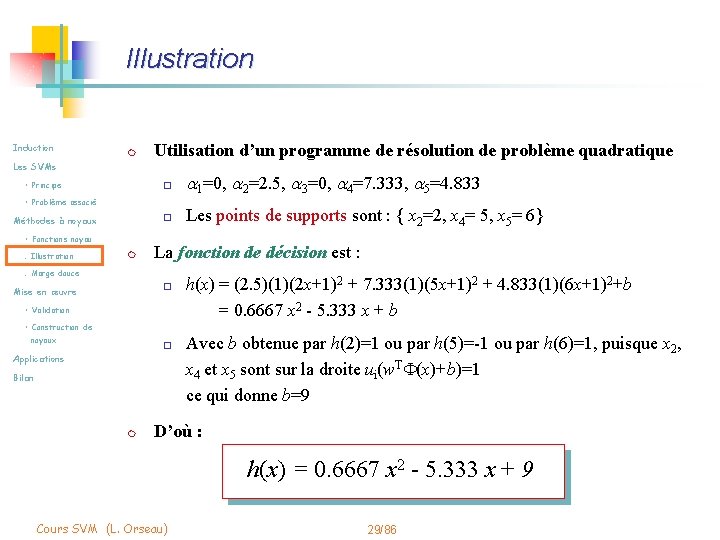

Illustration Induction m Les SVMs • Principe Utilisation d’un programme de résolution de problème quadratique o 1=0, 2=2. 5, 3=0, 4=7. 333, 5=4. 833 o Les points de supports sont : { x 2=2, x 4= 5, x 5= 6} • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration m La fonction de décision est : . Marge douce o Mise en œuvre • Validation h(x) = (2. 5)(1)(2 x+1)2 + 7. 333(1)(5 x+1)2 + 4. 833(1)(6 x+1)2+b = 0. 6667 x 2 - 5. 333 x + b • Construction de noyaux o Applications Bilan m Avec b obtenue par h(2)=1 ou par h(5)=-1 ou par h(6)=1, puisque x 2, x 4 et x 5 sont sur la droite ui(w. TF(x)+b)=1 ce qui donne b=9 D’où : h(x) = 0. 6667 x 2 - 5. 333 x + 9 Cours SVM (L. Orseau) 29/86

Illustration Valeur de la fonction discriminante Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation classe 1 classe 2 • Construction de noyaux Applications 1 Bilan 2 4 5 6 {x=2, x=5, x=6} sont points supports Cours SVM (L. Orseau) 30/86

Séparation linéaire dans l'espace des features Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 31/86

Illustration : le cas du XOR Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 32/86

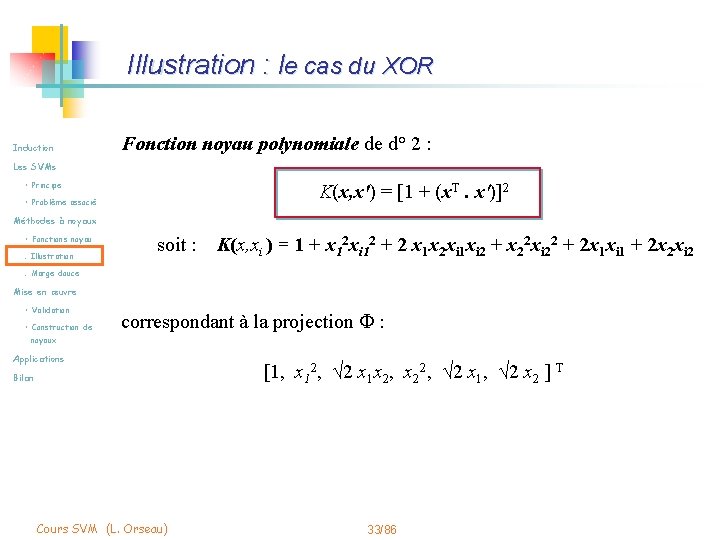

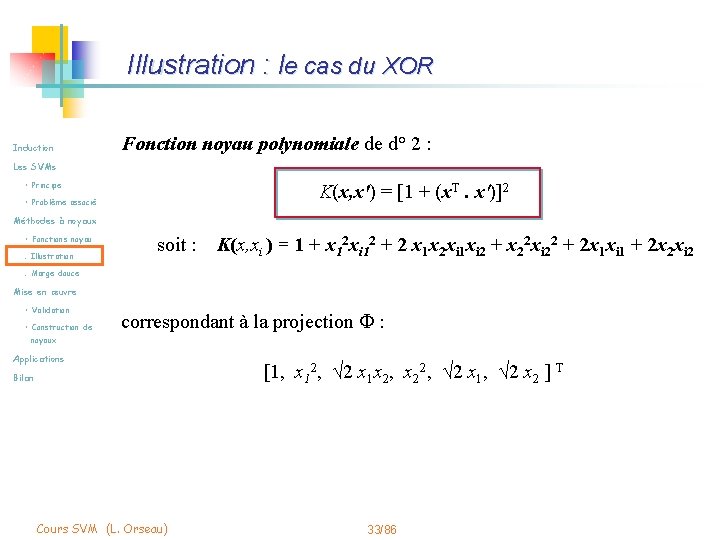

Illustration : le cas du XOR Induction Fonction noyau polynomiale de d° 2 : Les SVMs • Principe K(x, x') = [1 + (x. T. x')]2 • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration soit : K(x, xi ) = 1 + x 12 xi 12 + 2 x 1 x 2 xi 1 xi 2 + x 22 xi 22 + 2 x 1 xi 1 + 2 x 2 xi 2 . Marge douce Mise en œuvre • Validation • Construction de correspondant à la projection F : noyaux Applications Bilan Cours SVM (L. Orseau) [1, x 12, √ 2 x 1 x 2, x 22, √ 2 x 1, √ 2 x 2 ] T 33/86

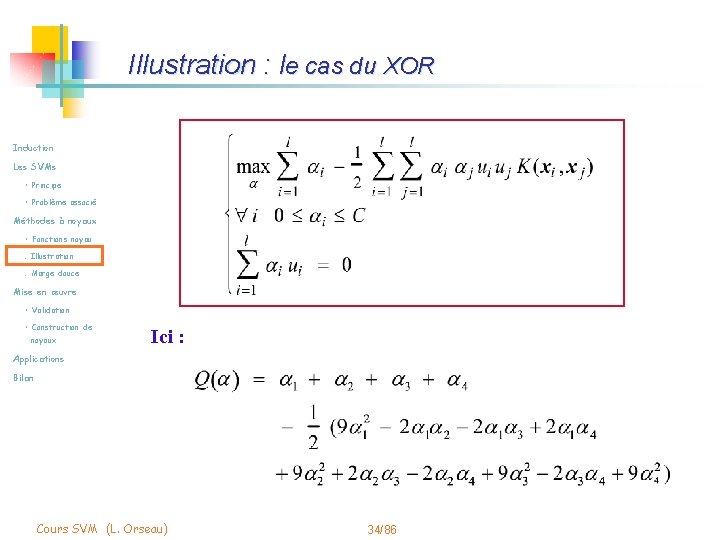

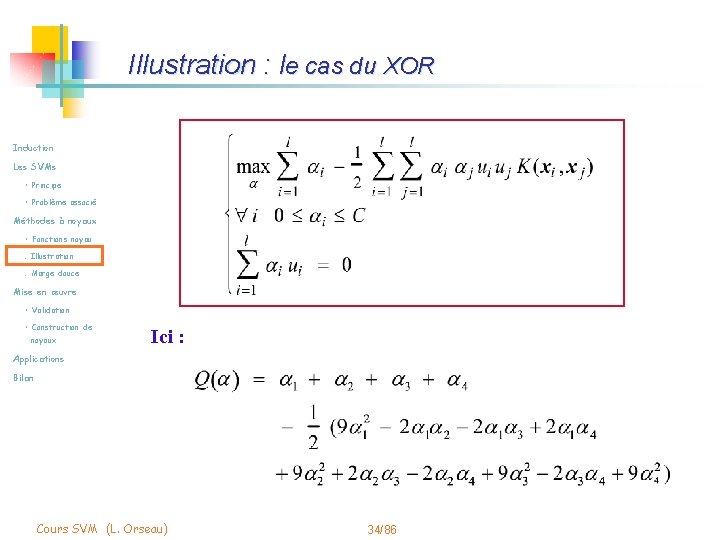

Illustration : le cas du XOR Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Ici : Applications Bilan Cours SVM (L. Orseau) 34/86

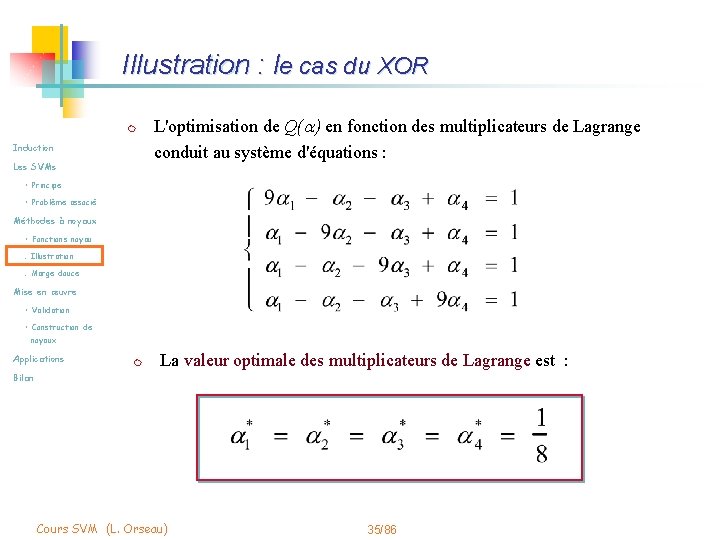

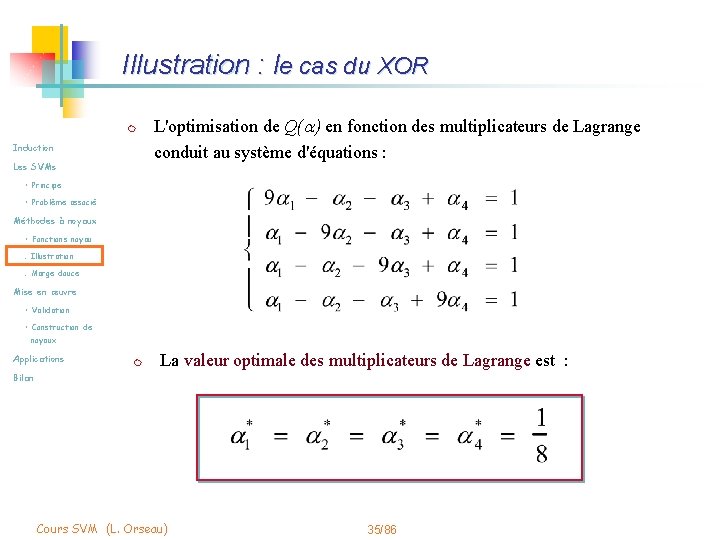

Illustration : le cas du XOR m Induction Les SVMs L'optimisation de Q( ) en fonction des multiplicateurs de Lagrange conduit au système d'équations : • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications m La valeur optimale des multiplicateurs de Lagrange est : Bilan Cours SVM (L. Orseau) 35/86

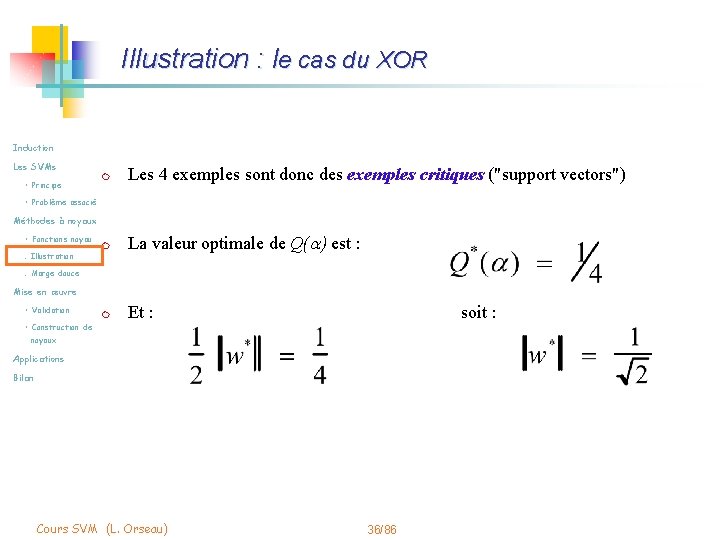

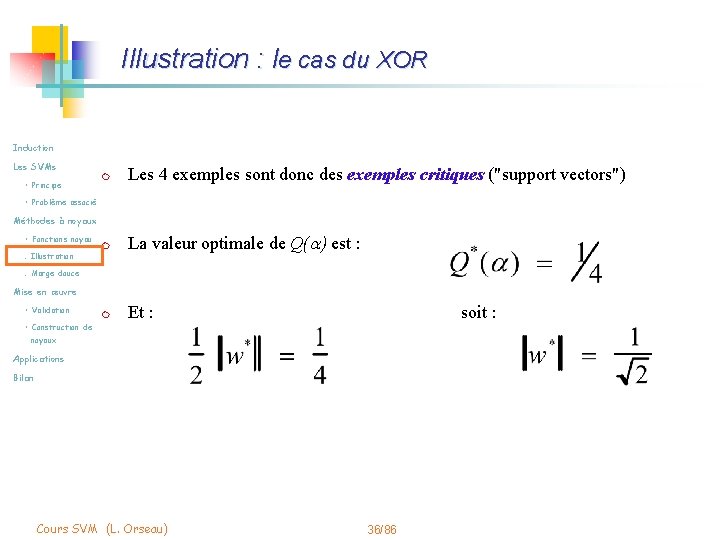

Illustration : le cas du XOR Induction Les SVMs • Principe m Les 4 exemples sont donc des exemples critiques ("support vectors") m La valeur optimale de Q( ) est : m Et : • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de soit : noyaux Applications Bilan Cours SVM (L. Orseau) 36/86

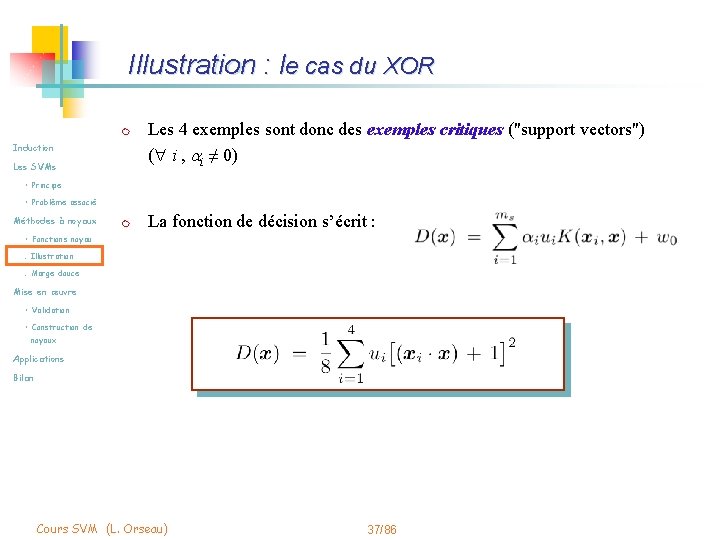

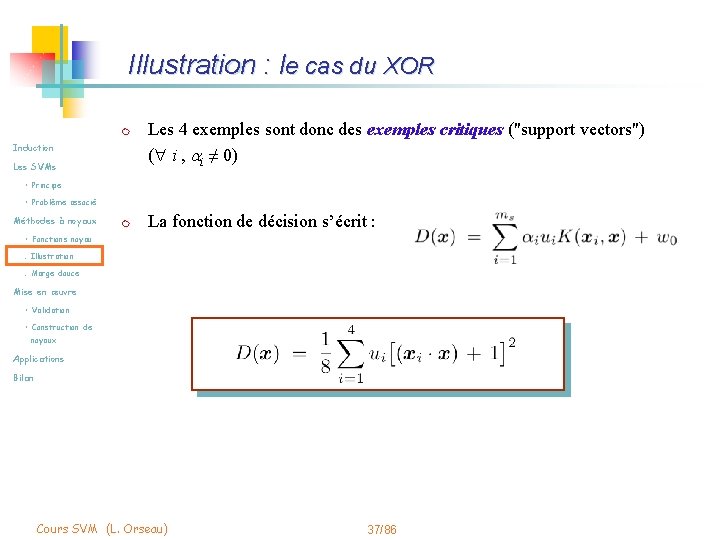

Illustration : le cas du XOR m Induction Les SVMs Les 4 exemples sont donc des exemples critiques ("support vectors") ( i , i ≠ 0) • Principe • Problème associé Méthodes à noyaux m La fonction de décision s’écrit : • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 37/86

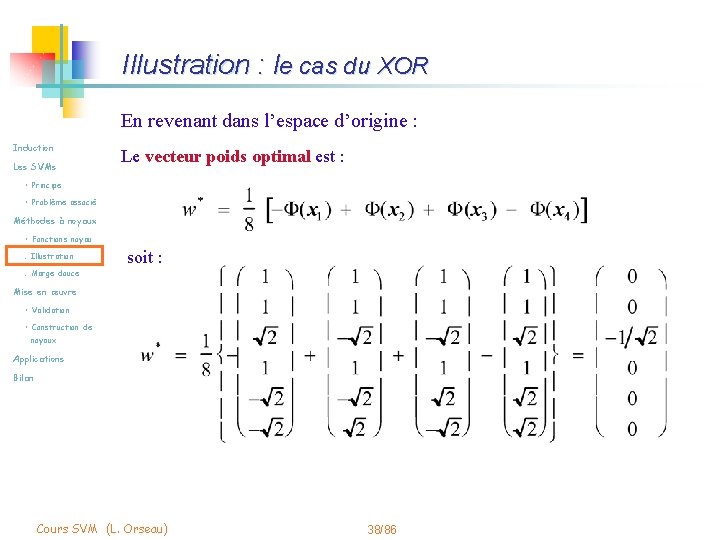

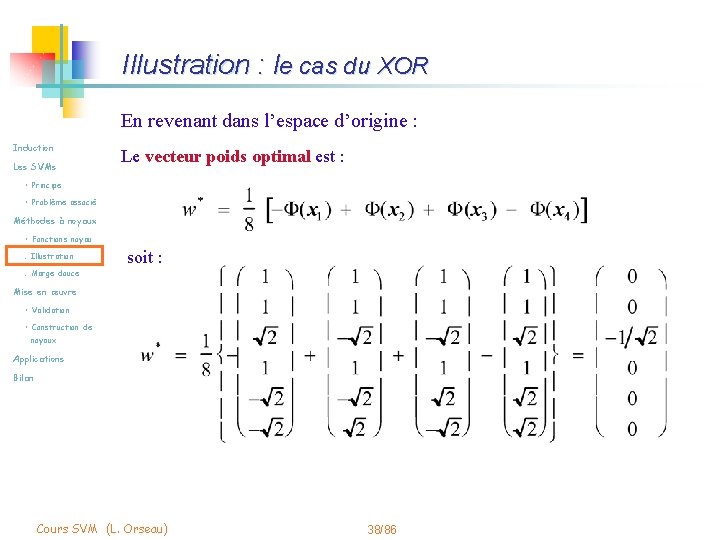

Illustration : le cas du XOR En revenant dans l’espace d’origine : Induction Les SVMs Le vecteur poids optimal est : • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration soit : . Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 38/86

Illustration : le cas du XOR Induction Les SVMs • Principe L'hyperplan optimal correspond à : • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 39/86

Illustration : le cas du XOR Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Séparatrice dans l'espace F(X) (espace à 6 dimensions) Séparatrice dans l'espace d'entrée D(x) = -x 1 x 2 Cours SVM (L. Orseau) 40/86

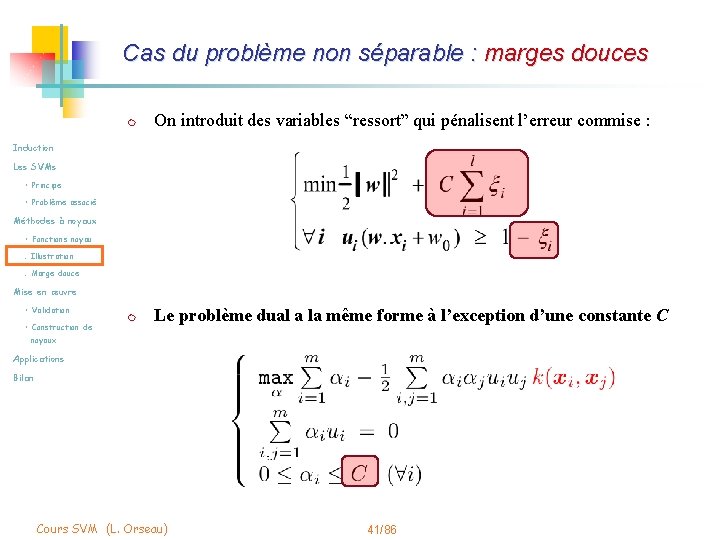

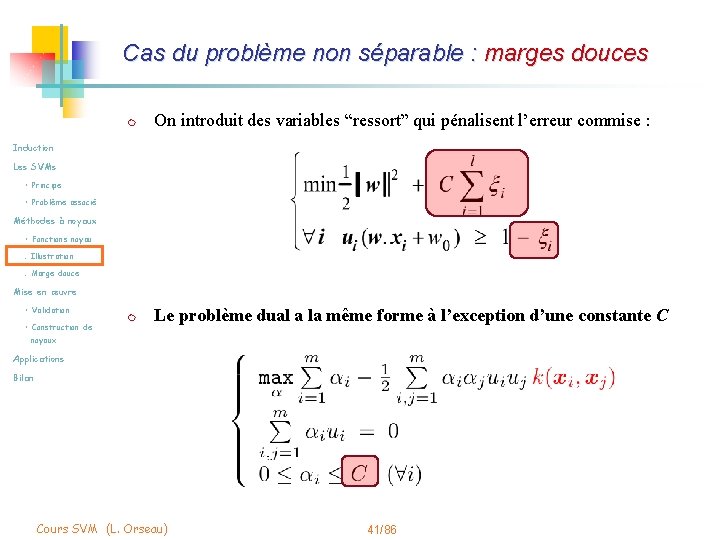

Cas du problème non séparable : marges douces m On introduit des variables “ressort” qui pénalisent l’erreur commise : m Le problème dual a la même forme à l’exception d’une constante C Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 41/86

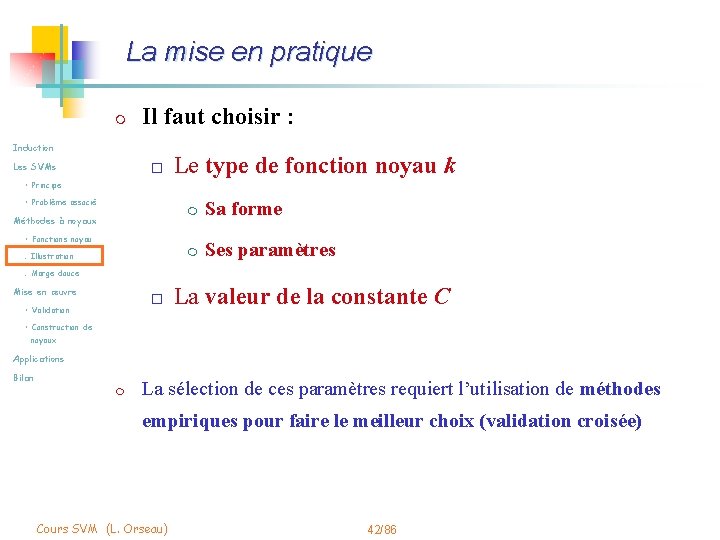

La mise en pratique m Il faut choisir : Induction Les SVMs o Le type de fonction noyau k • Principe • Problème associé Méthodes à noyaux m Sa forme m Ses paramètres • Fonctions noyau. Illustration. Marge douce Mise en œuvre o • Validation La valeur de la constante C • Construction de noyaux Applications Bilan m La sélection de ces paramètres requiert l’utilisation de méthodes empiriques pour faire le meilleur choix (validation croisée) Cours SVM (L. Orseau) 42/86

Exemple : exemple + Induction Les SVMs • Principe • : exemple Dans cercle : points de support • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Fct noyau polynomiale de degré 3 Mise en œuvre • Validation • Construction de noyaux Applications Bilan Démo : http: //svm. research. bell-labs. com/ http: //svm. dcs. rhbnc. ac. uk/pagesnew/G Pat. shtml Cours SVM (L. Orseau) 43/86

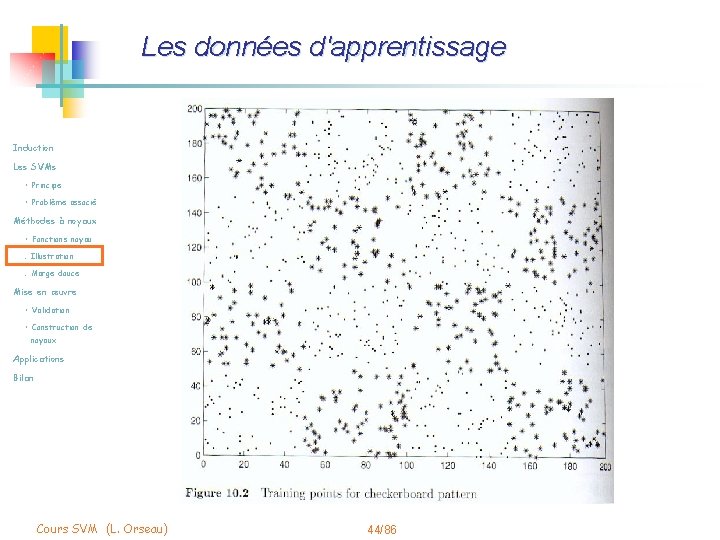

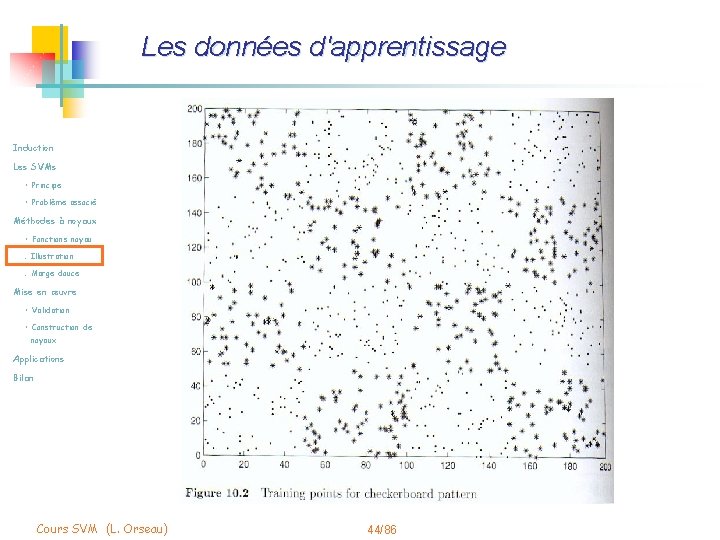

Les données d'apprentissage Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 44/86

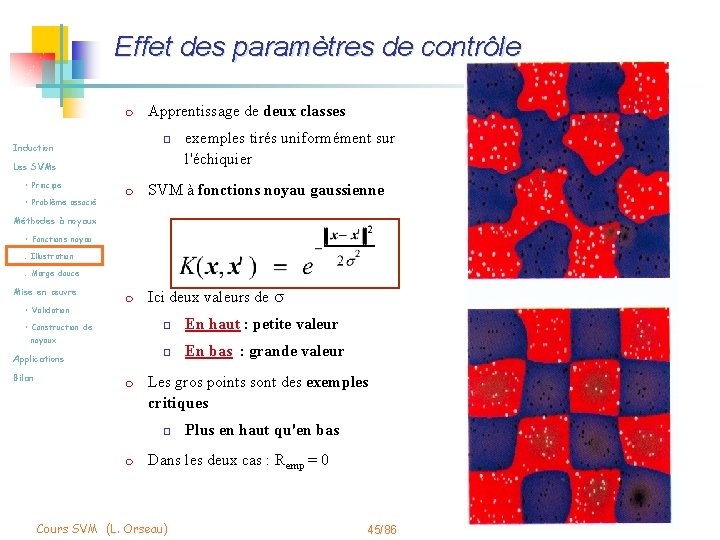

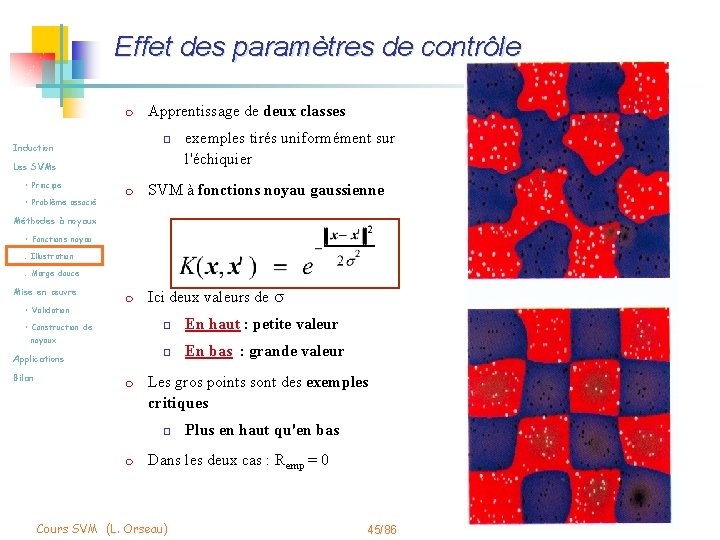

Effet des paramètres de contrôle m Apprentissage de deux classes o Induction Les SVMs • Principe • Problème associé exemples tirés uniformément sur l'échiquier m SVM à fonctions noyau gaussienne m Ici deux valeurs de s Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de o En haut : petite valeur o En bas : grande valeur noyaux Applications Bilan m Les gros points sont des exemples critiques o m Plus en haut qu'en bas Dans les deux cas : Remp = 0 Cours SVM (L. Orseau) 45/86

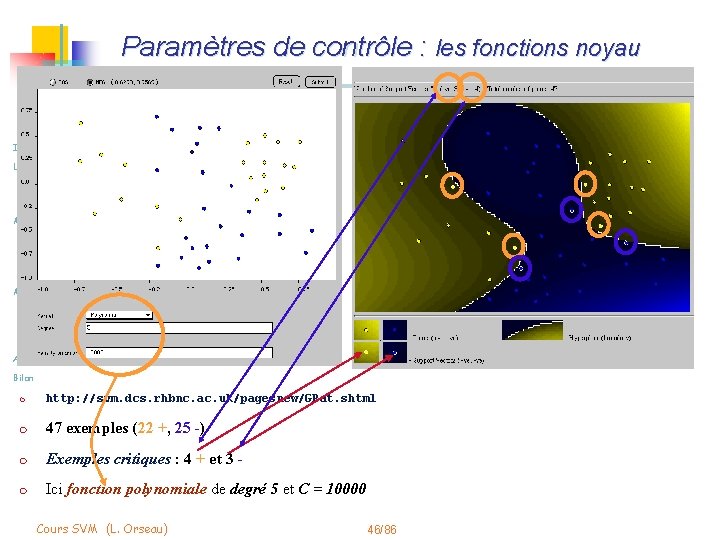

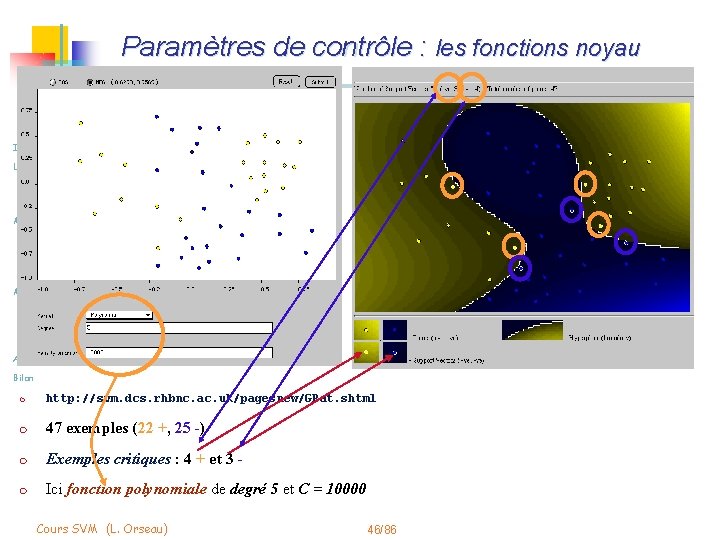

Paramètres de contrôle : les fonctions noyau Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan m http: //svm. dcs. rhbnc. ac. uk/pagesnew/GPat. shtml m 47 exemples (22 +, 25 -) m Exemples critiques : 4 + et 3 - m Ici fonction polynomiale de degré 5 et C = 10000 Cours SVM (L. Orseau) 46/86

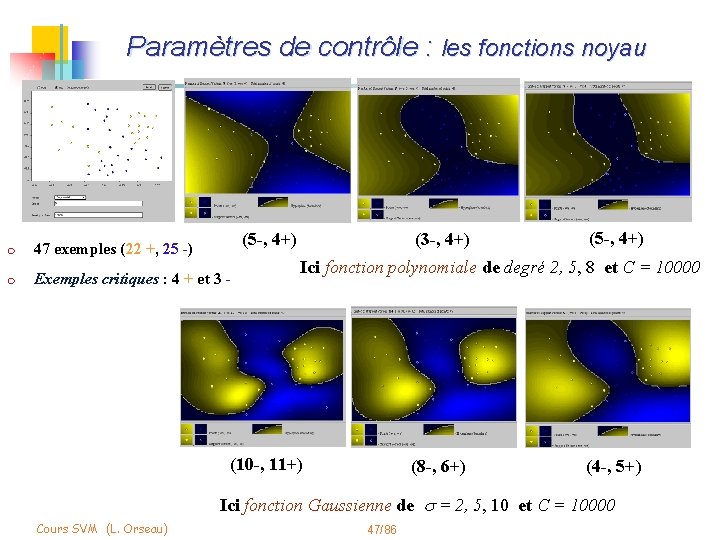

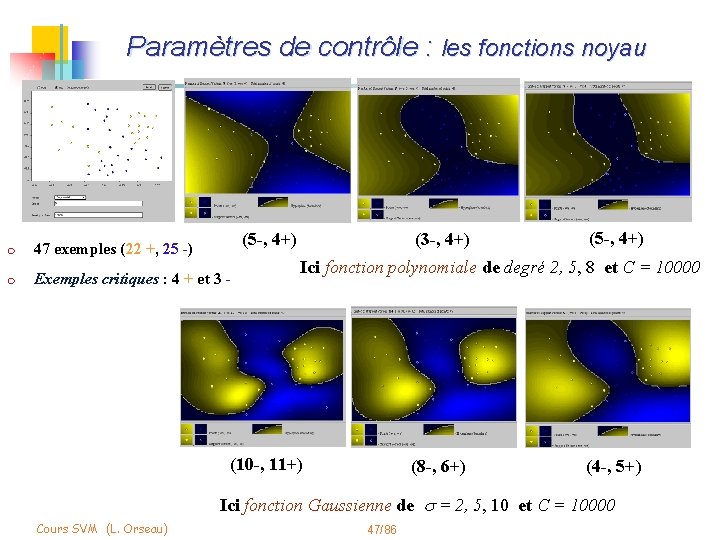

Paramètres de contrôle : les fonctions noyau Induction Les SVMs • Principe • Problème associé Méthodes à noyaux (5 -, 4+) • Fonctions noyau m m 47 exemples (22 +, 25 -) . Illustration . Marge douce Exemples critiques : 4 + et 3 - (3 -, 4+) (5 -, 4+) Ici fonction polynomiale de degré 2, 5, 8 et C = 10000 Mise en œuvre • Validation • Construction de noyaux Applications Bilan (10 -, 11+) (8 -, 6+) (4 -, 5+) Ici fonction Gaussienne de s = 2, 5, 10 et C = 10000 Cours SVM (L. Orseau) 47/86

Ajout de quelques points. . . Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan m http: //svm. dcs. rhbnc. ac. uk/pagesnew/GPat. shtml m 47 + 8 exemples (30 +, 25 -) m Exemples critiques : 5 + et 8 - m Ici fonction polynomiale de degré 5 et C = 10000 Cours SVM (L. Orseau) 48/86

Estimation de la performance m Empiriquement : par validation croisée m Heuristiquement (mais théoriquement fondé) Induction Les SVMs • Principe • Problème associé Méthodes à noyaux o Nombre de points de supports • Fonctions noyau m . Illustration. Marge douce Mise en œuvre o Caractéristiques de la matrice noyau • Validation • Construction de m Si pas de structure dans K, aucune régularité ne peut-être trouvée m E. g. noyaux Applications Bilan Moins il y en a, mieux c’est n Si les termes hors diagonale sont très petits : sur-adaptation n Si matrice uniforme : sous-apprentissage : tous les points sont attribués à la même classe Cours SVM (L. Orseau) 49/86

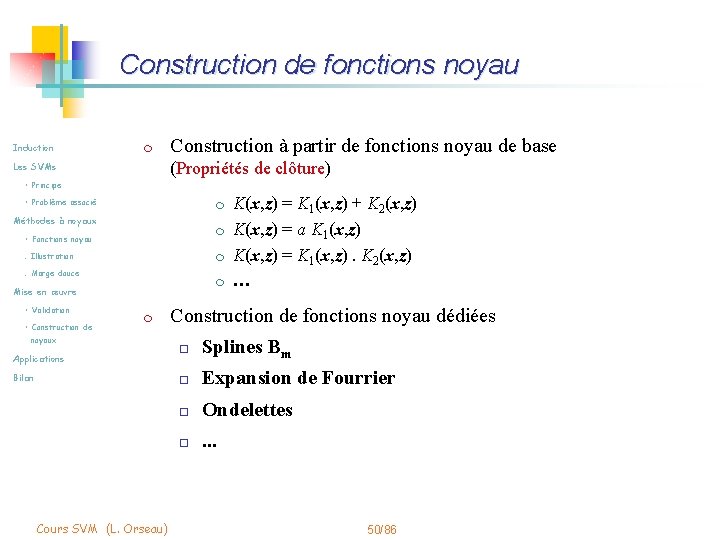

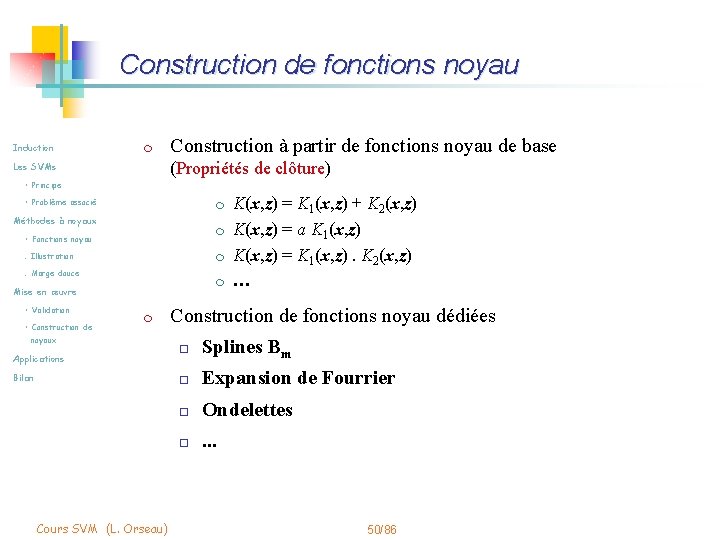

Construction de fonctions noyau Induction m Construction à partir de fonctions noyau de base (Propriétés de clôture) Les SVMs • Principe • Problème associé m Méthodes à noyaux m • Fonctions noyau. Illustration m . Marge douce m Mise en œuvre • Validation • Construction de m noyaux Applications Bilan Cours SVM (L. Orseau) K(x, z) = K 1(x, z) + K 2(x, z) K(x, z) = a K 1(x, z) K(x, z) = K 1(x, z). K 2(x, z) … Construction de fonctions noyau dédiées o Splines Bm o Expansion de Fourrier o Ondelettes o . . . 50/86

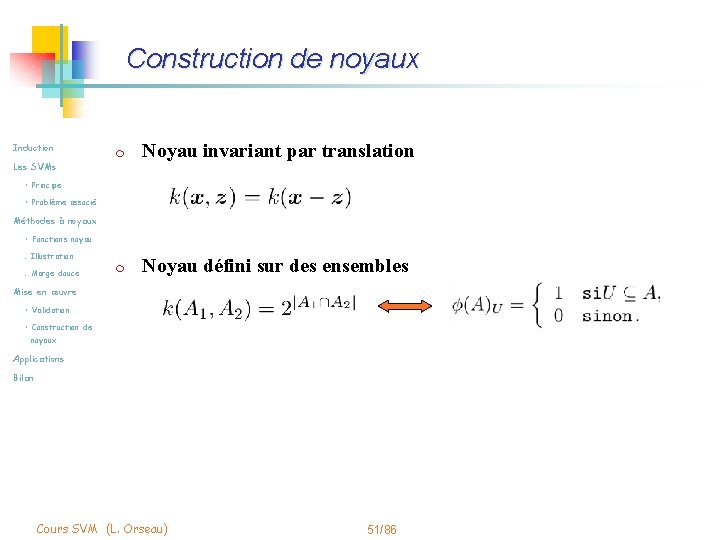

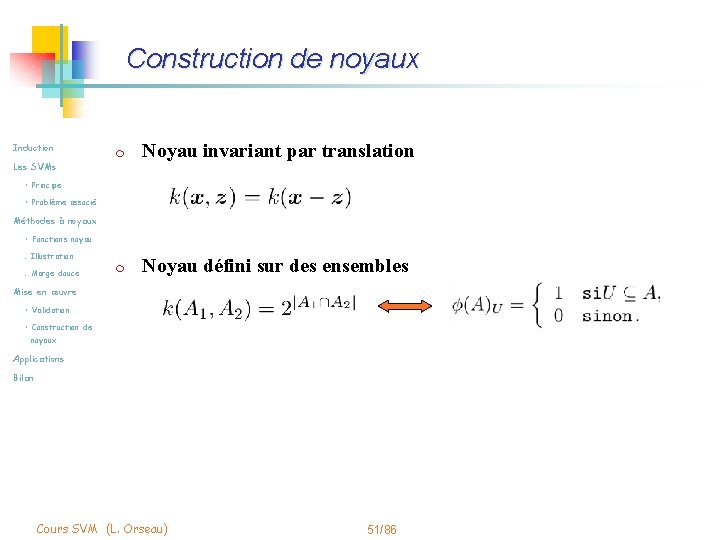

Construction de noyaux Induction m Noyau invariant par translation m Noyau défini sur des ensembles Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 51/86

Stratégies de construction Induction Les SVMs m • Principe • Problème associé Méthodes à noyaux • Fonctions noyau Noyau vu comme un moyen de coder de l’information a priori o Invariance: synonymie, longueur de document, … o Traitements linguistiques: normalisation des mots, semantique, stopwords, weighting scheme, … . Illustration. Marge douce Mise en œuvre • Validation m Noyaux de convolution : le texte est une structure de données récursivement définie. • Construction de noyaux Pb : construire un noyau global à partir de noyaux locaux ? Applications Bilan m Noyaux à partir de modèles génératifs : la “topologie” du problème est traduite en une fonction noyau Cours SVM (L. Orseau) 52/86

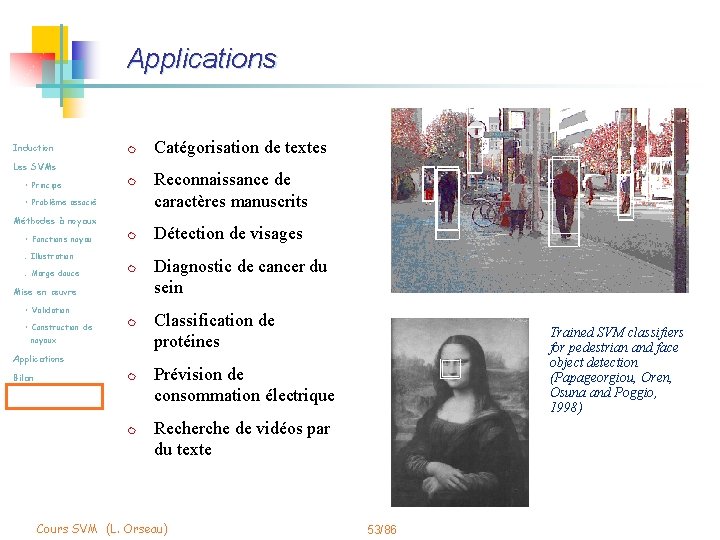

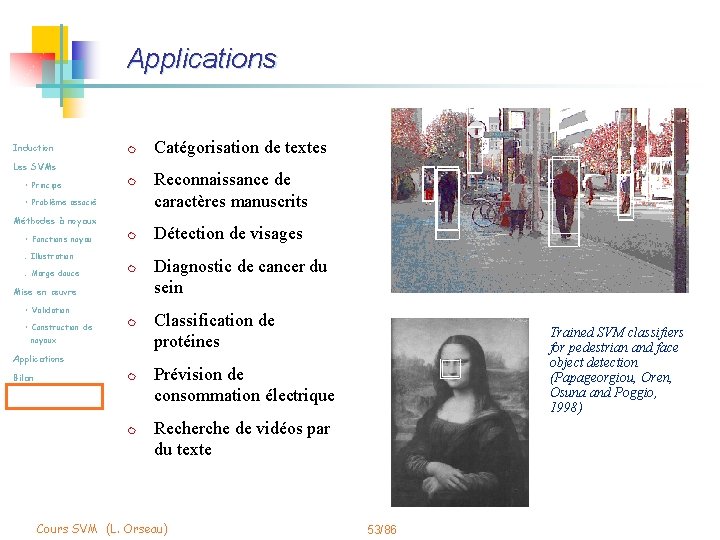

Applications Induction m Les SVMs • Principe m • Problème associé Méthodes à noyaux • Fonctions noyau m . Illustration. Marge douce m Mise en œuvre • Validation • Construction de m noyaux Applications Bilan m m Catégorisation de textes Reconnaissance de caractères manuscrits Détection de visages Diagnostic de cancer du sein Classification de protéines Trained SVM classifiers for pedestrian and face object detection (Papageorgiou, Oren, Osuna and Poggio, 1998) Prévision de consommation électrique Recherche de vidéos par du texte Cours SVM (L. Orseau) 53/86

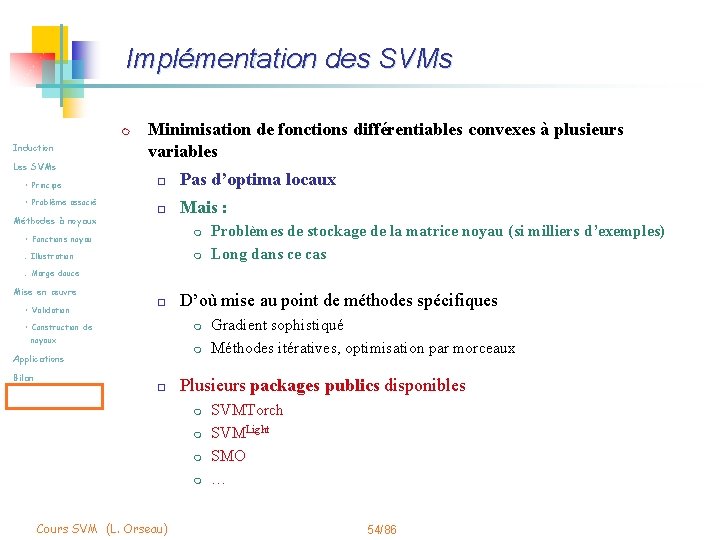

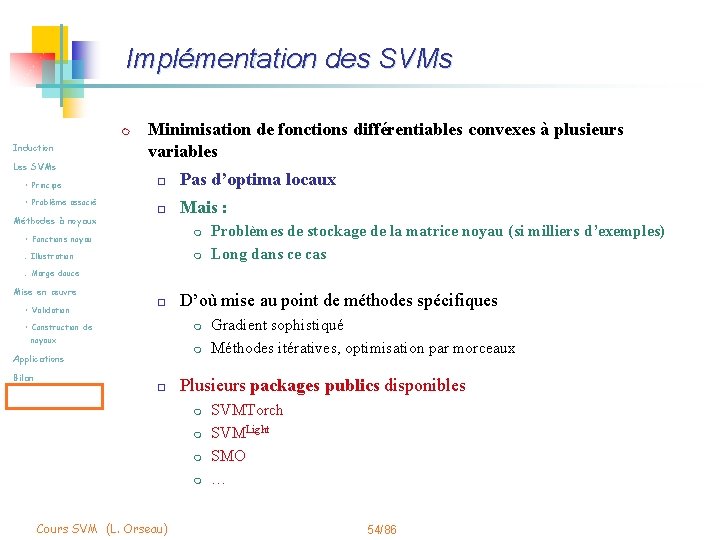

Implémentation des SVMs m Induction Les SVMs • Principe • Problème associé Méthodes à noyaux Minimisation de fonctions différentiables convexes à plusieurs variables o Pas d’optima locaux o Mais : m • Fonctions noyau. Illustration m Problèmes de stockage de la matrice noyau (si milliers d’exemples) Long dans ce cas . Marge douce Mise en œuvre • Validation o • Construction de m noyaux m Applications Bilan D’où mise au point de méthodes spécifiques o Plusieurs packages publics disponibles m m Cours SVM (L. Orseau) Gradient sophistiqué Méthodes itératives, optimisation par morceaux SVMTorch SVMLight SMO … 54/86

Bilan : état des recherches m Induction Deux tâches évidentes o Les SVMs Conception de noyaux m • Principe m • Problème associé Méthodes à noyaux o • Fonctions noyau. Illustration Noyautiser les algorithmes classiques ( « kernelization » ) m . Marge douce m Mise en œuvre • Validation m • Construction de m noyaux Applications m Bilan m m m Commence à être bien étudié Encore des recherches pour certains types de données SVM Kernel Régression Kernel PCA Clustering (K-means, …) Estimation de densité, détection de nouveauté Tri (ranking) … Recherche sur la sélection automatique des modèles (choix des paramètres) Cours SVM (L. Orseau) 55/86

Extensions Induction Les SVMs m Classification multi-classes m Régression m Détection de « nouveautés » m Analyse en composantes principales par noyaux • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 56/86

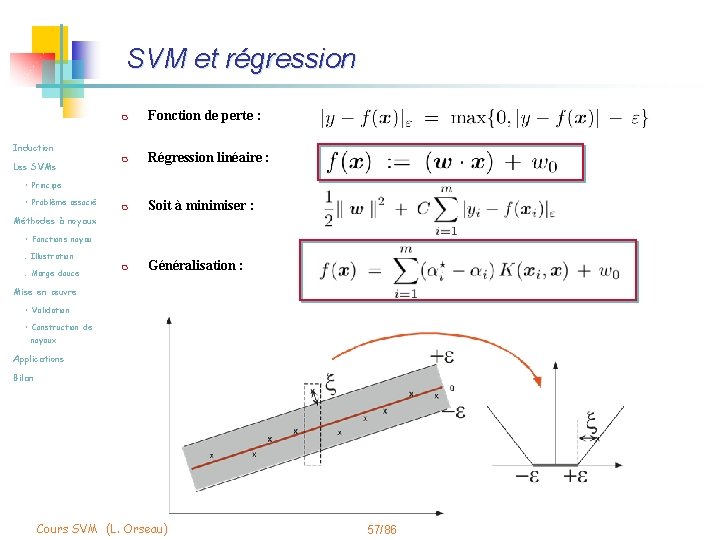

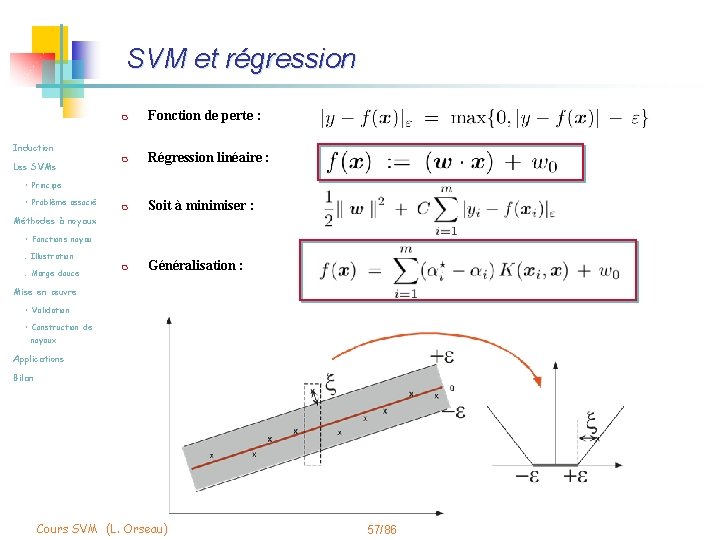

SVM et régression m Fonction de perte : m Régression linéaire : m Soit à minimiser : m Généralisation : Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 57/86

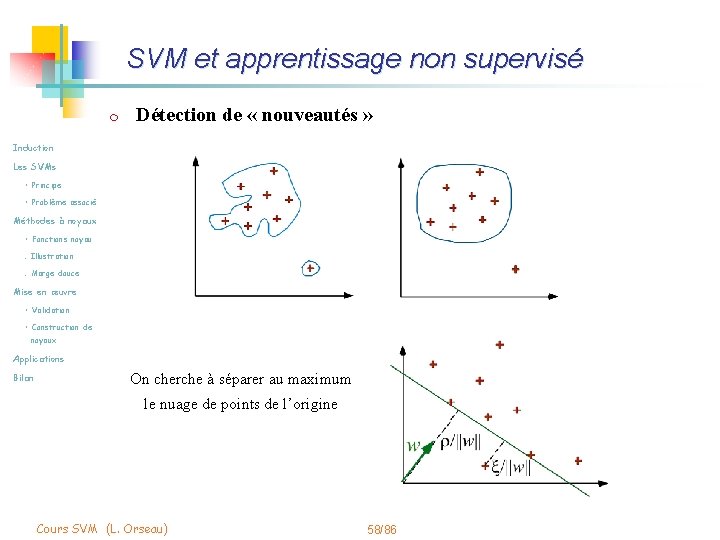

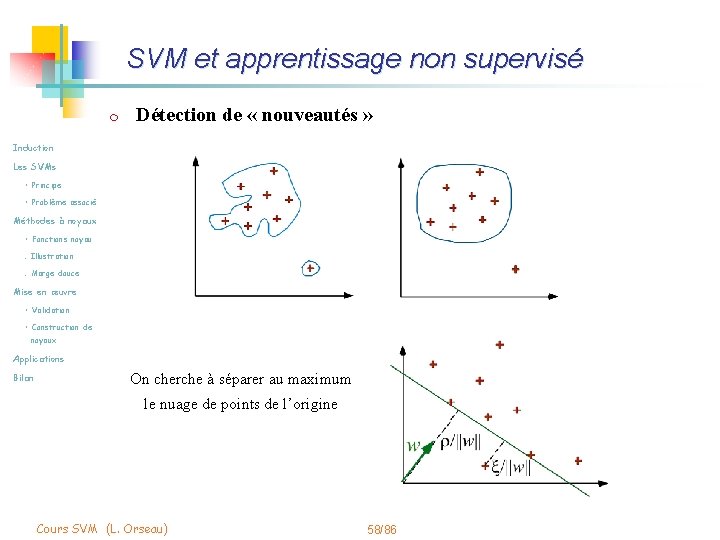

SVM et apprentissage non supervisé m Détection de « nouveautés » Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan On cherche à séparer au maximum le nuage de points de l’origine Cours SVM (L. Orseau) 58/86

Bilan Induction m Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau Les méthodes à noyau sont : o Une bonne idée o Destinées à durer . Illustration. Marge douce Mise en œuvre • Validation • Construction de m Offrent une boîte à outils noyaux Applications o Très versatile o Avec de bons fondements théoriques Bilan m Cours SVM (L. Orseau) E. g. garanties de performance 59/86

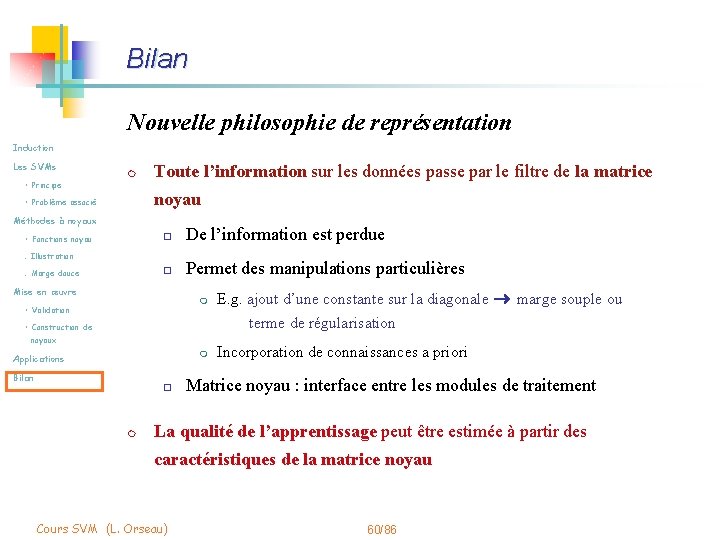

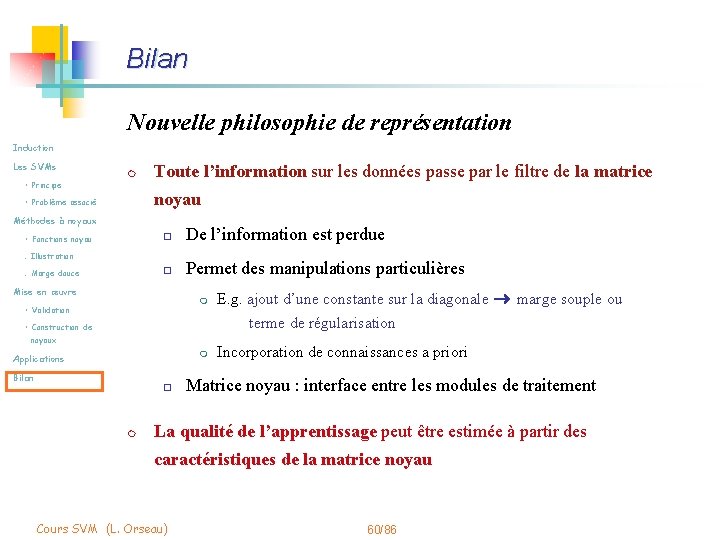

Bilan Nouvelle philosophie de représentation Induction Les SVMs m • Principe Toute l’information sur les données passe par le filtre de la matrice noyau • Problème associé Méthodes à noyaux • Fonctions noyau o De l’information est perdue o Permet des manipulations particulières . Illustration. Marge douce Mise en œuvre m • Validation E. g. ajout d’une constante sur la diagonale marge souple ou terme de régularisation • Construction de noyaux m Applications Bilan o m Incorporation de connaissances a priori Matrice noyau : interface entre les modules de traitement La qualité de l’apprentissage peut être estimée à partir des caractéristiques de la matrice noyau Cours SVM (L. Orseau) 60/86

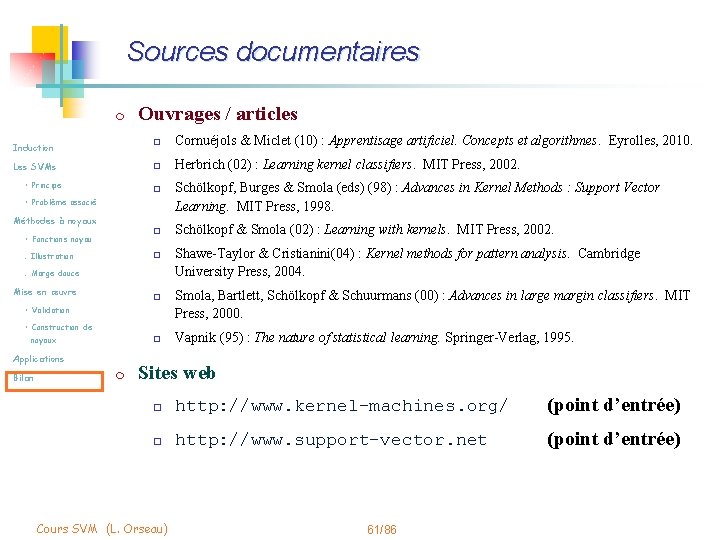

Sources documentaires m Ouvrages / articles Induction o Cornuéjols & Miclet (10) : Apprentisage artificiel. Concepts et algorithmes. Eyrolles, 2010. Les SVMs o Herbrich (02) : Learning kernel classifiers. MIT Press, 2002. • Principe o • Problème associé Méthodes à noyaux o • Fonctions noyau. Illustration o . Marge douce Mise en œuvre o • Validation • Construction de noyaux o Applications Bilan m Schölkopf, Burges & Smola (eds) (98) : Advances in Kernel Methods : Support Vector Learning. MIT Press, 1998. Schölkopf & Smola (02) : Learning with kernels. MIT Press, 2002. Shawe-Taylor & Cristianini(04) : Kernel methods for pattern analysis. Cambridge University Press, 2004. Smola, Bartlett, Schölkopf & Schuurmans (00) : Advances in large margin classifiers. MIT Press, 2000. Vapnik (95) : The nature of statistical learning. Springer-Verlag, 1995. Sites web o http: //www. kernel-machines. org/ (point d’entrée) o http: //www. support-vector. net (point d’entrée) Cours SVM (L. Orseau) 61/86

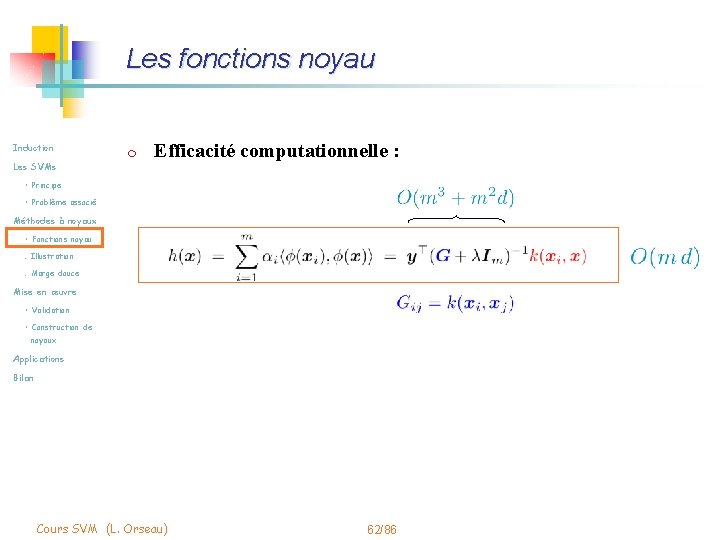

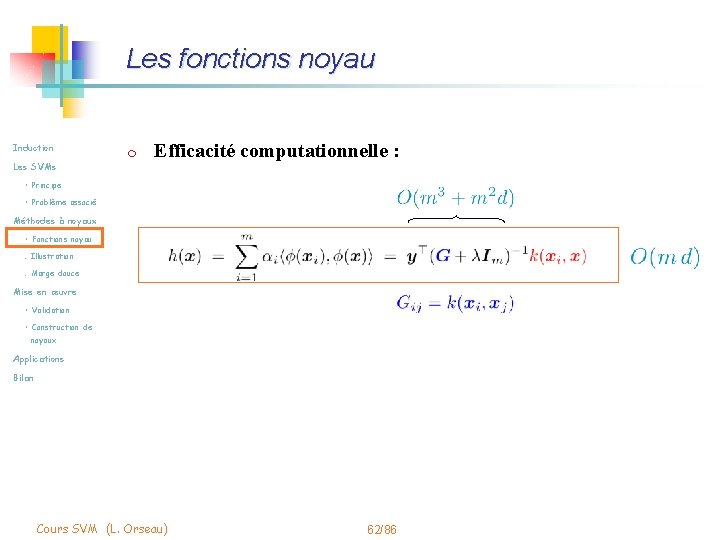

Les fonctions noyau Induction Les SVMs m Efficacité computationnelle : • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Cours SVM (L. Orseau) 62/86

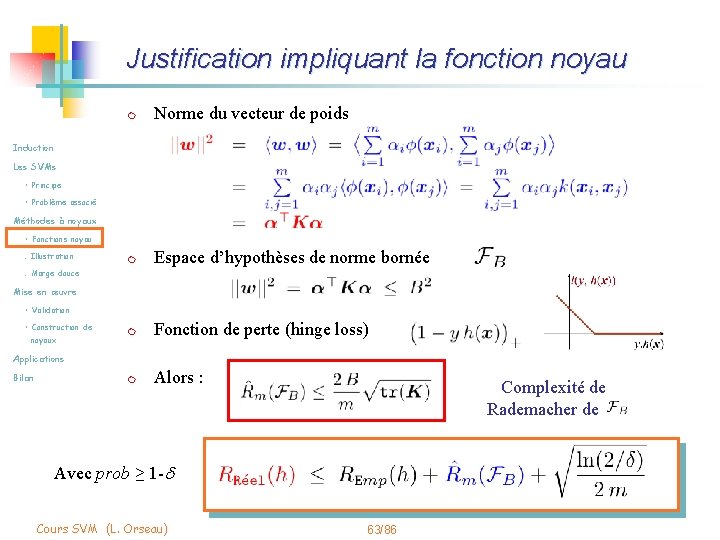

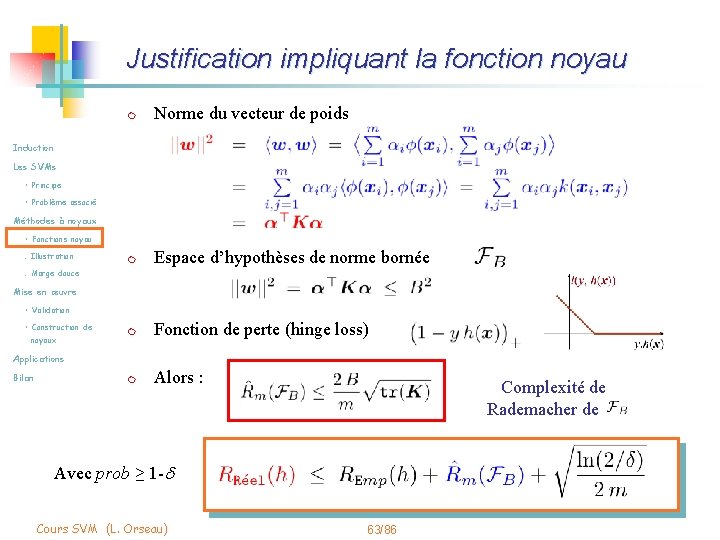

Justification impliquant la fonction noyau m Norme du vecteur de poids m Espace d’hypothèses de norme bornée m Fonction de perte (hinge loss) m Alors : Induction Les SVMs • Principe • Problème associé Méthodes à noyaux • Fonctions noyau. Illustration. Marge douce Mise en œuvre • Validation • Construction de noyaux Applications Bilan Complexité de Rademacher de Avec prob ≥ 1 -d Cours SVM (L. Orseau) 63/86

Binnormen

Binnormen Noyau gris centraux

Noyau gris centraux Noyaux vestibulaires

Noyaux vestibulaires Intermédiaire de wheland

Intermédiaire de wheland Laurent schroder

Laurent schroder Polarimetro de laurent

Polarimetro de laurent Laurent koutchouk

Laurent koutchouk Enzo tessier

Enzo tessier Pancreatitis del surco

Pancreatitis del surco Laurent arsac

Laurent arsac Laurent raigneau

Laurent raigneau Laurent lescouarch

Laurent lescouarch Laurent ledoux

Laurent ledoux Laurent arsac

Laurent arsac Laurent grosset

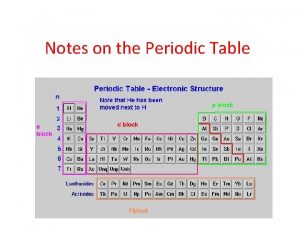

Laurent grosset Antoine laurent lavoisier periodic table

Antoine laurent lavoisier periodic table Carrosserie laurent capelli cuisery

Carrosserie laurent capelli cuisery Laurent friction

Laurent friction Laurent raigneau

Laurent raigneau Laurent series

Laurent series Laurent puig golf

Laurent puig golf Laurent itti

Laurent itti Tml

Tml Laurent ledoux

Laurent ledoux Russel caflisch

Russel caflisch Serie de laurent

Serie de laurent Laurent's steps to truly international hrm

Laurent's steps to truly international hrm Laurent ladouce

Laurent ladouce Echelle de cornell

Echelle de cornell Laurent babout

Laurent babout Laurent cappelletti

Laurent cappelletti Laurent ournac

Laurent ournac Laurent lefebvre umons

Laurent lefebvre umons Laurent serrez ma haire

Laurent serrez ma haire Laurent moor

Laurent moor Laurent itti

Laurent itti Laurent smolders

Laurent smolders Laurent series

Laurent series Laurent thys

Laurent thys Laurent meredieu

Laurent meredieu Laurent bouillon

Laurent bouillon Laurent bernasconi

Laurent bernasconi Deret laurent

Deret laurent Laurent simon hec montreal

Laurent simon hec montreal Laurent duret lyon

Laurent duret lyon Laurent bettini

Laurent bettini Laws of st laurent

Laws of st laurent Mobilit belgium

Mobilit belgium Laurent cremer

Laurent cremer Cristo

Cristo Laurent willaert

Laurent willaert Laurent allidieres

Laurent allidieres Laurent berenguier

Laurent berenguier Narcoleptsy

Narcoleptsy Laurent series

Laurent series Collège laurent mourguet

Collège laurent mourguet Laurent hocqueloux

Laurent hocqueloux Laurent di filippo

Laurent di filippo Laurent baduel

Laurent baduel Laurent alquier

Laurent alquier Socle commun

Socle commun Laurent barban

Laurent barban Laurent smal

Laurent smal Laurent raigneau

Laurent raigneau