Sieci dynamiczne Sieci Neuronowe Wykad 10 Wodzisaw Duch

- Slides: 43

Sieci dynamiczne Sieci Neuronowe Wykład 10 Włodzisław Duch Uniwersytet Mikołaja Kopernika Google: W. Duch

Co było • MLP w różnych wersjach • Głębokie uczenie

Co będzie • Sieci dynamiczne: sprzężenia zwrotne • Model Hopfielda • Modele pamięci asocjacyjnej

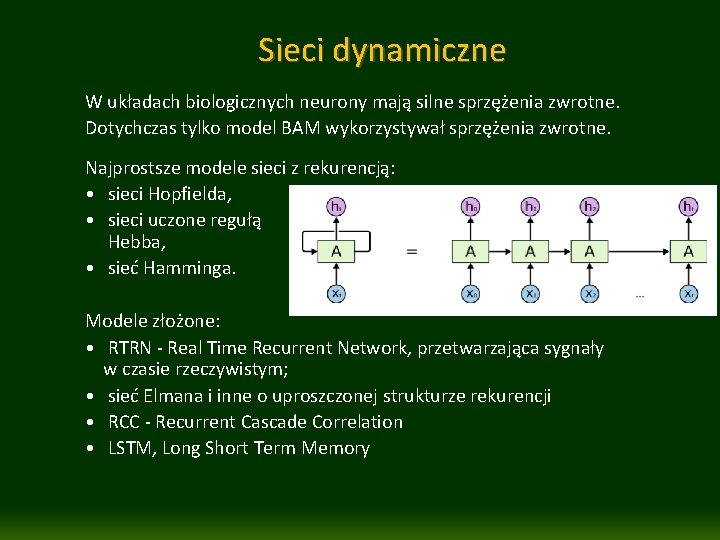

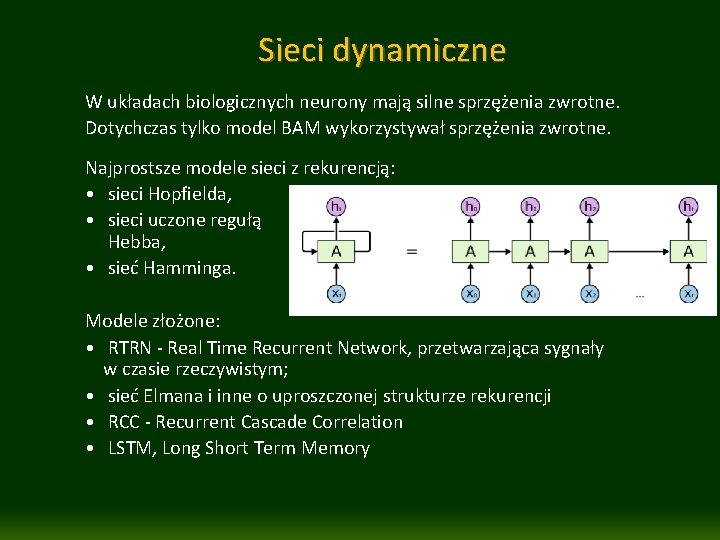

Sieci dynamiczne W układach biologicznych neurony mają silne sprzężenia zwrotne. Dotychczas tylko model BAM wykorzystywał sprzężenia zwrotne. Najprostsze modele sieci z rekurencją: • sieci Hopfielda, • sieci uczone regułą Hebba, • sieć Hamminga. Modele złożone: • RTRN - Real Time Recurrent Network, przetwarzająca sygnały w czasie rzeczywistym; • sieć Elmana i inne o uproszczonej strukturze rekurencji • RCC - Recurrent Cascade Correlation • LSTM, Long Short Term Memory

Reguła Hebba “Kiedy akson komórki A jest dostatecznie blisko by pobudzić komórkę B i wielokrotnie w sposób trwały bierze udział w jej pobudzaniu, procesy wzrostu lub zmian metabolicznych zachodzą w obu komórkach tak, że sprawność neuronu A jako jednej z komórek pobudzających B, wzrasta. ” D. O. Hebb, 1949 5

Model Hopfielda John Hopfield (1982, 1984), model pamięci autoasocjacyjnej. Założenia: • Wszystkie neurony są ze sobą połączone (fully connected network) z wagami synaps Wij. • Macierz wag połączeń jest symetryczna, Wi, i=0, Wij = Wji. Symetria jest wygodna z teoretycznego p. widzenia, pozwala wprowadzić f. energii; jest nierealistyczna z biologicznego p. widzenia. Dyskretny stan neuronu - potencjał Vi = ± 1 = sgn (I(V)) W późniejszych modelach stany rzeczywiste. 6

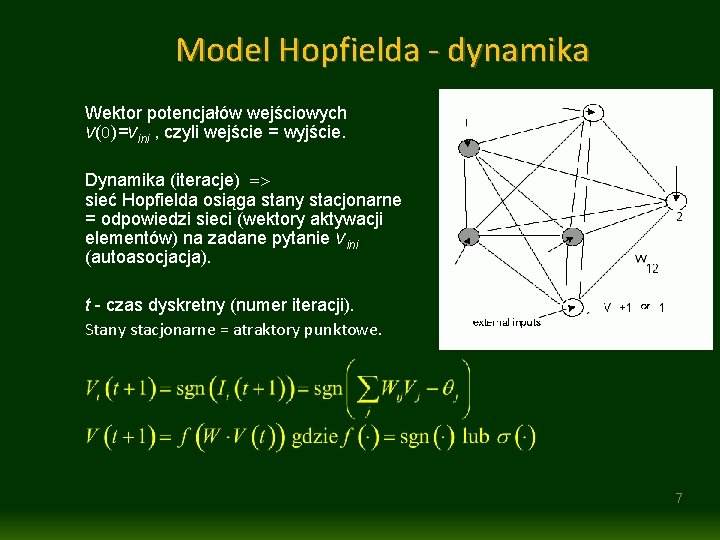

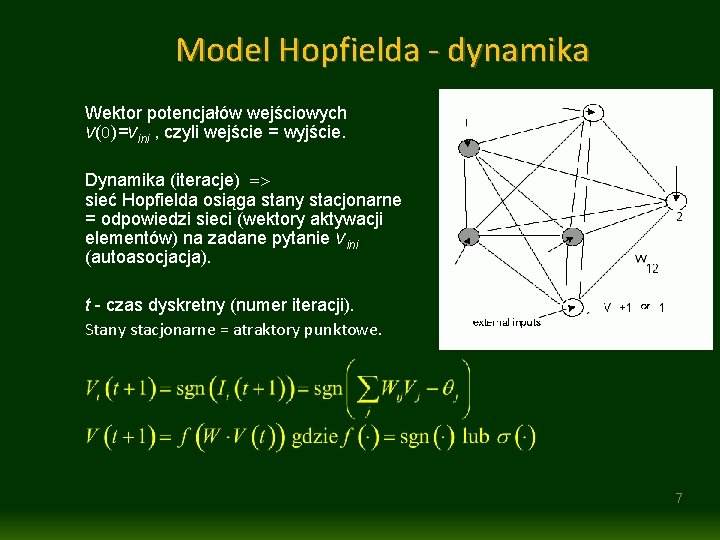

Model Hopfielda - dynamika Wektor potencjałów wejściowych V(0)=Vini , czyli wejście = wyjście. Dynamika (iteracje) => sieć Hopfielda osiąga stany stacjonarne = odpowiedzi sieci (wektory aktywacji elementów) na zadane pytanie Vini (autoasocjacja). t - czas dyskretny (numer iteracji). Stany stacjonarne = atraktory punktowe. 7

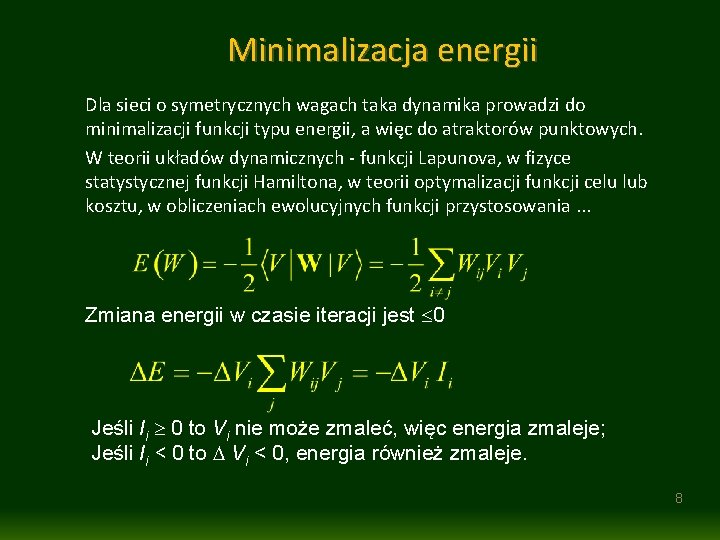

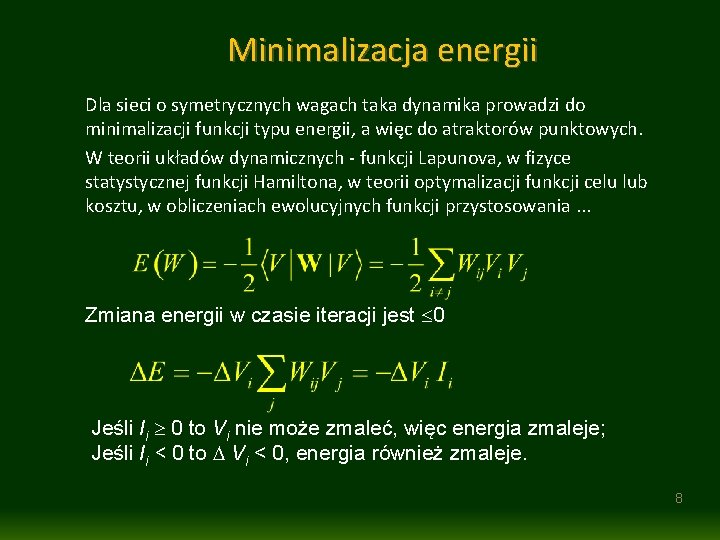

Minimalizacja energii Dla sieci o symetrycznych wagach taka dynamika prowadzi do minimalizacji funkcji typu energii, a więc do atraktorów punktowych. W teorii układów dynamicznych - funkcji Lapunova, w fizyce statystycznej funkcji Hamiltona, w teorii optymalizacji funkcji celu lub kosztu, w obliczeniach ewolucyjnych funkcji przystosowania. . . Zmiana energii w czasie iteracji jest 0 Jeśli Ii 0 to Vi nie może zmaleć, więc energia zmaleje; Jeśli Ii < 0 to D Vi < 0, energia również zmaleje. 8

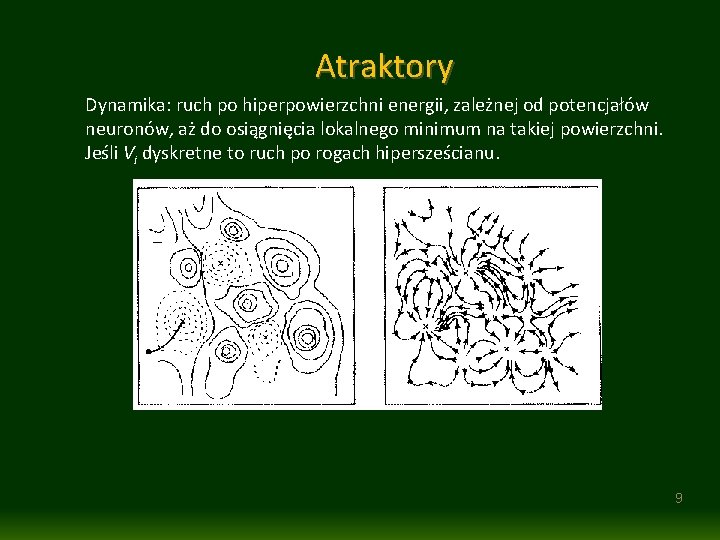

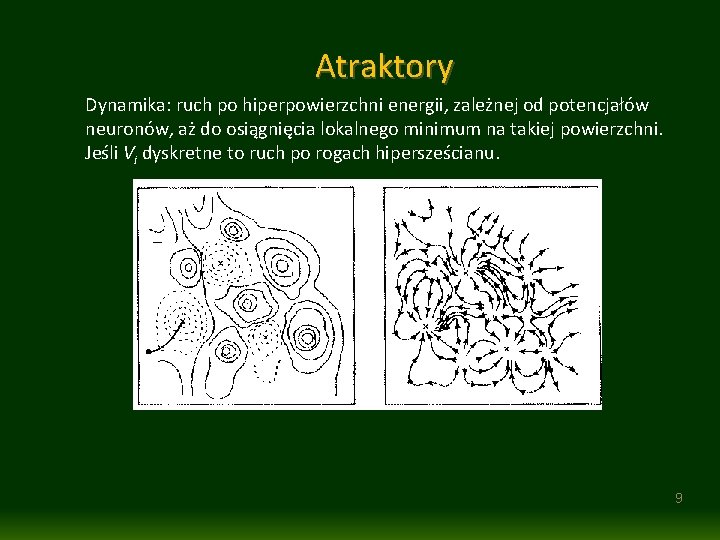

Atraktory Dynamika: ruch po hiperpowierzchni energii, zależnej od potencjałów neuronów, aż do osiągnięcia lokalnego minimum na takiej powierzchni. Jeśli Vi dyskretne to ruch po rogach hipersześcianu. 9

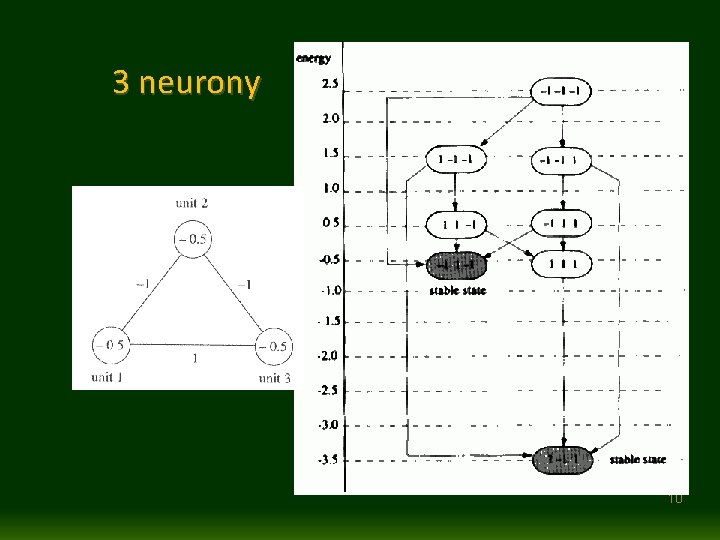

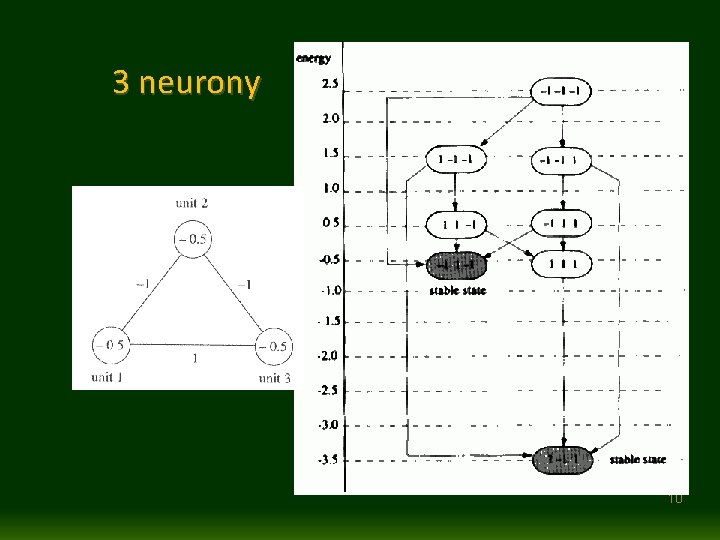

3 neurony 10

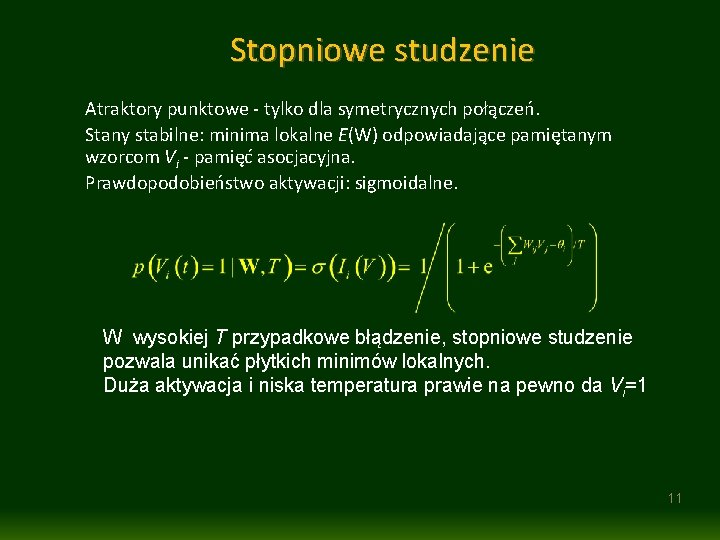

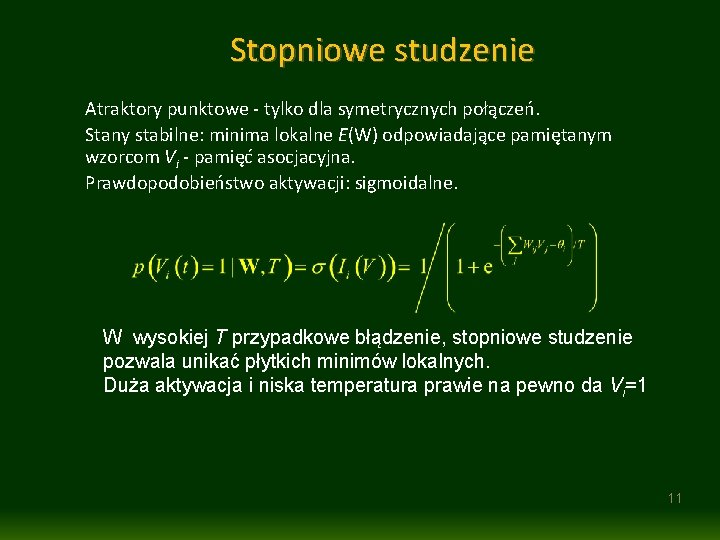

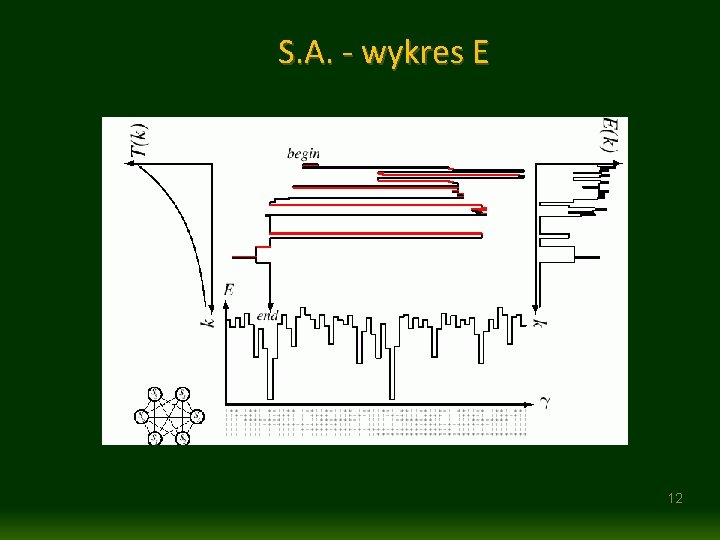

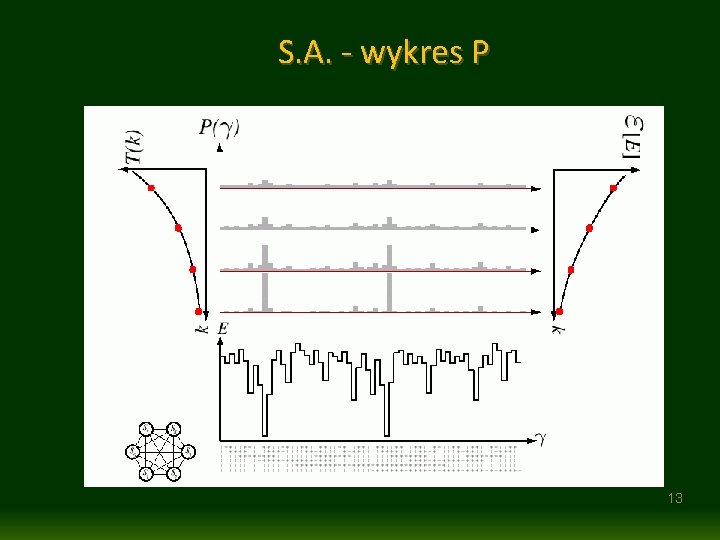

Stopniowe studzenie Atraktory punktowe - tylko dla symetrycznych połączeń. Stany stabilne: minima lokalne E(W) odpowiadające pamiętanym wzorcom Vi - pamięć asocjacyjna. Prawdopodobieństwo aktywacji: sigmoidalne. W wysokiej T przypadkowe błądzenie, stopniowe studzenie pozwala unikać płytkich minimów lokalnych. Duża aktywacja i niska temperatura prawie na pewno da Vi=1 11

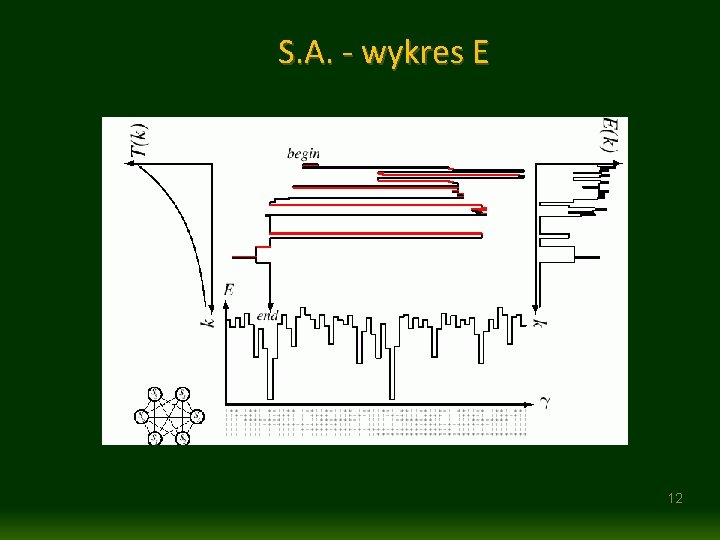

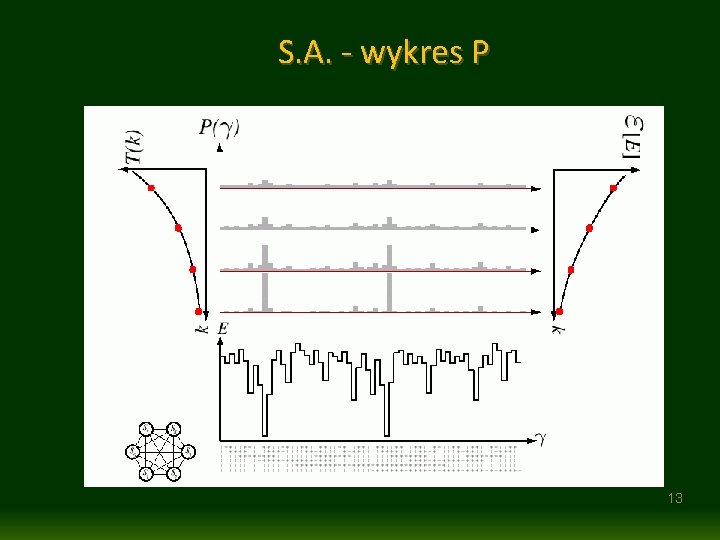

S. A. - wykres E 12

S. A. - wykres P 13

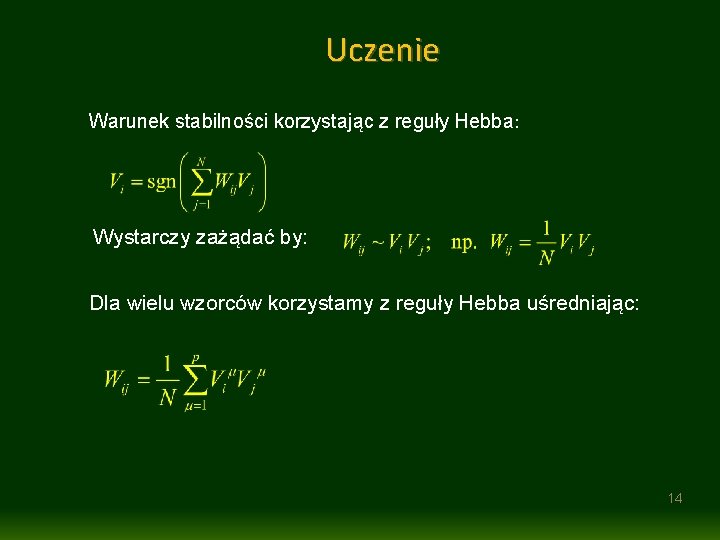

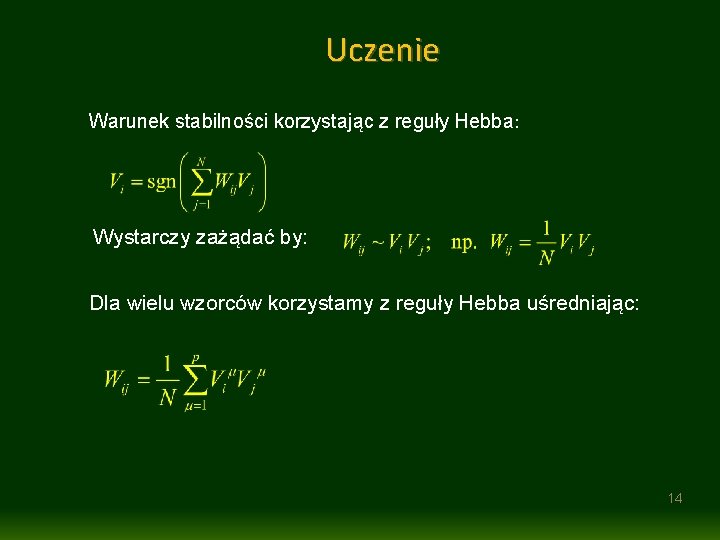

Uczenie Warunek stabilności korzystając z reguły Hebba: Wystarczy zażądać by: Dla wielu wzorców korzystamy z reguły Hebba uśredniając: 14

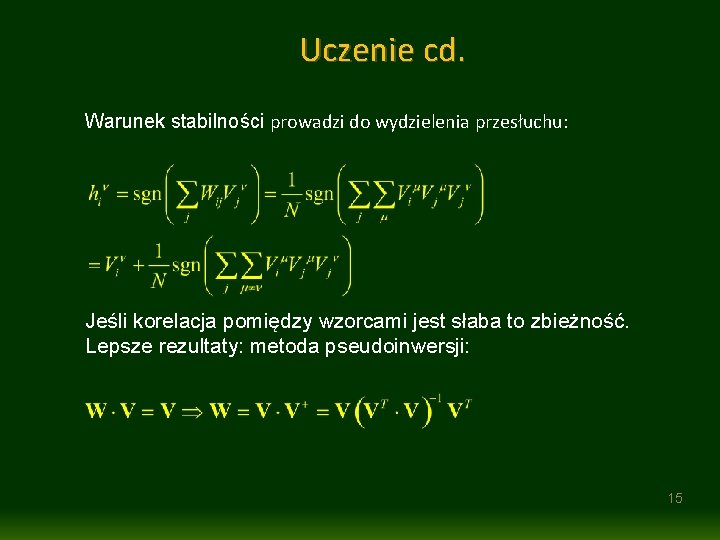

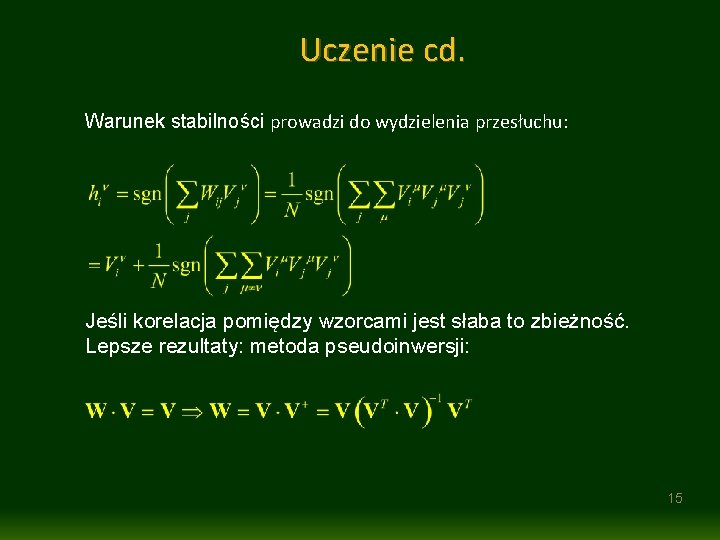

Uczenie cd. Warunek stabilności prowadzi do wydzielenia przesłuchu: Jeśli korelacja pomiędzy wzorcami jest słaba to zbieżność. Lepsze rezultaty: metoda pseudoinwersji: 15

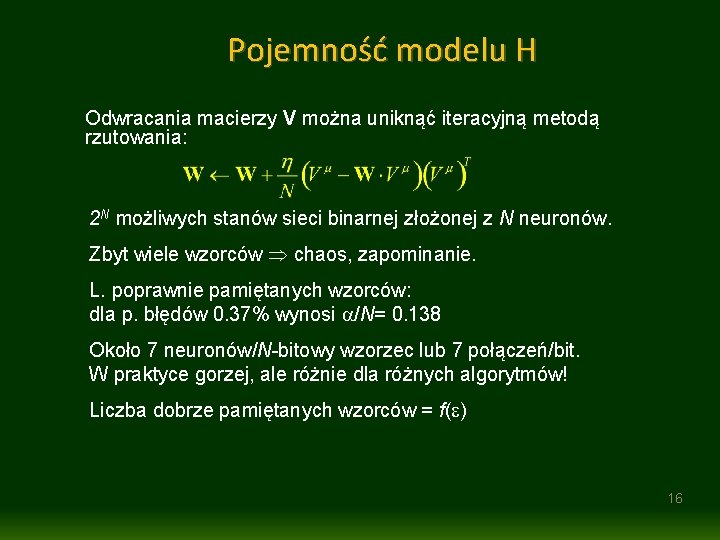

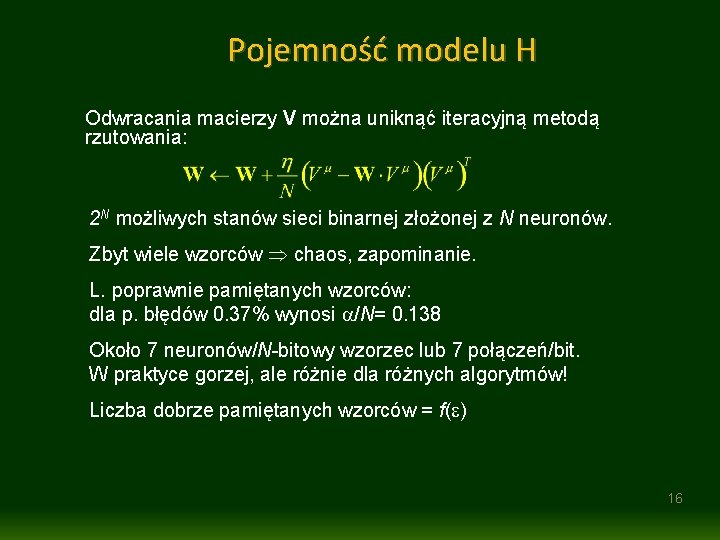

Pojemność modelu H Odwracania macierzy V można uniknąć iteracyjną metodą rzutowania: 2 N możliwych stanów sieci binarnej złożonej z N neuronów. Zbyt wiele wzorców Þ chaos, zapominanie. L. poprawnie pamiętanych wzorców: dla p. błędów 0. 37% wynosi a/N= 0. 138 Około 7 neuronów/N-bitowy wzorzec lub 7 połączeń/bit. W praktyce gorzej, ale różnie dla różnych algorytmów! Liczba dobrze pamiętanych wzorców = f(e) 16

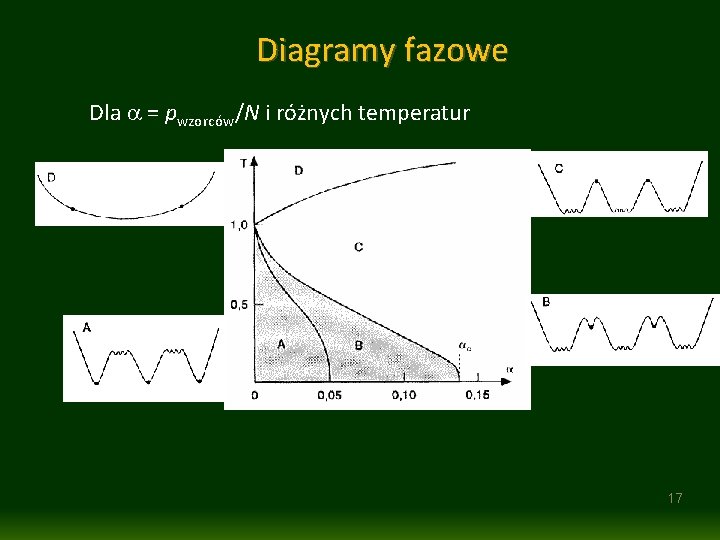

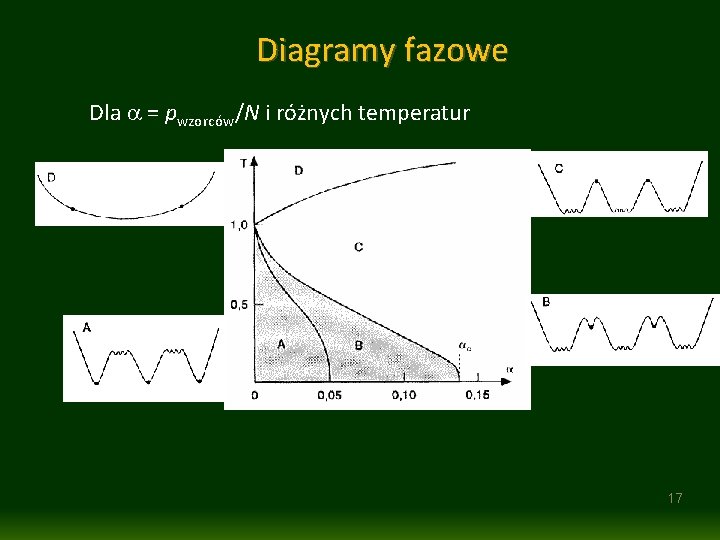

Diagramy fazowe Dla a = pwzorców/N i różnych temperatur 17

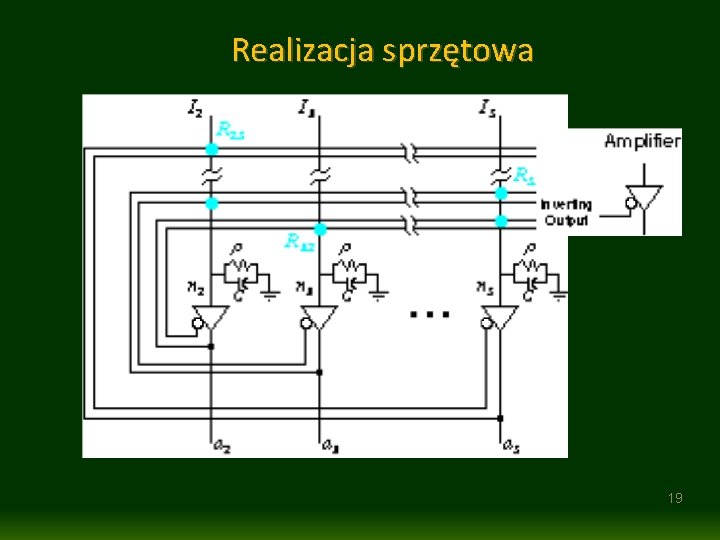

Sprytna modyfikacja Co zrobić jeśli wzorce b. duże, np. dla obrazów N 106 ? Faktoryzacja macierzy wag W na m<N wektorów własnych S S - macierze N x m Ortogonalizacja nowego wektora Zamiast mnożenia wag przez wektory O(N 2) wystarczy 2 Nxm. Szybka zbieżność dla dużych rozmiarów. Jeśli f=I to warunek stabilności oznacza, że V to wektory własne. 18

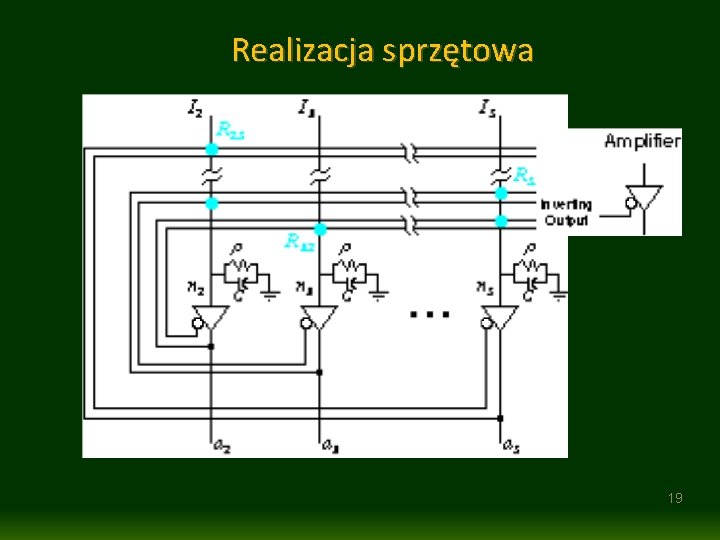

Realizacja sprzętowa 19

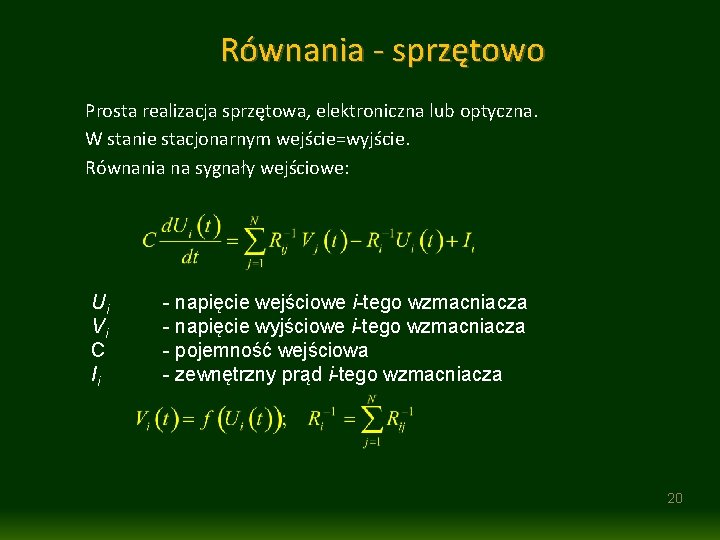

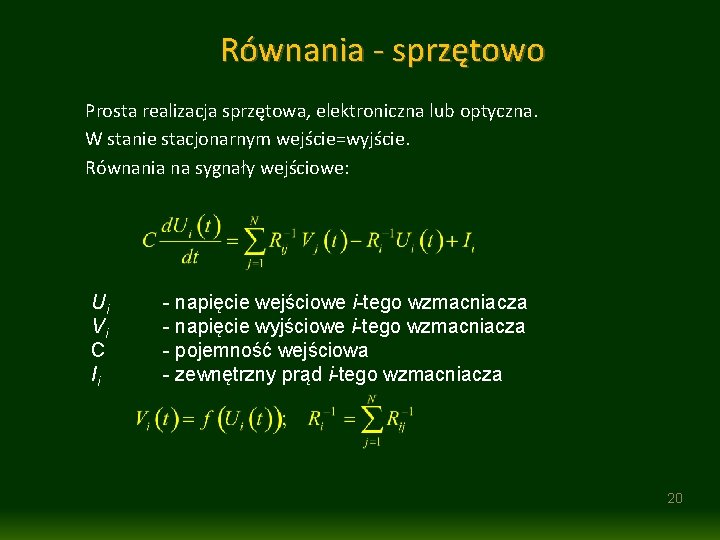

Równania - sprzętowo Prosta realizacja sprzętowa, elektroniczna lub optyczna. W stanie stacjonarnym wejście=wyjście. Równania na sygnały wejściowe: Ui Vi C Ii - napięcie wejściowe i-tego wzmacniacza - napięcie wyjściowe i-tego wzmacniacza - pojemność wejściowa - zewnętrzny prąd i-tego wzmacniacza 20

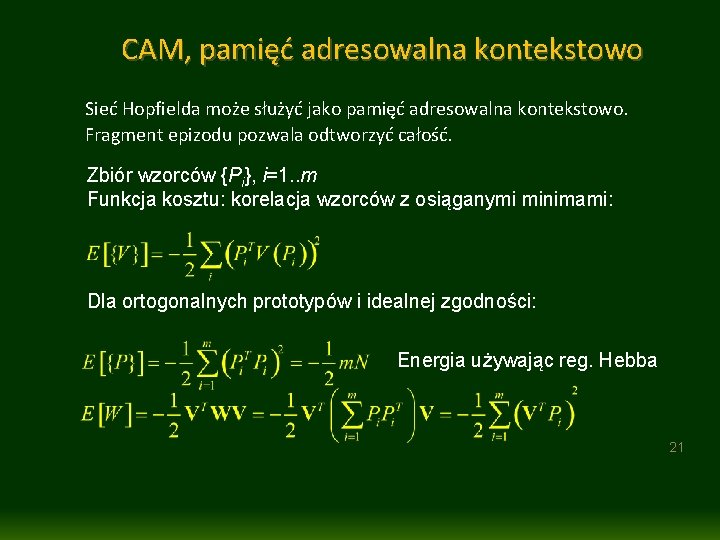

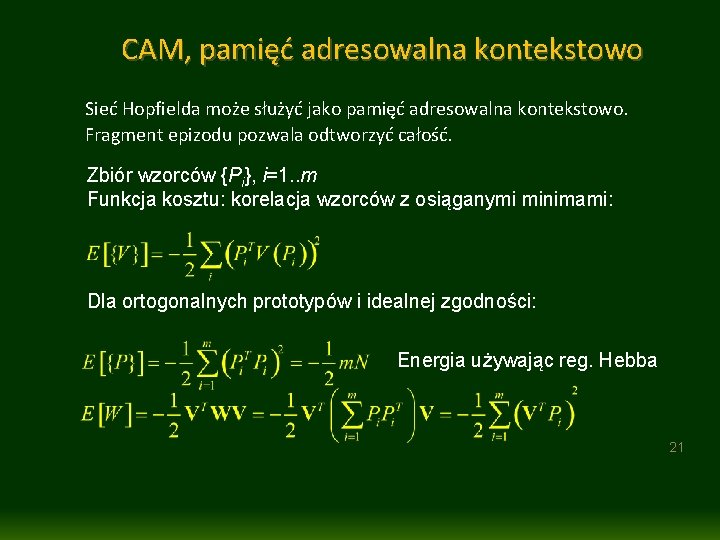

CAM, pamięć adresowalna kontekstowo Sieć Hopfielda może służyć jako pamięć adresowalna kontekstowo. Fragment epizodu pozwala odtworzyć całość. Zbiór wzorców {Pi}, i=1. . m Funkcja kosztu: korelacja wzorców z osiąganymi minimami: Dla ortogonalnych prototypów i idealnej zgodności: Energia używając reg. Hebba 21

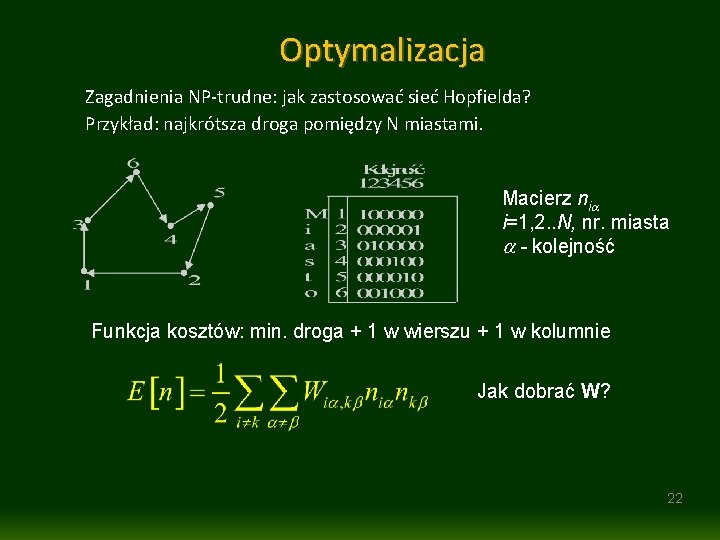

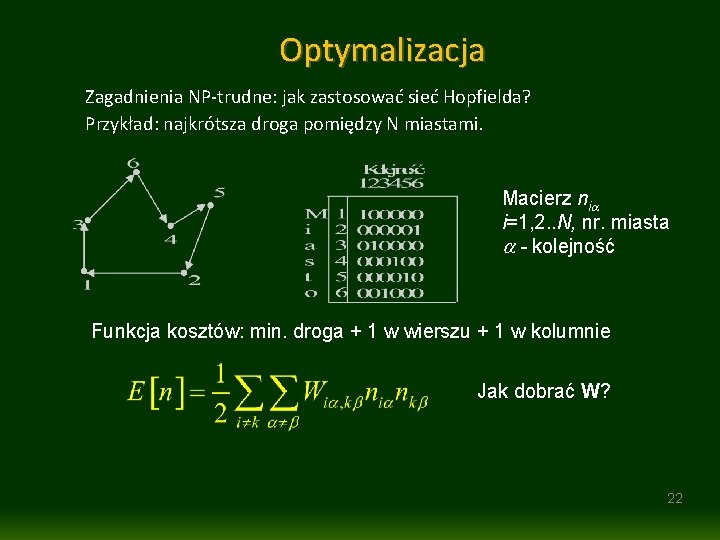

Optymalizacja Zagadnienia NP-trudne: jak zastosować sieć Hopfielda? Przykład: najkrótsza droga pomiędzy N miastami. Macierz nia i=1, 2. . N, nr. miasta a - kolejność Funkcja kosztów: min. droga + 1 w wierszu + 1 w kolumnie Jak dobrać W? 22

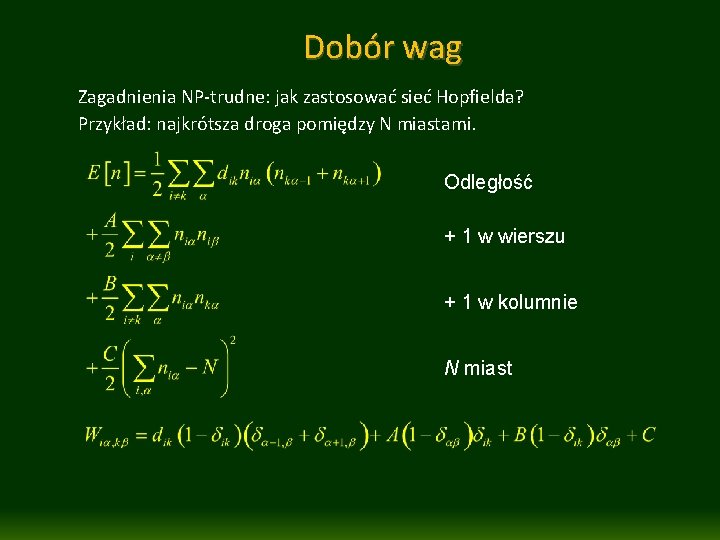

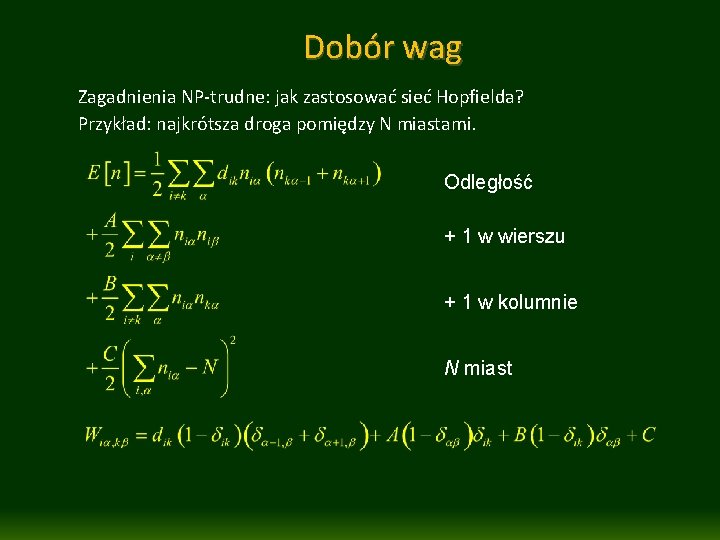

Dobór wag Zagadnienia NP-trudne: jak zastosować sieć Hopfielda? Przykład: najkrótsza droga pomiędzy N miastami. Odległość + 1 w wierszu + 1 w kolumnie N miast

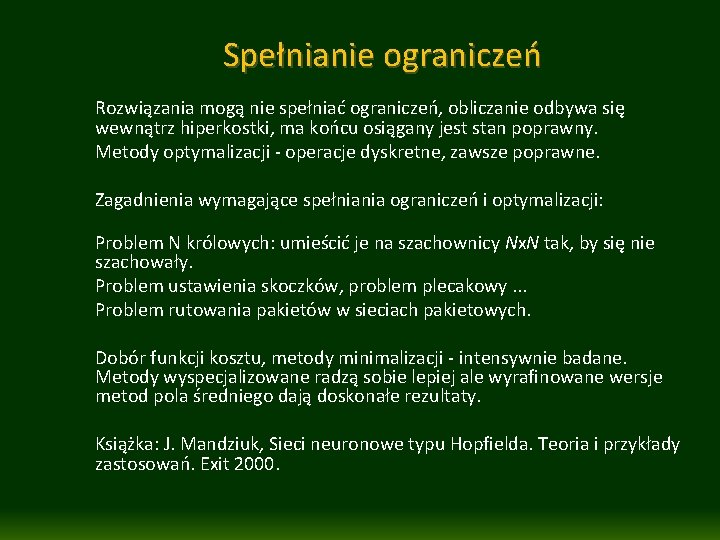

Spełnianie ograniczeń Rozwiązania mogą nie spełniać ograniczeń, obliczanie odbywa się wewnątrz hiperkostki, ma końcu osiągany jest stan poprawny. Metody optymalizacji - operacje dyskretne, zawsze poprawne. Zagadnienia wymagające spełniania ograniczeń i optymalizacji: Problem N królowych: umieścić je na szachownicy Nx. N tak, by się nie szachowały. Problem ustawienia skoczków, problem plecakowy. . . Problem rutowania pakietów w sieciach pakietowych. Dobór funkcji kosztu, metody minimalizacji - intensywnie badane. Metody wyspecjalizowane radzą sobie lepiej ale wyrafinowane wersje metod pola średniego dają doskonałe rezultaty. Książka: J. Mandziuk, Sieci neuronowe typu Hopfielda. Teoria i przykłady zastosowań. Exit 2000.

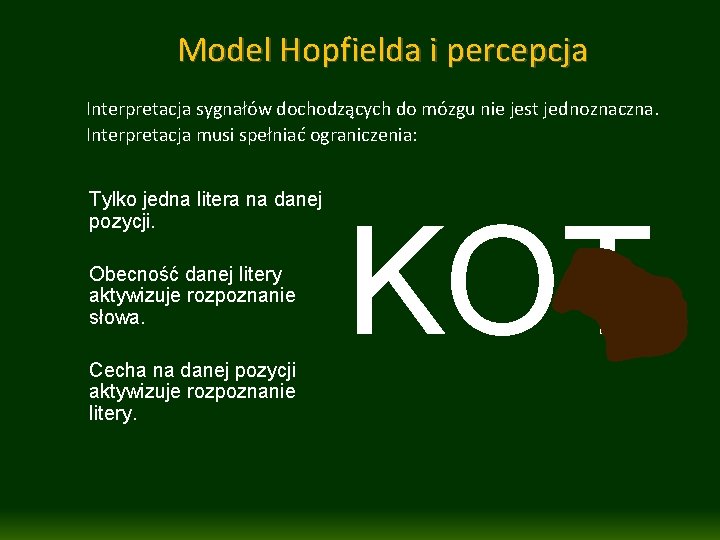

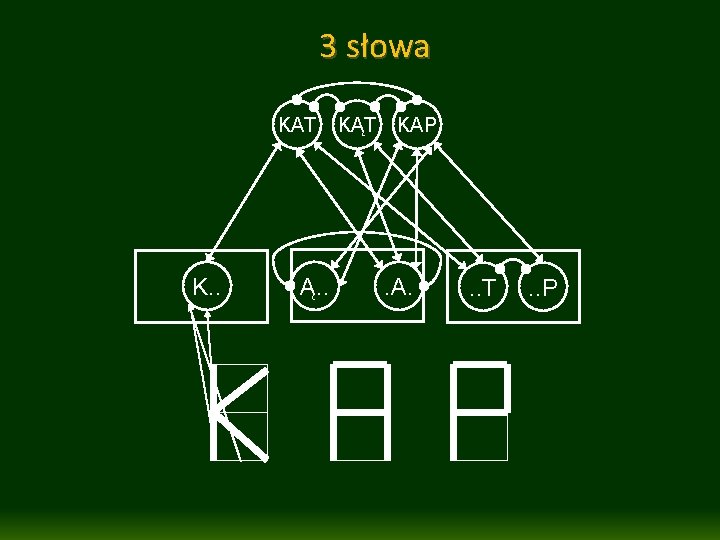

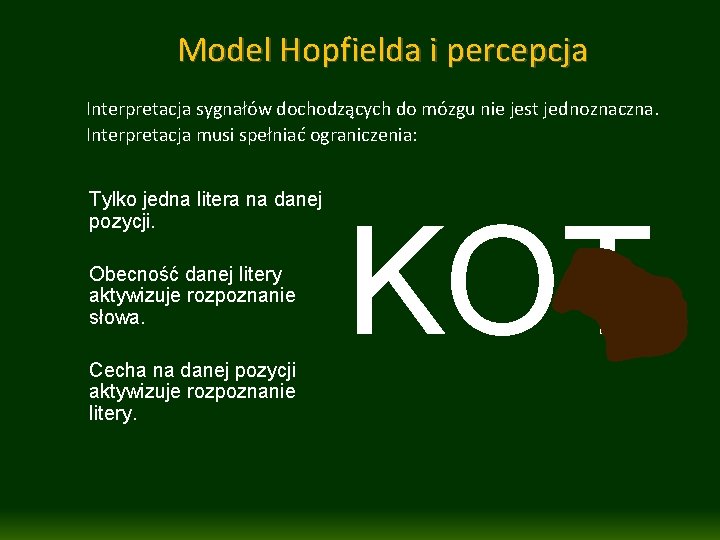

Model Hopfielda i percepcja Interpretacja sygnałów dochodzących do mózgu nie jest jednoznaczna. Interpretacja musi spełniać ograniczenia: Tylko jedna litera na danej pozycji. Obecność danej litery aktywizuje rozpoznanie słowa. Cecha na danej pozycji aktywizuje rozpoznanie litery. KOT

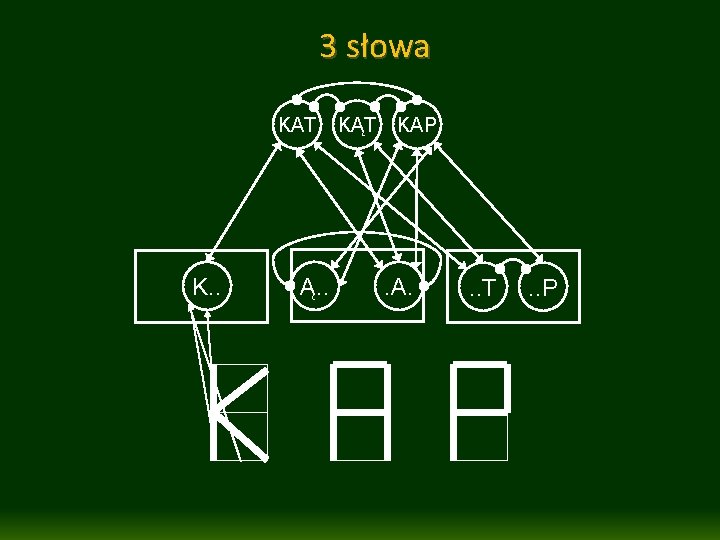

3 słowa KAT K. . Ą. . KĄT KAP . A. . . T . . P

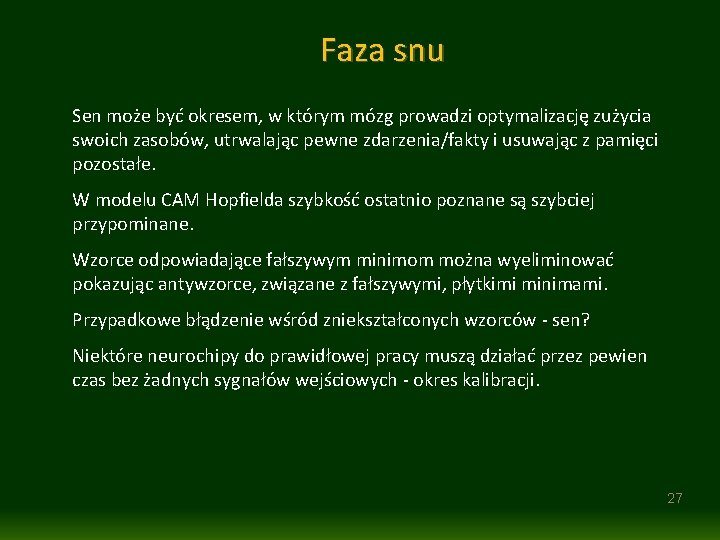

Faza snu Sen może być okresem, w którym mózg prowadzi optymalizację zużycia swoich zasobów, utrwalając pewne zdarzenia/fakty i usuwając z pamięci pozostałe. W modelu CAM Hopfielda szybkość ostatnio poznane są szybciej przypominane. Wzorce odpowiadające fałszywym minimom można wyeliminować pokazując antywzorce, związane z fałszywymi, płytkimi minimami. Przypadkowe błądzenie wśród zniekształconych wzorców - sen? Niektóre neurochipy do prawidłowej pracy muszą działać przez pewien czas bez żadnych sygnałów wejściowych - okres kalibracji. 27

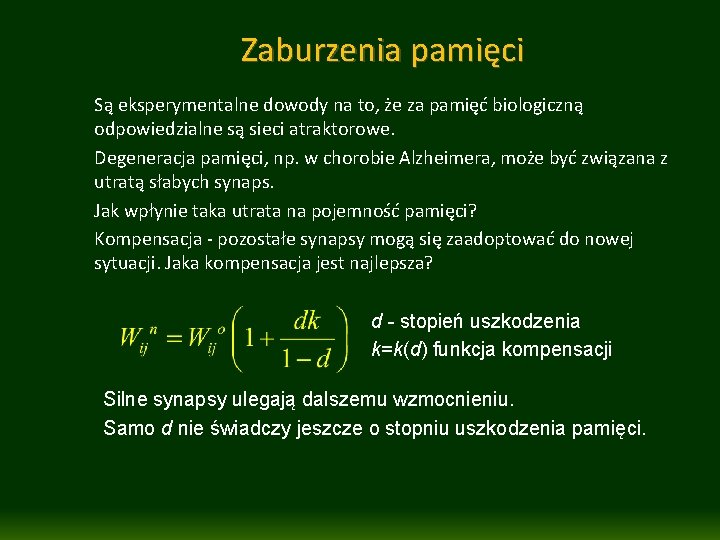

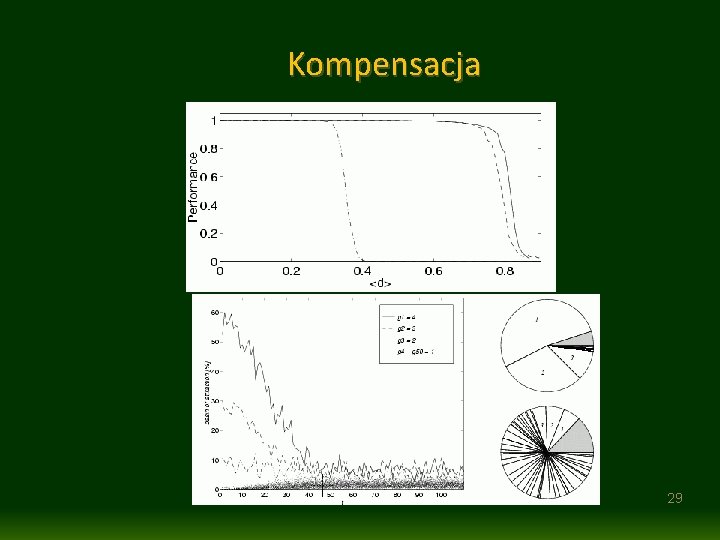

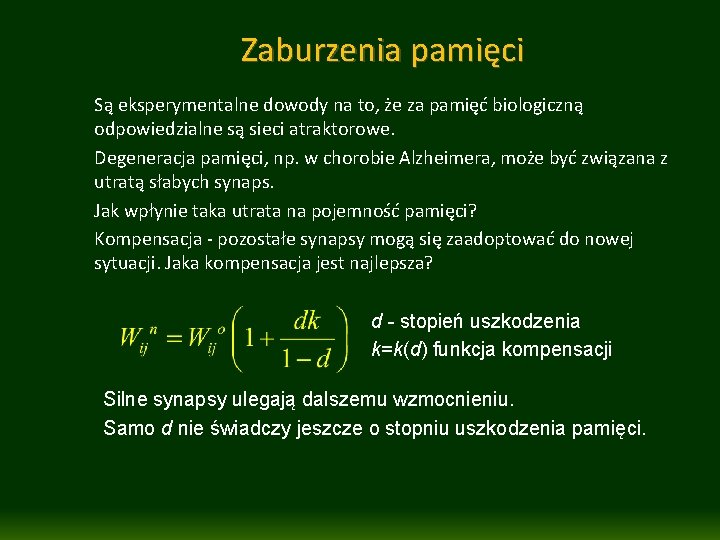

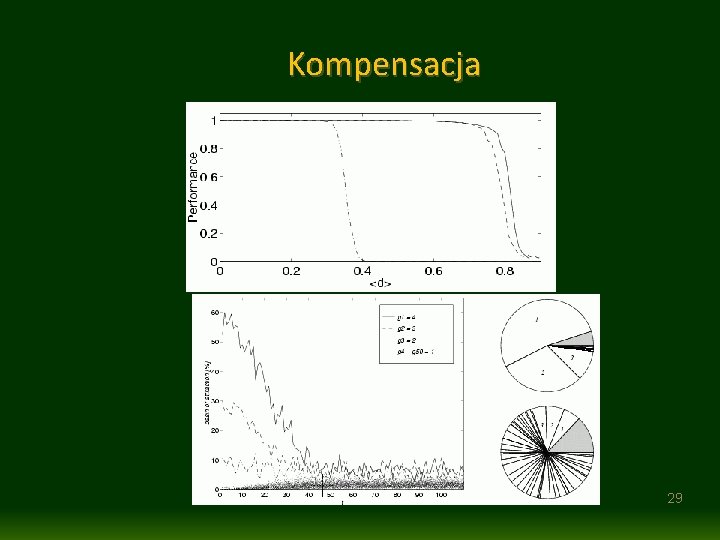

Zaburzenia pamięci Są eksperymentalne dowody na to, że za pamięć biologiczną odpowiedzialne są sieci atraktorowe. Degeneracja pamięci, np. w chorobie Alzheimera, może być związana z utratą słabych synaps. Jak wpłynie taka utrata na pojemność pamięci? Kompensacja - pozostałe synapsy mogą się zaadoptować do nowej sytuacji. Jaka kompensacja jest najlepsza? d - stopień uszkodzenia k=k(d) funkcja kompensacji Silne synapsy ulegają dalszemu wzmocnieniu. Samo d nie świadczy jeszcze o stopniu uszkodzenia pamięci.

Kompensacja 29

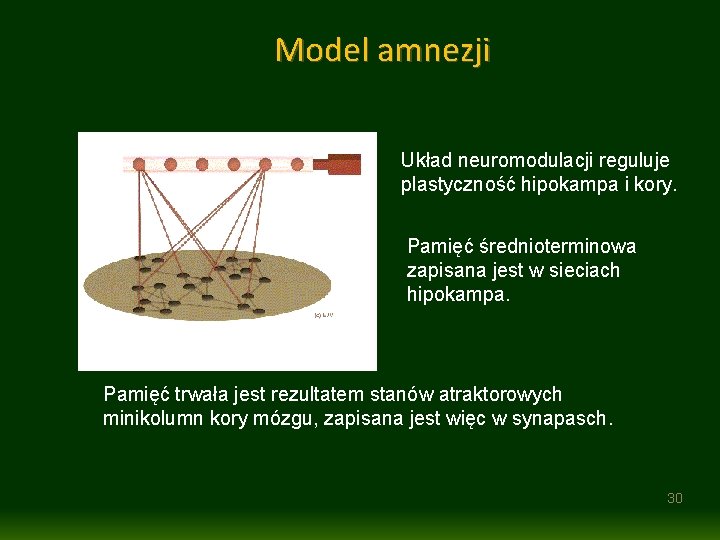

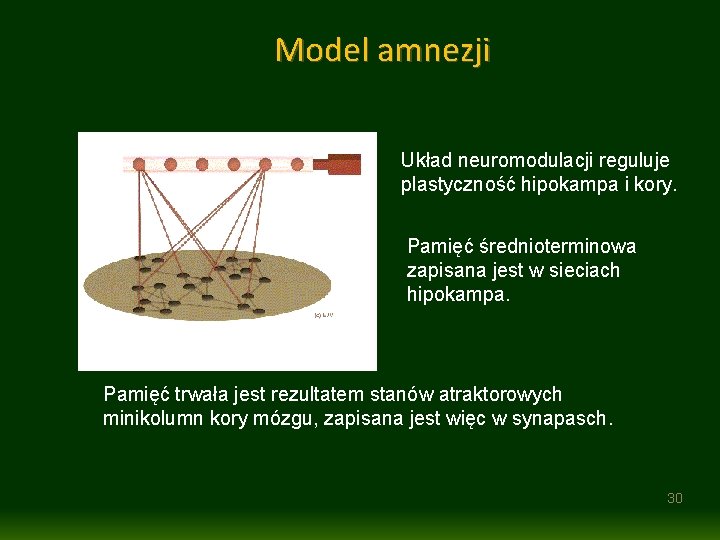

Model amnezji Układ neuromodulacji reguluje plastyczność hipokampa i kory. Pamięć średnioterminowa zapisana jest w sieciach hipokampa. Pamięć trwała jest rezultatem stanów atraktorowych minikolumn kory mózgu, zapisana jest więc w synapasch. 30

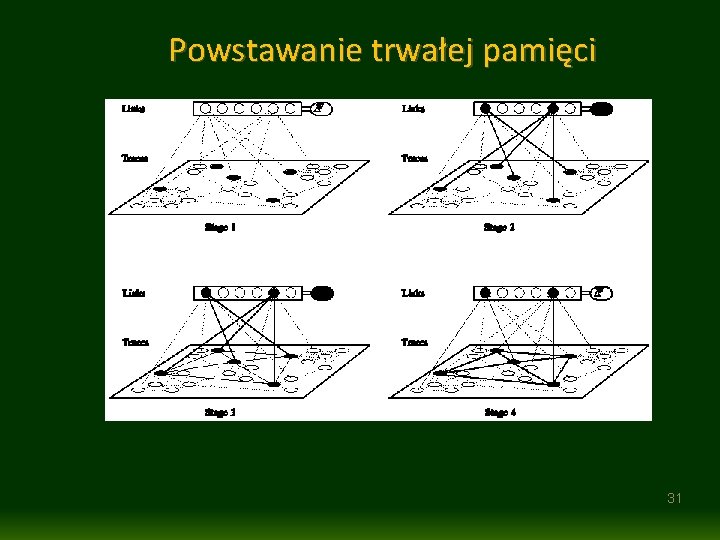

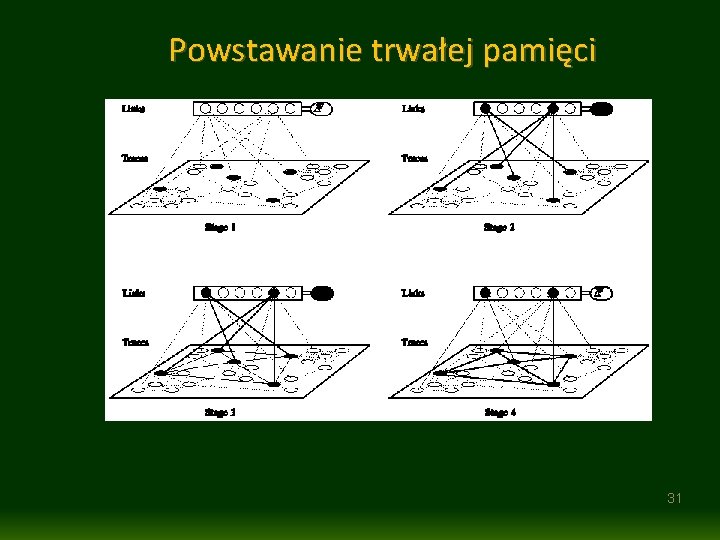

Powstawanie trwałej pamięci 31

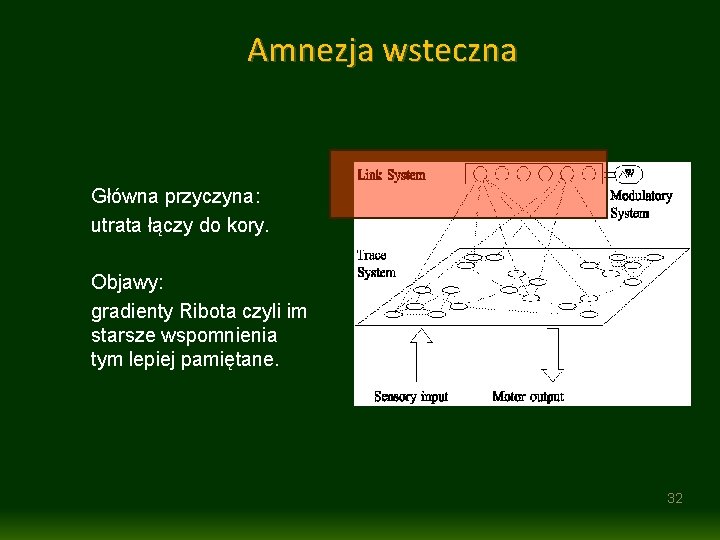

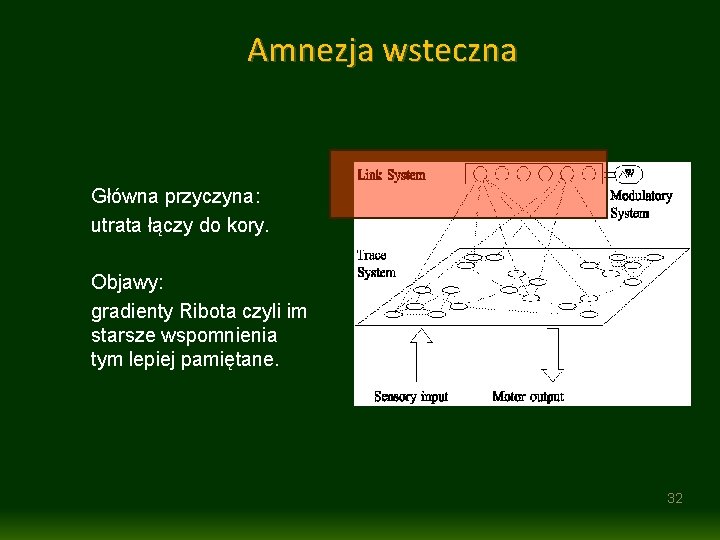

Amnezja wsteczna Główna przyczyna: utrata łączy do kory. Objawy: gradienty Ribota czyli im starsze wspomnienia tym lepiej pamiętane. 32

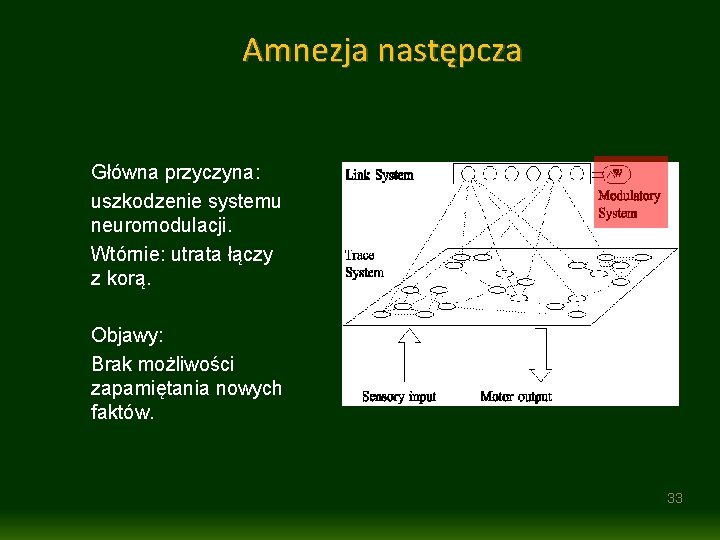

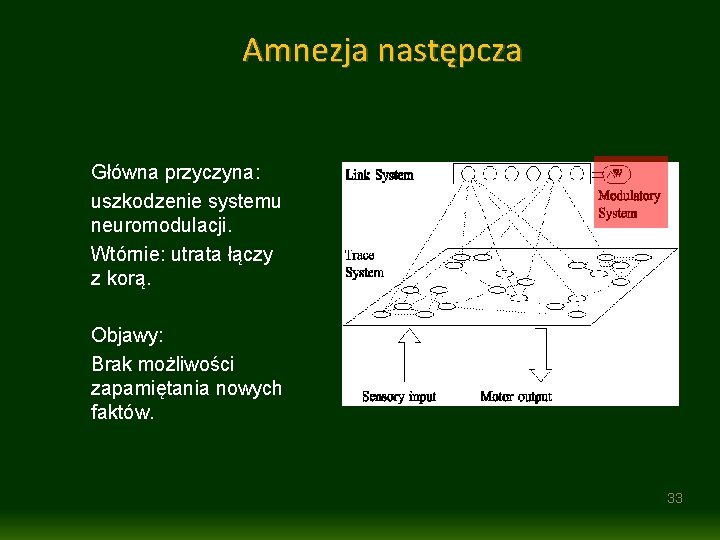

Amnezja następcza Główna przyczyna: uszkodzenie systemu neuromodulacji. Wtórnie: utrata łączy z korą. Objawy: Brak możliwości zapamiętania nowych faktów. 33

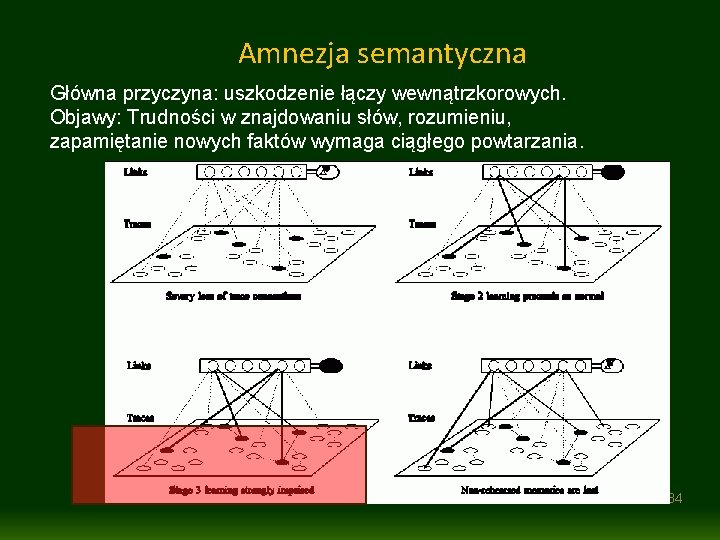

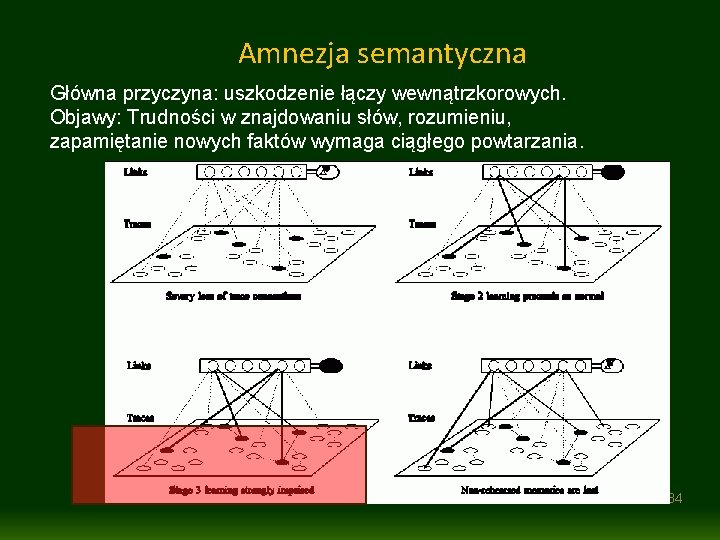

Amnezja semantyczna Główna przyczyna: uszkodzenie łączy wewnątrzkorowych. Objawy: Trudności w znajdowaniu słów, rozumieniu, zapamiętanie nowych faktów wymaga ciągłego powtarzania. 34

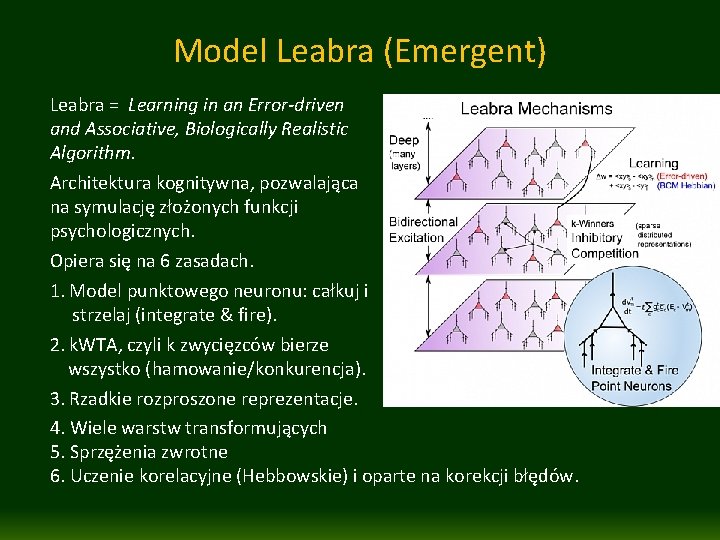

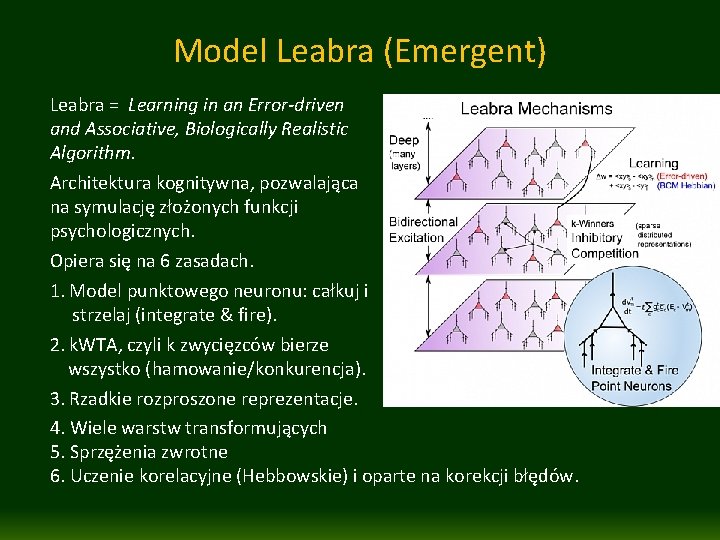

Model Leabra (Emergent) Leabra = Learning in an Error-driven and Associative, Biologically Realistic Algorithm. Architektura kognitywna, pozwalająca na symulację złożonych funkcji psychologicznych. Opiera się na 6 zasadach. 1. Model punktowego neuronu: całkuj i strzelaj (integrate & fire). 2. k. WTA, czyli k zwycięzców bierze wszystko (hamowanie/konkurencja). 3. Rzadkie rozproszone reprezentacje. 4. Wiele warstw transformujących 5. Sprzężenia zwrotne 6. Uczenie korelacyjne (Hebbowskie) i oparte na korekcji błędów.

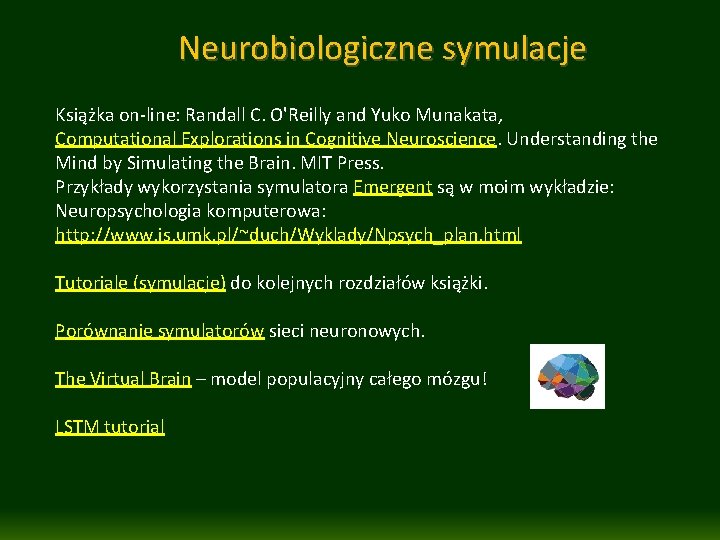

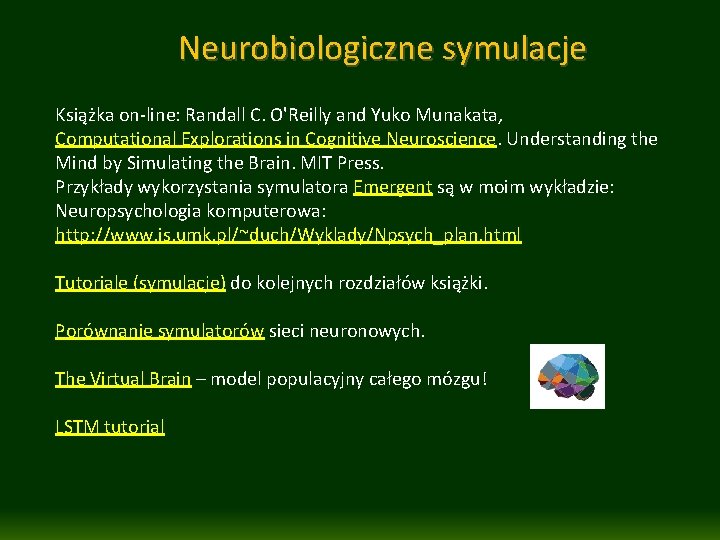

Neurobiologiczne symulacje Książka on-line: Randall C. O'Reilly and Yuko Munakata, Computational Explorations in Cognitive Neuroscience. Understanding the Mind by Simulating the Brain. MIT Press. Przykłady wykorzystania symulatora Emergent są w moim wykładzie: Neuropsychologia komputerowa: http: //www. is. umk. pl/~duch/Wyklady/Npsych_plan. html Tutoriale (symulacje) do kolejnych rozdziałów książki. Porównanie symulatorów sieci neuronowych. The Virtual Brain – model populacyjny całego mózgu! LSTM tutorial

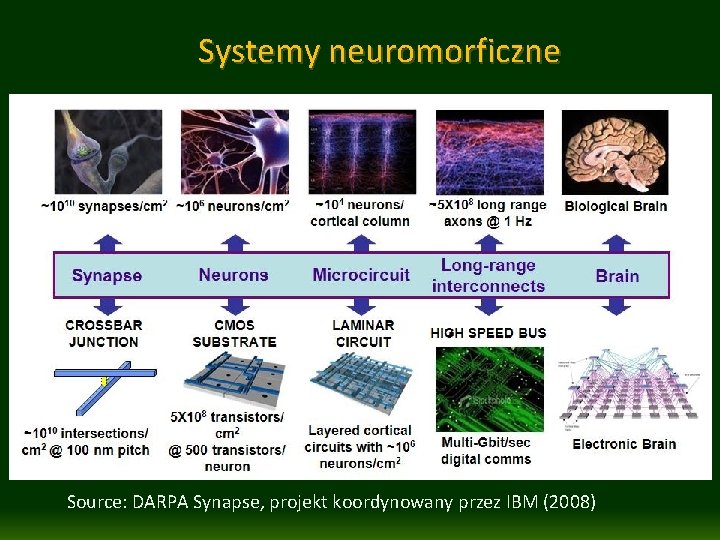

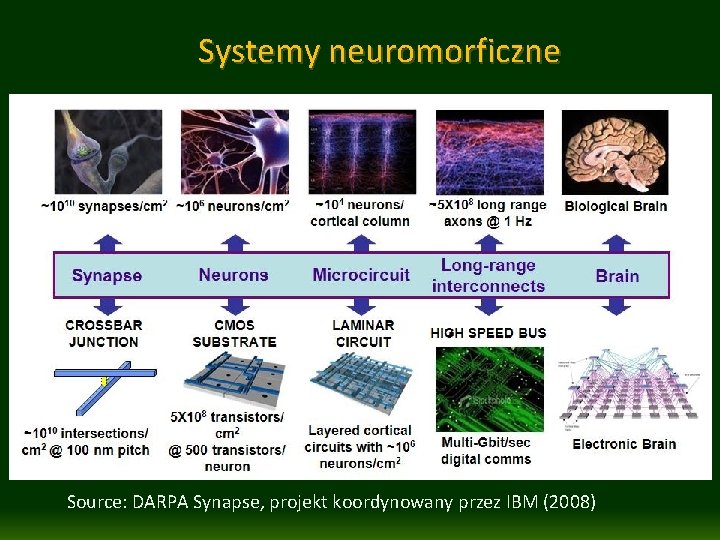

Systemy neuromorficzne Source: DARPA Synapse, projekt koordynowany przez IBM (2008)

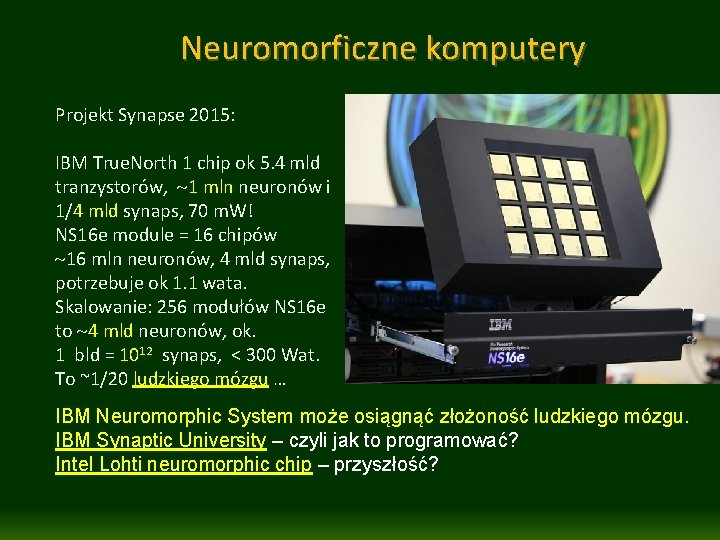

Neuromorficzne komputery Projekt Synapse 2015: IBM True. North 1 chip ok 5. 4 mld tranzystorów, ~1 mln neuronów i 1/4 mld synaps, 70 m. W! NS 16 e module = 16 chipów ~16 mln neuronów, 4 mld synaps, potrzebuje ok 1. 1 wata. Skalowanie: 256 modułów NS 16 e to ~4 mld neuronów, ok. 1 bld = 1012 synaps, < 300 Wat. To ~1/20 ludzkiego mózgu … IBM Neuromorphic System może osiągnąć złożoność ludzkiego mózgu. IBM Synaptic University – czyli jak to programować? Intel Lohti neuromorphic chip – przyszłość?

Koniec wykładu 10

Neurodynamika Spoczynkowa aktywność neuronów (1 -5 impulsów/sek) Ok. 10. 000 impulsów/sek dochodzi do neuronu w pobliżu progu. 1. Stabilna sieć z aktywnością spoczynkową: globalny atraktor. 2. Uczenie się przez tworzenie nowych atraktorów. Model Amit, Brunel 1995 Aktywność tła ma charakter stochastyczny. Jednorodność: neurony w identycznym środowisku. Impulsy wysyłane przez różne neurony nie są skorelowane. Aktywacja neuronu jest sumą wkładów synaptycznych. Gaussowski rozkład wkładów synaptycznych. Wystarczy aktywność neuronu = liczbie impulsów na sekundę.

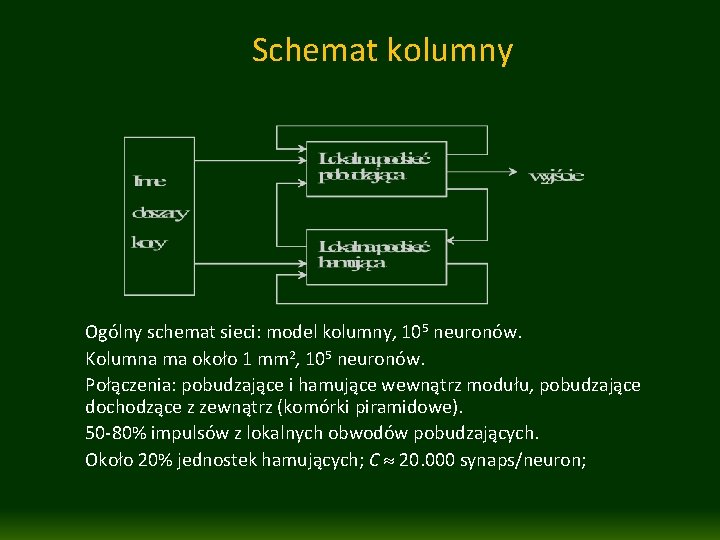

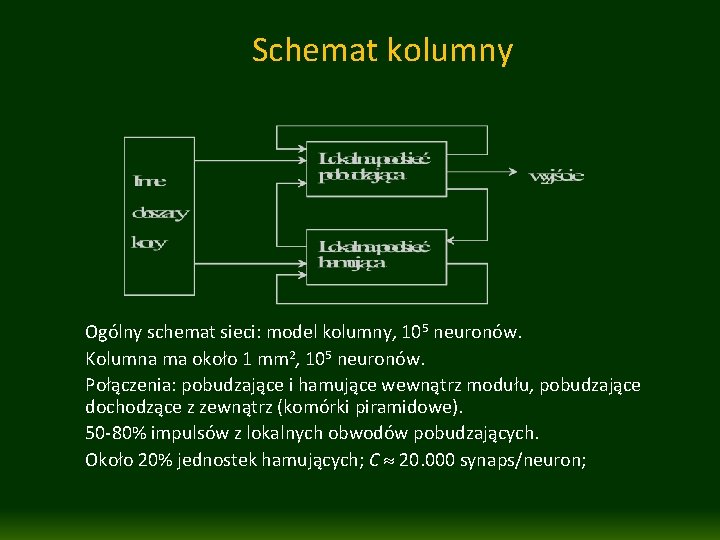

Schemat kolumny Ogólny schemat sieci: model kolumny, 105 neuronów. Kolumna ma około 1 mm 2, 105 neuronów. Połączenia: pobudzające i hamujące wewnątrz modułu, pobudzające dochodzące z zewnątrz (komórki piramidowe). 50 -80% impulsów z lokalnych obwodów pobudzających. Około 20% jednostek hamujących; C 20. 000 synaps/neuron;

Struktura sieci Sieć złożona z lokalnych modułów. Uczenie: początkowo moduł biorący udział w rozpoznawaniu zwiększa w nieselektywny sposób częstość impulsacji dla wszystkich sygnałów. Powyżej krytycznej wartości wzmocnienia LTP pojawiają się lokalne atraktory na tle globalnej aktywności - struktura sygnału uczącego. Aktywność spoczynkowa rośnie do około 20 Hz, utrzymuje się po zniknięciu bodźca - aktywna reprezentacja bodźca w pamięci. Pobudzenia wewnętrzne silniejsze niż zewnętrzne, utrzymują spontaniczną aktywność, modelowane przez rozkład Poissona. 50 -80% impulsów z lokalnych obwodów pobudzających o modyfikowalnych synapsach. Depolaryzacja membrany V(t) o t 10 ms opisana jest równaniem:

Działanie modelu Symulacja modułu z 2000 neuronów: spontaniczna aktywność jest stabilna w czasie lokalnego uczenia się, moduł uczący się ma podwyższoną częstość impulsacji wśród neuronów biorących udział w kodowaniu wzorca i obniżoną wśród pozostałych. Podwyższenie średniej częstości impulsacji przy prezentacji wzorców zapowiada pojawienie się nowego atraktora: pojawia się bifurkacja i dwa rozwiązania stabilne: spontaniczna aktywność + atraktor lokalny. Dobra zgodność z obserwacjami neurofizjologicznymi, opartymi na pomiarach aktywności neuronów małp w czasie wykonywania zadań wymagających aktywnej pamięci pokazywanego przez krótki czas bodźca (delayed match-to-sample). Podwyższona aktywność spontaniczna widoczna w trakcie uczenia, po nauczeniu widać aktywność związana z lokalnymi atraktorami.

Inwariantne

Inwariantne Sieci neuronowe

Sieci neuronowe Dziedziczenie dynamiczne

Dziedziczenie dynamiczne Dziedziczenie wieloaspektowe

Dziedziczenie wieloaspektowe Algorytm zachłanny problem plecakowy

Algorytm zachłanny problem plecakowy Duch prorocki a wróżby

Duch prorocki a wróżby Patryk duch

Patryk duch Príď svätý duch vojdi do nás

Príď svätý duch vojdi do nás Duch svätý symboly

Duch svätý symboly Google duch

Google duch Duch

Duch Formułka pragniemy, aby duch święty

Formułka pragniemy, aby duch święty Hebrajskie duch to

Hebrajskie duch to Dziady prezentacja

Dziady prezentacja Max weber protestantská etika a duch kapitalismu

Max weber protestantská etika a duch kapitalismu Dotkni sa mojich očí pane

Dotkni sa mojich očí pane Lau duch

Lau duch W zdrowym ciele zdrowy duch wikipedia

W zdrowym ciele zdrowy duch wikipedia Gdzie duch pana jest obecny tam jest wolność

Gdzie duch pana jest obecny tam jest wolność Sieć globalna wan

Sieć globalna wan Obliczanie przepustowości sieci

Obliczanie przepustowości sieci Nie ufaj osobom poznanym w sieci

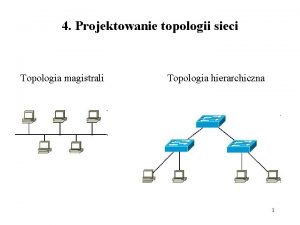

Nie ufaj osobom poznanym w sieci Topologia hierarchiczna

Topologia hierarchiczna Nie wierz wszystkiemu co czytasz w sieci

Nie wierz wszystkiemu co czytasz w sieci Schemat szkolnej sieci komputerowej

Schemat szkolnej sieci komputerowej Cechy sieci lan

Cechy sieci lan Zasady modernizacji lokalnej sieci komputerowej

Zasady modernizacji lokalnej sieci komputerowej Sieci komputerowe

Sieci komputerowe Stronicowanie na żądanie

Stronicowanie na żądanie Adresacja klasowa

Adresacja klasowa Prezentacja o cyberprzemocy

Prezentacja o cyberprzemocy Net art przykłady

Net art przykłady Podział sieci na podsieci

Podział sieci na podsieci Zasady bezpiecznej pracy w sieci

Zasady bezpiecznej pracy w sieci Xor split

Xor split Podział sieci komputerowych

Podział sieci komputerowych Obliczanie strat ciśnienia w sieci wodociągowej

Obliczanie strat ciśnienia w sieci wodociągowej Jedną z cech dobrze zaprojektowanej sieci nie jest

Jedną z cech dobrze zaprojektowanej sieci nie jest Schemat logiczny sieci

Schemat logiczny sieci Sieć komputerowa definicja

Sieć komputerowa definicja Podział sieci ze względu na zasięg

Podział sieci ze względu na zasięg Jaki typ sieci zainstalowałbyś w swojej szkole

Jaki typ sieci zainstalowałbyś w swojej szkole Climax brzesko internet

Climax brzesko internet Sieci przemysłowe asi

Sieci przemysłowe asi