Redes Neuronales Artificiales 2 Aprendizaje Dr Juan Jos

- Slides: 30

Redes Neuronales Artificiales 2 - Aprendizaje Dr. Juan José Flores Romero División de Estudios de Posgrado Facultad de Ingeniería Eléctrica juanf@zeus. umich. mx http: //lsc. fie. umich. mx/~juan/Materias/ANN

Curso Redes Neuronales Artificiales CONTENIDO Introducción n Aprendizaje n Perceptrones mono-nivel n Perceptrones multi-nivel n Otras Arquitecturas n

Redes Neuronales Artificiales RNA: Habilidad de aprender del medio ambiente y mejorar su desempeño por medio del aprendizaje. Aprendizaje: Proceso por el cual los parámetros (pesos sinápticos) de una RNA se adaptan por estimulación del medio ambiente. Algoritmo de Aprendizaje: Conjunto bien definido de reglas para actualizar los pesos sinápticos. Paradigma de Aprendizaje: Modelo del medio ambiente en el cual la RNA opera.

Algoritmos de Aprendizaje Corrección de Error n Basado en Memoria n Hebbian n Competitivo n Boltzmann n

Paradigmas de Aprendizaje Supervizado n No Supervisado n n. Por Refuerzos n. No Supervisado

Tareas de Aprendizaje Asociación de Patrones n Reconocimiento de Patrones n Aproximación Funcional n Control n Filtrado n

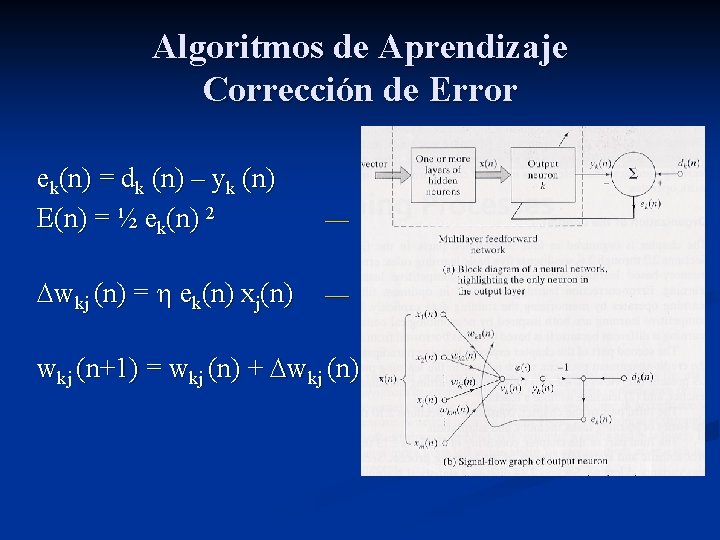

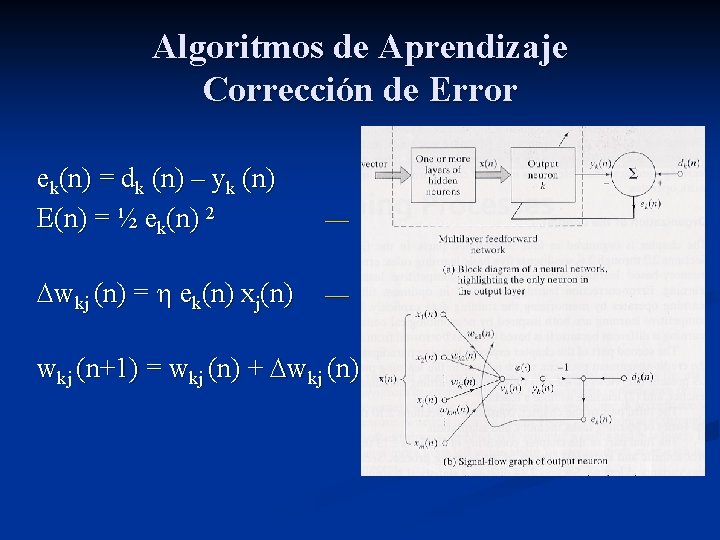

Algoritmos de Aprendizaje Corrección de Error ek(n) = dk (n) – yk (n) E(n) = ½ ek(n) 2 — Error Energy wkj (n) = ek(n) xj(n) — Delta Rule (Widrow-Hoff) wkj (n+1) = wkj (n) + wkj (n)

Algoritmos de Aprendizaje Basado en Memoria Almacenar ejemplos entrada – salida {(xi, di)} i=1, . . , N Ejemplo: Clasificación binaria Clases: C 1 y C 2 xtest (nuevo) es clasificado examinando su vecindad

Algoritmos de Aprendizaje Basado en Memoria Componentes: n Criterio para definir vecindad n Regla de aprendizaje Ejemplo: Vecino más Cercano (Nearest Neighbor) x* e {x 1, x 2, . . , x. N} es el vmc de xtest si Mini d(xi, xtest ) = d(x*, xtest ) Donde d(xi, xtest ) es la distancia Euclideana

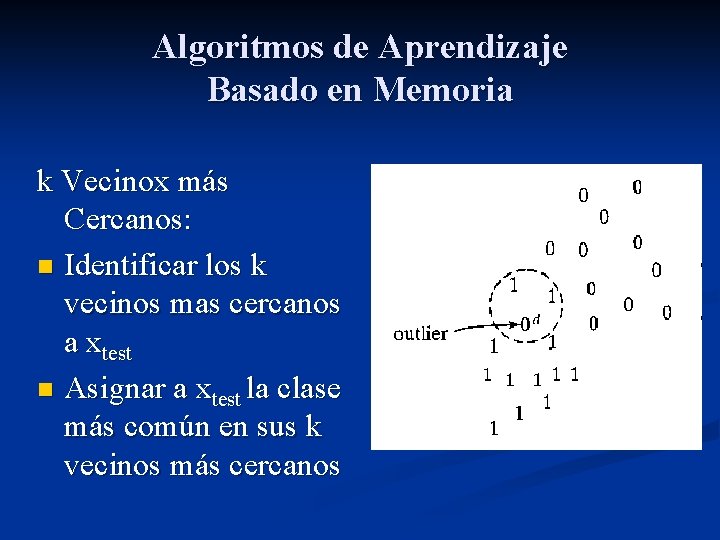

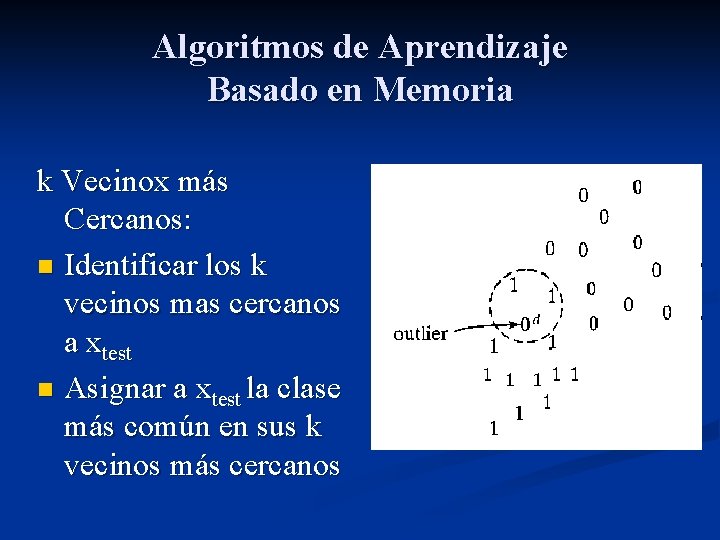

Algoritmos de Aprendizaje Basado en Memoria k Vecinox más Cercanos: n Identificar los k vecinos mas cercanos a xtest n Asignar a xtest la clase más común en sus k vecinos más cercanos

Algoritmos de Aprendizaje Hebbian Si dos neuronas vecinas se activan simultaneamente, el peso de su conexión se incrementa. 2. Si dos neuronas vecinas se activan asíncronamente, la conexión se debilita o elimina. La conexión se llama sinapsis hebbiana 1.

Algoritmos de Aprendizaje Hebbian Mecanismos en aprendizaje hebbiano 1. Dependiente del Tiempo. Aprendizaje depende de los tiempos de activación. 2. Local. Activaciones Espacio-Temporales. 3. Interactivo. Depende de la interacción entre neuronas vecinas. 4. Conjuncional (correlacional). La coocurrencia de señales produce una modificación de pesos.

Algoritmos de Aprendizaje Hebbian wkj – peso sináptico xj– señal presináptica yk– señal postsináptica wkj (n) = F(yk(n), xj(n)) wkj (n) = yk(n) xj(n) — Hebb´s hypothesis wkj (n) = (yk-yav) (xj(n)-xav) — Covariance Hypothesis

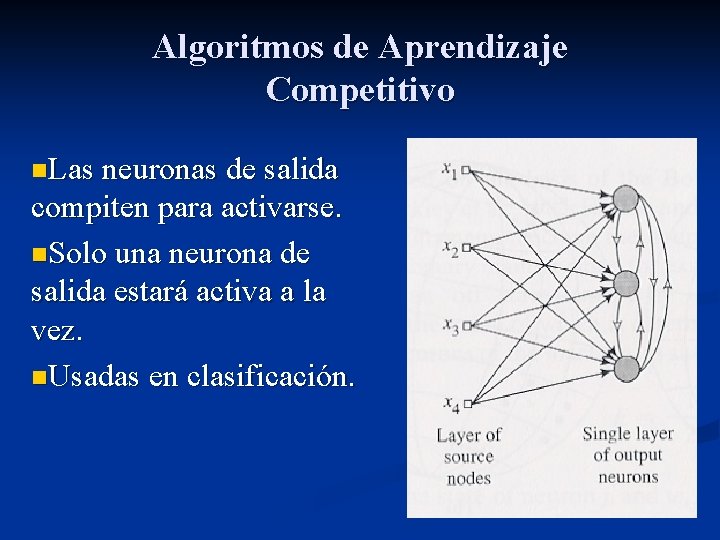

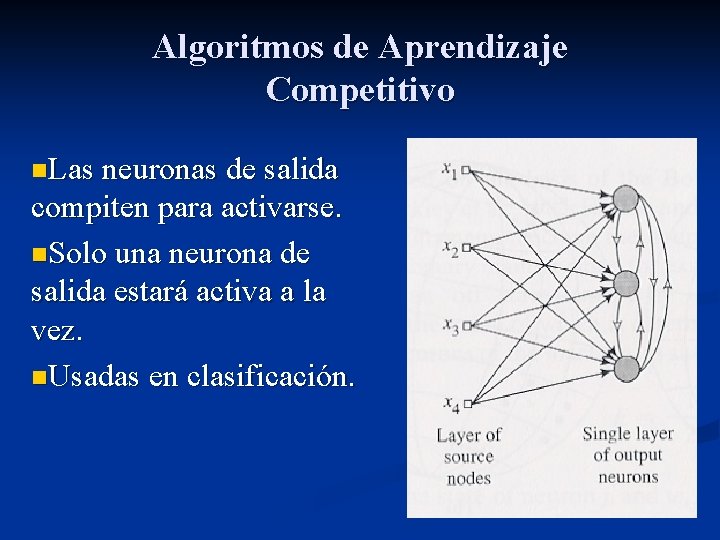

Algoritmos de Aprendizaje Competitivo n. Las neuronas de salida compiten para activarse. n. Solo una neurona de salida estará activa a la vez. n. Usadas en clasificación.

Algoritmos de Aprendizaje Competitivo yk= 1 si vk> vj j k yk= 0 otro caso i wkj = 1 k wkj = (xj – wkj) wkj = 0 si k gana si k pierde

Algoritmos de Aprendizaje Boltzmann Estructura recurrente Estados: 1 y -1 E = - ½ j k wkjxkxj para j k — Energy Seleccionar neurona k aleatoriamente Cambiar su estado a temperatura T con probabilidad wkj = ( kj+ – kj-) para j k

Algoritmos de Aprendizaje Boltzmann n Neuronas: n. Fijas (entradas) n. Libres n Utilizadas para modelar (aprender) una distribución de probabilidad de los datos de entrada. n Completan entradas incompletas.

Paradigmas de Aprendizaje Supervizado

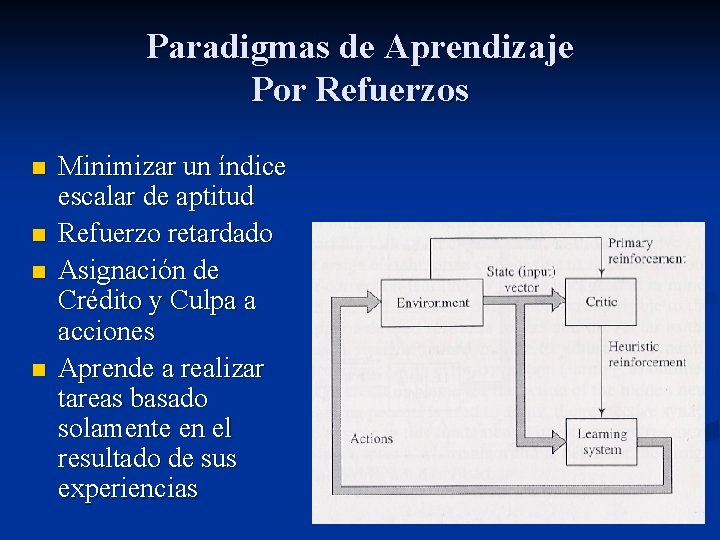

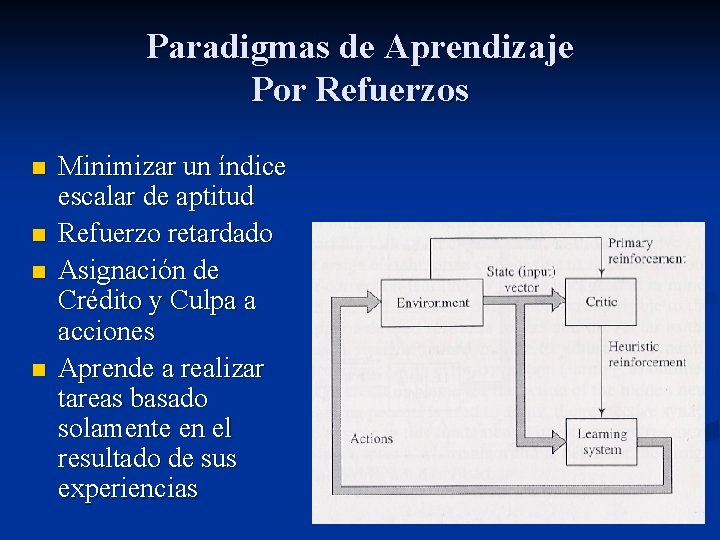

Paradigmas de Aprendizaje Por Refuerzos n n Minimizar un índice escalar de aptitud Refuerzo retardado Asignación de Crédito y Culpa a acciones Aprende a realizar tareas basado solamente en el resultado de sus experiencias

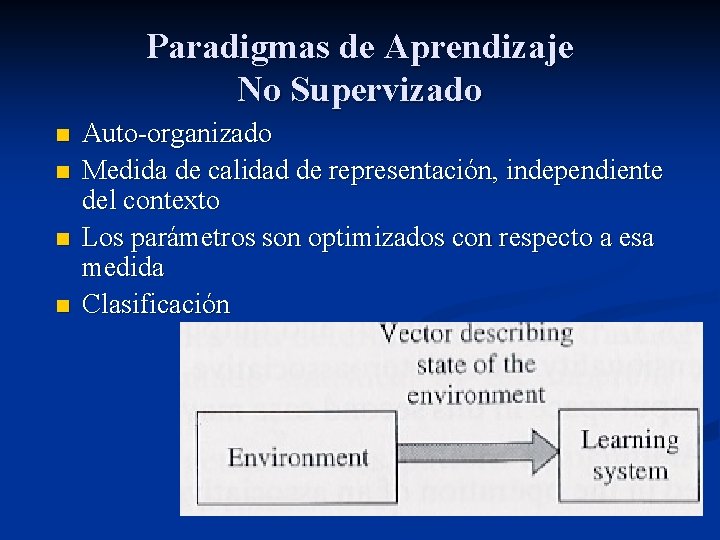

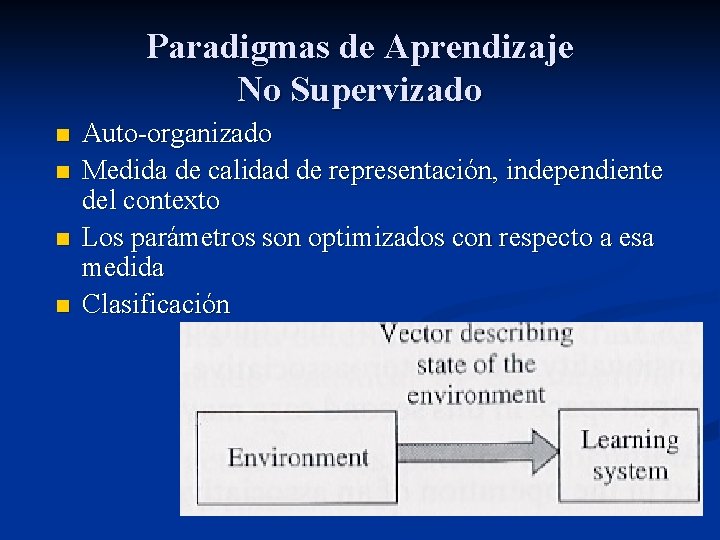

Paradigmas de Aprendizaje No Supervizado n n Auto-organizado Medida de calidad de representación, independiente del contexto Los parámetros son optimizados con respecto a esa medida Clasificación

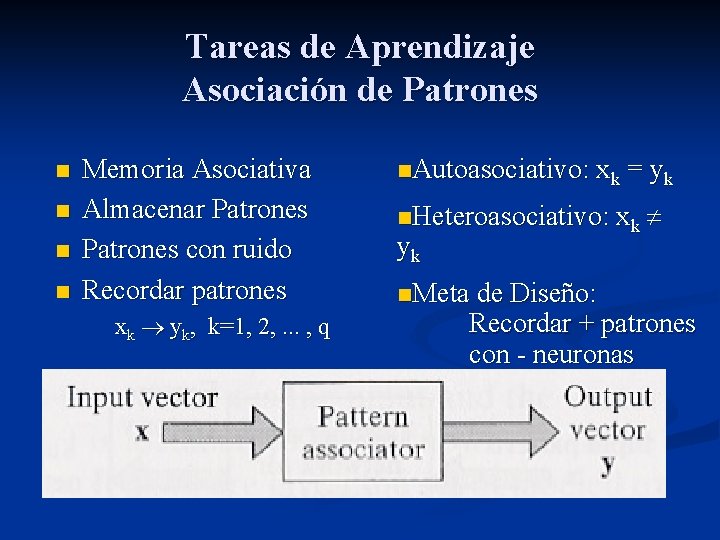

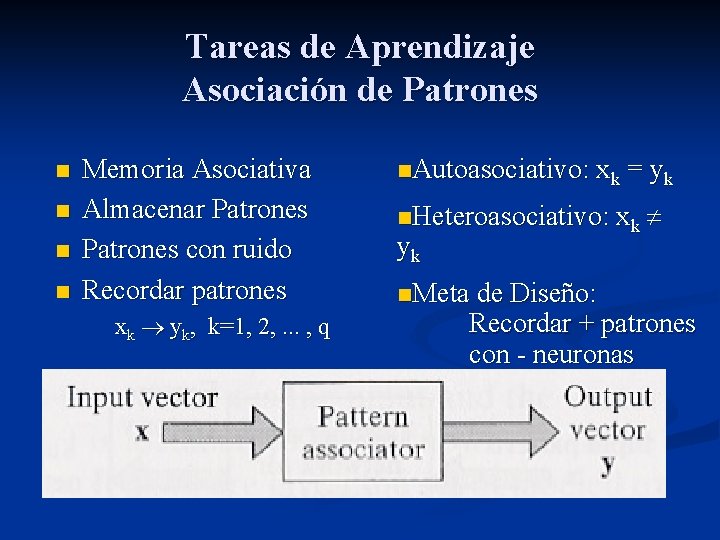

Tareas de Aprendizaje Asociación de Patrones n n Memoria Asociativa Almacenar Patrones con ruido Recordar patrones xk yk, k=1, 2, . . . , q n. Autoasociativo: xk = yk n. Heteroasociativo: xk yk n. Meta de Diseño: Recordar + patrones con - neuronas

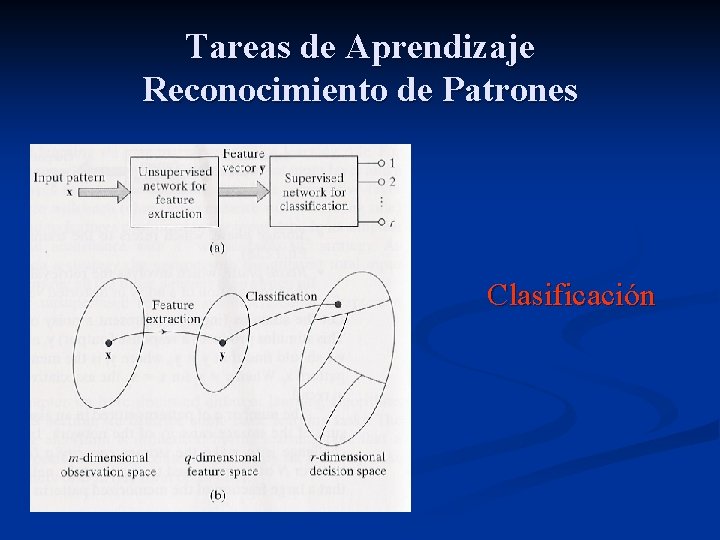

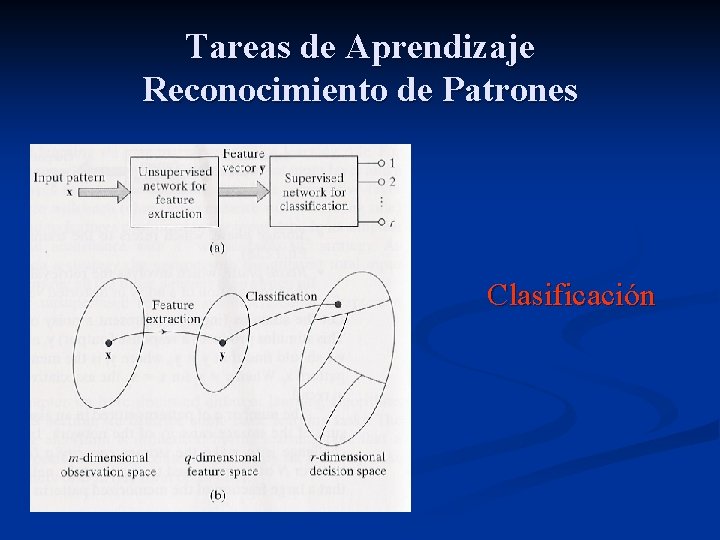

Tareas de Aprendizaje Reconocimiento de Patrones Clasificación

Tareas de Aprendizaje Aproximación Funcional n n d = f(x) T = {(xi, di)}, i=1, . . . , N F aproximación de f Meta: F(x) – f(x) < , x

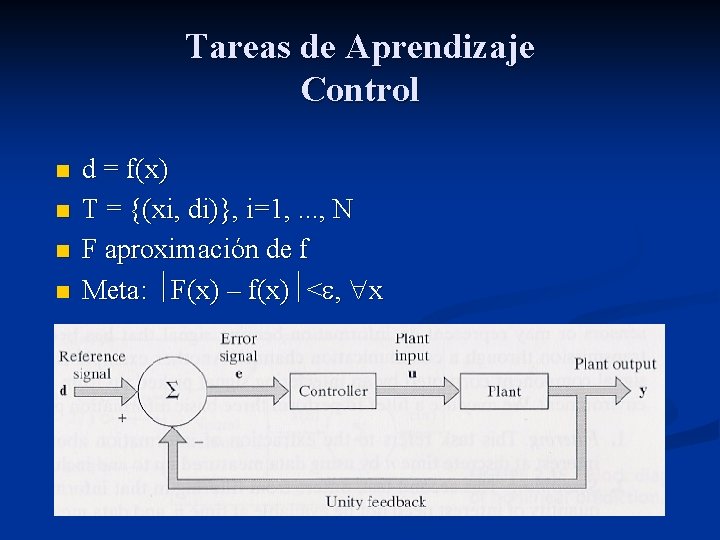

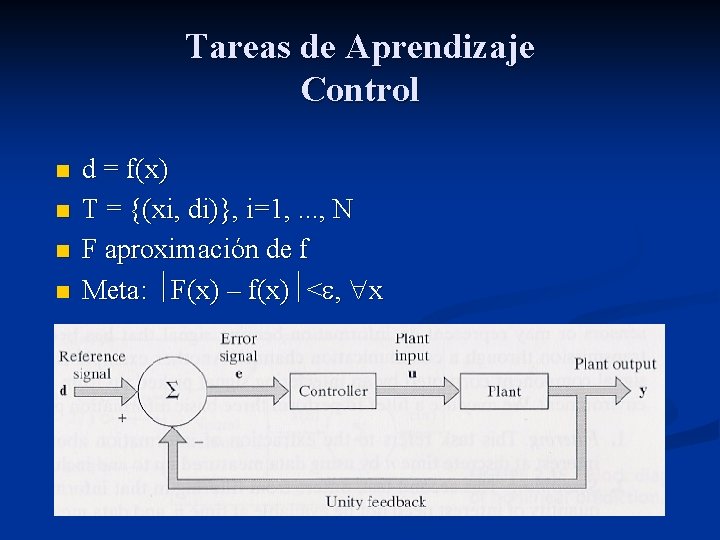

Tareas de Aprendizaje Control n n d = f(x) T = {(xi, di)}, i=1, . . . , N F aproximación de f Meta: F(x) – f(x) < , x

Tareas de Aprendizaje Filtrado. Extracción de información de una variable en el tiempo discreto n, usando mediciones hasta n. n Smoothing. Filtrado con retardo. n Predicción. Derivar información acerca del futuro de una variable, usando información pasada. n

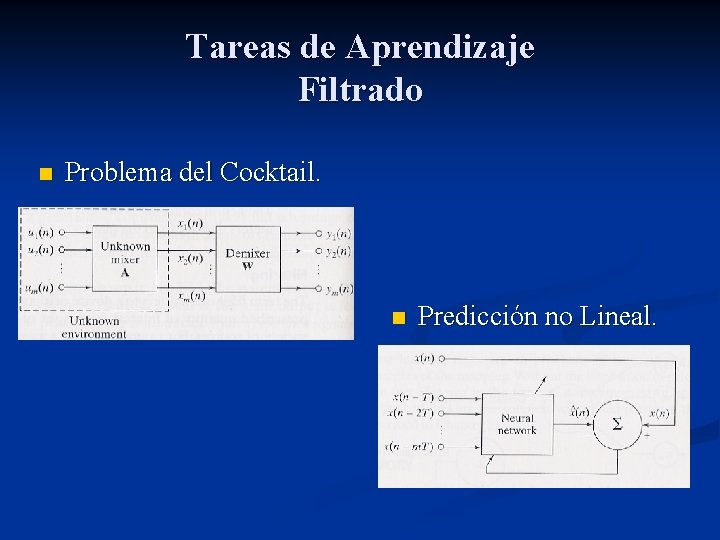

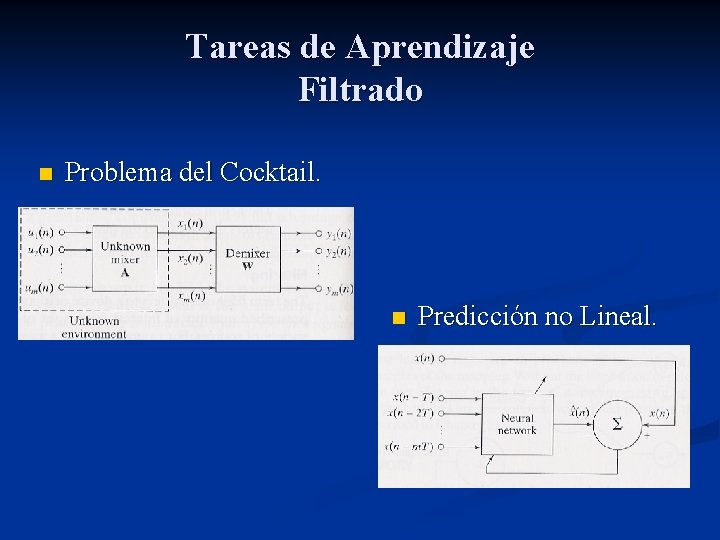

Tareas de Aprendizaje Filtrado n Problema del Cocktail. n Predicción no Lineal.

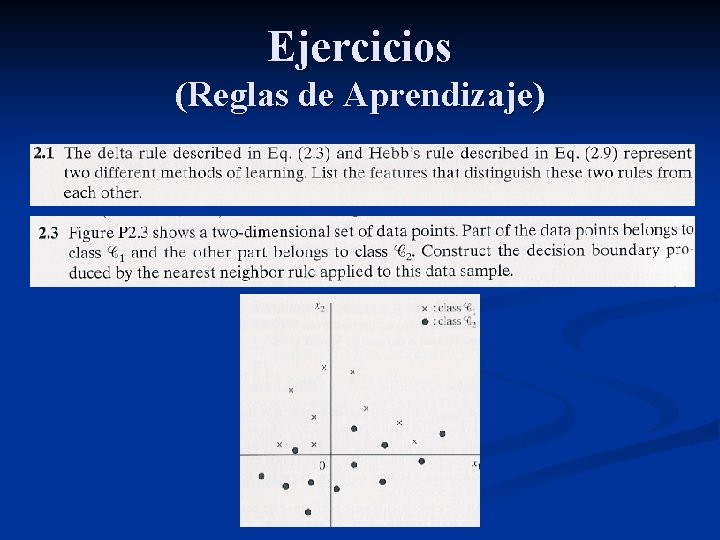

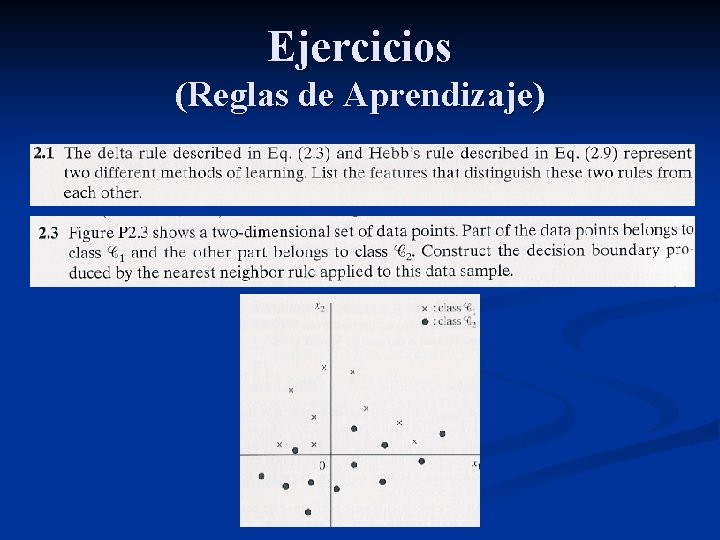

Ejercicios (Reglas de Aprendizaje)

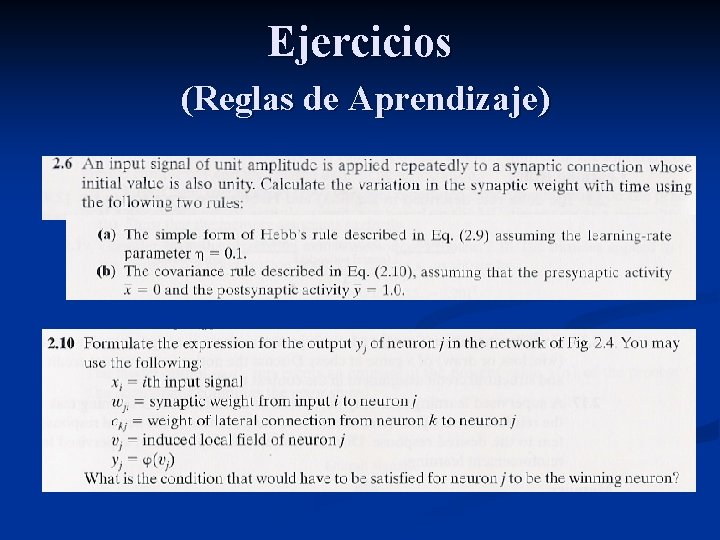

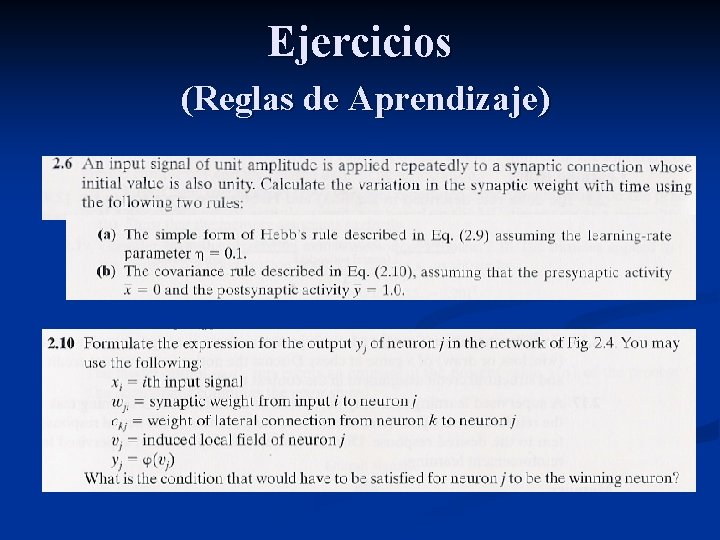

Ejercicios (Reglas de Aprendizaje)

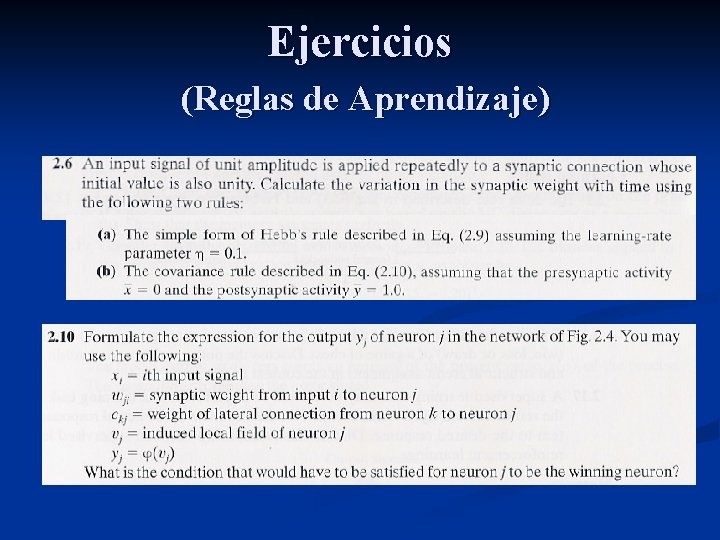

Ejercicios (Reglas de Aprendizaje)

Ejercicios (Paradigmas de Aprendizaje)

Neurona

Neurona Redes neuronales con arduino

Redes neuronales con arduino Inestabilidad y estabilidad de los circuitos neuronales

Inestabilidad y estabilidad de los circuitos neuronales Neurona unipolar bipolar y multipolar

Neurona unipolar bipolar y multipolar Peps y pips

Peps y pips Moldeamiento

Moldeamiento Estructuras artificiales

Estructuras artificiales Contexto lingüístico

Contexto lingüístico Hay cauchos artificiales

Hay cauchos artificiales Variables artificiales

Variables artificiales Formas caligraficas

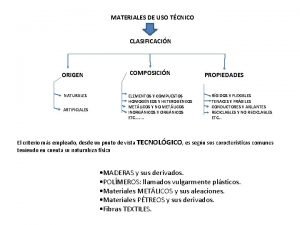

Formas caligraficas Clasificacion de materiales artificiales

Clasificacion de materiales artificiales Imanes artificiales

Imanes artificiales Define elemento estructural nombra los mismos

Define elemento estructural nombra los mismos Material artificial

Material artificial Lagrimas artificiales viscofresh

Lagrimas artificiales viscofresh Perchas artificiales para aves

Perchas artificiales para aves Metodos anticonceptivos artificiales

Metodos anticonceptivos artificiales Juan juan studio melina

Juan juan studio melina Tarile de jos vs olanda

Tarile de jos vs olanda Suomen kielen pilkkusäännöt

Suomen kielen pilkkusäännöt Jos r

Jos r Jos t

Jos t Još hrvatska ni propala tekst

Još hrvatska ni propala tekst Jos l.

Jos l. Jos operating system

Jos operating system Luis jos gallego

Luis jos gallego Jos kuilboer

Jos kuilboer Tipos de jos

Tipos de jos Sd angelman

Sd angelman Jos verlinden

Jos verlinden