PRIN STOA NAPOLI Enzo Capone Gianpaolo Carlino Alessandra

- Slides: 13

PRIN STOA @ NAPOLI Enzo Capone, Gianpaolo Carlino, Alessandra Doria, Rosario Esposito, Leonardo Merola, Silvio Pardi, Arturo Sanchez Pineda.

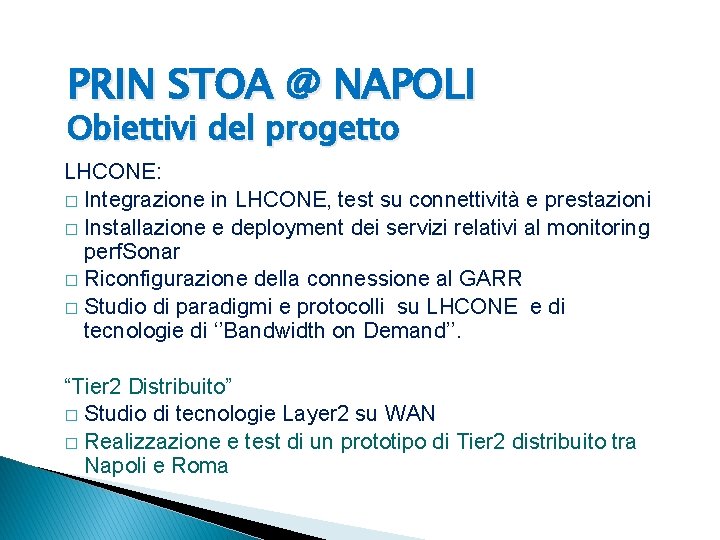

PRIN STOA @ NAPOLI Obiettivi del progetto LHCONE: � Integrazione in LHCONE, test su connettività e prestazioni � Installazione e deployment dei servizi relativi al monitoring perf. Sonar � Riconfigurazione della connessione al GARR � Studio di paradigmi e protocolli su LHCONE e di tecnologie di ‘’Bandwidth on Demand’’. “Tier 2 Distribuito” � Studio di tecnologie Layer 2 su WAN � Realizzazione e test di un prototipo di Tier 2 distribuito tra Napoli e Roma

SPERIMENTAZIONE Il Tier 2 di Napoli è stato un sito pilota per ATLAS per la sperimentazione LHCONE: • Installazione delle sonde di monitoring perf. Sonar per misure di banda TCP, latenza e perdita di pacchetti. • Configurazione in perf. Sonar di test specifici tra i Tier 2 di ATLAS. • Preparazione di uno script di installazione e configurazione di perf. Sonar, poi utilizzato da tutti i siti. 3

LHCONE in PRODUZIONE A fine 2013 è stata completamente riconfigurata la connessione con il GARR del Tier 2 di ATLAS Napoli : • Upgrade del link geografico a 10 Gbit/s, su link separato dalla sezione, con possibilità di fail-over. • Separazione del traffico General Internet da quello LHCONE, che richiede un collegamento all’istanza VRF dedicata sul router del GARR. • Configurazione del protocollo di routing BGP (Border Gateway Protocol) sul router di frontiera, per filtrare gli annunci provenienti da LHCONE La stessa connessione a LHCONE è attualmente utilizzata dal Tier 2 di ATLAS e dal Regional Center di BELLE II a Napoli 4

TIER 2 DISTRIBUITO Prototipo di Tier 2 distribuito tra Napoli e Roma 1 Applicazione dello studio di tecnologie Layer 2 su WAN • Sperimentare la possibilità di creare una infrastruttura unitaria geograficamente distribuita, attraverso tecnologie di Cloud Computing. • Studiare soluzioni ad alta affidabilità per il sito distribuito • Testare tecnologie di filesystem distribuiti su scala geografica, per gestire failover e crash recovery. • Verificare l’eventuale impatto della latenza sulla stabilità del sistema e individuarne i limiti. 5

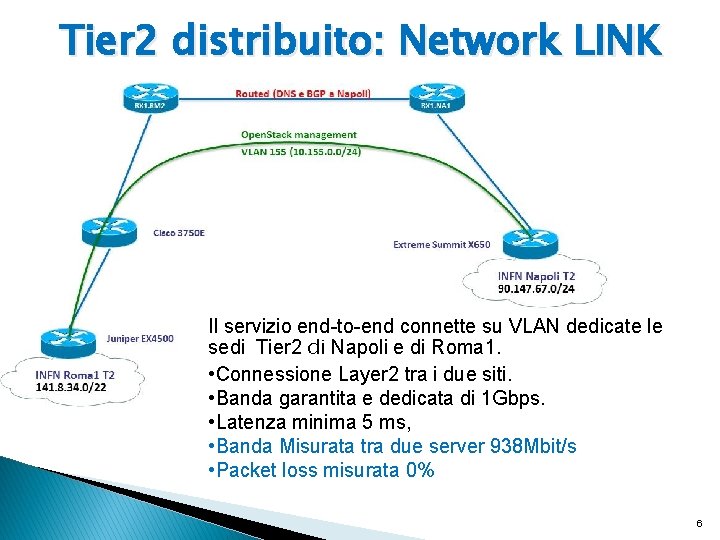

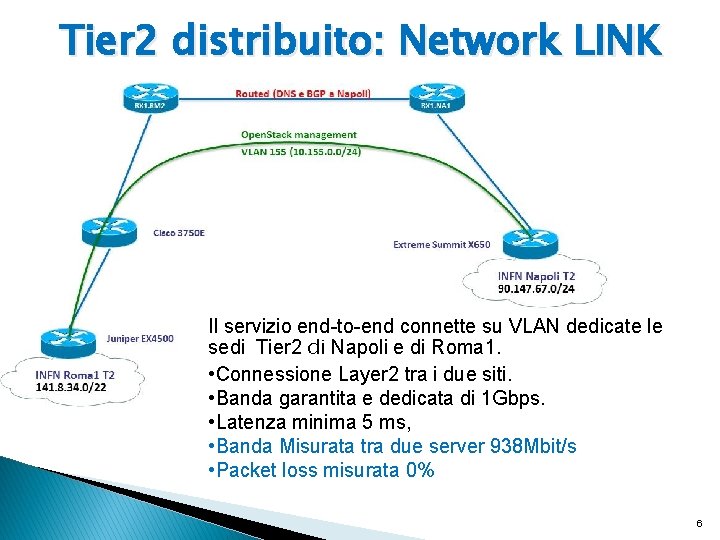

Tier 2 distribuito: Network LINK Il servizio end-to-end connette su VLAN dedicate le sedi Tier 2 di Napoli e di Roma 1. • Connessione Layer 2 tra i due siti. • Banda garantita e dedicata di 1 Gbps. • Latenza minima 5 ms, • Banda Misurata tra due server 938 Mbit/s • Packet loss misurata 0% 6

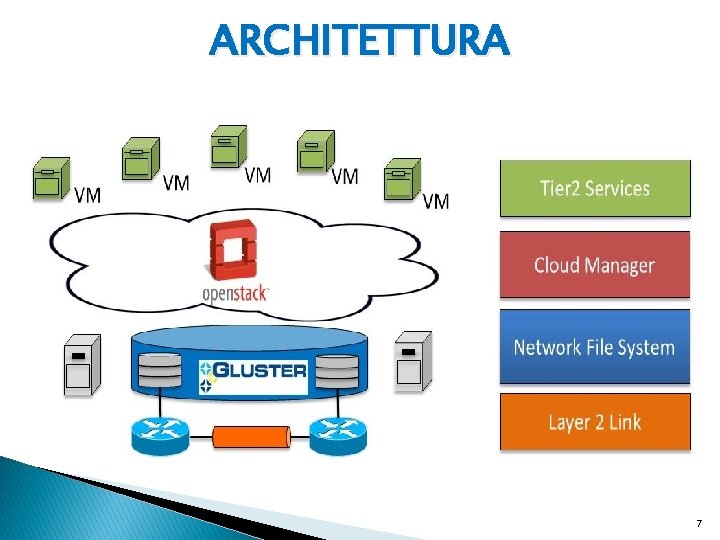

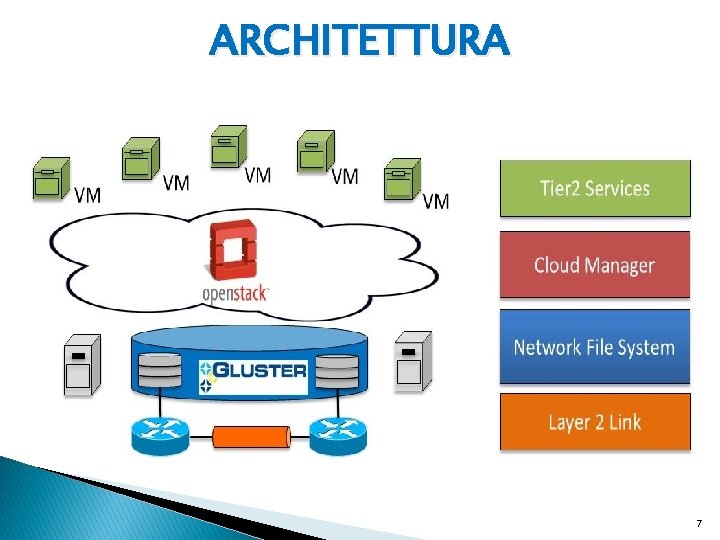

ARCHITETTURA 7

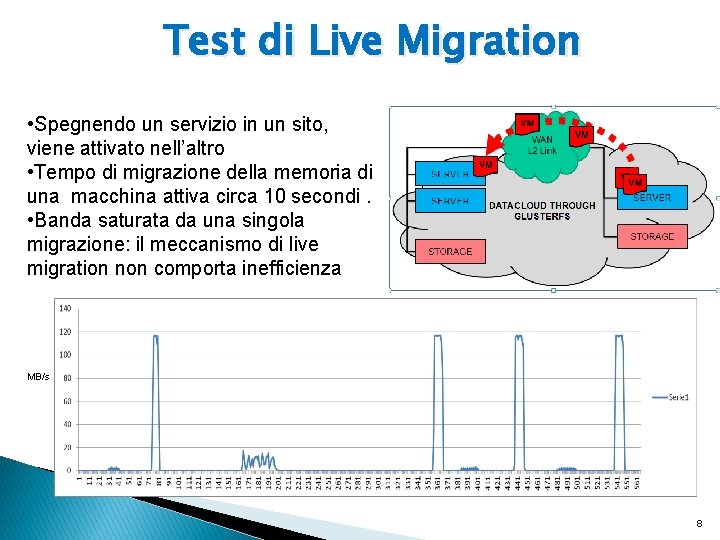

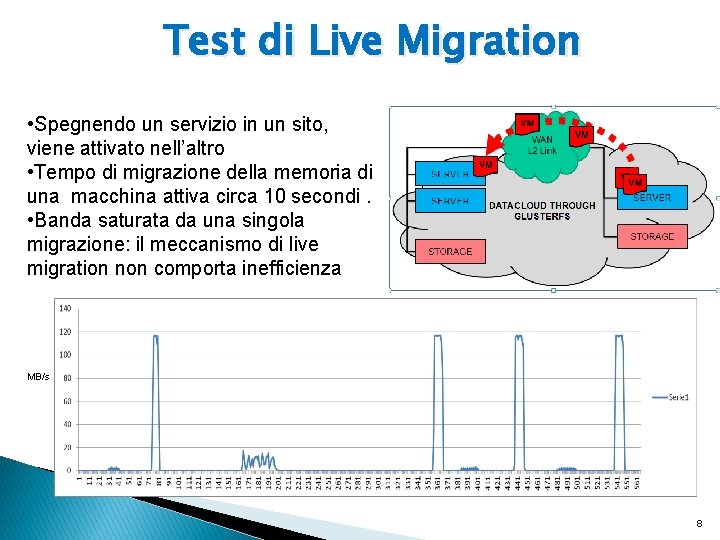

Test di Live Migration • Spegnendo un servizio in un sito, viene attivato nell’altro • Tempo di migrazione della memoria di una macchina attiva circa 10 secondi. • Banda saturata da una singola migrazione: il meccanismo di live migration non comporta inefficienza MB/s 8

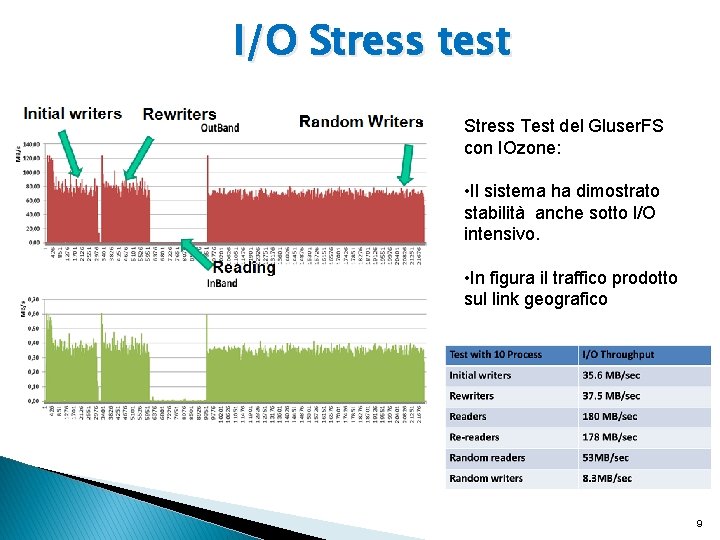

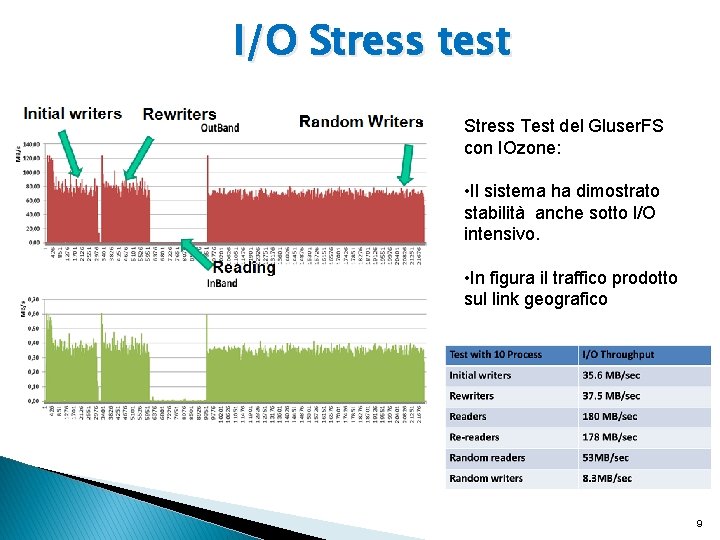

I/O Stress test Stress Test del Gluser. FS con IOzone: • Il sistema ha dimostrato stabilità anche sotto I/O intensivo. • In figura il traffico prodotto sul link geografico 9

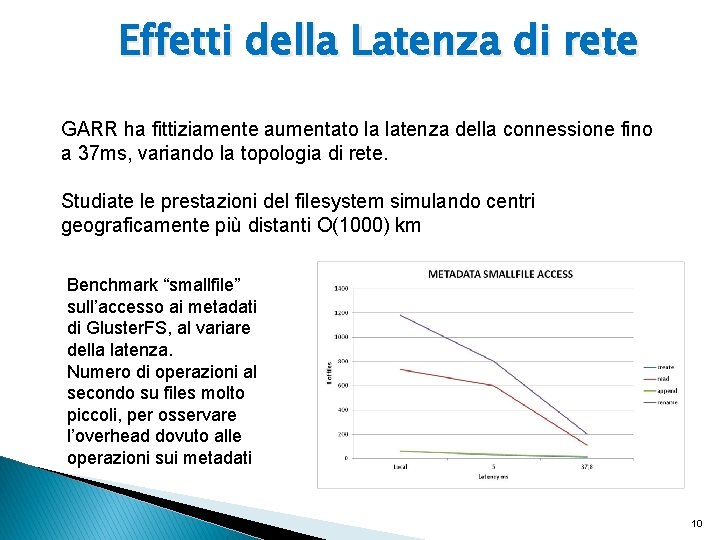

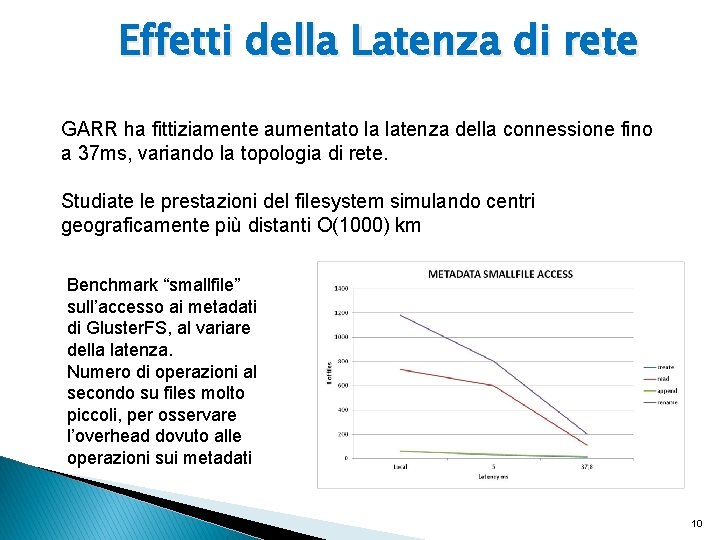

Effetti della Latenza di rete NEXT GARR ha fittiziamente aumentato la latenza della connessione fino a 37 ms, variando la topologia di rete. Studiate le prestazioni del filesystem simulando centri geograficamente più distanti O(1000) km Benchmark “smallfile” sull’accesso ai metadati di Gluster. FS, al variare della latenza. Numero di operazioni al secondo su files molto piccoli, per osservare l’overhead dovuto alle operazioni sui metadati 10

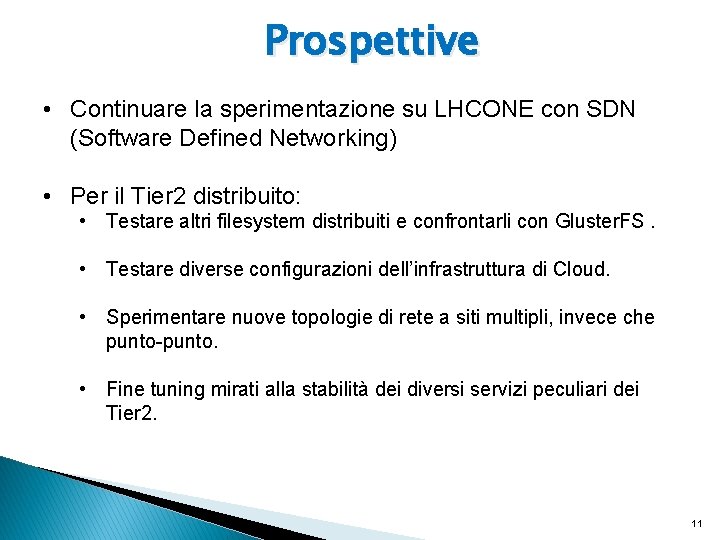

Prospettive NEXT • Continuare la sperimentazione su LHCONE con SDN (Software Defined Networking) • Per il Tier 2 distribuito: • Testare altri filesystem distribuiti e confrontarli con Gluster. FS. • Testare diverse configurazioni dell’infrastruttura di Cloud. • Sperimentare nuove topologie di rete a siti multipli, invece che punto-punto. • Fine tuning mirati alla stabilità dei diversi servizi peculiari dei Tier 2. 11

Backup 12

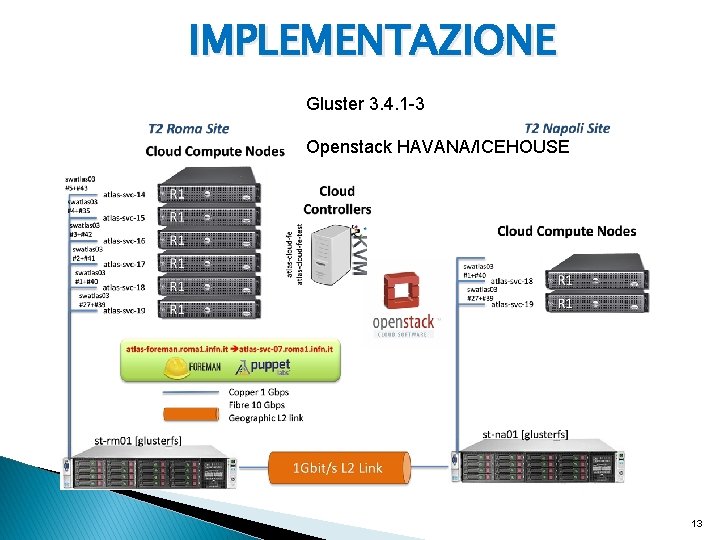

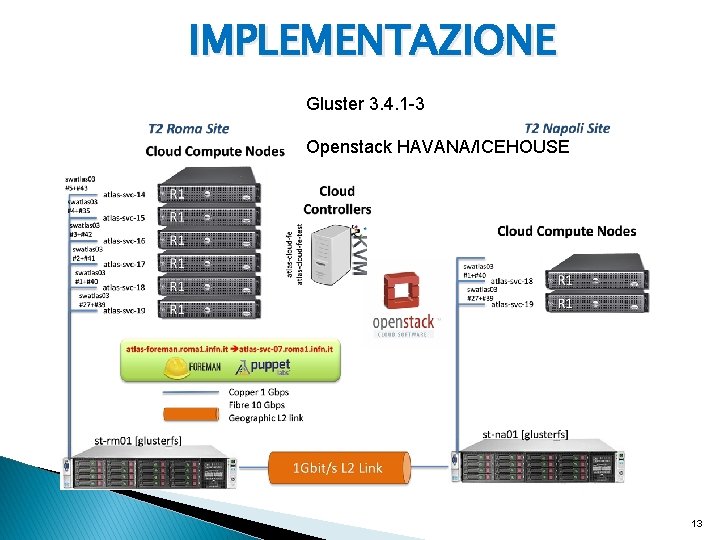

IMPLEMENTAZIONE Gluster 3. 4. 1 -3 Openstack HAVANA/ICEHOUSE 13