Multi Layer Perceptron Multi layer perceptron memiliki koneksi

- Slides: 14

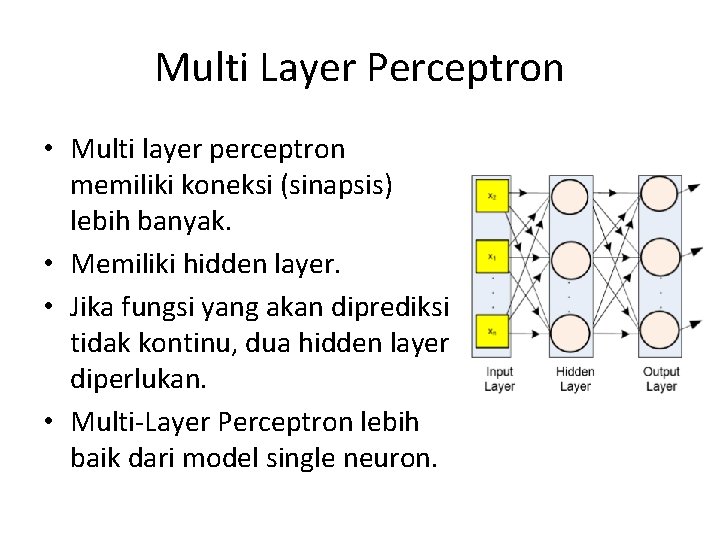

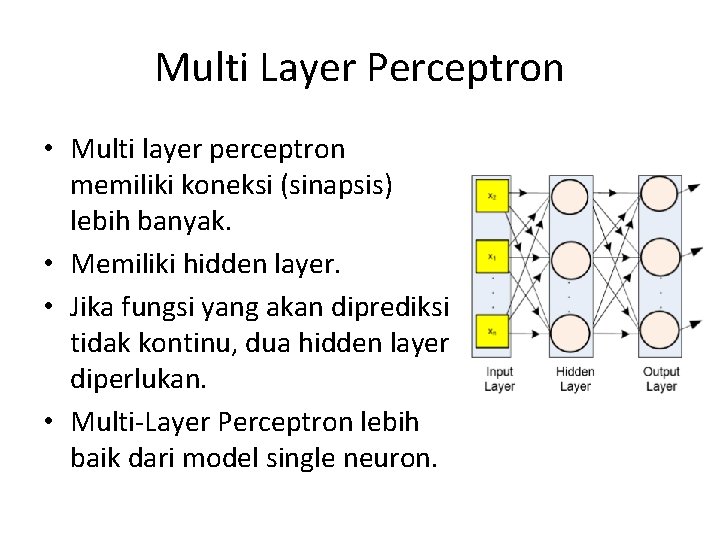

Multi Layer Perceptron • Multi layer perceptron memiliki koneksi (sinapsis) lebih banyak. • Memiliki hidden layer. • Jika fungsi yang akan diprediksi tidak kontinu, dua hidden layer diperlukan. • Multi‐Layer Perceptron lebih baik dari model single neuron.

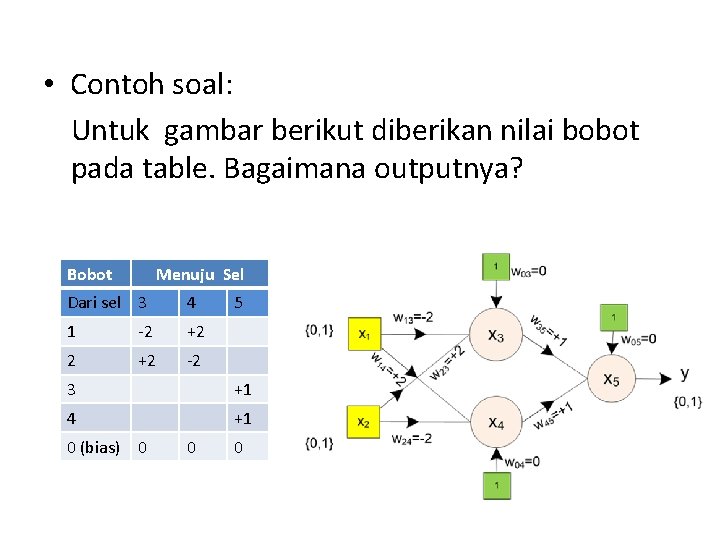

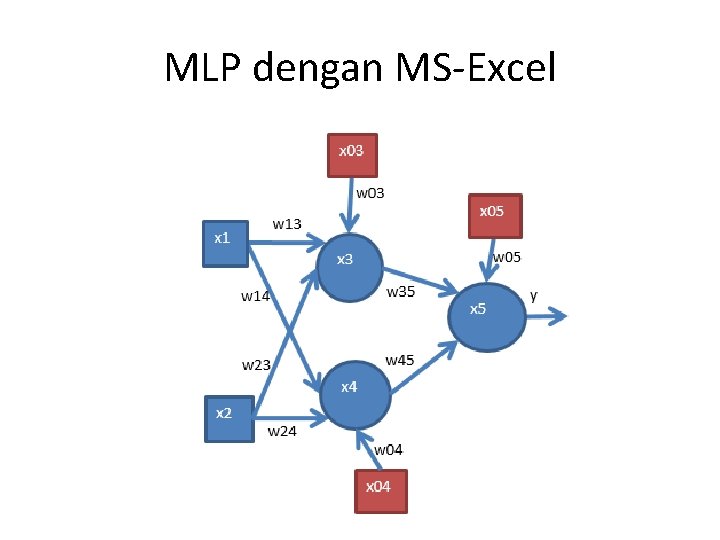

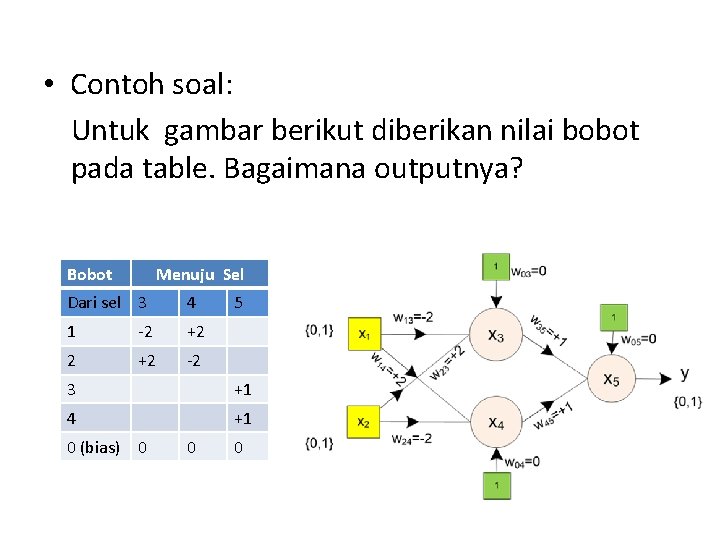

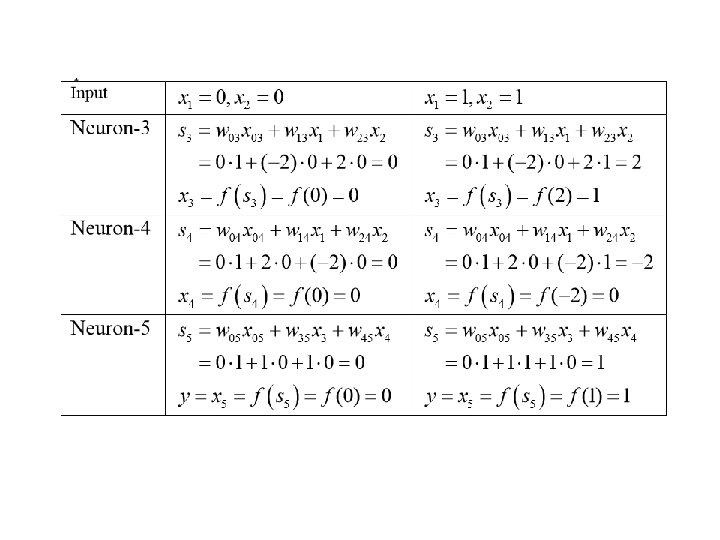

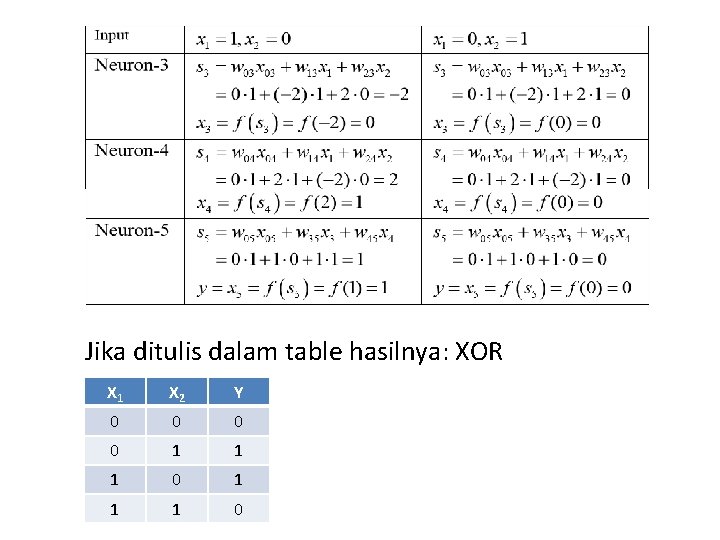

• Contoh soal: Untuk gambar berikut diberikan nilai bobot pada table. Bagaimana outputnya? Bobot Menuju Sel Dari sel 3 4 1 ‐ 2 +2 ‐ 2 5 3 +1 4 +1 0 (bias) 0 0 0

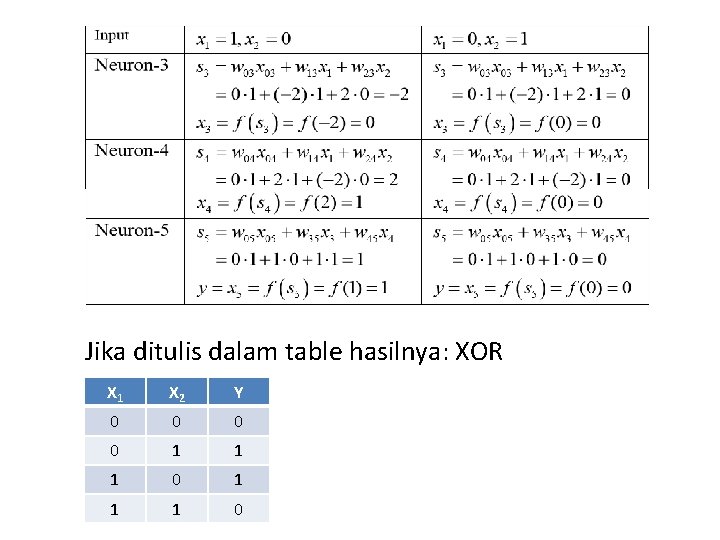

Jika ditulis dalam table hasilnya: XOR X 1 X 2 Y 0 0 1 1 1 0

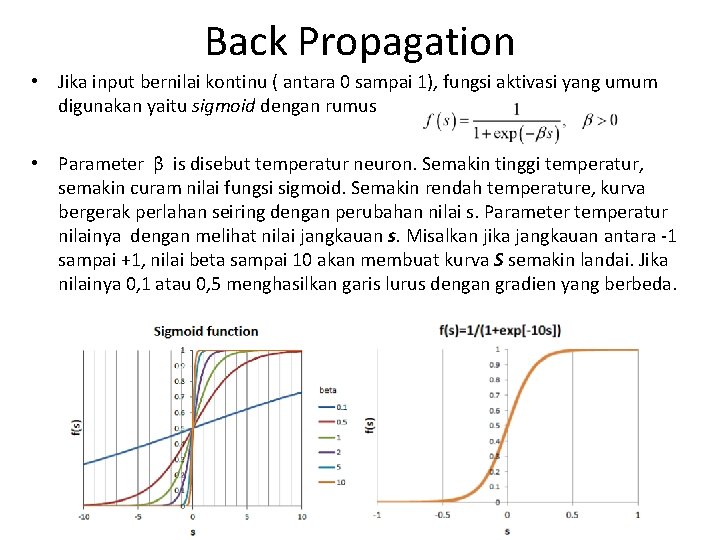

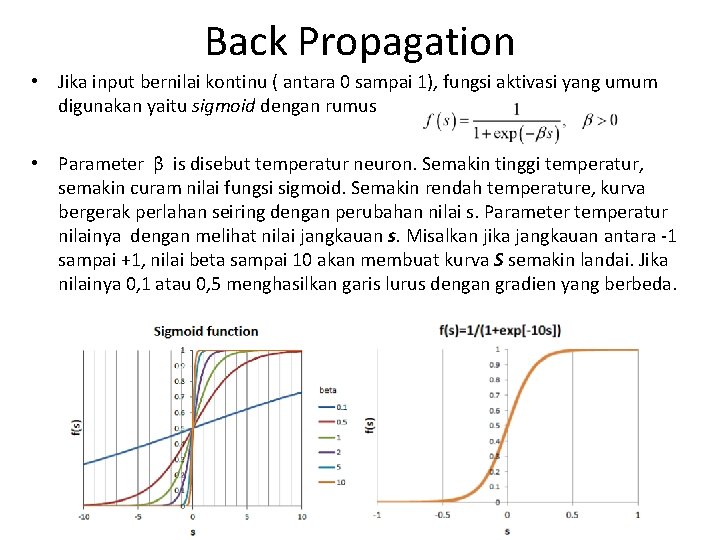

Back Propagation • Jika input bernilai kontinu ( antara 0 sampai 1), fungsi aktivasi yang umum digunakan yaitu sigmoid dengan rumus • Parameter β is disebut temperatur neuron. Semakin tinggi temperatur, semakin curam nilai fungsi sigmoid. Semakin rendah temperature, kurva bergerak perlahan seiring dengan perubahan nilai s. Parameter temperatur nilainya dengan melihat nilai jangkauan s. Misalkan jika jangkauan antara ‐ 1 sampai +1, nilai beta sampai 10 akan membuat kurva S semakin landai. Jika nilainya 0, 1 atau 0, 5 menghasilkan garis lurus dengan gradien yang berbeda.

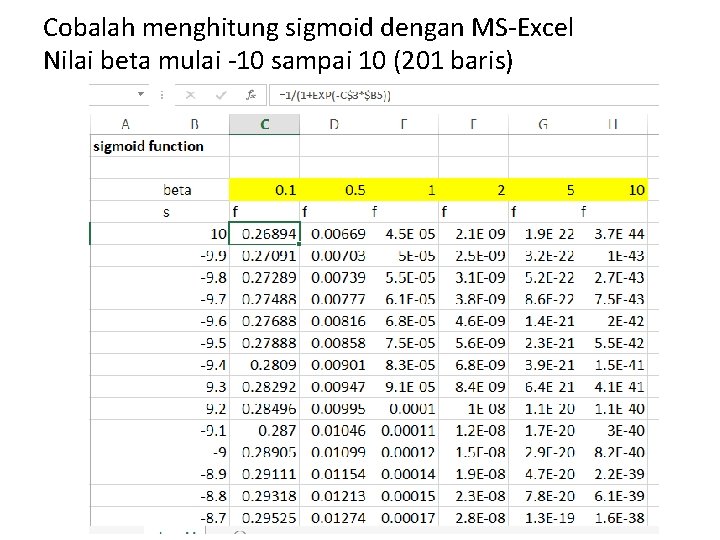

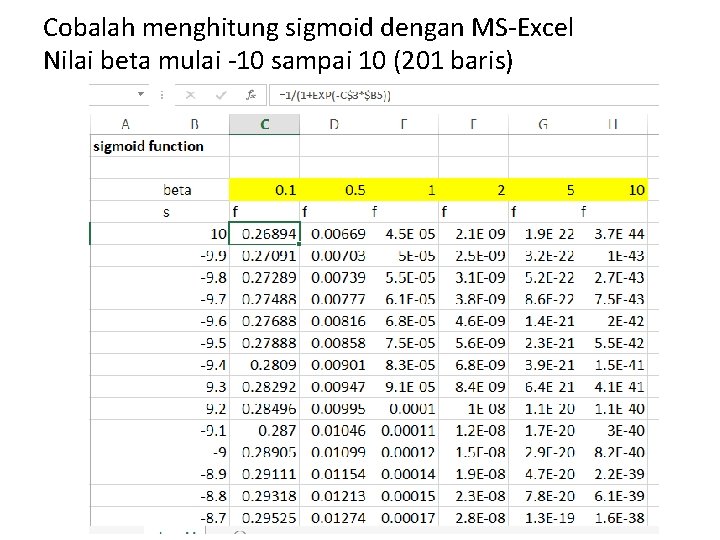

Cobalah menghitung sigmoid dengan MS‐Excel Nilai beta mulai ‐ 10 sampai 10 (201 baris)

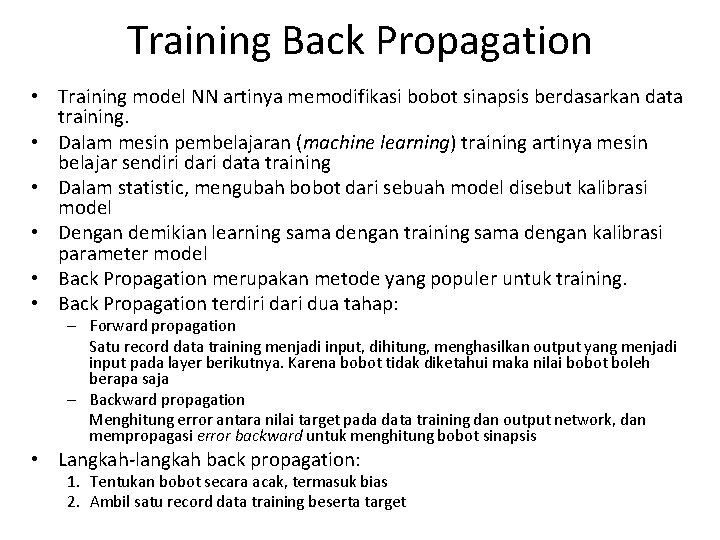

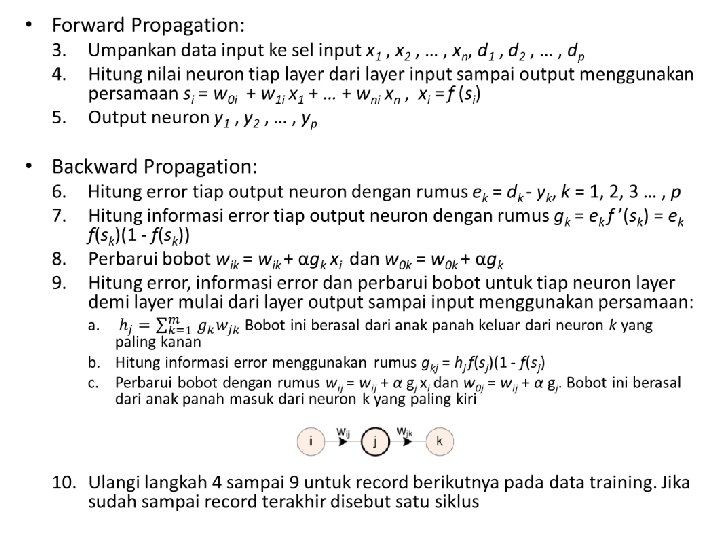

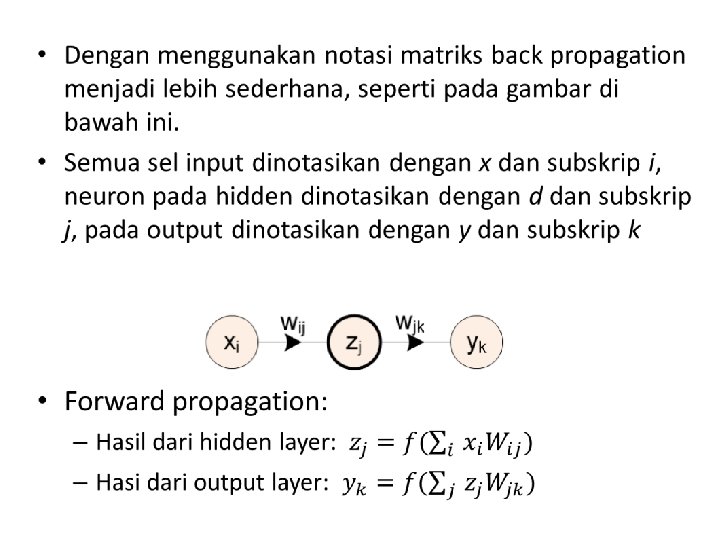

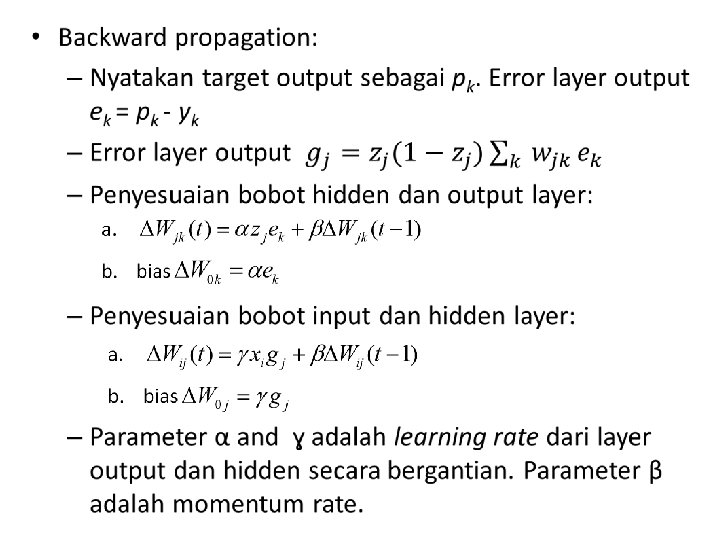

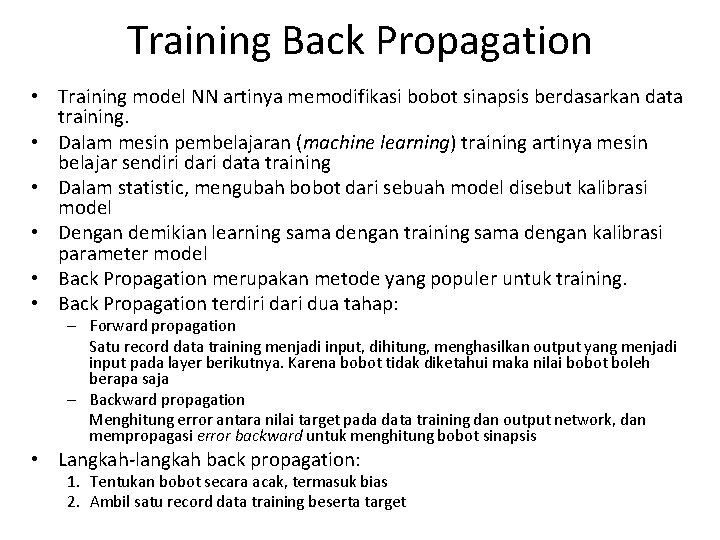

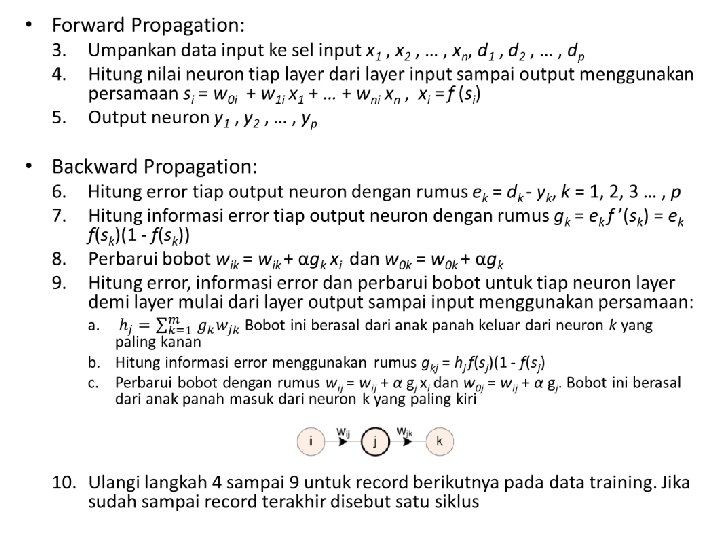

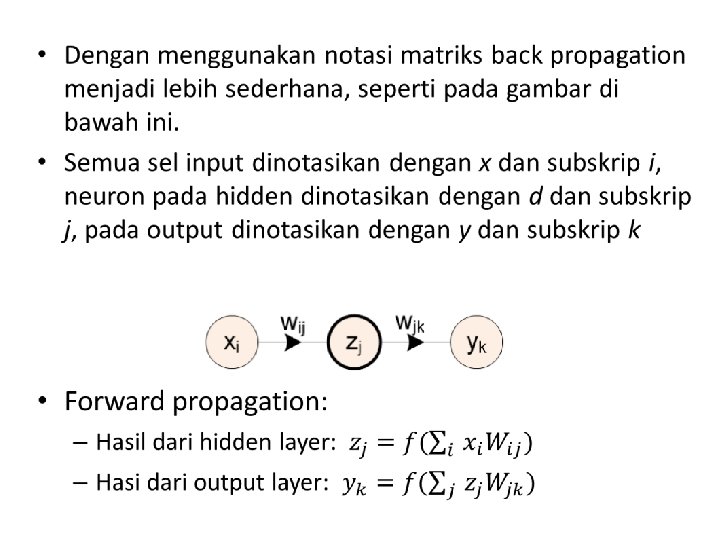

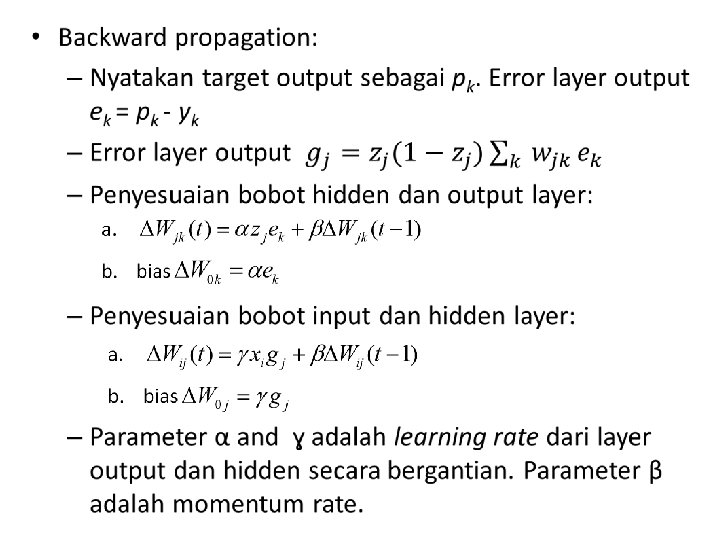

Training Back Propagation • Training model NN artinya memodifikasi bobot sinapsis berdasarkan data training. • Dalam mesin pembelajaran (machine learning) training artinya mesin belajar sendiri data training • Dalam statistic, mengubah bobot dari sebuah model disebut kalibrasi model • Dengan demikian learning sama dengan training sama dengan kalibrasi parameter model • Back Propagation merupakan metode yang populer untuk training. • Back Propagation terdiri dari dua tahap: – Forward propagation Satu record data training menjadi input, dihitung, menghasilkan output yang menjadi input pada layer berikutnya. Karena bobot tidak diketahui maka nilai bobot boleh berapa saja – Backward propagation Menghitung error antara nilai target pada data training dan output network, dan mempropagasi error backward untuk menghitung bobot sinapsis • Langkah‐langkah back propagation: 1. Tentukan bobot secara acak, termasuk bias 2. Ambil satu record data training beserta target

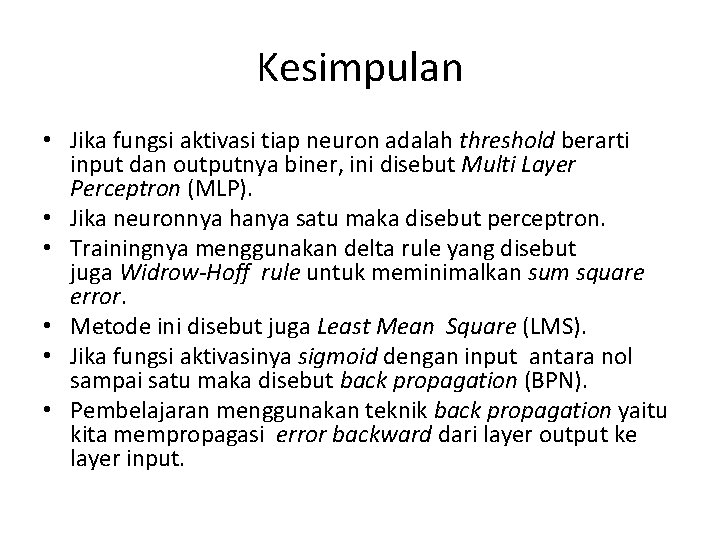

Kesimpulan • Jika fungsi aktivasi tiap neuron adalah threshold berarti input dan outputnya biner, ini disebut Multi Layer Perceptron (MLP). • Jika neuronnya hanya satu maka disebut perceptron. • Trainingnya menggunakan delta rule yang disebut juga Widrow‐Hoff rule untuk meminimalkan sum square error. • Metode ini disebut juga Least Mean Square (LMS). • Jika fungsi aktivasinya sigmoid dengan input antara nol sampai satu maka disebut back propagation (BPN). • Pembelajaran menggunakan teknik back propagation yaitu kita mempropagasi error backward dari layer output ke layer input.

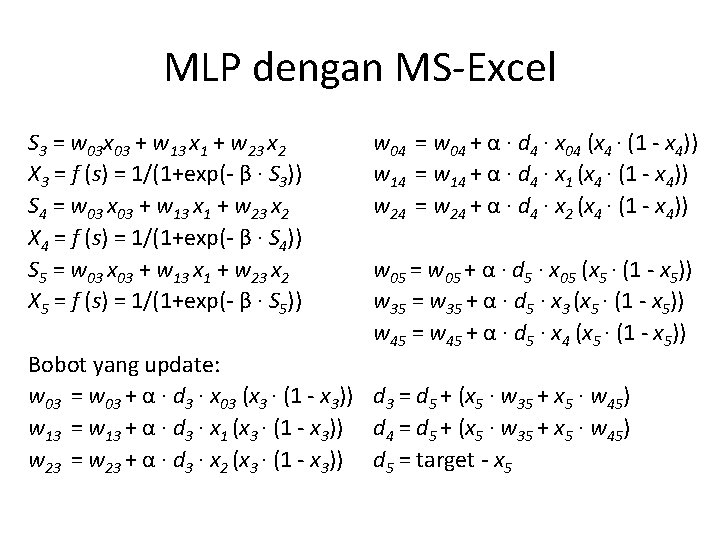

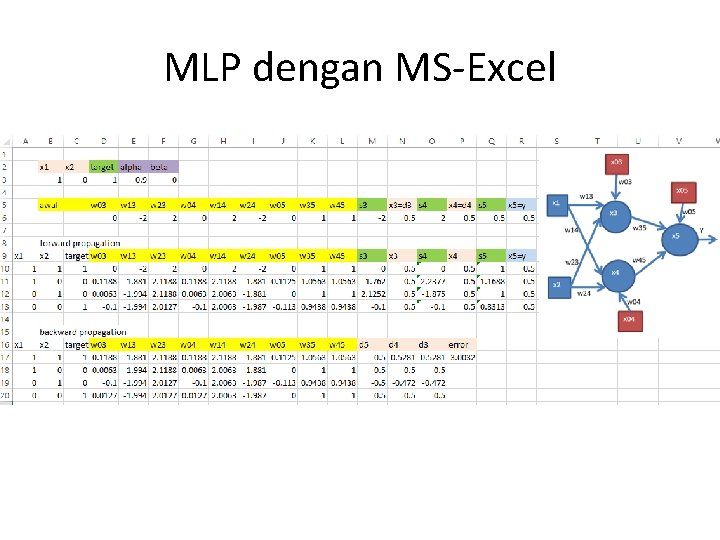

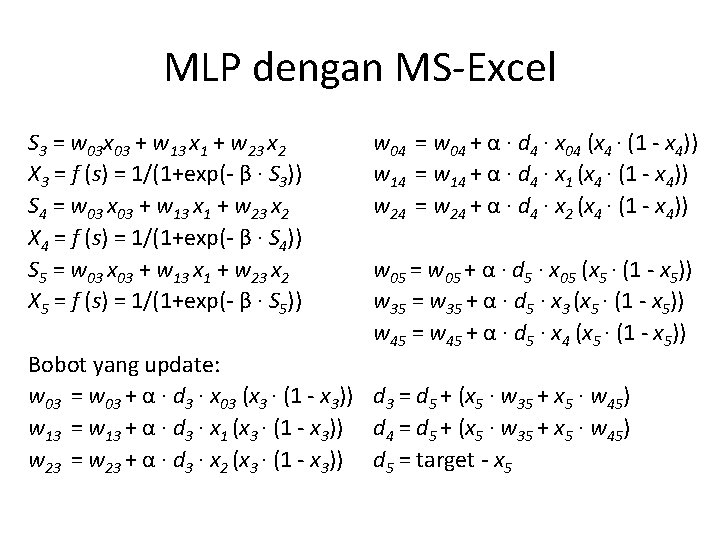

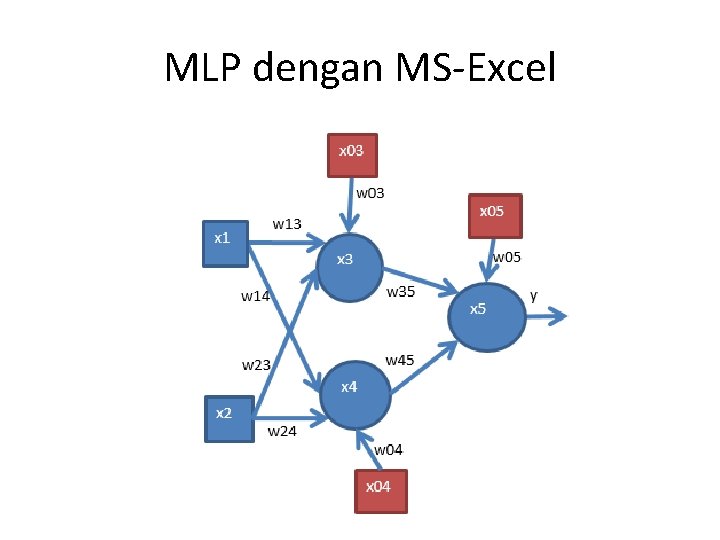

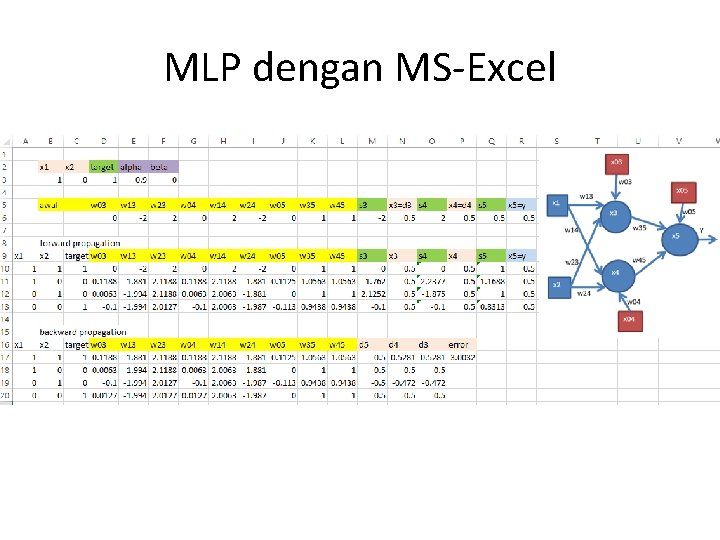

MLP dengan MS‐Excel S 3 = w 03 x 03 + w 13 x 1 + w 23 x 2 X 3 = f (s) = 1/(1+exp(‐ β · S 3)) S 4 = w 03 x 03 + w 13 x 1 + w 23 x 2 X 4 = f (s) = 1/(1+exp(‐ β · S 4)) S 5 = w 03 x 03 + w 13 x 1 + w 23 x 2 X 5 = f (s) = 1/(1+exp(‐ β · S 5)) w 04 = w 04 + α · d 4 · x 04 (x 4 · (1 ‐ x 4)) w 14 = w 14 + α · d 4 · x 1 (x 4 · (1 ‐ x 4)) w 24 = w 24 + α · d 4 · x 2 (x 4 · (1 ‐ x 4)) w 05 = w 05 + α · d 5 · x 05 (x 5 · (1 ‐ x 5)) w 35 = w 35 + α · d 5 · x 3 (x 5 · (1 ‐ x 5)) w 45 = w 45 + α · d 5 · x 4 (x 5 · (1 ‐ x 5)) Bobot yang update: w 03 = w 03 + α · d 3 · x 03 (x 3 · (1 ‐ x 3)) d 3 = d 5 + (x 5 · w 35 + x 5 · w 45) w 13 = w 13 + α · d 3 · x 1 (x 3 · (1 ‐ x 3)) d 4 = d 5 + (x 5 · w 35 + x 5 · w 45) w 23 = w 23 + α · d 3 · x 2 (x 3 · (1 ‐ x 3)) d 5 = target ‐ x 5

MLP dengan MS‐Excel

MLP dengan MS‐Excel