MDULO 4 SISTEMAS DE APOYO PARA LA TOMA

- Slides: 43

MÓDULO 4 SISTEMAS DE APOYO PARA LA TOMA DE DECISIONES Clase 7 Profesor: Nelson Baloian

Decision Support System (DSS) Clase 7 Curso basado en material de Kathryn Blackmond Laskey Diseño Centrado en la evaluación

Outline â Las teorías y las hipótesis â El método científico y la evaluación de hipótesis â Amenazas a la validez de resultados â Prueba y evaluación de DSS » La evaluación formativa / T & E Desarrollo » La evaluación sumativa / T & E operativos â Diseño centrado en la Evaluación

Teoría â Teoría » Conocimiento organizado sistemáticamente aplicable en una amplia gama de variedad de circunstancias, un sistema de supuestos, principios, y las normas de procedimiento diseñado para analizar, predecir o explicar un conjunto de fenómenos â La teoría científica » Siempre provisional » Debe ser refutable » Nunca puede ser probada

Hipótesis â Hipótesis » Declaración sobre la relación entre dos o más variables medibles » Lo suficientemente precisas como para ser verificada o refutada » Por lo general apoyado por la teoría • La verificación proporciona apoyo para la teoría • La refutación pone en cuestión la teoría â La ciencia avanza a través de un proceso iterativo : » Proponer una teoría » Desarrollar hipótesis para evaluar la teoría • La hipótesis es probable que sea cierto si la teoría es correcta • La hipótesis es probable que sea falsa en algunos casos alternativos a a la teoría » Recoger y analizar las pruebas que tienen que ver con la hipótesis » Afinar la teoría a la luz de la evidencia

Evolución de las Teorías â Vemos el mundo a través de nuestras teorías » Las variables que describen el mundo » Relación de las causas a los resultados observables » Las acciones que podemos tomar para cambiar el mundo â "Siempre hay una solución fácil del problema para todos los seres humanos - limpia, plausible y equivocada. "Mencken” â Teorías y observaciones "co-evolucionan" » Revisar la teoría basada en la observación » Utilizar la teoría para que nos diga qué observar â Teorización post-hoc ( "Después de esto") » Construida para explicar los resultados después de que se han observado » Proceda con precaución hasta que más evidencia confirmatoria sea recogida

Ingeniería y el Método Científico â El método científico: hipótesis, test, perfeccionamiento â La ciencia persigue el conocimiento por el bien de los conocimientos » Buscar las teorías que describen con precisión y predicen cómo el funciona el mundo » Buscar evidencias de que se fijan definitivamente las teorías correcta y refuta teorías incorrectas â La ingeniería aplica el método científico con el propósito de resolver los problemas en el mundo » Utilizar las teorías para hacer predicciones relevantes para el problema » Procurar la adecuación para un fin, no en última instancia la corrección » "¿Cómo pensaría un científico esto? " Puede ser una heurística útil » En la ingeniería, a menudo no pueden permitirse la pureza científica, pero es importante para comprender las concesiones que estamos haciendo

Predicción, explicación, intervención â Los estudios explicativos identificar los factores que explican las causas del resultado de una variable â Los estudios de predicción hacen predicciones sobre el valor futuro del resultado de una variable » Ejemplo: la raza predice el rendimiento académico, pero no creemos que la raza determina un rendimiento académico â buenos predictores no necesariamente explican! â Evaluación de las intervenciones requiere una explicación » Queremos diseñar un DSS que cauce mejoras en la ejecución de las tareas » Queremos evaluar el DSS para determinar si hay mejoras atribuibles al DSS y si es así cuáles son las causas » Queremos evaluar la capacidad de nuestra organización de desarrollar DSS para mejorar las decisiones de organización

Fuentes de evidencia empírica â Observación anecdótica o informal » Bueno para sugerir hipótesis (siempre comenzamos de esta manera) » Pobre para confirmación rigurosa de las hipótesis » Un buen estudio formal incluirá un componente anecdótico â Observación formal » La observación sistemática de la co-variación natural de A y B y otras causas plausibles de B » Si A y B co-varían cuando otras causas de B se mantienen fijos, inferir que A causa B » Inferencias causales están limitadas por el rango de variación natural en A, B, y otras causas potenciales de B â Manipulación directa » Manipula A (y posiblemente variables secundarias) directamente » Si B cambia cuando A es manipulado, inferir que A causa B

Fuentes de evidencia empírica (2) â Opinión » Encuesta de las opiniones de expertos, usuarios, clientes » La evidencia es tan buena como el conocimiento de los encuestados â Modelado » Ejecutar la simulación del sistema » Manipular A y ver que ocurre con B â Sistemas relacionados » Test de factibilidad del enfoque técnico a través del desarrollo de un prototipo » Evaluar DSS propuesto examinando similitudes y diferencias con DSS relacionados â Combinaciones » Testeo de componentes reales con componentes simuladas » Utilizar la opinión de expertos para ajustar los datos de sistemas relacionados

Ejemplo â Hipótesis: el uso del DSS hará aumentar la productividad â La evidencia anecdótica: » Entrevista a algunos usuarios DSS. » Resultados: La mayoría reporta que el sistema les ayuda a hacer su trabajo más eficaz y eficiente. â Evidencia Observacional: » Recopilar datos sobre los parámetros de productividad y otras variables de una muestra de los empleados, algunos de los cuales están usando DSS y algunos que no. » Resultados: DSS los usuarios tienden a ser más productivos. â Manipulación directa (cuasi-experimento): » Introducir DSS en la organización. Recoger datos de la productividad antes y después, así como datos sobre otras variables. » Resultado: aumento de la productividad después de la introducción de DSS. â Manipulación directa (controlada, experimento aleatorio): » Identificar los pares de empleados con similares características. Dar el DSS a uno de los empleados de los pares elegidos al azar. » Mida la productividad y otras variables antes y después de introducir el sistema » Resultados: ingenieros utilizando DSS aumentan la productividad, los otros no.

Hipótesis en la evaluación de DSS â ¿Cuáles son los objetivos de diseño de DSS? » debe ser identificado como parte de la definición del concepto operativo » Ejemplos de objetivos: • los usuarios con DSS deben realizar una determinada tarea (o parte de la tarea) de manera más rápida/más precisa/en menos pasos. . . que sin DSS • Los nuevos trabajadores usando DSS aprenden a realizar tareas más rápido que los nuevos trabajadores sin DSS • Costo del ciclo de vida DSS está justificada por mejoras en la productividad • DSS mejora del flujo de trabajo productivo • Los usuarios encuentran el sistema DSS natural para el uso â Las hipótesis para la evaluación deben referirse a objetivos » ¿Es alcanzado el objetivo? ¿En qué grado? » ¿Por qué razones objetivas es / no es alcanzado?

Variables e Hipótesis â Variable dependiente – medida del presunto efecto â Variable independiente - medida de la presunto causa » Manipulados en estudios de intervención » Se miden, pero no manipulada en los estudios observacionales â variables auxiliares - ni las causas ni los efectos (a veces llamadas variables molestia) » Pueden ser controladas (consideradas explícitamente en el diseño y análisis del modelo) » Cuando no son controladas, pueden ser confundidas con variables explicativas (dependientes e independientes)

Validez â Un estudio empírico es válido si proporciona resultados definitivos a favor o en contra de la hipótesis para la que fue diseñado testear â Validez interna » ¿Puede atribuirse el resultado a las variables explicativas que el investigador dice que están en funcionamiento? » ¿Podemos descartar variables de confusión como explicación? â La validez externa » ¿Puede ser el resultado de la muestra ser generalizado a la población? » ¿Se puede generalizar el resultado a algunas otras poblaciones? â Al incluir más factores se tiende a » Aumentar la validez externa » Disminuir de la validez interna

Amenazas a la Validez â Un estudio empírico está diseñado para proporcionar pruebas a favor o en contra de una hipótesis dada â Amenazas a la validez son razones por las cuales los resultados pueden no significar lo que el diseñador del estudio había previsto que signifiquen â Diseño de estudio cuidadoso requiere: » Previsión de las amenazas a la validez de » El control de los efectos de las amenazas a la validez

Ejemplos de amenazas a la Validez â Test experimental de un prototipo de sistema de apoyo a las decisiones » 200 sujetos fueron testeados en varios escenarios » 100 usaron el sistema 100 no lo usaron » Los sujetos fueron medidos según sus respuestas â Resultados del experimento » El promedio de los que lo usaron fue 63 de 100 » El promedio de los que no lo usaron fue 64 de 100 » El Cliente decidió no usar el sistema a gran escala â ¿Está fundamentada su decisión ?

Resultados por nivel de experiencia de los usuarios Usuarios Sin ayuda Con DSS expertos 70 (n=80) 90 (n=10) inexpertos 40 (n=20) 60 (n=90) total 64 (n=100) 63 (n=100) â El sistema produjo una mejoría considerable para ambos subgrupos â El experimento parece apoyar la tesis contraria! â La razón: el efecto de selección » Los grupos fueron desequilibrados en una característica relacionada con el rendimiento » El análisis no pudo controlar el desequilibrio â Los efectos de la selección son comunes con la asignación no aleatoria (por ejemplo, usuarios sin experiencia son más jóvenes y más dispuestos a probar nuevas tecnologías)

Control â Aislar el efecto de variables de interés puede ser difícil » Las variables dependientes miden el fenómeno de interés » Las variables independientes miden las causas de la hipótesis » Las variables externas introducen una variación adicional e interfieren con la capacidad de explicar â El control significa la incorporación de una variable en el diseño de una manera que su impacto en el conclusiones pueden ser evaluadas científicamente â Variables no controladas pueden confundirse con variables explicativas » No se puede medir la variación de las variables explicativas debida a las variables de confusión » Las variables de confusión amenazan la validez

Control para las variables de confusión â Eliminar variables » Establecer un valor constante - por ejemplo, el estudio sólo varones o sólo una única región geográfica » Limita la capacidad de generalizar » Aumenta el poder de las pruebas estadísticas â Incluir variables como factores en el diseño » control estadístico - ajustar los resultados para tomar en cuenta los factores incluidos » Incluir demasiados factores nos lleva a un diseño de bajo poder estadístico â inferencia bayesiana jerárquica puede incluir más variables que la estadística tradicional pero con pérdida de potencia estadística » Pero no hay almuerzos gratis

Manipulación â El experimento manipula las variables independientes usando aleatoriedad » Controla estadístitacamente variables no incluidas en el diseño â El cuasi-experimento manipula las variables estadísticas pero no en forma aleatoria » Confusión puede ser un problema â El estudio observacional examina la variación en la variable dependiente, en virtud de la variación natural en la variable independiente » Hay muchas fuentes de confusión en estudios observacionales » El control estadístico se utiliza a menudo, pero la asignación a menudo es sospechosa

Una nota sobre aleatoriedad â Usos de la aleatorización » Obtener muestras representativas de una población » Control de las variables no incluidas en el diseño â Balance (o representatividad) es más importante que asignación al azar en sí » Aleatorización restringida » Post-hoc ajuste de las muestras de desequilibrio

Controlando los efectos de la selección â Asignación aleatoria » No es una panacea: una muestra aleatoria puede estar desbalanceada por (mala) suerte » No siempre es posible â Matching » Haga un matching de características que piense pueden estar relacionadas con el resultado » Asignar uno de cada par “matcheado” a cada grupo » Puede ser usado con asignación random

Sesgo del Investigador â Expectativas y actitudes pueden afectar al resultado y la interpretación de los resultados » Los sujetos estudiados » ¿Qué se mide? » Los efectos sutiles en la medición » Exclusión de los "valores extremos" o "casos problema" » Errores de cálculo en la dirección de las expectativas » Análisis de información en línea / visuales que confirman el punto de vista del investigador » Estos sesgos pueden ser totalmente inconsciente! â Protección contra el sesgo del investigador » Mantener hipótesis múltiples » Sea consciente de los posibles sesgos » Involucrar a las partes imparciales

Diseño iterativo de un DSS centrado en la evaluación â Definir qué se entiende por "calidad de la decisión" â Desarrollar medidas de calidad de decisiones â Desarrollar hipótesis de los factores que contribuyen a la decisión de la calidad » Características de los usuarios » Características de las tareas » Las características del medio ambiente » Características del proceso de toma de decisiones â Desarrollar explicación del statu quo de la calidad de las decisiones â Generalizar a la teoría que predice la calidad de la decisión en virtud de alternativas, incluyendo el statu quo â Usar la teoría como guía para el diseño de nuevos o mejores DSS â Implementar y evaluar la teoría de las pruebas sobre este caso » Medida de la calidad de la decisión y las características de DSS relacionadas (por la teoría) a la decisión de la calidad â Afinar la teoría a la luz de la evaluación y la iteración â Aplicar enfoque mismo proceso de organización del ciclo de vida de DSS

El objetivo fundamental de un esfuerzo por desarrollar un DSS es lograr el nivel más alto de efectividad y productividad de los usuarios dentro de costos razonables

La evaluación de un DSS apoya el ciclo de vida del DSS â El proceso de desarrollo de un DSS implica tomar un número de decisiones » ¿Construir prototipo? » ¿Implementar el desarrollo a gran escala? » ¿Qué nivel de recursos comprometer? » ¿Añadir la funcionalidad? â La evaluación DSS proporciona información a los apoyar estas decisiones â La evaluación del DSS también proporciona información para la base de conocimientos de la comunidad acerca de DSS â La Estrategia de evaluación es en sí mismo una decisión » Recursos a comprometer para la evaluación » ¿Qué medir? » ¿Cómo se mide?

¿Por qué es tan difícil evaluar? â Los costos de un desarrollo evolutivo son difíciles de identificar (dependen de los resultados de la evaluación!!!) â Los beneficios son generalmente difíciles de medir, de presentar â Los costos de los tests empíricos rigurosos pueden ser prohibitivos

Evaluación formativa y sumativa â La evaluación formativa evalúa el diseño cuando se está desarrollando â La evaluación sumativa evalúa completa o producto casi completa

Evaluación Formativa â Propósito: » Identificar las debilidades y las prioridades para la mejora â Las decisiones apoyadas: » ¿El esfuerzo de desarrollo debe seguir o darse por concluido? » ¿Es el sistema está listo para pasar a la próxima etapa? » ¿Qué nuevas características deben ser incluidas en el próximo prototipo? » ¿Deberían modificarse los requisitos? ¿Cómo? » ¿Qué problemas deben ser solucionados? ¿En qué orden? â ¿Qué medir: » En esta etapa es menos importante la validez estadística que la comprensión de los puntos fuertes y debilidades del sistema » Recoger datos del proceso, anécdotas e impresiones del usuario junto con el resumen de las métricas de calidad de decisión

Evaluación Sumativa â Propósito: » Medir la calidad general del producto terminado â Las decisiones apoyadas: » Evaluar cuál de los productos competidores comprar » Compara el producto desarrollado con otros existentes en el mercado » Evaluar la calidad del DSS • Dar feedback para mejorar el proceso de desarrollo • Decidir si, cuándo y como desarrollar la siguiente versión • Evaluar el impacto del DSS en la organización â ¿Qué medir: » Más énfasis en una medición válida de la calidad general de la decisión » Datos del proceso y anécdotas son útiles para mejoras posteriores al producto pero no son el foco principal

Medidas de Efectividad (MOEs) y evaluación fomativa â Utilice ME para identificar áreas de mejoras y generar opciones » “El sistema obtuvo una puntuación baja en la usabilidad. Los usuarios piensan que la ubicación de los iconos no era coherente de pantalla en pantalla. Una opción para solucionar este problema es que los usuarios nos ayudan a rediseñar pantallas. Costo estimado: 2 hombres/semana de programador, 1 hombre/semana de usuario ". » “El sistema no cumplía con las limitaciones de tiempo en generar un programa. Tenemos que analizar el software y los algoritmos y determinar si hay una manera de acelerar la ejecución". â Use medidas agregadas para elegir entre opciones claramente definidas » Continuar el desarrollo? » Resolver este problema o el otro? » ¿Qué nuevas funcionalidades a aplicar en primer lugar?

¿Cuánta evaluación formativa es necesaria? â “Regla de oro “(Hicks & Hartson): para cada versión importante de un diseño de interacción » Tres grandes ciclos de evaluación formativa » Cada uno seguido por un rediseño » Seguido de la evaluación sumativa â Regla del 10%: » El esfuerzo de desarrollo debe tener algo que evaluar al momento en que el 10% de los recursos se han gastado

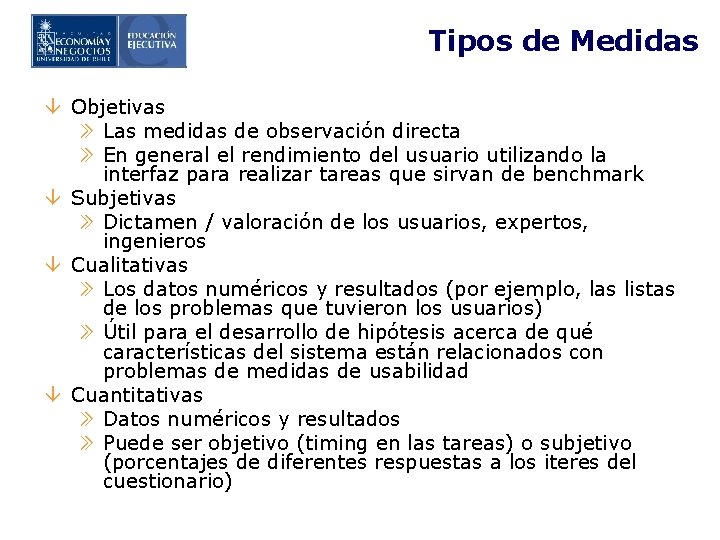

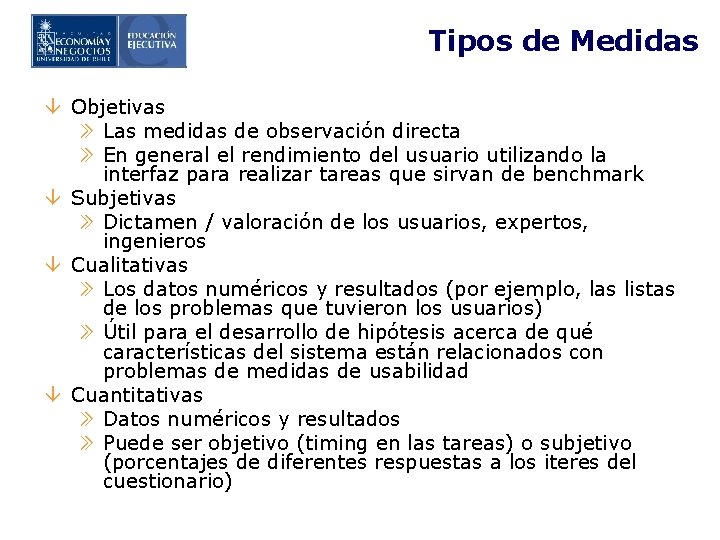

Tipos de Medidas â Objetivas » Las medidas de observación directa » En general el rendimiento del usuario utilizando la interfaz para realizar tareas que sirvan de benchmark â Subjetivas » Dictamen / valoración de los usuarios, expertos, ingenieros â Cualitativas » Los datos numéricos y resultados (por ejemplo, las listas de los problemas que tuvieron los usuarios) » Útil para el desarrollo de hipótesis acerca de qué características del sistema están relacionados con problemas de medidas de usabilidad â Cuantitativas » Datos numéricos y resultados » Puede ser objetivo (timing en las tareas) o subjetivo (porcentajes de diferentes respuestas a los iteres del cuestionario)

Midiendo el alcance de los objetivos â Requerimientos para las medidas de efectividad (MOEs) » Medibles (objetiva o subjetivamente) » Relacionadas con (algún aspecto de) la performance del DSS â Formas de medir » Medir el objetivo » Evaluación de experto » Juicio subjetivo â Identificar primero que valores medir luego decidir cómo medir » Error frecuente: si no sabemos qué medir entonces no importa â Descomposición jerárquica » Agrupar atributos en categorías » 7 o menos atributos en cada grupo » El nivel más alto es el objetivo principal » Trate de evaluar todas las dimensiones de valor

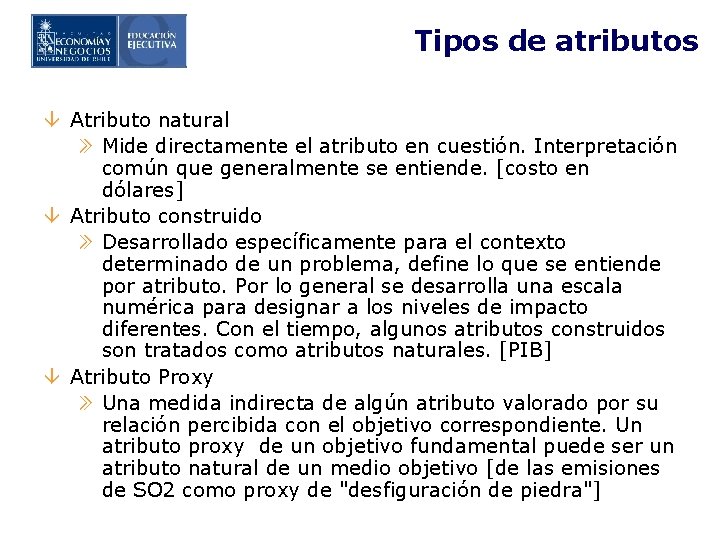

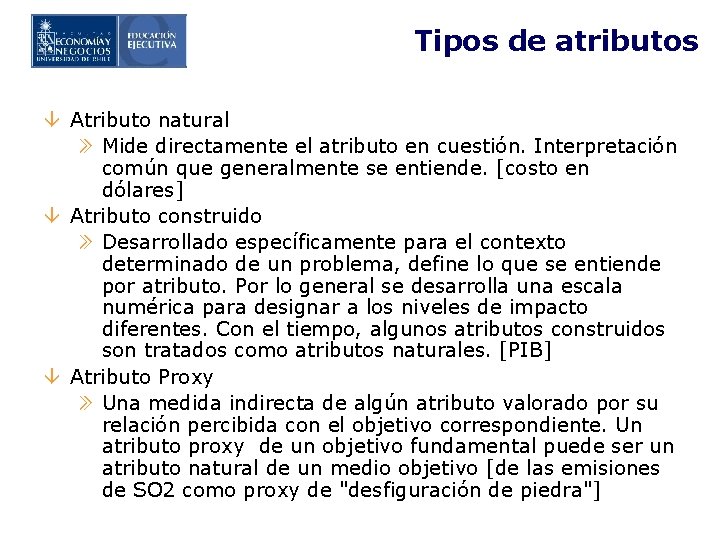

Tipos de atributos â Atributo natural » Mide directamente el atributo en cuestión. Interpretación común que generalmente se entiende. [costo en dólares] â Atributo construido » Desarrollado específicamente para el contexto determinado de un problema, define lo que se entiende por atributo. Por lo general se desarrolla una escala numérica para designar a los niveles de impacto diferentes. Con el tiempo, algunos atributos construidos son tratados como atributos naturales. [PIB] â Atributo Proxy » Una medida indirecta de algún atributo valorado por su relación percibida con el objetivo correspondiente. Un atributo proxy de un objetivo fundamental puede ser un atributo natural de un medio objetivo [de las emisiones de SO 2 como proxy de "desfiguración de piedra"]

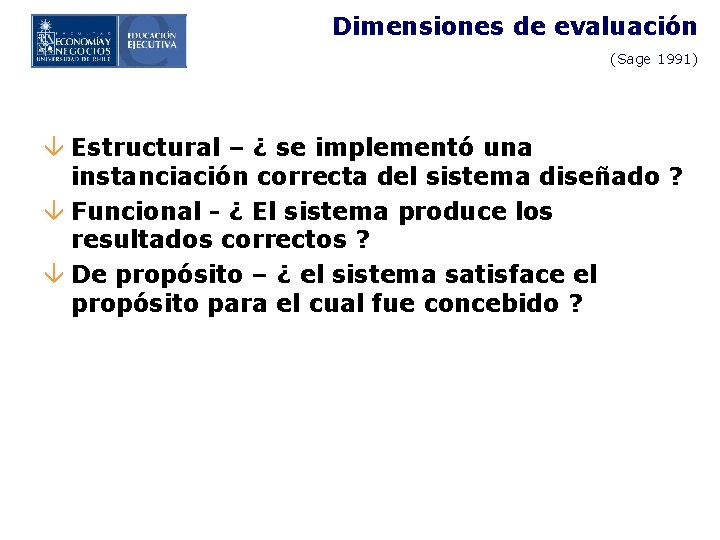

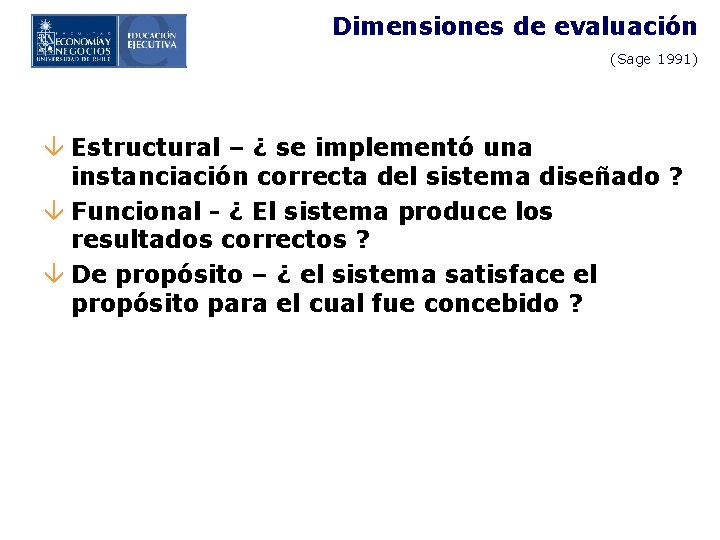

Dimensiones de evaluación (Sage 1991) â Estructural – ¿ se implementó una instanciación correcta del sistema diseñado ? â Funcional - ¿ El sistema produce los resultados correctos ? â De propósito – ¿ el sistema satisface el propósito para el cual fue concebido ?

Tipos de evaluación (Adelman 1992) â Evaluación técnica - aplicar criterios técnicos para evaluar la corrección (algorítmica y sistémática) â Evaluación empírica - recoger datos objetivos sobre Rendimiento de DSS â La evaluación subjetiva - evaluar DSS desde perspectiva de los potenciales usuarios

Ejemplos de Medidas de Efectividad para cada tipo de evaluación â Técnicos » errores identificados en el código » Evaluación del experto del diseño; hay un matching entre el método y la tarea » Resultados de correr los modules en cases de referencia (benchmarking) â Empíricos (observaciones de campo, quasi-experimentos, experimento) » Tiempo de decisión » Calidad de la decisión (juicio experto o medición objetiva) â Subjetivos » Cuestionarios » Entrevistas » Delphi u otro proceso de facilitación de grupo » Observaciones de campo

Interfaces a evaluar â DSS <-> Usuario » Correspondencia entre el DSS y el usuario (background, estilo de trabajo, necesidades operacionales) » Adecuación del DSS (facilidad de uso, adecuación de las características, . . . ) â DSS + Usuario <-> Organización » Eficiencia de la organización » Como encaja en la organización â Organización <-> Medio Ambiente » Calidad de las decisiones » Correspondencia entre el enfoque técnico y los requisitos de la tarea » Calidad del proceso de la toma de decisiones

Organizando la recolección de datos â El plan de pruebas debe incluir » Las medidas a tomas » Requerimientos para el cual el test es relevante » Resultados esperados agrupados en exitosos /aceptables/ problemáticos / inaceptables â El registro del test debe incluir » Las medidas (corpus) » Categorización de los resultados » Acciones a tomar como consecuencia » Prioridades de las acciones â Esta información debe estar resumida de modo que apoye la toma de decisiones

Diseño experimental â Por lo general muchos factores pueden influir en el valor de un variable dependiente » Características de los usuarios de » Características del problema » Características del montaje experimental â Objetivo: diseñar un experimento para estimar los efectos principales de los factores y las interacciones entre los factores de » Una interacción significa que el efecto de un factor que depende de los valores de de otros factores » Para estimar interacciones son necesarias muestras de datos de mayor tamaño que las necesarias para estimar los efectos principales â El diseño experimental establece un plan de cómo los sujetos del experimento serán asignados a las condiciones experimentales » Objetivo: poder estadístico suficiente para lograr un resultado válido

Resumen: Desarrollo de un DSS y evaluación â El desarrollo evolutivo suele ser necesario; dos puntos importantes: » Dimensiones de la evolución » Gestión de la evolución â La evolución implica ciclos de evaluación formativa » Evaluar en múltiples dimensiones » Identificar y priorizar las áreas de mejora » Hacer periódicamente decisiones de seguir / no seguir â La evaluación sumativa al final del proyecto ayuda incrementalmente a mejorar la capacidad de desarrollo de DSS â Las pruebas de campo puede ayudar a priorizar las mejoras y ofrecer "Lecciones aprendidas" para mejorar la organización del proceso de desarrollo de DSS

Sistemas de apoyo a la toma de decisiones ejemplos

Sistemas de apoyo a la toma de decisiones ejemplos Mdulo

Mdulo Decisiones repetitivas

Decisiones repetitivas Ejemplos de gdss

Ejemplos de gdss Operaciones de apoyo

Operaciones de apoyo Programa apoyo a familias para el autoconsumo

Programa apoyo a familias para el autoconsumo Modelos gerenciales de la toma de decisiones

Modelos gerenciales de la toma de decisiones Modelo oriental habilidades directivas

Modelo oriental habilidades directivas Y nadie toma para si esta honra

Y nadie toma para si esta honra Herramientas del metodo cuantitativo

Herramientas del metodo cuantitativo Proceso militar para la toma de decisiones

Proceso militar para la toma de decisiones Tubos para muestras de laboratorio

Tubos para muestras de laboratorio Sistemas ejecutivos

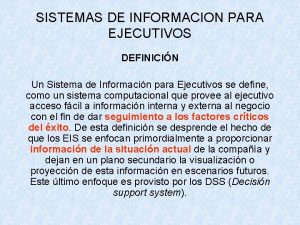

Sistemas ejecutivos Sistemas de información para ejecutivos

Sistemas de información para ejecutivos Primera ley de la termodinamica en sistemas abiertos

Primera ley de la termodinamica en sistemas abiertos Cuerpo suspendido

Cuerpo suspendido Direccion de apoyo a estudiantes unison

Direccion de apoyo a estudiantes unison Texto argumentativo ejemplo corto

Texto argumentativo ejemplo corto Apoyo a la lectoescritura

Apoyo a la lectoescritura Ejemplos de procesos de apoyo

Ejemplos de procesos de apoyo Plan de apoyo psicopedagógico

Plan de apoyo psicopedagógico Medios de apoyo

Medios de apoyo Procesos de apoyo

Procesos de apoyo Versos

Versos Apoyo comunal

Apoyo comunal Material de apoyo colegio san francisco coll

Material de apoyo colegio san francisco coll Redes de apoyo decreto

Redes de apoyo decreto Dadme un punto de apoyo

Dadme un punto de apoyo Bocadillos lenguaje

Bocadillos lenguaje Cuales son los apoyos verbales

Cuales son los apoyos verbales Configuraciones de apoyo ejemplos

Configuraciones de apoyo ejemplos Descansos incisales

Descansos incisales Carta gantt protocolos minsal

Carta gantt protocolos minsal Curso apoyo conductual

Curso apoyo conductual Reflexiones crecimiento espiritual

Reflexiones crecimiento espiritual Cuales son los valores de un buen conductor

Cuales son los valores de un buen conductor Dadme un punto de apoyo y movere

Dadme un punto de apoyo y movere Curso apoyo psicosocial

Curso apoyo psicosocial Cecosame

Cecosame Cap eis

Cap eis Sistema de apoyo a ejecutivos (ess)

Sistema de apoyo a ejecutivos (ess) Prestaciones y apoyo al empleado

Prestaciones y apoyo al empleado Apoyo en escuadra gimnasia

Apoyo en escuadra gimnasia Configuraciones de apoyo

Configuraciones de apoyo