LEARNING Theory and Algorithm Nelly Indriani Widiastuti M

- Slides: 28

LEARNING Theory and Algorithm Nelly Indriani Widiastuti M. T.

Pokok Bahasan • Pengenalan • Artificial Neural Network • Learning Vector Quantization

LEARNING • Learning sangat penting untuk lingkungan tidak diketahui, i. e. , designer tidak omniscience • Learning berguna sebagai metode konstruksi sistem i. e. , membuat agent mengenali realitas daripada merinci satu per satu • Learning memodifikasi mekanisme pengambilan keputusan sebuah agen untuk meningkatkan performa

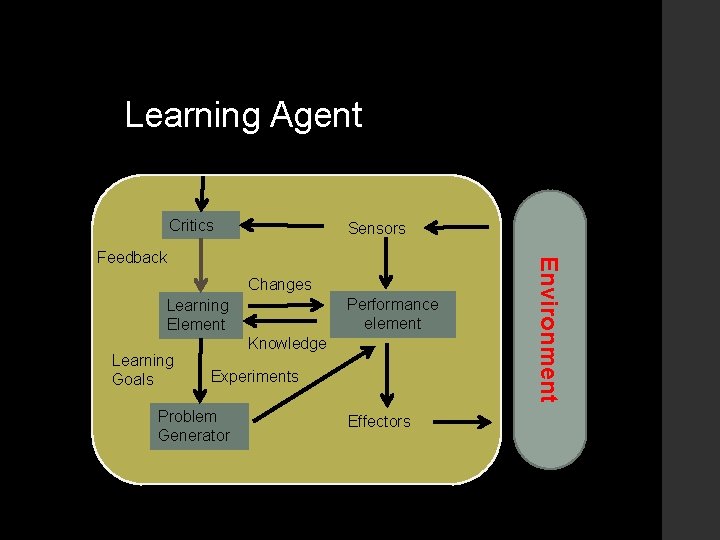

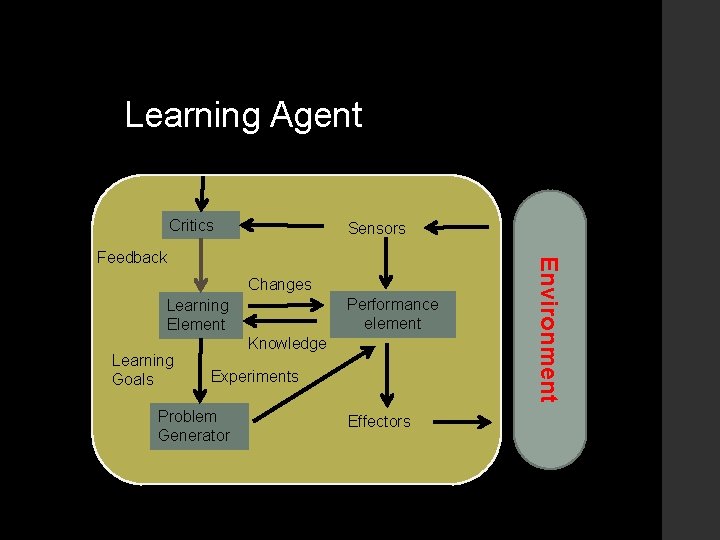

Learning Agent Critics Sensors Changes Performance element Learning Element Learning Goals Knowledge Experiments Problem Generator Effectors Environment Feedback

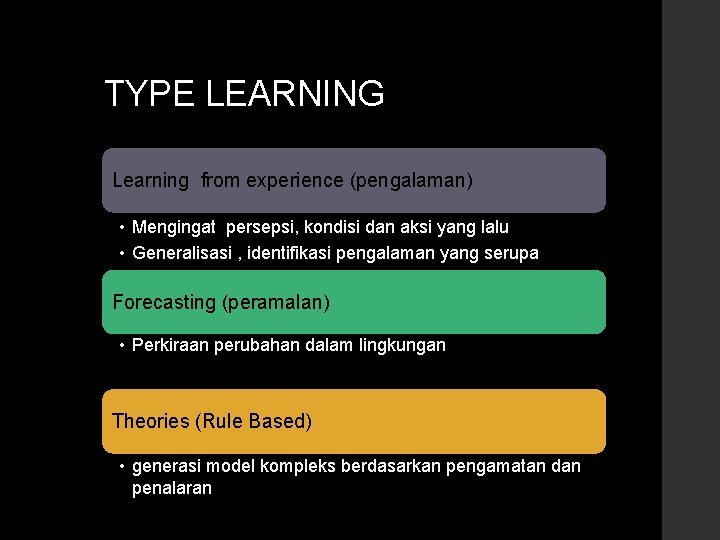

TYPE LEARNING Learning from experience (pengalaman) • Mengingat persepsi, kondisi dan aksi yang lalu • Generalisasi , identifikasi pengalaman yang serupa Forecasting (peramalan) • Perkiraan perubahan dalam lingkungan Theories (Rule Based) • generasi model kompleks berdasarkan pengamatan dan penalaran

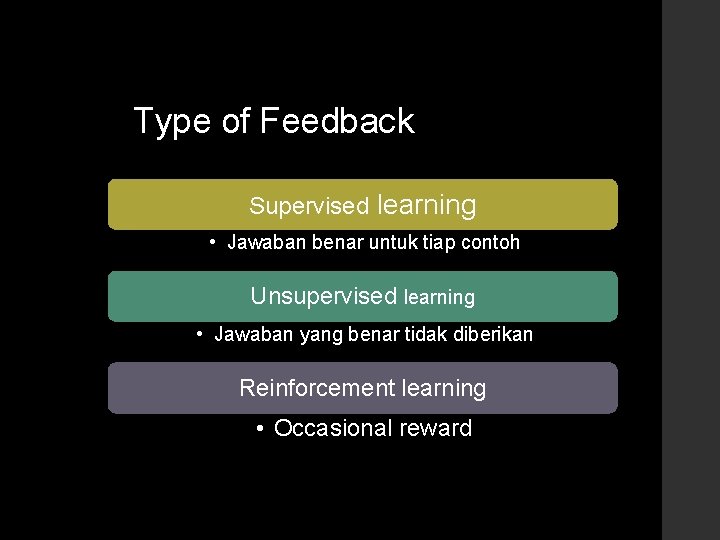

Type of Feedback Supervised learning • Jawaban benar untuk tiap contoh Unsupervised learning • Jawaban yang benar tidak diberikan Reinforcement learning • Occasional reward

Supervised learning • • Mencari suatu fungsi yang sesuai dengan contoh dari himpunan sample ( Data training ) Contoh : Backpropagation Hebb Rule Perceptron LVQ

Unsupervised learning • Atau Jaringan Kohonen • Belajar dari pola yang tidak berkaitan dengan nilai output : clustering

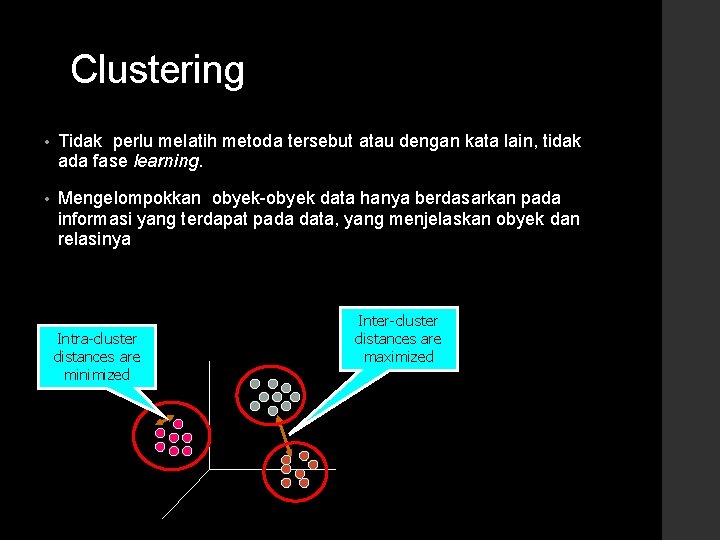

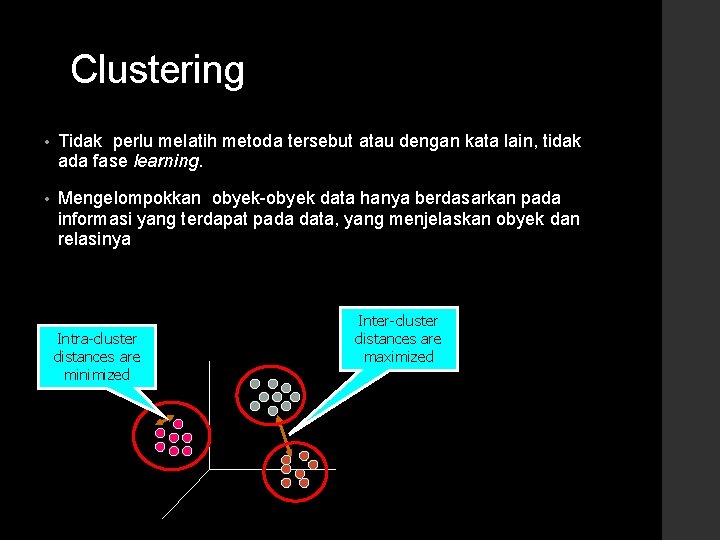

Clustering • Tidak perlu melatih metoda tersebut atau dengan kata lain, tidak ada fase learning. • Mengelompokkan obyek-obyek data hanya berdasarkan pada informasi yang terdapat pada data, yang menjelaskan obyek dan relasinya Intra-cluster distances are minimized Inter-cluster distances are maximized

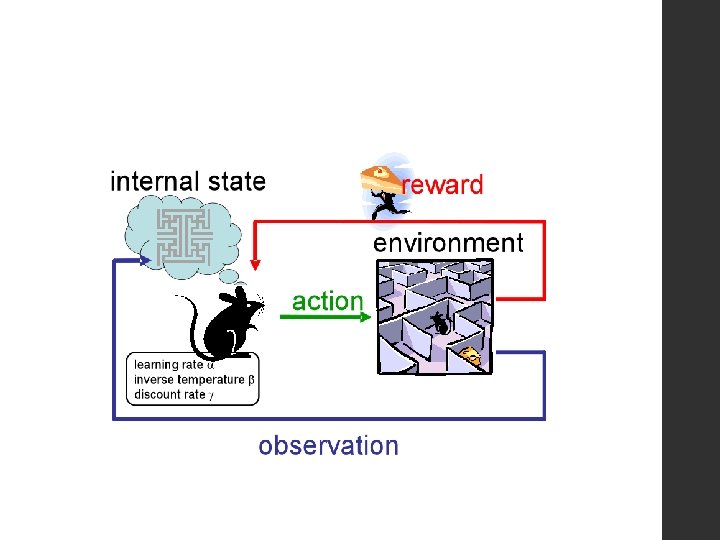

Reinforcement learning • Output tidak diketahui secara pasti untuk suatu input, tapi menerima feedback Feedback : entitas luar, lingkungan, atau agent itu sendiri. Feedback mungkin tertunda, dan tidak mengikuti masing aksi secara langsung.

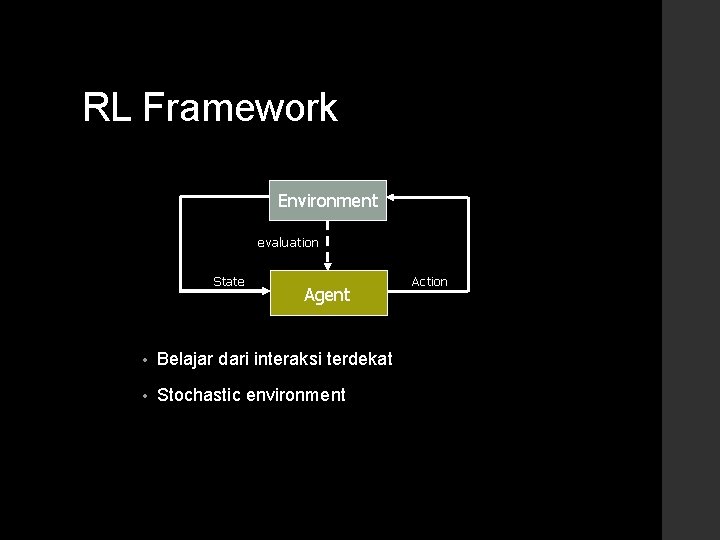

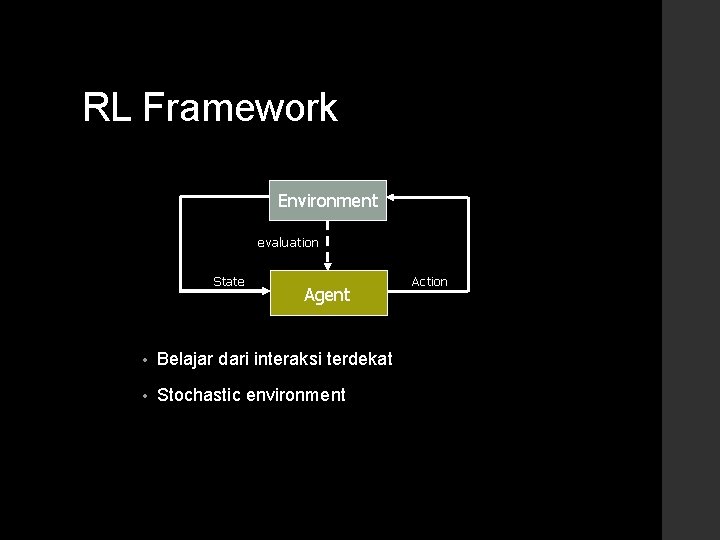

RL Framework Environment evaluation State Agent • Belajar dari interaksi terdekat • Stochastic environment Action

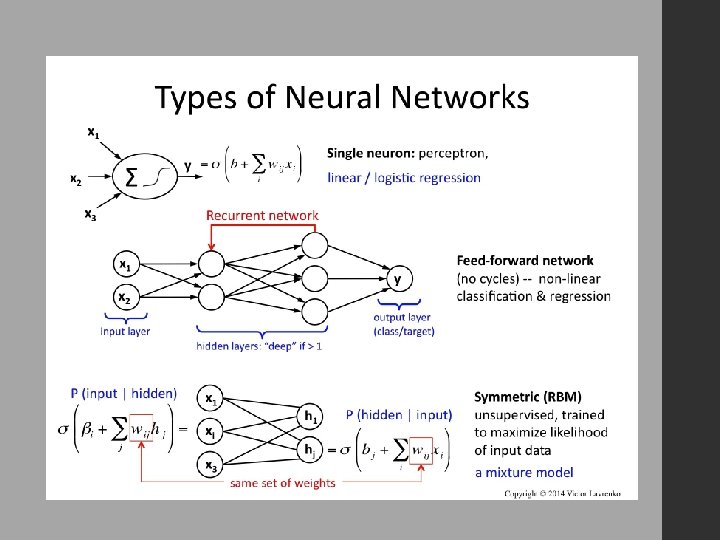

ARTIFICIAL NEURAL NETWORK

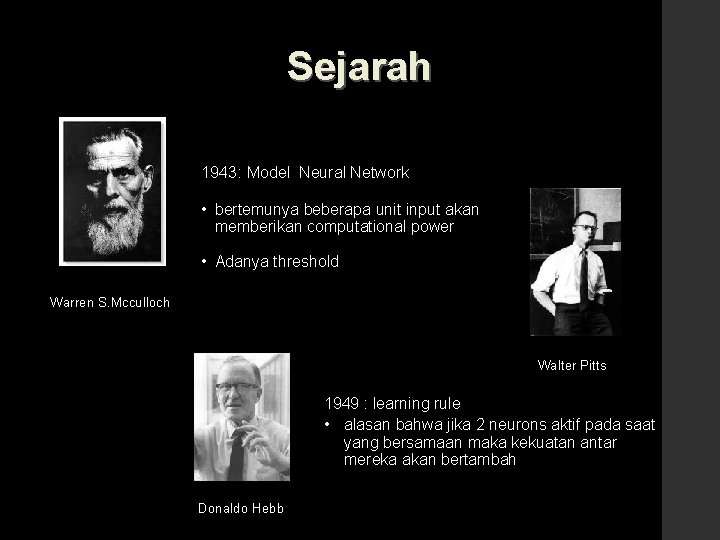

Sejarah 1943: Model Neural Network • bertemunya beberapa unit input akan memberikan computational power • Adanya threshold Warren S. Mcculloch Walter Pitts 1949 : learning rule • alasan bahwa jika 2 neurons aktif pada saat yang bersamaan maka kekuatan antar mereka akan bertambah Donaldo Hebb

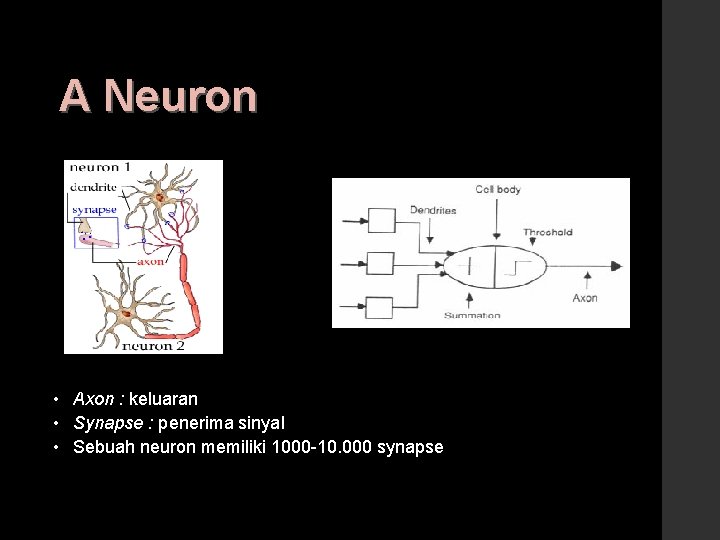

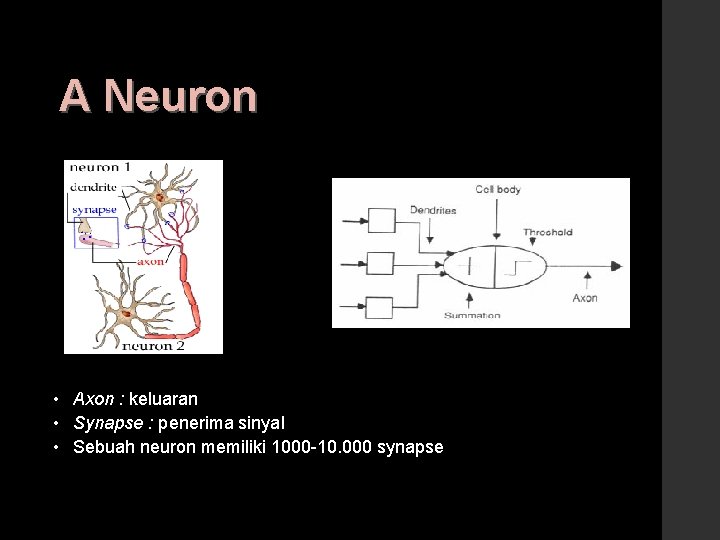

A Neuron • Axon : keluaran • Synapse : penerima sinyal • Sebuah neuron memiliki 1000 -10. 000 synapse

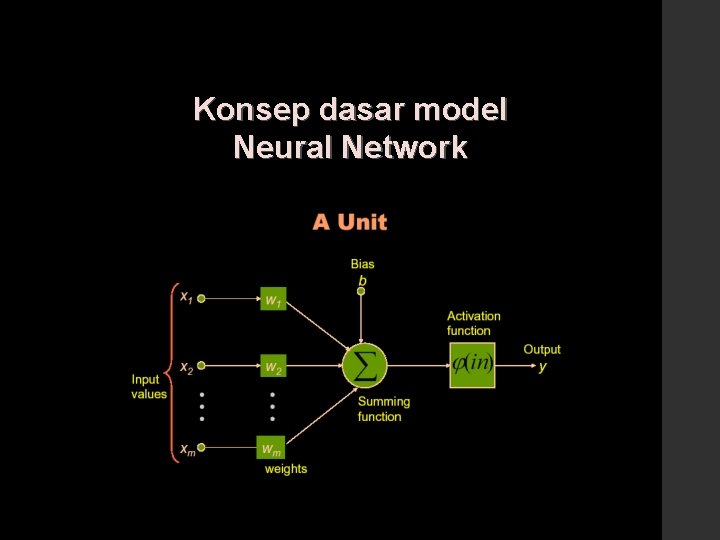

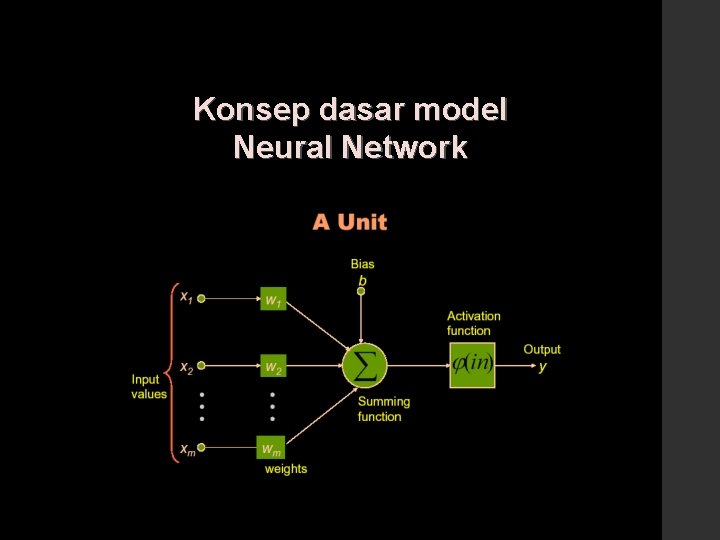

Konsep dasar model Neural Network

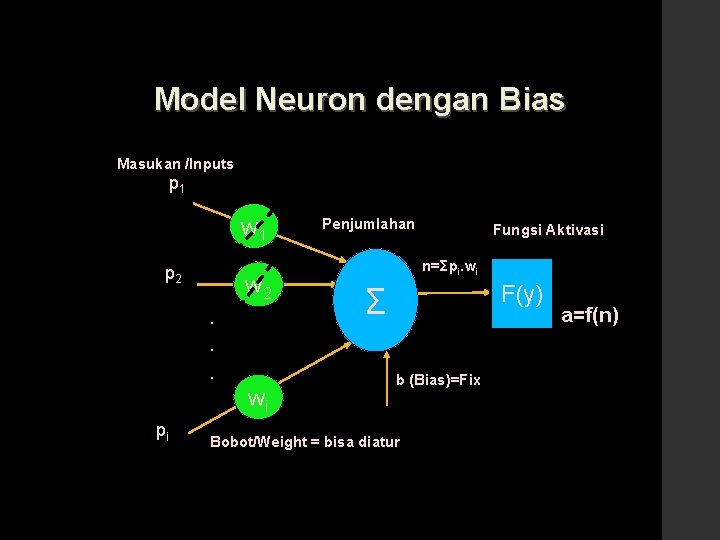

Model Neuron tanpa Bias Masukan /Inputs p 1 w 1 Penjumlahan n=Σpi. wi p 2 w 2. Σ . . wi pi Fungsi Aktifasi Bobot/Weight = bisa diatur F(y) a=f(n)

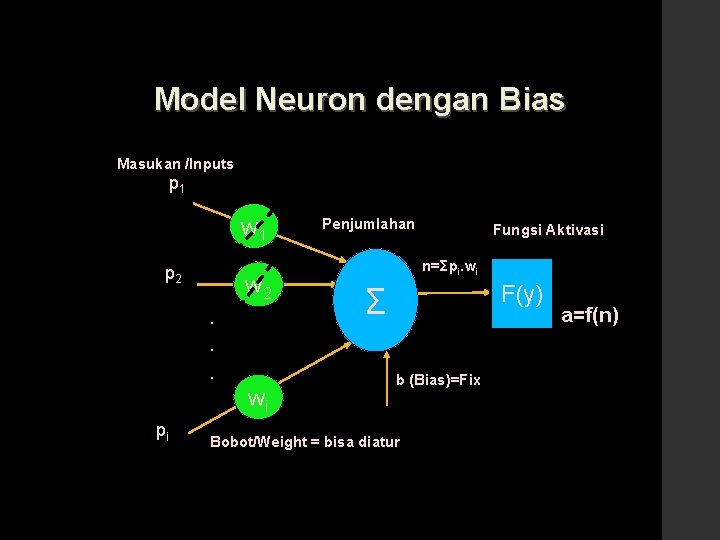

Model Neuron dengan Bias Masukan /Inputs p 1 w 1 p 2 w 2. Penjumlahan Fungsi Aktivasi n=Σpi. wi F(y) Σ . . wi pi b (Bias)=Fix Bobot/Weight = bisa diatur a=f(n)

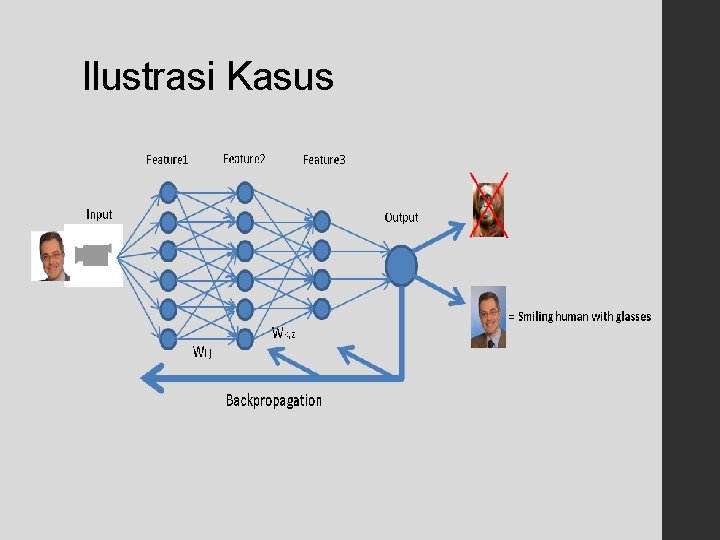

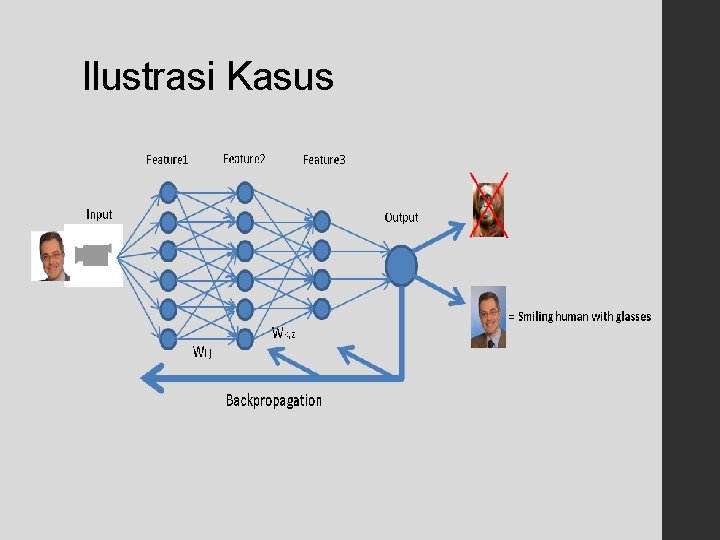

Ilustrasi Kasus

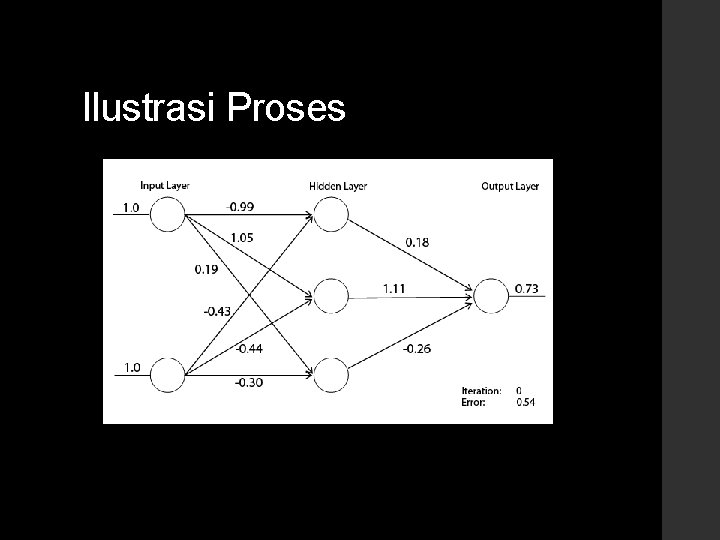

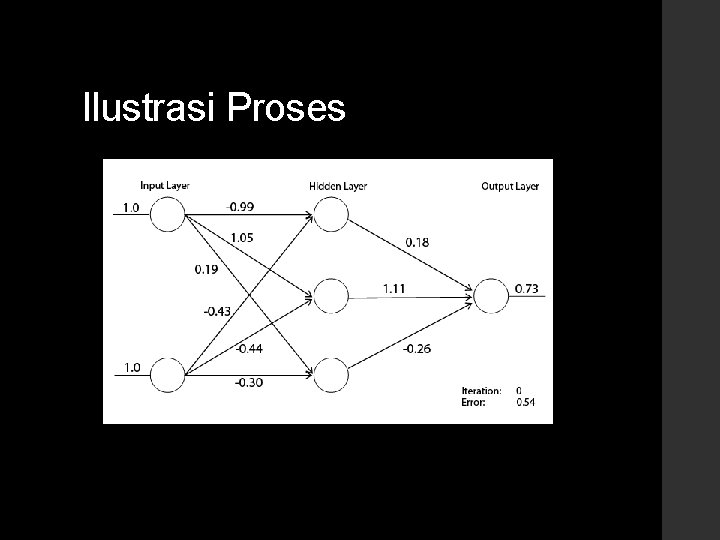

Ilustrasi Proses

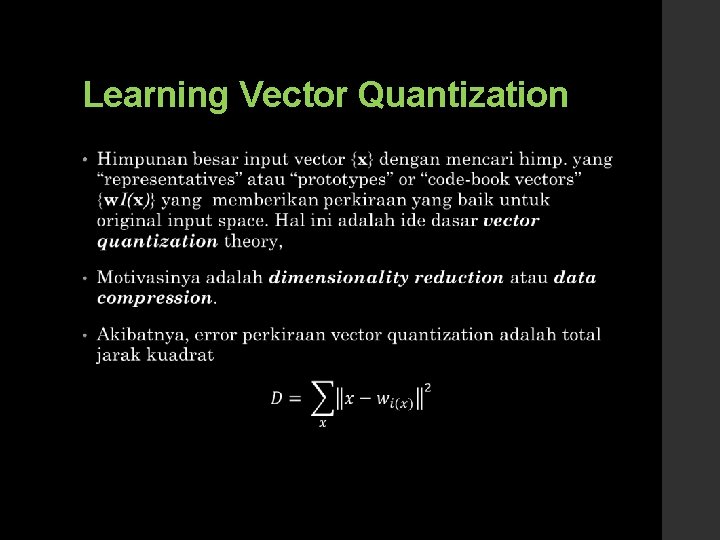

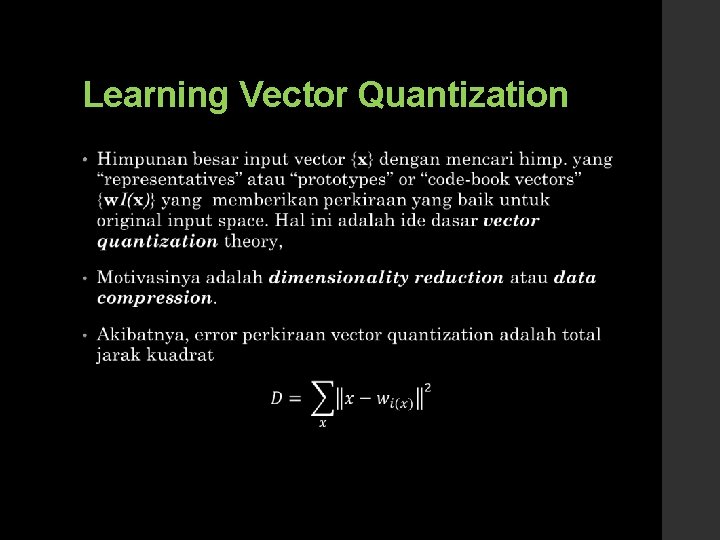

Learning Vector Quantization •

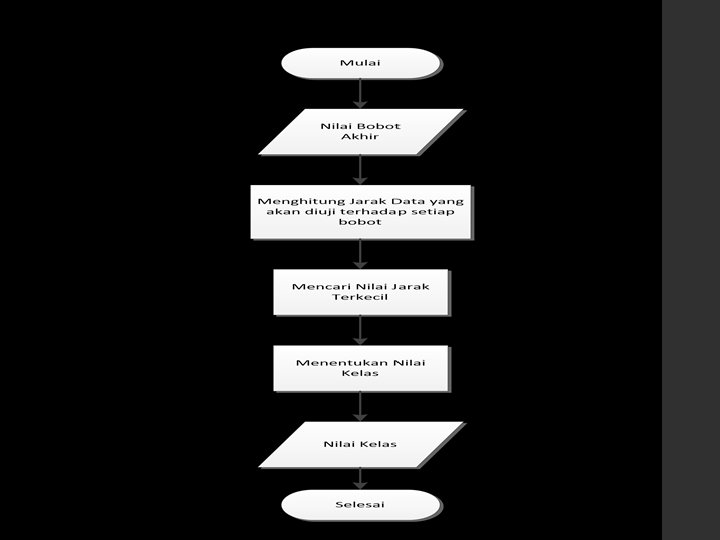

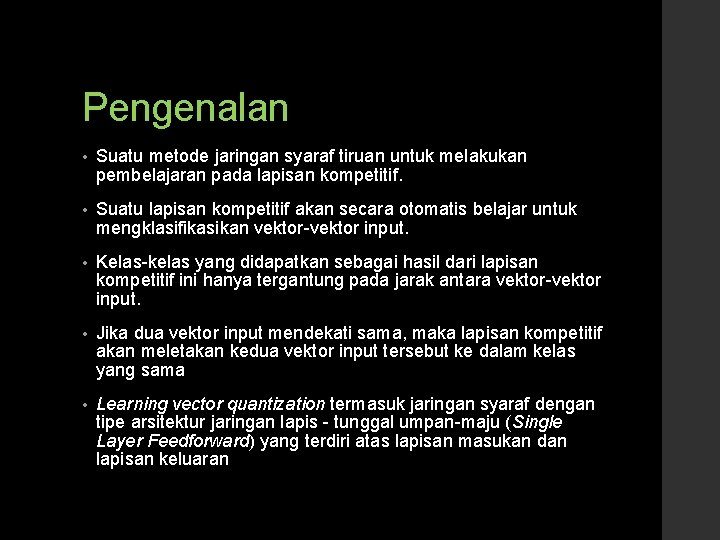

Pengenalan • Suatu metode jaringan syaraf tiruan untuk melakukan pembelajaran pada lapisan kompetitif. • Suatu lapisan kompetitif akan secara otomatis belajar untuk mengklasifikasikan vektor-vektor input. • Kelas-kelas yang didapatkan sebagai hasil dari lapisan kompetitif ini hanya tergantung pada jarak antara vektor-vektor input. • Jika dua vektor input mendekati sama, maka lapisan kompetitif akan meletakan kedua vektor input tersebut ke dalam kelas yang sama • Learning vector quantization termasuk jaringan syaraf dengan tipe arsitektur jaringan lapis - tunggal umpan-maju (Single Layer Feedforward) yang terdiri atas lapisan masukan dan lapisan keluaran

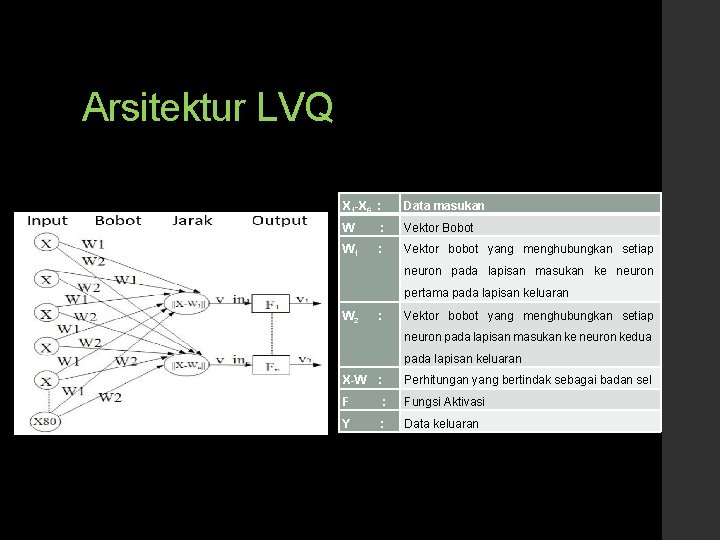

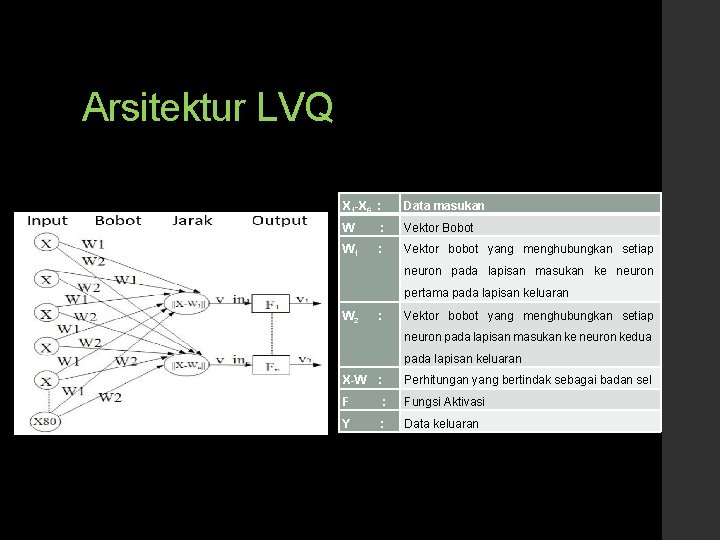

Arsitektur LVQ X 1 -X 6 : Data masukan W : Vektor Bobot W 1 : Vektor bobot yang menghubungkan setiap neuron pada lapisan masukan ke neuron pertama pada lapisan keluaran W 2 : Vektor bobot yang menghubungkan setiap neuron pada lapisan masukan ke neuron kedua pada lapisan keluaran X-W : Perhitungan yang bertindak sebagai badan sel F : Fungsi Aktivasi Y : Data keluaran

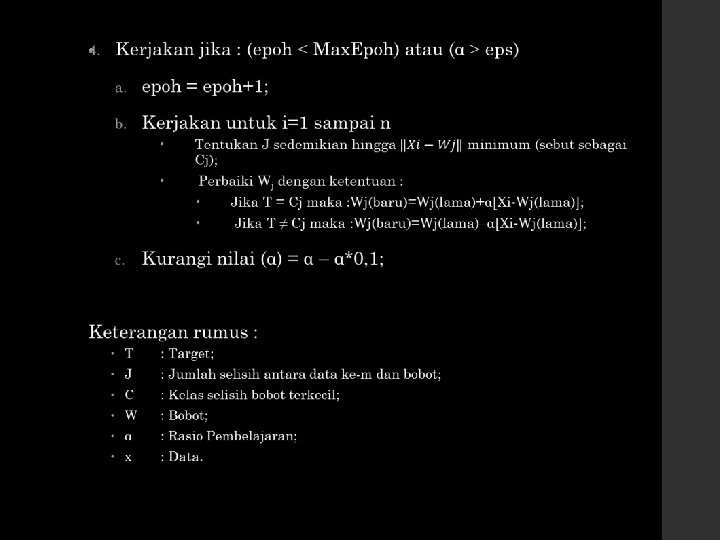

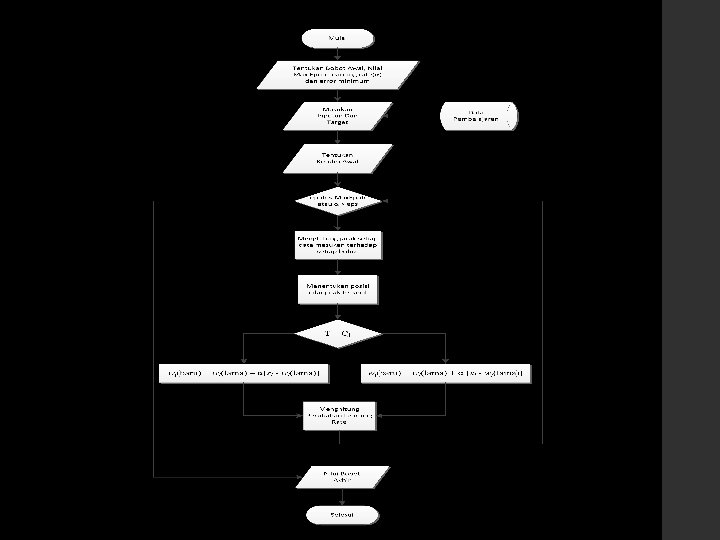

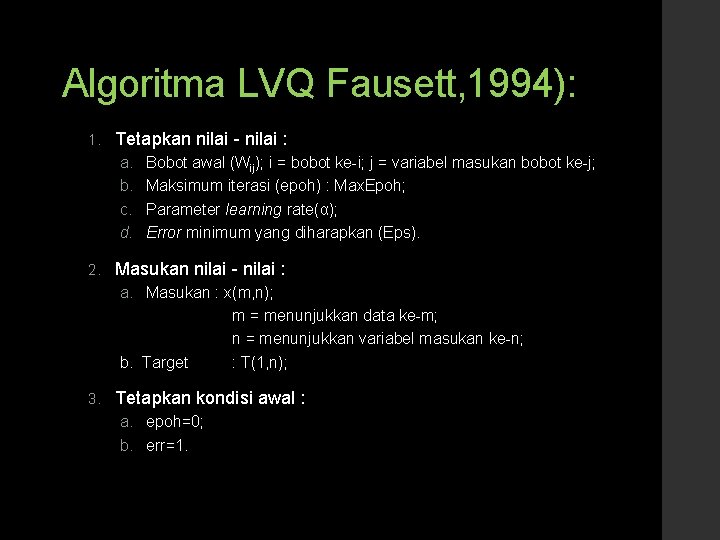

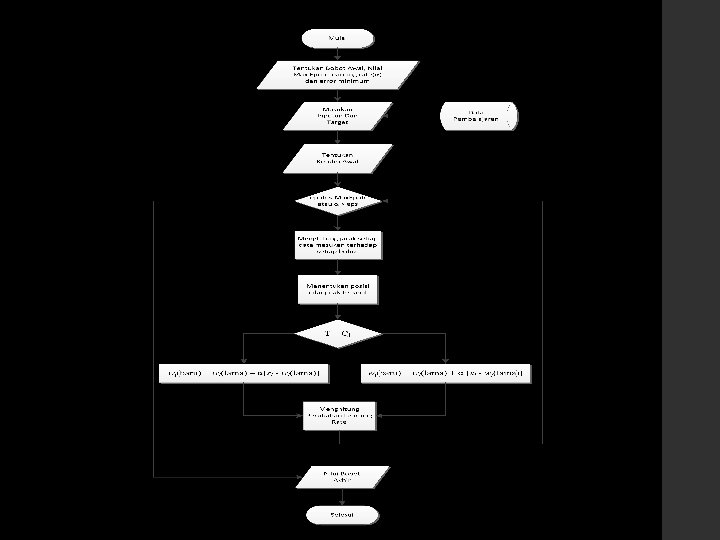

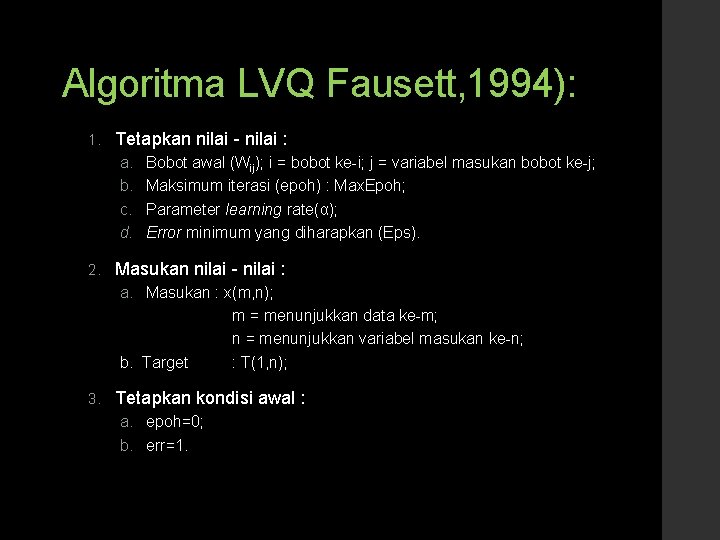

Algoritma LVQ Fausett, 1994): 1. Tetapkan nilai - nilai : a. b. c. d. 2. Bobot awal (Wij); i = bobot ke-i; j = variabel masukan bobot ke-j; Maksimum iterasi (epoh) : Max. Epoh; Parameter learning rate(α); Error minimum yang diharapkan (Eps). Masukan nilai - nilai : a. Masukan : x(m, n); m = menunjukkan data ke-m; n = menunjukkan variabel masukan ke-n; b. Target : T(1, n); 3. Tetapkan kondisi awal : a. epoh=0; b. err=1.