Introduction to Information Retrieval CS 276 Information Retrieval

- Slides: 51

Introduction to Information Retrieval CS 276 Information Retrieval and Web Search Christopher Manning and Prabhakar Raghavan Lecture 8: Evaluation

Introduction to Information Retrieval Sec. 6. 2 Nesta Aula § Como sabemos se nosso resultado é bom? § Avaliando um mecanismo de busca § Benchmarks § Precisão e retorno § Resumo dos resultados: § Fazendo os bons resultados utilizáveis para o usuário 2

Introduction to Information Retrieval AVALIANDO MECANISMOS DE BUSCA

Introduction to Information Retrieval Sec. 8. 6 Medidas para um mecanismo de busca § Quão rápido é a indexação § Número de documentos/hora § (Tamanho médio de documento) § Quão rápido é a busca § Latência em função do tamanho de índice § Expressividade da linguagem de consulta § Capacidade de expressar a necessidade de informações complexas § Velocidade em consultas complexas § UI ordenado (Uncluttered UI) § É grátis? 4

Introduction to Information Retrieval Sec. 8. 6 Medidas para um mecanismo de busca § Todos os critérios anteriores são mensuráveis: podemos quantificar a velocidade/tamanho § Nós podemos fazer expressividade precisa § A medida-chave: a felicidade do usuário § O que é isso? § Velocidade de resposta / tamanho do índice são fatores § Mas mesmo que incrivelmente rápidas, respostas inúteis não deixarão um usuário feliz § Precisamos de uma forma de quantificar a felicidade do usuário 5

Introduction to Information Retrieval Sec. 8. 6. 2 Medindo a felicidade de usuário § Questão: quem é o usuário que estamos tentando fazer feliz? § Depende da configuração § Sistema Web: § Usuário encontra o quer e retorna ao sistema § Pode medir a taxa de retorno de usuários § Usuário conclui a sua tarefa - a pesquisa como um meio, não fim § Veja Russell http: //dmrussell. googlepages. com/JCDL-talk-June-2007 short. pdf § Site de e. Commerce: usuário encontra o quer e compra § É do usuário final, ou do site e. Commerce, cuja felicidade se mede? § Medida do tempo para comprar, ou fração de usuáris que se tornam compradores? 6

Introduction to Information Retrieval Sec. 8. 6. 2 Medindo a felicidade de usuário § Empresas (companhias/governo/academia): Se preocupam sobre “produtividade do usuário” § Quanto tempo meus usuários economizam quando procuram por informação? § Muitos outros critérios têm a ver com a largura de acesso, acesso seguro, etc 7

Introduction to Information Retrieval Sec. 8. 1 Felicidade: não há como medir § Representante mais comum: relevância dos resultados de busca § Mas como medir relevância? § Vamos detalhar a metodologia aqui, em seguida, analisar os seus problemas § Medição da relevância requer 3 elementos: 1. Uma coleção de documentos de referência 2. Um conjunto referência de consultas 3. Uma avaliação, geralmente binária, de Relevante ou Não-Relevante para cada consulta e cada documento § Alguns trabalham com mais que binário, mas não é o padrão 8

Introduction to Information Retrieval Sec. 8. 1 Avaliando um sistema de RI § Nota: a necessidade de informação é traduzida em uma consulta § A relevância é avaliada em relação à informação necessária não a consulta § Por exemplo, informação necessária: Estou procurando informações sobre se beber vinho tinto é mais eficaz para reduzir o risco de ataques cardíacos do que o vinho branco. § Consulta: vinho branco vermelho ataque cardíaco eficaz § Avaliar se o documento aborda a informação necessário, não se possui estas palavras 9

Introduction to Information Retrieval Sec. 8. 2 Medida de relevância padrão § TREC - National Institute of Standards and Technology (NIST) rodou um grande teste base de RI por muitos anos § Reuters e outras coleções de documentos de referência usados § “Tarefas de recuperação” especificadas § As vezes como consultas § Um expert marca, para cada consulta e cada documento, Relevante ou Não-relevante § ou pelo menos um subconjunto de documentos que alguns sistemas retornam para a consulta 10

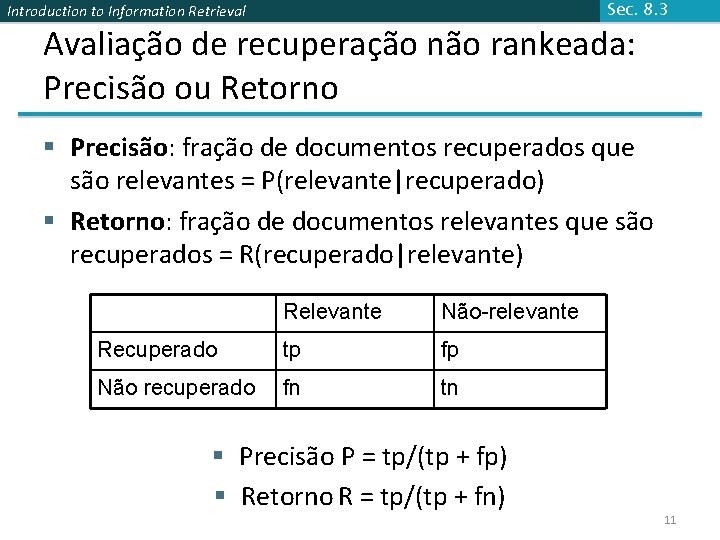

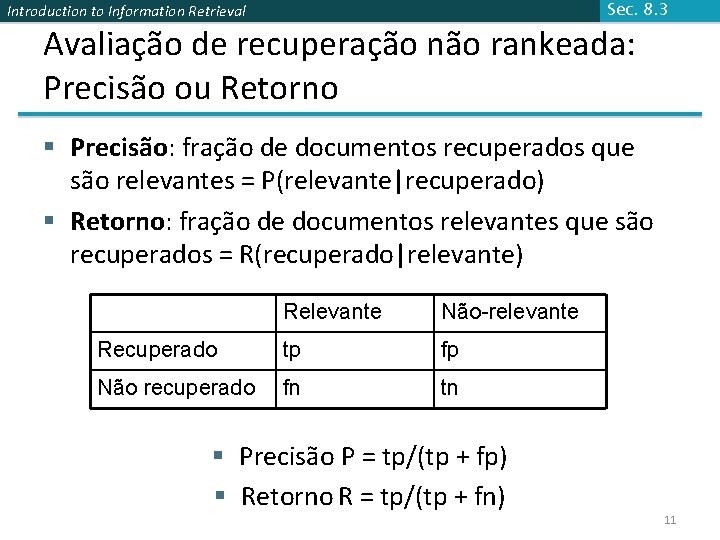

Sec. 8. 3 Introduction to Information Retrieval Avaliação de recuperação não rankeada: Precisão ou Retorno § Precisão: fração de documentos recuperados que são relevantes = P(relevante|recuperado) § Retorno: fração de documentos relevantes que são recuperados = R(recuperado|relevante) Relevante Não-relevante Recuperado tp fp Não recuperado fn tn § Precisão P = tp/(tp + fp) § Retorno R = tp/(tp + fn) 11

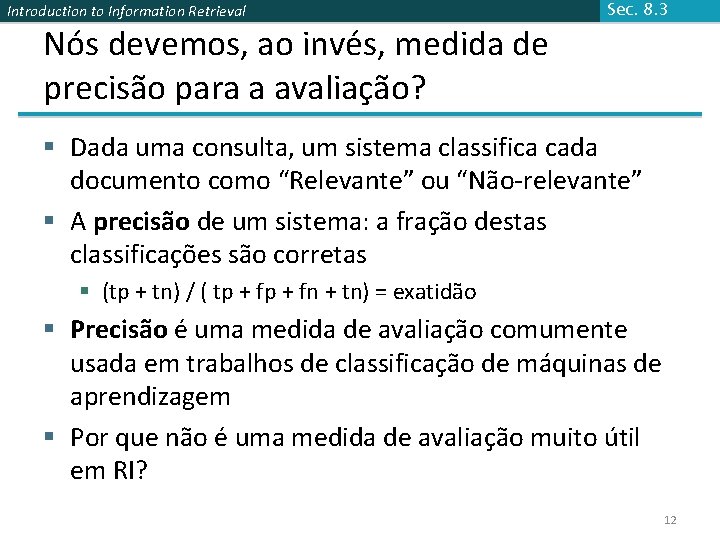

Introduction to Information Retrieval Nós devemos, ao invés, medida de precisão para a avaliação? Sec. 8. 3 § Dada uma consulta, um sistema classifica cada documento como “Relevante” ou “Não-relevante” § A precisão de um sistema: a fração destas classificações são corretas § (tp + tn) / ( tp + fn + tn) = exatidão § Precisão é uma medida de avaliação comumente usada em trabalhos de classificação de máquinas de aprendizagem § Por que não é uma medida de avaliação muito útil em RI? 12

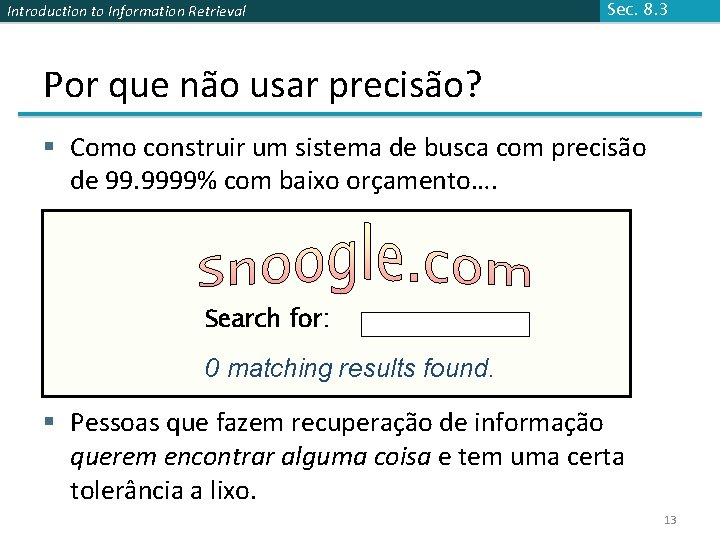

Introduction to Information Retrieval Sec. 8. 3 Por que não usar precisão? § Como construir um sistema de busca com precisão de 99. 9999% com baixo orçamento…. Search for: 0 matching results found. § Pessoas que fazem recuperação de informação querem encontrar alguma coisa e tem uma certa tolerância a lixo. 13

Introduction to Information Retrieval Sec. 8. 3 Precisão/Retorno § Você pode ter alto retorno (mas baixa precisão) ao recuperar todos os documentos para todas as consultas! § Retorno é uma função crescente de número de documentos recuperados § Em um bom sistema, quando a precisão decresce o número de documentos recuperados aumenta (retorno aumenta) § Isto não é um teorema, mas um resultado com forte confirmação empírica 14

Introduction to Information Retrieval Sec. 8. 3 Dificuldade no uso da precisão/retorno § Precisa da decisão humana de relevância § Pessoas não são assessores confiáveis § Decisão tem que ser binária § Decisões com nuances? § Fortemente enviesado por coleção/autoria § Resultados podem não traduzir de um domínio para outro 15

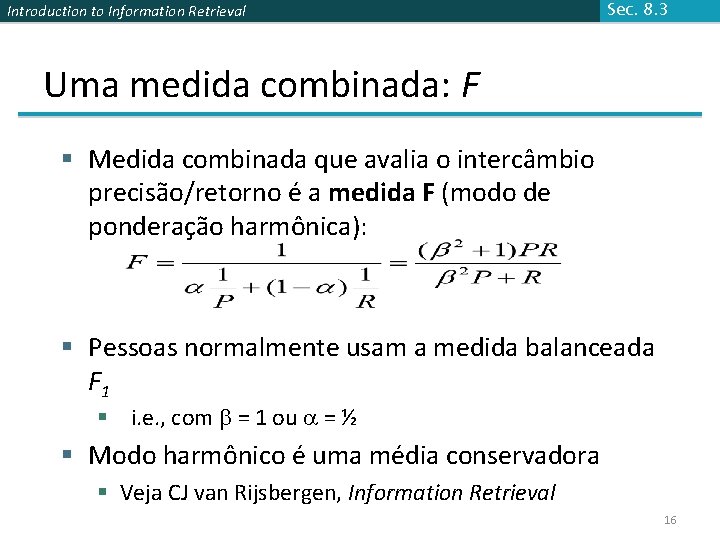

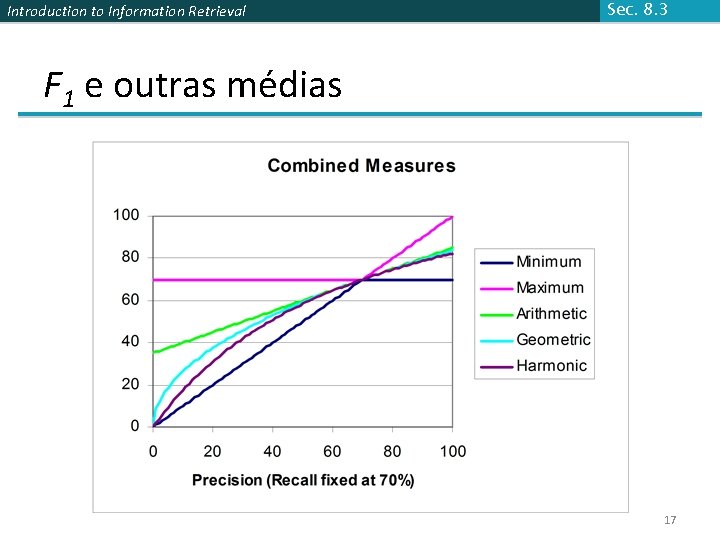

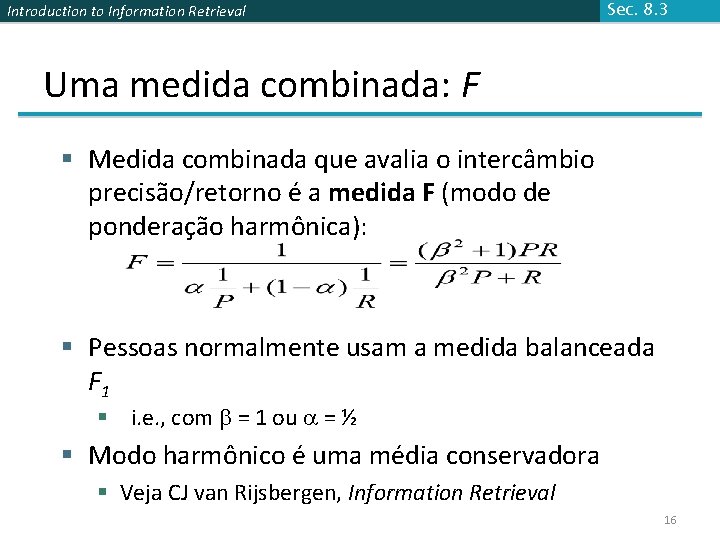

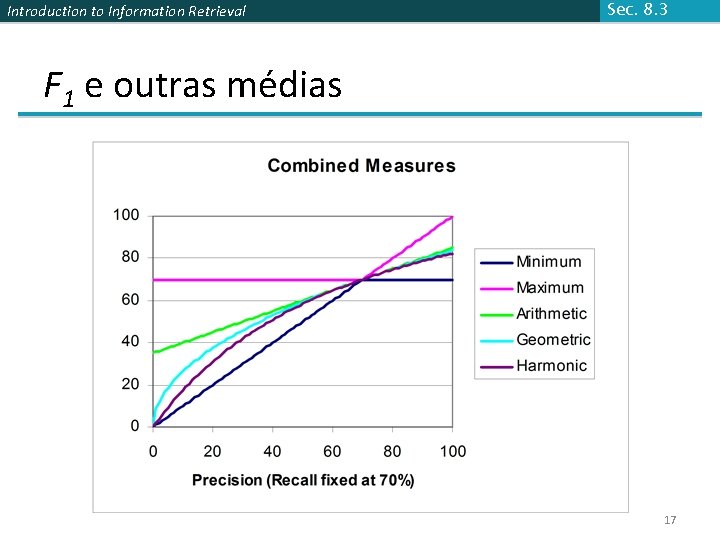

Introduction to Information Retrieval Sec. 8. 3 Uma medida combinada: F § Medida combinada que avalia o intercâmbio precisão/retorno é a medida F (modo de ponderação harmônica): § Pessoas normalmente usam a medida balanceada F 1 § i. e. , com = 1 ou = ½ § Modo harmônico é uma média conservadora § Veja CJ van Rijsbergen, Information Retrieval 16

Introduction to Information Retrieval Sec. 8. 3 F 1 e outras médias 17

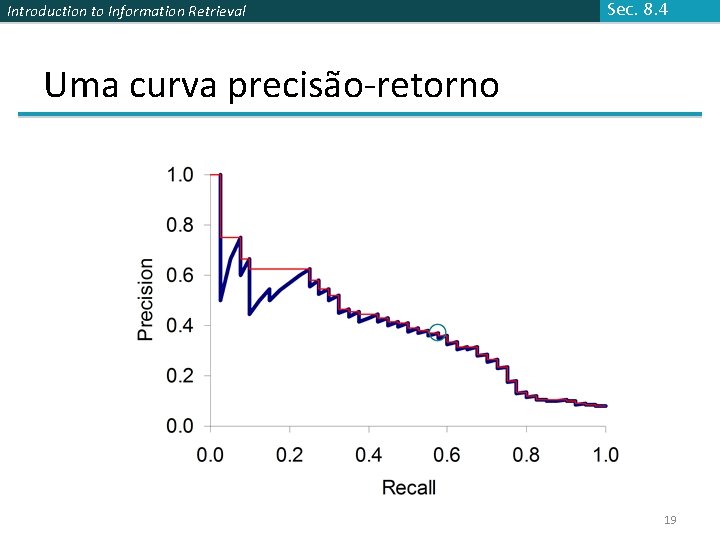

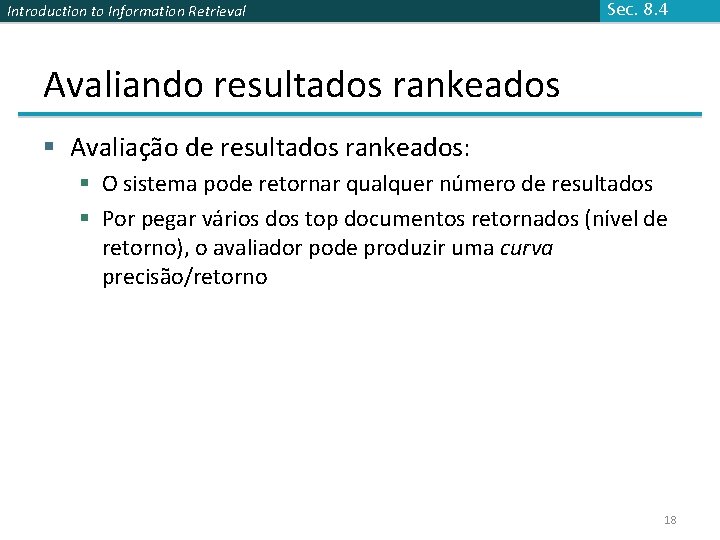

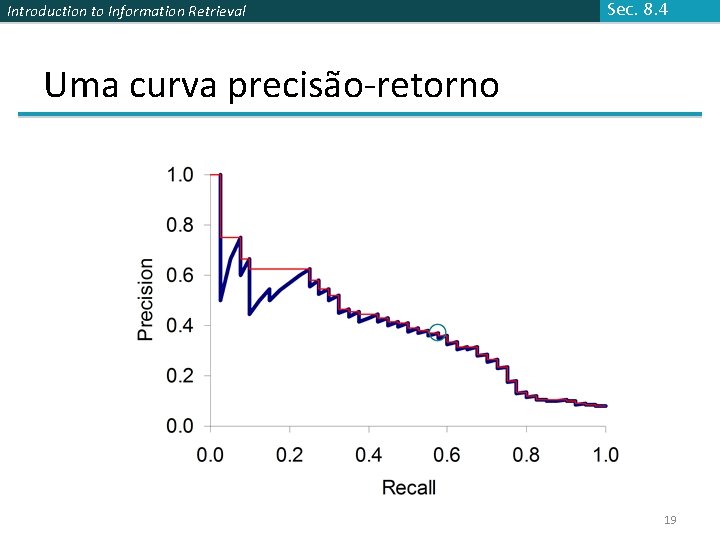

Introduction to Information Retrieval Sec. 8. 4 Avaliando resultados rankeados § Avaliação de resultados rankeados: § O sistema pode retornar qualquer número de resultados § Por pegar vários dos top documentos retornados (nível de retorno), o avaliador pode produzir uma curva precisão/retorno 18

Introduction to Information Retrieval Sec. 8. 4 Uma curva precisão-retorno 19

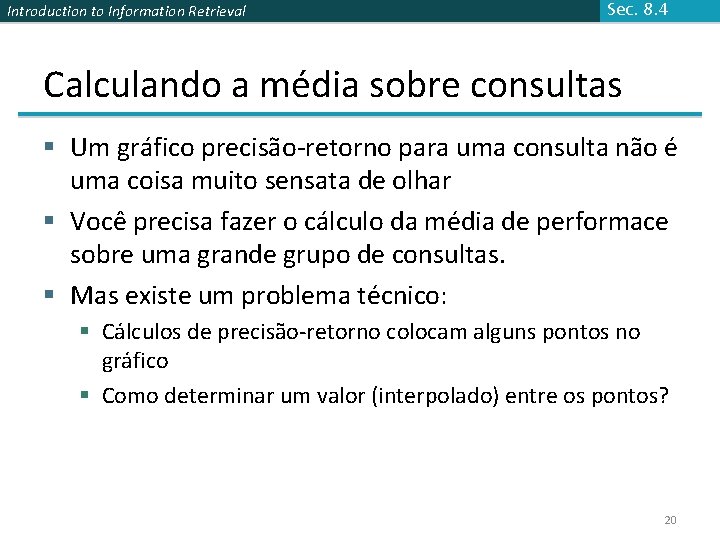

Introduction to Information Retrieval Sec. 8. 4 Calculando a média sobre consultas § Um gráfico precisão-retorno para uma consulta não é uma coisa muito sensata de olhar § Você precisa fazer o cálculo da média de performace sobre uma grande grupo de consultas. § Mas existe um problema técnico: § Cálculos de precisão-retorno colocam alguns pontos no gráfico § Como determinar um valor (interpolado) entre os pontos? 20

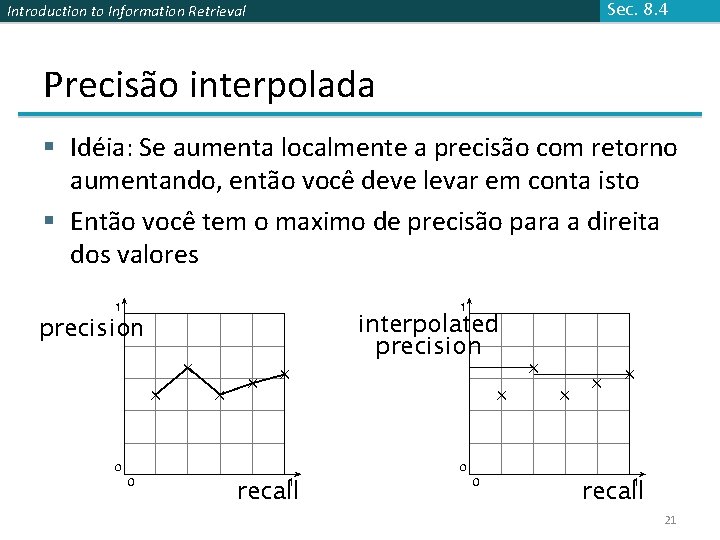

Introduction to Information Retrieval Sec. 8. 4 Precisão interpolada § Idéia: Se aumenta localmente a precisão com retorno aumentando, então você deve levar em conta isto § Então você tem o maximo de precisão para a direita dos valores 21

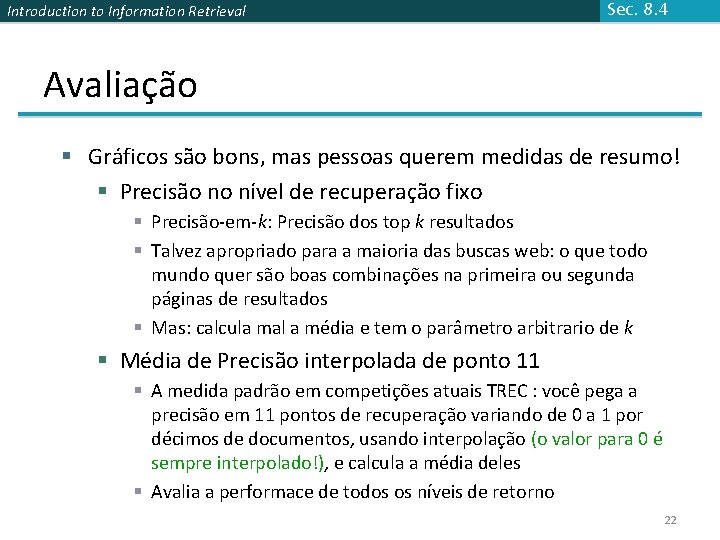

Introduction to Information Retrieval Sec. 8. 4 Avaliação § Gráficos são bons, mas pessoas querem medidas de resumo! § Precisão no nível de recuperação fixo § Precisão-em-k: Precisão dos top k resultados § Talvez apropriado para a maioria das buscas web: o que todo mundo quer são boas combinações na primeira ou segunda páginas de resultados § Mas: calcula mal a média e tem o parâmetro arbitrario de k § Média de Precisão interpolada de ponto 11 § A medida padrão em competições atuais TREC : você pega a precisão em 11 pontos de recuperação variando de 0 a 1 por décimos de documentos, usando interpolação (o valor para 0 é sempre interpolado!), e calcula a média deles § Avalia a performace de todos os níveis de retorno 22

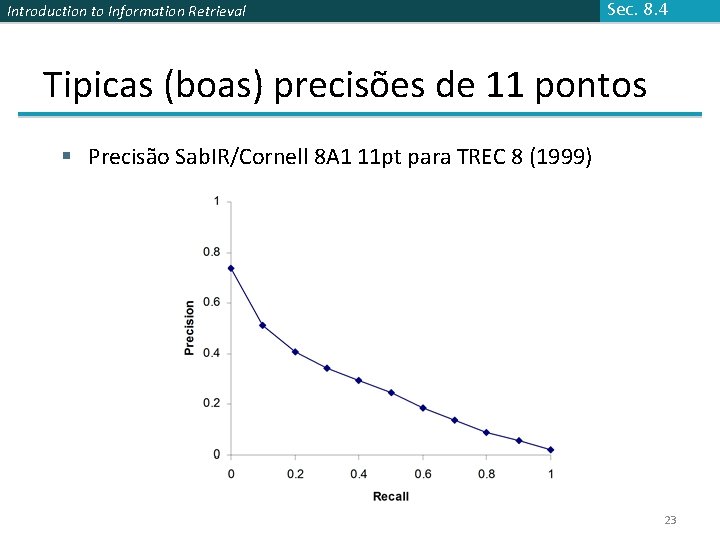

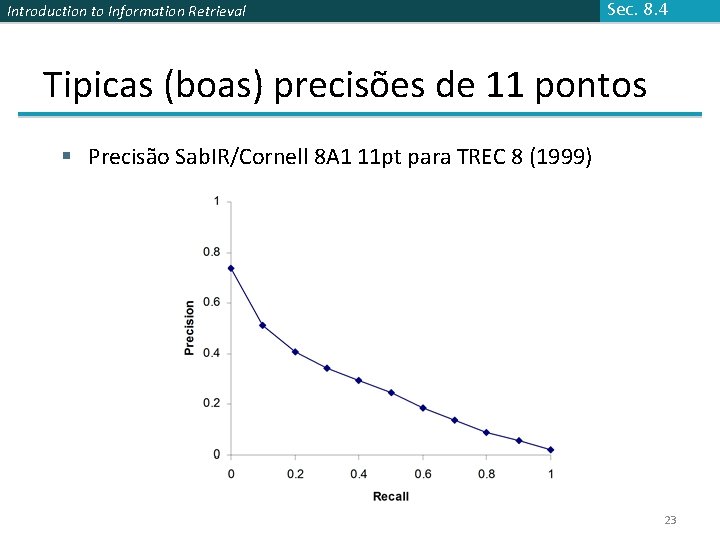

Introduction to Information Retrieval Sec. 8. 4 Tipicas (boas) precisões de 11 pontos § Precisão Sab. IR/Cornell 8 A 1 11 pt para TREC 8 (1999) 23

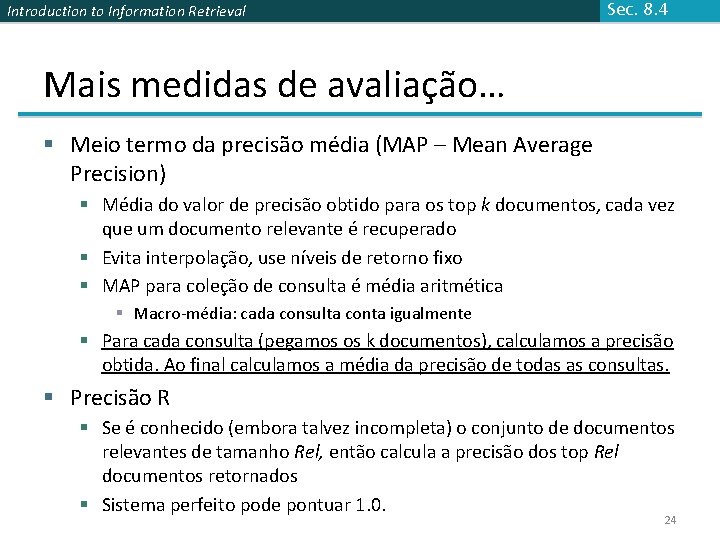

Introduction to Information Retrieval Sec. 8. 4 Mais medidas de avaliação… § Meio termo da precisão média (MAP – Mean Average Precision) § Média do valor de precisão obtido para os top k documentos, cada vez que um documento relevante é recuperado § Evita interpolação, use níveis de retorno fixo § MAP para coleção de consulta é média aritmética § Macro-média: cada consulta conta igualmente § Para cada consulta (pegamos os k documentos), calculamos a precisão obtida. Ao final calculamos a média da precisão de todas as consultas. § Precisão R § Se é conhecido (embora talvez incompleta) o conjunto de documentos relevantes de tamanho Rel, então calcula a precisão dos top Rel documentos retornados § Sistema perfeito pode pontuar 1. 0. 24

Introduction to Information Retrieval Sec. 8. 4 Variação § Para uma coleção de teste, é usual que um sistema seja pobre em alguma necessidade de informação (ex. , MAP = 0. 1) e excelente em outras (ex. , MAP = 0. 7) § De fato, é normal o caso em que a variação da performance do mesmo sistema em todas as consultas é muito maior do que a variação de diferentes sistemas na mesma consulta. § Ou seja, há necessidade de informações fáceis e difíceis! 25

Introduction to Information Retrieval CRIANDO COLEÇÕES DE TESTES PARA AVALIAÇÃO DE RI

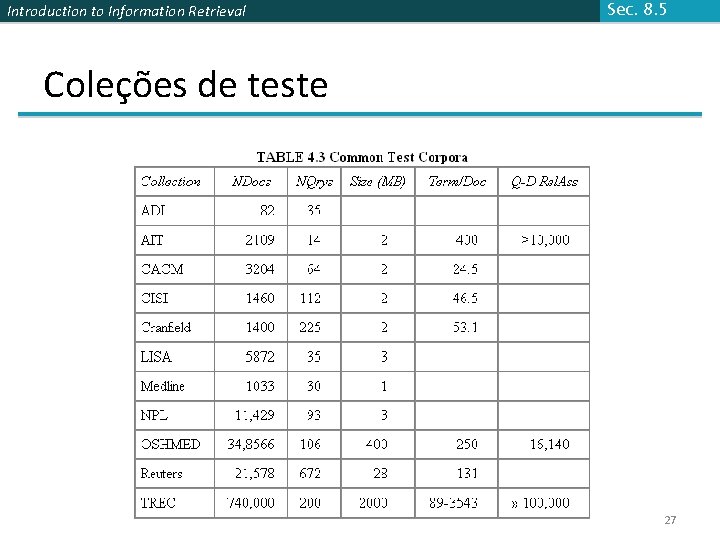

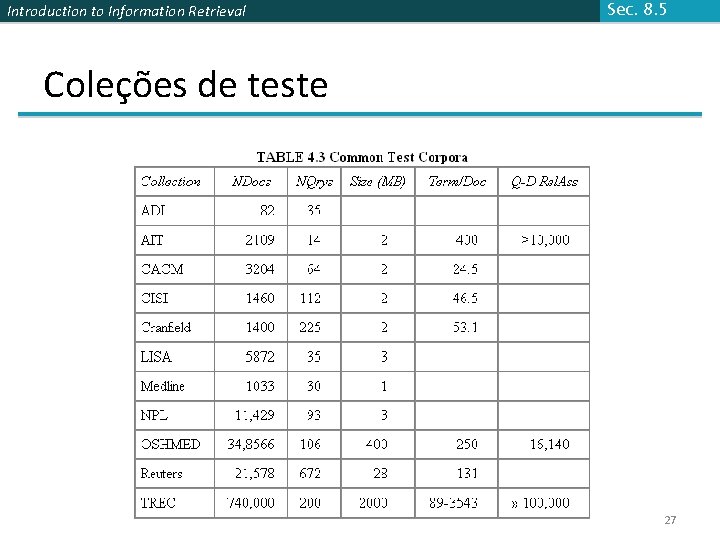

Introduction to Information Retrieval Sec. 8. 5 Coleções de teste 27

Introduction to Information Retrieval De coleções de documentos para coleções de teste Sec. 8. 5 § Ainda precisa § Consultas de teste § Avaliações de relevância § Consultas de teste § Deve ser pertinente para documentos disponíveis § Consultas relacionadas a engenharia em um domínio de engenharia § Melhor concebido por especialistas do domínio § Termos de consulta aleatórios geralmente não é uma boa idéia § Avaliações de relevância § Julgamento por homem, consumo de tempo 28

Introduction to Information Retrieval Sec. 8. 5 Unidade de avaliação § Podemos computar precisão, retorno, F, e curva ROC para diferentes unidades. § Unidades possíveis § Documentos (mais comum) § Fatos (usado em algumas avaliações TREC) § Entidades (ex. , companhias de carro) § Pode produzir resultados diferentes. Por quê? 29

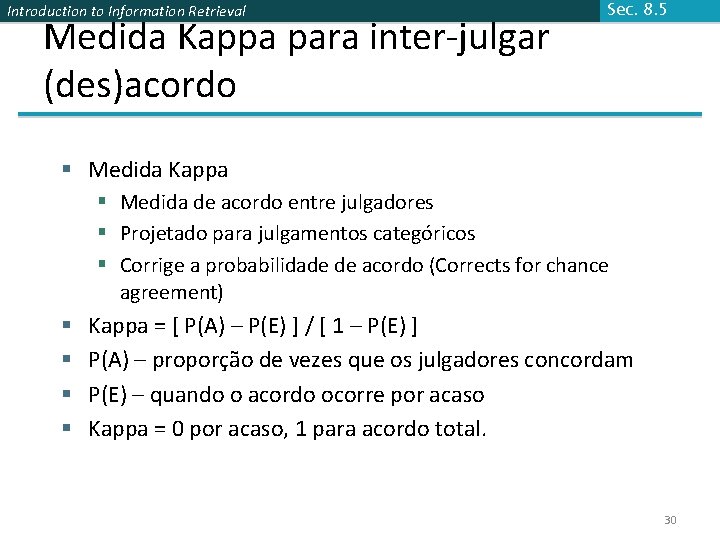

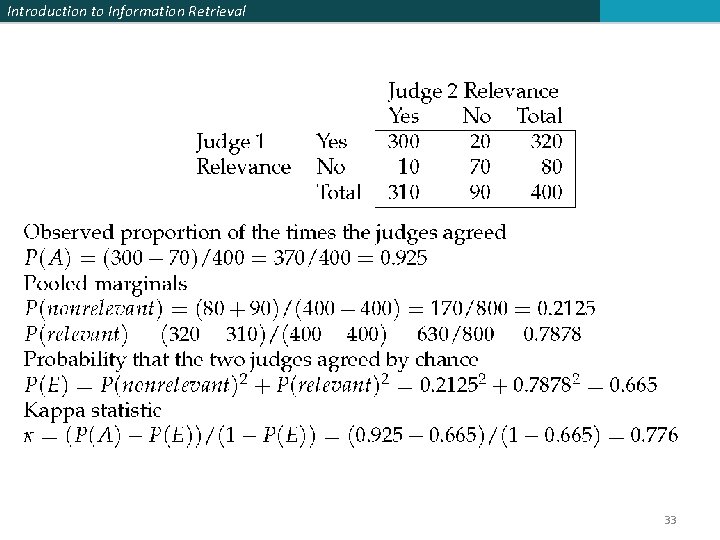

Introduction to Information Retrieval Medida Kappa para inter-julgar (des)acordo Sec. 8. 5 § Medida Kappa § Medida de acordo entre julgadores § Projetado para julgamentos categóricos § Corrige a probabilidade de acordo (Corrects for chance agreement) § § Kappa = [ P(A) – P(E) ] / [ 1 – P(E) ] P(A) – proporção de vezes que os julgadores concordam P(E) – quando o acordo ocorre por acaso Kappa = 0 por acaso, 1 para acordo total. 30

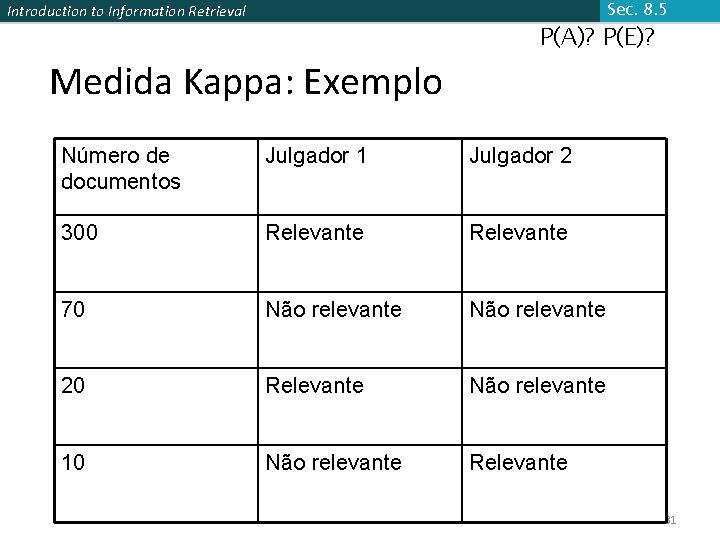

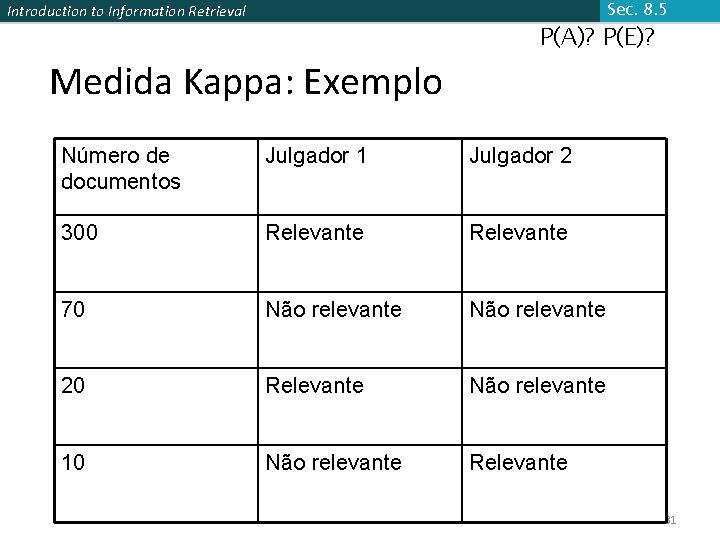

Sec. 8. 5 Introduction to Information Retrieval Medida Kappa: Exemplo P(A)? P(E)? Número de documentos Julgador 1 Julgador 2 300 Relevante 70 Não relevante 20 Relevante Não relevante 10 Não relevante Relevante 31

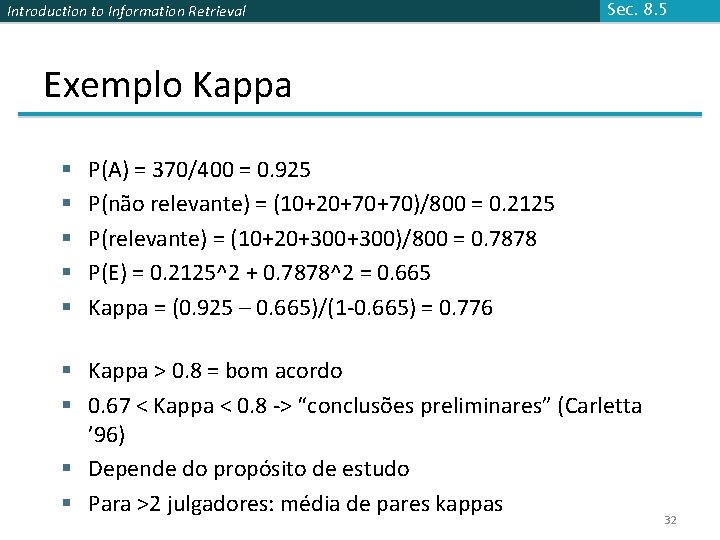

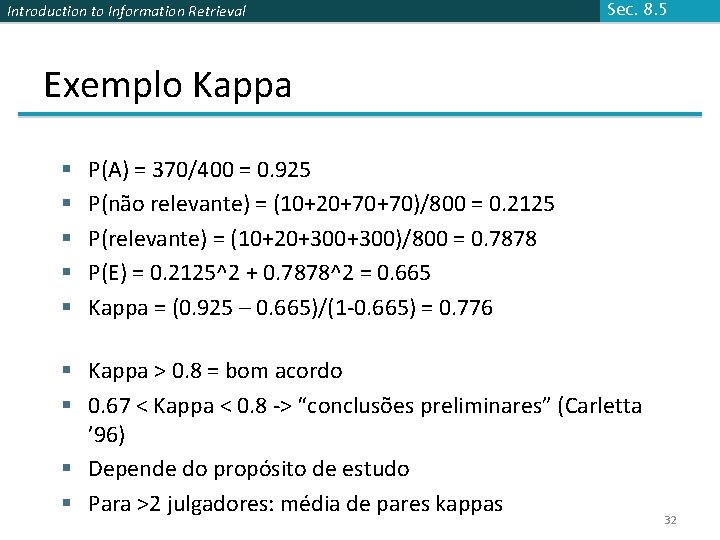

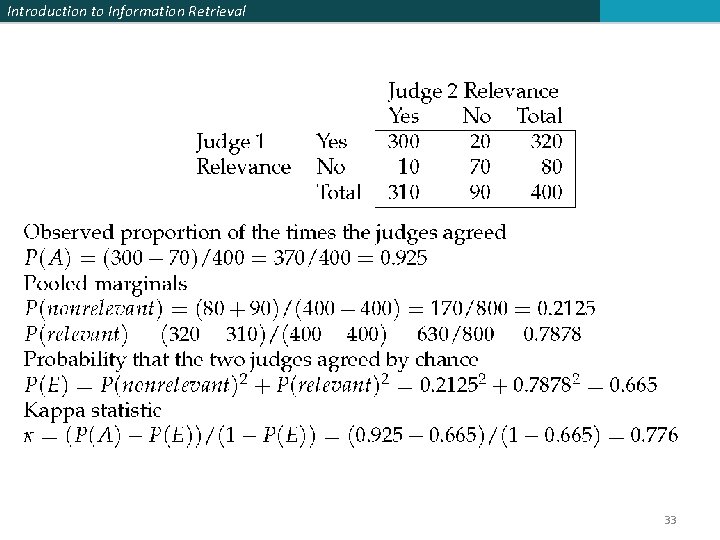

Introduction to Information Retrieval Sec. 8. 5 Exemplo Kappa § § § P(A) = 370/400 = 0. 925 P(não relevante) = (10+20+70+70)/800 = 0. 2125 P(relevante) = (10+20+300)/800 = 0. 7878 P(E) = 0. 2125^2 + 0. 7878^2 = 0. 665 Kappa = (0. 925 – 0. 665)/(1 -0. 665) = 0. 776 § Kappa > 0. 8 = bom acordo § 0. 67 < Kappa < 0. 8 -> “conclusões preliminares” (Carletta ’ 96) § Depende do propósito de estudo § Para >2 julgadores: média de pares kappas 32

Introduction to Information Retrieval 33

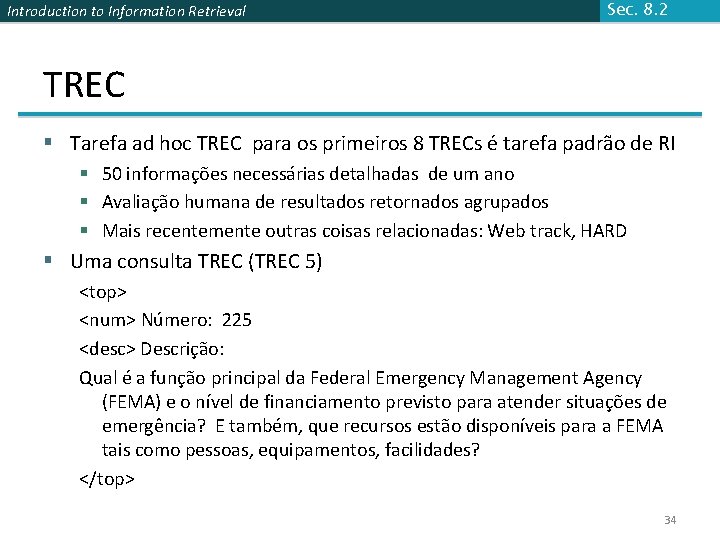

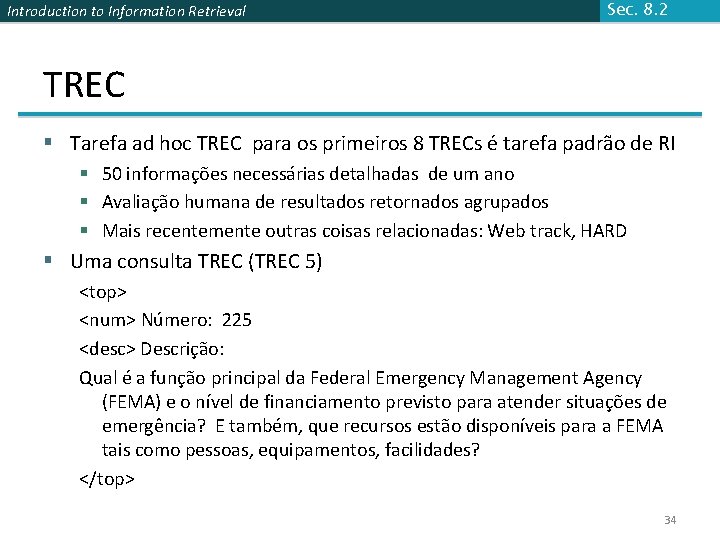

Introduction to Information Retrieval Sec. 8. 2 TREC § Tarefa ad hoc TREC para os primeiros 8 TRECs é tarefa padrão de RI § 50 informações necessárias detalhadas de um ano § Avaliação humana de resultados retornados agrupados § Mais recentemente outras coisas relacionadas: Web track, HARD § Uma consulta TREC (TREC 5) <top> <num> Número: 225 <desc> Descrição: Qual é a função principal da Federal Emergency Management Agency (FEMA) e o nível de financiamento previsto para atender situações de emergência? E também, que recursos estão disponíveis para a FEMA tais como pessoas, equipamentos, facilidades? </top> 34

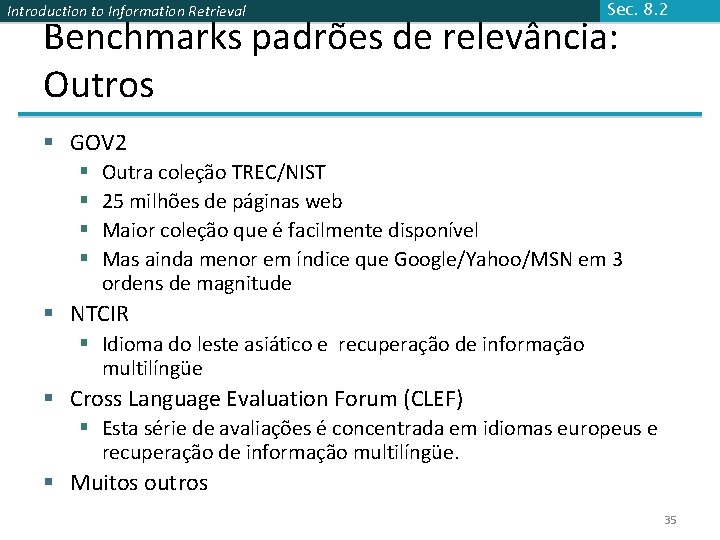

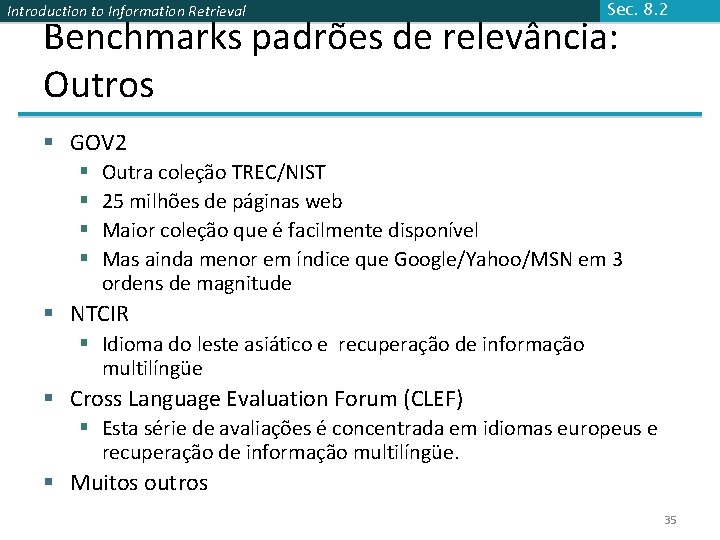

Introduction to Information Retrieval Sec. 8. 2 Benchmarks padrões de relevância: Outros § GOV 2 § § Outra coleção TREC/NIST 25 milhões de páginas web Maior coleção que é facilmente disponível Mas ainda menor em índice que Google/Yahoo/MSN em 3 ordens de magnitude § NTCIR § Idioma do leste asiático e recuperação de informação multilíngüe § Cross Language Evaluation Forum (CLEF) § Esta série de avaliações é concentrada em idiomas europeus e recuperação de informação multilíngüe. § Muitos outros 35

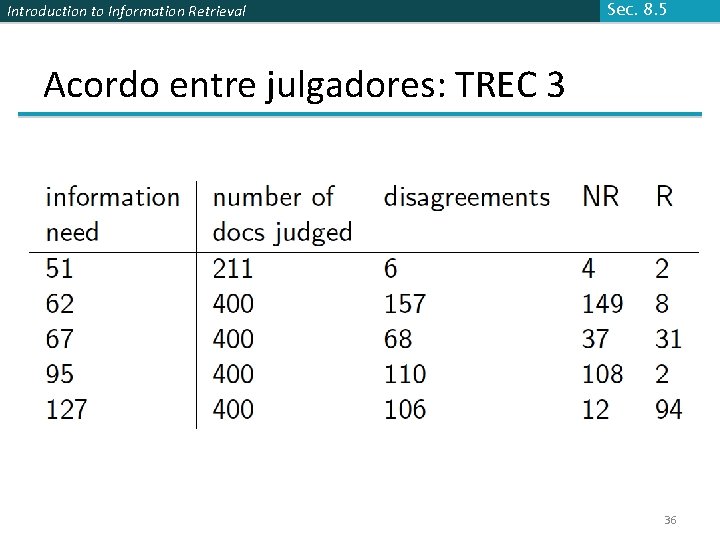

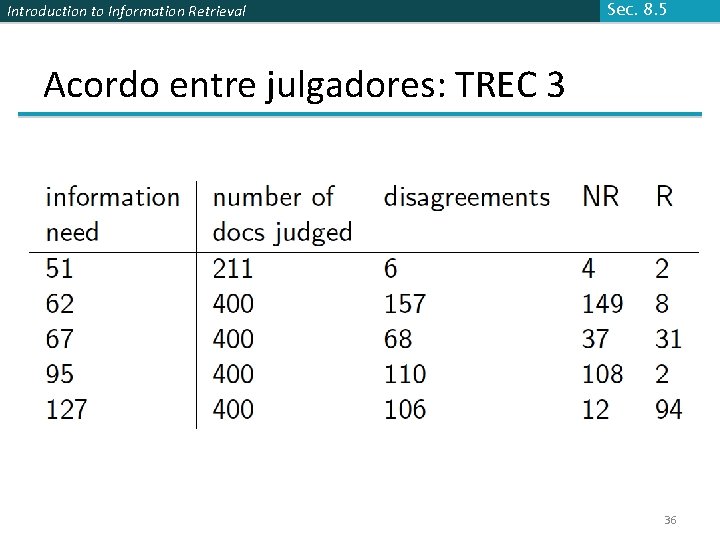

Introduction to Information Retrieval Sec. 8. 5 Acordo entre julgadores: TREC 3 36

Introduction to Information Retrieval Sec. 8. 5 Impacto do acordo entre julgadores § Impacto na medida de performance absoluta pode ser significativo (0. 32 vs 0. 39) § Pouco impacto no rankeamento de sistemas diferentes ou performance relativa § Suponha que nós queremos saber se um algoritmo A é melhor que o algoritmo B § Um experimento de recuperação de informação padrão nos dará uma resposta confiável para esta questão. 37

Introduction to Information Retrieval Sec. 8. 5. 1 Critica da relevância pura § Relevância vs Relevância marginal § Um documento pode ser redundante mesmo se for altamente relevante § Duplicatas § A mesma informação de diferentes fontes § Relevância marginal é uma melhor medida de utilidade para o usuário. § Usando fatos/entidades como unidades de avaliação mais diretamente mede a verdadeira relevância. § Mas, mais difícil para criar um conjunto de avaliação § Veja a referência Carbonell 38

Introduction to Information Retrieval Podemos evitar o julgamento humano? Sec. 8. 6. 3 § Não § Deixa o trabalho experimental difícil § Especialmente em larga escala § Em algumas configurações muito específicas, podemos usar proxies § Ex. : para recuperação aproximada de espaço vetorial, nós podemos comparar a proximidade de distância por cosseno dos documentos mais próximos daqueles encontrados por um algoritmo de recuperação aproximada § Mas, uma vez que testamos coleções, podemos reusá-las (contanto que nós não a super treinarmos muito mal) 39

Introduction to Information Retrieval Sec. 8. 6. 3 Avaliação em grandes mecanismos de busca § Mecanismos de busca possuem coleções de teste, de consultas e resultados rankeados à mão § Retorno é difícil para medir na web § Mecanismos de busca freqüentemente usam precisão dos top k, ex. , k = 10 §. . . Ou medidas que recompensam você mais por receber o rank 1 direito do que receber o rank 10 direito. § NDCG (Normalized Cumulative Discounted Gain) § Mecanismos de busca também usam medidas baseadas na não-relevância. § Cliques no primeiro resultado § Não muito confiável se você olhar em um simples clique … mas razoavelmente confiável no conjunto. § Estudos do comportamento do usuários em laboratório § Teste A/B 40

Introduction to Information Retrieval Sec. 8. 6. 3 Teste A/B § Propósito: Testa uma inovação única § Pré-requisito: Você tem um grande mecanismo de busca em funcionamento. § Possui a maioria dos usuários utilizando o sistema antigo § Desvia uma pequena parte do tráfego (ex. , 1%) para o novo sistema que inclui a inovação § Avalia com uma medida “automática” como cliques no primeiro resultado § Podemos agora verificar diretamente se a inovação melhora a felicidade do usuário. § Provavelmente a metodologia de avaliação que grandes mecanismos de busca confiam mais § A principio menos poderoso que fazer um análise de regressão multivariada, mas, mais fácil de entender 41

Introduction to Information Retrieval Sec. 8. 7 APRESENTAÇÃO DOS RESULTADOS 42

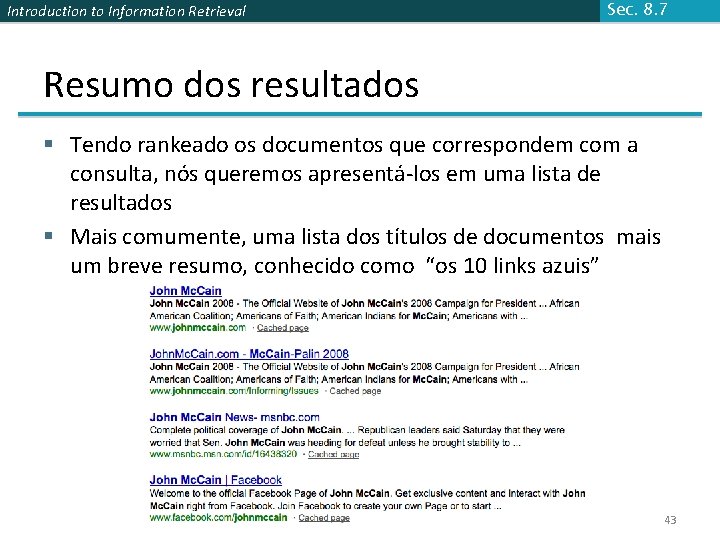

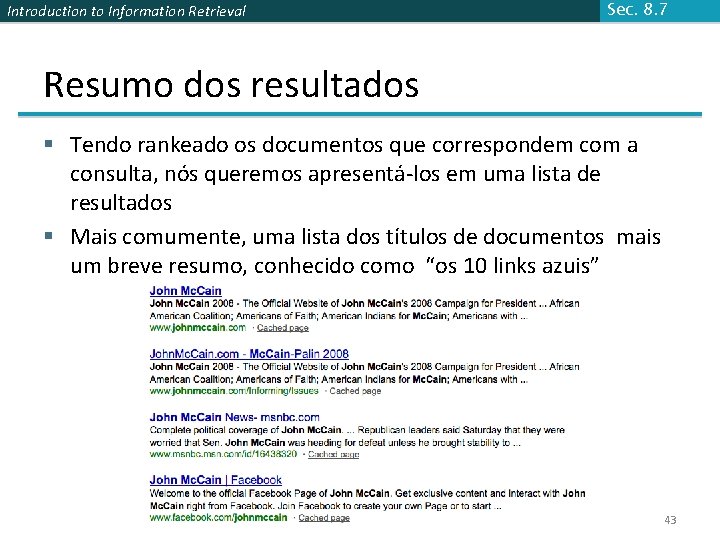

Introduction to Information Retrieval Sec. 8. 7 Resumo dos resultados § Tendo rankeado os documentos que correspondem com a consulta, nós queremos apresentá-los em uma lista de resultados § Mais comumente, uma lista dos títulos de documentos mais um breve resumo, conhecido como “os 10 links azuis” 43

Introduction to Information Retrieval Sec. 8. 7 Resumos § O título é freqüentemente extraído automaticamente do metadado do documento. E sobre os resumos? § A descrição é crucial. § Usuário pode identificar hits como bom/relevante baseando-se na descrição. § Dois tipos básicos: § Estático § Dinâmico § Um resumo estático de um documento é sempre o mesmo, independentemente da consulta que trouxe o documento § Um resumo dinâmico é uma tentativa dependente de consulta para explicar porque o documento foi recuperado para a consulta em questão 44

Introduction to Information Retrieval Sec. 8. 7 Resumos estáticos § Em sistemas típicos, o resumo estático é um subconjunto do documento § Heurística simples: as primeiras 50 (ou outro valor – pode ser variado) palavras do documento § Resumo é pegado na hora da indexação § Mais sofisticado: extrair de cada documento um conjunto de sentenças “chave” § Heurística NLP simples para pontuar cada sentença § Resumo é composto de frases com maior pontuação. § O mais sofisticado: NLP usado para sintetizar um resumo § Raramente usado em RI; cf. sumarização de texto funciona (cf. summarization work) 45

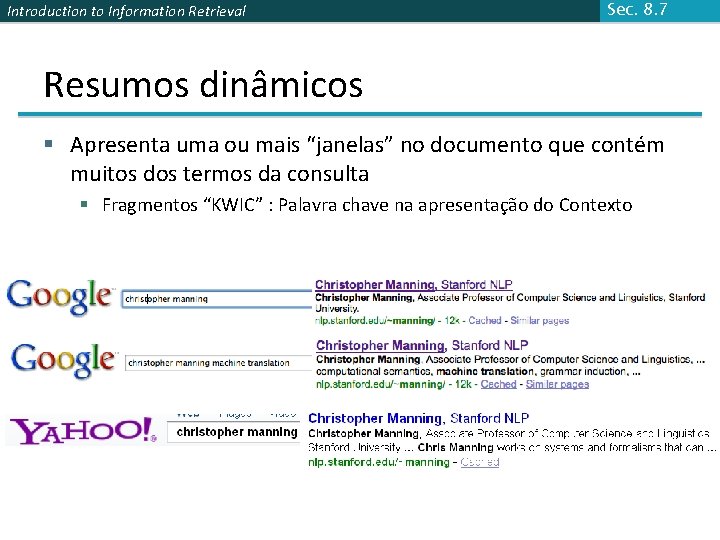

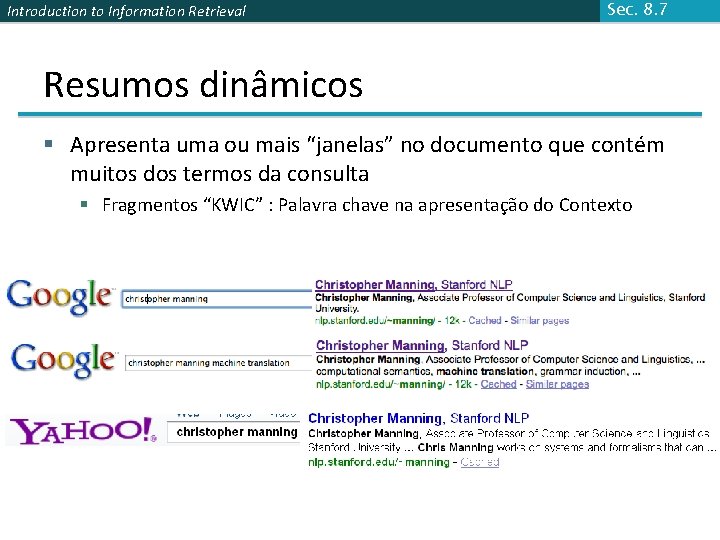

Introduction to Information Retrieval Sec. 8. 7 Resumos dinâmicos § Apresenta uma ou mais “janelas” no documento que contém muitos dos termos da consulta § Fragmentos “KWIC” : Palavra chave na apresentação do Contexto 46

Introduction to Information Retrieval Sec. 8. 7 Técnicas para resumos dinâmicos § Encontre pequenas janelas no documento que contém os termos da consulta § Requer procura rápida de janela no cache do documento § Pontua cada janela da consulta (Score each window wrt query) § Usa várias características como tamanho de janela, posição no documento, etc. § Combina recursos através de uma função de pontuação § Desafios na avaliação: julgar resumos § Mais fácil fazer comparações de pareamento (pairwise) do que avaliações de relevância binárias 47

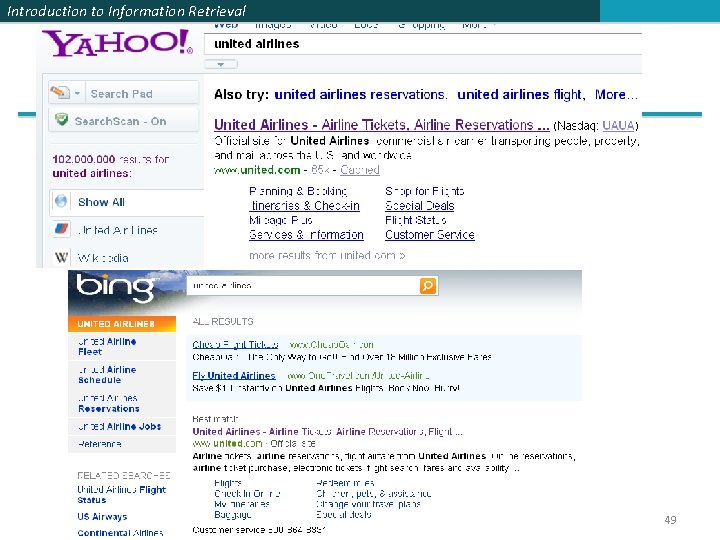

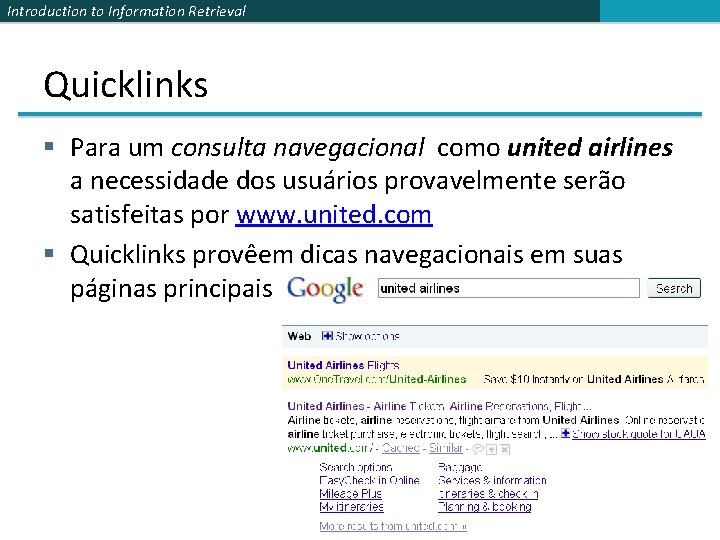

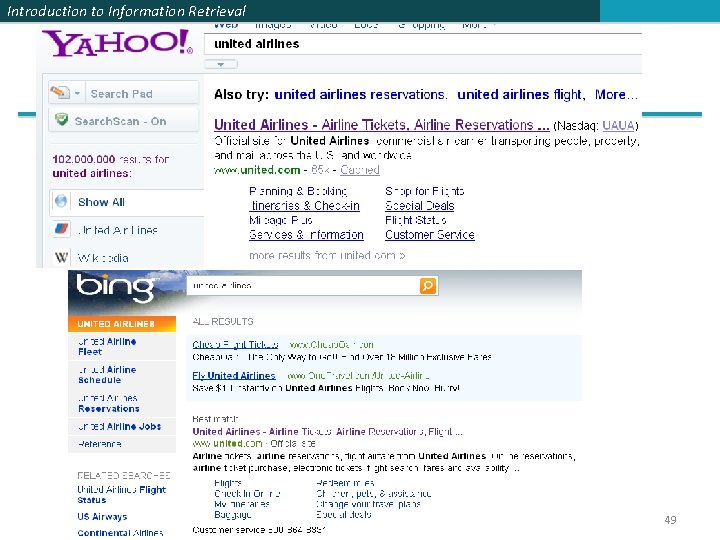

Introduction to Information Retrieval Quicklinks § Para um consulta navegacional como united airlines a necessidade dos usuários provavelmente serão satisfeitas por www. united. com § Quicklinks provêem dicas navegacionais em suas páginas principais 48

Introduction to Information Retrieval 49

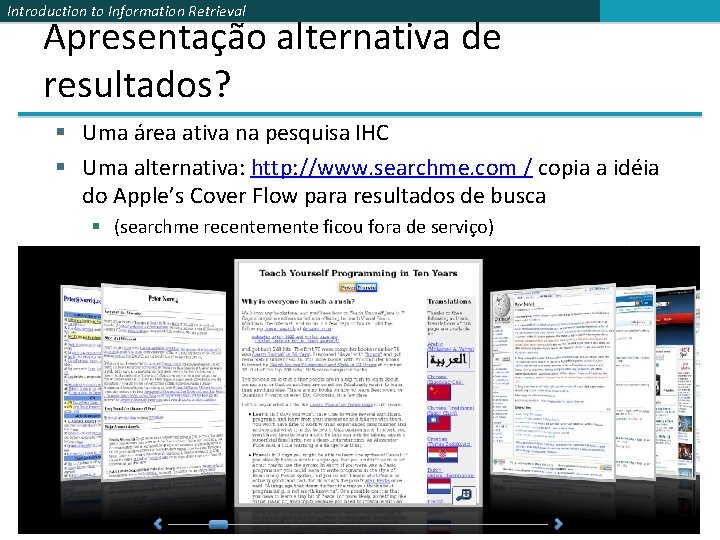

Introduction to Information Retrieval Apresentação alternativa de resultados? § Uma área ativa na pesquisa IHC § Uma alternativa: http: //www. searchme. com / copia a idéia do Apple’s Cover Flow para resultados de busca § (searchme recentemente ficou fora de serviço) 50

Introduction to Information Retrieval Resources for this lecture § § IIR 8 MIR Chapter 3 MG 4. 5 Carbonell and Goldstein 1998. The use of MMR, diversity-based reranking for reordering documents and producing summaries. SIGIR 21. 51