HPC platform efficiency and challenges for a system

- Slides: 22

HPC platform efficiency and challenges for a system builder Martin Hilgeman Technical Director, HPC martin. hilgeman@dell. com

The landscape is changing “We are no longer in the general purpose era… the argument of tuning software for hardware is moot. Now, to get the best bang for the buck, you have to tune both. ” - Kushagra Vaid, general manager of server engineering, Microsoft Cloud Solutions https: //www. nextplatform. com/2017/03/08/arm-amd-x 86 -server-chips-get-mainstream-lift-microsoft/amp/ 2 HPC Saudi 2018

4 nodes in 2 U – the HPC standard 3 HPC Saudi 2018

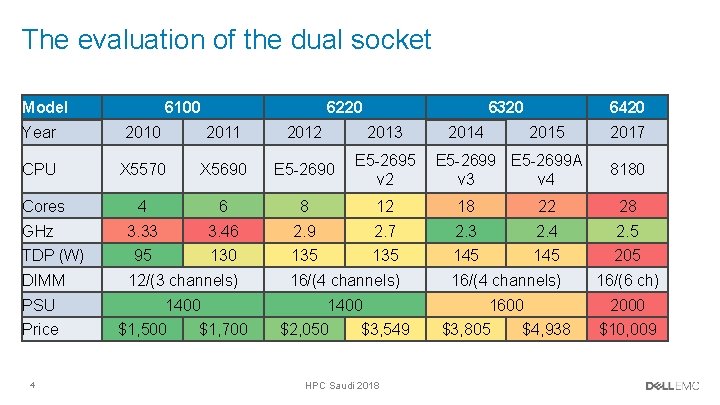

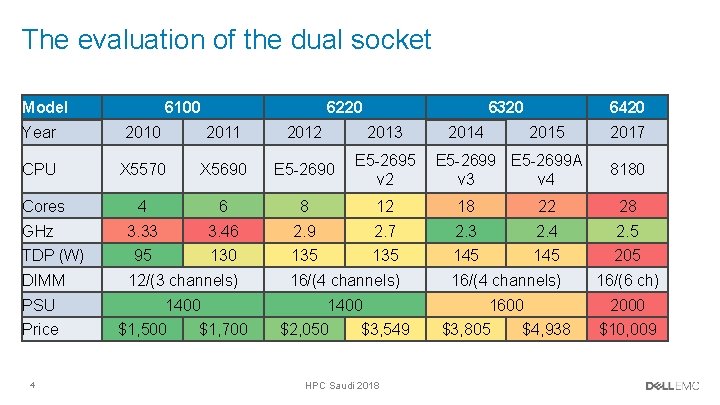

The evaluation of the dual socket Model 6100 6220 6320 Year 2010 2011 2012 2013 CPU X 5570 X 5690 E 5 -2695 v 2 Cores 4 6 8 12 18 22 28 3. 33 3. 46 2. 9 2. 7 2. 3 2. 4 2. 5 95 130 135 145 205 GHz TDP (W) DIMM PSU Price 4 2014 6420 2015 E 5 -2699 A v 3 v 4 2017 8180 12/(3 channels) 16/(4 channels) 16/(6 ch) 1400 1600 2000 $1, 500 $1, 700 $2, 050 $3, 549 HPC Saudi 2018 $3, 805 $4, 938 $10, 009

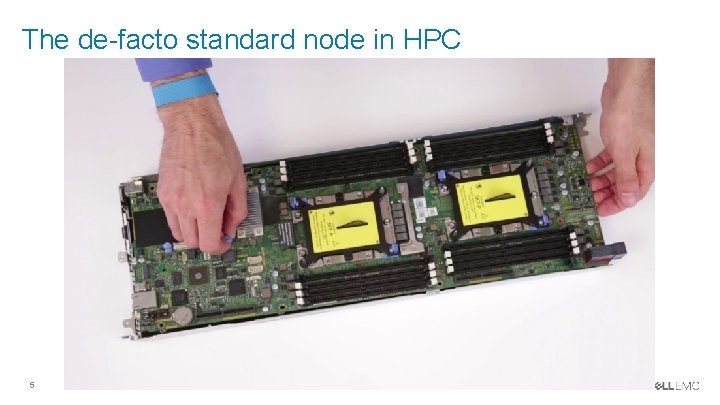

The de-facto standard node in HPC 5 HPC Saudi 2018

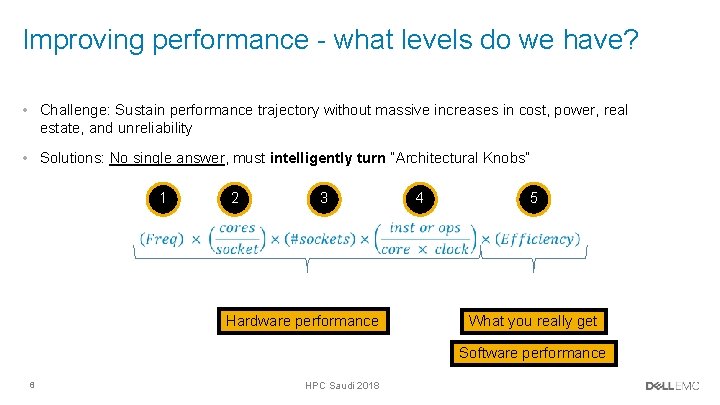

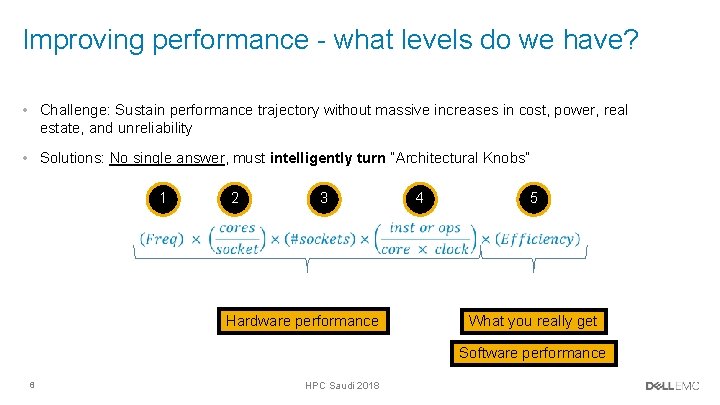

Improving performance - what levels do we have? • Challenge: Sustain performance trajectory without massive increases in cost, power, real estate, and unreliability • Solutions: No single answer, must intelligently turn “Architectural Knobs” 1 2 3 Hardware performance 4 5 What you really get Software performance 6 HPC Saudi 2018

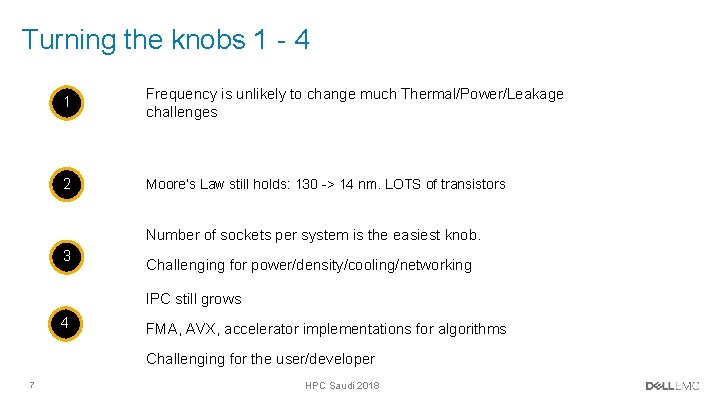

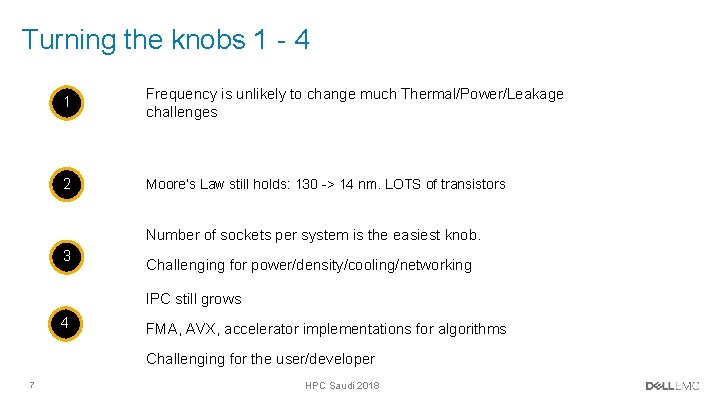

Turning the knobs 1 - 4 1 Frequency is unlikely to change much Thermal/Power/Leakage challenges 2 Moore’s Law still holds: 130 -> 14 nm. LOTS of transistors Number of sockets per system is the easiest knob. 3 Challenging for power/density/cooling/networking IPC still grows 4 FMA, AVX, accelerator implementations for algorithms Challenging for the user/developer 7 HPC Saudi 2018

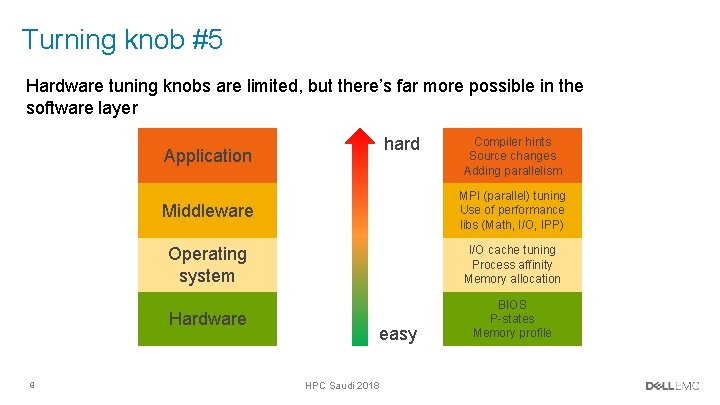

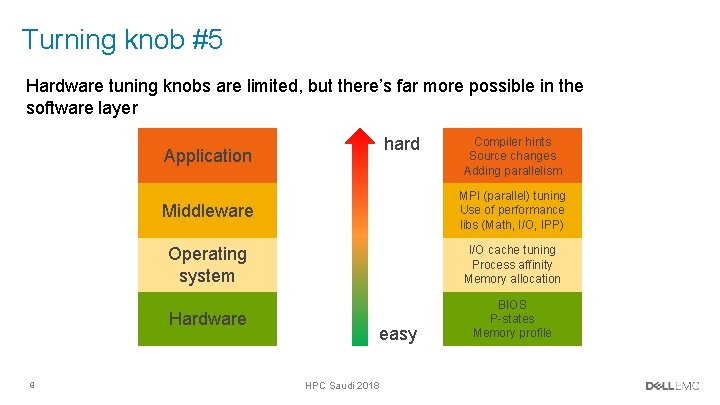

Turning knob #5 Hardware tuning knobs are limited, but there’s far more possible in the software layer hard Application 8 Compiler hints Source changes Adding parallelism Middleware MPI (parallel) tuning Use of performance libs (Math, I/O, IPP) Operating system I/O cache tuning Process affinity Memory allocation Hardware BIOS P-states Memory profile easy HPC Saudi 2018

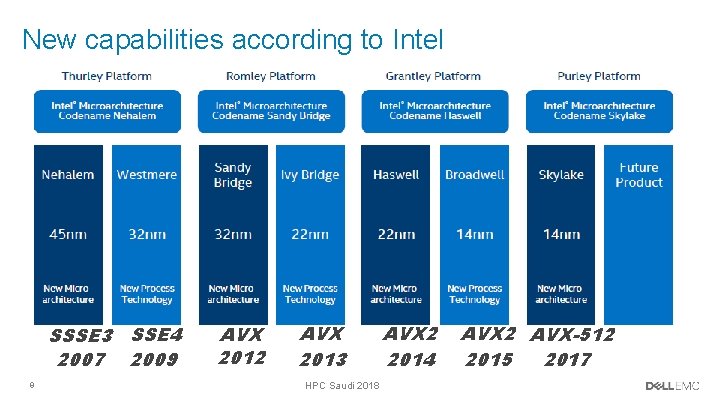

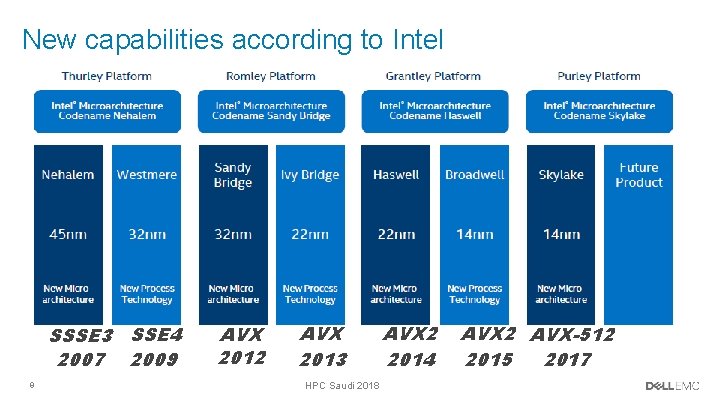

New capabilities according to Intel SSSE 3 SSE 4 2007 2009 9 AVX 2012 AVX 2013 HPC Saudi 2018 AVX 2 2014 AVX 2 AVX-512 2017 2015

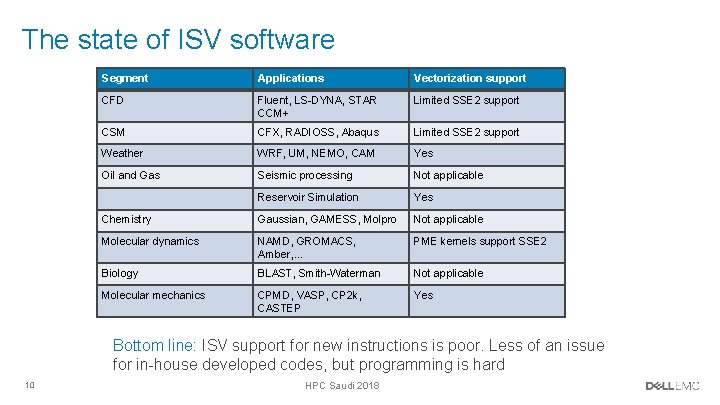

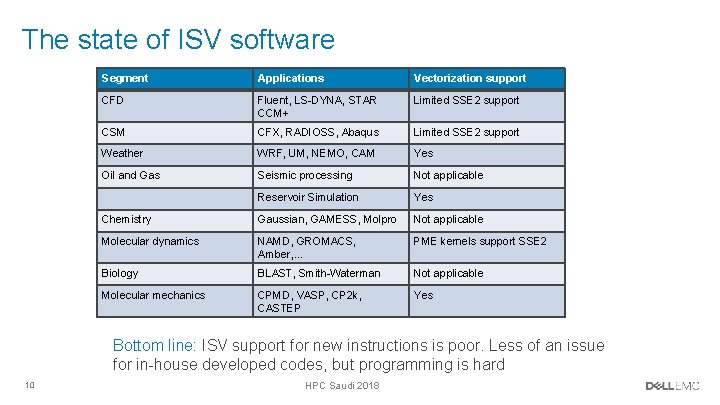

The state of ISV software Segment Applications Vectorization support CFD Fluent, LS-DYNA, STAR CCM+ Limited SSE 2 support CSM CFX, RADIOSS, Abaqus Limited SSE 2 support Weather WRF, UM, NEMO, CAM Yes Oil and Gas Seismic processing Not applicable Reservoir Simulation Yes Chemistry Gaussian, GAMESS, Molpro Not applicable Molecular dynamics NAMD, GROMACS, Amber, … PME kernels support SSE 2 Biology BLAST, Smith-Waterman Not applicable Molecular mechanics CPMD, VASP, CP 2 k, CASTEP Yes Bottom line: ISV support for new instructions is poor. Less of an issue for in-house developed codes, but programming is hard 10 HPC Saudi 2018

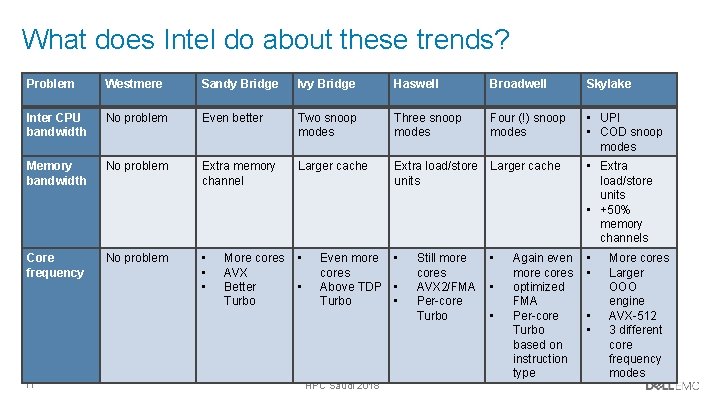

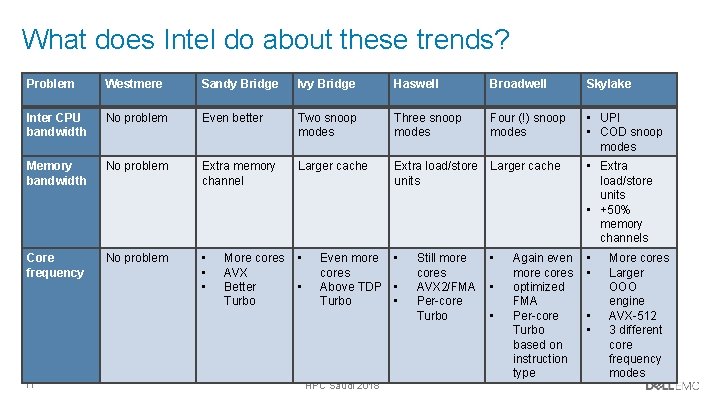

What does Intel do about these trends? Problem Westmere Sandy Bridge Ivy Bridge Haswell Broadwell Skylake Inter CPU bandwidth No problem Even better Two snoop modes Three snoop modes Four (!) snoop modes • UPI • COD snoop modes Memory bandwidth No problem Extra memory channel Larger cache Extra load/store units Larger cache • Extra load/store units • +50% memory channels Core frequency No problem • • 11 More cores AVX Better Turbo • Even more cores Above TDP Turbo HPC Saudi 2018 • • Still more cores AVX 2/FMA Per-core Turbo • • Again even more cores optimized FMA Per-core Turbo based on instruction type • • More cores Larger OOO engine AVX-512 3 different core frequency modes

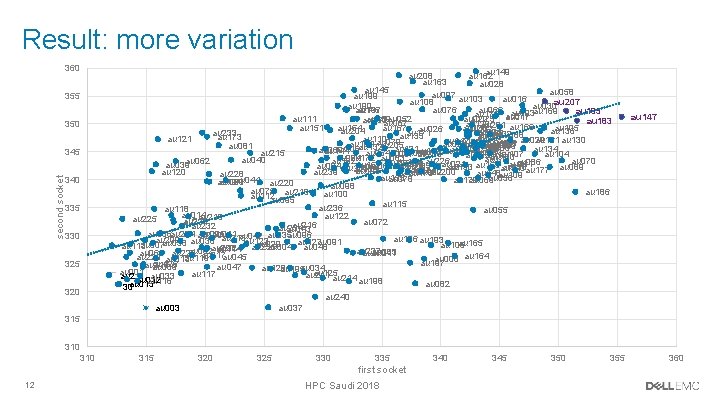

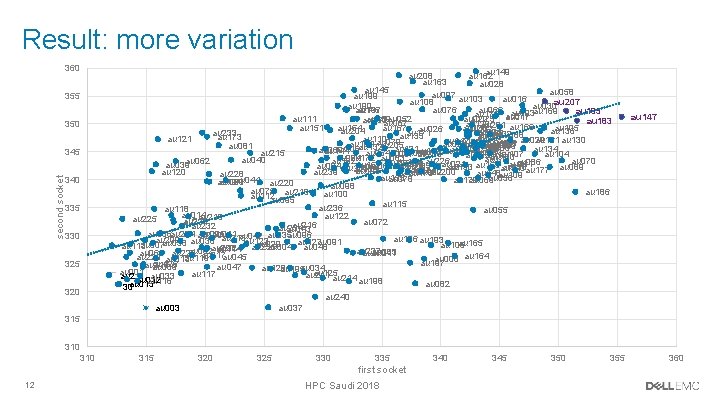

Result: more variation 360 au 208 au 163 au 145 au 058 au 097 au 103 au 199 au 016 au 207 au 108 au 190 au 066 au 023 au 030 au 146 au 076 au 137 au 169 au 185 au 176 au 077 au 017 au 111 au 022 au 052 au 175 au 159 au 160 au 183 au 067 au 129 au 201 au 166 au 020 au 167 au 026 au 105 au 151 au 154 au 102 au 204 au 136 au 031 au 233 au 080 au 171 au 032 au 188 au 182 au 025 au 135 au 143 au 173 au 110 au 121 au 161 au 130 au 142 au 079 au 189 au 019 au 068 au 156 au 184 au 027 au 029 au 024 au 018 au 205 au 081 au 139 au 049 au 132 au 088 au 053 au 134 au 131 au 206 au 168 au 059 au 191 au 144 au 141 au 152 au 187 au 090 au 064 au 101 au 215 au 087 au 203 au 107 au 104 au 057 au 181 au 202 au 180 au 172 au 063 au 084 au 073 au 040 au 192 au 070 au 226 au 062 au 086 au 174 au 054 au 061 au 238 au 021 au 039 au 157 au 153 au 094 au 150 au 060 au 051 au 085 au 046 au 071 au 133 au 050 au 089 au 140 au 138 au 074 au 177 au 093 au 120 au 158 au 200 au 239 au 092 au 148 au 109 au 178 au 228 au 155 au 056 au 078 au 179 au 069 au 044 au 220 au 194 au 099 au 098 au 075 au 218 au 186 au 100 au 112 au 095 au 115 au 236 au 118 au 055 au 014 au 122 au 219 au 225 au 212 au 072 au 231 au 216 au 232 au 234 au 043 au 006 au 224 au 010 au 011 au 005 au 096 au 042 au 035 au 213 au 196 au 193 au 209 au 123 au 091 au 127 au 165 au 229 au 007 au 038 au 036 au 227 au 106 au 113 au 004 au 048 au 124 au 235 au 114 au 002 au 237 au 083 au 041 au 065 au 170 au 222 au 217 au 221 au 013 au 119 au 045 au 008 au 164 au 197 au 126 au 210 au 047 au 009 au 128 au 034 au 195 au 125 au 001 au 117 au 211 au 214 au 033 au 2 au 012 au 116 au 198 au 082 au 015 30 au 240 au 037 au 003 355 350 345 second socket au 149 au 162 au 028 340 335 330 325 320 au 147 315 310 315 320 325 330 335 first socket 12 HPC Saudi 2018 340 345 350 355 360

A case study on power

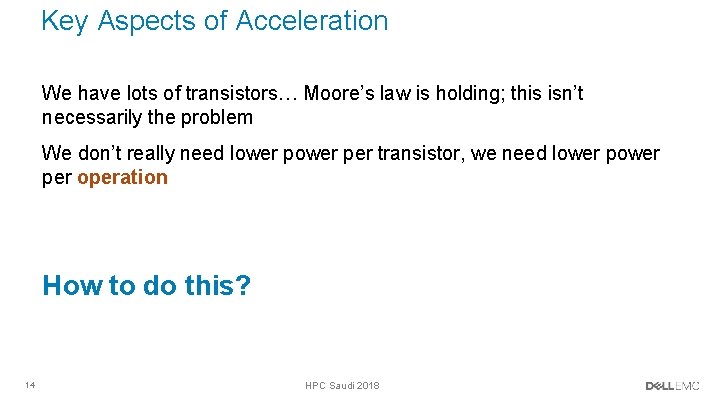

Key Aspects of Acceleration We have lots of transistors… Moore’s law is holding; this isn’t necessarily the problem We don’t really need lower per transistor, we need lower per operation How to do this? 14 HPC Saudi 2018

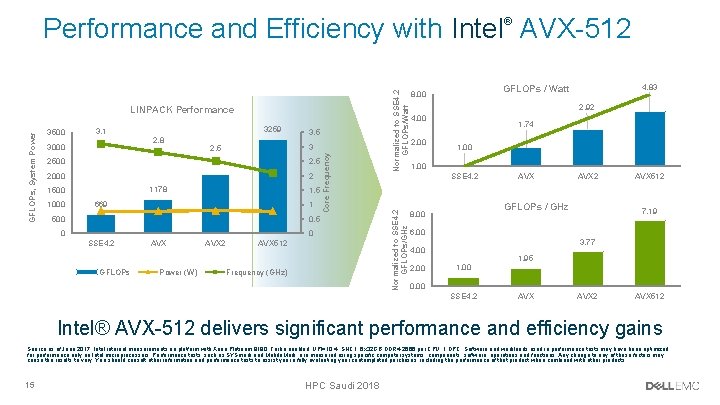

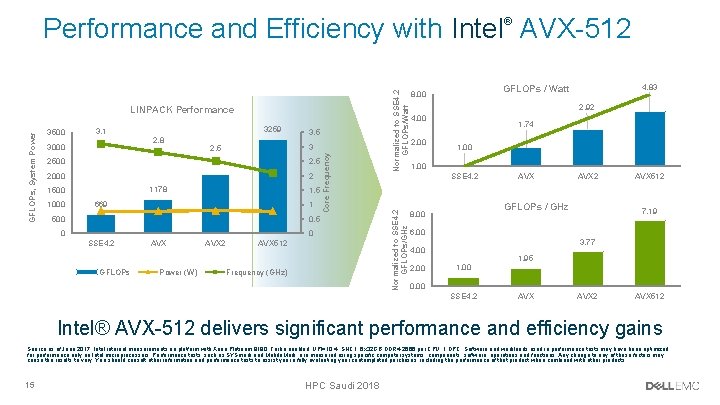

Performance and Efficiency with Intel AVX-512 3, 1 3000 3259 2, 8 2, 1 2000 1178 1500 1000 500 3 2, 5 2500 3, 5 2 2034 1, 5 669 1 760 768 791 767 SSE 4. 2 AVX 512 0 0, 5 0 GFLOPs Power (W) Frequency (GHz) 4, 83 GFLOPs / Watt 8, 00 2, 92 4, 00 2, 00 1, 74 1, 00 SSE 4. 2 Normalized to SSE 4. 2 GFLOPs/GHz 3500 Core Frequency GFLOPs, System Power LINPACK Performance Normalized to SSE 4. 2 GFLOPs/Watt ® AVX 2 GFLOPs / GHz 8, 00 AVX 512 7, 19 6, 00 3, 77 4, 00 2, 00 1, 95 0, 00 SSE 4. 2 AVX 512 Intel® AVX-512 delivers significant performance and efficiency gains Source as of June 2017: Intel internal measurements on platform with Xeon Platinum 8180, Turbo enabled, UPI=10. 4, SNC 1, 6 x 32 GB DDR 4 -2666 per CPU, 1 DPC. Software and workloads used in performance tests may have been optimized for performance only on Intel microprocessors. Performance tests, such as SYSmark and Mobile. Mark, are measured using specific computer systems, components, software, operations and functions. Any change to any of those factors may cause the results to vary. You should consult other information and performance tests to assist you in fully evaluating your contemplated purchases, including the performance of that product when combined with other products. 15 HPC Saudi 2018

Powerful instructions to save power For LINPACK, powerful instructions can bring significant performance gains. What about real applications? NAS parallel benchmarks, which are “mini applications” containing kernels for major HPC workload types 16 HPC Saudi 2018

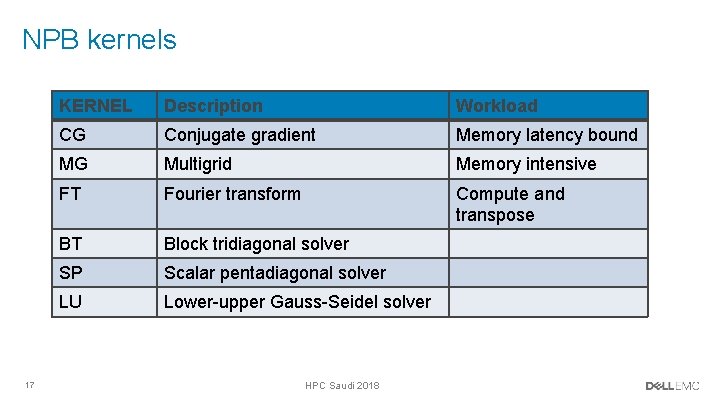

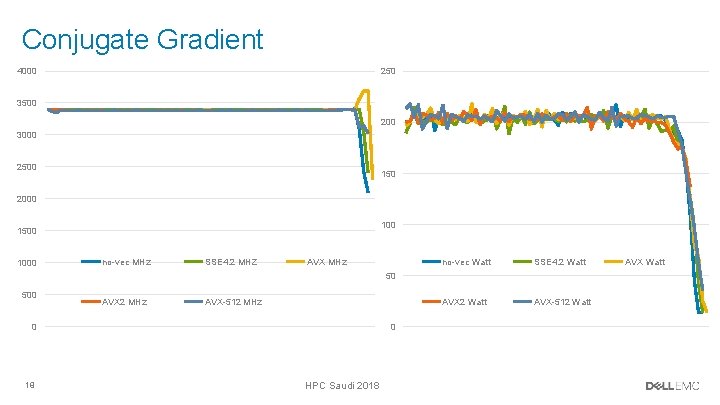

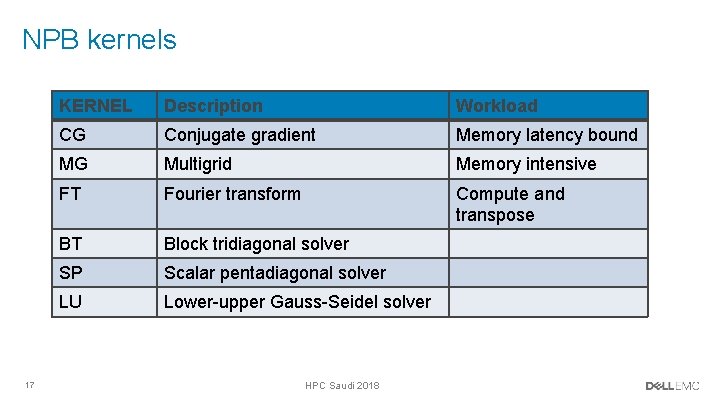

NPB kernels 17 KERNEL Description Workload CG Conjugate gradient Memory latency bound MG Multigrid Memory intensive FT Fourier transform Compute and transpose BT Block tridiagonal solver SP Scalar pentadiagonal solver LU Lower-upper Gauss-Seidel solver HPC Saudi 2018

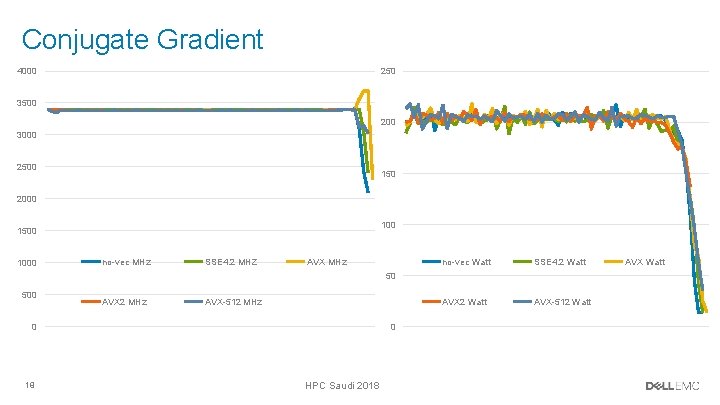

Conjugate Gradient 4000 250 3500 200 3000 2500 150 2000 1500 1000 no-vec MHz SSE 4. 2 MHZ AVX MHz no-vec Watt SSE 4. 2 Watt AVX-512 Watt 50 500 AVX 2 MHz AVX-512 MHz 0 18 0 HPC Saudi 2018 AVX Watt

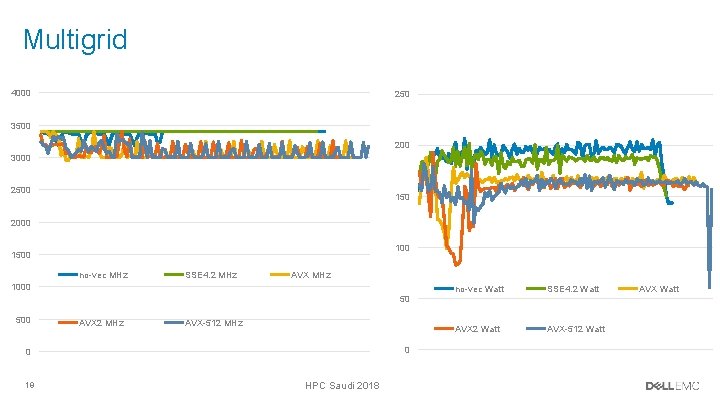

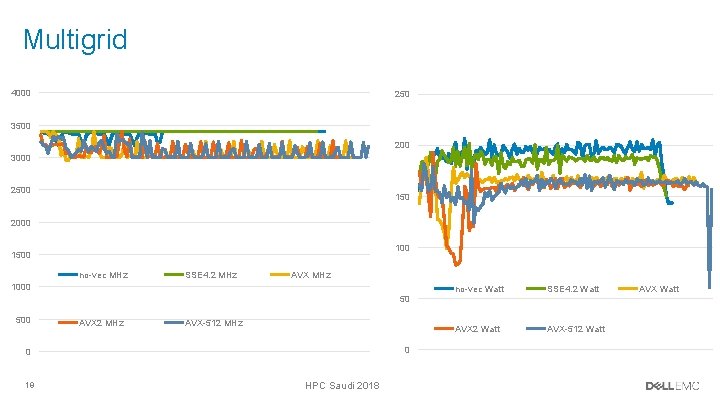

Multigrid 4000 250 3500 200 3000 2500 150 2000 1500 no-vec MHz SSE 4. 2 MHz AVX MHz 1000 50 500 AVX 2 MHz AVX-512 MHz 0 0 19 HPC Saudi 2018 no-vec Watt SSE 4. 2 Watt AVX-512 Watt AVX Watt

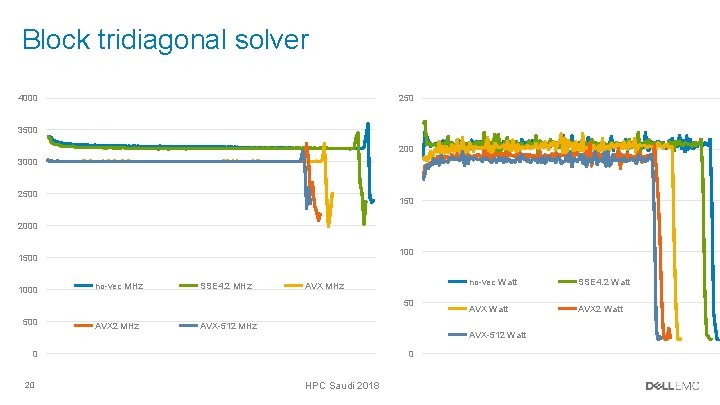

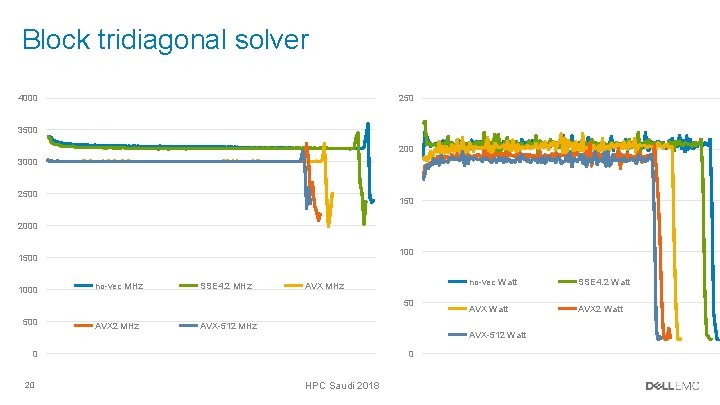

Block tridiagonal solver 4000 250 3500 200 3000 2500 150 2000 1500 1000 no-vec MHz SSE 4. 2 MHz AVX MHz 50 500 AVX 2 MHz AVX-512 MHz SSE 4. 2 Watt AVX-512 Watt 0 20 no-vec Watt 0 HPC Saudi 2018

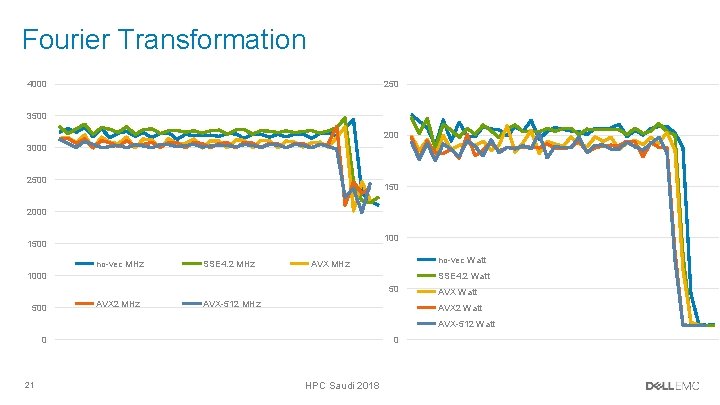

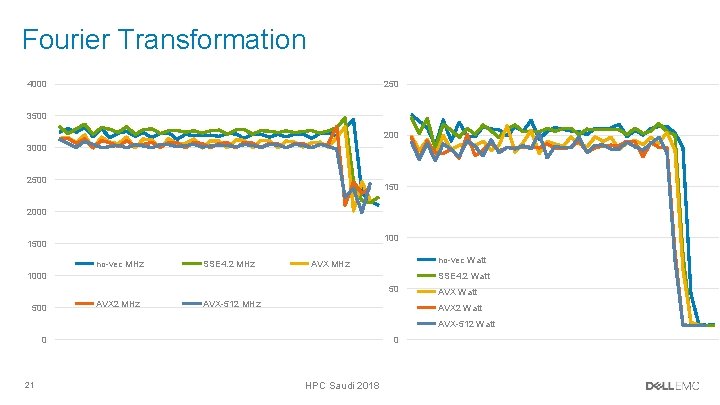

Fourier Transformation 4000 250 3500 200 3000 2500 150 2000 1500 no-vec MHz SSE 4. 2 MHz no-vec Watt AVX MHz SSE 4. 2 Watt 1000 50 500 AVX 2 MHz AVX-512 MHz AVX Watt AVX 2 Watt AVX-512 Watt 0 0 21 HPC Saudi 2018