Econometria Propriedades assintticas dos estimadores MQO Propriedades assintticas

![Convergência em média quadrática E[b|X]=β para qualquer X. Var[b|X] 0 para um X específico Convergência em média quadrática E[b|X]=β para qualquer X. Var[b|X] 0 para um X específico](https://slidetodoc.com/presentation_image_h/29300f29fc9fd2ba274000c8d88b5281/image-27.jpg)

- Slides: 44

Econometria Propriedades assintóticas dos estimadores MQO

Propriedades assintóticas O número de resultados estatísticos exatos, tais como o valor esperado ou a distribuição verdadeira, em muitos modelos é baixo. Usualmente, utilizamos resultados aproximados com base no que se sabe do comportamento de determinadas estatísticas de grandes amostras.

Convergência Definições, tipos de convergência quando n cresce: 1. Para uma constante; exemplo, a média amostral, 2. Para uma variável aleatória; exemplo, uma estatística t com n -1 graus de liberdade.

Convergência para uma constante Convergência de uma variável aleatória O que significa uma variável aleatória convergir para uma constante? Convergência da variância para zero. A variável aleatória converge para algo que não é aleatório.

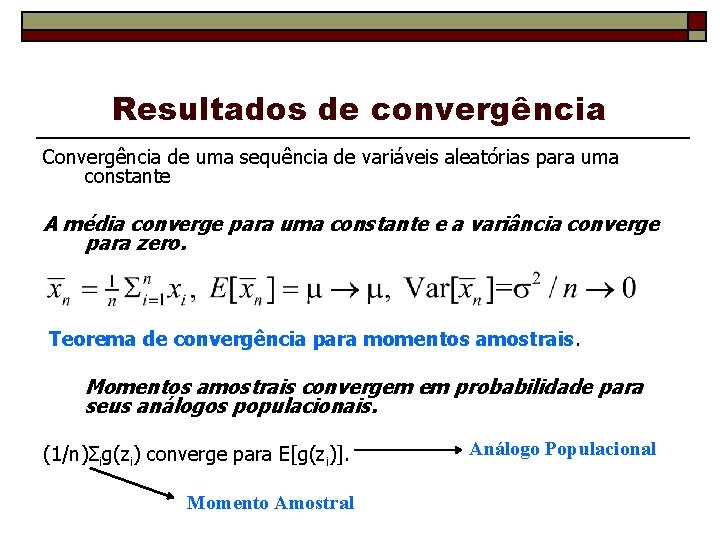

Resultados de convergência Convergência de uma sequência de variáveis aleatórias para uma constante A média converge para uma constante e a variância converge para zero. Teorema de convergência para momentos amostrais. Momentos amostrais convergem em probabilidade para seus análogos populacionais. (1/n)Σig(zi) converge para E[g(zi)]. Momento Amostral Análogo Populacional

Convergência em probabilidade A probabilidade que a diferença entre xn e c seja maior do que ε para qualquer ε vai para zero. Ou seja, xn fica perto de c.

Convergência em probabilidade significa que os valores das variáveis que não estão próximos de c ficam cada vez mais improváveis à medida que o n cresce. Exemplo: Suponha uma variável aleatória xn que assume dois valores, zero e n, com probabilidades (1 -1/n) e (1/n), respectivamente. Quando n aumenta , o segundo valor é menos provável. Xn converge em probabilidade para zero. Toda a massa da distribuição de probabilidade fica concentrada em pontos próximos de c.

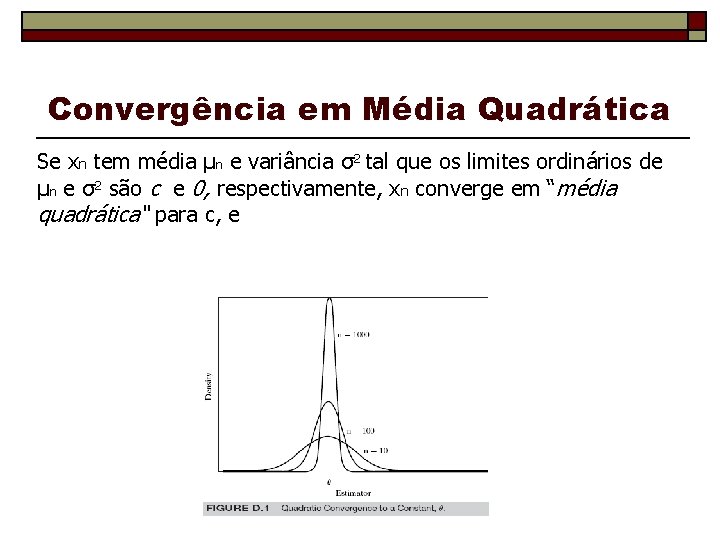

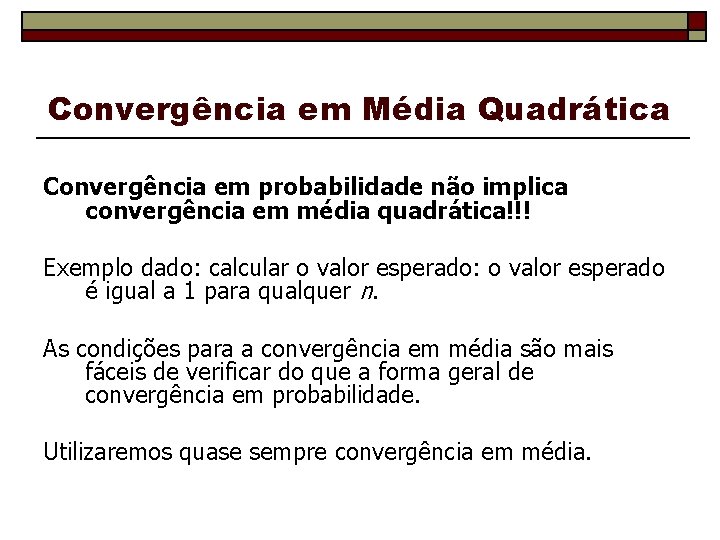

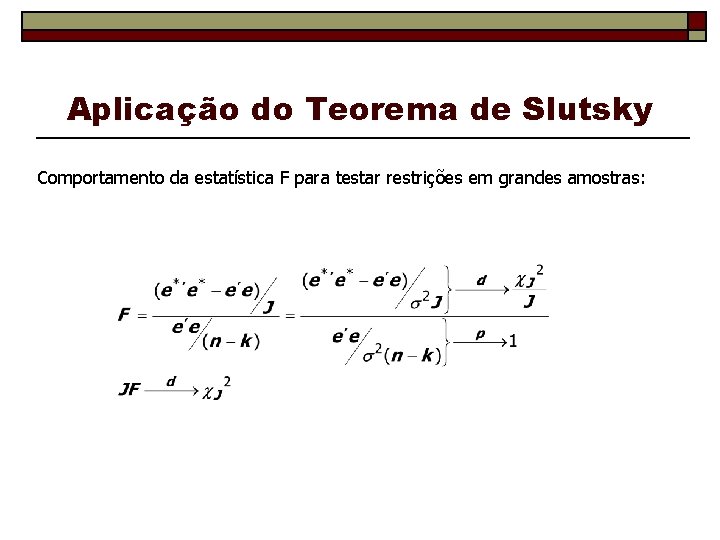

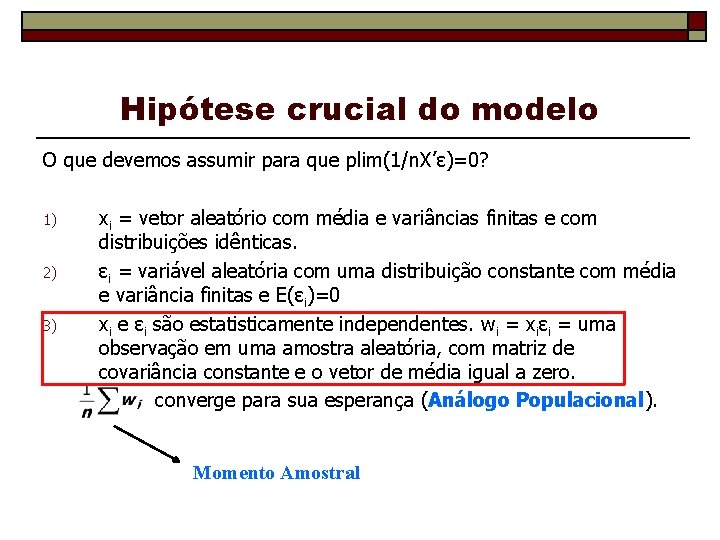

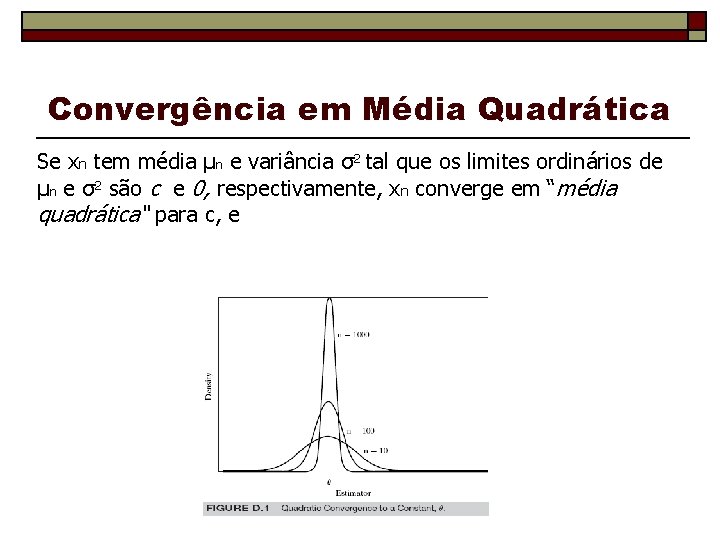

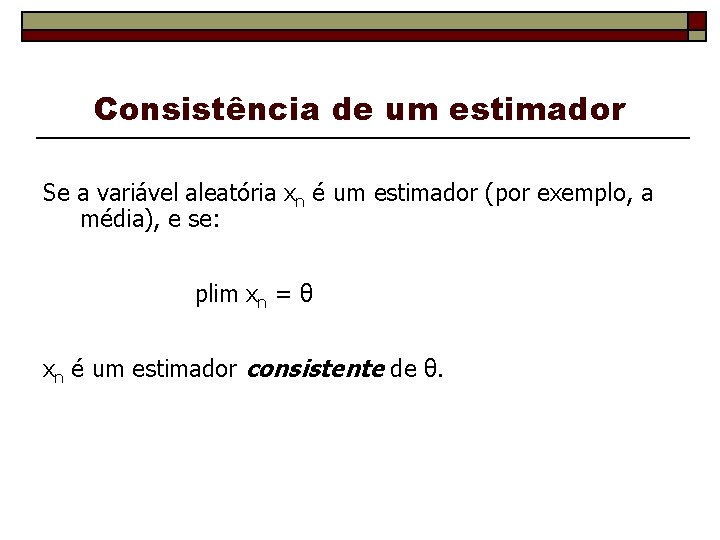

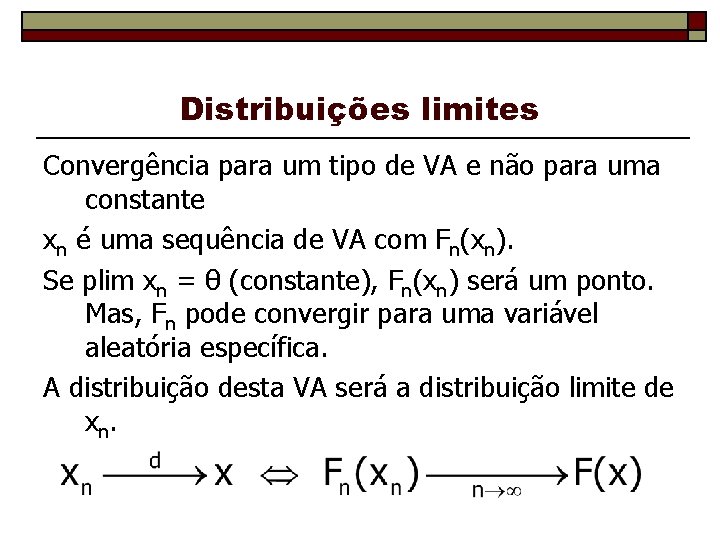

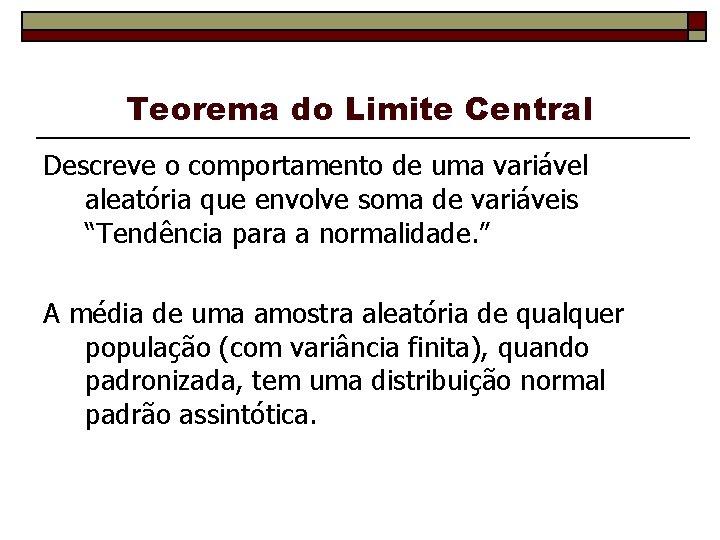

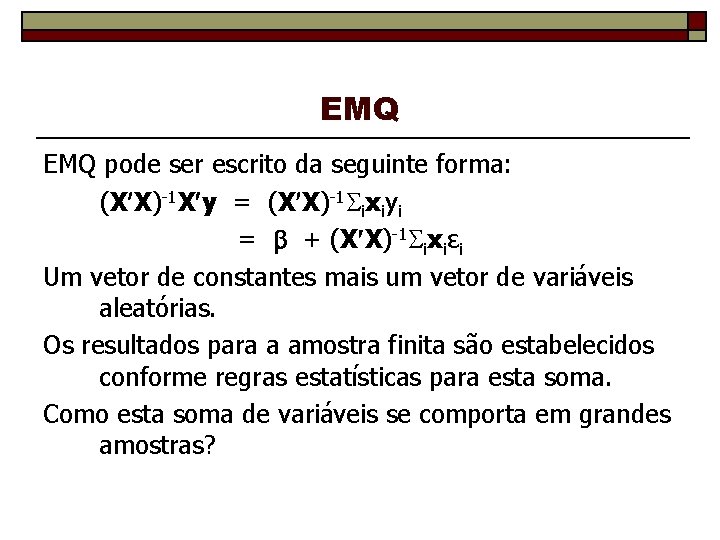

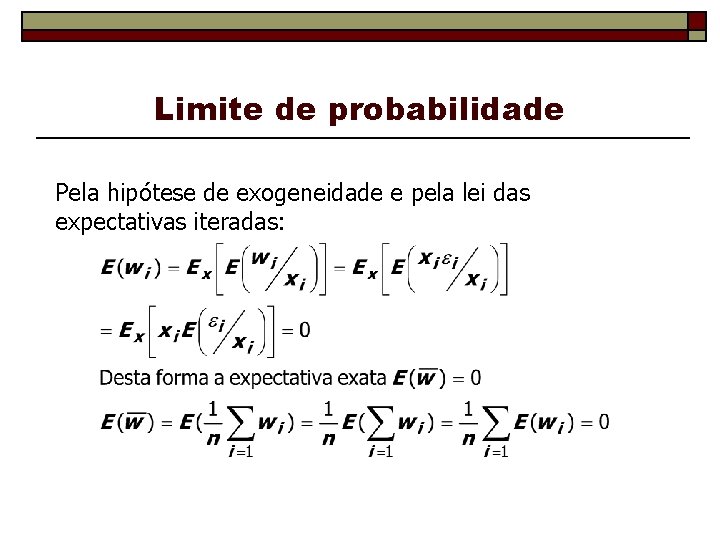

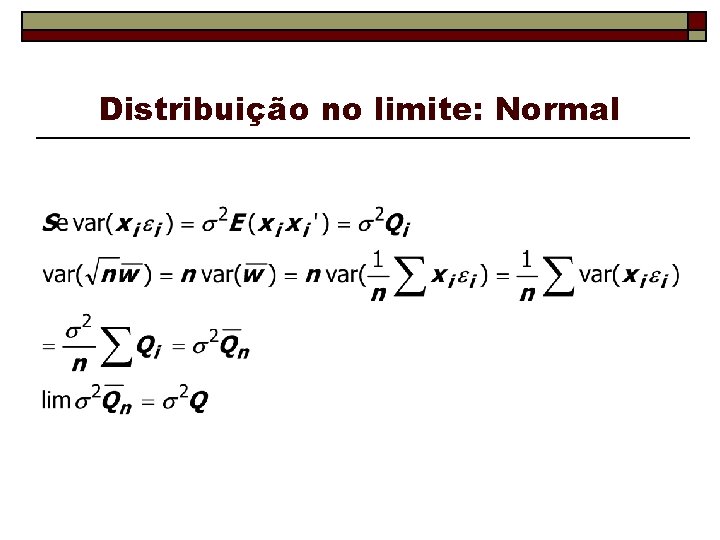

Convergência em Média Quadrática Se xn tem média μn e variância σ2 tal que os limites ordinários de μn e σ2 são c e 0, respectivamente, xn converge em “média quadrática“ para c, e

Convergência em Média Quadrática Convergência em probabilidade não implica convergência em média quadrática!!! Exemplo dado: calcular o valor esperado: o valor esperado é igual a 1 para qualquer n. As condições para a convergência em média são mais fáceis de verificar do que a forma geral de convergência em probabilidade. Utilizaremos quase sempre convergência em média.

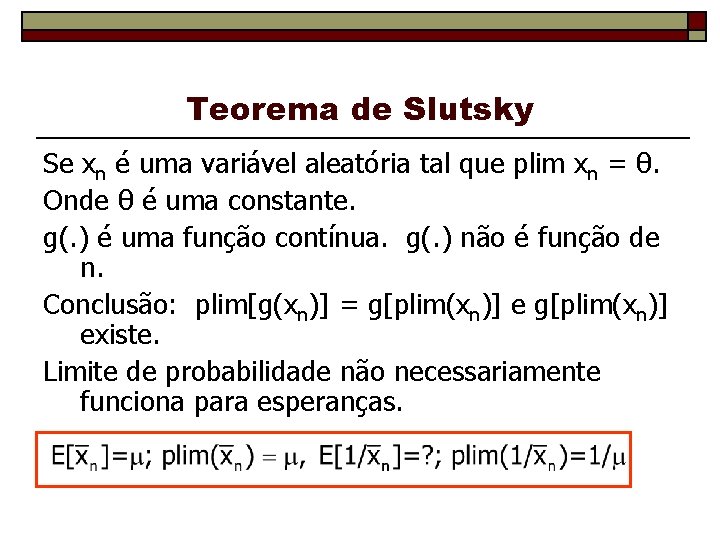

Consistência de um estimador Se a variável aleatória xn é um estimador (por exemplo, a média), e se: plim xn = θ xn é um estimador consistente de θ.

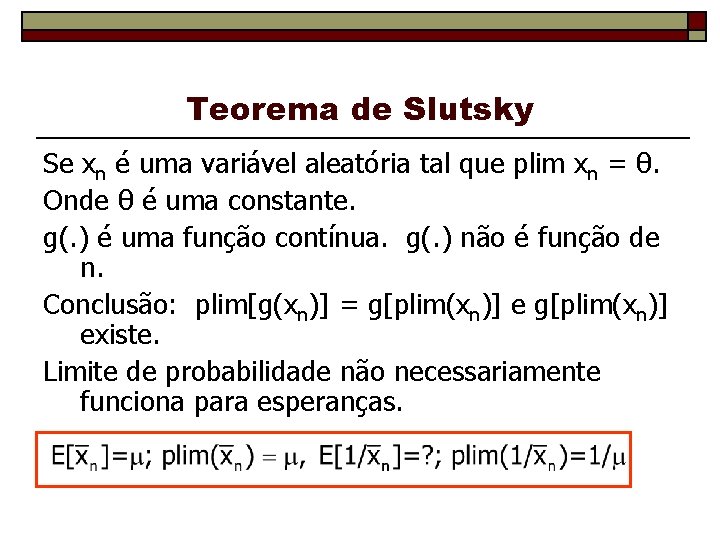

Teorema de Slutsky Se xn é uma variável aleatória tal que plim xn = θ. Onde θ é uma constante. g(. ) é uma função contínua. g(. ) não é função de n. Conclusão: plim[g(xn)] = g[plim(xn)] existe. Limite de probabilidade não necessariamente funciona para esperanças.

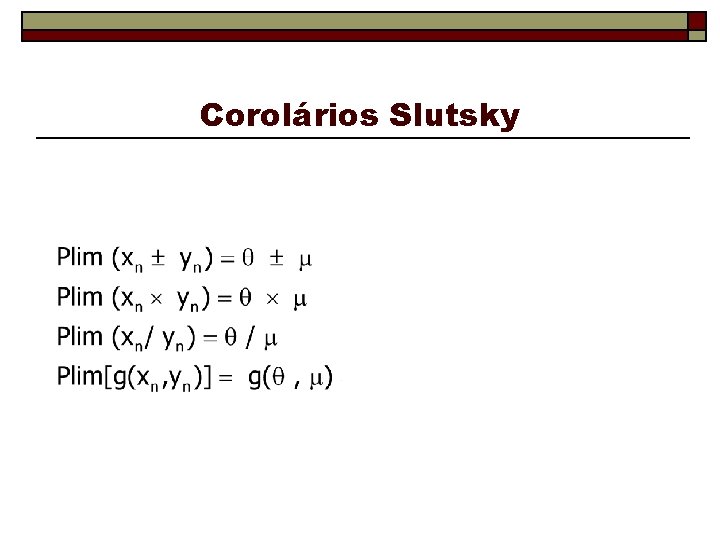

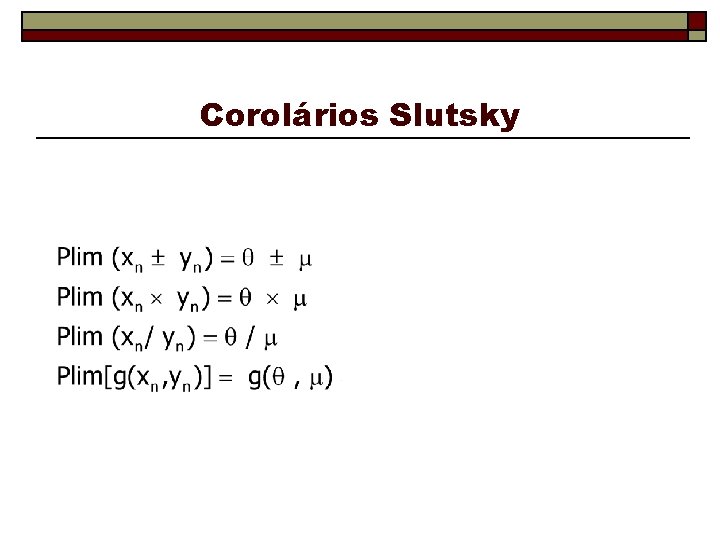

Corolários Slutsky

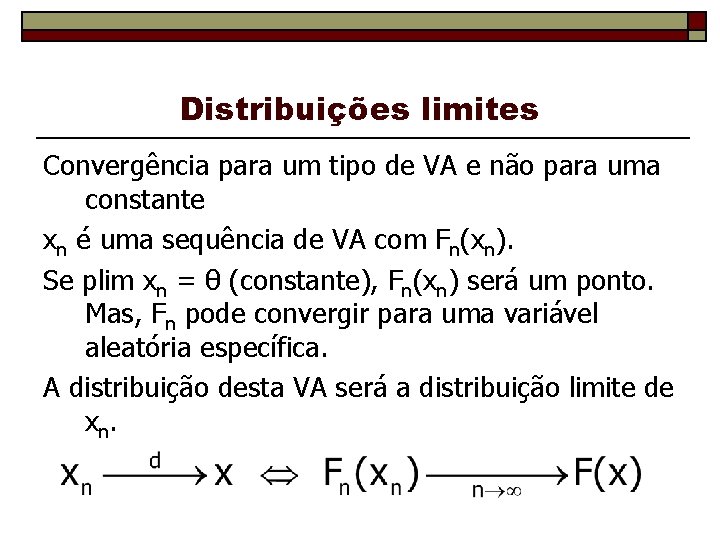

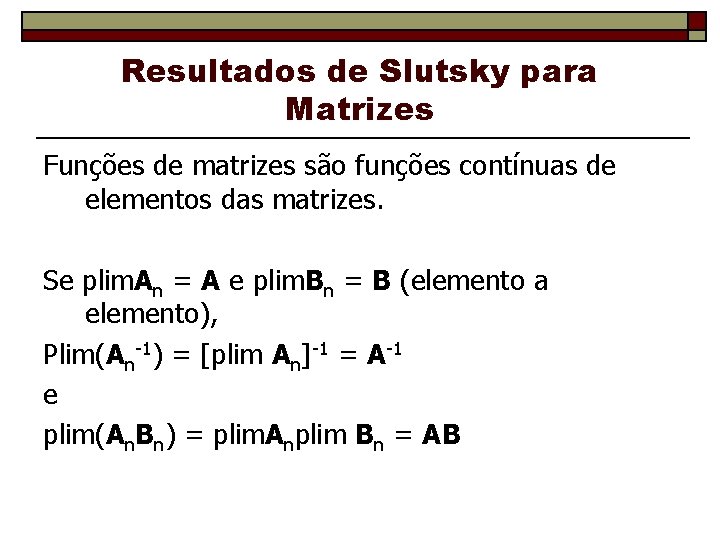

Resultados de Slutsky para Matrizes Funções de matrizes são funções contínuas de elementos das matrizes. Se plim. An = A e plim. Bn = B (elemento a elemento), Plim(An-1) = [plim An]-1 = A-1 e plim(An. Bn) = plim. Anplim Bn = AB

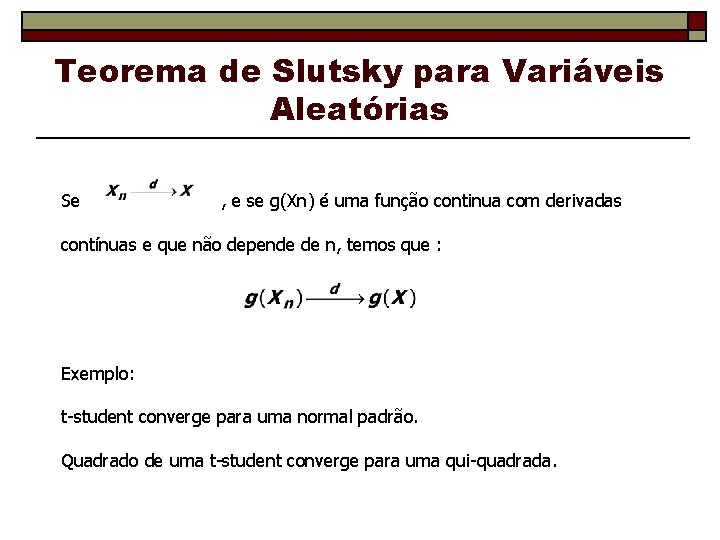

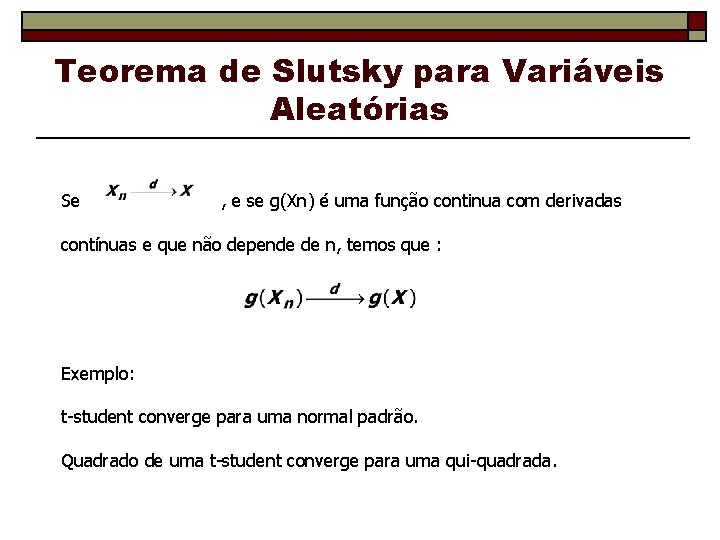

Distribuições limites Convergência para um tipo de VA e não para uma constante xn é uma sequência de VA com Fn(xn). Se plim xn = θ (constante), Fn(xn) será um ponto. Mas, Fn pode convergir para uma variável aleatória específica. A distribuição desta VA será a distribuição limite de xn.

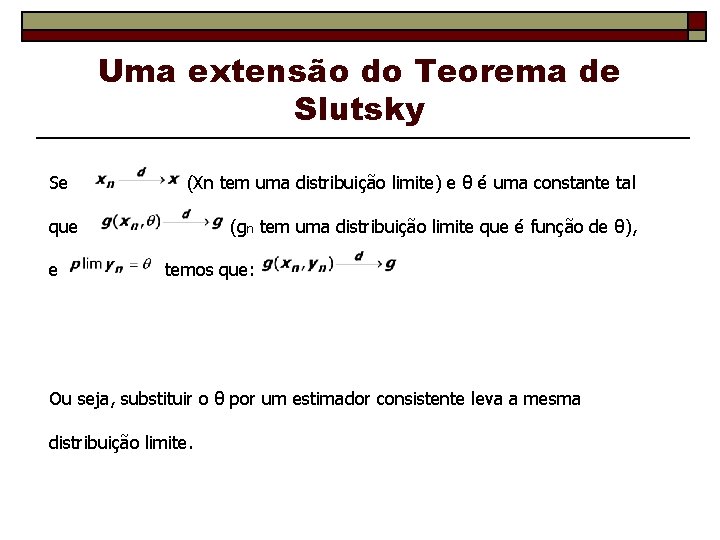

Teorema de Slutsky para Variáveis Aleatórias Se , e se g(Xn) é uma função continua com derivadas contínuas e que não depende de n, temos que : Exemplo: t-student converge para uma normal padrão. Quadrado de uma t-student converge para uma qui-quadrada.

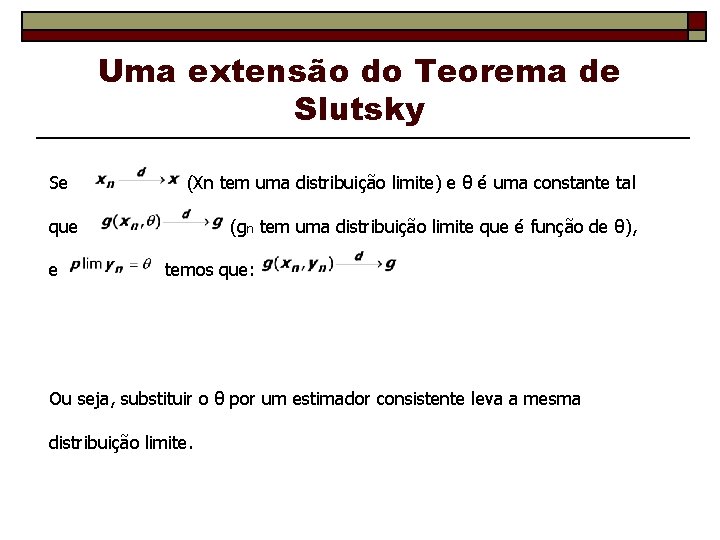

Uma extensão do Teorema de Slutsky Se (Xn tem uma distribuição limite) e θ é uma constante tal que e (gn tem uma distribuição limite que é função de θ), temos que: Ou seja, substituir o θ por um estimador consistente leva a mesma distribuição limite.

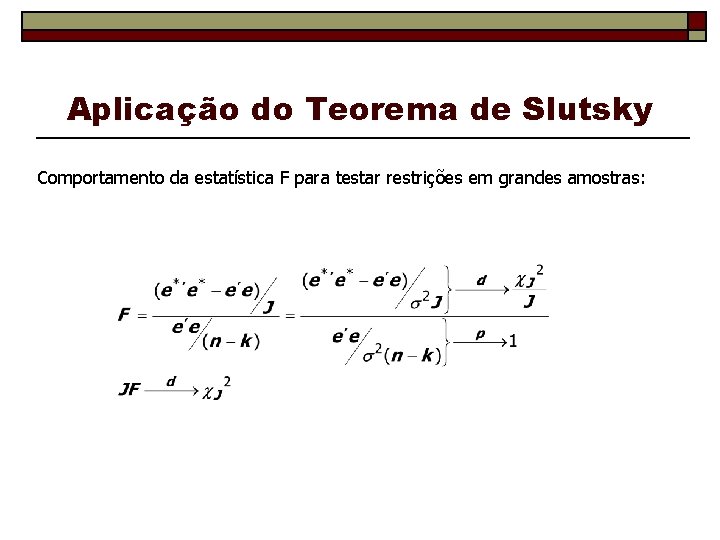

Aplicação do Teorema de Slutsky Comportamento da estatística F para testar restrições em grandes amostras:

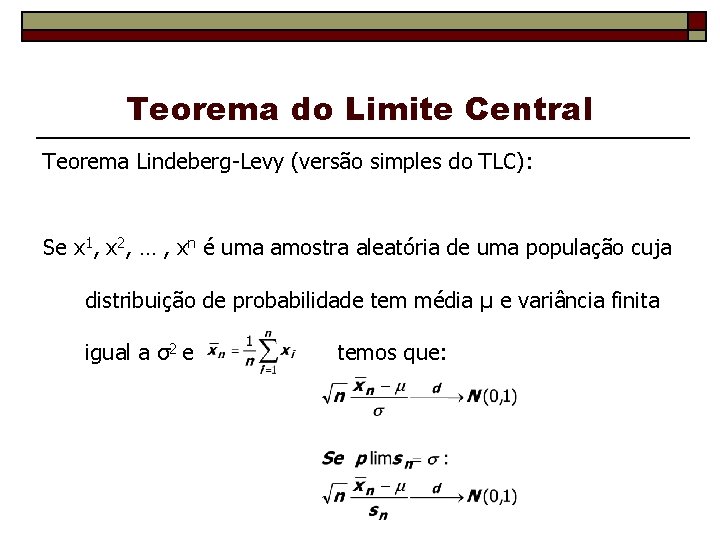

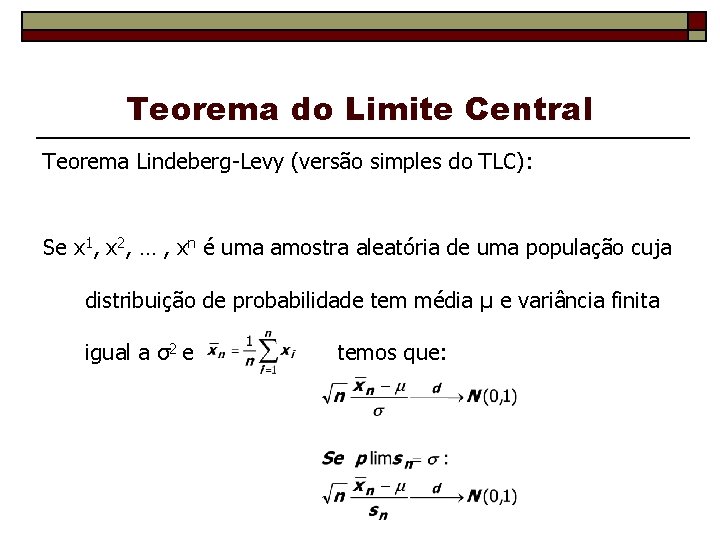

Teorema do Limite Central Descreve o comportamento de uma variável aleatória que envolve soma de variáveis “Tendência para a normalidade. ” A média de uma amostra aleatória de qualquer população (com variância finita), quando padronizada, tem uma distribuição normal padrão assintótica.

Teorema do Limite Central Teorema Lindeberg-Levy (versão simples do TLC): Se x 1, x 2, … , xn é uma amostra aleatória de uma população cuja distribuição de probabilidade tem média μ e variância finita igual a σ2 e temos que:

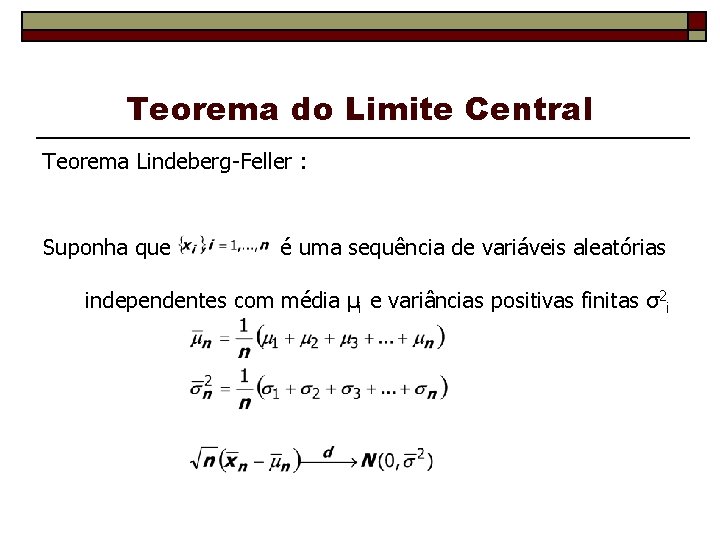

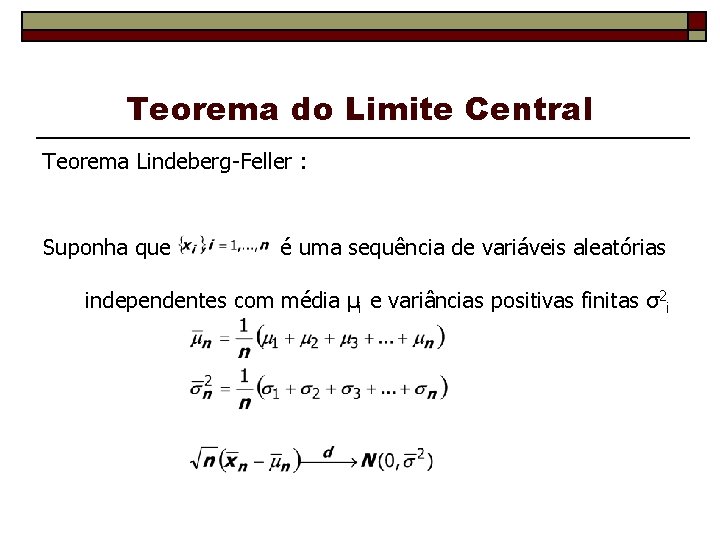

Teorema do Limite Central Teorema Lindeberg-Feller : Suponha que é uma sequência de variáveis aleatórias independentes com média μi e variâncias positivas finitas σ2 i

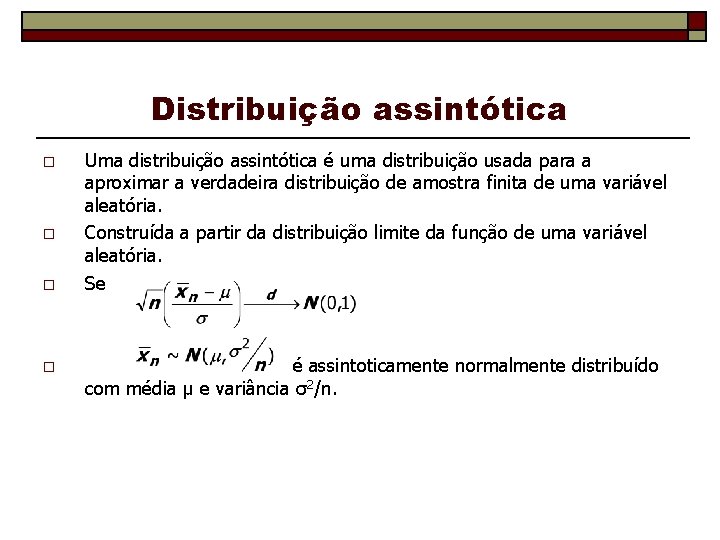

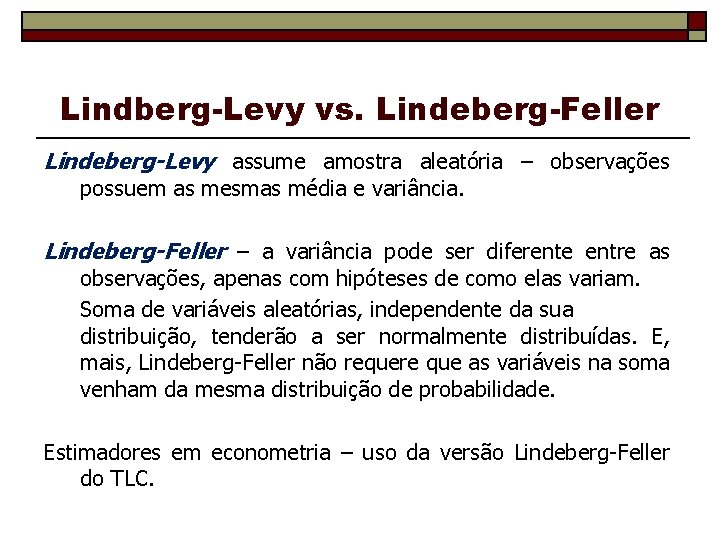

Lindberg-Levy vs. Lindeberg-Feller Lindeberg-Levy assume amostra aleatória – observações possuem as mesmas média e variância. Lindeberg-Feller – a variância pode ser diferente entre as observações, apenas com hipóteses de como elas variam. Soma de variáveis aleatórias, independente da sua distribuição, tenderão a ser normalmente distribuídas. E, mais, Lindeberg-Feller não requere que as variáveis na soma venham da mesma distribuição de probabilidade. Estimadores em econometria – uso da versão Lindeberg-Feller do TLC.

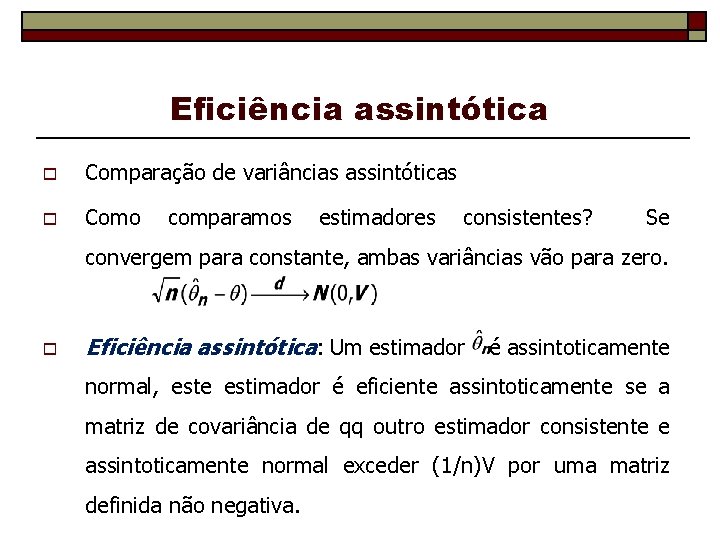

Distribuição assintótica o o Uma distribuição assintótica é uma distribuição usada para a aproximar a verdadeira distribuição de amostra finita de uma variável aleatória. Construída a partir da distribuição limite da função de uma variável aleatória. Se é assintoticamente normalmente distribuído com média μ e variância σ2/n.

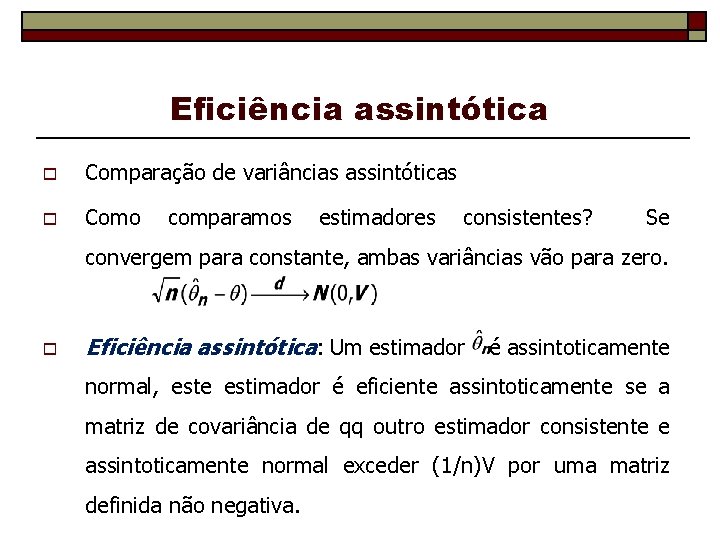

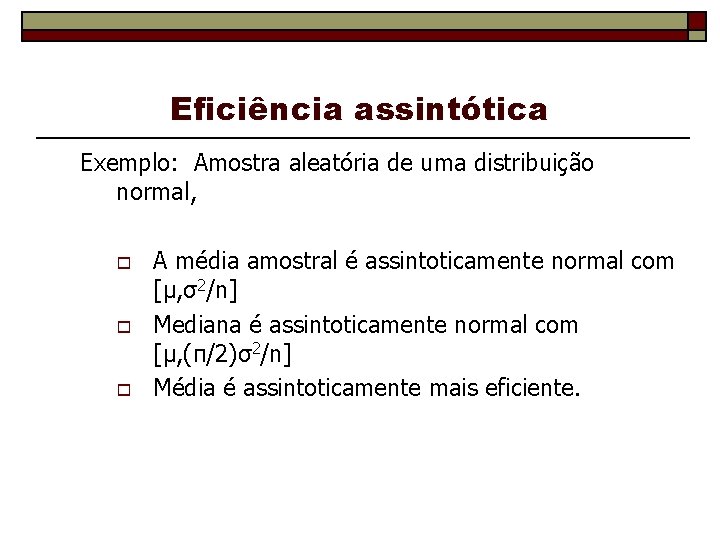

Eficiência assintótica o Comparação de variâncias assintóticas o Como comparamos estimadores consistentes? Se convergem para constante, ambas variâncias vão para zero. o Eficiência assintótica: Um estimador é assintoticamente normal, este estimador é eficiente assintoticamente se a matriz de covariância de qq outro estimador consistente e assintoticamente normal exceder (1/n)V por uma matriz definida não negativa.

Eficiência assintótica Exemplo: Amostra aleatória de uma distribuição normal, o o o A média amostral é assintoticamente normal com [μ, σ2/n] Mediana é assintoticamente normal com [μ, (π/2)σ2/n] Média é assintoticamente mais eficiente.

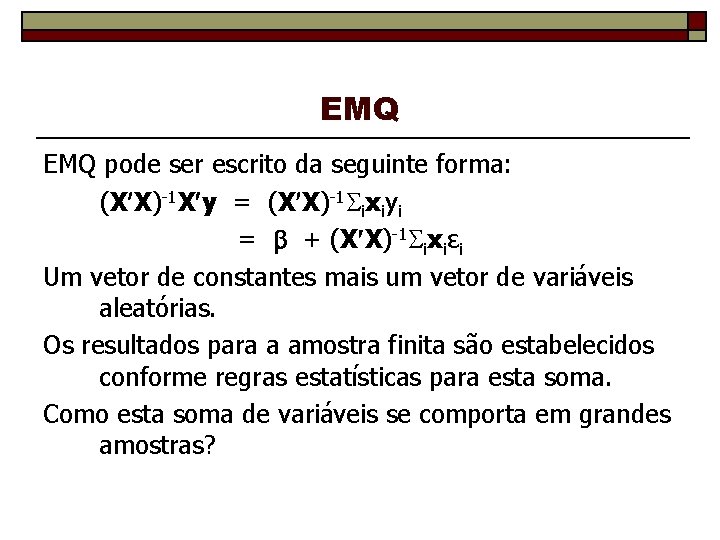

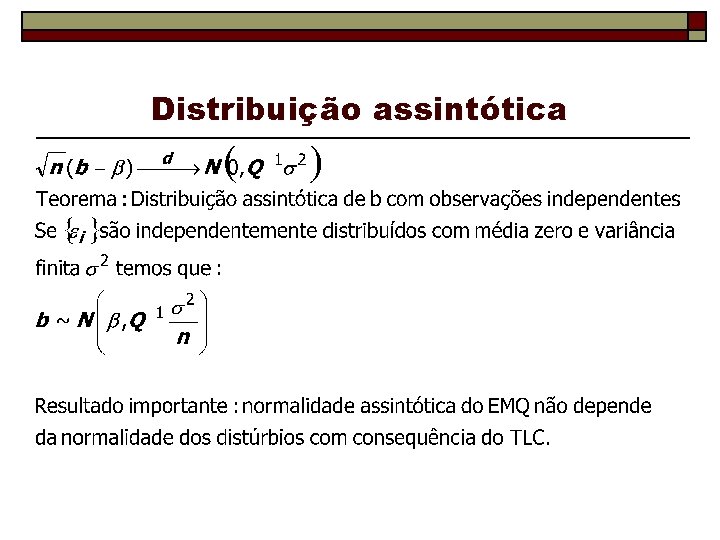

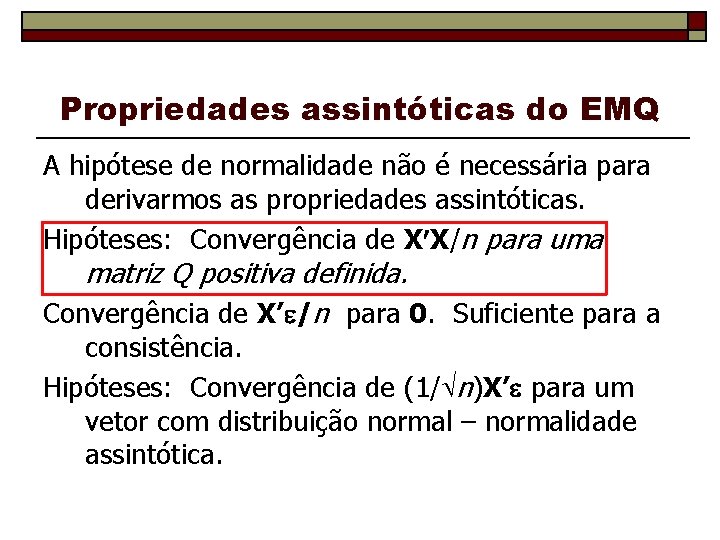

Propriedades assintóticas do EMQ A hipótese de normalidade não é necessária para derivarmos as propriedades assintóticas. Hipóteses: Convergência de X X/n para uma matriz Q positiva definida. Convergência de X’ /n para 0. Suficiente para a consistência. Hipóteses: Convergência de (1/ n)X’ para um vetor com distribuição normal – normalidade assintótica.

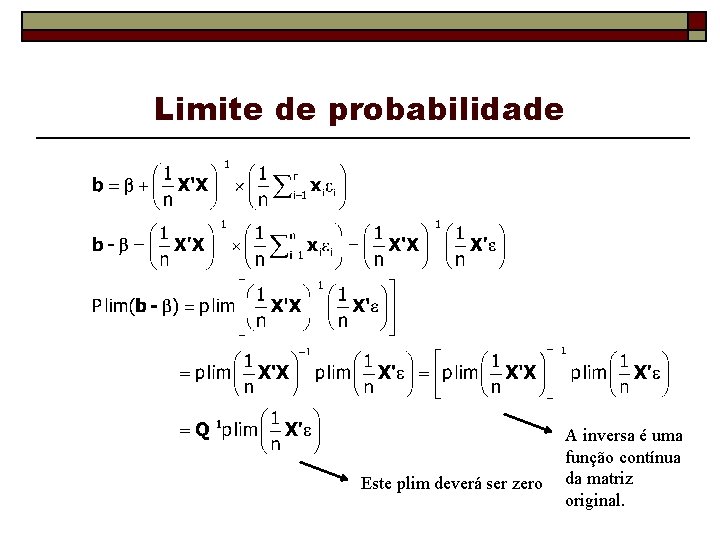

EMQ pode ser escrito da seguinte forma: (X X)-1 X y = (X X)-1 ixiyi = + (X X)-1 ixiεi Um vetor de constantes mais um vetor de variáveis aleatórias. Os resultados para a amostra finita são estabelecidos conforme regras estatísticas para esta soma. Como esta soma de variáveis se comporta em grandes amostras?

![Convergência em média quadrática EbXβ para qualquer X VarbX 0 para um X específico Convergência em média quadrática E[b|X]=β para qualquer X. Var[b|X] 0 para um X específico](https://slidetodoc.com/presentation_image_h/29300f29fc9fd2ba274000c8d88b5281/image-27.jpg)

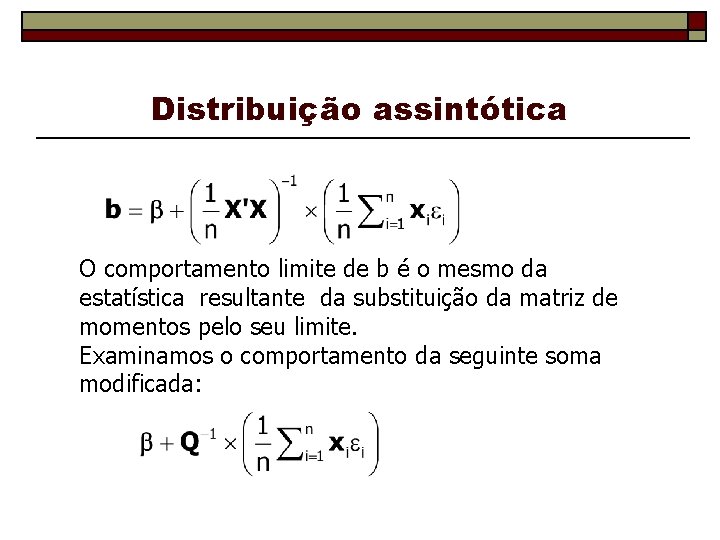

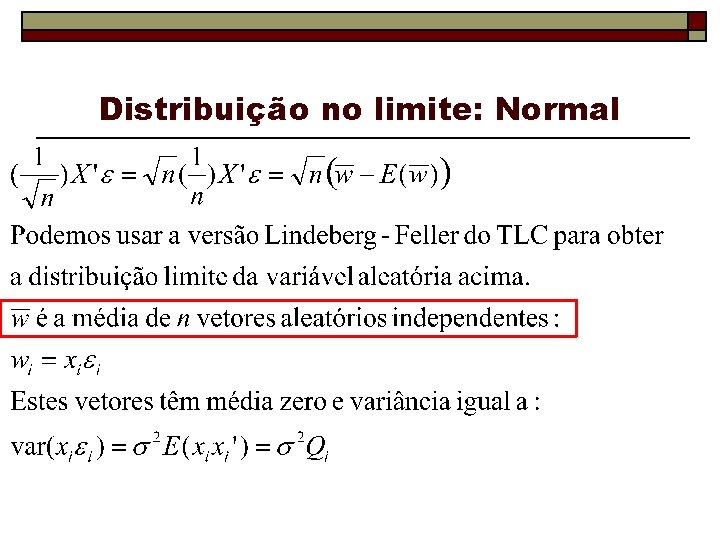

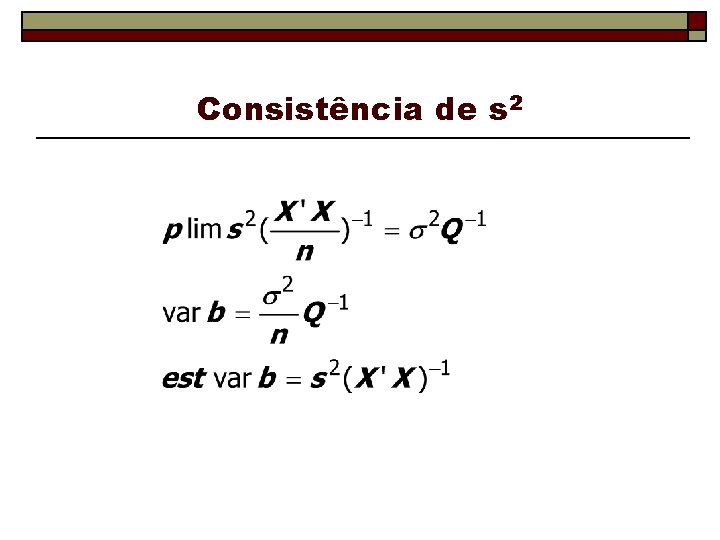

Convergência em média quadrática E[b|X]=β para qualquer X. Var[b|X] 0 para um X específico b converge para β b é consistente

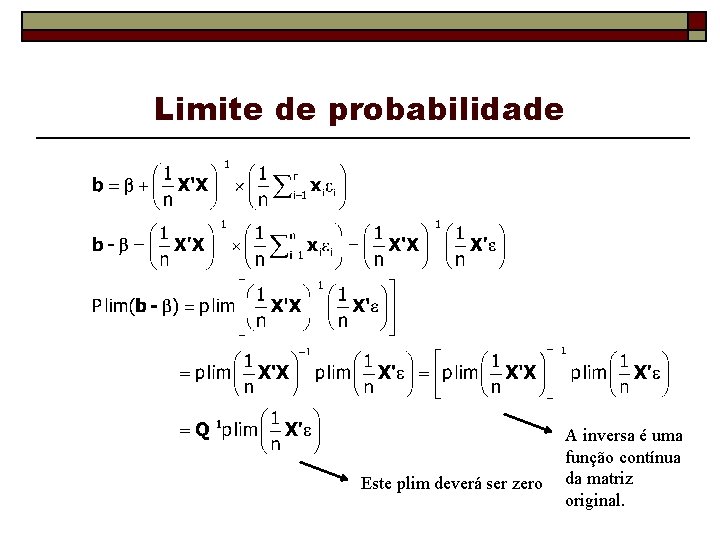

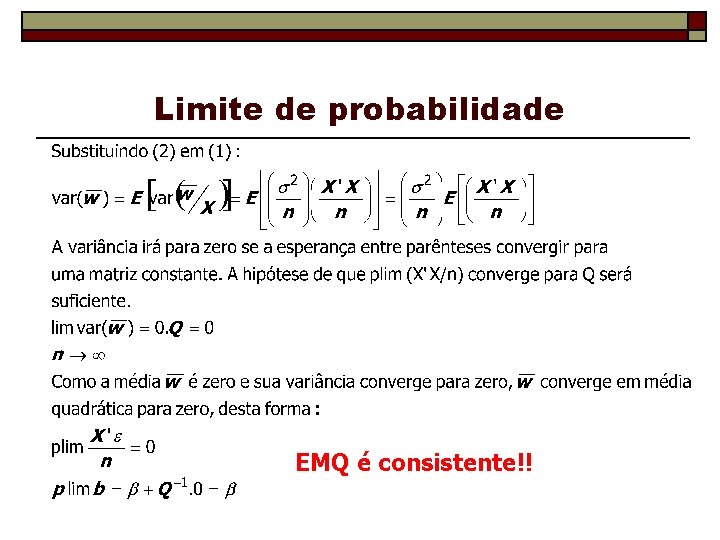

Limite de probabilidade Este plim deverá ser zero A inversa é uma função contínua da matriz original.

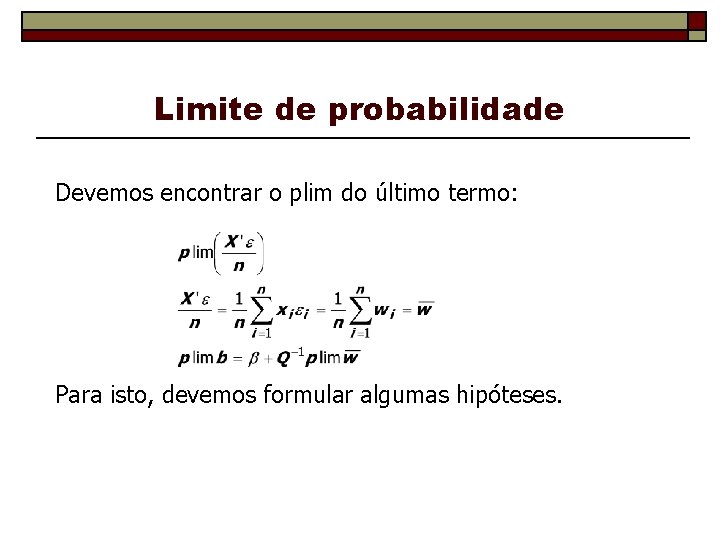

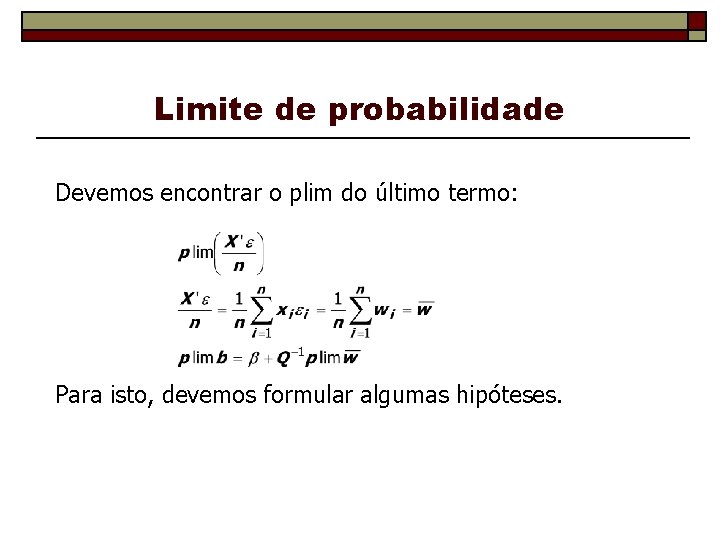

Limite de probabilidade Devemos encontrar o plim do último termo: Para isto, devemos formular algumas hipóteses.

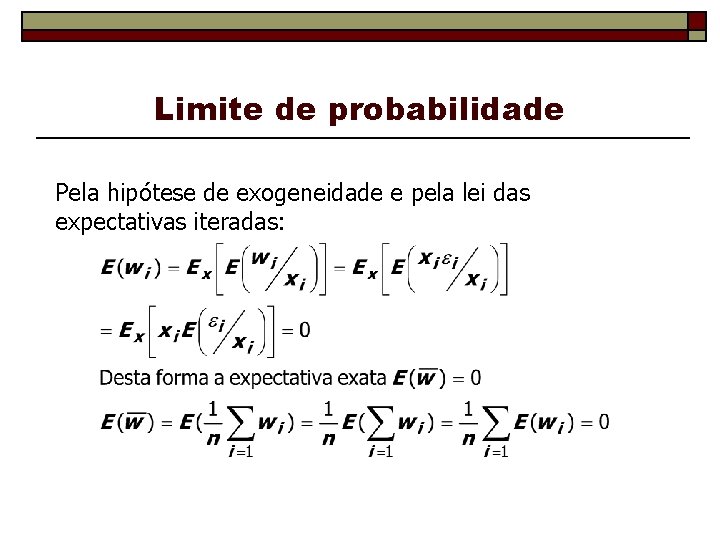

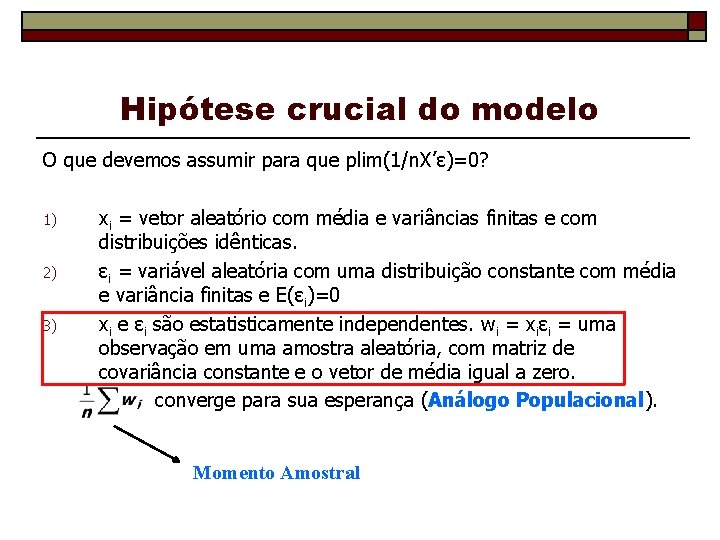

Hipótese crucial do modelo O que devemos assumir para que plim(1/n. X’ε)=0? 1) 2) 3) xi = vetor aleatório com média e variâncias finitas e com distribuições idênticas. εi = variável aleatória com uma distribuição constante com média e variância finitas e E(εi)=0 xi e εi são estatisticamente independentes. wi = xiεi = uma observação em uma amostra aleatória, com matriz de covariância constante e o vetor de média igual a zero. converge para sua esperança (Análogo Populacional). Momento Amostral

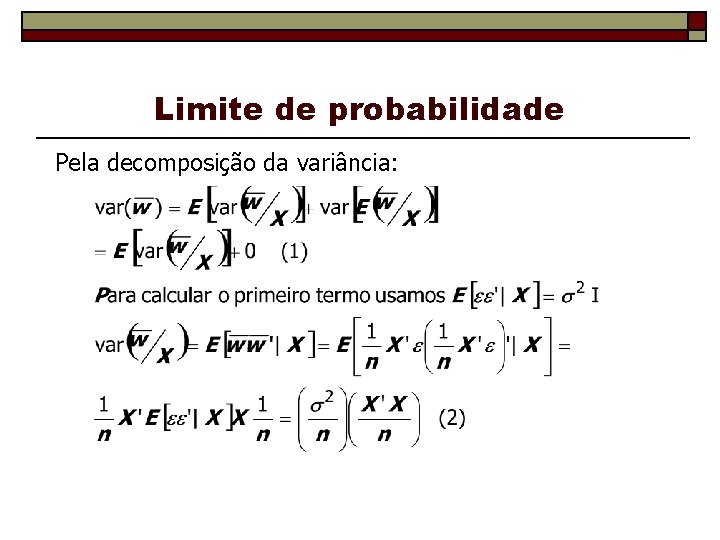

Limite de probabilidade Pela hipótese de exogeneidade e pela lei das expectativas iteradas:

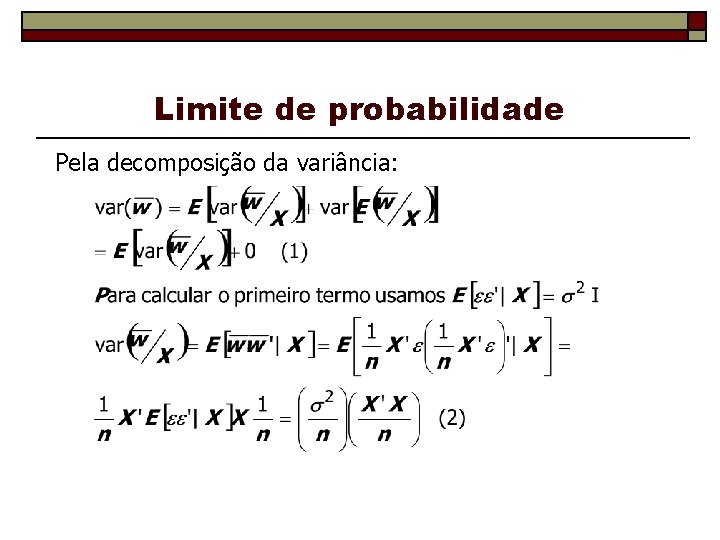

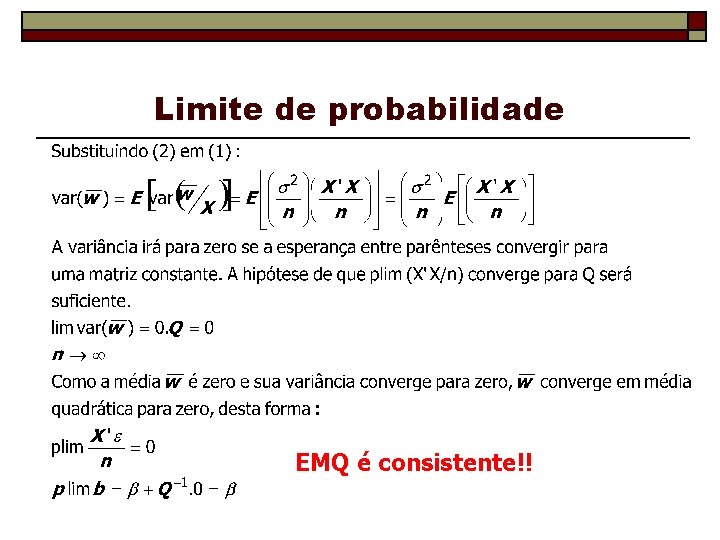

Limite de probabilidade Pela decomposição da variância:

Limite de probabilidade EMQ é consistente!!

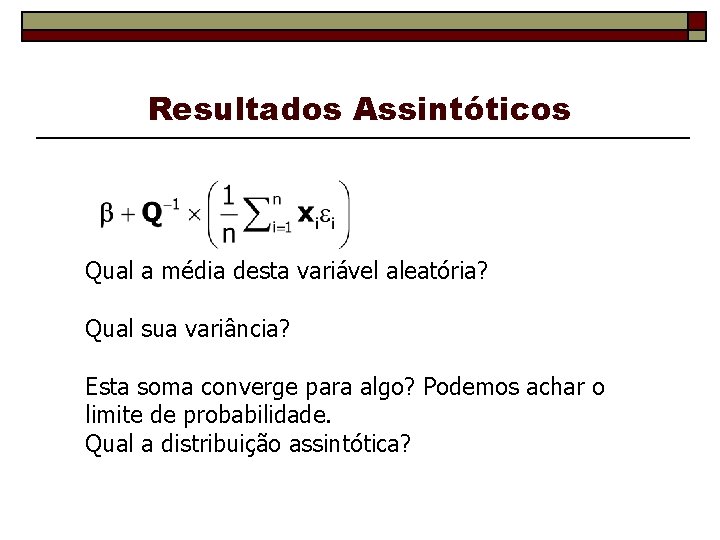

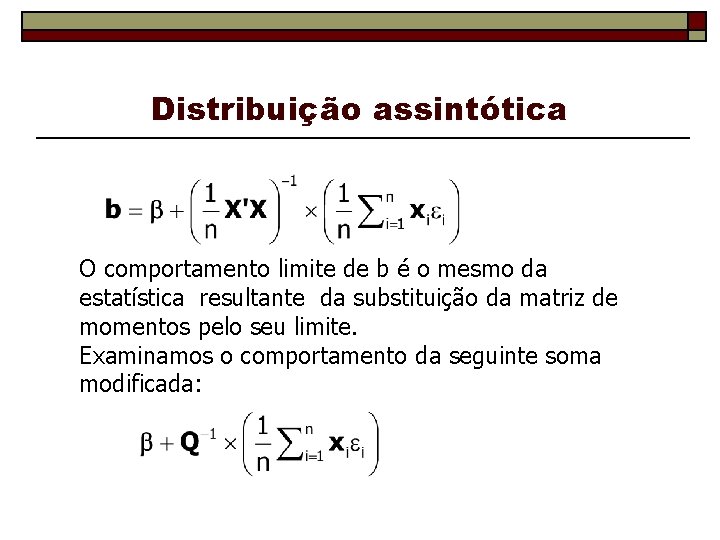

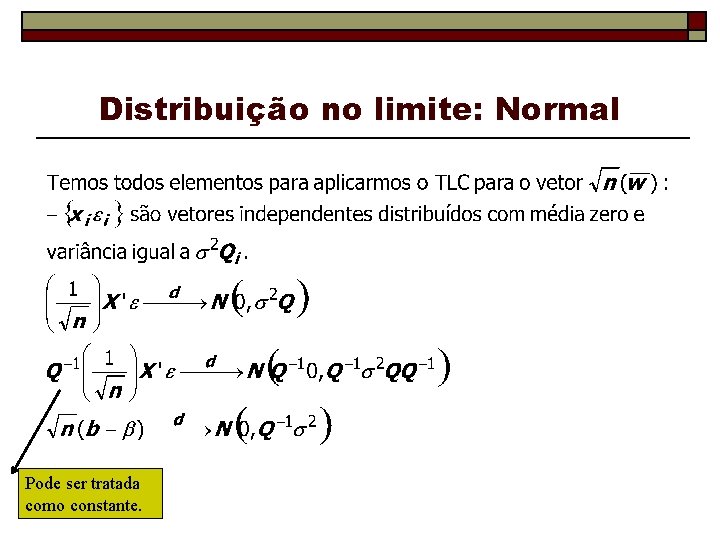

Distribuição assintótica O comportamento limite de b é o mesmo da estatística resultante da substituição da matriz de momentos pelo seu limite. Examinamos o comportamento da seguinte soma modificada:

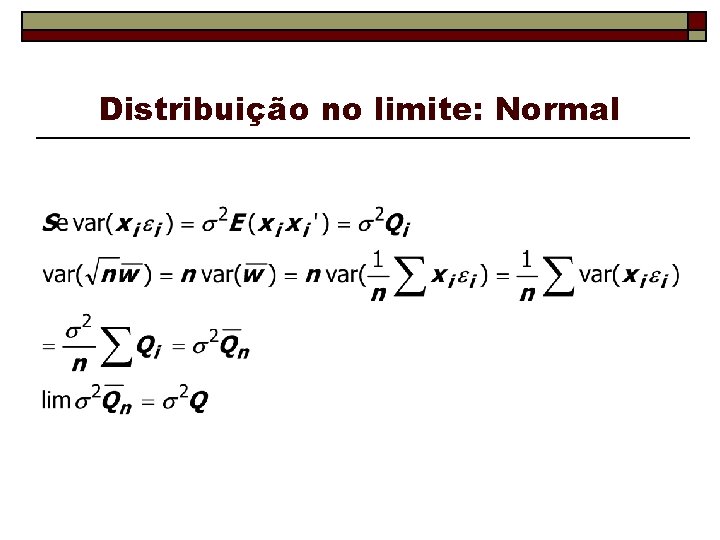

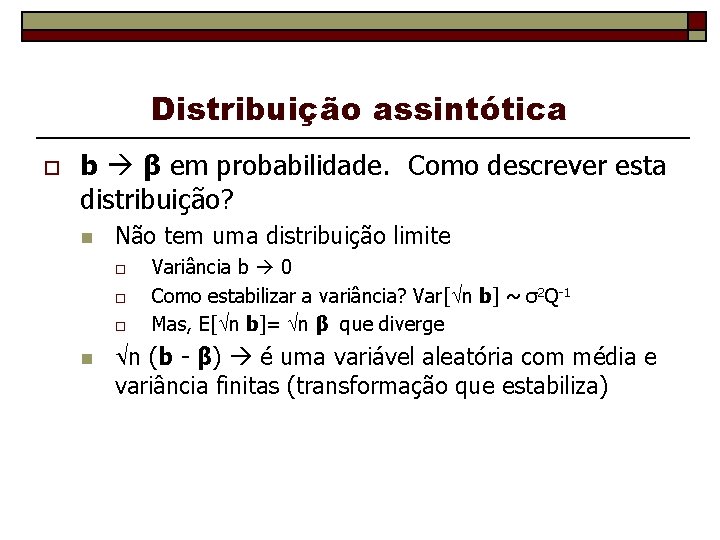

Resultados Assintóticos Qual a média desta variável aleatória? Qual sua variância? Esta soma converge para algo? Podemos achar o limite de probabilidade. Qual a distribuição assintótica?

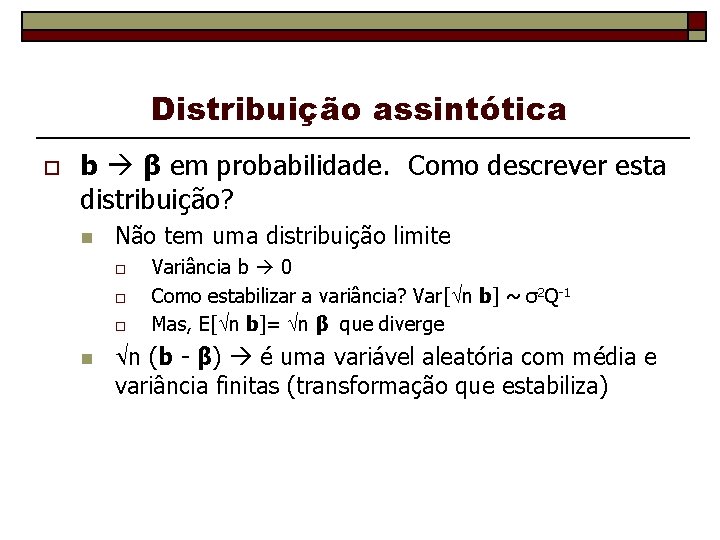

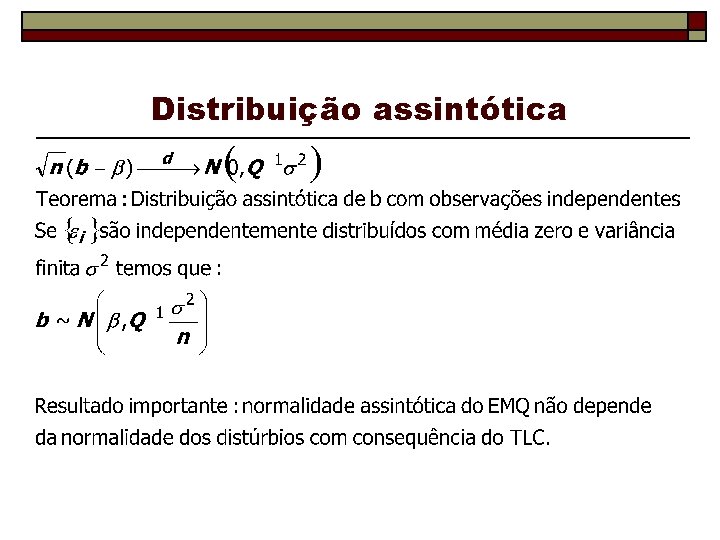

Distribuição assintótica o b β em probabilidade. Como descrever esta distribuição? n Não tem uma distribuição limite o o o n Variância b 0 Como estabilizar a variância? Var[ n b] ~ σ2 Q-1 Mas, E[ n b]= n β que diverge n (b - β) é uma variável aleatória com média e variância finitas (transformação que estabiliza)

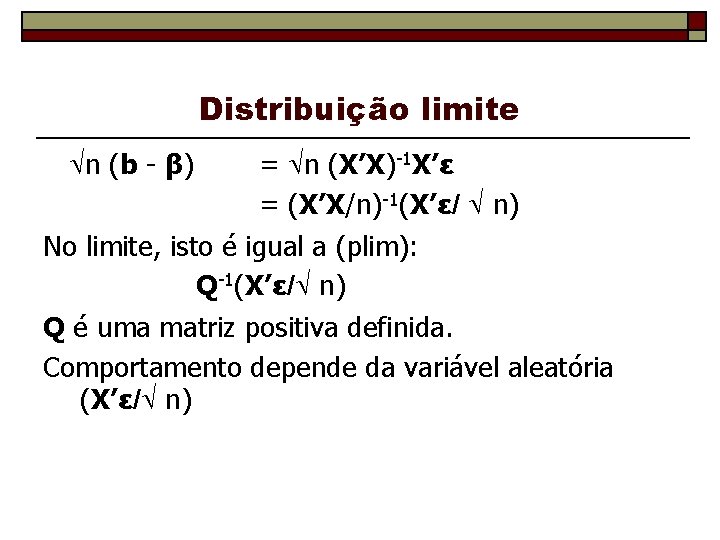

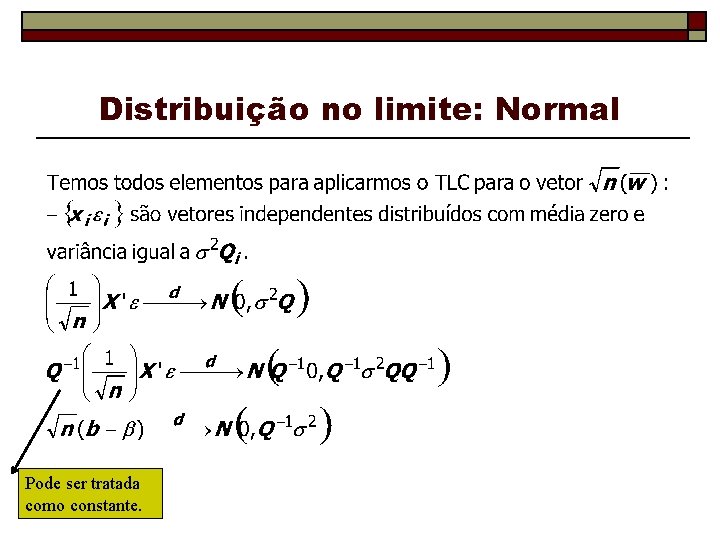

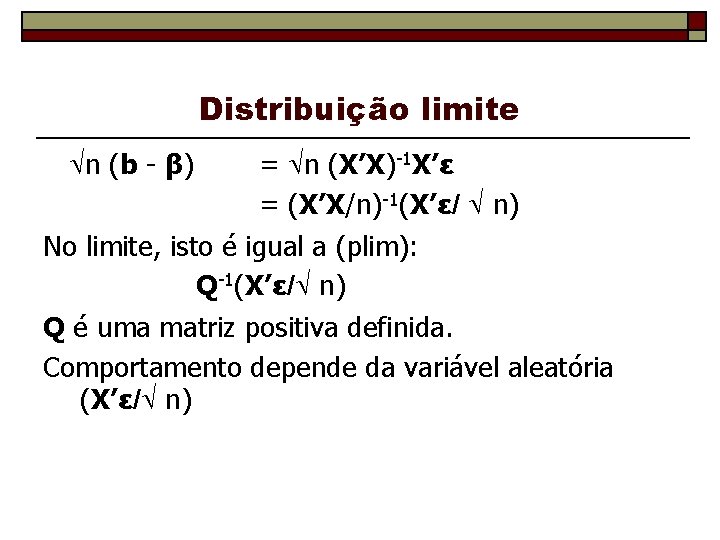

Distribuição limite n (b - β) = n (X’X)-1 X’ε = (X’X/n)-1(X’ε/ n) No limite, isto é igual a (plim): Q-1(X’ε/ n) Q é uma matriz positiva definida. Comportamento depende da variável aleatória (X’ε/ n)

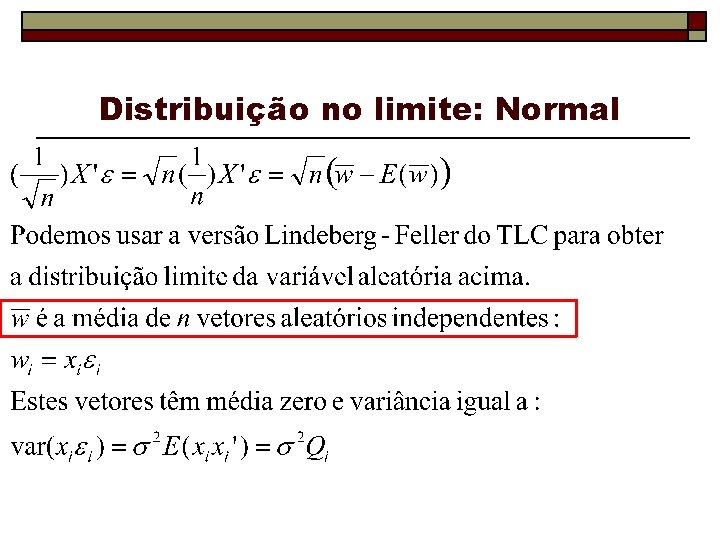

Distribuição no limite: Normal

Distribuição no limite: Normal

Distribuição no limite: Normal Pode ser tratada como constante.

Distribuição assintótica

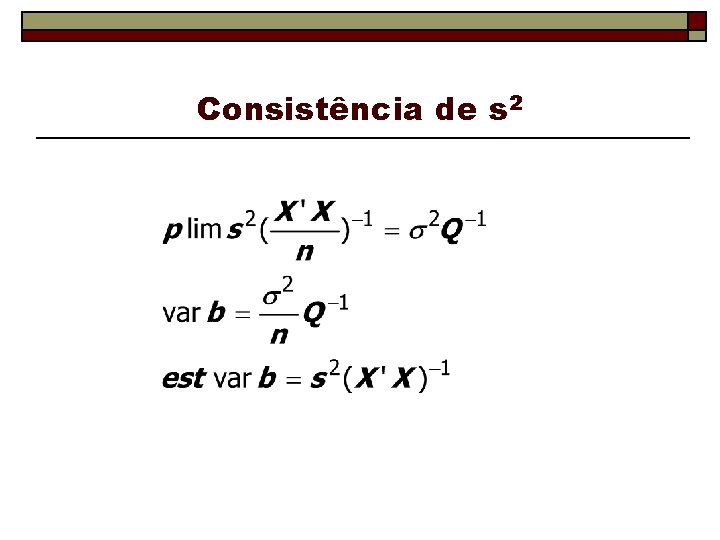

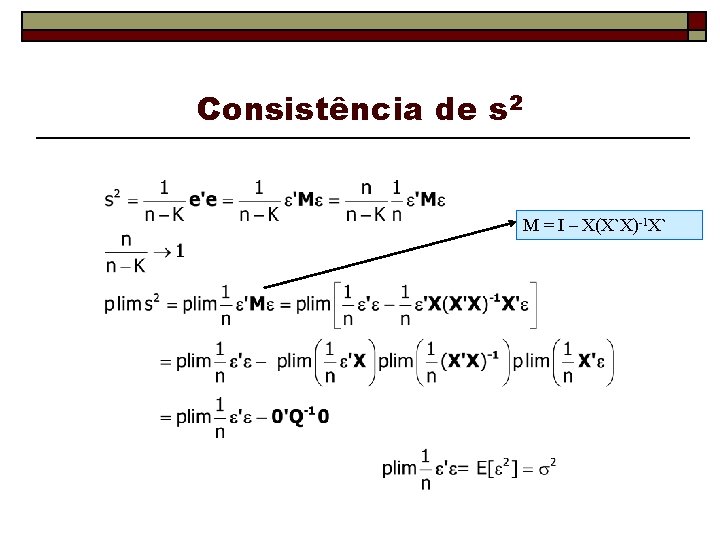

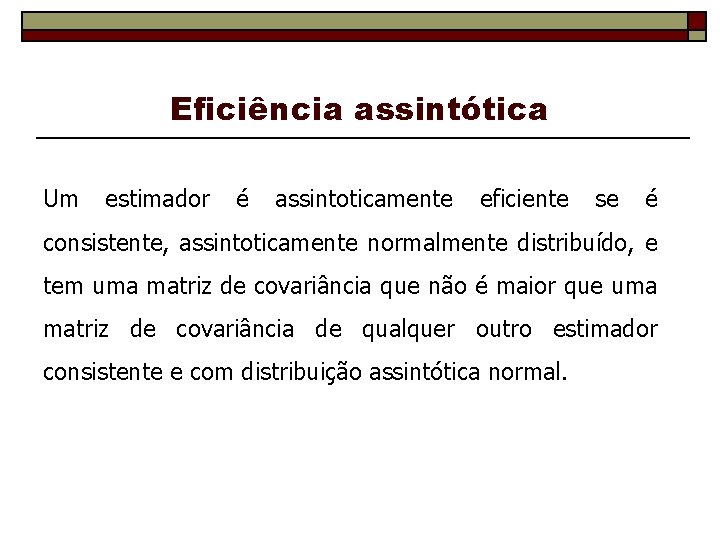

Consistência de s 2 M = I – X(X`X)-1 X`

Consistência de s 2

Eficiência assintótica Um estimador é assintoticamente eficiente se é consistente, assintoticamente normalmente distribuído, e tem uma matriz de covariância que não é maior que uma matriz de covariância de qualquer outro estimador consistente e com distribuição assintótica normal.