DATA MINING 02 Pengenalan data bagian 2 DR

DATA MINING 02 Pengenalan data bagian 2 DR. FARRIKH ALZAMI, M. KOM SISTEM INFORMASI – S 1 alzami@dsn. dinus. ac. id

Daftar Pustaka

Outline mata kuliah: data mining

Pembahasan pertemuan sebelumnya • Memahami tentang pengenalan tentang data • mengerti tentang atribut • Memahami dan mengetahui tipe dataset • Memahami dan dapat membedakan kualitas data • Memahami dan mampu menghitung Disimilarity measures • Memahami dan mampu menghitung Similarity measures

Capaian Pembelajaran pertemuan ini • Aggregation • Sampling • Dimensionality Reduction • Feature subset selection • Feature creation • Discretization and Binarization • Attribute Transformation

Agregasi

Agregasi Adalah Menggabungkan dua atau lebih atribut (atau objek) menjadi satu atribut (atau objek) Tujuan • Pengurangan data • Kurangi jumlah atribut atau objek • Ubah skala • Kota-kota dikumpulkan menjadi daerah, negara bagian, negara, dll. • Hari digabungkan menjadi beberapa minggu, bulan, atau tahun • Lebih banyak data "stabil“ • Data agregat cenderung memiliki variabilitas yang lebih sedikit

Agregasi: contoh Contoh ini didasarkan pada curah hujan di Australia dari periode 1982 hingga 1993. Slide berikutnya menunjukkan • Histogram untuk simpangan baku curah hujan rata-rata bulanan untuk 3. 030 0, 5◦ x 0, 5◦ sel kisi di Australia, dan • Histogram untuk simpangan baku rata-rata curah hujan tahunan untuk lokasi yang sama. Curah hujan tahunan rata-rata memiliki variabilitas yang lebih rendah daripada curah hujan bulanan rata-rata. Semua pengukuran curah hujan (dan standar deviasinya) dalam sentimeter.

Agregasi: contoh Standard Deviation of Average Monthly Precipitation Standard Deviation of Average Yearly Precipitation

Sampling • Sampling adalah teknik utama yang digunakan untuk reduksi data. • Ini sering digunakan untuk investigasi awal data dan analisis data akhir. • Para ahli statistik sering mengambil sampel karena memperoleh seluruh rangkaian data yang menarik terlalu mahal atau memakan waktu. • Pengambilan sampel biasanya digunakan dalam penambangan data karena memproses seluruh rangkaian data yang menarik terlalu mahal atau memakan waktu.

Sampling • Prinsip utama untuk pengambilan sampel yang efektif adalah sebagai berikut: • Menggunakan sampel akan bekerja hampir sama halnya dengan menggunakan seluruh kumpulan data, jika sampel tersebut representatif • Sampel mewakili jika memiliki sifat yang kira-kira sama (dengan minat) seperti kumpulan data asli

Tipe sampling • Simple random sampling (acak sederhana) • Ada probabilitas yang sama untuk memilih item tertentu • Pengambilan sampel tanpa penggantian • Karena setiap item dipilih, itu dihapus dari populasi • Sampling dengan penggantian • Objek tidak dihapus dari populasi karena mereka dipilih untuk sampel • Dalam pengambilan sampel dengan penggantian, objek yang sama dapat diambil lebih dari satu kali • Stratified sampling (sampling bertingkat) • Membagi data menjadi beberapa partisi; lalu gambarkan sampel acak dari setiap partisi

Ukuran sampling • Berapa ukuran sampel yang diperlukan untuk mendapatkan setidaknya satu objek dari masing-masing 10 kelompok yang berukuran sama. • Untuk sample 20, probabilitas 0. 2 • Lalu berapa ukuran sample yang pas? • Akan dijelaskan di bagian clustering

Curse of dimensionality • Sparsity: data banyak nilai 0 • Sekitar 90% data, nilainya 0, maka bisa disebut sparse • Ketika dimensi meningkat, data menjadi semakin jarang (sparse) di ruang yang didudukinya • Definisi kepadatan (density) dan jarak antar titik (distance between points), yang penting untuk pengelompokan deteksi outlier, menjadi kurang berarti • Akan dijelaskan di bab clustering

Dimensionality Reduction • Tujuan: • Hindari kutukan dimensi (curse of dimensionality) • Mengurangi jumlah waktu dan memori yang dibutuhkan oleh algoritma penambangan data • membuat data menjadi lebih mudah divisualisasikan • Dapat membantu menghilangkan fitur yang tidak relevan atau mengurangi noise • Teknik • Analisis Komponen Utama / Principal Components Analysis (PCA) • Dekomposisi Nilai Singular / Singular Value Decomposition (SVD) • Lainnya: supervised and non-linear techniques

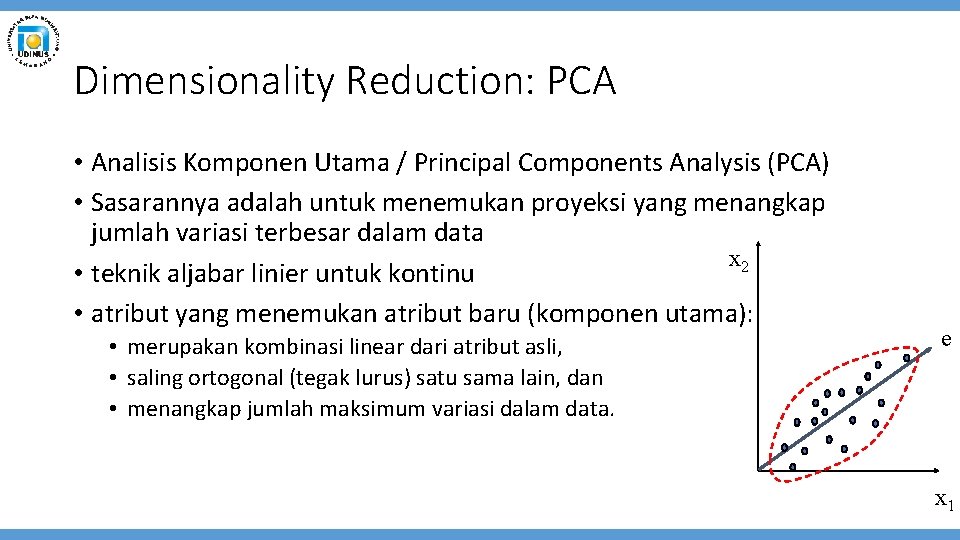

Dimensionality Reduction: PCA • Analisis Komponen Utama / Principal Components Analysis (PCA) • Sasarannya adalah untuk menemukan proyeksi yang menangkap jumlah variasi terbesar dalam data x 2 • teknik aljabar linier untuk kontinu • atribut yang menemukan atribut baru (komponen utama): • merupakan kombinasi linear dari atribut asli, • saling ortogonal (tegak lurus) satu sama lain, dan • menangkap jumlah maksimum variasi dalam data. e x 1

Dimensionality Reduction: PCA

Feature Subset Selection / Pemilihan Subset Fitur Cara lain untuk mengurangi dimensi data • Fitur yang berlebihan • Gandakan banyak atau semua informasi yang terkandung dalam satu atau lebih atribut lainnya • Contoh: harga beli suatu produk dan jumlah pajak penjualan yang dibayarkan • Fitur yang tidak relevan • Tidak mengandung informasi yang berguna untuk tugas penambangan data yang ada • Contoh: ID siswa seringkali tidak relevan dengan tugas memprediksi IPK siswa • Banyak teknik yang dikembangkan, terutama untuk klasifikasi

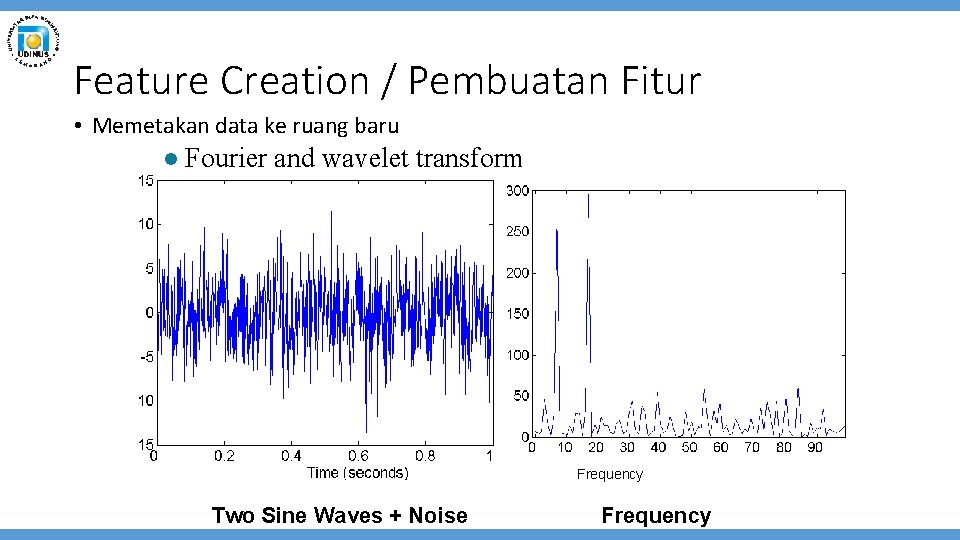

Feature Creation / Pembuatan Fitur • Buat atribut baru yang dapat menangkap informasi penting dalam kumpulan data jauh lebih efisien daripada atribut asli • Tiga metodologi umum: • Ekstraksi fitur • Contoh: mengekstraksi tepi dari gambar • Konstruksi fitur • Contoh: membagi massa dengan volume untuk mendapatkan kepadatan • Memetakan data ke ruang baru • Contoh: Analisis Fourier dan wavelet

Feature Creation / Pembuatan Fitur • Memetakan data ke ruang baru l Fourier and wavelet transform Frequency Two Sine Waves + Noise Frequency

Discretization • Diskretisasi adalah proses mengubah atribut kontinu menjadi atribut ordinal • Sejumlah nilai yang berpotensi tak terbatas dipetakan ke dalam sejumlah kecil kategori • Diskretisasi umumnya digunakan dalam klasifikasi • Banyak algoritma klasifikasi bekerja paling baik jika variabel independen dan dependen hanya memiliki beberapa nilai • Kami memberikan ilustrasi tentang kegunaan diskritisasi menggunakan set data Iris

Iris Sample Data Set • Iris Plant data set. • Can be obtained from the UCI Machine Learning Repository http: //www. ics. uci. edu/~mlearn/MLRepository. html • From the statistician Douglas Fisher • Three flower types (classes): • Setosa • Versicolour • Virginica • Four (non-class) attributes • Sepal width and length • Petal width and length Virginica. Robert H. Mohlenbrock. USDA NRCS. 1995. Northeast wetland flora: Field office guide to plant species. Northeast National Technical Center, Chester, PA. Courtesy of USDA NRCS Wetland Science Institute.

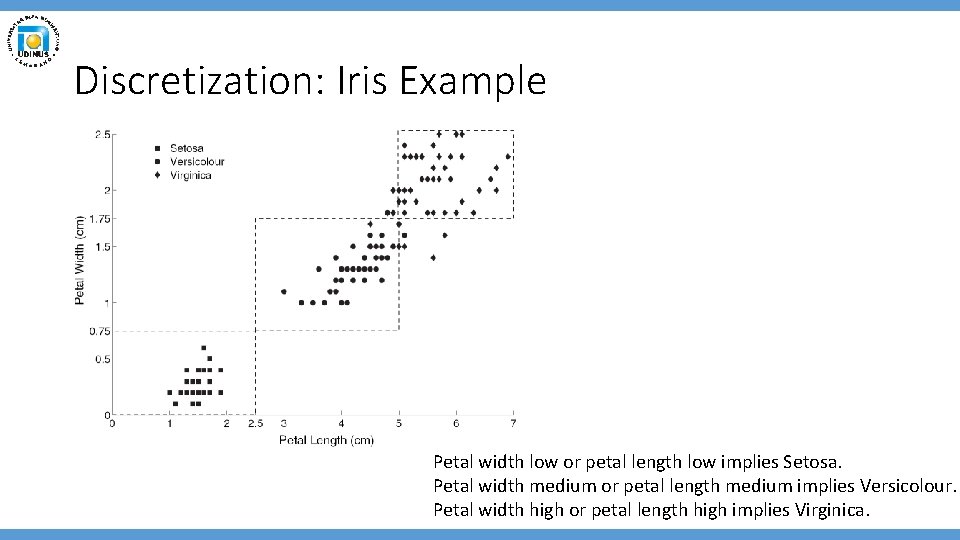

Discretization: Iris Example Petal width low or petal length low implies Setosa. Petal width medium or petal length medium implies Versicolour. Petal width high or petal length high implies Virginica.

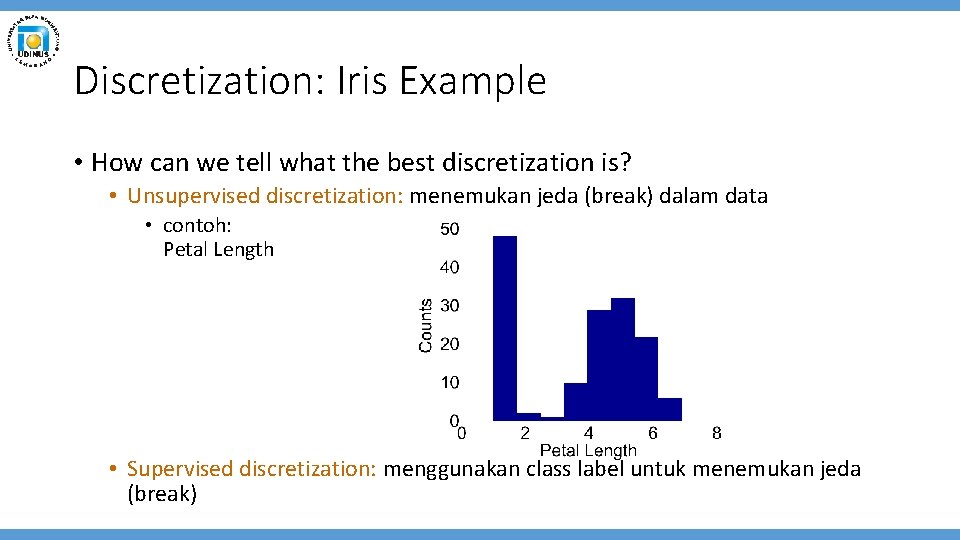

Discretization: Iris Example • How can we tell what the best discretization is? • Unsupervised discretization: menemukan jeda (break) dalam data • contoh: Petal Length • Supervised discretization: menggunakan class label untuk menemukan jeda (break)

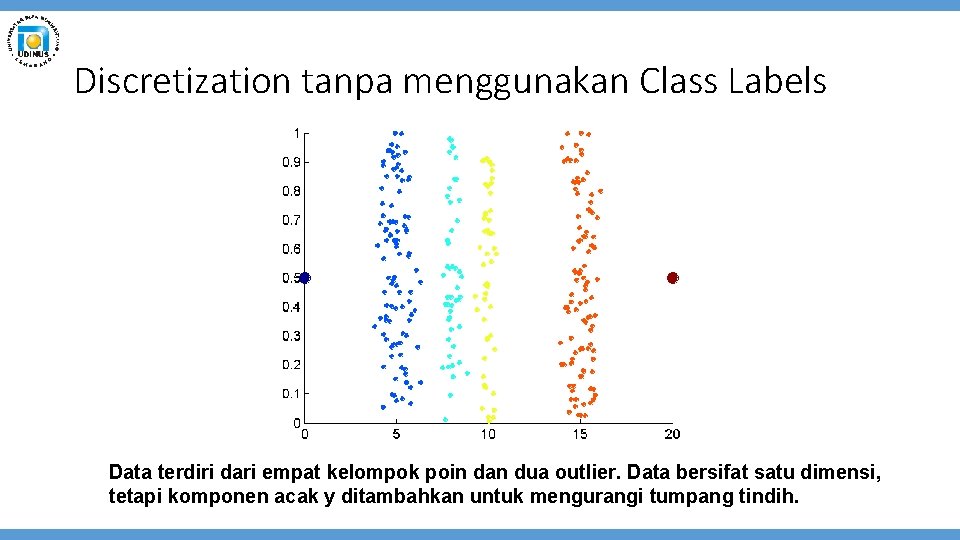

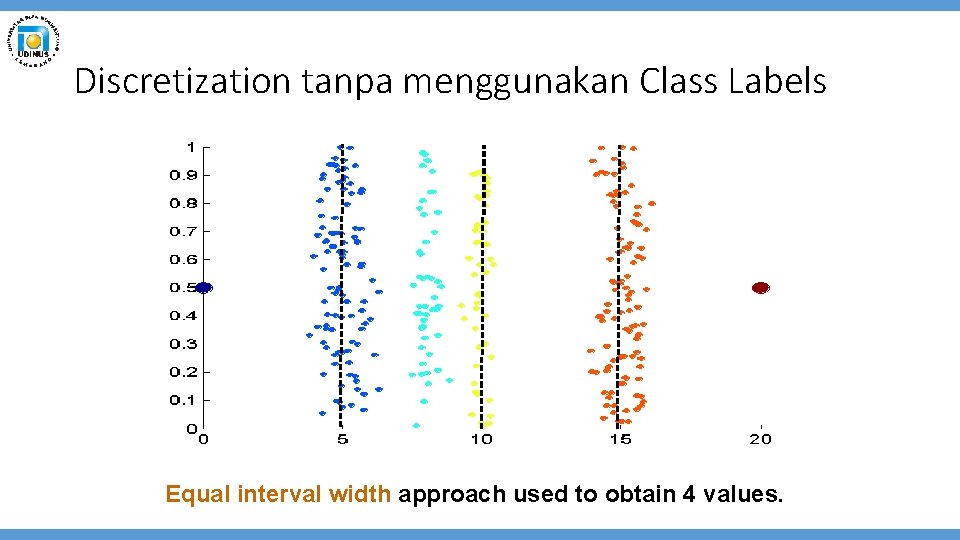

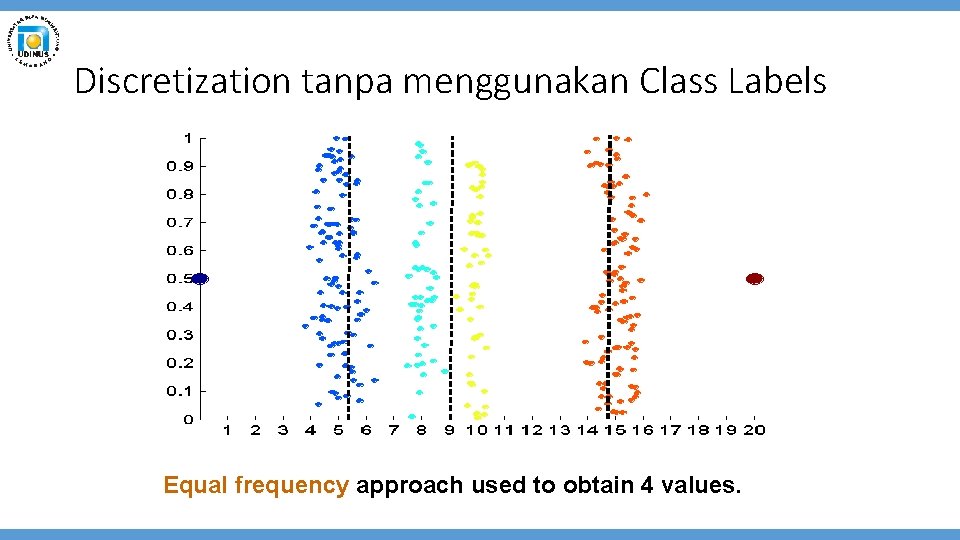

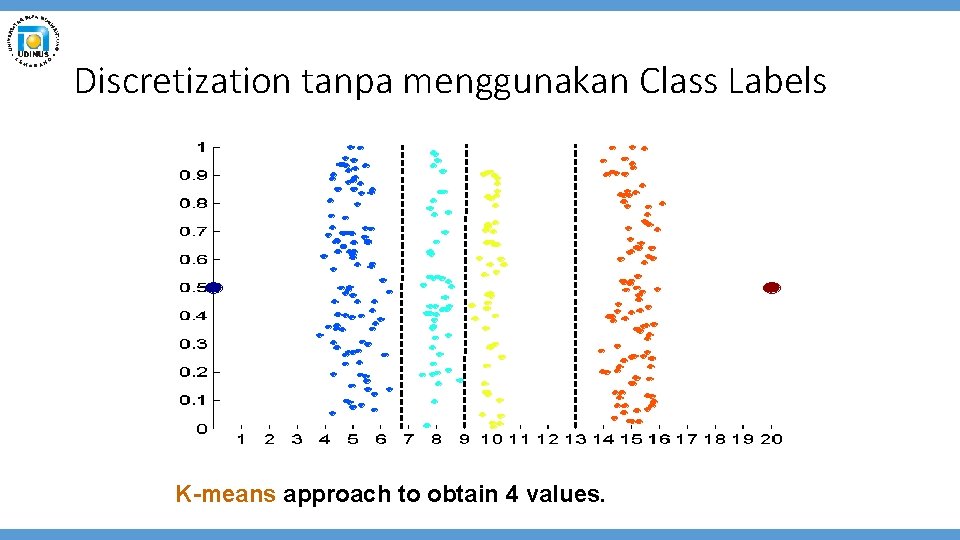

Discretization tanpa menggunakan Class Labels Data terdiri dari empat kelompok poin dan dua outlier. Data bersifat satu dimensi, tetapi komponen acak y ditambahkan untuk mengurangi tumpang tindih.

Discretization tanpa menggunakan Class Labels Equal interval width approach used to obtain 4 values.

Discretization tanpa menggunakan Class Labels Equal frequency approach used to obtain 4 values.

Discretization tanpa menggunakan Class Labels K-means approach to obtain 4 values.

Binarization • Binarisasi memetakan atribut kontinu atau kategorikal ke dalam satu atau lebih variabel biner • Biasanya digunakan untuk analisis asosiasi • Seringkali mengonversi atribut kontinu ke atribut kategorikal dan kemudian mengonversi atribut kategorikal ke sekumpulan atribut biner • Analisis asosiasi membutuhkan atribut biner asimetris • Contoh: warna mata dan tinggi diukur {rendah, sedang, tinggi}

Attribute Transformation Transformasi atribut adalah fungsi yang memetakan seluruh rangkaian nilai atribut yang diberikan ke serangkaian nilai penggantian baru sehingga setiap nilai lama dapat diidentifikasi dengan salah satu nilai baru. • Fungsi sederhana: xk, log(x), ex, |x| • Normalisasi • Mengacu pada berbagai teknik untuk menyesuaikan perbedaan antara atribut dalam hal frekuensi kemunculan, rerata, ragam, rentang • Keluarkan sinyal umum yang tidak diinginkan, mis. , Musiman • Dalam statistik, standardisasi mengacu pada mengurangi sarana dan membaginya dengan standar deviasi

Review Sebelum pertemuan selesai • Apa yang sudah kita pelajari pada pertemuan ini? • Aggregation • Sampling • Dimensionality Reduction • Feature subset selection • Feature creation • Discretization and Binarization • Attribute Transformation

Penutup Pada pertemuan berikutnya, kita akan mempelajari dan membahas: • Eksplorasi data • Visualisasi data

Tugas • Dikumpulkan pada:

selesai

- Slides: 34