Curso Introduo s Redes Neuronais Parte 2 Prof

- Slides: 26

Curso Introdução às Redes Neuronais Parte 2 Prof. Dr. rer. nat. Aldo von Wangenheim

Recapitulação: Aspectos Importantes • Modelagem dos Objetos • Implementação dos Algoritmos de Treinamento • Escolha e Gerência dos exemplos para Treinamento • Estes aspectos são independentes do modelo de rede que se deseja implementar.

Recapitulação: Modelagem dos Objetos a serem modelados: • • • Rede Camada (Layer) Neurônio Conexão Neuroreceptor (Site)

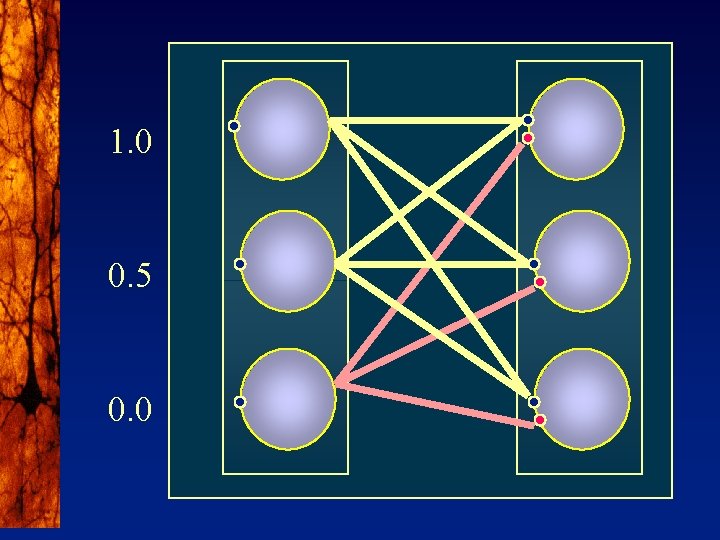

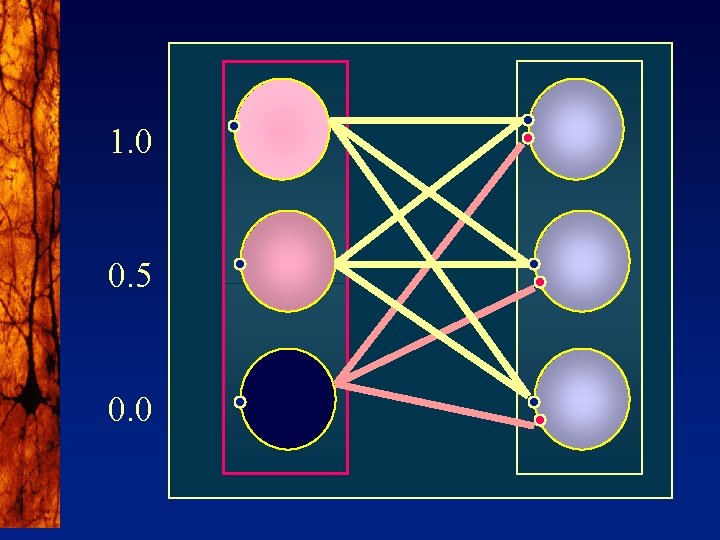

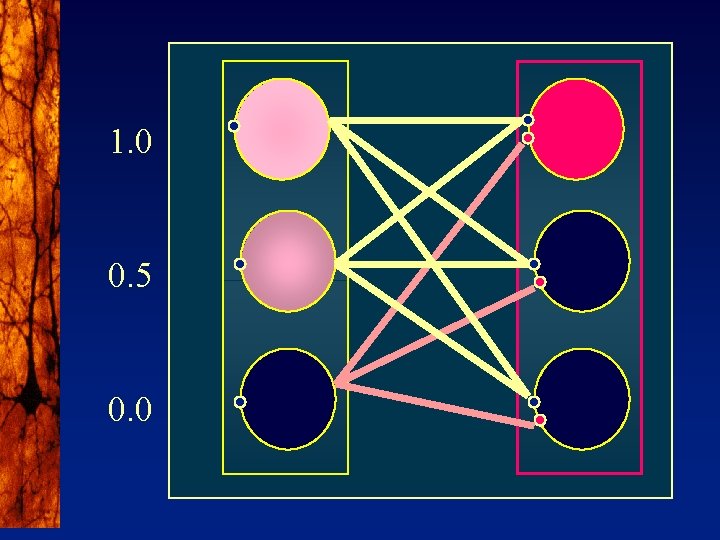

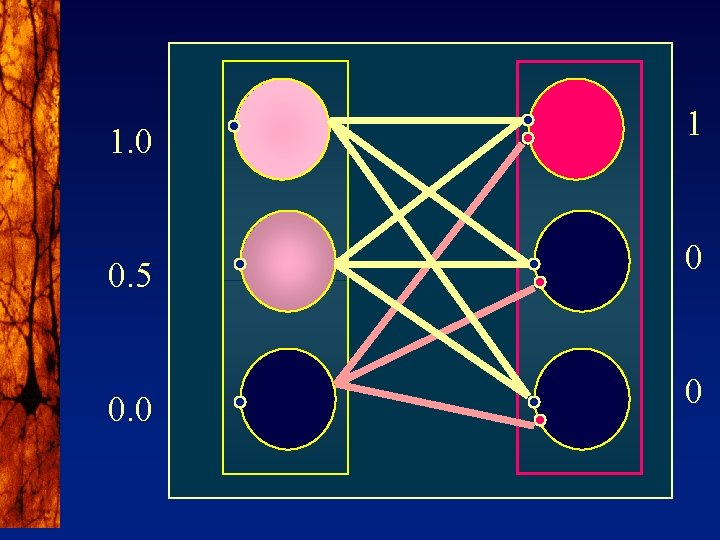

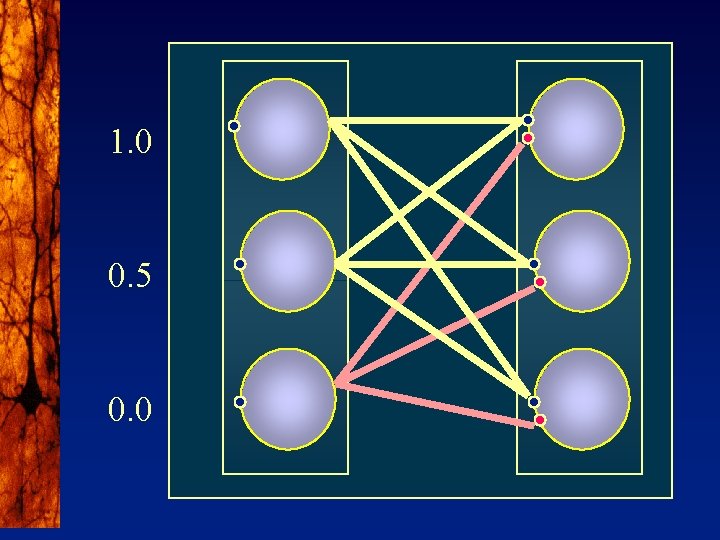

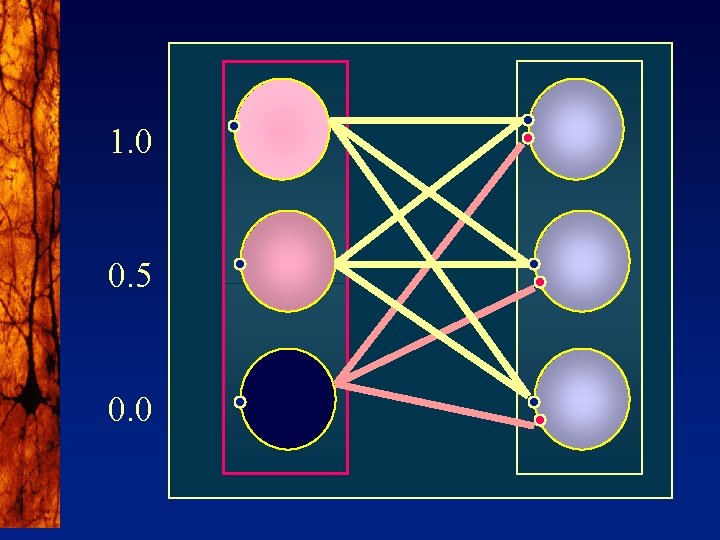

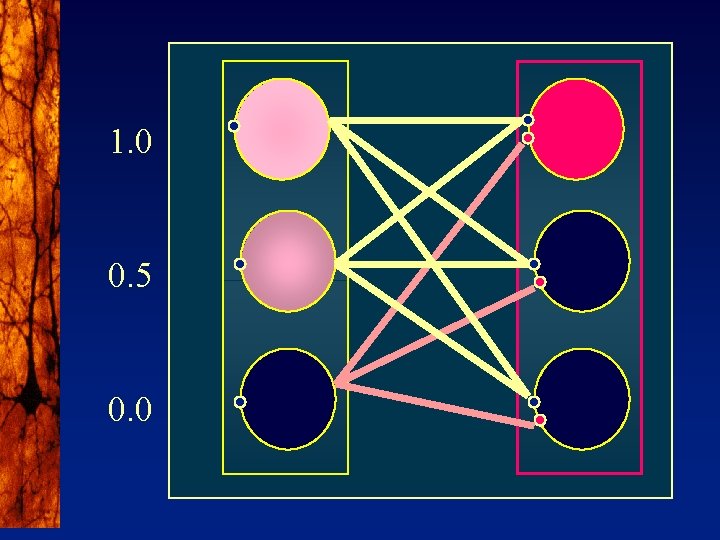

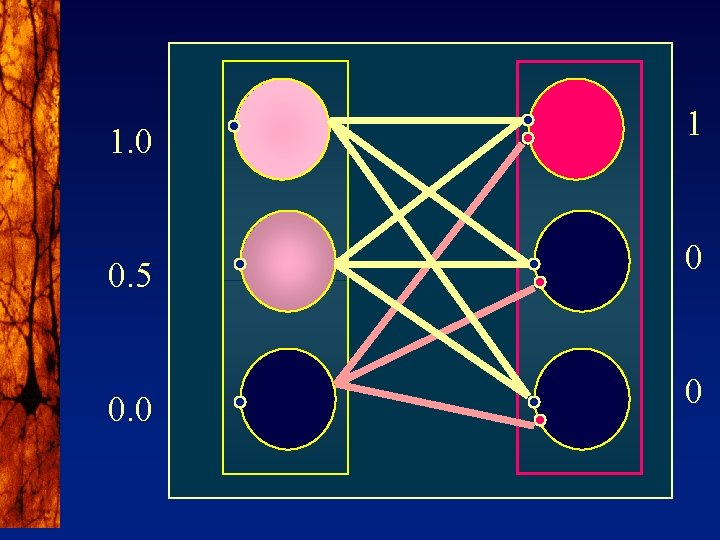

1. 0 0. 5 0. 0

1. 0 0. 5 0. 0

1. 0 0. 5 0. 0

1. 0 1 0. 5 0 0

Backpropagation • Modelo mais utilizado atualmente • Baseia-se em uma extensão dos Perceptrons • Utilizado quando queremos “aprender” uma função y = ? (x) desconhecida entre um conjunto de dados de entrada x e um conjunto de classificações possíveis y para esses. BP é um algoritmo para a implementação de classificadores de dados. 4 Representa teoricamente qualquer função, desde que exista. 4

Perceptrons (1957) • Redes Feed-Forward 4 Treinamento baseado no Erro entre saída e padrão. • 2 Camadas 4 Limitado pque não existiam algoritmos de treinamento. • Dois modelos de Neurônios: 4 Neurônios de Barreira • Representam dados linearmente separáveis 4 Neurônios Lineares • Representam dados linearmente independentes.

Aprendizado nos Perceptrons • Através da adaptação dos pesos wik • Mesmo para os dois tipos de neurônios.

Perceptron: Regra de Aprendizado

Perceptron: Regra de Aprendizado • A regra de aprendizado do Perceptron é chamada de Regra-Delta. 4 A cada passo é calculado um novo delta. • Com a Regra-Delta como foi definida por Rosenblatt havia vários problemas: 4 4 4 Só servia para treinar redes onde você pudesse determinar o erro em todas as camadas. Redes com só duas camadas eram limitadas. Nos neurônios lineares, onde era fácil determinar o erro numa camada interna, não fazia sentido incluí-la por causa da dependência linear.

Regra de Aprendizado: Minimizar o Erro • Inicializamos a rede com valores aleatórios para os pesos. • A Regra Delta aplicada repetidamente produz como resultado e minimização do erro apresentado pela rede:

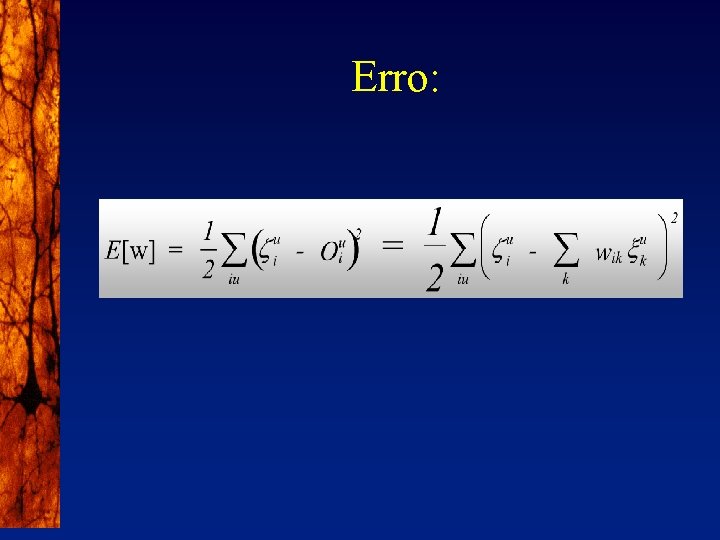

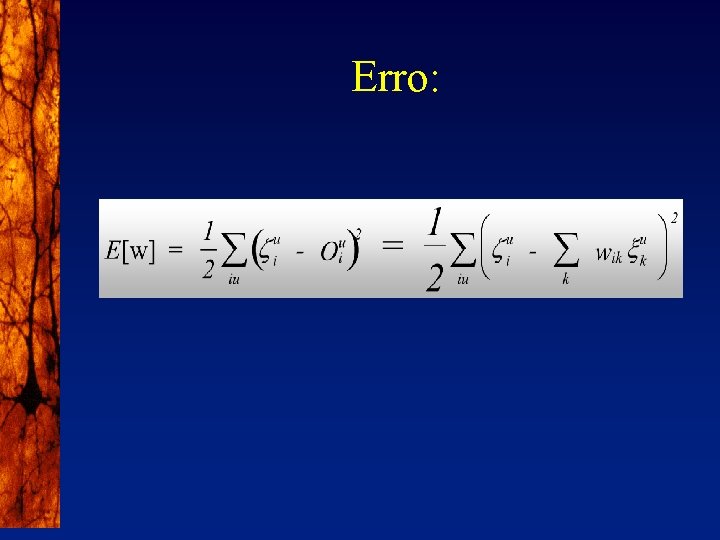

Erro:

Pesos Convergem para um Ponto de Erro Mínimo chamado Atrator

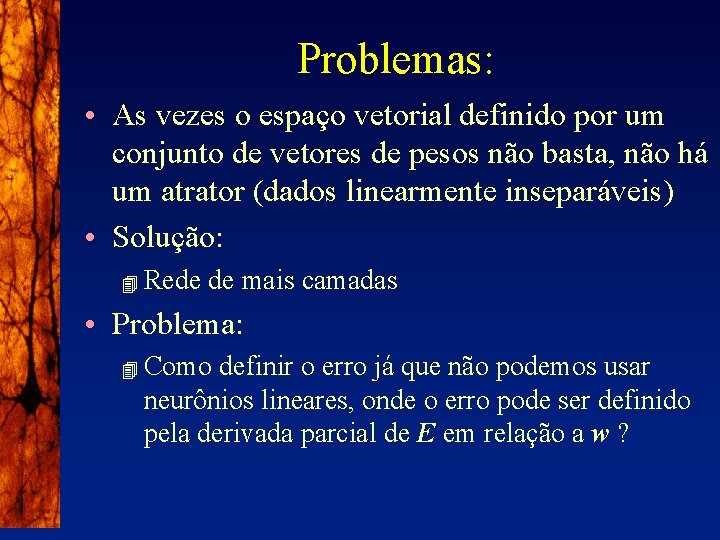

Problemas: • As vezes o espaço vetorial definido por um conjunto de vetores de pesos não basta, não há um atrator (dados linearmente inseparáveis) • Solução: 4 Rede de mais camadas • Problema: 4 Como definir o erro já que não podemos usar neurônios lineares, onde o erro pode ser definido pela derivada parcial de E em relação a w ?

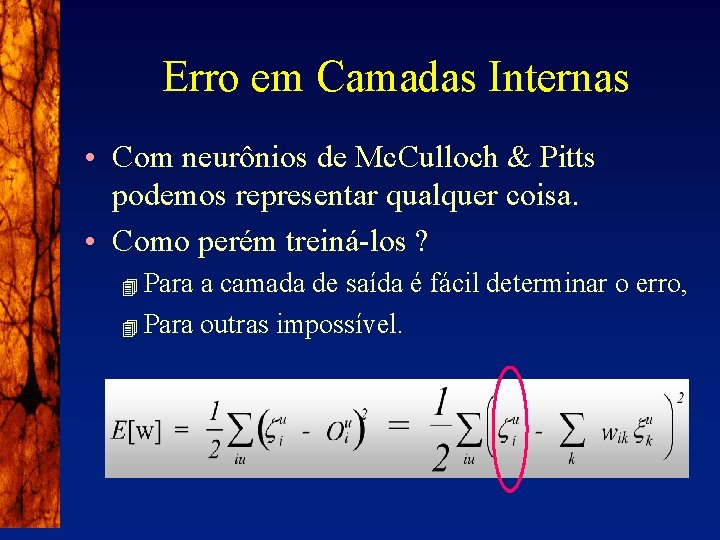

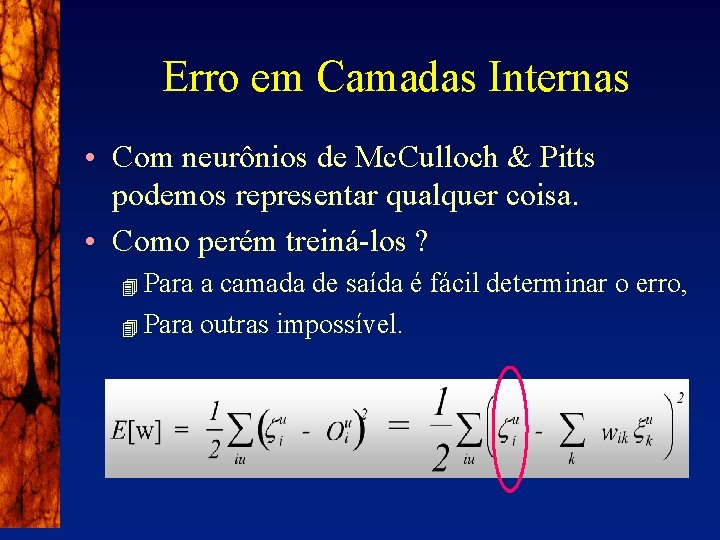

Erro em Camadas Internas • Com neurônios de Mc. Culloch & Pitts podemos representar qualquer coisa. • Como perém treiná-los ? Para a camada de saída é fácil determinar o erro, 4 Para outras impossível. 4

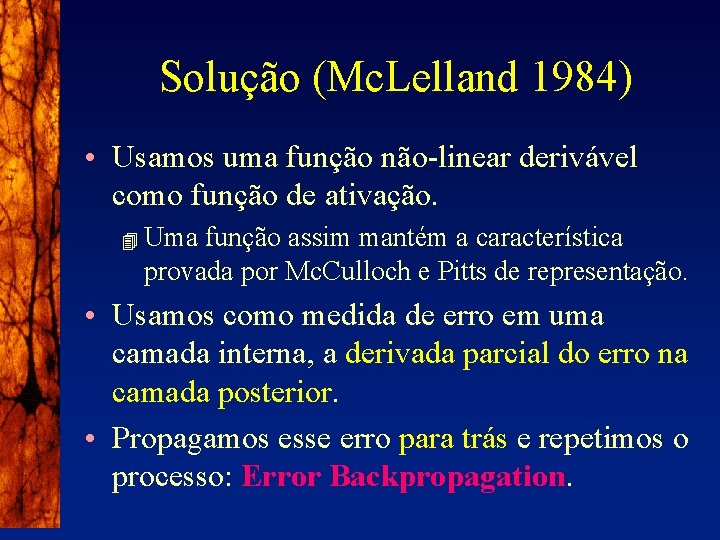

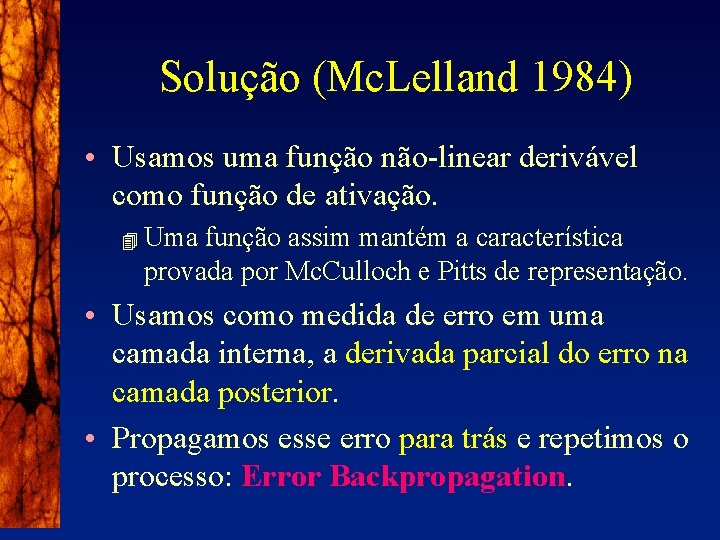

Solução (Mc. Lelland 1984) • Usamos uma função não-linear derivável como função de ativação. 4 Uma função assim mantém a característica provada por Mc. Culloch e Pitts de representação. • Usamos como medida de erro em uma camada interna, a derivada parcial do erro na camada posterior. • Propagamos esse erro para trás e repetimos o processo: Error Backpropagation.

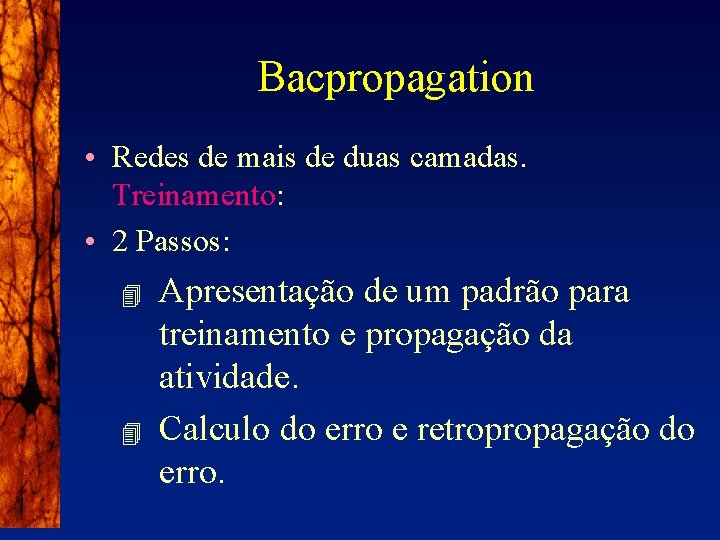

Bacpropagation • Redes de mais de duas camadas. Treinamento: • 2 Passos: 4 4 Apresentação de um padrão para treinamento e propagação da atividade. Calculo do erro e retropropagação do erro.

Treinamento em BP: • Padrão de treinamento é apresentado. • Atividade é propagada pelas camadas. • Erro é calculado na saída e vetores de pesos entrando na última camada são adaptados. • Derivada do erro em relação aos vetores de pesos (antes da adaptação) é calculada e usada para adaptação dos pesos da camada anterior. • Processo é repetido até a camada de entrada.

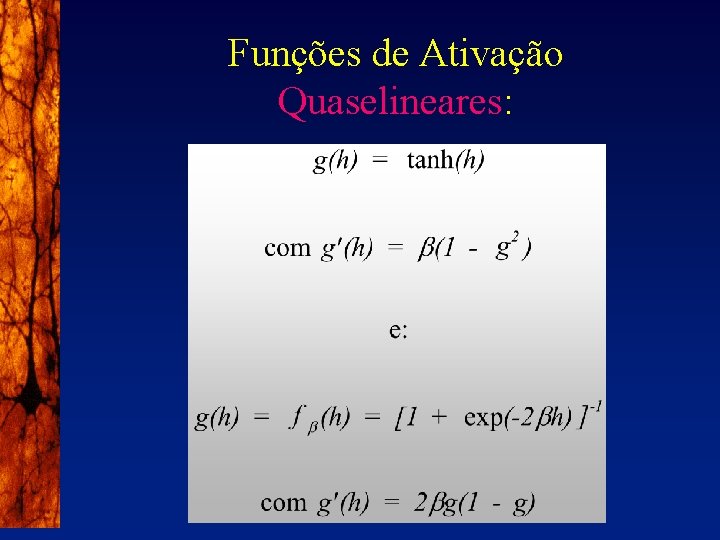

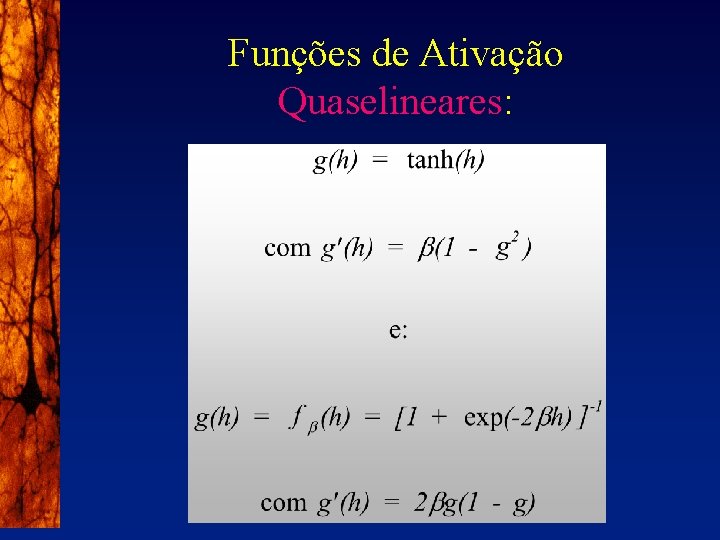

Funções de Ativação Quaselineares:

Este parte aquele parte

Este parte aquele parte Cinco decimales

Cinco decimales Partes da missa

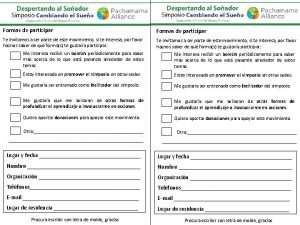

Partes da missa Te invitamos a ser parte o hacer parte

Te invitamos a ser parte o hacer parte Conjunto de valores morais

Conjunto de valores morais Curso de instalación de cámaras de seguridad a distancia

Curso de instalación de cámaras de seguridad a distancia Curso de edi

Curso de edi Curso cerâmica e cozedura a lenha

Curso cerâmica e cozedura a lenha Network analizer

Network analizer Curso realidad aumentada

Curso realidad aumentada Tipología de los participantes

Tipología de los participantes Senati reclamos

Senati reclamos Como modela el relieve un rio en su curso alto

Como modela el relieve un rio en su curso alto Para ser alfabetizador

Para ser alfabetizador Curso de ingreso psicología unlp

Curso de ingreso psicología unlp Ejemplos de enunciados oracionales

Ejemplos de enunciados oracionales Identifica la idea principal del texto

Identifica la idea principal del texto Suela de labor

Suela de labor Curso electra

Curso electra Revenue management curso

Revenue management curso Curso comando

Curso comando Oración inicio de curso 2020 21

Oración inicio de curso 2020 21 Profesorado de yoga intensivo

Profesorado de yoga intensivo Para medir o ângulo dalila

Para medir o ângulo dalila Curso de expresiones regulares

Curso de expresiones regulares Simulador ensamblaje de pc

Simulador ensamblaje de pc Curso de psicografia

Curso de psicografia