CMS HPC Italia outline Utilizzo di HPC in

- Slides: 12

CMS HPC Italia

outline Utilizzo di HPC in CMS Alcuni esempi Marconi nello specifico. . .

Overview di CMS Una iniziativa quasi in produzione: NERSC Cori: Cray XC basato su Intel Haswell – in fase di upgrade con inclusione di Intel Xeon Phi (Knights Landing) Edison: Cray XC 30 basato su Intel Ivy Bridge Sistema davvero minimale: una release (1!) di CMSSW installata a mano, no CVMFS Ok per una singola produzione, ma non praticabile come risorsa multipurpose Sottomissione via BOSCO (ssh gateway) che si attacca ad uno SLURM Usa containers Due iniziative in fase di commissioning SDSC Comet: basato su Intel Xeon E 5 -2680 v 3 Stampede TACC: basato su Intel E 5 8 -core (Sandy Bridge) e Intel Xeon Phi (Knights Corner) Accesso basato su CE standard; + facile

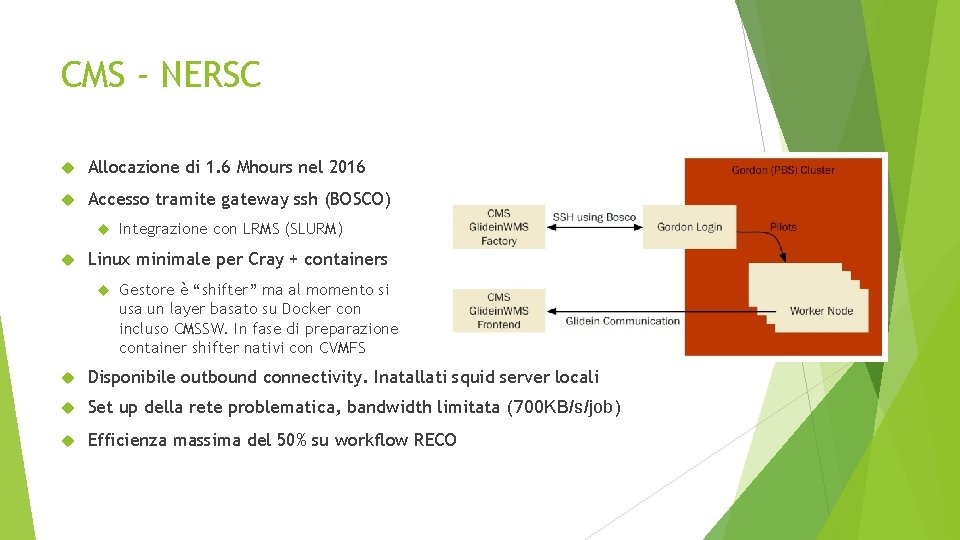

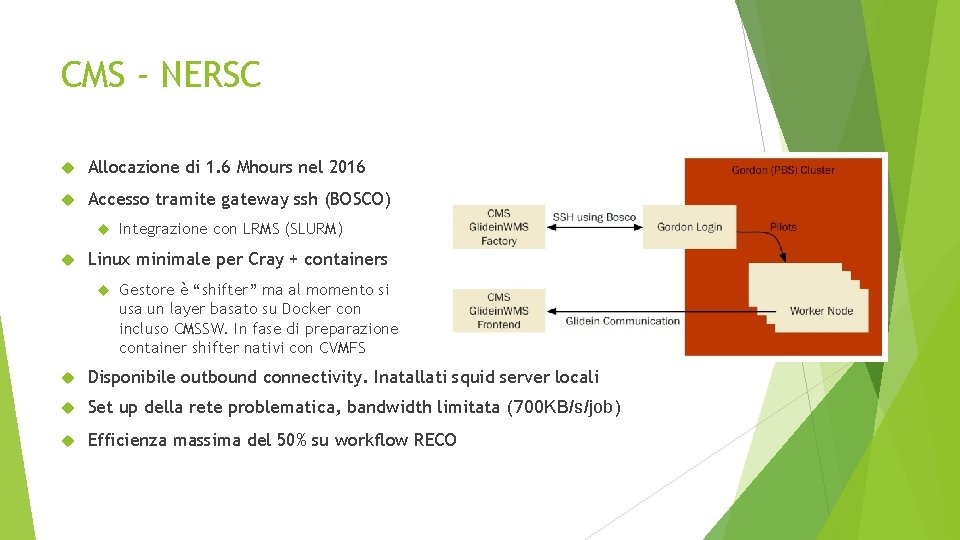

CMS - NERSC Allocazione di 1. 6 Mhours nel 2016 Accesso tramite gateway ssh (BOSCO) Integrazione con LRMS (SLURM) Linux minimale per Cray + containers Gestore è “shifter” ma al momento si usa un layer basato su Docker con incluso CMSSW. In fase di preparazione container shifter nativi con CVMFS Disponibile outbound connectivity. Inatallati squid server locali Set up della rete problematica, bandwidth limitata (700 KB/s/job) Efficienza massima del 50% su workflow RECO

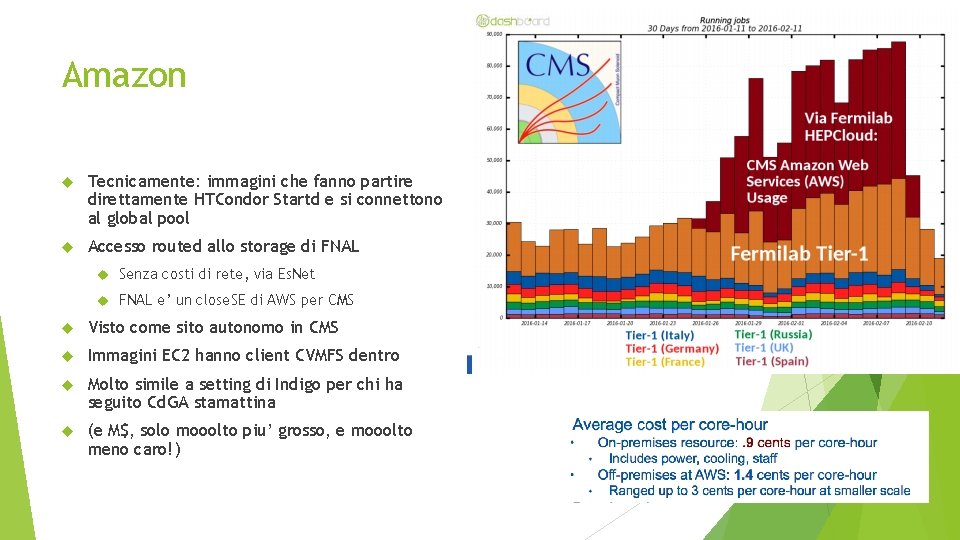

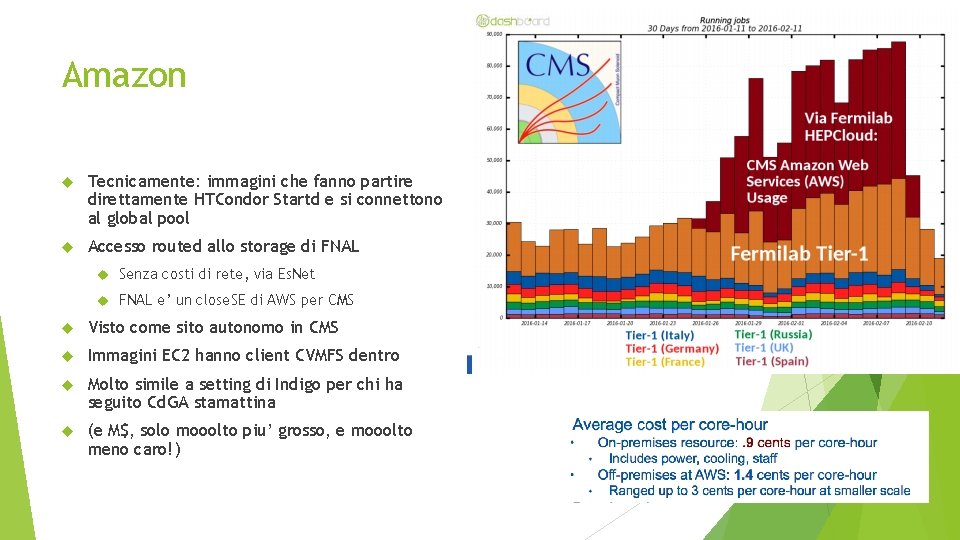

Amazon Tecnicamente: immagini che fanno partire direttamente HTCondor Startd e si connettono al global pool Accesso routed allo storage di FNAL Senza costi di rete, via Es. Net FNAL e’ un close. SE di AWS per CMS Visto come sito autonomo in CMS Immagini EC 2 hanno client CVMFS dentro Molto simile a setting di Indigo per chi ha seguito Cd. GA stamattina (e M$, solo mooolto piu’ grosso, e mooolto meno caro!)

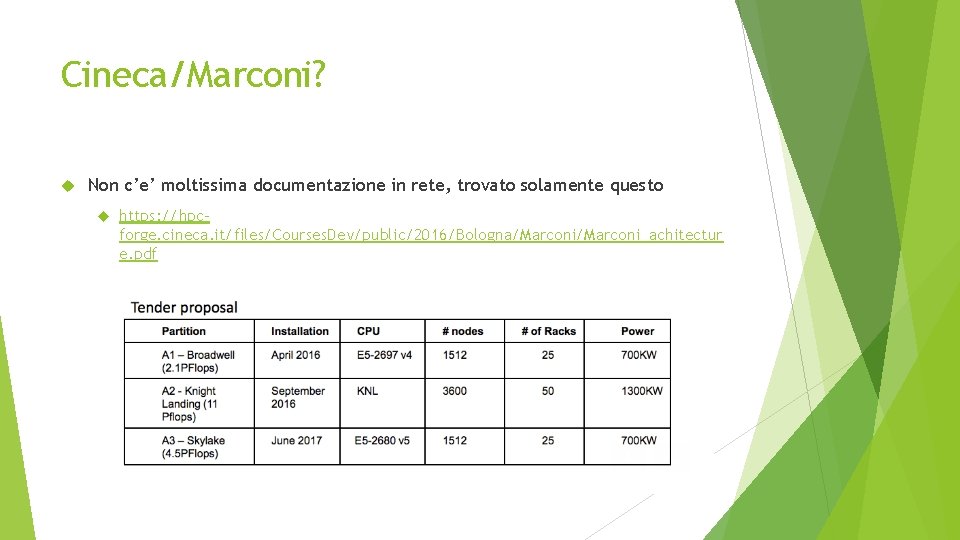

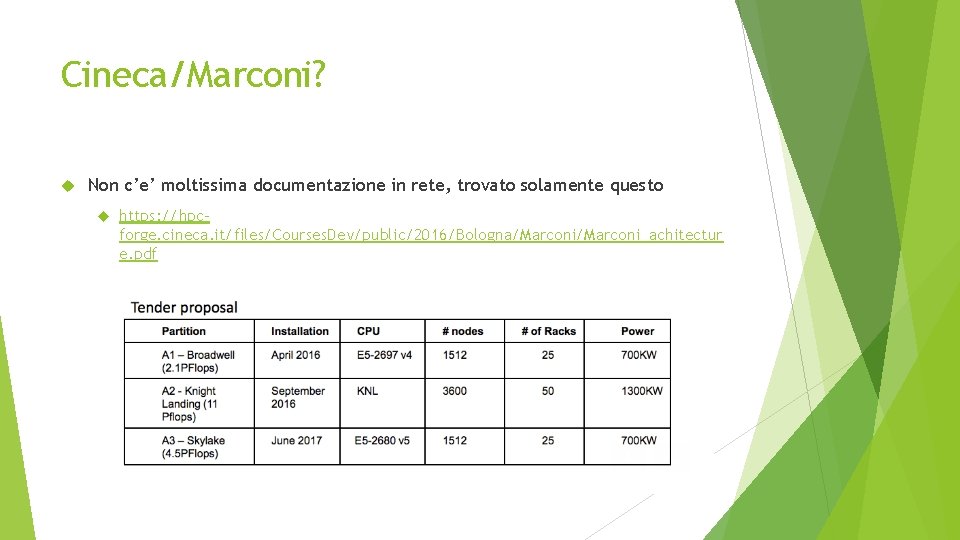

Cineca/Marconi? Non c’e’ moltissima documentazione in rete, trovato solamente questo https: //hpcforge. cineca. it/files/Courses. Dev/public/2016/Bologna/Marconi_achitectur e. pdf

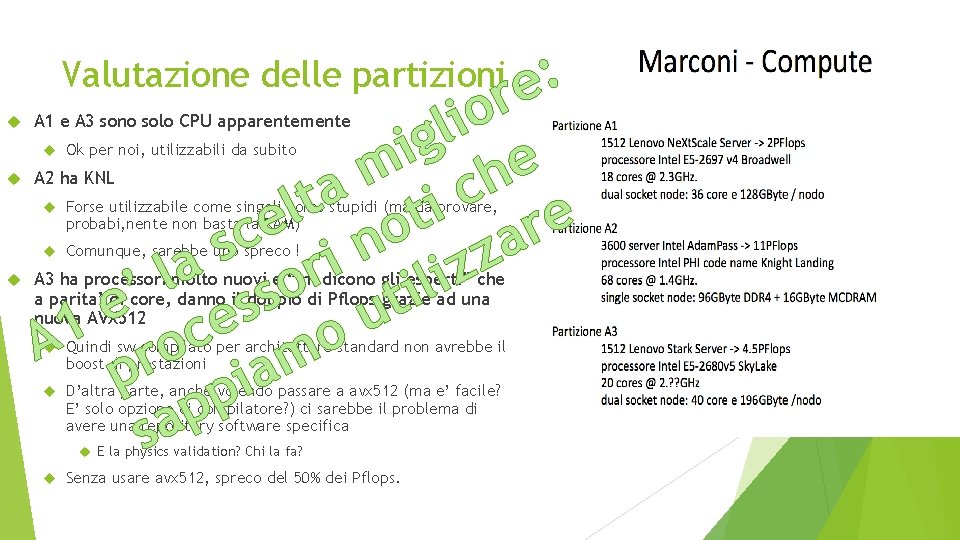

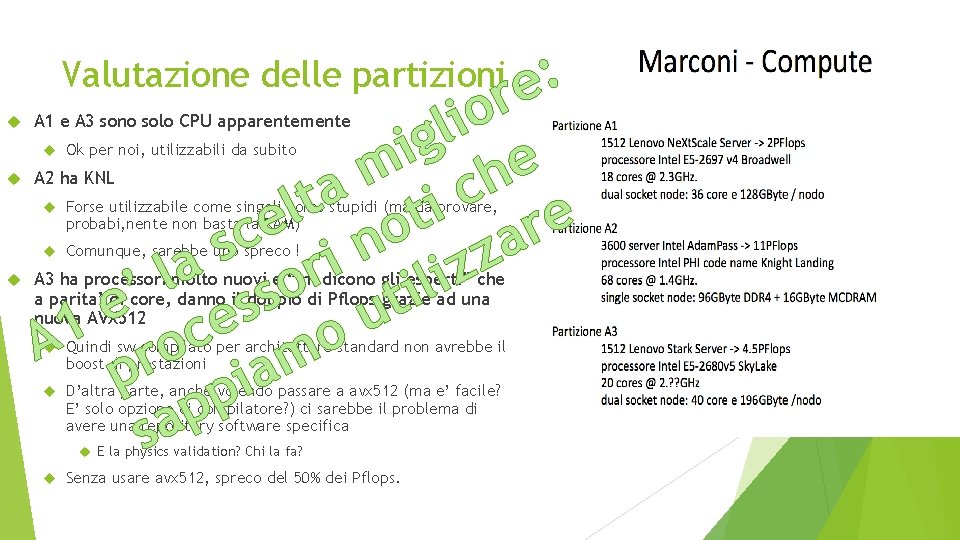

: re Valutazione delle partizioni o i l g i e m h a c t i l t e e r o c in a s z a z r l i l o i ’ s t e s u e 1 A roc mo p pia p sa A 1 e A 3 sono solo CPU apparentemente Ok per noi, utilizzabili da subito A 2 ha KNL Forse utilizzabile come singoli cores stupidi (ma da provare, probabi, nente non basta la RAM) Comunque, sarebbe uno spreco ! A 3 ha processori molto nuovi e “mi dicono gli esperti” che a parita’ di core, danno il doppio di Pflops grazie ad una nuova AVX 512 Quindi sw compilato per architetture standard non avrebbe il boost di prestazioni D’altra parte, anche volendo passare a avx 512 (ma e’ facile? E’ solo opzione di compilatore? ) ci sarebbe il problema di avere una repository software specifica E la physics validation? Chi la fa? Senza usare avx 512, spreco del 50% dei Pflops.

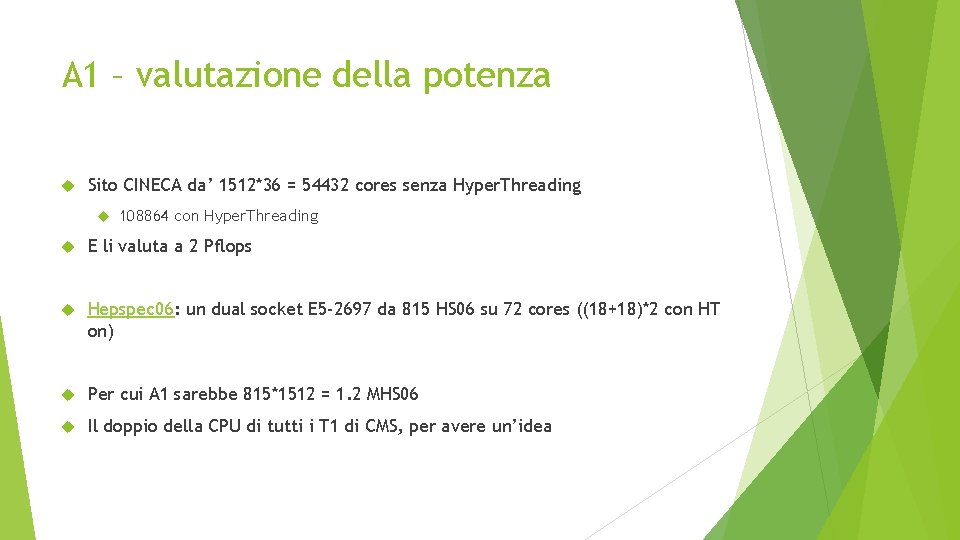

A 1 – valutazione della potenza Sito CINECA da’ 1512*36 = 54432 cores senza Hyper. Threading 108864 con Hyper. Threading E li valuta a 2 Pflops Hepspec 06: un dual socket E 5 -2697 da 815 HS 06 su 72 cores ((18+18)*2 con HT on) Per cui A 1 sarebbe 815*1512 = 1. 2 MHS 06 Il doppio della CPU di tutti i T 1 di CMS, per avere un’idea

Ambiente operativo (per quello che si capisce) PBS presente (non nel link, ma mi viene detto dai teorici pisani) Sistema operativo? Non specificato, mi sorprenderei fosse un problema (al max Docker) Networking? Locale assolutamente eccessivo per le nostre esigenze; WAN a noi andrebbe benissimo tutto tunnelling verso CNAF RAM: OK Disco locale: non specificato, ma sono macchine standard; qualcosa ci deve essere Come hint, su 72 cores a noi servirebbero > 200 GB

I dettagli possono complicare le cose Ci permetterebbero di caricare kernel modules? CVMFS e’ probabilmente il singolo punto in cui le cose si possono complicare Se non ci permettono di montarlo, anche con Docker diventa problematico (Docker non e’ una soluzione a questo problema) Ci sara’ un environment WLCG like? Certificati, CRL, etc… Probabilmente no … Docker? BOSCO?

Soluzioni possibili Estensione elastica del CNAF su cineca sarebbe largamente preferibile Accounting gratis (via CE CNAF e APEL) Come farlo? LSF: serve o tunnelling o DMZ; comunque servono demoni running HTCondor come batch system Dovremmo riuscire a usarlo anche come non root Serve infrastruttura lato CNAF, che se capisco si voleva comunque mettere in piedi

conclusioni Sulla carta, A 1 dovrebbe essere ben utilizzabile da noi Il problema sono davvero I dettagli, soprattutto umani Quanto il CINECA sarebbe flessibile per eventuali installazioni personalizzate? (GULP: potremmo reinstallare macchine? ? ) – chiaramente in questo modo si va in una situazione Bari-like, con una rete molto migliore Nella pratica, con un po’ di supporto lato CNAF, se ne vale la pena (no 100 cores per 1 mese), si puo’ e si deve fare …