Bestimmung der richtigen Wortbedeutung Einfache Vorstellung n n

Bestimmung der richtigen Wortbedeutung

Einfache Vorstellung n n n Einige Wörter haben mehr als eine Bedeutung (z. B. Bank, Hahn, Schloss, Titel, Kopf, . . . ) Ein Wort hat endlich viele, diskrete Bedeutungen, die in einem Wörterbuch, Thesaurus oder anderen Referenzquellen verankert sind Die Bestimmung der Bedeutung geschieht mit Hilfe des Kontexts

Das Problem ist komplizierter n n n Ein Wort hat selten eindeutige, klar abgetrennte Bedeutungen (wie „Bank“) Oft besteht ein Zusammenhang zwischen den Bedeutungen, sie sind nicht klar trennbar Beispiel: „title“ - Name/heading of a book, work of art or music Material at the start of the film The right of legal ownership of land The document that is evidence of this right An appellation of respect attached to a person‘s name

Definition der Wortbedeutung n n Variante: Bereits vorhandene Definitionen aus einem Lexikon/Wörterbuch übernehmen Kein einheitlicher Standard, Unterschiede in Anzahl und Art der Bedeutungen Teilweise sind Zuordnungen von Bedeutungen in einem Wörterbuch nicht konsistent Beispiel „This work doesn‘t have a title“

Bedeutungsbestimmung vs. Tagging n n Andere Art von Mehrdeutigkeit ist syntaktischer Natur z. B. „butter“ – Substantiv, Verb („you should butter your toast“) Starker Unterschied zw. Gebrauch als Verb und Gebrauch als Substantiv => Tagging ein Teilproblem? Bestimmung von Bedeutungen = Vergabe von semantischen Tags => Kann mit Tagging erledigt werden

Tagging als separates Problem n n Trennung, da unterschiedliche Natur der Probleme Unterschiedliche Methoden: Deskriptoren für syntaktische Methoden relevant Wörter mit einer relativ großen „Entfernung“ im Satz wichtig für Bestimmung der Wortbedeutung

Bayesische Klassifikation n Betrachtung eines großen Kontextfensters um das zu klärende Wort Annahme: Jedes Wort trägt zur Bedeutungsklärung bei Keine speziellen Merkmale werden ausgewählt. Stattdessen Kombination der Hinweise auf eine Bedeutung berücksichtigt

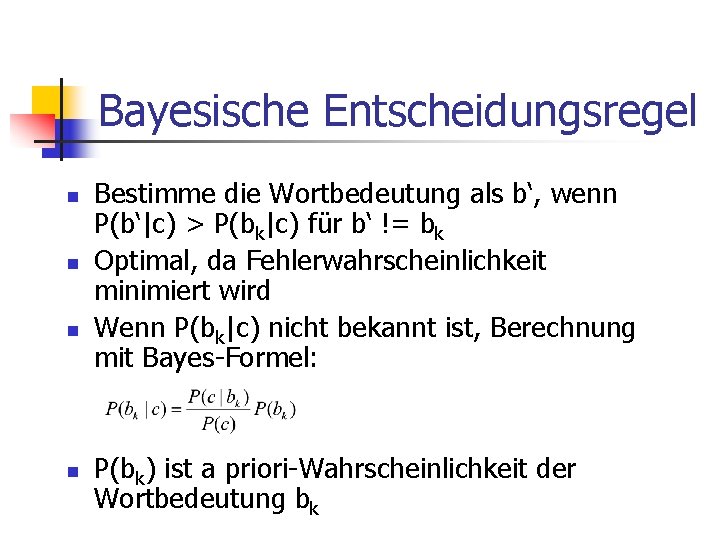

Bayesische Entscheidungsregel n n Bestimme die Wortbedeutung als b‘, wenn P(b‘|c) > P(bk|c) für b‘ != bk Optimal, da Fehlerwahrscheinlichkeit minimiert wird Wenn P(bk|c) nicht bekannt ist, Berechnung mit Bayes-Formel: P(bk) ist a priori-Wahrscheinlichkeit der Wortbedeutung bk

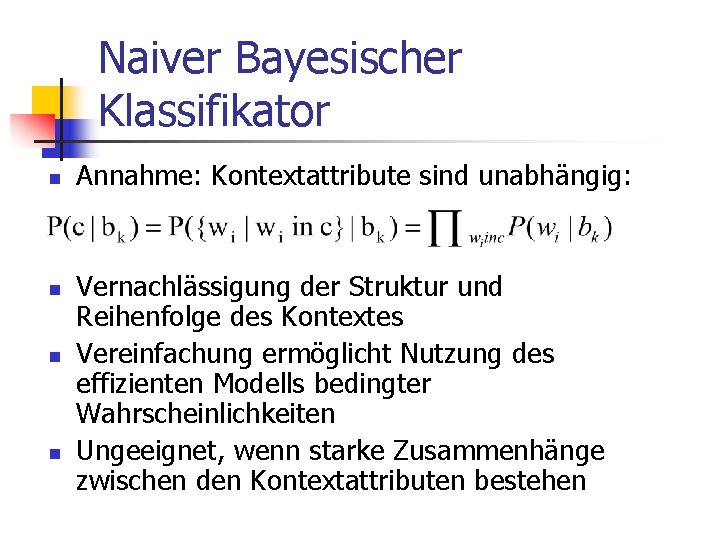

Naiver Bayesischer Klassifikator n n Annahme: Kontextattribute sind unabhängig: Vernachlässigung der Struktur und Reihenfolge des Kontextes Vereinfachung ermöglicht Nutzung des effizienten Modells bedingter Wahrscheinlichkeiten Ungeeignet, wenn starke Zusammenhänge zwischen den Kontextattributen bestehen

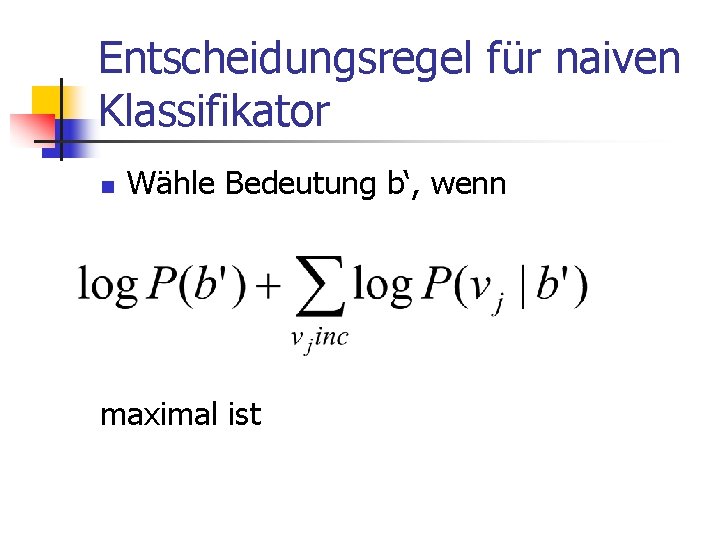

Entscheidungsregel für naiven Klassifikator n Wähle Bedeutung b‘, wenn maximal ist

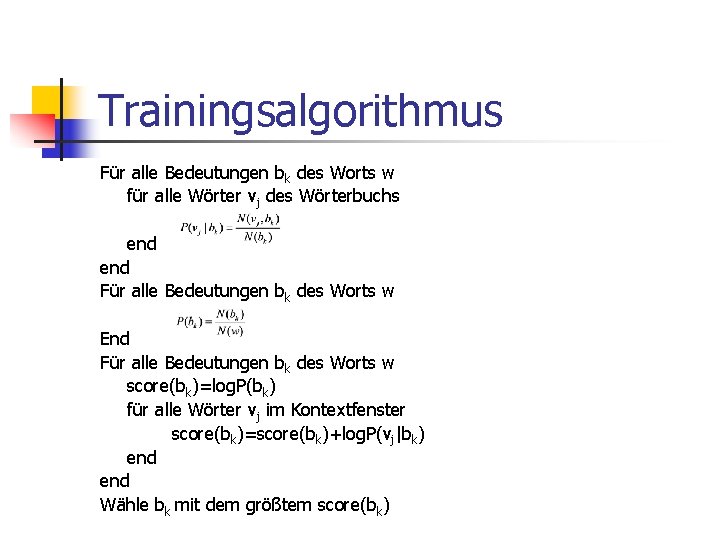

Trainingsalgorithmus Für alle Bedeutungen bk des Worts w für alle Wörter vj des Wörterbuchs end Für alle Bedeutungen bk des Worts w End Für alle Bedeutungen bk des Worts w score(bk)=log. P(bk) für alle Wörter vj im Kontextfenster score(bk)=score(bk)+log. P(vj|bk) end Wähle bk mit dem größtem score(bk)

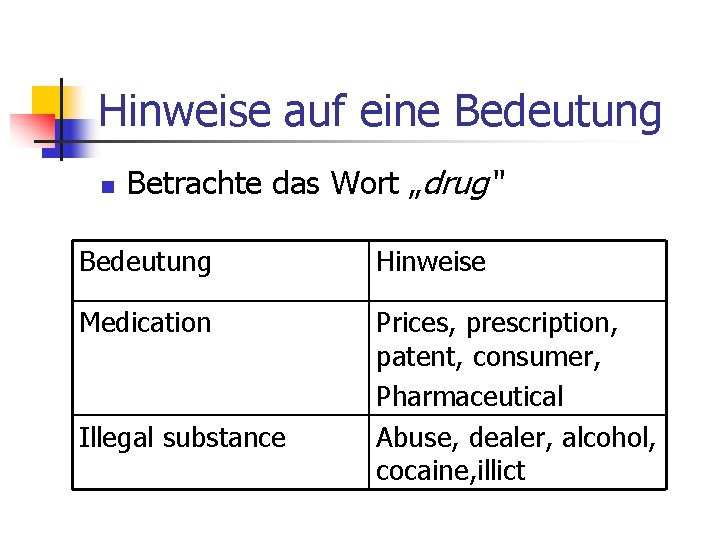

Hinweise auf eine Bedeutung n Betrachte das Wort „drug“ Bedeutung Hinweise Medication Prices, prescription, patent, consumer, Pharmaceutical Abuse, dealer, alcohol, cocaine, illict Illegal substance

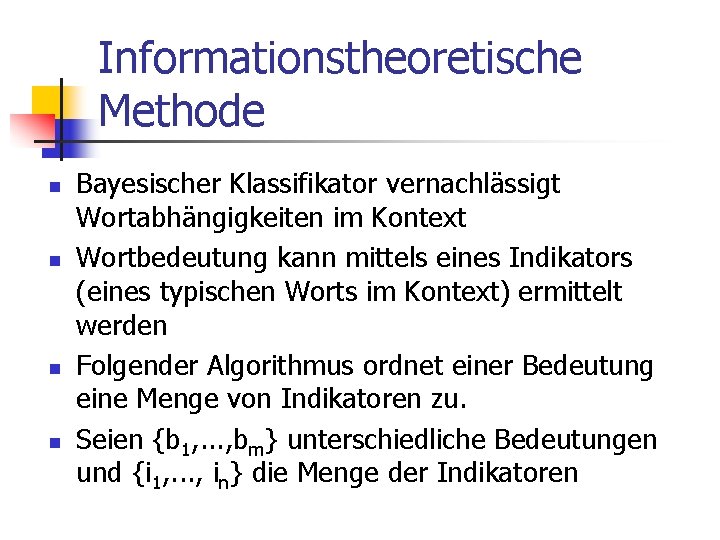

Informationstheoretische Methode n n Bayesischer Klassifikator vernachlässigt Wortabhängigkeiten im Kontext Wortbedeutung kann mittels eines Indikators (eines typischen Worts im Kontext) ermittelt werden Folgender Algorithmus ordnet einer Bedeutung eine Menge von Indikatoren zu. Seien {b 1, . . . , bm} unterschiedliche Bedeutungen und {i 1, . . . , in} die Menge der Indikatoren

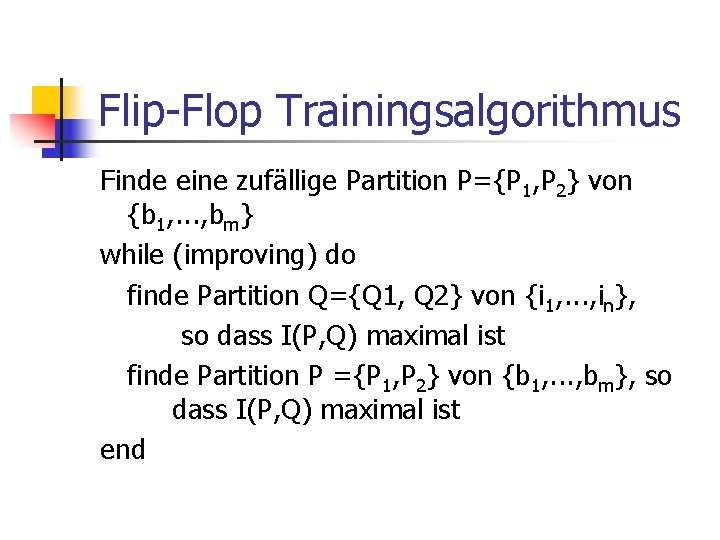

Flip-Flop Trainingsalgorithmus Finde eine zufällige Partition P={P 1, P 2} von {b 1, . . . , bm} while (improving) do finde Partition Q={Q 1, Q 2} von {i 1, . . . , in}, so dass I(P, Q) maximal ist finde Partition P ={P 1, P 2} von {b 1, . . . , bm}, so dass I(P, Q) maximal ist end

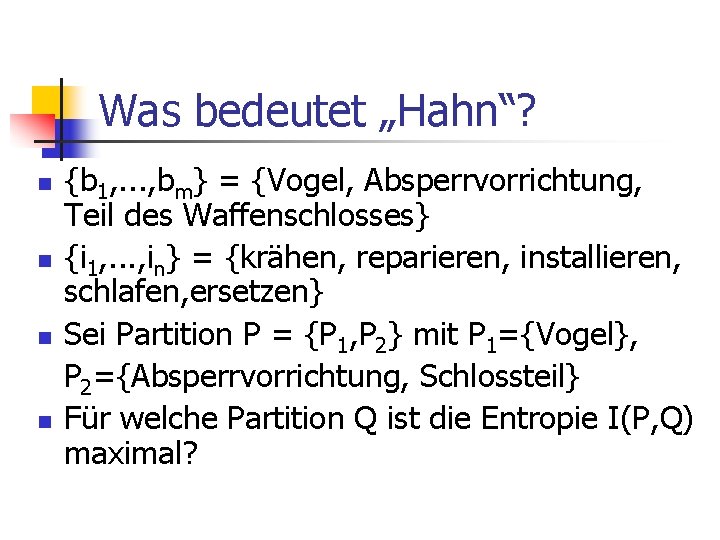

Was bedeutet „Hahn“? n n {b 1, . . . , bm} = {Vogel, Absperrvorrichtung, Teil des Waffenschlosses} {i 1, . . . , in} = {krähen, reparieren, installieren, schlafen, ersetzen} Sei Partition P = {P 1, P 2} mit P 1={Vogel}, P 2={Absperrvorrichtung, Schlossteil} Für welche Partition Q ist die Entropie I(P, Q) maximal?

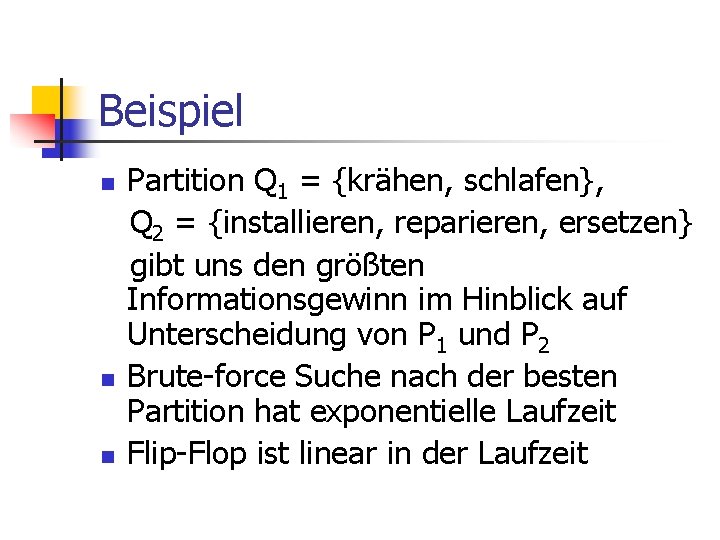

Beispiel n n n Partition Q 1 = {krähen, schlafen}, Q 2 = {installieren, reparieren, ersetzen} gibt uns den größten Informationsgewinn im Hinblick auf Unterscheidung von P 1 und P 2 Brute-force Suche nach der besten Partition hat exponentielle Laufzeit Flip-Flop ist linear in der Laufzeit

Anwendung n n Algorithmus für alle mögliche Positionen des Indikators im Kontext laufen lassen Indikatorposition mit dem größtem Informationsgewinn für beide Bedeutungen wählen Den Wert des Indikators ij an dieser Position bestimmen Wenn ij ist in Q 1, ordne dem Wort die Bedeutung 1 zu, wenn in Q 2 – Bedeutung 2.

Merkmale des IT-Algorithmus n n Überwachtes Lernen, da die Trainingstexte gekennzeichnet sein müssen Oft in Übersetzungssystemen verwendet Anstatt Wortbedeutungen werden ihre Übersetzungen betrachtet 20% Verbesserung

Nutzung eines Wörterbuchs n n n Idee: Wortdefinitionen sind oft gute Indikatoren für die definierte Bedeutung c-Kontext, Dk – Menge aller Wörter in Def. von bk, Ev – Menge aller Wörter in den Def. von allen Bedeutungen von v Für alle Bedeutungen bk des Worts w score(bk)=overlap(Dk, Uv in c Ev) end

Verbesserungsmöglichkeiten n n overlap – Mächtigkeit der Schnittmenge oder geeignete Metrik Mehrere Iterationen des Algorithmus Ev umfasst nicht alle, sondern in vorigen Iteration als relevant gefundene Bedeutungen Erweiterung jedes Worts im Kontext durch die Liste seiner Synonyme

Thesaurus-basierte Verfahren n n Nutzung der semantischen Kategorien Idee: Die Wortbedeutung wird durch die Kategorie bestimmt, die dem Kontext zugeordnet wird

Unsupervised disambiguation n Zuordnung von Bedeutungen nicht möglich Allerdings Bestimmung unterschiedlicher semantischer Gruppen realisierbar Clustering und Identifizierung unterschiedlicher Wortbedeutungen sind möglich

- Slides: 22